大数据工程平台实验操作手册3

普开大数据实验管理平台系统用户手册

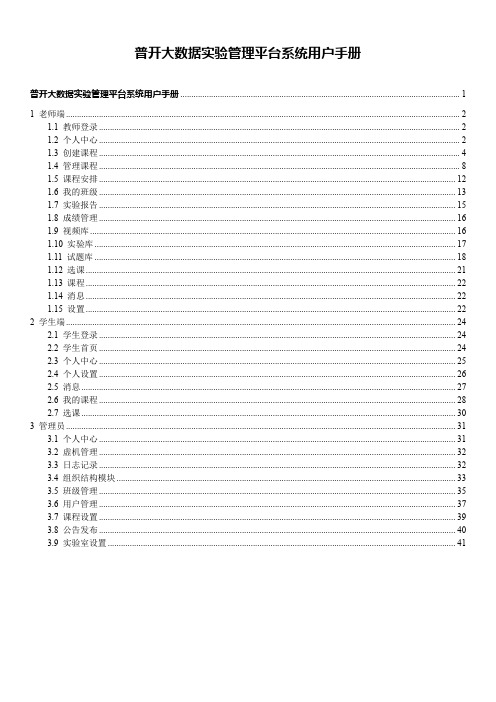

普开大数据实验管理平台系统用户手册普开大数据实验管理平台系统用户手册 (1)1 老师端 (2)1.1 教师登录 (2)1.2 个人中心 (2)1.3 创建课程 (4)1.4 管理课程 (8)1.5 课程安排 (12)1.6 我的班级 (13)1.7 实验报告 (15)1.8 成绩管理 (16)1.9 视频库 (16)1.10 实验库 (17)1.11 试题库 (18)1.12 选课 (21)1.13 课程 (22)1.14 消息 (22)1.15 设置 (22)2 学生端 (24)2.1 学生登录 (24)2.2 学生首页 (24)2.3 个人中心 (25)2.4 个人设置 (26)2.5 消息 (27)2.6 我的课程 (28)2.7 选课 (30)3 管理员 (31)3.1 个人中心 (31)3.2 虚机管理 (32)3.3 日志记录 (32)3.4 组织结构模块 (33)3.5 班级管理 (35)3.6 用户管理 (37)3.7 课程设置 (39)3.8 公告发布 (40)3.9 实验室设置 (41)大数据实验室是采用B/S结构,可以让学生在任何时间和地点做实验,不受环境和时间的限制。

老师也可以在任何时间和地点进行实验课程的相关工作。

1老师端1.1教师登录老师在浏览器打开登陆界面,输入用户名和密码进行登录。

登陆界面如下:登录界面可以进行本系统的使用手册进行下载!1.2个人中心老师登录进入系统后,老师端首页界面。

界面如下图所示:课程安排可以看到自己最近一周的课程排课情况,具体的课程安排下文会有详细的解释。

学生的登录情况是最近一周内学生的登录以及注册人数的详情,以折线图的形式展示出来,鼠标放上会有详细的人数。

1.3创建课程在上教师首页的导航栏中,有创建课程、管理课程、课程安排、我的班级、实验报告、成绩管理、视频库、实验库、试题库、试卷库、课程、选课、消息、设置和退出几项功能。

●点击创建课程,进入创建课程的页面。

大数据分析平台的建设与配置手册

大数据分析平台的建设与配置手册摘要:本文旨在为搭建和配置大数据分析平台的用户提供一份详尽的手册。

大数据分析平台作为一个结合了各种技术和工具的完整系统,可以实现对大量数据的采集、存储、处理和分析。

本手册将涵盖平台的搭建、配置、操作以及一些最佳实践等方面的内容,帮助用户有效地部署和管理大数据分析平台,从而提高数据分析的效率与准确性。

一、引言大数据分析平台的建设和配置是一个复杂的任务,需要进行适当的规划和设计。

本文将详细介绍大数据分析平台的搭建和配置步骤,包括硬件和软件环境准备,数据存储与处理工具选择,以及配置和管理等方面的内容。

二、环境准备1. 硬件环境准备在开始搭建大数据分析平台之前,您需要确保有足够的硬件资源来支持您的需求。

一般来说,大数据分析平台需要一台或多台具有较高计算能力和存储容量的服务器,以及稳定的网络连接。

2. 软件环境准备在选择软件环境时,您需要考虑到您的分析需求以及所选工具的兼容性和扩展性。

常用的大数据分析平台软件包括Hadoop、Spark、Hive和Pig等。

您需要确保所选平台与您的数据源兼容,并具备足够的处理能力。

三、数据存储与处理工具选择在搭建大数据分析平台时,选择适合的数据存储与处理工具非常重要。

以下是一些常用的工具及其特点:1. Hadoop:Hadoop是一个开源的分布式计算框架,适用于大规模数据存储和处理。

它主要由HDFS(Hadoop分布式文件系统)和MapReduce构成。

2. Spark:Spark是一个通用的大数据处理引擎,相比于Hadoop,它具备更好的性能和灵活性。

Spark支持多种数据处理模式,包括批处理、交互式查询和流式处理等。

3. Hive:Hive是一个基于Hadoop的数据仓库解决方案,它允许用户使用类似于SQL的查询语言进行数据分析。

Hive将SQL查询翻译成MapReduce任务来执行。

4. Pig:Pig是一个用于分析大型数据集的高级平台,它以脚本语言为基础,允许用户进行数据提取、转换和加载等操作。

大数据运维管理平台说明书

碧茂大数据运维管理平台说明书版本控制目录简介 (3)功能详细介绍 (3)配置管理 (6)集群监控 (11)告警系统 (17)巡检 (20)知识库 (24)简介碧茂运维管理平台是针对大数据分布式集群系统设计的自动化运维管理平台,核心功能包括集群资产管理,监控系统,告警系统,系统巡检和运维知识库系统等。

详细如下:一、资产管理提供可视化界面实现对主机和集群资源的统一配置和管理,对各项监控管理任务进行调度配置、监控和管理。

方便运维人员能随时掌握系统全貌,集群服务角色分布情况,硬件资源分配情况,能根据管理需求进行定制化定时任务调度。

二、监控系统1、主机的健康性能的监控2、集群服务的端口、健康性能指标的监控3、集群参数的监控,并自动给出调优建议4、集群日志的监控预警,自动化收集汇总集群进程和应用日志,并对错误日志进行预警三、告警系统1、选择任意监控的指标和阈值,进行邮件告警四、系统巡检(特色功能)对系统和集群进行健康和性能检查,自动化生成巡检报告。

分为基础巡检和深度巡检。

基础巡检指的是根据需求可以灵活选择需要巡检的服务、指标、参数,自动化生成巡检报告。

深度巡检指的是对不同服务的结构对象进行深入分析诊断。

五、知识库系统(特色功能)一套高质量的集群管理运维相关的知识管理系统,包括运维工具箱、最佳实践和解决方案。

知识库系统中的方案可以一键执行来实现复杂运维流程的自动化处理,包括:⚫日常集群操作需求,包括服务启停、参数修改、备份恢复、集群扩容迁移、安全配置和升级⚫自动化故障处理功能详细介绍登录界面用户首先需要获取license,激活产品后才能正常使用,提示如下:点击激活,会自动生成机器码,请联系厂商获取激活码激活后,会提示到期日,产品可以正常进行登录了首页是向导页,以路线图的方式引导你进行集群配置和集群监控配置管理全局配置用于配置全局参数和服务,包括数据保留配置、告警服务、告警配置和数据库配置等修改全局参数数据库配置用于配置关系型数据库,支持Mysql和PostgreSQL等,通常是CM、Hive、Hue、Oozie等元数据库,方便管理和查询。

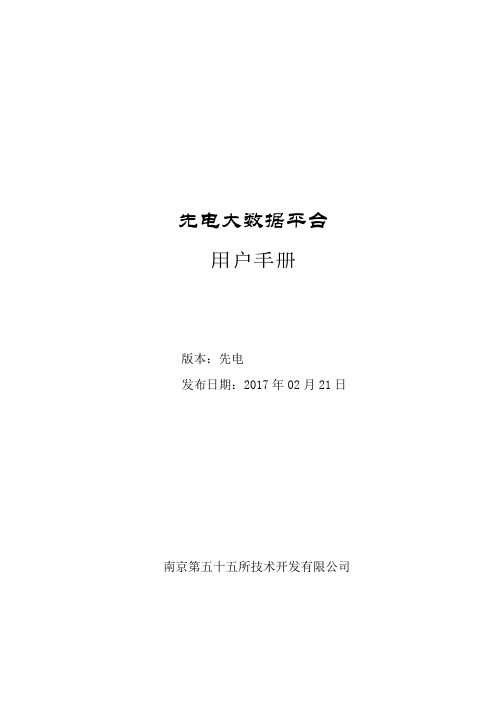

先电大数据平台操作手册

先电大数据平台用户手册版本:先电发布日期:2017年02月21日南京第五十五所技术开发有限公司版本修订说明目录1 概述...................................................... 错误!未定义书签。

大数据简介........................................ 错误!未定义书签。

先电大数据平台简介................................ 错误!未定义书签。

2 基本环境配置.............................................. 错误!未定义书签。

配置主机名........................................ 错误!未定义书签。

修改hosts文件.................................... 错误!未定义书签。

修改yum源........................................ 错误!未定义书签。

配置ntp .......................................... 错误!未定义书签。

配置SSH .......................................... 错误!未定义书签。

禁用Transparent Huge Pages ........................ 错误!未定义书签。

安装配置JDK....................................... 错误!未定义书签。

3 配置ambari-server ........................................ 错误!未定义书签。

安装MariaDB数据库................................ 错误!未定义书签。

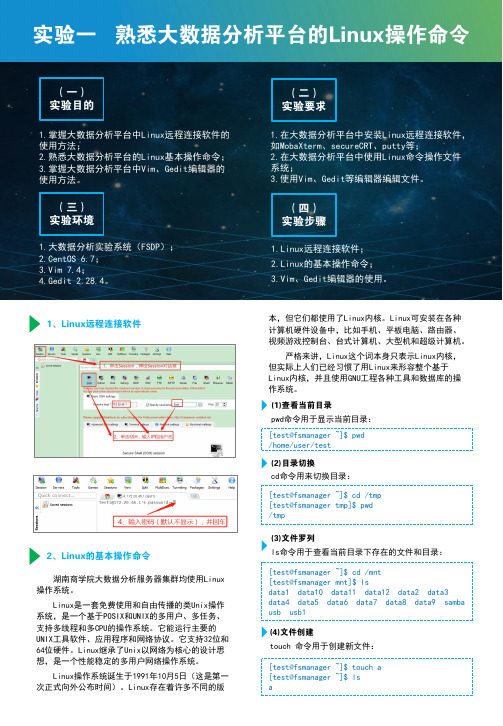

实验1 熟悉大数据分析平台的Linux操作命令

[test@fsmanager ~]$ pwd /home/user/test [test@fsmanager ~]$ cd /tmp [test@fsmanager tmp]$ pwd /tmp [test@fsmanager ~]$ cd /mnt [test@fsmanager mnt]$ lsdata1 data10 data11 data12 data2 data3 data4 data5 data6 data7 data8 data9 samba usb usb1 [test@fsmanager ~]$ touch a [test@fsmanager ~]$ ls a1、Linux 远程连接软件2、Linux 的基本操作命令湖南商学院大数据分析服务器集群均使用Linux 操作系统。

Linux 是一套免费使用和自由传播的类Unix 操作系统,是一个基于POSIX 和UNIX 的多用户、多任务、支持多线程和多CPU 的操作系统。

它能运行主要的UNIX 工具软件、应用程序和网络协议。

它支持32位和64位硬件。

Linux 继承了Unix 以网络为核心的设计思想,是一个性能稳定的多用户网络操作系统。

Linux 操作系统诞生于1991年10月5日(这是第一次正式向外公布时间)。

Linux 存在着许多不同的版(一) 实验目的1.掌握大数据分析平台中Linux 远程连接软件的使用方法;2.熟悉大数据分析平台的Linux 基本操作命令;3.掌握大数据分析平台中Vim 、Gedit 编辑器的使用方法。

(三) 实验环境1.在大数据分析平台中安装Linux 远程连接软件,如MobaXterm 、secureCRT 、putty 等;2.在大数据分析平台中使用Linux 命令操作文件系统;3.使用Vim 、Gedit 等编辑器编辑文件。

(四) 实验步骤(二) 实验要求1.Linux 远程连接软件;2.Linux 的基本操作命令;3.Vim 、Gedit 编辑器的使用。

新点大数据平台软件操作手册

新点大数据平台软件操作手册一、第一章、平台建设背景当今世界,信息技术与经济社会的交会融合引发数据迅猛增长,数据已成为国家基础性战略资源。

大数据的发展和应用正日益对全球生产、流通、分配、消费活动以及经济运行机制、社会生活方式和政府治理能力产生重要影响。

2014年,“大数据”被首次写入政府工作报告以来,中央主要领导对大数据中心的建设及大数据技术的应用高度重视,国务院及有关部门也陆续发布了一系列的文件。

2015年,《关于运用大数据加强对市场主体服务和监管的若干意见》、《关于积极推进“互联网+”行动的指导意见》和《促进大数据发展行动纲要》陆续颁布,2016年,《政务信息资源共享管理暂行办法》,明确规范政务部门间政务信息资源共享工作,2017年,《政务信息系统整合共享实施方案》,建立全国政务信息资源目录体系,政务信息系统整合共享取得显著成效,重要政务信息系统实现互联互通。

这几份重磅文件密集出台,标志着我国政府大数据战略部署和顶层设计正式确立,大数据的开发应用必将使政府治理“如虎添翼”。

二、第二章、建设原则建设大数据平台可以划分为四个阶段:信息资源规划、数据共享、数据开放、融合应用。

2.1、信息资源规划信息资源规划是政府管理、资源共享、电子政务建设的基础。

信息资源规划是以摸清政府部门信息资源底数为基础,以较为明确的需求如人口、法人、电子证照、地理信息为导向,通过信息资源规划IRP理论体系,按照三定方案或职责清单对政府业务进行分析,划分职能、梳理职能事项,并识别事项运行所发生的信息资源,详细描述信息资源的基础属性、采集属性、共享属性、开放属性等各类属性。

2.2、数据共享政务大数据平台建设第二阶段的主要任务就是先把政府部门之间的数据共享做起来,以数据应用为导向,综合考虑管理难度和技术难度,通过统一规划,逐步推进的策略,形成“条线内部门共享”、“平级跨部门共享”、“跨层级和跨区域共享”的信息资源共享共用的新格局。

大数据分析平台的搭建与使用教程

大数据分析平台的搭建与使用教程随着互联网的全面普及和信息技术的快速发展,大数据分析已成为企业决策和业务优化的重要手段。

为了充分利用海量数据中蕴含的商机和价值,许多企业开始搭建大数据分析平台,并通过数据分析来指导决策和业务发展。

本文将介绍大数据分析平台的搭建与使用教程,帮助读者了解如何构建一个高效可靠的大数据分析平台。

一、搭建大数据分析平台的基本步骤1.需求分析:在搭建大数据分析平台之前,首先要明确自己的需求和目标。

确定需要分析的数据类型、数据源、分析指标等等,并根据这些需求来选择合适的技术和工具。

2.选取适合的大数据技术:大数据技术包括分布式存储、分布式计算和分布式文件系统等。

常用的大数据技术有Hadoop、Spark等。

根据需求和预算,选择合适的技术来构建大数据分析平台。

3.搭建分布式存储系统:分布式存储系统是大数据分析平台的基础,用于存储海量的数据。

常用的分布式存储系统有HDFS、Amazon S3等。

根据选取的大数据技术,搭建相应的分布式存储系统。

4.搭建分布式计算平台:分布式计算平台用于对存储在分布式存储系统中的数据进行计算和分析。

常用的分布式计算平台有MapReduce和Spark。

根据选取的大数据技术,搭建相应的分布式计算平台。

5.建立数据采集系统:数据采集系统用于从各种数据源中获取数据,并存储到分布式存储系统中。

常用的数据采集工具有Flume、Kafka等。

根据需求和数据源类型,选择合适的数据采集工具。

6.构建数据分析模型:根据需求和目标,构建合适的数据分析模型,并使用分布式计算平台进行计算和分析。

常用的数据分析工具有Hive、Pig、R、Python等。

7.可视化和报表展示:将分析结果以可视化和报表的形式展示,便于理解和决策。

常用的可视化工具有Tableau、Power BI等。

二、大数据分析平台的使用教程1.数据采集:首先,通过数据采集系统采集各种数据源中的数据,并存储到分布式存储系统中。

大数据交易平台操作手册

大数据交易平台操作手册V1.0目录第1章平台简介 (4)第2章大数据交易平台操作说明 (4)2.1用户注册 (4)2.1.1个人用户注册 (4)2.1.2企业用户注册 (5)2.2数据资产 (6)2.2.1数据源 (6)2.2.2数据模型 (6)2.2.3可视化引擎工具 (7)2.2.4应用场景 (7)2.2.5采集爬取工具 (8)2.2.6清洗脱敏工具 (8)2.2.7数据分析平台 (9)2.2.8数据开发平台 (9)2.2.9数据管理平台 (10)2.2.10数据安全组件 (10)2.3项目试用 (11)2.4项目结算 (11)2.4.1创客用户支付结算 (11)2.4.2企业用户支付结算 (11)2.5个性定制 (11)2.5.1个性定制 (12)2.5.2我的定制 (12)2.6个人中心 (12)2.6.1用户信息管理 (12)2.6.2我的关注 (12)2.6.3我的项目 (12)第3章数据融合平台简介 (13)3.1平台简介 (13)3.2整体构架 (13)第4章融合平台使用说明 (14)4.1我的账户 (15)4.1.1账户管理 (15)4.1.2我的资产 (15)4.2数据源 (16)4.2.1自有数据源 (17)4.2.2平台数据源 (18)4.3数据模型 (18)4.3.1模型查看 (18)4.3.2模型上传 (18)4.4数据加工 (19)4.4.1项目管理 (20)4.4.2工作流管理 (21)4.4.3流程配置 (21)4.4.4节点参数设置 (22)4.4.5工作流保存 (25)4.4.6运行工作流 (26)4.4.7状态和结果 (26)4.5数据仓库 (26)4.6可视化引擎 (27)4.7大数据应用集成 (28)4.8发布管理 (28)4.9采集爬取工具 (28)4.10清洗脱敏工具 (28)4.11数据分析平台 (29)4.12数据开发平台 (29)4.13数据管理平台 (29)4.14数据安全组件 (29)4.15个人数据银行 (29)4.16控制面板 (29)4.16.1用户管理 (30)4.16.2权限管理 (31)4.16.3管控中心 (32)4.16.4监控中心 (33)第1章平台简介大数据交易平台通过构建公有云平台系统,实现数据源、数据模型、可视化引擎工具、应用场景、采集爬虫工具、清洗脱敏工具、数据分析平台、数据开发平台、数据管理平台、数据安全组件等大数据资产的分类展示、检索和使用。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

lab6:云化ETL系统平台配置

以组为单位,通过阅读数据集成服务系统操作文档,理解ETL概念,了解数据集成服务系统功能及其应用。

ETL:Extraction-Transformation-Loading的缩写,中文名称为数据提取、转换和加载。

ETL 负责将分布的、异构数据源中的数据如关系数据、平面数据文件等抽取到临时中间层后进行清洗、转换、集成,最后加载到数据仓库或数据集市中,成为联机分析处理、数据挖掘的基础。

数据集成服务系统:一个提供企业级数据集成项目所必须的工具与服务的ETL 系统存储库:以元数据形式存储源和目标,存储映射、转换器、任务节点、数据流和工作流等的存储平台;

数据流:实际数据处理的流程,由映射连接物理数据,生成数据流;

映射:数据处理的流程设计;

迁移映射:数据只做迁移的映射

转换:数据流中的一个数据转换器;

工作流:任务执行流程;

组件:一个任务容器,设置后是工作流中的一个任务节点;

任务节点:工作流下的一个任务

并发管理:任务执行并发控制管理

实验简明流程:

1.创建数据流,建立相应映射,建立源数据和目标数据的关联关系

2.创建工作流

3.目标数据入库

实验具体操作步骤:

登陆客户端,选择数据流登陆进入数据流编辑器,用户名:administrator 密码:bonc

点击创建映射,本例共创建两个映射。

编辑映射,根据不同组对映射命名,如第一组命名为:上网数据预处理01。

点击确定创建完成,此时事实表下映射目录下出现创建的映射。

进入创建的映射进行编辑,将“事实表-源-XD_GN”,“事实表-目标-XD_GN_HOST”和“表达式转换”拖入工作区,如图。

“表达式转换”工具位置在工具栏中如图:

右击“表达式转换”进行编辑。

添加三个端口,主要信息见下表:

长度表达式

端

口

A1 50 A1

A20 1000 A20

A36 2000 SUBSTRING(A36,INDEXOF(A36,'/',1,2)+1,INDEXOF(A36,'/',1,3)-(INDEXOF(A36,'/',1,2)+1))

“汇总器“工具位置在工具栏中如图:

端口长度表达式

A1 50 A1

A20 1000 SUM(A20)

A36 2000 A36

如图连线

完成后点击“版本控制-保存”

2 上网数据汇总

源表:XD_GN_HOST , DIM_HOST

目标表:XD_GN_HOST_TOTAL

连接器转换:

端口

端口名称数据类型长度M(是否主表字段)USER_ID 字符串50 是

HOST 字符串4000 是

FLOW 整数22 是

HOST#1 字符串1000 否

HOST_NAME 字符串1000 否

HOST_TYPE 字符串1000 否

条件

主运算符详细信息

HOST = HOST#1

汇总器转换:

端口

端口名称数据类型长度表达式分组

HOST_NAME 字符串1000 HOST_NAME是

HOST_TYPE 字符串1000 HOST_TYPE是

FLOW 整数22 SUM(FLOW) 否

USER_NUMB 整数18 COUNT(HOST_NAME) 否配置完成后,左侧目录下依此出现两个映射。

进入元数据平台进行工作流的操作:

在菜单栏上点击数据集成,单击工作流右键,如图所示点击添加子目录;

如图所示:

其中名称(按照自己的组号)以及顺序自己拟定,是否为叶子节点选择“是”,点击确定;

在新建的子目录下,单击右键选择添加工作流;

名称(按照自己的组号)自己拟定,点击保存;

保存新建的工作流后,出现如下界面:

单击左键将数据流拖拽出来,点击映射,选中自己已经建立好的映射,点击确定,如下图所示:

出现如下图所示界面,点击确定即可;

点击左侧连线,之后将数据流连接起来,点击签入即可;

在保存工作流后,单击已建好的工作流右键出现如下图所示界面:

点击“是”,即可启动工作流;

点击所建立的工作流右侧的运行实例出现如下图所示,其中红色框上表示刷新,可查看最新进程;

点击工作流右侧的历史实例,能够观察到历史运行记录,如下图表示流程运行成功;

工作流执行成功后,整个数据加工过程结束,目标表中已被灌入目标数据,可在BI-MARKET上进行各种形式的分析报表展示。