负载均衡操作步骤

Ros 双ADSL、NTH负载均衡实际操作设置(脚本化操作)

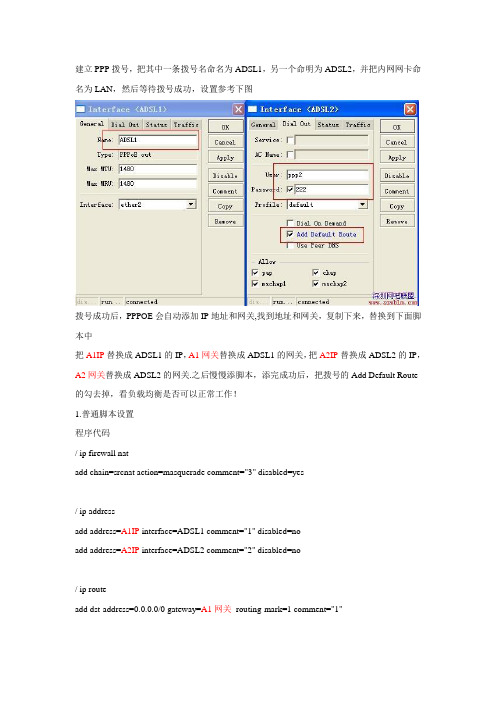

建立PPP拨号,把其中一条拨号名命名为ADSL1,另一个命明为ADSL2,并把内网网卡命名为LAN,然后等待拨号成功,设置参考下图拨号成功后,PPPOE会自动添加IP地址和网关,找到地址和网关,复制下来,替换到下面脚本中把A1IP替换成ADSL1的IP,A1网关替换成ADSL1的网关,把A2IP替换成ADSL2的IP,A2网关替换成ADSL2的网关.之后慢慢添脚本,添完成功后,把拨号的Add Default Route 的勾去掉,看负载均衡是否可以正常工作!1.普通脚本设置程序代码/ ip firewall natadd chain=srcnat action=masquerade comment="3" disabled=yes/ ip addressadd address=A1IP interface=ADSL1 comment="1" disabled=noadd address=A2IP interface=ADSL2 comment="2" disabled=no/ ip routeadd dst-address=0.0.0.0/0 gateway=A1网关routing-mark=1 comment="1"add dst-address=0.0.0.0/0 gateway=A2网关routing-mark=2 comment="2"add dst-address=0.0.0.0/0 gateway=A1网关comment="3"2.添加NAT,NTH脚本程序代码/ ip firewall mangleadd chain=prerouting in-interface=LAN protocol=tcp connection-state=new nth=1,1,0action=mark-connection \new-connection-mark=1 passthrough=yes comment="A1 NTH" disabled=noadd chain=prerouting in-interface=LAN protocol=tcp connection-mark=1 action=mark-routing new-routing-mark=1 \passthrough=no comment="A1 NTH" disabled=noadd chain=prerouting in-interface=LAN protocol=tcp connection-state=new nth=1,1,1action=mark-connection \new-connection-mark=2 passthrough=yes comment="A2 NTH" disabled=noadd chain=prerouting in-interface=LAN protocol=tcp connection-mark=2 action=mark-routing new-routing-mark=2 \passthrough=no comment="A2 NTH" disabled=no/ ip firewall natadd chain=srcnat connection-mark=1 action=src-nat to-addresses=A1IP to-ports=0-65535 comment="1" disabled=noadd chain=srcnat connection-mark=2 action=src-nat to-addresses=A2IP to-ports=0-65535 comment="2" disabled=no3.同步NAT,ADSL动态IP,网关脚本:位置winbox-system-script 点“+ ”号,改name为sync,然后复制下面的脚本到source里程序代码:local assign-address:local new-address:local status:local x:set x 2:for i from=1 to=$x do={:set status [/interface get [/interface find name=("ADSL" . $i)] running]:if ($status=true) do={:set new-address [/ip address get [/ip address find dynamic=yes interface=("ADSL" . $i)] address]:set new-address [:pick $new-address 0 ([:len $new-address] -3)]:set assign-address [/ip address get [/ip address find dynamic=no interface=("ADSL" . $i)] address]:set assign-address [:pick $assign-address 0 ([:len $assign-address] -3)]:set new-gateway [/ip address get [/ip address find dynamic=yes interface=("ADSL" . $i)] network] :set adckip [/tool netwatch get [/tool netwatch find comment=$i] host]:if ($assign-address != $new-address) do={ /ip address set [/ip address find comment=$i] address=$new-address network=$new-address broadcast=$new-address/ip route set [/ip route find comment=$i] gateway=$new-gateway]/ip firewall nat set [/ip firewall nat find comment=$i] to-addresses=$new-address/ip route set [/ip route find comment=$i] gateway=$new-gateway]}:if ($new-gateway != $adckip) do={/tool netwatch set [/tool netwatch find comment=$i]host=$new-gateway]}}}4.添加ADSL1当线脚本A1Down,自动停用NTH负载所需的参数,并将标记3的网关设为ADSL2的网关位置winbox-system-script 点“+ ”号,改name为A1Down,然后复制下面的脚本到source里程序代码:local new-gateway:set new-gateway [/ ip address get [/ip address find dynamic=yes interface=ADSL2] network]/ip route set [/ip route find comment=3] gateway=$new-gateway/ip route enable [/ip route find comment=3]/ip route disabled [/ip route find comment=1]/ip route disabled [/ip route find comment=2]/ip firewall nat enable [/ip firewall nat find comment=3]/ip firewall nat disabled [/ip firewall nat find comment=1]/ip firewall nat disabled [/ip firewall nat find comment=2]5.添加ADSL2当线脚本A2Down,自动停用NTH负载所需的参数,并将标记3的网关设为ADSL1的网关位置winbox-system-script 点“+ ”号,改name为A2Down,然后复制下面的脚本到source里程序代码:local new-gateway:set new-gateway [/ ip address get [/ip address find dynamic=yes interface=ADSL1] network]/ip route set [/ip route find comment=3] gateway=$new-gateway/ip route enable [/ip route find comment=3]/ip route disabled [/ip route find comment=1]/ip route disabled [/ip route find comment=2]/ip firewall nat enable [/ip firewall nat find comment=3]/ip firewall nat disabled [/ip firewall nat find comment=1]/ip firewall nat disabled[/ip firewall nat find comment=2]6.添加ADSL掉线判断NETWATCH程序代码/ tool netwatchadd host=A1网关timeout=1s interval=1m up-script="" down-script="A1Down"comment="1" add host=A2网关timeout=1s interval=1m up-script="" down-script="A2Down" comment="2"7.添加双线判断正常脚本allup。

启明星辰应用交付系统(负载均衡)ADC灌装版本操作手册

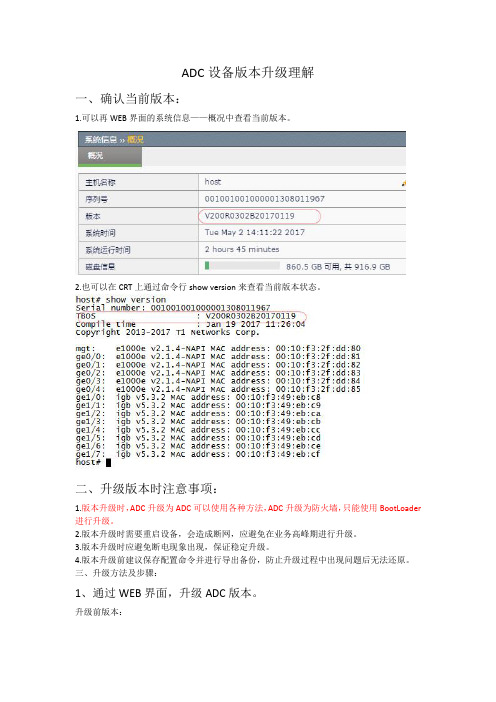

ADC设备版本升级理解一、确认当前版本:1.可以再WEB界面的系统信息——概况中查看当前版本。

2.也可以在CRT上通过命令行show version来查看当前版本状态。

二、升级版本时注意事项:1.版本升级时,ADC升级为ADC可以使用各种方法,ADC升级为防火墙,只能使用BootLoader 进行升级。

2.版本升级时需要重启设备,会造成断网,应避免在业务高峰期进行升级。

3.版本升级时应避免断电现象出现,保证稳定升级。

4.版本升级前建议保存配置命令并进行导出备份,防止升级过程中出现问题后无法还原。

三、升级方法及步骤:1、通过WEB界面,升级ADC版本。

升级前版本:(1)、首先在系统管理中选择版本管理,固件版本选项。

(2)、在固态版本中点击选择文件按钮,并选中升级后的版本文件,点击升级。

升级过程如下所示,可能需要等待几分钟。

(3)、升级完成后提示重启(4)、进入系统管理——配置——设备重启,重启设备如下。

在重启选项中选择重启系统,点击确定。

此时提醒重启系统,保存配置,点击确定即可。

需要等待几分钟升级后版本号如下。

2.使用BootLoader中的USB灌装进行ADC版本升级。

升级前版本如下:(1)、使用console线(9600)连接到ADC设备上。

(2)、长按电源键重启设备(3)、快速按Ctrl+C(一直按),进入BootLoader页面。

出现乱码后重新打开即可,如下。

选择1(configure network parameters),提示是否确认更改,选择y,此时只需要修改Startup image选项为升级后的版本名称即可。

例如bos.bin。

其他选项直接回车即可,最后保存。

(4)、将升级后的系统拷如U盘中,将U盘插入设备的USB接口,在BootLoader的菜单中选择4,然后回车即可。

(5)、更新完成后,选择6,重启设备。

几分钟过后,版本更新完成。

跟新后的版本如下;3.使用命令行进行版本升级。

NetMizer负载均衡操作

如用户内网地址段与NetMizer设备不是直连网段,则需要配置回程 路由。“目标网段”填写私网地址段,“网关地址”填写与 Netmzier设备内网口互联设备的接口地址。 注意:回程路由只需在 “负载均衡”-“路由策略”中添加,不必在 “网络管理”-“路由参数设置”中再添加。

动态转换策略:一对多的地址转换。

来源接口-选择内网口 均衡算法:此处的均衡算法只针对均衡方 式中的“流量”、“会话”和“主机”。 在均衡方式中选择最优路径后,均衡算法 将不会起任何作用。 均衡方式:为了用户上网体验达到最优, 一般使用“最优路径”。 访问速度:使用默认选项即可 线路绑定:不选择 线路监控:根据流量监控 路由属性:不选择 流量均衡:一般都是“基于流入方向流量 均衡网关带宽”。带宽利用率填写40%60%之间的数值,最小延时填写10ms20ms,最大延时填写30ms-60ms。 注意:带宽利用率和延时填写不宜过大也 不易过小,否则会影响用户上网体验。一 般按照如图配置即可,如链路质量差别较 大,质量差的链路带宽空闲多,可适当将 带宽利用率调低,或将最大延时调高。

Hale Waihona Puke 注意:NetMizer对来源地址的路由是通过负载均衡策略实现的, 只需在均衡策略中选择需要路由的来源地址及某条链路即可。 下图为地址组“1”的内网用户使用HTTP协议时只能使用“CNC” 链路的实例。

1,负载均衡策略是从上到下依次查找的,如发现匹配的策略会立刻执行并且不 会再向下查找,所以应把服务、来源地址或目的地址颗粒度较小的策略放在上 边。 2,所有选项卡中的可勾选对象,如果不做勾选,系统将默认选择全部。 3,地址和地址组,可以在“对象管理”中的“地址对象管理”及“地址组管理” 中添加。 4,可在“对象管理”中的“服务对象管理”中添加新的服务。

F5负载均衡器POOL配置

4.配置负载均衡Pool•负载均衡Pool简介•创建和修改负载均衡Pool•配置pool设置•配置Pool成员设置•管理pool和Pool成员负载均衡Pool简介在典型的客户端-服务器情形下,客户请求到达在请求标头中指定的目的地IP地址。

对于输入流量很大的站点来说,由于目的地服务器要处理大量请求,因而很快就会出现过载现象。

为解决这一难题,BIG-IP® 本地流量管理(LTM)系统将客户机请求分配到多个服务器上,而并非只是指定的目的地IP地址。

当创建负载均衡Pool时,您可以对LTM系统进行配置来解决此类问题。

什么是负载均衡Pool?负载均衡Pool是您组合起来接收和处理流量的一组设备,如Web服务器。

LTM系统将客户机流量请求发送到Pool成员中的任一服务器上,而不是发送到客户机请求指定的目的地IP地址。

当创建负载均衡Pool时,将服务器(称作Pool成员)分配到pool中,然后将pool与LTM系统中的Virtual Server相关联。

然后,LTM系统将进入Virtual Server中的流量传输到Pool成员。

单个服务器可隶属于一个或多个pool,这取决于您希望如何管理您的网络流量。

LTM系统选择将请求发送给哪个Pool成员由您指定给该pool的负载均衡法决定。

负载均衡法是一种算法,LTM系统利用它来选择处理请求的Pool成员。

例如,缺省负载均衡法是轮循,采用这种方法,LTM系统将每个输入请求发送到下一个可用的Pool成员,从而将请求平均分配到pool中的所有服务器上。

有关负载均衡法的完整列表,请参阅第4-9页上的“指定负载均衡法”。

负载均衡Pool的特性您可以配置LTM系统,以便对pool执行多种不同的操作。

您可以:•将状态Monitor和pool及Pool成员相关联;•激活或禁用SNAT连接;•若原定目标Pool成员不可用,重新连接到其它Pool成员;•在数据包内设置“服务质量”或“服务类型”级别;•指定pool的负载均衡运算法;•将Pool成员分配到pool内的优先组别。

A10负载均衡设备操作手册

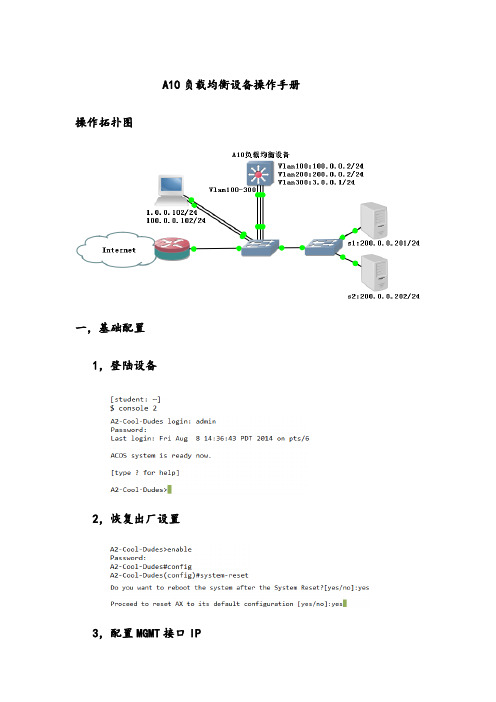

A10负载均衡设备操作手册操作拓扑图一,基础配置1,登陆设备2,恢复出厂设置3,配置MGMT接口IP4,使用SSH连接设备MGMT接口5,修改主机名为“A2”6,修改时区7,配置各Vlan及其IP查看接口网络参数:查看现有配置文件:查看所有配置文件:8,配置超时时间为60分钟9,保存配置文件为“A2Class”10,将配置保存至配置文件“Profile2”11,复制配置文件“A2Class”另存为“Profile3”12,将配置文件“A2Class”备份至FTP服务器,备份名称”或:13,将现在运行的配置备份至FTP服务器,名称为”“14,还原设备配置15,不同配置文件的不同处对比新建配置文件名为”NewProfile“从配置文件“A2Class”复制配置到”NewProfile“,加插命令:对比2个文件的差异:16,删除配置文件二,设置并开启负载均衡群集1,定义群集成员s1与s2:查看配置:2,将群集成员服务器的80端口加入群集组查看配置:3,配置SNAT“nat1”,地址为/24查看配置:4,应用源IP会话保持模板,将会话保持配置取名为“persist1”查看配置:5,定义对外虚拟IP,应用SNAT与源IP会话保持配置,开启群集查看配置:6,访问测试清除会话配置:三,开启健康检查四,更改HTTP头修改HTTP头,使抓包返回服务器平台信息为“nginx”:引用修改后的HTTP头,重新定义群集属性如下:测试:打开浏览器,按组合件Ctrl+Shift+I清理缓存,按下F12抓包,访问站点:下图中服务器已经变更为“nginx”:五,错误页面重定向如果所有群及成员均已故障无法提供服务,错误页面重定向可以将原站点的页面重定向至其他服务器提供的页面定义错误页面重定向URL为"":引用错误页面重定向URL,重新定义群集属性如下:模拟服务器全挂:测试:访问站点自动跳转至URL:“六、SSL卸载,服务组中使用80端口提供服务,由负载均衡设备将http协议转为https协议并对外服务,使客户端访问服务的443端口1,建立SSL服务器证书:2,创建客户端证书:点击“Save”后点击“OK”3,应用Cookie模板进行会话保持:查看配置:4,修改群集属性如下:删除80端口配置:增加443端口配置:查看配置:5,测试:客户端访问http服务的443端口,由A10负载均衡设备将https协议转为http协议,再递交至服务器处理;服务器提供http服务,由A10负载均衡设备将http协议转为https协议,再递交至客户端查看证书:七,A10负载均衡设备对服务器的优化设置1,应用模板,限制最大连接数查看配置:2,应用模板,启用HTTP页面压缩,令页面加载速度提高查看配置:3,应用模板,启用内存缓存查看配置:4,应用至群集设置八,双机HA主备模式1,2台设备恢复出厂设置2,配置主机名,时区,接口、Vlan地址主要设备:备用设备:3,双机HA主要设备:备用设备:4,在主要设备上配置负载均衡群集5,在备用设备上测试:主设备A1重启,A2切换成主设备,切换成功:主设备A1重启完成后,主设备切换回A1:。

负载均衡:静态负载均衡算法与动态负载均衡算法实例

负载均衡:静态负载均衡算法与动态负载均衡算法实例⼀、普通轮询算法这是Nginx 默认的轮询算法。

例⼦:两台相同的Tomcat服务器,通过 localhost:8080 访问Tomcat1,通过 localhost:8081访问Tomcat2,现在我们要输⼊ localhost 这个地址,可以在这两个Tomcat服务器之间进⾏交替访问。

1、分别修改两个Tomcat服务器的端⼝为8080和8081。

然后再修改Tomcat的⾸页,使得访问这两个页⾯时能够区分。

如下:修改端⼝号⽂件为 server.xml :修改⾸页的路径为:webapps/ROOT/index.jsp修改完成之后,分别启动这两个Tomcat服务器,然后分别输⼊相应的地址端⼝号:输⼊地址:localhost:8081输⼊地址:localhost:80802、修改 nginx 的配置⽂件 nginx.confupstream OrdinaryPolling {server 127.0.0.1:8080;server 127.0.0.1:8081;}server {listen 80;server_name localhost;location / {proxy_pass http://OrdinaryPolling;index index.html index.htm index.jsp;}}3、启动 nginx。

然后在浏览器输⼊localhost 地址,观看页⾯变化:⼆、基于⽐例加权轮询上述两台Tomcat服务器基本上是交替进⾏访问的。

但是这⾥我们有个需求:由于Tomcat1服务器的配置更⾼点,我们希望该服务器接受更多的请求,⽽ Tomcat2 服务器配置低,希望其处理相对较少的请求。

那么这时候就⽤到了加权轮询机制了。

nginx.conf 配置⽂件如下:upstream OrdinaryPolling {server 127.0.0.1:8080 weight=5;server 127.0.0.1:8081 weight=2;}server {listen 80;server_name localhost;location / {proxy_pass http://OrdinaryPolling;index index.html index.htm index.jsp;}}其实对⽐上⾯不加权的轮询⽅式,这⾥在 upstream 指令中多了⼀个 weight 指令。

A10负载均衡设备操作手册电子教案

A10负载均衡设备操作手册A10负载均衡设备操作手册操作拓扑图一,基础配置1,登陆设备2,恢复出厂设置3,配置MGMT接口IP4,使用SSH连接设备MGMT接口5,修改主机名为“A2”6,修改时区7,配置各Vlan及其IP查看接口网络参数:查看现有配置文件:查看所有配置文件:8,配置超时时间为60分钟9,保存配置文件为“A2Class”10,将配置保存至配置文件“Profile2”11,复制配置文件“A2Class”另存为“Profile3”12,将配置文件“A2Class”备份至FTP服务器,备份名称”A2.tar.gz“或:13,将现在运行的配置备份至FTP服务器,名称为”A2running.txt“14,还原设备配置15,不同配置文件的不同处对比新建配置文件名为”NewProfile“从配置文件“A2Class”复制配置到”NewProfile“,加插命令:对比2个文件的差异:16,删除配置文件二,设置并开启负载均衡群集1,定义群集成员s1与s2:查看配置:2,将群集成员服务器的80端口加入群集组查看配置:3,配置SNAT“nat1”,地址为200.0.0.22/24查看配置:4,应用源IP会话保持模板,将会话保持配置取名为“persist1”查看配置:5,定义对外虚拟IP,应用SNAT与源IP会话保持配置,开启群集查看配置:6,访问测试清除会话配置:三,开启健康检查四,更改HTTP头修改HTTP头,使抓包返回服务器平台信息为“nginx”:引用修改后的HTTP头,重新定义群集属性如下:测试:打开浏览器,按组合件Ctrl+Shift+I清理缓存,按下F12抓包,访问站点:下图中服务器已经变更为“nginx”:五,错误页面重定向如果所有群及成员均已故障无法提供服务,错误页面重定向可以将原站点的页面重定向至其他服务器提供的页面定义错误页面重定向URL为"http://1.0.0.201/failover":引用错误页面重定向URL,重新定义群集属性如下:模拟服务器全挂:测试:访问站点自动跳转至URL:“http://1.0.0.201/failover”六、SSL卸载,服务组中使用80端口提供服务,由负载均衡设备将http协议转为https协议并对外服务,使客户端访问服务的443端口1,建立SSL服务器证书:2,创建客户端证书:点击“Save”后点击“OK”3,应用Cookie模板进行会话保持:查看配置:4,修改群集属性如下:删除80端口配置:增加443端口配置:查看配置:5,测试:客户端访问http服务的443端口,由A10负载均衡设备将https协议转为http协议,再递交至服务器处理;服务器提供http服务,由A10负载均衡设备将http协议转为https协议,再递交至客户端查看证书:七,A10负载均衡设备对服务器的优化设置1,应用模板,限制最大连接数查看配置:2,应用模板,启用HTTP页面压缩,令页面加载速度提高查看配置:3,应用模板,启用内存缓存查看配置:4,应用至群集设置八,双机HA主备模式1,2台设备恢复出厂设置2,配置主机名,时区,接口、Vlan地址主要设备:备用设备:3,双机HA主要设备:备用设备:4,在主要设备上配置负载均衡群集5,在备用设备上测试:主设备A1重启,A2切换成主设备,切换成功:主设备A1重启完成后,主设备切换回A1:。

F5负载均衡-配置指导手册(含IPv6)

F5负载均衡-配置指导⼿册(含IPv6)F5负载均衡-配置⼿册设备概况图形化界⾯通过⽹络形式访问F5任⼀接⼝地址,打开浏览器输⼊https://⽹络接⼝地址;或pc机直连F5的MGMT带外管理⼝,打开浏览器,输⼊(MGMT地址在设备液晶⾯板查看)将进⼊F5的图形管理界⾯。

该界⾯适合进⾏设备的基础以及⾼级调试,是管理员常⽤的管理界⾯。

默认⽤户名/密码:admin/admin命令⾏界⾯通过console线直连F5的console⼝,或通过securecrt等⼯具以SSH2的形式访问F5任⼀接⼝地址,将进⼊命令⾏模式。

该界⾯适合进⾏底层操作系统的调试以及排错。

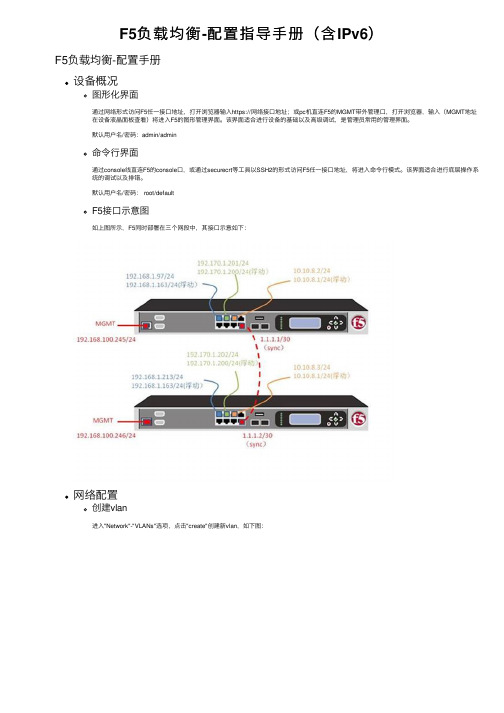

默认⽤户名/密码: root/defaultF5接⼝⽰意图如上图所⽰,F5同时部署在三个⽹段中,其接⼝⽰意如下:⽹络配置创建vlan进⼊"Network"-"VLANs"选项,点击"create"创建新vlan,如下图:名称处填写该vlan名称,如vlan_170。

再将相应的接⼝划⼊该vlan中,如1.3⼝。

如该vlan需要同交换⽹络中的vlan tag对应,则在tag处填写id,并将接⼝划⼊tagged栏,否则⼀律划⼊untagged。

点击"Finish"完成。

创建self ip进⼊"Network"-"self ips"进⾏F5设备的地址配置,点击"create"新建地址,如下图:填写相应地址和掩码,如192.170.1.202,掩码:255.255.255.0,在vlan处下拉选择之前创建好的vlan_170,将该地址与vlan_170绑定,即ip地址与接⼝做成了对应关系。

在双机部署下,浮动地址的创建需要点击Floating IP的勾,并选择unit ID 为1或2(主备区分),点击"Finish"完成创建。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

室分E1-E2同覆盖负载均衡

当本小区PRB利用率大于70%,相邻小区PRB利用率小区65%,且当前小区用户大于2时触发负载均衡切换

PRB利用率门限为版本默认,网管上没有修改页面,只能使用DV表进行修改,不建议修改该参数。

为了测试需要,可以修改PBR(单用户保障速率)来减低负载均衡的难度(触发条件)

1打开负荷均衡

采用“算法打开,采用盲切换方式”。

修改路径“无线业务配置”->“负荷管理”->”负荷均衡开关“->”算法打开,采用盲切换方式”

2修改PBR

把下行优先级比特速率设置为“4096”,设置路径:QOS配置->QOS和PBR映射->优先级比特速率

备注:如果确定移动放号的QCI策略,可以修改相应的“优先级比特速率”,如果上行负载均衡有需求,可以修改上行的PBR优先级速率

3修改邻区关系

把同覆盖的两个小区的“服务小区与E-UTRAN系统内邻区”(注意双向都要配置)关系修改为“同覆盖”,参数路径:邻接关系配置->E-UTRAN邻接关系->服务小区与E-UTRAN 系统内邻区;负荷均衡开关配置为“是”,参数路径:邻接关系配置->E-UTRAN邻接关系->负荷均衡开关

4修改小区个体偏移

把同覆盖的两个小区的“小区个体偏移”修改为“-10”(注意双向都要配置),配置路径:邻接关系配置->E-UTRAN邻接关系->小区个体偏移

备注:修改小区个体偏移是为了防止同覆盖的两个小区乒乓切换

系统内F-D基于测量的负荷均衡

本小区PRB利用率大于70%,邻区PRB利用率小区65%,本小区RSRP低于A2门限,邻小区RSRP高于A4门限,且本小区用户数大于1时触发负荷均衡

PRB利用率门限为版本默认,网管上没有修改页面,只能使用DV表进行修改,不建议修改该参数。

如果测试需要,可以通过修改PBR来减低负载均衡的难度

(触发条件)

外场负荷均衡的站点都是基于覆盖的事件测量配置,打开异频/异系统驻留负荷均衡算法开关。

在E-UTRAN邻接关系中配置X2口切换、服务小区与邻区关系为相邻

配置A2事件,实验室为了便于触发异频测量启动,门限值配置较高为-75dBm

配置基于负荷均衡的测试事件A4门限为-90dBm,A4门限为绝对门限,为了便于触发切换,门限可以适当配置低一点。