信息论基础答案2

信息论基础各章参考答案

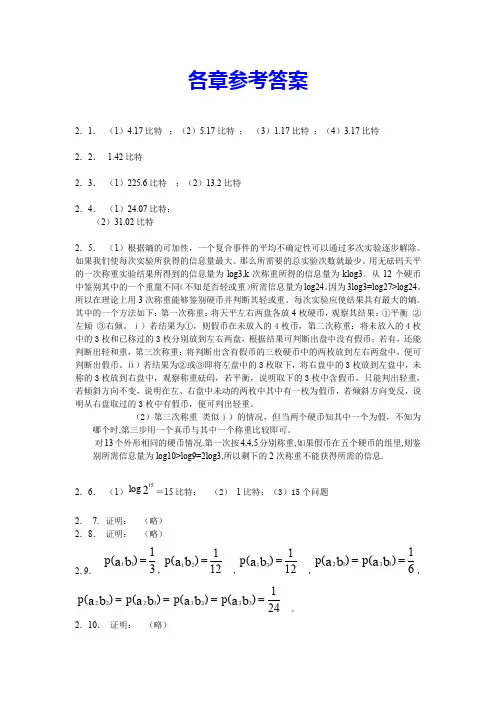

各章参考答案2.1. (1)4.17比特 ;(2)5.17比特 ; (3)1.17比特 ;(4)3.17比特2.2. 1.42比特2.3. (1)225.6比特 ;(2)13.2比特2.4. (1)24.07比特; (2)31.02比特2.5. (1)根据熵的可加性,一个复合事件的平均不确定性可以通过多次实验逐步解除。

如果我们使每次实验所获得的信息量最大。

那么所需要的总实验次数就最少。

用无砝码天平的一次称重实验结果所得到的信息量为log3,k 次称重所得的信息量为klog3。

从12个硬币中鉴别其中的一个重量不同(不知是否轻或重)所需信息量为log24。

因为3log3=log27>log24。

所以在理论上用3次称重能够鉴别硬币并判断其轻或重。

每次实验应使结果具有最大的熵。

其中的一个方法如下:第一次称重:将天平左右两盘各放4枚硬币,观察其结果:①平衡 ②左倾 ③右倾。

ⅰ)若结果为①,则假币在未放入的4枚币,第二次称重:将未放入的4枚中的3枚和已称过的3枚分别放到左右两盘,根据结果可判断出盘中没有假币;若有,还能判断出轻和重,第三次称重:将判断出含有假币的三枚硬币中的两枚放到左右两盘中,便可判断出假币。

ⅱ)若结果为②或③即将左盘中的3枚取下,将右盘中的3枚放到左盘中,未称的3枚放到右盘中,观察称重砝码,若平衡,说明取下的3枚中含假币,只能判出轻重,若倾斜方向不变,说明在左、右盘中未动的两枚中其中有一枚为假币,若倾斜方向变反,说明从右盘取过的3枚中有假币,便可判出轻重。

(2)第三次称重 类似ⅰ)的情况,但当两个硬币知其中一个为假,不知为哪个时,第三步用一个真币与其中一个称重比较即可。

对13个外形相同的硬币情况.第一次按4,4,5分别称重,如果假币在五个硬币的组里,则鉴别所需信息量为log10>log9=2log3,所以剩下的2次称重不能获得所需的信息.2.6. (1)215log =15比特; (2) 1比特;(3)15个问题2. 7. 证明: (略) 2.8. 证明: (略)2.9.31)(11=b a p ,121)(21=b a p ,121)(31=b a p ,61)()(1312==b a b a p p ,241)()()()(33233222====b a b a b a b a p p p p。

信息论编码与基础课后题(第二章)

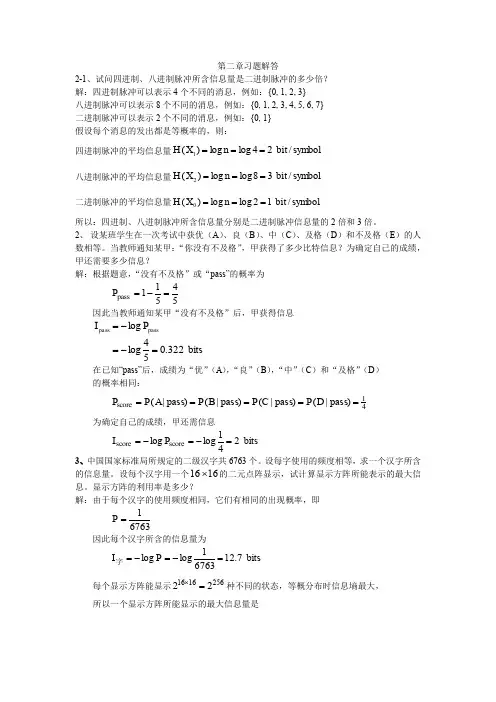

第二章习题解答2-1、试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍? 解:四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3}八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则:四进制脉冲的平均信息量symbol bit n X H / 24log log )(1=== 八进制脉冲的平均信息量symbol bit n X H / 38log log )(2=== 二进制脉冲的平均信息量symbol bit n X H / 12log log )(0===所以:四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。

2、 设某班学生在一次考试中获优(A )、良(B )、中(C )、及格(D )和不及格(E )的人数相等。

当教师通知某甲:“你没有不及格”,甲获得了多少比特信息?为确定自己的成绩,甲还需要多少信息? 解:根据题意,“没有不及格”或“pass”的概率为54511pass =-=P 因此当教师通知某甲“没有不及格”后,甲获得信息在已知“pass”后,成绩为“优”(A ),“良”(B ),“中”(C )和“及格”(D ) 的概率相同:41score )pass |()pass |()pass |()pass |(=====D P C P B P A P P 为确定自己的成绩,甲还需信息bits 241loglog score score =-=-=P I 3、中国国家标准局所规定的二级汉字共6763个。

设每字使用的频度相等,求一个汉字所含的信息量。

设每个汉字用一个1616⨯的二元点阵显示,试计算显示方阵所能表示的最大信息。

显示方阵的利用率是多少?解:由于每个汉字的使用频度相同,它们有相同的出现概率,即67631=P 因此每个汉字所含的信息量为bits 7.1267631loglog =-=-=P I 字每个显示方阵能显示256161622=⨯种不同的状态,等概分布时信息墒最大,所以一个显示方阵所能显示的最大信息量是bits322.054log log passpass =-=-=P Ibits 25621loglog =-=-=P I 阵显示方阵的利用率或显示效率为0497.02567.12===阵字I I η 4、两个信源1S 和2S 均有两种输出:1 ,0=X 和1 ,0=Y ,概率分别为2/110==X X P P ,4/10=Y P ,4/31=Y P 。

第一章 第二章课后作业答案

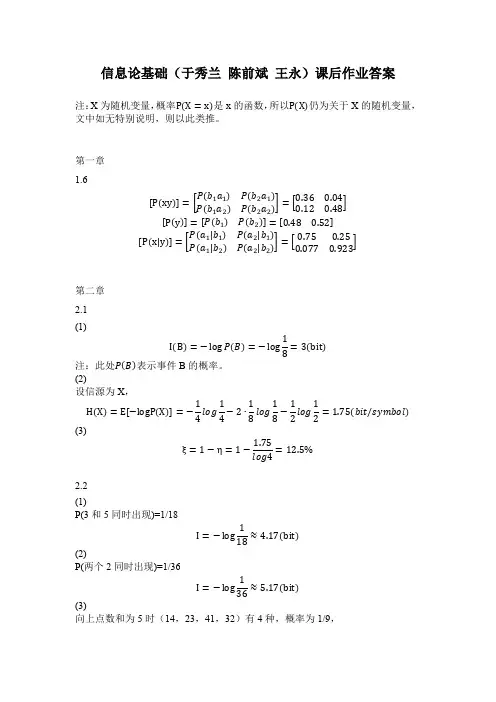

信息论基础(于秀兰 陈前斌 王永)课后作业答案注:X 为随机变量,概率P(X =x)是x 的函数,所以P(X)仍为关于X 的随机变量,文中如无特别说明,则以此类推。

第一章1.6[P (xy )]=[P(b 1a 1)P(b 2a 1)P(b 1a 2)P(b 2a 2)]=[0.360.040.120.48] [P (y )]=[P(b 1)P(b 2)]=[0.480.52] [P (x|y )]=[P(a 1|b 1)P(a 2|b 1)P(a 1|b 2)P(a 2|b 2)]=[0.750.250.0770.923]第二章2.1(1)I (B )=−log P (B )=−log 18=3(bit) 注:此处P (B )表示事件B 的概率。

(2)设信源为X ,H (X )=E [−logP (X )]=−14log 14−2∙18log 18−12log 12=1.75(bit/symbol) (3)ξ=1−η=1−1.75log4=12.5%2.2(1)P(3和5同时出现)=1/18I =−log118≈4.17(bit) (2)P(两个2同时出现)=1/36I =−log 136≈5.17(bit) (3)向上点数和为5时(14,23,41,32)有4种,概率为1/9,I =−log 19≈3.17(bit) (4)(5)P(两个点数至少有一个1)=1−5∙5=11 I =−log 1136≈1.71(bit) (6)相同点数有6种,概率分别为1/36;不同点数出现有15种,概率分别为1/18;H =6∙136∙log36+15∙118∙log18≈4.34(bit/symbol)2.9(1)H (X,Y )=E [−logP (X,Y )]=−∑∑P(x i ,y j )logP(x i ,y j )3j=13i=1≈2.3(bit/sequence)(2)H (Y )=E [−logP (Y )]≈1.59(bit/symbol)(3)H (X |Y )=H (X,Y )−H (Y )=0.71(bit/symbol)2.12(1)H (X )=E [−logP (X )]=−2log 2−1log 1≈0.92(bit/symbol) Y 的分布律为:1/2,1/3,1/6;H (Y )=E [−logP (Y )]≈1.46(bit/symbol)(2)H (Y |a 1)=E [−logP (Y|X )|X =a 1]=−∑P (b i |a 1)logP (b i |a 1)i=−34log 34−14log 14≈0.81(bit/symbol) H (Y |a 2)=E [−logP (Y|X )|X =a 2]=−∑P (b i |a 2)logP (b i |a 2)i=−12log 12−12log 12=1(bit/symbol) (3)H (Y |X )=∑P (a i )H (Y |a i )i =23∙0.81+13∙1≈0.87(bit/symbol)2.13(1)H (X )=H (0.3,0.7)≈0.88(bit/symbol)二次扩展信源的数学模型为随机矢量X 2=(X 1X 2),其中X 1、X 2和X 同分布,且相互独立,则H (X 2)=2H (X )=1.76(bit/sequence)平均符号熵H 2(X 2)=H (X )≈0.88(bit/symbol)(2)二次扩展信源的数学模型为随机矢量X 2=(X 1X 2),其中X 1、X 2和X 同分布,且X 1、X 2相关,H (X 2|X 1)=E [−logP (X 2|X 1)]=−∑∑P (x 1,x 2)logP (x 2|x 1)x 2x 1=−110log 13−210log 23−2140log 34−740log 14≈0.84(bit/symbol) H (X 2)= H (X 1,X 2)=H (X 2|X 1)+H (X 1)=0.84+0.88=1.72(bit/sequence)H 2(X 2)=H (X 2)/2=0.86(bit/symbol)2.14(1)令无记忆信源为X ,H (X )=H (14,34)=14×2+34×0.415≈0.81(bit/symbol ) (2)I (X 100)=−logP (X 100=x 1x 2…x 100)=−log [(14)m (34)100−m]=2m +(2−log3)(100−m )=200−(100−m )log3 (bit)(3)H (X 100)=100H (X )=81(bit/sequence)2.15(1)因为信源序列符号间相互独立,且同分布,所以信源为一维离散平稳信源。

《信息论基础》试卷(期末)(B2卷)

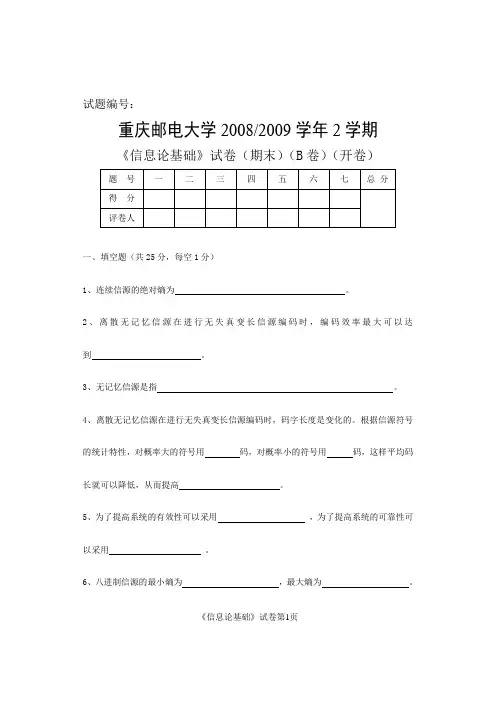

试题编号:重庆邮电大学2008/2009学年2学期《信息论基础》试卷(期末)(B卷)(开卷)一、填空题(共25分,每空1分)1、连续信源的绝对熵为。

2、离散无记忆信源在进行无失真变长信源编码时,编码效率最大可以达到。

3、无记忆信源是指。

4、离散无记忆信源在进行无失真变长信源编码时,码字长度是变化的。

根据信源符号的统计特性,对概率大的符号用码,对概率小的符号用码,这样平均码长就可以降低,从而提高。

5、为了提高系统的有效性可以采用,为了提高系统的可靠性可以采用。

6、八进制信源的最小熵为,最大熵为。

《信息论基础》试卷第1页7、若连续信源输出信号的平均功率为1瓦特,则输出信号幅度的概率密度函数为时,信源具有最大熵,其值为。

8、即时码是指。

9、无失真信源编码定理指出平均码长的理论极限值为,此时编码效率为,编码后的信息传输率为。

10、一个事件发生概率为0.125,则自信息量为。

11、信源的剩余度主要来自两个方面,一是,二是。

12、m阶马尔可夫信源的记忆长度为,信源可以有个不同的状态。

13、同时扔一对均匀的骰子,当得知“两骰子面朝上点数之和为2”所获得的信息量为比特,当得知“面朝上点数之和为8”所获得的信息量为比特。

14、在下面空格中选择填入数学符号“=,≥,≤,>”或“<”()+()()XHYH+。

H|YXYHH()()YX《信息论基础》试卷第2页二、(5分)已知信源的概率密度函数为1()a xb p x b a⎧≤≤⎪=-⎨⎪⎩其他,计算信源的相对熵。

三、(10分)一个平均功率受限的连续信道,信道带宽为1MHz,信道噪声为高斯白噪声。

(1)已知信道上的信号与噪声的平均功率比值为20,计算该信道的信道容量。

(2)如果信道上的信号与噪声的平均功率比值降为10,要达到相同的信道容量,信道带宽应为多少?(3)如果信道带宽降为0.5MHz,要达到相同的信道容量,信道上的信号与噪声的平均功率比值应为多少?《信息论基础》试卷第3页《信息论基础》试卷第4页四、(16分)一个离散无记忆信源123456()1/81/81/81/81/41/4X x x x x x x P x ⎡⎤⎡⎤=⎢⎥⎢⎥⎣⎦⎣⎦1) 求()H X 和冗余度;2) 编成Fano 码,计算编码效率; 3) 编成Huffman 码,计算编码效率《信息论基础》试卷第5页五、(16分)设一个离散无记忆信源的概率空间为它们通过干扰信道,信道输出端的接收符号集为[]21,b b Y =,已知信道传输概率如下图所示。

信息论基础智慧树知到课后章节答案2023年下潍坊学院

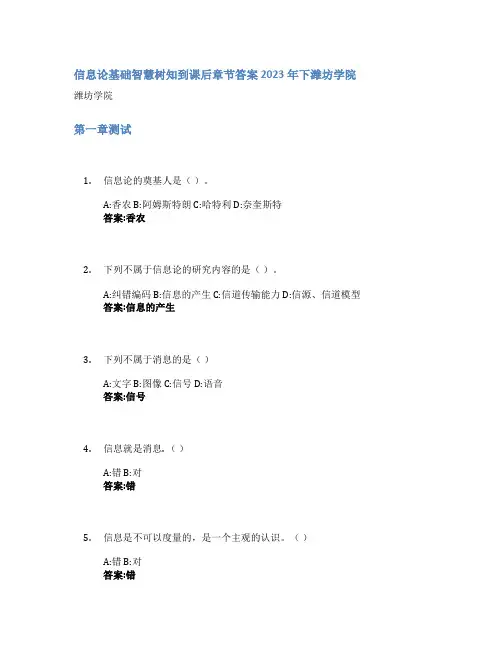

信息论基础智慧树知到课后章节答案2023年下潍坊学院潍坊学院第一章测试1.信息论的奠基人是()。

A:香农 B:阿姆斯特朗 C:哈特利 D:奈奎斯特答案:香农2.下列不属于信息论的研究内容的是()。

A:纠错编码 B:信息的产生 C:信道传输能力 D:信源、信道模型答案:信息的产生3.下列不属于消息的是()A:文字 B:图像 C:信号 D:语音答案:信号4.信息就是消息. ()A:错 B:对答案:错5.信息是不可以度量的,是一个主观的认识。

()A:错 B:对答案:错6.任何已经确定的事物都不含有信息。

()A:对 B:错答案:对7.1948年香农的文章《通信的数学理论》奠定了香农信息理论的基础。

()A:错 B:对答案:对8.信息论研究的目的就是要找到信息传输过程的共同规律,以提高信息传输的(),使信息传输系统达到最优化。

A:有效性 B:认证性 C:可靠性 D:保密性答案:有效性;认证性;可靠性;保密性9.下列属于香农信息论的主要研究理论的是()。

A:压缩理论 B:调制理论 C:保密理论 D:传输理论答案:压缩理论;保密理论;传输理论10.信源编码的作用包含()。

A:检错纠错 B:对信源的输出进行符号变换 C:数据压缩 D:提升信息传输的安全性答案:对信源的输出进行符号变换;数据压缩第二章测试1.信息传输系统模型中,用来提升信息传输的有效性的部分为()A:信源 B:信道编码器、信道译码器 C:信道 D:信源编码器、信源译码器答案:信源编码器、信源译码器2.对于自信息,以下描述正确的是()A:以2为底时,单位是奈特。

B:以2为底时,单位是比特。

C:以10为底时,单位是奈特。

D:以e为底时,单位是比特答案:以2为底时,单位是比特。

3.信息熵的单位是()A:比特 B:比特每符号 C:无法确定答案:比特每符号4.必然事件和不可能事件的自信息量都是0 。

()A:错 B:对答案:错5.概率大的事件自信息量大。

信息论编码与基础课后题(第二章)

第二章习题解答2-1、试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍? 解:四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则:四进制脉冲的平均信息量symbol bit n X H / 24log log )(1=== 八进制脉冲的平均信息量symbol bit n X H / 38log log )(2=== 二进制脉冲的平均信息量symbol bit n X H / 12log log )(0===所以:四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。

2、 设某班学生在一次考试中获优(A )、良(B )、中(C )、及格(D )和不及格(E )的人数相等。

当教师通知某甲:“你没有不及格”,甲获得了多少比特信息?为确定自己的成绩,甲还需要多少信息? 解:根据题意,“没有不及格”或“pass”的概率为54511pass =-=P 因此当教师通知某甲“没有不及格”后,甲获得信息在已知“pass”后,成绩为“优”(A ),“良”(B ),“中”(C )和“及格”(D ) 的概率相同:41score )pass |()pass |()pass |()pass |(=====D P C P B P A P P 为确定自己的成绩,甲还需信息bits 241loglog score score =-=-=P I 3、中国国家标准局所规定的二级汉字共6763个。

设每字使用的频度相等,求一个汉字所含的信息量。

设每个汉字用一个1616⨯的二元点阵显示,试计算显示方阵所能表示的最大信息。

显示方阵的利用率是多少?解:由于每个汉字的使用频度相同,它们有相同的出现概率,即67631=P 因此每个汉字所含的信息量为bits 7.1267631loglog =-=-=P I 字每个显示方阵能显示256161622=⨯种不同的状态,等概分布时信息墒最大,所以一个显示方阵所能显示的最大信息量是bits 322.054loglog passpass =-=-=P Ibits 25621loglog 256=-=-=P I 阵显示方阵的利用率或显示效率为0497.02567.12===阵字I I η 4、两个信源1S 和2S 均有两种输出:1 ,0=X 和1 ,0=Y ,概率分别为2/110==X X P P ,4/10=Y P ,4/31=Y P 。

信息理论基础智慧树知到课后章节答案2023年下浙江大学

信息理论基础智慧树知到课后章节答案2023年下浙江大学浙江大学第一章测试1.随机事件的互信息可小于0,随机变量的互信息也可小于0。

()答案:错2.对于连续随机变量,其微分熵越大,说明不确定性越大。

()答案:错3.必然事件和不可能事件的自信息量都是0。

()答案:错4.自信息量是P(xi)的单调递减函数。

()答案:对5.若离散变量X是离散变量Y的函数,则条件熵H(X|Y)恒为0。

()答案:对第二章测试1. A 村有一半人说真话,3/10人总说假话,2/10人拒绝回答;B村有3/10人诚实,一半人说谎,2/10人拒绝回答。

现随机地从A村和B村抽取人,p为抽到A村人的概率,1–p为抽到B村人的概率,问通过测试某人说话的状态平均能获得多少关于该人属于哪个村的信息?通过改变p,求出该信息的最大值。

答案:null2.一个无偏骰子,抛掷一次,如果出现1,2,3,4 点,则把一枚均匀硬币投掷一次,如果骰子出现5,6 点,则硬币投掷二次,求硬币投掷中正面出现次数对于骰子出现点数所提供的信息?答案:null3.在某中学有3/4学生通过了考试,1/4学生没有通过。

在通过考试的同学中10%有自行车,而没有通过的学生中50%有自行车,所有有自行车的同学都加入了联谊会,无自行车的同学中仅有40%加入联谊会。

a. 通过询问是否有自行车,能获得多少关于学生考试成绩的信息?b. 通过询问是否参加联谊会,能获得多少关于学生成绩的信息?c. 如果把学生成绩情况,自行车拥有情况和是否参加联谊会用三位二进数字传输,问每位数字携带多少信息?答案:null4.随机掷三颗骰子,以X 表示第一颗骰子抛掷的结果,以Y 表示第一颗和第二颗骰子抛掷之和,以Z 表示三颗骰子的点数之和,试求H(X|Y),H(Y|X),H(Z|X,Y),H(X,Z|Y)和H(Z|X)。

答案:null5.设一个系统传送10个数字:0,1,2,⋯,9,奇数在传送时以0.5概率等可能地错成另外的奇数,而其他数字总能正确接收。

朱雪龙《应用信息论基础》习题答案

第二章习题参考答案2.2证明:l(X;Y|Z) H(X|Z) H(X|YZ) H (XZ) H (Z) H (XYZ) H(YZ)H(X) H(Z |X) H(Z) H(XY) H (Z | XY) H (Y) H(Z|Y) [H(X) H(Y) H(XY)] H(Z|X) H(Z) H (Z | XY) H(Z |Y) I(X;Y) H(Z|X) H(Z) H (Z | XY) H(Z | Y)0 H(Z) H(Z) H (Z | XY) H(Z) H(Z) H (Z | XY)1 H (Z) H (Z | XY),即 H(Z) 1 H (Z | XY) 又 H(Z) 1,H(Z |XY) 0,故 H(Z) 1,H (Z | XY) 0 同理,可推出H(X) 1;H(Y) 1;H (XYZ) H(XY) H (Z | XY) H(X) H (Y) H (Z | XY) 1 1 0 22.3 1) H(X)= 0.918 bit , H(Y) = 0.918 bit2) H(X|Y)2= bit H(Y|X)=2-bit , H(X|Z)= 3 2 —bit33) I(X;Y): =0.251 bit , H(XYZ)= =1.585 bit2.4证明:(1)根据熵的可加性,可直接得到,a k 1), H(Y) log(k 1),故原式得证2.5考虑如下系统:又 l(X;Y|Z) = H(X|Z) — H(X|YZ) = H(X|Z) = 1 bit1不妨设 P(Z=0) = P(Z=1)=2设 P(X=0,Y=0|Z=0) = p P(X=1,Y=1|Z=0) = 1 — p1~[ Plogp + (1 — p)log (1 — p)]-[qlogq + (1 — q)log(1 — q)] =11满足上式的p 、q 可取:p =; q =2.1 In2 xnatIOg 2bi tP(X=0,Y=1|Z=1) = q P(X=1,Y=0|Z=1) = 1 — q⑵ Y 的值取自(31,32,假设输入X 、Y 是相互独立 的,则满足 I(X;Y) = 0则 H(X|Z)=•满足条件的一个联合分布:11 P(X=0, Y=0, Z=0)=4 P(X=1, Y=1, Z=0)=411 P(X=1, Y=1, Z=0)= 4P(X=1, Y=0, Z=1)=42.6 解:1 给出均匀分布p(x)—a x b 其中b a1,则 h(X) 0b a2.7 证明:l(X;Y;Z) = l(X;Y) — l(X;Y|Z)=I(X;Z) — I(X;Z|Y)•/ A, B 处理器独立,l(X;Z|Y) = 0••• l(X;Z) = I(X;Y) — I(X;Y|Z) W I(X;Y) 等号于p(x/yz) = p(x)下成立11 2.8 N=2 时, P(0 0) =, P(1 1)=—,其它为 022l( X ! ;X 2) = 1 bit N 工2时,l(X k1;X k |X 1 …X k 2) (3 W k)=P(X 「・・X k 2中有奇数个1) l(X k1;X k |X 「・・X k 2中有奇数个1) 1) l(X k1;X k |X 1…X k2中有偶数个1)1P(X 1…X k 2中有奇数个1)=-2 1P(X 1…X k 2中有偶数个1)=-2P(X k 1=1|X 1 - X k 2中有奇数个1P(X k1=0|X 1…X k 2中有奇数个1)=-2 1P(X k =1|X 1 - X k 2 中有奇数个 1)=-2 1P(X k =0|X 1…X k 2中有奇数个1)=-2 1P(X k 1=1|X 1 - X k 2 中有偶数个 1)=-+ P(X 1 - X k 2中有偶数个 1)=1(注意,这里k W N — 1)1 P(X k 1=0|X1- X k 2中有偶数个1)=-2P(X k=1|X「・X k2中有偶数个1)= (注意,这里k w N-1P(X k=O|X i…X k 2中有偶数个1)=-21P(X k 1=0, X k=0|X1- X k 2中有奇数个1)=—41P(X k 1=0, X k=1|X1 …X k 2 中有奇数个1)=-41P(X k 1=1, X k=0|X1- X k 2中有奇数个1)=-41P(X k 1=1, X k=1|X1 …X k 2 中有奇数个1)=-41P(X k 1=0, X k=0|X1 …X k 2 中有偶数个1)=-41P(X k1=O, X k=1|X1- X k 2中有偶数个1)=-41P(X k 1=1, X k=0|X1 …X k 2 中有偶数个1)=-41P(X k 1=1, X k=1|X1- X k 2中有偶数个1)=-4综上:l(X k1;X k|X1 …X k 2 中有奇数个1)(3w k w N -1)奇数个1)=H(X k 1|X1…X k 2中有奇数个1) + H(X k |X1…X k 2中有-H(X k 1;XJX1…X k 2中有奇数个1)=0l(X k1;X k|X1…X k 2中有偶数个1) = 0当 3 w k w N- 1 时,l(X k1;X k|X1 …X k 2) = 0当k = N时即l(X N 1 ;X N | X1 X N 2)=H(X N 1 |X 1 X N 2 )—H(X N 1 |X 1 X N 2 ,X N ) =1 bit2.91)实例如2.5题2)考虑随机变量X=Y=Z的情况1取P(X=0, Y=0, Z=0)=- P(X=1, Y=1, Z=1)= 则l(X;Y|Z) = 0I(X;Y) = 1 满足I(X;Y|Z)V I(X;Y)2.10 H(X Y) < H(X) + H(Y)等号在X 、Y 独立时取得满足H(X Y)取最大值2.11证明:p(xyz) p(x)p(y |x)p(z/y) l(X;Z|Y) 0,2.12证明:H (XYZ) H (XZ) H(Y | XZ) I (Y;Z |X) H(Y|X) H (Y | XZ) H (XYZ) H (XZ) H(Y|X) I(Y;Z|X)2.13证明:I(X;Y;Z) I(X;Y) I(X;Y|Z)H(X) H(X |Y) H(Y|Z) H (Y | XZ) H(X) H(X |Y) H(Y|Z) H(XYZ) H(XZ)H(XYZ) H(X |Y) H (Y|Z) H(Z|X) 而等式右边 H(XYZ)H(X) H (Y) H (Z)H (X) H (X |Y) H(Y) H(Y |Z) H(Z) H(Z | X) H (XYZ) H(X |Y) H (Y | Z) H (Z | X)故左式 右式,原式成立2.16证明:1卩心4)= 12 P( a2b2 )= 1 '24 P(a 3b 2)= 124P( a2b3)=P(a 3b 3)=1 24丄24I(X;Y) I(X;Y|Z) I(X;Y;Z) 故I (X ;Y ) I (X ;Y |Z )成立I(X;Z) I(X;Z|Y) I(X;Z) 02.15H(X)=1log(^)n=n (」)n = 2bitn 12 2222 121log(nat)1--P( a i b i )=3 - 1 P( a2b1)= 6 一 1 PGS)=- P(a 1b s )=2.14 P(X=n) = (2)n 1 1=(舟)"2 22 12 211E I(2PN (a k )尹N '(ak ),p(ak ))根据鉴别信息的凸性11 1 11(二 P N (aQ -P N '(a k ), p(a k )) -I (P N (a k ),P(aQ)二 1仇'何),p(aQ) 2 2 2 21 1 1 1又 E :l(P N (a k ), p(aQ) ; I 仇'何),p(aQ) 二 E l(P N (aQ, p(aQ) ; E I(P N '(aj p(aQ2 2 2 2而根据随机序列的平稳 性,有:1 1E -I (P N (a k ), p(a k )) T(P N ‘(a k ), p(aj)E I (P N (a k ), p(a k )) E I (P N '(a k ), p(a k )2 21 1E I (P 2N (a k ), p(a k )) E l(—P N (aQ - P N '(a k ), p(a k ))2 2R N (a k ) 1 2N 耐1^ a"二丄的概率为p k (丄),其中X 1X 2 2N 2NX N 中出现a k 的频 1 率为P N (a k )N N nW a k ) n 1 的概率为6中,X N 1X N 2X 2N 中出现a k 的 1 频率为P N '(a k)—N n2N l(X n N 1 n 2 N P N (a k )的概率为P k (晋),则有 1 F2N (a k )P N (ak ) 1 尹血)所以E 1 ( P2N (a k ),P(ak ))1 1E -I(P N(a k), p(a k)) -I(P N'(a k), P(aQ)2 2E l(P N(aJ p(a k))2-- log e2.17 解:2.18 I(P 2,P i ;X) l(q 2,q i ;X |Y)q 2(X k |y j )h 2(y j )log q2(xk |Yj)qm |y j )g,P i ;XY) P 2(xy) log P 2(xy))P 1(xy)dxdy ;P i (xy) g(x)h(y);其中 g(x)2x2 exP(1h(y) ------ 2 exp(2 yI(P 2,P I ;XY) p 2 (xy) log p 2(xy)dxdyg(x)h(y)1 、• •「2 / ---- JP 2(xy)log( ---- 2 )dxdy 2 loge P 2(xy) 12~~2(1 ) 2x~2 xxy2y_ 2 y2 x~2 x2y_ 2 ydxdy|(P I ,P 2;XY )1log( ---- 2)1 22(11log (------ 2)1 2 log e2E(X ) 22-E(Y )yE(XY)x yp 1(xy)log鷲dxdylog (〒丄诗)log e 2(1 2) 22-E(X )x22-E(Y )y-—E(XY)x yJ(P 2,P I ;XY) I(P 2,P I ;XY) I(P I , P 2;XY) 2--- log e当XY 满足P 1(xy)分布时,I (X;Y) 0; 当XY 满足P 2(xy)分布时,I (X ;Y) 1I(P 2,P 1;XY) log('12) P 2(xjlog P2"xk)P i (xQq 2(X k ,y j ) P 2(xQ q i (X k ,y j ) P i (X k )jP 2(x)h 2(y),且 q i (X k ,y j ) P i (xQh i (y j )时I(P 2,P i ;X) I(q 2,q i ;X |Y)q 2 (X k , y j ) log q i (X k ,y j ) P i (X k ) h i (y j )关系不定 2.19 解:天平有3种状态,即平衡,左重,左轻,所以每称一次消除的不确定性为Iog3, 12个一 一 1 1球中的不等重球(可较轻,也可较重)的不确定性为: loglog 24 因为3log312 2> log24••• 3次测量可以找出该球具体称法略。

信息论基础第二版习题答案

信息论基础第二版习题答案信息论是一门研究信息传输和处理的学科,它的基础理论是信息论。

信息论的基本概念和原理被广泛应用于通信、数据压缩、密码学等领域。

而《信息论基础》是信息论领域的经典教材之一,它的第二版是对第一版的修订和扩充。

本文将为读者提供《信息论基础第二版》中部分习题的答案,帮助读者更好地理解信息论的基本概念和原理。

第一章:信息论基础1.1 信息的定义和度量习题1:假设有一个事件发生的概率为p,其信息量定义为I(p) = -log(p)。

求当p=0.5时,事件的信息量。

答案:将p=0.5代入公式,得到I(0.5) = -log(0.5) = 1。

习题2:假设有两个互斥事件A和B,其概率分别为p和1-p,求事件A和B 同时发生的信息量。

答案:事件A和B同时发生的概率为p(1-p),根据信息量定义,其信息量为I(p(1-p)) = -log(p(1-p))。

1.2 信息熵和条件熵习题1:假设有一个二进制信源,产生0和1的概率分别为p和1-p,求该信源的信息熵。

答案:根据信息熵的定义,信源的信息熵为H = -plog(p) - (1-p)log(1-p)。

习题2:假设有两个独立的二进制信源A和B,产生0和1的概率分别为p和1-p,求两个信源同时发生时的联合熵。

答案:由于A和B是独立的,所以联合熵等于两个信源的信息熵之和,即H(A,B) = H(A) + H(B) = -plog(p) - (1-p)log(1-p) - plog(p) - (1-p)log(1-p)。

第二章:信道容量2.1 信道的基本概念习题1:假设有一个二进制对称信道,其错误概率为p,求该信道的信道容量。

答案:对于二进制对称信道,其信道容量为C = 1 - H(p),其中H(p)为错误概率为p时的信道容量。

习题2:假设有一个高斯信道,信道的信噪比为S/N,求该信道的信道容量。

答案:对于高斯信道,其信道容量为C = 0.5log(1 + S/N)。

信息论基础第二章信源熵-习题答案.doc

为(202120130213001203210110321010021032011223210),求(1) 此消息的自信息量是多少?(2) 此消息中平均每符号携带的信息量是多少?解:(1) 此消息总共有14个0、13个1、12个2、6个3,因此此消息发出的概率是:(]\25X ——,4丿此消息的信息量是:/ =-log/? = 87.811 bit(2)此消息中平均每符号携带的信息量是://〃 = 87.811/45 = 1.951 bit解释为什么> Iog6不满足信源储的极值性。

解: 6 H(X)= -工 /?(%,) log p(xji= -(0.2 log 0.2+ 0.19 log 0.19 + 0.181og0.18 + 0.171og0」7 + 0.161og0.16 + 0.171og0.17) =2.657 bit / symbolW(X)>log 2 6 = 2.5856不满足极值性的原因是工#(兀)=1.07 > i 。

2.7同时掷出两个正常的骰子,也就是各面呈现的概率都为1/6,求:(1) “3和5同时出现”这事件的自信息;(2) “两个1同时出现”这事件的自信息;(3) 两个点数的各种组合(无序)对的*商和平均信息量;(4) 两个点数之和(即2, 3,…,12构成的子集)的储;(5) 两个点数中至少有一个是1的自信息量。

解:2.4 设离散无记忆信源X P(X) 兀[=0 兀2 = 1 兀3 = 2 X 4 =3 3/8 1/4 1/4 1/8 ,其发出的信息 2. 6 ■ X 'x 2 兀4 尤5 兀6 ' > P(X).[0.2 0.19 0.18 0.17 0.16 0」74H(X)=-工"(xjlog #(兀)= 2.010 /=!设信源 求这个信源的储,并⑴用随机事件兀表示“3和5同时出现”,贝UI(x i ) = - log p(xj = - log — = 4.170 bit 18(2)用随机事件齐表示“两个1同吋出现”,则 p(xj = — X —=—'6 6 36/(兀)=- log p{x i ) = -log — = 5」70 bit⑶两个点数的排列如下: 1112 13 14 15 16 2122 23 24 25 26 3132 33 34 35 36 4142 43 44 45 46 5152 53 54 55 56 61 62 63 64 65 6622, 33, 44, 55, 66的概率是卜卜召 其他"组合的概率是2x 肚诂H(X) =-工 p(x /)logp(x,) = -f6x-^log-^ + 15x-l-log-^/ I 3o 3b 1 o 1 o ⑷参考上而的两个点数的排列,可以得出两个点数求和的概率分布如H :Xf 2 3 4 5 6 7 8 9 1() 11 121 1 1 1 1 5 1 5 1 1 1 1]p(X)_ 、36 18 12 9 36 6 36 9 12 18 36.H(X) = -工卩(无)log pg1 . 1 c 1 I 1,1. 1,1. 1,5, 5 1 I 1)-2x ——log — + 2x —log — + 2x — log — + 2x —log —+ 2x — log — + —log —I 36 36 18 18 12 12 9 9 36 36 6 6)= 3.274 bit/symbol⑸p(x.) = —x — xl 1 =——'6 6 36/(x z ) = - log /?(%, ) = - log= 1.710 bit 36共有21种组合:其中11,= 4.337 bit I symbol2.10对某城市进行交通忙闲的调查,并把天气分成晴雨两种状态,气温分成冷 暖两个状态,调查结果得联合出现的相对频度如下:若把这些频度看作概率测度,求:(1) 忙闲的无条件爛;(2) 天气状态和气温状态已知时忙闲的条件爛;⑶从天气状态和气温状态获得的关于忙闲的信息。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

《信息论基础》答案

一、填空题(共15分,每空1分)

1、若一连续消息通过某放大器,该放大器输出的最大瞬时电压为b,最小瞬时电压为a。

若消息从放大器中输出,则该信源的绝对熵是无穷大;其能在每个自由度熵的最

大熵是log b-a 。

2、高斯白噪声信道是指信道噪声服从正态分布,且功率谱为常数。

3、若连续信源的平均功率为 5 W,则最大熵为1.2 Iog10 e ,达到最大值的条件是高

斯信道。

4、离散信源存在剩余度的原因是信源有记忆(或输岀符号之间存在相关性)和不

等概。

5、离散无记忆信源在进行无失真变长信源编码时,编码效率最大可以达到 1 。

6、离散无记忆信源在进行无失真变长信源编码时,码字长度是变化的。

根据信源符号

的统计特性,对概率大的符号用短码,对概率小的符号用长码,这样平均码长

就可以降低,从而提高编码效率。

7、八进制信源的最小熵为0 ,最大熵为3bit 。

8、一个事件发生概率为,则自信息量为3bit 。

9、在下面空格中选择填入数字符号“,,,”或“ <”

H XY 二HY HXY HY H X

二、判断题(正确打",错误打X)(共5分,每小题1分)

1)离散无(")记忆等概信源的剩余度为0。

2) 离散无记忆信源N次扩展源的熵是原信息熵的N倍(")

3) 互信息可正、可负、可为零。

(")

4) 信源的真正功率P 永远不会大于熵功率P ,即P P

(X )

5) 信道容量与信源输出符号的概率分布有关。

(X )

、(5分)已知信源的概率密度函数p x如下图所示,求信源的相对熵

* p x

0.5

4

h x 2 p x log p x dx

1bit自由度

四、(15分)设一个离散无记忆信源的概率空间为P x 0.5 0.5

它们通过干扰信道,信道输出端的接收信号集为丫= 示。

试计算:

(1)信源X中事件x的自信息量;(3分)

(2)信源X的信息熵;(3分)

(3)共熵H XY ; ( 3 分)

(4)噪声熵H Y X ;(3分)

(5)收到信息丫后获得的关于信源X的平均信息量。

(1)I x11bit

(2)H丄,丄1bit/符号

2 2,已知信道出书概率如下图所

(3 分)

(3) H XY H 0.49,0.01 , 0.1, 0.4 1.432

(1)

(4) H X Y

H XY H X

0.432

I X,Y

H X H Y H X,Y (5)

1 H 0.59, 0.41

H XY

1 0.977 1.432

0.545

五、(10分)一个平均功率受限的连续信道,信道带宽为 声。

(1 )已知信道上的信号与噪声的平均功率比值为

63,计算该信道的信道蓉量。

(2)如果信道带宽降为 2MHz ,要达到相同的信道容量,信道上的信号与噪声的平均

功率比值应为多少

P S 0.2 0.2 0.2 0.1 0.1 0.1 0.1

C Blog 2 1 §

N

(1

)

C 10

106 log 2 1

63

6 107bit/s

(2

)

-2专 N 1 230 1 109

六、 (10

分)

已知信源共 7个符号信息,其概率空间为

S

S-1 S 2 S 3 S 4 S 5

S

6

S 7

10MHz ,信道噪声为高斯白噪

(3) H XY H 0.49,0.01 , 0.1, 0.4 1.432

(1)试用霍夫曼编码法编成二进制变长码。

(7分)(2)计算信源熵,平均码长和编码效率。

(9分)

(1)

1

H S H 0.2, 0.2, 0.2, 0.1,0.1,0.1,0.1,

2.72

分)

求随机变量Y X 1 X 2的概率密度函数,并计算变量

丫的熵h 丫 。

已知 p X 1X 2 得

p X

1

X 1 2

2 e

p X 2

1

e X 2

2 2

(2 分) 则p X 1X 2

p X 1 p X 2

(2 分)

所以 X 1和X 2独立,所以 y 为咼斯分布

L 0.2 2 =H S 0.8 3

2.8码元/信源符号

0.97

(3分)

L

七、(10分)设给定两随机变量

X ! 和 X 2, 它们的联合概率密度为

p XX 2

1

X 12 x 2 2

e X,x

S i 0.2

S 2 0.2

S 3 0.2 s 4 0.1 S 5 0.1

Ss 0.1

S 7 0.1

0.4

0.6

1

0.2 0

0.4

1

0.2

0.1

S 1 00

S 010 S 3 011

S 4

100

55 101 56 110

57 111

(7 分)

(2)

2

因为y x

1X2

所以 E Y 0, D Y 2 (2分)

所以 1

py 4 e

y24 (2 分)所以h Y log 4 e bit /自由度(2)八、(10分)设某信道的传递矩阵为

1111

p 3 3 6 6

6 6 3 3

计算该信道的信道容量,并说明达到信道容量的最佳输入概率分布。

解:s=4

C log s H p列矢量 4

log 2 H 1 1 1 1

3 3 6 6 (2

1 1

2 log - 1 1 log - 1 1 1 -log -

- log 1 0.0817bit/ 符号

3 3 3 3 6 6 6 6 分)

(2分)

最佳概率分布当输入概率p a1 P

a2 1

2

(2

分)

九、(14分)设有一个马尔可夫信源,如果X t为a时,X2为a、b、c的概率为1/3 ;如果X t为b时,X2为a、b、c的概率为1/3;如果X t为c时,X2为a、b的概率为1/2。

而且后面发X i的概率只与X i!有关,又P X i X i ! P X^ X! i 3。

(1)写出转移概率矩阵

(2)计算达到稳定后状态的极限概率。

(3)该马尔可夫信源的极限熵H

解(1)

1_ 1 1

3 3 3

P 1_ 1 1 (4分)

3 3 3

1 1 0

2 2

1 1 1 1

P E1 —P E1 -P E2 -P E3

3 3 2

P E

2 1 P

E1

耳E

2

^P E3

(2) 3 3 2

1 1

P E3 —P E1 P E2

3 3

P E1 P E 2 P E3 1

(3)

P E i P E2

3

H H2 P E I H a k E i

1

P E i H 1 1 1

3,3,3 P E2 H

H -,i,0

2 2

3 1

Iog3 log 2 1.439bit/ 符号

(3 分)。