MATLAB的统计工具箱中的多元统计分析中提供了聚类分析的两种方法

多元统计分析MATLAB

多元统计分析MATLAB多元统计分析(Multivariate statistical analysis)是指对多个变量之间的关系进行分析和研究的方法。

在实际应用中,往往需要考虑多个变量之间的相互作用,而不仅仅是单个变量的影响。

多元统计分析主要用于数据挖掘、模式识别、数据降维等领域,在各个学科中都有广泛的应用。

MATLAB是一种常用的科学计算和数据分析软件,广泛应用于工程、科学研究和教学领域。

它拥有丰富的功能和强大的计算能力,适用于各种多元统计分析方法的实现和应用。

多元方差分析(MANOVA)是指对多个因变量之间的差异进行分析和研究,可以用于比较不同组之间的差异。

MATLAB中提供了统计工具箱(Statistics and Machine Learning Toolbox),可以方便地进行多元方差分析的计算和可视化。

聚类分析是将相似的样本或变量聚集在一起形成集群的方法,可以用于对数据进行分类和分组。

MATLAB中提供了clusterdata、kmeans和linkage等函数,可以用于聚类分析的计算和可视化。

判别分析(Discriminant Analysis)是用于分类的一种方法,它可以通过构造一个判别函数,将样本分到不同的类别中。

在MATLAB中,可以使用classify函数进行判别分析的计算和可视化。

因子分析(Factor Analysis)是一种用于确定多个变量之间的共同因素的方法,可以用于发现隐含在数据中的结构和规律。

MATLAB中提供了factoran函数,可以进行因子分析的计算和可视化。

除了以上介绍的方法,MATLAB还提供了许多其他的多元统计分析方法和工具,如典型相关分析、聚类程度检验、时间序列分析等。

用户可以根据不同的需求选择合适的方法进行分析和研究。

综上所述,MATLAB是一种非常适用于多元统计分析的工具,它提供了丰富的函数和工具箱,可以方便地进行多元统计分析的计算和可视化。

如何在MATLAB中进行数据聚合与分析

如何在MATLAB中进行数据聚合与分析1. 引言数据聚合与分析是现代数据科学领域中的关键任务之一。

随着信息时代的到来,我们面对的数据量呈爆炸式增长,如何从这些海量的数据中提取有用的信息成为了一个迫切的问题。

MATLAB (Matrix Laboratory) 是一种强大的数值计算和可视化软件,具备丰富的数据处理和分析工具。

本文将介绍如何在MATLAB中进行数据聚合与分析,希望能为读者提供一些有用的方法和技巧。

2. 数据预处理在进行数据聚合与分析之前,通常需要对原始数据进行一些预处理工作,以清洗和转换数据,使其适合进一步的分析。

MATLAB提供了一系列的函数和工具来帮助我们完成这些任务。

2.1 数据清洗数据清洗是数据预处理的重要环节之一,它包括去除重复值、处理缺失值、纠正错误值等。

在MATLAB中,可以使用unique函数去除重复值,使用isnan函数判断缺失值,并使用合适的方法进行填充或删除。

2.2 数据转换有时候,我们需要对原始数据进行一些转换,例如归一化、标准化、对数转换等。

MATLAB提供了normc和zscore等函数来实现数据的归一化和标准化,log函数可以实现对数转换。

这些转换可以使得数据更具可比性,并且适合进行后续的分析。

3. 数据聚合数据聚合是将原始数据按照一定的规则进行分组,并对每个组进行统计分析的过程。

在MATLAB中,我们可以使用一些函数和工具来实现数据聚合。

3.1 分组首先,我们需要将原始数据按照某个变量进行分组。

MATLAB提供了groupcounts和splitapply等函数来实现分组,我们可以根据自己的需求选择合适的函数。

3.2 聚合分组完成后,我们可以对每个组进行聚合操作。

MATLAB提供了一系列的聚合函数,包括sum、mean、median、min、max等。

这些函数可以对分组后的数据进行统计分析,并生成聚合结果。

4. 数据分析数据分析是基于已经聚合的数据进行的,通过对聚合结果的进一步分析,我们可以得到关于数据的更多有意义的信息。

利用Matlab进行数据聚类与分类的方法

利用Matlab进行数据聚类与分类的方法导言在当今大数据时代,处理和分析庞大的数据成为许多领域的重要任务,而数据聚类与分类是其中重要的一环。

Matlab作为一种功能强大的编程语言和工具,在数据聚类与分类方面具有广泛的应用。

本文将介绍利用Matlab进行数据聚类与分类的常用方法和技巧。

一、数据聚类的概念与方法1.1 数据聚类的定义数据聚类是指将具有相似特征的数据对象自动分成若干组的过程,旨在将相似的数据归为一类,不相似的数据分开。

1.2 常用的数据聚类方法- K-means聚类算法:K-means是一种常见且简单的数据聚类方法,通过迭代优化的方式将数据划分成K个簇。

- 层次聚类算法:层次聚类是一种基于树形结构的聚类方法,它将数据逐步合并或分裂,直到得到最终的聚类结果。

- 密度聚类算法:密度聚类根据数据点的密度特征进行聚类,能够有效地发现任意形状和大小的聚类簇。

- 谱聚类算法:谱聚类结合图论的思想,通过计算数据的拉普拉斯矩阵特征向量,将数据聚类成多个划分。

二、利用Matlab进行数据聚类2.1 准备工作在使用Matlab进行数据聚类之前,需要准备好数据集。

通常,数据集需要进行预处理,包括数据清洗、特征选择和降维等步骤。

2.2 K-means聚类利用Matlab的统计工具箱,可以轻松实现K-means聚类算法。

首先,将数据集读入Matlab并进行必要的归一化处理。

然后,使用kmeans函数运行K-means聚类算法,指定聚类的簇数K和迭代次数等参数。

最后,根据聚类结果进行数据可视化或进一步的分析。

2.3 层次聚类Matlab中的cluster函数提供了层次聚类的功能。

将数据集转换为距离矩阵,然后调用cluster函数即可实现层次聚类。

该函数支持不同的聚类算法和距离度量方法,用户可以根据具体需求进行调整。

2.4 密度聚类实现密度聚类可以使用Matlab中的DBSCAN函数。

DBSCAN是一种基于密度的聚类算法,它通过确定数据点的领域密度来判定是否为核心对象,并通过核心对象的连接性将数据点分为不同的簇。

在Matlab中如何进行数据聚类分析

在Matlab中如何进行数据聚类分析数据聚类分析是一种常用的数据处理方法,在各个领域都有广泛的应用。

在Matlab中,数据聚类分析相对简单且易于实现。

本文将介绍在Matlab中如何进行数据聚类分析的基本步骤和常用的聚类算法,并通过实例演示其具体操作。

一、数据预处理在进行数据聚类分析之前,通常需要对原始数据进行预处理以保证聚类的准确性。

首先,要对数据进行标准化,使得不同维度的特征具有相同的范围和重要性。

常见的标准化方法有z-score标准化和min-max标准化。

其次,要对数据进行降维处理,以便对高维数据进行分析。

常见的降维方法有主成分分析(PCA)和线性判别分析(LDA)等。

最后,要对数据进行异常值处理,去除可能对聚类结果产生干扰的异常值。

二、选择聚类算法在Matlab中,有多种聚类算法可供选择,如K-means聚类、层次聚类、密度聚类等。

不同的聚类算法适用于不同的数据情况和分析目的。

在选择聚类算法时,应根据数据的特点、分析目的和算法的优缺点进行综合考虑。

下面将以K-means聚类算法为例进行演示。

三、K-means聚类算法实例演示K-means聚类算法是一种简单且常用的聚类算法。

其基本思想是通过迭代计算,将数据样本划分为K个簇,使得同一簇内的样本相似度较高,不同簇之间的相似度较低。

现假设有一组二维数据集,要对其进行聚类分析。

```matlab% 生成随机数据X = [randn(100,2)+ones(100,2); randn(100,2)-ones(100,2)];% K-means聚类K = 2; % 设置簇的个数[idx, C] = kmeans(X, K); % 进行聚类分析% 绘制聚类结果figure;plot(X(idx==1,1),X(idx==1,2),'r.','MarkerSize',12);hold on;plot(X(idx==2,1),X(idx==2,2),'b.','MarkerSize',12);plot(C(:,1),C(:,2),'kx','MarkerSize',15,'LineWidth',3);legend('Cluster 1','Cluster 2','Centroids','Location','NW');title 'Cluster Assignments and Centroids';hold off;```上述代码中,通过`randn`函数生成了一个含有200个样本的二维数据集X,然后利用`kmeans`函数进行聚类计算,得到了每个样本属于的簇的索引`idx`和簇的中心点坐标`C`。

matlab统计工具箱应用教程

统计工具箱是matlab提供给人们的一个强有力的统计分析工具.包含200多个m文件(函数),主要支持以下各方面的内容.〉〉概率分布:提供了20种概率分布,包含离散和连续分布,且每种分布,提供了5个有用的函数,即概率密度函数,累积分布函数,逆累积分布函数,随机产生器与方差计算函数.〉〉参数估计:依据特殊分布的原始数据,可以计算分布参数的估计值及其置信区间.〉〉描述性统计:提供描述数据样本特征的函数,包括位置和散布的度量,分位数估计值和数据处理缺失情况的函数等.〉〉线性模型:针对线性模型,工具箱提供的函数涉及单因素方差分析,双因素方差分析,多重线性回归,逐步回归,响应曲面和岭回归等.〉〉非线性模型:为非线性模型提供的函数涉及参数估计,多维非线性拟合的交互预测和可视化以及参数和预计值的置信区间计算等.〉〉假设检验: 此间提供最通用的假设检验函数:t检验和z检验〉〉其它的功能就不再介绍.统计工具箱函数主要分为两类:〉〉数值计算函数(M文件)〉〉交互式图形函数(Gui)matlab惯例:beta 线性模型中的参数,E(x) x的数学期望,f(x|a,b) 概率密度函数,F(x|a,b) 累积分布函数,I([a,b]) 指示(Indicator)函数p,q p事件发生的概率.[size=2][color=blue]第1节概率分布[/color][/size]统计工具箱提供的常见分布Uniform均匀,Weibull威布尔,Noncentral t,Rayleigh瑞利,Poisson泊松,Student's t,Normal正态,Negative Binomial,Noncentral FLognormal对数,正态,Hyper G,F分布,Gamma,Geometric几何,Noncentral chi-square,Exponential 指数,Binomial二项,Chi-squareBeta(分布),discrete,Continuous,Continuous,离散分布,统计量连续分布,数据连续分布,概率密度函数pdf,probbability density function〉〉功能:可选的通用概率密度函数〉〉格式:Y=pdf('Name',X,A1,A1,A3)'Name' 为特定的分布名称,第一个字母必须大写X 为分布函数自变量取值矩阵A1,A2,A3 分别为相应分布的参数值Y 存放结果,为概率密度值矩阵算例:>> y=pdf('Normal',-2:2,0,1)y =0.0540 0.2420 0.3989 0.2420 0.0540>> Y=pdf('Normal',-2:0.5:2,1,4)Y =0.0753 0.0820 0.0880 0.0930 0.0967 0.0990 0.0997 0.0990 0.0967>> p=pdf('Poisson',0:2:8,2)p =0.1353 0.2707 0.0902 0.0120 0.0009>> p=pdf('F',1:2:10,4,7)p =曲线>> x=[-6:0.05:6];>> y1=pdf('Normal',x,0,0.5);>> y2=pdf('Normal',x,0,1);>> y3=pdf('Normal',x,0,2);>> y4=pdf('Normal',x,0,4);>>plot(x,y1,'K-',x,y2,'K--',x,y3,'*',x,y4,'+')这个程序计算了mu=0,而sigma取不同值时的正态分布密度函数曲线的形态,可以看出,sigma越大,曲线越平坦.累积分布函数及逆累积分布函数cdf icdf〉〉功能:计算可选分布函数的累积分布和逆累积分布函数〉〉格式:P=cdf('Name',X,A1,A2,A3)X=icdf('Name',P,A1,A2,A3)>> x=[-3:0.5:3];>> p=cdf('Normal',x,0,1)p =0.0013 0.0062 0.0228 0.0668 0.1587 0.3085 0.5000 0.6915 0.8413 0.9332 0.9772 0.9938 0.9987>> x=icdf('Normal',p,0,1)x =-3.0000 -2.5000 -2.0000 -1.5000 -1.0000 -0.5000 0 0.5000 1.0000 1.5000 2.0000 2.5000 3.0000随机数产生器random〉〉功能:产生可选分布的随机数〉〉格式:y=random('Name',A1,A2,A3,m,n)A1,A2,A3 分布的参数'Name' 分布的名称m,n 确定y的数量,如果参数是标量,则y是m*n矩阵例如产生服从参数为(9,10)的F-分布的4个随机数值>> y=random('F',9,10,2,2)y =3.4907 1.67620.5702 1.1534均值和方差以'stat'结尾的函数均值和方差的计算函数[m,v]=normstat(mu,sigma)正态分布[mn,v]=hygestat(M,K,N)超几何分布[m,v]=geostat(P)几何分布[m,v]=gamstat(A,B)Gamma分布[m,v]=fstat(v1,v2)F分布[m,v]=expstat(mu)指数分布[m,v]=chi2stat(nu)二项分布[m,v]=betastat(A,B)Beta 分布函数名称及调用格式分布类型名称[m,v]=weibstat(A,B)威尔分布[m,v]=unistat(A,B)连续均匀分布[m,v]=unidstat(N)离散均匀分布[m,v]=tstat(nu)t分布[m,v]=raylstat(B)瑞利分布[m,v]=poisstat(lambda)泊松分布[m,v]=ncx2stat(nu,delta)非中心chi2分布[m,v]=nctstat(nu,delta)非中心t分布[m,v]=ncfstat(nu1,nu2,delta)非中心F分布[m,v]=nbinstat(R,P)负二项分布[m,v]=lognstat(mu,sigma)对数正态分布[size=2][color=blue]第2节参数估计[/color][/size]参数估计是总体的分布形式已经知道,且可以用有限个参数表示的估计问题.分为点估计(极大似燃估计Maximum likehood estimation, MLE)和区间估计.求取各种分布的最大似然估计估计量mle〉〉格式:phat=mle('dist',data)[phat,pci]=mle('dist',data)[phat,pci]=mle('dist',data,alpha)[phat,pci]=mle('dist',data,alpha,p1)〉〉'dist' 给定的特定分布的名称,'beta','binomial'等.Data为数据样本,矢量形式给出.Alpha用户给定的置信度值,以给出100(1-alpha)%的置信区间,缺省为0.05.最后一种是仅供二项分布参数估计,p1为实验次数.例1 计算beta 分布的两个参数的似然估计和区间估计(alpha=0.1,0.05,0.001),样本由随机数产生. >> random('beta',4,3,100,1);>> [p,pci]=mle('beta',r,0.1)p =4.6613 3.5719pci =3.6721 2.7811p =4.6613 3.5719pci =3.4827 2.62965.8399 4.5141>> [p,pci]=mle('beta',r,0.001)p =4.6613 3.5719pci =2.6825 1.99006.6401 5.1538例 2 计算二项分布的参数估计与区间估计,alpha=0.01.>> r=random('Binomial',10,0.2,10,1);>> [p,pci]=mle('binomial',r,0.01,10)p =0.2000 0.2000 0.1000 0.4000 0.2000 0.2000 0.4000 0 0.1000 0.2000pci =0.0109 0.0109 0.0005 0.0768 0.0109 0.0109 0.0768 NaN 0.0005 0.01090.6482 0.6482 0.5443 0.8091 0.6482 0.6482 0.8091 0.4113 0.5443 0.6482[size=2][color=blue]第3节描述统计[/color][/size]描述性统计包括:位置度量,散布度量,缺失数据下的统计处理,相关系数,样本分位数,样本峰度,样本偏度,自助法等〉〉位置度量:几何均值(geomean),调和均值(harmmean),算术平均值(mean),中位数(median),修正的样本均值(trimean).〉〉散布度量:方差(var),内四分位数间距(iqr),平均绝对偏差(mad),样本极差(range),标准差(std),任意阶中心矩(moment),协方差矩阵(cov).〉〉缺失数据情况下的处理:忽视缺失数据的最大值(nanmax),忽视缺失数据的平均值(nanmean),忽视缺失数据的中位数(nanmedian),忽视缺失数据的最小值(nanmin),忽视缺失数据的标准差(nanstd),忽视缺失数据的和(namsum).〉〉相关系数:corrcoef ,计算相关系数〉〉样本分位数:prctile,计算样本的经验分位数〉〉样本峰度:kurtosis,计算样本峰度〉〉样本偏度:skewness,计算样本偏度〉〉自助法:bootstrp,对样本从新采样进行自助统计中心趋势(位置)度量样本中心趋势度量的目的在于对数据样本在分布线上分布的中心位置予以定为.均值是对中心位置简单和通常的估计量.不幸的是,几乎所有的实际数据都存在野值(输入错误或其它小的技术问题造成的).样本均值对这样的值非常敏感.中位数和修正(剔除样本高值和低值)后的均值则受野值干扰很小.而几何均值和调和均值对野值也较敏感.下面逐个说明这些度量函数.〉〉geomean功能:样本的几何均值格式:m=geomean(X)若X为向量,则返回X中元素的几何均值;若X位矩阵,给出的结果为一个行向量,即每列几何均值. 例 1 计算随机数产生的样本的几何均值>> X=random('F',10,10,100,1);1.1007>> X=random('F',10,10,100,5);>> m=geomean(X)m =0.9661 1.0266 0.9703 1.0268 1.0333〉〉harmmean功能:样本的调和均值格式:m=harmmean(X)例 2 计算随机数的调和均值>> X=random('Normal',0,1,50,5);>> m=harmmean(X)m =-0.2963 -0.0389 -0.9343 5.2032 0.7122〉〉mean功能:样本数据的算术平均值格式:m=mean(x)例 3 计算正态随机数的算术平均数>>X=random('Normal',0,1,300,5);>> xbar=mean(X)xbar =0.0422 -0.0011 -0.0282 0.0616 -0.0080〉〉median功能:样本数据的中值(中位数),是对中心位值的鲁棒估计.格式:m=median(X)例 4 计算本的中值>> X=random('Normal',0,1,5,3)X =0.0000 0.8956 0.5689-0.3179 0.7310 -0.25561.0950 0.5779 -0.3775-1.8740 0.0403 -0.29590.4282 0.6771 -1.4751>> m=median(X)m =0.0000 0.6771 -0.2959〉〉trimmean功能:剔除极端数据的样本均值.格式:m=trimmean(X,percent)说明:计算剔除观测值中最高percent%和最低percent%的数据后的均值例5 计算修改后的样本均值>> X=random('F',9,10,100,4);>> m=trimmean(X,10)m =1.1470 1.1320 1.1614 1.0469散布度量散布度量是描述样本中数据离其中心的程度,也称离差.常用的有极差,标准差,平均绝对差,四分位数功能:计算样本的内四分位数的间距,是样本的鲁棒估计格式:y=iqr(X)说明:计算样本的75%和25%的分位数之差,不受野值影响.例6 计算样本的四分位间距>> X=random('Normal',0,1,100,4);>> m=iqr(X)m =1.3225 1.2730 1.3018 1.2322〉〉mad功能:样本数据的平均绝对偏差格式:y=mad(X)说明:正态分布的标准差sigma可以用mad乘以1.3估计例7 计算样本数据的绝对偏差>> X=random('F',10,10,100,4);>> y=mad(X)y =0.5717 0.5366 0.6642 0.7936>> y1=var(X)y1 =0.6788 0.6875 0.7599 1.3240>> y2=y*1.3y2 =0.8824 0.8938 0.9879 1.7212〉〉range功能:计算样本极差格式:y=range(X)说明:极差对野值敏感例8 计算样本值的极差>> X=random('F',10,10,100,4);>> y=range(X)y =10.8487 3.5941 4.2697 4.0814〉〉var功能:计算样本方差格式:y=var(X) y=var(X,1) y=var(X,w)Var(X)经过n-1进行了标准化,Var(X,1)经过n进行了标准变化例9 计算各类方差>> X=random('Normal',0,1,100,4);>> y=var(X)y =0.9645 0.8209 0.9595 0.9295>> y1=var(X,1)y1 =0.9548 0.8126 0.9499 0.9202>> w=[1:1:100];>> y2=var(X,w)〉〉std功能:样本的标准差格式:y=std(X)说明:经过n-1标准化后的标准差例10计算随机样本的标准差>> X=random('Normal',0,1,100,4);>> y=std(X)y =0.8685 0.9447 0.9569 0.9977〉〉cov功能:协方差矩阵格式:C=cov(X) C=cov(x,y) C=cov([x y])说明:若X为向量,cov(X)返回一个方差标量;若X为矩阵,则返回协方差矩阵;cov(x,y)与cov([x y])相同,x与y的长度相同.例11 计算协方差>> x=random('Normal',2,4,100,1);>> y=random('Normal',0,1,100,1);>> C=cov(x,y)C =12.0688 -0.0583-0.0583 0.8924处理缺失数据的函数在对大量数据样本时,常常遇到一些无法确定的或者无法找到确切的值.在这种情况下,用符号"NaN"(not a number )标注这样的数据.这种情况下,一般的函数得不到任何信息.例如m中包含nan数据>> m=magic(3);>> m([1 5 9])=[NaN NaN NaN];>> sum(m)ans =NaN NaN NaN但是通过缺失数据的处理,得到有用的信息.>> nansum(m)ans =7 10 13〉〉nanmax功能:忽视NaN(不确定的值),求其它数据的最大值格式:m=nanmax(X)[m,ndx]=nanmax(X)m=nanmax(a,b)说明:nanmax(X)返回X中数据除nan外的其它的数据的最大值,[m,ndx]=nanmax(X)还返回X最大值的序号给ndx.m=nanmax(a,b)返回a或者b的最大值,a,b长度同>> m=magic(3);>> m([1 5 9])=[NaN NaN NaN];>> [m,ndx]=nanmax(m)m =4 9 7处理缺失数据的常用函数Y=nansum(X)求包含确实数据的和nansumY=nanstd(X)求包含确实数据的标准差NanstdY=nanmedian(X)求包含确实数据中位数NanmedianY=nanmean(X)求包含确实数据的平均值Nanmean同上求包含确实数据的最小值Nanmin(略)求包含确实数据的最大值Nanmax调用格式功能函数名称中心矩moment功能:任意阶的中心矩格式:m=moment(X,order)说明:order为阶,函数本身除以X的长度例12 计算样本函数的中心矩>> X=random('Poisson',2,100,4);>> m=moment(X,1)m =0 0 0 0>> m=moment(X,2)m =1.76042.0300 1.6336 2.3411>> m=moment(X,3)m =1.37792.5500 2.3526 2.2964百分位数及其图形描述白分位数图形可以直观观测到样本的大概中心位置和离散程度,可以对中心趋势度量和散布度量作补充说明〉〉prctile功能:计算样本的百分位数格式:y=prctile(X,p)说明:计算X中数据大于P%的值,P的取值区间为[0,100],如果X为向量,返回X中P百分位数;X为矩阵,给出一个向量;如果P为向量,则y的第i个行对应于X的p(i) 百分位数.例如>> x=(1:5)'*(1:5)2 4 6 8 103 6 9 12 154 8 12 16 205 10 15 20 25>> y=prctile(x,[25,50,75])y =1.7500 3.5000 5.2500 7.0000 8.75003.0000 6.0000 9.0000 12.0000 15.00004.2500 8.5000 12.7500 17.0000 21.2500做出相应的百分位数的图形>> boxplot(x)5列分位数构造5个盒图,见下页.相关系数corrcoef功能:相关系数格式:R=corrcoef(X)例13 合金的强度y与含碳量x的样本如下,试计算r(x,y).>> X=[41 42.5 45 45.5 45 47.5 49 51 50 55 57.5 59.5;0.1,0.11 0.12 0.13 0.14 0.15 0.16 0.17 0.18 0.20 0.22 0.24]';>> R=corrcoef(X)R =1.0000 0.98970.9897 1.0000样本峰度kurtosis功能:样本峰度格式:k=kurtosis(X)说明:峰度为单峰分布区线"峰的平坦程度"的度量,其定义为Matlab 工具箱中峰度不采用一般定义(k-3,标准正态分布的峰度为0).而是定义标准正态分布峰度为3,曲线比正态分布平坦,峰度大于3,反之,小于3.例14 计算随机样本的峰度>> X=random('F',10,20,100,4);>> k=kurtosis(X)k =6.5661 5.58516.03497.0129样本偏度skewness功能:样本偏度格式:y=skewness(X)说明:偏度是度量样本围绕其均值的对称情况.如果偏度为负,则数据分布偏向左边,反之,偏向右边.其定义为>> X=random('F',9,10,100,4);>> y=skewness(X)y =1.0934 1.55132.0522 2.9240自助法bootstrap引例:一组来自15个法律学校的学生的lsat分数和gpa进行比较的样本.> load lawdata576.0000 3.3900635.0000 3.3000558.0000 2.8100578.0000 3.0300666.0000 3.4400580.0000 3.0700555.0000 3.0000661.0000 3.4300651.0000 3.3600605.0000 3.1300653.0000 3.1200575.0000 2.7400545.0000 2.7600572.0000 2.8800594.0000 2.9600绘图,并进行曲线拟合>> plot(lsat,gpa,'+')>> lsline通过上图的拟合可以看出,lsat随着gpa增长而提高,但是我们确信此结论的程度是多少曲线只给出了直观表现,没有量的表示.计算相关系数>> y=corrcoef(lsat,gpa)y =1.0000 0.77640.7764 1.0000相关系数是0.7764,但是由于样本容量n=15比较小,我们仍然不能确定在统计上相关的显著性多大.应此,必须采用bootstrp函数对lsat和gpa样本来从新采样,并考察相关系数的变化.>> y1000=bootstrp(1000,'corrcoef',lsat,gpa);>> hist(y1000(:,2),30)绘制lsat,gpa和相关系数得直方图如下结果显示,相关系数绝大多数在区间[0.4,1]内,表明lsat分数和gpa具有确定的相关性,这样的分析,不需要对象关系数的概率分布做出很强的假设.[size=2][color=blue]第4节假设检验[/color][/size]基本概念H0:零假设,即初始判断.H1:备择假设,也称对立假设.Alpha :显著水平,在小样本的前提下,不能肯定自己的结论,所以事先约定,如果观测到的符合零假设的样本值的概率小于alpha,则拒绝零假设.典型的显著水平取alpha=0.05.如果想减少犯错误的可能,可取更小的值.P-值:在零假设为真的条件下,观测给定样本结果的概率值.如果Pmu tail=-1——x>x =[119 117 115 116 112 121 115 122 116 118 109 112 119 112 117 113 114 109 109 118];>> h=ztest(x,115,4)h =表明,接受H0,认为该种汽油的平均价格为115美分.>> [h,sig,ci]=ztest(x,115,4,0.01,0)0.8668ci =112.8461 117.4539>> [h,sig,ci]=ztest(x,115,4,0.01,1)h =0sig =0.4334ci =113.0693 Inf>> [h,sig,ci]=ztest(x,115,4,0.01,-1)h=0sig =0.5666ci =-Inf 117.2307Ttest功能:单一样本均值的t检验格式:h=ttest(x,m)h=ttest(x,m,alpha)[h,sig,ci]=ttest(x,m,alpha,tail)说明:用于正态总体标准差未知时对均值的t检验.Tail功能与ztest作用一致.>> x=random('Normal',0,1,100,1);>> [h,sig,ci]=ttest(x,0,0.01,-1)h =sig =0.0648ci =-Inf 0.0808>> [h,sig,ci]=ttest(x,0,0.001,1)h =sig =0.9352ci =-0.4542 InfSigntest功能:成对样本的符号检验格式:p=signtest(x,y,alpha)[p,h]=signtest(x,y,alpha)说明:p给出两个配对样本x和y的中位数(对于正态分布,中位数,就是平均值.相等的显著性概率.X与y的长度相等.Y也可以为标量,计算x的中位数与常数y之间差异的概率.[p,h]返回结果h.如果这样两个样本的中位数之间差几乎为0,则h=0,否则有显著差异,则h=1.>> x=[0 1 0 1 1 1 1 0 1 0];>> y=[1 1 0 0 0 0 1 1 0 0];>> [p,h]=signtest(x,y,0.05)p =0.6875h =Signrank功能:威尔科克符号秩检验格式:p=signrank(x,y,alpha)[p,h]=signrank(x,y,alpha)说明:p给出两个配对样本x和y的中位数(对于正态分布,中位数和均值等)相等的假设的显著性的概率.X与y的长度相同.[p,h]返回假设检验的结果,如果两个样本的中位数之差极护卫零,则h=0;否则,有显著差异,则h=1.>> x=random('Normal',0,1,200,1);>> y=random('Normal',0.1,2,200,1);>> [p,h]=signrank(x,y,0.05)p =0.9757h =Ranksum功能:两个总体一致性的威尔科克秩和的检验格式:p=ranksum(x,y,alpha)[p,h]=ranksum(x,y,alpha)说明:p返回两个总体样本x和y一致的显著性概率.X和y的长度可以不同.但长度长的排在前面.[p,h]返回检验结果,如果总体x和y并非明显不一致,返回h=0,否则,h=1.>> x=random('Normal',0,2,20,1);>> y=random('Normal',0.1,4,10,1);>> [p,h]=ranksum(x,y,0.05)p =0.7918h =[size=2][color=blue]第5节统计绘图[/color][/size]统计绘图就是用图形表达函数,以便直观地,充分的表现样本及其统计量的内在本质性.Box图功能:数据样本的box图格式:boxplot(X) boxplot(X,notch) boxplot(X,notch,'sym')boxplot(X,notch,'sym,vert) boxplot(X,notch,'sym',vert,whis)说明1:"盒子"的上底和下底间为四分位间距,"盒子"的上下两条线分别表示样本的25%和75%分位数."盒子"中间线为样本中位数.如果盒子中间线不在盒子中间,表示样本存在一定的篇度.虚线贯穿"盒子"上下,表示样本的其余部分(除非有野值).样本最大值为虚线顶端,样本最小值为虚线底端.用"+"表示野值."切口"是样本的置信区间,却省时,没有切口说明2:notch=0,盒子没有切口,notch=1,盒子有切口;'sym'为野值标记符号,缺省时,"+"表示.Vert=0时候,box图水平放置,vert=1时,box图垂直放置.Whis定义虚线长度为内四分位间距(IQR)的函数(缺省时为1.5*IQR),若whis=0,box图用'sym'规定的记号显示盒子外所有数据.>> x1=random('Normal',2,1,100,1);>> x2=random('Normal',1,2,100,1);>> x=[x1 x2];>> boxplot(x,1,'*',1,0)绘图结果见下页Errorbar 误差条图功能:误差条图格式:errorbar(X,Y,L,U,symbol)errorbar(X,Y,L)errorbar(Y,L)说明:误差条是距离点(X,Y)上面的长度为U(i) ,下面的长度为L(i) 的直线.X,Y,L,U的长度必须相同.Symbol为一字符串,可以规定线条类型,颜色等.>> U=ones(20,1);>> L=ones(20,1);>> errorbar(r1,r2,L,U,'+')>> r1=random('Poisson',2,10,1);>>r2=random('Poisson',10,10,1);>> U=ones(10,1);>> L=U;>> errorbar(r1,r2,L,U,'+')Lsline 绘制最小二乘拟合线功能:绘制数据的最小二乘拟合曲线格式:lslineh=lsline说明:lsline为当前坐标系中的每一个线性数据给出其最小二乘拟合线.>> y=[2 3.4 5.6 8 11 12.3 13.8 16 18.8 19.9]';>> plot(y,'+')>> lslineRefcurve 参考多项式功能:在当前图形中给出多项式拟合曲线格式:h=refcurve(p)说明:在当前图形中给出多项式p(系数向量)的曲线,n阶多项式为y=p1*x^n+p2*x^(n-1)+…+pn*x+p0则p=[p1 p2 … pn p0]>> h=[85 162 230 289 339 381 413 437 452 458 456 440 400 356];>> plot(h,'+')>> refcurve([-4.9,100,0])。

多元统计分析MATLAB

多元统计分析MATLABMATLAB是一种用于技术计算和数据可视化的高级编程语言和环境。

它提供了丰富的工具箱和函数,用于进行多元统计分析,并能够帮助用户处理和分析大规模的数据。

在MATLAB中,可以使用各种函数进行多元统计分析,包括主成分分析(PCA)、多元方差分析(MANOVA)、线性回归、多元线性回归、判别分析、聚类分析和因子分析等。

这些函数可以帮助用户处理和分析多维数据,找到关键变量,解释变量之间的关系,并从数据中提取有用的信息。

主成分分析(PCA)是一种常用的多元统计分析方法,可用于降维和特征提取。

PCA可以将原始数据转化为一组新的无关变量,称为主成分,这些主成分是原始数据中方差最大的方向。

通过PCA,可以减少数据的维度,并可视化数据的分布和模式。

多元方差分析(MANOVA)是一种常用的多元统计分析方法,可用于比较两个或多个组别之间的差异。

MANOVA可以同时考虑多个因变量,并判断它们之间的差异是否显著。

它可以帮助我们理解多个因变量与一个或多个自变量之间的关系。

线性回归和多元线性回归是常见的用于建立因变量与自变量之间关系的统计方法。

MATLAB提供了强大的线性回归函数,可以帮助用户拟合线性模型,并评估模型的拟合优度。

判别分析是一种分类方法,可用于将观测对象分为不同的组别。

MATLAB中提供了各种判别分析函数,可用于建立分类模型,并预测新的观测对象所属的组别。

聚类分析是一种无监督学习方法,可用于将观测对象划分为相似的组别。

MATLAB中提供了各种聚类分析函数,如k-means和层次聚类,可用于对数据进行聚类,并将相似的观测对象放在一起。

因子分析是一种用于确定观测变量之间的潜在结构的统计方法。

MATLAB中提供了因子分析函数,可用于提取主成分和因子,并解释观测变量之间的关系。

综上所述,MATLAB提供了丰富的工具和函数,可用于进行多元统计分析。

这些方法可以帮助用户处理和分析大规模的数据,找到关键变量,解释变量之间的关系,并从数据中提取有用的信息。

如何在Matlab中进行模糊聚类分析

如何在Matlab中进行模糊聚类分析在数据分析领域,模糊聚类分析是一种常用的技术,它可以应用于各种领域的数据处理和模式识别问题。

而Matlab作为一种功能强大的数据分析工具,也提供了丰富的函数和工具箱,以支持模糊聚类分析的实施。

1. 引言模糊聚类分析是一种基于模糊集理论的聚类方法,与传统的硬聚类方法不同,它允许样本属于多个聚类中心。

这种方法的优势在于可以更好地应对数据中的不确定性和复杂性,对于某些模糊或模糊边界问题具有更好的解释能力。

2. 模糊聚类算法概述Matlab提供了多种模糊聚类算法的实现,其中最常用的是基于模糊C均值(Fuzzy C-Means,FCM)算法。

FCM算法的基本思想是通过最小化聚类后的模糊划分矩阵与原始数据之间的距离来确定每个样本所属的聚类中心。

3. 数据预处理与特征提取在进行模糊聚类分析之前,需要对原始数据进行预处理和特征提取。

预处理包括数据清洗、缺失值处理和异常值处理等;特征提取则是从原始数据中抽取出具有代表性和区分性的特征,用于模糊聚类分析。

4. 模糊聚类分析步骤在Matlab中,进行模糊聚类分析通常包括以下步骤:(1) 初始化聚类中心:通过随机选择或基于某种准则的方法初始化聚类中心。

(2) 计算模糊划分矩阵:根据当前的聚类中心,计算每个样本属于各个聚类中心的隶属度。

(3) 更新聚类中心:根据当前的模糊划分矩阵,更新聚类中心的位置。

(4) 判断终止条件:通过设置一定的终止条件,判断是否达到停止迭代的条件。

(5) 输出最终结果:得到最终的聚类结果和每个样本所属的隶属度。

5. 模糊聚类结果评估在进行模糊聚类分析后,需要对聚类结果进行评估以验证其有效性和可解释性。

常用的评估指标包括模糊划分矩阵的聚类有效性指标、外部指标和内部指标等。

通过这些指标的比较和分析,可以选择合适的模糊聚类算法和参数设置。

6. 模糊聚类的应用模糊聚类分析在诸多领域中都有广泛的应用。

例如,在图像处理中,可以利用模糊聚类方法对图像进行分割和识别;在生物信息学中,可以应用于基因表达数据的分类和模式识别等。

用matlab做聚类分析

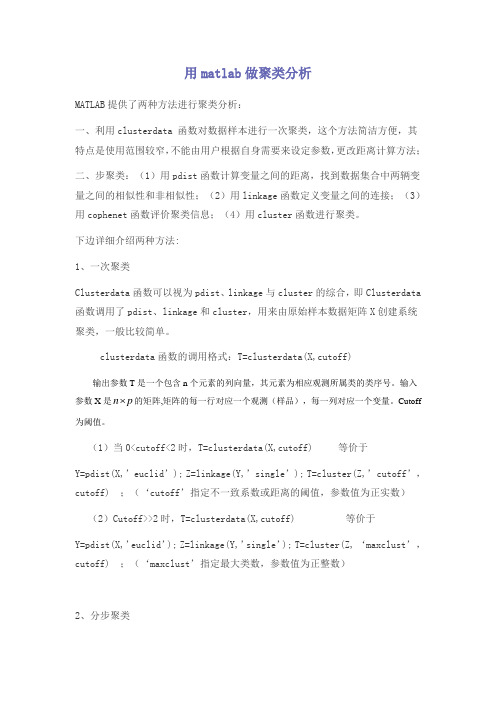

用matlab做聚类分析MATLAB提供了两种方法进行聚类分析:一、利用clusterdata 函数对数据样本进行一次聚类,这个方法简洁方便,其特点是使用范围较窄,不能由用户根据自身需要来设定参数,更改距离计算方法;二、步聚类:(1)用pdist函数计算变量之间的距离,找到数据集合中两辆变量之间的相似性和非相似性;(2)用linkage函数定义变量之间的连接;(3)用cophenet函数评价聚类信息;(4)用cluster函数进行聚类。

下边详细介绍两种方法:1、一次聚类Clusterdata函数可以视为pdist、linkage与cluster的综合,即Clusterdata函数调用了pdist、linkage和cluster,用来由原始样本数据矩阵X创建系统聚类,一般比较简单。

clusterdata函数的调用格式:T=clusterdata(X,cutoff)输出参数T是一个包含n个元素的列向量,其元素为相应观测所属类的类序号。

输入 的矩阵,矩阵的每一行对应一个观测(样品),每一列对应一个变量。

Cutoff 参数X是n p为阈值。

(1)当0<cutoff<2时,T=clusterdata(X,cutoff) 等价于Y=pdist(X,’euclid’); Z=linkage(Y,’single’); T=cluster(Z,’cutoff’,cutoff) ;(‘cutoff’指定不一致系数或距离的阈值,参数值为正实数)(2)Cutoff>>2时,T=clusterdata(X,cutoff) 等价于Y=pdist(X,’euclid’); Z=linkage(Y,’single’); T=cluster(Z, ‘maxclust’,cutoff) ;(‘maxclust’指定最大类数,参数值为正整数)2、分步聚类(1)求出变量之间的相似性用pdist函数计算出相似矩阵,有多种方法可以求距离,若此前数据还未无量纲化,则可用zscore函数对其标准化【pdist函数:调用格式:Y=pdist(X,’metric’)说明:X是M*N矩阵,为由M个样本组成,每个样本有N个字段的数据集‘seuclidean’:metirc取值为:’euclidean’:欧氏距离(默认)标准化欧氏距离;‘mahalanobis’:马氏距离;闵科夫斯基距离:‘ minkowski’;绝对值距离:‘ cityblock’…】pdist生成一个M*(M-1)/2个元素的行向量,分别表示M个样本两两间的距离。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

MATLAB的统计工具箱中的多元统计分析中提供了聚类分析的两种方法:1.层次聚类hierarchical clustering2.k-means聚类这里用最简单的实例说明以下层次聚类原理和应用发法。

层次聚类是基于距离的聚类方法,MATLAB中通过pdist、linkage、dendrogram、cluster等函数来完成。

层次聚类的过程可以分这么几步:(1) 确定对象(实际上就是数据集中的每个数据点)之间的相似性,实际上就是定义一个表征对象之间差异的距离,例如最简单的平面上点的聚类中,最经常使用的就是欧几里得距离。

这在MATLAB中可以通过Y=pdist(X)实现,例如>> X=randn(6,2)X =-0.4326 1.1892-1.6656 -0.03760.1253 0.32730.2877 0.1746-1.1465 -0.18671.1909 0.7258>> plot(X(:,1),X(:,2),'bo') %给个图,将来对照聚类结果把>> Y=pdist(X)Y =Columns 1 through 141.7394 1.0267 1.2442 1.5501 1.6883 1.8277 1.9648 0.54012.9568 0.2228 1.3717 1.1377 1.4790 1.0581Column 152.5092例子中X数据集可以看作包含6个平面数据点,pdist之后的Y是一个行向量,15个元素分别代表X 的第1点与2-6点、第2点与3-6点,......这样的距离。

那么对于M个点的数据集X,pdist之后的Y 将是具有M*(M-1)/2个元素的行向量。

Y这样的显示虽然节省了内存空间,但对用户来说不是很易懂,如果需要对这些距离进行特定操作的话,也不太好索引。

MATLAB中可以用squareform把Y转换成方阵形式,方阵中<i,j>位置的数值就是X中第i和第j点之间的距离,显然这个方阵应该是个对角元素为0的对称阵。

>> squareform(Y)ans =0 1.7394 1.0267 1.2442 1.5501 1.68831.7394 0 1.8277 1.9648 0.54012.95681.0267 1.8277 0 0.2228 1.3717 1.13771.2442 1.9648 0.2228 0 1.4790 1.05811.5501 0.5401 1.3717 1.4790 02.50921.68832.9568 1.1377 1.0581 2.5092 0这里需要注意的是,pdist可以使用多种参数,指定不同的距离算法。

help pdist把。

另外,当数据规模很大时,可以想象pdist产生的Y占用内存将是很吓人的,比如X有10k个数据点,那么X占10k*8*2Bytes=160K,这看起来不算啥,但是pdist后的Y会有10k*10k/2*8Bytes=400M 。

怕了把,所以,废话说在前面,用MATLAB的层次聚类来处理大规模数据,大概是很不合适的。

(2) 确定好了对象间的差异度(距离)后,就可以用Z=linkage(Y)来产生层次聚类树了。

>> Z=linkage(Y)Z =3.00004.0000 0.22282.0000 5.0000 0.54011.0000 7.0000 1.02676.0000 9.0000 1.05818.0000 10.0000 1.3717对于M个元素的X,前面说了Y是1行M*(M-1)/2的行向量,Z则是(M-1)*3的矩阵。

Z数组的前两列是索引下标列,最后一列是距离列。

例如上例中表示在产生聚类树的计算过程中,第3和第4点先聚成一类,他们之间的距离是0.2228,以此类推。

要注意的是,为了标记每一个节点,需要给新产生的聚类也安排一个标识,MATLAB中会将新产生的聚类依次用M+1,M+2,....依次来标识。

比如第3和第4点聚成的类以后就用7来标识,第2和第5点聚成的类用8来标识,依次类推。

通过linkage函数计算之后,实际上二叉树式的聚类已经完成了。

Z这个数据数组不太好看,可以用dendrogram(Z)来可视化聚类树。

可以看到,产生的聚类树的每一层都是一个倒置的U型(或者说是个n型,~~),纵轴高度代表了当前聚类中两个子节点之间的距离。

横轴上标记出了各个数据点索引下标。

稍微注意以下的是,dendrogram默认最多画30个最底层节点,当然可是设置参数改变这个限制,比如dendrogram(Z,0)就会把所有数据点索引下标都标出来,但对于成千上万的数据集合,这样的结果必然是图形下方非常拥挤。

看你的应用目的了,随你玩~(3)初步的聚类树画完后,还要做很多后期工作的,包括这样的聚类是不是可靠,是不是代表了实际的对象分化模式,对于具体的应用,应该怎样认识这个完全版的聚类树,产生具有较少分叉的可供决策参考的分类结果呢?这都是需要考虑的。

MATLAB中提供了cluster, clusterdata, cophenet, inconsistent等相关函数。

cluster用于剪裁完全版的聚类树,产生具有一定cutoff的可用于参考的树。

clusterdata可以认为是pdist,linkage,cluster的综合,当然更简易一点。

cophenet和inconsistent用来计算某些系数,前者用于检验一定算法下产生的二叉聚类树和实际情况的相符程度(就是检测二叉聚类树中各元素间的距离和pdist计算产生的实际的距离之间有多大的相关性),inconsistent则是量化某个层次的聚类上的节点间的差异性(可用于作为cluster的剪裁标准)。

后面这些的理解,大概需要对聚类有一个更深刻更数学的认识,我也不是很清楚,就不多说了。

from /coralliu/blog/item/dbde033b168fedeb15cecbe5.htmlMATLAB提供了两种方法进行聚类分析:1、利用clusterdata 函数对数据样本进行一次聚类,这个方法简洁方便,其特点是使用范围较窄,不能由用户根据自身需要来设定参数,更改距离计算方法;2、分步聚类:(1)用pdist函数计算变量之间的距离,找到数据集合中两辆变量之间的相似性和非相似性;(2)用linkage函数定义变量之间的连接;(3)用cophenetic函数评价聚类信息;(4)用cluster函数进行聚类。

下边详细介绍两种方法:1、一次聚类Clusterdata函数可以视为pdist、linkage与cluster的综合,一般比较简单。

【clusterdata函数:调用格式:T=clusterdata(X,cutoff)等价于Y=pdist(X,’euclid’); Z=linkage(Y,’single’); T=cluster(Z,cutoff) 】2、分步聚类(1)求出变量之间的相似性用pdist函数计算出相似矩阵,有多种方法可以求距离,若此前数据还未无量纲化,则可用zscore函数对其标准化【pdist函数:调用格式:Y=pdist(X,’metric’)说明:X是M*N矩阵,为由M个样本组成,每个样本有N个字段的数据集metirc取值为:’euclidean’:欧氏距离(默认)‘seuclidean’:标准化欧氏距离;‘mahalanobis’:马氏距离… 】pdist生成一个M*(M-1)/2个元素的行向量,分别表示M个样本两两间的距离。

这样可以缩小保存空间,不过,对于读者来说却是不好操作,因此,若想简单直观的表示,可以用squareform函数将其转化为方阵,其中x(i,j)表示第i个样本与第j个样本之的距离,对角线均为0.(2)用linkage函数来产生聚类树【linkage函数:调用格式:Z=l inkage(Y,’method’)说明:Y为pdist函数返回的M*(M-1)/2个元素的行向量,method可取值:‘single’:最短距离法(默认);’complete’:最长距离法;‘average’:未加权平均距离法;’weighted’:加权平均法‘centroid’:质心距离法;‘median’:加权质心距离法;‘ward’:内平方距离法(最小方差算法)】返回的Z为一个(M-1)*3的矩阵,其中前两列为索引标识,表示哪两个序号的样本可以聚为同一类,第三列为这两个样本之间的距离。

另外,除了M个样本以外,对于每次新产生的类,依次用M+1、M+2、…来标识。

为了表示Z矩阵,我们可以用更直观的聚类数来展示,方法为:dendrogram(Z), 产生的聚类数是一个n型树,最下边表示样本,然后一级一级往上聚类,最终成为最顶端的一类。

纵轴高度代表距离列。

另外,还可以设置聚类数最下端的样本数,默认为30,可以根据修改dendrogram(Z,n)参数n来实现,1<n<M。

dendrogram(Z,0)则表n=M的情况,显示所有叶节点。

(3)用cophenetic函数评价聚类信息【cophenet函数: 调用格式:c=cophenetic(Z,Y)说明:利用pdist函数生成的Y和linkage函数生成的Z计算cophenet相关系数。

】cophene检验一定算法下产生的二叉聚类树和实际情况的相符程度,就是检测二叉聚类树中各元素间的距离和pdist计算产生的实际的距离之间有多大的相关性,另外也可以用inconsistent表示量化某个层次的聚类上的节点间的差异性。

(4)最后,用cluster进行聚类,返回聚类列。