融合语音信号和脑电信号的多模态情感识别

《基于多模态生理信号的情感识别研究》范文

《基于多模态生理信号的情感识别研究》篇一一、引言随着人工智能的飞速发展,情感识别成为了计算机科学与心理学等交叉学科的研究热点。

在许多领域中,如社交机器人、智能医疗、智能驾驶等,对人的情感状态进行准确识别具有极其重要的意义。

多模态生理信号因其能反映人的内心情感状态,成为了情感识别领域的重要研究内容。

本文旨在探讨基于多模态生理信号的情感识别研究,以期为相关领域的研究与应用提供参考。

二、多模态生理信号概述多模态生理信号是指通过多种生理传感器获取的,反映人体生理状态的信息。

这些信息包括但不限于脑电波、心电信号、皮肤电导、呼吸频率等。

这些生理信号能够反映人的情绪状态,如兴奋、焦虑、平静等。

因此,通过对多模态生理信号的采集与分析,可以有效地识别人的情感状态。

三、多模态生理信号在情感识别中的应用多模态生理信号在情感识别中具有重要应用价值。

通过将不同模态的生理信号进行融合分析,可以提高情感识别的准确性与稳定性。

目前,基于多模态生理信号的情感识别研究主要采用以下方法:1. 信号预处理:对采集到的多模态生理信号进行预处理,如滤波、去噪等,以提高信号质量。

2. 特征提取:从预处理后的生理信号中提取与情感相关的特征,如脑电波的频率、心电信号的幅度等。

3. 模式识别:采用机器学习、深度学习等技术对提取的特征进行分类与识别,从而实现情感识别。

4. 情感模型构建:根据不同情感模型的需求,将多模态生理信号与其他信息(如语音、文本等)进行融合,构建更加完善的情感模型。

四、研究现状与挑战目前,基于多模态生理信号的情感识别研究已经取得了一定的成果。

然而,仍存在一些挑战与问题需要解决:1. 数据获取与处理:多模态生理信号的采集与处理需要专业的设备与技术支持,且数据质量对情感识别的准确性与稳定性具有重要影响。

因此,如何获取高质量的多模态生理信号成为了研究的重点。

2. 特征提取与选择:从多模态生理信号中提取与情感相关的特征是一项复杂而关键的任务。

《基于多模态生理信号的情感识别研究》范文

《基于多模态生理信号的情感识别研究》篇一一、引言情感识别作为人工智能领域的重要研究方向,对于人机交互、智能医疗、心理健康等领域具有广泛的应用前景。

随着传感器技术的不断发展,多模态生理信号的获取成为可能,为情感识别提供了新的研究途径。

本文旨在探讨基于多模态生理信号的情感识别研究,通过对相关领域的研究现状进行综述,分析现有研究的不足,并提出本文的研究问题、方法和贡献。

二、文献综述情感识别研究已经取得了显著的进展,但大多数研究主要关注于面部表情、语音等单一模态信息的分析。

然而,人的情感表达是复杂的,单一模态的信息往往无法全面反映一个人的真实情感。

近年来,多模态生理信号在情感识别中的应用逐渐受到关注。

多模态生理信号包括脑电波、心电信号、皮肤电导反应等多种生理信号,能够从多个角度反映人的情感状态。

当前的研究主要利用这些生理信号提取特征,并通过机器学习算法进行情感分类。

然而,现有研究仍存在一些问题。

首先,不同生理信号之间的融合方法有待进一步研究。

其次,现有研究的样本数据往往来源于特定场景,缺乏通用性。

最后,对于多模态生理信号与情感之间的关联机制仍需深入探讨。

三、研究问题与方法本文针对上述问题,提出基于多模态生理信号的情感识别研究。

首先,我们将研究不同生理信号之间的融合方法,以提取更全面的情感特征。

其次,我们将通过收集不同场景下的多模态生理信号数据,建立具有通用性的情感识别模型。

最后,我们将探讨多模态生理信号与情感之间的关联机制,为情感识别的深入研究提供理论依据。

研究方法上,我们将采用信号处理技术提取生理信号特征,利用机器学习算法进行情感分类,并通过交叉验证等方法评估模型的性能。

此外,我们还将运用统计学方法分析多模态生理信号与情感之间的关联。

四、研究贡献本文的研究将为情感识别提供新的研究途径,有助于提高情感识别的准确性和可靠性。

同时,本研究将促进多模态生理信号在人工智能、智能医疗、心理健康等领域的应用,为相关领域的发展提供有力支持。

基于深度学习的多模态脑电信号情感识别

基于深度学习的多模态脑电信号情感识别基于深度学习的多模态脑电信号情感识别随着人工智能技术的不断发展,情感识别在生活中的应用越来越广泛。

尤其是基于深度学习的多模态脑电信号情感识别技术的出现,为我们理解人类情感认知提供了新的途径。

本文将介绍基于深度学习的多模态脑电信号情感识别的原理、方法和应用。

首先,我们需要了解什么是脑电信号。

脑电信号是指人脑神经元活动产生的微弱电信号。

它可以通过将电极放置在头皮表面来测量。

脑电信号的波形和频谱反映了人的认知和情感状态。

情感识别是指通过分析脑电信号的特征来判断人的情感状态,如愤怒、快乐、厌恶等。

传统的脑电信号情感识别方法主要是基于人工设计的特征提取和分类算法。

这种方法需要对脑电信号进行预处理、特征提取和分类,过程繁琐且依赖于专业知识。

而基于深度学习的多模态脑电信号情感识别技术可以通过自动学习脑电信号的特征和情感之间的关系,实现自动化的情感识别。

多模态脑电信号情感识别是指将脑电信号与其他模态数据(如面部表情、心率、声音等)相结合,通过多模态数据的融合来提高情感识别的准确性和鲁棒性。

在多模态数据融合的过程中,深度学习模型可以学习到不同模态数据之间的复杂关系,从而提高情感识别的性能。

多模态脑电信号情感识别的关键是如何将脑电信号与其他模态数据相融合。

一种常用的方法是使用卷积神经网络(CNN)或循环神经网络(RNN)对脑电信号进行特征提取,然后将其他模态数据与脑电信号的特征进行融合,在进行情感识别任务。

深度学习模型可以从大量的数据中学习到融合过程中不同模态数据的权重分配,从而提高情感识别的准确性。

多模态脑电信号情感识别技术在许多领域都有广泛的应用。

例如,它可以用于情感监测系统,帮助人们识别他人的情感状态,从而更好地与人进行交流。

此外,它还可以用于心理健康辅助诊断系统,帮助心理医生更好地了解患者的情感状态,为患者提供更准确的治疗方案。

此外,多模态脑电信号情感识别还可以应用于虚拟现实游戏和教育系统,使其能够根据用户的情感状态实时调整内容和难度。

《基于脑电和语音多模态特征的抑郁症多分类识别研究》范文

《基于脑电和语音多模态特征的抑郁症多分类识别研究》篇一一、引言抑郁症作为现代生活中一种常见的心理健康问题,给个人及社会带来了极大的影响。

针对抑郁症的诊断,通常依赖专业医师的诊断和心理测量表等手段,然而这些方法存在效率低、主观性强等局限性。

因此,基于现代技术的抑郁症识别研究成为了研究热点。

本文旨在探讨基于脑电和语音多模态特征的抑郁症多分类识别研究,为抑郁症的早期发现和诊断提供新的途径。

二、研究背景及意义近年来,随着多模态技术的发展,结合多种生物信号特征的抑郁症识别研究日益增多。

其中,脑电信号和语音信号因其易于获取且富含信息,被广泛应用于抑郁症的研究中。

脑电信号反映了大脑的电生理活动,语音信号则体现了情感状态的变化。

通过融合这两种多模态特征,可以有效提高抑郁症识别的准确性和稳定性。

三、研究方法本研究首先通过采集受试者的脑电和语音数据,提取多模态特征。

在脑电数据中,主要关注各脑区的频带特征、事件相关电位等;在语音数据中,提取语调、音强等特征。

随后,利用机器学习算法和深度学习模型对提取的特征进行分类和识别。

在模型训练过程中,通过交叉验证等方法优化模型参数,提高模型的泛化能力。

四、实验设计与数据采集实验对象为患有不同严重程度抑郁症的受试者以及健康对照组。

在实验过程中,使用专业的脑电采集设备和录音设备获取受试者的脑电和语音数据。

同时,结合临床诊断结果和心理测量表得分等信息,对受试者进行分类。

五、特征提取与模型构建在特征提取阶段,对脑电数据进行频谱分析、事件相关电位分析等处理,提取出与抑郁症相关的特征;对语音数据进行声学特征分析、情感特征提取等处理。

随后,构建基于机器学习和深度学习的分类模型。

在模型构建过程中,采用多种算法进行对比分析,如支持向量机、随机森林、卷积神经网络等。

六、实验结果与分析通过实验数据的分析和处理,我们得到了基于脑电和语音多模态特征的抑郁症多分类识别结果。

实验结果表明,多模态特征融合的方法可以有效提高抑郁症识别的准确率。

基于语音和文本的双模态情感识别综述

基于语音和文本的双模态情感识别综述在人工智能的广阔天地中,双模态情感识别技术如同一位敏锐的心理分析师,通过捕捉细微的语音波动和文字线索,解读人类复杂的情感世界。

这项技术结合了语音和文本两种信息源,旨在更准确地理解和识别人们的情绪状态。

它的重要性不言而喻,因为情感是人类交流的核心,影响着我们的决策、社交互动乃至心理健康。

双模态情感识别技术的工作原理可以比作一部精密的交响乐章。

首先,它通过麦克风等设备捕捉语音信号,这些信号如同乐章中的音符,蕴含着丰富的情感信息。

接着,它利用自然语言处理技术分析文本内容,就如同解读乐章中的旋律和和声。

最后,这两种信息源被巧妙地融合在一起,形成对个体情感状态的全面判断。

与传统的单模态情感识别相比,双模态技术具有显著的优势。

它能够提供更全面的信息,减少误解和误判的可能性。

例如,一个人可能在电话中用平静的语气说出“我很好”,但他的文本消息却透露出疲惫和压力。

双模态技术能够捕捉到这种矛盾,从而更准确地理解他的真实情绪。

然而,双模态情感识别技术也面临着挑战。

其中之一就是如何确保数据的准确性和可靠性。

语音和文本数据可能受到各种因素的影响,如噪音、口音、方言或拼写错误等。

此外,个体差异也是一个不容忽视的因素。

每个人的情感表达方式都是独特的,这使得建立通用的情感识别模型变得更加困难。

展望未来,双模态情感识别技术的发展潜力巨大。

随着深度学习等先进技术的应用,我们可以期待更精确、更智能的情感识别系统出现。

这些系统将能够更好地适应个体差异,甚至能够实时监测和响应用户的情感变化。

这将为心理健康监测、客户服务优化等领域带来革命性的变革。

综上所述,基于语音和文本的双模态情感识别技术是一项令人兴奋的进步,它为我们提供了一种全新的视角来理解和互动人类的情感世界。

尽管面临挑战,但随着技术的不断进步和应用的拓展,我们有理由相信,这一领域将迎来更加辉煌的未来。

融合语音信号和脑电信号的多模态情感识别

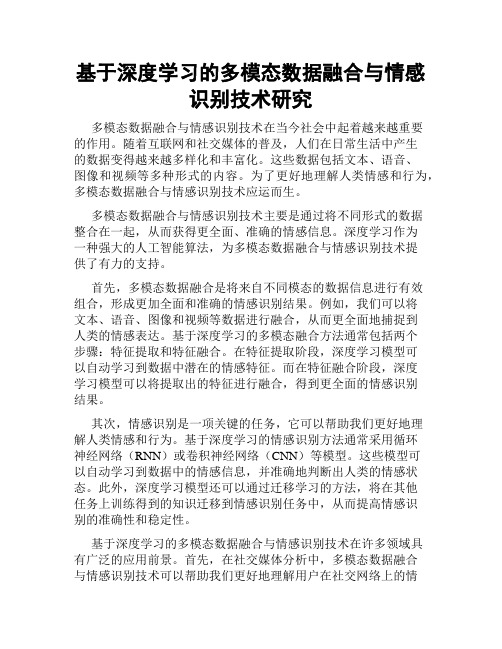

收稿日期:2018G05G29㊀㊀㊀㊀网络出版时间:2018G07G27基金项目:国家自然科学基金(61371193);山西省青年科技研究基金(2013021016G2)作者简介:马江河(1992-),男,太原理工大学硕士研究生,E Gm a l i :1360370562@q q.c o m 通信作者:孙㊀颖(1981-),女,博士,讲师,E Gm a l i :t y u t s y @163.c o m.网络出版地址:h t t p://k n s .c n k i .n e t /k c m s /d e t a i l /61.1076.T N.20180726.1012.004.h t m l d o i 10敭19665 j敭i s s n 1001G2400敭2019敭01敭023融合语音信号和脑电信号的多模态情感识别马江河,孙㊀颖,张雪英(太原理工大学信息与计算机学院,山西太原030024)摘要:为构造有效的情感识别系统,通过声音刺激分别诱发出高兴㊁悲伤㊁生气以及中性4种情感,并采集相应的语音信号和脑电信号.首先,利用相空间重构技术提取脑电信号和语音信号的非线性几何特征和非线性属性特征,并结合两者的基本特征分别实现情感识别;然后,通过构建基于限制玻尔兹曼机的特征融合算法,从特征层融合的角度实现多模态情感识别;最后,利用二次决策算法从决策融合的角度构建多模态情感识别系统.实验结果显示,从特征融合的角度构建的多模态情感识别系统相比语音信号和脑电信号情感整体识别率,分别提高1.08%和2.75%;从决策融合的角度构建的多模态情感识别系统相比语音信号和脑电信号情感整体识别率,分别提高6.52%和8.19%;决策融合相比特征融合构建的多模态情感识别系统整体识别效果更优.因此,融合语音信号和脑电信号等不同来源的情感数据可以构造出更有效的情感识别系统.关键词:语音信号;脑电信号;特征融合;决策融合中图分类号:T P 391.4㊀㊀文献标识码:A㊀㊀文章编号:1001G2400(2019)01G0143G08M u l t i m o d a l e m o t i o n r e c o g n i t i o n f o r t h e f u s i o no f s p e e c ha n dE E Gs i gn a l s MAJ i a n g h e S U N Y i n g Z HA N G X u e y i n g C o l l e g e o f I n f o r m a t i o na n dC o m p u t e r T a i y u a nU n i v e r s i t y o fT e c h n o l o g y T a i yu a n030024 C h i n a A b s t r a c t ㊀T o c o n s t r u c t a ne f f e c t i v e e m o t i o nr e c o g n i t i o ns y s t e m t h e e m o t i o n so f j o y s a d n e s s a n g e r a n d n e u t r a l i t y a r e i n d u c e db y s o u n ds t i m u l a t i o n a n dt h ec o r r e s p o n d i n g s p e e c ha n dE E Gs i gn a l sa r ec o l l e c t e d 敭F i r s t t h i s p a p e r e x t r a c t s t h en o n l i n e a r g e o m e t r i c f e a t u r e a n dn o n l i n e a r a t t r i b u t e f e a t u r e o fE E Ga n d s p e e c h s i g n a l sb yp h a s e s p a c e r e c o n s t r u c t i o n r e s p e c t i v e l y a n d t h e e m o t i o n r e c o g n i t i o n i s r e a l i z e db y c o m b i n i n g th e b a s i c f e a t u r e s 敭T h e n a f e a t u r e f u s i o na l g o r i t h mb a s e do n t h eR e s t r i c t e dB o l t z m a n n M a c h i n e i s c o n s t r u c t e d t o r e a l i z e m u l t i m o d a le m o t i o nr e c o g n i t i o nf r o m t h e p e r s p e c t i v eo ff e a t u r ef u s i o n 敭F i n a l l ya m u l t i m o d a l e m o t i o nr e c o g n i t i o n s y s t e mi s c o n s t r u c t e d t h r o u g hd e c i s i o n f u s i o nb y u s i n g t h e q u a d r a t icde c i s i o n a l g o r i t h m敭T h e r e s u l t s s h o wt h a t t h e o v e r a l l r e c o g n i t i o n r a t e of t h em u l t i m o d a l e m o t i o n r e c og n i t i o n s y s t e mc o n s t r u c t e d b y f e a t u r ef u s i o ni s1敭08%a n d2敭75%hi g h e rt h a nt h a to fs p e e c hs i g n a l sa n dt h a to f E E G s i gn a l s r e s p e c t i v e l y a n d t h a t t h e o v e r a l l r e c o g n i t i o n r a t e o f t h em u l t i m o d a l e m o t i o n r e c o g n i t i o n s y s t e mc o n s t r u c t e d b y d e c i s i o nf u s i o ni s6敭52%a n d8敭19%h i g h e rt h a nt h a to fs p e e c hs i g n a l sa n dt h a to fE E G s i gn a l s r e s p e c t i v e l y 敭T h e o v e r a l l r e c o g n i t i o ne f f e c t o f t h em u l t i m o d a l e m o t i o n r e c o g n i t i o ns ys t e mb a s e do nd e c i s i o n f u s i o n i sb e t t e r t h a n t h a t o f f e a t u r e f u s i o n 敭A m o r e e f f e c t i v e e m o t i o n r e c o g n i t i o n s y s t e mc a nb e c o n s t r u c t e d b y c o m b i n i n g t h e e m o t i o n a l d a t a o f d i f f e r e n t c h a n n e l s s u c ha s s p e e c hs i g n a l s a n dE E Gs i g n a l s 敭K e y W o r d s ㊀s p e e c hs i g n a l s e l e c t r o e n c e p h a l o Gg r a p hs i g n a l s f e a t u r e f u s i o n d e c i s i o n f u s i o n 情感识别作为模式识别的重要研究领域,是实现自然人机交互的关键技术之一[1].目前单一地通过语音信号㊁心电信号㊁人脸表情以及其他生理信号获得人类情感状态的研究已经取得了一定的进展.但是,当2019年2月第46卷㊀第1期㊀西安电子科技大学学报J O UR N A L ㊀O F ㊀X I D I A N ㊀U N I V E R S I T Y ㊀F e b .2019V o l .46㊀N o .1h t t p ://j o u r n a l .x i d i a n .e d u .c n /x d x b人类主观上对情感信号加以掩饰或者单一通道的情感信号受到其他信号的影响时,情感识别性能将会明显下降.因此,构建多模态情感识别系统是提高情感识别性能和系统鲁棒性的有效手段之一.目前,多模态情感研究已经成为情感识别领域的关键技术,文献[2]通过特征融合和决策融合算法实现了语音信号和心电信号的多模态情感识别.文献[3]结合语音信号与人脸表情验证了多模态情感识别系统的有效性,识别率可达97%以上.文献[4]基于脸部表情和脑电(E l e c t r o E n c e p h a l o GG r a p h ,E E G )信号验证了多模态信号相对单模态信号情感识别性能的优越性.语音信号是人类交流最有效的工具,通过语速㊁音调等信息可以直观地表达情感状态的外部信息,而对于表达障碍的人来讲,脑电信号可以充分反映人的生理和心理变化,可作为反映人类情感状态的内部信息.因此,内外情感信息的结合可以构造出更有效的情感识别系统.文献[5]通过结合脑电信号和语音信号构造出多模态情感识别系统,并通过实验验证了该系统的可行性,但在多模态信号的特征提取中,只提取了表征情感信息的基本特征,并未充分考虑语音信号和脑电信号的非线性特性,而研究表明,语音信号和脑电信号的非线性特征可以作为表征情感差异度的有效信息[6G7].基于以上问题,笔者选取了脑电信号和语音信号为研究对象,首先,提取了两者的基本特征和非线性全局特征(非线性属性特征+非线性几何特征)作为情感特征;然后,采用基于限制玻尔兹曼机(R e s t r i c t e dB o l t z m a n n M a c h i n e ,R B M )的特征融合的算法,从特征融合的角度实现多模态情感识别;最后,采用二次决策融合算法从决策融合的角度构建多模态情感识别系统,通过与单模态情感识别结果的对比,验证了文中所采用融合算法的有效性.综上得知,语音信号与脑电信号相结合可以提高情感识别系统的识别率和鲁棒性,可构造出更可靠的情感识别系统.1㊀情感信号的特征提取1.1㊀情感信号非线性几何特征提取㊀㊀针对语音信号和脑电信号的非线性特性,首先从几何结构上提取了刻画语音信号和脑电信号非线性几何特性的情感特征,采用相空间重构技术[8]将一维时间序列映射到高维空间,利用文献[9]提出的嵌入定理,对一维时间序列x (t )选取合适的延迟时间τ和嵌入维数m 来构造相空间矢量X =(x (t ),x (t +τ), ,x (t +(m -1)τ)),将相空间重构下基于轨迹的描述轮廓的3种非线性几何特征作为情感特征,图1为脑电信号和语音信号中性情感时域波形以及其所对应的相空间重构图.图1㊀脑电信号和语音信号中性情感时域波形以及其所对应的相空间重构图这里选定m =3,语音信号和脑电信号的延迟时间τ分别为1和4.首先将原始波形与之后的两个样本存在的下述关系定义为标识线,即x (t )=x (t +τ)=x (t +2τ)㊀.(1)提取语音信号和脑电信号不同情感状态下相空间重构的非线性几何特征,3种基于轨迹的描述符轮廓441㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀西安电子科技大学学报㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀第46卷h t t p ://j o u r n a l .x i d i a n .e d u .c n /x d x b如下所示:(1)第1轮廓:吸引子到圆心的距离可表示为 α=α1,α2,K ,αn []㊀,其中,αi =(a 2i +(a i +τi )2+(a i +2τi )2)1/2㊀.(2)(2)第2轮廓:吸引子到标识线的距离可表示为 d =[d 1,d 2, ,d n ]㊀,其中,d i =(1,1,1) (a i ,a i +τi ,a i +2τi )31/2㊀.(3)(3)第3轮廓:吸引子连续轨迹到圆心距离的总长度可表示为s =ðn i =1αi ㊀,(4)其中,n 表示吸引子的数目,吸引子a i =(a i ,a i +τi ,a i +2τi ),0ɤi ɤn .1.2㊀情感信号非线性属性特征提取情感信号的几何特性和属性特性均可以表征情感差异度信息,因此,结合情感信号的非线性属性特征和非线性几何特征可以更完整地表达情感信号的非线性特性.针对语音信号和脑电信号的非线性属性特性,分别提取了两者的H u r s t 指数和L y a p u n o v 指数两种非线性属性特征,其中,H u r s t 指数[10]用来衡量语音信号和脑电信号的时间序列的长期记忆性;最大L y a p u n o v 指数[11]可以反映相邻轨道的局部收敛或者发散程度的快慢.笔者采用W o l f [12]方法求得最大L y a p u n o v 指数.两者分别从不同方面对脑电信号进行非线性属性特性描述.而在脑电信号的特征提取中,近似熵[13]可作为衡量时间序列中的新信息发生率的有效方法.因此,同时提取的脑电信号的近似熵可作为其非线性属性特征.此外,提取语音信号声学特征以及脑电信号的功率谱熵作为两者的基本特征.表1为文中所提取的情感特征的维数统计,其中提取被试者12导脑电数据的脑电特征作为情感特征.表1㊀多模态情感特征维数统计情感信号特征类型维数统计特征语音信号基本特征1~98语速㊁平均过零率㊁能量㊁基频及共振峰㊁M F C C 非线性几何特征99~135吸引子到圆心和标识线距离㊁吸引子连续轨迹到圆心距离的总长度非线性属性特征136~140H u r s t ㊁最大L y a p u n o v 指数脑电信号基本特征141~152功率谱熵非线性几何特征153~596吸引子到圆心和标识线距离㊁吸引子连续轨迹到圆心距离的总长度非线性属性特征597~668H u r s t ㊁最大L y a p u n o v 指数㊁近似熵2㊀多模态情感融合算法研究为充分利用语音信号与脑电信号的表征情感信息的情感特征,分别从特征融合和决策融合的角度构建了多模态情感识别系统.2.1㊀基于R B M 的特征融合算法研究在特征层融合算法中,文中采用基于R B M [14]的多模态情感特征融合方法,以无监督的训练方式获取语音信号和脑电信号两种模态统计属性之间的联合分布,充分利用大量的无标签数据,弥补了目前特征融合方法过度依赖于样本类标签的缺陷,具有较好的实用性.2.1.1㊀限制玻尔兹曼机玻尔兹曼机(B o l t z m a n n M a c h i n e ,B M )是一种特殊的基于能量的模型,具有较强的无监督学习能力,但考虑到其训练时间长,计算方法复杂等缺点,研究人员提出了R B M ,R B M 网络结构如图2所示.541第1期㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀马江河等:融合语音信号和脑电信号的多模态情感识别h t t p ://j o u r n a l .x i d i a n .e d u .c n /x d xb图2㊀R B M 网络结构图R B M 网络参数训练可表示为(W ,a ,b )=S C D (x 0,m ,η,T )㊀,(5)其中,S C D 代表对比散度(C o n t r a s t i v eD i v e r g e n c e ,C D )算法,式(5)中,x 0是训练数据中的一个样本,m 是隐藏层神经元的个数,η是学习率,T 是训练的最大迭代次数,将可见层和隐藏层的连接权重记为W ,a 和b 分别为可见单元和隐含单元的偏置.获得隐藏层的输出可表示为h =f R B M (v |W ,b )㊀,(6)其中,f R B M 为激活函数.在R B M 中,可见层与隐含层层间全连接.其输入变量v 与输出变量h 联合配置的能量可表示为E (v ,h ;θ)=-ði a i v i -ðj b j h j -ði ðjh j W i ,j v i ㊀,(7)其中,θ={W i ,j ,a i ,b j },是R B M 的参数.2.1.2㊀基于R B M 的特征融合算法文中通过R B M 实现特征融合,并将融合特征作为基于粒子群优化的支持向量机(P S O GS VM )[15]分类器的输入获得多模态情感识别结果,总体流程如图3所示.基于R B M 的特征融合过程如下:(1)从语音信号的基本特性与非线性特性两方面,分别提取语音信号的基本特征和非线性全局特征.(2)从脑电信号的基本特性与非线性特性两方面,分别提取脑电信号的基本特征和非线性全局特征.(3)将语音信号的两类特征综合,并通过主成分分析融合获取表征语音信号情感状态的情感特征.(4)将脑电信号的两类特征综合,并通过主成分分析融合获取表征脑电信号情感状态的情感特征.将步骤(3)及步骤(4)得到的语音信号和脑电信号的情感特征作为R B M 输入,利用C D 算法得到隐层输出,可表示为P (h j =1|S ,E )=σðmi =1w 1i ,j S i +ðn i =1w 2i ,j E i +b h j ()㊀,(8)其中,h j 为隐层h 第j 个单元,S i 表示语音信号的第i 个特征,E i 表示脑电信号的第i 个特征,m 为语音信号的特征维数,n 为脑电信号的特征维数,w i ,j 为输入层第i 个单元与隐层第j 个单元之间的连接权值,b h j 为隐层中第j 个单元的偏置,σ表示s i g m o i d 函数.研究表明,隐层单元的期望值E (h ;l v )可以看作是所提特征的高层表示[16G17].图3㊀特征融合构建多模态情感识别系统框图2.2㊀二次决策融合算法考虑到文中语音信号和脑电信号在几何特性和属性特性上文中所提取特征的相似性,将脑电信号和语音信号的非线性属性特征㊁非线性几何特征以及基本特征组合为三类特征,并采用3种分类器分别进行情感识别,最后采用二次决策算法构建了多模态情感识别系统.文中所采用的二次决策算法如下:(1)为解决脑电信号和语音信号的非线性几何特征维数较高的问题,采用深度信念网络(D e e p B e l i e f N e t w o r k ,D B N )对提取的非线性几何特征进行情感识别.D B N 相比其他网络,不仅可以实现情感分类,而且可以将R B M 初始输入进行高层表示,使用这些高层特征替代原始数据,效果明显改善.(2)考虑到提取的语音信号和脑电信号的非线性属性特征维数相对较低,文中采用反向传播(B a c k 641㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀西安电子科技大学学报㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀第46卷h t t p ://j o u r n a l .x i d i a n .e d u .c n /x d x bP r o p a g a t i o n ,B P )神经网络进行情感识别,得到最终情感的输出概率.(3)将深度信念网络与B P 神经网络的输出概率作为证据的可信度分配,即单个证据的基本概率分配,利用(D e m p S t e r Gs h a f e r ,D S )证据[18]理论的合成规则进行证据融合,将输出结果作为非线性全局特征的情感概率分类结果.(4)将脑电信号和语音信号基本特征作为贝叶斯分类器的输入,计算其输出后验概率并进行情感分类.(5)将基本特征与D S 融合后得到的非线性全局特征的情感识别结果利用加权求和的思想进行二次决策融合,得到多模态情感信号的情感识别结果.加权求和的思想为,假设基本特征的情感识别结果为P (e j |b ),其对应的非线性全局特征的情感识别结果为P (e j |n ),经求和规则,得出归属于每一类情感状态的概率,即P j =a P (e j |b )+b P (e j |n )㊀,㊀㊀㊀㊀1ɤj ɤ4㊀㊀㊀㊀,㊀㊀㊀㊀a +b =1㊀㊀㊀㊀,ìîíïïï(9)其中,a 和b 分别代表基本特征的情感分类结果和非线性特征的情感识别结果的权重.文中权重通过基本情感特征以及非线性全局特征的识别正确结果进行设定,识别率较高的特征赋予较大的权重.P j 表示融合两类情感特征后得到的每类情感状态的概率,其中j 表示情感类别数.文中所采用的二次决策算法流程如图4所示.图4㊀决策融合算法的流程图3㊀实验3.1㊀数据采集及处理过程㊀㊀文中选用T Y U T 2.0语音库[19]作为语音数据来源,选取在校研究生男女各8名作为实验被试者.被试者均右手利,听力正常,视力或矫正视力正常.将每个声音随机呈现给参与者,且每个刺激仅显示1次,实验中的靶刺激为250H z 的纯音信号.刺激程序采用E Gpr i m e 2.0软件进行编写,记录被试者在不同情感语音的刺激下的64导脑电数据[20].实验重点考察听觉功能区对应的电极,选取F C 1㊁F C 2㊁F C 3㊁F C 4㊁C 1㊁C 2㊁C 3㊁C 4㊁C P 1㊁C P 2㊁C P 3㊁C P 4位置处的电极,即共12导的脑电数据进行分析.由于非线性几何特征是利用相空间重构技术对信号轨迹轮廓进行的描述,而脑电信号采集过程中容易受到其他噪声信号的干扰.因此,脑电信号的预处理主要是指去除采集到的脑电信号中所掺杂的伪迹.文中实验所要去除的伪迹主要包括眼电㊁肌电㊁心电㊁工频干扰㊁电磁干扰和与任务不相关的脑电等.3.2㊀实验方案及结果分析作为典型的情感信号,脑电信号和语音信号对情感的判别具有相互补充的作用.为了验证基于两者所构建的多模态情感识别系统的有效性,文中分别从特征融合和决策融合的角度设计实验.设计方案如下:方案1㊀为了验证基于R B M 特征融合方法的可行性,实验分别提取语音信号和脑电信号的非线性几何特征㊁非线性属性特征和基本特征;然后通过基于R B M 的特征融合算法获得多模态情感特征;最后分别通过P S O GS VM 分类器对语音信号和脑电信号以及多模态情感特征进行情感识别,实验结果如表2所示.方案2㊀为了验证文中特征融合方法的有效性,实验将文献[2]所采用主成分分析的特征融合方法与文中特征融合的方法进行比对,对比结果如图5(a )所示.方案3㊀为了验证文中二次决策融合方法的可行性,实验将语音信号和脑电信号提取的三类特征按类组合,分别对每类特征使用不同的分类器进行情感识别,然后采取二次决策算法从决策融合的角度构建多模态情感识别系统,实验结果如表3所示.741第1期㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀马江河等:融合语音信号和脑电信号的多模态情感识别h t t p ://j o u r n a l .x i d i a n .e d u .c n /x d x b方案4㊀为了验证文中二次决策融合方法的有效性,实验将文献[5]所采用基于D S 证据理论的决策融合方法与文中二次决策融合的方法进行比对,对比结果如图5(b)所示.表2㊀基于R B M 的特征融合及单模态情感识别结果对比%情感信号情感类型平均识别率悲伤生气高兴中性语音信号71.4385.7185.7178.5780.36脑电信号96.0075.7576.2566.7578.69特征融合85.0084.7581.2574.7581.44表3㊀二次决策融合实验结果%实验类型特征类型情感类型平均识别率悲伤生气高兴中性单类特征分类非线性几何特征85.5081.5082.2581.7582.75非线性属性特征95.047.6272.3184.7264.92基本特征79.2586.0096.0073.5083.69D S 融合非线性全局特征83.7582.5081.5080.5582.08二次决策情感特征全集81.7585.7597.0083.0086.88㊀㊀从表2和表3可以得出如下结论:(1)由表2结果显示,在语音信号的情感识别中,4种情感的识别率相对均衡;而在脑电信号情感识别中,悲伤情感比其他情感的识别率相对较高,可达96%.这是因为在脑电信号情感特征中,非线性几何特征维数较高,而悲伤情感在三维相空间重构中分布比较集中,相比其他情感误判可能性相对较小,而中性情感识别率最低,主要因为中性情感与其他情感相似度比较大,更容易被判别为其他情感.特征融合后,4种情感的识别率相对均衡,整体识别率可达81.44%,相比脑电信号和语音信号分别提高了1.08%和2.75%.其中中性情感的识别率相对较低,但对脑电信号中性情感识别有所提升.因此,脑电信号和语音信号在情感分类上具有相互辅助的作用.该实验结果表明,通过基于R B M 特征融合算法所构建的多模态情感识别系统更有助于对多种情感进行情感分类.(2)由表3结果显示,将语音信号和脑电信号的三类特征分别归类后,分别使用不同的分类器进行情感识别后,非线性几何特征相比非线性属性特征整体识别效果较好,主要因为非线性几何特征使用D B N 进行情感分类,D B N 本身包含着特征降维[21]的效果,因此,减小了特征的冗余性,最终识别率相对较高.而考虑到非线性属性特征维数较低,采用B P 神经网络进行识别后,生气情感的识别效果较差,因此说明非线性属性特征对生气情感分类较差,需要结合其他特征对生气情感进行判别.当利用D S 证据理论将非线性属性特征和非线性几何特征识别结果融合后,获得的非线性特征情感识别率相对非线性属性特征提高了17.16%,比非线性几何特征略低,但是4种情感的识别率相对比较均衡,均可达80%以上.因此,该结果说明情感信号非线性全局特征可以更完整地表达代表情感差异度的有效信息.当利用加权求和算法实现二次决策后,整体的情感识别效率相对非线性全局特征和基本特征分别提高4.8%和3.19%,其中高兴情感可达97%以上,而其他三类情感识别率均高于81%,即从决策融合的角度实现多模态情感识别,识别率相比单模态分别提高6.52%和8.19%.因此,通过决策融合所构造多模态情感识别系统可以更高效地实现情感识别.(3)如图5(a )所示,采用基于R B M 的融合算法实现特征融合,相比文献[2]中所采用特征融合算法效果更优,整体情感识别率相对提高2.25%.其中利用文献[2]主成分分析实现特征融合后,多模态情感整体识别率略低于语音的,但高于脑电信号的.因此,用语音信号辅助脑电信号有助于情感识别准确性的提升.而文中方法所构造的多模态情感识别系统相比单模态均有所提高.如图5(b )所示,采用文中二次决策融合算法实现决策融合相比文献[5]采用的决策方法整体效果更好,其中,生气情感识别率明显841㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀西安电子科技大学学报㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀第46卷h t t p ://j o u r n a l .x i d i a n .e d u .c n /x d x b提升,悲伤和中性情感相对较低,但是整体情感识别率提升了5.66%.因此,通过对比实验验证了文中融合算法的有效性.图5㊀方案2与方案4的结果图(4)由图6可以更直观地显示出单模态信号和多模态信号的情感识别效率,从整体识别效果来看,由二次决策算法所构建的多模态情感识别系统,相比基于R B M 特征融合算法所构建的多模态情感识别系统,情感识别效果更优,而多模态情感识别系统相比单一信号识别性能更高.在4种情感中,中性情感识别率相对较低,因为中性情感与其他情感相似性较大,而高兴情感和生气情感决策融合后构建的多模态情感识别系统识别率最高,悲伤情感脑电信号识别率相对较高,但整体识别率多模态情感识别系统的性能最优.因此,有效的融合算法是实现多模态情感识别的关键要素之一,是提高情感识别性能和鲁棒性的有效手段之一.图6㊀情感识别结果比对4㊀结束语文中选取了脑电信号和语音信号作为研究对象,首先,提取了两者的基本特征和非线性全局特征作为情感特征.然后,通过基于R B M 的融合算法,从特征层融合的角度实现多模态情感识别.最后,利用二次决策算法,从决策融合的角度构建多模态情感识别系统.通过实验验证了多模态情感识别系统相比单模态信号识别性能更优,其中决策融合相比特征融合构建的多模态情感识别系统整体识别效果更好.在今后的研究中,提取能代表情感差异度信息的情感特征以及探索更优的信息融合方法,将是多模态信号识别研究的重点,这也是今后重点的研究方向.参考文献:1 Z HA N GS Z HA N GS HU A N G T e t a l 敭S p e e c hE m o t i o nR e c o g n i t i o nU s i n g D e e p Co n v o l u t i o n a lN e u r a lN e t w o r k a n d D i s c r i m i n a n tT e m p o r a l P y r a m i d M a t c h i n g J 敭I E E ET r a n s a c t i o n s o n M u l t i m e d i a 2018 20 6 1576G1590敭 2 黄程韦 金赟 王青云 等敭基于语音信号与心电信号的多模态情感识别 J 敭东南大学学报 自然科学版 2010 40 5 895G900敭HU A N GC h e n g w e i J I N Y u n WA N G Q i n g y u n e ta l 敭M u l t i m o d a lE m o t i o n R e c o g n i t i o nB a s e do nS p e e c ha n d E C G S i g n a l s J 敭J o u r n a l o f S o u t h e a s tU n i v e r s i t y N a t u r a l S c i e n c eE d i t i o n 2010 40 5 895G900敭 3 P E R E Z GG A S P A R L A C A B A L L E R O GMO R A L E SS O T R U J I L L O GR OM E R O F 敭M u l t i m o d a lE m o t i o n R e c o g n i t i o n w i t hE v o l u t i o n a r y C o m p u t a t i o n f o rH u m a n Gr o b o t I n t e r a c t i o n J 敭E x p e r t S y s t e m sw i t hA p p l i c a t i o n s 2016 66 42G61敭 4 H U A N G X K O R T E L A I N E N J Z H A O G e t a l 敭M u l t i Gm o d a l E m o t i o n A n a l y s i s f r o m F a c i a l E x p r e s s i o n s a n d E l e c t r o e n c e p h a l o g r a m J 敭C o m p u t e rV i s i o na n d I m a g eU n d e r s t a n d i n g 2016 147 114G124敭941第1期㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀马江河等:融合语音信号和脑电信号的多模态情感识别051㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀西安电子科技大学学报㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀㊀第46卷5刘仁怡敭基于脑电和语音信号的情感识别研究D敭天津天津师范大学2015敭6姚慧孙颖张雪英敭情感语音的非线性动力学特征J敭西安电子科技大学学报2016435167G172敭Y A O H u i S U NY i n g Z HA N GX u e y i n g敭R e s e a r c h o nN o n l i n e a rD y n a m i c s F e a t u r e s o f E m o t i o n a l S p e e c h J敭J o u r n a l o f X i d i a nU n i v e r s i t y2016435167G172敭7HA T AM I K I A S N A S R A B A D IA M敭R e c o g n i t i o no fE m o t i o n a lS t a t e s I n d u c e db y M u s i cV i d e o sB a s e do n N o n l i n e a r F e a t u r eE x t r a c t i o n a n d S OM C l a s s i f i c a t i o n C P r o c e e d i n g s o ft h e201421s tI r a n i a n C o n f e r e n c e o n B i o m e d i c a l E n g i n e e r i n g敭P i s c a t a w a y I E E E2014333G337敭8孙颖宋春晓敭相空间重构的情感语音特征提取及优化J敭西安电子科技大学学报2017446162G168敭S U N Y i n g S O N GC h u n x i a o敭E m o t i o n a l S p e e c hF e a t u r eE x t r a c t i o n a n dO p t i m i z a t i o no f P h a s e S p a c eR e c o n s t r u c t i o n J敭J o u r n a l o fX i d i a nU n i v e r s i t y2017446162G168敭9T A K E N SF敭D e t e c t i n g S t r a n g eA t t r a c t o r s i nT u r b u l e n c e C L e c t u r eN o t e s i nM a t h e m a t i c s898敭H e i d e l b e r g S p r i n g e rGV e r l a g1981366G381敭10L A HM I R I S敭G e n e r a l i z e d H u r s tE x p o n e n tE s t i m a t e sD i f f e r e n t i a t eE E G S i g n a l so fH e a l t h y a n dE p i l e p t i cP a t i e n t s J敭P h y s i c aA S t a t i s t i c a lM e c h a n i c s a n d I t sA p p l i c a t i o n s2018490378G385敭11K O R D A AI A S V E S T A SP A MA T S O P O U L O SG K e t a l敭A u t o m a t i c I d e n t i f i c a t i o no fE y e M o v e m e n t sU s i n g t h e L a r g e s tL y a p u n o vE x p o n e n t J敭B i o m e d i c a l S i g n a l P r o c e s s i n g a n dC o n t r o l20184110G20敭12WO L FA S W I F TJB S W I N N E Y H L e t a l敭D e t e r m i n i n g L y a p u n o vE x p o n e n t s f r o maT i m eS e r i e s J敭P h y s i c aD N o n l i n e a rP h e n o m e n a1985163285G317敭13D A V I D GF P A U M M J O R G EJN e t a l敭N o i s y E E GS i g n a l sC l a s s i f i c a t i o nB a s e do nE n t r o p y m e t r i c s敭P e r f o r m a n c e A s s e s s m e n tU s i n g F i r s t a n dS e c o n dG e n e r a t i o nS t a t i s t i c s J敭C o m p u t e r s i nB i o l o g y a n d M e d i c i n e201787141G151敭14HA R R I N G T O N P D B敭F e a t u r e E x p a n s i o n b y a C o n t i n u o u s R e s t r i c t e d B o l t z m a n n M a c h i n e f o r N e a rGi n f r a r e d S p e c t r o m e t r i cC a l i b r a t i o n J敭A n a l y t i c aC h i m i c aA c t a2018101020G28敭15Z H E N G H Z HA N GS S U N X敭C l a s s i f i c a t i o nR e c o g n i t i o no fA n c h o rR o dB a s e do nP S OGS VM C P r o c e e d i n g s o f t h e 201729t hC h i n e s eC o n t r o l a n dD e c i s i o nC o n f e r e n c e敭P i s c a t a w a y I E E E20172207G2212敭16T E N G K WA N GJ敭C l a s s i f i c a t i o nR e l a t e d M a n i f o l dD i m e n s i o nE s t i m a t i o n w i t h R e s t r i c t e dB o l t z m a n n M a c h i n e C P r o c e e d i n g s o f t h e20137t hI n t e r n a t i o n a lC o n f e r e n c eo nI m a g ea n d G r a p h i c s敭W a s h i n g t o n I E E E C o m p u t e rS o c i e t y 2013857G862敭17C A IX HU S L I N X敭F e a t u r e E x t r a c t i o n U s i n g R e s t r i c t e d B o l t z m a n n M a c h i n ef o rS t o c k P r i c eP r e d i c t i o n C P r o c e e d i n g s o f t h e2012I E E EI n t e r n a t i o n a l C o n f e r e n c e o nC o m p u t e r S c i e n c e a n dA u t o m a t i o nE n g i n e e r i n g敭W a s h i n g t o n I E E EC o m p u t e r S o c i e t y201280G83敭18Z HA N G G J I A S L IX e t a l敭W e i g h t e dS c o r eGl e v e lF e a t u r eF u s i o nB a s e do nD e m p s t e rGS h a f e rE v i d e n c eT h e o r y f o r A c t i o nR e c o g n i t i o n J敭J o u r n a l o fE l e c t r o n i c I m a g i n g2018271013021敭19宋静张雪英孙颖等敭基于模糊综合评价法的情感语音数据库的建立J敭现代电子技术2016391351G54敭S O N GJ i n g Z HA N G X u e y i n g S U N Y i n g e ta l敭E s t a b l i s h m e n to f E m o t i o n a lS p e e c h D a t a b a s e B a s e d o n F u z z y C o m p r e h e n s i v eE v a l u a t i o n M e t h o d J敭M o d e r nE l e c t r o n i c sT e c h n i q u e2016391351G54敭20畅江张雪英张奇萍等敭不同语种及非言语情感声音的E R P研究J敭清华大学学报自然科学版201656101131G1136敭C HA N GJ i a n g Z HA N G X u e y i n g Z HA N G Q i p i n g e ta l敭E R P R e s e a r c h o nt h e E m o t i o n a l V o i c ef o rD i f f e r e n t L a n g u a g e s a n dN o nGs p e e c h U t t e r a n c e s J敭J o u r n a lo fT s i n g h u a U n i v e r s i t y S c i e n c ea n d T e c h n o l o g y201656101131G1136敭21L IK WU Y N A N Y e ta l敭H i e r a r c h i c a lM u l t iGc l a s sC l a s s i f i c a t i o ni n M u l t i m o d a lS p a c e c r a f tD a t a U s i n g D N Na n d W e i g h t e dS u p p o r tV e c t o rM a c h i n e J敭N e u r o c o m p u t i n g201725955G65敭(编辑:齐淑娟)㊀㊀h t t p://j o u r n a l.x i d i a n.e d u.c n/x d x b。

基于深度学习的多模态数据融合与情感识别技术研究

基于深度学习的多模态数据融合与情感识别技术研究多模态数据融合与情感识别技术在当今社会中起着越来越重要的作用。

随着互联网和社交媒体的普及,人们在日常生活中产生的数据变得越来越多样化和丰富化。

这些数据包括文本、语音、图像和视频等多种形式的内容。

为了更好地理解人类情感和行为,多模态数据融合与情感识别技术应运而生。

多模态数据融合与情感识别技术主要是通过将不同形式的数据整合在一起,从而获得更全面、准确的情感信息。

深度学习作为一种强大的人工智能算法,为多模态数据融合与情感识别技术提供了有力的支持。

首先,多模态数据融合是将来自不同模态的数据信息进行有效组合,形成更加全面和准确的情感识别结果。

例如,我们可以将文本、语音、图像和视频等数据进行融合,从而更全面地捕捉到人类的情感表达。

基于深度学习的多模态融合方法通常包括两个步骤:特征提取和特征融合。

在特征提取阶段,深度学习模型可以自动学习到数据中潜在的情感特征。

而在特征融合阶段,深度学习模型可以将提取出的特征进行融合,得到更全面的情感识别结果。

其次,情感识别是一项关键的任务,它可以帮助我们更好地理解人类情感和行为。

基于深度学习的情感识别方法通常采用循环神经网络(RNN)或卷积神经网络(CNN)等模型。

这些模型可以自动学习到数据中的情感信息,并准确地判断出人类的情感状态。

此外,深度学习模型还可以通过迁移学习的方法,将在其他任务上训练得到的知识迁移到情感识别任务中,从而提高情感识别的准确性和稳定性。

基于深度学习的多模态数据融合与情感识别技术在许多领域具有广泛的应用前景。

首先,在社交媒体分析中,多模态数据融合与情感识别技术可以帮助我们更好地理解用户在社交网络上的情感表达。

这对于电商平台和广告公司等进行用户行为分析和用户情感分析至关重要。

其次,在医疗领域,多模态数据融合与情感识别技术可以帮助医生和医学研究人员更好地理解患者的情感状态,并提供个性化的医疗服务。

此外,在智能交通系统中,多模态数据融合与情感识别技术可以帮助我们更好地理解驾驶员的情感状态,从而提高交通安全性和驾驶体验。

基于多模态特征提取与融合的语音情感识别方法

在语音情感识别方面,基于多模态特征提取与融合的方法是一种重要的研究方向。

通过综合利用语音、文本、图像和其他多种信息,可以提高情感识别的准确性和鲁棒性。

本文将从多个层面探讨基于多模态特征提取与融合的语音情感识别方法,以期帮助读者深入理解并掌握这一领域的研究进展。

1. 多模态特征提取的意义与重要性多模态特征提取意味着从不同的信息源中获取语音情感的相关特征,例如从语音信号中提取声音特征,从文本中提取情感词汇特征,从图像中提取面部表情特征等。

这种跨领域的信息融合可以帮助识别情感时更全面地考虑到不同信息源的贡献,从而提高情感识别的准确性和鲁棒性。

2. 多模态特征融合的方法与模型在语音情感识别中,多模态特征融合可以采用不同的方法和模型,常见的包括深度学习模型、集成学习模型和注意力机制模型等。

这些模型能够将来自不同信息源的特征进行有效地融合,并能够更好地挖掘出不同信息源之间的关联,从而提高情感识别的效果。

3. 个人观点与理解在我看来,基于多模态特征提取与融合的语音情感识别方法是未来语音识别领域的重要发展方向。

通过充分利用不同信息源的特征,可以更好地表达和理解语音中的情感信息,从而在情感识别任务中取得更好的效果。

我认为未来的研究还可以进一步探索不同信息源之间的相关性,以及如何更好地融合这些信息来提高情感识别的性能。

总结回顾通过本文的探讨,我们深入了解了基于多模态特征提取与融合的语音情感识别方法。

这种方法的意义与重要性在于可以全面地考虑不同信息源对情感识别的贡献,因此在未来的研究中将会有更大的发展空间。

希望本文能够帮助读者更全面、深入和灵活地理解这一领域的研究进展。

通过以上文章,从浅入深地介绍了基于多模态特征提取与融合的语音情感识别方法。

希望这篇文章能帮助你更好地理解并掌握这一重要研究方向。

随着智能技术的发展,情感识别在人机交互、情感智能等领域具有广泛的应用前景。

然而,传统的语音情感识别方法往往依赖于单一信息源,难以全面准确地表达语音中的情感信息。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

融合语音信号和脑电信号的多模态情感识别情感识别是实现机器智能化的关键技术之一,它通过对人类情感

的研究与分析,可以使机器理解人类情感并按照人类意愿完成相关指令。

在众多的情感信号中,语音信号是最直接且最有利的表达方式,

而脑电信号可靠性强且采集方便简单,二者对于情感识别相辅相成。

本文结合语音信号和脑电信号构造了多模态情感识别系统,分析了语

音信号和脑电信号与情感之间的关系,提取了二者表征情感差异度的

有效情感信息,采用特征融合和决策融合技术构建了多模态情感识别

系统,并通过对比实验验证了多模态情感识别系统的可靠性和鲁棒性。

论文研究内容及创新点如下:(1)详细介绍了语音情感识别系统的构成。

根据语音信号的语速、音调、自然度、清晰度等基本特性提取了语音信号的传统特征;从语音信号的属性特性和几何结构两方面分析

并提取了表征情感信息的非线性特征;选取TYUT2.0为语音情感数据库,采用支持向量机(Support Vector Machine,SVM)进行情感判别,

实验结果证明,以语音信号为载体的情感识别系统可以有效的实现情

感分类。

(2)提取了新的情感脑电特征并构造出有效情感特征子集。

针对脑电信号的非线性特性,利用相空间重构技术通过对相空间中几

何结构的分析提取了新的情感脑电特征,即脑电信号的非线性几何特征。

通过特征融合方法将其与功率谱熵以及非线性属性特征进行融合,获得了脑电信号能表征情感差异度的有效情感特征集合。

利用SVM进行情感分类,结果表明,本文提取的非线性几何特征可以有效地弥补

非线性属性特征对脑电信号非线性特性表征上的不足,结合功率谱熵

构造的情感特征集合能更好的描述情感之间的差异性。

(3)通过特征融合技术构造了多模态情感识别系统。

针对语音信号和脑电信号提取的情感特征,本文采用三种不同的特征融合的方法(限制玻尔兹曼机、局部线性嵌入算法、多维尺度变换算法)构造了多模态情感识别系统,在降低计算复杂度的同时去除了二者特征之间的冗余信息。

通过与单种情感信号的情感识别系统性能对比,结果表明,特征融合方法构建

的多模态情感识别系统情感识别性能更优。

(4)提出二次决策融合算法,构建了多模态情感识别系统。

鉴于语音信号和脑电信号情感特征提取类型的相似性,本文提出了二次决策融合算法,构建了多模态情

感识别系统。

将两种情感信号的同类型特征(基本特征、非线性属性和非线性几何特征)分别结合并采用不同的分类器进行情感识别;利

用DS证据理论将非线性属性和非线性几何特征识别结果进行融合获得非线性综合特征识别结果;通过投票法将基本特征与非线性综合特征情感识别结果融合得到最终的多模态情感识别结果,实验结果证明,二次决策融合算法构建的多模态情感识别系统相比单模态情感识别

系统识别率更高。