人工神经网络作业

人工神经网络方法

人工神经网络方法人工神经网络是一种类似于生物神经系统的计算模型,它由多个节点(神经元)和连接这些节点之间的权重组成。

这些节点和连接可以模拟人类大脑的工作原理,从而实现复杂的计算任务。

以下是人工神经网络常用的几种方法:1.前馈神经网络(Feedforward neural network)前馈神经网络是最常用的神经网络类型之一,它的数据流仅向前流动,没有回流。

该网络由多个层组成,其中输入层接受数据,输出层产生输出,中间层包含多个带有权重的神经元。

每个神经元的输出都可以通过权重连接到下一层神经元的输入。

通过调整权重,前馈神经网络可以进行监督学习,用于分类或回归问题。

2.循环神经网络(Recurrent neural network)循环神经网络是一种形式化的神经网络,它可以对序列数据进行处理,如语音识别、自然语言处理等。

循环神经网络的节点之间可以相互连接,形成一个循环,输入数据会在整个网络中进行传递和加工,输出也会受到之前状态的影响。

循环神经网络还可以使用长短时记忆(LSTM)单元或门控循环单元(GRU)单元来处理长序列数据。

3.卷积神经网络(Convolutional neural network)卷积神经网络是一种针对图像识别和视觉处理任务的神经网络。

它由多个卷积层、池化层和全连接层组成。

在输入层之后的每一层都是由若干个卷积核组成的,并对输入数据进行卷积处理。

卷积操作可以有效地提取图像特征,池化层可以对输出信号进行降采样处理。

通过卷积和池化操作,卷积神经网络可以自动学习特征,并具有很高的图像识别准确率。

4.自编码器(Autoencoder)自编码器是一种非监督学习方法,它可以有效地进行数据的压缩和重建。

自编码器通过输入数据,将其表示为低维的潜在表示,然后通过解码器将其转换回原始维度。

自编码器主要由编码器和解码器组成。

编码器将输入数据转换成低维度的潜在表示,解码器将潜在表示转换成原始数据。

在训练过程中,自编码器可以调整权重和偏置,以最小化重建误差。

人工神经网络原理第8章习题参考答案

1.人工神经网络适合于解决哪些问题?试举例说明。

人工神经网络技术在处理对内部规律不甚了解,也不能用一组规则和方程等数学表达式描述的较为复杂的问题时具有一定的优越性,尤其对容错性有一定要求的任务,例如图形的检测与识别、诊断、特征提取、推论等,人工神经网络都是比较合适的处理手段,对于上述任务,即使输入数据是模糊的或不完善的,人工神经网络仍然能够对其进行处理。

示例略。

2.一个人工神经网络应用的开发要经过哪些阶段?明确需求、选取模型、设计神经网络节点、设计神经网络结构、设计神经网络训练算法、选择训练和测试样本、网络训练与测试、实现神经网络。

3.若要用神经网络实现对0~9十个数字字符的识别,应当如何选取适当的人工神经网络模型?参见表8-1,可以选择BP、Hopfield等神经网络模型。

4.若要实现一个简单的交通标志识别系统,应当如何选取适当的人工神经网络模型?参见表8-1,可以选择BP、Hopfield等神经网络模型。

5.若有一个私人医生,每天可接受10个预约病人的上门服务。

若要为该医生设计一条当天的巡诊路线,以使该医生的巡诊距离最短,应当如何选取适当的人工神经网络模型?这是一个优化问题,可以选择Hopfield神经网络。

6.试述对习题2、3、4中选取的人工神经网络模型进行设计开发的全过程。

略。

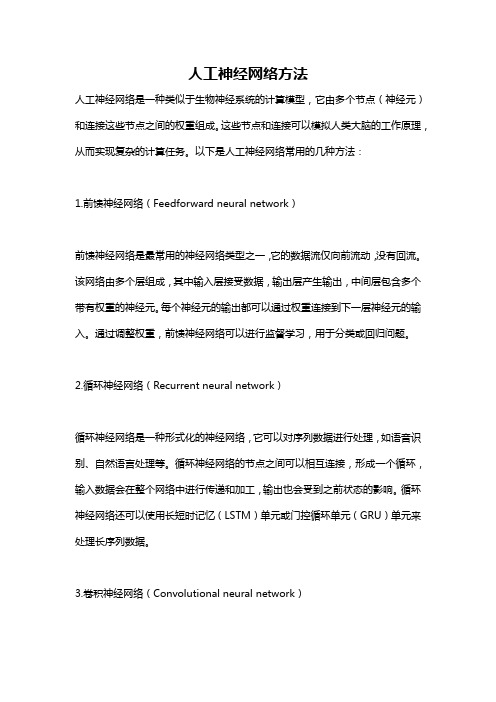

7.有如下几种模型,其特性如表8-4所示。

表8-4 人工神经网络模型的基本性能若要开发一个贷款评估人工神经网络,要求能够根据借贷申请人的月收入、生活费用支出、房租、水、电、交通费用支出及其他费用支出来实时地分析这一贷款申请是否合格。

如合格,则批准申请给予贷款,否则给予拒绝。

请从表8-4列出的人工神经网络模型中选择一个适合该贷款评估应用的模型,并阐明原因。

可根据输出类型(例如,此题是一个分类问题,而不是优化问题)、训练方法、要求的训练时间和执行时间等选取各项指标都符合具体需求的模型。

此题只是一个示例,让读者掌握如何选取适当的人工神经网络模型,具体选取过程略。

智能控制(神经网络)-作业

智能控制作业学生姓名: 学号: 专业班级:(一)7-2 采用BP网路、RBF网路、DRNN网路逼近线性对象, 分别进行matlab 仿真。

(二)采用BP网络仿真网络结构为2-6-1。

采样时间1ms, 输入信号, 权值的初值随机取值, 。

仿真m文件程序为:%BP simulationclear all;clear all;xite=0.5;alfa=0.5;w1=rands(2,6); % value of w1,initially by randomw1_1=w1;w1_2=w1;w2=rands(6,1); % value of w2,initially by randomw2_1=w2;w2_2=w2_1;dw1=0*w1;x=[0,0]';u_1=0;y_1=0;I=[0,0,0,0,0,0]'; % input of yinhanceng cellIout=[0,0,0,0,0,0]'; % output of yinhanceng cellFI=[0,0,0,0,0,0]';ts=0.001;for k=1:1:1000time(k)=k*ts;u(k)=0.5*sin(3*2*pi*k*ts);y(k)=(u_1-0.9*y_1)/(1+y_1^2);for j=1:1:6I(j)=x'*w1(:,j);Iout(j)=1/(1+exp(-I(j)));endyn(k)=w2'*Iout; %output of networke(k)=y(k)-yn(k); % error calculationw2=w2_1+(xite*e(k))*Iout+alfa*(w2_1-w2_2); % rectify of w2for j=1:1:6FI(j)=exp(-I(j))/(1+exp(-I(j))^2);endfor i=1:1:2for j=1:1:6dw1(i,j)=e(k)*xite*FI(j)*w2(j)*x(i); % dw1 calculation endendw1=w1_1+dw1+alfa*(w1_1-w1_2); % rectify of w1% jacobian informationyu=0;for j=1:1:6yu=yu+w2(j)*w1(1,j)*FI(j);enddyu(k)=yu;x(1)=u(k);x(2)=y(k);w1_2=w1_1;w1_1=w1;w2_2=w2_1;w2_1=w2;u_1=u(k);y_1=y(k);endfigure(1);plot(time,y,'r',time,yn,'b');xlabel('times');ylabel('y and yn');figure(2);plot(time,y-yn,'r');xlabel('times');ylabel('error');figure(3);plot(time,dyu);xlabel('times');ylabel('dyu');运行结果为:(三)采用RBF网络仿真网路结构为2-4-1, 采样时间1ms, 输入信号, 权值的初值随机取值, , 高斯基函数初值, 。

人工神经网络大作业

X X X X 大学研究生考查课作业课程名称:智能控制理论与技术研究生姓名:学号:作业成绩:任课教师(签名)交作业日时间:2010 年12 月22 日人工神经网络(artificial neural network,简称ANN)是在对大脑的生理研究的基础上,用模拟生物神经元的某些基本功能元件(即人工神经元),按各种不同的联结方式组成的一个网络。

模拟大脑的某些机制,实现某个方面的功能,可以用在模仿视觉、函数逼近、模式识别、分类和数据压缩等领域,是近年来人工智能计算的一个重要学科分支。

人工神经网络用相互联结的计算单元网络来描述体系。

输人与输出的关系由联结权重和计算单元来反映,每个计算单元综合加权输人,通过激活函数作用产生输出,主要的激活函数是Sigmoid函数。

ANN有中间单元的多层前向和反馈网络。

从一系列给定数据得到模型化结果是ANN的一个重要特点,而模型化是选择网络权重实现的,因此选用合适的学习训练样本、优化网络结构、采用适当的学习训练方法就能得到包含学习训练样本范围的输人和输出的关系。

如果用于学习训练的样本不能充分反映体系的特性,用ANN也不能很好描述与预测体系。

显然,选用合适的学习训练样本、优化网络结构、采用适当的学习训练方法是ANN的重要研究内容之一,而寻求应用合适的激活函数也是ANN研究发展的重要内容。

由于人工神经网络具有很强的非线性多变量数据的能力,已经在多组分非线性标定与预报中展现出诱人的前景。

人工神经网络在工程领域中的应用前景越来越宽广。

1人工神经网络基本理论[1]1. 1神经生物学基础可以简略地认为生物神经系统是以神经元为信号处理单元, 通过广泛的突触联系形成的信息处理集团, 其物质结构基础和功能单元是脑神经细胞即神经元(neu ron)。

(1) 神经元具有信号的输入、整合、输出三种主要功能作用行为。

突触是整个神经系统各单元间信号传递驿站, 它构成各神经元之间广泛的联接。

(3) 大脑皮质的神经元联接模式是生物体的遗传性与突触联接强度可塑性相互作用的产物, 其变化是先天遗传信息确定的总框架下有限的自组织过程。

人工神经网络例题

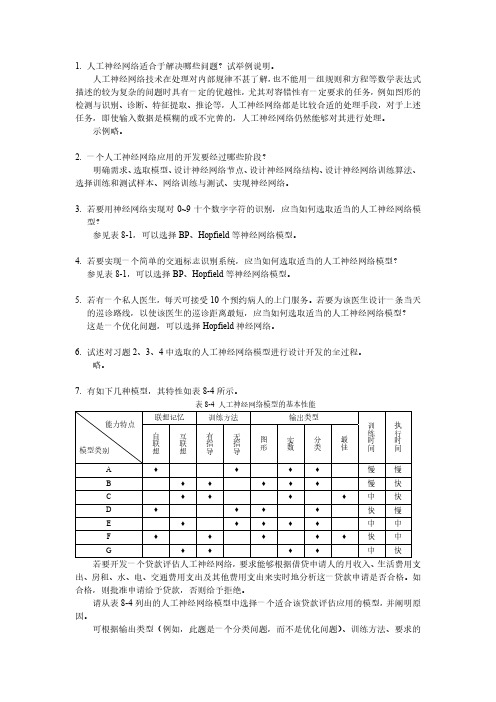

1、什么是BP 网络的泛化能力?如何保证BP 网络具有较好的泛化能力?(5分)解:(1)BP网络训练后将所提取的样本对中的非线性映射关系存储在权值矩阵中,在其后的工作阶段,当向网络输入训练时未曾见过的非样本数据时,网络也能完成由输入空间向输出空间的正确映射。

这种能力称为多层感知器的泛化能力,它是衡量多层感知器性能优劣的一个重要方面。

(2)网络的性能好坏主要看其是否具有很好的泛化能力,而对泛化能力的测试不能用训练集的数据进行,要用训练集以外的测试数据来进行检验。

在隐节点数一定的情况下,为获得更好的泛化能力,存在着一个最佳训练次数t0,训练时将训练与测试交替进行,每训练一次记录一训练均方误差,然后保持网络权值不变,用测试数据正向运行网络,记录测试均方误差,利用两种误差数据得出两条均方误差随训练次数变化的曲线,测试、训练数据均方误差曲线如下图1所示。

训练次数t0称为最佳训练次数,当超过这个训练次数后,训练误差次数减小而测试误差则开始上升,在此之前停止训练称为训练不足,在此之后称为训练过度。

图1. 测试、训练数据均方误差曲线2、什么是LVQ 网络?它与SOM 网络有什么区别和联系?(10 分)解:(1)学习向量量化(learning vector quantization,LVQ)网络是在竞争网络结构的基础上提出的,LVQ将竞争学习思想和监督学习算法相结合,减少计算量和储存量,其特点是网络的输出层采用监督学习算法而隐层采用竞争学习策略,结构是由输入层、竞争层、输出层组成。

(2)在LVQ网络学习过程中通过教师信号对输入样本的分配类别进行规定,从而克服了自组织网络采用无监督学习算法带来的缺乏分类信息的弱点。

自组织映射可以起到聚类的作用,但还不能直接分类和识别,因此这只是自适应解决模式分类问题中的第一步,第二步是学习向量量化,采用有监督方法,在训练中加入教师信号作为分类信息对权值进行细调,并对输出神经元预先指定其类别。

大工22夏《神经网络》大作业

大工22夏《神经网络》大作业

1. 项目介绍

本次《神经网络》大作业旨在让同学们深入理解神经网络的工作原理,并能够独立实现一个简单的神经网络模型。

通过完成本次作业,同学们将掌握神经网络的基本结构,训练过程以及参数优化方法。

2. 任务要求

1. 独立实现一个具有至少三层神经网络的结构,包括输入层、隐藏层和输出层。

2. 选择一个合适的激活函数,并实现其对应的激活和导数计算方法。

3. 实现神经网络的正向传播和反向传播过程,包括权重更新和偏置更新。

4. 在一个简单的数据集上进行训练,评估并优化所实现的神经网络模型。

3. 评分标准

1. 神经网络结构实现(30分)

2. 激活函数实现(20分)

3. 正向传播和反向传播实现(20分)

4. 模型训练与评估(20分)

5. 代码规范与文档说明(10分)

4. 提交要求

1. 提交代码文件,包括神经网络结构、激活函数、正向传播、反向传播以及训练与评估的实现。

2. 提交一份项目报告,包括项目简介、实现思路、实验结果及分析。

3. 请在提交前确保代码的可运行性,并在报告中附上运行结果截图。

5. 参考资料

1. Goodfellow, I. J., Bengio, Y., & Courville, A. C. (2016). Deep learning. MIT press.

2. Russell, S., & Norvig, P. (2016). Artificial intelligence: a modern approach. Pearson Education Limited.

祝大家作业顺利!。

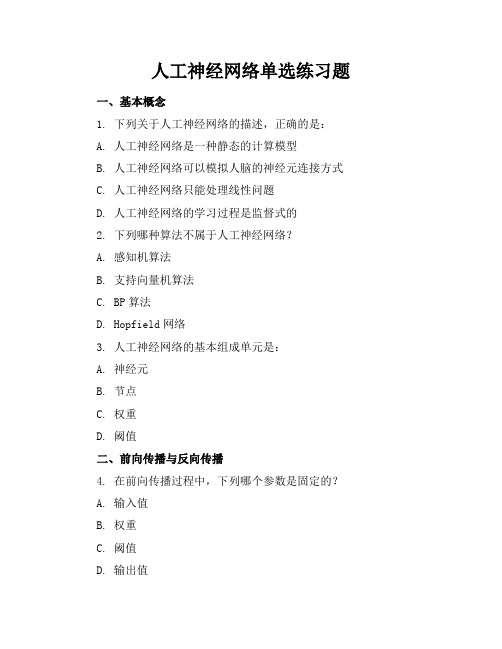

人工神经网络单选练习题

人工神经网络单选练习题一、基本概念1. 下列关于人工神经网络的描述,正确的是:A. 人工神经网络是一种静态的计算模型B. 人工神经网络可以模拟人脑的神经元连接方式C. 人工神经网络只能处理线性问题D. 人工神经网络的学习过程是监督式的2. 下列哪种算法不属于人工神经网络?A. 感知机算法B. 支持向量机算法C. BP算法D. Hopfield网络3. 人工神经网络的基本组成单元是:A. 神经元B. 节点C. 权重D. 阈值二、前向传播与反向传播4. 在前向传播过程中,下列哪个参数是固定的?A. 输入值B. 权重C. 阈值D. 输出值5. 反向传播算法的主要目的是:A. 更新输入值B. 更新权重和阈值C. 计算输出值D. 初始化网络参数6. 下列关于BP算法的描述,错误的是:A. BP算法是一种监督学习算法B. BP算法可以用于多层前馈神经网络C. BP算法的目标是最小化输出误差D. BP算法只能用于解决分类问题三、激活函数7. 下列哪种激活函数是非线性的?A. 步进函数B. Sigmoid函数C. 线性函数D. 常数函数8. ReLU激活函数的优点不包括:A. 计算简单B. 避免梯度消失C. 提高训练速度D. 减少过拟合9. 下列哪种激活函数会出现梯度饱和现象?A. Sigmoid函数B. ReLU函数C. Tanh函数D. Leaky ReLU函数四、网络结构与优化10. 关于深层神经网络,下列描述正确的是:A. 深层神经网络一定比浅层神经网络效果好B. 深层神经网络更容易过拟合C. 深层神经网络可以减少参数数量D. 深层神经网络训练速度更快11. 下列哪种方法可以降低神经网络的过拟合?A. 增加训练数据B. 减少网络层数C. 增加网络参数D. 使用固定的学习率12. 关于卷积神经网络(CNN),下列描述错误的是:A. CNN具有局部感知能力B. CNN具有参数共享特点C. CNN可以用于图像识别D. CNN无法处理序列数据五、应用场景13. 下列哪种问题不适合使用人工神经网络解决?A. 图像识别B. 自然语言处理C. 股票预测D. 线性规划14. 下列哪个领域不属于人工神经网络的应用范畴?A. 医学诊断B. 金融预测C. 智能家居D. 数值计算15. 关于循环神经网络(RNN),下列描述正确的是:A. RNN无法处理长距离依赖问题B. RNN具有短期记忆能力C. RNN训练过程中容易出现梯度消失D. RNN只能处理序列长度相同的数据六、训练技巧与正则化16. 下列哪种方法可以用来防止神经网络训练过程中的过拟合?A. 提前停止B. 增加更多神经元C. 减少训练数据D. 使用更大的学习率17. 关于Dropout正则化,下列描述错误的是:A. Dropout可以减少神经网络中的参数数量B. Dropout在训练过程中随机丢弃一些神经元C. Dropout可以提高模型的泛化能力D. Dropout在测试阶段不使用18. L1正则化和L2正则化的主要区别是:A. L1正则化倾向于产生稀疏解,L2正则化倾向于产生平滑解B. L1正则化比L2正则化更容易计算C. L2正则化可以防止过拟合,L1正则化不能D. L1正则化适用于大规模数据集,L2正则化适用于小规模数据集七、优化算法19. 关于梯度下降法,下列描述正确的是:A. 梯度下降法一定会找到全局最小值B. 梯度下降法在鞍点处无法继续优化C. 梯度下降法包括批量梯度下降、随机梯度下降和小批量梯度下降D. 梯度下降法的学习率在整个训练过程中保持不变20. 下列哪种优化算法可以自动调整学习率?A. 随机梯度下降(SGD)B. Adam优化算法C. Momentum优化算法D. 牛顿法21. 关于Adam优化算法,下列描述错误的是:A. Adam结合了Momentum和RMSprop算法的优点B. Adam算法可以自动调整学习率C. Adam算法对每个参数都使用相同的学习率D. Adam算法在训练初期可能会不稳定八、损失函数22. 在分类问题中,下列哪种损失函数适用于二分类问题?A. 均方误差(MSE)B. 交叉熵损失函数C. Hinge损失函数D. 对数损失函数23. 关于均方误差(MSE)损失函数,下列描述错误的是:A. MSE适用于回归问题B. MSE对异常值敏感C. MSE的输出范围是[0, +∞)D. MSE损失函数的梯度在接近最小值时趋近于024. 下列哪种损失函数适用于多分类问题?A. 交叉熵损失函数B. Hinge损失函数C. 对数损失函数D. 均方误差(MSE)九、模型评估与超参数调优25. 下列哪种方法可以用来评估神经网络的性能?A. 训练误差B. 测试误差C. 学习率D. 隐层神经元数量26. 关于超参数,下列描述正确的是:A. 超参数是在模型训练过程中自动学习的B. 超参数的值通常由经验丰富的专家设定C. 超参数的调整对模型性能没有影响D. 超参数包括学习率、批量大小和损失函数27. 关于交叉验证,下列描述错误的是:A. 交叉验证可以减少过拟合的风险B. 交叉验证可以提高模型的泛化能力C. 交叉验证会降低模型的训练速度D. 交叉验证适用于小规模数据集十、发展趋势与挑战28. 下列哪种技术是近年来人工神经网络的一个重要发展方向?A. 深度学习B. 线性回归C. 决策树D. K最近邻29. 关于深度学习,下列描述错误的是:A. 深度学习需要大量标注数据B. 深度学习模型通常包含多层神经网络C. 深度学习可以处理复杂的非线性问题D. 深度学习不适用于小规模数据集30. 下列哪种现象是训练深度神经网络时可能遇到的挑战?A. 梯度消失B. 参数过多C. 数据不平衡D. 所有上述选项都是挑战答案一、基本概念1. B2. B二、前向传播与反向传播4. B5. B6. D三、激活函数7. B8. D9. A四、网络结构与优化10. B11. A12. D五、应用场景13. D14. D15. C六、训练技巧与正则化16. A17. A18. A七、优化算法19. C20. B八、损失函数22. B23. D24. A九、模型评估与超参数调优25. B26. B27. D十、发展趋势与挑战28. A29. D30. D。

人工智能与神经网络 第二次作业

2-1 状态空间法、问题归约法、谓词逻辑法和语义网络法的要点是什么?它们有何本质上的联系及异同点? 状态空间法:基于解答空间的问题表示和求解方法,它是以状态和算符为基础来表示和求解问题的。

问题归约法:从目标出发逆向推理,建立子问题以及子问题的子问题,直至最后把初始问题归约为一个平凡的本原问题集合。

这就是问题归约法的实质。

谓词逻辑法:允许表达那些无法用命题逻辑表达的事情,其目的在于把数学中的逻辑论证符号化。

语义网络法:语义网络是知识的一种结构化图解表示,它由节点和弧线或链线组成。

节点用于表示实体、概念和情况等,弧线用于表示节点间的关系。

联系及异同点:状态空间图需要扩展过多的节点,容易出现“组合爆炸”,因而只适用于表示比较简单的问题,它是正向推理,只能表示或的关系。

问题归约法能够比状态空间法更有效地表示问题,状态空间法是问题归约法的特例,是逆向推理,能表示与或关系。

谓词逻辑法是一种形式语言,能够把数学中的逻辑论证符号化,可以表示比较复杂的问题。

语义网络法可用于表示多元关系,扩展后可以表示更复杂的关系。

2-3 利用图2.3,用状态空间法规划一个最短的旅行路程:此旅程从城市A 开始,访问其他城市不多于一次,并返回A 。

选择一个状态表示,表示出所求得的状态空间的节点及弧线,标出适当的代价,并指明图中从起始节点到目标节点的最佳路径。

最佳路径:ACDEBA 或 ABEDCA 总代价:6+5+6+10+7=34如下图所示 ,所有路径(其中红色所标出的为所要找的最佳路径)710 7 101396 6510BEDAC 图 2.32-4试说明怎样把一棵与或解树用来表达图2.28所示的电网络阻抗的计算。

单独的R、L或C可分别用R、jωL或1/jωC来计算,这个事实用作本原问题。

后继算符应以复合并联和串联阻抗的规则为基础。

图 2.28约定,用原来的与后继算法用来表达并联关系,用原来的或后继算法用来表达串联关系2-6 把下列句子变换成子句形式:(1) (∀x){P(x)→P(x)}(2) ∀x∀y(On(x,y)→Above(x,y))(3) ∀x∀y∀z(Above(x,y)∧Above(y,z)→Above(x,z))(4) ~{(∀x){P(x)→{(∀y)[p(y)→p(f(x,y))]∧(∀y)[Q(x,y)→P(y)]}}}(1)(ANY x) { P(x)→P(x) } (ANY x) {~P(x) OR P(x)} ~P(x) OR P(x)最后子句为:~P(x) OR P(x)(2) (ANY x) (ANY y) { On(x,y)→Above(x,y) } (ANY x) (ANY y) { ~On(x,y) OR Above(x,y) }~On(x,y) OR Above(x,y)最后子句为:~On(x,y) OR Above(x,y)(3) (ANY x) (ANY y) (ANY z) { Above(x,y) AND Above(y,z) → Above(x,z) }(命题联结词之优先级如下:否定→合取→析取→蕴涵→等价)(ANY x) (ANY y) (ANY z) { ~ [ Above(x,y) AND Above(y,z) ] OR Above (x,z) }~ [ Above(x,y) AND Above(y,z) ] OR Above (x,z)最后子句为:~[Above(x,y), Above(y,z)] OR Above(x,z)(4) ~{ (ANY x) { P(x)→ { (ANY y) [ p(y)→p(f(x,y)) ] AND (ANY y) [ Q(x,y) → P(y) ] } } }~ { (ANY x) { ~P(x) OR { (ANY y) [ ~p(y) OR p(f(x,y)) ] AND (ANY y) [ ~Q(x,y) OR P(y) ] } } }(EXT x) { P(x) AND { (EXT x) [ p(y) AND ~p(f(x,y)) ] OR (EXT y) [ Q(x,y) AND ~P(y) ] } }(EXT x) { P(x) AND { (EXT w) [ p(y) AND ~p(f(w,y)) ] OR (EXT v) [ Q(x,v) AND ~P(v) ] } }P(A) AND { [ p(y) AND ~p(f(B,y)) ] OR [ Q(A,C) AND ~P(C) ] }P(A) AND { [ p(y) AND ~p(f(B,y)) OR Q(A,C) ] AND [ p(y) AND ~p(f(B,y)) OR ~P(C) ] }P(A) AND { { p(y), ~p(f(B,y)) } OR Q(A,C) } AND { { p(y), ~p(f(B,y)) } OR ~P(C) }最后子句为:P(A){ p(x), ~p(f(B,x)) } OR Q(A,C){ p(y), ~p(f(B,y)) } OR ~P(C)2-7 用谓词演算公式表示下列英文句子(多用而不是省用不同谓词和项。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

西安建筑科技大学研究生课程考试试卷考试科目:人工神经网络课程编码:071032任课教师:谷立臣考试时间:2014.4.30学号:1307841390 学生姓名:李宇峰SOM神经网络在滚动轴承振动诊断中的应用摘要:SOM网络是一种重要的无导师学习训练算法的神经网络,使用该算法进行训练后,可以将高维输入空间映射到二维空间上,并对故障现象进行自动分类,从而得出它们对应的故障原因。

本文归纳和总结了SOM神经网络多参数诊断法的实施步骤,阐述了轴承故障与振动信号之间的关系以及神经网络的工作原理和实现过程,通过实验研究,提取了反映滚动轴承故障类型的振动信号的特征参数,以构建训练神经网络的特征向量,利用MA TLAB人工神经网络工具箱模拟和仿真SOM神经网络,然后用训练后的SOM神经网络对故障模式进行识别。

关键词:振动;滚动轴承;故障诊断;SOM神经网络1故障轴承振动与信号的关系故障滚动轴承在受载运转时,当缺陷部位与工作表面接触,都将产生一次冲击力。

这种冲击力将激起轴承系统的振动,并通过适当的振动传递通道,以振动和声音的形式传出。

信号传递过程,如图1所示。

滚动轴承工作时,由传感器拾取的振动信号成分比较复杂,损伤引起的固有衰减振动只是其中的组成部分。

当损伤微小时,往往被其他信号淹没而难以被发现。

信号处理的目的就是突出这些损伤特征成分。

图1轴承振动信号传递过程2 SOM神经网络的结构和学习算法2.1神经网络结构自组织特征映射神经网络是芬兰神经网络专家Kohnen于1981年提出的,网络结构由输入层和输出层组成。

输入层为单层神经元排列,其作用是通过权向量将外界信息转到输出层神经元。

输出层也叫竞争层,输出层的神经元同它周围的神经元侧向连接,成棋盘状平面。

其神经元排列有多种形式,其最典型的是二维形式。

在初始状态下,这些二维的处理单元阵列上没有这些信号特征的分布拓扑图。

利用SOM模型的这一特性,可以从外界环境中按照某种测度或者是某种可有序化的拓扑空间来抽取特征或者是表达信号的、概念性的元素。

自组织特征映射神经网络模型结构如图2所示。

图2 SOM 神经网络结构示意图采用的学习算法是在胜者为王的基础上改进的。

其自组织学习过程可以描述为:对于每一个网络的输入,不仅获胜神经元本身要调整权向量,其周围的神经元在其影响下也要不同程度地调整权向量。

这一调整过程,就是学习—竞争—学习。

随着不断学习,所有权矢量都在输入矢量空间相互分离,形成各自代表输入空间的一种模式,即为网络的自组织聚类功能。

2.2 SOM 神经网络学习SOM 网络采用的学习算法称为Kohonen 算法,按如下步骤进行:(1) 初始化。

将网络数值向量集ˆjW (j=1,2,…,m)赋予[0,1]区间随机值,确定学习率初始值(0)η(0(0)1)η<<,确定邻域初始值()g N t 的领域(0)g N ,确定总学习次数T ,m 为输出层神经元数目。

(2) 接受输入。

从输入向量集中随机选取向量k P 提供给网络输入层,并进行归一化处理。

其公式如下:2221122/||||(,,,)/[()()()]k k k k k k k k k n n P P P P P P P P P ==++r L L(3) 寻找获胜节点。

计算k P r和ˆjW 的点积,从中选出点积最大的获胜节点*j ;计算欧式距离,找出距离最小的获胜节点。

(4) 定义优胜邻域。

*()j N t 设*j 为中心确定t 时刻的权值调整域,一般初始邻域*(0)j N 较大,训练过程中*()j N t 随训练时间收缩。

(5) 调整权值。

对优胜邻域*()j N t 内的所有节点调整权值(1)()(,)[()]pij ij i ij w t w t t N x w t α+=+-*1,2,,,()j i n j N t =∈L 其中:()ij w t 为神经元的权值;(,)t N α为训练时间t 和第j 个神经元与获胜神经元*j 之间的拓扑距离N 函数。

(6) 结束检查。

训练结束是以学习率()t η是否衰减到0或某个预定的正小数为条件,不满足条件则回到(2)。

3 滚动轴承故障诊断的SOM 神经网络 3.1 滚动轴承常见故障特征参数选择描述滚动轴承振动时域波形的常用指标有均方根值,在峰值因子、波形因子、脉冲因子、裕度因子和史数据并且对载荷和转速的变化比较敏感,而无量纲参数指标基本不受轴承型号、转速和载荷等因素的影响,无需考虑相对标准或与以前的数据进行比较,另外,它们不受信号绝对水平的影响,所以即使测试条件略有变化,对参数的计算结果也不会产生太大的影响。

选择峰值因子、波形因子、脉冲因子、裕度因子和峭度等5个无量纲参数组成表征滚动轴承运行状态的特征向量,并作为SOM 神经网络的输入参数。

3.2 SOM 神经网络样本数据的建立通过实验测得滚动轴承各种故障状态下的上述5个参数作为振动数据,经数据采集系统后,对数据进行时域信号处理,不停的对轴承的状态进行监测,对每种典型的故障形式分别进行三组标准样本的数据采集,最后提取采集的特征向量组成神经网络学习样本。

由于原始的采集数据值比较大,而且不便于后期的分析,故将原始的测量数据采用2221122/||||(,,,)/[()()()]k k k k k k k k k n n P P P P P P P P P ==++r L L 公式进行归一化处理,得到表1如下所示:表13.3 神经网络样本设计从实验采集中得到15个样本,每个样本用5个指数来表示轴承的状态。

网络的输入模式为即一共有15组样本,每个样本包含5个元素,这5个元素组成了滚动轴承运行状态的标准样本。

利用训练函数train 对网络进行训练,经过训练的网络可以对输入向量进行正确分类。

但是网络的训练步数如果不合适,太少或太多都将会导致很不理想的结果,所以训练的步数的设定对于网络的性能影响比较大,所以这里将步数设置为250,如图3所示。

步数设置为400,如图4所示。

步数设置为500,如图5所示,并分别观察其权值分布。

图3训练250步时的权值分布图4训练400步时的权值分布当训练步数为500步时,网络达到了较好的分类效果(过多的步数不仅运行慢,而且效果不明显),此时网络的竞争层为10×6的结构。

神经元自组织分布,每个神经元可以区分不同的样本。

网络训练结束后,权值也就固定了。

以后每输入一个值,网络就会自动地对其进行分类。

此时获胜神经元的连接权值,分别代表了相应该类故障样本的“聚类”中心,记录下每个训练样本在竞争层的输出位置。

各种故障的“聚类”中心在图中基本能够均匀分布,这样有利于对故障种类的清晰识别和诊断。

从而可得到结论:利用SOM网络对滚动轴承故障模式进行了成功的识别与分类。

利用sim函数来观察网络对训练样本数据的分类结果。

进行诊断时,只要输入样本激活的获胜神经元落入该“聚类”中心邻域内,就可诊断出该样本故障是“聚类”中心所对应的故障。

聚类结果,如图6所示。

图6标准样本训练结果图图7SOM网络拓扑学结构图8 临近神经元之间的距离情况⨯=个;都代表一种故障类型,空格处表示对所有输入都不兴奋由图7可知,竞争层神经元有10660图8中蓝色代表神经元,红色代表神经元之间直接的连接,每个菱形中的颜色表示神经元之间距离的远近,从黄色到黑色,颜色越深说明神经元之间的距离越远。

3.4 神经网络的检验为了检验建立的SOM网络的可靠性,分别进行试验采集滚动轴承正常状态、外圈损坏、保持架损坏、内圈损坏的振动信号各一组,进行轴承故障的识别验证。

检验样本的数据,如表2所示。

表2神经网络检验样本神经网络检测结果如下所示:y = (1,1) 1(12,2) 1(12,3) 1(4,4) 1(6,5) 1(41,7) 1(51,8) 1(53,9) 1(10,10) 1(29,11) 1(20,12) 1(47,13) 1(59,14) 1(56,15) 1yc =1 12 12 4 6 6 41 51 53 10 29 20 4759 56rr = 21 15 52 29 55从结果可以看到待检验样本完全落在了标准样本聚类的结果范围内,达到了很好地分类结果,证明该方法对于滚动轴承的故障诊断是准确有效的。

4 结论通过检验样本(表2)数据的网络实际输出与期望值的比较,可以发现它们十分接近,输出结果比较理想。

在分析自组织特征映射神经网络的结构和学习算法的基础上,利用自组织特征映射神经网络对滚动轴承进行故障诊断。

该神经网络对被控对象的数学模型依赖程度较低,具有自学习、自适应、联想记忆、较强的容错性和非线性模式识别的能力,同时应用神经网络工具箱进行仿真的结果表明,基于SOM神经网络的诊断模型是准确和可靠的,适合于滚动轴承多故障复杂模式的故障诊断。

本实验说明运用SOM神经网络可以有效的识别轴承的故障状态,同时也说明把滚动轴承振动信号进行时域分析所得的无量纲参数作为轴承故障分析的参数特征向量是可行的,为滚动轴承诊断问题提供了一个较好的解决方案。

参考文献:[1]李春华,肖洋.基于SOM神经网络的矿井提升机减速器齿轮故障诊断[J].矿山机械,2007(35).[2]余金宝,谷立臣,孙颖宏.利用SOM网络可视化方法诊断液压系统故障[J].工程机械,2007(38).[3]朱大奇,史慧.人工神经网络原理及应用[M].北京:科学出版社.2006:144-163.[4]闻新,周鑫,等.MATLAB神经网络仿真与应用[M].北京:科学出版社,2003.[5]周开利,康耀红.神经网络模型及其MATLAB仿真程序设计[M].北京:清华大学出版社,2005.程序如下:X=[0.4152 0.1221 0.5559 0.6248 0.3009;0.4111 0.1204 0.5510 0.6528 0.2946;0.4136 0.1235 0.5399 0.6565 0.3016;0.4338 0.0985 0.5373 0.6684 0.2580;0.4439 0.0954 0.5231 0.6711 0.2644;0.4507 0.0894 0.5268 0.6715 0.2549;0.3286 0.0572 0.5413 0.6995 0.3263;0.3221 0.0588 0.5413 0.7017 0.3279;0.3281 0.0536 0.5440 0.7043 0.3122;0.2608 0.0453 0.5393 0.7785 0.1815;0.2671 0.0459 0.5357 0.7791 0.1802;0.2598 0.0450 0.5515 0.7735 0.1674;0.4099 0.0728 0.4992 0.7313 0.2066;0.3971 0.0672 0.4983 0.7365 0.2169;0.4016 0.0669 0.5160 0.7252 0.2050]';%% 网络建立和训练% newsom建立SOM网络。