《神经网络控制》PPT课件

合集下载

神经网络控制基础人工神经网络课件ppt课件

其他工业领域应用案例

电力系统

神经网络控制可以应用于电力系统的负荷预测、故障诊断和稳定性 分析等方面,提高电力系统的运行效率和安全性。

化工过程控制

神经网络控制可以对化工过程中的各种参数进行实时监测和调整, 确保生产过程的稳定性和产品质量。

航空航天

神经网络控制在航空航天领域的应用包括飞行器的姿态控制、导航控 制和故障诊断等,提高飞行器的安全性和性能。

05 神经网络控制性能评估与优化

性能评估指标及方法

均方误差(MSE)

衡量神经网络输出与真实值之间的误差,值越小表示性能越好。

准确率(Accuracy)

分类问题中正确分类的样本占总样本的比例,值越高表示性能越好。

交叉验证(Cross-Validation)

将数据集分成多份,轮流作为测试集和训练集来评估模型性能。

强化学习在神经网络控制中应用

强化学习原理

通过与环境进行交互并根据反馈信号进行学习的方法,使神经网络能够自主学习 到最优控制策略。

强化学习算法

包括Q-learning、策略梯度等算法,用于求解神经网络控制中的优化问题,实现 自适应控制。

04 神经网络控制系统设计与实现

系统需求分析

功能性需求

明确系统需要实现的功能,如 数据输入、处理、输出等。

非监督学习

无需已知输出数据,通过挖掘输入数 据中的内在结构和特征进行学习,常 用于聚类、降维等任务。

深度学习在神经网络控制中应用

深度学习模型

通过构建深层神经网络模型,实现对复杂非线性系统的建模与控制,提高控制 精度和性能。

深度学习优化算法

采用梯度下降等优化算法对深度学习模型进行训练,提高训练效率和模型泛化 能力。

智能控制--神经网络控制PPT课件

11. 结合多神经网络自学习控制器的结构图,说明多神 经网络自学习控制系统的基本思想、原理和特点。

.

71

权衡的有效途径:进行多次仿真实验。

✓ 输入信号的选择

时域上,要求输入信号持续加在系统对象上,以便在辨识 时间内充分激励系统的所有模态、反映系统对象的完整 动态过程。(这里的输入信号是加在系统上的信号,也将构成神经

网络的输入或输出信号)

频域上,要求输入信号的频谱覆盖系统的频谱。

✓ 等价准则的选择

等价意味着按照某种误差评价准则,使确定的神经网络模 型最好地拟合所关心的被辨识系统的静态或动态特性。

.

43

(2) 再励学习(强化学习)

介于上述两种情况之间,外部环境只对输出结果给 出评价,而不给出具体答案,学习系统通过强化那 些受奖励的动作来改善自身的性能。

离线学习

对一批实现给定的系统输入输出样本数据进行离线 学习,建立系统的一个逆模型,然后用此逆模型进 行在线控制。

.

44

非线性系统 +

-

神经网络

.

25

神经网络辨识的特点(与传统辨识方法相比)

✓ 神经网络本身作为一种辨识模型,其可调参数反映在网 络内部的极值上,无需建立实际系统的辨识格式。

✓ 借助网络外部的输入/输出数据拟合系统的输入/输出关 系,可对本质非线性系统进行辨识。(网络内部隐含着系统的

特性)

✓ 辨识的收敛速度不依赖于被辨识系统的维数,只与神经 网络本身所采用的学习算法有关。

神经网络控制

.

1

神经网络控制的优越性

神经网络可以处理那些难以用模型或规则描述的过程 或系统。

神经网络采用并行分布式信息处理,具有很强的容错 性。

神经网络是本质非线性系统,可实现任意非线性映射。

.

71

权衡的有效途径:进行多次仿真实验。

✓ 输入信号的选择

时域上,要求输入信号持续加在系统对象上,以便在辨识 时间内充分激励系统的所有模态、反映系统对象的完整 动态过程。(这里的输入信号是加在系统上的信号,也将构成神经

网络的输入或输出信号)

频域上,要求输入信号的频谱覆盖系统的频谱。

✓ 等价准则的选择

等价意味着按照某种误差评价准则,使确定的神经网络模 型最好地拟合所关心的被辨识系统的静态或动态特性。

.

43

(2) 再励学习(强化学习)

介于上述两种情况之间,外部环境只对输出结果给 出评价,而不给出具体答案,学习系统通过强化那 些受奖励的动作来改善自身的性能。

离线学习

对一批实现给定的系统输入输出样本数据进行离线 学习,建立系统的一个逆模型,然后用此逆模型进 行在线控制。

.

44

非线性系统 +

-

神经网络

.

25

神经网络辨识的特点(与传统辨识方法相比)

✓ 神经网络本身作为一种辨识模型,其可调参数反映在网 络内部的极值上,无需建立实际系统的辨识格式。

✓ 借助网络外部的输入/输出数据拟合系统的输入/输出关 系,可对本质非线性系统进行辨识。(网络内部隐含着系统的

特性)

✓ 辨识的收敛速度不依赖于被辨识系统的维数,只与神经 网络本身所采用的学习算法有关。

神经网络控制

.

1

神经网络控制的优越性

神经网络可以处理那些难以用模型或规则描述的过程 或系统。

神经网络采用并行分布式信息处理,具有很强的容错 性。

神经网络是本质非线性系统,可实现任意非线性映射。

神经网络控制器课件

神经网络原理 王永骥 9

小车倒立摆系统的控制

1. 示意图 2. 数学model:

m Lϕ 2 sin ϕ − 3 / 8g sin( 2ϕ) − fx′ + u ′ x′ = M + m(1 − 3 / 4 cos2 ϕ)

[

]

3 ′ ϕ ′′ = ( g sin ϕ − x′ cosϕ ) 4L

令

NN在控制器设计中的几条路 存在的几个问题 本章简介

神经网络原理

王永骥

2

NN控制器几条路 NN控制器几条路

1. 与已有控制结构的结合,如:NN自适 应控制(NN MRAC 、NN STR:直接、 2. 间接)、NN-PID、NN-IMC(PC) 3. 与已有控制方法的结合,如:NN-Fuzzy 控制、NN-expert控制 4. NN特有的控制器设计方法,如:监督 学习控制(SNC)、评价学习控制器 (ACE)、无模型的控制器设计方法 (单个元的或网络的,即按误差调整的)

一般控制系统可包含前馈和反馈控制器两种 (前馈:由期望输出产生控制信号,反馈:由 期望与实际之差产生控制信号) MRAC思路是给定期望响应的动态模型, 利用期望与实际输出之差去改变调节器参数, 使对象+控制器形成的闭环系统对给定信号的 响应与参考模型一致。当给定模型稳定时,闭 环系统稳定并改善了动态响应。 调节机构设计:可利用Lyapunov或Popov方法 以保证闭环的稳定

参考模型

神经网络原理

王永骥

23

NN MRAC 图

神经网络原理

王永骥

24

NN控制框图 NN控制框图

神经网络原理

王永骥

25

MRAC训练数据 MRAC训练数据

神经网络原理

小车倒立摆系统的控制

1. 示意图 2. 数学model:

m Lϕ 2 sin ϕ − 3 / 8g sin( 2ϕ) − fx′ + u ′ x′ = M + m(1 − 3 / 4 cos2 ϕ)

[

]

3 ′ ϕ ′′ = ( g sin ϕ − x′ cosϕ ) 4L

令

NN在控制器设计中的几条路 存在的几个问题 本章简介

神经网络原理

王永骥

2

NN控制器几条路 NN控制器几条路

1. 与已有控制结构的结合,如:NN自适 应控制(NN MRAC 、NN STR:直接、 2. 间接)、NN-PID、NN-IMC(PC) 3. 与已有控制方法的结合,如:NN-Fuzzy 控制、NN-expert控制 4. NN特有的控制器设计方法,如:监督 学习控制(SNC)、评价学习控制器 (ACE)、无模型的控制器设计方法 (单个元的或网络的,即按误差调整的)

一般控制系统可包含前馈和反馈控制器两种 (前馈:由期望输出产生控制信号,反馈:由 期望与实际之差产生控制信号) MRAC思路是给定期望响应的动态模型, 利用期望与实际输出之差去改变调节器参数, 使对象+控制器形成的闭环系统对给定信号的 响应与参考模型一致。当给定模型稳定时,闭 环系统稳定并改善了动态响应。 调节机构设计:可利用Lyapunov或Popov方法 以保证闭环的稳定

参考模型

神经网络原理

王永骥

23

NN MRAC 图

神经网络原理

王永骥

24

NN控制框图 NN控制框图

神经网络原理

王永骥

25

MRAC训练数据 MRAC训练数据

神经网络原理

神经网络控制

M—P模型的提出兴起了对神经网络的研究。

(2) 1949年心理学家D.O.Hebb提出神经元之间突触联系强度可变 的假设。他认为学习过程是在突触上发生的,突触的联系强度随其前 后神经元的活动而变化。根据这一假设提出的学习率为神经网络的学 习算法奠定了基础。

(3) 1958年,Rosenblatt提出感知机,第一次把神经网络的研究付 诸工程实践。这是一种学习和自组织的心理学模型,它基本上符合 神经生理学的知识,模型的学习环境是有噪声的,网络构造中存在 随机连接,这符合动物学习的自然环境。这种类型的机器显然有可 能应用于模式识别、联想记忆等方面。

3.兴盛阶段

再次兴起的原因:

(1)计算机不具备学习能力。在处理能明确定义的问题或运用能明 确定义的概念作为知识时,计算机比较容易对它们进行处理,但是对 一些知识背景不清楚、推理规则不明确、环境信息十分复杂的知识处 理或是算法难以提取的信息处理任务往往感到很困难。 (2)日本第五代机计划远未达到预想水平,也倾向使人觉得有必要 进一步弄清人们习以为常的认知功能是如何进行的.这些认知功能包 括视、听觉感知,学习记忆,运动控制等.从而使人们认识到不能拘 泥一格而必须开拓新的思路,探索新的人类智能实现途径。这时原来 已出现过的,与人脑的生理组织更为接近的神经网络模型就自然成为 理想的候选模型。

兴盛阶段的标志:

(1)近些年来.许多科学家提出了许多种具备不同信息处理能力的神 经网络模型,至今为止。约已开发出了三十多种。神经网络也 被应用到了许多信息处理领域,如模式别、自动控制、信号处理、辅助 决策、人工智能等等。 (2)神经计算机的研究也为神经网络的理论研究和应用研究促供了 强有力的支持,各大学、科研团体和公司开发了许多神经网络模拟软 件包、各种型号的电子神经计算机以及许多神经网络芯片。 (3)1987年6月在美国加州举行了第一届神经网络国际会议,并成立 了国际神经网络学会,以后每年召开两次国际联合神经网络大会 (IJCNN)。 1990年12月在北京召开了我国首届神经网络学术大会,在南 京召开的1991中国神经网络学术大会上成上了中国神经网络学会。当前 发行了两种专门介绍神经网络研究的刊物,《IEEE Transaction on Neural Network》和《Neural Network》

第6章神经网络控制PPT课件

18

第18页/共52页

4.竞争式学习 • 竞争式学习属于无教师学习方式。此种学习方式利用不同层间的神经元发生兴

奋性联接,以及同一层内距离很近的神经元间发生同样的兴奋性联接,而距离 较远的神经元产生抑制性联接。在这种联接机制中引人竟争机制的学习方式称 为竟争式学习。它的本质在于神经网络中高层次的神经元对低层次神经元的输 入模式进行竞争识别。

• 2). 网络能通过学习带正确答案的实例集自动提取“合理的”求 解规则,即具有自学习能力;

30

第30页/共52页

2.多层前向BP网络的问题:

1). BP算法的学习速度很慢 2). 网络训练失败的可能性较大 3). 难以解决应用问题的实例规模和网络规模间 的矛盾 4). 网络结构的选择尚无一种统一而完整的理论 指导,一般只能由经验选定 5). 新加入的样本要影响已学习成功的网络,而 且刻画每个输入样本的特征的数目也必须相同 6). 网络的预测能力第(31页也/共称52页泛化能力、推广能力) 31

33

第33页/共52页

神经网络训练的具体步骤如下

1.获取训练样本集

获取训练样本集合是训练神经网络的第一步,也是十 分重要和关键的一步。它包括训练数据的收集、分析、 选择和预处理等

2.选择网络类型与结构

神经网络的类型很多,需要根据任务的性质和要求来 选择合适的网络类型。

3.训练与测试

最后一步是利用获取的训练样本对网络进行反复训练, 直至得到合适的映射结果。

3.BP网络学习算法的改进

• 1). 增加“惯性项 • 2). 采用动态步长 • 3). 与其他全局搜索算法相结合 • 4). 模拟退火算法

• 目前在神经网络的学习中,基于梯度的算法都不能从理论上保证收敛结果是 全局最优的。

第18页/共52页

4.竞争式学习 • 竞争式学习属于无教师学习方式。此种学习方式利用不同层间的神经元发生兴

奋性联接,以及同一层内距离很近的神经元间发生同样的兴奋性联接,而距离 较远的神经元产生抑制性联接。在这种联接机制中引人竟争机制的学习方式称 为竟争式学习。它的本质在于神经网络中高层次的神经元对低层次神经元的输 入模式进行竞争识别。

• 2). 网络能通过学习带正确答案的实例集自动提取“合理的”求 解规则,即具有自学习能力;

30

第30页/共52页

2.多层前向BP网络的问题:

1). BP算法的学习速度很慢 2). 网络训练失败的可能性较大 3). 难以解决应用问题的实例规模和网络规模间 的矛盾 4). 网络结构的选择尚无一种统一而完整的理论 指导,一般只能由经验选定 5). 新加入的样本要影响已学习成功的网络,而 且刻画每个输入样本的特征的数目也必须相同 6). 网络的预测能力第(31页也/共称52页泛化能力、推广能力) 31

33

第33页/共52页

神经网络训练的具体步骤如下

1.获取训练样本集

获取训练样本集合是训练神经网络的第一步,也是十 分重要和关键的一步。它包括训练数据的收集、分析、 选择和预处理等

2.选择网络类型与结构

神经网络的类型很多,需要根据任务的性质和要求来 选择合适的网络类型。

3.训练与测试

最后一步是利用获取的训练样本对网络进行反复训练, 直至得到合适的映射结果。

3.BP网络学习算法的改进

• 1). 增加“惯性项 • 2). 采用动态步长 • 3). 与其他全局搜索算法相结合 • 4). 模拟退火算法

• 目前在神经网络的学习中,基于梯度的算法都不能从理论上保证收敛结果是 全局最优的。

4-4神经网络控制PPT课件

4.4 几种典型的神经网络

网络输出 u x )的非线性映射,径向基 RBF网络的输入层到隐含层实现 x i( 网络隐含层节点的作用函数一般取下列几种形式

最常用的是高斯激活函数

采用高斯基函数,具备如下优点: (1)表示形式简单,即使对于多变量输入也不增加太多的复改性; (2)径向对称; (3)光滑性好,任意阶导数存在; (4)由于该基函数表示简单且解析性好,因而使于进行理论分析。

其中,f 函数为Sigmoid函数

4.4 几种典型的神经网络

(4)调整权值,按误差反向传播方向,从输出节点开始返回到隐层按下式 修正权值

(5)返回第(2)步重复,直至误差满足要求为止。 使用BP算法应注意的几个问题 (1)学习速率 η的选锋非常重要。 (2)在设置各训练样本的期望输出分量时,不能设置为1或0,以设置为 0.9或0.1较为适宜。 (3)若实际问题给予网络的输入量较大,需做归一化处理,网络的输出也 要进行相应的处理。 (4)各加权系数的初值以设置为随机数为宜。 (5)在学习过程中,应尽量避免落入某些局部最小值点上,引入惯性项有 可能使网络避免落入某一局部最小值。

4.4 几种典型的神经网络

4.4.2 径向基神经网络

1985年,Powell提出了多变量插值的径向基函数(Radial Basis Function,RBF)方法。 径向基函数网络比BP网络需要更多的神经元,但是它能够按时间片 来训练网络。径向基网络是一种局部逼近网络,已证明它能以任意精度 逼近任一连续函数。 构成RBF网络的基本思想:用RBF作为隐单元的“基”构成隐含层 空间,这样就可将输入矢量直接(即不通过权连接)映射到隐空间。当 RBF的中心点确定以后,这种映射关系也就确定了。而隐含层空间到输 出空间的映射是线性的,即网络的输出是隐单元输出的线性加权和。此 处的权即为网络可调参数。

第9章 神经网络控制 智能控制第二版PPT

(5)神经网络的硬件实现愈趋方便。大规模集成电路 技术的发展为神经网络的硬件实现提供了技术手段, 为神经网络在控制中的应用开辟了广阔的前景。

神经网络控制所取得的进展为:

(1) 基于神经网络的系统辨识:可在已知常规模型结构 的情况下,估计模型的参数;或利用神经网络的线性、 非线性特性,建立线性、非线性系统的静态、动态、 逆动态及预测模型;

近似地取

u p k w j k

un k w j k

由此所产生的不精确通过权值调节来补偿。

则

w

j

k

Ek w j k

un

k

uk

u p w j

k k

un k uk h j k

神经网络权值的调整过程为:

Wk Wk 1 WkWk 1 Wk 2

其中 η为学习速率, 为动量因子。

9.4.2 仿真实例

u

参考模型

ym t

ect

-

+

rt + et

ut

yt

NNC

对象

-

图9-4 神经网络直接模型参考自适应控制

(2)间接模型参考自适应控制

如图9-5所示。神经网络辨识器NNI向神经 网络控制器NNC提供对象的信息,用于控制器 NNC的学习。

参考模型

ym t

ec t

-

+

rt + et

ut

yt

NNC

下单变量仿射非线性系统:

yk1 f yk gyk uk

若利用神经网络对非线性函数f yk 和 gyk 进 行逼近,得到 fˆyk 和 gˆyk ,则控制器为:

uk rk1 fˆyk / gˆyk

其中 rk 1 为 k 1 时刻的期望输出值。

神经网络控制所取得的进展为:

(1) 基于神经网络的系统辨识:可在已知常规模型结构 的情况下,估计模型的参数;或利用神经网络的线性、 非线性特性,建立线性、非线性系统的静态、动态、 逆动态及预测模型;

近似地取

u p k w j k

un k w j k

由此所产生的不精确通过权值调节来补偿。

则

w

j

k

Ek w j k

un

k

uk

u p w j

k k

un k uk h j k

神经网络权值的调整过程为:

Wk Wk 1 WkWk 1 Wk 2

其中 η为学习速率, 为动量因子。

9.4.2 仿真实例

u

参考模型

ym t

ect

-

+

rt + et

ut

yt

NNC

对象

-

图9-4 神经网络直接模型参考自适应控制

(2)间接模型参考自适应控制

如图9-5所示。神经网络辨识器NNI向神经 网络控制器NNC提供对象的信息,用于控制器 NNC的学习。

参考模型

ym t

ec t

-

+

rt + et

ut

yt

NNC

下单变量仿射非线性系统:

yk1 f yk gyk uk

若利用神经网络对非线性函数f yk 和 gyk 进 行逼近,得到 fˆyk 和 gˆyk ,则控制器为:

uk rk1 fˆyk / gˆyk

其中 rk 1 为 k 1 时刻的期望输出值。

神经网络控制器课件

神经网络原理

王永骥

5

监督学习NN控制器

问题的提出 SNC设计:

控制系统结构 思路 实例

神经网络原理 王永骥 6

问题的提出

当对象动力学特性未知时系统可控, 人的知识如何传递给控制装置?

解决思路:

1) 利用专家控制、规则控制 2) 采用监督(导师)NN控制(SNC)

神经网络原理

王永骥

7

控制系统结构

神经网络原理 王永骥 3

存在的几个问题

5. 缺乏一种专门适用于控制的动态神经网 络(目前方法:静态网络处理动态问题, 不可避免的带来差分方程定阶问题) 6. 稳定性、鲁棒型分析困难

神经网络原理

王永骥

4

本章简介

1) 2) 3) 4) 5) 6)

学习控制(监督) NN自适应(MRAC和STR) NN-PID NN-无模型控制(单个神经元) NN-Fuzzy(思想) 有关稳定性的一些成果

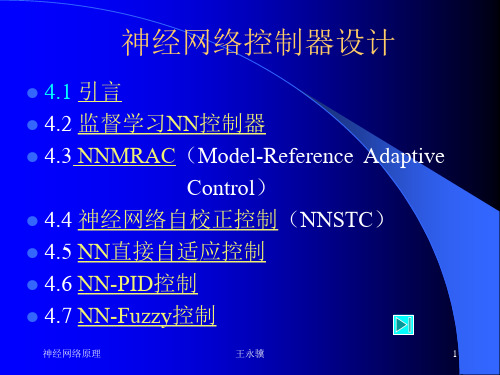

神经网络控制器设计

4.1 引言 4.2 监督学习NN控制器 4.3 NNMRAC(Model-Reference Adaptive Control) 4.4 神经网络自校正控制(NNSTC) 4.5 NN直接自适应控制 4.6 NN-PID控制 4.7 NN-Fuzzy控制

神经网络原理

王永骥

12

控制结果

1) 线性控制为状态反馈:

训练20000次后NN可实现线性律 K=[11.01,19.68,96.49,35.57] 2) 非线性:80000次 反馈线性化及解耦变换 3) 人控制:40000次 训练结束后,HSNC比 人本身操作更好 训练后,SNC还可继续在线学习以 适应新的扰动、取得新的控制策略样本、 增强对系统的全面了解。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

➢网络输出 RBF网络的输入层到隐含层实现 xui(x)的非线性映射,径向基

网络隐含层节点的作用函数一般取下列几种形式

最常用的是高斯激活函数

采用高斯基函数,具备如下优点: (1)表示形式简单,即使对于多变量输入也不增加太多的复改性; (2)径向对称; (3)光滑性好,任意阶导数存在; (4)由于该基函数表示简单且解析性好,因而使于进行理论分析。

h

12

4.4 几种典型的神经网络

➢RBF网络助学习过程 RBF网络的学习过程分为两个阶段。第一阶段是无教师学习;第二

阶段是有教师学习。

(1)无教师学习阶段

(a)给定各隐节点的初始中心向量 ci (0) 和判定停止计算的 (b)计算距离(欧氏距离)并求出最小距离的节点;

(c)调整中心

(d)判定聚类质量 对于全部样本 k反复进行以上(b),(c)步,直至满足以上条件。

h

14

4.4 几种典型的神经网络

➢ RBF网络有关的几个问题

(1)从理论上而言,RBF网络和BP网络一样可近似任何连续非线性函数。 (2)已证明RBF网络具有惟一最佳通近的特性,且无局部极小。 (3)求RBF网络隐节点的中心向量 c i 和标准化常数 i 是一个困难的问题。 (4)径向基函数,即径向对称函数有多种。 (5)RBF网络虽具有惟一最佳逼近的特性以及无局部极小的优点,但隐节 点的中心难求,这是该网络难以广泛应用的原因。 (6) RBF网络学习速度很快,适于在线实时控制。

构成RBF网络的基本思想:用RBF作为隐单元的“基”构成隐含层空 间,这样就可将输入矢量直接(即不通过权连接)映射到隐空间。当RBF 的中心点确定以后,这种映射关系也就确定了。而隐含层空间到输出空 间的映射是线性的,即网络的输出是隐单元输出的线性加权和。此处的 权即为网络可调参数。

h

9

4.4 几种典型的神经网络

(2)计算一个单元所接受总输入变化时的误差导数EI,EI实际上等于上述 步骤(1)的结果乘以一个单元的总输入变化时其输出的变化率,即

(3)计算一个与输出单元联接权值改变时的误差变化率EW

(4)为了计算对误差总的影响,把对各输出单元的所有单独影响相加

h

4

4.4 几种典型的神经网络

运用步骤(2)和(4),可把一层单元的EA变成前面一层单元的EA,为 了得到期望的前面各层的EA,可重复此计算步骤。当得到一个单元的 EA后,可用步骤(2)和(3)来计算作用于它的输入联接上的EW。 ➢BP算法的计算机实现流程 (1)初始化,对所有权值赋以随机任意小值,并对阈值设定初值; (2)给定训练数据集,即提供输入向量 X和期望输出 y ; (3)计算实际输出 y

h

11

4.4 几种典型的神经网络

考虑到提高网络精度和减少隐含层节点数,也可以将网络激活函数 改成多变量正态密度函数

式中,K E [x (ci)T(xci) 1]是输入协方差阵的逆。 RBF网络的隐含层到输出层实现 ui(x)yk的线性映射,即

式中,u i 是隐含层第 i个节点的输出;y k 是输出层第 k个节点的输出; wki 是隐含层到输出层的加权系数; k 是输出层的阀值;q是隐含层节点数。

BP学习算法的基本原理是梯度最速下降法,它的中心思想是调整权 值使网络总误差最小。

h

2

4.4 几种典型的神经网络

多层网络运用BP学习算法时,实际上包含了正向和反向传播两个阶 段。在正向传播过程中,输入信息从输入层经隐含层逐层处理,并传向 输出层,每一层神经元的状态只影响下一层神经元的状态。如果在输出 层不能得到期望输出,则转入反向传播,将误差信号沿原来的连接通道 近回,通过修改各层神经元的权值,使误差信号最小。

h

6

7

8

4.4 几种典型的神经网络

4.4.2 径向基神经网络

1985年,Powell提出了多变量插值的径向基函数(Radial Basis Function,RBF)方法。

径向基函数网络比BP网络需要更多的神经元,但是它能够按时间片 来训练网络。径向基网络是一种局部逼近网络,已证明它能以任意精度 逼近任一连续函数。

第4章 神经网络控制

h

1

4.4 几种典型的神经网络

按照神经网络的拓扑结构与学习算法相结合的方法可将神经网络的 类型分为前馈网络、竞争网络、反馈网络和随机网络四大类。

4.4.1 BP神经网络

1986年,D. E. Rumelhart和J. L. McClelland提出了一种利用误差反 向传播训练算法的神经网络,简称BP(Back Propagation)网络,是一种有 隐含层的多层前馈网络,系统地解决了多层网络中隐含单元连接权的学 习问题。 ➢BP算法原理

其中,f 函数为Sigmoid函数

h

5

4.4 几种典型的神经网络

(4)调整权值,按误差反向传播方向,从输出节点开始返回到隐层按下式 修正权值

(5)返回第(2)步重复,直至误差满足要求为止。 ➢使用BP算法应注意的几个问题 (1)学习速率 η的选锋非常重要。 (2)在设置各训练样本的期望输出分量时,不能设置为1或0,以设置为 0.9或0.1较为适宜。 (3)若实际问题给予网络的输入量较大,需做归一化处理,网络的输出也 要进行相应的处理。 (4)各加权系数的初值以设置为随机数为宜。 (5)在学习过程中,应尽量避免落入某些局部最小值点上,引入惯性项有 可能使网络避免落入某一局部最小值。

h

13

4.4 几种典型的神经网络

(2)有教师学习阶段 有教师学习也称为有监督学习。当 c i 确定以后,训练由隐含层至

输出层之间的权值,由上可知,它是一个线性方程组,则求权值就成为 线性优化问题。

隐含层至输出层之间的连接权值 wki 学习算法为

式中,u[u1(x)u2(x) uq(x)T ],ui ( x) 为高斯函数。

➢径向基函数网络模型 RBF网络由两层组成,其结构如图4-10所示。

图4-10 RBF网络的结构

输入层节点只是传递输入信号到隐含层,隐含层节点由像高斯核函数那 样的辐射状作用函数构成,而输出层节点通常是简单的线性函数。隐含 层节点中的作用函数(核函数)对输入信号将在局部产生响应。

h

10

4.4 几种典型的神经网络

这种网络没有反馈存在,实际运行仍是单向的,所以本能将其看成 是一非线性动力学系统,而只是一种非线性映射关系。具有隐含层BP网 络的结构如图4-9所示。

图4-9 BP网络的结构

h

3

4.4 几种典型的神经网络

➢误差反向传播算法的计算步骤 (1)计算一个输出单元活性改变时的误差导数EA,即实际活性与期望活 性的差值

网络隐含层节点的作用函数一般取下列几种形式

最常用的是高斯激活函数

采用高斯基函数,具备如下优点: (1)表示形式简单,即使对于多变量输入也不增加太多的复改性; (2)径向对称; (3)光滑性好,任意阶导数存在; (4)由于该基函数表示简单且解析性好,因而使于进行理论分析。

h

12

4.4 几种典型的神经网络

➢RBF网络助学习过程 RBF网络的学习过程分为两个阶段。第一阶段是无教师学习;第二

阶段是有教师学习。

(1)无教师学习阶段

(a)给定各隐节点的初始中心向量 ci (0) 和判定停止计算的 (b)计算距离(欧氏距离)并求出最小距离的节点;

(c)调整中心

(d)判定聚类质量 对于全部样本 k反复进行以上(b),(c)步,直至满足以上条件。

h

14

4.4 几种典型的神经网络

➢ RBF网络有关的几个问题

(1)从理论上而言,RBF网络和BP网络一样可近似任何连续非线性函数。 (2)已证明RBF网络具有惟一最佳通近的特性,且无局部极小。 (3)求RBF网络隐节点的中心向量 c i 和标准化常数 i 是一个困难的问题。 (4)径向基函数,即径向对称函数有多种。 (5)RBF网络虽具有惟一最佳逼近的特性以及无局部极小的优点,但隐节 点的中心难求,这是该网络难以广泛应用的原因。 (6) RBF网络学习速度很快,适于在线实时控制。

构成RBF网络的基本思想:用RBF作为隐单元的“基”构成隐含层空 间,这样就可将输入矢量直接(即不通过权连接)映射到隐空间。当RBF 的中心点确定以后,这种映射关系也就确定了。而隐含层空间到输出空 间的映射是线性的,即网络的输出是隐单元输出的线性加权和。此处的 权即为网络可调参数。

h

9

4.4 几种典型的神经网络

(2)计算一个单元所接受总输入变化时的误差导数EI,EI实际上等于上述 步骤(1)的结果乘以一个单元的总输入变化时其输出的变化率,即

(3)计算一个与输出单元联接权值改变时的误差变化率EW

(4)为了计算对误差总的影响,把对各输出单元的所有单独影响相加

h

4

4.4 几种典型的神经网络

运用步骤(2)和(4),可把一层单元的EA变成前面一层单元的EA,为 了得到期望的前面各层的EA,可重复此计算步骤。当得到一个单元的 EA后,可用步骤(2)和(3)来计算作用于它的输入联接上的EW。 ➢BP算法的计算机实现流程 (1)初始化,对所有权值赋以随机任意小值,并对阈值设定初值; (2)给定训练数据集,即提供输入向量 X和期望输出 y ; (3)计算实际输出 y

h

11

4.4 几种典型的神经网络

考虑到提高网络精度和减少隐含层节点数,也可以将网络激活函数 改成多变量正态密度函数

式中,K E [x (ci)T(xci) 1]是输入协方差阵的逆。 RBF网络的隐含层到输出层实现 ui(x)yk的线性映射,即

式中,u i 是隐含层第 i个节点的输出;y k 是输出层第 k个节点的输出; wki 是隐含层到输出层的加权系数; k 是输出层的阀值;q是隐含层节点数。

BP学习算法的基本原理是梯度最速下降法,它的中心思想是调整权 值使网络总误差最小。

h

2

4.4 几种典型的神经网络

多层网络运用BP学习算法时,实际上包含了正向和反向传播两个阶 段。在正向传播过程中,输入信息从输入层经隐含层逐层处理,并传向 输出层,每一层神经元的状态只影响下一层神经元的状态。如果在输出 层不能得到期望输出,则转入反向传播,将误差信号沿原来的连接通道 近回,通过修改各层神经元的权值,使误差信号最小。

h

6

7

8

4.4 几种典型的神经网络

4.4.2 径向基神经网络

1985年,Powell提出了多变量插值的径向基函数(Radial Basis Function,RBF)方法。

径向基函数网络比BP网络需要更多的神经元,但是它能够按时间片 来训练网络。径向基网络是一种局部逼近网络,已证明它能以任意精度 逼近任一连续函数。

第4章 神经网络控制

h

1

4.4 几种典型的神经网络

按照神经网络的拓扑结构与学习算法相结合的方法可将神经网络的 类型分为前馈网络、竞争网络、反馈网络和随机网络四大类。

4.4.1 BP神经网络

1986年,D. E. Rumelhart和J. L. McClelland提出了一种利用误差反 向传播训练算法的神经网络,简称BP(Back Propagation)网络,是一种有 隐含层的多层前馈网络,系统地解决了多层网络中隐含单元连接权的学 习问题。 ➢BP算法原理

其中,f 函数为Sigmoid函数

h

5

4.4 几种典型的神经网络

(4)调整权值,按误差反向传播方向,从输出节点开始返回到隐层按下式 修正权值

(5)返回第(2)步重复,直至误差满足要求为止。 ➢使用BP算法应注意的几个问题 (1)学习速率 η的选锋非常重要。 (2)在设置各训练样本的期望输出分量时,不能设置为1或0,以设置为 0.9或0.1较为适宜。 (3)若实际问题给予网络的输入量较大,需做归一化处理,网络的输出也 要进行相应的处理。 (4)各加权系数的初值以设置为随机数为宜。 (5)在学习过程中,应尽量避免落入某些局部最小值点上,引入惯性项有 可能使网络避免落入某一局部最小值。

h

13

4.4 几种典型的神经网络

(2)有教师学习阶段 有教师学习也称为有监督学习。当 c i 确定以后,训练由隐含层至

输出层之间的权值,由上可知,它是一个线性方程组,则求权值就成为 线性优化问题。

隐含层至输出层之间的连接权值 wki 学习算法为

式中,u[u1(x)u2(x) uq(x)T ],ui ( x) 为高斯函数。

➢径向基函数网络模型 RBF网络由两层组成,其结构如图4-10所示。

图4-10 RBF网络的结构

输入层节点只是传递输入信号到隐含层,隐含层节点由像高斯核函数那 样的辐射状作用函数构成,而输出层节点通常是简单的线性函数。隐含 层节点中的作用函数(核函数)对输入信号将在局部产生响应。

h

10

4.4 几种典型的神经网络

这种网络没有反馈存在,实际运行仍是单向的,所以本能将其看成 是一非线性动力学系统,而只是一种非线性映射关系。具有隐含层BP网 络的结构如图4-9所示。

图4-9 BP网络的结构

h

3

4.4 几种典型的神经网络

➢误差反向传播算法的计算步骤 (1)计算一个输出单元活性改变时的误差导数EA,即实际活性与期望活 性的差值