语义分析练习题

《语言学导论》(练习题及答案)

《语言学导论》(练习题及答案)语言学导论练题及答案1. 什么是语言学?语言学是研究语言的科学。

它涉及语言的结构、演化、语音、语法、语义、语用等方面的研究。

2. 语言学的主要分支有哪些?- 语音学:研究语音的产生、传播和感知。

- 语法学:研究语言的规则和结构。

- 语义学:研究语言意义的构成和理解。

- 语用学:研究语言在特定情境下的使用和交际功能。

- 社会语言学:研究语言与社会的关系。

3. 什么是语言的结构?语言的结构是指语言中各个层次(如语音、词汇、句子等)的组织方式和规则。

4. 语音学研究的是什么?语音学研究语音的产生、传播和感知。

它关注语音的音素、音位、音节以及音系等方面。

5. 语法学研究的是什么?语法学研究语言的规则和结构。

它涉及句子的构成和分析,包括词类、短语、句法关系等。

6. 语义学研究的是什么?语义学研究语言意义的构成和理解。

它关注词汇、句子和篇章层面的语义关系和意义表达。

7. 语用学研究的是什么?语用学研究语言在特定情境下的使用和交际功能。

它关注言语行为、话语策略和交际意图等。

8. 社会语言学研究的是什么?社会语言学研究语言与社会的关系。

它探讨语言在不同社会群体中的变化、语言的地位和使用情境等。

9. 语言学在日常生活中的应用有哪些?- 语言教育:帮助人们研究和教授语言。

- 语音技术:开发语音识别和合成等技术。

- 翻译和口译:促进不同语言之间的交流和理解。

- 语言规范:制定语法规则、文字标准等。

- 语义分析:帮助机器理解和处理自然语言。

10. 语言学为理解人类语言能力提供了哪些洞见?语言学研究揭示了语言是人类认知和交流的基本工具,提供了对语言产生、理解、学习和变化的深入认识。

2023届高考语文语言文字运用之赏析句子表达效果比较练习题

2023届高考语文语言文字运用之赏析句子表达效果比较练习题表达效果对比分析常见的鉴赏角度:句式变化、修辞手法、精妙用词、语体风格、篇章结构、逻辑顺序、人称使用、陈述对象、语言特点等。

解题思路:1.找不同:对比分析,找准改句与原句在表达方式和表达内容上有什么不同。

2.明角度:在第一步的基础上进行深入思考,体味原句表达方式有什么特点,表达内容有什么内涵;明确从那几个角度来作答,也就是踩准得分点。

3.定答案:在第二步的基础上,对原句的表达方式、表达内容的效果进行深入、透彻的分析。

专项习题逛消博会时,8大展馆、2800余个参展品牌、100余场配套活动,很难一一全看仔细。

走马观花下来,日行两万步不在话下。

美妆、珠宝、葡萄酒、时装、瑞士酒吧、特色小食……人们在人来人往中一路观看,在目不暇接中一路品味,在车水马龙中一路体验,消博会为参观者勾勒出了美好生活的样子,既有趣,又有料。

1、文中画波浪线的句子若改写成:“人们在人来人往、目不暇接、车水马龙中一路观看、品味和体验美妆、珠宝、葡萄酒、时装、瑞士酒吧、特色小食……有趣有料的消博会为参观者勾勒出了美好生活的样子。

”从语义上看,与原文基本相同,但原文表达效果更好,为什么?哈尼人垦殖梯田的想象力无比丰富:小者如簸箕,大则数亩地;低者几十层,最高近四千级。

哈尼梯田依山顺势、层层叠叠、连绵向上,直通云海。

2.文中画波浪线的部分与“大大小小,高高低低,依着山势,连绵高耸”语意基本相同,但原文的表达效果更好,请对此进行分析。

多少珍贵的动植物永远地沦为了标本?多少生态活页从我们的视野中被硬硬撕掉?多少诗词风光如“广陵散”般成了遥远的绝唱?3.文中画波浪线的句子可以改写成:“许多的诗词风光如‘广陵散’般成了遥远的绝唱,大量珍贵的动植物永远地成为了标本,无数的生态活页走出了我们的视野。

”改句与原文句意基本相同,但原文表达效果更好,为什么?水边多凤尾竹,随着微风摇曳着身姿,在碧波中照影儿。

自考_语言学概论_分章节练习题[1]

![自考_语言学概论_分章节练习题[1]](https://img.taocdn.com/s3/m/4f3b640dec630b1c59eef8c75fbfc77da26997a0.png)

自考_语言学概论_分章节练习题[1]第一章语言和语言学一、单项选择题1.语言的客观存在形式首先表现为口语。

语言学是指研究语言的科学。

2.在个别情况下,当口语已经发生巨大变化而书面语长期保持古代语言的面貌不变时,就可能产生言文脱节的现象。

3.在我国,白话文代替文言文的时间是五四运动以后。

4.世界各国都把书面语的产生作为文明史的开端。

5.共同的历史文化传统和民族认同感是确定一个“民族”的最根本的标准。

6.语言是最直观最容易识别的民族标志。

7.口语是语言的有声客观存在形式。

8.书面语虽然在口语的基础上产生,但也影响口语的发展。

9.口语和书面语都有两个方面:一方面是表示一定意义的声音或图形,这是一种物理现象;另一方面则是由声音或图形表示的意义,那是一种心理现象。

10.人与人的口头交际过程是非常复杂的,从通信理论的角度可以将之理解为编码和解码的过程。

11.主张把语言和言语分开的代表人和集大成的学者是现代语言之父索绪尔,他的代表作是《普通语言学教程》。

12.语言符号的特点有:任意性、强制性、可变性、离散性、线性。

13.索绪尔创立的语言学,使语言学成为现代意义的科学。

14.言语活动可以分为语言和言语两个分支,即索绪尔提出人类言语活动可分为语言和言语两个部分。

15.语言和言语:“语言”是言语活动中同一社会群体共同掌握的有规律可循而又成为系统的那一部分。

言语是个人“说话”的具体行为和结果,在每个人的发音、用词和使用的句子结构等方面体现出个人特色。

16.书面语和口语的关系是:前者是第二性的,后者是第-性的。

17.口语和书面语的所谓一致,是指基本的语言成分。

18.语言符号的物质实体(语音)和所表示的意义(语义)之间没有必然的理据关系,这说明,语言符号具有任意性。

19.语言符号是离散的,在时间这根轴上成线性排列。

语言符号的线性特征使离散的语言符号有可能组合成大小不等的语言单位,组合成连续的语流。

20.在语言系统的各个子系统中,语音系统的系统性最强。

考研现代汉语真题练习

现代汉语习题比较分析下列各组术语得联系与区别(每小题10分,共30分):1,主题——话题2,不定位语素、定位语素——词根、词缀3,语体——风格简答题(每小题12分,共24分)1,有人敲你的门,你问:“谁?”门外回答“我。

”请问,这时你能判断敲门人是谁吗?为什么?2,什么是新造词?词汇规范化原则有哪些?请举例说明。

分析题(共21分)1,用汉语拼音拼写下面的短语(2分)很有两下子2,用层次分析法分析下面的短语(4分)很吃了几碗饭3,比较下面的短语,归纳“很X”结构中“X”的语法类型和语义条件(15分):很能干——很能力(X)很希望——很愿望(X)很有潜力——很潜力(X)很吃了几碗饭——很吃饭(X)1,试说明下面用横线连接的几组词之间的联系类型和差异(不同),每类再补充1—2例。

(15分)⑴现在——兹私下——擅自⑵飞——飞翔好意——美意⑶空——孔满——漫2,试举例说明《语法讲义》中粘合式偏正结构和组合式偏正结构及其语法特点。

(15分)3,试从语形、语义、使用条件和问句性质等方面,论述下面这三个句子的异同。

并再举若干同类例子旁证。

(20分)⑴你吃点什么?⑵你吃点什么吗?⑶你吃点什么呢?名词解释1,音素2,音位3,单纯词4,修辞2,本国生产的和从外国进口的辨析题。

区分下列各组句子,说明他们在语义上的差异1,⑴我在这儿住五年。

⑵我在这儿住了五年。

⑶我在这儿住了五年了。

2,⑴,门开了。

⑵,门开着呢。

⑶,门开着来着。

问答题1,普通话里的u和b有哪些主要区别?2,同音词和多义词有什么不同?3,现代汉语有哪些特点?4,举例说明语素和汉字的关系。

5,汉字有什么特点?6,谈谈现代汉语划分词类的标准。

一,名词解释1,汉语标准化2,引申意义3,句型、句式4,词语的移用5,存现句五,简答题1,什么是传统语法?2,请比较程度宾语与程度补语有何不同。

3,下列语句是否有歧义?有歧义的,请分析产生歧义的原因和条件,并分化歧义。

⑴告别母校的学生⑵连校长也不认识。

编译原理习题

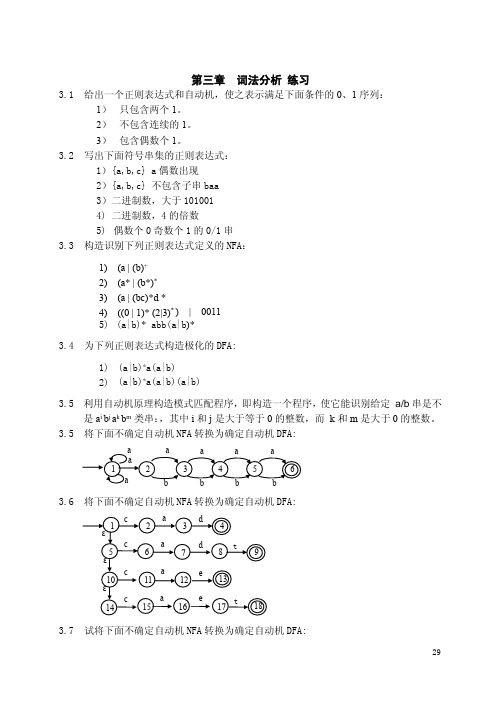

第三章词法分析练习3.1给出一个正则表达式和自动机,使之表示满足下面条件的0、1序列:1)只包含两个1。

2)不包含连续的1。

3)包含偶数个1。

3.2写出下面符号串集的正则表达式:1){a,b,c}a偶数出现2){a,b,c}不包含子串baa3)二进制数,大于1010014)二进制数,4的倍数5)偶数个0奇数个1的0/1串3.3构造识别下列正则表达式定义的NFA:1)(a|(b)+2)(a*|(b*)*3)(a|(bc)*d*4)((0|1)*(2|3)*)|00115)(a|b)*abb(a|b)*3.4为下列正则表达式构造极化的DFA:1)(a|b)*a(a|b)2)(a|b)*a(a|b)(a|b)3.5利用自动机原理构造模式匹配程序,即构造一个程序,使它能识别给定a/b串是不是a i b j a k b m类串:,其中i和j是大于等于0的整数,而k和m是大于0的整数。

3.5将下面不确定自动机NFA转换为确定自动机DFA:3.6将下面不确定自动机NFA转换为确定自动机DFA:3.7试将下面不确定自动机NFA转换为确定自动机DFA:3.8试写出下面确定自动机DFA的正则表达式:3.9设置一个名字表NameL和整数表ConstL,当遇到标识符时,将其字符串送入名字表NameL,并把其名字表地址作为标识符的Value值。

整常数情形也一样,不要求翻译成二进制数。

要求在NameL表和ConstL表中没有相同元素。

试用C语言写一个针对上述单词集的词法分析器。

单词class valuebegin BeginSymbend EndSymbvar VarSymbinteger IntSymbif IfSymbthen ThenSymbelse ElseSymb;SemiSymb:ColonSymb:=AssigSymb<LittleSymb<=LittEquiSymb标识符IdentSymb名字表地址整常数ConstSymb常数表地址3.10实数的语法定义如下面所述:<实数>::=<整数部分><小数部分><指数部分><整数部分>::=<数字>|<整数部分><数字><小数部分>::=ε|.<整数部分><指数部分>::=ε|e<指数符号><整数部分><指数符号>::=ε|+|-试写出实数的非确定自动机。

编译原理练习题答案

一、填空题:1-01.编译程序的工作过程一般可以划分为词法分析,语法分析,语义分析,之间代码生成,代码优化等几个基本阶段,同时还会伴有表格处理和出错处理.1-02.若源程序是用高级语言编写的,目标程序是机器语言程序或汇编程序,则其翻译程序称为编译程序.1-03.编译方式与解释方式的根本区别在于是否生成目标代码.1-04.翻译程序是这样一种程序,它能够将用甲语言书写的程序转换成与其等价的用乙语言书写的程序. 1-05.对编译程序而言,输入数据是源程序,输出结果是目标程序.1-06.如果编译程序生成的目标程序是机器代码程序,则源程序的执行分为两大阶段: 编译阶段和运行阶段.如果编译程序生成的目标程序是汇编语言程序,则源程序的执行分为三个阶段: 编译阶段, 汇编阶段和运行阶段.1-07.若源程序是用高级语言编写的,目标程序是机器语言程序或汇编程序,则其翻译程序称为编译程序。

1-08.一个典型的编译程序中,不仅包括词法分析、语法分析、中间代码生成、代码优化、目标代码生成等五个部分,还应包括表格处理和出错处理。

其中,词法分析器用于识别单词。

1-09.编译方式与解释方式的根本区别为是否生成目标代码。

2-01.所谓最右推导是指:任何一步αβ都是对α中最右非终结符进行替换的。

2-02.一个上下文无关文法所含四个组成部分是一组终结符号、一组非终结符号、一个开始符号、一组产生式。

2-03.产生式是用于定义语法成分的一种书写规则。

2-04.设G[S]是给定文法,则由文法G所定义的语言L(G)可描述为:L(G)={x│S x,x∈V T*} 。

2-05.设G是一个给定的文法,S是文法的开始符号,如果S x(其中x∈V*),则称x是文法的一个句型。

2-06.设G是一个给定的文法,S是文法的开始符号,如果S x(其中x∈V T*),则称x是文法的一个句子。

3-01.扫描器的任务是从源程序中识别出一个个单词符号。

4-01.语法分析最常用的两类方法是自上而下和自下而上分析法。

句子成分练习题初二

句子成分练习题初二1. 分析下列句子的成分,并写出句子中各成分的名称。

a) 鸟儿在天空中自由地飞翔。

b) 我们的老师是一位非常和蔼可亲的人。

c) 小狗快乐地摇着尾巴跑过去了。

d) 她是一个勇敢而独立的女孩。

在句子a)中,"鸟儿"是主语,"在天空中"是状语,"自由地"是状语,"飞翔"是谓语。

在句子b)中,"我们的老师"是主语,"是一位"是谓语,"非常和蔼可亲的人"是表语。

在句子c)中,"小狗"是主语,"快乐地"是状语,"摇着尾巴"是状语,"跑过去了"是谓语。

在句子d)中,"她"是主语,"是一个"是谓语,"勇敢而独立的女孩"是表语。

2. 下面的句子中,划出主语和谓语,并说明划出的词语属于什么成分。

a) 小明擅长画画。

b) 天空中飘着轻柔的云朵。

c) 母亲正在厨房里做饭。

d) 我们兴奋地欢呼着。

在句子a)中,"小明"是主语,"擅长画画"是谓语,属于谓语动词。

在句子b)中,"天空中"是主语,"飘着轻柔的云朵"是谓语,属于谓语动词。

在句子c)中,"母亲"是主语,"正在厨房里做饭"是谓语,属于谓语动词。

在句子d)中,"我们"是主语,"兴奋地欢呼着"是谓语,属于谓语动词。

3. 将下列句子中的划线部分改写为合适的词性。

a) 这只猫十分可爱。

b) 她很喜欢唱歌。

c) 我们要积极参与社区活动。

d) 我收到了他的来信。

在句子a)中,将"十分"改写为副词形式:"非常"。

语言学概论练习题第五章名词解释分析句子

语言学概论练习题第五章名词解释分析句子三、名词解释题〖可转化为选择题〗1.语义:语言形式表达的内容,是语言的意义。

2.理性意义:也叫做逻辑意义或指称意义,是对主观世界的认识。

3.非理性意义:是说话人的主观情感、态度以及语体风格等方面的内容,它一般总是附着在特定的理性意义之上的。

4、词汇意义:由语汇形式表达的意义。

5.语法意义:由语法形式表达的意义。

6.语境意义:语言形式在特定的交际场合和知识背景等语境因素的作用下所表达的意义。

7.词义;指同语音形式结合在一起的人们对一定对象的概括反映和主观态度以及其他附加色彩。

8.词的理性意义:同词的语音形式结合在一起的对一定对象的区别性特征的认识。

9.词的非理性意义:附着在词的理性意义之上的反映感情色彩、语体色彩和形象色彩等方面的意义,又叫做词义的附加色彩。

10.词的通俗意义:由于概括深度的差异分出助词的理性意义的一种类型,是人们对事物所具有的一组非本质性特征的反映。

11.词的科学意义:由于概括深度的差异分出的词的理性意义的一种类型,是人们对事物的本质特征的反映。

12.义项:词典释义的最小单位,是从词语的各种用例中概括出来的共同的,一般的、稳定的意义。

13.义素:从义项分析中得到的词义的语义特征。

14.义素分析:把词语的义项进一步分析为若干义素的组合,以便说明词义的结构、词义之间的异同以及词义之间的各种关系。

15.单义词:一类词的意义可以概括反映一类对象,即只有一个义项的词。

16.多义词:一个词的意义可以概括反映相互联系的几类对象,即包含几个互相联系的义项的词。

17.本义:多义词的多个意义中,最初的那个意义叫本义。

18.基本义:多义词的多个意义中的某个时期最常用、最主要的意义。

19.派生义:多义词的多个意义中直接或间接地从本义衍生出来的意义,也叫引申义。

20.同义词:一种语言或方言中若干以不同的语音形式表达相同或相近的意义的词。

21.等义词:指包括理性意义和非理性意义(附加色彩)在内的词完全相同的两个或两个以上的词。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

练习题:

一、指出下列语句中加“·”的名词性成分所担任的语义角色:

1、售票处

..

..都在挤电影...围满了人.,大家

票.。

2、昨天

..我买了一部词典

....。

3、我家去年盖了一幢小楼

....。

4、李老师退休时赠给学校图书馆

.....一批书。

5、他.是跳舞明星,他会跳探戈

..。

6、这个小店方便了周围的群众

.....。

7、食堂

..吃。

..我吃不惯,我还是在家里

8、陈朗用红木

....。

..打了一套家具

9、这件事

...他有他的想法。

10、他对我.说了许多大道理

.....。

二、分析下列语句中加“·”的词语的语义指向:

1、有一天,他在饭店里喝醉.了酒。

2、你干得太快

..了。

3、老师傅手把手教会.了两个徒弟。

4、他在院子里深深

..地挖了一个坑,栽了一棵树。

5、他把各种书籍杂乱无章

....地装在书架上。

6、妈妈给儿子找了一件干净

..的内衣。

7、我走了一大段冤枉

..路。

8、我们忽然

..发现了老虎。

9、这篇论文可把我写苦.了。

10、孙梅一听到这个消息慌慌张张

....地转身就走。

三、同样一个动词“考”,可以说:考大学、考研究生、考数学、考笔试、考五分,请分析它们的语义关系。

四、“老张有辆新车很得意”、“老张有条小狗很聪明”没有歧义,而“老张有个女儿很骄傲”则有歧义,请运用语义指向以及语义特征分析法作出解释。

五、我们可以说:“谦虚点儿”“老实点儿”“灵活点儿”,但是,不能说:“健康

点儿”“伟大点儿”“高尚点儿”。

为什么?试运用语义特征分析法做出解释。

六、请举例说明带“得”的述补谓语句,补语的语义指向分别指向谓语、主语和宾语的情况。

七、请运用语义指向的分析法分化下列歧义结构:

1、他不吃面条。

2、国王的脾气你也知道的。

思考题:

一、名词和名词可以构成偏正短语,试放心它们的语义关系。

二、请分析一下“今年又是一个丰收年”的语义指向。

“又”指向哪里?

三、“厂里有一辆新车”是歧义的,请用语义特征分析法解释其中的道理。