《信息论与编码》结课总结

信息论与编码课程报告

信息论与编码课程报告

信息论与编码是一门重要的课程,在计算机科学与技术,通信工程,信号处理

等专业中发挥着重要的作用。

信息论涉及到信息的量化、源编码、信息隐藏,噪声抑制以及信息协议的分析等诸多方面。

而编码中的许多领域如信号处理、视频编码、图像处理等又建立在信息论的基础之上。

在这门课程中,学生可以学习如何把信息量化,以及不同的编码方法和算法,明白信息和音频的处理,还可以学习复杂格式的音频、视频编码。

此外,学习中还会涉及到模拟和数字信号,熵、信道容量与噪讲,数字信号处理,数字信号编码等多种多样的知识点,其中还包括噪讲模型、噪讲容量等多种不同概念。

整个信息论和编码领域有着丰富的应用,为听力、视觉等智能分析技术的实现

提供了理论支撑。

基于信息论的研究发明了压缩编码技术,它可以用来压缩数据,提高传输速率和储存空间,同时编码技术可以使数据免于传输过程中的损耗,有效地实现了音频、视频等多种数据的传输。

此外,信息论和编码在模式识别与多媒体通信、卫星通信、生物医学等多个领域都有着重要的应用。

综上所述,信息论与编码课程是个重要的学科,在计算机科学与技术,通信工程,算法,信号处理,多媒体通信,生物医学等领域中有着广泛的应用。

该课程主要是以学习源编码,熵、信道容量,噪讲,数字信号处理,数字信号编码,噪讲模型,压缩编码等多种专业概念为基础,因此有深入研习的必要,以获得多方面的知识和理解,为日后的技能应用打实基础。

《信息论与编码》结课总结

三、内容:

1. 当代文明的三大科学支柱: (0.50)

材料科学、信息科学与能源科学。

2. 信息论发展的过程(1.50)

过程: 语言的产生 文字的产生 印刷术的发明 电报、电话的发明 计算机技术与通信技术的结合应用 且信息论研究对象是广义的通信系统。 要求:简单了解即可。 信息论的主要开创者(2.40) 香农、维纳

量。 定义式:

I (ai ; b j ) log

p ( ai b j ) p( a i )

(i 1,2, , n; j 1,2, , m) 三个含义: 含义一:

站在输出端的角度来看,两个不确定度之差,是不确定度被消除的部分,代 表已经确定的东西,实践是从 b j 得到的关于 ai 的信息量。 含义二: 站在输入端的角度来看,在输入端发出 ai 前、后,地输出端出现 b j 的不确定 度的差。 含义三:

6. 信源符号的自信息量的含义与计算(6.30)

定义: 信源发出符号所含的信息量叫做自信息量,简称为自信息。 表示: I (ai ) log 2 p (ai ) 提示:基本的计算如自信息量、熵等都要知道。

7. 信源符号间互信息量与平均互信息量的三个含义(7.25)

互信息量 定义: 我们定义 ai 的后验概率与先验概率比值的对数为 b j 对a i 的互信息量,也叫交互信息

22. Xn+1 循环码的生成多项式 g(x)与一致校验多项式 h(x)的关系, 对应生成矩阵和一致校验矩阵的生成,将消息利用生成矩阵生 成循环码(12.10)

8. 信源熵的三种物理含义及求解方法(12.25)

信源熵的定义:

三.信源熵

熵

条 件 熵

信 源 熵

联 合 熵

信源各个离散消息的自信息量的数学期望为信源的信源熵。

信息论与编码课程读后感800字

英文回答:Uponpletion of the Information Theory and Coding course, I have attained a thorough understanding of the foundational concepts and principles that underpin the transmission, storage, andpression of data. The course extensively covered topics such as entropy, mutual information, channel capacity, error-correcting codes, and datapression techniques. Through the rigorous lectures and assignments, I have gained insight into the practical applications of these concepts in variousmunication systems, including wirelessmunication, internet protocols, and error-correcting algorithms. A key takeaway from the course is the significance of efficient encoding and decoding techniques in ensuring the reliable and securemunication of information. My grasp of the theoretical underpinnings of information theory has provided me with a new perspective on the intricacies and challenges of data transmission, and has furnished me with valuable knowledge applicable to diverse real-world scenarios.完成信息理论和编码课程后,我对数据传输、存储和压缩的基础概念和原则有了透彻的理解。

信息论与编码原理期末大总结

信息论与编码原理期末大总结信息论与编码原理是一门研究信息传输和存储的学科,它的研究对象是信息的度量、编码和解码,是现代通信和计算机科学的重要基础理论之一、本学期学习信息论与编码原理课程,我对信息的压缩、编码和传输有了更深入的了解。

首先,信息的度量是信息论与编码原理的核心概念之一、通过信息的度量,我们可以衡量信息的多少和质量。

常用的度量方法是信息熵,它描述的是一个随机变量的不确定度。

熵越大,表示不确定度越高,信息量越大。

通过计算信息熵,我们可以对信息进行评估和优化,为信息的编码和传输提供指导。

其次,信息的压缩是信息论与编码原理的重要研究方向之一、在信息论中,有两种常用的压缩方法:有损压缩和无损压缩。

有损压缩是通过舍弃一些信息的方式来减少数据的大小,例如在图像和音频压缩中,我们可以通过减少图像的像素点或者音频的采样率来实现压缩。

无损压缩则是通过编码的方式来减少数据的大小,例如哈夫曼编码和阿贝尔编码等。

了解了不同的压缩方法,可以帮助我们在实际应用中选择合适的压缩算法。

再次,编码是信息论与编码原理的重要概念之一、编码是将信息转换为特定的符号序列的过程,它是实现信息传输和存储的关键技术。

在编码中,最常用的编码方法是短编码和长编码。

短编码通过将常用的符号映射到短的编码序列,来实现信息的高效传输。

例如ASCII编码就是一种常用的短编码方法。

相反,长编码通过将每个符号映射到相对较长的编码序列,来实现无歧义的解码。

例如哈夫曼编码就是一种常用的无损长编码方法。

最后,信道编码是信息论与编码原理中重要的研究方向之一、在通信中,信号会受到不同的干扰,如噪声和失真等。

为了减少信号传输时的误码率,可以使用信道编码来提升信号的可靠性。

常用的信道编码方法有奇偶校验码、海明码和卷积码等。

信道编码通过在信号中引入冗余信息,以检测和纠正信道传输中的错误,提高了通信的可靠性和稳定性。

总结起来,信息论与编码原理是研究信息传输和存储的重要学科,通过学习这门课程,我们可以了解信息的度量、压缩、编码和传输等基本原理和方法。

信息论与编码概念总结

信息论与编码概念总结信息论最初由克劳德·香农在1948年提出,被称为“信息论的父亲”。

它主要研究的是如何最大化信息传输的效率,并对信息传输的性能进行量化。

信息论的核心概念是信息熵,它描述了在一个信息源中包含的信息量的平均值。

信息熵越高,信息量越大,反之亦然。

具体来说,如果一个信源生成的信息是等可能的,那么它的信息熵达到最大值,可以通过二进制对数函数计算。

此外,信息论还提出了联合熵、条件熵、相对熵等概念,用于分析复杂的信息源与信道。

除了信息熵,信息论对信道容量的定义也是非常重要的。

信道容量指的是信道可以传输的最大信息速率,单位是bit/s。

在信息论中,最为典型的信道是噪声信道,它在传输数据过程中会引入随机噪声,从而降低传输的可靠性。

通过信道编码,可以在一定程度上提高信号的可靠性。

信息论提出了香农编码定理,它给出了当信道容量足够大时,存在一种信道编码方式,可以使误码率趋近于零,实现可靠的数据传输。

信息论不仅可以应用于通信领域,还可以应用于数据压缩。

数据压缩主要有无损压缩和有损压缩两种方式。

无损压缩的目标是保持数据的原始信息完整性,最常见的压缩方式是霍夫曼编码。

它通过统计原始数据中的频率分布,将高频率的符号用较短的编码表示,从而减小数据的存储空间。

有损压缩则是在保证一定的视觉质量、音频质量或其他质量指标的前提下,对数据进行压缩。

有损压缩的目标是尽可能减小数据的存储空间和传输带宽。

常见的有损压缩方法包括JPEG、MP3等。

编码是信息论的应用之一,它是实现信息传输与处理的关键技术。

编码主要分为源编码和信道编码两个方面。

源编码是将源信号进行编码,以减小信号的冗余,并且保持重构信号与原信号的接近程度。

常见的源编码方法有霍夫曼编码、香农-费诺编码等。

信道编码则是在信道传输中引入冗余信息,以便在传输过程中检测和修复错误。

常见的信道编码方法有海明码、卷积码、LDPC码等。

这些编码方法可以通过增加冗余信息的方式来提高传输的可靠性和纠错能力。

学习信息论与编码心得范文三篇

学习信息论与编码心得范文三篇学习信息论与编码心得范文三篇学习信息论与编码心得1作为就业培训,项目的好坏对培训质量的影响十分大,常常是决定性的作用。

关于在学习java软件开发时练习项目的总结,简单总结为以下几点:1、项目一定要全新的项目,不能是以前做过的2、项目一定要企业真实项目,不能是精简以后的,不能脱离实际应用系统3、在开发时要和企业的开发保持一致4、在做项目的时候不应该有参考代码长话短说就是以上几点,如果你想要更多的了解,可以继续往后看。

一:项目的地位因为参加就业培训的学员很多都是有一定的计算机基础,大部分都具备一定的编程基础,尤其是在校或者是刚毕业的学生,多少都有一些基础。

他们欠缺的主要是两点:(1)不能全面系统的、深入的掌握某种技术,也就是会的挺多,但都是皮毛,不能满足就业的需要。

(2)没有任何实际的开发经验,完全是想象中学习,考试还行,一到实际开发和应用就歇菜了。

解决的方法就是通过项目练习,对所学知识进行深化,然后通过项目来获取实际开发的经验,从而弥补这些不足,尽快达到企业的实际要求。

二:如何选择项目项目既然那么重要,肯定不能随随便便找项目,那么究竟如何来选择呢?根据java的研究和实践经验总结,选择项目的时候要注意以下方面:1:项目不能太大,也不能太小这个要根据项目练习的阶段,练习的时间,练习的目标来判断。

不能太大,太大了做不完,也不能太小,太小了没有意义,达不到练习的目的。

2:项目不能脱离实际应用系统项目应该是实际的系统,或者是实际系统的简化和抽象,不能够是没有实战意义的教学性或者是纯练习性的项目。

因为培训的时间有限,必须让学员尽快地融入到实际项目的开发当中去。

任何人接受和掌握一个东西都需要时间去适应,需要重复几次才能够真正掌握,所以每个项目都必须跟实际应用挂钩。

3:项目应能覆盖所学的主要知识点学以致用,学完的知识点需要到应用中使用,才能够真正理解和掌握,再说了,软件开发是一个动手能力要求很高的行业,什么算会了,那就是能够做出来,写出代码来,把问题解决了,你就算会了。

《信息论与编码》课程论文

《信息论与编码》课程小结《信息论与编码》课程小结信息论是信息科学的主要理论基础之一,它是在长期通信工程实践和理论基础上发展起来的。

信息论是应用概率论、随机过程和数理统计和近代代数等方法,来研究信息的存储、传输和处理中一般规律的学科。

它的主要目的是提高通信系统的可靠性、有效性和安全性,以便达到系统的最优化。

编码理论与信息论紧密关联,它以信息论基本原理为理论依据,研究编码和译码的理论知识和实现方法。

通过《信息论与编码》课程的学习,得到了以下总结:一、信息论的基本理论体系1948年,香农在贝尔系统技术杂志上发表“通信的数学理论”。

在文中,他用概率测度和数理统计的方法系统地讨论了通信的基本问题,得出了几个重要而带有普遍意义的结论,并由此奠定了现代信息论的基础。

香农理论的核心是:揭示了在通信系统中采用适当的编码后能够实现高效率和高可靠地传输信息,并得出了信源编码定理和信道编码定理。

从数学观点看,这些定理是最优编码的存在定理。

但从工程观点看,这些定理不是结构性的,不能从定理的结果直接得出实现最优编码的具体方法。

然而,它们给出了编码的性能极限,在理论上阐明了通信系统中各种因素的相互关系,为寻找最佳通信系统提供了重要的理论依据。

对信息论的研究内容一般有以下三种理解:(1) 狭义信息论,也称经典信息论。

它主要研究信息的测度、信道容量以及信源和信道编码理论等问题。

这部分内容是信息论的基础理论,又称香农基本理论。

(2) 一般信息论,主要是研究信息传输和处理问题。

除了香农理论以外,还包括噪声理论、信号滤波和预测、统计检测与估计理论、调制理论、信息处理理论以及保密理论等。

后一部分内容以美国科学家维纳(N.Wiener)为代表,其中最有贡献的是维纳和苏联科学家柯尔莫哥洛夫。

(3) 广义信息论。

广义信息论不仅包括上述两方面的内容,而且包括所有与信息有关的自然和社会领域,如模式识别、计算机翻译、心理学、遗传学、神经生理学、语言学、语义学甚至包括社会学中有关信息的问题,是新兴的信息科学理论。

信息论与编码总结

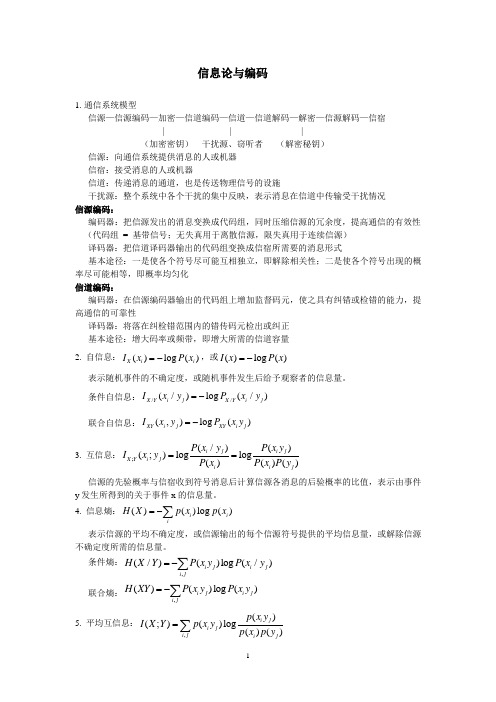

信息论与编码1. 通信系统模型信源—信源编码—加密—信道编码—信道—信道解码—解密—信源解码—信宿 | | |(加密密钥) 干扰源、窃听者 (解密秘钥)信源:向通信系统提供消息的人或机器信宿:接受消息的人或机器信道:传递消息的通道,也是传送物理信号的设施干扰源:整个系统中各个干扰的集中反映,表示消息在信道中传输受干扰情况 信源编码:编码器:把信源发出的消息变换成代码组,同时压缩信源的冗余度,提高通信的有效性 (代码组 = 基带信号;无失真用于离散信源,限失真用于连续信源)译码器:把信道译码器输出的代码组变换成信宿所需要的消息形式基本途径:一是使各个符号尽可能互相独立,即解除相关性;二是使各个符号出现的概率尽可能相等,即概率均匀化信道编码:编码器:在信源编码器输出的代码组上增加监督码元,使之具有纠错或检错的能力,提高通信的可靠性译码器:将落在纠检错范围内的错传码元检出或纠正基本途径:增大码率或频带,即增大所需的信道容量2. 自信息:()log ()X i i I x P x =-,或()log ()I x P x =-表示随机事件的不确定度,或随机事件发生后给予观察者的信息量。

条件自信息://(/)log (/)X Y i j X Y i j I x y P x y =-联合自信息:(,)log ()XY i j XY i j I x y P x y =-3. 互信息:;(/)()(;)log log ()()()i j i j X Y i j i i j P x y P x y I x y P x P x P y ==信源的先验概率与信宿收到符号消息后计算信源各消息的后验概率的比值,表示由事件y 发生所得到的关于事件x 的信息量。

4. 信息熵:()()log ()i iiH X p x p x =-∑ 表示信源的平均不确定度,或信源输出的每个信源符号提供的平均信息量,或解除信源不确定度所需的信息量。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

三、内容:

1. 当代文明的三大科学支柱: (0.50)

材料科学、信息科学与能源科学。

2. 信息论发展的过程(1.50)

过程: 语言的产生 文字的产生 印刷术的发明 电报、电话的发明 计算机技术与通信技术的结合应用 且信息论研究对象是广义的通信系统。 要求:简单了解即可。 信息论的主要开创者(2.40) 香农、维纳

《信息论与编码》结课总结

一、资料来源:

课件:林果园老师。

二、说明:

标题后数据为所对应的录音时间; 所要掌握的是相关方面最基础的知识与定理; 部分知识需要了解,部分知识需要掌握并懂得怎样用于做题; 首先理解相关基本概念、性质和定理,其次多复习平时作业、课堂讲解及课堂 小测验,许多题目相似; 考试难度不会超过平时题目的难度; 做题认真,步骤完整。

量。 定义式:

I (ai ; b j ) log

p ( ai b j ) p( a i )

(i 1,2, , n; j 1,2, , m) 三个含义: 含义一:

站在输出端的角度来看,两个不确定度之差,是不确定度被消除的部分,代 表已经确定的东西,实践是从 b j 得到的关于 ai 的信息量。 含义二: 站在输入端的角度来看,在输入端发出 ai 前、后,地输出端出现 b j 的不确定 度的差。 含义三:

10. 信源的平稳性和无记忆性的含义(14.45)

当信源所发符号序列的概率分布与时间的起点无关且符号之间无依赖关系, 则称此信源为平稳无记忆信源。

11. 离散无记忆信源的信源熵、N 次扩展的信源熵计算。 (15.30)

H(XN)=NH(X) 注意: 这里必须是离散平稳无记忆信源才行。

12. N 阶马尔科夫信源的定义(16.00)

3. 研究信息论的目的(3.00)

为了高效、可靠、安全、经济且随心所欲地交换和利用各种各样的信息。

4. 信息理论当中度量信息的基本观点(3.20)

三种观点要说清楚。

通及对应的编码(4.30)

有效性: 传递信息时信源用尽量少的符号表示尽可能多的信息; 信源编码 可靠性: 信息在信道的传输过程中衰减和干扰影响最小; 信道编码(研究的就是如何进行可靠的传输,首先要知道什么是信道容量) 安全性: 防止敌意所导致的破坏; 安全编码

8. 信源熵的三种物理含义及求解方法(12.25)

信源熵的定义:

三.信源熵

熵

条 件 熵

信 源 熵

联 合 熵

信源各个离散消息的自信息量的数学期望为信源的信源熵。

三种物理含义及求解方法: 信源输出后,平均每个离散消息所提供的信息量; 信源输出前,信源的平均不确定度; 变量 X 的随机性。 注意: 信息量是一个得到的概念,而不确定度则是一个概念的概念。 求解方法:

6. 信源符号的自信息量的含义与计算(6.30)

定义: 信源发出符号所含的信息量叫做自信息量,简称为自信息。 表示: I (ai ) log 2 p (ai ) 提示:基本的计算如自信息量、熵等都要知道。

7. 信源符号间互信息量与平均互信息量的三个含义(7.25)

互信息量 定义: 我们定义 ai 的后验概率与先验概率比值的对数为 b j 对a i 的互信息量,也叫交互信息

极限概率)、极限熵 H∞=Hn+1(0.20)

提示: 相关概念的理解; 对于概念的计算和应用; 对于状态要有很好的理解; 阶数与符号数间是有关系的。

14. 信道容量的含义(4.00)

提示: 对平均互信息量取的极大值; 特性的应用; 考查的是信道的一些特性;

15. 常见信道(无噪信道、强对称、对称、 (前三种一定要掌握)准 对称(这个是有时间可以去看) )容量的计算,达到信道容量时 对应信源的概率分布情况。 (5.00)

从通信系统的总体立场上,通信前后不确定度的差。 平均互信息量(8.30) 定义: 互信息量在联合概率空间 P(XY)中的统计平均值叫做平均互信息量。 定义式: n m n m p( ai b j ) I ( X ; Y ) E[ I (ai ; b j )] p (ai b j ) I (ai ; b j ) p (ai b j ) log p ( ai ) i 1 j 1 i 1 j 1 三个含义: 含义一: 从输出端的角度来看,平均互信息量是收到 Y 前、后,关于 X 的不确定度 减少的量,即由 Y 获得的关于 X 的平均信息量。 含义二: 从输入端的角度来看,平均互信息量是发送 X 前、后,关于 Y 的平均不确 定度减少的量。 含义三: 从通信的整体来看,平均互信息量等于通信前、后,整个系统不确定度减少 的量。 总结: 信息就是负熵——从一个事件获得另一个事件的平均互信息需要消除不确 定度,一旦消除了不确定度,就获得了信息。 提示: 站在三个不同的角度,具体内容在 26、27 和 28 页; 平均互信息量是一个非常重要的概念; 此处的概念涉及到后面的相关定理的引出。

提示: 信道容量的实现情况即是对应的概率分布情况;

16. 信源编码:香农编码、费诺编码、哈夫曼编码方法及步骤,其 编码效率的计算(6.05)

香农编码

费诺编码

哈夫曼编码

提示: 都是变长编码,所以会涉及到概率排序;

17. 信息率失真函数的含义(7.35)

提示: 与现实生活中所允许的失真程度是有关系的;

22. Xn+1 循环码的生成多项式 g(x)与一致校验多项式 h(x)的关系, 对应生成矩阵和一致校验矩阵的生成,将消息利用生成矩阵生 成循环码(12.10)

18. Dmax 的含义(8.00)

19. 二、三元离散信源的 Rmax、Rmin、Dmin、Dmax 计算,及信 息率失真函数 R(D)的计算(8.20)

20. 在信道编码中检错与纠错的含意是什么?(10.00)

提示: 针对于可靠性; 两者的关系:有一个定理;

21. 线性分组码生成矩阵与系统码生成矩阵之间的关系,系统码生 成矩阵与一致校验码矩阵之间的关系,码字的生成,编码效率 及最小距离的计算。 (11.10)

定义: 以信源输出符号序列内各符号间条件概率来反映记忆特性的一类信源叫做 马尔可夫信源。而当马尔可夫信源的当前输出符号仅与前面 N 个符号有关 时,称之为 N 阶马尔可夫信源。 提示: 相对于无记忆特性的有记忆特性应用; 定义方法; 一般在三阶以内。

13. 低阶马尔科夫信源的状态转移图、各状态的稳态分布概率(状态

n 1 H ( X ) E[I (ai )] E[log2 ] p(ai ) log2 p(ai ) p(ai ) i 1

同理可推出条件熵和联合熵的求解方法。

9. 离散信源的联合熵、条件熵、平均互信息量的含义及相互之间 的关系。 (13.10)

联合熵: H(XY) 条件熵: H(X/Y)或 H(Y/X) 平均互信息量: I(X;Y)