MongoDB集群架构

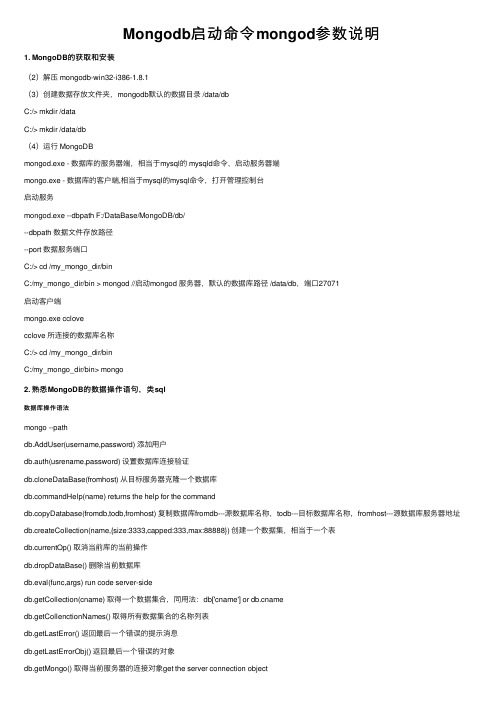

Mongodb启动命令mongod参数说明

Mongodb启动命令mongod参数说明1. MongoDB的获取和安装(2)解压 mongodb-win32-i386-1.8.1(3)创建数据存放⽂件夹,mongodb默认的数据⽬录 /data/dbC:/> mkdir /dataC:/> mkdir /data/db(4)运⾏ MongoDBmongod.exe - 数据库的服务器端,相当于mysql的 mysqld命令,启动服务器端mongo.exe - 数据库的客户端,相当于mysql的mysql命令,打开管理控制台启动服务mongod.exe --dbpath F:/DataBase/MongoDB/db/--dbpath 数据⽂件存放路径--port 数据服务端⼝C:/> cd /my_mongo_dir/binC:/my_mongo_dir/bin > mongod //启动mongod 服务器,默认的数据库路径 /data/db,端⼝27071启动客户端mongo.exe cclovecclove 所连接的数据库名称C:/> cd /my_mongo_dir/binC:/my_mongo_dir/bin> mongo2. 熟悉MongoDB的数据操作语句,类sql数据库操作语法mongo --pathdb.AddUser(username,password) 添加⽤户db.auth(usrename,password) 设置数据库连接验证db.cloneDataBase(fromhost) 从⽬标服务器克隆⼀个数据库mandHelp(name) returns the help for the commanddb.copyDatabase(fromdb,todb,fromhost) 复制数据库fromdb---源数据库名称,todb---⽬标数据库名称,fromhost---源数据库服务器地址db.createCollection(name,{size:3333,capped:333,max:88888}) 创建⼀个数据集,相当于⼀个表db.currentOp() 取消当前库的当前操作db.dropDataBase() 删除当前数据库db.eval(func,args) run code server-sidedb.getCollection(cname) 取得⼀个数据集合,同⽤法:db['cname'] or amedb.getCollenctionNames() 取得所有数据集合的名称列表db.getLastError() 返回最后⼀个错误的提⽰消息db.getLastErrorObj() 返回最后⼀个错误的对象db.getMongo() 取得当前服务器的连接对象get the server connection objectdb.getMondo().setSlaveOk() allow this connection to read from then nonmaster membr of a replica pair db.getName() 返回当操作数据库的名称db.getPrevError() 返回上⼀个错误对象db.getProfilingLevel() ?什么等级db.getReplicationInfo() ?什么信息db.getSisterDB(name) get the db at the same server as this onewdb.killOp() 停⽌(杀死)在当前库的当前操作db.printCollectionStats() 返回当前库的数据集状态db.printReplicationInfo()db.printSlaveReplicationInfo()db.printShardingStatus() 返回当前数据库是否为共享数据库db.removeUser(username) 删除⽤户db.repairDatabase() 修复当前数据库db.resetError()db.runCommand(cmdObj) run a database command. if cmdObj is a string, turns it into {cmdObj:1} db.setProfilingLevel(level) 0=off,1=slow,2=alldb.shutdownServer() 关闭当前服务程序db.version() 返回当前程序的版本信息数据集(表)操作语法db.linlin.find({id:10}) 返回linlin数据集ID=10的数据集db.linlin.find({id:10}).count() 返回linlin数据集ID=10的数据总数db.linlin.find({id:10}).limit(2) 返回linlin数据集ID=10的数据集从第⼆条开始的数据集db.linlin.find({id:10}).skip(8) 返回linlin数据集ID=10的数据集从0到第⼋条的数据集db.linlin.find({id:10}).limit(2).skip(8) 返回linlin数据集ID=1=的数据集从第⼆条到第⼋条的数据db.linlin.find({id:10}).sort() 返回linlin数据集ID=10的排序数据集db.linlin.findOne([query]) 返回符合条件的⼀条数据db.linlin.getDB() 返回此数据集所属的数据库名称db.linlin.getIndexes() 返回些数据集的索引信息db.linlin.group({key:...,initial:...,reduce:...[,cond:...]})db.linlin.mapReduce(mayFunction,reduceFunction,<optional params>)db.linlin.remove(query) 在数据集中删除⼀条数据db.linlin.renameCollection(newName) 重命名些数据集名称db.linlin.save(obj) 往数据集中插⼊⼀条数据db.linlin.stats() 返回此数据集的状态db.linlin.storageSize() 返回此数据集的存储⼤⼩db.linlin.totalIndexSize() 返回此数据集的索引⽂件⼤⼩db.linlin.totalSize() 返回些数据集的总⼤⼩db.linlin.update(query,object[,upsert_bool]) 在此数据集中更新⼀条数据db.linlin.validate() 验证此数据集db.linlin.getShardVersion() 返回数据集共享版本号db.linlin.find({'name':'foobar'}) select * from linlin where name='foobar'db.linlin.find() select * from linlindb.linlin.find({'ID':10}).count() select count(*) from linlin where ID=10db.linlin.find().skip(10).limit(20) 从查询结果的第⼗条开始读20条数据 select * from linlin limit 10,20 ----------mysqldb.linlin.find({'ID':{$in:[25,35,45]}}) select * from linlin where ID in (25,35,45)db.linlin.find().sort({'ID':-1}) select * from linlin order by ID descdb.linlin.distinct('name',{'ID':{$lt:20}}) select distinct(name) from linlin where ID<20db.linlin.group({key:{'name':true},cond:{'name':'foo'},reduce:function(obj,prev){prev.msum+=obj.marks;},initial:{msum:0}}) select name,sum(marks) from linlin group by namedb.linlin.find('this.ID<20',{name:1}) select name from linlin where ID<20db.linlin.insert({'name':'foobar','age':25}) insert into linlin ('name','age') values('foobar',25)db.linlin.insert({'name':'foobar','age':25,'email':'cclove2@'})db.linlin.remove({}) delete * from linlindb.linlin.remove({'age':20}) delete linlin where age=20db.linlin.remove({'age':{$lt:20}}) delete linlin where age<20db.linlin.remove({'age':{$lte:20}}) delete linlin where age<=20db.linlin.remove({'age':{$gt:20}}) delete linlin where age>20db.linlin.remove({'age':{$gte:20}}) delete linlin where age>=20db.linlin.remove({'age':{$ne:20}}) delete linlin where age!=20db.linlin.update({'name':'foobar'},{$set:{'age':36}}) update linlin set age=36 where name='foobar'db.linlin.update({'name':'foobar'},{$inc:{'age':3}}) update linlin set age=age+3 where name='foobar'官⽅提供的操作语句对照表:上⾏:SQL 操作语句下⾏:Mongo 操作语句CREATE TABLE USERS (a Number, b Number)db.createCollection("mycoll")INSERT INTO USERS VALUES(1,1)ers.insert({a:1,b:1})SELECT a,b FROM usersers.find({}, {a:1,b:1})SELECT * FROM usersers.find()SELECT * FROM users WHERE age=33ers.find({age:33})SELECT a,b FROM users WHERE age=33ers.find({age:33}, {a:1,b:1})SELECT * FROM users WHERE age=33 ORDER BY name ers.find({age:33}).sort({name:1})SELECT * FROM users WHERE age>33ers.find({'age':{$gt:33}})})SELECT * FROM users WHERE age<33ers.find({'age':{$lt:33}})})SELECT * FROM users WHERE name LIKE "%Joe%" ers.find({name:/Joe/})SELECT * FROM users WHERE name LIKE "Joe%"ers.find({name:/^Joe/})SELECT * FROM users WHERE age>33 AND age<=40 ers.find({'age':{$gt:33,$lte:40}})})SELECT * FROM users ORDER BY name DESCers.find().sort({name:-1})SELECT * FROM users WHERE a=1 and b='q'ers.find({a:1,b:'q'})SELECT * FROM users LIMIT 10 SKIP 20ers.find().limit(10).skip(20)SELECT * FROM users WHERE a=1 or b=2ers.find( { $or : [ { a : 1 } , { b : 2 } ] } )SELECT * FROM users LIMIT 1ers.findOne()SELECT DISTINCT last_name FROM usersers.distinct('last_name')SELECT COUNT(*y) FROM usersers.count()SELECT COUNT(*y) FROM users where AGE > 30ers.find({age: {'$gt': 30}}).count()SELECT COUNT(AGE) from usersers.find({age: {'$exists': true}}).count()CREATE INDEX myindexname ON users(name)ers.ensureIndex({name:1})CREATE INDEX myindexname ON users(name,ts DESC) ers.ensureIndex({name:1,ts:-1})EXPLAIN SELECT * FROM users WHERE z=3ers.find({z:3}).explain()UPDATE users SET a=1 WHERE b='q'ers.update({b:'q'}, {$set:{a:1}}, false, true)UPDATE users SET a=a+2 WHERE b='q'ers.update({b:'q'}, {$inc:{a:2}}, false, true)DELETE FROM users WHERE z="abc"ers.remove({z:'abc'});Mongodb启动命令mongod参数说明--quiet# 安静输出--port arg# 指定服务端⼝号,默认端⼝27017--bind_ip arg# 绑定服务IP,若绑定127.0.0.1,则只能本机访问,不指定默认本地所有IP--logpath arg# 指定MongoDB⽇志⽂件,注意是指定⽂件不是⽬录--logappend# 使⽤追加的⽅式写⽇志--pidfilepath arg# PID File 的完整路径,如果没有设置,则没有PID⽂件--keyFile arg# 集群的私钥的完整路径,只对于Replica Set 架构有效--unixSocketPrefix arg# UNIX域套接字替代⽬录,(默认为 /tmp)--fork# 以守护进程的⽅式运⾏MongoDB,创建服务器进程--auth# 启⽤验证--cpu# 定期显⽰CPU的CPU利⽤率和iowait--dbpath arg# 指定数据库路径--diaglog arg# diaglog选项 0=off 1=W 2=R 3=both 7=W+some reads--directoryperdb# 设置每个数据库将被保存在⼀个单独的⽬录--journal# 启⽤⽇志选项,MongoDB的数据操作将会写⼊到journal⽂件夹的⽂件⾥--journalOptions arg# 启⽤⽇志诊断选项--ipv6# 启⽤IPv6选项--jsonp# 允许JSONP形式通过HTTP访问(有安全影响)--maxConns arg# 最⼤同时连接数默认2000--noauth# 不启⽤验证--nohttpinterface# 关闭http接⼝,默认关闭27018端⼝访问--noprealloc# 禁⽤数据⽂件预分配(往往影响性能)--noscripting# 禁⽤脚本引擎--notablescan# 不允许表扫描--nounixsocket# 禁⽤Unix套接字监听--nssize arg (=16)# 设置信数据库.ns⽂件⼤⼩(MB)--objcheck# 在收到客户数据,检查的有效性,--profile arg# 档案参数 0=off 1=slow, 2=all--quota# 限制每个数据库的⽂件数,设置默认为8--quotaFiles arg# number of files allower per db, requires --quota--rest# 开启简单的rest API--repair# 修复所有数据库run repair on all dbs--repairpath arg# 修复库⽣成的⽂件的⽬录,默认为⽬录名称dbpath--slowms arg (=100)# value of slow for profile and console log--smallfiles# 使⽤较⼩的默认⽂件--syncdelay arg (=60)# 数据写⼊磁盘的时间秒数(0=never,不推荐)--sysinfo# 打印⼀些诊断系统信息--upgrade# 如果需要升级数据库* Replicaton 参数--fastsync# 从⼀个dbpath⾥启⽤从库复制服务,该dbpath的数据库是主库的快照,可⽤于快速启⽤同步--autoresync# 如果从库与主库同步数据差得多,⾃动重新同步,--oplogSize arg# 设置oplog的⼤⼩(MB)* 主/从参数--master# 主库模式--slave# 从库模式--source arg# 从库端⼝号--only arg# 指定单⼀的数据库复制--slavedelay arg# 设置从库同步主库的延迟时间* Replica set(副本集)选项:--replSet arg# 设置副本集名称--replSet arg# 设置副本集名称* Sharding(分⽚)选项--configsvr# 声明这是⼀个集群的config服务,默认端⼝27019,默认⽬录/data/configdb--shardsvr# 声明这是⼀个集群的分⽚,默认端⼝27018--noMoveParanoia# 关闭偏执为moveChunk数据保存# 上述参数都可以写⼊ mongod.conf 配置⽂档⾥例如:dbpath = /data/mongodblogpath = /data/mongodb/mongodb.loglogappend = trueport = 27017fork = trueauth = truee.g:./mongod -shardsvr -replSet shard1 -port 16161 -dbpath /data/mongodb/data/shard1a -oplogSize 100 -logpath/data/mongodb/logs/shard1a.log -logappend -fork -rest----------------------------------------------------------------------------------MonoDB shell命令操作语法和JavaScript很类似,其实控制台底层的查询语句都是⽤JavaScript脚本完成操作的。

mongodb的体系结构

mongodb的体系结构MongoDB的体系结构MongoDB是一种开源的文档数据库,采用分布式文件存储方式,具有高性能、可扩展性和灵活性。

它的体系结构包括数据库、集合、文档和索引四个层级。

1. 数据库层级在MongoDB中,数据库是最高级别的容器,用于存储和管理相关的数据集合。

一个MongoDB服务器可以同时运行多个数据库,每个数据库都有自己的文件和内存缓存。

2. 集合层级集合是MongoDB中的一个概念,类似于关系型数据库中的表。

一个数据库可以包含多个集合,每个集合都由多个文档组成。

集合不需要预定义模式,可以动态地添加或删除字段。

3. 文档层级文档是MongoDB中最基本的数据单位,类似于关系型数据库中的行。

文档是一个键值对的集合,可以包含不同类型的字段,如字符串、整数、日期等。

文档使用BSON(二进制JSON)格式进行存储,支持嵌套和数组类型的数据结构。

4. 索引层级索引是MongoDB中提高查询性能的关键元素。

通过在一个或多个字段上创建索引,可以加快查询操作的速度。

MongoDB支持多种类型的索引,包括单字段索引、复合索引、全文索引等。

索引可以在集合级别创建,也可以在文档级别创建。

MongoDB的体系结构是基于分布式存储的,可以通过水平扩展来满足大规模数据存储和处理的需求。

在一个MongoDB集群中,可以将数据分布在多个节点上,实现数据的负载均衡和高可用性。

每个节点都可以独立地处理查询和写入操作,通过复制机制来保证数据的一致性。

为了提高性能,MongoDB使用了内存映射文件的方式进行数据访问。

它将数据文件映射到内存中,通过缓存机制来加速读取操作。

同时,MongoDB还支持写入操作的持久化,可以将数据写入磁盘,保证数据的安全性。

除了基本的CRUD操作,MongoDB还提供了丰富的功能和特性,如聚合框架、地理空间索引、数据分片等。

这些功能可以帮助开发人员更方便地进行数据分析和处理,提高应用程序的性能和可扩展性。

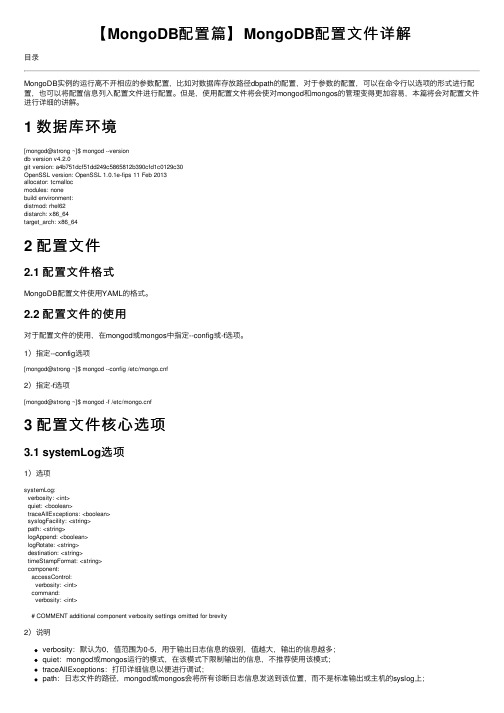

【MongoDB配置篇】MongoDB配置文件详解

【MongoDB配置篇】MongoDB配置⽂件详解⽬录MongoDB实例的运⾏离不开相应的参数配置,⽐如对数据库存放路径dbpath的配置,对于参数的配置,可以在命令⾏以选项的形式进⾏配置,也可以将配置信息列⼊配置⽂件进⾏配置。

但是,使⽤配置⽂件将会使对mongod和mongos的管理变得更加容易,本篇将会对配置⽂件进⾏详细的讲解。

1 数据库环境[mongod@strong ~]$ mongod --versiondb version v4.2.0git version: a4b751dcf51dd249c5865812b390cfd1c0129c30OpenSSL version: OpenSSL 1.0.1e-fips 11 Feb 2013allocator: tcmallocmodules: nonebuild environment:distmod: rhel62distarch: x86_64target_arch: x86_642 配置⽂件2.1 配置⽂件格式MongoDB配置⽂件使⽤YAML的格式。

2.2 配置⽂件的使⽤对于配置⽂件的使⽤,在mongod或mongos中指定--config或-f选项。

1)指定--config选项[mongod@strong ~]$ mongod --config /etc/f2)指定-f选项[mongod@strong ~]$ mongod -f /etc/f3 配置⽂件核⼼选项3.1 systemLog选项1)选项systemLog:verbosity: <int>quiet: <boolean>traceAllExceptions: <boolean>syslogFacility: <string>path: <string>logAppend: <boolean>logRotate: <string>destination: <string>timeStampFormat: <string>component:accessControl:verbosity: <int>command:verbosity: <int># COMMENT additional component verbosity settings omitted for brevity2)说明verbosity:默认为0,值范围为0-5,⽤于输出⽇志信息的级别,值越⼤,输出的信息越多;quiet:mongod或mongos运⾏的模式,在该模式下限制输出的信息,不推荐使⽤该模式;traceAllExceptions:打印详细信息以便进⾏调试;path:⽇志⽂件的路径,mongod或mongos会将所有诊断⽇志信息发送到该位置,⽽不是标准输出或主机的syslog上;logAppend:默认为false,若设为true,当mongod或mongos实例启动时,会将新的条⽬追加到已存在的⽇志⽂件,否则,mongod会备份已存在的⽇志,并创建新的⽇志⽂件;destination:指定⽇志输出的⽬的地,具体值为file或syslog,若设置为file,需指定path,该选项未指定,则将所有⽇志输出到标准输出;timeStampFormat:⽇志信息中的时间格式,默认为iso8601-local,该选项有三个值,分别为ctime、iso8601-utc和iso8601-local;3.2 processManagement选项1)选项processManagement:fork: <boolean>pidFilePath: <string>timeZoneInfo: <string>2)说明fork:默认值为false,设置为true,会激活守护进程在后台运⾏mongod或mongos进程;pidFilePath:指定mongod或mongos写PID⽂件的路径,不指定该值,则不会创建PID⽂件;3.3 cloud选项1)选项cloud:monitoring:free:state: <string>tags: <string>2)说明state:激活或禁⽤免费的MongoDB Cloud监控,该选项有以下三个值,分别为runtime、on和off,默认为runtime;在运⾏时可以通过db.enableFreeMonitoring()和db.disableFreeMonitoring()tags:描述环境上下⽂的可选标记;3.4 net选项1)选项net:port: <int>bindIp: <string>bindIpAll: <boolean>maxIncomingConnections: <int>wireObjectCheck: <boolean>ipv6: <boolean>unixDomainSocket:enabled: <boolean>pathPrefix: <string>filePermissions: <int>tls:certificateSelector: <string>clusterCertificateSelector: <string>mode: <string>certificateKeyFile: <string>certificateKeyFilePassword: <string>clusterFile: <string>clusterPassword: <string>CAFile: <string>clusterCAFile: <string>CRLFile: <string>allowConnectionsWithoutCertificates: <boolean>allowInvalidCertificates: <boolean>allowInvalidHostnames: <boolean>disabledProtocols: <string>FIPSMode: <boolean>compression:compressors: <string>serviceExecutor: <string>2)说明port:MongoDB实例监听客户端连接的TCP端⼝,对于mongod或mongos实例,默认端⼝为27017,对于分⽚成员,默认端⼝为27018,对于配置服务器成员,默认端⼝为27019;bindIp:默认值为localhost。

mongodb 分片原理

mongodb 分片原理MongoDB 分片是一种用于处理大量数据的横向扩展方法,允许将数据分布到多个服务器上。

分片可以在MongoDB 中实现水平扩展,提高系统的容量和性能。

以下是MongoDB 分片的基本原理:1. 分片键(Shard Key):-在MongoDB 中,数据根据一个称为分片键(Shard Key)的字段进行分片。

分片键的选择非常关键,它应该能够确保数据均匀分布,避免热点(hotspot)问题。

-分片键通常是在文档中的一个字段,MongoDB 根据这个字段的值来决定将文档存储在哪个分片上。

2. 分片集合(Sharded Collection):-分片集合是一个普通的MongoDB 集合,但被配置为进行分片。

这样的集合存储在多个分片服务器上,每个分片负责存储数据的一部分。

3. Config 服务器:-MongoDB 使用Config 服务器来跟踪每个分片中数据的范围和位置。

Config 服务器存储了分片集合的元数据,包括分片键的范围和分片的位置信息。

4. Mongos 路由器:-Mongos 是一个路由器,它位于应用程序和MongoDB 分片集群之间。

应用程序通过Mongos 与整个集群交互,Mongos 负责将请求路由到适当的分片上。

5. 数据迁移:-当有新的分片加入集群或现有的分片移除时,MongoDB 会自动进行数据迁移。

数据迁移确保分片集合中的数据保持均匀分布。

6. 均衡器(Balancer):- MongoDB 集群中有一个均衡器,它会监视每个分片上的数据量,并在需要时触发数据迁移以保持均衡。

均衡器可以手动启动或自动运行。

MongoDB 分片的主要优势在于它允许数据库在数据量增加时水平扩展,通过添加更多的分片来处理更多的负载。

分片键的选择和分片集群的规划是关键的设计决策,因为它们直接影响了系统的性能和可扩展性。

mongodb 高可用方案

mongodb 高可用方案MongoDB是一种流行的开源文档数据库,提供了高可用性和灵活性的解决方案。

为了实现高可用性,我们可以采用以下几种MongoDB的高可用方案:1. 副本集(Replica Set):副本集是MongoDB用于提供数据冗余和故障恢复的基本方式。

一个副本集由多个MongoDB实例组成,其中一个是主节点(Primary),其余是副本节点(Secondary)。

主节点处理所有的读写请求,副本节点复制主节点的数据,并提供读操作的能力。

如果主节点发生故障,副本集会自动进行主节点选举,选择一个新的主节点来接管服务。

2. 故障转移(Failover):故障转移是指当主节点不可用时,副本集能够自动选择一个新的主节点来保证服务的可用性。

副本集通过心跳机制来检测主节点的可用性,如果主节点不可用,副本集会自动进行选举以选择一个新的主节点。

这种自动故障转移可以在毫秒级别完成,不会对应用程序的正常运行产生明显的影响。

3. 分片集群(Sharded Cluster):分片集群是一种横向扩展的解决方案,用于处理大规模数据集。

在分片集群中,数据被分散存储在多个分片(Shard)上。

每个分片只存储部分数据,因此能够扩展到更大的存储容量和处理吞吐量。

分片集群还提供了故障恢复和自动扩容的功能,当某个分片发生故障或存储不足时,系统可以自动将数据迁移或重新分片来保证服务的可用性。

4. 心跳和延迟检测:为了进一步增加可用性和冗余性,可以在不同的地理位置部署MongoDB节点。

通过在多个地理位置部署节点,可以提供数据的快速复制和故障转移,以保证服务的高可用性。

此外,还可以通过定期发送心跳信号和检测延迟来实时监测节点的健康状况,以便及时发现并处理故障。

总结起来,MongoDB提供了多种高可用方案,包括副本集、故障转移、分片集群以及心跳和延迟检测等。

这些方案能够有效地提供数据冗余、故障恢复和灵活的扩展能力,以确保MongoDB系统的高可用性和可靠性。

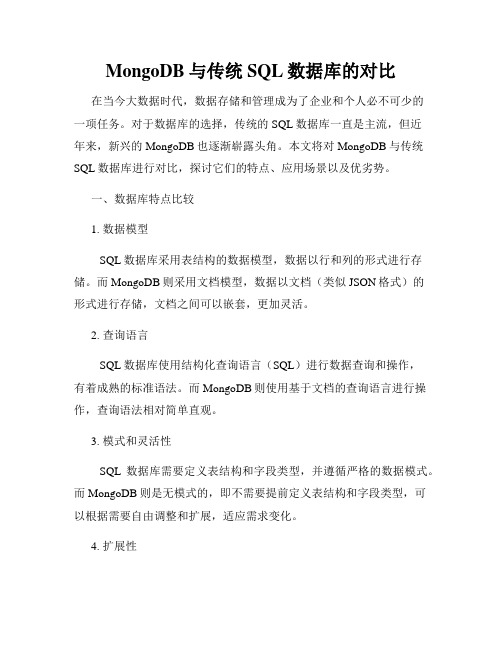

MongoDB与传统SQL数据库的对比

MongoDB与传统SQL数据库的对比在当今大数据时代,数据存储和管理成为了企业和个人必不可少的一项任务。

对于数据库的选择,传统的SQL数据库一直是主流,但近年来,新兴的MongoDB也逐渐崭露头角。

本文将对MongoDB与传统SQL数据库进行对比,探讨它们的特点、应用场景以及优劣势。

一、数据库特点比较1. 数据模型SQL数据库采用表结构的数据模型,数据以行和列的形式进行存储。

而MongoDB则采用文档模型,数据以文档(类似JSON格式)的形式进行存储,文档之间可以嵌套,更加灵活。

2. 查询语言SQL数据库使用结构化查询语言(SQL)进行数据查询和操作,有着成熟的标准语法。

而MongoDB则使用基于文档的查询语言进行操作,查询语法相对简单直观。

3. 模式和灵活性SQL数据库需要定义表结构和字段类型,并遵循严格的数据模式。

而MongoDB则是无模式的,即不需要提前定义表结构和字段类型,可以根据需要自由调整和扩展,适应需求变化。

4. 扩展性SQL数据库的扩展性相对较弱,需要通过水平分表和垂直切分等方式来实现扩展。

而MongoDB则天生支持分布式架构,可以通过分片集群来实现无缝扩展。

二、应用场景比较1. 关系型数据应用传统SQL数据库在处理结构化的、事务性强的数据方面表现出色,适用于金融、电商等需要强一致性和可靠性的应用场景。

2. 非结构化数据应用MongoDB擅长处理半结构化和非结构化数据,例如日志数据、用户行为数据等。

它的文档模型和灵活的数据结构更利于存储和处理这类数据。

3. 实时数据处理在需要高速读写和数据实时更新的应用中,MongoDB具备较大优势。

例如物联网、实时监控等场景,它可以快速写入和读取海量数据,并支持实时分析和查询。

三、优劣势比较1. 优势MongoDB具备以下优点:- 简化开发:无需事先定义表结构,减少开发成本和迭代调整的复杂性。

- 高扩展性:支持分布式架构,便于实现水平扩展和负载均衡。

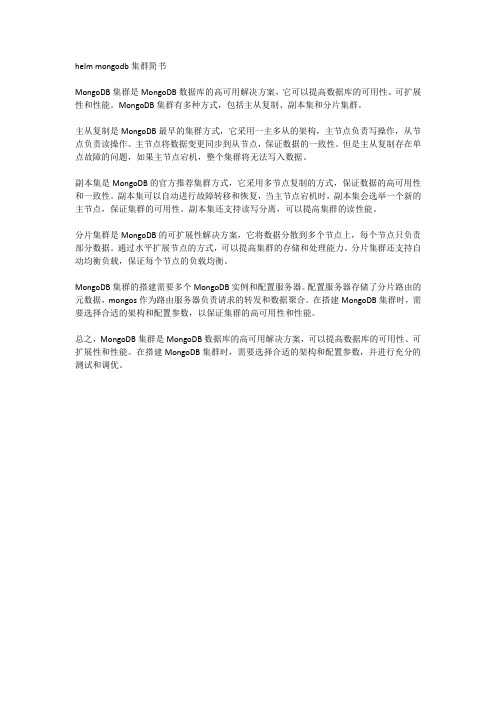

helm mongodb集群简书

helm mongodb集群简书

MongoDB集群是MongoDB数据库的高可用解决方案,它可以提高数据库的可用性、可扩展性和性能。

MongoDB集群有多种方式,包括主从复制、副本集和分片集群。

主从复制是MongoDB最早的集群方式,它采用一主多从的架构,主节点负责写操作,从节点负责读操作。

主节点将数据变更同步到从节点,保证数据的一致性。

但是主从复制存在单点故障的问题,如果主节点宕机,整个集群将无法写入数据。

副本集是MongoDB的官方推荐集群方式,它采用多节点复制的方式,保证数据的高可用性和一致性。

副本集可以自动进行故障转移和恢复,当主节点宕机时,副本集会选举一个新的主节点,保证集群的可用性。

副本集还支持读写分离,可以提高集群的读性能。

分片集群是MongoDB的可扩展性解决方案,它将数据分散到多个节点上,每个节点只负责部分数据。

通过水平扩展节点的方式,可以提高集群的存储和处理能力。

分片集群还支持自动均衡负载,保证每个节点的负载均衡。

MongoDB集群的搭建需要多个MongoDB实例和配置服务器。

配置服务器存储了分片路由的元数据,mongos作为路由服务器负责请求的转发和数据聚合。

在搭建MongoDB集群时,需要选择合适的架构和配置参数,以保证集群的高可用性和性能。

总之,MongoDB集群是MongoDB数据库的高可用解决方案,可以提高数据库的可用性、可扩展性和性能。

在搭建MongoDB集群时,需要选择合适的架构和配置参数,并进行充分的测试和调优。

基于MongoDB的NoSQL数据库系统设计与实现

基于MongoDB的NoSQL数据库系统设计与实现一、引言在当今信息爆炸的时代,数据量呈指数级增长,传统的关系型数据库已经无法满足大规模数据存储和处理的需求。

因此,NoSQL数据库应运而生,成为了解决大数据存储和处理问题的利器。

MongoDB作为一种典型的NoSQL数据库,以其高性能、高可扩展性和灵活的数据模型而备受青睐。

本文将深入探讨基于MongoDB的NoSQL数据库系统设计与实现。

二、MongoDB简介MongoDB是一个面向文档的NoSQL数据库,采用BSON(Binary JSON)格式存储数据,具有高性能、高可用性和水平扩展能力。

MongoDB将数据存储为一个文档,数据结构非常灵活,可以存储不同结构和类型的数据。

同时,MongoDB支持复制集和分片集群,保证了数据的可靠性和可扩展性。

三、NoSQL数据库系统设计原则CAP定理:NoSQL数据库系统设计需要考虑CAP定理,即一致性(Consistency)、可用性(Availability)和分区容忍性(Partition Tolerance)之间的平衡。

数据模型设计:根据应用场景设计合适的数据模型,避免关系型数据库中复杂的表连接操作。

索引设计:合理设计索引可以提高查询效率,但过多的索引会增加写入操作的开销。

分片策略:根据数据量和访问模式设计合适的分片策略,实现数据在集群中的均衡分布。

四、MongoDB数据库系统架构MongoDB数据库系统由多个组件组成,包括路由器、配置服务器、数据节点等。

其中路由器负责接收客户端请求并将请求路由到对应的数据节点,配置服务器存储集群的元数据信息,数据节点负责存储实际的数据。

五、NoSQL数据库系统设计与实现步骤需求分析:明确系统需求和使用场景,确定数据存储和访问模式。

数据建模:根据需求设计合适的数据模型,包括文档结构、字段类型等。

索引设计:根据查询需求设计合适的索引,提高查询效率。

分片策略设计:根据数据量和访问模式设计合适的分片策略。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

• 从节点

优先级为0的成员作为备用节点 隐藏节点 延时节点

• 投票节点

复制集Oplog

Oplog 是Mongodb 复制集的纽带 作用: 当Primary进行写操作的时候,会将这些写操作记录写入Primary的Oplog 中,而后Secondary会将 Oplog 复制到本机并应用这些操作,从而实现Replication的功能。 同时由于其记录了Primary上的写操作,故还能将其用作数据恢复。

复制集部署:举个例子

复制集的安全写级别

1:如果在执行写操作的时候指定了安全写级别,那 么该写操作将会使用指定的安全写级别而不是默认的 2:我们可以在每次写操作的时候指定安全写级别来 规避默认的安全写级别 3:我们可以在安全写级别中设定超时限制。这样可 以在写操作无法到达目标服务器的时候造成的堵塞。

✓$exist:因为松散的文档结构导致查询必须遍历每一个文档 ✓$ne:如果当取反的值为大多数,则会扫描整个索引 ✓$not:可能会导致查询优化器不知道应当使用哪个索引,所以会经常退化为全

表 扫描 ✓$nin:全表扫描 ✓$or:有多少个条件就会查询多少次,最后合并结果集,所以尽可能的使用 $in

IX. 不要一次取出太多的数据进行排序

复制集高可用

1:复制集成员每两秒向复制集中其他成员进行心跳检测。 如果某个节点在10秒内没有返回,那么它将被标记为不可用。 2:一个从节点无法与主节点进行连接。 当从节点们无法与主节点进行沟通的时候将会触发选举 3:如果复制集中的某个节点不能连接上其他多数节点, 那么它将不能升职为主节点。在选举中, 多数是指多数 投票 而不是多数节点个数。 4:我们可以通过设定 priority 来加重某个或者某些特殊的 节点在选举中获得选票的优先级。比如,当我们有一个 异地分布式架构的复制集 ,我们可以通过设置优先级来 使只有特定数据中心中的节点能够升职为主节点

复制集读选项

除了 primary 模式以外的复制集读选项都有可能返回非最新的数据,因为复制过程是异步的, 从节点 上应用操作可能会比主节点有所延后。如果我们不使用 primary 模式, 请确保业务允许数据存在可能的不一致。

I. 复制集的读写设置 ➢Read Preference ➢默认情况下,复制集的所有读请求都发到Primary,Driver可通过设置 Read Preference来将读请求路由到其他的节点。 ✓primary: 默认规则,所有读请求发到Primary ✓primaryPreferred: Primary优先,如果Primary不可达,请求 Secondary ✓secondary: 所有的读请求都发到secondary ✓secondaryPreferred:Secondary优先,当所有Secondary不可达时,请 求Primary nearest:读请求发送到最近的可达节点上(通过ping探测得出最近的节点) 统计分组函数优化 ➢db.props.aggregate([{$group:{_id:"$extra.uc_event.batchId",count:{$sum:1}}} ,{$match:{count:{$gt:1}}}],{ allowDiskUse: true }) 在secondary库执行 分析该语句可能出现的问题 ✓做统计分析,查询超过了mongodb限制的16M大小; ✓mongo内存限制。 aggregate函数 使用$group时,数据大小必须 小于16945KB

✓添加allowDiskUse: true解决

II.

Mongodb开发命名规则

III. 3.Mongodb的创建索引

✓需要和DBA沟通 ✓在后台创建索引—不影响业务正常的DML操作

b.works.createIndex({plan:1,trgpoints:1,cOrder:1,sValue:1},{background:true })

半初始化同步-初始化同步过程

以存在的复制集,添加新节点的工作原理。 在克隆的时候,会将数据抓取到内存里面,会对primary有影响。

复制集成员

• 主节点

主节点是唯一能够接收写请求的节点。MongoDB在 主节点 上进行写操作,并会将这些操作记录 到主节点的 oplog 中。 从节点 会将oplog复制到其本机并将这些操作应用到其自己的数据集上。

IV. 删除字段、修改字段值等不清楚的和DBA沟通 V. 库名全部小写,禁止使用任何`_`以外的特殊字符,比如我们线上lppmm数据库 VI. 集合名全部小写,禁止使用任何`_`以外的特殊字符 VII. 如果评估单集合数据量较大,比如8亿以上的集合,可以将一个大 集合拆分为多个小集合,即mongodb的分库分表-sharding; VIII. MongoDB的集合拥有“自动清理过期数据”的功能

✓需在该集合中文档的时间字段增加一个TTL索引即可实现该功能 ✓但需要注意的是该字段的类型则必须是mongoDate() ✓一定要结合实际业务设计是否需要

Mongodb开发命名规则

IX. 文档设计

✓文档中的key禁止使用任何`_`以外的特殊字符 ✓禁止使用_id,如:向_id中写入自定义内容

X.

查询中的某些 $ 操作符可能会导致性能低下

Mongodb集群架构

Mongodb

HA集群架构

01

Mongodb 命 名 规 则

02

Mongodb 复 制 集

03

Mongodb 分 片 集 群

04

型 场 景 Mongodb 集 群 模 式 典

05

研 发 特 别 注 意

ONE

Mongodb命名约束规则

SQL到MongoDB映射表

Mongodb开发命名规则

✓MongoDB 目前支持对32MB以内的结果集进行排序 ✓如果需要排序,那么请尽量限制结果集中的数据量

TW Mongodb O 副本集介绍

户端动通过isMaster命令,来判断复制集哪个节点是当前主节点; 判断之后,将writes操作,指向primary节点; Mongodb也属于异步复制,就是写完主库操作以后,将这个操作记录下来, 在主库的oplog里,oplog主从都有;secondary节点都是通过复制主节点的oplog到本机的oplog里进行应用