搜索引擎技术论文

搜索引擎

搜索引擎分析在当今的社会,上网成为了我们大部分人每天必不可少的一部分,网络具有太多的诱惑和开发的潜力,查询资料,消遣娱乐等等,但是这些大部分都离不开搜索引擎技术的应用。

今天在我的这篇论文里将会对搜索引擎进行一个分析和相关知识的概括。

就如大家所知道的互联网发展早期,以雅虎为代表的网站分类目录查询非常流行。

网站分类目录由人工整理维护,精选互联网上的优秀网站,并简要描述,分类放置到不同目录下。

用户查询时,通过一层层的点击来查找自己想找的网站。

也有人把这种基于目录的检索服务网站称为搜索引擎,但从严格意义上讲,它并不是搜索引擎。

1990年,加拿大麦吉尔大学计算机学院的师生开发出Archie。

当时,万维网还没有出现,人们通过FTP来共享交流资源。

Archie能定期搜集并分析FTP服务器上的文件名信息,提供查找分别在各个FTP主机中的文件。

用户必须输入精确的文件名进行搜索,Archie告诉用户哪个FTP服务器能下载该文件。

虽然Archie搜集的信息资源不是网页,但和搜索引擎的基本工作方式是一样的:自动搜集信息资源、建立索引、提供检索服务。

所以,Archie被公认为现代搜索引擎的鼻祖。

搜索引擎是指根据一定的策略、运用特定的计算机程序从互联网上搜集信息,在对信息进行组织和处理后,为用户提供检索服务,将用户检索相关的信息展示给用户的系统。

搜索引擎包括全文索引、目录索引、元搜索引擎、垂直搜索引擎、集合式搜索引擎、门户搜索引擎与免费链接列表等。

百度和谷歌等是搜索引擎的代表。

那么搜索引擎将来的发展方向和发展的前景又是如何?我们就先从以下的各类主流搜索引擎先进行一个大致的分析。

1.全文索引全文搜索引擎是当今主要网络搜素时所应用的搜索引擎,在网络上也是大家所熟知的,比如google和百度都是我们平时经常使用的。

它们从互联网提取各个网站的信息,建立起数据库,并能检索与用户查询条件相匹配的记录,按一定的排列顺序返回结果。

根据搜索结果来源的不同,全文搜索引擎可分为两类,一类拥有自己的检索程序,俗称“蜘蛛”程序或“机器人”程序,能自建网页数据库,搜索结果直接从自身的数据库中调用,上面提到的Google 和百度就属于这种类型;另一类则是租用其他搜索引擎的数据库,并按自定的格式排列搜索结果,如Lycos搜索引擎。

搜索引擎语义排序的设计与实现论文

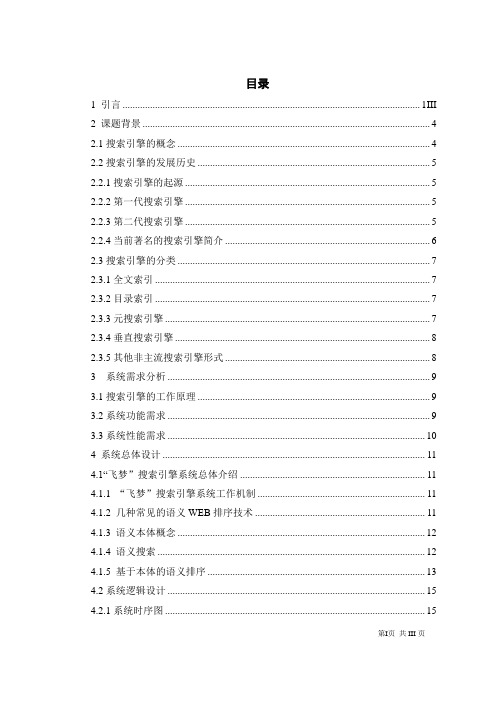

目录1 引言 (1III)2 课题背景 (2)2.1搜索引擎的概念 (2)2.2搜索引擎的发展历史 (3)2.2.1搜索引擎的起源 (3)2.2.2第一代搜索引擎 (3)2.2.3第二代搜索引擎 (3)2.2.4当前著名的搜索引擎简介 (4)2.3搜索引擎的分类 (5)2.3.1全文索引 (5)2.3.2目录索引 (5)2.3.3元搜索引擎 (5)2.3.4垂直搜索引擎 (6)2.3.5其他非主流搜索引擎形式 (6)3 系统需求分析 (7)3.1搜索引擎的工作原理 (7)3.2系统功能需求 (7)3.3系统性能需求 (8)4 系统总体设计 (9)4.1“飞梦”搜索引擎系统总体介绍 (9)4.1.1 “飞梦”搜索引擎系统工作机制 (9)4.1.2 几种常见的语义WEB排序技术 (9)4.1.3 语义本体概念 (10)4.1.4 语义搜索 (10)4.1.5 基于本体的语义排序 (11)4.2系统逻辑设计 (13)4.2.1系统时序图 (13)第I页共III页4.2.2系统流程图 (14)4.2.3系统数据流程图 (15)4.3系统模块介绍 (16)4.3.1 模块功能介绍 (16)5 系统详细设计 (21)5.1模块总体介绍 (21)5.2抓取子模块 (22)5.2.1运行Heritrix子模块 (22)5.2.2分析网页子模块 (27)5.3信息检索子模块 (30)5.3.1解析网页子模块 (30)5.3.2创建词库子模块 (31)5.3.3生成持久化类子模块 (31)5.3.4创建Document子模块 (32)5.3.5存储数据子模块 (33)5.4语义排序模块 (33)5.4.1概念定义 (33)5.4.2算法实现原理 (34)5.4.3 语义排序部分代码 (35)5.5用户子模块 (37)5.5.1搜索页面 (38)5.5.2详细信息页面 (38)5.5.3后台信息管理 (38)6 结论 (39)参考文献 (40)致谢 (42)第II页共III页1 引言随着互联网的不断发展和日益普及,信息技术的不断发展,网上的信息量在爆炸性增长,网络已经深入到了人们生活的各个方面,影响并改变了人们生活方式和思维方式。

各类搜索引擎的搜索语法应用论文

各类搜索引擎的搜索语法应用论文1 通配符搜寻语法通配符,作为一种用于模糊搜寻的特别语句,主要有星号〔*〕、问号〔?〕、百分号〔%〕等,用以代替一个或多个真正的字符。

谷歌支持的通配符是*,属于“fullw ordw ildcard”〔全词通配符〕,可以代替一个或多个英文单词、中文字词,以及多个字符,能多个* 一起使用,但是谷歌不支持?和% .国外的一些搜寻引擎如N orthernlight、yahoo 支持通配符 *,aolsearch、inktom i等支持通配符?,Northernlight还支持通配符% ,不过这些通配符不同于谷歌支持的“全词通配符”,而属于“partialw ordw ildcard”〔词间通配符〕,只能代替单词中的一个或几个字母,而非整个单词。

国内的中文搜寻引擎,如百度、搜狗等是不支持通配符搜寻语法。

2 精确搜寻语法精确搜寻,又称为强制搜寻,主要有加号〔+〕、双引号〔“”〕、书名号〔《》〕等几种。

1〕加号〔+〕,强制停用词〔stopw ord〕搜寻,表达式为+A,即检索的.文本处理过程中,遇到+后面的关键词A,就要马上停止,由此削减索引量,提高检索效率。

当前支持 + 停用词搜寻语法的主要是google,百度等国内搜寻并不支持。

2〕双引号〔“”〕,强制关键词的精确匹配搜寻,表达式为“A”,无中英文状态的要求,使用该语法的关键词,是被视作一个整体来搜寻,不再进行拆分,对于一个完成的句子或特定短语比较适合。

作为一种基本搜寻语法,被大多数搜寻引擎所支持。

3〕书名号〔《》〕,强制图书、报刊、音乐、影视等名称的精确匹配搜寻,表达式为《A》,谷歌、百度、360、有道等对此支持,而必应、雅虎、搜狗、搜搜并不支持。

3 规律搜寻语法规律搜寻就是在检索两个或以上的关键词时,需要用到布尔规律运算。

详细语法主要有“规律与”、“规律或”、“规律非”,分别表示AN D、O R、N O.1〕“规律与”,表示要同时包含两个或以上的关键词,操作符有空格、加号〔+〕、and号〔〕等几种,表达式分别是A B、A+B、AB,多数搜寻引擎是将空格作为“规律与”的操作符,而谷歌支持空格和加号〔+〕,百度支持空格和and号〔〕。

Google_云计算三大论文中文版

Google_云计算三大论文中文版Google公司是全球最大的搜索引擎和云计算服务提供商之一。

Google的云计算架构和算法在业界受到广泛关注,其通过一系列论文来介绍这些技术,并分享了它们的最佳实践。

本文将针对Google公司发表的三篇云计算论文(论文名称分别为《MapReduce:Simplified Data Processing on Large Clusters》、《The Google File System》、《Bigtable: A Distributed Storage System for Structured Data》),进行分类讲解,以帮助读者更好地了解云计算领域的相关技术。

一、MapReduce:Simplified Data Processing on Large ClustersMapReduce论文是Google公司云计算领域中的重要代表作之一,它的作者是Jeffrey Dean和Sanjay Ghemawat。

MAPREDUCE是一种大规模数据处理技术,其主要目的是在一个大型集群中分Distribute and Parallel Execution(分布式和并行执行)处理任务。

MapReduce将计算逻辑分解成两个部分- Map阶段和Reduce阶段。

在Map阶段,数据被按键提取;在Reduce阶段,数据被收集以计算结果。

这两个阶段可以在许多物理节点上并行执行,大大提高了计算效率。

此外,该论文引入了GFS分布式文件系统,为MapReduce提供了强大的文件系统支持。

二、The Google File SystemGFS是由Sanjay Ghemawat、Howard Gobioff和Shun-TakLeung共同编写的一篇论文。

它旨在解决分布式文件系统上的问题,以应对Google的大规模数据集和两台甚至三台以上的机器发生故障的情况。

GFS可以处理超过100TB以上的数据集,加速数据读取和写入,处理大规模数据存储集群。

毕业论文的关键词与搜索引擎优化

毕业论文的关键词与搜索引擎优化在信息高度依赖互联网的今天,搜索引擎成为人们获取信息的主要途径。

对于撰写毕业论文的学生而言,了解如何选取合适的关键词,并进行搜索引擎优化,能够提高论文的可见度和影响力。

本文将介绍毕业论文关键词的选择方法,并探讨搜索引擎优化对于论文的重要性。

一、毕业论文关键词的选择方法关键词是描述论文主要内容和研究领域的重要标签。

通过合理选择关键词,可以使论文更容易被搜索引擎收录和检索,提高论文的曝光率。

以下是选择毕业论文关键词的几个方法:1. 突出研究主题:关键词应直接与论文的主要研究课题相关。

例如,如果论文是关于大数据分析的,可以选择关键词为“大数据”、“数据分析”、“机器学习”等,突出研究的主题。

2. 参考相关文献:查找与论文研究领域相关的高影响力论文,并分析这些论文中常用的关键词。

借鉴这些关键词的选择方法,有助于提高论文的曝光率。

3. 使用科学工具:借助一些在线的关键词分析工具,如Google Trends和百度指数等,可以了解当前热门关键词和搜索趋势。

选择与研究课题相关且热门的关键词,有助于扩大论文的影响力。

二、搜索引擎优化对于毕业论文的重要性搜索引擎优化(Search Engine Optimization,简称SEO)是通过优化网页结构和内容,使其在搜索引擎中排名靠前的技术。

在毕业论文中进行搜索引擎优化,可以使论文更容易被检索和阅读。

以下是搜索引擎优化对毕业论文的重要性:1. 提高曝光率:搜索引擎优化可以使论文在搜索结果中更容易被用户发现,提高论文的曝光率。

这样,更多的读者将有机会了解和引用论文。

2. 增强可信度:搜索引擎通常会将排名靠前的网页视为更有权威性和可信度。

通过优化论文的关键词和网页结构,使其在搜索结果中排名靠前,可以增强论文的可信度,为论文的研究价值背书。

3. 扩大影响力:搜索引擎优化可以使毕业论文在互联网上具有更大的传播力。

当其他研究者在相关领域进行文献调研时,他们更有可能通过搜索引擎找到优化过的论文,从而提高论文的引用量和影响力。

搜索引擎论文

The Design and Realization of Open-Source SearchEngine Based on NutchGuojun Yu 1Xiaoyao Xie *,2Zhijie Liu 3Key Laboratory of Information and Computing Science of Guizhou ProvinceGuizhou Normal University Network CenterGuiyang,Chinaxyx@ (corresponding author:Xiaoyao Xie)Abstract —Search engines nowadays are becoming more andmore necessary and popular in surf surfing ing the Internet Internet..However,how these search engines like G oogle or B aidu work works s is unknown to many people.This paper,through a research into Open-source search engine Nutch,introduces how a common search engine works.By using Nutch,a search engine whichbelongs to Guizhou Normal University University’’s website is designed and at last,through the improvement of Nutch Nutch’’s sorting algorithm and experiment experiment,,it can be found that Nutch is very suitable for working in home-search home-search..Keywords-Search Engine Engine;;Nutch Nutch;;Lucene Lucene;;Java Open Source Source;;I.I NTRODUCTIONNutch is an open-source search engine based on LuceneJava,which is an open-source information retrieval library supported by the Apache Software Foundation for the search and index component,providing a crawler program,an Index engine and a Query engine[1].Nutch consists of the following three parts:(1)Pages collection (fetch).The program of collecting pages,by timely collection or incremental collection,chooses the URLs,through which pages are to be visited and then fetched to the local disk by the crawler.(2)Creating index.The program of creating index converts the pages or other files into the txt-document,divides them into segments,filters some useless information and then,creates and assists indexes which are composed by some smaller indexes based on key words or inverted documents.(3)Searcher.The program of searcher accepts user’s query words through segmentation and filtering and then divides them into groups of key words,according to which correspondent pages are matched in treasury index.Then,it puts the matches in order by sorting and returns the results to the users.The overall framework of Nutch is listed infigureFigure 1II.ACKGROUNDOn account of the fact that there are so many sites under Guizhou Normal University’s website,not only the pages but also some other resources like doc,pfd are needed to be indexed.In this sense,adding the text analyzer module to the design based on Nutch’s framework,the whole design is composed by the crawler design module,the text analyzer module,the index module and the search module as listed in figure2.Figure2III.HE PROCESS OF THE WORKFLOWA.An Analyzsis of the Nutch’CrawlerA Web crawler is a kind of robot or software agent.In general,it starts with a list of URLs to visit,called the seeds.When visiting these URLs,the crawler identifies all the hyperlinks in the page and adds them to the list of URLs to visit,called the crawl frontier [2].URLs from the frontier are recursively visited according to a set of policies.See figure3referenced from[2].Figure3There are four factors affecting the crawler’s ability referenced by [3]:Depth:the depth of the downloadtopN:the amount of page hyperlinks before the downloadThreads:the threads which the download programmer usesDelay:the delay time of the host visiting The work process of the Nutch’s Crawler includes four steps as follows:1.Create the initial collection of the URL.2.Begin the Fetching based on the pre-defined Depth,topN,Threads and Delay.3.Create the new URL waiting list and start the new round of Fetching like in Figure 4referenced by [8].4.Unite the resources downloaded in the local disk.B.Page Voice EliminationAfter getting the content,the pages include a lot of tags and other ad information.It is necessary to eliminate these spasms and get the effective document.Here the program must complete two missions.See figure 6referenced by [9].1.Analyze the inner html pages’basis information and distinguish the structure of the pages.2.At the same time,eliminate the voice of the page and avoid the same results.Figure 5Under the directory of the Nutch workspace,there are some folders listed as follows:Crawldb Directory:This folder stores the URLs downloaded and the time when they were downloaded.Linkdb Directory:This folder stores the relationship between the URLs,which is form the parsed results after the download.Segments:This folder stores the pages and resources that the crawler has fetched.The amount of the directories is related to the depth of the crawler’fetch.For much better management,the folders are named in their time.C.Creating the IndexAt the heart of all search engines is the concept of indexing,which means processing the original data into a highly efficient cross-reference lookup in order to facilitate rapid searching.Nutch’s Documents are analyzed and disposed by Lucene.Lucene is a high performance,scalable Information Retrieval (IR)library [4].It lets you add indexing and searching capabilities to your applications.Lucene is a mature,free,open-source project implemented in Java.Figure 6referenced by [6]displays the framework of the Lucene.And there are three steps to complete the work referenced by [5]-[6].Figure6The first step:Document ConvertingLucene does not care about the source of the data,its format,or even its language as long as you can convert it to text.This means you can use Lucene to index and search data stored in files,web pages on remote web servers, documents stored in local file systems,simple text files, Microsoft Word documents,HTML or PDF files,or any other formats,from which you can extract textual information.Figure7referenced by[6]tellingmore.Figure7The second step:AnalysisOnce you have prepared the data for indexing and have created Lucene Documents populated with Fields,you can call Index Writer’s add-Document(Document)method and hand your data off to Lucene to index.When you do that, Lucene first analyzes the data to make it more suitable for indexing.To do so,it splits the textual data into chunks,or tokens,and performs a number of optional operations on them.For instance,the tokens could be lowercased before indexing to make searches case-insensitive.Typically it’s also desirable to remove all frequent but meaningless tokens from the input,such as stop words(a,an,the,in,on,and soon)in English text.An important point about analyzers is that they are used internally for fields flagged to be tokenized.Documents such as HTML,Microsoft Word,XML contain meta-data such as the author,the title,the last modified date,and potentially much more.When you are indexing rich documents,this meta-data should be separated and indexed as separate fields.The third step:Storing the IndexAn inverted index(also referred to as postings file or inverted file)is an index data structure storing a mapping from content,such as words or numbers,to its locations in a database file,or in a document or a set of documents,in this case allowing full text search.The inverted file may be the database file itself,rather than its index.It is the most popular data structure used in document retrieval systems.With the inverted index created,the query can now be resolved by jumping to the word id(via random access)in the inverted index.Random access is generally regarded as being faster than sequential access.The main Classes which achieve three steps listed as follows:Index Writer,Directory,Analyzer,Document, and Field.D.The Disposal of the Chinese Words SegmentationA major hurdle(unrelated to Lucene)remains when we are dealing with various languages,handling text encoding. The Standard Analyzer is still the best built-in general-purpose analyzer,even accounting for CJK characters. However,the Sandbox CJK Analyzer seems better suited for Chinese Words analysis[6].When we are indexing documents in multiple languages into a single index,using a per-Document analyzer is more appropriate.At last,under the directory of the Nutch workspace, there are some folders which store the index listed as follows:Indexes:stores individual index directories.Index:stores the last directory according to the Lucene’s format,which is combined by some individual indexes.E.The Design and Realization of the Searching ModuleSearching is the process of looking up words in an index to find documents where they appear.The quality of a search is typically described using precision and recall metrics[7].Recall measures how well the search system finds relevant documents,whereas precision measures how well the system filters out the irrelevant documents. However,we must consider a number of other factors when thinking about searching.Support for single and multi-term queries,phrase queries,wildcards,result ranking,and sorting is also important as a friendly syntax for entering those queries.Figure7shows the process of the searching.Pretreatment means carrying on text treatment. Segmentation through the class Query Parser and mixing a term in accordance with the Lucene format are two examples.The main classes which achieve these functions are listed as follows:Index Search,Term,Query,Term Query, Hits.F.Sorting Search ResultsSome common search Sorting models are Boolean logic model,Fuzzy logic model,Vector logic model and Probability searching model.In some applications we mainly use vector logic model which calculates the weighted parameters through the TF-IDF method.In this process,through calculation from the key words and the document’s relativity,we can get the value of the relativity between the key words and each document.And then,we sort these values,putting the document which meets the need(the value is higher)forward to the user,But this model has some limits:First,Web has mass data.The page includes a lot of insignificant and iterant messages which affect the information that users really want.The model cannot deal with these messages well.Second,the model does not take the links into account.In fact,the other goal of the search engine is to find the page which users often visit.Through the page the search engine could decide the importance of links of another page,like Page Rank.Lucene’s sorting model is improved based upon vector model,listed as follows:Lucene sorting algorithm[6]:score_d=sum_t(tf_q*idf_t/norm_q*tf_d*idf_t/ norm_d_t)score_d:Document(d)’score.sum_t:Term(t)’summation.tf_q:The square root of t’s frequence.tf_d:The square root of t’s frequence in d.idf_t:log(numDocs/docFreq_t+1)+1.0。

搜索引擎优化技术在中职招生中应用论文

搜索引擎优化技术在中职招生中的应用摘要:中等职业学校要花很大力气去吸引学生来就读,学生的选择范围很大,几乎达到了任意选择的程度。

学生们选择哪个学校就读,对学校的生存和发展具有了决定性的意义。

利用互联网进行招生是对学校的招生工作最有意义的补充。

关键词:搜索引擎优化技术招生网站【中图分类号】g710随着互联网时代的到来,人们接受信息方式已经悄悄地由传统的媒体向互联网转移,我国网民已经突破5亿,而中职的招生却面临着前所为有的困境,每年在传统媒体投放的宣传费用一直在增加,但是效果却越来越收效甚微。

本文通过利用seo技术,对中职学校招生方式进行一种转变,从而提高中职学校的招生效果。

搜索引擎优化(seo)通过改善网站页面优化、网站关键字分析与分布、网站结构、用户体验等等多方面因素,提高网站对搜索引擎友好度,使网站在搜索引擎中得到更好的表现。

搜索引擎优化技术的主要工作搜索引擎优化通过了解各类搜索引擎如何抓取互联网页面,如何进行索引以及如何确定其对某一特定关键词的搜索结果排名等技术,来对网页进行相关的优化,使网站对全文搜索引擎友好,从而帮助全文搜索引擎找到含有最好内容的网页,使其提高搜索引擎排名,从而提高网站访问量,最终提升网站的销售能力或宣传能力。

作为中职学校招生对象大部分为年龄为13-18岁的学生,而学生父母年龄大约也在35-46岁之间,这部分人也是国内网民主力军,不管是学生还是家长本人都是通过各种方法想给学生找一个比较好的出路,由于生活平不断提高,生活节奏逐渐变快,人们没有大量时间去实地考察一个个学校,人们想了解一所学校,最好最快捷的方法就是通过互联网。

学校网站优化策略1.优化网页标题。

为每页内容写5到8个字的描述性标题,说明该页面最重要的内容,网页标题将出现在搜索结果页面的链接上,因此可稍带煽动性,以吸引搜索者点击该链接。

同时在首页内容中写上学样名和最重要的关键词,网站的每一个页面都应该有针对该页面的标题。

搜索引擎优化营销毕业论文

搜索引擎优化营销毕业论文搜索引擎优化(SEO)是一种通过改善网站在搜索引擎中的排名来增加网站流量的技术。

本文旨在探讨搜索引擎优化在营销中的应用及其对企业的影响。

摘要简介搜索引擎优化的策略1. 关键字优化:根据目标受众的需求和搜索惯,选择适当的关键字,并将其合理地分布在网站的标题、描述、URL和内容中。

2. 内容优化:提供高质量、有价值的内容,包括文章、博客、视频等。

通过更新和优化内容,吸引用户并提升网站在搜索引擎中的排名。

4. 社交媒体营销:充分利用社交媒体平台,与目标客户建立互动,分享有关企业和产品的相关内容,并吸引更多流量和关注。

搜索引擎优化对企业的影响1. 增加流量和曝光:通过搜索引擎优化,企业可以提高网站的排名,从而获得更多的点击和流量。

更多的曝光意味着更多的机会吸引潜在客户,并提高销售额。

2. 建立品牌形象:在搜索引擎中获得良好的可见性可以增强企业的品牌形象。

用户更容易记住排名靠前的网站,从而提高品牌的知名度和信任度。

3. 提高转化率:搜索引擎优化吸引到的流量往往是有针对性的,因此转化率相对较高。

通过优化网站的用户体验和增加相关内容,企业可以更好地引导用户进行购买或其他转化行为。

实践建议- 深入了解目标受众的需求和搜索惯,选择合适的关键字。

- 定期优化网站内容和结构,以适应搜索引擎的算法变化。

- 寻求专业的搜索引擎优化服务或培训,提升自身的专业能力。

- 持续跟踪分析网站数据和搜索引擎排名,及时调整优化策略。

结论通过搜索引擎优化,企业可以提高网站的可见性、流量和转化率,进而增加销售额和建立品牌形象。

因此,搜索引擎优化在现代企业营销中具有重要意义。

在实施搜索引擎优化策略时,企业应该根据目标受众的需求和搜索习惯,以及持续改进和优化网站内容。

学术搜索引擎在毕业论文文献检索中的应用研究

学术搜索引擎在毕业论文文献检索中的应用研究随着互联网的快速发展,学术搜索引擎在毕业论文文献检索中扮演着越来越重要的角色。

本文将探讨学术搜索引擎在毕业论文文献检索中的应用研究,分析其优势和局限性,并提出一些建议以提高毕业论文文献检索的效率和质量。

一、学术搜索引擎的概念及特点学术搜索引擎是指专门用于检索学术文献的搜索引擎,如Google Scholar、百度学术、知网等。

与传统搜索引擎相比,学术搜索引擎具有以下特点:1. 专业性强:学术搜索引擎主要面向学术研究人员和学生,检索结果更加专业和权威。

2. 涵盖范围广:学术搜索引擎可以检索包括期刊论文、学位论文、会议论文等在内的各类学术文献。

3. 检索精准:学术搜索引擎支持关键词检索、作者检索、期刊检索等多种检索方式,能够更准确地满足用户需求。

4. 提供引用信息:学术搜索引擎通常会显示文献的引用信息,方便用户了解该文献的影响力和相关研究。

二、学术搜索引擎在毕业论文文献检索中的应用1. 提供便捷的文献检索途径:学术搜索引擎为毕业论文的文献检索提供了便捷的途径,用户可以通过输入关键词或作者名快速找到相关文献。

2. 获取权威的学术资源:学术搜索引擎汇集了全球范围内的学术资源,用户可以获取到最新、最权威的研究成果,为毕业论文的写作提供有力支持。

3. 查找相关研究文献:学术搜索引擎可以根据用户输入的关键词推荐相关的研究文献,帮助用户扩大文献检索范围,提高文献检索效率。

4. 分析文献引用情况:学术搜索引擎提供文献的引用信息,用户可以了解该文献在学术界的影响力和被引情况,有助于评估文献的质量和重要性。

三、学术搜索引擎在毕业论文文献检索中的优势1. 资源丰富:学术搜索引擎汇集了全球范围内的学术资源,用户可以获取到各个学科领域的最新研究成果。

2. 检索精准:学术搜索引擎支持多种检索方式,用户可以根据自己的需求进行精准检索,提高文献检索效率。

3. 提供引用信息:学术搜索引擎显示文献的引用信息,用户可以了解该文献的学术影响力和相关研究情况,有助于评估文献的质量。

基于网络爬虫的搜索引擎设计与实现—毕业设计论文

本科毕业设计题目:基于网络爬虫的搜索引擎设计与实现系别:专业:计算机科学与技术班级:学号:姓名:同组人:指导教师:教师职称:协助指导教师:教师职称:摘要本文从搜索引擎的应用出发,探讨了网络蜘蛛在搜索引擎中的作用和地住,提出了网络蜘蛛的功能和设计要求。

在对网络蜘蛛系统结构和工作原理所作分析的基础上,研究了页面爬取、解析等策略和算法,并使用Java实现了一个网络蜘蛛的程序,对其运行结果做了分析。

关键字:爬虫、搜索引擎AbstractThe paper,discussing from the application of the search engine,searches the importance and function of Web spider in the search engine.and puts forward its demand of function and design.On the base of analyzing Web Spider’s system strtucture and working elements.this paper also researches the method and strategy of multithreading scheduler,Web page crawling and HTML parsing.And then.a program of web page crawling based on Java is applied and analyzed.Keyword: spider, search engine目录摘要 (1)Abstract (2)一、项目背景 (4)1.1搜索引擎现状分析 (4)1.2课题开发背景 (4)1.3网络爬虫的工作原理 (5)二、系统开发工具和平台 (5)2.1关于java语言 (5)2.2 Jbuilder介绍 (6)2.3 servlet的原理 (6)三、系统总体设计 (8)3.1系统总体结构 (8)3.2系统类图 (8)四、系统详细设计 (10)4.1搜索引擎界面设计 (10)4.2 servlet的实现 (12)4.3网页的解析实现 (13)4.3.1网页的分析 (13)4.3.2网页的处理队列 (14)4.3.3 搜索字符串的匹配 (14)4.3.4网页分析类的实现 (15)4.4网络爬虫的实现 (17)五、系统测试 (25)六、结论 (26)致谢 (26)参考文献 (27)一、项目背景1.1搜索引擎现状分析互联网被普及前,人们查阅资料首先想到的便是拥有大量书籍的图书馆,而在当今很多人都会选择一种更方便、快捷、全面、准确的方式——互联网.如果说互联网是一个知识宝库,那么搜索引擎就是打开知识宝库的一把钥匙.搜索引擎是随着WEB信息的迅速增加,从1995年开始逐渐发展起来的技术,用于帮助互联网用户查询信息的搜索工具.搜索引擎以一定的策略在互联网中搜集、发现信息,对信息进行理解、提取、组织和处理,并为用户提供检索服务,从而起到信息导航的目的.目前搜索引擎已经成为倍受网络用户关注的焦点,也成为计算机工业界和学术界争相研究、开发的对象.目前较流行的搜索引擎已有Google, Yahoo, Info seek, baidu等. 出于商业机密的考虑, 目前各个搜索引擎使用的Crawler 系统的技术内幕一般都不公开, 现有的文献也仅限于概要性介绍. 随着W eb 信息资源呈指数级增长及Web 信息资源动态变化, 传统的搜索引擎提供的信息检索服务已不能满足人们日益增长的对个性化服务的需要, 它们正面临着巨大的挑战. 以何种策略访问Web, 提高搜索效率, 成为近年来专业搜索引擎网络爬虫研究的主要问题之一。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

搜索引擎技术论文

中文智能搜索引擎技术研究

引言

随着互联网的快速发展,网络信息量不断增加。

面对数量庞大,种类多样的信息,一般搜索引擎无法为用户提供准确的检索结果,开发新的搜索引擎势在必行。

智能搜索引擎不仅要提高信息检索准确性和全面性,还要满足用户个性等搜索信息需求。

搜索引擎与智能代理相结合的智能化搜索引擎技术能够比较好的实现这一目标。

1搜索引擎

1.1搜索引擎基本原理

搜索引擎由信息搜集系统、文件处理系统、索引系统和检索系统组成。

信息搜集系统通过网页抓取程序(spider)在网络中顺着网页的超链接抓取网页,搜集文档的基本信息并下载至搜索引擎本地,然后将文档和其基本信息分开,并保存到原始文档数据库和文档信息数据库中。

文件处理系统负责将需要索引的文件转换成具有统一编码格式的文本文件。

信息搜集系统从网络上下载文件,保存到本地供索引器索引。

文件文本格式种类繁多,如纯文本文件、html格式文件、word文件、pdf文档等,文本格式相同的文件,字符编码方式也不尽相同。

文件的异构性要求文件处理系统将各种不同格式的类文本文件转换成纯文本文件。

索引系统将程序收集到的文件进行处理,建立索引库和索引。

相关处理还包括去除重复网页、分词(中文)、判断网页类型、分析超链接,计算网页的重要度、丰富度等。

检索系统通过用户输入的关键词从索引数据库中找到与关键词匹配的网页,并按照文档得分的高低依次显示在用户浏览器中。

1.2传统搜索引擎的局限性

面对浩如烟海的网络信息,用户想要通过一般搜索引擎获取准确和全面的信息较困难。

其局限性表现在:

(1)信息检索方式单一。

搜索引擎一般提供网站分类查询和关键

词全文检索两种方式,这两种方法均容易造成信息丢失,不能全面

检索用户需要的信息;不能对用户输入的关键词进行词意分析和词意

扩展。

如今信息的多样化要求搜索引擎不仅要检索出文档,还要检

索需要的图片、视频、音频等。

(2)不能个性化制定。

传统搜索引擎提供相同的界面和检索策略,不能提供用户信息定制,不同用户输入相同的查询条件返回的结果

相同。

不同领域的用户对同一个关键词的搜索返回的检索结果应该

不一样,智能搜索引擎能根据用户专业背景和网页浏览历史检索出

用户需求的信息。

(3)对信息的标引深度不够。

搜索引擎检索的结果往往只提供线

形的网址和包括关键词的网页信息,或者返回过多的无用信息,特

别是对特定文献数据库的检索更显得无能为力[1]。

(4)信息更新能力低。

搜索引擎信息收集和查询是两个分离的过程,缺少有机结合。

网络信息资源呈分布式、动态、快速增长,搜

索引擎的集中化架构不能跟上文档的扩张速度,也就不能有规律地

及时更新数据库,用户检索到的结果可能不是最新信息。

2智能搜索引擎

智能搜索引擎应摆脱传统搜索引擎的局限性,更加智能化,更具主动性,提供多元化的检索方式,为用户提供个性化制定,检索出

满足用户个性需求。

2.1智能搜索引擎主要特征

(1)智能性。

智能化搜索引擎网络蜘蛛通过自主启发式学习选择

最有效的搜索策略和最佳时机,在特定站点或者整个因特网搜集和

整理信息。

智能化搜索引擎可以将多个引擎的搜索结果进行整合,

作为一个整体存放到数据库中。

(2)个性化。

智能化搜索引擎提供个性化制定服务,用户注册基

本信息,如年龄、专业背景、工作方向等,通过分析用户基本信息

及平时浏览网页的记录制定出用户兴趣模块,检索出来的信息和用

户兴趣相关,不同兴趣的用户输入同一个关键词返回的结果可能不同。

(3)多元化。

智能化搜索引擎有多元化的检索方式,提供基于大

众的搜索分析,基于自然语言、关键词、概念和上下文,通过相关

反馈技术检索可选择查询路径。

对关键词进行词意扩展和词意派生,实现准确的分词,从而更加准确地把握用户的搜索需求。

(4)协作性。

智能化搜索引擎能通过各种通信协议和其它智能代

理进行信息交流,并可以相互协调共同完成复杂任务[2]。

2.2智能搜索引擎技术

要实现智能化搜索引擎,当前要特别加强对汉语分词技术、短语识别技术、同义词处理技术、知识库与推理机应有技术和人机对话

智能技术的研究。

智能化搜索引擎对语义的理解主要体现在以下两个方面:一是对用户输入的关键词的理解;二是对网页信息内容的理解。

传统搜索引

擎对关键字的识别是较机械的匹配方式,容易造成信息不准确和丢失。

智能化搜索引擎可对用户输入的关键词进行语义理解,并返回

用户想要的信息。

自然语言语义理解的技术主要有4种:①汉语分

词技术。

中国文化博大精深,语句是由各种词语按照一定的语序组

成的。

汉语对词语的划分相对英文来说复杂得多,汉语词语可以是

由一个字或者多个字组成。

汉语分词技术主要有基于字典、词库匹

配的分词、基于词频度和基于知识理解的分词,通过这些方法准确

把握用户输入关键词的含义;②短语识别技术。

短语是由词语所构成的,是句子中基本的识别单位,在汉语句法分析和语义分析中具有

重大意义。

用户搜索有时需要对关键词加一定的修饰词,例如关键

字为“搜索”,加入修饰词可为“个性化的搜索”,前者就是词语,后者为短语。

需要通过短语识别技术对关键词进行正确的分词,从

而准确理解用户的查询需求;③同义词处理技术。

包括基于词汇字面

相似度算法、基于词素的语义相似度算法以及基于《同义词词林》、《知网》等语义词典的语义相似度算法。

主要依靠人工方式构造同

义词库等辅助词库,利用搜索引擎主动联想技术实现对同义词的联想,准确把握用户关键词语义;④知识库构建技术。

知识库包含各种

词典,词典按其功能不同可分成定义词词典、同名词词典、派生词

词典等,词典按词的确定性又可分成系统词典与用户词典。

这些词

典构成了一个庞大而复杂的知识库。

人机接口智能化主要有以下技术:①人机交互界面技术。

智能化搜索引擎界面具有智能化、多元化、个性化等特点。

其技术主要包

括搜索请求提交技术、搜索结果表现技术、搜索向导技术、搜索行

为分析技术。

其中,搜索行为分析技术是个性化搜索的关键技术,

它通过分析用户的浏览记录和搜索习惯来提高搜索效率;②关联式综

合搜索。

将图片、新闻等各种有关联的信息呈现在同一界面上,用

户搜索时只需查询一次,即可在同一界面得到各种有关联的查询结果。

随着云技术的出现,智能搜索引擎将全球服务器当作一个云系统,从而极大提升从数据库中提取信息速度。

云技术的成熟能够有效提

升搜索引擎的算法速度,提高智能搜索引擎的运行速度[3]。

3结语

智能化搜索引擎技术的发展首先应该解决目前搜索引擎的局限性,然后再添加智能搜索。

智能搜索引擎应该在以下几个方面寻求发展:提供友好的查询界面;多元化的检索方式;强大的自然语言理解技术;

丰富的知识库;考虑按时间、地域顺序输出检索结果,以便用户选择

所需的最新信息;查询结果文摘动态生成;结果自动综合分析和评分[4]。

随着搜索引擎技术的发展,智能化搜索引擎变得更多元化、亲切、个性化,广泛融入进人们的生活,为用户提供更准确、符合需求的

搜索信息。

点击下页还有更多>>>搜索引擎技术论文。