基于Python的文本分类系统开发研究

基于python的中文文本数据集分类算法的设计与实现

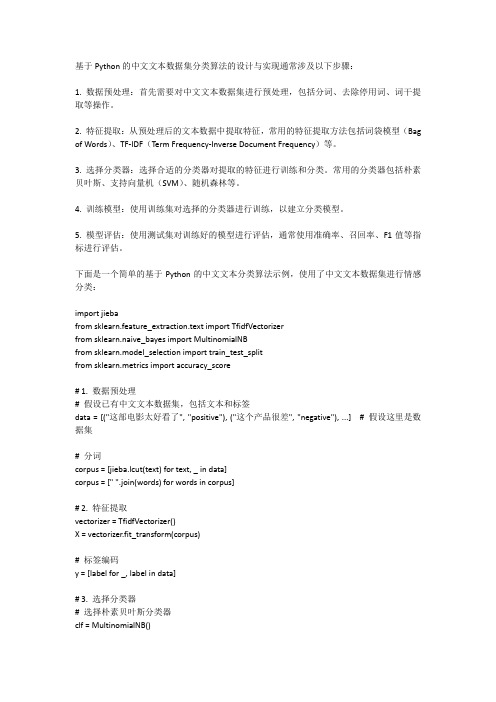

基于Python的中文文本数据集分类算法的设计与实现通常涉及以下步骤:1. 数据预处理:首先需要对中文文本数据集进行预处理,包括分词、去除停用词、词干提取等操作。

2. 特征提取:从预处理后的文本数据中提取特征,常用的特征提取方法包括词袋模型(Bag of Words)、TF-IDF(Term Frequency-Inverse Document Frequency)等。

3. 选择分类器:选择合适的分类器对提取的特征进行训练和分类。

常用的分类器包括朴素贝叶斯、支持向量机(SVM)、随机森林等。

4. 训练模型:使用训练集对选择的分类器进行训练,以建立分类模型。

5. 模型评估:使用测试集对训练好的模型进行评估,通常使用准确率、召回率、F1值等指标进行评估。

下面是一个简单的基于Python的中文文本分类算法示例,使用了中文文本数据集进行情感分类:import jiebafrom sklearn.feature_extraction.text import TfidfVectorizerfrom sklearn.naive_bayes import MultinomialNBfrom sklearn.model_selection import train_test_splitfrom sklearn.metrics import accuracy_score# 1. 数据预处理# 假设已有中文文本数据集,包括文本和标签data = [("这部电影太好看了", "positive"), ("这个产品很差", "negative"), ...] # 假设这里是数据集# 分词corpus = [jieba.lcut(text) for text, _ in data]corpus = [" ".join(words) for words in corpus]# 2. 特征提取vectorizer = TfidfVectorizer()X = vectorizer.fit_transform(corpus)# 标签编码y = [label for _, label in data]# 3. 选择分类器# 选择朴素贝叶斯分类器clf = MultinomialNB()# 4. 训练模型X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)clf.fit(X_train, y_train)# 5. 模型评估y_pred = clf.predict(X_test)accuracy = accuracy_score(y_test, y_pred)print("准确率:", accuracy)在这个示例中,我们使用了jieba库进行分词,sklearn库进行特征提取和朴素贝叶斯分类器的训练。

python 文本分类器的设计与实现 实验指导书

python 文本分类器的设计与实现实验指导书知识文章标题:深度剖析:Python 文本分类器的设计与实现实验指导导语在当今信息爆炸的时代,文本分类技术成为了信息处理领域的重要技术手段之一。

Python 作为一种简单易学、功能强大的编程语言,其在文本分类领域的应用越来越广泛。

本文将从实验指导的角度,深度剖析 Python 文本分类器的设计与实现,帮助读者系统地学习该技术,并在实践中掌握相关的编程和算法知识。

第一部分:Python 文本分类器概述1.1 文本分类器的概念和应用场景在大数据时代,海量的文本数据给人们带来了巨大的信息化挑战。

文本分类技术能够对这些文本进行自动化的分类和归类,从而实现信息的智能化管理和利用。

在新闻分类、情感分析、垃圾邮件过滤等领域,文本分类技术都有着重要的应用价值。

1.2 Python 文本分类器的优势和特点作为一种广泛应用于科学计算和人工智能领域的编程语言,Python 有着丰富的库和工具支持,使其在文本分类领域具有得天独厚的优势。

其简洁、灵活、易于理解和上手的特点,使得 Python 成为了研究者和开发者们喜爱的编程语言之一。

第二部分:Python 文本分类器的算法原理2.1 词袋模型和TF-IDF算法在文本分类中,词袋模型和 TF-IDF 算法是非常常用的基础算法。

词袋模型将文本表示成词汇的集合,忽略其词序和语法。

而 TF-IDF 算法则是通过统计词频和逆向文件频率来衡量词的重要性,从而实现文本特征的提取和权重计算。

2.2 朴素贝叶斯分类算法朴素贝叶斯分类算法是一种基于贝叶斯定理和特征条件独立性假设的概率统计分类方法。

在文本分类领域,朴素贝叶斯算法因其简单快速、效果稳定而被广泛应用。

2.3 文本分类器的设计与实现通过 Python 语言和相关的库和工具,我们可以实现一个简单但有效的文本分类器。

在实验中,我们需要考虑数据的预处理、特征提取、模型训练和评估等关键环节,以及对实验结果的分析和展望。

采用Python实现的文本分类与情感分析系统设计

采用Python实现的文本分类与情感分析系统设计一、引言随着互联网的快速发展,人们在网络上产生的文本数据量越来越庞大,如何从海量的文本数据中提取有用信息成为了一项重要的任务。

文本分类和情感分析作为自然语言处理领域的重要研究方向,可以帮助我们对文本进行自动分类和情感判断,从而更好地理解和利用文本信息。

本文将介绍采用Python实现的文本分类与情感分析系统设计。

二、文本分类1. 文本分类概述文本分类是指根据文本内容的特征将其划分到预定义的类别中。

在实际应用中,文本分类可以帮助我们对新闻、评论、邮件等文本进行分类,从而实现信息检索、情报监控等功能。

2. 文本分类方法常见的文本分类方法包括基于规则的分类、基于统计的分类和基于机器学习的分类。

在设计文本分类系统时,我们可以选择合适的方法来实现不同的需求。

3. Python实现文本分类Python作为一种简洁而强大的编程语言,提供了丰富的库和工具来支持文本分类任务。

我们可以使用NLTK、Scikit-learn等库来实现文本分类功能,并结合各种算法进行模型训练和评估。

三、情感分析1. 情感分析概述情感分析是指通过对文本中表达的情感进行识别和分析,从而判断文本所表达的情感倾向。

情感分析在舆情监控、产品评论分析等领域有着广泛的应用。

2. 情感分析方法情感分析方法主要包括基于词典的方法、基于机器学习的方法和深度学习方法。

不同方法适用于不同场景,我们可以根据具体需求选择合适的方法。

3. Python实现情感分析Python提供了丰富的库和工具来支持情感分析任务,如TextBlob、VADER等库可以帮助我们快速实现情感分析功能。

通过构建情感词典和训练模型,我们可以对文本进行情感倾向判断。

四、系统设计1. 系统架构基于Python实现的文本分类与情感分析系统主要包括数据预处理模块、特征提取模块、模型训练模块和结果展示模块。

通过这些模块协同工作,我们可以构建一个完整的文本处理系统。

使用Python快速实现文本分类

使用Python快速实现文本分类

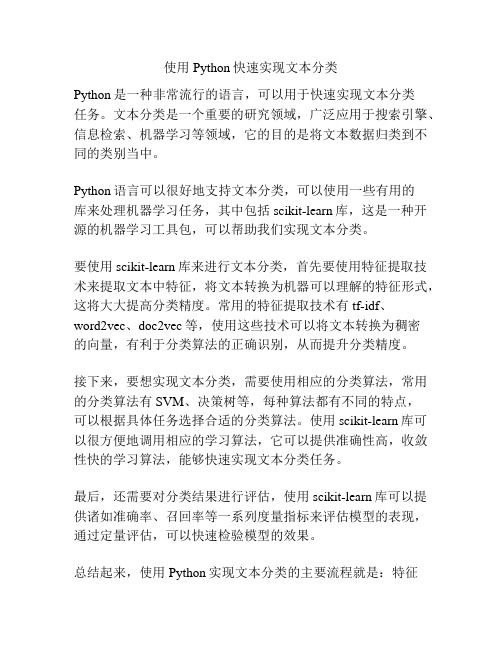

Python是一种非常流行的语言,可以用于快速实现文本分类

任务。

文本分类是一个重要的研究领域,广泛应用于搜索引擎、信息检索、机器学习等领域,它的目的是将文本数据归类到不同的类别当中。

Python语言可以很好地支持文本分类,可以使用一些有用的

库来处理机器学习任务,其中包括scikit-learn库,这是一种开源的机器学习工具包,可以帮助我们实现文本分类。

要使用scikit-learn库来进行文本分类,首先要使用特征提取技术来提取文本中特征,将文本转换为机器可以理解的特征形式,这将大大提高分类精度。

常用的特征提取技术有tf-idf、

word2vec、doc2vec等,使用这些技术可以将文本转换为稠密

的向量,有利于分类算法的正确识别,从而提升分类精度。

接下来,要想实现文本分类,需要使用相应的分类算法,常用的分类算法有SVM、决策树等,每种算法都有不同的特点,

可以根据具体任务选择合适的分类算法。

使用scikit-learn库可以很方便地调用相应的学习算法,它可以提供准确性高,收敛性快的学习算法,能够快速实现文本分类任务。

最后,还需要对分类结果进行评估,使用scikit-learn库可以提供诸如准确率、召回率等一系列度量指标来评估模型的表现,通过定量评估,可以快速检验模型的效果。

总结起来,使用Python实现文本分类的主要流程就是:特征

提取——采用分类算法——评估结果,使用Python语言可以快速实现文本分类,广泛应用于搜索引擎、信息检索、机器学习等领域,能够有效解决复杂任务。

基于Python的文本分类技术的研究及应用

基于Python的文本分类技术的研究及应用近年来,文本分类技术已经成为人工智能领域中备受关注的一个研究方向。

而Python作为一种高效、简洁、易于学习的编程语言,也在文本分类技术的研究和应用中发挥了重要的作用。

在本文中,我将从几个不同的角度讨论基于Python的文本分类技术的研究及应用。

一、文本分类技术的基本原理文本分类技术是一种将文本数据归类的技术,主要应用于垃圾邮件过滤、情感分析、新闻分类、文本归档等领域。

其基本原理是使用有标注的训练数据来训练分类器,然后根据分类器的规则对新的文本进行分类。

文本分类涉及的主要流程包括特征提取、特征选择、分类模型训练和分类模型预测等。

二、Python在文本分类技术中的应用Python作为一种强大的编程语言,具备优秀的文本处理能力,因此在文本分类技术中有着广泛的应用。

在特征提取方面,Python可以使用nltk等常用的自然语言处理库,实现常见的文本预处理方法,如分词、去除停用词、词性标注等。

在特征选择方面,Python可以通过不同的特征选择算法,如信息增益、卡方检验、互信息等来选择最具代表性的特征。

在分类模型训练方面,Python支持多种分类器算法,如朴素贝叶斯、随机森林、支持向量机等。

在分类模型预测方面,Python的sklearn等库也提供了方便快捷的接口,可以轻松实现对新文本的分类预测。

三、Python实现的经典文本分类模型1、朴素贝叶斯分类器模型朴素贝叶斯分类器是文本分类中最经典的模型之一。

Python中的sklearn库提供了朴素贝叶斯分类器的实现,可以使用文本特征向量进行训练,从而得到分类器模型。

2、支持向量机分类器模型支持向量机分类器是一种常用的分类器算法,其使用最优分割超平面来分离不同类别的训练样本。

Python中的sklearn库提供了支持向量机分类器的实现,可以根据不同的参数选择不同的核函数进行训练,得到最优的分类器模型。

3、随机森林分类器模型随机森林分类器是一种基于决策树的分类器算法,它通过随机选择训练样本和特征,构建多个决策树,并采用投票的方式对新样本进行分类。

基于Python的文本分类系统开发研究

c ai e n d a tg so y h n i h o e c an w r so e eo me tae a d e s d A f a s c in wi e d v td t x ii s me a - il isa d a v n a e fP t o n t ewh l h i o k f v lp n r d r s e . n l e t l b e o e e h b t o d t d i o l o v n a e fa p yn yh n i e tca s c t n:h x mp e e n t td a e: i e rKe n lP r mee ee t n wi aa Vi aiai n a tg s o p li g P to n t x ls i a i t e e a ls d mo sr e r L n a r e a a tr S lc i t D t s l t i f o a o h u z o

0 引 言

文 本 分 类 。 研 究 将 一 篇 文 章 判 定 为 预 先 设 定 类 别 问 题 , j

输

预 处 理

入 择

分 类 算 法

测 试 评 估

相关研究成 果广泛应 用于信息 分发 、 邮件过滤 、 网页主题归类 、

供 了 坚 实 的 理论 基 础 ; 本 分 类 还 属 于实 践 性 很 强 的研 究 领 域 , 文

各 环 节 对 文 本 分 类 系统 T P m y开 发 提 出 了 不 同 需 求 : 入 输 环 节需 要灵 活 的 文 本 处 理 以 及 根 据 需 要 进 行 网 页 抓 取 ; 处 理 预

孙 强 李建华 李生红

( 上海 交 通 大 学 电 子 工 程 系 E海 2 0 4 ) 02 0

Python技术与文本分类的结合应用

Python技术与文本分类的结合应用随着互联网和社交媒体的迅速发展,数据量的爆炸式增长给我们带来了前所未有的挑战。

在这个信息过载的时代,如何从大量的文本数据中提取有用的信息成为了一个迫切的问题。

因此,文本分类成为了一项重要的技术。

Python作为一门简洁而功能强大的编程语言,凭借其丰富的库和工具,在文本分类领域发挥了重要作用。

Python提供了各种用于文本处理和自然语言处理(NLP)的库,如NLTK、spaCy和TextBlob等。

这些库提供了各种文本预处理、特征提取、模型训练和评估的功能,使得我们能够更轻松地进行文本分类的工作。

在文本分类中,预处理是必不可少的一步。

Python提供了强大的库来处理文本数据的清洗和规范化,如去除标点符号、停用词和数字等。

此外,Python还可以进行词形还原(lemmatization)和词干提取(stemming),以减少词汇的变体对分类结果的影响。

通过这些预处理步骤,我们可以得到更加干净和规范的文本数据。

接下来,特征提取是文本分类中的关键步骤。

Python提供了各种特征提取的方法,如词袋模型(bag-of-words model)、TF-IDF和Word2Vec等。

词袋模型将文本转化为词语的向量表示,通过统计每个词语在文本中出现的次数或频率来得到向量。

TF-IDF是一种常用的特征提取方法,它考虑了词语在文本集合中的重要性。

Word2Vec则是一种基于神经网络的词嵌入方法,通过学习词语在上下文中的分布来得到向量表示。

这些特征提取方法使得我们能够将文本数据转化为机器学习算法所能理解的数字特征。

在特征提取之后,模型训练成为了下一步。

Python提供了各种机器学习算法库,如scikit-learn和Keras等。

这些库包含了各种分类算法,如朴素贝叶斯、支持向量机(SVM)和深度学习等。

我们可以根据实际需求选择适当的分类算法,然后使用训练数据对模型进行训练。

训练完成后,我们可以使用测试数据对模型进行评估,得到分类的准确率、召回率等指标。

基于Python的文本分类系统开发研究_孙强

3 基于 Python的文本分类系统开发

本节结合文本分 类系统 TmPy开发 过程中的若 干环节 来具 体展示 Python语言开发的快捷与灵活 。

3.1 基于线性核函数的参数选择

线性核函数进行 文本分类需要考虑惩 罚因子 C的寻优 。 C 选择过大时容易受噪 声影响 , 过小时 又容易 产生学 习能力 不足 问题 。 利用 Python的黏合功能可以方便地调 用 LibSVM软 件相 关功能 , 设计算法遍历 C参 数 , 将输 出分 类准 确率 以图 形方 式 直观显示 。 以 LibSVM自带 heart数据为例 , 遍历 log(C)从 -15 到 10的处理结果如图 2所示 , 可见左侧较高准确率处 (C较小 ) 表现稳定 , 比右侧 (C较大 )更为可靠 。

当然 , 如同常用编程语言一样 , Python也有其 不足之 处 , Python在运行性能方 面比 C、Fortran等 编译类 型语 言仍有 较明 显 差距 , 对于运算 密集型应用应 当考虑通 过将耗 费计算 量特别 大 的部分重写为 C模块供 Python调用 , 或 者通过胶水特性直 接调 用 C、Fortran等语言的已有程序来进行弥 补 , Python最大优势 在 于活跃和友好的社区 , 开发遇到问题可以得到及时真诚的反馈 , 进而完善文本分类系统 , 提高其实用性 , 并将其用于网络信息 处 理 、邮 件过滤等应用领域 。

选择合适的比值 ak, N作为 k步进停止标准 。 利用公开的搜狗 语 料库进行对比实验 , 精简版 本共 9个 类别 (N=9), 每个 类别 以 训练样本文件名切分 前 70%文 件为训 练集 , 后 30%为测 试集 , 以两分分词法进行分 词 , 信 息增益 方式选 择 6000 维特征 , 以 正 则化的 TFIDF为特 征权 重方 式 。 以 两个 样本 的余 弦值 为相 似 性度量 , 对比 结果见 表 1, 由 表 1可 知 , 无论是准 确率还 是召 回 率 , 自 适应 kNN方式均有明显提高 。