极限学习机elm代码

elm算法逐句解释

ELM算法,即超限学习机(Extreme Learning Machine)算法,是一种新型的快速学习算法。

以下是对ELM算法的逐句解释:针对的问题是单隐层的前馈神经网络(SLFNs):ELM算法主要解决的是单隐层前馈神经网络的问题。

这种网络的特点是有一个输入层、一个隐层和一个输出层。

输入层到隐层的权重W和偏差B可以随机设定:在ELM算法中,输入层到隐层的权重和偏差可以随机设定,不需要通过训练得到。

隐层激励函数具有无限可微的特征即可:对于隐层的激励函数,只需要具备无限可微的特性,例如常用的radial basis、sine、cosine、exponential等函数。

输出层权重用回归矩阵的伪逆矩阵和训练输出值来确定:输出层的权重是通过计算回归矩阵的伪逆矩阵和训练输出值来确定的。

这里的伪逆矩阵又称广义逆矩阵,即Moore-Penrose generalized inverse matrix。

与其他算法相比,例如很火的SVM来说,ELM算法计算速度也更有优势:与其他流行的机器学习算法相比,如支持向量机(SVM),ELM算法在计算速度上具有优势。

ELM可以随机初始化输入权值和阈值并得到相应的隐节点输出:超限学习机(ELM)可以随机初始化输入权值和阈值,并直接得到对应的隐节点输出。

从神经网络的结构来看,超限学习机是一个简单的单层前向神经网络:从网络结构的角度看,ELM是一个简单的单层前向神经网络,包含输入层、隐含层和输出层。

隐含层有L个神经元,L远远小于N,输出层输出的向量为m维:在ELM的网络结构中,隐含层通常包含较少的神经元(L个),且L远小于输入样本数N。

同时,输出层输出的向量是m维的。

一个有L个隐含层节点的单隐含层神经网络:对于具有L个隐节点的单隐含层神经网络,每个隐节点的输出是根据其对应的输入权值、偏置和激活函数来计算的。

总的来说,ELM算法是一种针对单隐层前馈神经网络的快速学习算法,具有随机初始化输入权值和阈值、计算速度快等特点。

kelm代码解析

kelm代码解析一、KELM代码简介KELM(Kernelized Extreme Learning Machine)是一种基于核方法的极限学习机算法。

与其他机器学习算法类似,KELM旨在通过学习输入特征和输出标签之间的非线性关系,从而实现对未知数据的分类或回归任务。

在我国科研人员的努力下,KELM代码已经得以实现并广泛应用于各个领域。

二、KELM算法原理KELM算法的核心思想是基于核方法的非线性映射。

核方法通过将输入数据映射到高维特征空间,从而使得原本在低维空间中难以解决的分类或回归问题在高维空间中变得容易。

KELM算法在此基础上,利用极限学习机(ELM)的快速学习特性,实现对高维特征空间中的非线性关系进行学习。

三、KELM代码实现详解KELM代码的实现主要包括以下几个步骤:1.数据预处理:对输入数据和标签进行归一化处理,使得数据在同一尺度上进行计算。

2.选择核函数:根据问题需求,选择合适的核函数(如径向基核、Sigmoid核等)。

3.初始化参数:设置极限学习机的输入权重、偏置项和核参数。

4.迭代优化:利用梯度下降法或其他优化算法,不断更新极限学习机的参数,直至收敛。

5.分类或回归预测:利用训练好的极限学习机对未知数据进行分类或回归预测。

四、KELM代码应用场景KELM代码在许多实际应用场景中表现出良好的性能,如文本分类、图像识别、生物信息学和金融风险管理等。

相较于其他算法,KELM具有较快的收敛速度和较高的预测准确性,能够有效地解决非线性分类和回归问题。

五、总结与展望KELM代码作为一种基于核方法的极限学习机算法,在非线性分类和回归领域具有广泛的应用前景。

随着科研人员对KELM算法的不断优化和改进,其在实际应用中的性能也将进一步提升。

ELM

• DELM:

• C=0.01时,训练集准确率=0.983,测试集准确度= 0.8594 • C=1时,训练集准确率=1,测试集准确度= 0.7632 • C=100时,训练集准确率=1,测试集准确度= 0.4030

• 实验表明,DELM可以提供更好的模型,或者模型的泛化性更强

极限学习机理解

王岳青

ELM网络结构

• 输入层:

• n个节点表示样本维度,xj表示第 j个样本

• 隐含层

• 有L个节点,L越大,表达能力越 强 • 节点i与输入层连接权值表示为ai, 与输出层连接权值表示为βi.

• 输出层:

• oj表示样本j的输出,表示m个类 别,

ELM网络结构

ELM理解

ELM理解

ELM理解

• 验证

• 实验设计:使用MNIST数据库,5000个训练样本,1000个测试样本,将 训练集中类别1的数目由486减少到5,其他样本不变 • 分别使用ELM、DELM和DWELM(带样本权值的DELM)

ELM理解

增量式ELM算法

P0 ( H 0T H 0

I 1 ) C

1 T 1 P ( P H H ) 1 0 0 0

此处使用了Sherman-Morrison 求逆定理

T T 1 P 1 P 0 P 0 H1 ( I H1P 0 H1 ) H1P 0

增量式ELM

• 验证:算法是否有效 • 实验设计:

• 使用MNIST-5000训练,首先采用3000个样本训练,并测试,之后分别用 500、500、1000个样本更新模型,更新后测试 • 对比实验,直接使用5000个样本训练后测试

测试 精度

ELM优化的深度自编码分类算法

ELM优化的深度自编码分类算法徐毅;董晴;戴鑫;宋威【期刊名称】《计算机科学与探索》【年(卷),期】2018(012)005【摘要】针对自编码神经网络训练时间长的问题,提出了一种改进的深度自编码神经网络算法.首先利用极限学习机(extreme learning machine,ELM)作为自编码块,构建多层自编码神经网络,以提高分类准确率.采用ELM能避免大量的迭代过程,减少网络训练时间.其次为实现分类,在各输出层中加入标签节点,对实际输出与各样本的期望标签进行比对,使原始的自编码无监督学习转化为监督学习过程,从而在深度学习的过程中实现分类训练.为验证该方法的有效性,在多个UCI数据集中进行广泛的测试.实验结果表明,与其他自编码网络和RBF(radial basis function)神经网络相比,该方法取得了良好的分类准确率,并且有效提高了训练速度.%For the autoencoder neural networks having long training time, this paper puts forward a kind of im-proved deep autoencoder neural network.Firstly,this paper uses extreme learning machine(ELM)as an autoencoder block and constructs a multilayer autoencoder neural network, to improve the classification accuracy. Using ELM can avoid the iterative process and reduce the training time of network.Secondly,this paper adds the label tag in the output layer nodes,and expects the actual output with the sample tag,making the unsupervised learning to be a su-pervised learning and achieving the classification training in the process of deep learning.To verify the validity of the proposed method,this paper tests in the multipleUCI datasets.The experimental results show that the accuracy is good and the training speed is improved, compared with other autoencoder networks and radial basis function (RBF)neural network.【总页数】8页(P820-827)【作者】徐毅;董晴;戴鑫;宋威【作者单位】江南大学物联网工程学院,江苏无锡214122;江南大学物联网工程学院,江苏无锡214122;江南大学物联网工程学院,江苏无锡214122;江南大学物联网工程学院,江苏无锡214122【正文语种】中文【中图分类】TP183【相关文献】1.基于粒子群优化的深度神经网络分类算法 [J], 董晴;宋威2.基于动态等级PSO-ELMAN的乙烯裂解深度模型及其优化控制 [J], 陈宇颖;范启富3.基于深度学习的高分辨率影像样本构建与分类算法优化 [J], 郭功举;岳照溪;潘琛4.基于鲸鱼优化和深度学习的不平衡大数据分类算法 [J], 孙二华;胡云冰5.基于多特征融合与CELM的场景分类算法 [J], 王光;陶燕;沈慧芳;周树东因版权原因,仅展示原文概要,查看原文内容请购买。

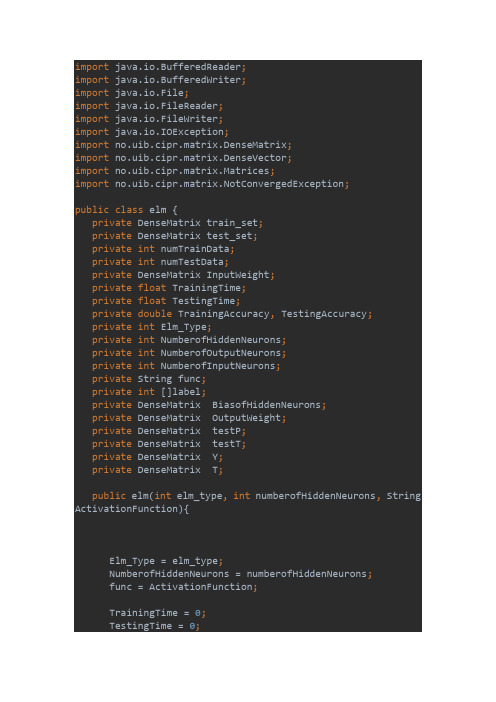

ELM极限学习机算法源码

import java.io.BufferedReader;import java.io.BufferedWriter;import java.io.File;import java.io.FileReader;import java.io.FileWriter;import java.io.IOException;import no.uib.cipr.matrix.DenseMatrix;import no.uib.cipr.matrix.DenseVector;import no.uib.cipr.matrix.Matrices;import no.uib.cipr.matrix.NotConvergedException;public class elm {private DenseMatrix train_set;private DenseMatrix test_set;private int numTrainData;private int numTestData;private DenseMatrix InputWeight;private float TrainingTime;private float TestingTime;private double TrainingAccuracy, TestingAccuracy;private int Elm_Type;private int NumberofHiddenNeurons;private int NumberofOutputNeurons;private int NumberofInputNeurons;private String func;private int []label;private DenseMatrix BiasofHiddenNeurons;private DenseMatrix OutputWeight;private DenseMatrix testP;private DenseMatrix testT;private DenseMatrix Y;private DenseMatrix T;public elm(int elm_type, int numberofHiddenNeurons, String ActivationFunction){Elm_Type = elm_type;NumberofHiddenNeurons = numberofHiddenNeurons;func = ActivationFunction;TrainingTime = 0;TestingTime = 0;TrainingAccuracy= 0;TestingAccuracy = 0;NumberofOutputNeurons = 1;}public elm(){}public DenseMatrix loadmatrix(String filename) throws IOException{BufferedReader reader = new BufferedReader(new FileReader(new File(filename)));String firstlineString = reader.readLine();String []strings = firstlineString.split(" ");int m = Integer.parseInt(strings[0]);int n = Integer.parseInt(strings[1]);if(strings.length > 2)NumberofOutputNeurons = Integer.parseInt(strings[2]);DenseMatrix matrix = new DenseMatrix(m, n);firstlineString = reader.readLine();int i = 0;while (i<m) {String []datatrings = firstlineString.split(" ");for (int j = 0; j < n; j++) {matrix.set(i, j,Double.parseDouble(datatrings[j]));}i++;firstlineString = reader.readLine();}return matrix;}public void train(String TrainingData_File) throws NotConvergedException{try {train_set = loadmatrix(TrainingData_File);} catch (IOException e) {e.printStackTrace();}train();}public void train(double [][]traindata) throws NotConvergedException{//classification require a the number of classtrain_set = new DenseMatrix(traindata);int m = train_set.numRows();if(Elm_Type == 1){double maxtag = traindata[0][0];for (int i = 0; i < m; i++) {if(traindata[i][0] > maxtag)maxtag = traindata[i][0];}NumberofOutputNeurons = (int)maxtag+1;}train();}private void train() throws NotConvergedException{numTrainData = train_set.numRows();NumberofInputNeurons = train_set.numColumns() - 1;InputWeight = (DenseMatrix)Matrices.random(NumberofHiddenNeurons, NumberofInputNeurons);DenseMatrix transT = new DenseMatrix(numTrainData, 1);DenseMatrix transP = new DenseMatrix(numTrainData, NumberofInputNeurons);for (int i = 0; i < numTrainData; i++) {transT.set(i, 0, train_set.get(i, 0));for (int j = 1; j <= NumberofInputNeurons; j++)transP.set(i, j-1, train_set.get(i, j));}T = new DenseMatrix(1,numTrainData);DenseMatrix P = newDenseMatrix(NumberofInputNeurons,numTrainData);transT.transpose(T);transP.transpose(P);if(Elm_Type != 0) //CLASSIFIER{label = new int[NumberofOutputNeurons];for (int i = 0; i < NumberofOutputNeurons; i++) {label[i] = i; }DenseMatrix tempT = newDenseMatrix(NumberofOutputNeurons,numTrainData);tempT.zero();for (int i = 0; i < numTrainData; i++){int j = 0;for (j = 0; j < NumberofOutputNeurons; j++){if (label[j] == T.get(0, i))break;}tempT.set(j, i, 1);}T = newDenseMatrix(NumberofOutputNeurons,numTrainData); //T=temp_T*2-1;for (int i = 0; i < NumberofOutputNeurons; i++){for (int j = 0; j < numTrainData; j++)T.set(i, j, tempT.get(i, j)*2-1);}transT = newDenseMatrix(numTrainData,NumberofOutputNeurons);T.transpose(transT);}long start_time_train = System.currentTimeMillis();BiasofHiddenNeurons = (DenseMatrix)Matrices.random(NumberofHiddenNeurons, 1);DenseMatrix tempH = newDenseMatrix(NumberofHiddenNeurons, numTrainData);InputWeight.mult(P, tempH);//DenseMatrix ind = new DenseMatrix(1, numTrainData);DenseMatrix BiasMatrix = newDenseMatrix(NumberofHiddenNeurons, numTrainData);for (int j = 0; j < numTrainData; j++) {for (int i = 0; i < NumberofHiddenNeurons; i++) {BiasMatrix.set(i, j, BiasofHiddenNeurons.get(i, 0));}}tempH.add(BiasMatrix);DenseMatrix H = new DenseMatrix(NumberofHiddenNeurons, numTrainData);if(func.startsWith("sig")){for (int j = 0; j < NumberofHiddenNeurons; j++) { for (int i = 0; i < numTrainData; i++) {double temp = tempH.get(j, i);temp = 1.0f/ (1 + Math.exp(-temp));H.set(j, i, temp);}}}else if(func.startsWith("sin")){for (int j = 0; j < NumberofHiddenNeurons; j++) { for (int i = 0; i < numTrainData; i++) {double temp = tempH.get(j, i);temp = Math.sin(temp);H.set(j, i, temp);}}}else if(func.startsWith("hardlim")){}else if(func.startsWith("tribas")){}else if(func.startsWith("radbas")){}DenseMatrix Ht = newDenseMatrix(numTrainData,NumberofHiddenNeurons);H.transpose(Ht);Inverse invers = new Inverse(Ht);DenseMatrix pinvHt = invers.getMPInverse();OutputWeight = new DenseMatrix(NumberofHiddenNeurons, NumberofOutputNeurons);pinvHt.mult(transT, OutputWeight);long end_time_train = System.currentTimeMillis();TrainingTime = (end_time_train -start_time_train)* 1.0f/1000;DenseMatrix Yt = newDenseMatrix(numTrainData,NumberofOutputNeurons);Ht.mult(OutputWeight,Yt);Y = new DenseMatrix(NumberofOutputNeurons,numTrainData);Yt.transpose(Y);if(Elm_Type == 0){double MSE = 0;for (int i = 0; i < numTrainData; i++) {MSE += (Yt.get(i, 0) - transT.get(i, 0))*(Yt.get(i, 0) - transT.get(i, 0));}TrainingAccuracy = Math.sqrt(MSE/numTrainData);}else if(Elm_Type == 1){float MissClassificationRate_Training=0;for (int i = 0; i < numTrainData; i++) {double maxtag1 = Y.get(0, i);int tag1 = 0;double maxtag2 = T.get(0, i);int tag2 = 0;for (int j = 1; j < NumberofOutputNeurons; j++) {if(Y.get(j, i) > maxtag1){maxtag1 = Y.get(j, i);tag1 = j;}if(T.get(j, i) > maxtag2){maxtag2 = T.get(j, i);tag2 = j;}}if(tag1 != tag2)MissClassificationRate_Training ++;}TrainingAccuracy = 1 -MissClassificationRate_Training* 1.0f/numTrainData;}}public void test(String TestingData_File){try {test_set = loadmatrix(TestingData_File);} catch (IOException e) {// TODO Auto-generated catch blocke.printStackTrace();}numTestData = test_set.numRows();DenseMatrix ttestT = new DenseMatrix(numTestData, 1);DenseMatrix ttestP = new DenseMatrix(numTestData, NumberofInputNeurons);for (int i = 0; i < numTestData; i++) {ttestT.set(i, 0, test_set.get(i, 0));for (int j = 1; j <= NumberofInputNeurons; j++)ttestP.set(i, j-1, test_set.get(i, j));}testT = new DenseMatrix(1,numTestData);testP = newDenseMatrix(NumberofInputNeurons,numTestData);ttestT.transpose(testT);ttestP.transpose(testP);long start_time_test = System.currentTimeMillis();DenseMatrix tempH_test = newDenseMatrix(NumberofHiddenNeurons, numTestData);InputWeight.mult(testP, tempH_test);DenseMatrix BiasMatrix2 = newDenseMatrix(NumberofHiddenNeurons, numTestData);for (int j = 0; j < numTestData; j++) {for (int i = 0; i < NumberofHiddenNeurons; i++) {BiasMatrix2.set(i, j, BiasofHiddenNeurons.get(i, 0));}tempH_test.add(BiasMatrix2);DenseMatrix H_test = newDenseMatrix(NumberofHiddenNeurons, numTestData);if(func.startsWith("sig")){for (int j = 0; j < NumberofHiddenNeurons; j++) { for (int i = 0; i < numTestData; i++) {double temp = tempH_test.get(j, i);temp = 1.0f/ (1 + Math.exp(-temp));H_test.set(j, i, temp);}}}else if(func.startsWith("sin")){for (int j = 0; j < NumberofHiddenNeurons; j++) { for (int i = 0; i < numTestData; i++) {double temp = tempH_test.get(j, i);temp = Math.sin(temp);H_test.set(j, i, temp);}}}else if(func.startsWith("hardlim")){}else if(func.startsWith("tribas")){}else if(func.startsWith("radbas")){}DenseMatrix transH_test = newDenseMatrix(numTestData,NumberofHiddenNeurons);H_test.transpose(transH_test);DenseMatrix Yout = newDenseMatrix(numTestData,NumberofOutputNeurons);transH_test.mult(OutputWeight,Yout);DenseMatrix testY = newDenseMatrix(NumberofOutputNeurons,numTestData);Yout.transpose(testY);long end_time_test = System.currentTimeMillis();TestingTime = (end_time_test -start_time_test)* 1.0f/1000;//REGRESSIONif(Elm_Type == 0){double MSE = 0;for (int i = 0; i < numTestData; i++) {MSE += (Yout.get(i, 0) -testT.get(0,i))*(Yout.get(i, 0) - testT.get(0,i));}TestingAccuracy = Math.sqrt(MSE/numTestData);}//CLASSIFIERelse if(Elm_Type == 1){DenseMatrix temptestT = newDenseMatrix(NumberofOutputNeurons,numTestData);for (int i = 0; i < numTestData; i++){int j = 0;for (j = 0; j < NumberofOutputNeurons; j++){if (label[j] == testT.get(0, i))break;}temptestT.set(j, i, 1);}testT = newDenseMatrix(NumberofOutputNeurons,numTestData);for (int i = 0; i < NumberofOutputNeurons; i++){for (int j = 0; j < numTestData; j++)testT.set(i, j, temptestT.get(i, j)*2-1);}float MissClassificationRate_Testing=0;for (int i = 0; i < numTestData; i++) {double maxtag1 = testY.get(0, i);int tag1 = 0;double maxtag2 = testT.get(0, i);int tag2 = 0;for (int j = 1; j < NumberofOutputNeurons; j++) { if(testY.get(j, i) > maxtag1){maxtag1 = testY.get(j, i);tag1 = j;}if(testT.get(j, i) > maxtag2){maxtag2 = testT.get(j, i);tag2 = j;}}if(tag1 != tag2)MissClassificationRate_Testing ++;}TestingAccuracy = 1 -MissClassificationRate_Testing* 1.0f/numTestData;}}public double[] testOut(double[][] inpt){test_set = new DenseMatrix(inpt);return testOut();}public double[] testOut(double[] inpt){test_set = new DenseMatrix(new DenseVector(inpt));return testOut();}//Output numTestData*NumberofOutputNeuronsprivate double[] testOut(){numTestData = test_set.numRows();NumberofInputNeurons = test_set.numColumns()-1;DenseMatrix ttestT = new DenseMatrix(numTestData, 1);DenseMatrix ttestP = new DenseMatrix(numTestData, NumberofInputNeurons);for (int i = 0; i < numTestData; i++) {ttestT.set(i, 0, test_set.get(i, 0));for (int j = 1; j <= NumberofInputNeurons; j++)ttestP.set(i, j-1, test_set.get(i, j));}testT = new DenseMatrix(1,numTestData);testP = newDenseMatrix(NumberofInputNeurons,numTestData);ttestT.transpose(testT);ttestP.transpose(testP);DenseMatrix tempH_test = newDenseMatrix(NumberofHiddenNeurons, numTestData);InputWeight.mult(testP, tempH_test);DenseMatrix BiasMatrix2 = newDenseMatrix(NumberofHiddenNeurons, numTestData);for (int j = 0; j < numTestData; j++) {for (int i = 0; i < NumberofHiddenNeurons; i++) {BiasMatrix2.set(i, j, BiasofHiddenNeurons.get(i, 0));}}tempH_test.add(BiasMatrix2);DenseMatrix H_test = newDenseMatrix(NumberofHiddenNeurons, numTestData);if(func.startsWith("sig")){for (int j = 0; j < NumberofHiddenNeurons; j++) { for (int i = 0; i < numTestData; i++) {double temp = tempH_test.get(j, i);temp = 1.0f/ (1 + Math.exp(-temp));H_test.set(j, i, temp);}}}else if(func.startsWith("sin")){for (int j = 0; j < NumberofHiddenNeurons; j++) { for (int i = 0; i < numTestData; i++) {double temp = tempH_test.get(j, i);temp = Math.sin(temp);H_test.set(j, i, temp);}}}else if(func.startsWith("hardlim")){}else if(func.startsWith("tribas")){}else if(func.startsWith("radbas")){}DenseMatrix transH_test = newDenseMatrix(numTestData,NumberofHiddenNeurons);H_test.transpose(transH_test);DenseMatrix Yout = newDenseMatrix(numTestData,NumberofOutputNeurons);transH_test.mult(OutputWeight,Yout);double[] result = new double[numTestData];if(Elm_Type == 0){for (int i = 0; i < numTestData; i++)result[i] = Yout.get(i, 0);}else if(Elm_Type == 1){for (int i = 0; i < numTestData; i++) {int tagmax = 0;double tagvalue = Yout.get(i, 0);for (int j = 1; j < NumberofOutputNeurons; j++) {if(Yout.get(i, j) > tagvalue){tagvalue = Yout.get(i, j);tagmax = j;}}result[i] = tagmax;}}return result;}public float getTrainingTime() {return TrainingTime;}public double getTrainingAccuracy() {return TrainingAccuracy;public float getTestingTime() {return TestingTime;}public double getTestingAccuracy() {return TestingAccuracy;}public int getNumberofInputNeurons() {return NumberofInputNeurons;}public int getNumberofHiddenNeurons() {return NumberofHiddenNeurons;}public int getNumberofOutputNeurons() {return NumberofOutputNeurons;}public DenseMatrix getInputWeight() {return InputWeight;}public DenseMatrix getBiasofHiddenNeurons() {return BiasofHiddenNeurons;}public DenseMatrix getOutputWeight() {return OutputWeight;}//for predicting a data file based on a trained model.public void testgetoutput(String filename) throws IOException {try {test_set = loadmatrix(filename);} catch (IOException e) {// TODO Auto-generated catch blocke.printStackTrace();}numTestData = test_set.numRows();NumberofInputNeurons = test_set.numColumns() - 1;double rsum = 0;double []actual = new double[numTestData];double [][]data = newdouble[numTestData][NumberofInputNeurons];for (int i = 0; i < numTestData; i++) {actual[i] = test_set.get(i, 0);for (int j = 0; j < NumberofInputNeurons; j++) data[i][j] = test_set.get(i, j+1);}double[] output = testOut(data);BufferedWriter writer = new BufferedWriter(new FileWriter(new File("Output")));for (int i = 0; i < numTestData; i++) {writer.write(String.valueOf(output[i]));writer.newLine();if(Elm_Type == 0){rsum += (output[i] - actual[i])*(output[i] - actual[i]);}if(Elm_Type == 1){if(output[i] == actual[i])rsum ++;}}writer.flush();writer.close();if(Elm_Type == 0)System.out.println("Regression GetOutPut RMSE: "+Math.sqrt(rsum* 1.0f/numTestData));else if(Elm_Type == 1)System.out.println("Classfy GetOutPut Right:"+rsum*1.0f/numTestData);}}。

ELM极限学习机算法源码

ELM极限学习机算法源码一、极限学习机(ELM)算法概述极限学习机(ELM)是一种机器学习方法,由乔明·埃德尔霍尔斯(Gao Ming)博士发明。

该方法利用随机权重的网络结构,能够更快速的训练深层神经网络,并减少需要调整的参数。

具体来说,ELM可以用于定义输入和输出之间的非线性回归/分类函数,以及进行数据挖掘和逻辑回归,实现优化和计算机视觉等方面的研究。

二、ELM算法源码实现1.导入相关库并定义函数import numpy as npimport matplotlib.pyplot as plt#定义sigmoid函数def sigmoid(x):return 1 / (1 + np.exp(-x))2.读取数据并处理:#读取数据x = np.loadtxt('data.txt', delimiter=',', dtype='float32', skiprows=1)X=x[:,:-1]y = x[:, -1][:, np.newaxis]#添加偏置项,让数据集变为更合适的格式X = np.hstack([np.ones_like(X, dtype='float32'), X]) 3.训练模型#初始化ELM网络参数input_nodes = X.shape[1]hidden_nodes = 6output_nodes = 1#随机生成权重和偏置W = np.random.normal(size=(input_nodes, hidden_nodes)) b = np.zeros((1, hidden_nodes))# 将输入数据和随机生成的权重输入sigmoid函数H = sigmoid(np.dot(X, W) + b)#计算输出层参数beta = np.dot(np.linalg.pinv(H), y)4.预测#计算预测值y_pred = np.dot(H, beta)#画出预测结果和样本数据plt.scatter(X[:,1], y, label='Real data')plt.plot(X[:,1], y_pred, label='Predicted data') plt.title('ELM')plt.xlabel('Input')plt.ylabel('Output')plt.legenplt.。

一种修正的模糊极限学习机

计算机应用与软件

Computer Applications and Software

Vol.34 No.5 May 2017

一种修正的模糊极限学习机

李丽娜闫德勤楚永贺

(辽宁师范大学计算机与信息技术学院辽宁大连116081) 摘 要 极限学习机 E L M (E x tre m e

s c h o la rs ’a tte n tio n w ith its s im p le th e o ry and easy im p le m e n ta tio n . R e c e n tly , researchers on noise and o u tlie r data have proposed re le va n t research a lg o rith m s . H o w e v e r , how to use ELM b e tte r in c la s s ific a tio

(M F E L M )

fo llo w s

based on the te c h n ic a l

: MF

good p e rfo rm an ce o f E L M processing n o rm a l data c la s s ific a tio n w h en d e a lin g w ith the c la s s ific a tio n o f noise and o u tlie r d a ta ; the a c tiv a tio n o r k e r e l fu n c tio n s fo r the E L M also a p p ly to th e M F E L M m o d e l ; M F E L M can be exte nde d to co st se n sitive le a rn in g by assign ing d iffe re n t m em b ersh ips to each data sam ple a c c o rd in g to d iffe re n t re q u ire m e n ts . the

ELM极限学习机算法源码

矿产资源开发利用方案编写内容要求及审查大纲

矿产资源开发利用方案编写内容要求及《矿产资源开发利用方案》审查大纲一、概述

㈠矿区位置、隶属关系和企业性质。

如为改扩建矿山, 应说明矿山现状、

特点及存在的主要问题。

㈡编制依据

(1简述项目前期工作进展情况及与有关方面对项目的意向性协议情况。

(2 列出开发利用方案编制所依据的主要基础性资料的名称。

如经储量管理部门认定的矿区地质勘探报告、选矿试验报告、加工利用试验报告、工程地质初评资料、矿区水文资料和供水资料等。

对改、扩建矿山应有生产实际资料, 如矿山总平面现状图、矿床开拓系统图、采场现状图和主要采选设备清单等。

二、矿产品需求现状和预测

㈠该矿产在国内需求情况和市场供应情况

1、矿产品现状及加工利用趋向。

2、国内近、远期的需求量及主要销向预测。

㈡产品价格分析

1、国内矿产品价格现状。

2、矿产品价格稳定性及变化趋势。

三、矿产资源概况

㈠矿区总体概况

1、矿区总体规划情况。

2、矿区矿产资源概况。

3、该设计与矿区总体开发的关系。

㈡该设计项目的资源概况

1、矿床地质及构造特征。

2、矿床开采技术条件及水文地质条件。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

矿产资源开发利用方案编写内容要求及审查大纲

矿产资源开发利用方案编写内容要求及《矿产资源开发利用方案》审查大纲一、概述

㈠矿区位置、隶属关系和企业性质。

如为改扩建矿山, 应说明矿山现状、

特点及存在的主要问题。

㈡编制依据

(1简述项目前期工作进展情况及与有关方面对项目的意向性协议情况。

(2 列出开发利用方案编制所依据的主要基础性资料的名称。

如经储量管理部门认定的矿区地质勘探报告、选矿试验报告、加工利用试验报告、工程地质初评资料、矿区水文资料和供水资料等。

对改、扩建矿山应有生产实际资料, 如矿山总平面现状图、矿床开拓系统图、采场现状图和主要采选设备清单等。

二、矿产品需求现状和预测

㈠该矿产在国内需求情况和市场供应情况

1、矿产品现状及加工利用趋向。

2、国内近、远期的需求量及主要销向预测。

㈡产品价格分析

1、国内矿产品价格现状。

2、矿产品价格稳定性及变化趋势。

三、矿产资源概况

㈠矿区总体概况

1、矿区总体规划情况。

2、矿区矿产资源概况。

3、该设计与矿区总体开发的关系。

㈡该设计项目的资源概况

1、矿床地质及构造特征。

2、矿床开采技术条件及水文地质条件。