linux集群配置文档

Websphere for Linux集群安装和配置

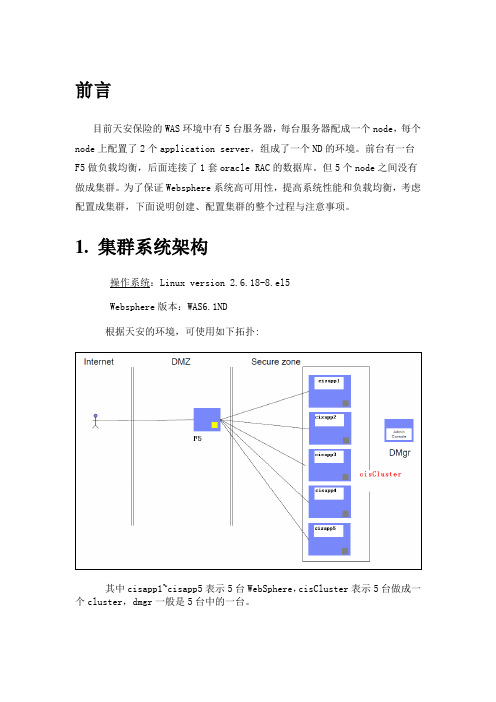

前言目前天安保险的WAS环境中有5台服务器,每台服务器配成一个node,每个node上配置了2个application server,组成了一个ND的环境。

前台有一台F5做负载均衡,后面连接了1套oracle RAC的数据库。

但5个node之间没有做成集群。

为了保证Websphere系统高可用性,提高系统性能和负载均衡,考虑配置成集群,下面说明创建、配置集群的整个过程与注意事项。

1. 集群系统架构操作系统:Linux version 2.6.18-8.el5Websphere版本:WAS6.1ND根据天安的环境,可使用如下拓扑:其中cisapp1~cisapp5表示5台WebSphere,cisCluster表示5台做成一个cluster,dmgr一般是5台中的一台。

2. 创建集群(含session复制)(截图为我本机测试截图,只是示意图,与天安保险的节点名和集群名不符)在DMGR控制台中,选择集群,然后新建。

注意:先创建一个空的集群,然后我们再向该集群中添加成员即可。

这里还要注意勾选“配置HTTP会话内存到内存复制”,这样就能使session 在集群内共享,比如用户登录,加入被集群分配给node1来处理,用户的登录信息就会被保存在session中,如果此时node1宕机了,用户就会被分配到其他节点来处理而不会要求重新登录。

如果在创建集群时没有勾选此选项,也可按如下方式操作:配置会话复制服务器 --> 应用程序服务器 --> 选择集群成员 --> 容器设置:会话管理--> 其他属性:分布式环境设置 --> 确认分布式会话选择的是内存到内存复制,其他属性:定制调整参数 -->调整级别:低(故障转移优化)写频率 servlet服务结束写内容所有会话调度会话清除:false对集群每个成员重复以上操作(建议在故障转移和系统性能之间取折中。

另:会话复制还有一种数据库方式,由于对性能影响较大,不推荐使用)添加集群如下。

linux下weblogic92集群安装部署-图文

linux下weblogic92集群安装部署-图文第一章JDK安装1.1安装JDK1.5#chmodu+某./jdk-1_5_0_15-linu某-amd64-rpm.bin#./jdk-1_5_0_15-linu某-amd64-rpm.bin#rpm-ivhjdk-1_5_0_15-linu某-amd64.rpm安装过程中会出现如下界面Preparing...###########################################[100% ]jdk###########################################[100%] JDK将自动安装到/ur/java/jdk1.5.0_15目录下,安装完成。

1.2配置环境变量(1)打开/etc/profile文件#vi/etc/profile进入vi以后,按i键,输入内容,最后按一下ESC,再按冒号(:),输入wq就保存退出在文件中加入:e某portJAVA_HOME=/ur/java/jdk1.5.0_15e某portCLASSPATH=.:$JAVA_HOME/lib/dt.jar:$JAVA_HOME/lib/tool.jare 某portPATH=$JAVA_HOME/bin:$PATH一定要注意,如果path配错了,造成的后果是毁灭性的,系统将崩溃。

(2)注销或重启系统后,输入如下命令,检查java环境变量是否配置成功Java-verion//出现正确的版本信息,则配置成功第二章Weblogic9.2群集安装准备2.1预备知识Weblogic中Domain和Server的关系DomainDomain是WebLogicServer实例的基本管理单元。

所谓Domain就是,由配置为AdminitratorServer的WebLogicServer实例管理的逻辑单元,这个单元是有所有相关资源的集合。

ServerServer是一个相对独立的,为实现某些特定功能而结合在一起的单元。

Linux环境resin部署集群系统手册OA

resin集群部署手册(linux环境下)目录1、配置resin (3)1.1配置startresin.sh (3)1.2启动和关闭resin (3)2、ecology在resin集群上需要共享的资源文件 (4)2.1.资源共享设置 (4)2.2、应用缓存同步设置 (6)四、升级集群补丁包 (6)五、测试故障切换 (6)1、配置resin前期的文件拷贝工作就不写了,直接配置resin1.1配置startresin.sh将启动脚本中添加以下标黄的文字,对于标绿的规则是如果有ABC三台应用,则A机器写BC的ecology访问地址,中间以逗号分隔,如192.168.52.10:8080,192.168.12:8080实例:配置192.168.52.10的/opt/Resin/bin/startresin.sh,内容如下:ulimit -n 65535export LANG=zh_CN.GBKnohup /opt/Resin/bin/httpd.sh -DsimpleMode=true -Dinitial_hosts=192.168.52.11:8080 start配置192.168.52.11的/opt/Resin/bin/startresin.sh,内容如下:ulimit -n 65535export LANG=zh_CN.GBKnohup /opt/Resin/bin/httpd.sh -DsimpleMode=true -Dinitial_hosts=192.168.52.10:8080 start1.2启动和关闭resinResin分别安装在192.168.52.10,192.168.52.11,分别以root身份登入系统。

进入/opt/Resin/bin。

启动:[root@OA-APP bin]# ./startresin.sh停止:[root@OA-APP bin]# ./stopresin.sh2、ecology在resin集群上需要共享的资源文件2.1.资源共享设置配置文件服务器的对外共享:步骤1:vi /etc/exports(按i,才能输入)输入需要共享的文件夹(注意空隙使用tab),格式如下:/data 192.168.52.13(rw,sync,no_root_squash)/data 192.168.52.14(rw,sync,no_root_squash)注:这句话的意思是将/data文件夹共享给192.168.52.13和14服务器,也可以用*号代替,如:/data *(rw,sync,no_root_squash)意思是将/data文件夹共享到所有和这个服务器网络通的机器步骤2:重新exportexportfs –rv步骤3:重启nfs服务service nfs restartservice portmap restart(针对rhel5)service rpcbind restart(针对rhel6以上版本)vi /etc/rc.local在文件末尾加上service nfs startservice portmap start(针对rhel5)service rpcbind start(针对rhel6以上版本)将共享出来的文件夹挂载到应用服务器上:步骤4:在需要共享节点挂载共享文件到对于目录(除主控节点外)mount -t nfs 192.168.52.10:/data /data步骤5:挂载完成后,需要将资源文件链接到ecology目录下对应文件1、将ecology以下目录拷贝到/data目录下email filesystem images images_face images_frame LoginTemplateFile messager m_img others page wui2、将ecology\WEB-INF下的service目录/data目录下备份mv images images.bakmv images_face images_face.bakmv images_frame images_frame.bakmv LoginTemplateFile LoginTemplateFile.bakmv m_img m_img.bakmv filesystem filesystem.bakmv page page.bakmv messager messager.bakmv email email.bakmv wui wui.bakmv others others.bakcd WEB-INFmv service service.bak链接ln -sf /data/filesystem /opt/ecologyln -sf /data/images /opt/ecologyln -sf /data/images_face /opt/ecologyln -sf /data/images_frame /opt/ecologyln -sf /data/LoginTemplateFile /opt/ecologyln -sf /data/messager /opt/ecologyln -sf /data/m_img /opt/ecologyln -sf /data/page /opt/ecologyln -sf /data/wui /opt/ecologyln -sf /data/email /opt/ecologyln -sf /data/others /opt/ecologyln -sf /data/service /opt/ecology/WEB-INF/如果是E8系统还需要做:将ecology/WEB-INF/hrmsettings.xml 做软连接mv hrmsettings.xml hrmsettings.xml.bakln -sf /data/hrmsettings.xml /opt/ecology/WEB-INF/hrmsettings.xml其他需要做软连接的访问域名/system/SystemSetEdit.jsp?_fromURL=52得到的结果类似这种,可以查看客户设置的附件目录然后针对这个目录做一下软连接步骤6:在需要共享节点随机启动时,挂载共享文件(除主控节点外)(注意空隙使用tab) vi /etc/fstab192.168.52.10:/data /data nfs defaults 0 02.2、应用缓存同步设置步骤1、编辑/etc/hosts,清空原有127默认配置,将集群各节点ip地址加入到hosts中(重要!!!)步骤2、修改/WEB-INF/prop/weaver.properties文件,加入以下内容:MainControlIP = 主节点ip(集群中任意一个节点,但有且只能有一个)ip = 本机ipbroadcast=231.12.21.132步骤3、为保证服务器间访问畅通,最好关闭linux自带防火墙。

linux下weblogic集群部署

Weblogic集群安装手册(一)部署计划:10.2.66.88:6060 主控domain AdminServer10.2.66.88:7001 应用domain slave110.2.66.85:7001应用domain slave2(二)创建主控域运行$weblogic_home/common/bin/config.sh1、默认创建新的域2、选择默认模版3、默认选择创建基本的域4、调整域的名称,直接名称5、默认域创建目录6、设置weblogic用户和密码7、选择weblogic的启动模式,我这里选择的是生产模式8、选择jdk9、选择安装集群10、添加托管节点11、配置集群因为集群是通过广播(有unicast和multicast两种)来同步集群中的节点,并且把每个节点中的session通过这个广播地址来进行复制和同步,即主控域不断的时时刻刻的会和它下面的子节点间保持通讯、经常去询问各个子节点的。

集群信息传送模式:有unitcast与multicast两种,在11G版本前都是multicast10G后开始支持unicast 协议。

如果指定了multicast,就必须指定一个“多点传送地址”。

以下采用multicast方式,地址采用默认的,端口使用6060:12、关联集群与节点13、由于我们采取IP形式,不在这里指定计算机名,直接下一步,并创建域(三)创建节点(分别在10.2.66.88、10.2.66.85创建)1 – 3、和创建主控域一样4、调整域的名称为domain_70015 - 8、和创建主控域一样9、创建一般的应用域10、修改域名称和端口相关信息,并创建域(四)启动集群1、进入域目录启动主控weblogic输入(第6步设置的用户名密码) 用户名weblogic,密码weblogic1232、设置免密码登录,在AdmiServer下面创建security文件夹,里边包含boot.properties文件。

OracleBIEE12cLinuxHA集群安装配置手册

Oracle BIEE 12c Linux系统集群安装配置文档仇辉2017年2月1文档控制编制审核发布目录1文档控制 (2)2安装环境准备 (4)2.1BIEE12C H IGH A VAILABILITY A RCHITECTURE (4)2.2此次安装环境规划 (5)2.3操作系统 (5)2.4创建组和用户 (5)2.5共享文件夹划分 (5)2.6在节点1和节点2上进行NFS配置 (5)2.7JDK安装 (6)2.8介质下载及解压 (7)2.9禁用防火墙 (7)2.10安装必要P ACKAGE软件包 (7)2.11配置报错问题解决 (8)3BIEE软件安装 (8)3.1在节点1上安装O RACLE F USION M IDDLEWARE 12C I NFRASTRUCTURE (8)3.2在节点1上安装O RACLE B USINESS I NTELLIGENCE 12C (15)3.3在节点1上配置O RACLE B USINESS I NTELLIGENCE 12C (20)3.4在节点2上的安装配置 (28)3.5在节点1上的操作 (29)3.6在节点2上的操作 (30)3.7在节点1上的操作 (31)3.8RCU使用 (32)2安装环境准备2.1BIEE12C High Availability Architecture2.2此次安装环境规划2.3操作系统cat /etc/issue此次操作系统环境为: Red Hat Enterprise Linux Server release 6.5 (Santiago) x642.4创建组和用户groupadd bieeuseradd -g biee obieepasswd obiee2.5共享文件夹划分2.6在节点1和节点2上进行NFS配置在节点1进行配置vi /etc/exports/app/nfsshare 10.8.154.30(rw,sync,no_root_squash)rpcbind和nfs服务均启动成功后,执行showmount -e可查看本机当前已发布的共享资源列表:service rpcbind startservice nfs startchkconfig rpcbind on //设置开机启动服务chkconfig nfs onchkconfig --list rpcbind //确保服务开机启动chkconfig --list nfs节点2配置如下mount -t nfs 10.8.154.29:/app/nfsshare /app/nfssharemount | grep nfs开机时自动挂载vi /etc/fstab10.8.154.29:/app/nfsshare /app/nfsshare nfs defaults 0 02.7JDK安装官网下载JDK1.8版本jdk-8u121-linux-x64.tar.gz,进行解压环境变量配置如下:export JAVA_HOME=/usr/jdk1.8.0_121export JAVA_BIN=/usr/jdk1.8.0_121/binexport CLASSPATH=.:$JAVA_HOME/lib/tools.jar:$JAVA_HOME/lib:$JAVA_HOME/bin PATH=$PATH:$HOME/bin:$JAVA_BIN:$CLASSPATH2.8介质下载及解压在oracle网站下载安装介质。

Linux服务器集群的搭建与优化

Linux服务器集群的搭建与优化在现代信息化时代,计算机网络已经成为了企业必备的一项基础设施。

大型企业拥有庞大的数据量、庞大的访问量,因此需要大型服务器来管理和维护它们的数据。

Linux服务器集群是目前企业最常见的服务器解决方案。

下面我们来探讨一下Linux服务器集群的搭建与优化。

一、Linux服务器的基本原理对于Linux服务器来说,它是一个软件程序,它就像Windows操作系统一样,需要硬件来支持。

Linux服务器和Windows服务器不同的是,它们的核心设计理念是不同的。

Linux服务器是基于开源协议设计的,这意味着它源代码可以被公开查看和修改。

而Windows服务器是商业开发的,它的源代码是保密的。

对于Linux服务器集群来说,它是由多台服务器组成。

这些服务器可以互相协作来完成任务。

每个服务器都可以独立运行,当一台服务器发生故障时,其他服务器可以接管这个服务器的任务,从而提高了全系统的可靠性和稳定性。

为什么需要一个Linux服务器集群呢?一方面,企业需要一个高性能的服务器来处理数据;另一方面,为了保证服务器的可靠性,企业需要一个基于高可用(HA)技术的服务器,这就是Linux服务器集群的应用场景。

二、Linux服务器集群的搭建在进行Linux服务器集群的搭建之前,需要准备以下工作:(1)安装Red Hat Enterprise LinuxRed Hat Enterprise Linux(RHEL)是一种基于Red Hat Linux操作系统的Linux操作系统。

它是企业级Linux操作系统的标准之一。

因此,如果你想要构建高性能、高可靠的Linux服务器集群,建议选择Red Hat Enterprise Linux。

(2)开启SSH服务SSH是一种安全远程访问协议。

通过SSH,你可以在远程服务器上执行命令和修改文件,还可以上传和下载文件。

在Linux服务器集群中,SSH连接是必须的。

在Red Hat Enterprise Linux中,SSH默认是已经开启的。

(Linux环境)Apache配置WebLogic集群分发

Apache配置WebLogic集群分发(Linux)目录一、安装Apache (2)1、拷贝apache安装包至linux文件夹 (2)2、解压apache安装包 (3)3、创建apache安装目录 (3)4、配置检查 (3)5、编译 (3)6、安装 (3)二、检查Apache是否安装成功 (3)1、启动Apache (3)2、检查Appache服务是否启动 (3)三、Apache分发配置 (3)四、重启apache服务 (5)五、常见问题 (5)六、注意事项 (5)一、安装Apache1、拷贝apache安装包至linux文件夹httpd-2.2.17.tar.gz放至/data/soft-installer目录2、解压apache安装包[root@localhost ~]# cd /data/soft-installer[root@localhost soft-installer]# tar zxvf httpd-2.2.17.tar.gz3、创建apache安装目录[root@localhost sof-installer]#cd /root/soft/httpd-2.2.17[***********************.17]#mkdir/usr/local/apache4、配置检查[root@localhost httpd-2.2.17]#./configure --prefix=/usr/local/apache --enable-so5、编译[***********************.17]#make6、安装[***********************.17]#makeinstall二、检查Apache是否安装成功1、启动Apache[***********************.17]#/usr/local/apache/bin/apachectlstart2、检查Appache服务是否启动[***********************.17]#ps-ef|grep httpd或者打开浏览器,在地址栏输入“http://ip”出现“It works!”或apache图标的漂亮界面,说明apache安装成功!三、Apache分发配置1、拷贝weblogic mod_wl_22.so至/usr/local/apache/modules/目录切换至weblogic目录如:/root/Oracle/Middleware/wlserver_10.3/server/plugin/linux/x86_64路径,找到mod_wl_22.so文件将文件复制到/usr/local/apache/modules目录2、配置httpd.confA、编辑Apache配置文件:[***********************.17]#vi/usr/local/apache/conf/httpd.confB、加载weblogic_module配置输入/LoadModule后回车,找到下面文本中的黑色字体部分,并添加黄色标记的语句:# LoadModule foo_module modules/mod_foo.soLoadModule weblogic_module modules/mod_wl_22.soC、配置监听端口#Listen 12.34.56.78:80Listen 9085D、配置分发节点IP及端口httpd.conf文件末尾添加如下语句,标红部分为分发节点IP和端口配置(需根据具体需要自行调整)四、重启apache服务[***********************.17]#/usr/local/apache/bin/apachectlrestart五、常见问题1、ntax error on line 202 of /etc/httpd/conf/httpd.conf: Cannot load/etc/httpd/modules/mod_wl_22.so into server: libstdc++.so.5: cannotopen shared object file: No such file or directory(modules是链接形式才出现)解决办法:安装compat-libstdc++-33-3.2.3-69.el6.x86_64.rpm程序A、将compat-libstdc++-33-3.2.3-69.el6.x86_64.rpm拷贝至/data/soft-installerB、cd /data/soft-installerC、rpm -ivh compat-libstdc++-33-3.2.3-69.el6.x86_64.rpm六、注意事项1、httpd.conf文件中配置的监听端口不能冲突2、httpd.conf 末尾添加语句,配置节点信息,需要配置成对应的IP和端口信息。

大数据技术基础实验报告-Linux环境下hadoop集群的搭建与基本配置

大数据技术基础实验报告-Linux环境下hadoop集群的搭建与基本配置实验内容:(一)安装和配置CentOS(二)安装和配置Java环境(三)启动和配置SSH绵密登录(四)安装和配置Hadoop设置仅主机连接模式启动Linux虚拟机,手动设置IP地址,注意和windows下虚拟网卡地址一个网段;2. 安装winscp(windows和linux虚拟机传数据的小工具),pieTTY(linux小客户端),并使用工具连接到虚拟机linux,通过winscp上传jdk、hadoop到linux虚拟机;3. 永久关闭防火墙,和Selinux,不然ssh无密码连接时可能会无法连接。

执行如下命令/etc/init.d/iptables stopchkconfig iptables offvi /etc/sysconfig/selinux 设置SELINUX=disabled4. 进入/etc/hosts添加自己的IP地址和主机名。

如192.168.18.120 hadoop5. 安装jdk并配置环境变量。

(用RPM包或压缩包)。

rmp安装命令:rpm -ivh jdk-7u67-linux-x86.rpmmv命令jdk相关目录改名进入/etc/profile文件,添加Java环境变量vi /etc/profileexport JAVA_HOME=/usr/local/jdkexport PATH=$PATH:$JAVA_HOME/bin执行source /etc/profile 刷新配置文件验证jdk是否成功。

Java -version6. 配置用户免密码登录。

7.安装hadoop(安装版本hadoop 2.7版本以上)使用ssh上传文件到linux主机执行了mv命令解压后更改文件夹名为hadoop在/etc/profile文件下添加环境变量,如下export HADOOP_HOME=/home/hadoop/hadoopexport PATH=$PATH:$HADOOP_HOME/bin保存配置文件执行source /etc/profile 使其立即生效切换到hadoop_home 下etc/Hadoop下修改相关配置文件。

CAS集群部署(Linux)

安装CAS集群(v1.0)目录1部署操作 (2)1.1硬件及部署要求 (2)1.1.1部署图 (2)1.2操作系统安装—SERVER1,2 .................................................................................................. 错误!未定义书签。

1.3安装M EMCACHED (2)1.3.1安装环境 (2)1.3.2安装步骤 (3)1.4安装LVS (7)1.5配置CAS集群模式 (11)1 部署操作1.1 硬件及部署要求以下几种集群部署策略请根据实际情况选择确定。

(1)使用认证平台人数在3万人以下,并发5000以下,不推荐集群化部署,单台即可;节点服务器要求(2路4核,8G 内存以上)物理机优先。

1.1.1 部署图说明:此架构为CAS 的集群模式,考虑高并发的模式及双击热备的模式,Memcached 需要配置1-2G 内存,可以考虑单独部署服务器,可以与其中一台CAS 服务器进行一起部署。

如果Memcached 挂了或者不能访问了,CAS 服务器就不能访问。

● CPU 类型:Intel/AMD (64位,主频2.6GHz 以上,2核及以上) ● 内存容量:4GB 及以上● 硬盘容量:160GB 以上,Raid 1/5 ● 网络控制器:千兆以太网卡(两块以上) ● IP (对外提供服务):3个,其中一个为虚拟ip ● 集群策略:MirrorMode ● 拓扑图:PCSmart Phone IP :Memcached1.2 安装Memcached1.2.1 安装环境redhat server 6.3(64bit)/ Centos 6.3(64bit)1.2.2安装步骤(确认是用root用户登录)将memcached-1.4.0.tar.gz , libevent-2.0.13-stable.tar.gz上传至/root路径下1.2.2.1安装libevent注意:这里一定要注意指定--prefix,后面配置memcached的时候就有必要用到。

linux集群

RHCS集群配置需要用到的各组件功能:RHCS(Red Hat Cluster Suite):能够提供高可用性、高可靠性、负载均衡、存储共享且经济廉价的集群工具集合。

LUCI:是一个基于web的集群配置方式,通过luci可以轻松的搭建一个功能强大的集群系统。

CLVM:Cluster逻辑卷管理,是LVM的扩展,这种扩展允许cluster中的机器使用LVM来管理共享存储。

CMAN:分布式集群管理器。

GFS(Google File System):以本地文件系统的形式出现。

多个Linux机器通过网络共享存储设备,每一台机器都可以将网络共享磁盘看作是本地磁盘,如果某台机器对某个文件执行了写操作,则后来访问此文件的机器就会读到写以后的结果。

实验需求:集群管理/ISCSI共享存储主机IP:192.168.0.40主机名: 集群节点一IP:192.168.0.41主机名:集群节点二IP:192.168.0.42主机名:一、【准备工作】1、修改管理主机和每个节点的hosts文件,保证三台服务器的hosts文件一样。

注:主机名最好使用域名形式,因为之前只用了gfs1这样的主机名,到后来,配置都顺利结束,但重启节点后,发现共享存储挂不上,看到是clvmd启动超时,估计是主机名的原因,解析不到?有待斟酌。

2、两台节点上分别关闭selinux、iptables和NetworkManager注:两台节点上都得操作,操作完后reboot重启两台节点,使配置生效二、【群集管理主机设置】1、安装并启用luci集群管理这时,你就可以用https://:8084(或https://192.168.0.40:8084)登陆集群web管理界面了,以root登陆即可三、【各节点配置】1、在两台节点分别yum安装ricci、rgmanager、cman启动cman如出现错误:Starting cman... xmlconfig cannot find /etc/cluster/cluster.conf [FAILED]是因为节点还没有加入集群,没有产生配置文件/etc/cluster/cluster.conf2、在两台节点上给ricci用户设置与root相同的密码四、【集群web管理界面配置】1、浏览器打开https://192.168.0.40:8084 输入root和root密码进行登陆2、添加集群点击Manager Clusters---> Create 创建一个集群,如下图,输入集群名称,添加每个节点的主机名、密码,勾选Download Packages、Reboot Nodes Before Jo ining Cluster、Enable Shared Storage Support,最后点击Create Cluster创建集群,耐心等待,创建过程中两台节点会重启...创建成功后显示如下:在到任意一个节点上去查看集群状态,都是Online,说明集群配置成功。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Linux集群配置文档(中文配置文档) RHCS+Oracle配置实战图解(1) 在RHCS中,最难理解的是Fence机制,下面的配置过程将首先以"手动Fence"为例进行讲解,以更深入地描述Fence在集群运行过程中的运行步骤及作用,最后再换成真实的Fence设备。需要注意的是,虽然通过"手动Fence"可以完整地配置RHCS,但在生产环境中不推荐这样做,因为一旦出现硬件级故障的话,"手动Fence"需要管理员通过人工干预方式进行系统切换。

1. 安装红帽集群套件RHCS 安装RHCS主要有以下3个途径: 通过RHEL5 AP高级平台版介质进行安装,并在安装过程中输入通过rhn.redhat.com网站激活后得到的Install Number,选中相应的"Cluster(集群)"组件。

通过RHCSS(Red Hat Cluster Solution Suite,红帽集群解决方案套件)的安装光盘进行安装,RHCSS的好处是已经附带了多种流行数据库的支持接口,并可以提供磁盘镜像(Mirro)及企业系统备份功能。

注意: 购买RHCSS订阅时就已经包括了上门安装服务,会有专人为客户进行生产环境下的安装配置。

通过RHEL5 AP高级平台版介质进行手动安装,将安装介质挂载到/media/cdrom,然后进行以下操作:

(1) 建立文件/etc/yum.repos.d/mycdrom.repo,内容如下:

(2) 执行yum命令进行集群组件的安装: 2. 红帽集群套件RHCS配置前的准备 在两台服务器中分别安装RHCS,并按照表12-1所示配置服务器。 表12-1 RHCS集群配置说明 3. 通过system-config-cluster配置RHCS 打开一个终端并通过root用户身份运行命令system-config-cluster,或通过"系统"|"管理"|"服务器设置"|"system-config-cluster"来打开集群配置界面。

建立新集群 建立一个新的集群,命名为"new_cluster"。请注意:集群的名称要求少于16个字符,否则集群启动时会出现问题,如图12-3所示。对于双节点的集群来说,"Custom Configure Multicast"和"Use a Quorum Disk"都可以不作设置。

Custom Configure Multicast:用于指定一个用于本集群的多播地址。 Use a Quorum Disk:当多个节点要求仲裁机制时,指定仲裁策略。在实际应用中,超过两个节点的集群应用相对还是比较少,因此本书只涉及到RHCS双节点的配置。有兴趣了解"Quorum Disk"的读者可以参考红帽公司的官方文档。

添加节点 (1) 在图12-4左边的树状目录中选中"Cluster Nodes",单击"Add a Cluster Node"添加集群节点。

(2) 在"Node Properties"窗口中填入两个节点的机器名,分别为server1.example.com和server2.example.com,如图12-5所示。此处不但添加了节点,还同时指定了集群的"心跳"。由于在/etc/hosts中已经指定了两个节点名称对应的IP分别为192.168.100.11和192.168.100.12,因此两台服务器通过此网络接口对连即可成为"心跳线"。

图12-3 新建集群

(点击查看大图)图12-4 添加集群节点

12.6.3 RHCS+Oracle配置实战图解(2) 添加Fence设备 (1) 在图12-4左边的树状节点中选中"Fence Devices",单击"Add a Fence Device"打开Fence配置窗口。

(2) 在"Add a New Fence Device"下拉菜单中选中"Manual Fencing"以手动Fencing。 (3) 在"Name"处为Fence设备自定义一个名称,如"m_fencing",如图12-6所示。

图12-5 加入节点server1.example.com

图12-6 添加手动Fence设备

节点与Fence设备绑定 (1) 在图11-7左边的树状目录中选中"server1.example.com",单击"Manage Fencing For This Node"。

(2) 为节点server1.example.com添加一个"Fence Level"(注:为进一步保证集群"脑裂"时的有效切换,RHCS允许对一个节点添加多个Fence设备并建立分级的Fence操作)。

(点击查看大图)图12-7 为节点添加Fence Level (3) 选中"Fence-Level-1",单击"Add a New Fence to this Level",在"Fence Properties"窗口的"Add a New Fence"下拉菜单中选择刚才建立的名为"m_fencing"的设备,如图12-8所示。

图12-8 指定Fence Level使用的Fence设备

(4) 在节点server2.example.com上重复以上步骤,将其与名为"m_fencing"的设备绑定。 新建Failover Domain (1) 在图12-4左边的树状目录中选中"Failover Domains",单击"Create a Failover Domain"。 (2) 在"Name for new Failover Domain"文本框中指定自定义的Failover Domain名称,如ora_domain,如图12-9所示。

图12-9 新建Failover Domain

(3) 通过"Available Cluster Nodes"下拉菜单将server1.example.com及server2. example.com加入到当前的Failover Domain中,如图12-10所示。

Restrict Failover To This Domains Members:指派给这个Failover Domain的Service只可以在当前加入的成员上执行;如果不选此项,Service将允许在本集群中的任何节点进行Failover切换。为保证系统的严谨性,建议选中此项。 Prioritized List:用于调整Failover Domain中节点的优先级别,指定Service优先在哪个节点中运行。(注:对于双节点情况,如果,两台服务器的性能相同,那么一般不需要设置它们的优先关系,先启动服务器为主服务器,后启动的的为备用服务器。当主服务器出现故障,备用服务器进行Service接管后,即使主服务器通过检修重新加入集群,由于主/备服务器性能相同,因此没有必要再浪费时间进行Service切换)

添加Resource - IP Address (1) 在图12-4左边的树状目录中选中"Resources",单击"Create a Resource"。 (2) 在"Select a Resource Type"下拉菜单中选中"IP Address"并填入IP地址,如192.168.101.10,如图12-11所示。此地址就是上面提到的"虚拟IP",对于每一个通过网络进行连接的Service来说,都要求至少有一个独立的"虚拟IP"。

图12-10 为Failover Domain添加节点

图12-11 添加IP Address资源

12.6.3 RHCS+Oracle配置实战图解(3) 添加Resource - File System (1) 在图12-4左边的树状目录中选中"Resources",单击"Create a Resource"。 (2) 在"Select a Resource Type"下拉菜单中选中"File System",并按图12-12所示指定文件系统资源的名称、文件系统类型、挂载点及使用的磁盘设备。

Options:执行mount指令时的特殊参数,与mount指令的"-o"参数相同。 File System ID:RHCS中要求每个File System都有一个唯一的ID号,此项一般不用指定,系统会自动进行分配。

Force unmount - 一旦服务要求切换,在进行umount操作时使用-f参数 Reboot host node if unmount fails - 若umount失败,则尝试对此系统进行重启操作。 Check file system before mounting - 挂载文件系统前通过fsck命令对文件系统进行检查,这可以更好地保证文件系统的完整性,但对于大文件系统来说,这将花费很长的时间。

添加Resource - Script (1) 在图12-4左边的树状目录中选中"Resources",单击"Create a Resource"。 (2) 在"Select a Resource Type"下拉菜单中选中"Script",为此资源定义一个"Name"为ora_script、以/etc/init.d/dbora为脚本文件的Scrgt资源,如图12-13所示。

/etc/init.d/dbora是一个用于对Oracle进行启动(start)、停止(stop)及状态检查(status)的脚本,RHCS要求每个脚本都支持这3种参数操作,并根据应用的实际运行情况返回"0(表示正常)"或"非0(表示运行异常)"。RHCS就是靠这些参数及返回值来判断应用程序运行得正常与否,以保证当应用软件由于自身或其他原因而导致异常时进行Failover切换(本书将在后面的章节中为读者详细分析/etc/init.d/dbora脚本的运行过程)。

图12-12 添加File System资源