基于视频多特征融合的列车车厢烟雾检测方法

基于多光谱图像的烟雾检测

基于多光谱图像的烟雾检测

卫颖卓;张绍武;刘彦伟

【期刊名称】《光谱学与光谱分析》

【年(卷),期】2010(030)004

【摘要】烟雾检测对于火灾早期防范非常重要,传统的智能视频和图像处理技术易受背景运动信息影响,抗干扰性差,且不容易区分森林水雾和燃烧产生的烟雾,森林防火误报率高.为此提出一种新的多光谱图像检测方法检测烟雾.采用多光谱成像系统,获取400至720 nm波段范围的烟雾、水雾光谱图像序列,对图像进行分层像素整合处理;利用欧氏距离度量不同分块光谱特征差异,获取动态区域光谱特征向量,根据目标与背景间光谱特征向最差异,提取烟雾、水雾区域.室内外试验结果表明:多光谱图像检测方法可用于烟雾检测,能够有效地检测并区分烟雾和水雾,与视频图像方法结合,可有效地用于森林火灾监测,降低森林火灾检测误报率.

【总页数】4页(P1061-1064)

【作者】卫颖卓;张绍武;刘彦伟

【作者单位】西北工业大学自动化学院,陕西,西安,710072;西北工业大学自动化学院,陕西,西安,710072;西北工业大学自动化学院,陕西,西安,710072

【正文语种】中文

【中图分类】TP391

【相关文献】

1.基于光流改进与YOLOv3的烟雾检测方法 [J], 李澎林;章军伟;李伟

2.基于改进Tiny-YOLOv3的烟雾检测算法 [J], 吉森荣

3.基于改进Tiny-YOLOv3的烟雾检测算法 [J], 吉森荣

4.基于图像处理技术的烟雾检测在家庭火灾防范中应用 [J], 杨剑;陈世娥

5.基于视频区域动态特征的林火烟雾检测技术研究 [J], 刘长春;刘鹏举;季烨云因版权原因,仅展示原文概要,查看原文内容请购买。

基于多传感器信息融合的列车组合定位

基于多传感器信息融合的列车组合定位

随着铁路交通的不断发展,列车组合定位技术在铁路运输中起着重要作用。

列车组合定位是指通过多种传感器信息融合来确定列车在铁路轨道上的位置和方向,以实现列车运行安全和准确导航的技术。

本文将介绍基于多传感器信息融合的列车组合定位技术的原理和方法。

列车组合定位技术需要使用多种传感器来获取列车位置和方向的信息。

常用的传感器有全球定位系统(GPS)、惯性导航系统(INS)、一致速度模型(CV)等。

这些传感器可以在列车上装配,并通过相互协作获取列车的位置和方向信息。

列车组合定位技术需要将多种传感器信息进行融合处理。

这是因为单一传感器可能存在精度和可靠性的限制,通过将多个传感器的信息互相协作,可以提高定位的准确性和可靠性。

融合处理的方法可以采用信息融合算法,如卡尔曼滤波算法、粒子滤波算法等。

通过将不同传感器的测量结果进行集成和优化,可以提高列车组合定位的性能。

对于列车组合定位技术来说,传感器数据的预处理和校准也是非常重要的。

预处理主要指对传感器数据进行滤波和去噪处理,以提取有效的信息。

校准则是指对传感器数据进行准确校正,消除传感器之间的误差。

只有在数据预处理和校准的基础上,才能有效地进行传感器信息的融合。

在实际应用中,列车组合定位技术还需要考虑其他因素,如轨道地图的更新、环境变化的影响等。

轨道地图的更新是指及时更新轨道信息,以保证列车组合定位的准确性。

环境变化的影响可以通过传感器信息融合的方法进行动态校正,以适应不同环境下的列车运行。

多特征融合的视频火焰检测算法研究

多特征融合的视频火焰检测算法研究谢伟【期刊名称】《电脑知识与技术》【年(卷),期】2014(000)022【摘要】The flame detection based-on videos provide a new way for solving the problem that the conventional flame detection methods based-on detecting smoke or heat are limited by circumstance. Common video flame detection principally employ the color, shape and frequency features to detect flame. These methods are too complex to be used in real-time environment. This pa-per combines the color, movement and flicker and proposes a simple and efficient video flame detection method. Firstly use the ViBe algorithm to extract moving regions in video as candidates for reducing calculation, then select the suspects through the color model of flame, and lastly according to the flicker property build a simple model to remove the non-flame areas having color simi-lar to flame. The experiments show that the proposed method can detect flame in various circumstances and perform efficiently.%基于视频的火焰检测算法为解决传统感烟感温火焰检测方法受环境制约的问题提供了一条新的路径。

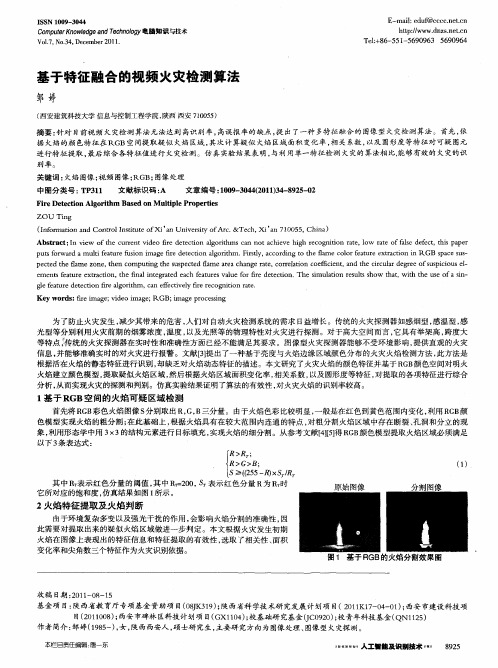

基于特征融合的视频火灾检测算法

为 了防止火 灾发生 , 少其 带来 的危害 , 减 人们对 自动火灾 检测系统 的需求 日益增 长。传统 的火灾探测器 如感 烟型 , 感温 型 , 感

光型等分别 利用 火灾前期 的烟雾浓 度 , 温度 , 以及光 照等 的物理特性对火灾进行探测 。对于高大空 间而言 , 它具有举架高 , 跨度大 等特点 传统 的火灾探 测器 在实时性和准 确性 方面 已经不能满足其要 求。图像型火灾探测器 能够不 受环境影响 , 提供直观的火灾 信息 , 并能够准确实 时的对 火灾进行报警 。文献 [ 提 出了一 种基于亮度与火焰边缘 区域颜 色分 布的火灾火焰检测方法 , 3 】 此方法是 根据活在火焰的静态特征进行识别 , 却缺乏对火焰动态特征 的描述 。本文研究 了火灾火焰 的颜色特征并基于 R B G 颜色空 间对 明火 火焰建立颜色模型 , 提取疑似火焰区域 , 然后 根据火焰 区域面积变化率 , 相关系数 , 以及 圆形 度等特征 , 对提取 的各项特征进行综合 分析 , 从而实现火灾 的探测和判别 。仿真实验结果证 明了算法 的有效性 , 对火灾火焰 的识别率较高 。

一种基于多类特征融合的车辆识别方法

一种基于多类特征融合的车辆识别方法随着城市化的不断发展,城市交通越来越繁忙,车辆识别技术也越来越重要。

车辆识别是指通过对视频图像中的车辆进行自动检测和识别,以达到交通管理、安全监控和追溯车辆等目的。

然而,由于不同场景、不同光照和角度的影响,车辆识别面临许多挑战。

因此,在车辆识别中,如何提高识别准确性是一个非常重要的问题。

近年来,基于深度学习的车辆识别方法已经成为主流方法,如卷积神经网络。

然而,深度学习需要的数据量巨大,而且对硬件资源要求较高。

为了解决这些问题,本文提出了一种基于多类特征融合的车辆识别方法,旨在提高车辆识别准确性,并应用于实际场景中。

本文的方法主要包括两个步骤:车辆特征提取和多类特征融合分类。

首先,我们使用图像处理方法将车辆从视频中分割出来,然后针对车辆进行特征提取。

为了充分利用车辆的各种特征,我们采用多类特征提取的方法。

具体来说,我们使用深度神经网络提取图像的深度特征,同时,提取几何特征和颜色特征。

其中,几何特征包括车辆区域大小、形状和纹理等,颜色特征包括颜色直方图和颜色空间等。

接下来,在特征提取的基础上,我们采用多类特征融合分类的方法。

具体来说,我们训练了三个不同的分类器,分别针对深度特征、几何特征和颜色特征。

然后,针对每一帧图像,将三个分类器的输出合并成一个综合分类结果。

我们采用投票和加权融合两种方法进行综合结果的计算,以获得更高的准确性。

为了验证本文提出的方法的有效性,我们在一个现实场景下进行了车辆识别实验。

我们采集了数千张车辆图像,并将它们分为训练集和测试集。

实验结果表明,本文方法在不同场景下都能取得较高的识别准确率,并且相比单一特征的方法,本文提出的方法在准确性上有显著提升。

此外,对于不同类型的车辆,本文方法也具有较好的适应性和鲁棒性。

综上所述,本文提出了一种基于多类特征融合的车辆识别方法,旨在解决车辆识别中的挑战性问题。

通过充分利用深度、几何和颜色等多种特征,本文方法在车辆识别准确率上有显著提升,并且本方法具有很好的适应性和鲁棒性。

基于多技术融合的地铁列车障碍物检测系统设计分析探讨

基于多技术融合的地铁列车障碍物检测系统设计分析探讨近年来,地铁成为人们出行的主要方式之一,但是地铁列车在行驶中往往会遇到各种障碍物,这些障碍物可能会对列车的安全行驶造成威胁。

因此,设计一套地铁列车障碍物检测系统至关重要。

传统的地铁列车障碍物检测系统主要依靠单一技术,容易受到外界环境的影响,检测准确性有限。

为了提高地铁列车的安全性能,本文基于多技术融合的思路,设计一套高效的地铁列车障碍物检测系统。

首先,本文将采用多种传感器技术进行障碍物检测。

例如,激光雷达可以实时扫描地铁车厢内外的环境,检测出潜在的障碍物;红外传感器可以检测车厢内的温度变化,发现异常情况;摄像头可以捕捉车厢内的图像,识别出潜在的障碍物。

通过多种传感器技术的融合,可以提高系统的检测准确性和全面性。

其次,本文将采用深度学习技术对传感器数据进行处理和分析。

传感器数据量庞大,深度学习技术可以有效地处理这些数据,提取出有用的信息。

通过训练深度学习模型,可以实现对障碍物的实时识别和定位。

同时,深度学习技术可以根据历史数据不断优化模型,提高系统的稳定性和准确性。

最后,本文将设计一个智能控制系统,实现对地铁列车的实时监控和控制。

当系统检测到有障碍物出现时,可以通过智能控制系统及时对列车进行干预,避免发生事故。

智能控制系统还可以通过与车辆通讯系统的集成,实现对列车其他系统的协调控制,进一步提高列车的安全性能。

综上所述,基于多技术融合的地铁列车障碍物检测系统,具有高效、准确和稳定的特点,可以有效提高地铁列车的安全性能,保障乘客的出行安全。

未来,随着物联网、人工智能等新技术的不断发展,地铁列车障碍物检测系统将进一步得到完善和升级,为地铁运输行业的发展注入新的动力。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于视频多特征融合的列车车厢烟雾检测方法陈海鹏;刘飞;徐磊;徐广伟;王宏雷;谭华春【摘要】列车车厢中环境相对复杂且遮挡物较多,为了提高视频烟雾检测的准确性,剔除场景中疑似烟雾的干扰物,降低由于环境中光照变化导致的误检情况,提出了基于运动、颜色及衰减等多特征融合的烟雾检测算法.该算法能有效克服背景复杂、光照变化大,以及阴影问题带来的干扰.算法主要由3部分构成:烟雾运动检测、颜色特征分析提取和多特征融合.该算法通过背景建模方法分割出运动的区域,引入归一化RGB空间烟雾颜色基础模型及衰减模型,以剔除疑似烟雾区域的干扰,同时可以有效地降低光照影响.【期刊名称】《北京交通大学学报》【年(卷),期】2015(039)001【总页数】6页(P67-71,77)【关键词】图像处理;视频烟雾检测;运动分割;衰减模型;多特征融合【作者】陈海鹏;刘飞;徐磊;徐广伟;王宏雷;谭华春【作者单位】南车青岛四方机车车辆股份有限公司,山东青岛266111;南车青岛四方机车车辆股份有限公司,山东青岛266111;南车青岛四方机车车辆股份有限公司,山东青岛266111;南车青岛四方机车车辆股份有限公司,山东青岛266111;易程(苏州)智能系统有限公司,江苏苏州215163;北京理工大学机械与车辆学院,北京100081【正文语种】中文【中图分类】TP391近年来,随着我国铁路的快速发展,对高铁列车的安全问题越来越重视.由于车厢空间密闭、狭窄,高度有限,一旦发生火灾,疏散困难,会造成人员伤亡及严重的经济损失和巨大的社会负面效应.而根据对火灾规律的研究,烟雾通常先于火焰出现,所以对列车车厢内的烟雾检测至关重要.传统的烟雾检测技术一般是根据烟雾的特殊颗粒、独特气体及温度等变化,采用温度感应、烟尘感应、光度感应、气味感应及综合的探测设计.如吸气式烟雾探测器,烟雾探测器和一个单点的进气口样式烟雾探测器.传统的烟雾探测器被安装在目标对象的附近,烟雾到达检测器可以检测到,而早期烟雾扩散速率通常是缓慢的,需要较长的时间到达检测器.由于光的传播较之气体的传播更加快速,所以很有必要研究基于图像视觉的烟雾预警系统,提高烟雾检测的报警速度.同时,基于计算机视觉技术的烟雾探测能提供更直观的现场信息,在更大程度上满足对消防安全的要求,与传统的烟雾探测系统相比,具有很大的优势.目前,基于视频的烟雾检测方法大致可分为3类:①基于颜色判别的烟雾检测,如在YCbCr色彩空间对不同场景视频进行分析统计,得到烟雾的颜色判别模型[1];或者通过统计烟雾像素的HIS颜色空间中的色度信息构建色彩模型,然后利用烟雾使图像模糊这一动态特征最终实现对烟雾的判别[2],这类方法的缺点是在亮度变化较大的环境下,容易产生误检.②基于烟雾的动态特性检测方法,主要利用烟雾的缓慢扩散性,如利用光流场来进行烟雾探测,根据烟雾扩散的不规则特性,通过光流法统计出此特征来实施检测[3];或者将监控画面区域分割成小块,在时间维度上计算区域块的累积量和主运动方向来探测,这种烟雾识别方法,可以在一定程度上抑制了噪声的干扰[4].③分析视频图像中能量变动的烟雾检测方法,主要是通过小波分解,获取图像能量变化信息,文献[5-6]利用小波变换提取运动区域的高频即代表能量信息,然后分析帧间高频分量的变化判断是否是烟雾导致的能量变化,排除疑似物干扰,检测出烟雾.尽管上述的烟雾检测方法均取得了不错的进展,但由于动车组列车车厢对实时性要求较高,且存在环境复杂、内部空间狭小、人群拥挤及遮挡较多等特点,仍面临一些问题,如:现有的一些效果较好的算法,需要的时间过长,不能满足在列车上烟雾监控的实时处理要求;在对列车的安全监控中,环境变动较大,固定的特征量检测阈值选取对检测结果影响较大,在此类复杂环境下检测性能严重下降.本文作者针对上述列车车厢内烟雾检测存在问题,基于视频图像区域中烟雾颜色、运动及能量特征融合,改进烟雾检测模型,提出一种快速且稳定的烟雾检测算法.所提出的方法通过简单的学习,计算出疑似烟雾区域的运动特征,融合烟雾的静态特征(颜色、形状)和能量特征进一步实现烟雾的自动检测.在对烟雾检测过程中,首先将可能是烟雾的区域提取出来,这是当前烟雾检测的重点和难点之一,前景区域的有效检测对于后续的目标分类和跟踪等至关重要.目前常用的分割方法有3种,即帧间差分法、光流法和背景建模法.帧间差分算法是通过帧间图像的差值获得运动物体(烟雾和非烟雾)的轮廓,该方法速度较快,但不能提取出对象的完整区域[7];基于光流的分割方法,由于计算复杂度高且容易受噪声影响,不适宜实时检测;背景建模法获取运动区域较为准确,适合于背景变化不大的情况,但对光照等外部条件变化较大的场景较敏感.本研究为固定视角的运动检测,摄像机安装后对整个场景进行监控,其位置不会发生改变,因此不需要使用光流法等计算量较大的运动检测算法.由于监控场景为列车车厢环境,遮挡较多,在运动检测中需要对背景进行重建和更新.本研究的目标是对火灾烟雾进行检测,对算法的实时性要求较高,因此,在对图像进行相关预处理后,使用一种改进的背景建模法对运动区域进行检测.首先使用低通滤波对背景进行提取和更新,然后使用带阈值的背景差分法获得粗略的运动目标,最后通过形态学处理如膨胀、腐蚀,增强得到的运动区域效果.1.1 背景更新Kalman滤波可以在运动检测的基础上对多帧图像进行降噪处理,使用递归低通高斯滤波预测缓变的背景图像[8].在一个视频图像序列中,若x和y为像素点的坐标,B(k,x,y)为第k帧时x,y位置的背景图像灰度值,I(k,x,y)为第k帧时x,y位置的输入图像灰度值,M(k,x,y)为第k帧时x,y位置的运动图像二值化值,基于Kalman滤波的背景图像更新公式为式中g(k)为动态增益因子,通过运动因子α和背景因子β求得,α和β为某一固定的经验阈值,为了使运动区域能够从背景中有效的分割出来,一般在(0,1)区间内取值,本文中α取0.05,β取0.08.此外,需考虑到当k=1时,初始背景图像尚未建立的情况,取B(1,x,y)=I(1,x,y),其中I(1,x,y),可以从图像采集设备中获取,即假设初始状态时图像中没有运动区域.1.2 运动区域分割背景图像更新之后,可使用背景差分法将图像中的前景感兴趣区域分割出来,由于差分后的图像不仅包含目标整体的运动区域,还产生很多灰度值不为0的噪点,因此采用一种带阈值的背景差分法,运动图像M(k,x,y)的计算公式为式中t为二值化分割阈值,由实验经验,t的取值在12~14之间时分割的效果较好,在有效分割出运动主体区域的同时,又能将与运动目标无关的噪声像素过滤掉.本实验中烟雾图像前景区域分割的效果如图1所示,其中:图1(a)为模拟的实验场景,使用加湿器产生的雾气模拟烟雾;图1(b)为运用递归低通高斯滤波得到的初始分割效果图像;图1(c)为经过带阈值的背景差分处理后得到的分割效果.在建立背景模型的基础上,应对如高铁列车车厢这样不断变动的背景实时更新混合高斯模型.传统的更新方式是通过最大似然估计法更新模型参数和加权系数,但最大似然估计法结构复杂,计算效率低,很难满足实时性的要求.为了达到实时性要求,本文作者采用K-Means[9]更新参数和权函数,以保证烟雾运动特征提取的实时性和准确性.2.1 基本颜色模型RGB颜色模型是比较常用的颜色模型,研究人员在RGB的颜色模型下,统计发现烟雾的3种颜色通道值非常接近[2].之后研究人员又发现烟雾的颜色近似为浅灰或蓝白色,因蓝色分量的值在RGB颜色模型中比例偏高[4].具体算法规则为Cmin=min(R,G,B),Cmax=max(R,G,B),I=(R+G+B)/3.条件1:|Cmax-Cmin|<T3条件2:T2<I<T3条件3:式中:Cmin为RGB分量中的最小值;Cmax为RGB分量中的最大值;I为RGB分量的平均值;T2为RGB分量平均值的下界;T3为最大分量和最小分量差值的上界及RGB分量平均值的上界;T4为当RGB分量中蓝色分量为最大时,最大分量和最小分量差值的上界.如果满足条件1和条件2同时成立,或条件2与条件3同时成立,且符合烟雾颜色区间范围,则满足烟雾颜色特征条件.采用RGB颜色判别模型的处理效果如图2所示,其中:图2(a)为模拟的实验场景,使用加湿器产生的雾气模拟烟雾;图2(b)为使用上述颜色判别模型得到的可能存在烟雾区域.2.2 烟雾光衰减模型一般的火灾场景中,由于空气中烟尘等悬浮固体颗粒介质,导致光线从物体表面反射到检测设备过程中,自然光因烟尘粒子散射衰减,得到的成像其对比度、饱和度及色调发生偏离.自然光在烟雾情况下衰减的模型示意如图3所示.根据光在烟雾环境传输的物理特性,成像的物理模型可描述为式中:右边第一项为直接衰减模型(Direct attenuation),描述了场景中辐射率在介质中直接衰减的结果;右边第二项是大气散射模型(Airlight model),反映了由于烟雾颗粒散射导致的颜色偏离结果;F(x)为观察图像即输入图像;ψ(x)为场景辐射度,x 代表二维空间位置;φ(x)是场景色彩在各个区域通过程度的描述(透射图);A为空气光.当大气同质时,透射图可以表述为φ(x)=exp(-γd(x)),0<φ(x)<1(5)式中:γ为大气散射系数;d(x)为场景深度.去除烟雾目的是通过已知F(x)恢复ψ(x)、A和φ(x)等.基于上述技术的烟雾检测算法处理流程如下:①从获得的图像中把分割出前景区域,然后通过烟雾的联通域分析判定,排除非烟雾区域;②利用颜色及衰减特性建立烟雾检测基础模型,剔除一些假烟雾像素;③融合色彩特征与运动特征,将烟雾像素从这些感兴趣区域提取,降低虚景,最后确认发出警告信息.算法处理流程如图4所示,图中算法的输入为采集的视频数据,输出为烟雾检测后的报警信息.软件环境:Windows 7,OpenCV 2.4.5开源计算机视觉库,因此需要OpenCV运行库文件.同时对软件Visual Studio 2008进行开发,需要安装Visual C ++开发的应用程序所需的运行组件.硬件环境:处理器Intel Core i5,内存1 G,硬盘空间100 GB,显卡Intel HD Graphics 300.实验模拟搭建了动车组车厢内环境,首先在室内模拟车厢内封闭环境,为了减少遮挡物影响,摄像机采用全景摄像头,吊顶安装,高度设置模拟车厢顶部高度约为2.8 m,同时实验环境中安排各种座椅等干扰物来模拟车厢中复杂的环境.点燃放在半径为20 cm圆盆中的纸张、纺织物,并保持阴燃,产生烟雾,采用全景摄像机拍摄整个实验过程.实验中测试了在此搭建环境下的算法,结果如图5所示.从图5的处理结果可看出,烟雾通常从阴燃点持续冒出,烟雾呈白色半透明状,使用本文提出的改进背景建模方法定位烟雾区域,可以在烟雾的初期快速检测到烟雾,如图5(a)所示;通过融合烟雾光衰减模型的颜色特征剔除疑似像素,如图5(b)中人的干扰.为了验证改进后的颜色模型效果,实验使用挥动的黑色塑料袋对实验进行干扰,效果如图6所示.图6(a)为模拟运动的黑色塑料袋干扰检测,图6 (b)为将图6(a)通过本文算法剔除塑料袋干扰后的背景分割效果图,可见背景分割后没有出现干扰物的形状.实验结果表明,改进后的彩色模型减少了分布对颜色变化的敏感性,对强度的变化也相对稳健,强干扰物如挥动的黑色塑料袋等在经过改进的彩色模型处理后被完全剔除,因此本方法能迅速的探测到烟雾,同时具有较强的抗干扰性.针对列车车厢中烟雾检测的需求,提出了基于计算机视觉的改进烟雾颜色模型的检测算法.该算法通过运动特征提取获取烟雾的动态信息,进而通过颜色、衰减等特性来剔除一些强干扰物如挥动的黑色塑料袋等,实验结果证明,本文所提出的算法能够及时地检测出烟雾并能有效地排除这些干扰物,为列车车厢提供安全的保障.【相关文献】[1]Celik T,Özkaramanl H,Demirel H.Fire and smoke detection without sensors:image processing-based approach[C]//Proc of 15th European Signal Processing Conf,2007:1794-1798.[2]Chen T H,Yin Y H,Huang S F,et al.The smoke detection for early fire-alarming system base on video processing[C]//Proceedings of 2006 International Conference on Intelligent Information Hiding and Multimedia Signal Processing,2006:427-430.[3]Kopilovic I,Vagvolgyi B,Sziranyi T.Application of panoramic annular lens for motion analysis tasks:surveillance and smoke detection[C]//Proceedings of15thInternational Conference on Pattern Recognition(ICPR),Los Alamitos,2000:714-717. [4]Yuan F.A fast accumulative motion orientation model based on integral image for video smoke detection[J]. Pattern Recognition Letters,2008,29(7):925-932.[5]Toreyin B U,Dedeoglu Y,Cetin A E.Wavelet-based realtime smoke detection in video[C]//Proceedings of 13thEuropean Signal Processing Conference,2005:4-8.[6]Shuai Shi,Zhou Ping,Wang Yaming.Wavelet based realtime smoke detection [J].Application Research of Computer,2007,24(3):309-311.[7]夏文德,练秋生.基于视频处理的烟雾检测快速算法[J].电子技术,2007,36(11):135-138. XIA Wende,LIAN Qiusheng.A fast algorithm of smoke checking based on video processing[J].Electronic Technology,2007,36(11):135-138.(in Chinese)[8]严勇,黄席樾,刘爱君.Kalman滤波在运动图像背景提取及更新中的应用[J].自动化与仪器仪表,2006(2): 28-30.YAN Yong,HUANG Xiyue,LIU Aijun.The application of Kalman filter to both background subtraction and background updating of motional image[J].Automation&Instrumentation,2006(2):28-30.(in Chinese)[9]Yu G,Sapiro G,Mallat S.Solving inverse problems with piecewise linear estimators:from Gaussian mixture models to structured sparsity[J].IEEE Transactions on Image Processing,2012,21(5):2481-2499.。