Nutanix超融合平台架构介绍

Nutanix超融合体系架构之:运行机制

数据保护

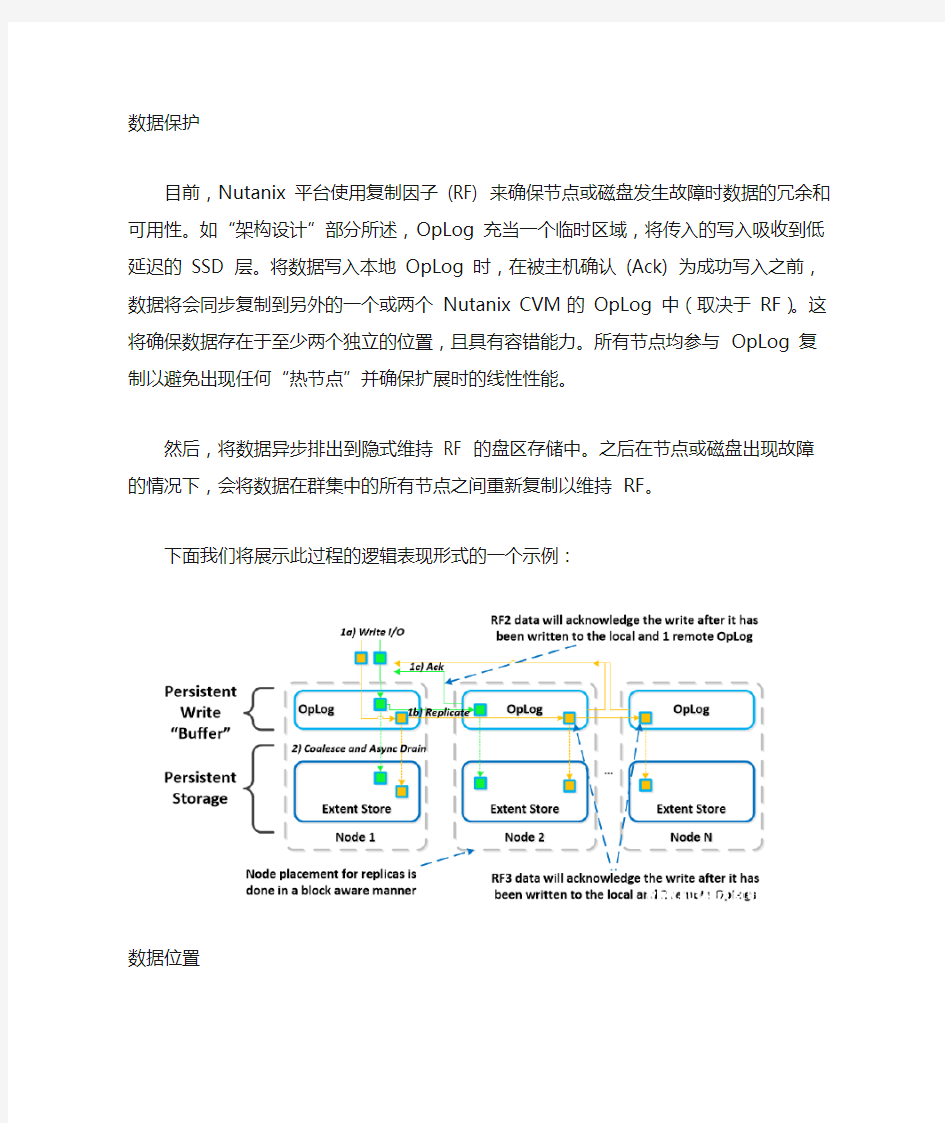

目前,Nutanix 平台使用复制因子(RF) 来确保节点或磁盘发生故障时数据的冗余和可用性。如“架构设计”部分所述,OpLog 充当一个临时区域,将传入的写入吸收到低延迟的SSD 层。将数据写入本地OpLog 时,在被主机确认(Ack) 为成功写入之前,数据将会同步复制到另外的一个或两个Nutanix CVM 的OpLog 中(取决于RF)。这将确保数据存在于至少两个独立的位置,且具有容错能力。所有节点均参与OpLog 复制以避免出现任何“热节点”并确保扩展时的线性性能。

然后,将数据异步排出到隐式维持RF 的盘区存储中。之后在节点或磁盘出现故障的情况下,会将数据在群集中的所有节点之间重新复制以维持RF。

下面我们将展示此过程的逻辑表现形式的一个示例:

数据位置

作为一个融合的(计算+存储)平台,I/O 和数据位置对与Nutanix 有关的群集和VM 性能至关重要。如前面I/O 路径中所述,所有读取/写入IO 均由本地控制器VM (CVM) 提

供服务,本地控制器VM 位于邻近常规VM 的每个虚拟机监控程序中。在CVM 的控制下,VM 的数据将在本地由CVM 提供服务并且位于本地磁盘中。当VM 从一个虚拟机监控程序节点移动到另一个时(或发生HA 事件时),最新迁移的VM 的数据将由现在的本地CVM 提供服务。在读取旧数据(存储在现在的远程节点/CVM 上)时,I/O 将由本地CVM 转发到远程CVM。所有写入I/O 将立即在本地出现。NDFS 会检测到I/O 从另一节点出现,并在后台将数据迁移到本地,现在将允许在本地为所有读取I/O 提供服务。为了不泛洪网络,只在读取时迁移数据。

下面我们将展示数据在虚拟机监控程序的节点之间移动时如何“跟随”VM 的一个示例:

可伸缩元数据

元数据是任何智能系统的核心,对文件系统或存储阵列而言甚至更为重要。就NDFS 而言,一些关键结构对于它的成功至关重要:它必须时刻保持正确(又称“严格一致性”),它必须可伸缩,而且它必须能够大规模执行。如前面架构部分所述,NDFS 使用“环式”结构作为键值存储,键值存储将存储重要元数据及其他平台数据(如状态等)。为了确保元数据的可用性和冗余,在奇数节点(如3、5 等)之间使用RF。

当元数据写入或更新时,写入或更新的行将被写入环中的一个节点,然后复制到n 个对等节点中(其中n 取决于群集大小)。大部分节点必须同意,然后才能提交任何内容,内容

的提交是使用paxos 算法强制执行的。这将确保所有作为平台一部分存储的数据和元数据的严格一致性。

下面我们将展示4 节点群集的元数据插入/更新的一个示例:

扩展时的性能也是NDFS 元数据的另一个重要结构。与传统的双控制器或“主”模型不同,每个Nutanix 节点负责整个平台元数据的一个子集。这消除了传统上允许群集中所有节点为元数据提供服务并进行管理的瓶颈现象。通过一致性哈希方案来尽量减少修改群集大小时键的重新分配(又称“添加/移除节点”)

当群集扩展时(例如从4 个扩展到8 个节点),为了确保“块感知”和可靠性,这些节点将被插入整个环中的节点之间。

下面我们将展示元数据“环”及其如何伸缩的一个示例:

Shadow Clones

Nutanix 分布式文件系统有一个称为“影子克隆”的功能,它支持“多读取者”场景下特定虚拟磁盘或VM 数据的分布式缓存。有关该功能的一个典型例子是,在VDI 部署期间,许多“链接克隆”会将读取请求转发到中心主VM 或“基准VM”。在VMware View 中,这被称为副本磁盘,通过所有链接的克隆读取,而在XenDesktop 中,这被称为MCS 主VM。这在任何可能有多个读取者的场景(如部署服务器、存储库等)中也会起作用。

数据或I/O 本地化是实现最高VM 性能的重要因素,也是NDFS 的关键结构。借助影子克隆,NDFS 将监控vDisk 访问趋势,这与监控数据本地化类似。但是,如果两个以上远程CVM(以及本地CVM)发出请求,并且所有请求都是读取I/O,则vDisk 将标记为不可变。一旦磁盘标记为不可变,则可通过每个向磁盘发出请求的CVM 在本地缓存vDisk (也称基准vDisk 的影子克隆)。

如此一来,每个节点上的VM 即可在本地读取基准VM 的vDisk。对于VDI 而言,这意味着副本磁盘可以通过每个节点进行缓存,所有针对基准的读取请求可以在本地获得服务。注意:为了不泛洪网络并有效利用缓存,只在读取时迁移数据。如果基准VM 已修改,将会放弃影子克隆并重新开始这一过程。影子克隆默认为禁用状态(在3.5 版及之前版本中),

可以使用以下NCLI 命令启用/禁用:ncli cluster edit-params

enable-shadow-clones=true

下面的示例将展示影子克隆的工作原理及其如何实现分布式缓存:

Elastic Dedupe Engine

弹性重复数据删除引擎是基于软件的NDFS 功能,可以在容量(HDD) 和性能(SSD/内存)层执行重复数据删除。在插入数据的过程中,会使用SHA-1 哈希以16K 的粒度为连续的数据流提取指纹。指纹只在插入数据时提取,之后则会永久性地存储到写入块的元数据中。这与传统方法相反,传统方法是利用后台扫描,需要重新读取数据,而Nutanix 直接在插入时提取指纹。对于能够在容量层执行重复数据删除的重复数据,则不需要扫描或重新读取数据,实际上可以删除重复副本。

注意:最初提取指纹时使用的是4K 的粒度,但在测试之后,16K 在重复数据删除和降低元数据开销这两方面的综合性能最佳。完成重复数据删除的数据保存到缓存中时,则使用4K。

下面的示例将展示弹性重复数据删除引擎伸缩和处理本地VM I/O 请求的方式:

当数据I/O 大小为64K 或更大时,在插入数据时会提取指纹。SHA-1 计算利用Intel 加速技术,这一过程仅产生非常小的CPU 开销。如果在插入数据时没有完成指纹提取(例如I/O 大小较小时),可以作为后台进程完成指纹提取。

弹性重复数据删除引擎不仅适用于容量磁盘层(HDD),而且适用于性能层(SSD/内存)。在确定重复数据后,依据相同指纹的多个副本,后台进程将使用NDFS MapReduce 框架(管理者)移除重复数据。对于正被读取的数据,数据会保存到NDFS 内容缓存,这是一个多层/池缓存。对具有相同指纹的数据的任何后续请求都将直接从缓存中提取。有关内容缓存和池结构的详细信息,请参阅I/O 路径概述中的“内容缓存”小节,或者单击此处。下面的示例将展示展示弹性重复数据删除引擎如何与NDFS I/O 路径进行交互:

网络和I/O

Nutanix 平台没有利用任何底板来实现节点间通信,只依靠标准10GbE 网络。专用私有网络上的虚拟机监控程序可以处理在Nutanix 节点上运行的VM 的所有存储I/O。虚拟机监控程序处理I/O 请求,然后将请求转发到本地CVM 上的私有IP。随后,CVM 将使用其外部IP,通过公有10GbE 网络对其他Nutanix 节点执行远程复制。对于所有读取请求,大多数情况下都可以在本地完成,而不需要利用10GbE 网络。

这意味着,利用公有10GbE 网络的流量只有NDFS 远程复制流量和VM 网络I/O。但是,如果CVM 发生故障或数据位于远程位置,CVM 会将请求转发到群集中的其他CVM。同时,群集范围内的任务(例如磁盘平衡)会在10GbE 网络上临时生成I/O。

下面的示例将展示VM 的I/O 路径如何与私有和公有10GbE 网络进行交互:

CVM Autopathing

对于NDFS,可靠性和灵活性即使不是最重要的部分,也是一个关键部分。作为一个分布式系统,NDFS 的作用是处理组件、服务和CVM 故障。本节将介绍如何处理CVM 故障(未来的更新中将介绍如何处理组件故障)。CVM 故障包括用户关闭CVM 电源、CVM 滚动升级或可能导致CVM 发生故障的任何事件。NDFS 有一个称为“自动寻路”的功能,当本地CVM 不可用时,则由另一个CVM 透明地处理I/O。

虚拟机监控程序和CVM 使用私有192.168.5.0 网络在专用vSwitch 上进行通信(前文已有详细说明)。这意味着,对于所有存储I/O,这一过程发生在CVM 的内部IP 地址上(192.168.5.2)。CVM 的外部IP 地址用于远程复制和CVM 通信。

下面的示例将展示此过程:

如果本地CVM 发生故障,之前由本地CVM 托管的本地192.168.5.2 地址将不可用。NDFS 将自动检测到这一中断,并通过10GbE 将这些I/O 重定向到群集中的另一个CVM。重新路由过程对主机上运行的虚拟机监控程序和VM 都是透明的。这意味着,即使CVM 电源已经关闭,VM 仍然能够继续为NDFS 执行I/O。NDFS 也能够自我修复,这意味着它将检测到CVM 已经关闭电源,并将自动重新启动或开启本地CVM 电源。一旦本地CVM 恢复并可用,流量将无缝地回传并由本地CVM 提供服务。

下面我们将展示故障CVM 的这一过程的图形表示:

磁盘平衡

NDFS 采用极其动态的平台设计,可以处理各种工作负载,并且一个群集可以混合使用多种异类节点:计算密集型(3050 等)和存储密集型(60X0 等)。混合使用具有较大存储容量的节点时,必须确保数据均匀分布。

NDFS 拥有一个称为“磁盘平衡”的本机功能,该功能用于确保数据在整个群集中均匀分布。磁盘平衡控制节点对其本地存储容量的利用率,并与NDFS ILM 集成。其目的是,一旦利用率达到一定阈值,就让节点之间的利用率保持均匀。

下面的示例将展示处于“不平衡”状态的混合群集(3050 + 6050) :

磁盘平衡利用NDFS 管理者框架,作为预定进程运行,并在超过阈值时运行(例如本地节点容量利用率> n %)。如果数据不平衡,管理者将确定需要移动的数据,并将任务分布到群集中的各个节点。

如果节点类型是同类(例如3050),利用率应特别均匀。但是,如果某个节点上运行的某些VM 写入的数据多于其他节点,则每个节点的容量利用率会有所倾斜。在这种情况下,磁盘平衡会开始运行,并将该节点上的最冷数据移动到群集中的其他节点。

如果节点类型是异类(例如3050 + 6020/50/70),或者某个节点用于“仅限存储”模式(不运行任何VM),则可能需要移动数据。

下面的示例将展示运行磁盘平衡后处于“平衡”状态的混合群集:

在有些情况下,客户可能需要以“仅限存储”状态运行某些节点,CVM 只在主要用于批量存储容量的节点上运行。

下面的示例将展示混合群集中的仅限存储节点,磁盘平衡将数据从活动VM 节点移动到该节点:

软件定义的控制器架构

如上所述(可能有无数次),Nutanix 平台是基于软件的解决方案,以“捆绑式的软件+硬件设备”进行销售。控制器VM 是绝大多数Nutanix 软件和逻辑所在的地方,它的设计初衷是一个可扩展的且可插拔的体系架构。

通过软件定义且不依赖任何硬件卸载或构造的一个重要优势在于可扩展性。与任何产品生命周期一样,它经常会推出改进功能和新功能。由于不依赖任何自定义ASIC/FPGA 或硬件功能,Nutanix 可以通过简单的软件更新来开发并部署这些新功能。这意味着,通过升级Nutanix 软件的当前版本,即可部署新功能(如重复数据删除)。这样还可以在传统硬件型号上部署较新的功能。

例如,在早期的硬件平台(例如2400)上,运行一个使用旧版Nutanix 软件的工作负载。当前运行的软件版本不提供重复数据删除功能,而此功能对工作负载大有益处。为了获得这些功能,您在工作负载运行过程中对Nutanix 软件版本执行滚动升级,现在便拥有了重复数据删除功能。整个过程就是这样简单。

与添加功能类似,在NDFS 中创建新“适配器”或接口是另一个重要功能。当产品首次发货时,它只支持来自虚拟机监控程序的I/O 使用iSCSI,而现在则包括NFS 和SMB。未来将能够为各种工作负载和虚拟机监控程序(HDFS 等)创建新适配器。同样,通过软件更新即可完成部署。

这与几乎所有传统基础架构相反,因为通常必须升级硬件或购买软件,才能获得“最前沿最优秀”的功能。Nutanix 则不同,因为所有功能都在软件中部署,它们可以在任何硬件平台、任何虚拟机监控程序上运行,并且通过简单的软件升级即可完成部署。

下面我们将展示软件定义的控制器框架的逻辑表现形式:

存储分层与优先级

上文中的“磁盘平衡”一节讨论了Nutanix 群集中的所有节点之间如何共用存储容量,以及如何使用ILM 将热数据保存到本地。类似的概念适用于磁盘分层,其中群集的SSD 和HDD 层属于群集范围,NDFS ILM 负责触发数据移动事件。

对于本地节点上运行的VM 生成的所有I/O,本地节点的SSD 层始终是优先级最高的层,但是群集的所有SSD 资源可用于群集内的所有节点。SSD 层将始终提供最高性能,它也是混合阵列需要管理的一个重要事项。

可以按照以下原则在较高级别上划分层优先级:

特定类型的资源(例如SSD、HDD 等)实现共用,形成群集范围内的存储层。这意味着,群集内的任何节点都可以利用整个层容量,无论是否位于本地。

下面我们将展示共用分层的一个高级示例:

一个常见的问题是,如果本地节点的SSD 满了将会出现什么情况?正如“磁盘平衡”一节所述,一个重要概念是尽量让磁盘层内的设备利用率保持均匀。如果某个本地节点的SSD 利用率很高,磁盘平衡将开始起作用,将本地SSD 上的最冷数据移动到群集中的其他SSD。这样可以释放本地SSD 上的空间,以便让本地节点写入到本地SSD,而不是通过网络。值得一提的是,所有CVM 和SSD 都可用于此远程I/O,以消除任何潜在的瓶颈,并修复通过网络执行I/O 的某些问题。

另一种情况是,当整体层利用率超过特定阈值

[curator_tier_usage_ilm_threshold_percent (Default=75)] 时,NDFS ILM 将开始起作用并作为管理者工作的一部分,将数据从SSD 层向下迁移到HDD 层。这将使利用率保持在上述阈值范围内,或者释放以下数量的空间[curator_tier_free_up_percent_by_ilm (Default=15)],取两者中较大者。需要向下迁移的数据使用最后一次访问时间进行选择。如果SSD 层利用率为95%,则SSD 层中20% 的数据将移动到HDD 层(95% –> 75%)。但是,如果利用率为80%,按照最少的层释放数量,只有15% 的数据会移动到HDD 层。

ntnx-bible-how-it-works-18.png(141.76 KB, 下载次数: 0)

下载附件保存到相册

2015-8-30 22:47 上传

NDFS ILM 将持续监控I/O 模式并按需要(向下/向上)迁移数据,同时还会将最热数据保存在本地,而不论其在哪一层。

可用性域

可用性域(也称节点/块/机架感知)是分布式系统在确定组件和数据位置时所遵循的一个关键结构。NDFS 当前具有节点和块感知功能,但随着群集大小不断增加,将增加机架感知功能。Nutanix 用“块”指代包含一个、两个或四个服务器“节点”的机架。注意:要激活块感知,必须使用3 个块。

例如,3450 是一个具有4 个节点的块。跨多个块分布角色或数据的原因在于,当一个块发生故障或需要维护时,系统可以不间断地继续运行。注意:在块中,冗余PSU 和风扇是唯一共享的组件。

感知可以分为几个关键领域:

?Data (The VM data)

?Metadata (Cassandra)

?配置数据(Zookeeper)

数据

借助NDFS,数据副本将写入到群集中的其他块,以确保在某个块发生故障时或计划停机时间,数据仍然可用。这同样适用于RF2 和RF3 场景以及块故障。

可以与“节点感知”做一个简单比较,在节点感知中,副本需要复制到另一个节点,从而在节点发生故障时提供保护。块感知在块发生中断时提供数据可用性保证,进一步加强了保护。下面我们将展示副本位置在有3 个块的部署中有何作用:

如果块发生故障,块感知将保持运行,重新复制的块将复制到群集中的其他块:

Metadata

Nutanix 利用经过大量修改的Cassandra 平台存储元数据和其他必要信息。Cassandra 利用环式结构并复制到环中的n 个对等位置,以确保数据一致性和可用性。

下面的示例将展示包含12 个节点的群集的Cassandra 环:

Cassandra 对等复制在整个环中以顺时针方向遍历各个节点。借助块感知功能,对等节点分布于各个块中,以确保同一个块上不会有两个对等节点。

下面我们将展示一个节点布局示例,将上述环转换为基于块的布局:

Nutanix超融合平台架构介绍

Nutanix超融合体系架构之:运行机制

数据保护 目前,Nutanix 平台使用复制因子(RF) 来确保节点或磁盘发生故障时数据的冗余和可用性。如“架构设计”部分所述,OpLog 充当一个临时区域,将传入的写入吸收到低延迟的SSD 层。将数据写入本地OpLog 时,在被主机确认(Ack) 为成功写入之前,数据将会同步复制到另外的一个或两个Nutanix CVM 的OpLog 中(取决于RF)。这将确保数据存在于至少两个独立的位置,且具有容错能力。所有节点均参与OpLog 复制以避免出现任何“热节点”并确保扩展时的线性性能。 然后,将数据异步排出到隐式维持RF 的盘区存储中。之后在节点或磁盘出现故障的情况下,会将数据在群集中的所有节点之间重新复制以维持RF。 下面我们将展示此过程的逻辑表现形式的一个示例: 数据位置 作为一个融合的(计算+存储)平台,I/O 和数据位置对与Nutanix 有关的群集和VM 性能至关重要。如前面I/O 路径中所述,所有读取/写入IO 均由本地控制器VM (CVM) 提

供服务,本地控制器VM 位于邻近常规VM 的每个虚拟机监控程序中。在CVM 的控制下,VM 的数据将在本地由CVM 提供服务并且位于本地磁盘中。当VM 从一个虚拟机监控程序节点移动到另一个时(或发生HA 事件时),最新迁移的VM 的数据将由现在的本地CVM 提供服务。在读取旧数据(存储在现在的远程节点/CVM 上)时,I/O 将由本地CVM 转发到远程CVM。所有写入I/O 将立即在本地出现。NDFS 会检测到I/O 从另一节点出现,并在后台将数据迁移到本地,现在将允许在本地为所有读取I/O 提供服务。为了不泛洪网络,只在读取时迁移数据。 下面我们将展示数据在虚拟机监控程序的节点之间移动时如何“跟随”VM 的一个示例: 可伸缩元数据 元数据是任何智能系统的核心,对文件系统或存储阵列而言甚至更为重要。就NDFS 而言,一些关键结构对于它的成功至关重要:它必须时刻保持正确(又称“严格一致性”),它必须可伸缩,而且它必须能够大规模执行。如前面架构部分所述,NDFS 使用“环式”结构作为键值存储,键值存储将存储重要元数据及其他平台数据(如状态等)。为了确保元数据的可用性和冗余,在奇数节点(如3、5 等)之间使用RF。 当元数据写入或更新时,写入或更新的行将被写入环中的一个节点,然后复制到n 个对等节点中(其中n 取决于群集大小)。大部分节点必须同意,然后才能提交任何内容,内容

超融合数据中心解决处理方案==

高校IT基础架构设施升级方案----SMARTX超融合+虚拟化解决方案

北京中科泰科技有限公司 一、当前高校数据中心的现状和问题 随着高校信息化建设的不断深入,各个部门各个院系都根据各自的业务需求建设了相应的应用系统,而且增加的速度非常快,数据量也是呈几何级数的增长,随之而来的也给机房带来新的挑战:第一,资源整合问题:各院系各部门烟囱式信息化建设,存在大量信息孤岛,资源无法共享。各自购买添加服务器和存储等硬件设施,资源的总体利用效率较低。第二,应用扩展问题:服务器托管模式,新应用部署需要频繁接入机房,布线、配置网络,部署时间长。大部分新应用没有对存储、备份、可靠性等进行统一规划,机房的硬件设施没有统一规划,网络拓扑结构越来越复杂,新增系统布线困难。第三,运维运营问题:由于信息中心人力资源有限,而各院系人员运维运营能力薄弱,导致信息中心工作压力越来越大,工作人员经常超负荷工作。第四,拥有成本和能耗问题:硬件资源分散在各个院系和部门,资源利用效率低,运维总体成本大,能耗高。第四,空间问题:每年大量投入新增硬件设施,增加机柜,机房空间越来越局促。 面对信息化建设的挑战,该如何利用新技术更好的支撑高校信息化建设,提供更好的IT服务,满足各个院系各个部门的期望?我们认为,采用目前国际上流行的最先进的超融合加虚拟化技术重新建立标准统一、安全

可扩展的超融合IT基础架构,重新定义数据中心,将IT设备以可水平扩展的资源池的方式提供给各个院系各个部门,达到资源利益效率最大化,同 时节省IT基础设施投资成本,节省数据中心能耗,实现绿色数据中心。二、虚拟化与高校IT基础设施 高校IT业务的迅猛发展要求IT基础设施将能满足其快速增长及变化的需求,传统IT架构已经被证实无法有效应对这种业务增长和变化的境况。服务器虚拟化技术的出现和兴起,高效的解决当前面临的一系列难题,将成为未来IT基础架构的发展方向。虚拟化技术,以按需、易扩展的方式获得所需的资源应用。提供的资源被称为虚拟资源,虚拟资源在使用者看来是可以无限扩展的,并且可以随时获取,按需使用。虚拟化技术带来了以下几个好处和变革: 1、资源利用更高效,节省成本 在虚拟化的架构下,硬件资源都被虚拟成计算、网络和存储资源,统一管理和并按需分配。这样可以避免重复建设,避免异构平台的产生,极大的提升IT资源的利用率,节省能耗,减少IT成本的投入。 2、管理复杂度大大降低 高校IT部门除了成本之外,最关心的是IT的敏捷性和管理型,虚拟化带来了敏捷性和可管理性上的飞跃,一个新业务、一个新网站或是一个新服务,可以在短时间内部署好,而不是数天和数周的准备,部署和测试。 3、横向扩展

VxRail超融合平台技术规格

PRODUCT OVERVIEW VCE VXRAIL? APPLIANCE The VCE VxRail? Appliance, the exclusive hyper-converged infrastructure appliance from VCE|EMC and VMware, is the easiest and fastest way to stand up a fully virtualized Software-Defined Data Center (SDDC) environment. With the power of a whole Storage Area Network (SAN) in just two rack units, it provides a simple, cost-effective hyper-converged solution that delivers compute, network, storage, virtualization, and management for a wide variety of applications and workloads. Built on the foundation of VMware Hyper-Converged software and managed through the familiar vCenter interface, the VxRail Appliance provides existing VMware customers an experience they are already familiar with. Seamless integration with existing VMware tools, such as vRealize Operations, lets customers leverage and extend their existing IT tools and processes. Additionally, the VxRail Appliance is discoverable and visible in VCE Vision? Intelligent Operations for a comprehensive IT core to edge management ecosystem. The VxRail Appliance is fully loaded with integrated mission-critical data services—including replication, backup, and cloud tiering—all at no additional charge. The VxRail Appliance incorporates data protection technology, including EMC RecoverPoint for VMs and VMware vSphere Data Protection. Integrated EMC CloudArray seamlessly extends the VxRail Appliance to public and private clouds to securely expand storage capacity without limits, providing an additional 10 TB of on-demand cloud tiering included per appliance. The VxRail Appliance architecture is a distributed system consisting of common modular building blocks that scale linearly from 1 to 16 2U/4 node appliances, up to 64 nodes in a cluster. Multiple compute, memory, and storage options deliver configurations to match any use case. A fully populated all-flash appliance supports up to 112 cores and up to 76 T B of raw storage. A 64-node all-flash cluster delivers 1,792 cores and 1,216 TB of raw storage, making it the industry’s most powerful HCIA to date to maximize performance and scale for applications that demand low latency. The VxRail Appliance is backed by a single point of world-class support for both hardware and software. The VxRail Appliance is available with EMC Enhanced and Premium support options, both of which include EMC ESRS for call home and proactive two-way remote connection for remote monitoring, diagnosis, and repair to ensure maximum availability. Detailed specifications and a comparison of the VxRail Appliances follows. VxRail

超融合数据中心规划

Q1:你们对数据中心的规划是如何考虑的? A1:Nutanix主要是做基础架构的公司,因此对于企业云数据中心的规划,是在IAAS层面上适当考虑与paas的结合,而对于基础架构来说,是基于超融合的标准模块化方式构建存储、计算一体化平台,在后续的版本中也会增加虚拟化平台Micro segment的内容. 在数据中心整体架构方面,会结合业界的网络、负载均衡等厂商方案,在企业云平台中予以集成,如上述的生态系统图。此外,对于数据中心基础架构规划方面比较全面的技术发展介绍,个人觉得ZDNet在13年的“软件定义与硬件重构”不错,是比较好的中文公开发行资料,可以结合当前的技术发展趋势作为参考。 Q2; 竞争分析可以介绍下吗? 主流的超融合之间的比较 A2:关于竞争分析,从技术角度讲会比较多,我下面引用一个用户在选择Nutanix时候的分析吧,他写的比较简洁.

这个用户从09年开始虚拟化,虚拟化软件是vSphere。经过前期对比,最终方案在Nutanix

和vSan间选择,最后他考虑1、兼容性对系统的影响——以前吃过很多兼容性造成的苦头,因此没有选择软件排他的vSAN;2、Nutanxi在这个用户的应用性能测试时有很好的表现和对比,应用测试主要是他们核心的SQL Server数据库,用的实际业务数据;3、保留一定的软件平台选择性也是用户考虑的一部分因素;因此最终这个用户选择了Nutanix。当然不同用户的关注点也可能会有所不同。 Q3: 请问Nutanix可以和Openstack云平台整合吗? A3:Nutanix可以和OpenStack云平台进行整合,通过一个或一组已定制的OVM,内含Openstack的驱动,如下图所示: Q4:Nutanix有节点数规模限制吗?会受到传统网络架构的限制吗? A4:节点规模数没有明确的限制,但在软件版本上有限制:标准版最大12节点,高级版和Ultimate版无限制,但实际部署时还是要根据网络、数据、应用的情况进行考虑,例如百思

超融合

什么叫“超融合基础架构 最近,深信服的收到不少业界朋友的咨询:“你们准备推出的超融合架构,究竟 是什么概念?” 其实,“超融合”这个概念,可以简单理解为:将虚拟计算平台和存储融合到一起,将每台服务器里面自带的硬盘组成存储池,以虚拟化的形式提供数据中心所需要的计算、网络、安全以及存储等IT基础架构。在这里,也讲解一下超融合相对于传统虚拟化方案的优势。 横向与纵向的扩展性 顾名思义,横向扩展就是当发现存储和计算资源不够用了,按需添加服务器即可。比如,当用户的共享存储写满了,用户不得不花大价钱去购买一个新的存储机柜,然而此时存储机柜的资源利用率是很低的。而使用超融合方案的用户,他们只需要投入较少的费用去购买一个新的服务器加入集群,即可扩展存储空间。 便捷提供多副本,提高数据安全 超融合方案可便捷支持2-3个副本。当某些服务器损坏时,若采用超融合方案,所需要的数据还会存在对应的副本里,工作还能正常进行。而对比于传统的共享存储,用户想做两个副本时,只好硬着头皮再买一个一模一样的存储设备做备份,增加了不少IT投资。 分布式存储,拉近计算和存储的距离 传统的共享存储在数据读写时,都需要通过网线或光纤进行数据传输。而超融合分布式的存储在读数据的时候,基本都是直接读取本地的副本数据,减少数据流经网线或光纤的时间,加快数据读取速度。 软硬件一体化,省钱省力省心

超融合方案所支持的软硬件一体化,即用户可以一次性轻松地把云数据中心部署好,其中包括服务器、服务器虚拟化、存储虚拟化等虚拟化软件。信服君做过调研对比,不少用户会分开购买硬件和软件,采购成本较高。同时,软硬件一体机在出厂时已将软件植入到硬件当中,并且已经通过兼容测试,用户可直接架到机房,通电并简单配置即可使用。 而相比于国外厂商,深信服的超融合方案会更加全面,包含计算资源虚拟化、存储资源虚拟化及网络资源虚拟化,并且提供完整的2-7层网络服务。当然,深信服君最后还得提醒大家一句,在选择超融合方案时,还是有很多东西需要考虑的,如产品安全可靠性、后期维护是否便捷、服务支持是否及时、采购成本对比等。服务器里面自带的硬盘组成存储池,以虚拟化的形式提供数据中心所需要的计算、网络、安全以及存储等IT基础架构。在这里,也讲解一下超融合相对于传统虚拟化方案的优势。

超融合数据中心项目-集成实施方案

超融合数据中心项目集成实施方案

1. 概览 项目立足于超融合数据中心建设趋势及需求,采用新一代超融合数据中心解决方案,建设成为简化 管理、高效复用、绿色环保及安全保护的基础架构,为新旧业务系统提供有力支撑。 2. 总体设计 2.1 总体规划拓扑 2.2 货物内容 LAN VMware vSphere 4 IBM HS22 Oracle Sun Server X2-4 Oracle Sun Server X2-4 Oracle VM IBM x3850 X5 IBM x3850 X5 VMware vSphere EMC VNX 5400IBM DS5020 IBM x3650M4 HDS AMS2300 DMZ IBM DS4700EMC VNX 5300EMC VNX 5300... SAN Citrix XenServer LIS ERP 图文 ... 耳鼻喉网站病案邮件防火墙 ... ...

2.2.1虚拟化迁移服务 本次虚拟化迁移服务包括《应用迁移清单》列出的的所有内网应用及外网除网站的其他应用迁移,其他应用迁移工作后续服务提供; 本次利旧设备重配置工作包括《设备利旧清单》中列出的所有设备,其他设备重配置工作后续服务提供; 本次备份系统部署实施因条件限制,先利旧一台服务器及本次存储,后续如需重配置连接备份存储或重新部署。 2.2.2数据库服务 本次数据库服务包括核心应用 HIS本地容灾复制部署实施工作,核心应用 LIS的应用迁移工作(首选P2V 转换,转换不成功再采用数据迁移方式进行迁移);其他故障恢复演练支持等服务后续提供; 3.集成实施方案 3.1EMCVxRail实施方案 3.1.1地址与用户名规划 3.1.1.1.IP地址信息

超融合架构解读

超融合架构解读

超融合可以说是目前业内最大的热点之一,大型厂商和创业公司纷纷投身其中。不过,与从业者的津津乐道相比,超融合的广大目标用户却对其缺乏足够的认识,甚至一些IT专业人士也还不知超融合究竟为何物。因此,在华为公司的支持下,企事录从即日起开设“FusionCube超融合大讲堂”,以每10天左右一期的节奏连载,帮助您深入了解超融合的方方面面。 本文作为开篇,先来说说超融合是什么…… 近几年来,超融合系统的热度越来越高,各种打着超融合旗号的公司和产品如雨后春笋般涌现,令人眼花缭乱,也引发了很多困惑:究竟什么是超融合系统?与融合系统是什么关系?一体机又是怎么回事? 最关键的是:超融合有什么用?回答了之前的问题,也就不难理解了。 基本概念与分类 无论从中英文的字面意义来理解,超融合(Hyperconverged)都应该是在融合(Converged)之后发展起来的——如果要分类,前者应该属于后者的一支。 IDC和Gartner也是这么认为的,虽然在细节上有所区别。 譬如,Gartner似乎很喜欢Integrated(集成)和Infrastructure(基础设施)这两个词。大的分类上,IDC所谓Converged Systems(融合系统),Gartner称为Integrated Systems(集成系统)。

IDC与Gartner对融合系统的大致分类(注:随时间推移略有变化) IDC将融合系统(Converged Systems)分为三类,前两类——集成系统(Integrated Systems)和认证参考系统(Certified Reference Systems)——主要是供应商构成不同,技术成分上基本没有区别,都是由服务器硬件、磁盘存储系统、网络设备供应商和基本构件/系统管理软件组成的供应商认证的预集成系统。 Gartner也有对应的分类,分别称为集成基础设施(Integrated Infrastructure)系统和参考架构(Reference Architecture)系统,合称融合基础设施(Converged Infrastructure,CI)。

超融合是安全的有力保障

超融合是安全的有力保障 为了更好地支持未来3~5年校园网的建设规划,陕西省行政学院迫切需对原有虚拟化平台进行改造。在2016年立项的智慧校园项目信息平台建设项目中,学院明确提出要建立一套完善的数据安全机制。 行业用户选择超融合解决方案的原因有很多种:有人希望借助超融合技术实现IT基础架构的高度整合,从而有效地简化管理并降低成本;有人则希望利用超融合解决方案替代传统的SAN存储,更好地支持“互联网+”应用;而陕西省行政学院之所以选择联想的超融合解决方案,主要目的还是确保整个系统和数据的安全。 兼顾两个系统 与普通的教育和培训机构不同,陕西省行政学院是培训公务员和国企领导干部,培养公共管理人员和政策研究人员,开展社会科学研究,为陕西省委、省政府提供决策咨询服务的机构。学院建有设备先进、覆盖全院的校园网络和各种现代化培训教学设施,具备同期在院培训四五百人的能力,并于2010年被国家行政学院列为全国首批教学科研基地。 正是因为参与培训的学员身份的特殊性,而且流动性

大,学院对于保证学员个人信息,以及学习信息的安全性提出了非常高的要求。另外,学院希望通过大量数据的积累,为今后的教育和培训提供决策支撑,同时实现快速的查询等。 随着信息化建设的不断深入和完善,学院目前已经完成了服务器虚拟化的整合,可以确保应用的安全,当某台服务器出现故障时,应用可以自动切换,但是系统架构仍然存在单点隐患,因为原有的系统中只有一台直连存储设备。随着新业务系统不断上线,原有虚拟化平台的隐患越来越明显。为了更好地支持未来3~5年校园网的建设规划,学院迫切需对原有虚拟化平台进行改造。在2016年立项的智慧校园项目信息平台建设项目中,学院明确提出要建立一套完善的数据安全机制。 据陕西省行政学院电子设备与信息管理处刘旭勇处长介绍,智慧校园项目信息平台建设项目于2016年4月开始筹备,学院针对数据安全这一问题进行了广泛而深入的调研,一方面要确保数据万无一失;另一方面,鉴于学院当前的培训规模和实际情况,又不能搞大投入,而是要追求高性价比。在这一原则指导下,项目方案于当年10月完成,11月开始进行建设,12月中旬整个项目基本完工。 学院原计划通过存储网关和增加新的SAN存储来构建存储资源池,以解决原有存储资源池的单点隐患。但是,通

超融合:架构演变和技术发展

超融合:架构演变和技术发展 开篇推荐: ?如何学习微服务大规模设计? (点击文字链接可阅读) 1、超融合:软件定义一切趋势下的诱人组合 超融合是以虚拟化为核心,将计算、存储、网络等虚拟资源融合到一台标准x86 服务器中形成基本架构单元,通过一整套虚拟化软件,实现存储、计算、网络等基础功能的虚拟化,从而使购买者到手不需要进行任何硬件的配置就可以直接使用。 “超”特指虚拟化,对应虚拟化计算架构。这一概念最早源自Nutanix 等存储初创厂商将Google/Facebook 等互联网厂商采用的计算存储融合架构用于虚拟化环境,为企业客户提供一种基于X86 硬件平台的计算存储融合产品或解决方案。超融合架构中最根本的变化是存储,由原先的集中共享式存储(SAN、NAS)转向软件定义存储,特别是分布式存储(如Object、Block、File 存储)。 “融合”是指计算和存储部署在同一个节点上,相当于多个组件部署在一个系统中,同时提供计算和存储能力。物理

融合系统中,计算和存储仍然可以是两个独立的组件,没有直接的相互依赖关系。超融合则重点以虚拟化计算为中心,计算和存储紧密相关,存储由虚拟机而非物理机 CVM(Controller VM)来控制并将分散的存储资源形成统一的存储池,而后再提供给Hypervisor 用于创建应用虚拟机。 超融合已从1.0 阶段发展至3.0 阶段,服务云平台化趋势明显,应用场景不断丰富。超融合1.0,特点是简单的硬件堆砌,将服务器、存储、网络设备打包进一个“盒子” 中;超融合2.0,其特点则是软件堆砌,一般是机架式服务器+分布式文件系统+第三方虚拟化+第三方云平台,具有更多的软件功能。 在1.0 和2.0 阶段,超融合和云之间仍旧有着“一步之遥”,并不能称之为“开箱即用”的云就绪系统,超融合步入3.0 阶段,呈现以下两个特点:

超融合技术介绍

超融合技术介绍

什么是流行?什么是火爆?对于一门IT技术来说就是,你要是没听过或者不了解,都会不好意思出门跟人聊天…而现今的超融合,就是这样一门技术。 超融合是超融合基础架构(HCI:Hyper-Converged Infrastructure)的简称。只要谈起Infra,那么必然就会牵扯到数据中心(DC)。是,超融合的准则是软件定义一切,是实现SDDC(软件定义数据中心)的终极技术路径。 如今绝大多数的数据中心基础架构的层次划分很清晰,对于物理架构分层,大概可以分为以太网络层、服务器层、光纤网络层和集中存储层。 超融合基础架构,主要基于分布式存储等技术来压缩传统SAN架构的服务器层、光纤网络层和存储层为一层,融合的这一层具体如何称呼我还不清楚,暂且称之为超融合层吧。超融合层的设备从物理层面来讲具备计算、网络(主要是存储网络)和存储功能。如下图: 就像在我们喜欢在吃汉堡之前习惯性的压一下,那样一口下去才能享受到整个汉堡的口感。举这个么比较亲民(Low)的例子主要是为了说明,超融合基础架构是从纵向进行压缩(融合)的,免去了复杂的SAN网络,朋友们再也不用担心光纤线的标签掉了之后,满机房开地板

去找线了…另外,完美的综合布线,一般只能在别人家的机房里看到,自己家的光交后面基本都跟瀑布一样… 当然超融合基础架构带来最大的利益远不止是这点,高IOPS和虚拟化支持等才是超融合的核心功能。 什么是Nutanix 提起超融合,免不了提到Nutanix。Nutanix的横空出世就好像海贼王里进入伟大航路后半段的超新星们一样,其风头之强、劲道之猛,已然开始威胁传统四皇的地位了。这里还需要介绍另一位超新星,那就是Docker了(请允许我为了我钟爱的Docker扯远了一点…) 就个人认知,Nutanix是一家基于软件来提供软硬件一体化超融合解决方案的公司,全球超融合技术的领跑者。目前全球市场份额占有率是第一,中国市场第三。 Nutanix的超融合软硬件解决方案到底能做什么,如下图: Nutanix提供了基于硬件层面的物理基础设施(Nutanix超融合服务器)和基于软件层面的虚拟基础设施(Nutanix AHV虚拟化)的一体化解决方案,实现从硬件层面融合计算、网络和存储层到软件层面的多种虚拟化平台支持的全面覆盖。看到这里就应该可以理解为啥四

超融合行业应用案例分析

超融合行业应用案例分析

目录 1.政府行业 (3) 1.1.山东省住建厅采用超融合架构建设协同办公系统; (3) 1.2.深信服助力淄博市高新区管委会改造传统数据中心 (4) 1.3.滨州市高新区采用深信服私有云打造智慧园区 (6) 1.4.莱芜国土局通过深信服超融合搭建新型数据中心 (8) 1.5.章丘市政府采用超融合架构实现业务系统改造 (10) 1.6.聊城市高新区财政局采用超融合架构进行业务系统新建 (11) 2.企业 (12) 2.1.深信服为淄博热力搭建超融合数据中心 (12) 2.2.深信服助力兖矿集团兴隆庄煤矿建设工业云平台 (14) 2.3.青岛维客集团采用超融合实现数据中心改造 (17) 2.4.山东渤海实业采用超融合架构进行业务系统升级 (18) 3.教育行业 (20) 3.1.深信服超融合助力沂源职教中心数字化校园建设 (20) 4.卫生行业 (21) 4.1.高青县人民医院采用超融合构建医院数据中心 (21)

1.政府行业 1.1.山东省住建厅采用超融合架构建设协同办公系统;【项目背景】 山东省住建厅于2003年建成的办公自动化系统,系统的软件和硬件设施已经无法满足信息化建设要求。据调研,省直部门基本上都实现了无纸化办公和移动办公系统。为了提高办公效率和管理水平,省住建厅继续建设协同办公自动化平台。 而本次协同办公系统的基础架构平台采用了超融合架构实现; 【解决方案】 在建设协同办公自动化平台时,原计划采用3台应用服务器、1台数据库服务器,1台存储,再配合一台防火墙实现系统安全防护;为了考虑后期基础平台的可拓展性以及整体运维,最后采用了4台双路X86服务器,运行了超融合系统,通过构建超融合资源池承载OA系统所需要的计算、存储、网络、安全资源;项目还采用了一套虚拟化的下一代应用防火墙实现安全防护;同时项目还部署了340点的并发桌面云。桌面云项目也是通过8台双路服务器部署超融合平台实现承载;

传统架构与超融合方案对比

一站式IT服务商杨瑞 134******** 服务热线 原客户方案 EMC超融合方案 描述 刀片 + 虚拟化 + 光纤存储 描述 光纤存储 + 超融合解决方案(深度集成虚拟化环境) 问题 1.此方案为传统架构,无法横向扩展。 2.数据过度集中,数据风险高,单台存储发生故障时,所有业务均会受影响。 3.缺乏虚机数据保护方案 4.运维管理不够方便 5.兼容性稳定性欠缺 6.扩展能力有限 优势 1.此方案架构先进,稳定成熟,支持横向扩展。 2.超融合方案中的软硬件均经过大量严格的兼容性稳定性测试,专门针对虚拟化环境而设计优化,内置丰富软件功能。 3.无需一次大规模采购,保护现有投资,延伸到云计算架构 描述 软硬件厂商为不同家,硬件为HP,软件为Vmware。描述 软硬件厂商均为EMC,Vmware为EMC控股子公司。 问题 1.从实施到售后,都由不同厂商或集成商商负责。 2.出现问题需要各厂商配合解决,容易出现推诿,影响处理效率。 3.HP目前国内的售后均由第三方紫光公司进行支持。优势 1.一体化方案,加电后15分钟即可开始部署虚拟化环境。 2.从实施到售后均由EMC原厂统一提供专业服务 描述 原存储仅为双控64GB缓存。 刀片单从配置上来看,性能可能占优,也可能存在“超配”情况。 描述 EMC存储缓存总共248GB 超融合配置48core,512GB内存,24TB存储空间,3.2TB缓存加速盘,8个万兆网口。 问题 1.HP存储的二级缓存只能读不能写,对数据库的写性能没有任何提升。 2.刀片为纯硬件产品,没有针对虚拟化做专门的设计与优化。 优势 1.EMC存储可以扩展到1TB二级缓存,可读可写,对性能提升有很大帮助。 2.超融合方案专门为虚拟化设计优化,性能均衡。 3.单台最大可以支持到200个VM,未来可以按需升级。描述 存储+刀片+网络+虚拟化,多套系统,多个管理员描述超融合简化运维,减轻运维人员压力 问题 1.管理界面较多,操作复杂 2.不同产品的运维要求不同,对运维人员的技能要求高 优势 1.上架15分钟即可交付使用,扩展新节点只需5分钟2.统一标准化界面 3.统一管理计算,存储,虚拟化等资源,运维管理简单化描述 多套系统需要同时运维 描述 超融合运维轻便 问题 1.占地空间大,占用机柜空间多。 2.系统耗能高。包括设备耗电,制冷成本。 3.需要运维人员具备多种专业技能,时间多用在底层维护上。 优势 1.一套超融合装置仅仅2U 2.能源消耗低 3.运维人员可以专注于系统整体的运行状况与性能调优。 描述传统备份方式描述虚拟带库+虚拟机连续性数据保护方案 问题 1.备份以固定时间执行,存在数据丢失风险,且不能及时恢复 2.没有专门针对虚拟机的数据保护方案 优势 1.与vCenter无缝集成,可以直接将虚机备份到备份设备中,无需借助专门的备份软件。 2.具有企业级重复数据消除功能,可将备份窗口缩减 90%,备份空间的需求减至原来的1/3,对网络带宽的需求减少达95% 3.快速恢复,恢复速度加快30% 4.可以与EMC备份设备集成扩展。 描述无。描述 1.VSAN+vSphere深度内核级集成 2.内含虚拟机连续性保护软件 3.内含Vmware Data Protection虚机数据保护套件 4.云就绪,内含EMC云管理软件与容量许可 5.内含运维管理软件 6.内含应用商店 问题用户需要为所需软件功能另外付费优势 深度整合丰富的软件功能,确保满足业务需求和数据安全。 以下为超融合内含软件功能。 虚机数据保护 除了备份外,还有专门针对虚机的连续性数据保护方案。无缝集成vCenter环境。 连续性数据保护精细到虚机VM级别,可以对运行重要业务 的虚机提供任意时间点回滚的保护方式,消除逻辑故障对虚机的影响。 还可以将虚机数据从本地到远程站点进行双向复制。存储虚拟化 超融合方案内置存储虚拟化软件VSAN,并且与vShpere内核级集成,系统开销小 管理软件超融合方案内置管理软件,远程收集并报告硬件和软件配 置,实时掌握应用程序,VM和整体硬件的状态,还可针对 可用性、性能和容量的状态警报和运行状况统计云整合超融合方案内置云管理软件,可将数据延伸到公有云,提高托管容量,创建可访问的在线归档。 功能扩展 内置应用商店,一键访问,随时下载经过验证的增值软件,增强用户体验。 总结 高级软件功能 ? 方案不能成为产品的简单堆积。要针对客户的业务需求,制定定制化的先进方案。 1.对于企业级关键业务而言,性能并不足以成为首要选择因素,稳定压到一切! 2.安全是方案的命脉,软件是方案的灵魂。 整体方案 厂商 配置性能 运维管理 运维成本 数据备份方式

IT超融合规划方案 v2

数据中心规划方案

目录 1.1数据中心方案设计原则 (3) 1.2超融合数据中心方案 (4) 1.3方案推荐配置 (9) 1.4N UTANIX NX-1065-G5介绍 (9) 1.5N UTANIX路坦力融合架构的优势 (10) 1.5.1 Prism 强大易用的管理框架 (10) 1.5.2 从最小规模起步 (10) 1.5.3 横向扩展优势 (10) 1.5.4 性能优势 (11) 1.5.5 数据保护和可靠性 (12) 1.6N UTANIX超融合应用场景 (13) 1.7超融合架构与传统架构对比 (19)

1.1数据中心方案设计原则 计算机系统设计必须适应当前信息化各项应用,又可面向未来信息化发展的需要,因此必须是高质量的。在方案设计时,需要遵循以下原则: (一)实用性和先进性 数据中心采用先进成熟的技术满足大规模数据综合业务的需求,兼顾相关的管理需求,尽可能采用先进的技术,使整个系统在相当一段时期内保持技术的先进性,以适应未来云计算信息化的发展的需要。 (二)安全可靠性 为保证各项业务应用,数据中心基础架构必须具有高可靠性,尽量避免系统的单点故障。要对网络结构、网络设备、服务器设备等各个方面进行高可靠性的设计和建设。在采用硬件备份、冗余等可靠性技术的基础上,采用相关的软件技术提供较强的管理机制、控制手段和事故监控与网络安全保密等技术措施提高整个数据中心的安全可靠性。 (三)灵活性和可扩展性 信息系统是一个不断发展的系统,所以它必须具有良好的灵活性和可扩展性,能够根据企业信息化不断深入发展的需要,方便灵活的扩展网络覆盖范围、扩大网络容量和提高网络的各层次节点的功能。具备支持多种通信媒体、多种物理接口的能力,提供技术升级、设备更新的灵活性。 (四)开放性和互连性 应具备与多种协议计算机通信网络互连互通的特性,确保系统的基础设施的作用可以充分的发挥。在结构上真正实现开放,基于开放式标准,包括各种局域网、广域网、计算机等,坚持统一规范的原则,从而为未来的发展奠定基础。 (五)经济性和投资保护

超融合云计算方案

超融合云计算方案(总24页) -CAL-FENGHAI.-(YICAI)-Company One1 -CAL-本页仅作为文档封面,使用请直接删除

目录 一. 总则 (4) 1.1 需求概述 (4) 1.2 建设目标 (7) 1.3 建设原则 (8) 二. 超融合云计算方案 (9) 2.1 方案拓扑图 ................................................... 错误!未定义书签。 2.2 方案描述 ..................................................... 错误!未定义书签。 2.3 方案优势 (10) 2.4 软件拓扑图 (9) 三. 方案设计说明 (11) 3.1 方案概要 ..................................................... 错误!未定义书签。 3.2 配置清单 ..................................................... 错误!未定义书签。 3.3 配置说明 ..................................................... 错误!未定义书签。 3.4 计算资源 ................................................................... 11 2016-11-15 XXXX 超融合云数据中心方案建议书

3.5 存储资源 (11) 3.5.1 高效性 ................................................ 错误!未定义书签。 3.5.2 可靠性 ................................................ 错误!未定义书签。 3.5.3 扩展能力 .............................................. 错误!未定义书签。 3.6 网络设计..................................................... 错误!未定义书签。 3.7 SDN 网络 (12) 3.7.1 VXLAN....................................................................................................... 错误!未定义书签。 3.7.2 分布式虚拟路由器 (12) 3.7.3 浮动IP地址 (16) 3.7.4 SNAT.......................................................................................................... 错误!未定义书签。 3.8 安全设计 (13) 3.8.1 平台安全 (14) 3.8.2 存储安全 (14) 3.8.3 虚拟化安全 (15) 3.8.4 网络安全 (15) 3.8.5 系统维护安全 (16) 四. 云计算平台软件............................................................................................................... 错误!未定义书签。 4.1 功能设计说明......................................................................................................... 错误!未定义书签。 4.1.1 多节点管理................................................................................................ 错误!未定义书签。 4.1.2 资源调度 .................................................................................................... 错误!未定义书签。 4.1.3 弹性磁盘管理............................................................................................ 错误!未定义书签。 4.1.4 虚拟机迁移................................................................................................ 错误!未定义书签。 4.2 云计算底层操作系统............................................................................................. 错误!未定义书签。 4.2.1 系统服务SLA............................................................................................ 错误!未定义书签。

FusionCube数据库超融合平台技术白皮书

FusionCube数据库超融合平台 技术白皮书

目录 2.1系统架构 (2) 2.1.1统一管理 (3) 2.1.2深度融合 (4) 2.1.3弹性扩容 (5) 2.1.4预集成 (5) 2.2分布式存储软件 (5) 2.2.1分布式机头 (6) 2.2.2分布式缓存 (6) 2.2.3精简配置 (7) 2.3高性能SSD存储 (8) 2.4高速IB交换网络 (9) 2.5可靠网络设计 (9) 3.1 E9000机框 (10) 3.2 E9000刀片 (11) 3.3 10GE交换 (14) 3.4 InfiniBand交换 (15) 4.1数据库基础设施配置规格指标 (17) 4.2 HANA一体机配置规格指标 (18)

1 引言 当今世界,越来越多的企业采用虚拟化与云计算技术来构建IT系统,提升IT系统的资源利用率,但同时面临如下挑战: ●基础设施平台部署和管理复杂,运维费用仍然维持增长趋势 ●安装部署复杂,硬软件来自多厂商,规划、部署、调优需要丰富的经验支撑 ●多厂商设备,售后支持界面多,解决问题慢 ●维护体系庞大(不同厂商硬件设备维护、虚拟平台管理) ●小规模数据中心优势不明显(人员要求高,上规模才有优势) ●扩充不灵活,业界数据库一体机大多采用固定规格配置,不能按业务需求灵活部署计算和存储资源,不能支持多种数据库。 客户越来越关注成本控制、业务敏捷、风险管控几方面,希望能拥有总成本低、新业务的上线时间快、资源可弹性伸缩、安全可靠、高性能的IT系统。 华为公司全力打造的华为FusionCube数据库超融合基础设施(Huawei FusionCubeHyper-Converged Infrastructure for Database)正是以计算/存储/网络融合、预集成、高性能、高可靠、高安全、业务快捷部署、统一运维管理、资源水平扩展为其设计理念,充分满足企业未来业务需求,帮助其IT系统转型以更快更好地应对日益激烈的竞争环境,实现与客户的共同成长。 本文档描述了FusionCube数据库超融合基础设施的架构、软硬件及其配置形态。本文档供销售工程师,渠道商,高级业务经理以及希望用FusionCube部署数据库相关IT设施的客户。

超融合数据中心项目验收方案

超融合数据中心项目验收方案 设备验收 我公司将按合同规定的设备到货方式供货,并按合同规定的方式对设备进行验收,验收标准以合同规定或以相应设备规格为准,验收结果以书面形式经各方认可签字盖章。合同设备运抵目的地后,由合同各方共同组成验收小组进行对合同设备进行验收。我方保证所提供的设备与合同相符,并且在运输途中没有损坏。验收方式如下(具体验收方式以合同为准): 设备数量清点验收 验收人员:用户、我方工程师、DELLEMC工程师; 验收内容及标准:检查外包装是否完好(有无运输损坏或其他形式的损坏),检查货物内容和数量与合同是否相符,软件许可数量及内容是否与合同相符。 验收结果:验收通过后,各方签订设备验收报告(签字盖章)。 设备加电验收 验收人员: 用户、我方工程师、DELLEMC工程师; 验收内容及标准:按照设备说明书、相关性能指标参数,确立各方认可的设备加电验收的具体内容。 验收结果:验收通过后,各方签订设备验收报告(签字盖章)。 工程验收 我公司将按合同规定进行工程实施,并按合同规定的方式对工程进行验收,验收标准以合同规定为准,验收结果以书面形式经各方认可签字盖章。工程实施结束后,由合同各方共同组成验收小组对工程进行验收。验收的前提条件是合同设备清单中所描述的设备功能都已经确认,并且系统已经能够正常运行。我方保证按合同要求进行工程实施,并且通过工程测试。工程验收分为工程初验和工程终验,验收方式如下(具体验收方式以合同为准):

工程初验 验收人员: 用户、我方工程师、DELLEMC工程师; 验收内容及标准: 工程实施结束后,由验收小组共同讨论确认工程测试、验收方式和内容。其中单项设备的测试和验收,依据设备原厂商提供的技术性能指标作为参照,进行设备的正确性、可靠性检查;系统集成测试和验收,以系统方案为基准进行测试,验收标准是满足系统方案设计要求。 针对本项目的测试内容如下: 验收结果:验收通过后,各方签订工程初验报告(签字盖章)。 工程终验 验收人员: 用户、我方工程师、DELLEMC工程师; 验收内容及标准: 系统试运行期结束或到达合同规定的终验日期,所有硬、软件性能技术指标达到系统方案设计要求时,对工程进行最终验收。在终验前的设备