模式识别——用身高和或体重数据进行性别分类

用身高和/或体重数据进行性别分类

1、【实验目的】

(1)掌握最小错误率Bayes 分类器的决策规则 (2)掌握Parzen 窗法 (3)掌握Fisher 线性判别方法 (4)熟练运用matlab 的相关知识。

2、【实验原理】

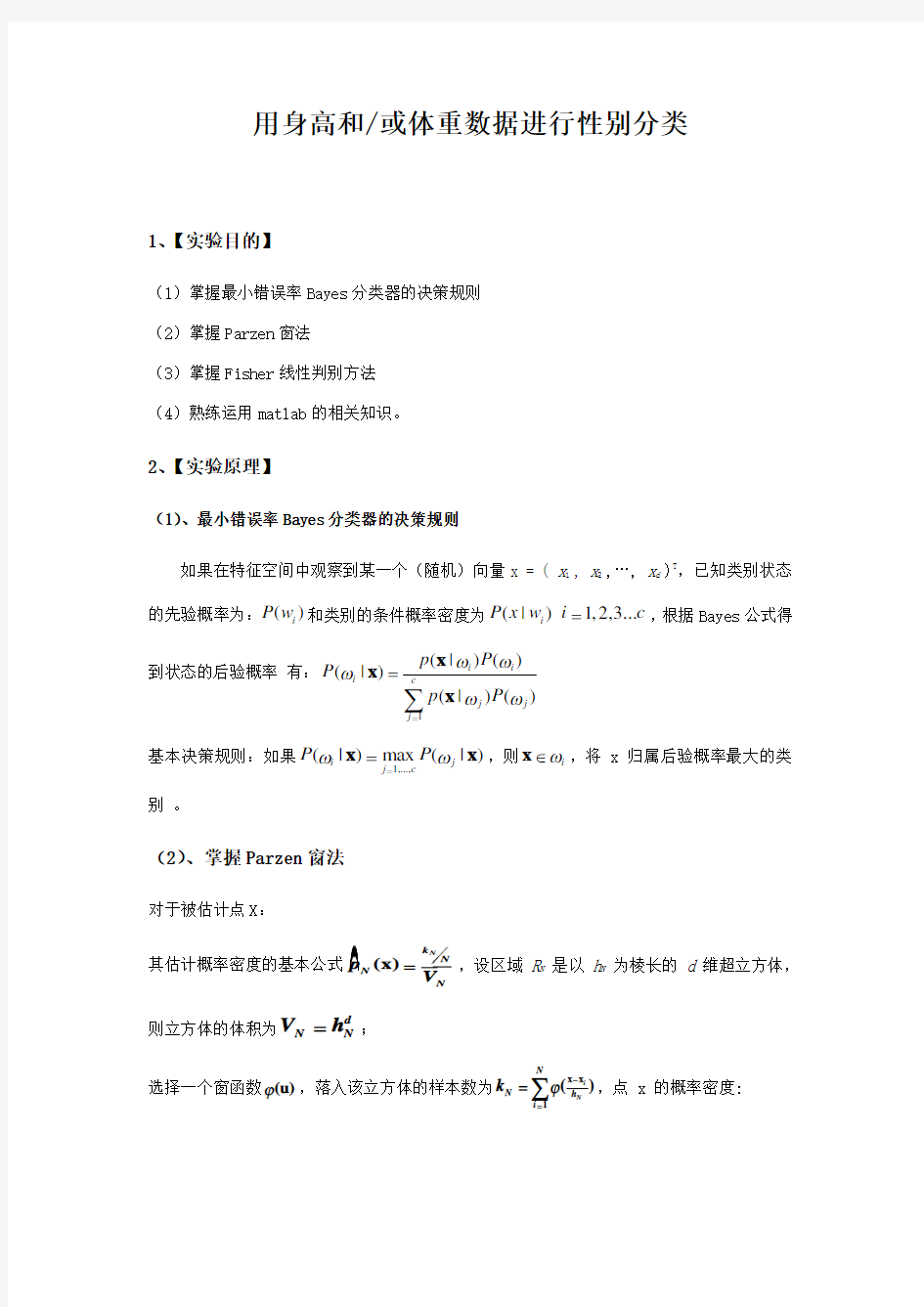

(1)、最小错误率Bayes 分类器的决策规则

如果在特征空间中观察到某一个(随机)向量x = ( x 1 , x 2 ,…, x d )T

,已知类别状态的先验概率为:()i P w 和类别的条件概率密度为(|)1,2,3...i P x w i c =,根据Bayes 公式得到状态的后验概率 有:1

(|)()

(|)(|)()

i i i c

j

j

j p P P p P ωωωωω==

∑x x x

基本决策规则:如果1,...,(|)max (|)i j j c

P P ωω==x x ,则i ω∈x ,将 x 归属后验概率最大的类

别 。

(2)、掌握Parzen 窗法

对于被估计点X :

其估计概率密度的基本公式(x)N

k N

N N

p V =,设区域 R N 是以 h N 为棱长的 d 维超立方体,

则立方体的体积为d

N

N V h =;

选择一个窗函数(u)?,落入该立方体的样本数为x x 1

(

)i

N

N

N h i k ?-==

∑,点 x 的概率密度:

x x 11

1(x)(

)N

i N

N

k N

N

N V h i N

p V N

?-==

=∑

其中核函数:x x 1i K(x,x )(

)i N

N

V h ?-=

,满足的条件:i (1) K(x,x )0≥;i (2) K(x,x )dx 1=?。

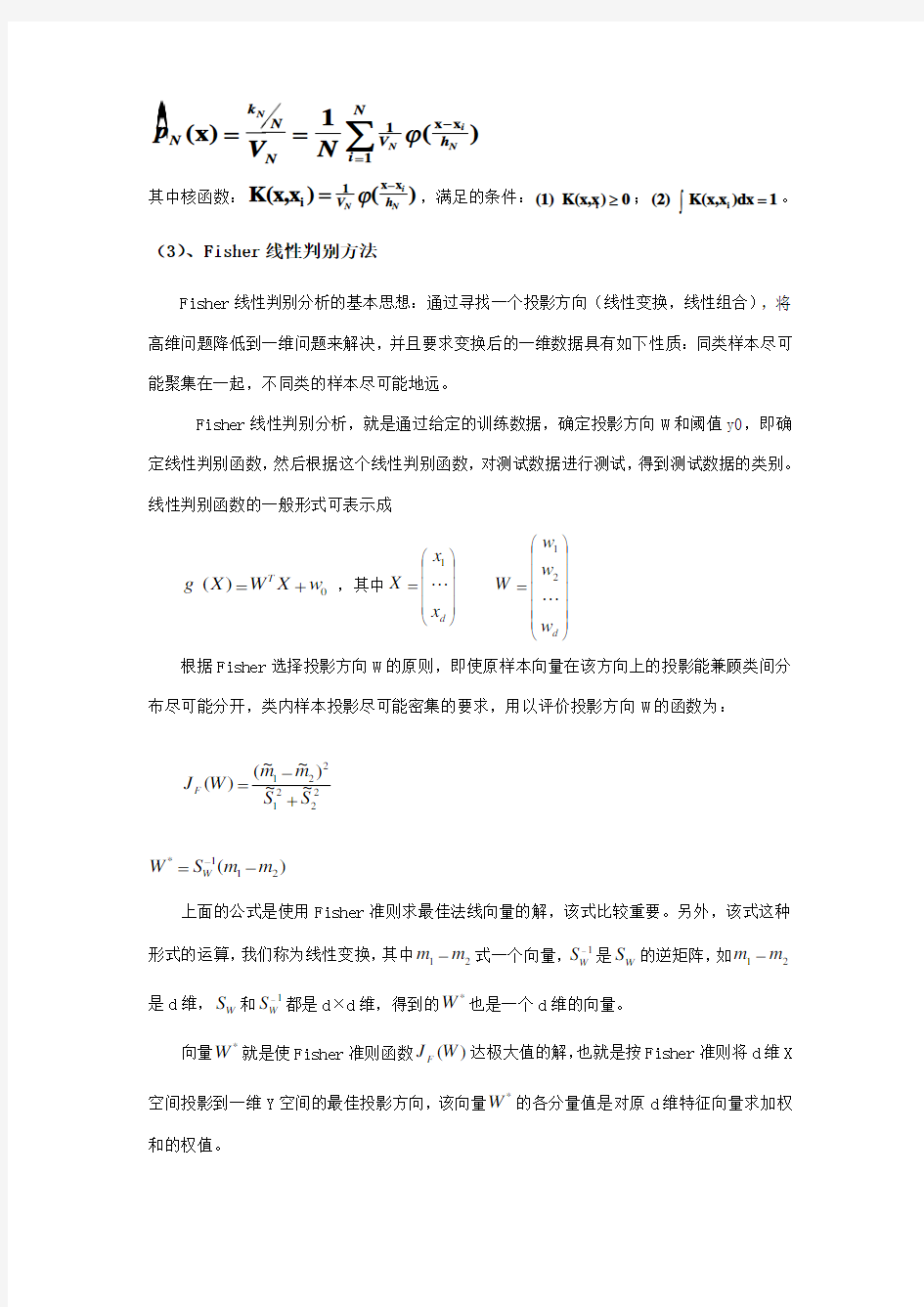

(3)、Fisher 线性判别方法

Fisher 线性判别分析的基本思想:通过寻找一个投影方向(线性变换,线性组合),将高维问题降低到一维问题来解决,并且要求变换后的一维数据具有如下性质:同类样本尽可能聚集在一起,不同类的样本尽可能地远。

Fisher 线性判别分析,就是通过给定的训练数据,确定投影方向W 和阈值y0,即确定线性判别函数,然后根据这个线性判别函数,对测试数据进行测试,得到测试数据的类别。 线性判别函数的一般形式可表示成

0)(w X W X g T

+= ,其中?????

??=d x x X 1 ?

?????

?

??=d w w w W 21 根据Fisher 选择投影方向W 的原则,即使原样本向量在该方向上的投影能兼顾类间分布尽可能分开,类内样本投影尽可能密集的要求,用以评价投影方向W 的函数为:

2

2

2122

1~~)~~()(S S m m W J F +-= )(211

*m m S W W -=-

上面的公式是使用Fisher 准则求最佳法线向量的解,该式比较重要。另外,该式这种

形式的运算,我们称为线性变换,其中21m m -式一个向量,1-W S 是W S 的逆矩阵,如21m m -是d 维,W S 和1-W S 都是d ×d 维,得到的*

W 也是一个d 维的向量。

向量*

W 就是使Fisher 准则函数)(W J F 达极大值的解,也就是按Fisher 准则将d 维X 空间投影到一维Y 空间的最佳投影方向,该向量*

W 的各分量值是对原d 维特征向量求加权和的权值。

以上讨论了线性判别函数加权向量W 的确定方法,并讨论了使Fisher 准则函数极大的d 维向量0W 的计算方法,但是判别函数中的另一项0W 尚未确定,一般可采用以下几种方法确定

0W 如

2

~~2

10m m W +-= 或者 m N N m N m N W ~~~2122110=++-= 或当1

)(ωp 与2)(ωp 已知时可用[]??????-+-+=2)(/)(ln 2

~~212

1210N N p p m m W ωω

当W0确定之后,则可按以下规则分类:

2

010ωω∈→->∈→->X w X W X w X W T

T

3、【实验内容及要求】

(1)、实验对象

女生的身高、体重数据 男生的身高、体重数据

----- 训练样本集

328个同学的身高、体重、性别数据 124个同学的身高、体重、性别数据

----- 测试样本集

(2)基本要求:

(1) 用和的数据作为训练样本集,建立Bayes 分类器,用测试样本数据对该分类器进行测试。调整特征、分类器等方面的一些因素,考察它们对分类器性能的影响,从而加深对所学内容的理解和感性认识。(试验直接设计线性分类器的方法,与基于概率密度估计的贝叶斯分离器进行比较)

(2) 试验非参数估计,体会与参数估计在适用情况、估计结果方面的异同。

4、【实验结果与分析】

(1)、Bayes分类器的实验结果与分析

A、对于 328个同学的身高、体重、性别数据的测试样本集:

A1、当先验概率为:男,女时:

身高分类错误个数: 15 身高分类错误率为: %

体重分类错误个数: 15 体重分类错误率为: %

【实验结果:】

A2、当先验概率为:男,女时:

身高分类错误个数: 19 身高分类错误率为: %体重分类错误个数: 14 体重分类错误率为: %

B、对于 124个同学的身高、体重、性别数据的测试样本集:

B1、当先验概率为:男,女时:

身高分类错误个数: 16 身高分类错误率为: %

体重分类错误个数: 21 体重分类错误率为: %

【实验结果:】

B2、当先验概率为:男,女时:

身高分类错误个数: 31 身高分类错误率为: %

体重分类错误个数: 35 体重分类错误率为: %

【结果分析:】

样本数据集中,男女先验概率为();样本数据集中,男女先验概率为()。

对比实验结果,可以发现身高的分类错误率都小于体重的分类错误率,样本集越大,各个特征对应的分类错误率就越小。假设先验概率为()的分类错误率小于假设先验概率为()的分类集,就算假设的先验概率与实际的很相近,可是结果不准确。

程序框图

导入样本数据

计算二维正态分布参数求类条件概率密度

计算先验概率和后验概率

构成分类器

测试训练样本

结果判断

满意不满意

调整参数

Bayes分类器源程序实验代码:

clear all;

load ;

load ;

%样本的分析

figure;

for i=1:250

if(i<79)

plot(datasetf1(i,2),datasetf1(i,1),'r+'); end

plot(datasetm1(i,2),datasetm1(i,1),'k*');

hold on;

end

title('样本数据');

xlabel('体重(Kg)'),ylabel('身高(cm)');

legend('男生','女生');

fid=fopen('','r');

test1=fscanf(fid,'%f %f %s',[3,inf]);

test=test1';

fclose(fid);

Fmean = mean(datasetf1);

Mmean = mean(datasetm1);

Fvar = std(datasetf1);

Mvar = std(datasetm1);

preF = ;

preM = ;

error = 0;

Nerror = 0;

%身高的决策

figure;

for i = 1:124

PFheight = normpdf(test(i,1),Fmean(1,1),Fvar(1,1)) ; PMheight = normpdf(test(i,1),Mmean(1,1),Mvar(1,1)) ; pFemale = preF*PFheight;

pMale = preM*PMheight;

if(pFemale plot(i,test(i,1),'k*'); if (test(i,3)=='f') Nerror = Nerror +1; end else plot(i,test(i,1),'r+'); if (test(i,3)=='M') Nerror = Nerror +1; end end hold on; end; error = Nerror/124*100; title('身高最小错误率Bayes分类'); xlabel('测试序号'),ylabel('身高(cm)'); sprintf('%s %d %s %%s','身高分类错误个数:',Nerror,'身高分类错误率为:',error,'%') %体重决策 figure; error = 0; Nerror = 0; for j= 1:124 PFweight = normpdf(test(j,2),Fmean(1,2),Fvar(1,2)) ; PMweight = normpdf(test(j,2),Mmean(1,2),Mvar(1,2)) ; pwFemale = preF*PFweight; pwMale = preM*PMweight; if(pwFemale plot(j,test(j,2),'k*'); if (test(j,3)=='f') Nerror = Nerror +1; end else plot(j,test(j,2),'r+'); if (test(j,3)=='M') Nerror = Nerror +1; end end hold on; end; error = Nerror/124*100; title('体重最小错误率Bayes分类'); xlabel('测试序号'),ylabel('体重(kg)'); sprintf('%s %d %s %%s','体重分类错误个数:',Nerror,'体重分类错误率为:',error,'%') (2)、Parzen窗法的实验结果与分析(先验概率为、对于中有78个女生和250个男生,共328个同学的身高、体重、性别数据的测试样本集的结果: 女生人数为:84;男生人数为:244;拒分人数:0; 女生错分人数:4;男生错分人数:33;总的错分人数:37; 女生分类错误率:;男生分类错误率:;总的分类错误率:; B、对于中有40个女生和84个男生,共124个同学的身高、体重、性别数据的测试样本集: 女生人数为:41;男生人数为:83;拒分人数:0; 女生错分人数:15;男生错分人数:6;总的错分人数:21; 女生分类错误率:;男生分类错误率:;总的分类错误率:; 结果分析: Parzen窗法的分类结果比较准确,样本集越大,错误率就越小。Parzen窗法的源程序代码: clc; clear all; [FH FW]=textread('','%f%f'); [MH MW]=textread('','%f%f'); FA=[FH FW]; MA=[MH MW]; N1=max(size(FA)); h1=7; hn1=h1/(sqrt(N1)); VN1=hn1^2; N2=max(size(MA)); h2=7; hn2=h2/(sqrt(N2)); VN2=hn2^2; [tH tW]=textread('','%f%f%*s'); X=[tH tW]; [M N]=size(X); s=zeros(M,1); error=0; errorgirl=0; errorboy=0; errorrate=0; errorgirlrate=0; errorboyrate=0; girl=0; boy=0; bad=0; for k=1:M A=[X(k,1) X(k,2)]; x=A; p=;%p为属于女生的先验概率,则1-p为男生的先验概率 pp=0; for i=1:N1 fa=[FA(i,1) FA(i,2)]; n=1/sqrt(2*pi)*exp*abs((x-fa)*(x-fa)')/(hn1^2)); pp=pp+n; end p1=1/VN1*pp'; y1=1/N1*p1;%是女生的条件概率密度函数 qq=0; for j=1:N2 ma=[MA(j,1) MA(j,2)]; m=1/sqrt(2*pi)*exp*abs((x-ma)*(x-ma)')/(hn2^2)); qq=m+qq; end q1=sum(1/VN2*qq'); y2=1/N2*q1;%男生的概率密度函数,即其条件概率 g=p*y1-(1-p)*y2;%g为判别函数 if g>0 if k<=50 s(k,1)=0;%判为女生 girl=girl+1; else errorboy=errorboy+1; end else if g<0 if k<=50 errorgirl=errorgirl+1; else s(k,1)=1;%判为男生 boy=boy+1; end else s(k,1)=-2;%不能判别是指等于0时的情况 bad=bad+1; end end end errorgirl errorboy bad girl=errorboy+girl boy=boy+errorgirl error=errorgirl+errorboy errorgirlrate=errorgirl/50 errorboyrate=errorboy/250 errorrate=error/M 什么是模式识别 1 模式识别的概念 模式识别[8]是一种从大量信息和数据出发,在专家经验和已有认识的基础上,利用计算机和数学推理的方法对形状、模式、曲线、数字、字符格式和图形自动完成识别的过程。模式识别包括相互关联的两个阶段,即学习阶段和实现阶段,前者是对样本进行特征选择,寻找分类的规律,后者是根据分类规律对未知样本集进行分类和识别。广义的模式识别属计算机科学中智能模拟的研究范畴,内容非常广泛,包括声音和语言识别、文字识别、指纹识别、声纳信号和地震信号分析、照片图片分析、化学模式识别等等。计算机模式识别实现了部分脑力劳动自动化。 模式识别--对表征事物或现象的各种形式的(数值的,文字的和逻辑关系的)信息进行处理和分析,以对事物或现象进行描述、辨认、分类和解释的过程,是信息科学和人工智能的重要组成部分。 模式还可分成抽象的和具体的两种形式。前者如意识、思想、议论等,属于概念识别研究的范畴,是人工智能的另一研究分支。我们所指的模式识别主要是对语音波形、地震波、心电图、脑电图、图片、文字、符号、三位物体和景物以及各种可以用物理的、化学的、生物的传感器对对象进行测量的具体模式进行分类和辨识。 模式识别问题指的是对一系列过程或事件的分类与描述,具有某些相类似的性质的过程或事件就分为一类。模式识别问题一般可以应用以下4种方法进行分析处理。 统计模式识别方法:统计模式识别方法是受数学中的决策理论的启发而产生的一种识别方法,它一般假定被识别的对象或经过特征提取向量是符合一定分布规律的随机变量。其基本思想是将特征提取阶段得到的特征向量定义在一个特征空间中,这个空间包含了所有的特征向量,不同的特征向量,或者说不同类别的对象都对应于空间中的一点。在分类阶段,则利用统计决策的原理对特征空间进行划分,从而达到识别不同特征的对象的目的。统计模式识别中个应用的统计决策分类理论相对比较成熟,研究的重点是特征提取。 人工神经网络模式识别:人工神经网络的研究起源于对生物神经系统的研究。人工神经网络区别于其他识别方法的最大特点是它对待识别的对象不要求有太多的分析与了解,具有一定的智能化处理的特点。 句法结构模式识别:句法结构模式识别着眼于对待识别对象的结构特征的描述。 在上述4种算法中,统计模式识别是最经典的分类识别方法,在图像模式识别中有着非常广泛的应用。 2 模式识别研究方向 模式识别研究主要集中在两方面,即研究生物体(包括人)是如何感知对象的,属于认知科学的范畴,以及在给定的任务下,如何用计算机实现模式识别的理论和方法。前者是生理学家、心理学家、生物学家和神经生理学家的研究内容,后者通过数学家、信息学专家和计算机科学工作着近几十年来的努力,已经取得了系统的研究成果。 一个计算机模式识别系统基本上事有三部分组成的[11],即数据采集、数据处理和分类决策或模型匹配。任何一种模式识别方法都首先要通过各种传感器把被研究对象的各种物理变量转换为计算机可以接受的数值或符号(串)集合。习惯上,称这种数值或符号(串)所组成的空间为模式空间。为了从这些数字或符号(串)中抽取出对识别有效的信息,必须对它进行处理,其中包括消除噪声,排除不相干的信号以及与对象的性质和采用的识别方法密切相关的特征的计算(如表征物体的形状、周长、面积等等)以及必要的变换(如为得到信号功率谱所进行的快速傅里叶变换)等。然后通过特征选择和提取或基元选择形成模式的特 用身高和/或体重数据进行性别分类 1、【实验目的】 (1)掌握最小错误率Bayes 分类器的决策规则 (2)掌握Parzen 窗法 (3)掌握Fisher 线性判别方法 (4)熟练运用matlab 的相关知识。 2、【实验原理】 (1)、最小错误率Bayes 分类器的决策规则 如果在特征空间中观察到某一个(随机)向量x = ( x 1 , x 2 ,…, x d )T ,已知类别状态的先验概率为:()i P w 和类别的条件概率密度为(|)1,2,3...i P x w i c =,根据Bayes 公式得到状态的后验概率 有:1 (|)() (|)(|)() i i i c j j j p P P p P ωωωωω== ∑x x x 基本决策规则:如果1,...,(|)max (|)i j j c P P ωω==x x ,则i ω∈x ,将 x 归属后验概率最大的类 别 。 (2)、掌握Parzen 窗法 对于被估计点X : 其估计概率密度的基本公式(x)N k N N N p V =,设区域 R N 是以 h N 为棱长的 d 维超立方体, 则立方体的体积为d N N V h =; 选择一个窗函数(u)?,落入该立方体的样本数为x x 1 ( )i N N N h i k ?-== ∑,点 x 的概率密度: x x 11 1(x)( )N i N N k N N N V h i N p V N ?-== =∑ 其中核函数:x x 1 i K(x,x )( )i N N V h ?-=,满足的条件:i (1) K(x,x )0≥;i (2) K(x,x )dx 1=?。 (3)、Fisher 线性判别方法 Fisher 线性判别分析的基本思想:通过寻找一个投影方向(线性变换,线性组合),将 经济运行模拟:身高体重分析 姓名:王萌萌 学号:20094120216 指导老师:乔雅君 院系:经济学院 身高体重分析 王萌萌 (河南财经政法大学经济学院郑州 450000) 一、实验目的 为了研究河南财经政法大学09级经济学院同学身高体重的关系,同时考虑性别因素对体重的影响。建立身高体重模型,首先对经济二班同学的身高体重回归分析。为了进一步说明身高对于体重的影响,同时对经济学院四个班同学的身高体重进行回归分析。 二、数据说明 表 1:09级经济学院四个班学生身高体重数据 以上数据由09级经济学院学生登记提供 三、实证分析 (一)09级经济二班同学的身高体重简单回归分析 1.建立模型 为了分析09级经济二班身高体重的关系。估计模型如下: u H W +?+?=10 其中W 代表体重(kg ),H 代表身高(cm),10??、代表回归系数,u 代表随机误差项。 2.估计结果 通过运行Eviews5.0估计结果如下: 表二:二班同学身高h (cm )体重w (kg )估计结果 Dependent Variable: W Method: Least Squares Date: 05/11/12 Time: 08:41 Sample: 1 43 Included observations: 43 Variable Coefficient Std. Error t-Statistic Prob. H 1.238985 0.152011 8.150606 0.0000 C -150.4884 25.78017 -5.837373 0.0000 R-squared 0.618365 Mean dependent var 59.41860 Adjusted R-squared 0.609056 S.D. dependent var 12.28284 S.E. of regression 7.679906 Akaike info criterion 6.960487 Sum squared resid 2418.219 Schwarz criterion 7.042403 Log likelihood -147.6505 F-statistic 66.43238 Durbin-Watson stat 1.950340 Prob(F-statistic) 0.000000 估计方程为: H W 238985.14884.150?+-= 25.78017 0.152011 t 值 -5.837373 8.150606 P 值 0.0000 0.0000 2R =0.618365,2R =0.609056,F=66.43238(P=0.0000) 3.模型检验 P 检验:由表一可知,p 值(0.0000),在0.05的显著水平下,p 值小于0.05,拒绝原假设。说明二班同学身高对体重的影响是显著的。 (二)二班数据加虚拟变量回归(加法模型) 1.建立模型 为了研究二班同学身高体重关系,并考虑性别因素建立模型如下 加法模型u S H W +?+?+?=210其中W 代表体重(kg ),H 代表身高(cm ),S 代表性别, ?? ?=女 男10S 为虚拟变量,10??、是回归系数,u 是随机误差项。 表三:二班同学身高体重模型考虑性别因素估计结果(加法模型) Dependent Variable: W Method: Least Squares Date: 05/11/12 Time: 09:12 Sample: 1 43 Included observations: 43 Variable Coefficient Std. Error t-Statistic Prob. S -7.591082 4.365116 -1.739033 0.0897 H 0.820754 0.282592 2.904375 0.0060 C -75.57212 49.89161 -1.514726 0.1377 人工智能与模式识别 摘要:信息技术的飞速发展使得人工智能的应用围变得越来越广,而模式识别作为其中的一个重要方面,一直是人工智能研究的重要方向。在介绍人工智能和模式识别的相关知识的同时,对人工智能在模式识别中的应用进行了一定的论述。模式识别是人类的一项基本智能,着20世纪40年代计算机的出现以及50年代人工智能的兴起,模式识别技术有了长足的发展。模式识别与统计学、心理学、语言学、计算机科学、生物学、控制论等都有关系。它与人工智能、图像处理的研究有交叉关系。模式识别的发展潜力巨大。 关键词:模式识别;数字识别;人脸识别中图分类号; Abstract: The rapid development of information technology makes the application of artificial intelligence become more and more widely. Pattern recognition, as one of the important aspects, has always been an important direction of artificial intelligence research. In the introduction of artificial intelligence and pattern recognition related knowledge at the same time, artificial intelligence in pattern recognition applications were discussed.Pattern recognition is a basic human intelligence, the emergence of the 20th century, 40 years of computer and the rise of artificial intelligence in the 1950s, pattern recognition technology has made great progress. Pattern recognition and statistics, psychology, ·在一个10类的模式识别问题中,有3类单独满足多类情况1,其余的类别满足多类情况2。问该模式识别问题所需判别函数的最少数目是多少? 应该是252142 6 *74132 7=+=+ =++C 其中加一是分别3类 和 7类 ·一个三类问题,其判别函数如下: d1(x)=-x1, d2(x)=x1+x2-1, d3(x)=x1-x2-1 (1)设这些函数是在多类情况1条件下确定的,绘出其判别界面和每一个模式类别的区域。 (2)设为多类情况2,并使:d12(x)= d1(x), d13(x)= d2(x), d23(x)= d3(x)。绘出其判别界面和多类情况2的区域。 (3)设d1(x), d2(x)和d3(x)是在多类情况3的条件下确定的,绘出其判别界面和每类的区域。 ·两类模式,每类包括5个3维不同的模式,且良好分布。如果它们是线性可分的,问权向量至少需要几个系数分量?假如要建立二次的多项式判别函数,又至少需要几个系数分量?(设模式的良好分布不因模式变化而改变。) 如果线性可分,则4个 建立二次的多项式判别函数,则102 5 C 个 ·(1)用感知器算法求下列模式分类的解向量w: ω1: {(0 0 0)T , (1 0 0)T , (1 0 1)T , (1 1 0)T } ω2: {(0 0 1)T , (0 1 1)T , (0 1 0)T , (1 1 1)T } 将属于ω2的训练样本乘以(-1),并写成增广向量的形式。 x ①=(0 0 0 1)T , x ②=(1 0 0 1)T , x ③=(1 0 1 1)T , x ④=(1 1 0 1)T x ⑤=(0 0 -1 -1)T , x ⑥=(0 -1 -1 -1)T , x ⑦=(0 -1 0 -1)T , x ⑧=(-1 -1 -1 -1)T 第一轮迭代:取C=1,w(1)=(0 0 0 0) T 因w T (1) x ① =(0 0 0 0)(0 0 0 1) T =0 ≯0,故w(2)=w(1)+ x ① =(0 0 0 1) 因w T (2) x ② =(0 0 0 1)(1 0 0 1) T =1>0,故w(3)=w(2)=(0 0 0 1)T 因w T (3)x ③=(0 0 0 1)(1 0 1 1)T =1>0,故w(4)=w(3) =(0 0 0 1)T 因w T (4)x ④=(0 0 0 1)(1 1 0 1)T =1>0,故w(5)=w(4)=(0 0 0 1)T 因w T (5)x ⑤=(0 0 0 1)(0 0 -1 -1)T =-1≯0,故w(6)=w(5)+ x ⑤=(0 0 -1 0)T 因w T (6)x ⑥=(0 0 -1 0)(0 -1 -1 -1)T =1>0,故w(7)=w(6)=(0 0 -1 0)T 因w T (7)x ⑦=(0 0 -1 0)(0 -1 0 -1)T =0≯0,故w(8)=w(7)+ x ⑦=(0 -1 -1 -1)T 因w T (8)x ⑧=(0 -1 -1 -1)(-1 -1 -1 -1)T =3>0,故w(9)=w(8) =(0 -1 -1 -1)T 因为只有对全部模式都能正确判别的权向量才是正确的解,因此需进行第二轮迭代。 第二轮迭代: 因w T (9)x ①=(0 -1 -1 -1)(0 0 0 1)T =-1≯0,故w(10)=w(9)+ x ① =(0 -1 -1 0)T 用身高和体重数据进行性别分类的实验报告(二) 一、 基本要求 1、试验非参数估计,体会与参数估计在适用情况、估计结果方面的异同。 2、试验直接设计线性分类器的方法,与基于概率密度估计的贝叶斯分类器进行比较。 3、体会留一法估计错误率的方法和结果。 二、具体做法 1、在第一次实验中,挑选一次用身高作为特征,并且先验概率分别为男生0.5,女生0.5的情况。改用Parzen 窗法或者k n 近邻法估计概率密度函数,得出贝叶斯分类器,对测试样本进行测试,比较与参数估计基础上得到的分类器和分类性能的差别。 2、同时采用身高和体重数据作为特征,用Fisher 线性判别方法求分类器,将该分类器应用到训练和测试样本,考察训练和测试错误情况。将训练样本和求得的决策边界画到图上,同时把以往用Bayes 方法求得的分类器也画到图上,比较结果的异同。 3、选择上述或以前实验的任意一种方法,用留一法在训练集上估计错误率,与在测试集上得到的错误率进行比较。 三、原理简述及程序框图 1、挑选身高(身高与体重)为特征,选择先验概率为男生0.5女生0.5的一组用Parzen 窗法来求概率密度函数,再用贝叶斯分类器进行分类。 以身高为例 本次实验我们组选用的是正态函数窗,即21()2u u φ?? = -???? ,窗宽为N h h =h 是调节的参量,N 是样本个数) d N N V h =,(d 表示维度)。因为区域是一维的,所以体积为N n V h =。Parzen 公式为()?N P x =111N i i N N x x N V h φ=??- ???∑。 故女生的条件概率密度为11111111N i i n x x p N VN h φ=??-= ??? ∑ 1.简述模式的概念及其直观特性,模式识别的分类,有哪几种方法。(6’) 答(1):什么是模式?广义地说,存在于时间和空间中可观察的物体,如果我们可以区别它们是否相同或是否相似,都可以称之为模式。 模式所指的不是事物本身,而是从事物获得的信息,因此,模式往往表现为具有时间和空间分布的信息。 模式的直观特性:可观察性;可区分性;相似性。 答(2):模式识别的分类: 假说的两种获得方法(模式识别进行学习的两种方法): ●监督学习、概念驱动或归纳假说; ●非监督学习、数据驱动或演绎假说。 模式分类的主要方法: ●数据聚类:用某种相似性度量的方法将原始数据组织成有意义的和有用的各种数据 集。是一种非监督学习的方法,解决方案是数据驱动的。 ●统计分类:基于概率统计模型得到各类别的特征向量的分布,以取得分类的方法。 特征向量分布的获得是基于一个类别已知的训练样本集。是一种监督分类的方法, 分类器是概念驱动的。 ●结构模式识别:该方法通过考虑识别对象的各部分之间的联系来达到识别分类的目 的。(句法模式识别) ●神经网络:由一系列互相联系的、相同的单元(神经元)组成。相互间的联系可以 在不同的神经元之间传递增强或抑制信号。增强或抑制是通过调整神经元相互间联 系的权重系数来(weight)实现。神经网络可以实现监督和非监督学习条件下的分 类。 2.什么是神经网络?有什么主要特点?选择神经网络模式应该考虑什么因素? (8’) 答(1):所谓人工神经网络就是基于模仿生物大脑的结构和功能而构成的一种信息处 理系统(计算机)。由于我们建立的信息处理系统实际上是模仿生理神经网络,因此称它为人工神经网络。这种网络依靠系统的复杂程度,通过调整内部大量节点之间相互连接的关系,从而达到处理信息的目的。 人工神经网络的两种操作过程:训练学习、正常操作(回忆操作)。 答(2):人工神经网络的特点: ●固有的并行结构和并行处理; ●知识的分布存储; ●有较强的容错性; ●有一定的自适应性; 人工神经网络的局限性: ●人工神经网络不适于高精度的计算; ●人工神经网络不适于做类似顺序计数的工作; ●人工神经网络的学习和训练往往是一个艰难的过程; ●人工神经网络必须克服时间域顺序处理方面的困难; ●硬件限制; ●正确的训练数据的收集。 答(3):选取人工神经网络模型,要基于应用的要求和人工神经网络模型的能力间的 匹配,主要考虑因素包括: 模式识别与机器学习期末考查 思考题 1:简述模式识别与机器学习研究的共同问题和各自的研究侧重点。 机器学习是研究让机器(计算机)从经验和数据获得知识或提高自身能力的科学。 机器学习和模式识别是分别从计算机科学和工程的角度发展起来的。然而近年来,由于它们关心的很多共同问题(分类、聚类、特征选择、信息融合等),这两个领域的界限越来越模糊。机器学习和模式识别的理论和方法可用来解决很多机器感知和信息处理的问题,其中包括图像/视频分析、(文本、语音、印刷、手写)文档分析、信息检索和网络搜索等。近年来,机器学习和模式识别的研究吸引了越来越多的研究者,理论和方法的进步促进了工程应用中识别性能的明显提高。 机器学习:要使计算机具有知识一般有两种方法;一种是由知识工程师将有关的知识归纳、整理,并且表示为计算机可以接受、处理的方式输入计算机。另一种是使计算机本身有获得知识的能力,它可以学习人类已有的知识,并且在实践过程中不总结、完善,这种方式称为机器学习。机器学习的研究,主要在以下三个方面进行:一是研究人类学习的机理、人脑思维的过程;和机器学习的方法;以及建立针对具体任务的学习系统。机器学习的研究是在信息科学、脑科学、神经心理学、逻辑学、模糊数学等多种学科基础上的。依赖于这些学科而共同发展。目前已经取得很大的进展,但还没有能完全解决问题。 模式识别:模式识别是研究如何使机器具有感知能力,主要研究视觉模式和听觉模式的识别。如识别物体、地形、图像、字体(如签字)等。在日常生活各方面以及军事上都有广大的用途。近年来迅速发展起来应用模糊数学模式、人工神经网络模式的方法逐渐取代传统的用统计模式和结构模式的识别方法。特别神经网络方法在模式识别中取得较大进展。理解自然语言计算机如能“听懂”人的语言(如汉语、英语等),便可以直接用口语操作计算机,这将给人们带来极大的便利。计算机理解自然语言的研究有以下三个目标:一是计算机能正确理解人类的自然语言输入的信息,并能正确答复(或响应)输入的信息。二是计算机对输入的信息能产生相应的摘要,而且复述输入的内容。三是计算机能把输入的自然语言翻译成要求的另一种语言,如将汉语译成英语或将英语译成汉语等。目前,研究计算机进行文字或语言的自动翻译,人们作了大量的尝试,还没有找到最佳的方法,有待于更进一步深入探索。 机器学习今后主要的研究方向如下: 1)人类学习机制的研究; 第一章 绪论 1.什么是模式?具体事物所具有的信息。 模式所指的不是事物本身,而是我们从事物中获得的___信息__。 2.模式识别的定义?让计算机来判断事物。 3.模式识别系统主要由哪些部分组成?数据获取—预处理—特征提取与选择—分类器设计/ 分类决策。 第二章 贝叶斯决策理论 1.最小错误率贝叶斯决策过程? 答:已知先验概率,类条件概率。利用贝叶斯公式 得到后验概率。根据后验概率大小进行决策分析。 2.最小错误率贝叶斯分类器设计过程? 答:根据训练数据求出先验概率 类条件概率分布 利用贝叶斯公式得到后验概率 如果输入待测样本X ,计算X 的后验概率根据后验概率大小进行分类决策分析。 3.最小错误率贝叶斯决策规则有哪几种常用的表示形式? 答: 4.贝叶斯决策为什么称为最小错误率贝叶斯决策? 答:最小错误率Bayes 决策使得每个观测值下的条件错误率最小因而保证了(平均)错误率 最小。Bayes 决策是最优决策:即,能使决策错误率最小。 5.贝叶斯决策是由先验概率和(类条件概率)概率,推导(后验概率)概率,然后利用这个概率进行决策。 6.利用乘法法则和全概率公式证明贝叶斯公式 答:∑====m j Aj p Aj B p B p A p A B p B p B A p AB p 1) ()|()() ()|()()|()(所以推出贝叶斯公式 7.朴素贝叶斯方法的条件独立假设是(P(x| ωi) =P(x1, x2, …, xn | ωi) = P(x1| ωi) P(x2| ωi)… P(xn| ωi)) 8.怎样利用朴素贝叶斯方法获得各个属性的类条件概率分布? 答:假设各属性独立,P(x| ωi) =P(x1, x2, …, xn | ωi) = P(x1| ωi) P(x2| ωi)… P(xn| ωi) 后验概率:P(ωi|x) = P(ωi) P(x1| ωi) P(x2| ωi)… P(xn| ωi) 类别清晰的直接分类算,如果是数据连续的,假设属性服从正态分布,算出每个类的均值方差,最后得到类条件概率分布。 均值:∑==m i xi m x mean 11)( 方差:2)^(11)var(1∑=--=m i x xi m x 9.计算属性Marital Status 的类条件概率分布 给表格计算,婚姻状况几个类别和分类几个就求出多少个类条件概率。 ???∈>=<2 11221_,)(/)(_)|()|()(w w x w p w p w x p w x p x l 则如果∑==21 )()|()()|()|(j j j i i i w P w x P w P w x P x w P 2,1),(=i w P i 2,1),|(=i w x p i ∑==2 1)()|()()|()|(j j j i i i w P w x P w P w x P x w P ∑=== M j j j i i i i i A P A B P A P A B P B P A P A B P B A P 1) ()| ()()|()()()|()|( 用身高和体重数据进行性别分类的实验报告 一、基本要求: 1.用FAMALE.TXT和MALE.TXT的数据作为训练样本集,建立Bayes分类器,用测试样本数据对该分类器进行测试。调整特征、分类器等方面的一些因素,考察它们对分类器性能的影响,从而加深对所学内容的理解和感性认识。二、具体做法: (1)应用单个特征进行实验:以(a)身高或者(b)体重数据作为特征,在正态分布假设下利用最大似然法或者贝叶斯估计法估计分布密度参数,建立最小错误率Bayes分类器,写出得到的决策规则,将该分类器应用到测试样本,考察测试错误情况。在分类器设计时可以考察采用不同先验概率(如0.5对0.5, 0.75对0.25, 0.9对0.1等)进行实验,考察对决策规则和错误率的影响。 (2)应用两个特征进行实验:同时采用身高和体重数据作为特征,分别假设二者相关或不相关,在正态分布假设下估计概率密度,建立最小错误率Bayes分类器,写出得到的决策规则,将该分类器应用到训练/测试样本,考察训练/测试错误情况。比较相关假设和不相关假设下结果的差异。在分类器设计时可以考察采用不同先验概率(如0.5 vs. 0.5, 0.75 vs. 0.25, 0.9 vs. 0.1等)进行实验,考察对决策和错误率的影响。 (3)自行给出一个决策表,采用最小风险的Bayes决策重复上面的某个或全部实验。 三、原理简述及程序框图 最小错误率Bayes分类器 (1)基于身高 第一步求出训练样本的方差和期望 第二步利用单变量正态分布公式算出条件概率 第三步将前两步的值带入贝叶斯公式 第四步 若pF>=pM ,则判断其为第一类,反之,第二类 (2-1) 假设身高与体重不相关 令协方差矩阵次对角元素为零 判别函数可简化为()0T T i i i i g x x W x w x w =++ 其中 11 2 i i W -=-∑,1i i w μ-=∑ ()1 01122 i T i i i i w u u In InP ω-=-∑-∑+ 具体算法步骤如下: 第一步将训练样本集数据转为矩阵FA ,MA 。 第二步分别对FA ,MA 求取协方差12,∑∑,令协方差矩阵次对角 元素为零,平均值12,μμ并输入先验概率()()12,P P ωω 第三步将第二步所得数值代入判别函数表达式得()()12,g x g x 。 第四步将待测样本集数据转为矩阵T ,将T 中数值依次代()()12g x g x - ,若()()120g x g x ->,则判断其为第一类,反之,第二类。 题型: 1.填空题5题 填空题2.名词解释4题 3.问答题4题 4.计算作图题3题 5.综合计算题1题 备注1:没有整理第一章和第六章,老师说不考的 备注2:非线性判别函数相关概念P69 概率相关定义、性质、公式P83以后 最小错误率贝叶斯决策公式P85 最小风险贝叶斯P86 正态贝叶斯P90 综合计算有可能是第六次作业 一、填空题 物以类聚人以群分体现的是聚类分析的基本思想。 模式识别分类:1.从实现方法来分模式识别分为监督分类和非监督分类;2.从理论上来分, 有统计模式识别,统计模式识别,模糊模式识别,神经网络模式识别法 聚类分析是按照不同对象之间的差异,根据距离函数的规律做模式分类的。 模式的特性:可观察性、可区分性、相似性 模式识别的任务:一是研究生物体(包括人)是如何感知对象的,二是如何用计算机实现 模式识别的理论和方法。 计算机的发展方向:1.神经网络计算机--模拟人的大脑思维;2.生物计算机--运用生 物工程技术、蛋白分子作芯片; 3.光计算机--用光作为信息载体,通过对光的处理来完成对信息的处理。 训练学习方法:监督学习、无监督学习(无先验知识,甚至类别数也未知)。 统计模式识别有:1.聚类分析法(非监督);2.判决函数法/几何分类法(监督);3.基于 统计决策的概率分类法 - 以模式集在特征空间中分布的类概率密度函数为基础,对总体特 征进行研究,以取得分类的方法 数据的标准化目的:消除各个分量之间数值范围大小对算法的影响 模式识别系统的基本构成:书P7 聚类过程遵循的基本步骤:特征选择;近邻测度;聚类准则;聚类算法;结果验证;结果 判定。 相似测度基础:以两矢量的方向是否相近作为考虑的基础,矢量长度并不重要。 确定聚类准则的两种方式:阈值准则,函数准则 基于距离阈值的聚类算法——分解聚类:近邻聚类法;最大最小距离聚类法 类间距离计算准则:1)最短距离法2)最长距离法 3)中间距离法4)重心法5)类平均距 离法6)离差平方和法P24 系统聚类法——合并的思想 用于随机模式分类识别的方法,通常称为贝叶斯判决。 BAYES 决策常用的准则:最小错误率;最小风险 错误率的计算或估计方法:①按理论公式计算;②计算错误率上界;③实验估计。 未来若干次作业需要用到的数据文件: ●FAMALE.TXT 50个女生的身高、体重数据 ●MALE.TXT 50个男生的身高、体重数据 ----- 训练样本集 ●test1.txt 35个同学的身高、体重、性别数据(15个女生、20个男生) ●test2.txt 300个同学的身高、体重、性别数据(50个女生、250个男生) ----- 测试样本集 作业. 用身高和/或体重数据进行性别分类的实验(一) 基本要求: 用FAMALE.TXT和MALE.TXT的数据作为训练样本集,建立Bayes分类器,用测试样本数据对该分类器进行测试。调整特征、分类器等方面的一些因素,考察它们对分类器性能的影响,从而加深对所学内容的理解和感性认识。 具体做法: 1.应用单个特征进行实验:以(a)身高或者(b)体重数据作为特征,在正态分布假设下利用最大似然法或者贝叶斯估计法估计分布密度参数,建立最小错误率Bayes分类器,写出得到的决策规则,将该分类器应用到测试样本,考察测试错误情况。在分类器设计时可以考察采用不同先验概率(如0.5对 0.5, 0.75对0.25, 0.9对0.1等)进行实验,考察对决策规则和错误率的影响。2.应用两个特征进行实验:同时采用身高和体重数据作为特征,分别假设二者相关或不相关,在正态分布假设下估计概率密度,建立最小错误率Bayes分类器,写出得到的决策规则,将该分类器应用到训练/测试样本,考察训练/测试错误情况。比较相关假设和不相关假设下结果的差异。在分类器设计时可以考察采用不同先验概率(如0.5 vs. 0.5, 0.75 vs. 0.25, 0.9 vs. 0.1等)进行 模式识别简介 Pattern recognition 诞生 狗的嗅觉的灵敏度非常高,大约是人的50至100倍。狗通过这项特异的功能来识别各种各样的东西,帮助人类完成一些鉴别工作。不仅如此,识别也是人类的一项基本技能,人们无时无处的在进行“模式识别”,古人有一成语“察言观色”表达的正是这个意思。 模式识别是人类的一项基本智能,在日常生活中,人们经常在进行“模式识别”。随着20世纪40年代计算机的出现以及50年代人工智能的兴起,人们当然也希望能用计算机来代替或扩展人类的部分脑力劳动。计算机模式识别在20世纪60年代初迅速发展并成为一门新学科。 概念 简单来说,模式识别就是通过计算机用数学技术方法来研究模式的自动处理和判读。我们把环境与客体统称为“模式”。随着计算机技术的发展,人类有可能研究复杂的信息处理过程。信息处理过程的一个重要形式是生命体对环境及客体的识别。对人类来说,特别重要的是对光学信息(通过视觉器官来获得)和声学信息(通过听觉器官来获得)的识别。这是模式识别的两个重要方面。市场上可见到的代表性产品有光学字符识别(Optical Character Recognition, OCR)、语音识别系统。其计算机识别的显著特点是速度快,准确性高,效率高。在将来完全可以取代人工录入。 模式识别是指对表征事物或现象的各种形式的(数值的、文字的和逻辑关系的)信息进行处理和分析,以对事物或现象进行描述、辨认、分类和解释的过程,是信息科学和人工智能的重要组成部分。 研究 模式识别研究主要集中在两方面,一是研究生物体(包括人)是如何感知对象的,属于认识科学的范畴,二是在给定的任务下,如何用计算机实现模式识别的理论和方法。前者是生理学家、心理学家、生物学家和神经生理学家的研究内容,后者通过数学家、信息学专家和计算机科学工作者近几十年来的努力,已经取得了系统的研究成果。 应用计算机对一组事件或过程进行辨识和分类,所识别的事件或过程可以是文字、声音、图像等具体对象,也可以是状态、程度等抽象对象。这些对象与数字形式的信息相区别,称为模式信息。 模式识别所分类的类别数目由特定的识别问题决定。有时,开始时无法得知实际的类别数,需要识别系统反复观测被识别对象以后确定。 模式识别与统计学、心理学、语言学、计算机科学、生物学、控制论等都有关系。它与人工智能、图像处理的研究有交叉关系。例如自适 1、试说明Mahalanobis 距离平方的定义,到某点的Mahalanobis 距离平方为常数的轨迹的几何意义,它与欧氏距离的区别与联系。 答:Mahalanobis 距离的平方定义为:∑---=1 2)()(),(u x u x u x r T 其中x ,u 为两个数据,1-∑是一个正定对称矩阵(一般为协方差矩阵)。根据定义,距 某一点的Mahalanobis 距离相等点的轨迹是超椭球,如果是单位矩阵Σ,则Mahalanobis 距离就是通常的欧氏距离。 2、试说明用监督学习与非监督学习两种方法对道路图像中道路区域的划分的基本做法,以说明这两种学习方法的定义与它们间的区别。 答:监督学习方法用来对数据实现分类,分类规则通过训练获得。该训练集由带分类号的数据集组成,因此监督学习方法的训练过程是离线的。 非监督学习方法不需要单独的离线训练过程,也没有带分类号(标号)的训练数据集,一般用来对数据集进行分析,如聚类,确定其分布的主分量等。 就道路图像的分割而言,监督学习方法则先在训练用图像中获取道路象素与非道路象素集,进行分类器设计,然后用所设计的分类器对道路图像进行分割。 使用非监督学习方法,则依据道路路面象素与非道路象素之间的聚类分析进行聚类运算,以实现道路图像的分割。 3、已知一组数据的协方差矩阵为??? ? ??12/12/11,试问 (1) 协方差矩阵中各元素的含义。 (2) 求该数组的两个主分量。 (3) 主分量分析或称K-L 变换,它的最佳准则是什么? (4) 为什么说经主分量分析后,消除了各分量之间的相关性。 答:协方差矩阵为??? ? ??12/12/11,则 (1) 对角元素是各分量的方差,非对角元素是各分量之间的协方差。 (2) 主分量,通过求协方差矩阵的特征值,用???? ? ? ?? ----121211λλ=0得4/1)1(2=-λ,则 ?? ?=2/32/1λ,相应地:2/3=λ,对应特征向量为???? ??11,21 =λ,对应??? ? ??-11。 这两个特征向量,即为主分量。 (3) K-L 变换的最佳准则为: 对一组数据进行按一组正交基分解,在只取相同数量分量的条件下,以均方误差计算截尾误差最小。 (4) 在经主分量分解后,协方差矩阵成为对角矩阵,因而各主分量间相关性消除。 4、试说明以下问题求解是基于监督学习或是非监督学习: (1) 求数据集的主分量 (2) 汉字识别 (3) 自组织特征映射 (4) CT 图像的分割 答:(1) 求数据集的主分量是非监督学习方法; (2) 汉字识别:对待识别字符加上相应类别号—有监督学习方法; (3) 自组织特征映射—将高维数组按保留近似度向低维映射—非监督学习; (4) CT 图像分割—按数据自然分布聚类—非监督学习方法; 5、试列举线性分类器中最著名的三种最佳准则以及它们各自的原理。 《模式识别及应用》课程教学大 纲 ( 06、07级) 编号:40021340 英文名称:Pattern Recognition and Its Applications 适用专业:电子信息工程 责任教学单位:电子工程系电子信息 教研室 总学时:32 学分:2 考核形式:考查 课程类别:专业课 修读方式:必修 教学目的:模式识别是电子信息工程专业的一门专业必修课。通过该课程的学习,学生能够掌握模式识别的基本理论和主要方法,并且能掌握在大量的模式样本中获取有用信息的原理和算法,通过课外上机练习,学会编写模式识别的算法程序,达到理论和实践相结合的目的,使学生了解模式识别的应用领域,为将来从事这一方面的研究打下初步基础。 主要教学内容及要求:由于本课程的目标是侧重在应用模式识别技术,因此在学习内容上侧重基本概念的讲解,辅以必要的数学推导,使学生能掌握模式识别技术中最基本的概念,以及最基本的处理问题方法。 本课程安排了一些习题,以便学生能通过做练习与实验进一步掌握课堂知识,学习了本课程后,大部分学生能处理一些简单模式识别问题,如设计获取信息的手段,选择要识别事物的描述方法以及进行分类器设计。 第一章概论 1.掌握模式识别的概念 2.熟悉模式识别系统 3.熟悉模式识别的应用 第二章统计模式识别——概率分类法 1. 掌握概率分类的判别标准 (1)Bayes法则 (2)Bayes风险 (3)基于Bayes法则的分类器 (4)最小最大决策 (5)Neyman-pearson决策 2. 熟悉正态密度及其判别函数 (1)正态密度函数 (2)正态分布样品的判别函数 3.了解密度函数的估计 第三章聚类分析 1. 掌握基于试探的聚类算法 (1)基于最近邻规则的试探法 (2)最大最小距离法 2.熟悉层次聚类算法 3.熟悉动态聚类法 (1)K均值算法 (2)迭代自组织的数据分析算法4.了解合取聚类法、最小张树分类法 第四章模糊模式识别 1.掌握模糊信息处理的基本概念 2.熟悉模糊识别信息地获取 3.熟悉模糊综合评判 4.熟悉基于识别算法的模糊模式识别 5.熟悉模糊聚类分析 第五章神经网络识别理论及模型 1.掌握人工神经网络基本模型 2.熟悉神经网络分类器 3.熟悉模糊神经网络系统 4.熟悉神经网络识别模型及相关技术 第六章特征提取与选择 1.掌握类别可分性判据 2.掌握基于可分性判据进行变换的特征提取与选择 3.掌握最佳鉴别矢量的提取 4.熟悉离散K-L变换及其在特征提取与选择中的应用 5.熟悉基于决策界的特征提取 6.熟悉特征选择中的直接挑选法 本课程与其他课程的联系与分工:本课程的先修课程是线性代数、概率与数理统计。它与数字图像处理课可并开。所学知识可以直接应用于相关课题的毕业设计中,并可为学生在研究生阶段进一步深入学习模式识别理论和从事模式识别方向的研究工作打下基础。 西安交通大学 《模式识别》实验一——IRIS正态分布假设下的贝叶斯分类 吴娟梅硕2081 3112313030 对于具有多个特征参数的样本(如本实验的iris 数据样本有4d =个参数),其正态分布的概率密度函数可定义为 112 2 11()exp ()()2(2)T d p π-??= --∑-???? ∑ x x μx μ 式中,12,,,d x x x ????=x 是d 维行向量,12,,,d μμμ????=μ 是d 维行向量,∑是d d ?维协方差矩阵,1-∑是∑的逆矩阵,∑是∑的行列式。 本实验我们采用最小错误率的贝叶斯决策,使用如下的函数作为判别函数 ()(|)(), 1,2,3i i i g p P i ωω==x x (3个类别) 其中()i P ω为类别i ω发生的先验概率,(|)i p ωx 为类别i ω的类条件概率密度函数。 由其判决规则,如果使()()i j g g >x x 对一切j i ≠成立,则将x 归为i ω类。 我们根据假设:类别i ω,i=1,2,……,N 的类条件概率密度函数(|)i p ωx ,i=1,2,……,N 服从正态分布,即有(|)i p ωx ~(,)i i N ∑μ,那么上式就可以写为 112 2 ()1()exp ()(),1,2,32(2)T i i d P g i ωπ-?? = -∑=???? ∑ x x -μx -μ 对上式右端取对数,可得 111()()()ln ()ln ln(2)222 T i i i i d g P ωπ-=-∑+-∑-i i x x -μx -μ 上式中的第二项与样本所属类别无关,将其从判别函数中消去,不会改变分类结果。则判别函数()i g x 可简化为以下形式 111 ()()()ln ()ln 22 T i i i i g P ω-=-∑+-∑i i x x -μx -μ 武汉理工大学 模式识别及其在图像处理中的应用 学院(系):自动化学院 课程名称:模式识别原理 专业班级:控制科学与工程1603班 任课教师:张素文 学生姓名:王红刚 2017年1月3日 模式识别及其在图像处理中的应用 摘要:随着计算机和人工智能技术的发展,模式识别在图像处理中的应用日益广泛。综述了模式识别在图像处理中特征提取、主要的识别方法(统计决策法、句法识别、模糊识别、神经网络)及其存在的问题, 并且对近年来模式识别的新进展———支持向量机与仿生模式识别做了分析和总结, 最后讨论了模式识别亟待解决的问题并对其发展进行了展望。 关键词:模式识别;图像处理;特征提取;识别方法 Pattern Recognition and Its Application in Image Processing Abstract:With the development of computer and artificial intelli-gence , pattern recognition is w idely used in the image processing in-creasingly .T he feature extraction and the main methods of pattern recognition in the image processing , w hich include statistical deci-sion, structural method , fuzzy method , artificial neural netw ork aresummarized.T he support vector and bionic pattern recognition w hich are the new developments of the pattern recognition are also analyzed .At last, the problems to be solved and development trends are discussed. Key words:pattern recognition ;image processing ;feature extrac-tion;recognition methods什么是模式识别

模式识别——用身高和或体重数据进行性别分类

身高体重分析

人工智能与模式识别

黄庆明 模式识别与机器学习 第三章 作业

用身高和体重数据进行性别分类的实验报告

(完整版)中科院-模式识别考题总结(详细答案)

1模式识别与机器学习思考题及参考答案

模式识别习题及答案

用身高和体重数据进行分类实验

模式识别期末考试复习

用身高和或体重数据进行性别分类的实验

模式识别简介

模式识别练习题(简答和计算)..

模式识别及应用--教学大纲

模式识别报告 bayes分类

模式识别及其在图像处理中的应用