机器学习十大算法 C4.5中文翻译

1.什么是C4.5

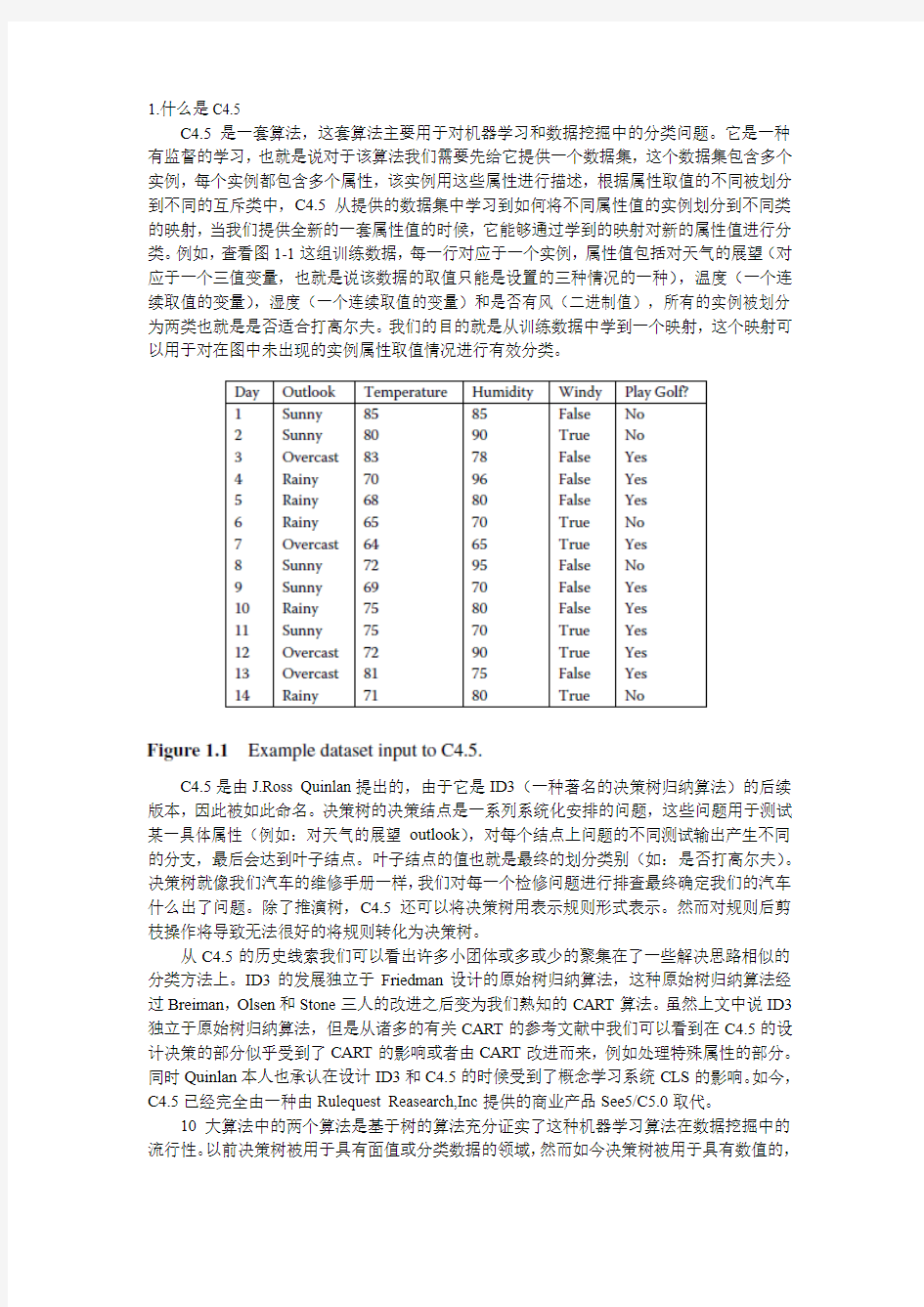

C4.5是一套算法,这套算法主要用于对机器学习和数据挖掘中的分类问题。它是一种有监督的学习,也就是说对于该算法我们需要先给它提供一个数据集,这个数据集包含多个实例,每个实例都包含多个属性,该实例用这些属性进行描述,根据属性取值的不同被划分到不同的互斥类中,C4.5从提供的数据集中学习到如何将不同属性值的实例划分到不同类的映射,当我们提供全新的一套属性值的时候,它能够通过学到的映射对新的属性值进行分类。例如,查看图1-1这组训练数据,每一行对应于一个实例,属性值包括对天气的展望(对应于一个三值变量,也就是说该数据的取值只能是设置的三种情况的一种),温度(一个连续取值的变量),湿度(一个连续取值的变量)和是否有风(二进制值),所有的实例被划分为两类也就是是否适合打高尔夫。我们的目的就是从训练数据中学到一个映射,这个映射可以用于对在图中未出现的实例属性取值情况进行有效分类。

C4.5是由J.Ross Quinlan提出的,由于它是ID3(一种著名的决策树归纳算法)的后续版本,因此被如此命名。决策树的决策结点是一系列系统化安排的问题,这些问题用于测试某一具体属性(例如:对天气的展望outlook),对每个结点上问题的不同测试输出产生不同的分支,最后会达到叶子结点。叶子结点的值也就是最终的划分类别(如:是否打高尔夫)。决策树就像我们汽车的维修手册一样,我们对每一个检修问题进行排查最终确定我们的汽车什么出了问题。除了推演树,C4.5还可以将决策树用表示规则形式表示。然而对规则后剪枝操作将导致无法很好的将规则转化为决策树。

从C4.5的历史线索我们可以看出许多小团体或多或少的聚集在了一些解决思路相似的分类方法上。ID3的发展独立于Friedman设计的原始树归纳算法,这种原始树归纳算法经过Breiman,Olsen和Stone三人的改进之后变为我们熟知的CART算法。虽然上文中说ID3独立于原始树归纳算法,但是从诸多的有关CART的参考文献中我们可以看到在C4.5的设计决策的部分似乎受到了CART的影响或者由CART改进而来,例如处理特殊属性的部分。同时Quinlan本人也承认在设计ID3和C4.5的时候受到了概念学习系统CLS的影响。如今,C4.5已经完全由一种由Rulequest Reasearch,Inc提供的商业产品See5/C5.0取代。

10大算法中的两个算法是基于树的算法充分证实了这种机器学习算法在数据挖掘中的流行性。以前决策树被用于具有面值或分类数据的领域,然而如今决策树被用于具有数值的,

标记符号的以及混合类型的属性值的多种领域例如临床决策制定,制造业,文本分析,生物信息学,空间数据建模,和一些特定领域,这些领域的决策制定能够表示为一个决策树或规则的形式。

2.算法描述

C4.5并不是单单的指一个算法而是一套算法-C4.5,C4.5-no-pruning和C4.5-rules-具备很多功能。我们首先给出基本的C4.5算法,然后再讨论这些功能。

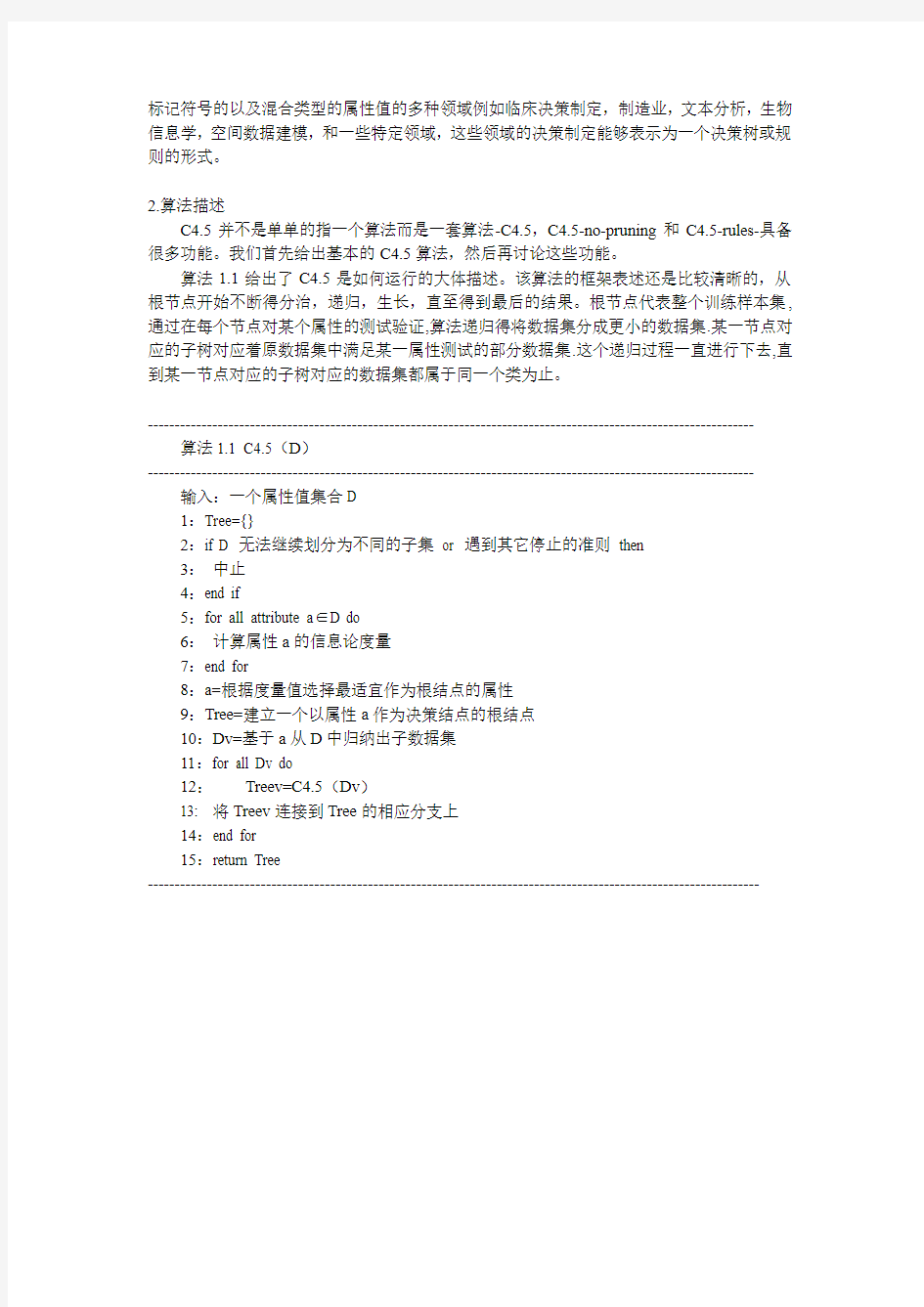

算法1.1给出了C4.5是如何运行的大体描述。该算法的框架表述还是比较清晰的,从根节点开始不断得分治,递归,生长,直至得到最后的结果。根节点代表整个训练样本集,通过在每个节点对某个属性的测试验证,算法递归得将数据集分成更小的数据集.某一节点对应的子树对应着原数据集中满足某一属性测试的部分数据集.这个递归过程一直进行下去,直到某一节点对应的子树对应的数据集都属于同一个类为止。

----------------------------------------------------------------------------------------------------------------- 算法1.1 C4.5(D)

----------------------------------------------------------------------------------------------------------------- 输入:一个属性值集合D

1:Tree={}

2:if D 无法继续划分为不同的子集or 遇到其它停止的准则then

3:中止

4:end if

5:for all attribute a∈D do

6:计算属性a的信息论度量

7:end for

8:a=根据度量值选择最适宜作为根结点的属性

9:Tree=建立一个以属性a作为决策结点的根结点

10:Dv=基于a从D中归纳出子数据集

11:for all Dv do

12:Treev=C4.5(Dv)

13: 将Treev连接到Tree的相应分支上

14:end for

15:return Tree

------------------------------------------------------------------------------------------------------------------

图1.1给出了Golf数据集,用于作为算法的输入。就如先前陈述的一样,我们的目标是预测一天的天气状况是否适宜打高尔夫。在图1.1中样本的部分属性取值是离散的,部分又是连续取值的。

图1.2是高尔夫数据集对应的决策树。下面就让我们来分析一下构造该决策树可能遇到的问题。

1.分类树中的测试是怎样的?

从如1.2可以看出,C4.5并没有对结点限制最多产生两条分支而是可以产生两种或更多种结果。如果属性是布尔类型的,将产生两条测试分支。对于属性取值为离散变量,这很简单,离散变量对应着多个值,每个值就对应着测试的一个分支,测试就是验证样本对应的属性值对应哪个分支。这样数据集就会被分成几个小组。对于连续变量,所有连续变量的测试分支都是2条,其测试分支分别对应着{<=t?,>=t?},t对应着分支阈值。

2.如何选择测试?

C4.5根据信息论标准来选择测试,比如增益(在信息论中,熵对应着某一分布的平均信息量,其值同时也对应着要完全无损表示该分布所需要的最小的比特数,本质上熵对应着不确定性,可能的变化的丰富程度。所谓增益,就是指在应用了某一测试之后,其对应的可能性丰富程度下降,不确定性减小,这个减小的幅度就是增益,其实质上对应着分类带来的好处)或者增益比(这个指标实际上就等于增益/熵,之所以采用这个指标是为了克服采用增益作为衡量标准的缺点,采用增益作为衡量标准会导致分类树倾向于优先选择那些具有比较多的分支的测试,这种倾向需要被抑制)。我们通常将增益比作为默认的标准。算法在进行Tree-Growth时,总是“贪婪得”选择那些信息论标准最高的那些测试。

3.如何选择连续变量的阈值?

就像前面所表述的那样,对于离散性和布尔型的属性,只需要对属性的所有可能取值进行测试就够了。然而连续型变量需要确定一个阈值,将其划分为两个范围。这阈值如何确定呢?很简单,把需要处理的样本(对应根节点)或样本子集(对应子树)按照连续变量的大小从小到大进行排序,假设该属性对应的不同的属性值一共有N个,那么总共有N-1个可能的候选分割阈值点,每个候选的分割阈值点的值为上述排序后的属性值链表中两两前后连

续元素的中点,那么我们的任务就是从这个N-1个候选分割阈值点中选出一个,使得前面提到的信息论标准最大。举个例子,对于Golf数据集,我们来处理温度属性,来选择合适的阈值。首先按照温度大小对对应样本进行排序如下:

----------------------------------------------------------------------------------

64 65 68 69 70 71 72 72 75 75 80 81 83 85

----------------------------------------------------------------------------------- 那么可以看到有13个可能的候选阈值点,比如middle[64,65], middle[65,68]….,middle[83,85]。那么最优的阈值该选多少呢?通过计算信息熵的方式计算每种候选阈值点的熵值,选取熵值最小的阈值点,熵值越小,增益越大,后面我们会详细的介绍熵与增益。对于临近的变量Vi与Vi+1如果取值为Vi的所有样本和取值Vi+1的所有样本属于相同的分类,选取他们之间的值作为阈值点将无法增加信息增益或增益比。通过这种方法可以减少阈值点的测试。

4.Tree-Growing如何终止?

前面提到Tree-Growing实际上是一个递归过程,那么这个递归什么时候到达终止条件退出递归呢?有两种方式,第一种方式是如果某一节点的分支所覆盖的样本都属于同一类的时候,那么递归就可以终止,该分支就会产生一个叶子节点.还有一种方式就是,如果某一分支覆盖的样本的个数如果小于一个阈值,那么也可产生叶子节点,从而终止Tree-Growing。

5.如何确定叶子结点的类?

前面提到Tree-Growing终止的方式有2种,对于第一种方式,叶子节点覆盖的样本都属于同一类,那么这种情况下叶子节点的类自然不必多言。对于第二种方式,叶子节点覆盖的样本未必属于同一类,直接一点的方法就是,该叶子节点所覆盖的样本哪个类占大多数,那么该叶子节点的类别就是那个占大多数的类。

我们将现在来详细的介绍如何由图1.1得到图1.2中的树。这就涉及到测试的选择问题,前面《如何选择测试?》提到测试的选择是依据信息论标准,信息论标准有两种,一种是增益,一种是增益比。首先来看看增益Gain的计算。假设随机变量x,它可能属于c个类中

的任何一个,通过样本的统计,它分别属于各个类的概率分别为,那么要

想把某一样本进行归类所需要的熵就为:

根据这个公式可以计算出playGolf?的熵:

所以它的熵值为0.940。它的信息论含义就是我要想把PlayGolf?这个信息传递给别人话,平均来讲我至少需要0.940个bit来传递这个信息。C4.5的目标就是经过分类来减小这个熵。那么我们来依次考虑各个属性测试,通过某一属性测试我们将样本分成了几个子集,这使得样本逐渐变得有序,那么熵肯定变小了。这个熵的减小量就是我们选择属性测试的依据。还是以Golf数据集为例,Outlook的增益Gain(Outlook),其公式如下:

它的实质是把数据集D根据某一属性测试分成v个子集,这使得数据集D变得有序,使得

数据集D的熵变小了。分组后的熵其实就是各个子集的熵的权重和。下面我们给出一个增益的具体计算过程:

通过计算我们得到Gain(Outlook)=0.940-0.694=0.246,依据同样的方法我们可以计算出其它属性对应的信息增益。可以得到第一个测试属性是Outlook。这是一个贪婪的选择只考虑眼前的最大并不考虑对将来决策的影响。,就像前面阐述的一样,当子数据集为空也就是说所有的子数据集属于同一类别落在同一叶子节点上时树的增长就停止了,我们观察到对于outlook等于overcast的样本对应的结果都是yes,所以在属性取值为overcast的方向上的树的增长就停止了。然而,对于另外两个分支,样本对应的结果并不唯一,所以需要继续递归,但是outlook属性不能再作为划分标准。对于不同的分支需要选择不同的测试属性。

到这里似乎一切都很完美,增益这个指标非常得make sense,但是其实增益这个指标有一个缺点。我们来考虑Golf数据集中的Day这个属性(我们假设它是一个真属性,实际上很可能大家不会把他当做属性),Day有14个不同的值,那么Day的属性测试节点就会有14个分支,很显然每个分支其实都覆盖了一个“纯”数据集(所谓“纯”,指的就是所覆盖的数据集都属于同一个类),那么其熵增益显然就是最大的,那么Day就默认得作为第一个属性。之所以出现这样的情况,是因为增益这个指标天然得偏向于选择那些分支比较多的属性,也就是那些具有的值比较多的那些属性。这种偏向性是我们希望克服的,我们希望公正地评价所有的属性。因此又一个指标被提出来了Gain Ratio-增益比。某一属性A的增益比计算公式如下:

Entropy(A)实际上就是属性A的熵,只不过这个熵有所不同,他不是样本最终分类{PlayGolf?}的熵,而是对应属性分组{A?}的熵,它反映的是属性A本身的信息量。下面我给出一个计算增益比GainRatio(Outlook)的例子:

1:已知Gain(Outlook)=0.246

2:属性Outlook的熵Entropy:

Sunny概率:5/14 Overcast:4/14 Rainy:5/14

Entropy=-5/14log2(5/14) -4/14log2(4/14) -5/14log2(5/14) #注意与上面熵计算方法的不同

通过计算我们很容易得到GainRatio(Outlook)=0.246/1.577=0.156。增益比实际上就是对增益进行了归一化,这样就避免了指标偏向分支多的属性的倾向。

1.3 C4.5的功能

1.3.1 树的剪枝

决策树为什么要剪枝?原因就是避免决策树“过拟合”样本。前面的算法生成的决策树非常的详细而庞大,每个属性都被详细地加以考虑,决策树的树叶节点所覆盖的训练样本都是“纯”的。因此用这个决策树来对训练样本进行分类的话,你会发现对于训练样本而言,这个树表现堪称完美,它可以100%完美正确得对训练样本集中的样本进行分类(因为决策树本身就是100%完美拟合训练样本的产物)。但是这会带来一个问题,如果训练样本中包含了一些错误,按照前面的算法,这些错误也会100%一点不留得被决策树学习了,这就是“过拟合”。C4.5的缔造者昆兰教授很早就发现了这个问题,他作过一个试验,在某一个数据集中,过拟合的决策树的错误率比一个经过简化了的决策树的错误率要高。那么现在的问题就来了,如何在原生的过拟合决策树的基础上,通过剪枝生成一个简化了的决策树?

第一种方法,也是最简单的方法,称之为基于误判的剪枝。这个思路很直接,完全的决策树不是过度拟合么,我再搞一个测试数据集来纠正它。对于完全决策树中的每一个非叶子节点的子树,我们尝试着把它替换成一个叶子节点,该叶子节点的类别我们用子树所覆盖训练样本中存在最多的那个类来代替,这样就产生了一个简化决策树,然后比较这两个决策树在测试数据集中的表现,如果简化决策树在测试数据集中的错误比较少,并且该子树里面没有包含另外一个具有类似特性的子树(所谓类似的特性,指的就是把子树替换成叶子节点后,其测试数据集误判率降低的特性),那么该子树就可以替换成叶子节点。该算法以bottom-up 的方式遍历所有的子树,直至没有任何子树可以替换使得测试数据集的表现得以改进时,算法就可以终止。

第一种方法很直接,但是需要一个额外的测试数据集,能不能不要这个额外的数据集呢?为了解决这个问题,于是就提出了悲观剪枝。悲观剪枝是C4.5的一种创新。该方法剪枝的依据是训练样本集中的样本误判率。我们知道一颗分类树的每个节点都覆盖了一个样本集,根据算法这些被覆盖的样本集往往都有一定的误判率,因为如果节点覆盖的样本集的个数小于一定的阈值,那么这个节点就会变成叶子节点,所以叶子节点会有一定的误判率。而每个节点都会包含至少一个的叶子节点,所以每个节点也都会有一定的误判率。悲观剪枝就是递归得估算每个内部节点所覆盖样本节点的误判率。剪枝后该内部节点会变成一个叶子节点,该叶子节点的类别为原内部节点的最优叶子节点所决定。然后比较剪枝前后该节点的错误率来决定是否进行剪枝。该方法和前面提到的第一种方法思路是一致的,不同之处在于如何估计剪枝前分类树内部节点的错误率。

悲观剪枝的思路非常巧妙。把一颗子树(具有多个叶子节点)的分类用一个叶子节点来替代的话,在训练集上的误判率肯定是上升的(这是很显然的,同样的样本子集,如果用子树分类可以分成多个类,而用单颗叶子节点来分的话只能分成一个类,多个类肯定要准确一些)。于是我们需要把子树的误判计算加上一个经验性的惩罚因子。对于一颗叶子节点,它覆盖了N个样本,其中有E个错误(也就是说本不应该划分到这个类的样本,样本中却将其划分到了该类,这就是错误),那么该叶子节点的错误率为(E+0.5)/N。这个0.5就是惩罚因子,那么一颗子树,它有L个叶子节点,那么该子树的误判率估计为

。现在,假设我们用最优叶子节点替换掉了子树,我们

通过测试数据的测试发现它误判的次数为J,当J+0.5在范围内时,

悲观剪枝就用这个最优叶子节点替换掉子树。

这个方法可以被扩展为基于期望置信区间的剪枝。我们可以将叶子节点的误差率e建模成伯努利随机变量。对于一个给定的显著性因子CL,对于一个上界e max我们有e 那么一棵树错误分类一个样本值为1,正确分类一个样本值为0,该树错误分类的概率(误判率)为e(e为分布的固有属性,可以通过统计出来),那么树的误判次数就是伯努利分布,我们可以估计出该树的误判次数均值和标准差: 把子树替换成叶子节点后,该叶子的误判次数也是一个伯努利分布,其概率误判率e 为(E+0.5)/N,因此叶子节点的误判次数均值为 使用训练数据,子树总是比替换为一个叶节点后产生的误差小,但是使用校正后有误差计算方法却并非如此,当子树的误判个数大过对应叶节点的误判个数一个标准差之后,就决定剪枝: 这个条件就是剪枝的标准。 当并不一定非要大一个标准差,可以给定任意的置信区间,我们设定一定的显著性因子,就可以估算出误判次数的上下界。 比如T4这棵子树的误差率: 子树误差率的标准误差: 子树替换为一个叶节点后,其误差率为: 因为,所以决定将子树T4替换这一个叶子节点。 1.3.2 连续值属性的改进 相对于那些离散值属性,分类树算法倾向于选择那些连续值属性,因为连续值属性会有更多的分支,熵增益也最大。算法需要克服这种倾向。还记得前面讲得如何克服分类树算法倾向于离散值较多的离散属性么?对了,我们利用增益率来克服这种倾向。增益率也可以用来克服连续值属性倾向。增益率作为选择属性的依据克服连续值属性倾向,这是没有问题的。但是如果利用增益率来选择连续值属性的分界点,会导致一些副作用。分界点将样本分成两个部分,这两个部分的样本个数之比也会影响增益率。根据增益率公式,我们可以发现,当分界点能够把样本分成数量相等的两个子集时(我们称此时的分界点为等分分界点),增益率的抑制会被最大化,因此等分分界点被过分抑制了。子集样本个数能够影响分界点,显然不合理。因此在决定分界点是还是采用增益这个指标,而选择属性的时候才使用增益率这个指标。这个改进能够很好得抑制连续值属性的倾向。当然还有其它方法也可以抑制这种倾向,比如MDL,有兴趣的读者可以自己阅读相关文章。 1.3.3 处理缺失属性 如果有些训练样本或者待分类样本缺失了一些属性值,那么该如何处理?要解决这个问题,需要考虑个问题:i)当开始决定选择哪个属性用来进行分支时,如果有些训练样本缺失了某些属性值时该怎么办?ii)一个属性已被选择,那么在决定分支的时候如果有些样本缺失了该属性该如何处理?iii)当决策树已经生成,但待分类的样本缺失了某些属性,这些属性该如何处理?针对这三个问题,昆兰提出了一系列解决的思路和方法。 对于问题i),计算属性a的增益或者增益率时,如果有些样本没有属性a,那么可以有这么几种处理方式:(I)忽略这些缺失属性a的样本。(C)给缺失属性a的样本赋予属性a一个均值或者最常用的的值。(R)计算增益或者增益率时根据缺失属性样本个数所占的比率对增益/增益率进行相应的“打折”。(S)根据其他未知的属性想办法把这些样本缺失的属性补全。 对于问题ii),当属性a已经被选择,该对样本进行分支的时候,如果有些样本缺失了属性a,那么:(I)忽略这些样本。(C)把这些样本的属性a赋予一个均值或者最常出现的值,然后再对他们进行处理。(R)把这些属性缺失样本,按照具有属性a的样本被划分成的子集样本个数的相对比率,分配到各个子集中去。至于哪些缺失的样本被划分到子集1,哪些被划分到子集2,这个没有一定的准则,可以随机而动。(A)把属性缺失样本分配给所有的子集,也就是说每个子集都有这些属性缺失样本。(U)单独为属性缺失的样本划分一个分支子集。(S)对于缺失属性a的样本,尝试着根据其他属性给他分配一个属性a的值,然后继续处理将其划分到相应的子集。 对于问题iii),对于一个缺失属性a的待分类样本,有这么几种选择:(U)如果有单独的确实分支,依据此分支。(c)把待分类的样本的属性a值分配一个最常出现的a的属性值,然后进行分支预测。(S)根据其他属性为该待分类样本填充一个属性a值,然后进行分支处理。(F)在决策树中属性a节点的分支上,遍历属性a节点的所有分支,探索可能所有的分类结果,然后把这些分类结果结合起来一起考虑,按照概率决定一个分类。(H)待分类样本在到达属性a节点时就终止分类,然后根据此时a节点所覆盖的叶子节点类别状况为其分配一个发生概率最高的类。 1.3.4 推理规则 C4.5决策树能够根据决策树生成一系列规则集,我们可以把一棵决策树看成一系列规 则的组合。一个规则对应着从根节点到叶子节点的路径,该规则的条件是路径上的条件,结果是叶子节点的类别。C4.5首先根据决策树的每个叶子节点生成一个规则集,对于规则集中的每条规则,算法利用“爬山”搜索来尝试是否有条件可以移除,由于移除一个条件和剪枝一个内部节点本质上是一样的,因此前面提到的悲观剪枝算法也被用在这里进行规则简化。MDL准则在这里也可以用来衡量对规则进行编码的信息量和对潜在的规则进行排序。简化后的规则数目要远远小于决策树的叶子节点数。根据简化后的规则集是无法重构原来的决策树的。规则集相比决策树而言更具有可操作性,因此在很多情况下我们需要从决策树中推理出规则集。C4.5有个缺点就是如果数据集增大了一点,那么学习时间会有一个迅速地增长。 机器学习10大算法 什么是机器学习呢? 从广泛的概念来说,机器学习是人工智能的一个子集。人工智能旨在使计算机更智能化,而机器学习已经证明了如何做到这一点。简而言之,机器学习是人工智能的应用。通过使用从数据中反复学习到的算法,机器学习可以改进计算机的功能,而无需进行明确的编程。 机器学习中的算法有哪些? 如果你是一个数据科学家或机器学习的狂热爱好者,你可以根据机器学习算法的类别来学习。机器学习算法主要有三大类:监督学习、无监督学习和强化学习。 监督学习 使用预定义的“训练示例”集合,训练系统,便于其在新数据被馈送时也能得出结论。系统一直被训练,直到达到所需的精度水平。 无监督学习 给系统一堆无标签数据,它必须自己检测模式和关系。系统要用推断功能来描述未分类数据的模式。 强化学习 强化学习其实是一个连续决策的过程,这个过程有点像有监督学习,只是标注数据不是预先准备好的,而是通过一个过程来回调整,并给出“标注数据”。 机器学习三大类别中常用的算法如下: 1. 线性回归 工作原理:该算法可以按其权重可视化。但问题是,当你无法真正衡量它时,必须通过观察其高度和宽度来做一些猜测。通过这种可视化的分析,可以获取一个结果。 回归线,由Y = a * X + b表示。 Y =因变量;a=斜率;X =自变量;b=截距。 通过减少数据点和回归线间距离的平方差的总和,可以导出系数a和b。 2. 逻辑回归 根据一组独立变量,估计离散值。它通过将数据匹配到logit函数来帮助预测事件。 下列方法用于临时的逻辑回归模型: 添加交互项。 消除功能。 正则化技术。 使用非线性模型。 3. 决策树 利用监督学习算法对问题进行分类。决策树是一种支持工具,它使用树状图来决定决策或可能的后果、机会事件结果、资源成本和实用程序。根据独立变量,将其划分为两个或多个同构集。 决策树的基本原理:根据一些feature 进行分类,每个节点提一个问题,通过判断,将数据分为两类,再继续提问。这些问题是根据已有数据学习出来的,再投 1、蒙特卡罗算法(该算法又称随机性模拟算法,是通过计算机仿真来解决问题的算法,同时可以通过模拟来检验自己模型的正确性,是比赛时必用的方法) 2、数据拟合、参数估计、插值等数据处理算法(比赛中通常会遇到大量的数据需要处理,而处理数据的关键就在于这些算法,通常使用Matlab作为工具) 3、线性规划、整数规划、多元规划、二次规划等规划类问题(建模竞赛大多数问题属于最优化问题,很多时候这些问题可以用数学规划算法来描述,通常使用Lindo、Lingo软件实现) 4、图论算法(这类算法可以分为很多种,包括最短路、网络流、二分图等算法,涉及到图论的问题可以用这些方法解决,需要认真准备) 5、动态规划、回溯搜索、分支定界等计算机算法(这些算法是算法设计中比较常用的方法,很多场合可以用到竞赛中) 6、最优化理论的三大非经典算法:模拟退火法、神经网络、遗传算法(这些问题是用来解决一些较困难的最优化问题的算法,对于有些问题非常有帮助,但是算法的实现比较困难,需慎重使用)元胞自动机 7、网格算法和穷举法(网格算法和穷举法都是暴力搜索最优点的算法,在很多竞赛题中有应用,当重点讨论模型本身而轻视算法的时候,可以使用这种暴力方案,最好使用一些高级语言作为编程工具) 8、一些连续离散化方法(很多问题都是实际来的,数据可以是连续的,而计算机只认的是离散的数据,因此将其离散化后进行差分代替微分、求和代替积分等思想是非常重要的) 9、数值分析算法(如果在比赛中采用高级语言进行编程的话,那一些数值分析中常用的算法比如方程组求解、矩阵运算、函数积分等算法就需要额外编写库函数进行调用) 10、图象处理算法(赛题中有一类问题与图形有关,即使与图形无关,论文中也应该要不乏图片的,这些图形如何展示以及如何处理就是需要解决的问题,通常使用Matlab进行处理) 以上为各类算法的大致介绍,下面的内容是详细讲解,原文措辞详略得当,虽然不是面面俱到,但是已经阐述了主要内容,简略之处还望大家多多讨论。 1、蒙特卡罗方法(MC)(Monte Carlo): 蒙特卡罗(Monte Carlo)方法,或称计算机随机模拟方法,是一种基于“随机数”的计算方法。这一方法源于美国在第二次世界大战进行研制原子弹的“曼哈顿计划”。该计划的主持人之一、数学家冯·诺伊曼用驰名世界的赌城—摩纳哥的Monte Carlo—来命名这种方法,为它蒙上了一层神秘色彩。 蒙特卡罗方法的基本原理及思想如下: 当所要求解的问题是某种事件出现的概率,或者是某个随机变量的期望值时,它们可以通过某种“试验”的方法,得到这种事件出现的频率,或者这个随机变数的平均值,并用它们作为问题的解。这就是蒙特卡罗方法的基本思想。蒙特卡罗方法通过抓住事物运动的几何数量和几何特征,利用数学方法来加以模拟,即进行一种数字模拟实验。它是以一个概率模型为基础,按照这个模型所描绘的过程,通过模拟实验的结果,作为问题的近似解。 可以把蒙特卡罗解题归结为三个主要步骤: 构造或描述概率过程;实现从已知概率分布抽样;建立各种估计量。 例:蒲丰氏问题 为了求得圆周率π值,在十九世纪后期,有很多人作了这样的试验:将长为2l的一根针任意投到地面上,用针与一组相间距离为2a( l<a)的平行线相交的频率代替概率P,再利用准确的关系式: Chapter10 CART:Classi?cation and Regression Trees Dan Steinberg Contents 10.1Antecedents (180) 10.2Overview (181) 10.3A Running Example (181) 10.4The Algorithm Brie?y Stated (183) 10.5Splitting Rules (185) 10.6Prior Probabilities and Class Balancing (187) 10.7Missing Value Handling (189) 10.8Attribute Importance (190) 10.9Dynamic Feature Construction (191) 10.10Cost-Sensitive Learning (192) 10.11Stopping Rules,Pruning,Tree Sequences,and Tree Selection (193) 10.12Probability Trees (194) 10.13Theoretical Foundations (196) 10.14Post-CART Related Research (196) 10.15Software Availability (198) 10.16Exercises (198) References (199) The1984monograph,“CART:Classi?cation and Regression Trees,”coauthored by Leo Breiman,Jerome Friedman,Richard Olshen,and Charles Stone(BFOS),repre-sents a major milestone in the evolution of arti?cial intelligence,machine learning, nonparametric statistics,and data mining.The work is important for the compre-hensiveness of its study of decision trees,the technical innovations it introduces,its sophisticated examples of tree-structured data analysis,and its authoritative treatment of large sample theory for trees.Since its publication the CART monograph has been cited some3000times according to the science and social science citation indexes; Google Scholar reports about8,450citations.CART citations can be found in almost any domain,with many appearing in?elds such as credit risk,targeted marketing,?-nancial markets modeling,electrical engineering,quality control,biology,chemistry, and clinical medical research.CART has also strongly in?uenced image compression 179 机器学习的十种经典算法详解 毫无疑问,近些年机器学习和人工智能领域受到了越来越多的关注。随着大数据成为当下工业界最火爆的技术趋势,机器学习也借助大数据在预测和推荐方面取得了惊人的成绩。比较有名的机器学习案例包括Netflix根据用户历史浏览行为给用户推荐电影,亚马逊基于用户的历史购买行为来推荐图书。那么,如果你想要学习机器学习的算法,该如何入门呢?就我而言,我的入门课程是在哥本哈根留学时选修的人工智能课程。老师是丹麦科技大学应用数学和计算机专业的全职教授,他的研究方向是逻辑学和人工智能,主要是用逻辑学的方法来建模。课程包括了理论/核心概念的探讨和动手实践两个部分。我们使用的教材是人工智能的经典书籍之一:Peter Norvig教授的《人工智能——一种现代方法》,课程涉及到了智能代理、基于搜索的求解、对抗搜索、概率论、多代理系统、社交化人工智能,以及人工智能的伦理和未来等话题。在课程的后期,我们三个人还组队做了编程项目,实现了基于搜索的简单算法来解决虚拟环境下的交通运输任务。我从课程中学到了非常多的知识,并且打算在这个专题里继续深入学习。在过去几周内,我参与了旧金山地区的多场深度学习、神经网络和数据架构的演讲——还有一场众多知名教授云集的机器学习会议。最重要的是,我在六月初注册了Udacity的《机器学习导论》在线课程,并且在几天前学完了课程内容。在本文中,我想分享几个我从课程中学到的常用机器学习算法。机器学习算法通常可以被分为三大类——监督式学习,非监督式学习和强化学习。监督式学习主要用于一部分数据集(训练数据)有某些可以获取的熟悉(标签),但剩余的样本缺失并且需要预测的场景。非监督式学习主要用于从未标注数据集中挖掘相互之间的隐含关系。强化学习介于两者之间——每一步预测或者行为都或多或少有一些反馈信息,但是却没有准确的标签或者错误提示。由于这是入门级的课程,并没有提及强化学习,但我希望监督式学习和非监督式学习的十个算法足够吊起你的胃口了。监督式学习1.决策树:决策树是一种决策支持工具,它使用树状图或者树状模型来表示决策过程以及后续得到的结果,包括概率事件结果等。请观察下图来理解决策树的结构。 从商业决策的角度来看,决策树就是通过尽可能少的是非判断问题来预测决策正确的概 数据挖掘十大经典算法,你都知道哪些? 当前时代大数据炙手可热,数据挖掘也是人人有所耳闻,但是关于数据挖掘更具体的算法,外行人了解的就少之甚少了。 数据挖掘主要分为分类算法,聚类算法和关联规则三大类,这三类基本上涵盖了目前商业市场对算法的所有需求。而这三类里又包含许多经典算法。而今天,小编就给大家介绍下数据挖掘中最经典的十大算法,希望它对你有所帮助。 一、分类决策树算法C4.5 C4.5,是机器学习算法中的一种分类决策树算法,它是决策树(决策树,就是做决策的节点间的组织方式像一棵倒栽树)核心算法ID3的改进算法,C4.5相比于ID3改进的地方有: 1、用信息增益率选择属性 ID3选择属性用的是子树的信息增益,这里可以用很多方法来定义信息,ID3使用的是熵(shang),一种不纯度度量准则,也就是熵的变化值,而 C4.5用的是信息增益率。区别就在于一个是信息增益,一个是信息增益率。 2、在树构造过程中进行剪枝,在构造决策树的时候,那些挂着几个元素的节点,不考虑最好,不然容易导致过拟。 3、能对非离散数据和不完整数据进行处理。 该算法适用于临床决策、生产制造、文档分析、生物信息学、空间数据建模等领域。 二、K平均算法 K平均算法(k-means algorithm)是一个聚类算法,把n个分类对象根据它们的属性分为k类(kn)。它与处理混合正态分布的最大期望算法相似,因为他们都试图找到数据中的自然聚类中心。它假设对象属性来自于空间向量,并且目标是使各个群组内部的均方误差总和最小。 从算法的表现上来说,它并不保证一定得到全局最优解,最终解的质量很大程度上取决于初始化的分组。由于该算法的速度很快,因此常用的一种方法是多次运行k平均算法,选择最优解。 k-Means 算法常用于图片分割、归类商品和分析客户。 三、支持向量机算法 支持向量机(Support Vector Machine)算法,简记为SVM,是一种监督式学习的方法,广泛用于统计分类以及回归分析中。 SVM的主要思想可以概括为两点: (1)它是针对线性可分情况进行分析,对于线性不可分的情况,通过使用非线性映射算法将低维输入空间线性不可分的样本转化为高维特征空间使其线性可分; (2)它基于结构风险最小化理论之上,在特征空间中建构最优分割超平面,使得学习器得到全局最优化,并且在整个样本空间的期望风险以某个概率满足一定上界。 四、The Apriori algorithm Apriori算法是一种最有影响的挖掘布尔关联规则频繁项集的算法,其核心是基于两阶段“频繁项集”思想的递推算法。其涉及到的关联规则在分类上属于单维、单层、布尔关联规则。在这里,所有支持度大于最小支 Chapter8 k NN:k-Nearest Neighbors Michael Steinbach and Pang-Ning Tan Contents 8.1Introduction (151) 8.2Description of the Algorithm (152) 8.2.1High-Level Description (152) 8.2.2Issues (153) 8.2.3Software Implementations (155) 8.3Examples (155) 8.4Advanced Topics (157) 8.5Exercises (158) Acknowledgments (159) References (159) 8.1Introduction One of the simplest and rather trivial classi?ers is the Rote classi?er,which memorizes the entire training data and performs classi?cation only if the attributes of the test object exactly match the attributes of one of the training objects.An obvious problem with this approach is that many test records will not be classi?ed because they do not exactly match any of the training records.Another issue arises when two or more training records have the same attributes but different class labels. A more sophisticated approach,k-nearest neighbor(k NN)classi?cation[10,11,21],?nds a group of k objects in the training set that are closest to the test object,and bases the assignment of a label on the predominance of a particular class in this neighborhood.This addresses the issue that,in many data sets,it is unlikely that one object will exactly match another,as well as the fact that con?icting information about the class of an object may be provided by the objects closest to it.There are several key elements of this approach:(i)the set of labeled objects to be used for evaluating a test object’s class,1(ii)a distance or similarity metric that can be used to compute This need not be the entire training set. 151 数据挖掘领域的十大经典算法原理及应用 国际权威的学术组织the IEEE International Conference on Data Mining (ICDM) 2006年12月评选出了数据挖掘领域的十大经典算法:C4.5, k-Means, SVM, Apriori, EM, PageRank, AdaBoost, kNN, Naive Bayes, and CART. 不仅仅是选中的十大算法,其实参加评选的18种算法,实际上随便拿出一种来都可以称得上是经典算法,它们在数据挖掘领域都产生了极为深远的影响。 1.C4.5 C4.5算法是机器学习算法中的一种分类决策树算法,其核心算法是ID3算法.C4.5算法继承了ID3算法的优点,并在以下几方面对ID3算法进行了改进: 1)用信息增益率来选择属性,克服了用信息增益选择属性时偏向选择取值多的属性的不足; 2) 在树构造过程中进行剪枝; 3) 能够完成对连续属性的离散化处理; 4) 能够对不完整数据进行处理。 C4.5算法有如下优点:产生的分类规则易于理解,准确率较高。其缺点是:在构造树的过程中,需要对数据集进行多次的顺序扫描和排序,因而导致算法的低效。 2. The k-means algorithm即K-Means算法 k-means algorithm算法是一个聚类算法,把n的对象根据他们的属性分为k个分割,k < n。它与处理混合正态分布的最大期望算法很相似,因为他们都试图找到数据中自然聚类的中心。它假设对象属性来自于空间向量,并且目标是使各个群组内部的均方误差总和最小。 3. Support vector machines 支持向量机,英文为Support Vector Machine,简称SV 机(论文中一般简称SVM)。它是一种監督式學習的方法,它广泛的应用于统计分类以及回归分析中。支持向量机将向量映射到一个更高维的空间里,在这个空间里建立有一个最大间隔超平面。在分开数据的超平面的两边建有两个互相平行的超平面。分隔超平面使两个平行超平面的距离最大化。假定平行超平面 人工智能之机器学习常见算法 摘要机器学习无疑是当前数据分析领域的一个热点内容。很多人在平时的工作中都或多或少会用到机器学习的算法。这里小编为您总结一下常见的机器学习算法,以供您在工作和学习中参考。 机器学习的算法很多。很多时候困惑人们都是,很多算法是一类算法,而有些算法又是从其他算法中延伸出来的。这里,我们从两个方面来给大家介绍,第一个方面是学习的方式,第二个方面是算法的类似性。 学习方式 根据数据类型的不同,对一个问题的建模有不同的方式。在机器学习或者人工智能领域,人们首先会考虑算法的学习方式。在机器学习领域,有几种主要的学习方式。将算法按照学习方式分类是一个不错的想法,这样可以让人们在建模和算法选择的时候考虑能根据输入数据来选择最合适的算法来获得最好的结果。 监督式学习: 在监督式学习下,输入数据被称为训练数据,每组训练数据有一个明确的标识或结果,如对防垃圾邮件系统中垃圾邮件非垃圾邮件,对手写数字识别中的1,2,3,4等。在建立预测模型的时候,监督式学习建立一个学习过程,将预测结果与训练数据的实际结果进行比较,不断的调整预测模型,直到模型的预测结果达到一个预期的准确率。监督式学习的常见应用场景如分类问题和回归问题。常见算法有逻辑回归(LogisTIc Regression)和反向传递神经网络(Back PropagaTIon Neural Network) 非监督式学习: 在非监督式学习中,数据并不被特别标识,学习模型是为了推断出数据的一些内在结构。常见的应用场景包括关联规则的学习以及聚类等。常见算法包括Apriori算法以及k-Means 算法。 半监督式学习: 在此学习方式下,输入数据部分被标识,部分没有被标识,这种学习模型可以用来进行预 数据挖掘十大经典算法 国际权威的学术组织the IEEE International Conference on Data Mining (ICDM) 2006年12月评选出了数据挖掘领域的十大经典算法:C4.5, k-Means, SVM, Apriori, EM, PageRank, AdaBoost, kNN, Naive Bayes, and CART. 不仅仅是选中的十大算法,其实参加评选的18种算法,实际上随便拿出一种来都可以称得上是经典算法,它们在数据挖掘领域都产生了极为深远的影响。 1. C4.5 C4.5算法是机器学习算法中的一种分类决策树算法,其核心算法是ID3算法. C4.5算法继承了ID3算法的优点,并在以下几方面对ID3算法进行了改进: 1) 用信息增益率来选择属性,克服了用信息增益选择属性时偏向选择取值多的属性的不足; 2) 在树构造过程中进行剪枝; 3) 能够完成对连续属性的离散化处理; 4) 能够对不完整数据进行处理。 C4.5算法有如下优点:产生的分类规则易于理解,准确率较高。其缺点是:在构造树的过程中,需要对数据集进行多次的顺序扫描和排序,因而导致算法的低效。 2. The k-means algorithm 即K-Means算法 k-means algorithm算法是一个聚类算法,把n的对象根据他们的属性分为k个分割,k < n。它与处理混合正态分布的最大期望算法很相似,因为他们都试图找到数据中自然聚类的中心。它假设对象属性来自于空间向量,并且目标是使各个群组内部的均方误差总和最小。 3. Support vector machines 支持向量机,英文为Support Vector Machine,简称SV机(论文中一般简称SVM)。它是一种監督式學習的方法,它广泛的应用于统计分类以及回归分析中。支持向量机将向量映射到一个更高维的空间里,在这个空间里建立有一个最大间隔超平面。在分开数据的超平面的两边建有两个互相平行的超平面。分隔超平面使两个平行超平面的距离最大化。假定平行超平面间的距离或差距越大,分类器的总误差越小。一个极好的指南是C.J.C Burges的《模式识别支持向量机指南》。van der Walt 和Barnard 将支持向量机和其他分类器进行了比较。 4. The Apriori algorithm Apriori算法是一种最有影响的挖掘布尔关联规则频繁项集的算法。其核心是基于两阶段频集思想的递推算法。该关联规则在分类上属于单维、单层、布尔关联规则。在这里,所有支持度大于最小支持度的项集称为频繁项集,简称频集。 5. 最大期望(EM)算法 在统计计算中,最大期望(EM,Expectation–Maximization)算法是在概率(probabilistic)模型中寻找参数最大似然估计的算法,其中概率模型依赖于无法观测的隐藏变量(Latent Variabl)。最大期望经常用在机器学习和计算机视觉的数据集聚(Data Clustering)领域。 6. PageRank PageRank是Google算法的重要内容。2001年9月被授予美国专利,专利人是Google创始人之一拉里?佩奇(Larry Page)。因此,PageRank里的page不是指网页,而是指佩奇,即这个 机器学习常见算法分类汇总 ?作者:王萌 ?星期三, 六月25, 2014 ?Big Data, 大数据, 应用, 热点, 计算 ?10条评论 机器学习无疑是当前数据分析领域的一个热点内容。很多人在平时的工作中都或多或少会用到机器学习的算法。这里IT经理网为您总结一下常见的机器学习算法,以供您在工作和学习中参考。 机器学习的算法很多。很多时候困惑人们都是,很多算法是一类算法,而有些算法又是从其他算法中延伸出来的。这里,我们从两个方面来给大家介绍,第一个方面是学习的方式,第二个方面是算法的类似性。 学习方式 根据数据类型的不同,对一个问题的建模有不同的方式。在机器学习或者人工智能领域,人们首先会考虑算法的学习方式。在机器学习领域,有几种主要的学习方式。将算法按照学习方式分类是一个不错的想法,这样可以让人们在建模和算法选择的时候考虑能根据输入数据来选择最合适的算法来获得最好的结果。 监督式学习: 在监督式学习下,输入数据被称为“训练数据”,每组训练数据有一个明确的标识或结果,如对防垃圾邮件系统中“垃圾邮件”“非垃圾邮件”,对手写数字识别中的“1“,”2“,”3“,”4“等。在建立预测模型的时候,监督式学习建立一个学习过程,将预测结果与“训练数据”的实际结果进行比较,不断的调整预测模型,直到模型的预测结果达到一个预期的准确率。监督式学习的常见应用场景如分类问题和回归问题。常见算法有逻辑回归(Logistic Regression)和反向传递神经网络(Back Propagation Neural Network) 非监督式学习: 在非监督式学习中,数据并不被特别标识,学习模型是为了推断出数据的一些内在结构。常见的应用场景包括关联规则的学习以及聚类等。常见算法包括Apriori算法以及k-Means算法。 半监督式学习: 1、C4.5 机器学习中,决策树是一个预测模型;他代表的是对象属性与对象值之间的一种映射关系。树中每个节点表示某个对象,而每个分叉路径则代表的某个可能的属性值,而每个叶结点则对应从根节点到该叶节点所经历的路径所表示的对象的值。决策树仅有单一输出,若欲有复数输出,可以建立独立的决策树以处理不同输出。从数据产生决策树的机器学习技术叫做决策树学习, 通俗说就是决策树。 决策树学习也是数据挖掘中一个普通的方法。在这里,每个决策树都表述了一种树型结构,他由他的分支来对该类型的对象依靠属性进行分类。每个决策树可以依靠对源数据库的分割进行数据测试。这个过程可以递归式的对树进行修剪。当不能再进行分割或一个单独的类可以被应用于某一分支时,递归过程就完成了。另外,随机森林分类器将许多决策树结合起来以提升分类的正确率。决策树同时也可以依靠计算条件概率来构造。决策树如果依靠数学的计算方法可以取得更加理想的效果。决策树一般都是自上而下的来生成的。 选择分割的方法有好几种,但是目的都是一致的:对目标类尝试进行最佳的分割。从根到叶子节点都有一条路径,这条路径就是一条“规则”。决策树可以是二叉的,也可以是多叉的。对每个节点的衡量: 1)通过该节点的记录数 2)如果是叶子节点的话,分类的路径 3)对叶子节点正确分类的比例。 有些规则的效果可以比其他的一些规则要好。由于ID3算法在实际应用中存在一些问题,于是Quilan提出了C4.5算法,严格上说C4.5只能是ID3的一个改进算法。相信大家对ID3算法都很.熟悉了,这里就不做介绍。 C4.5算法继承了ID3算法的优点,并在以下几方面对ID3算法进行了改进: 1) 用信息增益率来选择属性,克服了用信息增益选择属性时偏向选择取值多的属性的不足; 2) 在树构造过程中进行剪枝; 3) 能够完成对连续属性的离散化处理; 4) 能够对不完整数据进行处理。 前端资源收集 前端资-源收集 收集的资-源 44个 Javascript 变态题解析 javascript 变态题解析 正则表达式收集 正则表达式收集 十大经典排序算法总结(JavaScript描述)排序算法的总结 前端工具库汇总 前端工具库总结 怎么学JavaScript? 学习javascript 的学习指导 不定期更新 JavaScript技巧 javascript 编码技巧总结 H5项目常见问题汇总及解决方案 高质量的常见问题汇总 廖雪峰的 git 教-程 Git忽略规则.gitignore梳理 git 配置提交规则 全局环境,执行环境 setTimeout promises 很酷,但很多人并没有理解就在用了 promises 使用错误汇总 promises webpack 2 中文文档 输入url后的加载过程 详细解答从输入URL 到页面显示的过程 数组Array.prototype方法 介绍了数组的一些新的方法 移动端真机调试 Web 客户端存储 ESLint中文指南 webpack 2 集成ESLint react-webpack2-skeleton webpack 2 react 成功案例,包括热加载 cookie 小结 CSS定制多行省略 Ajax 知识体系大梳理 js+nodejs完成文件上传 用 webpack 实现持久化缓存 搜罗一切webpack的好文章好工具 深入理解 CSS:字体度量、line-height 和 vertical-align 原生JS中DOM节点相关API合集 正则表达式前端使用手册 聊一聊H5应用缓存-Manifest fetch进阶指南 mozilla 开发者网络 深入理解javascript原型和闭包系列JavaScript深入系列 深度长文 JavaScript数组所有API全解密你真的懂 JavaScript 的正则吗?webpack2 终极优化 文件上传那些事儿 写给前端工程师的DNS基础知识 初识weex(前端视角) - 环境搭建 前端命名规范 正则表达式 总有你要的编程书单(GitHub )JavaScript深入系列 javascript 的一些功能点 如何在小程序中调用本地接口 移动端浏览器调试方法汇总 HTML5移动开发中的input输入框类型 互联网协议入门 机器学习十大经典算法 机器学习中,决策树是一个预测模型;他代表的是对象属性与对象值之间的一种映射关系。树中每个节点表示某个对象,而每个分叉路径则代表的某个可能的属性值,而每个叶结点则对应从根节点到该叶节点所经历的路径所表示的对象的值。决策树仅有单一输出,若欲有复数输出,可以建立独立的决策树以处理不同输出。 从数据产生决策树的机器学习技术叫做决策树学习,?通俗说就是决策树。 决策树学习也是数据挖掘中一个普通的方法。在这里,每个决策树都表述了一种树型结构,他由他的分支来对该类型的对象依靠属性进行分类。每个决策树可以依靠对源数据库的分割进行数据测试。这个过程可以递归式的对树进行修剪。?当不能再进行分割或一个单独的类可以被应用于某一分支时,递归过程就完成了。另外,随机森林分类器将许多决策树结合起来以提升分类的正确率。 决策树同时也可以依靠计算条件概率来构造。决策树如果依靠数学的计算方法可以取得更加理想的效果。 决策树是如何工作的 决策树一般都是自上而下的来生成的。 选择分割的方法有好几种,但是目的都是一致的:对目标类尝试进行最佳的分割。 从根到叶子节点都有一条路径,这条路径就是一条“规则”。 决策树可以是二叉的,也可以是多叉的。 对每个节点的衡量: 1)?通过该节点的记录数 2)?如果是叶子节点的话,分类的路径 3)?对叶子节点正确分类的比例。 有些规则的效果可以比其他的一些规则要好。 由于ID3算法在实际应用中存在一些问题,于是Quilan提出了C4.5算法,严格上说C4.5只能是ID3的一个改进算法。相信大家对ID3算法都很.熟悉了,这里就不做介绍。 ?C4.5算法继承了ID3算法的优点,并在以下几方面对ID3算法进行了改进: ?1)?用信息增益率来选择属性,克服了用信息增益选择属性时偏向选择取值多的属性的不足; ?2)?在树构造过程中进行剪枝; ?3)?能够完成对连续属性的离散化处理; ?4)?能够对不完整数据进行处理。 ?C4.5算法有如下优点:产生的分类规则易于理解,准确率较高。其缺点是:在构造树的过程中,需要对数据集进行多次的顺序扫描和排序,因而导致算法的低效。此外,C4.5只适合于能够驻留于内存的数据集,当训练集大得无法在内存容纳时程序无法运行。 来自搜索的其他内容: C4.5算法是机器学习算法中的一种分类决策树算法,其核心算法 关于机器学习的十大经典算法 1、C4.5 C4.5算法是机器学习算法中的一种分类决策树算法,其核心算法是ID3算法.C4.5算法继承了ID3算法的优点,并在以下几方面对ID3算法进行了改进: 1)用信息增益率来选择属性,克服了用信息增益选择属性时偏向选择取值多的属性的不足; 2)在树构造过程中进行剪枝; 3)能够完成对连续属性的离散化处理; 4)能够对不完整数据进行处理。 C4.5算法有如下优点:产生的分类规则易于理解,准确率较高。其缺点是:在构造树的过程中,需要对数据集进行多次的顺序扫描和排序,因而导致算法的低效。 2、Thek-meansalgorithm即K-Means算法 k-meansalgorithm算法是一个聚类算法,把n的对象根据他们的属性分为k个分割,k 1.什么是C4.5 C4.5是一套算法,这套算法主要用于对机器学习和数据挖掘中的分类问题。它是一种有监督的学习,也就是说对于该算法我们需要先给它提供一个数据集,这个数据集包含多个实例,每个实例都包含多个属性,该实例用这些属性进行描述,根据属性取值的不同被划分到不同的互斥类中,C4.5从提供的数据集中学习到如何将不同属性值的实例划分到不同类的映射,当我们提供全新的一套属性值的时候,它能够通过学到的映射对新的属性值进行分类。例如,查看图1-1这组训练数据,每一行对应于一个实例,属性值包括对天气的展望(对应于一个三值变量,也就是说该数据的取值只能是设置的三种情况的一种),温度(一个连续取值的变量),湿度(一个连续取值的变量)和是否有风(二进制值),所有的实例被划分为两类也就是是否适合打高尔夫。我们的目的就是从训练数据中学到一个映射,这个映射可以用于对在图中未出现的实例属性取值情况进行有效分类。 C4.5是由J.Ross Quinlan提出的,由于它是ID3(一种著名的决策树归纳算法)的后续版本,因此被如此命名。决策树的决策结点是一系列系统化安排的问题,这些问题用于测试某一具体属性(例如:对天气的展望outlook),对每个结点上问题的不同测试输出产生不同的分支,最后会达到叶子结点。叶子结点的值也就是最终的划分类别(如:是否打高尔夫)。决策树就像我们汽车的维修手册一样,我们对每一个检修问题进行排查最终确定我们的汽车什么出了问题。除了推演树,C4.5还可以将决策树用表示规则形式表示。然而对规则后剪枝操作将导致无法很好的将规则转化为决策树。 从C4.5的历史线索我们可以看出许多小团体或多或少的聚集在了一些解决思路相似的分类方法上。ID3的发展独立于Friedman设计的原始树归纳算法,这种原始树归纳算法经过Breiman,Olsen和Stone三人的改进之后变为我们熟知的CART算法。虽然上文中说ID3独立于原始树归纳算法,但是从诸多的有关CART的参考文献中我们可以看到在C4.5的设计决策的部分似乎受到了CART的影响或者由CART改进而来,例如处理特殊属性的部分。同时Quinlan本人也承认在设计ID3和C4.5的时候受到了概念学习系统CLS的影响。如今,C4.5已经完全由一种由Rulequest Reasearch,Inc提供的商业产品See5/C5.0取代。 10大算法中的两个算法是基于树的算法充分证实了这种机器学习算法在数据挖掘中的流行性。以前决策树被用于具有面值或分类数据的领域,然而如今决策树被用于具有数值的, Chapter4 Apriori Hiroshi Motoda and Kouzou Ohara Contents 4.1Introduction (62) 4.2Algorithm Description (62) 4.2.1Mining Frequent Patterns and Association Rules (62) 4.2.1.1Apriori (63) 4.2.1.2AprioriTid (66) 4.2.2Mining Sequential Patterns (67) 4.2.2.1AprioriAll (68) 4.2.3Discussion (69) 4.3Discussion on Available Software Implementations (70) 4.4Two Illustrative Examples (71) 4.4.1Working Examples (71) 4.4.1.1Frequent Itemset and Association Rule Mining (71) 4.4.1.2Sequential Pattern Mining (75) 4.4.2Performance Evaluation (76) 4.5Advanced Topics (80) 4.5.1Improvement in Apriori-Type Frequent Pattern Mining (80) 4.5.2Frequent Pattern Mining Without Candidate Generation (81) 4.5.3Incremental Approach (82) 4.5.4Condensed Representation:Closed Patterns and Maximal Patterns (82) 4.5.5Quantitative Association Rules (84) 4.5.6Using Other Measure of Importance/Interestingness (84) 4.5.7Class Association Rules (85) 4.5.8Using Richer Expression:Sequences,Trees,and Graphs (86) 4.6Summary (87) 4.7Exercises (88) References (89) 61 2017年第6期信息通信2017 (总第174 期)INFORMATION & COMMUNICATIONS (Sum. No 174)机器学习算法研究及前景展望 陈嘉博 (重庆邮电大学,重庆400065) 摘要:近年,随着人工智能的快速发展,机器学习逐渐成为学术研究的热点。机器学习是人工智能的核心,专门研究计 算机怎样模拟和人类的学习行为,重新组织已有的知识结构并以此来改善自身功能。通过分析机器学习的经典算法中 的BP神经网络算法,深度学习算法以及朴素贝叶斯算法的模型和理论依据来对机器学习做简单的介绍,同时阐述了经 典算法在机器学习中的重要应用,最后探讨了机器学习未来的愿景。 关键词:机器学刁;深度学习;神经网络;算法 中图分类号:TP181 文献标识码:A文章编号=1673-1131(2017)06-0005-02 〇引言 学习是人类具备的重要能力,现在计算机发展到了具有逐步学习能力的阶段。什么是机器学习呢?机器学习通过自主学习大量数据中存在的规律,获得新经验和知识从而提高计算机智能,使得计算机拥有类似人类的决策能力?随着大数据和硬件技术的计算和存储能力的发展,机器学习得到了迅猛的发展。但目前机器学习仍处于初级发展阶段,计算机在处理问题的能力上与人脑相比仍有很大的差距 1机器学习的经典算法 机器学习主要目的在于自主地在数据中得到相应的结论。机器学习算法主要是通过数学及统计方法求解问题的最优解的过程。下面介绍机器学习领域的B P神经网络算法,深度学习算法以及朴素贝叶斯分类算法。 1.1 B P神经网络算法 B P神经网络是由Rumelhart和MeCelland在1986年提出的,是一种按误差逆传播算法训练的多层前馈网络,是目前阈值,使该神经网络的误差平方和最小。 机器学习可以看做是数理统计的一个应用,在数理统计中—个常见的任务就是拟合,也就是给定一些样本点,用合适的曲线揭示这些样本点随着自变量的变化关系。但是样本点不再限定在简单的轴上,而是由向量构成的广义点,而这将形成多层复合函数。同时多层神经网络的本质即为多层复合函数。 Layer L, Layer L2 应用最广泛的神经网络模型之一。B P神经网络能够学习和存储大量的输入一输出模式映射关系,而并不需要在事前掲示描述这种映射关系的数学方程。它使用梯度下降法作为它的学习规则,通过反向传播的方式来调整神经网络的权值和 图1神经网络拓扑结构 B P网络是阶层型神经网络,分为输入层,隐含层以及输出层三层。其中隐层可扩展为多层。神经网络中相邻层之间的各个神经元进行全连接,而每层各神经元之间完全绝缘。如 制热状态,若温度超过标准值,输出为低电平,热电制冷器处于制冷状态,并设置发光二极管D1(红)处于导通状态?若温度超过标准值,则13管脚输出低电平,热电制冷器处于制冷状态,同理发光二极管D2(绿)处于导通状态。3结论 基于LM317正电压稳压器的驱动模块和LTC1293开关 模式芯片的温度自动控制模块,利用LABVIEW软件开发上 位机控制系统。该系统具有自动控温,多通道信号解调,及计 算机采集处理等功能。利用解调系统对光纤光栅传感器解调 实验结果表明:自制解调系统可实现8通道的动态信号实时 解调,系统可用于0~300kH z髙频动态信号检测。能够满足工 程方面的广泛应用。 参考文献: [1]张瑞君.波长可调谐DFB激光器以其进展[J].集成电路通 m,2006,24(2):42-47. [2]赵立民,李文强.光纤B ragg光栅传感器的解调方法概述 [J].传感器与微系统肩.26⑶:17-19. [3]康守强.基于D S P的光纤Bragg光栅传感信号解调技术 的研究[D].哈尔滨:哈尔滨理工大学.20076-11. [4]马丽,史铁林,张东生,等.光纤光栅的解调方法探究[J].科技 资讯,2006,31:38-39. [5]李学成?基于光纤光栅地震传感器的研究[D].兰州:兰州大 学,2010:25-28. 5机器学习10大算法-周辉

十大经典数学模型

机器学习十大算法:CART

机器学习的十种经典算法详解

十 大 经 典 排 序 算 法 总 结 超 详 细

机器学习十大算法8:kNN

数据挖掘领域的十大经典算法原理及应用

人工智能之机器学习常见算法

数据挖掘中十大经典算法

机器学习常见算法分类汇总

机器学习10大经典算法.

十 大 经 典 排 序 算 法 总 结 超 详 细

十 大 经 典 排 序 算 法 总 结 超 详 细

关于机器学习的十大经典算法

机器学习十大算法 C4.5中文翻译

机器学习十大算法:Apriori

机器学习算法研究及前景展望