人工智能原理教案03章 不确定性推理方法3.3 主观BAYES方法

3.3主观Bayes方法

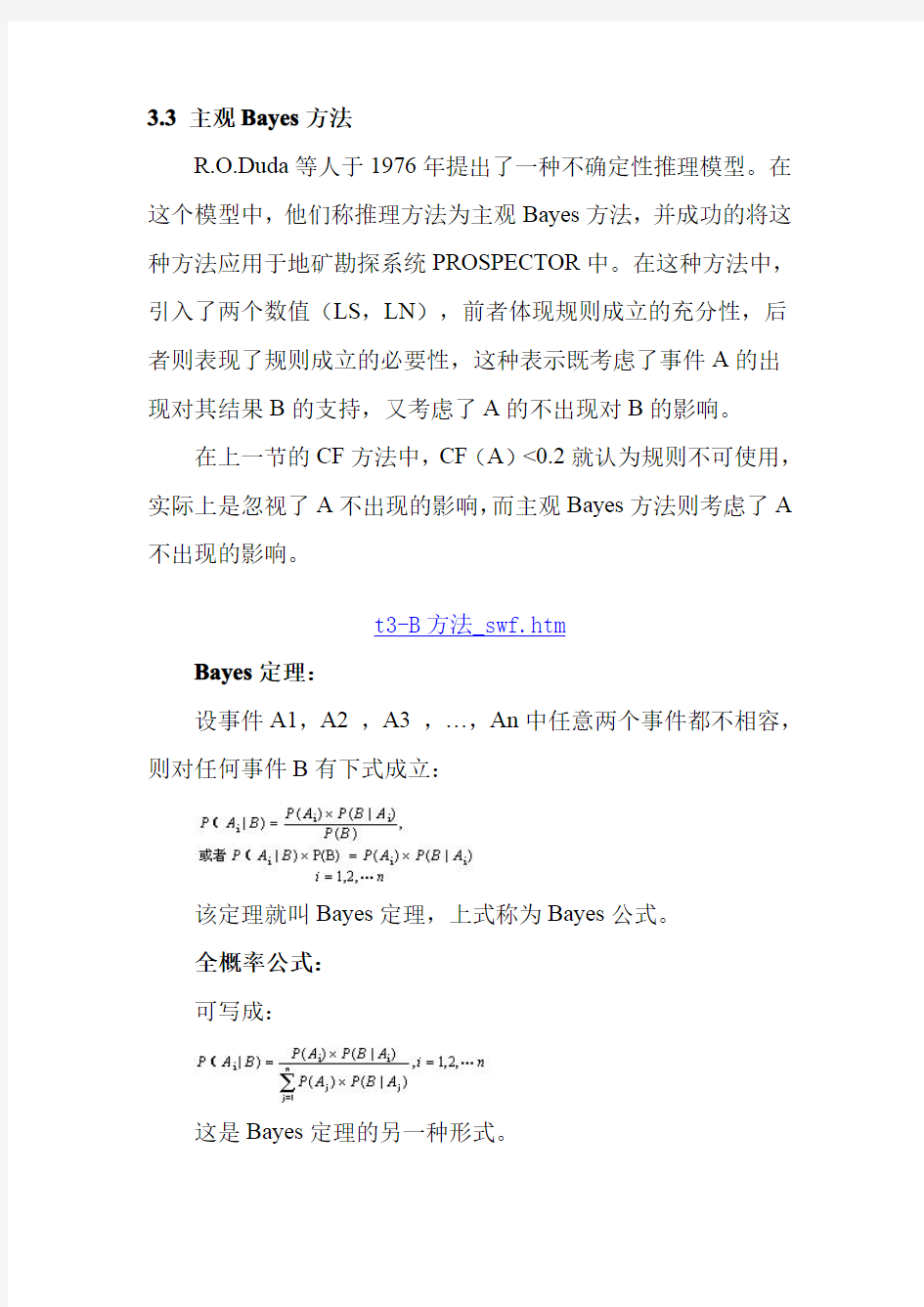

R.O.Duda等人于1976年提出了一种不确定性推理模型。在这个模型中,他们称推理方法为主观Bayes方法,并成功的将这种方法应用于地矿勘探系统PROSPECTOR中。在这种方法中,引入了两个数值(LS,LN),前者体现规则成立的充分性,后者则表现了规则成立的必要性,这种表示既考虑了事件A的出现对其结果B的支持,又考虑了A的不出现对B的影响。

在上一节的CF方法中,CF(A)<0.2就认为规则不可使用,实际上是忽视了A不出现的影响,而主观Bayes方法则考虑了A 不出现的影响。

t3-B方法_swf.htm

Bayes定理:

设事件A1,A2,A3,…,An中任意两个事件都不相容,则对任何事件B有下式成立:

该定理就叫Bayes定理,上式称为Bayes公式。

全概率公式:

可写成:

这是Bayes定理的另一种形式。

Bayes定理给出了一种用先验概率P(B|A),求后验概率P (A|B)的方法。例如用B代表发烧,A代表感冒,显然,求发烧的人中有多少人是感冒了的概率P(A|B)要比求因感冒而发烧的概率P(B|A)困难得多。

3.3.1规则的不确定性

为了描述规则的不确定性,引入不确定性描述因子LS,LN:对规则A→B的不确定性度量f(B,A)以因子(LS,LN)来描述:

表示A真时对B的影响,即规则成立的充分性

表示A假时对B的影响,即规则成立的必要性

实际应用中概率值不可能求出,所以采用的都是专家给定的LS,LN值。从LS,LN的数学公式不难看出,LS表征的是A的发生对B发生的影响程度,而LN表征的是A的不发生对B发生的影响程度。

几率函数O(X):

即,表示证据X的出现概率和不出现的概率之比,显然O(X)是P(X)的增函数,且有:

P(X)=0,O(X)=0

P(X)=0.5,O(X)=1

P(X)=1,O(X)=∞,几率函数实际上表示了证据X的不确定性。

几率函数与LS,LN的关系:

O(B|A)=LS·O(B)

O(B|~A)=LN·O(B)

几个特殊值:

LS、LN≥0,不独立。

LS,LN不能同时>1或<1

LS,LN可同时=1

3.3.2证据的不确定性

证据的不确定性度量用几率函数来描述:

虽然几率函数与概率函数有着不同的形式,但是变化趋势是相同的:当A为真的程度越大(P(A)越大)时,几率函数的值也越大。

由于几率函数是用概率函数定义的,所以,在推理过程中经

常需要通过几率函数值计算概率函数值时,此时可用如下等式:

3.3.3推理计算

由于是不确定性推理,所以必须讨论证据发生的各种可能性。

①A必出现时(即P(A)=1):

O(B|A)=LS·O(B)

O(B|~A)=LN·O(B)

②当A不确定时即P(A)≠1时

设A'代表与A有关的所有观察,

P(B|A')=P(B|A)P(A|A')+P(B|~A)P(~A|A')

当P(A|A')=1时,证据A必然出现

当P(A|A')=0时,证据A必然不出现

当P(A|A')=P(A)时,观察A'对A没有影响:

P(B|A')=P(B)

这样可得P(A|A')为0,P(A),1时相应的P(B|A')的值,根据这三点可以得到线性插值图,见图3-2。P(A|A')的其它取值下的P(B|A')可根据此图通过线性插值法得到。

更简单的还有用两点直线插值的,当然也可以用更复杂的插

值方法,只要你有足够的数据。

图3-2线性插值图

t3-2插值_swf.htm

当证据不确定时,证据理论推理的基本原理是,从该证据A 往前看,即寻找A的出处。如果A是由A'导出的,即A'→A→B,则当A不清楚的时候,采用A'的相关信息进行计算。如果还不行,就再往前推。是一个递归推导的过程。

注意:A'是指从A向前看的各个相关证据,所以有时可能存在多个相关证据。

③当存在两个证据时

P(A1∧A2|A')=min{P(A1|A'),P(A2|A')}

P(A1∨A2|A')=max{P(A1|A'),P(A2|A')}

④多个观察时

若A1→B,A2→B而A1,A2相互独立,对A1,A2的观察分别为A1',A2'

例题1

已知:P(A)=1,P(B1)=0.04,P(B2)=0.02

R1:A→B1LS=20LN=1

R2:B1→B2LS=300LN=0.001

计算:P(B2|A)

分析:当使用规则R2时,证据B1并不是确定的发生了,即P(B1)≠1,因此要采用插值方法。

解:

先依照A必然发生,由定义和R1得:

O(B1)=0.04/(1-0.04)=0.0417

O(B1|A)=LS*O(B1)=0.83

P(B1|A)=0.83/(1+0.83)=0.454

然后假设P(B1|A)=1,计算:

P(B2|B1)=300*0.02/(300*0.02+1)=0.857

最后进行插值:

P(B2|A)=0.02+(0.857-0.02)*(0.454-0.04)/(1-0.04)

=0.410

例题2

已知:证据A1,A2必然发生,且P(B1)=0.03,P(B2)=0.01,规则如下:

R1:A1→B1LS=20LN=1

R2:A2→B1LS=300LN=1

R3:B1→B2LS=300LN=0.0001

求B1,B2的更新值。

解:

先求B1的更新值:

依R1,P1(B)=0.03

O(B1)=0.03/(1-0.03)=0.030927

O(B1|A1)=LS×O(B1)=20×0.030927=0.61855

P(B1|A1)=0.61855/(1+0.61855)=0.382

使用规则R1后,B1的概率从0.03上升到0.382

依R2:

O(B1|A1A2)=300×O(B1|A1)=185.565

P(B1|A1A2)=185.565/(1+185.565)=0.99464

使用规则R2后,B1的概率从0.382上升到0.99464

再求B2的更新值:

由于B1不确定所以讨论其前项证据A,

证据A必然发生时,由以上计算可知P(B1)=0.03,规则R1:A1→B1LS=20LN=1

对于规则R1,证据A必然发生,可得

P(B1|A)=0.382;

但是使用规则R3时,B1并非确定地发生,因此要用插值法。先假设P(B1|A)=1,此时

P(B2|B1)=300*0.01/((300-1)*0.01+1)(公式(1))

=0.75188

再假设P(B1|A)=P(B1)=0.03时,即A对B1无影响

P(B2)=0.01

根据这两个值可进行插值计算:

P(B2|A)=0.01+(0.75188-0.01)*(0.382-0.03)/(1-0.03)

=0.305105

总结

主观Bayes方法优点:直观,明了。

问题:要求B j个事件相互独立(无关),实际上是不可能的。

P(A/B i)和P(B i)难以计算。实际应用中,为了避开这一点采用LS,LN的专家给定值。

《人工智能原理及其应用》(王万森)第3版课后习题答案

第1章人工智能概述课后题答案 1.1什么是智能?智能包含哪几种能力? 解:智能主要是指人类的自然智能。一般认为,智能是是一种认识客观事物和运用知识解决问题的综合能力。 智能包含感知能力,记忆与思维能力,学习和自适应能力,行为能力 1.2人类有哪几种思维方式?各有什么特点? 解:人类思维方式有形象思维、抽象思维和灵感思维 形象思维也称直感思维,是一种基于形象概念,根据感性形象认识材料,对客观对象进行处理的一种思维方式。 抽象思维也称逻辑思维,是一种基于抽象概念,根据逻辑规则对信息或知识进行处理的理性思维形式。 灵感思维也称顿悟思维,是一种显意识与潜意识相互作用的思维方式。 1.3什么是人工智能?它的研究目标是什么? 解:从能力的角度讲,人工智能是指用人工的方法在机器(计算机)上实现智能;从学科的角度看,人工智能是一门研究如何构造智能机器或智能系统,使它能模拟、延伸和扩展人类智能的学科。 研究目标: 对智能行为有效解释的理论分析; 解释人类智能; 构造具有智能的人工产品; 1.4什么是图灵实验?图灵实验说明了什么? 解:图灵实验可描述如下,该实验的参加者由一位测试主持人和两个被测试对象组成。其中,两个被测试对象中一个是人,另一个是机器。测试规则为:测试主持人和每个被测试对象分别位于彼此不能看见的房间中,相互之间只能通过计算机终端进行会话。测试开始后,由测试主持人向被测试对象提出各种具有智能性的问题,但不能询问测试者的物理特征。被测试对象在回答问题时,都应尽量使测试者相信自己是“人”,而另一位是”机器”。在这个前提下,要求测试主持人区分这两个被测试对象中哪个是人,哪个是机器。如果无论如何更换测试主持人和被测试对象的人,测试主持人总能分辨出人和机器的概率都小于50%,则认为该机器具有了智能。 1.5人工智能的发展经历了哪几个阶段? 解:孕育期,形成期,知识应用期,从学派分立走向综合,智能科学技术学科的兴起

确定性与不确定性推理主要方法-人工智能导论

确定性与不确定性推理主要方法 1.确定性推理:推理时所用的知识与证据都是确定的,推出的结论也是确定的,其真值或者为真或者为假。 2.不确定性推理:从不确定性的初始证据出发,通过运用不确定性的知识,最终推出具有一定程度的不确定性但却是合理或者近乎合理的结论的思维过程。 3.演绎推理:如:人都是会死的(大前提) 李四是人(小前提) 所有李四会死(结论) 4.归纳推理:从个别到一般:如:检测全部产品合格,因此该厂产品合格; 检测个别产品合格,该厂产品合格。 5.默认推理:知识不完全的情况下假设某些条件已经具备所进行的推理; 如:制作鱼缸,想到鱼要呼吸,鱼缸不能加盖。 6.不确定性推理中的基本问题: ①不确定性的表示与量度: 1)知识不确定性的表示 2)证据不确定性的表示 3)不确定性的量度 ②不确定性匹配算法及阈值的选择 1)不确定性匹配算法:用来计算匹配双方相似程度的算法。 2)阈值:用来指出相似的“限度”。 ③组合证据不确定性的算法 最大最小方法、Hamacher方法、概率方法、有界方法、Einstein方 法等。 ④不确定性的传递算法 1)在每一步推理中,如何把证据及知识的不确定性传递给结论。 2)在多步推理中,如何把初始证据的不确定性传递给最终结论。 ⑤结论不确定性的合成 6.可信度方法:在确定性理论的基础上,结合概率论等提出的一种不确定性推

理方法。其优点是:直观、简单,且效果好。 可信度:根据经验对一个事物或现象为真的相信程度。可信度带有较大的主观性和经验性,其准确性难以把握。C-F模型:基于可信度表示的不确定性推理的基本方法。 CF(H,E)的取值范围: [-1,1]。 若由于相应证据的出现增加结论 H 为真的可信度,则 CF(H,E)> 0,证据的出现越是支持 H 为真,就使CF(H,E) 的值越大。 反之,CF(H,E)< 0,证据的出现越是支持 H 为假,CF(H,E)的值就越小。若证据的出现与否与 H 无关,则 CF(H,E)= 0。 证据E的可信度取值范围:[-1,1] 。 对于初始证据,若所有观察S能肯定它为真,则CF(E)= 1。 若肯定它为假,则 CF(E) = –1。 若以某种程度为真,则 0 < CF(E) < 1。 若以某种程度为假,则-1 < CF(E) < 0 。 若未获得任何相关的观察,则 CF(E) = 0。 静态强度CF(H,E):知识的强度,即当 E 所对应 的证据为真时对 H 的影响程度。 动态强度 CF(E):证据 E 当前的不确定性程度。 C-F模型中的不确定性推理:从不确定的初始证据出发,通过运用相关的不确定性知识,最终推出结论并求出结论的可信度值。 模糊逻辑给集合中每一个元素赋予一个介于0和1之间的实数,描述其属于一个集合的强度,该实数称为元素属于一个集合的隶属度。集合中所有元素的隶属度全体构成集合的隶属函数。 模糊知识表示 人类思维判断的基本形式: 如果(条件)→则(结论)

人工智能不确定性推理部分参考答案教学提纲

人工智能不确定性推理部分参考答案

不确定性推理部分参考答案 1.设有如下一组推理规则: r1: IF E1 THEN E2 (0.6) r2: IF E2 AND E3 THEN E4 (0.7) r3: IF E4 THEN H (0.8) r4: IF E5 THEN H (0.9) 且已知CF(E1)=0.5, CF(E3)=0.6, CF(E5)=0.7。求CF(H)=? 解:(1) 先由r1求CF(E2) CF(E2)=0.6 × max{0,CF(E1)} =0.6 × max{0,0.5}=0.3 (2) 再由r2求CF(E4) CF(E4)=0.7 × max{0, min{CF(E2 ), CF(E3 )}} =0.7 × max{0, min{0.3, 0.6}}=0.21 (3) 再由r3求CF1(H) CF1(H)= 0.8 × max{0,CF(E4)} =0.8 × max{0, 0.21)}=0.168 (4) 再由r4求CF2(H) CF2(H)= 0.9 ×max{0,CF(E5)} =0.9 ×max{0, 0.7)}=0.63 (5) 最后对CF1(H )和CF2(H)进行合成,求出CF(H) CF(H)= CF1(H)+CF2(H)+ CF1(H) × CF2(H) =0.692

2 设有如下推理规则 r1: IF E1 THEN (2, 0.00001) H1 r2: IF E2 THEN (100, 0.0001) H1 r3: IF E3 THEN (200, 0.001) H2 r4: IF H1 THEN (50, 0.1) H2 且已知P(E1)= P(E2)= P(H3)=0.6, P(H1)=0.091, P(H2)=0.01, 又由用户告知: P(E1| S1)=0.84, P(E2|S2)=0.68, P(E3|S3)=0.36 请用主观Bayes方法求P(H2|S1, S2, S3)=? 解:(1) 由r1计算O(H1| S1) 先把H1的先验概率更新为在E1下的后验概率P(H1| E1) P(H1| E1)=(LS1× P(H1)) / ((LS1-1) × P(H1)+1) =(2 × 0.091) / ((2 -1) × 0.091 +1) =0.16682 由于P(E1|S1)=0.84 > P(E1),使用P(H | S)公式的后半部分,得到在当前观察S1下的后验概率P(H1| S1)和后验几率O(H1| S1) P(H1| S1) = P(H1) + ((P(H1| E1) – P(H1)) / (1 - P(E1))) × (P(E1| S1) – P(E1)) = 0.091 + (0.16682 –0.091) / (1 – 0.6)) × (0.84 – 0.6) =0.091 + 0.18955 × 0.24 = 0.136492 O(H1| S1) = P(H1| S1) / (1 - P(H1| S1)) = 0.15807 (2) 由r2计算O(H1| S2) 先把H1的先验概率更新为在E2下的后验概率P(H1| E2) P(H1| E2)=(LS2×P(H1)) / ((LS2-1) × P(H1)+1)

不确定性推理部分参考答案

第6章不确定性推理部分参考答案 6.8 设有如下一组推理规则: r1: IF E1THEN E2 (0.6) r2: IF E2AND E3THEN E4 (0.7) r3: IF E4THEN H (0.8) r4: IF E5THEN H (0.9) 且已知CF(E1)=0.5, CF(E3)=0.6, CF(E5)=0.7。求CF(H)=? 解:(1) 先由r1求CF(E2) CF(E2)=0.6 × max{0,CF(E1)} =0.6 × max{0,0.5}=0.3 (2) 再由r2求CF(E4) CF(E4)=0.7 × max{0, min{CF(E2 ), CF(E3 )}} =0.7 × max{0, min{0.3, 0.6}}=0.21 (3) 再由r3求CF1(H) CF1(H)= 0.8 × max{0,CF(E4)} =0.8 × max{0, 0.21)}=0.168 (4) 再由r4求CF2(H) CF2(H)= 0.9 ×max{0,CF(E5)} =0.9 ×max{0, 0.7)}=0.63 (5) 最后对CF1(H )和CF2(H)进行合成,求出CF(H) CF(H)= CF1(H)+CF2(H)+ CF1(H) × CF2(H) =0.692 6.10 设有如下推理规则 r1: IF E1THEN (2, 0.00001) H1 r2: IF E2THEN (100, 0.0001) H1 r3: IF E3THEN (200, 0.001) H2 r4: IF H1THEN (50, 0.1) H2 且已知P(E1)= P(E2)= P(H3)=0.6, P(H1)=0.091, P(H2)=0.01, 又由用户告知: P(E1| S1)=0.84, P(E2|S2)=0.68, P(E3|S3)=0.36 请用主观Bayes方法求P(H2|S1, S2, S3)=? 解:(1) 由r1计算O(H1| S1) 先把H1的先验概率更新为在E1下的后验概率P(H1| E1) P(H1| E1)=(LS1× P(H1)) / ((LS1-1) × P(H1)+1) =(2 × 0.091) / ((2 -1) × 0.091 +1) =0.16682 由于P(E1|S1)=0.84 > P(E1),使用P(H | S)公式的后半部分,得到在当前观察S1下的后验概率P(H1| S1)和后验几率O(H1| S1)

人工智能原理及其应用(第2版)》王万森编著电子工业出版社课后习题答案37

第2章知识表示方法部分参考答案 2.8设有如下语句,请用相应的谓词公式分别把他们表示出来: (1)有的人喜欢梅花,有的人喜欢菊花,有的人既喜欢梅花又喜欢菊花。 解:定义谓词 P(x):x是人 L(x,y):x喜欢y 其中,y的个体域是{梅花,菊花}。 将知识用谓词表示为: (?x )(P(x)→L(x, 梅花)∨L(x, 菊花)∨L(x, 梅花)∧L(x, 菊花)) (2) 有人每天下午都去打篮球。 解:定义谓词 P(x):x是人 B(x):x打篮球 A(y):y是下午 将知识用谓词表示为: (?x )(?y) (A(y)→B(x)∧P(x)) (3)新型计算机速度又快,存储容量又大。 解:定义谓词 NC(x):x是新型计算机 F(x):x速度快 B(x):x容量大 将知识用谓词表示为: (?x) (NC(x)→F(x)∧B(x)) (4) 不是每个计算机系的学生都喜欢在计算机上编程序。 解:定义谓词 S(x):x是计算机系学生 L(x, pragramming):x喜欢编程序 U(x,computer):x使用计算机 将知识用谓词表示为: ?(?x) (S(x)→L(x, pragramming)∧U(x,computer)) (5)凡是喜欢编程序的人都喜欢计算机。 解:定义谓词 P(x):x是人 L(x, y):x喜欢y 将知识用谓词表示为:

( x) (P(x)∧L(x,pragramming)→L(x, computer)) 2.9用谓词表示法求解机器人摞积木问题。设机器人有一只机械手,要处理的世界有一张桌子,桌上可堆放若干相同的方积木块。机械手有4个操作积木的典型动作:从桌上拣起一块积木;将手中的积木放到桌之上;在积木上再摞上一块积木;从积木上面拣起一块积木。积木世界的布局如下图所示。 图机器人摞积木问题 解:(1) 先定义描述状态的谓词 CLEAR(x):积木x上面是空的。 ON(x, y):积木x在积木y的上面。 ONTABLE(x):积木x在桌子上。 HOLDING(x):机械手抓住x。 HANDEMPTY:机械手是空的。 其中,x和y的个体域都是{A, B, C}。 问题的初始状态是: ONTABLE(A) ONTABLE(B) ON(C, A) CLEAR(B) CLEAR(C) HANDEMPTY 问题的目标状态是: ONTABLE(C) ON(B, C) ON(A, B) CLEAR(A) HANDEMPTY (2) 再定义描述操作的谓词 在本问题中,机械手的操作需要定义以下4个谓词: Pickup(x):从桌面上拣起一块积木x。 Putdown(x):将手中的积木放到桌面上。 Stack(x, y):在积木x上面再摞上一块积木y。

人工智能原理教案03章 不确定性推理方法3.3 主观BAYES方法

3.3主观Bayes方法 R.O.Duda等人于1976年提出了一种不确定性推理模型。在这个模型中,他们称推理方法为主观Bayes方法,并成功的将这种方法应用于地矿勘探系统PROSPECTOR中。在这种方法中,引入了两个数值(LS,LN),前者体现规则成立的充分性,后者则表现了规则成立的必要性,这种表示既考虑了事件A的出现对其结果B的支持,又考虑了A的不出现对B的影响。 在上一节的CF方法中,CF(A)<0.2就认为规则不可使用,实际上是忽视了A不出现的影响,而主观Bayes方法则考虑了A 不出现的影响。 t3-B方法_swf.htm Bayes定理: 设事件A1,A2,A3,…,An中任意两个事件都不相容,则对任何事件B有下式成立: 该定理就叫Bayes定理,上式称为Bayes公式。 全概率公式: 可写成: 这是Bayes定理的另一种形式。

Bayes定理给出了一种用先验概率P(B|A),求后验概率P (A|B)的方法。例如用B代表发烧,A代表感冒,显然,求发烧的人中有多少人是感冒了的概率P(A|B)要比求因感冒而发烧的概率P(B|A)困难得多。 3.3.1规则的不确定性 为了描述规则的不确定性,引入不确定性描述因子LS,LN:对规则A→B的不确定性度量f(B,A)以因子(LS,LN)来描述: 表示A真时对B的影响,即规则成立的充分性 表示A假时对B的影响,即规则成立的必要性 实际应用中概率值不可能求出,所以采用的都是专家给定的LS,LN值。从LS,LN的数学公式不难看出,LS表征的是A的发生对B发生的影响程度,而LN表征的是A的不发生对B发生的影响程度。 几率函数O(X): 即,表示证据X的出现概率和不出现的概率之比,显然O(X)是P(X)的增函数,且有: P(X)=0,O(X)=0

人工智能原理及其应用(第二版)习题答案

本页面为作品封面,下载文档后可自由编辑删除! 精 品 文 档

知识表示方法部分参考答案 2.8设有如下语句,请用相应的谓词公式分别把他们表示出来: (1)有的人喜欢梅花,有的人喜欢菊花,有的人既喜欢梅花又喜欢菊花。 解:定义谓词 P(x):x是人 L(x,y):x喜欢y 其中,y的个体域是{梅花,菊花}。 将知识用谓词表示为: (?x )(P(x)∧(L(x, 梅花)∨L(x, 菊花)∨L(x, 梅花)∧L(x, 菊花))) (2) 有人每天下午都去打篮球。 解:定义谓词 P(x):x是人 B(x):x打篮球 A(y):y是下午 将知识用谓词表示为: (?x )(?y) (A(y)∧B(x)∧P(x)) (3)新型计算机速度又快,存储容量又大。 解:定义谓词 NC(x):x是新型计算机 F(x):x速度快 B(x):x容量大 将知识用谓词表示为: (?x) (NC(x)→F(x)∧B(x)) (4) 不是每个计算机系的学生都喜欢在计算机上编程序。 解:定义谓词 S(x):x是计算机系学生 L(x, pragramming):x喜欢编程序 U(x,computer):x使用计算机 将知识用谓词表示为: ?(?x) (S(x)→L(x, pragramming)∧U(x,computer)) (5)凡是喜欢编程序的人都喜欢计算机。 解:定义谓词 P(x):x是人 L(x, y):x喜欢y 将知识用谓词表示为: (?x) (P(x)∧L(x,pragramming)→L(x, computer))

2.9用谓词表示法求解机器人摞积木问题。设机器人有一只机械手,要处理的世界有一张桌子,桌上可堆放若干相同的方积木块。机械手有4个操作积木的典型动作:从桌上拣起一块积木;将手中的积木放到桌之上;在积木上再摞上一块积木;从积木上面拣起一块积木。积木世界的布局如下图所示。 图机器人摞积木问题 解:(1) 先定义描述状态的谓词 CLEAR(x):积木x上面是空的。 ON(x, y):积木x在积木y的上面。 ONTABLE(x):积木x在桌子上。 HOLDING(x):机械手抓住x。 HANDEMPTY:机械手是空的。 其中,x和y的个体域都是{A, B, C}。 问题的初始状态是: ONTABLE(A) ONTABLE(B) ON(C, A) CLEAR(B) CLEAR(C) HANDEMPTY 问题的目标状态是: ONTABLE(C) ON(B, C) ON(A, B) CLEAR(A) HANDEMPTY (2) 再定义描述操作的谓词 在本问题中,机械手的操作需要定义以下4个谓词: Pickup(x):从桌面上拣起一块积木x。 Putdown(x):将手中的积木放到桌面上。 Stack(x, y):在积木x上面再摞上一块积木y。 Upstack(x, y):从积木x上面拣起一块积木y。 其中,每一个操作都可分为条件和动作两部分,具体描述如下: Pickup(x)

人工智能不确定性推理部分参考答案

不确定性推理部分参考答案 1.设有如下一组推理规则: r1: IF E1THEN E2 (0.6) r2: IF E2AND E3THEN E4 (0.7) r3: IF E4THEN H (0.8) r4: IF E5THEN H (0.9) 且已知CF(E1)=0.5, CF(E3)=0.6, CF(E5)=0.7。求CF(H)=? 解:(1) 先由r1求CF(E2) CF(E2)=0.6 × max{0,CF(E1)} =0.6 × max{0,0.5}=0.3 (2) 再由r2求CF(E4) CF(E4)=0.7 × max{0, min{CF(E2 ), CF(E3 )}} =0.7 × max{0, min{0.3, 0.6}}=0.21 (3) 再由r3求CF1(H) CF1(H)= 0.8 × max{0,CF(E4)} =0.8 × max{0, 0.21)}=0.168 (4) 再由r4求CF2(H) CF2(H)= 0.9 ×max{0,CF(E5)} =0.9 ×max{0, 0.7)}=0.63 (5) 最后对CF1(H )和CF2(H)进行合成,求出CF(H) CF(H)= CF1(H)+CF2(H)+ CF1(H) × CF2(H) =0.692 2 设有如下推理规则 r1: IF E1THEN (2, 0.00001) H1 r2: IF E2THEN (100, 0.0001) H1 r3: IF E3THEN (200, 0.001) H2 r4: IF H1THEN (50, 0.1) H2 且已知P(E1)= P(E2)= P(H3)=0.6, P(H1)=0.091, P(H2)=0.01, 又由用户告知: P(E1| S1)=0.84, P(E2|S2)=0.68, P(E3|S3)=0.36 请用主观Bayes方法求P(H2|S1, S2, S3)=? 解:(1) 由r1计算O(H1| S1) 先把H1的先验概率更新为在E1下的后验概率P(H1| E1) P(H1| E1)=(LS1× P(H1)) / ((LS1-1) × P(H1)+1) =(2 × 0.091) / ((2 -1) × 0.091 +1) =0.16682 由于P(E1|S1)=0.84 > P(E1),使用P(H | S)公式的后半部分,得到在当前观察S1下的后验概率P(H1| S1)和后验几率O(H1| S1) P(H1| S1) = P(H1) + ((P(H1| E1) – P(H1)) / (1 - P(E1))) × (P(E1| S1) – P(E1))

人工智能原理与应用_(张仰森_著)_高等教育出版社_课后答案

2.7解:根据谓词知识表示的步骤求解问题如下: 解法一: (1)本问题涉及的常量定义为: 猴子:Monkey,箱子:Box,香蕉:Banana,位置:a,b,c (2)定义谓词如下: SITE(x,y):表示x在y处; HANG(x,y):表示x悬挂在y处; ON(x,y):表示x站在y上; HOLDS(y,w):表示y手里拿着w。 (3)根据问题的描述将问题的初始状态和目标状态分别用谓词公式表示如下: 问题的初始状态表示: SITE(Monkey,a)∧HANG(Banana,b)∧SITE(Box,c)∧~ON(Monkey,Box)∧~HOLDS(Monkey,Banana) 问题的目标状态表示: SITE(Monkey,b)∧~HANG(Banana,b)∧SITE(Box,b) ∧ON(Monkey,Box)∧HOLDS(Monkey,Banana) 解法二: (1)本问题涉及的常量定义为: 猴子:Monkey,箱子:Box,香蕉:Banana,位置:a,b,c (2)定义谓词如下: SITE(x,y):表示x在y处; ONBOX(x):表示x站在箱子顶上; HOLDS(x):表示x摘到了香蕉。 (3)根据问题的描述将问题的初始状态和目标状态分别用谓词公式表示如下: 问题的初始状态表示: SITE(Monkey,a)∧SITE(Box,c)∧~ONBOX(Monkey)∧~HOLDS(Monkey) 问题的目标状态表示: SITE(Box,b)∧SITE(Monkey,b)∧ONBOX(Monkey)∧HOLDS(Monkey) 从上述两种解法可以看出,只要谓词定义不同,问题的初始状态和目标状态就不同。所以,对于同样的知识,不同的人的表示结果可能不同。 2.8解:本问题的关键就是制定一组操作,将初始状态转换为目标状态。为了用谓词公式表示操作,可将操作分为条件(为完成相应操作所必须具备的条件)和动作两部分。条件易于用谓词公式表示,而动作则可通过执行该动作前后的状态变化表示出来,即由于动作的执行,当前状态中删去了某些谓词公式而又增加一些谓词公式从而得到了新的状态,通过这种不同状态中谓词公式的增、减来描述动作。 定义四个操作的谓词如下,操作的条件和动作可用谓词公式的增、删表示: (1)goto 不确定性推理 摘要:对3种最常用的不确定性推理方法进行了分析和评述:概率推理、D-S证据推理和模糊推理。分别针对不同类型的不确定性。概率推理针对的是"事件发生与否不确定"这样的不确定性。D-S证据推理针对的是"分不清"或"不知道"这样的不确定性。模糊推理则是针对概念内涵或外延不清晰这样的不确定性。概率推理的理论体系是严密的,但其推理结果有赖可信的先验概率和条件概率。D-S证据推理是不可信的,但在一定条件下可以转化为概率推理问题来处理。模糊推理是一种很有发展潜力的推理方法,主要问题是推理规则需要具体设计,且设计好坏决定推理结果。 关键词:不确定性推理概率推理 D-S证据论模糊推理 引言 近年来,不确定性推理技术引起了人们的重视。这一方面是由于现实问题中普遍含有种种的不确定性,因此对不确定性推理技术有很大的需求。另一方面也在于不断出现的不确定性推理技术出现了一些问题,引起了人们的热议。 本文对三种应用最为广泛的不确定性推理技术进行了分析和评述。它们是:概率推理、D-S证据推理和模糊推理。它们分别具有处理不同类型的不确定性的能力。概率推理处理的是“事件发生与否不确定”这样的不确定性;D-S证据推理处理的是含有“分不清”或“不知道”信息这样的不确定性;模糊推理则是针对概念内涵或外延不清晰这样的不确定性。这些不确定性在实际的推理问题中是非常普遍的,因此这3种推理技术都有广泛的应用。 然而,这些推理技术在实际中的应用效果相差很大。有的得出的推理结果非常合理,用推理结果去执行任务的效果也非常好。也有的效果很差,推理结果怪异,完全背离人的直觉。应用效果差的原因可能是所用推理技术本身的缺陷,也可能是应用者对所用技术了解掌握不够。 无论如何,都非常有必要对这些不确定性推理技术进行一番对比分 3.3 主观Bayes方法 R.O.Duda等人于1976年提出了一种不确定性推理模型。在这个模型中,他们称推理方法为主观Bayes方法,并成功的将这种方法应用于地矿勘探系统PROSPECTOR中。在这种方法中,引入了两个数值(LS,LN),前者体现规则成立的充分性,后者则表现了规则成立的必要性,这种表示既考虑了事件A的出现对其结果B的支持,又考虑了A的不出现对B的影响。 在上一节的CF方法中,CF(A)<0.2就认为规则不可使用,实际上是忽视了A不出现的影响,而主观Bayes方法则考虑了A 不出现的影响。 t3-B方法_swf.htm Bayes定理: 设事件A1,A2 ,A3 ,…,An中任意两个事件都不相容,则对任何事件B有下式成立: 该定理就叫Bayes定理,上式称为Bayes公式。 全概率公式: 可写成: 这是Bayes定理的另一种形式。 Bayes定理给出了一种用先验概率P(B|A),求后验概率P (A|B)的方法。例如用B代表发烧,A代表感冒,显然,求发烧的人中有多少人是感冒了的概率P(A|B)要比求因感冒而发烧的概率P(B|A)困难得多。 3.3.1 规则的不确定性 为了描述规则的不确定性,引入不确定性描述因子LS, LN:对规则A→B的不确定性度量f(B,A)以因子(LS,LN)来描述: 表示A真时对B的影响,即规则成立的充分性 表示A假时对B的影响,即规则成立的必要性 实际应用中概率值不可能求出,所以采用的都是专家给定的LS, LN值。从LS,LN的数学公式不难看出,LS表征的是A的发生对B发生的影响程度,而LN表征的是A的不发生对B发生的影响程度。 几率函数O(X): 不确定性推理 1/4/2004 ● 对每个模型需要把握的重点: (1) 知识不确定性的表示方法 (2) 证据不确定性的表示方法 (3) 组合证据不确定性的计算方法 (4) 不确定性的传递算法,亦即如何由证据的不确定性以及知识的不确定性求出结论的 不确定性 (5) 结论不确定性的合成算法,即如果有多条知识推出相同的结论,应该怎样计算出最 终的结论不确定性 ● 学过的模型: 一. 概率方法 二. 主观Bayes 方法 ◆ 实质:根据证据E 的概率P(E)以及LS ,LN 的值,将H 的先验概率P(H)更新为后验概率P(H/E)。其中,LS ,LN ,P(H)都由领域专家给出,P(E)则是由用户的具体观察得到的。 ◆ 模型: (1) 知识不确定性的表示:使用充分性量度LS 和必要性量度LN ,并且这两者都是由领 域专家给出的(P163) (2) 证据不确定的表示:用概率P(E/S)来表示,其中S 表示一次观察,E 为证据。一般 的该值是根据用户给出的可信度C(E/S)计算出来的,具体计算方法参见课本P163-164 (3) 组合证据不确定性的计算:极大极小法(P164) (4) 不确定性的传递算法:引入几率函数来辅助推理过程。几率函数定义为: ()()1() P x x P x Θ=- 根据知识对应的证据的确定性不同分成三种情况,即 1)证据肯定存在的情况: (/)()H E LS H Θ=?Θ 或 ()()(/)(1)()11()LS P H LS H P H E LS P H LS H ??Θ==-?++?Θ 2)证据肯定不存在的情况: (/)()H E LN H Θ?=?Θ 或不确定性推理方法研究word版

人工智能原理教案03章不确定性推理方法33主观Bayes方法

不确定性推理知识要点