LoadRunner性能测试指标参考

性能测试指标参考

目录

1术语 (2)

1.1响应时间 (2)

1.2并发用户数 (2)

1.3在线用户数 (2)

1.4吞吐量 (3)

2 Vuser图 (3)

2.1 “运行Vuser ”图(Running Vusers) (3)

2.2 “集合”图(Rendezvous) (3)

3 错误图 (3)

3.1 “每秒错误数(按描述)”图(Error Statistics) (3)

4 事务图 (4)

4.1 “平均事务响应时间”图(Average Transaction Response Time) (4)

4.2“负载下的事务响应时间”图(Running Vuser –Average Transaction Response Time) (4)

4.3“页面细分”图(Web Page Diagnostics图) (5)

4.4“每秒事务数”(Transactions per second 简称:TPS) (6)

5 Web资源图 (6)

5.1“每秒点击次数”图(Hits per Second) (6)

5.2“吞吐量”图(Throughput) (6)

6 系统资源图 (6)

6.1 LoadRunner下监控的UNIX资源指标 (6)

6.1.1平均负载(Average load) (6)

6.1.2 CPU利用率(CPU utilization) (7)

6.1.3 每秒传入的包数(Paging rate) (7)

6.2使用NMON工具监控Linux资源 (7)

6.2.1 系统资源汇总(SYS_SUMM) (7)

6.2.2 磁盘资源汇总(DISK_SUMM) (8)

6.2.3 内存资源(MEM) (8)

7 网络监控器图 (9)

7.1 “网络延迟时间”图(Network Delay Time) (9)

8 数据库服务器资源图 (10)

8.1 Oracle服务器监控度量 (10)

8.1.1 添加Oracle自定义计数器 (11)

8.1.2 性能分析工具Statspack所提供的性能分析指标 (15)

8.2 SQL Server服务器监控度量 (18)

1术语

1.1响应时间

响应时间是从请求到响应所需时间,从客户端请求开始,结束于来自服务器的响应并

呈现页面的时间。

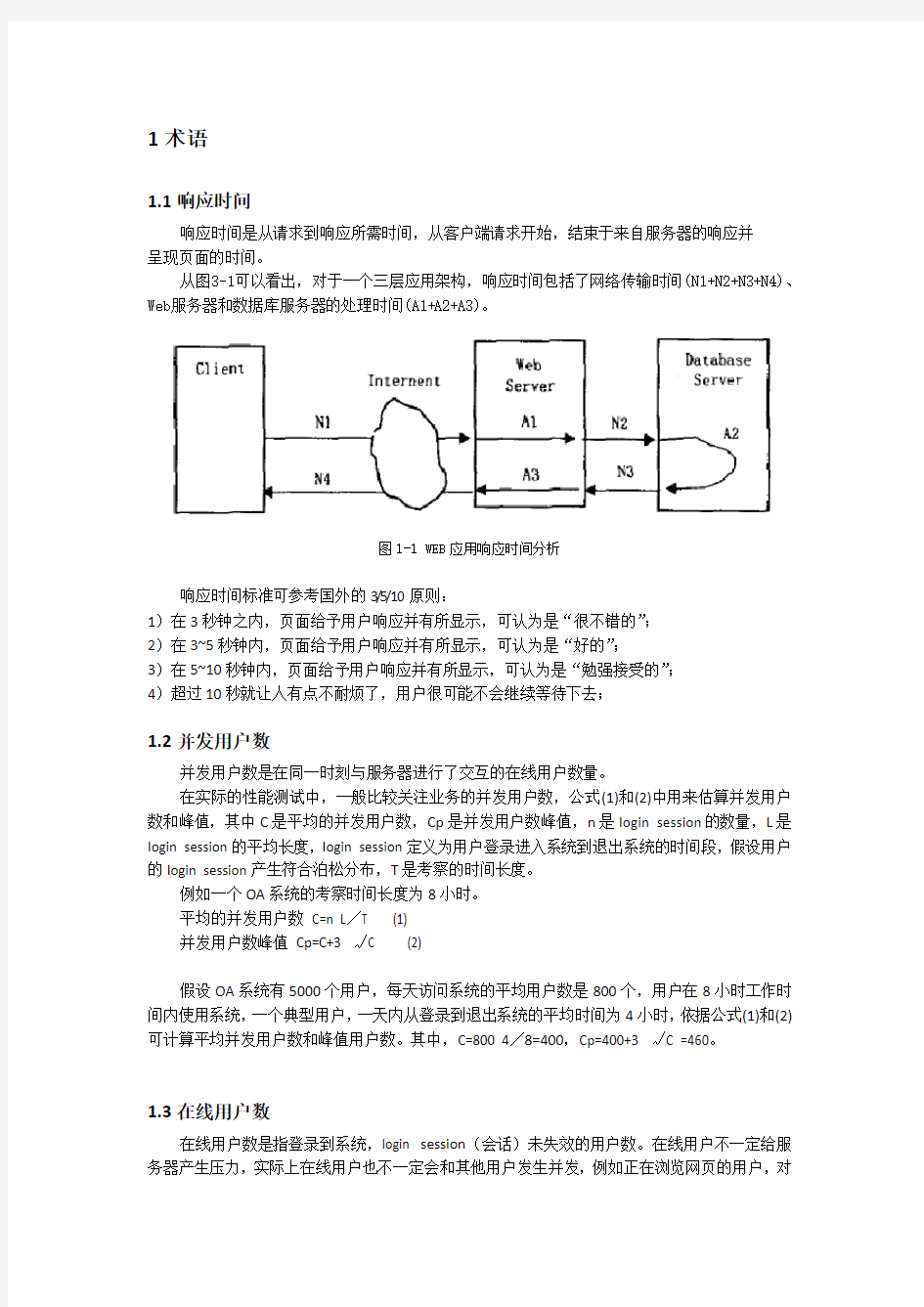

从图3-1可以看出,对于一个三层应用架构,响应时间包括了网络传输时间(N1+N2+N3+N4)、Web服务器和数据库服务器的处理时间(A1+A2+A3)。

图1-1 WEB应用响应时间分析

响应时间标准可参考国外的3/5/10原则:

1)在3秒钟之内,页面给予用户响应并有所显示,可认为是“很不错的”;

2)在3~5秒钟内,页面给予用户响应并有所显示,可认为是“好的”;

3)在5~10秒钟内,页面给予用户响应并有所显示,可认为是“勉强接受的”;

4)超过10秒就让人有点不耐烦了,用户很可能不会继续等待下去;

1.2并发用户数

并发用户数是在同一时刻与服务器进行了交互的在线用户数量。

在实际的性能测试中,一般比较关注业务的并发用户数,公式(1)和(2)中用来估算并发用户数和峰值,其中C是平均的并发用户数,Cp是并发用户数峰值,n是Iogin session的数量,L是Iogin session的平均长度,Iogin session定义为用户登录进入系统到退出系统的时间段,假设用户的Iogin session产生符合泊松分布,T是考察的时间长度。

例如一个OA系统的考察时间长度为8小时。

平均的并发用户数C=n L/T (1)

并发用户数峰值Cp=C+3 √C (2)

假设OA系统有5000个用户,每天访问系统的平均用户数是800个,用户在8小时工作时间内使用系统,一个典型用户,一天内从登录到退出系统的平均时间为4小时,依据公式(1)和(2)可计算平均并发用户数和峰值用户数。其中,C=800 4/8=400,Cp=400+3 √C =460。

1.3在线用户数

在线用户数是指登录到系统,Iogin session(会话)未失效的用户数。在线用户不一定给服务器产生压力,实际上在线用户也不一定会和其他用户发生并发,例如正在浏览网页的用户,对

服务器没有任何影响。

1.4吞吐量

吞吐量是在一次性能测试过程中网络上传输的数据量的总和。吞吐量/传输时间就是吞吐率,TPS是每秒钟系统能够处理的交易或者事务的数量,它是衡量系统处理能力的重要指标。吞吐量树枝越大

说明系统处理能力越强;

吞吐量应该是随着每秒点击率的增加而增加,这种增加是建立在带宽足够处理用户提出的所有请求的基础上。

在比较吞吐量和每秒点击率中可以获得服务器在执行过程中的信息。如果服务器如预期的一样执行,那么呑吐量会随着它每秒的点击量而增加。如果点击的次数增加而呑吐量恒定或减少,就说明服务器无法执行增加的请求(每秒点击率),结果就是事务响应时间的增加。

2 Vuser图

在负载测试场景执行期间,Vuser 会在执行事务时生成数据。通过Vuser 图您可以

确定场景执行期间Vuser 的整体运行情况。这些图会显示Vuser 状态、已完成脚

本的Vuser 数以及集合统计信息。将这些图与事务图相结合可以确定Vuser 数目

对事务响应时间的影响。

2.1 “运行Vuser ”图(Running Vusers)

“运行Vuser”图显示测试期间每秒钟执行Vuser 脚本的Vuser 数及其状态。此图

对于确定任意给定时刻服务器上的Vuser 负载非常有用。默认情况下,此图仅显

示处于运行状态的Vuser。要查看其他Vuser 状态,请将筛选条件设置为所需的状

态。

2.2 “集合”图(Rendezvous)

“集合”图显示在集合点处释放Vuser 的时间以及每个点释放的Vuser 数。

此图有助于了解事务性能时间。通过对比“集合”图和“平均事务响应时间”

图,您可以看到由集合产生的负载峰值如何影响事务时间。

3 错误图

3.1 “每秒错误数(按描述)”图(Error Statistics)

“每秒错误数(按描述)”图显示负载测试场景运行期间每秒所发生错误的平均数(按错误描述分组)。在图例中显示错误描述。错误数越小越好,通过错误数可以定位系统在负载情况下,什么时候出错,查找出系统错误的原因。

常见错误提示分析:

1、Error: Failed to connect to server “10.10.10.30:8080″: [10060] Connection Error: timed out Error: Server “10.10.10.30″ has shut down the connection prematurely

分析:

A、应用服务死掉。

小用户时:程序上的问题。程序上处理数据库的问题

B、应用服务没有死

应用服务参数设置问题

例:在许多客户端连接Weblogic应用服务器被拒绝,而在服务器端没有错误显示,则有可能是Weblogic中的server元素的AcceptBacklog属性值设得过低。如果连接时收到connection refused消息,说明应提高该值,每次增加25%。

C、数据库的连接

在应用服务的性能参数可能太小了;或数据库启动的最大连接数(跟硬件的内存有关)

2、Error: Page download timeout (120 seconds) has expired

分析:可能是以下原因造成

A、应用服务参数设置太大导致服务器的瓶颈

B、页面中图片太多

C、在程序处理表的时候检查字段太多

4 事务图

4.1 “平均事务响应时间”图(Average Transaction Response Time)

“平均事务响应时间”图显示负载测试场景运行期间每秒内用于执行事务的平均时间。X 轴表示自场景开始运行以来经过的时间。Y 轴表示每个事务的平均响应时间(秒)。响应时间标准可参考国外的3/5/10原则(见术语章节-响应时间部分)。平均事务响应时间会随着负载用户数的增加而增加。平均事务响应时间在规定时间内越平稳越好。响应时间出现波峰越多系统越不稳定。

4.2“负载下的事务响应时间”图(Running Vuser –Average Transaction Response Time)

“负载下的事务响应时间”图是“运行 Vuser”图与“平均事务响应时间”图的组合,显示负载测试场景运行期间相对于任何给定时间点运行的 Vuser 数目的事务时间。此图有助于查看 Vuser 负载对性能时间的总体影响,在分析逐渐加压的场景时最有用。

在Analysis的“运行 Vuser”图 - 点击右键–选择“合并图表”(Merge Graphs)- 在图表选项,选择“平均事务响应时间”图;在合并类型选项,选择“Correlate”。即可生成“负载下的事务响应时间”图。

图4-1 “负载下的事务响应时间”图

4.3“页面细分”图(Web Page Diagnostics图)

“平均事务响应时间”图点击右键选择“Show Transaction Breakdown Tree” - 在“Breakdown Tree”选择一要查看“页面细分”图的事务 - 点击右键,选择“Web Page Diagnostics for XX(事务)”,生成“页面细分”图。

注:生成“页面细分”图的前提是,执行场景时,需要在Controller – Diagnostics –Configuration,勾上“Web Page Diagnostics”。

正常的从浏览器发送一个请求到最后显示,整个过程由以下时间片组成,如图4-2所示。

图4-2 网络时间解析图

1)DNS解释时间(DNS Resolution)

浏览器向服务器发送一个请求,一般情况下,客户端的请求首先被发送到DNS服务器上,通过域名解析,将DNS名解析为IP地址。其中域名解析的时间就是DNS解析时间(DNS Resolution)。通过这个时间可以确定DNS服务器或DNS服务器的配置是否有问题。如

果DNS服务器运行情况良好,这个时间会比较小。

2)连接时间(Connection)

DNS解析完成后,请求被送到Web服务器,之后浏览器与Web服务器之间需要建立一个

初始化连接。建立连接的过程就是连接时间(Connection)。通过这个时间就可以判断

网络的情况,也可以判断Web服务器是否能够响应这个请求。如果正常,这个时间会比

较小。

3)第一个字节时间(First Buffer)

建立连接后,Web服务器发出第一个数据包,经过网络传输到客户端,浏览器成功接收

到第一个字节的时间就是First Buffer的时间。这个度量时间不仅可以表示Web服务

器的延迟时间,还可以表示网络反应时间。

4)接收时间(Receive)

从浏览器接收第一个字节起,知道成功收到最后一个字节,下载完成为止。

5)Client Time: 请求在客户端浏览器延迟时间,可能是由于客户端浏览器的ThinkTime

或者客户端其他方面引起的延迟;

6)Error Time:从发送一个HTTP请求,到Web服务器发送回一个HTTP错误信息所需要的时间。

4.4“每秒事务数”(Transactions per second 简称:TPS)

性能又一关键数据指标TPS,该数据反映了系统在同一时间内处理业务最大能力,这个数据越高,说明系统处理能力越强。当然TPS会受到负载的影响,也会随着负载的增加而逐渐增加,当系统进入繁忙的时候,TPS会下降。当TPS下降要查看是否服务处理能力下载,是否出现事务等待排队,导致响应时间的增加等情,结合响应时间指标和服务器指标分析。

5 Web资源图

5.1“每秒点击次数”图(Hits per Second)

“每秒点击次数”图显示负载测试场景运行期间的每一秒内Vuser向Web服务器发出的 HTTP 请求数。此图可帮助您根据点击次数对 Vuser 生成的负载量进行评估。可以将此图与“平均事务响应时间”、“负载用户数”图进行比较,查看点击次数对事务性能的影响。点击随负载用户增加而增加,点击次数越多越好。点击数增加,响应时间增加超出规定时间,说明系统服务器排队处理事务,需要关注服务器的磁盘、内存、和CPU使用情况确定系统性能问题。

5.2“吞吐量”图(Throughput)

“吞吐量”图显示在负载测试场景运行的每一秒,服务器上的吞吐量。吞吐量以字节为单位,表示Vuser 在任意给定的一秒内从服务器接收的数据量。此图可帮助您根据服务器吞吐量对Vuser 生成的负载量进行评估。可以将此图与“平均事务响应时间”图进行比较,查看吞吐量对事务性能的影响。吞吐量会随负载用户增加受影响。当负载用户数量增加,吞吐量增加,响应时间在规定范围,说明系统稳定。当负载用户增加,吞吐量增加或者下降,响应时间超出规定范围,说明系统有问题或者服务处理能力下载。

6 系统资源图

LoadRunner可监控Windows资源、UNIX资源。下面说下UNIX资源的三个重要的指标。6.1 LoadRunner下监控的UNIX资源指标

6.1.1平均负载(Average load)

上一分钟同时处于“就绪”状态的平均进程数,数值最好小于 CPU个数 * 核心数 * 0.7。如果等于,那就是说CPU正好满负载,再多一点,可能就要出问题了,有任务不能被及时分配处理器。

6.1.2 CPU利用率(CPU utilization)

CPU 的使用时间百分比。如果该值持续超过95%,表明瓶颈是CPU。那也许该增加一个处理器或换一个更快的处理器,如果服务器专用于SQL Server,可接受的最大上限是80-85%。合理使用范围应该在60%-70%,最好不要超过75%。

6.1.3 每秒传入的包数(Paging rate)

每秒钟读入物理内存或写入页面文件的页数,如果该数值偶尔走高,表明当时有线程竞争内存。如果持续很高,则内存可能是瓶颈,也有可能是内存访问命中率底。

6.2使用NMON工具监控Linux资源

监控前需要根据服务器的操作系统来安装相应版本的NMON(NMON for Solaris, NMON for Linux)。

为了配合性能测试,我们往往需要将一个时间段内系统资源消耗情况记录下来,这时可以使用命令:./nmon -f -s 10 -c 360。说明:

./nmon:反斜杠后面的命令名为安装的一个文件名(不同版本可能不同)

-f :按标准格式输出文件名称:

-s :每隔n秒抽样一次,这里为10秒

-c :取出多少个抽样数量,这里为360,即监控=10*360/3600=1小时

该命令启动后,会在nmon所在目录下生成监控文件,并持续写入资源数据,直至360个监控点收集完成——即监控1小时,这些操作均自动完成,无需手工干预,测试人员可以继续完成其他操作。如果想停止该监控,需要通过“#ps –ef|grep nmon”查询进程号,然后杀掉该进程以停止监控。

注:对于NMON for Solaris,可以使用命令:./sadc 10 360 test。即每隔10秒抽样一次,抽样360次。

test是文件名,同时还会生成一个test.hostname_yymmdd_hhmm.nmon格式的数据。

由于在Solaris,直接输入上面命令,若关闭shell窗口,或输入命令后回车,则直接退出执行命令。为了使命令能在后台执行,命令要改为:nohup ./sadc 10 360 test & UNIX操作系统监控命令:vmstat \ iostat \top\sat\sag;

6.2.1 系统资源汇总(SYS_SUMM)

系统资源汇总如下图所示,显示了系统CPU及IO资源的总体使用情况。CPU%值持续超过95%,表明瓶颈是CPU。如果服务器专用于SQL Server,可接受的最大上限是80-85%。合理使用范围应该在60%-70%,最好不要超过75%。

图6-1 系统资源汇总

6.2.2 磁盘资源汇总(DISK_SUMM)

可以通过磁盘的详细信息来帮助判断磁盘IO值偏高的原因(若认为磁盘IO值偏高)。如果磁盘写入数据较多,平均值达到每秒450KB,可以判断这是造成磁盘IO偏高的主要原因,那么结合系统实际设置,可以进一步确定造成问题的原因,如系统日志级别过低等等。

下图是磁盘资源汇总图:

图6-2 磁盘资源汇总

6.2.3 内存资源(MEM)

内存资源主要有两项指标:实际剩余内存百分比(Real Free %),实际内存总体大小(Real total(MB))。通过这两个指标,可以知道内存的使用情况。下图为内存资源图。

图6-3 内存资源

7 网络监控器图

7.1 “网络延迟时间”图(Network Delay Time)

在使用“网络延迟时间”图前,需要添加要监控的路径。

例如需要监控数据库服务器和Vuser Load Generator 之间的网络延迟时间,在Controller 的“网络延迟时间”图 - 点击右键,选择“Add Measurements” - 在Network Delay Time对话框的“Monitor the network delay from machine:”区域点击“Add”–输入数据库服务器的IP地址–在“To machine(s):”区域点击“Add”–输入Vuser Load Generator(即负载机)的IP地址–点击“OK”,即可监控数据库服务器和Vuser Load Generator 之间的网络延迟时间。

下图将网络延迟显示为场景已用时间的函数。图中显示,在场景开始后的第 8 分钟,

有 16 毫秒的延迟。

图7-1 “网络延迟时间”图

也可以通过“网络子路径时间”图、“网络段延迟”图来查看某网络段的延迟时间。

为了验证网络瓶颈,可以合并多个图来确定瓶颈是否由网络引起。例如,使用“网络延迟时间”和“运行 Vuser”图可以确定Vuser的数目如何影响网络延迟。“网络延迟时间”图显示负载测试场景运行期间的网络延迟。“运行 Vuser”图显示正在运行的Vuser数目。

在下面的合并图中,将网络延迟与正在运行的 Vuser 数目进行了对比。此图显示,当 10 个Vuser 全部运行时,出现了22毫秒的网络延迟,暗示网络可能已超载。

图7-2 “网络延迟时间-运行Vuser”图

8 数据库服务器资源图

8.1 Oracle服务器监控度量

使用LoadRunner监控Oracle服务器需要设置Oracle监控环境,具体请参与LR11的用户操作手册《HP LoadRunner Controller User Guide》如何设置 Oracle 监控环境章节,或参考《研发-orcal数据库监控配置》。

监控 Oracle 服务器时最常使用以下度量(来自 V$SYSSTAT 表):

8.1.1 添加Oracle自定义计数器

LR自带的计数器,有时候不足以满足监控的需求,故需要手动添加自定义的Oracle计数器。

添加步骤如下:

1)在LR的安装目录“\HP\LoadRunner\dat\monitors”下找到文件“vmon.cfg”

2)打开该文件“vmon.cfg”,找到第三行“CustomCounters=xx”(其中xx为目前已定义的自定义计数器个数),把自定义计数器个数“xx”改为(原个数+本次添加的个数)

总和

3)在该文件“vmon.cfg”中以下面格式插入相应的计数器定义说明:

;[Custom0]

;Name must be unique

;Name=Five Hundred

;Description=This counter always returns 500.

;Query=SELECT 500 FROM DUAL

;IsRate=0

其中,“[Custom0]”的序号“0”应改为相应的序号(序号必须由“0”开始连续加1递

增,如0,1,2…;若本来已有自定义计数器,由序号由原有序号开始递增。)下面为增加的12个计数器:

[Custom0]

;Name must be unique

Name=库快存命中率

Description=命中率应大于0.9

Query=SELECT 100*((sum(pins-reloads))/sum(pins)) from v$librarycache

IsRate=0

[Custom1]

;Name must be unique

Name=高速缓存区命中率

Description=命中率应大于0.9

Query=SELECT round(1-SUM(PHYSICAL_READS)/(SUM(DB_BLOCK_GETS) + SUM(CONSISTENT_GETS)), 4) * 100 FROM (SELECT CASE WHEN NAME='physical reads' THEN VALUE END PHYSICAL_READS,CASE WHEN NAME = 'db block gets' THEN VALUE END DB_BLOCK_GETS,CASE WHEN NAME = 'consistent gets' THEN VALUE END CONSISTENT_GETS FROM V$SYSSTAT WHERE Name IN ('physical reads','db block gets','consistent gets'))

IsRate=0

[Custom2]

;Name must be unique

Name=共享区库缓存区命中率

Description=命中率应大于0.99

Query=Select round(sum(pins-reloads)/sum(pins) * 100, 2) from v$librarycache

IsRate=0

[Custom3]

;Name must be unique

Name=共享区字典缓存区命中率

Description=命中率应大于0.85

Query=Select round(sum(gets-getmisses-usage-fixed)/sum(gets) * 100, 2) from v$rowcache IsRate=0

[Custom4]

;Name must be unique

Name=检测回滚段的争用

Description=应该小于1%

Query=select round(sum(waits)/sum(gets) * 100, 2) from v$rollstat

IsRate=0

[Custom5]

;Name must be unique

Name=检测回滚段收缩次数

Description=应该

Query=select sum(shrinks) from v$rollstat, v$rollname where v$https://www.360docs.net/doc/4e9061909.html,n = v$https://www.360docs.net/doc/4e9061909.html,n IsRate=0

[Custom6]

;Name must be unique

Name=监控表空间的I/O读总数

Description=监控表空间的I/O

Query=select sum(f.phyrds) pyr from v$filestat f, dba_data_files df where f.file# = df.file_id IsRate=0

[Custom7]

;Name must be unique

Name=监控表空间的I/O块读总数

Description=监控表空间的I/O

Query=select sum(f.phyblkrd) pbr from v$filestat f, dba_data_files df where f.file# = df.file_id IsRate=0

[Custom8]

;Name must be unique

Name=监控表空间的I/O写总数

Description=监控表空间的I/O

Query=select sum(f.phywrts) pyw from v$filestat f, dba_data_files df where f.file# = df.file_id IsRate=0

[Custom9]

;Name must be unique

Name=监控SGA中重做日志缓存区的命中率

Description=应小于1%

Query=select

Decode(immediate_gets+immediate_misses,0,0,immediate_misses/(immediate_gets+immediate _misses)*100) ratio2 FROM v$latch WHERE name IN ('redo copy')

IsRate=0

[Custom10]

;Name must be unique

Name=监控内存和硬盘的排序比率

Description=应小于10%

Query=select round(sum(case when name='sorts (disk)'then value else 0 end)/sum(case when name='sorts (memory)' then value else 0 end)*100,2) from (select name,value from v$sysstat where name in ('sorts (memory)','sorts (disk)'))

IsRate=0

[Custom11]

;Name must be unique

Name=内存排序命中率

Description=应大于95%

Query=select round((100*b.value)/decode((a.value+b.value), 0, 1, (a.value+b.value)), 2)from v$sysstat a, v$sysstat b where https://www.360docs.net/doc/4e9061909.html,='sorts (disk)' and https://www.360docs.net/doc/4e9061909.html,='sorts (memory)'

IsRate=0

4)编辑该文件后,需要重启LR的控制器,才能在监控Oracle服务器时在“CUSTOM”下添加这些自定义的计数器。

指标说明:

8.1.2 性能分析工具Statspack所提供的性能分析指标

注:以下指标取自Oracle的性能分析工具Statspack所提供的性能分析指标。

8.2 SQL Server服务器监控度量

web项目测试实战性能测试结果分析样章报告

5.4.2测试结果分析 LoadRunner性能测试结果分析是个复杂的过程,通常可以从结果摘要、并发数、平均事务响应时间、每秒点击数、业务成功率、系统资源、网页细分图、Web服务器资源、数据库服务器资源等几个方面分析,如图5- 1所示。性能测试结果分析的一个重要的原则是以性能测试的需求指标为导向。我们回顾一下本次性能测试的目的,正如错误!未找到引用源。所列的指标,本次测试的要求是验证在30分钟内完成2000次用户登录系统,然后进行考勤业务,最后退出,在业务操作过程中页面的响应时间不超过3秒,并且服务器的CPU 使用率、内存使用率分别不超过75%、70%,那么按照所示的流程,我们开始分析,看看本次测试是否达到了预期的性能指标,其中又有哪些性能隐患,该如何解决。 图5- 1性能测试结果分析流程图 结果摘要 LoadRunner进行场景测试结果收集后,首先显示的该结果的一个摘要信息,如图5- 2所示。概要中列出了场景执行情况、“Statistics Summary(统计信息摘要)”、“Transaction Summary(事务摘要)”以及“HTTP Responses Summary(HTTP响应摘要)”等。以简要的信息列出本次测试结果。 图5- 2性能测试结果摘要图

场景执行情况 该部分给出了本次测试场景的名称、结果存放路径及场景的持续时间,如图5- 3所示。从该图我们知道,本次测试从15:58:40开始,到16:29:42结束,共历时31分2秒。与我们场景执行计划中设计的时间基本吻合。 图5- 3场景执行情况描述图 Statistics Summary(统计信息摘要) 该部分给出了场景执行结束后并发数、总吞吐量、平均每秒吞吐量、总请求数、平均每秒请求数的统计值,如图5- 4所示。从该图我们得知,本次测试运行的最大并发数为7,总吞吐量为842,037,409字节,平均每秒的吞吐量为451,979字节,总的请求数为211,974,平均每秒的请求为113.781,对于吞吐量,单位时间内吞吐量越大,说明服务器的处理能越好,而请求数仅表示客户端向服务器发出的请求数,与吞吐量一般是成正比关系。 图5- 4统计信息摘要图 Transaction Summary(事务摘要) 该部分给出了场景执行结束后相关Action的平均响应时间、通过率等情况,如图5- 5所示。从该图我们得到每个Action的平均响应时间与业务成功率。

软件测试实验报告LoadRunner的使用

南昌大学软件学院 实验报告 实验名称 LoadRunner的使用 实验地点 实验日期 指导教师 学生班级 学生姓名 学生学号 提交日期 LoadRunner简介: LoadRunner 是一种适用于各种体系架构的自动负载测试工具,它能预测系统行为并优化系统性能。LoadRunner 的测试对象是整个企业的系统,它通过模拟实际用户的操作行为和实行实时性能监测,来帮助您更快的查找和发现问题。此外,LoadRunner 能支持广范的协议和技术,为您的特殊环境提供特殊的解决方案。LoadRunner是目前应用最为广泛的性能测试工具之一。 一、实验目的

1. 熟练LoadRunner的工具组成和工具原理。 2. 熟练使用LoadRunner进行Web系统测试和压力负载测试。 3. 掌握LoadRunner测试流程。 二、实验设备 PC机:清华同方电脑 操作系统:windows 7 实用工具:WPS Office,LoadRunner8.0工具,IE9 三、实验内容 (1)、熟悉LoadRunner的工具组成和工具原理 1.LoadRunner工具组成 虚拟用户脚本生成器:捕获最终用户业务流程和创建自动性能测试脚本,即我们在以后说的产生测试脚本; 压力产生器:通过运行虚拟用户产生实际的负载; 用户代理:协调不同负载机上虚拟用户,产生步调一致的虚拟用户;压力调度:根据用户对场景的设置,设置不同脚本的虚拟用户数量;监视系统:监控主要的性能计数器; 压力结果分析工具:本身不能代替分析人员,但是可以辅助测试结果的分析。 2.LoadRunner工具原理 代理(Proxy)是客户端和服务器端之间的中介人,LoadRunner 就是通过代理方式截获客户端和服务器之间交互的数据流。 ①虚拟用户脚本生成器通过代理方式接收客户端发送的数据包,

loadrunner学习总结

Loadrunner学习总结 LoadRunner,是一种预测系统行为和性能的负载测试工具。通过以模拟上千万用户实施并发负载及实时性能监测的方式来确认和查找问题,LoadRunner 能够对整个企业架构进行测试。企业使用LoadRunner能最大限度地缩短测试时间,优化性能和加速应用系统的发布周期。 LoadRunner可适用于各种体架构的自动负载测试,能预测系统行为并评估系统性能。操作流程如下: 1.录制脚本: 选择适当的协议,web服务器一般选择http协议。 录制方式一般选择HTML-based Script,但有下列情况选择URL-based Script:不是基于浏览器的应用程序,应用程序中包含javaScript脚本且产生了请求,基于浏览器的应用程序使用了https协议

默认设置记录的浏览器为IE,不要使用其他浏览器 在录制过程中不要后退页面 2.录制结束后点绿色方块按钮结束录制,系统会自动生成录制脚本。

3.录制完之后就是对脚本的回放处理,可以在运行时设置界面设置回放的设置, 如:迭代(重复次数)、步(开始新迭代时候的时间设置)、思考时间(录制时间的停留时间)等,设置好之后就开始回放。 4.回放结束后,回放的情况会显示出来,没有错误表示录制的进程没有问题。 5.负载测试运行

选择录制的脚本添加,然后确认。

可以在场景计划 可以在场景计划这里设置要测试的参数,比如开始用户数,持续时间,停止方式等。 如果想测定某个操作的响应时间,可以在脚本中插入事务,使用事务把该操作包装起来。分析执行结果的时候可以查看到该事务的响应时间。 插入集合点,可以使多个用户并发进行同一操作,提高操作的并发程度,以对服务器增加负载,测试并发能力。 在Run-Time Setting设置中,设置网络带宽以模拟不同带宽的网络;设置block、action的迭代次数。 对脚本进行参数化,设置参数变更方式

使用LoadRunner 编写性能测试方案

使用LoadRunner编写性能测试方案 1.声明 本测试方案适用于航空订票系统的性能测试,可指导其他航空订票系统的测试。本方案版权归于某某性能测试开发组,如果引用请声明具体测试环境和测试数据,否则测试结果无效。 2. 系统概述 此次测试的系统是航空订票网站系统,此系统应用Perl语言开发的基于B/S架构的网上订票系统,此系统的主要功能包括:用户注册、用户登录、定制票据、查看票据、取消票据、用户注销等主要功能。 本次测试过程重点关注系统的响应时间、并发用户、吞吐量等性能指标。 3. 词汇表 1)用户 用户指所有的访问系统的人,包括已经注册了用户名的人和没有注册用户名的人,测试过程中的Vusers就是模拟人的行为。 2)在线用户 在线用户指所有访问系统的用户,这些用户可以是正在和服务器进行交互的用户,也可以是正在浏览信息、填写表单等跟服务器没有交互行为的用户。 3)并发用户 并发用户指同时向服务器发出请求的用户,这些用户必须跟服务器进行数据交互。 4)响应时间 响应时间指从客户端发出请求到客户端从服务器获得数据这个过程花费的时间。响应时间是一个往返的过程,包括了客户端请求和服务器响应的时间,可以模拟用户的真实感受。5)平均响应时间 平均响应时间指针对某个业务的访问统计所有的响应时间,然后求平均。 6)标准偏差 标准偏差指一组数据取样空间中所有的值对应平均值的偏离度,用来衡量系统响应的可靠性和稳定性的指标。 7)TPS 每秒钟的事物数 5. 性能测试模型 5.1 用户体验模型

业界网站的用户感受标准符合一个3-5秒的标准,其中3秒的响应时间用户会感觉网站的响应很好,我们定义为良好响应;5秒的响应时间用户还可以接受,我们定义为可忍受;响应时间在8秒以上时,用户感受基本上已经不能接受,我们定义为不可忍受。 5.2 系统用户模型 1. 系统创建1000个注册用户,test0001-test1000 2. 基准测试过程中采用非注册用户 3. 用户登录、订票、查票等业务采用注册用户 5.3 业务模型 通过登录订票网站系统我们确认以下业务模型 5.4 用户接入模型 用户接入模型:是指用户在访问系统时,以什么样的方式或者带宽来访问系统。比如拨号方式、ADSL、小区宽带或者校园网等。测试过程中可通过测试工具或者相关设备对用户接入模式进行仿真。对用户接入行为的仿真模型我们称为用户接入模型。 测试过程中为了保证在系统的最大压力下,测试系统支持并发用户的能力,因此在测试过程中采用局域网环境,所有用户接入均采用共享100MBPS或者1000MBPS方式。根据木桶原理在保证最大压力情况下系统的性能特征,同样可以支持在不足带宽情况下用户接入的情况5.5 浏览器模型 浏览器模型:是指在测试过程中模拟用户浏览器的类型、操作模式、缓存处理、非HTML 资源处理等配置方式的一个模型。浏览器模型的建立可以真实的仿真用户基于客户端访问系统的情况。 测试过程中的浏览器模型: 浏览器仿真:IE6.0、IE7.0、Firefox 浏览器缓存仿真:缓存HTML资源、每次迭代清除缓存 非HTML资源:下载非HTML资源 5.6 思考时间模型 思考时间模型:是指在测试过程中模拟人的真实操作行为,比如一个人访问应用系统的过程中,不可能是一直跟服务器进行交互,一定存在浏览、填写表单、阅读说明等行为,因此在性能测试过程中,需要通过一种机制来模拟这种行为,那么这种行为的模拟方式就是建立“思考时间模型”,通过测试脚本程序上的等待来完成用户以上行为的仿真。 测试过程中的思考时间模型:通过对一般用户行为的调查确定思考时间为5-10秒随机选取方式 6. 性能测试环境 6.1 测试环境 负载与性能测试环境图

(完整word版)LoadRunner测试报告

嘉应学院计算机学院 实验报告 实验地点锡科405 课程名称软件测试实验名称负载测试工具 LoadRunner 指导老师实验时间第11周提交时间第12周班级姓名座号 一、实验目的和要求 ?规划负载测试。定义性能测试要求,例如并发用户数量、典型业务流程和要求的 响应时间。 ?创建Vuser 脚本。在自动化脚本中录制最终用户活动。 ?定义场景。使用LoadRunner Controller 设置负载测试环境。 ?运行场景。使用LoadRunner Controller 驱动、管理并监控负载测试。 ?分析结果。使用LoadRunner Analysis 创建图和报告并评估性能。 二、实验环境、内容和方法 实验环境:Windows 7 负载测试工具LoadRunner 实验对象:教务管理系统 三、实验过程描述 1.创建脚本 要生成负载,首先要创建模拟实际用户行为的自动脚本。 1.1录制用户操作: 打开VUG

创建一个空白Web 脚本 录制业务流程来创建脚本

打开一个项目后出现 登录到教务管理系统。 在User Name (用户名)框中输入11111,在Password (密码)框中输入123。单击Login (登录)。欢迎页面打开。 在浮动工具栏上单击停止以停止录制 已成功录制 2利用创建的虚拟用户脚本创建负载测试 启动Controller 默认情况下,Controller 打开时会显示“新建场景”对话框。

生成重负载 选择load generators

您将使用本地计算机作为Load Generator (默认情况下包括在场景 中)。localhost Load Generator 的状态为关闭。这说明Controller 未连接到Load Generator。 3运行负载测试场景 单击strat 监控负载下的应用程序

LoadRunner性能测试实战教程

LoadRunner性能测试实战讲解 内容介绍: 很多使用LoadRunner的测试人员经常面临两个难题:脚本开发与性能测试分析。本书就是基于帮助测试人员解决这两个问题而编写,致力于使读者学精LoadRunnner这一强大的性能测试工具。 全书共分为四部分:入门篇、基础篇、探索篇、实战篇。第一篇入门篇的内容包括第1章和第2章,着重于讲解性能测试与LoadRunner的基础理论知识。第二篇基础篇的内容包括第3章至第5章,是LoadRunner 的基本使用部分,着重讲解Virtual User Generator、Controller、Analysis的使用方法。第三篇探索篇的... 第1部分入门篇.. (1) 第1章性能测试基础知识.. 3 1.1 性能测试基本概念 (4) 1.1.1 什么是性能测试 (4) 1.1.2 性能测试应用领域 (6) 1.1.3 性能测试常见术语 (8) 1.2 全面性能测试模型 (11) 1.2.1 性能测试策略模型 (14) 1.2.2 性能测试用例模型 (17) 1.2.3 模型的使用方法 (20) 1.3 性能测试调整基础 (21) 1.4 如何做好性能测试 (24) 1.5 本章小结 (28) 第2章LoadRunner基础知识.. 29 2.1 LoadRunner简介 (29) 2.1.1 LoadRunner主要特点 (29) 2.1.2 LoadRunner常用术语 (31) 2.2 LoadRunner工作原理 (32) 2.3 LoadRunner测试流程 (33) 2.4 LoadRunner的部署与安装 (35) 2.5 本章小结 (41) 第2部分基础篇 (43) 第3章脚本的录制与开发.. 45 3.1 Virtual User Generator简介 (45)

loadrunner测试报告

1.系统概述

项目名称: 项目简称: 项目单位: 开 发 商:

2.测试场景

场景

Scenario1 Scenario1 Scenario1 Scenario1

执行脚本 11qq 11qq 11qq 11qq

并发用户数 10 100 300 1010

并发策略 时间

2014/10/22 10:14 - 2014/10/22 10:17 2014/10/22 11:43 - 2014/10/22 10:55 2014/10/22 11:10 - 2014/10/22 11:25 2014/10/22 11:38 - 2014/10/22 12:04

同步点

3 分钟, 17 秒 12 分钟, 09 秒 15 分钟, 39 秒 26 分钟, 28 秒.

分析 概要

场景名: 会话中的结果数: 持续时间: Scenario1 C:\Users\Administrator\AppData\Local\Temp\res\res. lrr 26 分钟, 28 秒.

时间段: 2014/10/22 11:38 - 2014/10/22 12:04

统计信息概要表

运行 Vuser 的最大数目: 总吞吐量(字节): 平均吞吐量(字节/秒): 总点击次数: 平均每秒点击次数: 错误总数:

1,006 187,564,053 118,039 28,569 17.979 12 查看 HTTP 响应概要

您可以使用以下对象定义 SLA 数据 SLA 配置向导 您可以使用以下对象分析事务行为 分析事务机制

事务摘要

事务:

通过总数: 22,387

失败总数: 12

停止总数: 607

平均响应时间

事务名称 Action_Transaction vuser_end_Transaction vuser_init_Transaction

SLA Status

最小值 2.098 0 0

平均值 2.437 0 0

最大值 3.058 0.019 0.041

标准偏差 0.299 0 0.001

90 Percent 2.948 0 0

通过 18,834 2,020 2,020

失败 12 0 0

停止 607 0 0

服务水平协议图例:

Pass

Fail

No Data

HTTP 响应概要

HTTP 响应 HTTP_200 HTTP_302

合计 28,557 12

每秒 17.972 0.008

查看每秒重试次数图。

利用loadrunner分析场景、监视图表

7 分析以及监视场景 在运行过程中,可以监视各个服务器的运行情况(DataBase Server、Web Server 等)。 监视场景通过添加性能计数器来实现。这一章非常的重要,确定系统瓶颈全靠它了。 下面重点讲讲需要添加那些计数器,以及那些计数器代表什么意思。 由于Win2000 Professional、Server 以及Advanced Server 提供的计数器不完全相同,这 里我们讨论将以Server 为基准。 监视场景需要在Run 视图中设置 然后,出现添加计数器的对话框 其他的操作就和控制面板“性能”中添加性能计数器的操作一样,这里不再详细说明。本章主要说明一下各个系统计数器的含义(数据库的计数器不做重点,只是拿SQL Server2000 作为例子进行说明。因为数据库各个版本之间差异比较大,请参考您使用的数据

库系统的帮助)。 8 分析实时监视图表 这一章仅仅介绍几个最重要的图表。 Q1 事务响应时间是否在可接受的时间内?哪个事务用的时间最长? 看Transaction Response Time 图,可以判断每个事务完成用的时间,从而可以判断出那个事 务用的时间最长,那些事务用的时间超出预定的可接受时间。 下图可以看出,随着用户数的不断增加,login 事务的响应时间增长的最快! Q2 网络带宽是否足够? “Throughput”图显示在场景运行期间的每一秒钟,从Web Server 上接受到的数据量的值。拿这个值和网络带宽比较,可以确定目前的网络带宽是否是瓶颈。 如果该图的曲线随着用户数的增加,没有随着增加,而是呈比较平的直线,说明目前的 网络速度不能够满足目前的系统流量。 Q3 硬件和操作系统能否处理高负载? “Windows Resources”图实时地显示了Web Server 系统资源的使用情况。利用该图提供的数据,可以把瓶颈定位到特定机器的某个部件。

LoadRunner测试结果分析

LoadRunner测试结果分析LoadRunner测试结果分析之我见一 LoadRunner生成测试结果并不代表着这次测试结果的结束,相反,这次测试结果的重头戏才刚刚开始。如何对测试结果进行分析,关系着这次测试的成功与否。网上关于LoadRunner测试结果如何分析的介绍相当匮乏,在总结他人的观点和自己的实验体会基础上来介绍如何进行LoadRunner测试结果分析。 1. LoadRunner测试结果分析的第一步应该是查看分析综述(Analysis Summary),其包括统计综述(Statistics Summary)、事务综述(Transaction Summary)、HTTP响应综述(HTTP Responses Summary)三部分。在统计综述中查看Total Errors的数量,HTTP响应综述中查看HTTP 404数量,若数值相对较大(HTTP 404则相对于HTTP 200),则说明系统测试中出错较多,系统系能有问题;另外查看事务的平均响应时间和其90%的事务平均响应时间,若时间过长,超过测试计划中的要求值,则说明系统的性能不满足我们的要求。 2.第二步对LoadRunner测试结果图进行分析,首先对事务综述(Transaction Summary)进行分析,该图可以直观地看出在测试时间内事务的成功与失败情况,所以比第一步更容易判断出被测系统运行是否正常。 3.接着分析事务平均响应时间(Average Transaciton Response Time),若事务平均响应时间曲线趋高,则说明被测系统处理事务的速度开始逐渐变慢,即被测系统随着运行时间的变化,整体性能不断下降。当系统性能存在问题时,该曲线的走向一般表现为开始缓慢上升,然后趋于平稳,最后缓慢下降。原因是:被测系统处理事务能力下降,事务平均响应时间变长,在曲线上表现为缓慢上升;而并发事务达到一定数量时,被测系统无法处理多余的事务,此时曲线变现为趋于平稳;当一段时间后,事务不断被处理,其数量减少,在曲线上表现为下降。如果被测系统没有等待机制,那么事务响应时间会越来越长,最后系统崩溃。

loadrunner结果分析论文(标准版)

Loadrunner 结果分析论文 指导老师:高小雷 作者:闵光辉 学校:东莞理工学院 班级:08计算机科学与技术2班 邮箱:mingh168@https://www.360docs.net/doc/4e9061909.html, Loadrunner性能测试的目的: 自动性能测试是一项规范,它利用有关产品、人员和过程的信息来减少应用程 序、升级程序或修补程序部署中的风险。自动性能测试的核心原理是通过将生产 时的工作量应用于预部署系统来衡量系统性能和最终用户体验。构造严密的性能 测试可回答如下问题: ?应用程序是否能够很快地响应用户的要求? ?应用程序是否能处理预期的用户负载并具有盈余能力? ?应用程序是否能处理业务所需的事务数量? ?在预期和非预期的用户负载下,应用程序是否稳定? ?是否能确保用户在真正使用软件时获得积极的体验? 通过回答以上问题,自动性能测试可以量化更改业务指标所产生的影响。进而可 以说明部署的风险。有效的自动性能测试过程将有助于您做出更明智的发行决 策,并防止系统出现故障和解决可用性问题。 LoadRunner 包含下列组件: ?虚拟用户生成器用于捕获最终用户业务流程和创建自动性能测试脚本(也称为虚拟用户脚本)。 ?Controller 用于组织、驱动、管理和监控负载测试。 ?负载生成器用于通过运行虚拟用户生成负载。 ?Analysis 有助于您查看、分析和比较性能结果。 ?Launcher 为访问所有LoadRunner 组件的统一界面。 负载测试流程: 负载测试通常由五个阶段组成:计划、脚本创建、场景定义、场景执行和结果 分析。 计划负载测试:定义性能测试要求,例如并发用户的数量、典型业务流程和所需 响应时间。 创建Vuser 脚本:将最终用户活动捕获到自动脚本中。 定义场景:使用LoadRunner Controller 设置负载测试环境。 运行场景:通过LoadRunner Controller 驱动、管理和监控负载测试。 分析结果:使用LoadRunner Analysis 创建图和报告并评估性能。Loadrunner测试结果分析如下:

性能测试与LoadRunner基础笔试题

性能测试与LoadRunner基础笔试题 笔试:45分钟满分100分 选择:(共6分,3分一题) 1. To control the time between iterations in a Vuser, you will need to configure which run-time(2分) feature? A. Run Logic B. Pacing C. Think Time D. Network Speed 2. You are about to run a Debug scenario with a small number of Vusers. What type of log setting will you select to help identify and check errors in the Vuser scripts?(2分) A. Only when errors occur B. Standard log C. Extended log 判断:(共20分,2分一题) 1.集合点可以贯穿整个事务,加了集合点,整个事务都是同步运行的 2.集合点可以加在vuser_int中 3.LR可以录制单机程序 4.一个脚本中可以有多个action 5.10M的网络环境中,不能模拟20M的带宽 6.HTTPS安全协议,可以使用‘HTML-based script’模式录制 7.vuser_end中内容是不可以迭代运行的 8.file类型参数化,最多只能参数化100个 9.手动关联,查找需要关联的数据,要在Sending request中查找 10.调试lr脚本可以run step by step

LoadRunner压力测试结果分析探讨

LoadRunner 压力测试结果分析探讨 分析原则: 1.具体问题具体分析(这是由于不同的应用系统,不同的 测试目的,不同 的性能关注点) 2. 查找瓶颈时按以下顺序,由易到难。 服务器硬件瓶颈 网络瓶颈(对局域网,可以不考虑) 服务器操作系统 瓶颈(参数配置) 中间件瓶颈(参数配置,数据库,web 服务器等) 瓶颈(SQL 语句、数据库设计、业务逻辑、算法等) 分析的信息来源: 1.根据场景运行过程中的错误提示信息 2.根据测试结果收集到的监控指标数据 .错误提示分析 分析实例: 1. Error: Failed to connect to server Connection 分析: A 应用服务死掉。 (小用户时:程序上的问题。程序上处理数据库的问题,实际测试中多半是 服务器链接的配置问题) B 、应用服务没有死 (应用服务参数设置问题) 应用 “172.17.7.230 〃 : [10060] Error: timed out Error: Server conn ecti on p rematurely “172.17.7.230 〃 has shut down the

对应的Apache 和tomcat 的最大链接数需要修改,如果连接时收到 connection refused 消息,说明应提高相应的服务器最大连接的设置,增加幅 度要根据实际情况和服务器硬件的情况来定,建议每次增加 25%! C 数据库的连接 (数据库启动的最大连接数(跟硬件的内存有关) ) D 我们的应用程序spring 控制的最大链接数太低 2. Error: Page download timeout (120 seconds) has expired 分析: 实际测试时有些资源需要请求外网,而我们的测试环境是局域网环境 3. Error “http://172.17.7.230/Home.do 分析: A 脚本设计错误,造成页面异常。服务器有响应! B 、并发数过大,造成服务器响应延迟。 4. Error page “text=xxxxx ” 分析: A 脚本设计问题,例如,前一脚本修改了某些内容,造成后面的脚本访问 异常。 B 、不确定因素,有时候回放正常的脚本,一放到场景中就出现这样的错误。 只能反复修改脚本! .监控指标数据分析 1.Vusers 数 A 、 应用服务参数设置太大导致服务器的瓶颈 B 、 页面中图片太多 C 、 在程序处理表的时候检查字段太大多 D 、

Loadrunner使用测试实验报告

一、实验目的 熟悉LoadRunner 的使用并对网站进行并发测试得到性能指标。 二、实验内容 1、题目内容描述 题目一:LoadRunner 的使用 熟悉LoadRunner 的界面,掌握LoadRunner 进行性能测试的测试流程。题目二:对某个网站进行并发测试 录制用户登录系统过程,并进行参数化。然后分别模拟10个、20个、50 个和100个用户登录系统,分别获得响应时间、吞吐量等性能指标。 2、测试计划 测试流程: 第一步:制定测试计划 第二步:创建虚拟用户脚本 第三步:创建场景 第四步:运行测试 第五步:监视场景 第六步:分析测试结果 1. 系统分析 本网站的用户有三类,一类是教师,可以对学生该科目的成绩等进行操作;一类是学生,进入该网站并登录教务系统,另一类是管理员。 2. 系统压力强度估算 3. 系统性能测试项 本次测试的主要内容是用户并发测试。主要指对系统的核心部分进行测试,以真实的业务数据作为输入,选择有代表性和关键的业务操作来设计测试用例。根据测试计划,对下列业务进行并发测试: (1)点击进入计科学院 (2)主页搜索 (3)登陆教务系统 (4)组合业务

注:由于条件的限制,在进行性能测试中不可能对所有的功能点都进行性能测试,在此只选择了几个典型的功能点。 3、实验过程 使用LoadRunner对西南科技大学的网站进行测试。 1对登陆的用户名和密码进行参数化 设置迭代次数为1,设置虚拟用户分别为5和10,localhost 进行连接,点击运行。 2. 设置本地连接、等待时间等。 3. 运行。 4、测试结果

、实验思考 通过这次实验学习了使用LoadRunner 对网站进行性能测试,压力测试,获得响应时间、吞吐量、点击率等性能指标。使用这个工具对我们测试网站的性能有很大的帮助,经过参数化后模拟登陆用户进行大量并发测试,获得性能指标,避免网站承受能力差的情况,提高质量。这样使用工具来测试网站比手动测试方便多了,而且不会出错。

LoadRunner性能测试软件的基本使用步骤

LoadRunner性能测试软件的基本使用步骤 一. 1、测试脚本录制 1.1录制前准备工作 在录制脚本前需检查压测环境的整体功能是否正确,待测部分的功能是否正确,只有确定功能正确后才可进行压测。 1.2录制及调试脚本 在准备工作OK后,进行脚本的录制,具体过程如下: 打开“开始>程序>MercuryLoadRunner>MercuryLoadRunner”测试脚本录制; 2、点击“Create/EdirScripts”,也可在“File”下选择New 新建。 3、选择Web(HTTP/HTML)协议,我们测试的是B/S模式,采用的是Web协议,选择后点【OK】按钮。 4、点击界面中的录制按钮,这个表示开始录制脚本点。 录制前,如果已经打开待测页面的话,建议关闭该页面。点【OK】后,同时会出现这表示现在已经开始录制。 5、所有操作完成后,点击中停止按钮,停止录制,页面将自动关闭,返回到loadrunner录制界面,将在界面中显示录制脚本代码,保存录制的脚本。 6、调试代码并进行参数化 录制后的代码需要进行调试才可用于压测,调试的办法就是进行

回放操作,如果回放过程无错误,运行结果也正确的话,则可用于压测。 二.设计测试场景 在脚本录制完成,调试通过后,可以进行测试场景的设计。 1.打开“开始>程序>MercuryLoadRunner >MercuryLoadRunner” 2.点击的RunLoadTests;在新建场景的窗口,选择一种场景类型。 3.选择要进行场景设计的脚本,若没有出现需要对应的脚本,可点击Browse查找后添加进来,选择好脚本后,点add则可加入到右边的窗口中然后点【OK】。 4.显示的是脚本的路径与并发数个数,根据测试方案中的并发 数可更改此处的并发数。 Eg:假如我们设计的场景是每15秒增加2个,所有并发数增加完后持续运行5分钟,5分钟运行结束后,每30秒减少5个并发。 5.再点击页面右下角的“Run-timeSettings” 。 6.一切设置OK后,点击运行测试场景。 三.测试结果分析 1.场景执行结束后可以,使用loadrunner自带的分析工具进行结果分析。 2.在菜单栏中选择打开,找到要分析的场景执行结果,点【打开】即可,还可以直接在场景运行结束后,点击Controller菜单栏

具体实例教你如何做LoadRunner结果分析

具体实例教你如何做LoadRunner结果分析 文本Tag:测试工具性能测试LoadRunner 【IT168 技术文档】1.前言: LoadRunner 最重要也是最难理解的地方--测试结果的分析.其余的录制和加压测试等设置对于我们来讲通过几次操作就可以轻松掌握了.针对Results Analysis 我用图片加文字做了一个例子,希望通过例子能给大家更多的帮助.这个例子主要讲述的是多个用户同时接管任务,测试系统的响应能力,确定系统瓶颈所在.客户要求响应时间是1 个人接管的时间在5S 内. 2.系统资源: 2.1 硬件环境: CPU:奔四2.8E 硬盘:100G 网络环境:100Mbps 2.2 软件环境: 操作系统:英文windowsXP 服务器:tomcat 服务 浏览器:IE6.0 系统结构:B/S 结构 3.添加监视资源

下面要讲述的例子添加了我们平常测试中最常用到的 一些资源参数.另外有些特殊的资源暂时在这里不做讲解了.我会在以后相继补充进来。 Mercury Loadrunner Analysis 中最常用的5 种资源. 1. Vuser 2. Transactions 3. Web Resources 4. Web Page Breakdown 5. System Resources 在Analysis 中选择“Add graph”或“New graph”就可以看到这几个资源了.还有其他没有数据的资源,我们没有让它显示. 如果想查看更多的资源,可以将左下角的display only graphs containing data 置为不选.然后选中相应的点“open graph”即可. 打开Analysis 首先可以看的是Summary Report.这里显示了测试的分析摘要.应有尽有.但是我们并不需要每个都要仔细去看.下面介绍一下部分的含义: Duration(持续时间):了解该测试过程持续时间.测试人员本身要对这个时期内系统一共做了多少的事有大致的熟 悉了解.以确定下次增加更多的任务条件下测试的持续时间。

网站性能测试报告模板

网站性能测试报告

目录 1项目背景 (3) 2编写目的 (3) 3参考文档 (3) 4参与测试人员 (3) 5测试说明 (3) 5.1 测试对象 (3) 5.2 测试环境结构图 (4) 5.2.1测试环境 (4) 6测试流程 (5) 7测试方法 (5) 8测试结果统计 (6) 8.1 用户并发测试:独立业务 (6) 8.2 用户并发测试:组合业务 (16) 8.3 大数据量测试 (22) 9分析与建议 (22) 9.1 独立业务 (22) 9.2 组合业务 (22) 9.3 大数据 (22) 9.4 其它....................................................................................................错误!未定义书签。

1项目背景 为了了解网易网的行你呢,我特此对网易网站进行压力测试。2 2编写目的 描述网易网站,在大数据量的数据环境下,系统的执行效率和稳定性。3参考文档 4参与测试人员 软件测试0801雷晓华 5测试说明 5.1测试对象 网易网站

5.2测试环境结构图 5.2.1测试环境5.2.1.1服务器端 5.2.1.1.1硬件环境 5.2.1.1.2软件环境

5.2.1.2客户端 5.2.1.2.1硬件环境 5.2.1.2.2软件环境 6测试流程 1、搭建模拟用户真实运行环境。 2、安装压力测试工具Loadrunner7.8。 3、使用LoadRunner中VuGen录制测试脚本。 4、使用Load Runner Controller组织发起模拟负载,并收集测试数据以及测试目标机器和网络的资源数据。 5、使用LoadRunner 的Analysis组件,分析测试结果。 6、整理并分析测试结果,写测试总结报告。 7测试方法 使用Mercury公司的性能测试软件LoadRunner8.1,对本系统业务进行脚本录制,测试回放,逐步加压和跟踪记录。测试过程中,由LoadRunner的管理平台调用各前台测试,发起各种组合的业务请求,并跟踪记录服务器端的运行情况和返回给客户端的运行结果。 1、录制日常访问量比较大的业务模块的代码,对测试机器进行压力测试。 2、模拟用户在单个业务操作和两个业务混合操作时,20、50、100、300、500用户同时并发,进行多次连续测试,完成测试目标。

LoadRunner性能测试指标参考

性能测试指标参考 目录 1术语 (2) 1.1响应时间 (2) 1.2并发用户数 (2) 1.3在线用户数 (2) 1.4吞吐量 (3) 2 Vuser图 (3) 2.1 “运行Vuser ”图(Running Vusers) (3) 2.2 “集合”图(Rendezvous) (3) 3 错误图 (3) 3.1 “每秒错误数(按描述)”图(Error Statistics) (3) 4 事务图 (4) 4.1 “平均事务响应时间”图(Average Transaction Response Time) (4) 4.2“负载下的事务响应时间”图(Running Vuser –Average Transaction Response Time) (4) 4.3“页面细分”图(Web Page Diagnostics图) (5) 4.4“每秒事务数”(Transactions per second 简称:TPS) (6) 5 Web资源图 (6) 5.1“每秒点击次数”图(Hits per Second) (6) 5.2“吞吐量”图(Throughput) (6) 6 系统资源图 (6) 6.1 LoadRunner下监控的UNIX资源指标 (6) 6.1.1平均负载(Average load) (6) 6.1.2 CPU利用率(CPU utilization) (7) 6.1.3 每秒传入的包数(Paging rate) (7) 6.2使用NMON工具监控Linux资源 (7) 6.2.1 系统资源汇总(SYS_SUMM) (7) 6.2.2 磁盘资源汇总(DISK_SUMM) (8) 6.2.3 内存资源(MEM) (8) 7 网络监控器图 (9) 7.1 “网络延迟时间”图(Network Delay Time) (9) 8 数据库服务器资源图 (10) 8.1 Oracle服务器监控度量 (10) 8.1.1 添加Oracle自定义计数器 (11) 8.1.2 性能分析工具Statspack所提供的性能分析指标 (15) 8.2 SQL Server服务器监控度量 (18)

LoadRunner压力测试

LoadRunner压力测试

一、环境准备 优化操作系统(centOS) 1、执行命令 sudo modprobe -r xt_NOTRACK nf_conntrack_netbios_ns nf_conntrack_ipv4 xt_state sudo modprobe -r nf_conntrack 2、使用文本编辑器打开 /etc/sysctl.conf 修改net.ipv4.tcp_max_tw_buckets的值 net.ipv4.tcp_max_tw_buckets= 16000 修改nginx配置 (只在压力测试使用,测试完毕后恢复) 1、找到以下条目,修改值 proxy_connect_timeout 600; proxy_send_timeout 600; proxy_read_timeout 600; 2、修改 upstream 中的值 server 192.168.0.254:8003 max_fails=15 fail_timeout=160s weight=1 srun_id=03; jvm_route $cookie_JSESSIONID reverse; 修改 LEAP.xml (只在压力测试使用,测试完毕后恢复) 在RPCServices 节点中添加disablesid="true" 例:

二、Loadrunner安装之前 安装要求 1、Loadrunner(主控机和压力机)必须安装在windows2003 server 版本下 2、必须安装IE浏览器,建议为IE6版本,其他版本在脚本录制过程中会出现打不开IE的情况 安装虚拟光驱

实验三:性能测试与LoadRunner

实验三:性能测试与LoadRunner(4学时) 一、实验目的 1、了解Load Runner负载测试工具的安装过程,进行安装实验。 2、了解Load Runner负载测试工具的用途和简单的操作。 3、掌握Load Runner负载测试工具测试过程。 4、能够使用Load Runner负载测试工具进行简单的测试工作。 二、实验环境 操作系统:windows 2000 XP + SP2 应用系统:LoadRunner9.5+负载测试工具 三、实验过程: LoadRunner 是HP公司开发一款成熟的性能测试工具,LoadRunner 作为性能测试的实现者,涉及性能测试流程、性能测试技术和软件体系架构等众多方面的知识点。 性能测试的基准大体有以下几方面: —响应时间 从应用系统发出请求开始,到客户端接收到最后一个字节数据为止所消耗的时间。合 理的响应时间取决于实际的用户需求。 —并发用户数 一般是指同一时间段内访问系统的用户数量。 —吞吐量 指单位时间内系统处理的客户请求数量。 —性能计数器 描述服务器或操作系统性能的一些数据指标,比如Windows 系统资源管理器。 ------------------------------------------------------------------------------- 本次实验课是针对LoadRunner(以下简称LR)的使用,我们将采用LR 自带的HP WEBTours 应用程序来进行熟悉。 1.启动示例程序 在开始程序中启动LoadRunneràsamplesàWebà启动Web 服务器,如下图 启动后在屏幕右下角会出现如下标识 :

精通软件性能测试与loadrunner实战

最新版LoadRunner性能测试实战 内容介绍: 很多使用LoadRunner的测试人员经常面临两个难题:脚本开发与性能测试分析。本书就是基于帮助测试人员解决这两个问题而编写,致力于使读者学精LoadRunnner这一强大的性能测试工具。 全书共分为四部分:入门篇、基础篇、探索篇、实战篇。第一篇入门篇的内容包括第1章和第2章,着重于讲解性能测试与LoadRunner的基础理论知识。第二篇基础篇的内容包括第3章至第5章,是LoadRunner 的基本使用部分,着重讲解Virtual User Generator、Controller、Analysis的使用方法。第三篇探索篇的... 第1部分入门篇.. (1) 第1章性能测试基础知识.. 3 1.1 性能测试基本概念 (4) 1.1.1 什么是性能测试 (4) 1.1.2 性能测试应用领域 (6) 1.1.3 性能测试常见术语 (8) 1.2 全面性能测试模型 (11) 1.2.1 性能测试策略模型 (14) 1.2.2 性能测试用例模型 (17) 1.2.3 模型的使用方法 (20) 1.3 性能测试调整基础 (21) 1.4 如何做好性能测试 (24) 1.5 本章小结 (28) 第2章LoadRunner基础知识.. 29 2.1 LoadRunner简介 (29) 2.1.1 LoadRunner主要特点 (29) 2.1.2 LoadRunner常用术语 (31) 2.2 LoadRunner工作原理 (32) 2.3 LoadRunner测试流程 (33) 2.4 LoadRunner的部署与安装 (35) 2.5 本章小结 (41) 第2部分基础篇 (43) 第3章脚本的录制与开发.. 45