Google分布式数据库简介.

Google Spanner简介

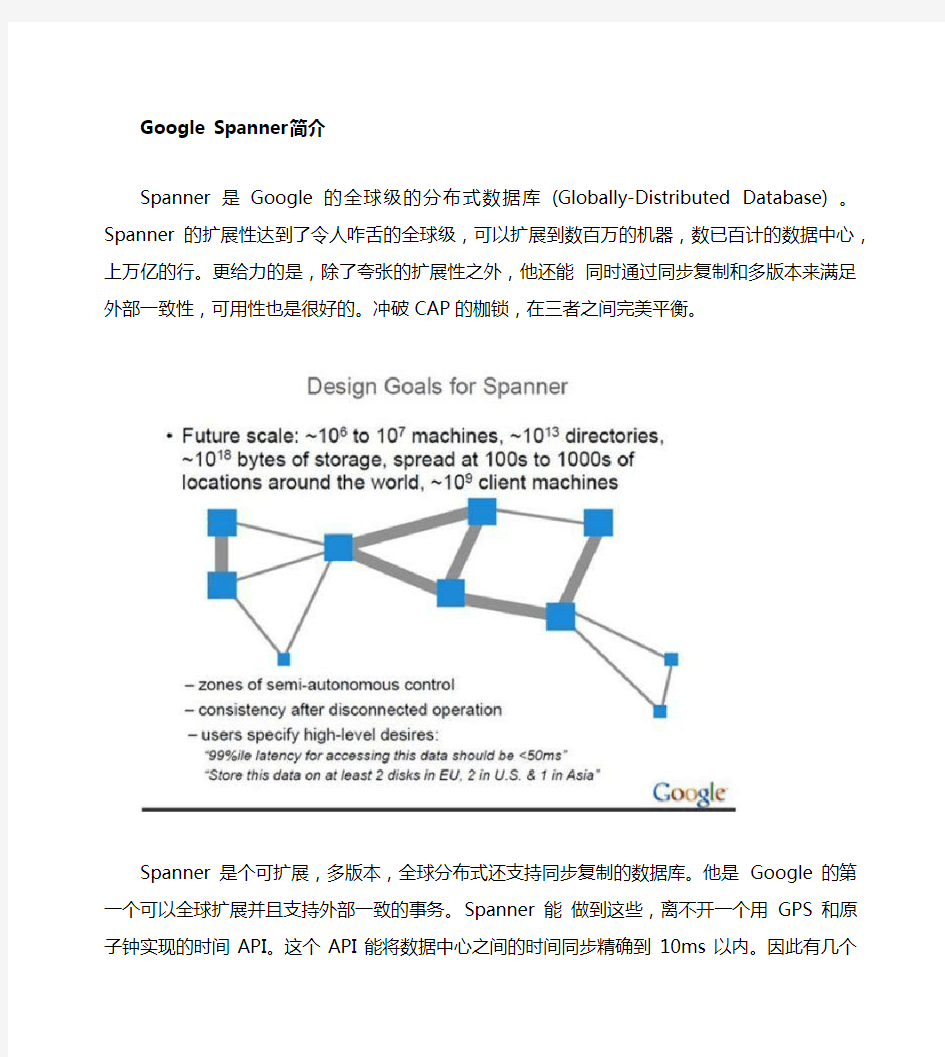

Spanner 是Google的全球级的分布式数据库 (Globally-Distributed Database) 。Spanner的扩展性达到了令人咋舌的全球级,可以扩展到数百万的机器,数已百计的数据中心,上万亿的行。更给力的是,除了夸张的扩展性之外,他还能同时通过同步复制和多版本来满足外部一致性,可用性也是很好的。冲破CAP的枷锁,在三者之间完美平衡。

Spanner是个可扩展,多版本,全球分布式还支持同步复制的数据库。他是Google的第一个可以全球扩展并且支持外部一致的事务。Spanner能做到这些,离不开一个用GPS和原子钟实现的时间API。这个API能将数据中心之间的时间同步精确到10ms以内。因此有几个给力的功能:无锁读事务,原子schema修改,读历史数据无block。

EMC中国研究院实时紧盯业界动态,Google最近发布的一篇论文《Spanner: Google’s Globally-Distributed Database》, 笔者非常感兴趣,对Spanner进行了一些调研,并在这里分享。由于Spanner 并不是开源产品,笔者的知识主要来源于Google的公开资料,通过现有公开资料仅仅只能窥得Spanner 的沧海一粟,Spanner背后还依赖有大量Google的专有技术。

下文主要是Spanner的背景,设计和并发控制。

Spanner背景

要搞清楚Spanner原理,先得了解Spanner在Google的定位。

从上图可以看到。Spanner位于F1和GFS之间,承上启下。所以先提一提F1和GFS。

F1

和众多互联网公司一样,在早期Google大量使用了Mysql。Mysql是单机的,可以用Master-Slave来容错,分区来扩展。但是需要大量的手工运维工作,有很多的限制。因此Google开发了一个可容错可扩展的RDBMS——F1。和一般的分布式数据库不同,F1对应RDMS应有的功能,毫不妥协。起初F1是基于Mysql的,不过会逐渐迁移到Spanner。

F1有如下特点:

· 7×24高可用。哪怕某一个数据中心停止运转,仍然可用。

·可以同时提供强一致性和弱一致。

·可扩展

·支持SQL

·事务提交延迟50-100ms,读延迟5-10ms,高吞吐

众所周知Google BigTable是重要的NoSql产品,提供很好的扩展性,开源世界有HBase与之对应。为什么Google还需要F1,而不是都使用 BigTable呢?因为BigTable提供的最终一致性,一些需要事务级

别的应用无法使用。同时BigTable还是NoSql,而大量的应用场景需要有关系模型。就像现在大量的互

联网企业都使用Mysql而不愿意使用HBase,因此Google才有这个可扩展数据库的F1。而Spanner就是 F1的至关重要的底层存储技术。

Colossus(GFS II)

Colossus也是一个不得不提起的技术。他是第二代GFS,对应开源世界的新HDFS。GFS是著名的分布式文件系统。

初代GFS是为批处理设计的。对于大文件很友好,吞吐量很大,但是延迟较高。所以使用他的系统不得不

对GFS做各种优化,才能获得良好的性能。那为什么 Google没有考虑到这些问题,设计出更完美的GFS ?因为那个时候是2001年,Hadoop出生是在2007年。如果Hadoop是世界领先水平的话,GFS比世界

领先水平还领先了6年。同样的 Spanner出生大概是2009年,现在我们看到了论文,估计Spanner在Google已经很完善,同时Google内部已经有更先进的替代技术在酝酿了。笔者预测,最早在2015年

才会出现Spanner和F1的山寨开源产品。

Colossus是第二代GFS。Colossus是Google重要的基础设施,因为他可以满足主流应用对FS的要求。Colossus的重要改进有:

·优雅Master容错处理 (不再有2s的停止服务时间)

· Chunk大小只有1MB (对小文件很友好)

· Master可以存储更多的Metadata(当Chunk从64MB变为1MB后,Metadata会扩大64倍,但是Google也解决了)

Colossus可以自动分区Metadata。使用Reed-Solomon算法来复制,可以将原先的3份减小到1.5份,提高写的性能,降低延迟。客户端来复制数据。具体细节笔者也猜不出。

与BigTable, Megastore对比

Spanner主要致力于跨数据中心的数据复制上,同时也能提供数据库功能。在Google类似的系统有BigTable和Megastore。和这两者相比,Spanner又有什么优势呢。

BigTable在Google得到了广泛的使用,但是他不能提供较为复杂的Schema,还有在跨数据中心环境下的强一致性。Megastore 有类RDBMS的数据模型,同时也支持同步复制,但是他的吞吐量太差,不能适应应用要求。Spanner不再是类似BigTable的版本化 key-value存储,而是一个“临时多版本”的数据库。何为“临时多版本”,数据是存储在一个版本化的关系表里面,存储的时间数据会根据其提交的时间打上时间戳,应用可以访问到较老的版本,另外老的版本也会被垃圾回收掉。

Google官方认为 Spanner是下一代BigTable,也是Megastore的继任者。

Google Spanner设计

功能

从高层看Spanner是通过Paxos状态机将分区好的数据分布在全球的。数据复制全球化的,用户可以指定数据复制的份数和存储的地点。 Spanner可以在集群或者数据发生变化的时候将数据迁移到合适的地点,做负载均衡。用户可以指定将数据分布在多个数据中心,不过更多的数据中心将造成更多的延迟。用户需要在可靠性和延迟之间做权衡,一般来说复制1,2个数据中心足以保证可靠性。

作为一个全球化分布式系统,Spanner提供一些有趣的特性。

·应用可以细粒度的指定数据分布的位置。精确的指定数据离用户有多远,可以有效的控制读延迟(读延迟取决于最近的拷贝)。指定数据拷贝之间有多远,可以控制写的延迟(写延迟取决于最远的拷贝)。还要数据的复制份数,可以控制数据的可靠性和读性能。(多写几份,可以抵御更大的事故)

· Spanner还有两个一般分布式数据库不具备的特性:读写的外部一致性,基于时间戳的全局的读一致。这两个特性可以让Spanner支持一致的备份,一致的MapReduce,还有原子的Schema修改。

这写特性都得益有Spanner有一个全球时间同步机制,可以在数据提交的时候给出一个时间戳。因为时间是系列化的,所以才有外部一致性。这个很容易理解,如果有两个提交,一个在T1,一个在T2。那有更晚的时间戳那个提交是正确的。

这个全球时间同步机制是用一个具有GPS和原子钟的TrueTime API提供了。这个TrueTime API能够将不同数据中心的时间偏差缩短在10ms内。这个API可以提供一个精确的时间,同时给出误差范围。Google已经有了一个TrueTime API的实现。笔者觉得这个TrueTimeAPI 非常有意义,如果能单独开源这部分的话,很多数据库如MongoDB都可以从中受益。

体系结构

Spanner由于是全球化的,所以有两个其他分布式数据库没有的概念。

·Universe。一个Spanner部署实例称之为一个Universe。目前全世界有3个。一个开发,一个测试,一个线上。因为一个Universe就能覆盖全球,不需要多个。

· Zones. 每个Zone相当于一个数据中心,一个Zone内部物理上必须在一起。而一个数据中心可能

有多个Zone。可以在运行时添加移除Zone。一个Zone可以理解为一个BigTable部署实例。

如图所示。一个Spanner有上面一些组件。实际的组件肯定不止这些,比如TrueTime API Server。如果仅仅知道这些知识,来构建Spanner是远远不够的。但Google都略去了。那笔者就简要介绍一下。

· Universemaster: 监控这个universe里zone级别的状态信息

· Placement driver:提供跨区数据迁移时管理功能

· Zonemaster:相当于BigTable的Master。管理Spanserver上的数据。

·Location proxy:存储数据的Location信息。客户端要先访问他才知道数据在那个Spanserver上。

· Spanserver:相当于BigTable的ThunkServer。用于存储数据。

可以看出来这里每个组件都很有料,但是Google的论文里只具体介绍了Spanserver的设计,笔者也只能介绍到这里。下面详细阐述Spanserver的设计。

Spanserver

本章详细介绍Spanserver的设计实现。Spanserver的设计和BigTable非常的相似。参照下图

从下往上看。每个数据中心会运行一套Colossus (GFS II) 。每个机器有100-1000个tablet。Tablet概念上将相当于数据库一张表里的一些行,物理上是数据文件。打个比方,一张1000行的表,有10个tablet,第1-100行是一个tablet,第101-200是一个tablet。但和BigTable不同的是BigTable里面的 tablet

存储的是Key-Value都是string,Spanner存储的Key多了一个时间戳:

(Key: string, timestamp: int64) ->string。

因此spanner天生就支持多版本,tablet在文件系统中是一个B-tree-like的文件和一个write-ahead日志。

每个Tablet上会有一个Paxos状态机。Paxos是一个分布式一致性协议。Table的元数据和log都存储在上面。Paxos会选出一个 replica做leader,这个leader的寿命默认是10s,10s后重选。Leader就相当

于复制数据的master,其他replica的数据都是从他那里复制的。读请求可以走任意的replica,但是写

请求只有去leader。这些replica统称为一个paxos group。

每个leader replica的spanserver上会实现一个lock table还管理并发。Lock table记录了两阶段提交

需要的锁信息。但是不论是在Spanner还是在BigTable上,但遇到冲突的时候长时间事务会将性能很差。所以有一些操作,如事务读可以走lock table,其他的操作可以绕开lock table。

每个leader replica的spanserver上还有一个transaction manager。如果事务在一个paxos group里面,可以绕过transaction manager。但是一旦事务跨多个paxos group,就需要transaction manager 来协调。其中一个Transactionmanager被选为leader,其他的是slave听他指挥。这样可以保证事务。

Directories and Placement

之所以Spanner比BigTable有更强的扩展性,在于Spanner还有一层抽象的概念directory, directory

是一些key-value的集合,一个directory里面的key有一样的前缀。更妥当的叫法是bucketing。Directory是应用控制数据位置的最小单元,可以通过谨慎的选择Key的前缀来控制。据此笔者可以猜出,在设计初期,Spanner是作为F1的存储系统而设立,甚至还设计有类似directory的层次结构,这样的

层次有很多好处,但是实现太复杂被摒弃了。

Directory作为数据放置的最小单元,可以在paxos group里面移来移去。Spanner移动一个directory

一般出于如下几个原因:

·一个paxos group的负载太大,需要切分

·将数据移动到access更近的地方

·将经常同时访问的directory放到一个paxos group里面

Directory可以在不影响client的前提下,在后台移动。移动一个50MB的directory大概需要的几秒钟。

那么directory和tablet又是什么关系呢。可以理解为Directory是一个抽象的概念,管理数据的单元;

而tablet是物理的东西,数据文件。由于一个Paxos group可能会有多个directory,所以spanner的tablet实现和BigTable的tablet实现有些不同。BigTable的tablet是单个顺序文件。Google有个项目,名为Level DB,是BigTable的底层,可以看到其实现细节。而Spanner的tablet可以理解是一些基于行的分区的容器。这样就可以将一些经常同时访问的directory放在一个tablet里面,而不用太在意顺序关系。

在paxos group之间移动directory是后台任务。这个操作还被用来移动replicas。移动操作设计的时候

不是事务的,因为这样会造成大量的读写 block。操作的时候是先将实际数据移动到指定位置,然后再用

一个原子的操作更新元数据,完成整个移动过程。

Directory还是记录地理位置的最小单元。数据的地理位置是由应用决定的,配置的时候需要指定复制数目和类型,还有地理的位置。比如(上海,复制2份;南京复制1分) 。这样应用就可以根据用户指定终端用户实际情况决定的数据存储位置。比如中国队的数据在亚洲有3份拷贝, 日本队的数据全球都有拷贝。

前面对directory还是被简化过的,还有很多无法详述。

数据模型

Spanner的数据模型来自于Google内部的实践。在设计之初,Spanner就决心有以下的特性:

·支持类似关系数据库的schema

· Query语句

·支持广义上的事务

为何会这样决定呢?在Google内部还有一个Megastore,尽管要忍受性能不够的折磨,但是在Google 有300多个应用在用它,因为 Megastore支持一个类似关系数据库的schema,而且支持同步复制(BigTable只支持最终一致的复制) 。使用Megastore的应用有大名鼎鼎的Gmail, Picasa, Calendar, Android Market和AppEngine。而必须对Query语句的支持,来自于广受欢迎的Dremel,笔者不久前写了篇文章来介绍他。最后对事务的支持是比不可少了,BigTable在Google内部被抱怨的最多的就是其只能支持行事务,再大粒度的事务就无能为力了。Spanner的开发者认为,过度使用事务造成的性能下降的恶果,应该由应用的开发者承担。应用开发者在使用事务的时候,必须考虑到性能问题。而数据库必须提供事务机制,而不是因为性能问题,就干脆不提供事务支持。

数据模型是建立在directory和key-value模型的抽象之上的。一个应用可以在一个universe中建立一个或多个 database,在每个database中建立任意的table。Table看起来就像关系型数据库的表。有行,有列,还有版本。Query语句看起来是多了一些扩展的SQL语句。

Spanner的数据模型也不是纯正的关系模型,每一行都必须有一列或多列组件。看起来还是Key-value。主键组成Key,其他的列是Value。但这样的设计对应用也是很有裨益的,应用可以通过主键来定位到某一行。

上图是一个例子。对于一个典型的相册应用,需要存储其用户和相册。可以用上面的两个SQL来创建表。Spanner的表是层次化的,最顶层的表是 directory table。其他的表创建的时候,可以用interleave in parent来什么层次关系。这样的结构,在实现的时候,Spanner可以将嵌套的数据放在一起,这样在分区的时候性能会提升很多。否则Spanner 无法获知最重要的表之间的关系。

TrueTime

TrueTime API 是一个非常有创意的东西,可以同步全球的时间。上表就是TrueTime API。TT.now()可以获得一个绝对时间TTinterval,这个值和UnixTime是相同的,同时还能够得到一个误差e。 TT.after(t)和TT.before(t)是基于TT.now()实现的。

那这个TrueTime API实现靠的是GFS和原子钟。之所以要用两种技术来处理,是因为导致这两个技术的

失败的原因是不同的。GPS会有一个天线,电波干扰会导致其失灵。原子钟很稳定。当GPS失灵的时候,原子钟仍然能保证在相当长的时间内,不会出现偏差。

实际部署的时候。每个数据中心需要部署一些Master机器,其他机器上需要有一个slave进程来从Master同步。有的Master用 GPS,有的Master用原子钟。这些Master物理上分布的比较远,怕出现

物理上的干扰。比如如果放在一个机架上,机架被人碰倒了,就全宕了。另外原子钟不是并很贵。Master 自己还会不断比对,新的时间信息还会和Master自身时钟的比对,会排除掉偏差比较大的,并获得一个

保守的结果。最终 GPS master提供时间精确度很高,误差接近于0。

每个Slave后台进程会每个30秒从若干个Master更新自己的时钟。为了降低误差,使用Marzullo算法。每个slave还会计算出自己的误差。这里的误差包括的通信的延迟,机器的负载。如果不能访问Master,误差就会越走越大,知道重新可以访问。

Google Spanner并发控制

Spanner使用TrueTime来控制并发,实现外部一致性。支持以下几种事务。

·读写事务

·只读事务

·快照读,客户端提供时间戳

·快照读,客户端提供时间范围

例如一个读写事务发生在时间t,那么在全世界任何一个地方,指定t快照读都可以读到写入的值。

上表是Spanner现在支持的事务。单独的写操作都被实现为读写事务;单独的非快照被实现为只读事务。事务总有失败的时候,如果失败,对于这两种操作会自己重试,无需应用自己实现重试循环。

时间戳的设计大大提高了只读事务的性能。事务开始的时候,要声明这个事务里没有写操作,只读事务可

不是一个简单的没有写操作的读写事务。它会用一个系统时间戳去读,所以对于同时的其他的写操作是没

有Block的。而且只读事务可以在任意一台已经更新过的replica上面读。

对于快照读操作,可以读取以前的数据,需要客户端指定一个时间戳或者一个时间范围。Spanner会找到

一个已经充分更新好的replica上读取。

还有一个有趣的特性的是,对于只读事务,如果执行到一半,该replica出现了错误。客户端没有必要在本地缓存刚刚读过的时间,因为是根据时间戳读取的。只要再用刚刚的时间戳读取,就可以获得一样的结果。

读写事务

正如BigTable一样,Spanner的事务是会将所有的写操作先缓存起来,在Commit的时候一次提交。这样的话,就读不出在同一个事务中写的数据了。不过这没有关系,因为Spanner的数据都是有版本的。

在读写事务中使用wound-wait算法来避免死锁。当客户端发起一个读写事务的时候,首先是读操作,他

先找到相关数据的leader replica,然后加上读锁,读取最近的数据。在客户端事务存活的时候会不断的向leader发心跳,防止超时。当客户端完成了所有的读操作,并且缓存了所有的写操作,就开始了两阶段提交。客户端闲置一个coordinator group,并给每一个leader发送coordinator的id和缓存的写数据。

leader首先会上一个写锁,他要找一个比现有事务晚的时间戳。通过Paxos记录。每一个相关的都要给coordinator发送他自己准备的那个时间戳。

Coordinatorleader一开始也会上个写锁,当大家发送时间戳给他之后,他就选择一个提交时间戳。这个

提交的时间戳,必须比刚刚的所有时间戳晚,而且还要比TT.now()+误差时间还有晚。这个Coordinator 将这个信息记录到Paxos。

在让replica写入数据生效之前,coordinator还有再等一会。需要等两倍时间误差。这段时间也刚好让Paxos来同步。因为等待之后,在任意机器上发起的下一个事务的开始时间,都比如不会比这个事务的结

束时间早了。然后coordinator将提交时间戳发送给客户端还有其他的replica。他们记录日志,写入生效,释放锁。

只读事务

对于只读事务,Spanner首先要指定一个读事务时间戳。还需要了解在这个读操作中,需要访问的所有的读的Key。Spanner可以自动确定Key的范围。

如果Key的范围在一个Paxos group内。客户端可以发起一个只读请求给group leader。leader选一个时间戳,这个时间戳要比上一个事务的结束时间要大。然后读取相应的数据。这个事务可以满足外部一致性,读出的结果是最后一次写的结果,并且不会有不一致的数据。

如果Key的范围在多个Paxos group内,就相对复杂一些。其中一个比较复杂的例子是,可以遍历所有的group leaders,寻找最近的事务发生的时间,并读取。客户端只要时间戳在TT.now().latest之后就可以满足要求了。

分布式服务架构方案

高并发分布式服务架构方案 下图是一个非常全面的架构蓝图,针对不同的应用系统需要的模块各有不同。此架构方案主要包括以下几个方面的设计:数据存储和读取,基础服务,应用层(APP/业务/Proxy),日志监控等,下面对这些主要的问题提供具体的各项针对性技术方案。 数据的存储和读取 分布式系统应该根据应用对数据不同的一致性、可用性等要求和数据的不同特性,采用不同的数据存储和读取方案,主要有以下几种可选方案: 1)内存型数据库。内存型的数据库,以高并发高性能为目标,在事务性方面没那么严格, 适合进行海量数据的存储和读取。例如开源nosql数据库mongodb、redis等。 2)关系型数据库。关系型数据库在满足并发性能的同时,也需要满足事务性,可通过 读写分离,分库分表来应对高并发大数据量的情况。例如Oracle,Mysql等。 3)分布式数据库。对于数据的高并发的访问,传统的关系型数据库提供读写分离的方案, 但是带来的确实数据的一致性问题提供的数据切分的方案;对于越来越多的海量数据,传统的数据库采用的是分库分表,实现起来比较复杂,后期要不断的进行迁移维护;对

于高可用和伸缩方面,传统数据采用的是主备、主从、多主的方案,但是本身扩展性比较差,增加节点和宕机需要进行数据的迁移。对于以上提出的这些问题,分布式数据库HBase有一套完善的解决方案,适用于高并发海量数据存取的要求。 基础服务 基础服务主要是指数据层之上的数据路由,Cache,搜索等服务。 1)路由Router。对于数据库切分方案中的分库分表问题,需要解决在请求对应的数据时 定位需要访问的位置,可根据一致性Hash,维护路由表至内存数据库等方案解决。 2)Cache。对于高并发的系统来讲,使用Cache可以减轻对后端系统的压力,所有Cache 可承担大部分热数据的读操作。当前用的比较多的是redis和memcache,redis比memcache有丰富的数据操作的API,redis对数据进行了持久化,而memcache没有这个功能,因此memcache更加适合在关系型数据库之上的数据的缓存。 3)搜索。搜索可以支持应用系统的按照关键词的检索,搜索提示,搜索排序等功能。开源 开源的企业级搜索引擎主要有lucene, sphinx,选择搜索引擎主要考虑以下三个方面: a)搜索引擎是否支持分布式的索引和搜索,来应对海量的数据,支持读写分离,提高 可用性 b)索引的实时性 c)搜索引擎的性能 Solr是基于Lucene开发的高性能的全文搜索服务器,满足以上三个方面的考虑,而且目前在企业中应用非常广泛。 应用层 应用层主要包括面向用户的应用,网站、APP等,还包括相关的业务处理的运算等。 1)负载均衡-反向代理。一个大型的平台包括很多个业务域,不同的业务域有不同的集群, 可以用DNS做域名解析的分发或轮询,DNS方式实现简单。但是因存在cache而缺乏灵活性;一般基于商用的硬件F5、NetScaler或者开源的软负载lvs在做分发,当然会采用做冗余(比如lvs+keepalived)的考虑,采取主备方式。Nginx是基于事件驱动的、异步非阻塞的架构、支持多进程的高并发的负载均衡器/反向代理软件,可用作反向代理的工具。

谷歌公司薪酬激励分析

绩效与薪酬管理 教学号:11130133 姓名:刘明慧专业:人力资源管理 谷歌公司薪酬激励分析 一、谷歌公司简介 谷歌(Google)是一家美国上市的公司,于1998年9月以私有股份公司的创立,不久之后它就成为了全球搜索领域的先驱。2004年8月,谷歌公司的股票在纳斯达克(Nasdaq)上市,成为公有股份公司。谷歌公司的总部称作“Googleplex”,位于美国加州圣克拉拉县的芒廷维尤。“Googol”是一个数学术语,表示 1 后面带有100个零,它是由美国数学家爱德华·卡斯纳的侄子米尔顿·西洛塔所创造,因出现在凯斯纳和詹姆士·纽曼合著的“数学与想象力”一书中而得到普及。谷歌(Google)公司对这个词作了微小改变,借以反映公司的使命,意在组织网上无边无际的信息资。谷歌的实用性及便利性赢得了众多用户的青睐,它几乎完全是在用户的交口称颂下成为全球最知名的品牌之一的。 目前谷歌被公认为全球规模最大的搜索引擎,它提供了简单易用的免费服务。谷歌将自己定位为创新的源泉,在这里IT人士可以找到充满挑战的工作以及改变世界的机遇。 二、谷歌公司薪酬管理现状及优势 薪酬管理是人力资源管理乃至整个企业管理的核心内容之一,不仅涉及企业的经济核算与效益,而且与员工切身利益息息相关。科学有效的薪酬激励机制能够让员工发挥出最佳的潜能,为企业创造出更大的价值。 在《财富》杂志的2012年美国100家最佳雇主排行榜上,谷歌排名第一,并非浪得虚名。高福利、高薪酬,再加上贴心的人文关怀,谷歌公司无可厚非的受到人才们的青睐。 ㈠谷歌公司的薪酬体系 据调查,2012年谷歌公司平均薪水为:106,104美元;薪水最高的职位;高级软件工程师(140,481美元);薪水最低职位:客户策略师(60,909美元)。 谷歌推出以绩效为导向的富有竞争力的全面薪酬:谷歌的全面薪酬包括工资、津贴、奖金、福利、保险、股票期权等。在对员工的短期、中期、和长期激励上,各自发挥着不同的作用。 对外,谷歌整体薪酬保持着市场上的强大竞争力;对内,充分考虑不同岗位,职级以及员工工作表现的差异性,建立了全方位的以业绩为导向的薪资理念。谷歌为所有正式员工发放股票期权,并且每年都会根据员工上一年度的业绩表现再授予股票期权。业

分布式数据库系统复习题

一、何为分布式数据库系统?一个分布式数据库系统有哪些特点? 答案:分布式数据库系统通俗地说,是物理上分散而逻辑上集中的数据库系统。分布式数据库系统使用计算机网络将地理位置分散而管理和控制又需要不同程度集中的多个逻辑单位连接起来,共同组成一个统一的数据库系统。因此,分布式数据库系统可以看成是计算机网络与数据库系统的有机结合。一个分布式数据库系统具有如下特点: 物理分布性,即分布式数据库系统中的数据不是存储在一个站点上,而是分散存储在由计算机网络连接起来的多个站点上,而且这种分散存储对用户来说是感觉不到的。 逻辑整体性,分布式数据库系统中的数据物理上是分散在各个站点中,但这些分散的数据逻辑上却构成一个整体,它们被分布式数据库系统的所有用户共享,并由一个分布式数据库管理系统统一管理,它使得“分布”对用户来说是透明的。 站点自治性,也称为场地自治性,各站点上的数据由本地的DBMS管理,具有自治处理能力,完成本站点的应用,这是分布式数据库系统与多处理机系统的区别。 另外,由以上三个分布式数据库系统的基本特点还可以导出它的其它特点,即:数据分布透明性、集中与自治相结合的控制机制、存在适当的数据冗余度、事务管理的分布性。 二、简述分布式数据库的模式结构和各层模式的概念。 分布式数据库是多层的,国内分为四层: 全局外层:全局外模式,是全局应用的用户视图,所以也称全局试图。它为全局概念模式的子集,表示全局应用所涉及的数据库部分。 全局概念层:全局概念模式、分片模式和分配模式 全局概念模式描述分布式数据库中全局数据的逻辑结构和数据特性,与集中式数据库中的概念模式是集中式数据库的概念视图一样,全局概念模式是分布式数据库的全局概念视图。分片模式用于说明如何放置数据库的分片部分。分布式数据库可划分为许多逻辑片,定义片段、片段与概念模式之间的映射关系。分配模式是根据选定的数据分布策略,定义各片段的物理存放站点。 局部概念层:局部概念模式是全局概念模式的子集。局部内层:局部内模式 局部内模式是分布式数据库中关于物理数据库的描述,类同集中式数据库中的内模式,但其描述的内容不仅包含只局部于本站点的数据的存储描述,还包括全局数据在本站点的存储描述。 三、简述分布式数据库系统中的分布透明性,举例说明分布式数据库简单查询的 各级分布透明性问题。 分布式数据库中的分布透明性即分布独立性,指用户或用户程序使用分布式数据库如同使用集中式数据库那样,不必关心全局数据的分布情况,包括全局数据的逻辑分片情况、逻辑片段的站点位置分配情况,以及各站点上数据库的数据模型等。即全局数据的逻辑分片、片段的物理位置分配,各站点数据库的数据模型等情况对用户和用户程序透明。

Google公司战略管理

企业战略管理案例-Google的企业战略 目录 、(SWOT分析) 、Google的SPACE分析 、Google的外部因素评价矩阵EFE 、Google的竞争态势矩阵CPM

1、Google公司简介 Google是一家美国上市公司(公有股份公司),于1998年9月7 日以私有股份公司的形式创立,以设计并管理一个互联网搜索引擎。Google 网站于1999年下半年启动;2004年8月19日,Google公司的股票在纳斯达克上市,成为公有股份公司。Google公司的总部称作“Googleplex”,它位于加利福尼亚山景城。Google目前被认为是全球规模最大的搜索引擎,它提供了简单易用的免费服务。“不作恶(Don’t be evil)”是谷歌公司的一项非正式的公司口号,最早是由Gmail服务创始人在一次会议中提出。目前,Google公司旗下的业务种类繁多,主要分为四大类: 搜索类产品是Google的主要产品,包括网页搜索、视频搜索、地图搜索等; 网络应用产品主要是注入Google talk、Gmail、Google chrome 等; 手机系统产品是Google新推出的手机系统Android; 盈利产品Google Adwords 是关键字搜索广告。 2、Google 企业文化 尽管自 1998 年创立以来,Google 的规模已经扩大了很多,但他们仍坚持营造一种小公司的氛围。午餐的时候,几乎所有人都在公司的餐厅随意就座用餐,与各个不同部门的同事一起愉快地畅谈。Google 秉承一贯的创新理念,而这有赖于每位员工都能够毫无顾忌地交流想法和观点。这就意味着每个员工都是功不可没的贡献者,而且每个人都要在公司身兼

谷歌公司战略的分析

谷歌公司战略的分析/选择 公司简介 ???????公司名称:谷歌外文名称:Google 总部地点:美国加利福尼亚州山景城成立时间:1998年9月7日经营范围:网络信息服务例如搜索引擎等公司性质:美国上市公司,外商独资公司口号:完美的搜索引擎、不作恶(Don't be evil) ?年营业额:380亿美元(2011年)?员工数:32467(2011年12月31日 愿景把服务延伸到所有终端装置使命整合全球信息,使人人皆可访问并从中受益名称来历 ? Google公司选用“Google”一词用来代表在互联网上可以获得的海量的资源。“Google”源于单词“Googol”,指的是10的100次幂。 Google 企业文化 每位员工都能够毫无顾忌地交流想法和观点要求工程师们每天都有20%时间在个人感 兴趣的项目上公司提供员工免费餐点,早中晚餐全包巧克力、懒人球以及巨型积木随处可见,使这里更像是托儿所公司里面设有牙医与家庭医师请育婴假的员工 可照领75%的薪水 Google公司旗下的业务种类繁多,主要分为四大类:?搜索类产品是Google的主要产 品,包括 网页搜索、视频搜索、地图搜索等; ?网络应用产品主要是注入Google talk、 Google公司旗下的业务种类繁多,主要分为四大类: Gmail、Google chrome 等; ?手机系统产品Android是Google推出的 手机系统 ?盈利产品Google Adwords 是关键字搜 索广告。 Google搜索服务 网页图片Google公司一直以来致力于为广大用户提供快速、整合相关性高的搜索服

新闻音乐搜索务。2007年底,在垂直搜索的基础上,Google首先推出视频图书“整合搜索”。 Google搜索服务 Google搜索引擎较早引入云计算,大大提高了搜索速度和信息量。 “Google靠云计算成就最好的搜索引擎。” ——李开复 Google软件与在线服务 Google利用其搜索功能的优势,开发出多种在线功能性服务和软件,涉及各领域,PC版本和手机版本更大地方便了用户。 日程管理软件照片管理软件3D绘图软件 Google 地图 翻译软件 Gmail Google广告服务 关键字广告 广告 广告联盟 Google拥有两种不同的广告方案,考虑到不同广告主的需要。让广告得到快速、广 泛的传播,使得广告效果最大化。 关键字广告 广告联盟 swot 分析 ? S(strength) ?? 1.企业文化、目标和管理模式,帮助谷歌吸引顾客和高素质人才。2.技术。谷歌在搜索算法与硬件创新运作方面具有优势。Google的每一个搜索结果都是“纯技术选择”,是计算机程序按照点击率规则自动排列出来的3.品牌形象,顾客忠诚度。G oogle杰出的形象-代表创新、互联网、诚信。不进行推销、不追求快速致富的形象深入人心,也使得Google

分布式数据库设计报告

分布式数据库设计报告

目录 1案例背景 (1) 需求分析 (1) 2 分布式数据库设计 (2) 设计目标 (2) 总体设计目标 (2) (4)可靠性: (3) 完成方式及周期 (3) 分布式数据库架构图 (4) 物理设计施工 (5) 3 总结 (5) 4所用设备汇总 (7) 5所使用软件 (7)

成品车间分布式数据库设计 1案例背景 随着成品车间信息化程度越来越高,我们的传统集中式数据库系统的缺点逐渐体现出来主要有: 1、所有数据处理、存储集中在一台计算机上完成,一旦机器损坏或系统崩 溃数据数据很难恢复。 2、单台机器写入/查询处理能力不足,一台机器既要读取数据,又要写入数 据,遇到大批量超过单台数据库的处理能力,就会出现卡顿,在生产时 间不敢批量制造/查询数据。 3、硬件性能瓶颈,包括(硬盘、CPU、内存),使用升级硬件的方法效果有限。 4、出现故障没有备用服务器可以替代。 5、当前成品车间存在2种数据库,oracle,sql sever,交叉使用不方便管 理维护,出现问题排查困难。 6、由于数据库初期创建数据库/表比较混乱,现在对数据的统计管理需要在 两台服务器之间交叉进行,统计难度高,效率低。 需求分析 成品车间信息化程度越来越高,各个节点产生的数据量越来越大,对数据系统要求越来越高,我们所使用的传统集中式数据库已经无法从容应对越来越大的数据。 成品车间生产线数据库主要有oracle和sql server两种,分别分布在2台计算机中,柔性线、自动线、三相线交叉使用两种类型数据库,主要出现的问题有; 1、一旦其中一个数据库出现问题,那么就有很大的几率导致三条线体 的某个节点或全部节点失去数据服务,导致停线。 2、数据库出现故障,必须停线,故障修复之后才可以上线使用。

Google各类产品简介

Google各类产品简介 1.Google Adwords(关键词竞价排名) 1.产品简介:通过设置关键词,进行排查某些无必要不精准或者价值不高的关键词后,在后台进行上线推广,当用户搜索这些关键词的时候可以检索到我们公司网站的信息,然后进行一个跳转,可以自己设定着陆页。(着陆页可以是我们的官网,也可以是产品的详细页面)。关键词可以根据不同的地区设置不同的关键词组,跳转的页面也可以不同(图2位跳转位置)。 2.广告投放位置: 左上方三个广告,左下方四个广告。

2.Google Gmail广告 1.产品简介:展示在国外邮箱上的广告,根据用户的搜索习惯(自己设置客户群体信息),将某些会产生询盘的客户进行标记,对这些客户进行广告投放。(点击后的样式可以是全屏,也可以单一的介绍产品信息) 2.广告投放位置: 展示在右侧以及上方 3.Google再营销 1.产品简介:当客户进入你的网站产品详情页点击后,但是当时没有产生购买(可能因为价格等问题),这个产品可以将这些客户进行一个保留,然后针对这些客户投放相应广告。 2.广告投放位置: 主要根据针对的客户群体投放广告,当客户浏览网站时,会看到相应的广告。 4.Google展示广告(联盟) 1.产品简介:根据关键词,主题等方式定位网站,或者通过用户的兴趣等定位人群投放广告。(一个跟人走,一个跟着网站走) 2.广告投放位置: 定位网站根据客户的LED灯等情况建议投放到以下网站,或者获取人群信息以及展示的位置:

5.Google产品列表广告 1.产品简介:主要以介绍单一产品为主,实现在线购买的过程。(如果没有在线购买无法使用这个广告功能) 2.广告投放位置:显示在Google搜索引擎左上方以及右上方的广告,点击后会进入一个产品的购买页面

谷歌的组织架构

深度#16 : 由Google新的组织架构Alphabet产生的联想 字数666阅读149评论0喜欢0 Google新格局

近日,Google对旗下所有的业务线做了一次重大的梳理和调整。简单来讲,将所有资产重新梳理规整到新的集团公司Alphabet旗下。 布局现在 Google Ventures vs. Google ? Google Ventures:中短线战略投资(资本),为公司现有业务线寻找重要的战略投资项目 ? ? Google:传统互联网核心业务(业务) ? Google Ventures是弹药,为Google现在的核心业务提供战略投资项目的机会。 布局未来 Google Capital vs. Google X Google Capital:长线天使投资布局(资本),为公司未来业务线寻找重要的战略投资项目 ? Google X:内部创新实验室(业务)

? ? Google Capital是弹药,为Google未来的产品线提供战略投资项目的机会。 ? 产业布局 Calico vs. Nest ?未来医疗:Calico ?智能家居:Nest 整体规划 Alphabet整体可以划归三部分:资本、现有业务、未来实验室。Google Ventures和Google Capital是资本。Google、Calico和Nest是现有业务。Google X是未来实验室(孵化器)。 本质上是一家广告公司 Google对于产业的整体大局把握是令人赞叹的,Google创始人在公司上市之前并没有更多被资本左右,在公司上市之后还能够主动做出重大调整的行动力更是令人敬佩。Google本身的搜索业务为公司带来最大的现金流,但是看上去更多像是一家广告公司。 Alphabet重组的意义 Google Ventures和Google Capital能够通过战略投资,持续为公司带来新鲜血液。Google X能够保持公司对于最新科技的敏感性。但是如何平衡在资本

分布式数据库设计方案

1.大型分布式数据库解决方案 企业数据库的数据量很大时候,即使服务器在没有任何压力的情况下,某些复杂的查询操作都会非常缓慢,影响最终用户的体验;当数据量很大的时候,对数据库的装载与导出,备份与恢复,结构的调整,索引的调整等都会让数据库停止服务或者高负荷运转很长时间,影响数据库的可用性和易管理性。 分区表技术 让用户能够把数据分散存放到不同的物理磁盘中,提高这些磁盘的并行处理能力,达到优化查询性能的目的。但是分区表只能把数据分散到同一机器的不同磁盘中,也就是还是依赖于一个机器的硬件资源,不能从根本上解决问题。 分布式分区视图 分布式分区视图允许用户将大型表中的数据分散到不同机器的数据库上,用户不需要知道直接访问哪个基础表而是通过视图访问数据,在开发上有一定的透明性。但是并没有简化分区数据集的管理、设计。用户使用分区视图时,必须单独创建、管理每个基础表(在其中定义视图的表),而且必须单独为每个表管理数

据完整性约束,管理工作变得非常复杂。而且还有一些限制,比如不能使用自增列,不能有大数据对象。对于全局查询并不是并行计算,有时还不如不分区的响应快。 库表散列 在开发基于库表散列的数据库架构,经过数次数据库升级,最终采用按照用户进行的库表散列,但是这些都是基于自己业务逻辑进行的,没有一个通用的实现。客户在实际应用中要投入很大的研发成本,面临很大的风险。 面对海量数据库在高并发的应用环境下,仅仅靠提升服务器的硬件配置是不能从根本上解决问题的,分布式网格集群通过数据分区把数据拆分成更小的部分,分配到不同的服务器中。查询可以由多个服务器上的CPU、I/O来共同负载,通过各节点并行处理数据来提高性能;写入时,可以在多个分区数据库中并行写入,显著提升数据库的写入速度。

分布式数据库课程设计报告

分布式数据库在学生信息管理系统中的应用 班级: 姓名: 设计时间: 指导教师: 评语:_________________________________评阅成绩:____评阅教师:_____ 目录

摘要 (3) 第一章绪论 (4) 1.1课题研究的意义 (4) 1.2分布式数据库技术国外发展现状 (4) 1.3分布式数据库技术国内发展现状 (5) 1.4分布式数据库技术发展动向 (5) 第二章分布式数据库理论 (6) 2.1分布式数据库理论 (6) 2.1.1分布式数据库系统的有关概念 (6) 2.1.2分布式数据库系统的特点 (6) 2.1.3分布式数据库数据分片 (7) 2.1.4分布式数据库数据分布 (7) 2.1.5数据分布设计策略 (8) 第三章系统总体设计 (10) 3.1系统功能设计 (10) 3.2系统结构设计 (10) 3.3系统概念设计 (11) 4.4系统逻辑设计 (11) 4.5系统物理设计(表设计) (11) 第四章系统实现 (15) 4.1P OWER B UILDER开发工具简介 (15) 4.2P OWERBUILDER 9应用程序开发的基本步骤 (16) 4.3编码规范 (16) 4.4应用程序对象A PP_MAPBEX (16) 4.5具体窗口的实现 (17) 第五章课程设计总结 (23) 第六章参考文献 (23)

摘要 社会在飞速的发展,计算机的应用正深入到人们生活的每一个角落。我们作为当代的大学生,更应该推动和实践计算机信息系统在生活在的应用,为将来的工作和学习打好基础。 本系统为简易的分布式学生信息管理系统,实现学生的基本信息管理和学生成绩管理。 本系统采用了Power Builder9+SQL2000的结构来开发程序。Power Bulider(以下简称pb)做为应用程序开发工具和程序界面开发工具,pb具有功能强大,集成性好的优点,很适合小型系统的应用开发和界面开发。后台数据库使用SQL 2000系统,Microsoft SQL Server 2000是美国微软公司推出的使用相当广泛的数据库管理系统,包含一套图形工具,如服务器管理(用于启动和关闭数据库服务)、企业管理器(用于创建和修改数据库及备份数据库等)和查询分析器(用于交互执行Transact-SQL 语句和过程并提供图形查询分析功能)等。 本报告说明了整个系统从分析到设计再到实现的具体步骤和过程,从中我学到了很多知识和技能。 关键词:分布式信息管理系统PB+SQL2000

谷歌的发展历史

Google 一、企业简介 Google公司(中文译名:谷歌),是一家美国的跨国科技企业,致力于互联网搜索、云计算、广告技术等领域,开发并提供大量基于互联网的产品与服务,其主要利润来自于AdWords等广告服务。 谷歌的使命是整合全球信息,使人人皆可访问并从中受益。谷歌是第一个被公认为全球最大的搜索引擎,在全球围拥有无数的用户。 二、企业发展 1997年到1998年间,谷歌联合创始人拉里·佩奇和尔盖·布林在学生宿舍里共同开发了全新的在线搜索引擎,之后他们募集了100万美元,在美国加门罗帕克的一间车库筹备公司。成立数天后,公司注册了https://www.360docs.net/doc/5613421403.html,域名。 1999年6月7日,谷歌获得了两家风险投资公司的投资,一共是2500万美元,这成为谷歌发展的最重要的开始。 2000年,谷歌与雅虎公司达成合作协议,谷歌为雅虎提供搜索引擎服务,使得谷歌开始崭露头角。在此之前,谷歌还未成为搜索行业的主流,当时的行业领头羊仍是雅虎。 2001年,谷歌的网页评级机制PageRank被授予了美国专利。但在互联网激烈的竞争下,仅仅靠出售技术,没有其他盈利方式是远远不够的,于是埃克里·施密特被风投家介绍空降到谷歌,成为公司CEO。

谷歌开始了一个新的时代。谷歌创新的推出了Adwords文字广告——在搜索结果右边附加相关广告,使得谷歌在保持主页简明朴素的同时又能增加广告收入,这是谷歌最核心最成功的赚钱方式。 2006年10月,谷歌公司以16.5亿美元,收购影音容分享YouTube,是谷歌有史以来最大的并购。 2007年11月05日,谷歌宣布基于Linux平台的开源手机操作系统的名称为android。 2008年9月7日,Google Map卫星升空,将为Google Earth提供50厘米分辨率高清照片。同年,谷歌与金融集团汇丰银行(HSBC)以及国际有线电视集团Liberty Global组成名为“O3b Networks”的网络计划,通过发射16颗卫星将网络服务带入地球上还未连上网络的地区,取名为O3b就是指地球上另外未有网络建设的30亿人口,希望借这样的网络计划工程,真正建立在地球上任何区域皆有连网能力的环境。 2012年2月14日,谷歌收购Motorola获欧盟和美国批准。

分布式数据库TDSQL架构原理概述

腾讯分布式数据库TDSQL金融级能力的架构原理概述

目录

TDSQL是什么:腾讯如何打造一款金融级分布式数据库 我们先初步了解TDSQL产品,以及它的适用场景。第一章包括四个方面:使用场景、发展历程、核心特性,以及兼容性。 首先,TDSQL是腾讯推出的一款兼容MySQL的自主可控、高一致性分布式数据库产品。这里我们强调一点,高度兼容MySQL——TDSQL完全兼容MySQL协议,并且做到完全自主可控、数据强一致性。第二是TDSQL具备分布式的特性,具备一个弹性扩展、高可用的架构。在互联网行业,海量的用户流量场景很常见,如果数据库不具备可伸缩性、可扩展性,是很难应对如:电商的大型促销,春节抢红包等突增流量的场景,这些其实都是对数据库应对海量用户流量的考验。

目前TDSQL已经服务超过500+的金融政企,行业覆盖银行、保险、证券、政务、互联网金融等各个领域。 我们再看一下TDSQL的前世今生。TDSQL最早可以追溯到2002年,那个时候其实还不叫TDSQL,它是腾讯计费平台部的一个数据库服务,当时使用了开源的MySQL。2002年-2007年随着公司业务的发展,腾讯所面临的用户量的压力也越来越大。这个时候我们提出了7×24小时不宕机的高可用设计方案,来保证数据库能提供7×24小时不间断连续高可用服务。那个时候,腾讯的增值业务日渐成规模,业务对数据也越来越敏感,对数据可用性的要求越来越高,甚至平时还要防备一些像运营商的光纤被挖断等各种各样的异常场景。

在2007年-2012年,这可能是互联网时代从互联网到移动互联网的发展的快速5年。当然,公司的业务也是突飞猛进。我们开始把这个高可用的数据库产品化。到2012年,TDSQL的雏形就已经出来了,作为一款内部产品,开始在公司内部提供金融级的数据强一致性、可靠性服务。 从2012年起,TDSQL已经在腾讯内部做得已经比较成熟,已经是一个知名的产品了,但是它一直没有对外做商业化。2014年恰逢一个很好的机会——微众银行的成立。微众银行做数据库选型的时候关注到了TDSQL,经过反复测试验证,发现当时的TDSQL已经完全具备了微众银行对数据可用性和一致性的要求。借此机会,TDSQL成功在微众银行投产,成为微众银行唯一的数据库,覆盖了银行的核心业务。 所以说2014年,TDSQL完成了商业化,也实现了私有化部署。2014年以后,TDSQL推广到了很多银行、金融机构,这过程中是借鉴了2014年TDSQL在微众银行成功实施的宝贵的经验。 因为在2014年微众银行的部署中,我们也踩了很多坑,也认识到在私有化部署环境的各种各样的挑战,并一一攻克了这些挑战。当2014年在私有化部署完成之后,再到2015年TDSQL上公有云,我们继续通过公有云服务打磨自己的产品。

Google架构介绍

Google系统架构在伸缩性上可以说称王了,Google一直的目标就是构建高性能高伸缩性的基础组织来支持它们的产品。 平台 Linux 使用大量开发语言:Python,Java,C++ 状态 ?在2006年大约有450,000台廉价服务器; ?在2005年Google索引了80亿Web页面,现在没有人知道数目; ?目前在Google有超过200个GFS集群。一个集群可以有1000或者甚至5000台机器。成千上万的机器从运行着5000000000000000字节存储的GFS集群获取数据,集群总的读写吞吐量可以达到每秒40兆字节; ?目前在Google有6000个MapReduce程序,而且每个月都写成百个新程序; ?BigTable伸缩存储几十亿的URL,几百千千兆的卫星图片和几亿用户的参数选择; 堆栈 Google形象化它们的基础组织为三层架构: 1、产品:搜索,广告,email,地图,视频,聊天,博客; 2、分布式系统基础组织:GFS,MapReduce和BigTable; 3、计算平台:一群不同的数据中心里的机器; 4、确保公司里的人们部署起来开销很小; 5、花费更多的钱在避免丢失日志数据的硬件上,其他类型的数据则花费较少; 可信赖的存储机制-谷歌文件系统GFS(Google File System) 1、可信赖的伸缩性存储是任何程序的核心需求,谷歌文件系统GFS就是Google的核心存储平台; 2、Google File System - 大型分布式结构化日志文件系统,Google在里面扔了大量的数据; 3、为什么构建GFS而不是利用已有的东西?因为可以自己控制一切并且这个平台与别的不一样,G oogle需要: -跨数据中心的高可靠性; -成千上万的网络节点的伸缩性; -大读写带宽的需求; -支持大块的数据,可能为上千兆字节; -高效的跨节点操作分发来减少瓶颈; 4、系统有Master和Chunk服务器 -Master服务器在不同的数据文件里保持元数据。数据以64MB为单位存储在文件系统中。客户端与Master服务器交流来在文件上做元数据操作并且找到包含用户需要数据的那些Chunk服务器;

几款分布式数据库的对比

1 概述 随着海量数据问题的出现,海量管理能力,多类型,变化快,高可用性,低成本,高端可扩展性等需求给企业数据战略带来了巨大的挑战。企业数据仓库、数据中心的技术选型变得尤其重要!所以在选型之前,有必要对目前市场上各种大数据量的解决方案进行分析。 2 主流分布式并行处理数据库产品介绍 2.1 Greenplum 2.1.1 基础架构 Greenplum是基于Hadoop的一款分布式数据库产品,在处理海量数据方面相比传统数据库有着较大的优势。 Greenplum整体架构如下图: SQL MapReduce 数据库由Master Severs和Segment Severs通过Interconnect互联组成。 Master主机负责:建立与客户端的连接和管理;SQL的解析并形成执行计划;执行计划向Segment的分发收集Segment的执行结果;Master不存储业务数据,只存储数据字典。 Segment主机负责:业务数据的存储和存取;用户查询SQL的执行。 2.1.2 主要特性 Greenplum整体有如下技术特点: ◆ Shared-nothing架构 海量数据库采用最易于扩展的Shared-nothing架构,每个节点都有自己的操作系统、数据库、硬件资源,节点之间通过网络来通信。 ◆ 基于gNet Software Interconnect 数据库的内部通信通过基于超级计算的“软件Switch”内部连接层,基于通用的gNet (GigE, 10GigE) NICs/switches在节点间传递消息和数据,采用高扩展协议,支持扩展到1000个以上节点。

◆ 并行加载技术 利用并行数据流引擎,数据加载完全并行,加载数据可达到4。5T/小时(理想配置)。并且可以直接通过SQL语句对外部表进行操作 ◆ 支持行、列压缩存储技术 海量数据库支持ZLIB和QUICKLZ方式的压缩,压缩比可到10:1。压缩数据不一定会带来性能的下降,压缩表通过利用空闲的CPU资源,而减少I/O资源占用。 海量数据库除支持主流的行存储模式外,还支持列存储模式。如果常用的查询只取表中少量字段,则列模式效率更高,如查询需要取表中的大量字段,行模式效率更高。 海量数据库的多种压缩存储技术在提高数据存储能力的同时,也可根据不同应用需求提高查询的效率 2.1.3 主要局限 ● 列存储模式的使用有限制,不支持delete/update操作。 ● 用户不可灵活控制事务的提交,用户提交的处理将被自动视作整体事 务,整体提交,整体回滚。 ● 数据库需要额外的空间清理维护(vacuum),给数据库维护带来额外的 工作量。 ● 用户不能灵活分配或控制服务器资源。 ● 对磁盘IO有比较高的要求。 ● 备份机制还不完善,没有增量备份。 2.2 Vertica 2.2.1 基础架构 与以往常见的行式关系型数据库不同,Vertica 是一种基于列存储(Column-Oriented)的数据库体系结构,这种存储机构更适合在数据仓库存储和商业智能方面发挥特长。 常见的RDBMS 都是面向行(Row-Oriented Database)存储的,在对某一列汇总计算的时候几乎不可避免的要进行额外的I/O 寻址扫描,而面向列存储的数据库能够连续进行I/O 操作,减少了I/O 开销,从而达到数量级上的性能提升。 同时,Vertica 支持海量并行存储(MPP)架构,实现了完全无共享,因此扩展容易,可以利用廉价的硬件来获取高的性能,具有很高的性价比。

谷歌公司简介

谷歌公司简介 谷歌新LOGOGoogle公司(Google Inc.,NASDAQ:GOOG),是一家美国的上市公司(公有股份公司),于1998年9月7日以私有股份公司的形式创立,以设计并管理一个互联网搜索引擎;Google公司总部位于加利福尼亚山景城,在全球各地都设有销售和工程办事处。Google网站于1999年下半年启动;2004年8月19日,Google公司的股票在纳斯达克(Nasdaq)上市,成为公有股份公司。Google公司的总部称作"Googleplex",位于美国加州圣克拉拉县的山景城(Mountain View)。在共创办人拉里·佩奇退下后,Novell公司的前任行政总裁,埃里克·施密特(Eric E.Schmidt)博士,成为了Google公司的行政总裁。Google成立的第一步始于Google创始人Larry Page和Sergey Brin在斯坦福大学的学生宿舍内共同开发了全新的在线搜索引擎,然后迅速传播给全球的信息搜索者。Google目前被公认为是全球规模最大的搜索引擎,它提供了简单易用的免费服务,用户可以在瞬间得到相关的搜索结果。当您访问 https://www.360docs.net/doc/5613421403.html,或众多Google域之一时,您可以使用多种语言查找信息、查看股价、地图和要闻、查找美国境内所有城市的电话簿名单、搜索数十亿计的图片并详读全球最大的Usenet信息存档–超过十亿条帖子,发布日期可以追溯到1981年。用户不必特意访问Google主页,也可以访问所有这些信息。2006年4月12日,Google公司行政总裁埃里克·施密特在北京宣布该公司的全球中文名字为"谷歌"(有报道指出取义"丰收之歌",不过亦有报道指出取义"山谷之歌")。同时,Google公司于2006年2月15日在台湾地区登记之分公司取名为"美商科高国际有限公司"。此前,在一份中国国际经济贸易仲裁委员会域名争议解决中心裁决书中,公司被称为"科高公司"。该公司亦拥有"谷歌.cn"、"谷歌.中国"、"咕果.com"(但不拥有"咕果.中国"及"咕果.公司")等中文域名。尽管中文用户在除其英文名外更常称Google为"古狗"或"狗狗",其中文域名"古狗.com"、"古狗.cn"、"古狗.中国"等均已被其他公司抢注。此外,Google 在北京的分公司曾使用"咕果"作为合约签订以及网络招聘的中文译名。北京时间(UTC+8)2006年4月17日凌晨1时左右,Google简体中文网站正式出现"谷歌"字样(其他地区依旧仅显示"Google")。Google中国对"谷歌"的解释是"播种与期待之歌,亦是收获与欢愉之歌",并称此名称是经Google中国的全体员工投票选出。"谷歌"发布不久,即遭到很多用户的批评。随后,部分中文用户发

OceanBase企业级分布式数据库介绍

透明可扩展的企业级数据库

?目录什什么是透明可扩展 透明可扩展的理论基础 透明可扩展的关键设计 OceanBase实践

?企业级数据库:Oracle、SQLServer、DB2 ?云数据库:Amazon Aurora、Amazon Redshift ? 魔力四象限 ?行行业现状 A B I L I T Y T O E X E C U T E CHALLENGERS LEADERS NICHE PLAYERS VISIONARIES MongoDB MarkLogic Intersystems Amazon Web Services Microsoft Oracle SAP IBM EnterpriseDB DataStax MapR Actian Google Alibaba Cloud COMPLETENESS OF VISION As of June 2018 ?Gartner.Inc

企业级数据库?面临的问题 $$$单机不不可扩展成本?高

DB(写?入)DB(只读)?云数据库:开源数据库 + 存储计算分离 ?解决了存储可扩展问题,但事务和SQL不可扩展 ?开源数据库核心能力距离企业级数据库仍有较大差距 存储集群Hybrid clouds require excellent distributed OLTP DBMS, and the memory/storage architecture still requires a lot of work. In addition, data security and data management are both issues that need to be considered. —C Mohan@ICDE 2019, IBM Fellow

Google公司人力资源管理

长江大学工程技术学院《国际企业经营与管理概论》 结课报告 系部管理系 专业班级市销61301 学生姓名刘仁泽 学生序号17

目录 一、Google公司简介..................................................................................... II 二、Google 企业文化.................................................................................... II 三、Google的价值观..................................................................................... II 四、Google公司人力资源管理的特点 (1) (一)Google公司人力资源管理与核心能力 (1) (二)Google公司人力资源战略规划 (1) (三)Google公司职位分享与职位评价 (2) (四)Google公司企业绩效管理及薪酬管理 (2) (五)Google公司人力资源外包 (2) 五、Google公司人力资源管理的问题 (3) (一)Google触及个人隐私 (3) (二)Google遭遇中国本土 (3) 六、Google公司人力资源管理的借鉴 (4) 七、结论 (5) 参考文献 (5)

一、Google公司简介 Google是一家美国上市公司(公有股份公司),于1998年9月7 日以私有股份公司的形式创立,以设计并管理一个互联网搜索引擎。Google网站于1999年下半年启动;2004年8月19日,Google公司的股票在纳斯达克上市,成为公有股份公司。Google公司的总部称作“Googleplex”,它位于加利福尼亚山景城。Google目前被认为是全球规模最大的搜索引擎,它提供了简单易用的免费服务。“不作恶(Don’t be evil)”是谷歌公司的一项非正式的公司口号,最早是由Gmail服务创始人在一次会议中提出。 目前,Google公司旗下的业务种类繁多,主要分为四大类: 搜索类产品是Google的主要产品,包括网页搜索、视频搜索、地图搜索等; 网络应用产品主要是注入Google talk、Gmail、Google chrome 等; 手机系统产品是Google新推出的手机系统Android; 盈利产品Google Adwords 是关键字搜索广告。 二、Google 企业文化 尽管自 1998 年创立以来,Google 的规模已经扩大了很多,但他们仍坚持营造一种小公司的氛围。午餐的时候,几乎所有人都在公司的餐厅随意就座用餐,与各个不同部门的同事一起愉快地畅谈。Google 秉承一贯的创新理念,而这有赖于每位员工都能够毫无顾忌地交流想法和观点。这就意味着每个员工都是功不可没的贡献者,而且每个人都要在公司身兼数职。他们聘用员工的准则非常包容,注重能力胜于经验。他们在全球各地均设有办事处,员工使用的语言高达数十种,从土耳其语到泰卢固语,包罗甚广。这样形成的团队反映了 Google 为全球用户服务的理念。工作之余,Google 员工会投身于各种趣味活动中,比如自行车越野、品酒、飞行以及飞盘游戏等。 三、Google的价值观 Google 创始人之一 Larry Page 指出:“完美的搜索引擎需要做到确解用户之意,切返用户之需”。Google 致力于成为这一技术领域的开拓者。尽管 Google 已是全球公认的业界领先的搜索技术公司,但其目标是为所有信息搜寻者提供更高标准的服务。 3.1、以用户为中心,其他一切水到渠成。 创建伊始,Google 就以提供最佳的用户体验为中心任务。不管是设计新的互联网浏览器,还是采用新的首页外观,他们都非常谨慎,确保它们最终可以满足“用户”的需求,而不是达到他们自己的内部目标或底线。 3.2、心无旁骛、精益求精。 Google 要做的就是搜索。拥有世界上最大的研究队伍之一,可以心无旁骛地攻克搜索问题,知道自己擅长什么,也知道如何可以做得更好,因此不断地改善搜索服务,将强

分布式数据中心架构发展概述

分布式数据中心架构发展概述

目录 一、数据中心发展概述 (3) 二、为什么需要分布式数据中心 (3) 三、集中和分布式架构两种数据中心的区别 (6) 四、分布式架构建设的挑战 (11) 五、结束语 (14)

一、数据中心发展概述 什么是数据中心?百度百科给出定义是:数据中心是全球协作的特定设备网络,用来在因特网络基础设施上传递、加速、展示、计算、存储数据信息。数据中心大部分电子元件都是由低直流电源驱动运行的。 数据中心的产生致使人们的认识从定量、结构的世界进入到不确定和非结构的世界中,它将和交通、网络通讯一样逐渐成为现代社会基础设施的一部分,进而对很多产业都产生了积极影响。不过数据中心的发展不能仅凭经验,还要真正的结合实践,促使数据中心发挥真正的价值作用,促使社会的快速变革。 二、为什么需要分布式数据中心 说到发展,数据中心正随着各个行业的蓬勃发展而不断高速的建设着。云计算、大数据和物联网等新技术的大规模使用,让数据中心成为了医疗、政府、互联网和金融等行业建设的重点。特别是在银行、保险等领域,数据中心由于承载核心业务,不允许任何数据中断、要求能够快速响应业务变化和具备一定的灵活性,已经成为了名副其实的“生产中心”。反观数据中心,传统的集中式架构已经无法满足新时代业务的需求。而基于分布式架构的数据中心是一个和集中式架构相对应的技术体系,包括了分布式业务部署、分布式计算、存储、网络安全等多种分布式技术的集合。在传统数据中心无法保证业务响应能力、连续性和灵活性,发展达到一定瓶颈的时候,分布式架构就自然成为了一种必然的选择。

在早期的数据中心建设中,大多数IT建设者们并不太关注采用何种技术架构,觉得没有那么重要。数据中心的建设重点就是让承载的业务系统稳定运行,为服务器、存储和网络设备提供一个良好的运行环境,让业务系统没那么容易“宕机”即可。所以早期大部分数据中心都是烟囱式的架构设计,每个业务系统都会配置一套独立硬件设备,数据完全是割裂的,导致设备利用率非常低,资源完全无法共享。典型的“标配”方案为两台高端小型机(或X86服务器)做数据库服务器双机,然后再加两台或以上应用服务器,后端连接两台FC交换机(或IPSAN交换机)和一台存储设备。直到现在,仍然可以看到许多招标文件中有类似的配置方案。当然,并不能说明这种配置方案不好或者不对,只能说在没有很好规划和合理利用的情况下,这样的配置会导致数据中心空间、能耗、制冷大规模增加,而且设备数量的随意增加还会严重影响运维和管理的效率。 为了应对信息化的快速发展,提高设备利用率和灵活性,云计算技术被大规模推广和采用。云计算可以提供可用的、便捷的、按需的资源提供,逐渐成为了主流的数据中心架构,目前大多数行业的数据中心都已经具备了云计算的能力。除了大规模数据库等少数业务场景以外,新业务应用基本都是使用云模式进行构建,同时还有大量现有的业务应用正不断向云计算环境进行迁移。将应用系统运行在虚拟化环境中似乎已经成为了一种常态。在云计算环境中,服务器虚拟化是基本的云计算技术之一。虚拟化软件厂商正在逐步将基于物理资源的数据中心向虚拟化资源的数据中心进行转变,有效的控制了数据中心内服务器数量和规模的增长,提高了服务器的利用效率。同时,虚拟化系统所具备的特性极大的提高了数据中心系统的可靠性。特别在主动运维、灾备建设和故障切换等方面对数据中心的业务连续性是一种质的飞跃。在这一阶段,虚拟化技术的大规模应用让传统数据中心在不改变集中式的架构条件下,获得了最大化的资源整合和共享,但是架构仍然没有太大的变化,更多的是一种服务模式的转变。