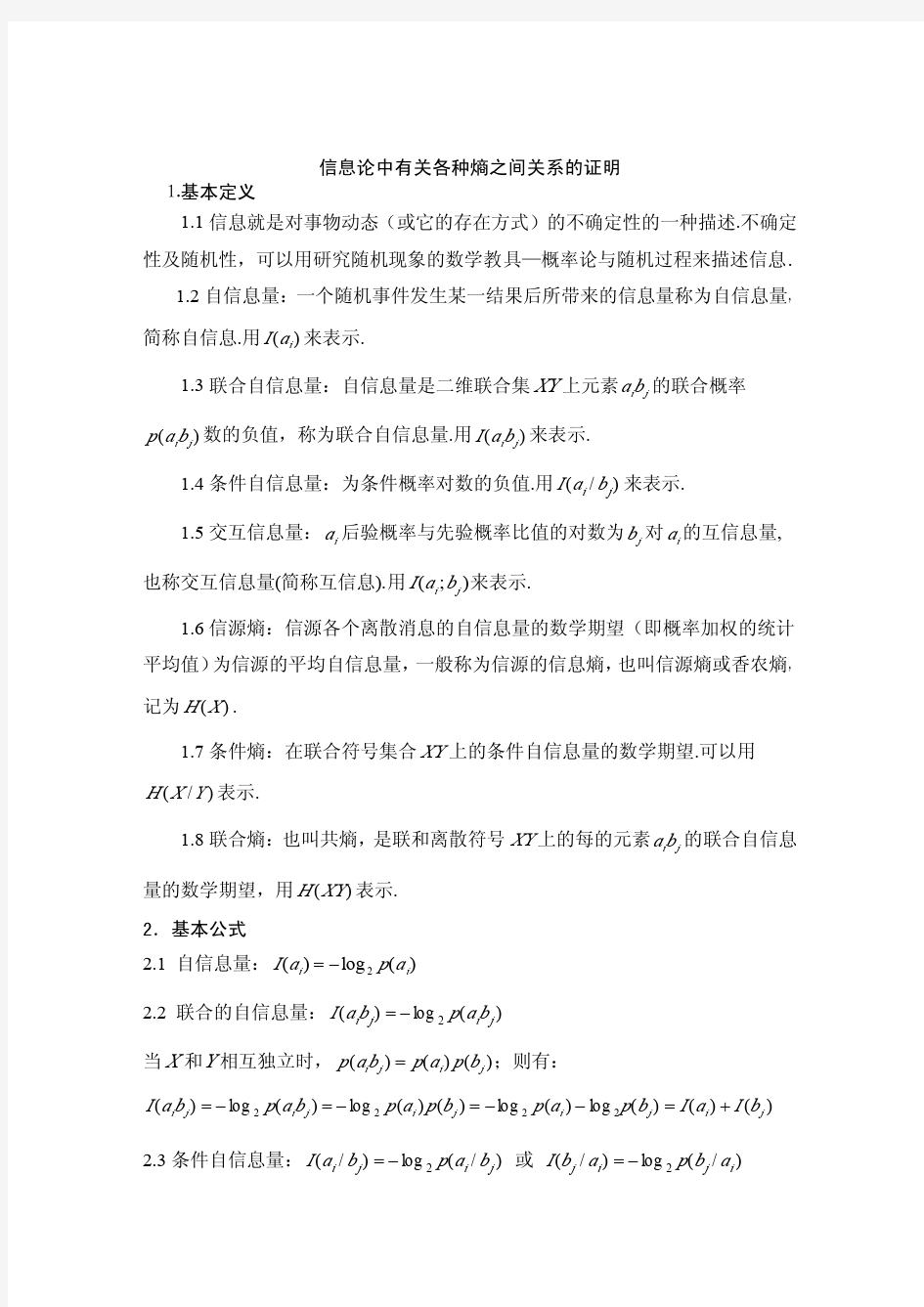

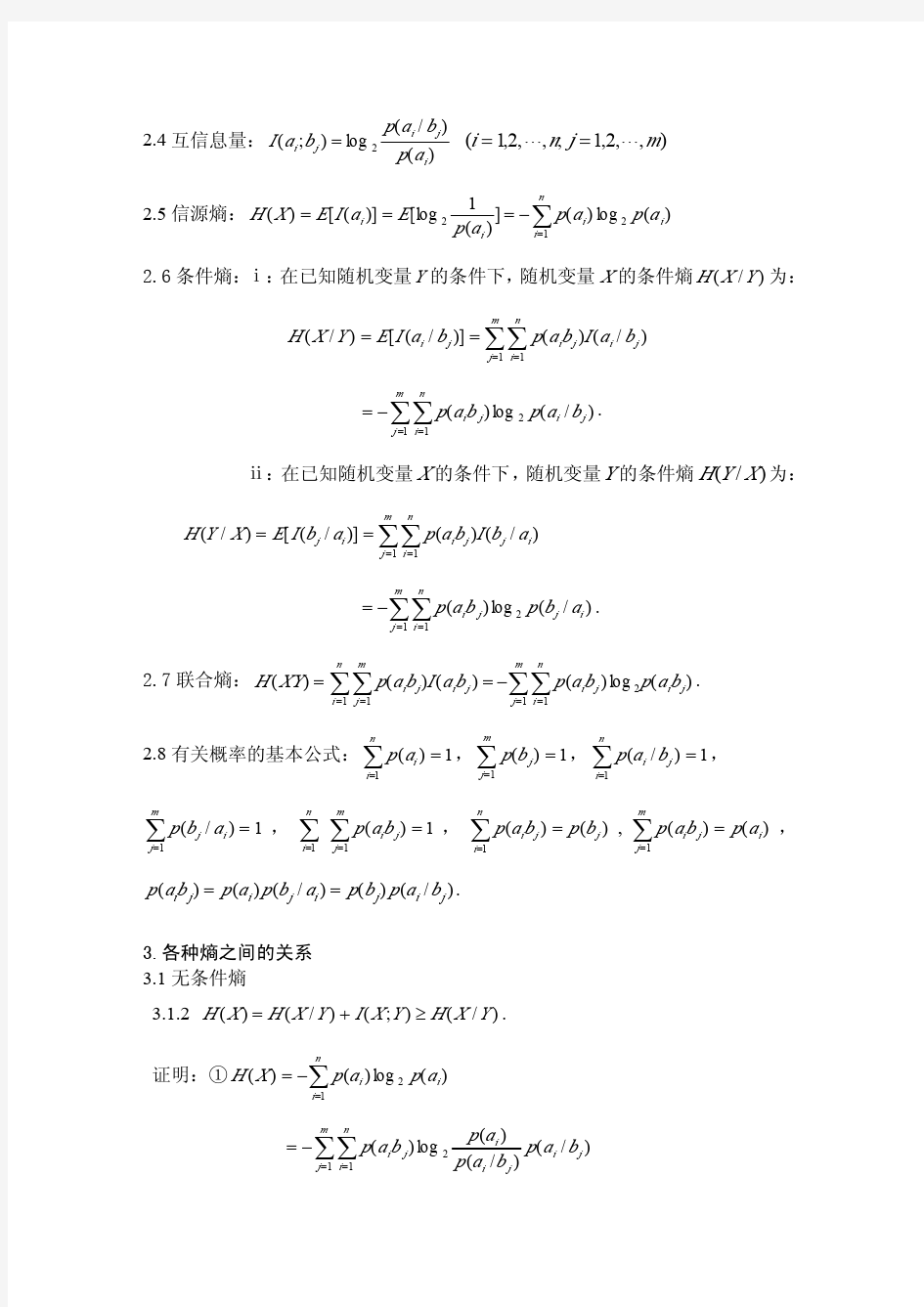

信息论中信源熵之间关系的证明

信源及信源熵习题答案

第二章: 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍 解: 四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则: 四进制脉冲的平均信息量H(X 1) = log 2n = log 24 = 2 bit/symbol 八进制脉冲的平均信息量H(X 2) = log 2n = log 28 = 3 bit/symbol 二进制脉冲的平均信息量H(X 0) = log 2n = log 22 = 1 bit/symbol 《 所以: 四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量 解: 设随机变量X 代表女孩子学历 X x 1(是大学生) x 2(不是大学生) P(X) ( 设随机变量Y 代表女孩子身高 Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) " 已知:在女大学生中有75%是身高160厘米以上的 即:p(y 1/ x 1) = 求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15.075.025.0log )()/()(log )/(log )/(2111121111=??? ???-=? ? ????-=-= 一副充分洗乱了的牌(含52张牌),试问 (1) 任一特定排列所给出的信息量是多少 (2) 若从中抽取13张牌,所给出的点数都不相同能得到多少信息量 》 解: (1) 52张牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是: bit x p x I i i 581.225!52log )(log )(2==-= (2) 52张牌共有4种花色、13种点数,抽取13张点数不同的牌的概率如下:

第3章_离散信源(1)题与答案

3.1 设有一离散无记忆信源,其概率空间为 ??? ? ??=====??????8/14/1324/18/310)(4321x x x x X P X 该信源发出的信息序列为(202 120 130 213 001 203 210 110 321 010 021 032 011 223 210)。 求: (1) 此消息的自信息量是多少? (2) 此消息中平均每符号携带的信息量是多少? 解: (1) 此消息总共有14个0、13个1、12个2、6个3,因此消息发出的概率是: 6 2514814183?? ? ?????? ?????? ??=p 此消息的信息量是:bit p I 811.87log =-= (2) 此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/== 3.2 某一无记忆信源的符号集为{0, 1},已知信源的概率空间为 ???? ??=??????4/34/110 )(X P X (1) 求信息符号的平均熵; (2) 由100个符号构成的序列,求某一特定序列(例如有m 个“0”和(100 - m )个“1”)的自信息量的表达式; (3) 计算(2)中序列的熵。 解: (1) bit x p x p X H i i i 811.043log 4341log 41 )(log )()(=??? ??+-=-=∑ (2) bit m x p x I x p m i i m m m i 585.15.4143 log )(log )(4 34341)(100 100100 100100+=-=-==? ? ? ?????? ??=--- (3) bit X H X H 1.81811.0100)(100)(100=?== 3.5 某信源的消息符号集的概率分布和二进制代码如题表3.2所列。 题表 3.2

第二章信源熵-习题答案(精品文档)

· 1 · 2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍? 解: 四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则: 四进制脉冲的平均信息量H(X 1) = log 2n = log 24 = 2 bit/symbol 八进制脉冲的平均信息量H(X 2) = log 2n = log 28 = 3 bit/symbol 二进制脉冲的平均信息量H(X 0) = log 2n = log 22 = 1 bit/symbol 所以: 四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。 2.2 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量? 解: 设随机变量X 代表女孩子学历 X x 1(是大学生) x 2(不是大学生) P(X) 0.25 0.75 设随机变量Y 代表女孩子身高 Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5 已知:在女大学生中有75%是身高160厘米以上的 即:p(y 1/ x 1) = 0.75 求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15.075.025.0log )()/()(log )/(log )/(2111121111=??? ???-=? ? ????-=-= 2.3 一副充分洗乱了的牌(含52张牌),试问 (1) 任一特定排列所给出的信息量是多少? (2) 若从中抽取13张牌,所给出的点数都不相同能得到多少信息量? 解: (1) 52张牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是: bit x p x I i i 581.225!52log )(log )(2==-= (2) 52张牌共有4种花色、13种点数,抽取13张点数不同的牌的概率如下: bit C x p x I C x p i i i 208.134 log )(log )(4)(1352 13 2 213 52 13 =-=-==

信息论与编码第二章 信源熵习题的答案[最新]

2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍? 解: 四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则: 四进制脉冲的平均信息量symbol bit n X H / 24log log )(1=== 八进制脉冲的平均信息量symbol bit n X H / 38log log )(2=== 二进制脉冲的平均信息量symbol bit n X H / 12log log )(0=== 所以: 四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。 2.2 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量? 解: 设随机变量X 代表女孩子学历 X x 1(是大学生) x 2(不是大学生) P(X) 0.25 0.75 设随机变量Y 代表女孩子身高 Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5 已知:在女大学生中有75%是身高160厘米以上的 即:bit x y p 75.0)/(11= 求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15 .075.025.0log )()/()(log )/(log )/(11111111=?-=-=-= 2.3 一副充分洗乱了的牌(含52张牌),试问 (1) 任一特定排列所给出的信息量是多少? (2) 若从中抽取13张牌,所给出的点数都不相同能得到多少信息量? 解: (1) 52张牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是: ! 521)(=i x p bit x p x I i i 581.225!52log )(log )(==-= (2) 52张牌共有4种花色、13种点数,抽取13张点数不同的牌的概率如下:

第四章 信源编码 习题解答

第四章信源编码 习题解答 1、一个信源由 1) 哪些是非奇异码?哪些是唯一可译码?哪些是即时码? 2) 分别计算每个唯一可译码的平均码长和编码效率。 解:1)A 、B 、C 、D 、E 、F 是非奇异码。A 、B 、C 、F 是唯一可译码(E 不满足克拉夫特不等式)。A 、C 、F 是即时码(B 是续长码)。 3) 编码A : 平均码长:3A L = 码元/消息 信源熵:111111 ()lb lb 4lb 222441616 H X =---?=比特/消息 编码效率:max ()/2/3 66.7%lb21 A H H X L H η====码码 编码B 和C : 平均码长:111111 23456 2.1252416161616 B C L L ==+?+?+?+?+?= 码元/消息 编码效率:max ()/2/2.125 94.1%lb21 B C H H X L H ηη=====码码 编码F : 平均码长:11 1234 2.524 16F L ??=? +?+?= ??? 码元/消息 编码效率:max ()/2/2.5 80%lb21 F H H X L H η====码码 2、离散无记忆信源X 的概率空间为:1 234567()0.200.190.180.170.150.100.01X x x x x x x x p X ????=???????? 1)对其进行费诺编码,并计算其编码效率; 2)对其进行哈夫曼编码,并将其编码效率与费诺编码相比较。

解:1)费诺编码: 平均码长:()()()0.20.1720.190.180.1530.10.014 2.74L =+?+++?++?=码元/符号 信源熵: ()0.20lb0.200.19lb0.190.18lb0.180.17lb0.170.15lb0.150.1lb0.10.01lb0.01 2.60/874H X =-------= 比特符号 编码后平均码元熵:() 2.60874 0.95212.74H X H L ===码比特/码元 编码效率:max 0.9521 95.21%lb2 H H η= ==码码 2)哈夫曼编码: 码长 码字 信源X p (X ) 2 10 x 1 2 11 x 2 3 000 x 3 3 001 x 4 3 010 x 5 4 0110 x 6 4 0111 x 7 平均码长:()()()0.20.1920.180.170.1530.10.014 2.72L =+?+++?++?=码元/符号 编码后平均码元熵:() 2.60874 0.95912.72H X H L ===码比特/码元 编码效率:max 0.9591 95.91%lb2 H H η= ==码码 与费诺编码相比,哈夫曼编码的编码效率要高于费诺编码。 一般情况下哈夫曼编码效率较高,但费诺编码如果每次划分概率很接近,则效率也很高。

第二章信源信息熵

第二章信源与信息熵 主要内容:(1)信源的描述与分类;(2)离散信源熵和互信息;(3)离散序列信源的熵;(4)连续信源的熵和互信息;(5)冗余度。 重点:离散/连续信源熵和互信息。 难点:离散序列有记忆信源熵。 说明:本章内容主要针对信源,但是很多基本概念却是整个信息论的基础,所以安排了较多课时。由于求熵涉及一些概率论的基础知识,考虑到大四的同学可能对这部分知识已经遗忘,故适当复习部分概率论知识。较难的 2.1.2节马尔可夫信源部分放置在本章最后讲,便于同学理解。本章概念和定理较多,比较抽象,课堂教学时考虑多讲述一些例题,通过例题来巩固概念和消化定理。 作业: 2.1—2.7,2.10,2.12。 课时分配:10课时。 板书及讲解要点: 在信息论中,信源是发出消息的源,信源输出以符号形式出现的具体消息。如果符号是确定的而且预先是知道的,那么该消息就无信息而言。只有当符号的出现是随机的,预先无法确定,一旦出现某个符合就给观察者提供了信息。因此应该用随机变量或随机矢量来表示信源,运用概率论和随机过程的理论来研究信息,这就是香农信息论的基本点。 2.1 信源的描述与分类 在通信系统中收信者在未收到消息以前对信源发出什么消息是不确定的,是随机的,所以可用随机变量、随机序列或随机过程来描述信源输出的消息,或者说用一个样本空间及其概率测度——概率空间来描述信源。 信源:产生随机变量、随机序列和随机过程的源。 信源的基本特性:具有随机不确定性。 信源的分类 离散信源:文字、数据、电报——随机序列 连续信源:话音、图像——随机过程 离散信源:输出在时间和幅度上都是离散分布的消息。

消息数是有限的或可数的,且每次只输出其中一个消息,即两两不相容。 发出单个符号的无记忆信源 离散无记忆信源: 发出符号序列的无记忆信源 离散信源 离散有记忆信源: 发出符号序列的有记忆信源 发出符号序列的马尔可夫信源 概率论基础: 无条件概率,条件概率和联合概率的性质和关系: (1) 非负性 0()()(/)(/)()1i j j i i j i j p x p y p y x p x y p x y ≤≤,,,, (2) 完备性 111 1 11 ()1,()1,(/)1, (/)1,()1 n m n i j i j i j i m m n j i i j j j i p x p y p x y p y x p x y ===========∑∑∑∑∑∑ 1 1 ()(),()()n m i j j i j i i j p x y p y p x y p x ====∑∑ (3) 联合概率 ()()(/)()(/)()()()(/)()(/)() i j i j i j i j i j i j j i j i j i p x y p x p y x p y p x y X Y p x y p x p y p y x p y p x y p x =====当与相互独立时,, (4) 贝叶斯公式 1 1 () () (/)(/)() () i j i j i j j i n m i j i j i j p x y p x y p x y p y x p x y p x y === = ∑∑, 2.1.1 无记忆信源: 例如扔骰子,每次试验结果必然是1~6点中的某一个面朝上。可以用一个离散型随机变量X 来描述这个信源输出的消息。

2015秋.信息论.第2章离散信源与信息熵

第2章离散信源与信息熵 信号 信号+干扰 消息 干扰 消息 信源 编码器 信道 译码器 信宿 噪声源 通信系统模型 信息

2.1 信源的分类和描述 信源是信息的发源地,可以是人、生物、机器或其他事物。信源的输出是包含信息的消息。消息的形式可以是离散的或连续的。 信源输出为连续信号形式(如语音),可用连续随机变量描述。 连续信源←→模拟通信系统 信源输出是离散的消息符号(如书信),可用离散随机变量描述。 离散信源←→数字通信系统

离散信源…X i…X j… 离散无记忆信源:输出符号X i X j 之间相互无影响; 离散有记忆信源:输出符号X i X j 之间彼此依存。 3 离散信源 无记忆 有记忆发出单个符号发出符号序列马尔可夫信源 非马尔可夫信源

y j 将一粒棋子随意地放 在棋盘中的某列; 棋子放置的位置是一 个随机事件; 可看做一个发出单个 符号的离散信源。 x i

1212,,...,(),(),...,()m m x x x X P p x p x p x ????=???????? 就数学意义来讲,信源就是一个概率场,可用概率空间来描述信源。由离散随机变量X 表示棋子位置: 10()1,()1m i i i p x p x =≤≤=∑i x 其中,代表随机事件的某一结果。

2.2离散信源的信息熵信息的可度量性是信息论建立的基础; 香农的信息论用事件发生概率的对数来描述事件的不确定性,得到消息的信息量,建立熵的概念。 2.2.1自信息量 –定义2.1 任意随机事件x i 的自信息量定义为: i i i 1(x )log log (x )(x ) I P P ==-

信源熵习题答案

文档从网络中收集,已重新整理排版.word 版本可编辑.欢迎下载支持. 1word 版本可编辑.欢迎下载支持. 2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍? 解: 四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则: 四进制脉冲的平均信息量symbol bit n X H / 24log log )(1=== 八进制脉冲的平均信息量symbol bit n X H / 38log log )(2=== 二进制脉冲的平均信息量symbol bit n X H / 12log log )(0=== 所以: 四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。 2.2 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量? 解: 设随机变量X 代表女孩子学历 X x 1(是大学生) x 2(不是大学生) P(X) 0.25 0.75 设随机变量Y 代表女孩子身高 Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5 已知:在女大学生中有75%是身高160厘米以上的 即:bit x y p 75.0)/(11= 求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15 .075.025.0log )()/()(log )/(log )/(11111111=?-=-=-= 2.3 一副充分洗乱了的牌(含52张牌),试问 (1) 任一特定排列所给出的信息量是多少? (2) 若从中抽取13张牌,所给出的点数都不相同能得到多少信息量? 解: (1) 52张牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是: (2) 52张牌共有4种花色、13种点数,抽取13张点数不同的牌的概率如下: 2.4 设离散无记忆信源? ?????=====??????8/14/1324/18/310)(4321x x x x X P X ,其发出的信息为(202120130213001203210110321010021032011223210),求 (1) 此消息的自信息量是多少? (2) 此消息中平均每符号携带的信息量是多少? 解: (1) 此消息总共有14个0、13个1、12个2、6个3,因此此消息发出的概率是: 此消息的信息量是:bit p I 811.87log =-=

离散信源题与答案

? ?? ???=====??????8/14/1324/18/310)(4321x x x x X P X 该信源发出的信息序列为(202 120 130 213 001 203 210 110 321 010 021 032 011 223 210)。 求: (1) 此消息的自信息量是多少 (2) 此消息中平均每符号携带的信息量是多少 解: (1) 此消息总共有14个0、13个1、12个2、6个3,因此消息发出的概率是: 6 2514814183?? ? ?????? ?????? ??=p 此消息的信息量是:bit p I 811.87log =-= (2) 此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/== 某一无记忆信源的符号集为{0, 1},已知信源的概率空间为 ???? ??=??????4/34/110 )(X P X (1) 求信息符号的平均熵; (2) 由100个符号构成的序列,求某一特定序列(例如有m 个“0”和(100 - m )个“1”)的自信息量的表达式; (3) 计算(2)中序列的熵。 解: (1) bit x p x p X H i i i 811.043log 4341log 41 )(log )()(=??? ??+-=-=∑ (2) bit m x p x I x p m i i m m m i 585.15.414 3 log )(log )(4 34341)(100 100100 100100+=-=-==? ? ? ?????? ??=--- (3) bit X H X H 1.81811.0100)(100)(100=?== 某信源的消息符号集的概率分布和二进制代码如题表所列。 题表

离散信源题与答案

设有一离散无记忆信源,其概率空间为 ??? ? ??=====??????8/14/1324/18/310)(4321x x x x X P X 该信源发出的信息序列为(202 120 130 213 001 203 210 110 321 010 021 032 011 223 210)。 求: (1) 此消息的自信息量是多少? (2) 此消息中平均每符号携带的信息量是多少? 解: (1) 此消息总共有14个0、13个1、12个2、6个3,因此消息发出的概率是: 6 2514814183?? ? ?????? ?????? ??=p 此消息的信息量是:bit p I 811.87log =-= (2) 此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/== 某一无记忆信源的符号集为{0, 1},已知信源的概率空间为 ???? ??=??????4/34/110 )(X P X (1) 求信息符号的平均熵; (2) 由100个符号构成的序列,求某一特定序列(例如有m 个“0”和(100 - m )个“1”)的自信息量的表达式; (3) 计算(2)中序列的熵。 解: (1) bit x p x p X H i i i 811.043log 4341log 41 )(log )()(=??? ??+-=-=∑ (2) bit m x p x I x p m i i m m m i 585.15.4143 log )(log )(4 34341)(100 100100 100100+=-=-==? ? ? ?????? ??=--- (3) bit X H X H 1.81811.0100)(100)(100=?== 某信源的消息符号集的概率分布和二进制代码如题表所列。 题表

英语信源汉语信源信息熵的研究

英语信源、汉语信源及其信息熵的研究 摘要 英语信源和汉语信源是两种不同的自然语信源,而信息熵反映了信源的记忆长度,信源的记忆长度越长,熵就越小。只有当记忆长度为0,即信源符号间彼此没有任何依赖关系且等概率分布时,信源熵达到最大值。也就是说,信源符号相关性越强,所提供的平均信息量就越小。所以,研究这两种信源的信息熵,就可以得出每种信源中符号的相关性,和提供的平均信息量,量化的来比较两种语言。 关键词 英语信源 汉语信源 信息熵 正文 一、英语信源及其信息熵 英语字母有26个,加上空格,共27个符号。根据熵的性质,信源的最大熵 02log 27 4.76(/)H bit symbol == 但实际上,英语中的字母并非等概率出现,字母之间还有严格的依赖关系。如果我们对英语书中27个符号出现的概率加以统计,可得: 27个英语字符出现的概率 符号 概率 符号 概率 符号 概率 空格 0.2 S 0.052 Y,M 0.012 E 0.105 H 0.047 G 0.011 T 0.072 D 0.035 B 0.0105 O 0.0654 L 0.029 V 0.008 A 0.063 C 0.023 K 0.003 N 0.059 F,U 0.0225 X 0.002

I 0.055 M 0.021 J,Q 0.001 R 0.054 P 0.0175 Z 0.001 如果不考虑上述符号之间的依赖关系,即近似地认为信源是离散无记忆信源,根据离散上的定义可得 27121()log () 4.03(/) i i i H p a p a bit symbol ==-=∑ 按上述表格中的概率分布,随机选择英语字母排列起来,得到一个信源输出序列: AI_NGAE_ITE_NNR_ASAEV_OTE_BAINTHA_HYROO_POER_SE TRYGAIETRWCO … 可见,这些字母完全是随机排列,毫无相关性,却不是英语单词,所以我们应该考虑字母的依赖性。 为了进一步逼近实际情况,可把婴语信源近似地看作1阶,2阶,…,∞阶马尔可夫信源,求得相应的熵 2 3.32(/)H bit symbol = 3 3.1(/)H bit symbol = 异推出,马尔可夫信源阶数越高,输出的序列越接近实际情况。当依赖关系延伸到无穷远时,信源输出就是真正的英语。所以我们求马尔可夫信源的极限熵 1.4(/)H bit symbol ∞= 二、汉语信源及其信息熵

第四章 信源编码 习题解答

第四章信源编码习题解答 1、一个信源由: 1) 2)分别计算每个唯一可译码得平均码长与编码效率。 解:1)A、B、C、D、E、F就是非奇异码。A、B、C、F就是唯一可译码(E不满足克拉夫特不等式)。A、C、F就是即时码(B就是续长码)。 3)编码A: 平均码长: 信源熵:比特/消息 编码效率: 编码B与C: 平均码长: 111111 23456 2.125 2416161616 B C L L ==+?+?+?+?+?=码元/消息 编码效率: 编码F: 平均码长: 编码效率: 2、离散无记忆信源X得概率空间为: 1)对其进行费诺编码,并计算其编码效率; 2)对其进行哈夫曼编码,并将其编码效率与费诺编码相比较。解:1)费诺编码:

平均码长:()()()0.20.1720.190.180.1530.10.014 2.74L =+?+++?++?=码元/符号 信源熵: ()0.20lb0.200.19lb0.190.18lb0.180.17lb0.170.15lb0.150.1lb0.10.01lb0.01 2.60/874H X =-------= 比特符号 编码后平均码元熵:比特/码元 编码效率: 2)哈夫曼编码: 码长 码字 信源X p (X ) 2 10 x 1 0、20 2 11 x 2 0、19 3 000 x 3 0、18 3 001 x 4 0、17 3 010 x 5 0、15 4 0110 x 6 0、10 4 0111 x 7 0、01 平均码长:()()()0.20.1920.180.170.1530.10.014 2.72L =+?+++?++?=码元/符号 编码后平均码元熵:比特/码元 编码效率: 与费诺编码相比,哈夫曼编码得编码效率要高于费诺编码。 一般情况下哈夫曼编码效率较高,但费诺编码如果每次划分概率很接近,则效率也很高。 3、离散无记忆信源X 得概率空间为: 1)对其进行费诺编码; 2)对其进行哈夫曼编码。 解:1)费诺编码:

英语信源汉语信源信息熵的研究

英语信源、汉语信源及其信息熵的研究 摘要英语信源和汉语信源是两种不同的自然语信源,而信息熵反映了信源的记忆长度,信源的记忆长度越长,熵就越小。只有当记忆长度为0,即信源符号间彼此没有任何依赖关系且等概率分布时,信源 符号概率符号概率符号概率 空格0.2 S 0.052 Y,M 0.012 E 0.105 H 0.047 G 0.011 T 0.072 D 0.035 B 0.0105 O 0.0654 L 0.029 V 0.008 0.023 K 0.003 A 0.063 C N 0.059 F,U 0.0225 X 0.002 I 0.055 M 0.021 J,Q 0.001

R 0.054 P 0.0175 Z 0.001 如果不考虑上述符号之间的依赖关系,即近似地认为信源是离散无记忆信源,根据离散上的定义可得 27121()log () 4.03(/) i i i H p a p a bit symbol ==-=∑ 1.4(/)H bit symbol ∞= 二、汉语信源及其信息熵 对于英语,字符数少,可轻松的计算出英语信源的信息熵,但是对于汉语这个中文字符极其庞大的信源,科学家们做出了大量的统计

与计算。方法同上面的英语信源信息熵的计算,不过计算量增加了非常多。下面是截取的一些统计资料。 CCL 语料库-现代汉语总字频数:307,317,060 总字种数:9711 字频表: 的:11523375 一:4140344 是:3291508 了:3059837 在:2933070 人:2827726 不:2733842 国:2645758 有:2507415 中:2182025 他:2029395 这:1968713 我:1940875 和:1872750 大:1832977 (ZIPF'S LAW)核算,汉字的容量极限是12366个汉字,汉字的平均信息量是9.65比特 三、英语信源和汉语信源的比较 显而易见,汉语信源的信源熵远远大于英语信源的信息熵,说明

信源及信源熵习题答案

· 1 · 第二章: 2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍? 解: 四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则: 四进制脉冲的平均信息量H(X 1) = log 2n = log 24 = 2 bit/symbol 八进制脉冲的平均信息量H(X 2) = log 2n = log 28 = 3 bit/symbol 二进制脉冲的平均信息量H(X 0) = log 2n = log 22 = 1 bit/symbol 所以: 四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。 2.2 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量? 解: 设随机变量X 代表女孩子学历 X x 1(是大学生) x 2(不是大学生) P(X) 0.25 0.75 设随机变量Y 代表女孩子身高 Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5 已知:在女大学生中有75%是身高160厘米以上的 即:p(y 1/ x 1) = 0.75 求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15.075.025.0log )()/()(log )/(log )/(2111121111=??? ???-=? ? ????-=-= 2.3 一副充分洗乱了的牌(含52张牌),试问 (1) 任一特定排列所给出的信息量是多少? (2) 若从中抽取13张牌,所给出的点数都不相同能得到多少信息量? 解: (1) 52张牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是: bit x p x I i i 581.225!52log )(log )(2==-= (2) 52张牌共有4种花色、13种点数,抽取13张点数不同的牌的概率如下: bit C x p x I C x p i i i 208.134 log )(log )(4)(1352 13 2 213 52 13=-=-==

汉语信源与英语信源及其信息熵的研究

汉语信源、英语信源及其信息熵的研究 【摘要】本文主要搜集资料,对目前在信息熵领域内对于汉语、英语这两大主流语言的信源进行信息熵研究的资料进行了阅读和整合,给出了基本研究方法及目前比较权威的几种语言的信息熵。 【关键字】信息熵 【正文】汉语信息产业基础建设的中心课题,就是要利用信息熵的基本原理和方法来提高中文的效率。 美国的信息产业能有今天的称雄世界的实力,能接连不断地产生新的技术产品,是跟坚实的基础建设分不开的。这个基础建设的基本依据,是信息科学技术的基本原理和方法:信息熵(ENTROPY )。 第二次世界大战期间,美国为了提高信息储存和传递的效率,发明了多种新的编码方法,奠定了现代信息科学技术的基础。战争结束后,这些方法得到了飞跃发展。在这些方法当中,科学家香农和霍夫曼提出的信息熵和数据压缩的理论和方法最能代表现代信息学的基本概念。个人计算机和BBS 问世以后,信息熵和数据压缩技术迅速普及。现在,这种技术已经成为计算机和联网必不可少的组成部份。 信息熵的基本目的,是找出某种符号系统的信息量和多余度之间的关系,以便能用最小的成本和消耗来实现最高效率的数据储存、管理和传递。 从信息论的角度考虑, 自然语言理解可以看作是利用所获得信息消除句子中文字的不确定性过程. 统计语言模型是对自然语言的一种近似描述, 它是自然语言理解的核心. 应用语言模型就可以帮助人们实现对句子中所出现的语言成分的预测, 消除自然语言理解过程中的不确定性. 不同的语言模型其预测或者说消除不确定性的能力不同. 预测能力强的模型是人们所期望的, 因此, 对语言模型性能的评价就成了语言建模的一个很重要问题, 它能够指导人们建立更为有效的语言模型. 针对各种语言模型建立有效的评价指标, 是一个比较复杂和困难的问题, 目前还没有一个好的解决办法.不过从信息熵的角度对统计语言模型的复杂度度量方法进行定量化的推理与描述,可以得到一些有意义的结论. 从信息论角度考虑, 一种语言或其子集可以看作离散信源. 如果所考虑的语言的字符集V 的大小为V , 语言中的语句由这些字符任意构成, 各字符的出现与上下文无关, 且出现的概率相等, 则在某一时刻出现某一字符的随机试验结局就有V 种可能. 按照信息论中的编码理论, 要区别每个字符就需要log 2..V..比特的信息. 也就是说, 每个字符所含的信息量为log 2V , 记为H0.但实际的自然语言中, 语句中各语言符号的出现概率不可能相等. 若暂不考虑上下文相关性, 假设第i( i= 1, 2, ., V) 个字符出现的概率为Pi , 则信源输出的各字符的平均信息量为: H= - Pi log 2Pi V i=1 (1) 信息论中将式( 1) 称为熵. 熵表示了消息出现的不确定性的大小, 表现在

信源及信源熵习题问题详解

第二章: 2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍? 解: 四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则: 四进制脉冲的平均信息量H(X 1) = log 2n = log 24 = 2 bit/symbol 八进制脉冲的平均信息量H(X 2) = log 2n = log 28 = 3 bit/symbol 二进制脉冲的平均信息量H(X 0) = log 2n = log 22 = 1 bit/symbol 所以: 四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。 2.2 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量? 解: 设随机变量X 代表女孩子学历 X x 1(是大学生) x 2(不是大学生) P(X) 0.25 0.75 设随机变量Y 代表女孩子身高 Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y) 0.5 0.5 已知:在女大学生中有75%是身高160厘米以上的 即:p(y 1/ x 1) = 0.75 求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15.075.025.0log )()/()(log )/(log )/(2111121111=??? ???-=? ? ????-=-= 2.3 一副充分洗乱了的牌(含52牌),试问 (1) 任一特定排列所给出的信息量是多少? (2) 若从中抽取13牌,所给出的点数都不相同能得到多少信息量? 解: (1) 52牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是: bit x p x I i i 581.225!52log )(log )(2==-= (2) 52牌共有4种花色、13种点数,抽取13点数不同的牌的概率如下: bit C x p x I C x p i i i 208.134 log )(log )(4)(1352 13 2 213 52 13 =-=-==