aix创建文件系统

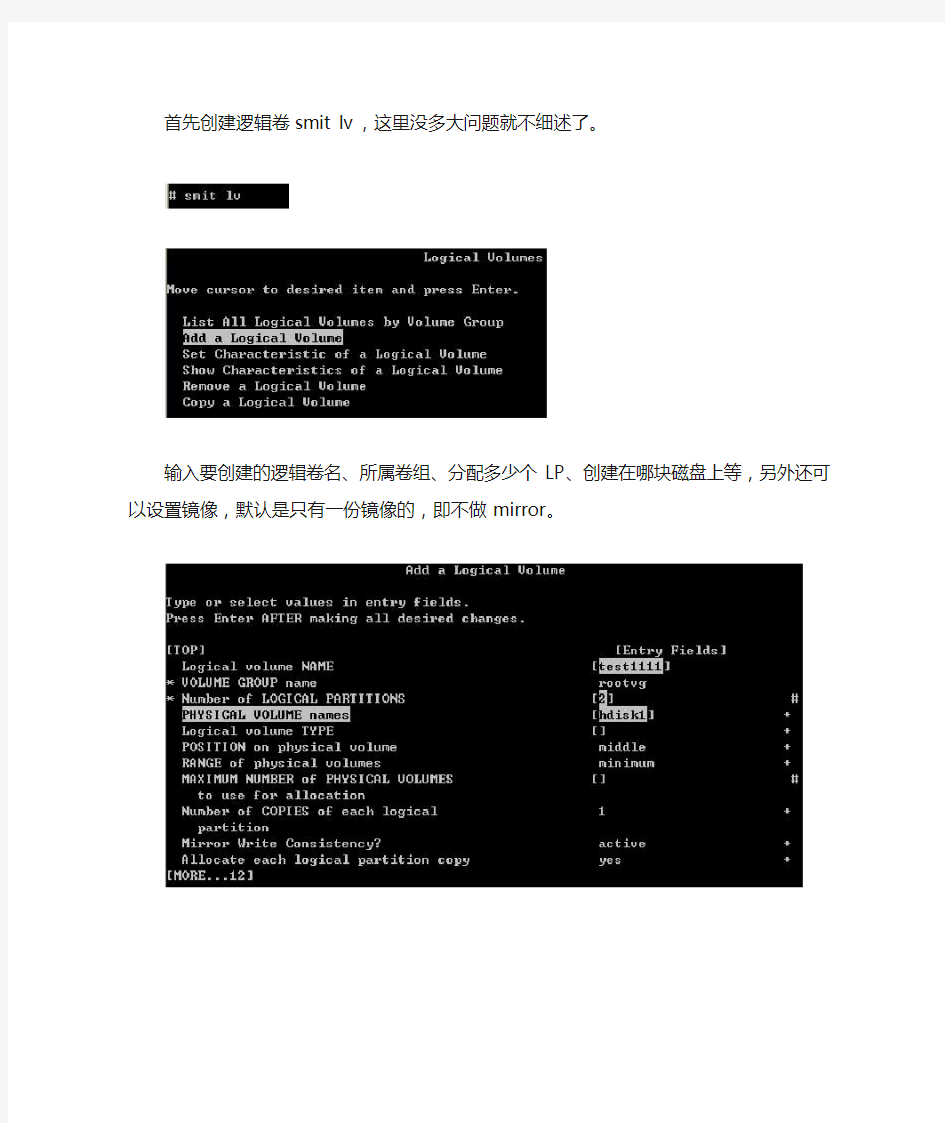

首先创建逻辑卷smit lv,这里没多大问题就不细述了。

输入要创建的逻辑卷名、所属卷组、分配多少个LP、创建在哪块磁盘上等,另外还可以设置镜像,默认是只有一份镜像的,即不做mirror。

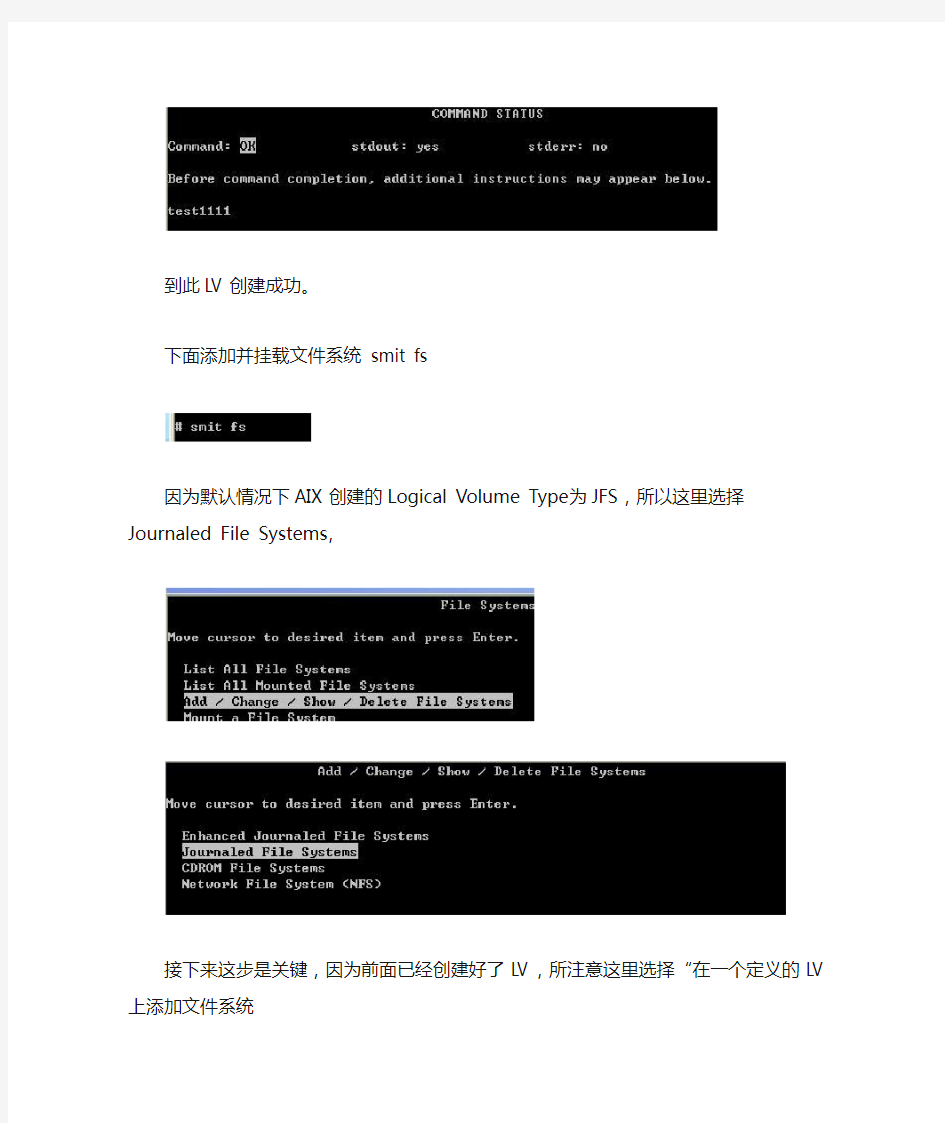

到此LV创建成功。

下面添加并挂载文件系统smit fs

因为默认情况下AIX创建的Logical Volume Type为JFS,所以这里选择

Journaled File Systems,

接下来这步是关键,因为前面已经创建好了LV,所注意这里选择“在一个定义的LV上添加文件系统(Add a Journaled File system on a Previously Defined Logical Volume)”,

这里选择要创建的文件系统类型,选择标准文件系统

接下来可以按Esc+4选择或者手工输入前面创建的逻辑卷名test1111,本例中我用选择的(这样可以避免手工输入出错)

输入挂载点,这里我挂载到/home/test1111上;系统重启时自动挂载,选择yes,还有其他的选项根据需要相应设置。

回车运行

这样文件系统就添加完成了,下面查看挂载情况。

df-k可以查看当前已挂载的文件系统磁盘空间使用情况,当然这里使用不加任何参数的mount命令也是可以的,输出显示test1111当前未挂载。

查看设备ls/dev/test*

挂载文件系统,AIX下的挂载命令跟Linux下一样,都是使用mount命令。

再次查看文件系统当前的挂载情况,验证挂载是否成功。

输出显示/dev/test1111已成功挂载到/home/test1111,至此,创建逻辑卷、添加文件系统以及文件系统挂载都结束了。

如何解决AIX的文件系统故障

如何解决AIX的文件系统故障 在进行文件系统维护和管理过程中,会碰到这样一些问题,例如无法安装文件系统或者无法拆卸文件系统,当文件系统的超级块被破坏,而无法正常使用文件系统,如何修复r ootvg中的主要文件系统,下面就讨论如何解决一些常见的文件系统问题。 一、恢复超级块错误 有些用户在使用fsck或mount命令时,当见到下面的提示信息时,可能是文件系统的超级块出了问题:fsck: Not an AIX3 file system fsck: Not an AIXV3 file system fsck: Not an AIX4 file system fsck: Not an AIXV4 file system fsck: Not a recognized file system type mount: invalid argument 例如,当用户安装一个/allenfs文件系统时,出现下面的错误提示:#mount /allenfs mount: 0506-324 Cannot mount /dev/lv1 on /allenfs: A system call received a para meter that is not valid. 修复该文件系统时,出现下面错误提示,并异常终止:#fsck /dev/lv1 Not a recognized filesystem type. (TERMINATED) 要解决这个问题,只能用备份的超级块来恢复主超级块,我们都知道,在文件系统中,1号逻辑块是主超级块,31号逻辑块是备份超级块,因此就把31号逻辑块上的内容写到1号逻辑块上去。 例如文件系统对应的逻辑卷为/dev/lv1,则恢复该文件系统的超级块命令如下: #dd count=1 bs=4k skip=31 seek=1 if=/dev/lv1 of=/dev/lv1 当恢复完成,就要用fsck命令来检查文件系统的完整性: #fsck /dev/lv1 ** Checking /dev/rlv1 (/allen) ** Phase 0 - Check Log log redo processing for /dev/rlv00 ** Phase 1 - Check Blocks and Sizes ** Phase 2 - Check Pathnames ** Phase 3 - Check Connectivity ** Phase 4 - Check Reference Counts ** Phase 5 - Check Inode Map

几种Nand flash文件系统的对比

几种Nand flas文件系统的对比 1.来源:NLE-FFS: A Flash File System with PRAM for Non-linear Editing For thesedevices, NAND flash memory has became the most attractive storage medium due to outstanding characteristics such as its increased capacity, low power consumption, small size and light weight. For the efficient management of NAND flashmemory, several flash file systems have been proposed, including JFFS2, YAFFS2, CFFS and PFFS. several file systems such as MNFS,NAMU and ScaleFFS have been designed for real-time recording /playback and large-capacity storage. A. YAFFS2 YAFFS2 is the most widely employed file system for NAND flash memory. YAFFS2 essentially saves the object ID (file ID) and the chunk (page) number in the spare region to show the offset of a page and the owner file of the page. Therefore, YAFFS2 reads the spare regions and object headers to establish the metadata in memory. Although YAFFS2 is designed to support NAND flash memory, it has scalability problems. With YAFFS2, the location of the updated page is saved in NAND flash pages or spare regions, as shown in Fig. 10 (a); hence, the file system

AIX 里面dump文件系统扩充

在errpt中出现E87EF1BE的dump不够的报错 在errpt中出现 E87EF1BE 0926082807 P O dumpcheck The largest dump device is too small. 信息.断定为存放dump文件的lg_dumplv容量不够.一般推荐的dump device 值大小为sysdumpdev –e 估计值的1.5 倍。 需要扩容.扩容步骤如下: 1.查看lg_dumplv大小的估计值 #sysdumpdev -e 0453-041 Estimated dump size in bytes: 1287651328 即1.2G 2.现在lg_dumplv大小 #lslv lg_dumplv 其中PP SIZE: 256 megabyte(s) PPs: 4 经计算,现在容量为1G.需要扩容0.2G 3.查看lg_dumplv所在的vg的容量是否够用 #lsvg rootvg 其中PP SIZE: 256 megabyte(s) TOTAL PPs: 1092 (279552 megabytes) FREE PPs: 826 (211456 megabytes) 经计算,vg剩余容量为206.5G,因为根盘做了镜像.故,可用剩余容量为103G左右.因pp size为256m,故扩容2pps,即0.5G(其实扩1个pp也可以.2个放心点.) 4.扩容操作 extendlv lg_dumplv 2 5.检查当前lg_dumplv的大小. #lslv lg_dumplv 其中PP SIZE: 256 megabyte(s) PPs: 6 即,现在容量为1.5G. 6.使用dumpcheck命令查看,是否还出现errpt信息

AIX卷组下文件系统在线扩容

一台AIX小机因生产需要对/sapdata目录进行扩容,由原来的90G扩容到210G,增加120G 的空间.AIX小机后端通过光纤交换机连的EMC存储。首先在EMC存储上把空闲的硬盘做RAID,划分LUN,映射到生产AIX小机。 EMC划完LUN映射完后,在AIX小机上执行cfgmgr ,然后lspv看是否认到新扩容的硬盘. # cfgmgr -i disk # lspv hdisk0 00c6abdfc094f4e8 rootvg active hdisk1 00c6abcfc4edbd87 rootvg active hdisk6 oravg active hdisk7 oravg active 注意HDISK后的16位数字,如果没有请执行 #chdev –l hdisk6 –a pv=yes (以使物理卷为LVM所用)。 #chdev –l hdisk7 –a pv=yes (以使物理卷为LVM所用)。 #lspv hdisk0 00c6abdfc094f4e8 rootvg active hdisk1 00c6abcfc4edbd87 rootvg active hdisk6 00c6abcf1d17f7bf oravg active hdisk7 00c6abcf1d189c64 oravg active (如果是HA架构,在A节点上识别到后执行#rmdev –Rd1 hdisk6然后在B节点上cfgmgr扫再认)--检查两节点LSPV是否一致和HDISK是否一致。 原文件目录大小 #df -g /dev/sapdata 90.00 84.80 94% 26 1% /oracle/sapdata 然后执行smitty hacmp--- System Management (C-SPOC)-- HACMP Logical Volume Management--- Shared Volume Groups-- Set Characteristics of a Shared Volume Group-- Add a Volume to a Shared Volume Group--选择需要扩容的VG--回车,然后选择添加的硬盘---确定。然后进行扩容文件系统。#smitty chfs—change/show charactertistics of an enhanced journaled file system—选择要扩的文件系统—然后回车继续. 如果文件系统扩容出错,一般是文件系统的Block size或卷的LV原大小限制了最大扩容空间,可以# smitty hacmp--- System Management (C-SPOC)-- HACMP Logical Volume Management--- Shared file systems---enhanced journaled file systems---change/show characteristics of a shared enhanced journaled file system—选择文件系统来修改块大小,之后就可以成功扩文件系统。注:修改LV的大小,可以通过#smitty chlv来进行。 原参数: Type or select values in entry fields. Press Enter AFTER making all desired changes. [Entry Fields] File system name /oracle/sapdata NEW mount point [/oracle/sapdata] SIZE of file system Unit Size 512bytes +

NFS文件系统简介及原理

NFS文件系统简介及原理 什么是文件系统,NFS文件系统又是什么?简单的说,文件系统就是通过软件对磁盘上的数据进行组织和管理的一种机制,对其的一种封装或透视。NFS,Network File System。顾名思义,网络文件系统,即通过网络,对在不同主机上的文件进行共享。 为什么需要使用NFS呢?在生产环境,我们很少使用单机部署应用,因为单机存在单点故 障,一旦宕机,将无法为前端业务提供服务,这是客户无法容忍的。现在提倡的高可用及7*24服务,是我们追求的目标。对于一些小的应用,双机成为了主流。我们来看一种简单集群场景,应用分别部署在A及B上,前端通过F5或着web服务器访问应用。如下 图: 那么当客户端发出一个请求时,F5根据一定的机制进行转发,有可能有A服务器进行响应,也有可能由B服务器进行响应。而在web应用中上传一些静态文件是很常见的一种功能,如图片。假设用户在某一时间,上传了一张照片到A服务器上,那么下次访问时,被F5路由到了B服务器上,由于B服务器上并没有存储上传的照片,所以将造成用户无法看到自己上传的照片。 那么很容易想到,是不是可以把文件上传到一个公用的服务器上呢?这样不管访问的是A

还是B,读、取文件都只存在一份。答案是肯定的,这个公用的服务器我们也称之为文件服务器。上面的架构就演变成了下面的架构: 说了这么多,跟NFS又有什么关系呢?NFS提供了一种机制,可以让A、B访问C中的一个共享目录,就像是操作本地文件一样。既然NFS有这么牛逼的能力,又有什么原因不去深入了解一下呢?注:此处当然也可以通过sftp或ftp进行文件上传和下载。 NFS的原理:我们用一个图来进行说明: 首先:NFS包括两部分,服务端及客户端 由于NFS服务功能很多,会有很多端口,这些端口还有可能不固定,那么客户端就无法与服务器进行通信,因为程序间通信必须通过端口(tcp/udp都是端到端通信),那么就需要一个

NFS-网络文件系统实现资源共享

NFS -网络文件系统实现资源共享 NFS 会经常用到,用于在网络上共享存储。假如有三台机器 netbook 、myhost1、myhost2,它们需要访问同一个目录,目录中都是图片,传统的做法是把这些图片分别放到netbook 、myhost1、myhost2。但是使用NFS 只需要放到netbook 上的一个目录中(如:/root/netbook ),然后共享给myhost1、myhost2即可。访问的时候,metbook 主机的用户直接访问/root/netbook 目录即可,而主机myhost1、myhost2则可以通过网络间接地访问该目录的。实现方式如下: 一、为三台主机配置网络信息(以提供照片共享的主机为例) 1.分别修改各主机的IP 地址 [root @localhonst ~]#vi /etc/sysconfig/network -scripts/ifcfg-eth0 2.分别修改各主机的机器名 [root @localhonst ~]#vi /etc/sysconfig/network 3.分别修改各主机的本机路由信息 [root @localhonst ~]#vi /etc/hosts 4.重启计算机,以使配置生效 [root @localhonst ~]#init 6 二、配置NFS 服务器 1.启动系统的NFS 服务功能 方法一: [root @netbook ~]#service nfs start 方法二: [root @netbook ~]# /etc/init.d/nfs start

方法三: [root @netbook ~]#rfsysv NFS 服务需要portmap 服务的支持,在启动NFS 之前,需要启动portmap ,否则将会出现如下的提示。 启动portmap : [root @netbook ~]#service portmap start “”如果允许任何访问用户具有读写权限,则exports 文件的内容可配置为:

AIX文件系统讲解

目录 第1章认识AIX文件系统 (1) 1.1 文件系统类型 (1) 1.2 日志文件系统-原理篇(必读) (1) 1.2.1 日志型文件系统JFS Journaled File System (2) 1.2.2 增强型日值文件系统jfs2 (7) 第2章创建文件系统 (7) 2.1 smitty crfs 创建文件系统(具体的参数解释可以参考命令行) (7) 2.2 命令行方式创建文件系统 (7) 2.2.1 语法 (7) 2.2.2 描述 (8) 第3章维护文件系统 (13) 3.1安装、卸载文件系统 (13) 3.1.1 smitty mount 安装文件系统 (13) 3.1.2 命令行方式下安装卸载文件系统 (13) 3.2 删除文件系统 (14) 3.3 改变文件系统大小 (15) 3.3.1 smitty chjfs 方式改变文件系统 (15) 3.3.2 命令行方式改变文件系统 (15) 3.4 fsck校验文件系统 (16) 3.5 df、du文件系统空间维护 (17) 3.5.1 df命令 (17) 3.5.2 du命令 (17) 3.6 整理文件系统碎片 (18) 3.6.1 命令行方式整理文件系统碎块 (18) 3.7 AIX文件系统常见故障诊断与维护 (18)

3.7.1 超级块故障诊断与恢复 (19) 3.7.2 df du 显示结果不一致诊断 (19) 3.7.3 重建jfslog日志文件系统 (20) 3.7.4 无法建立或删除文件系统的诊断与恢复 (20) 3.7.5 无法卸载文件系统的诊断与恢复 (21)

关键词: 文件系统JFS AIX 摘要: 缩略语清单: 参考资料清单:

网络文件系统

网络文件系统 网络文件系统,英文Network File System(NFS)。是由SUN公司研制的UNIX表示层协议(pressentation layer protocol),能使使用者访问网络上别处的文件就像在使用自己的计算机一样。NFS是基于UDP/IP协议的应用,其实现主要是采用远程过程调用RPC机制,RPC提供了一组与机器、操作系统以及低层传送协议无关的存取远程文件的操作。RPC采用了XDR的支持。XDR是一种与机器无关的数据描述编码的协议,他以独立与任意机器体系结构的格式对网上传送的数据进行编码和解码,支持在异构系统之间数据的传送。 ①提供透明文件访问以及文件传输; ②容易扩充新的资源或软件,不需要改变现有的工作环境; ③高性能,可灵活配置。 [1]网络文件系统(NFS)是文件系统之上的一个网络抽象,来允许远程客户端以与本地文件系统类似的方式,来通过网络进行访问。虽然NFS 不是第一个此类系统,但是它已经发展并演变成UNⅨ? 系统中最强大最广泛使用的网络文件系统。NFS 允许在多个用户之间共享公共文件系统,并提供数据集中的优势,来最小化所需的存储空间。 NFS与以往一样有用并在不断演变 网络文件系统(NFS)从1984 年问世以来持续演变,并已成为分布式文件系统的基础。当前,NFS(通过pNFS 扩展)通过网络对分布的文件提供可扩展的访问。探索分布式文件系背后的理念,特别是,最近NFS 文件进展。 NFS 的简短历史 第一个网络文件系统—称为File Access Listener —由Digital Equipment Corporation(DEC)在1976 年开发。Data Access Protocol(DAP)的实施,这是DECnet 协议集的一部分。比如TCP/IP,DEC 为其网络协议发布了协议规范,包括DAP。 NFS 是第一个现代网络文件系统(构建于IP 协议之上)。在20 世纪80 年代,它首先作为实验文件系统,由Sun Microsystems 在内部完成开发。NFS 协议已归档

AIX系统管理手册

索引 1 命令索引 2 存储管理 2.1 概述 AIX下磁盘首先是一个物理卷(PV),几个物理卷组成一个巻组(VG)。 定义巻组过程中,需要指定分区大小(PP),这个尺寸用于逻辑卷(LV)的定义。 Fget_config –Av

2.2 物理卷定义(PV) 系统扫描到磁盘以后,首先给他增加一个pvid,使其变成PV,命令如下: Chdev –l hdisk7 –a pv=yes 删除pvid,命令如下: Chdev –l hdisk7 –a pv=clear 查看物理卷的详细信息,使用lspv命令。 2.3 巻组定义(VG) 使用lsvg –l查看巻组的详细信息,包括此巻组分成了几个逻辑卷,这几个逻辑卷又挂载在那个文件系统上。 创建一个卷组使用mkvg命令。 Extendvg:将一个物理卷添加到已有卷中。 Chvg:更改卷组属性。 Reducevg:删除或者导出一个物理卷。 Lsvg列出vg列表。 2.4 逻辑卷定义(LV) 使用lslv查看逻辑卷的详细定义。 Mklv:创建一个逻辑卷。 Chlv:修改一个逻辑卷的名称或者特征。 Extendlv:增加逻辑卷分配的逻辑分区的数据。 Cplv:复制逻辑卷。

Rmlv:除去逻辑卷。 Mklvcopy:增加逻辑卷的副本数目,用于逻辑卷镜像。 Rmlvcopy:减少逻辑卷的副本数目,用于删除逻辑卷镜像。 Crfs:为逻辑卷创建一个文件系统。 2.5 交换空间(PS) Mkps:创建新的页面空间。 Chps:修改页面空间属性。 Lsps –a:显示页面空间列表。 Rmps:移除页面空间。 Swapon,swapoff:激活或者禁用页面空间。 2.6 文件系统命令 Backup、restore:备份和还原。 Chfs:修改jfs文件属性,例如,为文件系统扩容。 Dd:将数据从一个存储设备直接复制到另一个存储设备。 Df:获得文件已使用空间大小。 Fsck:检查文件系统的一致性,并修复。 Crfs:在卷组上直接创建文件系统。 Mkfs:在逻辑卷上创建文件系统。 Rmfs:删除一个文件系统。 Lsfs:显示一个文件系统属性。

Windows下NFS Server搭建和使用

Windows下NFS Server搭建和使用 Revision History 1.NFS简介 NFS是Network File System的简写,即网络文件系统。NFS允许一个系统在网络上与他人共享目录和文件。通过使用NFS,用户和程序可以像访问本地文件一样访问远端系统上的文件。NFS就是一种Linux系统或Unix系统下的共享文件服务,类似于windows共享。NFS 服务器可以看作是一个文件服务器,它可以让你的PC通过网络将远端的NFS 服务器共享出来的文件挂载到自己的系统中,在客户端看来使用NFS的远端文件就象是在使用本地文件一样。 2.NFS测试所需设备和条件 Windows2008 PC1台作为NFS server Windows2008系统光盘 Windows7 PC1台作为NFS Client 3.NFS Server搭建 用装有Windows2008系统的PC作为NFS server 3.1安装NFS Server 1)插入Windows2008系统光盘,点击开始->管理工具->服务器管理器,在左边的树中选中” 功能”项,右边的窗口中会列出功能的详细信息,点击”添加功能”,如图1所示

图1 2)进入添加功能向导窗口,远程服务器管理工具->文件服务工具->勾选网络文件系统服务 工具,如图2所示,点击下一步

图2 3)点击安装,开始安装,如图3~4所示 图3

图4 4)安装完成后,点击关闭,如图5所示 图5

5)添加角色服务,在服务器管理器的左边的树中选中”角色”, 右边会列出角色的详细信息, 点击”添加角色”,如图6所示 图6 6)进入添加角色向导,点击下一步,如图7所示 图7

IBM AIX文件系统和lv块的修复步骤

您须尝试修复这个lv ,看是否能吃修复,请您按照下面步骤操作,由于是corruption 问题,数据完整性不能完全保证: 1> 使用系统安装光盘引导系统, 按以下顺序启动到维护模式。 将系统安装光盘放入到光驱,开机后按键盘"1"进入SMS模式。 --------------------------------------------------------- Main Menu 1. Select Language 2. Setup Remote IPL (Initial Program Load) 3. Change SCSI Settings 4. Select Console 5. Select Boot Options 6. Firmware Boot Side Options --------------------------------------------------------- ---> 选择"5". . --------------------------------------------------------- Multiboot 1. Select Install/Boot Device 2. Configure Boot Device Order 3. Multiboot Startup

在文件系统中使用 NFSv4 ACL

在文件系统中使用 NFSv4 ACL 管理 NFSv4 ACL 级别: 中级 Samyak Jain , 高级软件工程师, IBM 2009 年 7 月 15 日 在不同的文件系统上使用不同的命令管理 NFSv4 ACL 可能很困难。本文讨论并对比的命令可能你在对不同的文件系统操作时会用到。 使用 NFSv4 ACL 的文件系统 NFSv4 (Network File System – Version 4) 协议引入了一种新的 ACL (访问控制列表)格式,这种格式扩展了现有的其他 ACL 格式。NFSv4 ACL 很容易使用,还引入了更详细的文件安全属性,因此 NFSv4 ACL 更安全。IBM? AIX?、Sun Solaris 和 Linux? 等操作系统已经在文件系统中实现了 NFSv4 ACL 。 当前,IBM AIX 5L version 5.3 和更高版本中支持 NFSv4 ACL 的文件系统是 NFSv4、JFS2 with EAv2 (Extended Journaled Filesystem with Extended Attributes format version 2) 和 General Parallel Filesystem (GPFS)。在 Sun Solaris 中,ZFS 支持这种 ACL 模型。在 RedHat Linux 中,NFSv4 支持 NFSv4 ACL 。 什么是 ACL ? 访问控制列表 (ACL) 用来指定文件系统对象(比如文件和目录)的访问权限。它是由许多访问控制项 (ACE) 组成的列表,每个访问控制项定义一个用户或组及其权限。

nfs起根文件系统

1为什么要制作nfs起根文件系统 制作用于mini2440开发板使用的内核,并使用nfs起根文件系统。 2应用arm平台的linux2.6.29内核。 首先清理内核中间文件,配置文件 命令#cd /home/guoqian/4-3-1 #cd linux-2.6.29 #make distclean 3选择参考配置文件 为了使制作的内核支持nfs起根文件系统,选择config-mini2440作为配置文件。 修改配置文件CMDLINE,修改代码如下: ******************************************************************************* CMDLINE=”root=/dev/nfs nfsroot=192.168.14.2:/nfsroot/rootfs ip=192.168.1.55 rw console=ttySAC0 mem=64M” ******************************************************************************* 解释:CMDLINE:命令行启动参数定义了内核挂载根文件系统的方式 (1)root=/dev/nfs →表示内核采用nfs方式起根文件系统 (2)nfsroot=192.168.14.2:/nfsroot/rootfs →表示nfs起的根文件系统位于nfs服务器/nfsroot/rootfs目录,服务器IP地址为192.168.14.2 (3)ip=192.168.1.55 →开发板IP地址,要求与服务器IP地址在同一网段 (4)rw →文件系统可读可写 (5)console=ttySAC0 mem=64M →ttySAC0作为控制台,内存64M 4配置内核

AIX移动文件系统到一个新的卷组

移动一个JFS 或 JFS-2 文件系统到一个新的卷组 移动文件系统 注意:在进行下列步骤描述的任何操作之前。请确认对将要迁移的数据拥有一个完整备份。 由于AIX 存储分配是在卷组的级别上执行的,存储不能跨越卷组。在一个卷组的空间变得很有限的情况下,另一个卷组的可用空间不可以直接被用来解决存储短缺的问题。 一个解决方法是增加更多的物理卷到相关的卷组,但在某些情况下,这种方法可能不是一个好的选择。如果其他的卷组包含足够的可用空间,另一个选择可能是,移动需要的逻辑卷到想要的卷组中,并且按需要扩展它们。 源逻辑卷能被移动到另一个卷组用cplv命令。如以下步骤所示: 注意:为了保证数据的完整性和一致性,在进行这些操作的时候,逻辑卷必须处在非活动状态(inactive)。如果逻辑卷包含一个已经装入(mounted)的文件系统,这个文件系统必须被先行卸下(unmount)。如果逻辑卷正被用作一个裸的(RAW)存储设备,使用这个逻辑卷的应用必选先关闭这个设备,或者应用本身退出运行。 1. 用cplv命令拷贝源逻辑卷到目的卷组 举例而言,如果myvg 是新的卷组名,mylv是用户的逻辑卷,键入:

# cplv -v myvg mylv 这将返回新的逻辑卷的名字,诸如 lv00 如果被移动的逻辑卷正用于裸设备存储,跳到第6步。如果是JFS 或 JFS2文件系统,进行第2步。 注意,裸存储设备不应该使用裸设备的前512个字节。这是为逻辑卷控制块(LVCB)保留的。cplv将不拷贝裸逻辑卷的前512个字节,但它会更新新的逻辑卷的LVCB中的域。 2. 所有的JFS和JFS2 文件系统都需要一个日志设备,它是jfslog类型的逻辑卷或者 jfs2log型的逻辑卷(对于JFS2文件系统)。在目的卷组上运行 lsvg –l <卷组名> 。如果在新的卷组上不存在JFS或JFS2日志设备,使用mklv和logform 命令创建日志设备。 # mklv -t jfslog myvg 1 或 # mklv -t jfs2log myvg 1 # logform /dev/loglv00 如果JFS 或JFS2日志设备已经存在,直接到步骤3 3. 用chfs命令改变文件系统以引用新的卷组和新的逻辑卷中的日志设备 例如,如果myfilesystem 是用户的文件系统名,键入 # chfs -a dev=/dev/lv00 -a log=/dev/loglv00 /myfilesystem

存储分盘,SAN交换机划zone,AIX创建文件系统V2

存储划盘、SAN交换机划Zone、AIX 创建文件系统 1、存储划盘 确认事项: 1:确认规划的RAID组中知否还有可用资源 2:确认需要资源的主机是否已经与高端存储的前端口建立组关系 操作流程: 1:从高端存储的RAID组中划出Ldev。 2:将高端存储的前端口与主机的HBA卡的WWN号划进同一个组(主机之前没有用过该存储的资源)。 3:将LUN划进对应的组 1.1新建ldev 具体操作步骤: 远程桌面连接入高端存储

选择Modify Mode模式 选择Install,进入管理界面,并点击Logical Device Fomat Modify模式:可以修改配置 View模式:不能更改,只能查询配置信息 进入逻辑设备格式界面

选择CVS Configuration,进入LDEV管理界面选择LDEV(CVS)…,进入创建LDEV界面CVS Configuration :ldev管理 LUN Configuration: 逻辑单元管理 Volume to Space:用于收回ldev LDEV(CVS)Installaton:用于创建新的ldev

选择Raid组,用于创 建新的ldev 选择需要创建LDEV的RAID组,点击Detail 选择拆分的组,每个 ldev组最大为3T, 也就是包含ldev总 和为3T 选择LDEV分组,并点击Detail

创建几个ldev, 和每个ldev包 含的Block数量 Ldev的单 位 选择需要创建的LDEV的数量,和Blocks的数量,1M=1*2*1024个Blocks 点击ADD添加,并点击OK

AIX系统新建文件系统操作步骤

QT-PAMS-DG-PLMS-MT-00101.00.000 (内部保密资料) 东莞AIX系统新建文件系统操作文档 自2009年11月23日起正式生效 编制:玉丽丽审批:

声明 本文件所有权和解释权归广州从兴电子开发有限公司所有,广州从兴电子开发有限公司书面许可,不得复制或向第三方公开。 版本修订历史

1.概述 1.1.目的 AIX新建文件系统操作步骤文档,提供给对AIX新建文件系统的人员没有操作过或没有经验者参考。 1.2.来源 AIX新建文件系统yuli,用于备份数据库数据使用。 1.3.重要程度 重要 1.4.描述 在AIX操作系统中新建文件系统操作步骤。 2.处理步骤 2.1.一般新建步骤 1.连接到需要新建文件系统的服务器检查环境是否符合新建文件系统的要求。 2.检查卷组及卷组的大小,其中命令:lspv(查看有什么卷组),lspv 卷组名 称(查看某个卷组的使用情况,如已用空间,空余空间等相关信息。) 3.以东莞数据库服务器新建一个备份文件系统为例,在array2vg卷组新建文 件系统,文件系统名称为:yuli,文件系统的大小为500G,具体操作如下: 1)用root用户连接数据库服务器,查看array2vg使用情况(lsvg array2vg),使用情况如下图所示:

从图中可以看到array2vg可用空间满足新建文件系统要求。 2)Smitty hacmp (回车),如下图所示: 选择:system Management(C-SPOC),回车,如下图所示: 选择:HACMP Logical Volume Management,回车,如下图所示: 选择:Shared File Systems,回车,如下图所示: 选择:Enhanced Journaled File Systems,回车,如下图所示: 选择:Add an Enhanced Journaled File System(新建增强型文件系统),回车,(注:若是在原有的逻辑卷上新建文件系统,则选择:Add an Enhanced Journaled File System on a Prcviously Defincd Logical Volume),如

Hi3518内核和文件系统烧写以及nfs挂载

Hi3518内核和文件系统烧写以及NFS挂载

修改履历

第一步编译内核和文件系统 文档说明:涉及到目录的请根据自己的实际情况进行更改,本文档仅根据笔者的测试进行举例说明。 1 安装交叉编译器 cd arm-hisiv100nptl-linux ./cross.install 说明:3518e推荐使用100nptl进行编译,arm-hisiv100nptl-linux-(使用uclibc库,uclibc 工具链支持全规格版本和小型化版本 )arm-hisiv200-linux-(glibc 库glibc 工具链只支持全规格版本),实验时没有使用hisiv200,不确定会出什么问题,不推荐使用。 2 编译步骤 cd ./linux-3.0.y ./mk3518.sh mk3518.sh 脚本里面包含了编译linux内核所需的所有的命令,具体看mk3518.sh文件,编译成功将生成在目录arch/arm/boot/uImage文件,这个就是要烧录到板子上的 注意:大小大约为1M。大于1M也许会出问题,在实验前期都是大于1M,烧录的时候出问题。 制作rootfs文件系统,使用的是最新的squashfs只读文件系统,使用的工具为mksquashfs,目录squashfs4.2为这个工具的代码 rm ./rootfs.squashfs //仅仅为了删除之前存在的文件系统,如果没有,可不执行这一步。 ./mksquashfs ./rootfsrootfs.squashfs -b 256K cp ./rootfs.squashfs ./tftpboot //可不用命令,自己拷贝,黏贴,文件夹根据自己实际情况所定。 生成的rootfs.squashfs这个就是要烧录到板子上的文件 注意:生成的文件大约为1.5M 地址空间说明 | 256K | 1M | 1.5M | |------------|---------------|-----------------------| | boot | kernel | rootfs |

aix文件系统在线扩容

aix文件系统在线扩容 aix的文件系统扩容是非常灵活的,如果不涉及加硬盘的硬件操作,只要通过aix里面的命令或者smitty菜单就行了,当然做好数据备份在任何情况下都是必要的。 1、因为数据库归档日志目录空间较小,而日志增长又比较快,因归档日志满很容易造成数据库挂起,所以准备对文件系统进行扩容。 # df -g Filesystem GB blocks Free %Used Iused %Iused Mounted on /dev/hd4 5.00 4.90 3% 7024 1% / /dev/hd2 20.00 14.77 27% 57946 2% /usr /dev/hd9var 10.00 9.37 7% 7454 1% /var /dev/hd3 15.00 14.41 4% 3290 1% /tmp /dev/hd1 6.00 5.01 17% 1873 1% /home /proc - - - - - /proc /dev/hd10opt 15.00 14.62 3% 10242 1% /opt /dev/lv00 0.25 0.24 4% 18 1% /var/adm/csd /dev/fslv00 10.00 9.20 8% 2876 1% /sapmnt/BWP /dev/lv_oracle 0.50 0.50 1% 47 1% /oracle /dev/BWP 5.00 4.55 9% 12334 2% /oracle/BWP /dev/BWP_102_64 9.00 4.84 47% 22062 2% /oracle/BWP/102_64 /dev/BWP_mirrlogA 0.50 0.40 20% 6 1% /oracle/BWP/mirrlogA /dev/BWP_mirrlogB 0.50 0.40 20% 6 1% /oracle/BWP/mirrlogB /dev/BWP_oraarch 50.00 38.82 93% 279 1% /oracle/BWP/oraarch /dev/BWP_origlogA 0.50 0.36 29% 9 1% /oracle/BWP/origlogA 2、查看当前活动的卷,只有两个,经与工程师确认数据库归档日志目录在ORAVG卷上。# lsvg -o oravg rootvg 进一步详细查看ORAVG卷的信息 # lsvg -l oravg oravg: LV NAME TYPE LPs PPs PVs LV STATE MOUNT POINT lv_oracle jfs2 2 2 1 open/syncd /oracle client jfs2 2 2 1 open/syncd /oracle/client stage_102_64 jfs2 28 28 1 open/syncd /oracle/stage/102_64 BWP jfs2 20 20 1 open/syncd /oracle/BWP BWP_102_64 jfs2 36 36 1 open/syncd /oracle/BWP/102_64 BWP_origlogA jfs2 2 2 1 open/syncd /oracle/BWP/origlogA BWP_origlogB jfs2 2 2 1 open/syncd /oracle/BWP/origlogB BWP_mirrlogA jfs2 2 2 1 open/syncd /oracle/BWP/mirrlogA BWP_mirrlogB jfs2 2 2 1 open/syncd /oracle/BWP/mirrlogB BWP_oraarch jfs2 200 200 1 open/syncd /oracle/BWP/oraarch 发现当前目录的PPS大小为200

JZ2440开发板网络文件系统搭建nfs

JZ2440网络文件系统nfs搭建 问题描述: 在驱动程序开发阶段,会涉及到频繁的编译调试程序,如果每次都把驱动程序编译到内核去,会浪费大量的时间。所以通常把驱动程序编译成.ko的模块动态加载到内核,这样可以省去编译整个内核的过程,大大提高了驱动开发的效率。那么虚拟机上编译好的驱动模块怎样传递给目标机(开发板)呢,就是通过本文介绍的网络文件系统,PC机共享出一个网络文件系统给开发板,开发板就相当于多了一个本地文件夹一样。 原料: 1、JZ2440开发板+已经移植好的linux系统; 2、USB转UART连接线一根; 3、网线一根; 4、笔记本电脑安装vmware + Ubuntu; 步骤: 1、设置开发板IP地址,使开发板与虚拟机在同一个局域网。这里采用的是笔记本无线上网, 有限网络连接到开发板,该部分不清楚的可以参考我之前的笔记《开发板通过笔记本的有线网络上网》。 a)开发板正常启动后,通过Uart中断: # ifconfig eth0 Link encap:Ethernet HWaddr 00:60:6E:33:44:55 inet addr:192.168.1.17Bcast:192.168.1.255 Mask:255.255.255.0 UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1 RX packets:28 errors:0 dropped:0 overruns:0 frame:0 TX packets:0 errors:0 dropped:0 overruns:0 carrier:0 collisions:0 txqueuelen:1000 RX bytes:2776 (2.7 KiB) TX bytes:0 (0.0 B) Interrupt:51 Base address:0xa000 b)查看虚拟机上的IP地址: book@book-desktop:~$ ifconfig eth3 Link encap:Ethernet HWaddr 00:0c:29:e4:a7:e1 inet addr:192.168.2.102Bcast:192.168.2.255 Mask:255.255.255.0 inet6 addr: fe80::20c:29ff:fee4:a7e1/64 Scope:Link UP BROADCAST RUNNING MULTICAST MTU:1500 Metric:1 RX packets:3015 errors:0 dropped:0 overruns:0 frame:0 TX packets:2173 errors:0 dropped:0 overruns:0 carrier:0 collisions:0 txqueuelen:1000 RX bytes:940451 (940.4 KB) TX bytes:241758 (241.7 KB) Interrupt:18 Base address:0x2024 eth4 Link encap:Ethernet HWaddr 00:0c:29:e4:a7:eb inet addr:192.168.3.54 Bcast:192.168.3.255 Mask:255.255.255.0