语义分析的一些方法

语义分析的一些方法

语义分析的一些方法(上篇)

5040

语义分析,本文指运用各种机器学习方法,挖掘与学习文本、图片等的深层次概念。wikipedia上的解释:In machine learning, semantic analysis of a corpus is the task of building structures that approximate concepts from a large set of documents(or images)。

工作这几年,陆陆续续实践过一些项目,有搜索广告,社交广告,微博广告,品牌广告,内容广告等。要使我们广告平台效益最大化,首先需要理解用户,Context(将展示广告的上下文)和广告,才能将最合适的广告展示给用户。而这其中,就离不开对用户,对上下文,对广告的语义分析,由此催生了一些子项目,例如文本语义分析,图片语义理解,语义索引,短串语义关联,用户广告语义匹配等。

接下来我将写一写我所认识的语义分析的一些方法,虽说我们在做的时候,效果导向居多,方法理论理解也许并不深入,不过权当个人知识点总结,有任何不当之处请指正,谢谢。

本文主要由以下四部分组成:文本基本处理,文本语义分析,图片语义分析,语义分析小结。先讲述文本处理的基本方法,这构成了语义分析的基础。接着分文本和图片两节讲述各自语义分析的一些方法,值得注意的是,虽说分为两节,但文本和图片在语义分析方法上有很多共通与关联。最后我们简单介绍下语义分析在广点通“用户广告匹配”上的应用,并展望一下未来的语义分析方法。

1 文本基本处理

在讲文本语义分析之前,我们先说下文本基本处理,因为它构成了语义分析的基础。而文本处理有很多方面,考虑到本文主题,这里只介绍中文分词以及Term Weighting。

1.1 中文分词

拿到一段文本后,通常情况下,首先要做分词。分词的方法一般有如下几种:

?基于字符串匹配的分词方法。此方法按照不同的扫描方式,逐个查找词库进行分词。根据扫描方式可细分为:正向最大匹配,反向最大匹配,

双向最大匹配,最小切分(即最短路径);总之就是各种不同的启发规则。

?全切分方法。它首先切分出与词库匹配的所有可能的词,再运用统计语言模型决定最优的切分结果。它的优点在于可以解决分词中的歧义问

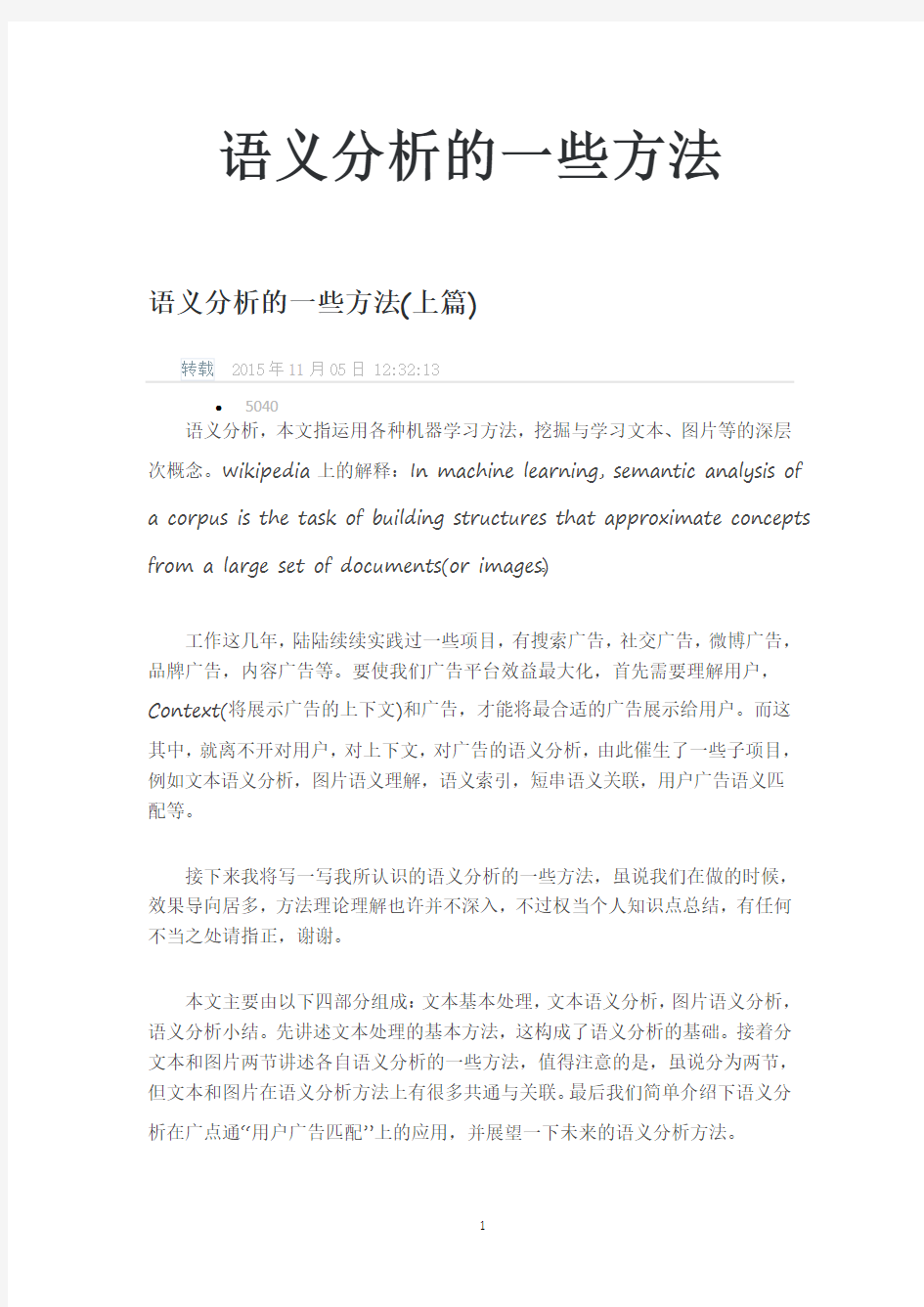

题。下图是一个示例,对于文本串“南京市长江大桥”,首先进行词条检索(一般用Trie存储),找到匹配的所有词条(南京,市,长江,大桥,南京市,长江大桥,市长,江大桥,江大,桥),以词网格(word lattices)形式表示,接着做路径搜索,基于统计语言模型(例如n-gram)[18]找到最优路径,最后可能还需要命名实体识别。下图中“南京市长江大桥”

的语言模型得分,即P(南京市,长江,大桥)最高,则为最优切分。

图1. “南京市长江大桥”语言模型得分

?

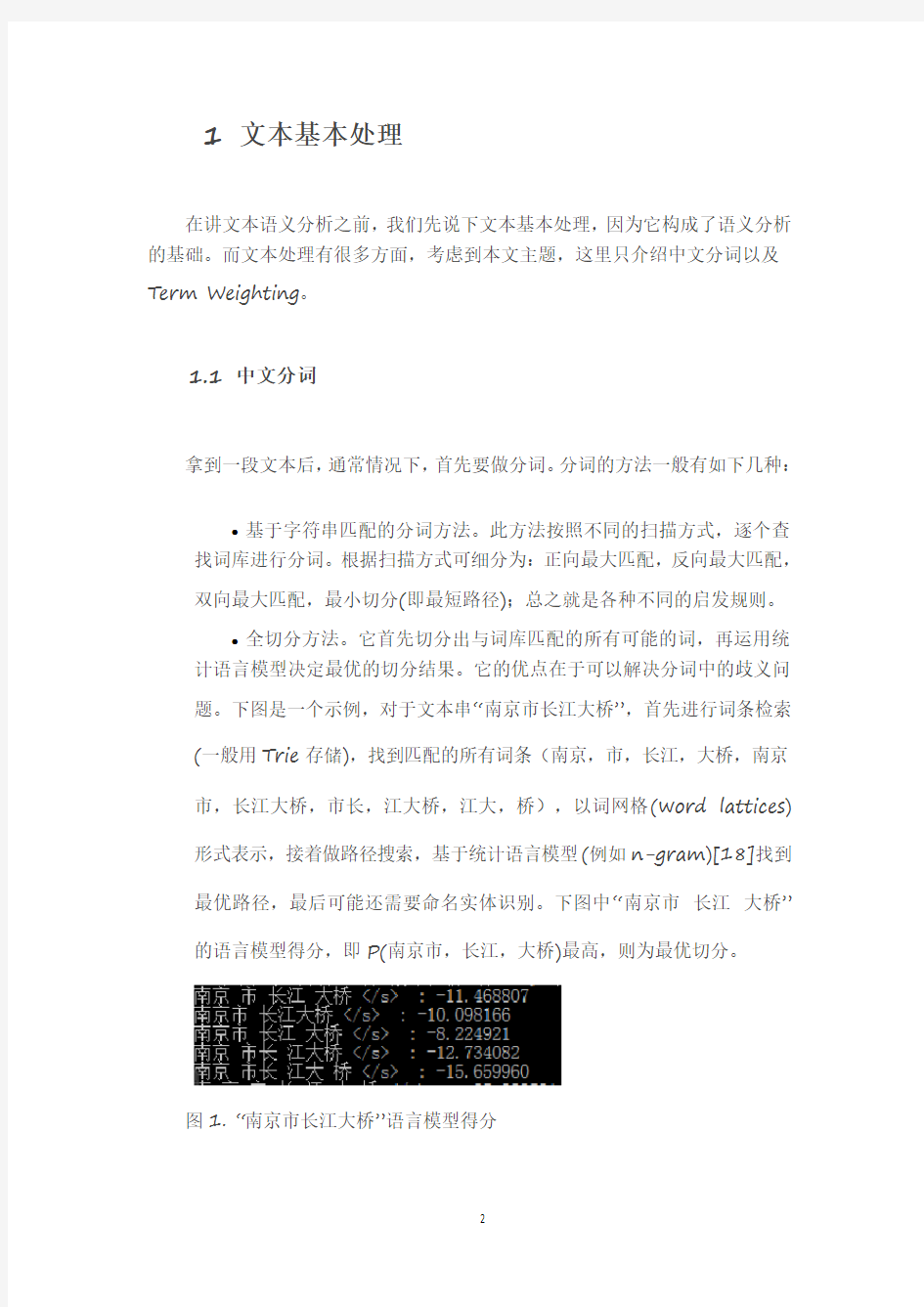

?由字构词的分词方法。可以理解为字的分类问题,也就是自然语言处理中的sequence labeling问题,通常做法里利用HMM,MAXENT,MEMM,CRF等预测文本串每个字的tag[62],譬如B,E,I,S,这四个tag分别表示:beginning, inside, ending, single,也就是一个词的开始,中间,结束,以及单个字的词。例如“南京市长江大桥”的标注结果可能为:“南(B)京(I)市(E)长(B)江(E)大(B)桥(E)”。由于CRF既可以像最大熵模型一样加各种领域feature,又避免了HMM的齐次马尔科夫假设,所以基于CRF的分词目前是效果最好的,具体请参考文献[61,62,63]。除了HMM,CRF等模型,分词也可以基于深度学习方法

来做,如文献[9][10]所介绍,也取得了state-of-the-art的结果。

图2. 基于深度学习的中文分词

?

上图是一个基于深度学习的分词示例图。我们从上往下看,首先对每一个字进行Lookup Table,映射到一个固定长度的特征向量(这里可以利用词向量,boundary entropy,accessor variety等);接着经过一个标准的神经网络,分别是linear,sigmoid,linear层,对于每个字,预测该字属于B,E,I,S的概率;最后输出是一个矩阵,矩阵的行是B,E,I,S 4个tag,利用viterbi算法就可以完成标注推断,从而得到分词结果。

?

一个文本串除了分词,还需要做词性标注,命名实体识别,新词发现等。通常有两种方案,一种是pipeline approaches,就是先分词,再做词性标注;另一种是joint approaches,就是把这些任务用一个模型来完成。有兴趣可以参考文献[9][62]等。

一般而言,方法一和方法二在工业界用得比较多,方法三因为采用复杂的模型,虽准确率相对高,但耗时较大。

1.2 语言模型

前面在讲“全切分分词”方法时,提到了语言模型,并且通过语言模型,还可以引出词向量,所以这里把语言模型简单阐述一下。

语言模型是用来计算一个句子产生概率的概率模型,即

P(w_1,w_2,w_3…w_m),m表示词的总个数。根据贝叶斯公式:

P(w_1,w_2,w_3 … w_m) = P(w_1)P(w_2|w_1)P(w_3|w_1,w_2) …

P(w_m|w_1,w_2 … w_{m-1})。

最简单的语言模型是N-Gram,它利用马尔科夫假设,认为句子中每个单词只与其前n–1个单词有关,即假设产生w_m这个词的条件概率只依赖于前n–1个词,则有P(w_m|w_1,w_2…w_{m-1}) =

P(w_m|w_{m-n+1},w_{m-n+2} … w_{m-1})。其中n越大,模型可区别性越强,n越小,模型可靠性越高。

N-Gram语言模型简单有效,但是它只考虑了词的位置关系,没有考虑词之间的相似度,词语法和词语义,并且还存在数据稀疏的问题,所以后来,又逐

渐提出更多的语言模型,例如Class-based ngram model,topic-based ngram model,cache-based ngram model,skipping ngram model,指数语言模型(最大熵模型,条件随机域模型)等。若想了解更多请参考文章[18]。

最近,随着深度学习的兴起,神经网络语言模型也变得火热[4]。用神经网络训练语言模型的经典之作,要数Bengio等人发表的《A Neural Probabilistic Language Model》[3],它也是基于N-Gram的,首先将每个单词

w_{m-n+1},w_{m-n+2} … w_{m-1}映射到词向量空间,再把各个单词的词向量组合成一个更大的向量作为神经网络输入,输出是P(w_m)。本文将此模型简称为ffnnlm(Feed-forward Neural Net Language Model)。ffnnlm 解决了传统n-gram的两个缺陷:(1)词语之间的相似性可以通过词向量来体现;(2)自带平滑功能。文献[3]不仅提出神经网络语言模型,还顺带引出了词向量,关于词向量,后文将再细述。

图3. 基于神经网络的语言模型

从最新文献看,目前state-of-the-art语言模型应该是基于循环神经网络(recurrent neural network)的语言模型,简称rnnlm[5][6]。循环神经网络相比于传统前馈神经网络,其特点是:可以存在有向环,将上一次的输出作为本次的输入。而rnnlm和ffnnlm的最大区别是:ffnnmm要求输入的上下文是固定长度的,也就是说n-gram中的n 要求是个固定值,而rnnlm不限制上下文的长度,可以真正充分地利用所有上文信息来预测下一个词,本次预测的中间隐层信息(例如下图中的context信息)可以在下一次预测里循环使用。

图4. 基于simple RNN(time-delay neural network)的语言模型

如上图所示,这是一个最简单的rnnlm,神经网络分为三层,第一层是输入层,第二层是隐藏层(也叫context层),第三层输出层。假设当前是t时刻,则分三步来预测P(w_m):

?单词w_{m-1}映射到词向量,记作input(t)

?连接上一次训练的隐藏层context(t–1),经过sigmoid function,生成当前t时刻的context(t)

?利用softmax function,预测P(w_m)

参考文献[7]中列出了一个rnnlm的library,其代码紧凑。利用它训练中文语言模型将很简单,上面“南京市长江大桥”就是rnnlm的预测结果。

基于RNN的language model利用BPTT(BackPropagation through time)算法比较难于训练,原因就是深度神经网络里比较普遍的vanishing gradient问题[55](在RNN里,梯度计算随时间成指数倍增长或衰减,称之为Exponential Error Decay)。所以后来又提出基于LSTM(Long short term memory)的language model,LSTM也是一种RNN网络,关于LSTM 的详细介绍请参考文献[54,49,52]。LSTM通过网络结构的修改,从而避免vanishing gradient问题。

图5. LSTM memory cell

如上图所示,是一个LSTM unit。如果是传统的神经网络unit,output activation bi = activation_function(ai),但LSTM unit的计算相对就复杂些了,它保存了该神经元上一次计算的结果,通过input gate,output gate,forget gate来计算输出,具体过程请参考文献[53,54]。

1.3 Term Weighting

Term重要性

对文本分词后,接下来需要对分词后的每个term计算一个权重,重要的term应该给与更高的权重。举例来说,“什么产品对减肥帮助最大?”的term weighting结果可能是: “什么0.1,产品0.5,对0.1,减肥0.8,帮助0.3,最大0.2”。Term weighting在文本检索,文本相关性,核心词提取等任务中都有重要作用。

Term weighting的打分公式一般由三部分组成:local,global 和normalization [1,2]。即

TermWeight=L_{i,j} G_i N_j。L_{i,j}是term i在document j中的local weight,G_i是term i的global weight,N_j是document j 的归一化因子。

常见的local,global,normalization weight公式[2]有:

图6. Local weight formulas

图7. Global weight formulas

?

图8. Normalization factors

?

Tf-Idf是一种最常见的term weighting方法。在上面的公式体系里,Tf-Idf的local weight是FREQ,glocal weight是IDFB,normalization 是None。tf是词频,表示这个词出现的次数。df是文档频率,表示这个词在多少个文档中出现。idf则是逆文档频率,idf=log(TD/df),TD表示总文档数。Tf-Idf在很多场合都很有效,但缺点也比较明显,以“词频”度量重要性,不够全面,譬如在搜索广告的关键词匹配时就不够用。

?

除了TF-IDF外,还有很多其他term weighting方法,例如Okapi,MI,LTU,ATC,TF-ICF[59]等。通过local,global,normalization各种公式的组合,可以生成不同的term weighting计算方法。不过上面这些方法都是无监督计算方法,有一定程度的通用性,但在一些特定场景里显得不够灵活,不够准确,所以可以基于有监督机器学习方法来拟合term weighting结果。

?

图9. Okapi计算公式

?

?利用有监督机器学习方法来预测weight。这里类似于机器学习的分类任务,对于文本串的每个term,预测一个[0,1]的得分,得分越大则term重要性越高。既然是有监督学习,那么就需要训练数据。如果采用人工标注的话,极大耗费人力,所以可以采用训练数据自提取的方法,利用程序从搜索日志里自动挖掘。从海量日志数据里提取隐含的用户对于term重要性的标注,得到的训练数据将综合亿级用户的“标注结果”,覆盖面更广,且来自于真实搜索数据,训练结果与标注的目标集分布接近,训练数据更精确。下面列举三种方法(除此外,还有更多可以利用的方法):?从搜索session数据里提取训练数据,用户在一个检索会话中的检索核心意图是不变的,提取出核心意图所对应的term,其重要性就高。

?从历史短串关系资源库里提取训练数据,短串扩展关系中,一个term出现的次数越多,则越重要。

?从搜索广告点击日志里提取训练数据,query与bidword共有term的点击率越高,它在query中的重要程度就越高。

通过上面的方法,可以提取到大量质量不错的训练数据(数十亿级别的数据,这其中可能有部分样本不准确,但在如此大规模数据情况下,绝大部分样本都是准确的)。

有了训练数据,接下来提取特征,基于逻辑回归模型来预测文本串中每个term的重要性。所提取的特征包括:

?term的自解释特征,例如term专名类型,term词性,term idf,位置特征,term的长度等;

?term与文本串的交叉特征,例如term与文本串中其他term的字面交叉特征,term转移到文本串中其他term的转移概率特征,term 的文本分类、topic与文本串的文本分类、topic的交叉特征等。

核心词、关键词提取

?短文本串的核心词提取。对短文本串分词后,利用上面介绍的term weighting方法,获取term weight后,取一定的阈值,就可以提取出短文本串的核心词。

?长文本串(譬如web page)的关键词提取。这里简单介绍几种方法。

想了解更多,请参考文献[69]。

?采用基于规则的方法。考虑到位置特征,网页特征等。

?基于广告主购买的bidword和高频query建立多模式匹配树,在长文本串中进行全字匹配找出候选关键词,再结合关键词weight,以及某些规则找出优质的关键词。

?类似于有监督的term weighting方法,也可以训练关键词weighting的模型。

?基于文档主题结构的关键词抽取,具体可以参考文献[71]。

参考文献

1.Term-weighting approaches in automatic text retrieval,Gerard Salton et.

2.New term weighting formulas for the vector space method in information retrieval

3. A neural probabilistic language model 2003

4.Deep Learning in NLP-词向量和语言模型

5.Recurrent neural network based language models

6.Statistical Language Models based on Neural Networks,mikolov博士论文

7.Rnnlm library

8. A survey of named entity recognition and classification

9.Deep learning for Chinese word segmentation and POS tagging

10.Max-margin tensor neural network for chinese word segmentation

11.Learning distributed representations of concepts

12.Care and Feeding of Topic Models: Problems, Diagnostics, and Improvements

13.LightLda

14.word2vec

15.Efficient Estimation of Word Representations in Vector Space

16.Deep Learning实战之word2vec

17.word2vec中的数学原理详解出处2

18.斯坦福课程-语言模型

19.Translating Videos to Natural Language Using Deep Recurrent Neural Networks

20.Distributed Representations of Sentences and Documents

21.Convolutional Neural Networks卷积神经网络

22. A New, Deep-Learning Take on Image Recognition

23.Spatial Pyramid Pooling in Deep Convolutional Networks for Visual Recognition

24. A Deep Learning Tutorial: From Perceptrons to Deep Networks

25.Deep Learning for Computer Vision

26.Zero-shot leanring by convex combination of semantic embeddings

27.Sequence to sequence learning with neural network

28.Exploting similarities among language for machine translation

29.Grammar as Foreign Language Oriol Vinyals, Lukasz Kaiser, Terry Koo, Slav Petrov, Ilya Sutskever, Geoffrey Hinton, arXiv 2014

30.Deep Semantic Embedding

31.张家俊. DNN Applications in NLP

32.Deep learning for natural language processing and machine translation

33.Distributed Representations for Semantic Matching

34.distributed_representation_nlp

35.Deep Visual-Semantic Alignments for Generating Image Descriptions

36.Convolutional Neural Networks for Sentence Classification

37.Senna

38.ImageNet Large Scale Visual Recognition Challenge

39.Krizhevsky A, Sutskever I, Hinton G E. ImageNet Classification with Deep Convolutional Neural Networks

40.Gradient-Based Learning Applied to Document Recognition

41.Effetive use of word order for text categorization with convolutional neural network,Rie Johnson

42.Learning Phrase Representations using RNN Encoder-Decoder for Statistical Machine Translation

43.Show and Tell: A Neural Image Caption Generator

44.Deep Image: Scaling up Image Recognition

https://www.360docs.net/doc/9d15071121.html,rge-Scale High-Precision Topic Modeling on Twitter

46. A. Krizhevsky. One weird trick for parallelizing convolutional neural networks. arXiv:1404.5997, 2014

47. A Brief Overview of Deep Learning

48.Going deeper with convolutions. Christian Szegedy. Google Inc. 阅读笔记

49.Long Short-Term Memory Recurrent Neural Network Architectures for Large Scale Acoustic Modeling

50.Semi-Supervised Learning Tutorial

51.https://www.360docs.net/doc/9d15071121.html,/question/24904450

52.LONG SHORT-TERM MEMORY BASED RECURRENT NEURAL NETWORK ARCHITECTURES FOR LARGE VOCABULARY SPEECH RECOGNITION

53.LSTM Neural Networks for Language Modeling

54.LONG SHORT-TERM MEMORY

55.Bengio, Y., Simard, P., Frasconi, P., “Learning long-term dependencies with gradient descent is difficult” IEEE Transactions on Neural Networks 5 (1994), pp. 157–166

56.AliasLDA

57.Gibbs sampling for the uninitiated

58.Learning classifiers from only positive and unlabeled data

59.TF-ICF: A New Term Weighting Scheme for Clustering Dynamic Data Streams

60.LDA数学八卦

61.Chinese Word Segmentation and Named Entity Recognition Based on Conditional Random Fields Models

62.Conditional Random Fields: Probabilistic Models for Segmenting and Labeling Sequence Data

63.Chinese Segmentation and New Word Detection using Conditional Random Fields

64.Gregor Heinrich. Parameter estimation for text analysis

65.Peacock:大规模主题模型及其在腾讯业务中的应用

66.L. Yao, D. Mimno, and A. McCallum. Efficient methods for topic model inference on streaming document collections. In KDD, 2009.

67.David Newman. Distributed Algorithms for Topic Models

68.Xuemin. LDA工程实践之算法篇

69.Brian Lott. Survey of Keyword Extraction Techniques

70.Yi Wang, Xuemin Zhao, Zhenlong Sun, Hao Yan, Lifeng Wang, Zhihui Jin, Liubin Wang, Yang Gao, Ching Law,

and Jia Zeng. Peacock: Learning Long-Tail Topic Features for Industrial Applications. TIST’2015.

71.刘知远. 基于文档主题结构的关键词抽取方法研究

72.Hinton. Reducing the Dimensionality of Data with Neural Networks

73.Samaneh Moghaddam. On the design of LDA models for aspect-based opinion mining;

74.The FLDA model for aspect-based opinion mining: addressing the cold start problem

75.Ross Girshick et. Rich feature hierarchies for accurate object detection and semantic segmentation

76.J. Uijlings, K. van de Sande, T. Gevers, and A. Smeulders. Selective search for object recognition. IJCV, 2013.

77.Baidu/UCLA: Explain Images with Multimodal Recurrent Neural Networks

78.Toronto: Unifying Visual-Semantic Embeddings with Multimodal Neural Language Models

79.Berkeley: Long-term Recurrent Convolutional Networks for Visual Recognition and Description

80.Xinlei Chen et. Learning a Recurrent Visual Representation for Image Caption Generation

语义分析

语义分析 1.语义分析? 机器机和人不一样的地方是人可以直接理解词的意思,文章的意思,机器机不能理解。 人看到苹果这两个字就知道指的是那个圆圆的,挺好吃的东西,搜索引擎却不能从感性上理解。但搜索引擎可以掌握词之间的关系,这就牵扯到语义分析。 可参考:https://www.360docs.net/doc/9d15071121.html,/dispbbs.asp?boardID=2&ID=74541 2.为什么要使用语义分析? 我国中文自然语言处理普遍采用西基于拉丁语系的“关键词”技术,以此来分析理解中文。然而,中文本身的特点决定它与西语之间巨大的区别,所以从汉语信息处理的需要看,当前急迫需要突破的是语义问题。 可参考: https://www.360docs.net/doc/9d15071121.html,/dicksong2008/blog/item/88fb751e9ac9501a4134 17f4.html 2.1中文与西语不同决定我们无法采用西语的架构体系来处理中文,具体区别在于: 西语词间有间隔,汉语词间无间隔。众所周知,英文是以词为单位的,词和词之间是靠空格隔开,而中文是以字为单位,句子中所有的字连起来才能描述一个意思。 例如,英文句子I am a student,用中文则为:“我是一个学生”。计算机可以很简单通过空格知道student是一个单词,但是不能很容易明白“学”、“生”两个字合起来才表示一个词。把中文的汉字序列切分成有意义的词,就是中文分词,有些人也称为切词。 “我是一个学生”,分词的结果是:“我是一个学生”。中文分词就成了计算机处理的难题。 汉语形态不发达,句尾没有形态标记。英语动词、名词很清楚,加上词尾可以是副词;西语有时态,过去式、现在式等等非常清楚,中文则依靠词语或者依靠自己的判断来确定时态。 同音字多增加了机器识别的难度。 汉语语义灵活,由于形态不发达,所以语序无规律。在一次学术会议上,一位著名的人工智能专家说:“按…主-谓-宾?或…名-动-名?这一规则,计算机可显出…牛吃草?,也可显出…草吃牛?。从语法格式上看,…草吃牛?也不错,但这句话是说不通的。 人依靠自己的经验可以判断,机器如何来判断呢?

句法结构中的语义分析

句法结构中的语义分析 学习要点:掌握句法结构分析中运用语义关系、语义指向、语义特征三种语义分析方法,并且能够运用这些分析法解释一些常见的语言现象。 句法结构是句法形式和语义内容的统一体。对句法结构不仅要做形式分析,如句法层次分析、句法关系分析、以及句型分析等,还要做种种语义分析。句法结构中的语义分析主要指语义关系、语义指向、语义特征三种分析法。 一、语义关系 (一)句法关系和语义关系 在句法结构中,词语与词语之间不仅发生种种语法关系,主谓、述补、述宾、偏正、联合等,而且发生种种语义关系。语义关系,语义学中指语言成分所表示的客观对象之间的关系,我们所说的语义关系是指动作和动作者、动作和受动者、动作和工具、动作和处所、事物和事物之间的关系等。句法关系和语义关系可能一致,也可能不一致。 ⑴吃面条。/削苹果。(句法、语义关系一致。) ⑵我吃完了。/饼干吃完了。/文章写好了。(句法、语义关系不一致) 前者“我”与“吃”是动作者(施事)和动作的关系,后者“饼干”和“吃”是受动者(受事)和动作的关系,结果和动作的关系。 一种句法结构关系,可能包含着多种语义关系,如:修理家具。/挖了一个坑。/来了一个客人。/写毛笔。(述宾关系,受事、结果、施事、工具。)反之,一种语义关系也可能构成多种句法结构关系。 ⑶沙发上坐着一个人。 ⑷那个人坐在沙发上。 ⑸那个人在沙发上坐着。 这几个句法结构的语义关系基本相同,“人”“沙发上”与“坐”之间都是“施事”“处所”与“动作”的关系;但句法结构关系却不一样。 (二)动词和名词语义关系的类别 汉语句法结构中的语义关系是多种多样的,句法分析的重点是动词跟名词性词语之间的语义关系。在各种语义关系中,名词性成分担任了一定的语义角色,如“受事、结果、施事、工具”等,这实际上也就是揭示了名词性成分跟动词之间的关系。名词性词语经常担任的语义角色主要有: 1、施事:指动作的发出者(可用介词“被、叫、让、给”引进) 他在看书。/小狗啃完了骨头。/敌人被我们打败了。 2、受事:指动作行为的承受者(可用介词“把、将”引进)。 小牛吃草。/张三修桌子。/毛把花瓶打碎了。 3、系事:指连系动词联接的对象(?) 我们是教师。/小王成了大学生。 4、与事:指动作行为的间接的承受者(送、还?)(可用介词“给”引进)。 张三还李四一支笔。/我给兰兰送去一些巧克力。 5、结果:指动作行为产生的结果。 编草帽。/烙饼。/做烟斗。/打毛衣。/盖大楼。

技术的本质

技术的性质(第二课时) 一、课程标准对本章的要求 1.知道技术是人类为满足自身的需要和愿望对大自然进行的改造。 2.知道技术的发展需要发明和革新,并能通过案例进行说明。 3.理解技术活动往往需要综合运用多种知识。 4.通过对历史和现实的一些重大问题的调查和研究,理解技术的两面性. 5.知道知识产权在技术领域的重要性,了解专利的作用、有关规定及申请方法。 二、教学目标 知识与技能 1.知道技术的性质包括技术的目的性、创新性、综合性、两面性、专利性等。 2.知道创新的形式包括发明和革新。 3.理解科学与技术的区别与联系。 4.知道知识产权的内容。知道专利制度的含义,能说出申请专利的一般过程。 过程与方法 1.通过举例分析,理解技术的目的性即是技术“因人而生,以人为本,为人服务”的具体体现。 2.通过讨论及案例理解创新对技术发展的作用。 3.通过举例分析理解技术与其他学科的相互关系。 4.通过对典型案例的讨论理解技术的两面性。 5.理解知识产权及专利制度在技术领域的重要性。 情感态度与价值观 1.通过交流、讨论,养成技术意识,破除对技术及创新的神秘感,能够积极主动的参与技术活动,培养创新意识。2.增强法制观念,自觉抵制侵犯知识产权的行为。

三、教学重点、难点。 重点:理解创新对技术发展的重要性,培养学生的创新意识。 增强学生的法制观念,自觉抵制侵犯知识产权的行为。 难点:理解科学活动与技术活动的区别和联系。 四、学生情况分析 通过对第一章第一节“技术的的价值”的学习,学生对技术是社会发展、文明进步、经济增长的主要动力有了一定的认识,对技术“因人而生,为人服务”有了一定的了解,形成了对学习技术课程的欲望和兴趣。但是对技术仍有一定的神秘感,对技术的内涵,即内在特性还不够了解。 五、课时安排: 2课时 六、教材分析: 这是学生学习通用技术后的第二节内容,在前面一节的学习中,学生感悟了技术的价值和魅力,对技术的含义有了一定的了解,懂得技术“因人而生、为人服务”,是社会发展、文明进步、经济增长的主要动力。在这一节要学习技术的基本特性,这里讲的基本特性并非是技术的本质,技术的本质是指诸多技术基本性质中最根本最核心的特性,这里要加以区别,教材中讲述了5种基本特性:目的性、创新性、综合性、两面性、专利性等,按照课程标准和教材中的学习目标可以看到,这一节由两个需要学生理解的性质是综合性和两面性,其他的性质只要求指导和了解既可,所以教学是要有所侧重。教材在最后的思考题是:你认为技术还有那些特性?请作具体说明。通过这个思考,学生会自然而然的将课本知识向课外延伸,给学生提供了一定的拓展空间,这一点要引起我们的充分重视。 技术的目的性,教材首先指出技术都是人类有意识、有目的活动的成果。而每一项具体的技术又一定是为人们某方面具体的需求服务的。然后用案例“助听器的发明”加以具体阐述。并指出技术的目的性体现在丰富多彩的技术活动之中。是推进技术不断优化和不断发展的源动力。对于这个案例的处理,要注意它是为了“技术都是人类有意识、有目的活动的成果”这个论点进行说明的,所以在分析这个案例时,先要让学生分析,助听器的目的是为了什么,接着要分析,为了达到之一目的,人们都作了些什么,?又是如何去做的?。 技术的创新性,教材首先指出创新的重要性:创新是技术的核心所在,也是对人类富有挑战意义的内在原因。教材的“小辞典”包括随后的“讨论”就是要让学生正确理解创新的概念,告诉学生:技术创新可以从不同的角度加以理解,要让学生认识到创新不一定就是发明,不要把创新看得太神秘,关键是突出一个“新”字。然后教材进一步明确技术创新常表现为技术革新和技术发明,并利用“瓦特蒸汽机”的例子说明技术发明对技术发展的推动作用,老师可以补充像“超导技术”、“纳米技术”等,也可以让学生举一些身边发生的案例来进行说明。教材中技术的创新是一个艰难而曲折的历程,可以理解为技术的创新不是一帆风顺的,要培养自己百折不挠、实事求是、不怕困难、追求创新的良好态度与品质;技术创新没有止境,只有更好,没有最好,谁也不知道将来会发展成什么样子。这也正是创新对人类富有挑战意义的魅力所在。 技术的综合性,教材分成了三块进行了阐述:一是技术具有跨学科性,每项技术都要综合运用多个学科、多方面的知识,教材举了小板凳的例子,教师可以让学生寻找一些身边的常用物品加以阐述;二是技术与科学的区别和联系,

情感分析简述

情感分析简述 分类:NLP2012-04-08 12:38 1022人阅读评论(3) 收藏举报情感classification算法测试translationmatrix 情感分析,我研究了也有半年有余了,ACL Anthology上关于情感分析的论文也基本看过了一遍,但是到目前还没有什么成就的。以下是我为一位同学毕业设计写的情感分析方面的综述,引用的论文基本上是ACL 和COLING还有EMNLP上历年关于情感分析的论文,本文应该学术性比较强一点,本文虽不打算发表,但由于将来可能还有用,以及关于学术上的原因,请大家如果要引用请务必标明出处 (https://www.360docs.net/doc/9d15071121.html,/s/blog_48f3f8b10100irhl.html)。 概述 情感分析自从2002年由Bo Pang提出之后,获得了很大程度的研究的,特别是在在线评论的情感倾向性分析上获得了很大的发展,目前基于在线评论文本的情感倾向性分析的准确率最高能达到90%以上,但是由于深层情感分析必然涉及到语义的分析,以及文本中情感转移现象的经常出现,所以基于深层语义的情感分析以及篇章级的情感分析进展一直不是很大。情感分析还存在的一个问题是尚未存在一个标准的情感测试语料库,虽然Bo Pang实验用的电影评论数据集(https://www.360docs.net/doc/9d15071121.html,/people/pabo/movie-review-data/)以及Theresa Wilson等建立的MPQA(https://www.360docs.net/doc/9d15071121.html,/mpqa/)是目前广泛使用的两类情感分析数据集,但是并没有公认的标准加以确认。 目前情感分析的研究基本借鉴文本分类等机器学习的方法,还没有根据自身的特点形成一套独立的研究方法,当然在某种程度上也可以把情感分析看出一种特殊的文本分类。比较成熟的方法是基于监督学习的机器学习方法,半监督学习和无监督学习目前的研究不是很多,单纯的基于规则的情感分析这两年已很少研究了。既然目前很多情感分析的研究基于机器学习,那么特征选择就是一个很重要的问题,N元语法等句法特征是使用最多的一类特征,而语义特征(语义计算)和结构特征(树核函数)从文本分类的角度看效果远没有句法特征效果好,所以目前的研究不是很多的。 由于基于监督学习情感分析的研究已经很成熟了,而且在真实世界中由于测试集的数量要远远多于训练集的数量,并且测试集的领域也不像在监督学习中被限制为和训练集一致,也就是说目前情感分析所应用的归纳偏置假设在真实世界中显得太强的,为了和真实世界相一致,基于半监督学习或弱指导学习的情感分析和跨领域的情感分析势必是将来的研究趋势之一。 在情感分析的最初阶段基于语义和基于规则的情感分析曾获得了比较大的重视,但是由于本身实现的复杂性以及文本分类和机器学习方法在情感分析应用上获得的成功,目前关于这方面的研究以及很少了,但是事实上,语义的相关性和上下文的相关性正是情感分析和文本分类最大的不同之处,所以将基于语义和规则的情感分析与基于机器学习的情感分析相结合也将是未来的研究趋势之一。 以下将分别对情感分析的起源,目前基于监督学习,无监督学习,基于规则和跨领域的情感分析的一些研究工作进行简单的介绍。 起源 虽然之前也有一些相关工作,但目前公认的情感分析比较系统的研究工作开始于(Pang et al., 2002)基于监督学习(supervised learning)方法对电影评论文本进行情感倾向性分类和(Turney,2002)基于无监督学习(unsupervised learning)对文本情感情感倾向性分类的研究。(Pang et al., 2002)基于文本的N元语法(ngram)和词类(POS)等特征分别使用朴素贝叶斯(Naive Bayes),最大熵(Maximum Entropy)和支持向量机(Support Vector Machine,SVM)将文本情感倾向性分为正向和负向两类,将文本的情感进行二元划分的做法也一直沿用至今。同时他们在实验中使用电影评论数据集目前已成为广泛使用的情感分析的测试集。(Turney ,2002)基于点互信息(Pointwise Mutual Information,PMI)计算文本中抽取的关键词和种子词(excellent,poor)的相似度来对文本的情感倾向性进行判别(SO-PMI算法)。 在此之后的大部分都是基于(Pang et al., 2002)的研究。而相对来说,(Turney et al.,2002)提出的无监督学习的方法虽然在实现上更加简单,但是由于单词之间的情感相似度难以准确的计算和种子词的难以确定,继续在无监督学习方向的研究并不是很多的,但是利用SO-PMI算法计算文本情感倾向性的思想却被很多研究者所继承了。 监督学习 目前,基于监督学习的情感分析仍然是主流,除了(Li et al.,2009)基于非负矩阵三分解(Non-negative Matrix Tri-factorization),(Abbasi et al.,2008)基于遗传算法(Genetic Algorithm)的情感分析之外,使用的最多的监督学习算法是朴素贝叶斯,k最近邻(k-Nearest Neighbor,k-NN),最大熵和支持向量机的。而对于算法的改进主要在对文本的预处理阶段。 一个和文本分类不同地方就是情感分析有时需要提取文本的真正表达情感的句子。(Pang et al., 2004)基于文本中的主观句的选择和(Wilson el al.,2009)基于文本中的中性实例(neutral instances)的分析,都是为了能够尽量获得文本中真正表达情感的句子。(Abbasi et al.,2008)提出通过信息增益(Information Gain,IG)的方法来选择大量特征集中对于情感分析有益的特征。 而对于特征选择,除了N元语法和词类特征之外,(Wilson el al.,2009)提出混合单词特征,否定词特征,情感修饰特征,情感转移特征等各类句法特征的情感分析,(Abbasi et al.,2008)提出混合句子的句法(N元语法,词类,标点)和结构特征(单词的长度,词类中单词的个数,文本的结构特征等)的情感分析。 除了对于文本的预处理,对于监督学习中情感分析还进行了以下方面的研究的。(Melville et al., 2009)和(Li et al.,2009)提出结合情感词的先验的基于词典的情感倾向性和训练文本中后验的基于上下文的情感情感倾向性共同判断文本的情感倾向性。(Taboada et al.,2009)提出结合文本的题材(描述,评论,背景,解释等)和文本本身的特征共同判断文本的情感倾向性。(Tsutsumi et al.,2007)提出利用多分类器融合技术来对文本情感分类。(Wan, 2008)和(Wan, 2009)提出结合英文中丰富的情感分析资源来提高中文情感分析的效果。 基于规则/无监督学习

研究方法和技术路线

研究方法和技术路线 调查法 调查法是科学研究中最常用的方法之一。它是有目的、有计划、有系统地搜集有关研究对象现实状况或历史状况的材料的方法。调查方法是科学研究中常用的基本研究方法,它综合运用历史法、观察法等方法以及谈话、问卷、个案研究、测验等科学方式,对教育现象进行有计划的、周密的和系统的了解,并对调查搜集到的大量资料进行分析、综合、比较、归纳,从而为人们提供规律性的知识。 调查法中最常用的是问卷调查法,它是以书面提出问题的方式搜集资料的一种研究方法,即调查者就调查项目编制成表式,分发或邮寄给有关人员,请示填写答案,然后回收整理、统计和研究。 观察法 观察法是指研究者根据一定的研究目的、研究提纲或观察表,用自己的感官和辅助工具去直接观察被研究对象,从而获得资料的一种方法。科学的观察具有目的性和计划性、系统性和可重复性。在科学实验和调查研究中,观察法具有如下几个方面的作用:①扩大人们的感性认识。②启发人们的思维。③导致新的发现。 实验法 实验法是通过主支变革、控制研究对象来发现与确认事物间的因果联系的一种科研方法。其主要特点是:第一、主动变革性。观察与调查都是在不干预研究对象的前提下去认识研究对象,发现其中的问题。而实验却要求主动操纵实验条件,人为地改变对象的存在方式、变化过程,使它服从于科学认识的需要。第二、控制性。科学实验要求根据研究的需要,借助各种方法技术,减少或消除各种可能影响科学的无关因素的干扰,在简化、纯化的状态下认识研究对象。第三,因果性。实验以发现、确认事物之间的因果联系的有效工具和必要途径。 文献研究法 文献研究法是根据一定的研究目的或课题,通过调查文献来获得资料,从而全面地、正确地了解掌握所要研究问题的一种方法。文献研究法被子广泛用于各种学科研究中。其作用有:①能了解有关问题的历史和现状,帮助确定研究课题。②能形成关于研究对象的一般印象,有助于观察和访问。③能得到现实资料的比较资料。④有助于了解事物的全貌。 实证研究法 实证研究法是科学实践研究的一种特殊形式。其依据现有的科学理论和实践的需要,提出设计,利用科学仪器和设备,在自然条件下,通过有目的有步骤地操纵,根据观察、记录、测定与此相伴随的现象的变化来确定条件与现象之间的因果关系的活动。主要目的在于说明各种自变量与某一个因变量的关系。 定量分析法 在科学研究中,通过定量分析法可以使人们对研究对象的认识进一步精确化,以便更加科学地揭示规律,把握本质,理清关系,预测事物的发展趋势。

现代汉语语法的五种分析方法

现代汉语语法的五种分析方法

现代汉语语法的五种分析方法 很有用,请好好学习之。 北语之声论坛专业精华转贴 现代汉语语法的五种分析方法是语法学基础里 很重要的一个内容,老师上课也会讲到,我在这 里把最简略的内容写在下面,希望能对本科生的专业课学习有所帮助 详细阐释中心词分析法、层次分析、变换分析法、语义特征分析法和语义指向分析的具体内涵:一. 中心词分析法: 分析要点: 1.分析的对象是单句; 2.认为句子又六大成分组成——主语、谓语(或述语)、宾语、补足语、形容词附加语(即定语)和副词性附加语(即状语和补语)。 这六种成分分为三个级别:主语、谓语(或述语)是主要成分,宾语、补足语是连 带成分,形容词附加语和副词性附加语是附加成分; 3.作为句子成分的只能是词; 4.分析时,先找出全句的中心词作为主语和谓

语,让其他成分分别依附于它们; 5.分析步骤是,先分清句子的主要成分,再决定有无连带成分,最后指出附加成分。 标记: 一般用║来分隔主语部分和谓语部分,用══标注主语,用——标注谓语,用~~~~~~标注宾语,用()标注定语,用[ ]标注状语,用< >标注补语。 作用: 因其清晰明了得显示了句子的主干,可以一下子把握住一个句子的脉络,适合于中小学语文教学,对于推动汉语教学语法的发展作出了很大贡献。 还可以分化一些歧义句式。比如:我们五个人一组。 (1)我们║五个人一组。(2)我们五个人║一组。 总结:中心词分析法可以分化一些由于某些词或词组在句子中可以做不同的句子成分而造成的歧义关系。 局限性: 1.在一个层面上分析句子,

层次性不强; 2.对于一些否定句和带有修饰成分的句子,往往难以划分; 如:我们不走。≠我们走。 封建思想必须清除。≠思想清除。 3. 一些由于句子的层次关系 不同而造成的歧义句子无法分析; 如:照片放大了一点儿。咬死了猎人的狗。 二. 层次分析: 含义: 在分析一个句子或句法结构时,将句法构造的层次性考虑进来,并按其构造层次逐层进行分析,在分析时,指出每一层面的直接组成成分,这种分析就叫层次分析。 朱德熙先生认为,层次分析不能简单地将其看作是一种分析方法,而是应当看做一种分析原则,是必须遵守的。(可以说说为什么) 层次分析实际包含两部分内容:一是切分,一是定性。切分,是解决一个结构的直接组成成分到底是哪些;而定性,是解决切分所得的直接组成成分之间在句法上是什么关系。

现代汉语语法研究方法的演变及原因

现代汉语语法研究方法的演变及原因 摘要:本文以特定时期著名的语法理论和语法著作为研究对象,分析现代汉语语法研究方法在一个世纪的演变与发展,并试图找出语法研究方法演变与发展的原因。 关键词:语法研究、方法 一、现代汉语语法研究概况 1898年,马建忠参阅西洋语法,写出了《马氏文通》,才标志着中国现代语法学的全面建立。1924年,黎锦熙的《新著国语文法》问世,这是以白话文为对象,全面研究现代汉语语法的第一部力作。《新著国语文法》建立句本位,打破了《马氏文通》以来的“词类本位”的传统。他把句子划分成主语、述语、宾语、补足语、形容性的附加语、副词性附加语等六种成分,第一次明确地规定了分析句子的方法,建立了完备的现代汉语语法体系。这个时期,语法专题论文较少,最重要的当推赵元任的《北京、苏州、常州语助词的研究》(1926)。1938年,陈望道等人在上海发起了关于文法革新的讨论,这场讨论的目的是“以科学的方法严谨的态度缔造中国文法体系”。真正建立起新的汉语语法体系的是吕叔湘的《中国文法要略》(1942)和王力的《中国现代语法》(1943)此外,还有高名凯的《汉语语法论》(1948)美国赵元任的《国语入门》(1948)(《北京口语语法》)等重要作品问世。1949年新中国的成立,给汉语语法学带来了前所未有的变化,由于党和政府的提倡,社会上很快掀起了学习语法修辞的热潮。这个

时期可以称作语法学的发展时期。毛泽东对有关人士指示:“在报上写文章及为学校写文法教科书”,要在全社会普及“文法教育”。1951年6月6日,《人民日报》发表社论《正确使用祖国的语言,为语言的纯洁和健康而斗争!》。从此开始普及语法知识,重要的著作有吕叔湘、朱德熙的《语法修辞讲话》(1951)、吕叔湘的《语法学习》(1951)和张志公《汉语语法常识》(1952)等。一些学者进行科学的语法研究,对当时及以后的语言学产生了重要影响,如丁声树的《现代汉语语法讲话》、王力的《汉语史稿》和陆志韦的《汉语构词法》等。这个时期的语法研究还有一项引人注目的成果,即教学语法。中国第一次有了全国统一使用的教学语法体系——“暂拟汉语教学语法系统”。它划分词类是根据词的意义和语法特点,往往对每类词的语法特点都详加说明,分析句子时采用中心词分析法,在确定主语宾语时不依据施受关系,而大体依据位置的先后。到了新时期,汉语语法研究空前活跃,空前繁荣,空前深入,是语言学科中发展最快的一个部门,取得了举世瞩目的成就。吕叔湘的《汉语语法分析问题》(1979)、朱德熙的《现代汉语语法研究》(1980)影响深远。80年代以来,研究的实践越来越证明,对于现代汉语语法研究来说,“多角验证”的思路是既宽展又有效的。90年代以后,现代汉语语法研究比以往更加活跃,研究领域涉及汉语语法的各个方面,研究队伍更加壮大,取得的成果更加引人注目,新的理论、新的见解被提出来。“三个平面”理论、本位理论、配价语法、汉语的时体研究等问题都成为二十世纪末汉语语法研究的热点。这个时期,进一步加强了句法

在线词频、语义、情感分析工具试用心得

根据之前在@数据化管理 微博那里看到的一些在线效率工具,来试用一下。首先就从在线词频、语义、情感分析工具开始吧。 @数据化管理 推荐了三个网站,分别是图悦、大数据搜索与挖掘平台和腾讯文智。 以新浪微博“英国公投决定脱欧 新浪正实时解读”的直播页面为试用对象,地址 为https://www.360docs.net/doc/9d15071121.html,/zt/l/v/news/ygtogt2016/ ①图悦:https://www.360docs.net/doc/9d15071121.html,/ 初始页面背景是黑色的,看着不舒服,页面换肤后变成白底还可以接受。 左边文本栏可输入待分析的文本,也可以直接复制链接,很人性化。贴入要分析的网页地址,点击分析出图,右边就获得了分析结果。、 结果显示有多种模式,下面截图显示的是默认的热词权重图-标准模式。热词词频图是每个热词后面带括号显示词频,比较乱,不好看。微信模式是圆形的显示框变成扁椭圆式,地图模式是显示框为中国地图的轮廓。 可以导出EXCEL,列明分析出来的关键词、词频和权重。 ②大数据搜索与挖掘平台:https://www.360docs.net/doc/9d15071121.html,/nlpir/ 看上去功能比较强大,同样可以输入网页URL进行文本抓取。分析结果分为多个板块: 分词标注:可以对词语的词性进行分类分析,发现新词

实体抽取:对文本的实体类型和实体内容进行分析,下图是图表效果,●代表实体类型,●代表实体内容。另外还有文本效果,内容是一样的,效果不如这个好看,就不截图了。 词频统计:按照名词、动词、形容词分类显示词频,有柱状图和折线图两类图表,鼠标停留在某个词上会显示词频数量。 文本分类:似乎是对文本所讨论的问题进行归类,猜哒。 情感分析:不太明确是啥意思 -。-,什么叫正面,什么又叫负面呢,特定人物又是谁?

义素分析法分析“看的方式”语义场

义素分析法分析“看的方式”语义场 摘要:“看的方式”的语义场可以归为同义语义场。通过义素分析的方法,并写出 每个词的基本义的义素表达式,来分析该语义场内的词之间的异同。词不仅有理 性意义还有感性意义,通过感性意义能更好的区别和运用同义词。 关键字:义素分析法,同义词辨析,看的方式 一、义素分析法在同义词辨析中的运用 同义词辨析一直以来都是语言研究的重要方面,不仅是在语言研究,还是在 语言运用中,甚至在语言的教学中都具有特殊的意义。义素分析法是准确描写和 掌握词义的有效方法。词义并不是一个整体,而是有若干层次的结构,义素是构 成词义的最小意义单位。将义素分析法引入对外汉语词汇教学,可以对词义的微 观层面进行准确有效的分析,把词义分割成若干个义素的组合,不仅有利于准确 掌握同义词之间的大同小异,还能提高人们对语言的运用能力,有利于第二语言 学习者在语言学习中理解两个及两个以上抽象的同义词,加深对汉语词汇的理解 和运用。 本文主要通过义素分析法来分析比较“看的方式”的语义场,来说明义素分析 法在同义词比较中的运用。运用义素分析法的表达式来研究“看的意义相同或相近的词”。本文研究的看的方式词有:看、望、顾、瞪、瞥、瞅、盯、窥、伺、瞟、瞰。 二、“看的方式”的语义场义素分析的方法和步骤 1.确立语义场 语义场是通过不同词之间的对比,根据它们词义的共同特点或关系划分出来 的类。同义语义场相当于一些论著中讲的一组广义的同义词(即不包括等义词),它所包括的各个义位间大同小异。所谓的同,表现为基本义相同或者是基本义有 一部分相同。所谓的异,就是附加义不同,或者是基本义有一部分不同,又或是 不只是基本义有一部分不同附加义也不一样。“看的方式”语义场内的词是眼部动 作描写都有“用眼睛看”这一基本义项,因此,这些看的方式词都可以看作是“看” 这个词的同义词。那么“看的方式”就构成了一个眼部动作的同义语义场。根据义 素分析法的分析并通过表达式的比较,可以准确的辨析出同义语义场内各个词之 间的细微区别,有利于第二语言的学习。 2.通过义素的具体对比分析“看的方式:看、望、顾、瞪、瞥、瞅、盯、窥、伺、瞟、瞰”的异同。 这些字从现代汉语词典第七版中查到“看的方式”词的意义如下所示: (1)看: [动] 使视线接触人或物:~书|~电影|~了他一眼。 [动] 观察并加以判断:我~他是个可靠的人l你~这个办法好不好。 [动] 取决于;决定于:这件事能 不能成功全~你了|飞机能否准时起飞,要~天气如何。 [动] 访问;探望:~望|~朋友。 [动] 对待:~待|另眼相~|别拿我当外人~。 [动] 诊治:王大夫把我的病~好了。照料:照~l衣帽自~。 [动] 用在表示动作或变化的词或词组前面,表示预见到某 种变化趋势,或者提醒对方注意可能发生或将要发生的某种不好的事情或情况: 行情~涨|别跑!~摔着!|~饭快凉了,快吃吧。 [助] 用在动词或动词结构后面, 表示试一试(前面的动词常用重叠式):想想~I找找~|等一等~l评评理~先做几 天~。 (2)望: [动] 向远处看:登山远~|一~无际的稻田。观看;察看:~风!观~|~ 闻问切。探望:拜~|看~。盼望;希望①:~子成龙l~准时到会。盼头;希望②:

语言学概论分类模拟语法(四)

语言学概论分类模拟语法(四) 分析题 1. 分析下面两个有歧义的语言片段,分析造成歧义的原因: (1)你这倒霉蛋的弟弟(2)三个艺术学院的学生 答案:(1)你这倒霉蛋的弟弟 属于组合歧义中的词义歧义,语义指向不同造成歧义。“倒霉蛋”可以指向“我”,意思是我是个倒霉蛋,我有个弟弟。“倒霉蛋”还可以指向“弟弟”,意思是我的弟弟是个倒霉蛋。 (2)三个艺术学院的学生 属于组合歧义中的语法歧义,层次不同造成歧义。“三个”可以修饰“艺术学院”,意思是有三个艺术学院,学生是这三个艺术学院的。“三个”也可以修饰“学生”,意思是艺术学院的三个学生。 2. 分析下面语段的层次,并说明其中含有哪几个词组、哪几个词、哪几个语素: 两本儿书、一份报纸我都收起来了。 答案:分析下面语段的层次,并说明其中含有哪几个词组、哪几个词、哪几个语素: 词组:两本儿书一份报纸我都收起来了 词:两本书一份报纸我都收起来了 语素:两本书一份报纸我都收起来了 3. 下面是台湾高山族阿眉斯语的一些句子和对应的汉语意义: nipatafaj kaku tiniraan. 我去陪伴他。 陪伴我他 niala tnira tura awaw. 他去拿那盏灯。 拿他那灯 u parakataj tmi. 阿麦是司机。 是司机阿麦 tku wama nimi. 阿麦父亲叫古拉斯。

古拉斯叫父亲阿麦 nitala hu kaku tmian. 我再去等一下阿麦。 等再我阿麦 niama kami tmian. 我们去阿麦那儿玩。 去玩我们阿麦 (1)写出上述材料反映的句子成分的语序。 (2)上述材料反映出来的表人专名有什么语法范畴? (3)上述材料反映出来的人称代词有什么语法范畴? (4)上述语法范畴是用什么语法手段表示的? (5)写出阿眉斯语表示宾格的语素。 答案:(1)上述材料反映阿眉斯语的句子成分的优势语序是BAC,即动词——施事——受事。 (2)上述材料反映表人专名的语法范畴有“格”,包括主格(如阿麦的主格mi)、所有格(如阿麦的形容词性所有格nimi和名词性所有格mian)和宾格(如阿麦的宾格mian)。 (3)上述材料反映出来的人称代词的语法范畴有“格”和“数”,“格”包括主格(如他nira)、宾格(如他iniraan),“数”包括单数(如我kaku)和复数(如我们kami). (4)上述语法范畴是用外部附加(ni)和内部屈折(如kaku—kaini)表示的。 (5)阿眉斯语表示宾格的语素有前加的i和后加的an。 4. 试以变换分析法说明下列句子的意义差异。 (1)墙上挂着画。 (2)台上演着梆子戏。 (3)山上架着炮。 答案:以上句子可以变换为: (1)墙上挂着画。………………………………………(1)a画挂在墙上。√ (2)台上演着梆子戏。…………………………………(2)a梆子戏演在台上。× (3)山上架着炮。………………………………………(3)a炮架在山上。√ (1)墙上挂着画。………………………………………(1)b墙上正在挂画。× (2)台上演着梆子戏。…………………………………(2)b台上正在演梆子戏。√ (3)山上架着炮。………………………………………(3)b山上正在架炮。√ 通过变换可见:“挂”的语义特征[+存现][-持续],“演”的语义特征[-存现][+持续],“架”的语义特征[+存现][+持续],即(1)墙上挂着画。表示存现、附着。(2)台上演着梆子戏。表示持续。(3)山上架着炮。有歧义,既可表示存现,又可表示持续。

一种基于混合分析的汉语文本句法语义分析方法

中 文 信 息 学 报 第16卷第4期 JOURNAL OF CHINESE INFORMATION PROC ESSING Vol.16No.4一种基于混合分析的汉语文本句法语义分析方法 尹 凌 姚天 张冬茉 李 芳 (上海交通大学计算机科学与工程系 上海 200030) 摘要:本文提出了一种领域相关的汉语文本句法语义分析方法。根据领域文本的特点,该方法将浅层句法分析和深层句法语义分析结合在了一起。其浅层句法分析部分采用有限状态层叠的方法,将文本中的命名实体识别出来,从而大大减轻了深层分析部分的负担。其深层句法语义分析部分将语义分析和语法分析结合起来,主要依靠词汇搭配信息来决定句子的结构。该方法在解决领域相关文本的短语结构歧义方面取得了较好的试验结果。 关键词:浅层句法分析;深层句法分析;有限状态层叠;分语义场 中图分类号:T P391.1 A Hybrid Analysis Based Chinese Text Syntactic and Semantic Analysis Method Yin Ling Y ao T ian fang Zhang Dong mo Li Fang (Department of Computer Science and Engineeri ng Shanghai Jiao Tong University 200030 Shanghai) Abstract:T his paper proposes a Chinese text analysis method on specific domain.A ccording to the texts character, t his met hod combines shallow parsing technolog y w ith deep parsing and semantic analysis technology.Drawing on fi nite state cascades method,its shallow parsing module recognizes named entities in the tex ts.So that it greatly eases t he burden of the deep analysis mo dule.Principally depending on wo rd collocation information,its deep analysis mod ule combines syntactic analysis and semantic analysis to determine sentence structure.It gains goo d effect at resolv ing t he ambiguity of phrase structure in specific do main. Key Words:shallow parsing;deep parsing;finite state cascades;sub semant ic field 一、概述 对于汉语语料库的多级加工,主要分为切词、词类标注、短语结构标注、语义信息标注[1]等。针对后两个阶段,本文以足球比赛报道为试验领域,提出了一种领域相关的汉语文本分析方法。它对已经完成分词和词性标注的中间文本进行处理,借鉴并扩展了C.J.Fillmore的格语法,分析结果力求将句子中各个成分之间的格关系标注清楚。 分析足球比赛报道文本的特点,发现有许多实体名称,如球队名称,比赛名称,人的身份等,对深层句法和语义分析是至关重要的。我们把这些实体名称称为命名实体(named enti 收稿日期:2001-12-24 基金项目:国家自然科学基金(60083003). 作者尹凌,女,1978年生,上海交通大学计算机系研究生,主要研究方向为自然语言处理.姚天,男,上海交通大学副教授,主要研究方向为自然语言处理.张冬茉,女,上海交通大学副教授,主要研究方向为自然语言处理.李芳,女,上海交通大学副教授,主要研究方向为自然语言处理.

自然辩证法-论技术的本质

自然辩证法概论 论文题目:论技术的本质 时间:2014.12 论技术的本质 对于技术本质的研究,是技术哲学的一个基本而且重要的理论问题。技术,从广义上讲,是按照某种有价值的实践目的来控制、改造自然、改造社会和改造

人自身的全部活动中所应用的一切手段、方法和知识等活动方式的总和,它包含三个方面:与物质性、经济性相关的技术;建立并规定社会关系和组织关系的技术;在专门的科学部门,如哲学、语言、艺术创作中用到的技术,即精神技术。狭义上的技术是人类为满足社会需要而依靠自然规律和自然界的物质、能量和信息,来创造、控制、应用和改进人工自然系统的手段和方法。技术的存在取决于人们的需要,并满足其需要;早期人类创造及使用技术是为了解决其基本需求。而现在的技术则是为了满足人们更广泛的需求和欲望,并需要一巨大的社会结构来支撑它。理解技术的本质[1],需要先了解技术的范畴是活动过程,技术的目的是为了人类控制和掌握世界。 我认为从农民的耕种的方式的转变就能说明什么是技术的本质。在我那里的人们都是靠自己的双手,通过辛勤劳动来种植庄稼。很久以前,社会技术发展还不是很成熟,家乡人们的种植经验都是祖祖辈辈在耕种过程中长期观察大自然,及农作物生长的条件而积累下来的。才有了现在的我们知道在什么季节里种植什么样的作物,什么时候该对农作物进行修枝、除虫、除草等活动。而现在,随着社会的发展,聪慧的人们发明、创造了很多自动化、机械化的机器,这些机器帮助很多农民走向了机械化耕作作物的时代,大大减少了耕作的人力与物力。 从上面农民耕种的变化可以清晰地看出,技术的本质,包含两层含义:一是技术活动;狭义的是指人类在利用自然、改造自然的劳动过程中所掌握的方法和手段;广义的是指人类改造自然、改造社会和改造人类自身的方法和手段;二是技术成果,是技术理论、技术工艺与技术产品。其中技术理论是在科学理论应用于工程实践的过程中产生与发展起来的,是科学理论与工程实践的中介。技术与人是在矛盾中共同发展的,技术是由人开发的,技术的产生也是人类造成的,技术产生之后,人们会利用技术去生产一些产品以服务社会,随着人们日益增长的物质文化,人们肯定会技术提出新的要求,这也会促使新技术的产生,所以技术离不开人,人也离不开技术。 技术是随着人类改造自然的实践和科学知识的发展而发展。当人类首次用石头做成原始的劳动工具--石器工具,实现了从猿到人的转变,从而也揭开了人类改造自然的历史序幕时,就有了技术的最初萌芽。在原始的刀、斧、弓、箭等工具的制造中,在狩猎、饲养、栽培的农牧业生产劳动过程中,由于生产经验和劳

语义分析

三、词法、语法、语义分析结合 一、实验目的与要求 在实现词法、语法分析程序的基础上,编写相应的语义子程序,进行语义处理,加深对语法制导翻译原理的理解,进一步掌握将语法分析所识别的语法范畴变换为某种中间代码(四元式)的语义分析方法,并完成相关语义分析器的代码开发。 二、实验内容 语法制导翻译模式是在语法分析的基础上,增加语义操作来实现的。对于给定文法中的每一产生式,编写相应的语义子程序。在语法分析过程中,每当用一个产生式进行推导或归约时,语法分析程序除执行相应的语法分析动作之外,还要调用相应的语义子程序,以便完成生成中间代码、查填有关表格、检查并报告源程序中的语义错误等工作。每个语义子程序需指明相应产生式中各个符号的具体含义,并规定使用该产生式进行分析时所应采取的语义动作。这样,语法制导翻译程序在对源程序从左到右进行的一遍扫描中,既完成语法分析任务,又完成语义分析和中间代码生成方面的工作。 输入:包含测试用例,如由无符号数和+、?、*、/、(、)构成的算术表达式的源程序文件。 输出:将源程序转换为中间代码形式表示,并将中间代码序列输出到文件中。若源程序中有错误,应指出错误信息。 三、实验设计 语法制导翻译模式实际上是对前后文无关文法的一种扩展。一般而言,首先需要根据进行的语义工作,完成对文法的必要拆分和语义动作的编写,从而为每个产生式都配备相应的语义子程序,以便在进行语法分析的同时进行语义解释。要求从编译器的整体设计出发,重点通过对实验二中语法分析程序的扩展,完成一个编译器前端程序的编写、调试和测试工作,形成一个将源程序翻译为中间代码序列的编译系统。 对文法G3[<算术表达式>]中的产生式添加语义处理子程序,完成无符号数的四则运算的计值处理,将输入的四则运算转换为四元式形式的中间代码。本实验只进行了算术表达式四元式的翻译。 四、源代码 1、在.h文件中添加了 //语义分析部分 #define PMAX 5//define 后面不加括号,定义产生式符号属性字符串的长度 int NXQ=0; /*全局变量NXQ用于指示所要产生的下一个四元式的编号*/ int NXTemp=1;//整型变量NXTemp指示临时变量的编号 int SentenceCount=1;//存放文件中句子的个数 struct QUATERNION /*四元式表的结构*/ { char op[PMAX]; /*操作符*/ char arg1[PMAX]; /*第一个操作数*/ char arg2[PMAX]; /*第二个操作数*/ char result[PMAX]; /*运算结果*/ }pQuad[256]; /*存放四元式的数组*/ char EBracket_Place[PMAX];//(E)的语义属性

语义指向分析刍议

语文研究 1998年第3期(总第68期) 语义指向分析刍议 周 刚 80年代以来,我国汉语语法研究出现了一种新的语义分析方法,就是语义指向分析。随着语法研究从描写到解释不断深入和发展,语义指向分析已经越来越受到重视。但是,对这一方法的系统探讨和研究还不多见,本文旨在对语义指向分析的演进、类型、作用和语义指向的形式标志等问题加以探讨,以期起到抛砖引玉的作用。 1 语义指向分析的演进 1 1 语义指向分析的来源 关于语义指向分析的来源,语法学界已有两种说法:一种认为,(陆俭明1995)语义指向分析产生于80年代,胡树鲜(1982)在 两组副词的语义特点及其多项作用点 一文中已有萌芽,沈开木(1983)开始提到语义关系上的 指向 ,而第一次完整使用语义指向这个术语的是刘宁生(1984)。另一种则认为(沈开木1996),语义指向是由 指向 演化而来, 指向 是吕叔湘对沈开木(1983)一文审稿时提出来的,后来邵敬敏(1985)提出 语义指向 这一术语。 笔者有不同的看法。其实语义指向分析的源头还可以追溯到60年代,文炼(1960)就已指出汉语的句子在形式和意义上的不一致性,并且具体分析了这种语法现象: 他洗衣服洗得干干净净。 他看小说看得着了迷。 第 两句的格式相同,都是 主 谓 宾 谓(重用) 补 。但是表达的语义关系不完全一样:第 句的补语是说明宾语的,而第 句的补语是说明主语的。 文章虽然没有用到 语义指向 这一术语,但是使用了 说明 一词,相当于语义的指向。接着,李临定(1963)进一步讨论了有关补语跟其他成分的语义关系问题,却也没有使用 语义指向 这一术语,而延续使用 说明 一词。语义指向分析方法至此呈现萌芽状态。到70年代末,著名语言学家吕叔湘(1979)第一次明确地提出了 在语义上A指向C 的说法: 也有这种情形:论结构关系,A应该属于B,但是在语义上A指向C,例如:(a) 圆圆的排成一个圈 (圆的圈)|(b) 走了一大截冤枉路 (走得冤枉)|(c) 几个大商场我都跑了 (都总括几个)。 吕先生提纲挈领地分析了形容词状语、定语和副词状语三种成分的语义指向,为语法研究指出了一个新的方向。进入80年代,沈开木(1983)开始使用 指向 这一术语,分析了 也 字语义上的 多项指向 问题。刘宁生(1984)首次使用 语义指向 这一术语,论述了在句首的 在 介词结构的语义指向,指出 在 句法上是全句的修饰语,其语义指向却不一致,有时指向主语,有时指向谓语。此后, 语义指向 这一术语就使用开了,运用语