k -Statistic

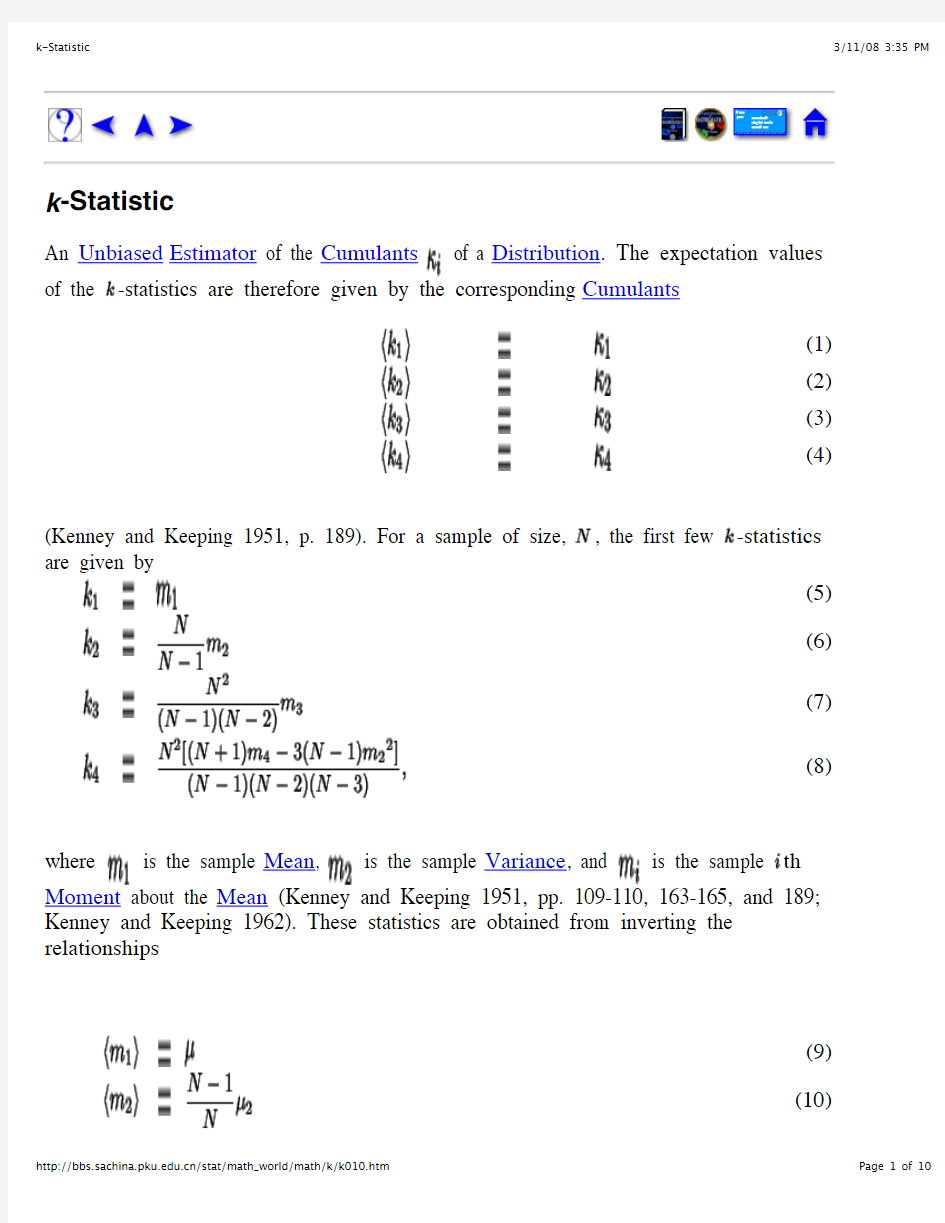

of a

of the -statistics are therefore given by the corresponding

(Kenney and Keeping 1951, p. 189). For a sample of size, , the first few -statistics are given by

where is the sample , is the sample , and is the sample th Moment about the (Kenney and Keeping 1951, pp. 109-110, 163-165, and 189;

(11)

(12)

(13) The first moment (sample Mean) is

(14) and the expectation value is

(15) The second Moment (sample Standard Deviation) is

(16) and the expectation value is

(17) since there are terms , using

(18)

and where is the Moment about 0. Using the identity

(19)

to convert to the Moment about the Mean and simplifying then gives

(20) The factor is known as Bessel's Correction.

The third Moment is

(21) Now use the identities

(22)

(23) where it is understood that sums over products of variables exclude equal indices. Plugging in

(24)

The expectation value is then given by

(25)

where is the Moment about 0. Plugging in the identities

(26)

(27) and simplifying then gives

(28) (Kenney and Keeping 1951, p. 189).

The fourth Moment is

(29)

Now use the identities

(30)

(31)

(32) Plugging in,

(33)

The expectation value is then given by

(34) where are Moments about 0. Using the identities

(35)

(36)

(37) and simplifying gives

(38) (Kenney and Keeping 1951, p. 189).

The square of the second moment is

(39) Now use the identities

(41)

(42) Plugging in,

(43)

The expectation value is then given by

(44)

where are Moments about 0. Using the identities

(45)

(46)

and simplifying gives

(48) (Kenney and Keeping 1951, p. 189).

The Variance of is given by

(49) so an unbiased estimator of is given by

(50)

(Kenney and Keeping 1951, p. 189). The Variance of can be expressed in terms of Cumulants by

(51)

An Unbiased Estimator for is

(52) (Kenney and Keeping 1951, p. 190).

Now consider a finite population. Let a sample of be taken from a population of .

Then Unbiased Estimators for the population Mean, for the population Variance, for the population Skewness, and for the population Kurtosis

are

(53)

(54)

(55)

(56)

(Church 1926, p. 357; Carver 1930; Irwin and Kendall 1944; Kenney and Keeping 1951, p. 143), where is the sample Skewness and is the sample Kurtosis.

See also Gaussian Distribution, Kurtosis, Mean, Moment, Skewness, Variance

References

Carver, H. C. (Ed.). ``Fundamentals of the Theory of Sampling.'' Ann. Math. Stat.1, 101-121, 1930.

Church, A. E. R. ``On the Means and Squared Standard-Deviations of Small Samples from Any Population.'' Biometrika18, 321-394, 1926.

Irwin, J. O. and Kendall, M. G. ``Sampling Moments of Moments for a Finite Population.'' Ann. Eugenics12, 138-142, 1944.

Kenney, J. F. and Keeping, E. S. Mathematics of Statistics, Pt. 2, 2nd ed. Princeton, NJ: Van Nostrand, 1951.

Kenney, J. F. and Keeping, E. S. ``The -Statistics.'' §7.9 in Mathematics of Statistics, Pt. 1,

3rd ed. Princeton, NJ: Van Nostrand, pp. 99-100, 1962.

Statistical Table T-test F-test 的表格

Appendix2 Tables of statistical distributions Table A2.1Normal critical values for different values ofα α0.40.250.20.150.10.050.0250.010.0050.001 Zα.2533.6745.84161.03641.28161.64491.96002.32632.57583.0902 Source:Biometrika Tables for Statisticians(1966),volume1,3rd edn.Reprinted with permission of Oxford University Press. 616

Appendixes617 Table A2.2Critical values of Student’s t-distribution for different probability levels,αand degrees of freedom,ν α0.40.250.150.10.050.0250.010.0050.0010.0005ν 10.3249 1.0000 1.9626 3.0777 6.313812.706231.820563.6567318.3087636.6189 20.28870.8165 1.3862 1.8856 2.9200 4.3027 6.96469.924822.327131.5991 30.27670.7649 1.2498 1.6377 2.3534 3.1824 4.5407 5.840910.214512.9240 40.27070.7407 1.1896 1.5332 2.1318 2.7764 3.7469 4.60417.17328.6103 50.26720.7267 1.1558 1.4759 2.0150 2.5706 3.3649 4.0321 5.8934 6.8688 60.26480.7176 1.1342 1.4398 1.9432 2.4469 3.1427 3.7074 5.2076 5.9588 70.26320.7111 1.1192 1.4149 1.8946 2.3646 2.9980 3.4995 4.7853 5.4079 80.26190.7064 1.1081 1.3968 1.8595 2.3060 2.8965 3.3554 4.5008 5.0413 90.26100.7027 1.0997 1.3830 1.8331 2.2622 2.8214 3.2498 4.2968 4.7809 100.26020.6998 1.0931 1.3722 1.8125 2.2281 2.7638 3.1693 4.1437 4.5869 110.25960.6974 1.0877 1.3634 1.7959 2.2010 2.7181 3.1058 4.0247 4.4370 120.25900.6955 1.0832 1.3562 1.7823 2.1788 2.6810 3.0545 3.9296 4.3178 130.25860.6938 1.0795 1.3502 1.7709 2.1604 2.6503 3.0123 3.8520 4.2208 140.25820.6924 1.0763 1.3450 1.7613 2.1448 2.6245 2.9768 3.7874 4.1405 150.25790.6912 1.0735 1.3406 1.7531 2.1314 2.6025 2.9467 3.7328 4.0728 160.25760.6901 1.0711 1.3368 1.7459 2.1199 2.5835 2.9208 3.6862 4.0150 170.25730.6892 1.0690 1.3334 1.7396 2.1098 2.5669 2.8982 3.6458 3.9651 180.25710.6884 1.0672 1.3304 1.7341 2.1009 2.5524 2.8784 3.6105 3.9216 190.25690.6876 1.0655 1.3277 1.7291 2.0930 2.5395 2.8609 3.5794 3.8834 200.25670.6870 1.0640 1.3253 1.7247 2.0860 2.5280 2.8453 3.5518 3.8495 210.25660.6864 1.0627 1.3232 1.7207 2.0796 2.5176 2.8314 3.5272 3.8193 220.25640.6858 1.0614 1.3212 1.7171 2.0739 2.5083 2.8188 3.5050 3.7921 230.25630.6853 1.0603 1.3195 1.7139 2.0687 2.4999 2.8073 3.4850 3.7676 240.25620.6848 1.0593 1.3178 1.7109 2.0639 2.4922 2.7969 3.4668 3.7454 250.25610.6844 1.0584 1.3163 1.7081 2.0595 2.4851 2.7874 3.4502 3.7251 260.25600.6840 1.0575 1.3150 1.7056 2.0555 2.4786 2.7787 3.4350 3.7066 270.25590.6837 1.0567 1.3137 1.7033 2.0518 2.4727 2.7707 3.4210 3.6896 280.25580.6834 1.0560 1.3125 1.7011 2.0484 2.4671 2.7633 3.4082 3.6739 290.25570.6830 1.0553 1.3114 1.6991 2.0452 2.4620 2.7564 3.3962 3.6594 300.25560.6828 1.0547 1.3104 1.6973 2.0423 2.4573 2.7500 3.3852 3.6460 350.25530.6816 1.0520 1.3062 1.6896 2.0301 2.4377 2.7238 3.3400 3.5911 400.25500.6807 1.0500 1.3031 1.6839 2.0211 2.4233 2.7045 3.3069 3.5510 450.25490.6800 1.0485 1.3006 1.6794 2.0141 2.4121 2.6896 3.2815 3.5203 500.25470.6794 1.0473 1.2987 1.6759 2.0086 2.4033 2.6778 3.2614 3.4960 600.25450.6786 1.0455 1.2958 1.6706 2.0003 2.3901 2.6603 3.2317 3.4602 700.25430.6780 1.0442 1.2938 1.6669 1.9944 2.3808 2.6479 3.2108 3.4350 800.25420.6776 1.0432 1.2922 1.6641 1.9901 2.3739 2.6387 3.1953 3.4163 900.25410.6772 1.0424 1.2910 1.6620 1.9867 2.3685 2.6316 3.1833 3.4019 1000.25400.6770 1.0418 1.2901 1.6602 1.9840 2.3642 2.6259 3.1737 3.3905 1200.25390.6765 1.0409 1.2886 1.6577 1.9799 2.3578 2.6174 3.1595 3.3735 1500.25380.6761 1.0400 1.2872 1.6551 1.9759 2.3515 2.6090 3.1455 3.3566 2000.25370.6757 1.0391 1.2858 1.6525 1.9719 2.3451 2.6006 3.1315 3.3398 3000.25360.6753 1.0382 1.2844 1.6499 1.9679 2.3388 2.5923 3.1176 3.3233∞0.25330.6745 1.0364 1.2816 1.6449 1.9600 2.3263 2.5758 3.0902 3.2905 Source:Biometrika Tables for Statisticians(1966),volume1,3rd edn.Reprinted with permission of Oxford University Press.

K-means算法简介

K-means聚类算法 K-means也是聚类算法中最简单的一种了,但是里面包含的思想却是不一般。最早我使用并实现这个算法是在学习韩爷爷那本数据挖掘的书中,那本书比较注重应用。看了Andrew Ng的这个讲义后才有些明白K-means后面包含的EM思想。 聚类属于无监督学习,以往的回归、朴素贝叶斯、SVM等都是有类别标签y的,也就是说样例中已经给出了样例的分类。而聚类的样本中却没有给定y,只有特征x,比如假设 宇宙中的星星可以表示成三维空间中的点集。聚类的目的是找到每个样本x潜在的类别y,并将同类别y的样本x放在一起。比如上面的星星,聚类后结果是一个个星团,星团里面的点相互距离比较近,星团间的星星距离就比较远了。 在聚类问题中,给我们的训练样本是,每个,没有了y。 K-means算法是将样本聚类成k个簇(cluster),具体算法描述如下: 1、随机选取k个聚类质心点(cluster centroids)为。 2、重复下面过程直到收敛 { 对于每一个样例i,计算其应该属于的类 对于每一个类j,重新计算该类的质心 } K是我们事先给定的聚类数,代表样例i与k个类中距离最近的那个类,的值 是1到k中的一个。质心代表我们对属于同一个类的样本中心点的猜测,拿星团模型来解释就是要将所有的星星聚成k个星团,首先随机选取k个宇宙中的点(或者k个星星)作为k个星团的质心,然后第一步对于每一个星星计算其到k个质心中每一个的距离,然后选取 距离最近的那个星团作为,这样经过第一步每一个星星都有了所属的星团;第二步对于

每一个星团,重新计算它的质心(对里面所有的星星坐标求平均)。重复迭代第一步和第二步直到质心不变或者变化很小。 下图展示了对n个样本点进行K-means聚类的效果,这里k取2。 K-means面对的第一个问题是如何保证收敛,前面的算法中强调结束条件就是收敛,可以证明的是K-means完全可以保证收敛性。下面我们定性的描述一下收敛性,我们定义畸变函数(distortion function)如下: J函数表示每个样本点到其质心的距离平方和。K-means是要将J调整到最小。假设当 前J没有达到最小值,那么首先可以固定每个类的质心,调整每个样例的所属的类别来让J函数减少,同样,固定,调整每个类的质心也可以使J减小。这两个过程就是内循环中使J单调递减的过程。当J递减到最小时,和c也同时收敛。(在理论上,可以有多组不同的和c值能够使得J取得最小值,但这种现象实际上很少见)。

K-MEANS算法(K均值算法)

k-means 算法 一.算法简介 k -means 算法,也被称为k -平均或k -均值,是一种得到最广泛使用的聚类算法。 它是将各个聚类子集内的所有数据样本的均值作为该聚类的代表点,算法的主要思想是通过迭代过程把数据集划分为不同的类别,使得评价聚类性能的准则函数达到最优,从而使生成的每个聚类内紧凑,类间独立。这一算法不适合处理离散型属性,但是对于连续型具有较好的聚类效果。 二.划分聚类方法对数据集进行聚类时包括如下三个要点: (1)选定某种距离作为数据样本间的相似性度量 k-means 聚类算法不适合处理离散型属性,对连续型属性比较适合。因此在计算数据样本之间的距离时,可以根据实际需要选择欧式距离、曼哈顿距离或者明考斯距离中的一种来作为算法的相似性度量,其中最常用的是欧式距离。下面我给大家具体介绍一下欧式距离。 假设给定的数据集 ,X 中的样本用d 个描述属性A 1,A 2…A d 来表示,并且d 个描述属性都是连续型属性。数据样本x i =(x i1,x i2,…x id ), x j =(x j1,x j2,…x jd )其中,x i1,x i2,…x id 和x j1,x j2,…x jd 分别是样本x i 和x j 对应d 个描述属性A 1,A 2,…A d 的具体取值。样本xi 和xj 之间的相似度通常用它们之间的距离d(x i ,x j )来表示,距离越小,样本x i 和x j 越相似,差异度越小;距离越大,样本x i 和x j 越不相似,差异度越大。 欧式距离公式如下: (2)选择评价聚类性能的准则函数 k-means 聚类算法使用误差平方和准则函数来评价聚类性能。给定数据集X ,其中只包含描述属性,不包含类别属性。假设X 包含k 个聚类子集X 1,X 2,…X K ; {} |1,2,...,m X x m total ==() ,i j d x x =

统计名词解释

1.参数(parameter):总体的统计指标或特征值。总体参数是事物本身固有的、不变的。 统计量(statistic):由样本所算出的统计指标或特征值。 2.正态分布:以均数u为中心左右完全对称的分布,记为X~N(u, ) 标准正态分布:以均数为0,标准差为1的正态分布,记为u~N(0,1) 3.平均数:也叫平均值,是一组(群)数据典型或有代表性的值。这个值趋向于落在根据数据大小排列的数据的中心,包括算术平均数、几何平均数、中位数等。 标准差S:将方差开方,得到标准差,它是最常用的变异指标,标准差越大,说明数据的变异程度越大。 标准误S X:在统计理论上将样本统计量的标准差称为标准误,用来衡量均数抽样误差的大小。据此,样本均数的标准差称为标准误。 S p(样本率的标准差):率的标准误,用来描述样本率的抽样误差。 4.参数检验:总体分布已知,对其中一些未知参数进行估计或检验。这类统计推断的方法叫参数统计或参数检验。 参数检验:假定比较数据服从某分布,通过参数的估计量( , s)对比较总体的参数(μ)作检验,统计上称为参数法检验(parametric test)。如t、u检验、方差分析。 非参数检验:是指在统计检验中不需要假定总体分布形式和用参数估计量,直接对比较数据的分布进行统计检验的方法,称为非参数检验(nonparametric test). 5.率(rate):强度相对数,用以说明某现象发生的频率或强度。是某事物或现象发生的实际数与可能数的比例关系。 构成比(proportion):结构相对数,它说明一种事物内部各组成部分所占的比重或分布,常以百分数表示,其计算公式为: 比(ratio):又称相对比,是A、B两个有关指标之比,说明A为B的若干倍或百分之几,它是对比的最简单形式。其计算公式为:比=A/B。 6.相关系数:用以说明具有直线关系的两个变量间相关关系的密切程度和相关方向的指标,称为相关系数,又称为积差相关系数。 复相关系数:是决定系数的平方根,相对系数的绝对值,用来度量应变量与多个自变量间的线性相关程度。 决定系数:是反映回归贡献相对程度的指标,是回归平方和与总体平方和之比。无单位,取值在0到1之间。 回归系数:直线回归方程= a+bX的系数b称为回归系数,也就是回归直线的斜率(slope),表示X 每增加一个单位,Y平均改变 b 个单位。 偏回归系数:是多元线性回归方程中的各个自变量的回归系数。 标准偏回归系数:将原始数据实施标准化变换后的直线回归方程中的偏回归系数,反映各变量对因变量的贡献大小。 零相关:指两个变量间没有直线相关的关系。 7. 统计描述:指选用恰当的统计指标,选用合适的统计表和统计图,对资料的数量特征及其分布规律进行测定和描述。 统计推断:从总体中随机抽取一定含量的样本进行研究,目的是通过样本的信息判断总体的特征,这一过程称为统计推断。 8.X检验:以卡方分布为理论依据,用途颇广的假设检验方法。 秩和检验:推断一个总体表达分布位置的中位数M和已知M0,两个或多个总体的分布是否有差别。 9.生存率:是指接受某种治疗的病人或患某病的病人中,经若干年的随访后,尚存活的病人数所占的比例。

统计学名词解释

统计学名词解释 1试验方案(Experimental project) 试验方案就是根据试验目的和要求所拟进行比较的一组试验处理(Experimental treatment)的总称。 2效应(Effect): 引起试验差异的结果称为试验效应。 3互作(Interaction effect): 指两个或两个以上处理因数间的相互作用产生的效应。 4误差(Error):观察值与其理论值间的差异。 5观察值(Observation):试验或调查结果取得的数据。 6准确性(Accuracy):是指观测值与其理论值间的符合程度。 7精确性(Precision):是指观测值间的符合程度。 8重复(Replication): 重复的作用是估计试验误差,降低试验误差,提高试验的精确度。 9随机排列(Random assortment) : 随机排列的目的是每个处理有相同的处理效应,避免人为因数对处理结果的影响。 10局部控制(Local control) 尽可能将各个处理放置于同一环境条件下。 11总体(Population): 具有共同性质的所有个体所组成的集团。 12观察值(Observation):每一个体的某一性状、特性的测定数值。 13变数(Variable):所有观察值的集合。 14变量(Variable):变数中的每一成员称为变量。 15随机变量(Random variable): 总体内个体间尽管属性相同但仍然受一些随机因数的影响造成观察值或表现上的差异。 16参数(Parameter): 由总体的全部观察值计算而的总体特征数。例如总体平均数μ、总体方差σ2。17统计数(Statistic): 由样本中各个体观察值计算而得的样本特征数。例如样本平均数x、样本方差s。18随机变量(Random variable) 随机变量是指随机试验中(变数)所取的某一个实数值。或随机试验中被测定的量。 19二项总体(Binary population) 间断性随机变数,其总体中只包含两项结果所构成的总体称为二项总体(Binary population)。其特征:P+q=1 20二项式分布(Binomial distribution) 二项式概率分布简称二项式分布(Binomial distribution) 21显著水平(Significance level): 用来测验假设的概率标准5%或1%等,称为显著水平。 22统计假设Statistical assumption :假设与试验结果相符的可能性大,就接受该假设;反亦反。 23参数估计就是根据所获得的样本观察资料,计算样本指标,对所

机器学习kmeans聚类算法与应用

机器学习算法day02_Kmeans聚类算法及应用课程大纲 Kmeans聚类算法原理Kmeans聚类算法概述 Kmeans聚类算法图示 Kmeans聚类算法要点 Kmeans聚类算法案例需求 用Numpy手动实现 用Scikili机器学习算法库实现 Kmeans聚类算法补充算法缺点 改良思路 课程目标: 1、理解Kmeans聚类算法的核心思想 2、理解Kmeans聚类算法的代码实现 3、掌握Kmeans聚类算法的应用步骤:数据处理、建模、运算和结果判定

1. Kmeans聚类算法原理 1.1 概述 K-means算法是集简单和经典于一身的基于距离的聚类算法 采用距离作为相似性的评价指标,即认为两个对象的距离越近,其相似度就越大。 该算法认为类簇是由距离靠近的对象组成的,因此把得到紧凑且独立的簇作为最终目标。 1.2 算法图示 假设我们的n个样本点分布在图中所示的二维空间。 从数据点的大致形状可以看出它们大致聚为三个cluster,其中两个紧凑一些,剩下那个松散一些,如图所示: 我们的目的是为这些数据分组,以便能区分出属于不同的簇的数据,给它们标上不同的颜色,如图:

1.3 算法要点 1.3.1 核心思想 通过迭代寻找k个类簇的一种划分方案,使得用这k个类簇的均值来代表相应各类样本时所得的总体误差最小。 k个聚类具有以下特点:各聚类本身尽可能的紧凑,而各聚类之间尽可能的分开。 k-means算法的基础是最小误差平方和准则, 其代价函数是: 式中,μc(i)表示第i个聚类的均值。 各类簇内的样本越相似,其与该类均值间的误差平方越小,对所有类所得到的误差平方求和,即可验证分为k类时,各聚类是否是最优的。 上式的代价函数无法用解析的方法最小化,只能有迭代的方法。 1.3.2 算法步骤图解 下图展示了对n个样本点进行K-means聚类的效果,这里k取2。

单元统计cell statistic详解

一单元统计 当进行多层面栅格数据叠合分析时,经常需要以栅格单元为单位来进行单元统计(Cell Statistics)分析。ArcGIS 的单元统计分析功能提供了十种单元统计方法,分别为: 1. Minimum:找出各单元上出现最小的数值; 2. Maximum:找出各单元上出现最大的数值; 3. Range:统计各单元上出现数值的范围; 4. Sum:计算各单元上出现数值的和; 5. Mean:计算各单元上出现数值的平均数; 6. Standard Deviation:计算各单元上出现数值的标准差; 7. Variety:找出各单元上不同数值的个数; 8. Majority:统计各单元上出现频率最高的数值; 9. Minority:统计各单元上出现频率最低的数值; 10. Median:计算各单元上出现数值的中值; 如下图1 中的一组表格所示,表格中每一格子代表一个栅格单元,最后一个表格是基于前两个表格进行单元统计的最小值统计得到的结果。即将前两个表格中相对应栅格数值进行比较,找出各单元上出现的最小数值。 图1 最小值单元统计 单元统计功能常用于同一地区多时相数据的统计,通过单元统计得出所需分析数据。例如,同一地区不同年份的人口分析,同一地区不同年份的土地利用类型分析等。 单元统计的操作过程如下,图2 所示: 1. Spatial Analyst 下拉菜单中选择Cell Statistics; 2. 在Layer 列表框中选择你要用来计算的图层,在列表框中选择一个图层,点击Add 按钮将其加入Input rasters 列表框(也可用Browse 按钮从磁盘中选择要使用的栅格数据); 3. 在Overlay statistic 栏中选择你用来对输入图层进行计算的统计类型; 4. 为输出结果指定目录及名称; 5. 点击OK 按钮。

聚类分析K-means算法综述

聚类分析K-means算法综述 摘要:介绍K-means聚类算法的概念,初步了解算法的基本步骤,通过对算法缺点的分析,对算法已有的优化方法进行简单分析,以及对算法的应用领域、算法未来的研究方向及应用发展趋势作恰当的介绍。 关键词:K-means聚类算法基本步骤优化方法应用领域研究方向应用发展趋势 算法概述 K-means聚类算法是一种基于质心的划分方法,输入聚类个数k,以及包含n个数据对象的数据库,输出满足方差最小标准的k个聚类。 评定标准:同一聚类中的对象相似度较高;而不同聚类中的对象相似度较小。聚类相似度是利用各聚类中对象的均值所获得一个“中心对象”(引力中心)来进行计算。 解释:基于质心的划分方法就是将簇中的所有对象的平均值看做簇的质心,然后根据一个数据对象与簇质心的距离,再将该对象赋予最近的簇。 k-means 算法基本步骤 (1)从n个数据对象任意选择k 个对象作为初始聚类中心 (2)根据每个聚类对象的均值(中心对象),计算每个对象与这些中心对象的距离;并根据最小距离重新对相应对象进行划分 (3)重新计算每个(有变化)聚类的均值(中心对象) (4)计算标准测度函数,当满足一定条件,如函数收敛时,则算法终止;如果条件不满足则回到步骤(2) 形式化描述 输入:数据集D,划分簇的个数k 输出:k个簇的集合 (1)从数据集D中任意选择k个对象作为初始簇的中心; (2)Repeat (3)For数据集D中每个对象P do (4)计算对象P到k个簇中心的距离 (5)将对象P指派到与其最近(距离最短)的簇;

(6)End For (7)计算每个簇中对象的均值,作为新的簇的中心; (8)Until k个簇的簇中心不再发生变化 对算法已有优化方法的分析 (1)K-means算法中聚类个数K需要预先给定 这个K值的选定是非常难以估计的,很多时候,我们事先并不知道给定的数据集应该分成多少个类别才最合适,这也是K一means算法的一个不足"有的算法是通过类的自动合并和分裂得到较为合理的类型数目k,例如Is0DAIA算法"关于K一means算法中聚类数目K 值的确定,在文献中,根据了方差分析理论,应用混合F统计量来确定最佳分类数,并应用了模糊划分嫡来验证最佳分类数的正确性。在文献中,使用了一种结合全协方差矩阵RPCL算法,并逐步删除那些只包含少量训练数据的类。文献中针对“聚类的有效性问题”提出武汉理工大学硕士学位论文了一种新的有效性指标:V(k km) = Intra(k) + Inter(k) / Inter(k max),其中k max是可聚类的最大数目,目的是选择最佳聚类个数使得有效性指标达到最小。文献中使用的是一种称为次胜者受罚的竞争学习规则来自动决定类的适当数目"它的思想是:对每个输入而言不仅竞争获胜单元的权值被修正以适应输入值,而且对次胜单元采用惩罚的方法使之远离输入值。 (2)算法对初始值的选取依赖性极大以及算法常陷入局部极小解 不同的初始值,结果往往不同。K-means算法首先随机地选取k个点作为初始聚类种子,再利用迭代的重定位技术直到算法收敛。因此,初值的不同可能导致算法聚类效果的不稳定,并且,K-means算法常采用误差平方和准则函数作为聚类准则函数(目标函数)。目标函数往往存在很多个局部极小值,只有一个属于全局最小,由于算法每次开始选取的初始聚类中心落入非凸函数曲面的“位置”往往偏离全局最优解的搜索范围,因此通过迭代运算,目标函数常常达到局部最小,得不到全局最小。对于这个问题的解决,许多算法采用遗传算法(GA),例如文献中采用遗传算法GA进行初始化,以内部聚类准则作为评价指标。 (3)从K-means算法框架可以看出,该算法需要不断地进行样本分类调整,不断地计算调整后的新的聚类中心,因此当数据量非常大时,算法的时间开销是非常大 所以需要对算法的时间复杂度进行分析,改进提高算法应用范围。在文献中从该算法的时间复杂度进行分析考虑,通过一定的相似性准则来去掉聚类中心的候选集,而在文献中,使用的K-meanS算法是对样本数据进行聚类。无论是初始点的选择还是一次迭代完成时对数据的调整,都是建立在随机选取的样本数据的基础之上,这样可以提高算法的收敛速度。

statistic terms

第一章数据分析:描述图形和从图形出収 Association 相关 Bar chart 条形图 Bivariate data 双变量 Boxplot 盒式图 Center 中心值 包括

mean 平均值 median 中位数 Conditional probability 条件概率 Continuous data 连续数据,取自某个区间 Continuous random variable 连续随机变量 Correlation coefficient 相关系数,表征定量数据间的线性相关程度Correlation is not causation

相关关系不意味着因果关系 Discrete data 离散数据 Discrete random variable 离散随机变量 Dotplot 点图 First quartile 第一四分位秩(下四分位秩) Five(5)-number summary5 数值方法,即 min value,Q1,median,Q3,max value Histogram

直方图 Inter quartile range 四分位距 Least-squares regression line 最小二乘回归线 Line of best fit 最佳拟合线 Marginal and joint frequencies (双向表中的)边际频数和联合频数 Mean 平均值 Median 中位数

Mode 众数 分布中最常出现的值 bell-shaped 钟形 数据分布形式 Negatively associated 负相关 Outlier 极端值 Percentile rank 百分位秩

数据挖掘报告-Kmeans算法

数据挖掘课程报告 班级 XXXXXX 学生姓名 XXXXXX 学号 2010100XXXXX 指导教师 XXXXXXX 日期 2013年10月15日

k-means 算法与猫群算法的聚类效果比较分析 摘要:本文在聚类个数k 值预先设定的前提下,分别应用了k-means 算法、猫群算法对储层含油性问题进行聚类分析,比较了这两种算法的聚类效果。实验结果显示:本文所采用的传统的k-means 算法常容易陷入局部最优。而猫群算法在样本数目较小时(如以表oilsk81为例时),是一种快速、高效的识别算法。当样本数目翻倍时,受实际算法代码设计的影响,识别的正确率将会下降,这也充分说明了猫群算法的运算效果受代码和样本大小的影响,有较大的不确定性。 关键词:k-means ;猫群算法;聚类分析; 1 引言 K-means 算法[1]是由J.B. Mac Queen 于1967 年提出的,该算法是一个经典的基于划分的聚类算法,因其算法效率较高,易于其它方法相结合,目前已成为数据挖掘、机器学习、模式识别和数量统计等领域应用最广的聚类算法之一。 近几年来提出了很多的群体智能算法,这些算法都是通过模仿生物界中某些动物的行为演化出来的智能算法[2]。猫群算法作为群体智能算法之一,具有良好的局部搜索和全局搜索能力[3],算法控制参数较少,通过两种模式的结合搜索,大大的提高了搜索优良解的可能性和搜索效率,较其他算法较容易实现,收敛速度快,具有较高的运算速度,易于其他算法结合。但也有出现“早熟”现象的弊端[4]。群体中个体的优化只是根据一些表层的信息,即只是通过适应度值来判断个体的好坏,缺乏深层次的理论分析和综合因素的考虑。由于猫群算法出现较晚,该算法目前主要应用于函数优化问题[5],故在聚类分析研究方面,很有必要对猫群算法进行深入研究。 传统的k-means 算法与新兴的聚类方法猫群算法相比较会有哪些异同点呢,接下来将具体阐述。 2 算法模型 2.1 K-means 算法模型 设对n 个m 维样本集进行聚类,n 个样本集表示为12{,,,}n X X X X = ,其中 12(,,,)i i i im X x x x = ,聚类成k 个分类表示为12{,,}k C C C C = ,其质心表示为1 ,1,2,....j j i x C j z X j k n ∈= =∑, j n 为 j C 中包含的数据点的个数,则聚类的目标是使k 个类满 足以下条件:

statistics的用法总结大全

statistics的用法总结大全 想了解statistics的用法吗?今天小编就给大家带来了statistics的用法,希望能够帮助到大家,下面小编就和大家分享,来欣赏一下吧。 statistics的用法总结大全 statistics的意思 n. 统计,统计学,统计法,统计资料,统计数字,“statistic”的复数 statistics用法 statistics可以用作名词 statistics作“统计资料,统计数字”解用作主语时,谓语动词常用复数形式。作“统计学”解用作主语时,谓语动词用单数形式。 statistics用作名词的用法例句 He is a professor of statistics.他教授统计学。 There is a compulsory course in statistics.有一门统计学的必修课。 Get me a printout of the statistics.给我一份打印出的统计资料。 statistics用法例句 1、The degree provides a thorough grounding in both mathematics and statistics.该学位课程将为数学和统计学打下扎实的基础。 2、A close look at the statistics reveals a troubling picture. 仔细看过统计数据后,会发现情况令人担忧。 3、Their governments have no reason to "massage" the statistics. 他们的政府没有理由“窜改”这些数据。 correlational statistics的中文翻译及用法 phr. 相关,关联;相互关系 英语解释 · a statistical relation between two or more variables such that systematic changes in the value of one variable are accompanied by systematic changes in the other 相似短语 · correlational statistics phr. 相关,关联;相互关系 · correlational analysis phr. 因素相关性分析

统计学名词解释

名词解释: 医学统计学:用统计学的原理和方法研究生物医学问题的一门学科。 变量(variable):观察单位的某项特征 变量值(value of variable):变量的观察结果(测量值) 总体(population):是根据研究目的确定的同质的观察单位的全体,确切的说是同质的所有的观察单位某种变量值的集合。 样本(sample)从总体中随机抽取部分由代表性的观察单位,其测量值的集合称为样本。 随机抽样(random sample):按随机化原则从总体中抽取部分观察单位的过程。 同质(homogeneity):是针对被研究指标来讲,其影响因素相同。简单地理解就是指对研究指标影响大约可以控制的主要因素应尽可能相同。 变异(variation):指在自然地状态下,个体测量结果在同质基础上的差异。 等级资料(ordinal data):将观察单位按测量结果的某种属性的不同程度分组,所得各组的观察单位称为等级资料,如患者的治疗结果可分为治愈,好转,有效,无效,死亡。有序变量(定性变量的一种)。 概率(probability):是度量某一随机事件A发生可能性大小的一个数值,记为P(A),P(A)越大,说明A事件发生的可能性越大,0 matlab实现Kmeans聚类算法 1.简介: Kmeans和应用于混合高斯模型的受限EM算法是一致的。高斯混合模型广泛用于数据挖掘、模式识别、机器学习、统计分析。Kmeans 的迭代步骤可以看成E步和M步,E:固定参数类别中心向量重新标记样本,M:固定均值只考虑(估计)了均值,而没有估计类别的方差,所以聚类的结构比较适合于特征协方差相等的类别。 Kmeans在某种程度也可以看成Meanshitf的特殊版本,Meanshift 是所以Meanshift可以用于寻找数据的多个模态(类别),利用的是梯度上升法。在06年的一篇CVPR文章上,证明了Meanshift方法是牛顿拉夫逊算法的变种。Kmeans和EM算法相似是指混合密度的形式已知(参数形式已知)情况下,利用迭代方法,在参数空间中搜索解。而Kmeans和Meanshift相似是指都是一种概率密度梯度估计的方法,不过是Kmean选用的是特殊的核函数(uniform kernel),而与混合概率密度形式是否已知无关,是一种梯度求解方式。 k-means是一种聚类算法,这种算法是依赖于点的邻域来决定哪些点应该分在点,也可以对高维的空间(3维,4维,等等)的点进行聚类,任意高维的空间都可以。 上图中的彩色部分是一些二维空间点。上图中已经把这些点分组了,并使用了不同的颜色对各组进行了标记。这就是聚类算法要做的事情。 这个算法的输入是: 1:点的数据(这里并不一定指的是坐标,其实可以说是向量) 2:K,聚类中心的个数(即要把这一堆数据分成几组) 所以,在处理之前,你先要决定将要把这一堆数据分成几组,即聚成几类。但并不是在所有情况下,你都事先就能知道需要把数据聚成几类的。意味着使用k-means就不能处理这种情况,下文中会有讲解。 把相应的输入数据,传入k-means算法后,当k-means算法运行完后,该算法的输出是: 1:标签(每一个点都有一个标签,因为最终任何一个点,总会被分到某个类,类的id号就是标签) 2:每个类的中心点。 标签,是表示某个点是被分到哪个类了。例如,在上图中,实际上有4中“标签”,每个“标签”使用不同的颜色来表示。所有黄色点我们可以用标签以看出,有3个类离的比较远,有两个类离得比较近,几乎要混合在一起了。 当然,数据集不一定是坐标,假如你要对彩色图像进行聚类,那么你的向量就可以是(b,g,r),如果使用的是hsv颜色空间,那还可以使用(h,s,v),当然肯定可以有不同的组合例如(b*b,g*r,r*b) ,(h*b,s*g,v*v)等等。 在本文中,初始的类的中心点是随机产生的。如上图的红色点所示,是本文随机产生的初始点。注意观察那两个离得比较近的类,它们几乎要混合在一起,看看算法是如何将它们分开的。 类的初始中心点是随机产生的。算法会不断迭代来矫正这些中心点,并最终得到比较靠5个中心点的距离,选出一个距离最小的(例如该点与第2个中心点的距离是5个距离中最小的),那么该点就归属于该类.上图是点的归类结果示意图. 经过步骤3后,每一个中心center(i)点都有它的”管辖范围”,由于这个中心点不一定是这个管辖范围的真正中心点,所以要重新计算中心点,计算的方法有很多种,最简单的一种是,直接计算该管辖范围内所有点的均值,做为心的中心点new_center(i). 如果重新计算的中心点new_center(i)与原来的中心点center(i)的距离大于一定的阈值(该阈值可以设定),那么认为算法尚未收敛,使用new_center(i)代替center(i)(如图,中心点从红色点 1发展过程 统计在金融上应用广泛 统计学的英文statistics最早源于现代拉丁文statisticum collegium(国会) 以及意大利文statista(国民或政治家)。德文Statistik,最早是由Gottfried Achenwall于1749年使用,代表对国家的资料进行分析的学问,也就是“研 究国家的科学”。在十九世纪统计学在广泛的数据以及资料中探究其意义,并 且由John Sinclair引进到英语世界。 统计学是一门很古老的科学,一般认为其学理研究始于古希腊的亚里斯多德时代,迄今已有两千三百多年的历史。它起源于研究社会经济问题,在两千多年 的发展过程中,统计学至少经历了“城邦政情”,“政治算数”和“统计分析 科学”三个发展阶段。所谓“数理统计”并非独立于统计学的新学科,确切地说:它是统计学在第三个发展阶段所形成的所有收集和分析数据的新方法的一 个综合性名词。概率论是数理统计方法的理论基础,但是它不属于统计学的范畴,而属于数学的范畴。 城邦政情 “城邦政情”(Matters of state)阶段始于古希腊的亚里斯多德撰写“城邦政情”或“城邦纪要”。他一共撰写了一百五十馀种纪要,其内容包括各城邦的 历史、行政、科学、艺术、人口、资源和财富等社会和经济情况的比较、分析,具有社会科学特点。“城邦政情”式的统计研究延续了一两千年,直至十七世 纪中叶才逐渐被“政治算数”这个名词所替代,并且很快被演化为“统计学”(Statistics)。统计学依然保留了城邦(state)这个词根。 政治算术 威廉·配第 与“城邦政情”阶段没有很明显的分界点,本质的差别也不大。 “政治算术”的特点是统计方法与数学计算和推理方法开始结合。分析社会经济问题的方式更加注重运用定量分析方法。 1690年英国威廉·配弟出版《政治算数》一书作为这个阶段的起始标志。 威廉·配第用数字,重量和尺度将社会经济现象数量化的方法是近代统计学的重要特征。因此,威廉·配第的《政治算术》被后来的学者评价为近代统计学的来源,威廉·配第本人也被评价为近代统计学之父。 配第在书中使用的数字有三类: 第一类是对社会经济现象进行统计调查和经验观察得到的数字.因为受历史条件的限制,书中通过严格的统计调查得到的数据少,根据经验得出的数字多; 第二类是运用某种数学方法推算出来的数字。其推算方法可分为三种: 平均数为基础进行推算的方法”; 第三类是为了进行理论性推理而采用的例示性的数字。配第把这种运用数字和符号进行的推理称之为“代数的算法”。从配第使用数据的方法看,“政治算数”阶段的统计学已经比较明显地体现了“收集和分析数据的科学和艺术”特点,统计实证方法和理论分析方法浑然一体,这种方法即使是现代统计学也依然继承。[1] 统计分析科学 在“政治算术”阶段出现的统计与数学的结合趋势逐渐发展形成了“统计分析科学”。 十九世纪末,欧洲大学开设的“国情纪要”或“政治算数”等课程名称逐渐消失,代之而起的是“统计分析科学”课程。当时的“统计分析科学”(Science of statistical analysis)课程的内容仍然是分析研究社会经济问题。matlab实现Kmeans聚类算法

统计学 - 发展过程