谁说菜鸟不会数据分析(入门篇)笔记5.2数据分析工具-5多选题分析

谁说菜鸟不会数据分析(入门篇)

5.2数据分析工具

5.2.5多选题分析

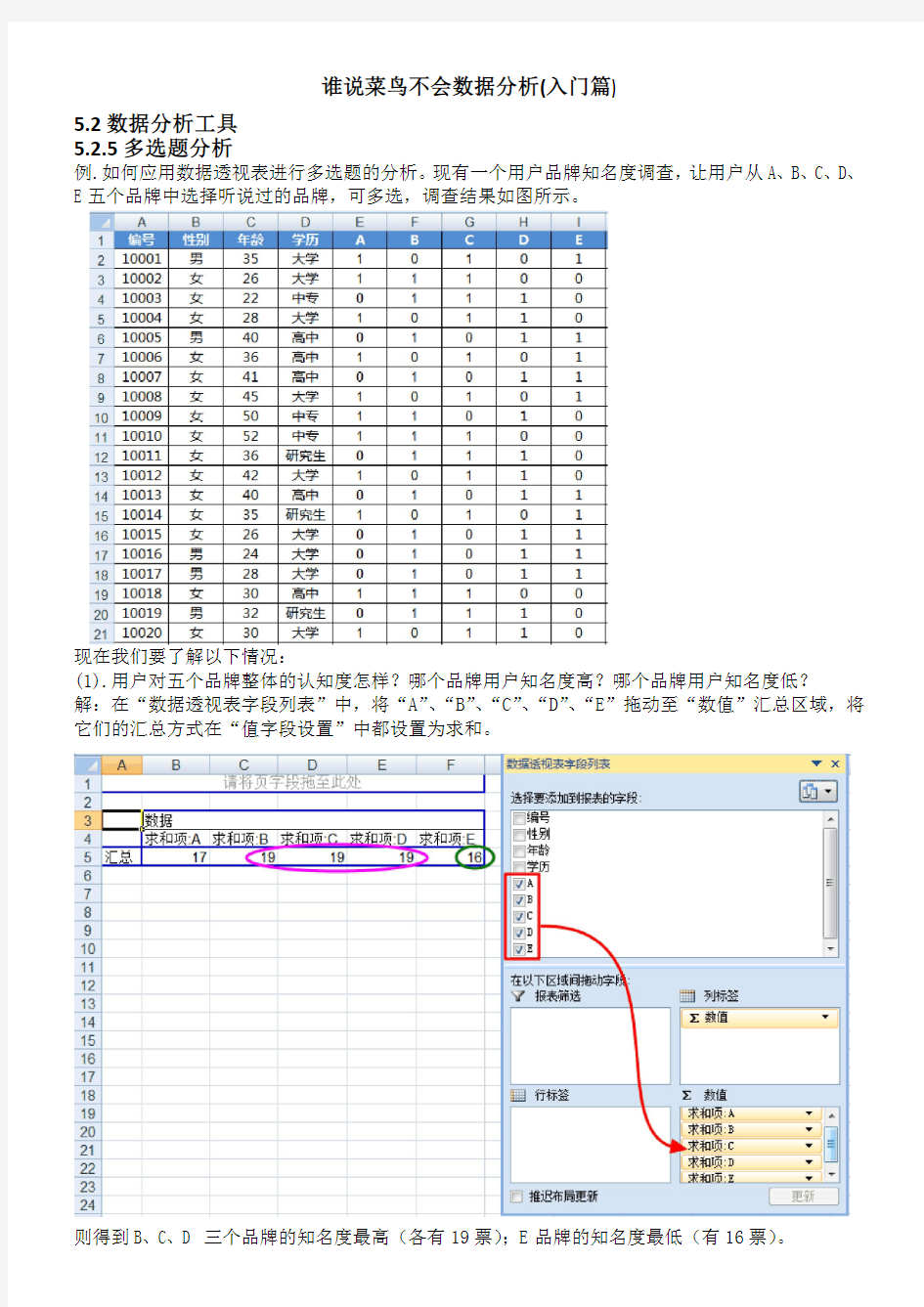

例.如何应用数据透视表进行多选题的分析。现有一个用户品牌知名度调查,让用户从A、B、C、D、E五个品牌中选择听说过的品牌,可多选,调查结果如图所示。

现在我们要了解以下情况:

(1).用户对五个品牌整体的认知度怎样?哪个品牌用户知名度高?哪个品牌用户知名度低? 解:在“数据透视表字段列表”中,将“A”、“B”、“C”、“D”、“E”拖动至“数值”汇总区域,将它们的汇总方式在“值字段设置”中都设置为求和。

则得到B、C、D三个品牌的知名度最高(各有19票);E品牌的知名度最低(有16票)。

(2).不同性别的用户对品牌的认知度是否有差异?

解:在“数据透视表字段列表”中,将“性别”拖动至“行标签”区域;将“A”、“B”、“C”、“D”、“E”拖动至“数值”汇总区域,将它们的汇总方式在“值字段设置”中都设置为求和。

则得到在男性用户中B、D、E 三个品牌的知名度相对较高(分别有7票、7票、6票);在女性用户中A、C 两个品牌的知名度相对较高(分别有15票、17票)。

(3).不同年龄段的用户对品牌的认知度是否有差异?

解:新增一个“年龄段”分组字段,利用VLOOKUP 函数根据“年龄”字段进行年龄段的分组。 =VLOOKUP(C4,$L$1:$M$4,2)中省略了range_lookup ,即默认为近似匹配。

意思为:在L 列中查找最接近单元格C4,但又不能大于单元格C4的值(即L 列≤C4的值),然后返回查找区域L1:M4中第二列的值(即M 列中的值)。

例:单元格C4(=22),阈值中符合要求的为单元格L2(=0)(即L2≤C4),则返回对应的单元格M2的值(即青年)。

在“数据透视表字段列表”中,将“年龄段”拖动至“行标签”区域;将“A”、“B”、“C”、“D”、“E”拖动至“数值”汇总区域,将它们的汇总方式在“值字段设置”中都设置为求和。

则得到在老年用户中A、B两个品牌的知名度相对较高(各有4票);在青年用户中B、D、E三个品牌的知名度相对较高(各有7票);在中年用户中C品牌的知名度相对较高(有12票)。

(4).不同学历的用户对品牌的认知度是否有差异?

解:在“数据透视表字段列表”中,将“学历”拖动至“行标签”区域;将“A”、“B”、“C”、“D”、“E”拖动至“数值”汇总区域,将它们的汇总方式在“值字段设置”中都设置为求和。

则得到在不同学历人群间,各品牌知名度的差异较不明显。

丁璐璐-英雄联盟网络游戏的营销策略分析资料

丁璐璐-英雄联盟网络游戏的营销策略分析

沈阳工学院 学年论文 题目:英雄联盟网络游戏的营销策略分析 学院:经济与管理学院 专业:市场营销 学号: 1520110537 学生姓名:丁璐璐 指导教师:董乃群 2017年1月6日

摘要 随着中国互联网络游戏产业的出现和发展,游戏行业这些年来也不断的变化更新中。网络游戏这个产业从初步发展到现在的蓬勃发展,这都归结于网络游戏行业资金得到迅速聚集,高利润使得许多竞争者大量研发新型、大型网络游戏,以及用户的成倍增长这些因素共同促进而成。 《英雄联盟》(简称LOL)是由美国拳头游戏(Riot Games)开发、中国大陆游戏代理运营的英雄对战MOBA竞技网游。游戏里拥有数百个个性英雄,并拥有排位系统、天赋系统、符文系统等特色养成系统。《英雄联盟》还致力于推动全球电子竞技的发展,除了联动各赛区发展职业联赛,每年还会举办“季中冠军赛”“全球总决赛”“All Star全明星赛”三大世界级赛事,获得了亿万玩家的喜爱,形成了自己独有的电子竞技文化。 本文主要分为六个部分。第一部写了研究的背景以及意义;第二部分主要写了英雄联盟的游戏规模、营销策略和存在问题;第三部分写了英雄联盟的竞争环境和SWOT分析;第四部分为英雄联盟的优化策略;第五部分为英雄联盟的 4P策略;第六部分是结论。 关键词:英雄联盟;营销策略;LOL

目录 摘要............................................................Ⅰ 目录............................................................Ⅱ 绪论............................................................1 1英雄联盟营销现状...............................................3 1.1英雄联盟的游戏规模.........................................3 1.2英雄联盟的营销策略.........................................4 1.3英雄联盟营销存在问题.......................................7 2英雄联盟竞争分析...............................................7 2.1英雄联盟的竞争环境.........................................7 2.2英雄联盟的SWOT分析....................................16

一个案例说清楚如何进行数据分析

案例研究:全球创新网络和分析(GINA) EMC 全球创新网络和分析(GINA)团队由一群在EMC 全球各地卓越中心(COE)工作的高级技术专家构成。这个团队的宗旨是吸引全球卓越中心(COE)员工来从事创新、研究和大学的合作伙伴关系。在2012 年,新任职的团队总监想加强这些活动,并建立一个机制来追踪和分析相关信息。此外,GINA 团队想要创建更加健壮的机制来记录他们与EMC 内部、学术界或者其他组织机构的思想领袖的非正式对话,用来在日后发掘洞见 GINA 团队想要提供一种在全球范围内分享想法,以及在地理上相互远离的GINA 成员之间分享知识的手段。它们计划创建一个包含结构化和非结构化数据的存储库,用于实现下面三个主要目标。 ●存储正式和非正式的数据。 ●追踪全球技术专家的研究。 ●挖掘数据模式和洞察力,以提高团队的运营和战略。 GINA 的案例研究展示了一个团队如何应用数据分析生命周期在EMC 内分析创新数据。创新通常难以评估,该团队想要使用高级分析方法在公司内部识别关键创新者。 第1 阶段:发现 在GINA 项目的发现阶段,团队开始确定数据源。虽然GINA 由一群掌握许多不同技能的技术专家组成,他们对想要探索的领域有一些相关数据和想法,但缺少一个正式的团队来执行这些分析。在咨询了包括巴布森学院(Babson College)的知名分析专家Tom Davenport、麻省理工学院集体智慧专家兼协同创新网络(CoIN,Collaborative Innovation Networks)创始人PeterGloor 等专家后,团队决定在EMC 内部寻找志愿者来众包工作。 团队中的各种角色如下所示。 ●业务人员、项目发起人、项目经理:来自于首席技术官办公室的副总裁。 ●商业智能分析师:来自于IT 部门的代表。 ●数据工程师和数据库管理员(DBA)):来自于IT 部门的代表。 ●数据科学家:EMC 杰出工程师,他还开发了GINA 案例研究中的社交图谱。 项目发起人想要利用社交媒体和博客[26]来加速全球创新和研究数据的收集,并激励世界范围内的数据科学家“志愿者”团队。鉴于项目发起人缺少一个正式的团队,他需要想办法找到既有能力有愿意花时间来解决问题的人。数据科学家们往往热衷于数据,项目发起人依靠这些人才的激情富有创新地完成了工作挑战。 该项目的数据主要分为两大类。第一类是近 5 年EMC 内部创新竞赛,被称为创新线路图(以前称为创新展示),提交的创新想法。创新线路图是一个正式的、有机的创新过程,来自世界各地的员工提交创新想法,然后被审查和评判。最好的想法被选择出来进行孵化。因此,创新线路图的数据是结构化数据和非结构化数据的混合,结构化数据包括创新想法的数量、提交日期和提交者,非结构化数据包括该创新想法的文本描述。 该项目的数据主要分为两大类。第一类是近 5 年EMC 内部创新竞赛,被称为创新线路图(以前称为创新展示),提交的创新想法。创新线路图是一个正式的、有机的创新过程,来自世界各地的员工提交创新想法,然后被审查和评判。最好的想法被选择出来进行孵化。因此,创新线路图的数据是结构化数据和非结构化数据的混合,结构化数据包括创新想法的数量、提交日期和提交者,非结构化数据包括该创新想法的文本描述。 第二类数据包括来自世界各地创新和研究活动的备忘录和笔记。这些数据也包括结构化数据和非结构化数据。结构化数据包括日期、名称、地理位置等属性。非结构化数据包括“谁、

《利用python进行数据分析》读书笔记

《利用python进行数据分析》读书笔记 pandas是本书后续内容的首选库。pandas可以满足以下需求:具备按轴自动或显式数据对齐功能的数据结构。这可以防止许多由于数据未对齐以及来自不同数据源(索引方式不同)的数据而导致的常见错误。. 集成时间序列功能既能处理时间序列数据也能处理非时间序列数据的数据结 构数学运算和简约(比如对某个轴求和)可以根据不同的元数据(轴编号)执行灵活处理缺失数据合并及其他出现在常见数据库(例如基于SQL的)中的关系型运算1、pandas数据结构介绍两个数据结构:Series和DataFrame。Series是一种类似于以为NumPy数组的对象,它由一组数据(各种NumPy数据类型)和与之相关的一组数据标签(即索引)组成的。可以用index和values分别规定索引和值。如果不规定索引,会自动创建0 到N-1 索引。#-*- encoding:utf-8 -*- import numpy as np import pandas as pd from pandas import Series,DataFrame #Series可以设置index,有点像字典,用index索引 obj = Series([1,2,3],index=['a','b','c'])

#print obj['a'] #也就是说,可以用字典直接创建Series dic = dict(key = ['a','b','c'],value = [1,2,3]) dic = Series(dic) #下面注意可以利用一个字符串更新键值 key1 = ['a','b','c','d'] #注意下面的语句可以将Series 对象中的值提取出来,不过要知道的字典是不能这么做提取的 dic1 = Series(obj,index = key1) #print dic #print dic1 #isnull 和notnull 是用来检测缺失数据 #print pd.isnull(dic1) #Series很重要的功能就是按照键值自动对齐功能 dic2 = Series([10,20,30,40],index = ['a','b','c','e']) #print dic1 + dic2 #name属性,可以起名字 https://www.360docs.net/doc/1912098205.html, = 's1' https://www.360docs.net/doc/1912098205.html, = 'key1' #Series 的索引可以就地修改 dic1.index = ['x','y','z','w']

全平台直播行业白皮书

2018年度全平台直播行业白皮书 致力于服务主播 小葫芦

2017年小葫芦通过海量的主播数据对直播行业做了详细的总结,2018年 小葫芦数据的覆盖量已扩展到了全平台3600万以上的直播间,在各直播平台争相上市,短视频风生水起的一年,小葫芦2018年直播行业白皮书对直播行业有哪些总结? PS:数据全覆盖虎牙、斗鱼、YY、快手、B站、企鹅电竞、熊猫等28家主流平台。 序言

01 OPTION 02 OPTION 03 OPTION 04 OPTION 年度总体数据 2018年度全平台直播行业浅析 主播礼物数据 2018年主播礼物收入究竟如何 主播弹幕数据 2018年主播弹幕文化究竟如何 主播特征数据 2018年主播有意思的特征数据 目 录 页

01.年度总体数据 总体数据对比送礼月度数据弹幕月度数据直播时长数据直播分类情况直播开播频次

总体数据对比 10 20 30 40 50 60 70 80 90 10010 20 30 40 50 60 70 80 90100 1,453,192人87,424,650人21,006,937,229条 35,524年209,725,063人 2,172,030人143,227,648人45,247,211,652条58,937年337,812,960人 新增主播送礼人数弹幕数量直播时长互动人数 2017年 此为2017年全年的直播行业相关数据,整体对比2018年略逊一筹。2018年 此为2018年全年直播行业相关数据,对比2017年占比均有提升。

送礼人数月度数据 2018年送礼总人数 2018年全平台送礼总人数达到惊人的143,227,648,相比2017年87,424,650增幅63%。 后半年送礼人数增加 从7月份开始,2018年后半年参与直播送礼的人数有所增加。 8月,9月送礼人数最多 8月和9月送礼人数居多,寒暑假,依旧是直播的高峰期,学生群体人数众 多。

怎么写好一份数据分析报告

怎么写好一份数据分析报告? 分析报告的输出是是你整个分析过程的成果,是评定一个产品、一个运营事件的定性结论,很可能是产品决策的参考依据,既然这么重要那当然要写好它了。我认为一份好的分析报告,有以下一些要点: 首先,要有一个好的框架,跟盖房子一样,好的分析肯定是有基础有层次,有基础坚实,并且层次明了才能让阅读者一目了然,架构清晰、主次分明才能让别人容易读懂,这样才让人有读下去的欲望; 第二,每个分析都有结论,而且结论一定要明确,如果没有明确的结论那分析就不叫分析了,也失去了他本身的意义,因为你本来就是要去寻找或者印证一个结论才会去做分析的,所以千万不要忘本舍果; 第三,分析结论不要太多要精,如果可以的话一个分析一个最重要的结论就好了,很多时候分析就是发现问题,如果一个一个分析能发现一个重大问题,就达到目的了,不要事事求多,宁要仙桃一口,不要烂杏一筐,精简的结论也容易让阅者接受,减少重要阅者(通常是事务繁多的领导,没有太多时间看那么多)的阅读心理门槛,如果别人看到问题太多,结论太繁,不读下去,一百个结论也等于0; 第四、分析结论一定要基于紧密严禁的数据分析推导过程,不要有猜测性的结论,太主观的东西会没有说服力,如果一个结论连你自己都没有肯定的把握就不要拿出来误导别人了; 第五,好的分析要有很强的可读性,这里是指易读度,每个人都有自己的阅读习惯和思维方式,写东西你总会按照自己的思维逻辑来写,你自己觉得很明白,那是因为整个分析过程是你做的,别人不一定如此了解,要知道阅者往往只会花10分钟以内的时间来阅读,所以要考虑你的分析阅读者是谁?他们最关心什么?你必须站在读者的角度去写分析邮件; 第六,数据分析报告尽量图表化,这其实是第四点的补充,用图表代替大量堆砌的数字会有助于人们更形象更直观地看清楚问题和结论,当然,图表也不要太多,过多的图表一样会让人无所适从; 第七、好的分析报告一定要有逻辑性,通常要遵照:1、发现问题--2、总结问题原因--3、解决问题,这样一个流程,逻辑性强的分析报告也容易让人接受;

【EXCEL】数据分析那些事(菜鸟入门必看)

Q1:我现在的工作有一点数据分析的模块,自从上微薄后了解到还有专门从事数据分析工作,我现在想做这一行,但是经验、能力都还是菜鸟中的菜鸟,请问成为一名数据分析师还有需要哪些准备? A:很简单,我们可以看一下国内知名互联网数据分析师的招聘要求,进行自我对照,即可知道需要做哪些准备。 数据分析师职位要求: 1、计算机、统计学、数学等相关专业本科及以上学历; 2、具有深厚的统计学、数据挖掘知识,熟悉数据仓库和数据挖掘的相关技术,能够熟练地使用SQL; 3、三年以上具有海量数据挖掘、分析相关项目实施的工作经验,参与过较完整的数据采集、整理、分析和建模工作; 4、对商业和业务逻辑敏感,熟悉传统行业数据挖掘背景、了解市场特点及用户需求,有互联网相关行业背景,有网站用户行为研究和文本挖掘经验尤佳; 5、具备良好的逻辑分析能力、组织沟通能力和团队精神; 6、富有创新精神,充满激情,乐于接受挑战。 Q2:对数据分析有浓厚兴趣,希望从事数据分析、市场研究相关工作,但听说对学历要求较高,请问我是否要读研,读研的话应该读哪个方向? A:读研要看自身情况,但可明确:专业不是问题,本科学历就够。关键是兴趣与能力,以及自身的努力,兴趣是学习成长最好的老师! 当然如果是在校生考上研究生的话那是最好,如果考不上可以先工作,等你工作有经验了,你就知道哪方面的知识是自己需要,要考哪方面的研究生,也就更有方向性。 Q3:那么如何培养对数据分析的兴趣呢? A:建议如下: 1、先了解数据分析是神马? 2、了解数据分析有何用?可解决什么问题? 3、可以看看啤酒与尿布等成功数据分析案例; 4、关注数据分析牛人微博,听牛人谈数据分析(参考Q1的三个链接); 5、多思考,亲自动手分析实践,体验查找、解决问题的成就感; 6、用好搜索引擎等工具,有问题就搜索,你会有惊喜发现; 7、可以看看@李开复老师写的《培养兴趣:开拓视野,立定志向》; 有网友说:让数据分析变的有趣的方法是,把自己想象成福尔摩斯,数据背后一定是真相!Q4:我有点迷茫,是练好技能再找工作,还是找一个数据分析助理之类的要求不是特别高的工作,在工作中提升? A:建议在工作中进行学习实践,这才是最好的提升。看那么多书,没有实践都是虚的。 Q5:我是做电商的,对于数据分析这块,您有什么好的软件工具类推荐吗? A:做数据分析首先是熟悉业务及行业知识,其次是分析思路清晰,再次才是方法与工具,切勿为了方法而方法,为工具而工具!不论是EXCEL、SPSS还是SAS,只要能解决问题的工具就是好工具。 问题的高效解决开始于将待解决问题的结构化,然后进行系统的假设和验证。分析框架可以帮助我们:1、以完整的逻辑形式结构化问题;2、把问题分解成相关联的部分并显示它们之间的关系;3、理顺思路、系统描述情形/业务;4、然后洞察什么是造成我们正在解决的问题的原因。

读书笔记|《数据分析思维:分析方法和业务知识》

读书笔记|《数据分析思维:分析方法和业务知识》 ● 笔记 ●第1篇方法 ●第1章业务指标 ●如何理解数据 ●弄清楚每一列的含义 ●对数据进行分类 ●用户数据:我是谁 ●性别 ●年龄 ●地区 ●行为数据:我做了什么 ●点击某个菜单的次数 ●分享量 ●收藏数 ●产品数据:卖什么 ●文章标题 ●日期 ●阅读量 ●常用的指标 ●用户数据指标 ●日新增用户数 ●一个产品如果没有用户增长,,用户就会慢慢减少 ●活跃率 ●= 活跃用户数/总用户数 ●日活跃用户数 ●周活跃用户数 ●月活跃用户数 ●注意:统计人数要去掉重复的数据,同一个人在一个区间里面只计算一次 ●留存率

●= 第1天新增用户中,在第N天使用过产品的用户数/第1天使用过产品的用 户数 ●次日留存率(N=2) ●第7日留存率(N=7) ●第30天留存率(N=30) ●为什么关注留存 ●留存可以评估产品功能对用户的粘性 ●留存低 - 粘性小 - 就要找到用户流失的原因 ●行为数据指标 ●PV - Page View 访问次数 ●UV - Unique View 访问人数 ●转发率 ●= 转发某功能的用户数/看到该功能的用户数 ●转化率 ●店铺转化率= 购买产品的人数/到店铺的人数 ●广告转化率= 点击广告的人数/看到广告的人数 ●K因子 - K factor ●平均每个用户向多少人发出邀请*接收到邀请到人转化为新用户的转化率 ●当K>1时 - 新增用户数就会像雪球一样增大 ●当K<1时 - 新增用户数到某个规模时就会停止通过自传播增长 ●产品数据指标 ●总量 ●成交总量 ●成交数量 ●成交总额GMV - Gross merchandise volume - 流水 ●= 销售额+取消订单金额+拒收订单金额+退货订单金额 ●访问时长 ●人均 ●人均付费(ARPU 或客单价)= 总收入/总用户数 ●ARPU - Average revenue per user ●付费用户人均付费(ARPPU) = 总收入/付费人数

淘宝数据分析怎么做

淘宝数据分析怎么做 除了以上的数据点外,电子商务网站上的日常运营数据还包括网站相关数据、商品相关数据、订单相关数据、客户相关数据和品牌相关数据等等。 不得不做的数据分析 电子商务运营的各个环节都需要以数据为依据,而对于数据我们也需要进行处理。当然,不需要等到所有的数据都准备好了再来做数据分析,可以根据手中有限的数据开始,等有了更多的数据之后,再启用新的方式和算法对新的数据做分析。 1.流量分析 分析流量来源最主要的原因是让我们能够更好地了解自己的潜在客户。要做好用户体验,我们首先就需要了解潜在客户的人群属性、时空属性和兴趣属性,相当于对他们做了背景调查。只有详细了解了访客,我们才能有的放矢。 分析流量的来源特点:流量的来源包括搜索引擎、关键词购买、外部链接和直接访问等。不同的流量都有各自的特点,而因为这些特点,各自的作用也是不尽相同的。 分析访客的时空属性:如果访客时空属性可以和我们网站的商品属性相匹配,那么流量变现的效果会有提升。 分析访客的人群属性:关于访客的信息(包括访客的年龄、性别、学历、收入信息等)可以从大量的网页浏览记录和网络行为中识别出来。关于访客的信息越多,访客网页浏览记录越多,我们对这些人群属性的判断就越精准。如果我们能够准确把握流量来源的人群属性,就可以使得商品的推送更加精准。 分析客户的兴趣属性:通过流量来源的特性分析我们可以对客户的兴趣点有一定分析,从客户的兴趣点出发,我们能更好的推送产品信息。 不过我们要注意对于流量的分析,关于访客的人群属性和兴趣属性的判断对于每个人不是100%准确的。 2.网站分析 如果你的网站相对比较简单,则可以直接采用谷歌分析等网站分析工具来对网站做流量分析。不过如果网站比较复杂,那么我们需要使用构建系统工具通过日志分析来了解网站访问的详细信息。如果能够结合多个网站上的日志分析,我们可以了解客户在进入网站前和进入网站后的行为,从而更加深入了解客户对网站上的商品和内容的兴趣。 因为每个客户的使用习惯是不同的,因而他们对于网站的要求也是不一样的。在做优化页面的时候,我们只能考虑到大多数人员的需求。当然,如果我们能够很清晰地把对页面有特殊要求的人群区分出来,针对他们做特定的优化也是可以的。 网站内容:频繁更新的文章、和商品相关的专题、公司的官方博客以及微博的链接、网站上各个位置的网络分享功能,此外,应当提供便捷的客户沟通工具。 页面跳出率和二跳率:跳出率和二跳率是用来衡量外部流量质量的重要指标。简单来说,跳出率越低越好,而二跳率是越高越好的。

实验设计与数据处理心得

实验设计与数据处理心得体会 刚开始选这门课的时候,我觉得这门课应该就是很难懂的课程,首先我们做过不少的实验了,当然任何自然科学都离不开实验,大多数学科(化工、化学、轻工、材料、环境、医药等)中的概念、原理与规律大多由实验推导与论证的,但我觉得每次到处理数据的时候都很困难,所以我觉得这就是门难懂的课程,却也就是很有必要去学的一门课程,它对于我们工科生来说也就是很有用途的,在以后我们实验的数据处理上有很重要的意义。 如何科学的设计实验,对实验所观测的数据进行分析与处理,获得研究观测对象的变化规律,就是每个需要进行实验的人员需要解决的问题。“实验设计与数据处理”课程就就是就是以概率论数理统计、专业技术知识与实践经验为基础,经济、科学地安排试验,并对试验数据进行计算分析,最终达到减少试验次数、缩短试验周期、迅速找到优化方案的一种科学计算方法。它主要应用于工农业生产与科学研究过程中的科学试验,就是产品设计、质量管理与科学研究的重要工具与方法,也就是一门关于科学实验中实验前的实验设计的理论、知识、方法、技能,以及实验后获得了实验结果,对实验数据进行科学处理的理论、知识、方法与技能的课程。 通过本课程的学习,我掌握了试验数据统计分析的基本原理,并能针对实际问题正确地运用,为将来从事专业科学的研究打下基础。这门课的安排很合理,由简单到复杂、由浅入深的思维发展规律,先讲单因素试验、双因素试验、正交试验、均匀试验设计等常用试验设计

方法及其常规数据处理方法、再讲误差理论、方差分析、回归分析等数据处理的理论知识,最后将得出的方差分析、回归分析等结论与处理方法直接应用到试验设计方法。 比如我对误差理论与误差分析的学习:在实验中,每次针对实验数据总会有误差分析,误差就是进行实验设计与数据评价最关键的一个概念,就是测量结果与真值的接近程度。任何物理量不可能测量的绝对准确,必然存在着测定误差。通过学习,我知道误差分为过失误差,系统误差与随机误差,并理解了她们的定义。另外还有对准确度与精密度的学习,了解了她们之间的关系以及提高准确度的方法等。对误差的学习更有意义的应该就是如何消除误差,首先消除系统误差,可以通过对照试验,空白试验,校准仪器以及对分析结果的校正等方法来消除;其次要减小随机误差,就就是要在消除系统误差的前提下,增加平行测定次数,可以提高平均值的精密度。 比如我对方差分析的理解:方差分析就是实验设计中的重要分析方法,应用非常广泛,它就是将不同因素、不同水平组合下试验数据作为不同总体的样本数据,进行统计分析,找出对实验指标影响大的因素及其影响程度。对于单因素实验的方差分析,主要步骤如下:建立线性统计模型,提出需要检验的假设;总离差平方与的分析与计算;统计分析,列出方差分析表。对于双因素实验的方差分析,分为两种,一种就是无交互作用的方差分析,另一种就是有交互作用的方差分析,对于这两种类型分别有各自的设计方法,但就是总体步骤都与单因素实验的方差分析一样。

python分析英雄联盟

还不会选英雄阵容?python来帮你carry全场 欢迎来到召唤术峡谷~”英雄联盟作为一款长青游戏,风靡了这么多年,2018全球总决赛的IG冠军一出更是引发了众多撸迷又将游戏重新拾起。 今天我们就来分析一下战队的阵容选择会对胜率带来什么样的影响。 1.载入必要的包 import pandas as pd import matplotlib.pyplot as plt import seaborn as sns from pyecharts import Radar 2.读取并观察数据情况 dat_hero=pd.read_csv('TeamHero_index.csv') dat_hero.head()

3.数据分析 (1)红蓝方因素对胜负的影响 众所周知,在英雄联盟中,由于蓝方会先手ban英雄及pick英雄,因此通常蓝方的胜率更高一些。让我们来看看数据是否能够印证这一点。 取出红方获胜的数据: red_win1=dat_hero[dat_hero['是否红方'].isin(['1'])] red_win1=red_win1[red_win1['是否获胜'].isin(['1'])] red_win2=dat_hero[dat_hero['是否红方'].isin(['0'])] red_win2=red_win2[red_win2['是否获胜'].isin(['0'])] red_win=pd.concat([red_win1,red_win2]) red_win.shape (208,8) 取出蓝方获胜的数据 blue_win1=dat_hero[dat_hero['是否红方'].isin(['1'])] blue_win1=blue_win1[blue_win1['是否获胜'].isin(['0'])] blue_win2=dat_hero[dat_hero['是否红方'].isin(['0'])] blue_win2=blue_win2[blue_win2['是否获胜'].isin(['1'])] blue_win=pd.concat([blue_win1,blue_win2]) blue_win.shape (316,8) 画出红蓝方胜场直方图

数据挖掘与分析心得体会

正如柏拉图所说:需要是发明之母。随着信息时代的步伐不断迈进,大量数据日积月累。我们迫切需要一种工具来满足从数据中发现知识的需求!而数据挖掘便应运而生了。正如书中所说:数据挖掘已经并且将继续在我们从数据时代大步跨入信息时代的历程中做出贡献。 1、数据挖掘 数据挖掘应当更正确的命名为:“从数据中挖掘知识”,不过后者显得过长了些。而“挖掘”一词确是生动形象的!人们把数据挖掘视为“数据中的知识发现(KDD)”的同义词,而另一些人只是把数据挖掘视为知识发现过程的一个基本步骤! 由此而产生数据挖掘的定义:从大量数据中挖掘有趣模式和知识的过程!数据源包括数据库、数据仓库、Web、其他信息存储库或动态地流入系统的数据。作为知识发现过程,它通常包括数据清理、数据集成、数据变换、模式发现、模式评估和知识表示六个步骤。 数据挖掘处理数据之多,挖掘模式之有趣,使用技术之大量,应用范围之广泛都将会是前所未有的;而数据挖掘任务之重也一直并存。这些问题将继续激励数据挖掘的进一步研究与改进! 2、数据分析 数据分析是指用适当的统计方法对收集来的大量第一手资料和第二手资料进行分析,以求最大化地开发数据资料的功能,发挥数据的作用。是为了提取有用信息和形成结论而对数据加以详细研究和概括总结的过程。 数据分析有极广泛的应用范围。典型的数据分析可能包含以下三个步: 1、探索性数据分析:当数据刚取得时,可能杂乱无章,看不出规律,通过作图、造表、用各种形式的方程拟合,计算某些特征量等手段探索规律性的可能形式,即往什么方向和用何种方式去寻找和揭示隐含在数据中的规律性。 2、模型选定分析,在探索性分析的基础上提出一类或几类可能的模型,然后通过进一步的分析从中挑选一定的模型。 3、推断分析:通常使用数理统计方法对所定模型或估计的可靠程度和精确程度作出推断。 数据分析的目的是把隐没在一大批看来杂乱无章的数据中的信息集中、萃取和提炼出来,以找出所研究对象的内在规律。在实用中,数据分析可帮助人们作出判断,以便采取适当行动。数据分析是组织有目的地收集数据、分析数据,使之成为信息的过程。这一过程是质量管理体系的支持过程。在产品的整个寿命周期,包括从市场调研到售后服务和最终处置的各

如何用EXCEL做数据线性拟合和回归分析

如何用Excel做数据线性拟合和回归分析 我们已经知道在Excel自带的数据库中已有线性拟合工具,但是它还稍显单薄,今天我们来尝试使用较为专业的拟合工具来对此类数据进行处理。 在数据分析中,对于成对成组数据的拟合是经常遇到的,涉及到的任务有线性描述,趋势预测和残差分析等等。很多专业读者遇见此类问题时往往寻求专业软件,比如在化工中经常用到的Origin和数学中常见的MATLAB等等。它们虽很专业,但其实使用Excel 就完全够用了。我们已经知道在Excel自带的数据库中已有线性拟合工具,但是它还稍显单薄,今天我们来尝试使用较为专业的拟合工具来对此类数据进行处理。 注:本功能需要使用Excel扩展功能,如果您的Excel尚未安装数据分析,请依次选择“工具”-“加载宏”,在安装光盘支持下加载“分析数据库”。加载成功后,可以在“工具”下拉菜单中看到“数据分析”选项 实例某溶液浓度正比对应于色谱仪器中的峰面积,现欲建立不同浓度下对应峰面积的标准曲线以供测试未知样品的实际浓度。已知8组对应数据,建立标准曲线,并且对此曲线进行评价,给出残差等分析数据。 这是一个很典型的线性拟合问题,手工计算就是采用最小二乘法求出拟合直线的待定参数,同时可以得出R的值,也就是相关系数的大小。在Excel中,可以采用先绘图再添加趋势线的方法完成前两步的要求。 选择成对的数据列,将它们使用“X、Y散点图”制成散点图。

在数据点上单击右键,选择“添加趋势线”-“线性”,并在选项标签中要求给出公式和相关系数等,可以得到拟合的直线。 拟合的直线是y=15620x+6606.1,R2的值为0.9994。 因为R2>0.99,所以这是一个线性特征非常明显的实验模型,即说明拟合直线能够以大于99.99%地解释、涵盖了实测数据,具有很好的一般性,可以作为标准工作曲线用于其他未知浓度溶液的测量。 为了进一步使用更多的指标来描述这一个模型,我们使用数据分析中的“回归”工具来详细分析这组数据。 在选项卡中显然详细多了,注意选择X、Y对应的数据列。“常数为零”就是指明该模型是严格的正比例模型,本例确实是这样,因为在浓度为零时相应峰面积肯定为零。先前得出的回归方程虽然拟合程度相当高,但是在x=0时,仍然有对应的数值,这显然是一个可笑的结论。所以我们选择“常数为零”。 “回归”工具为我们提供了三张图,分别是残差图、线性拟合图和正态概率图。重点来看残差图和线性拟合图。 在线性拟合图中可以看到,不但有根据要求生成的数据点,而且还有经过拟和处理的预测数据点,拟合直线的参数会在数据表格中详细显示。本实例旨在提供更多信息以起到抛砖引玉的作用,由于涉及到过多的专业术语,请各位读者根据实际,在具体使用

电子竞技行业盈利模式——以《英雄联盟》为例毕业论文

毕业论文声明 本人郑重声明: 1.此毕业论文是本人在指导教师指导下独立进行研究取得的成果。除了特别加以标注地方外,本文不包含他人或其它机构已经发表或撰写过的研究成果。对本文研究做出重要贡献的个人与集体均已在文中作了明确标明。本人完全意识到本声明的法律结果由本人承担。 2.本人完全了解学校、学院有关保留、使用学位论文的规定,同意学校与学院保留并向国家有关部门或机构送交此论文的复印件和电子版,允许此文被查阅和借阅。本人授权大学学院可以将此文的全部或部分内容编入有关数据库进行检索,可以采用影印、缩印或扫描等复制手段保存和汇编本文。 3.若在大学学院毕业论文审查小组复审中,发现本文有抄袭,一切后果均由本人承担,与毕业论文指导老师无关。 4.本人所呈交的毕业论文,是在指导老师的指导下独立进行研究所取得的成果。论文中凡引用他人已经发布或未发表的成果、数据、观点等,均已明确注明出处。论文中已经注明引用的内容外,不包含任何其他个人或集体已经发表或撰写过的研究成果。对本文的研究成果做出重要贡献的个人和集体,均已在论文中已明确的方式标明。 学位论文作者(签名): 年月

关于毕业论文使用授权的声明 本人在指导老师的指导下所完成的论文及相关的资料(包括图纸、实验记录、原始数据、实物照片、图片、录音带、设计手稿等),知识产权归属华北电力大学。本人完全了解大学有关保存,使用毕业论文的规定。同意学校保存或向国家有关部门或机构送交论文的纸质版或电子版,允许论文被查阅或借阅。本人授权大学可以将本毕业论文的全部或部分内容编入有关数据库进行检索,可以采用任何复制手段保存或编汇本毕业论文。如果发表相关成果,一定征得指导教师同意,且第一署名单位为大学。本人毕业后使用毕业论文或与该论文直接相关的学术论文或成果时,第一署名单位仍然为大学。本人完全了解大学关于收集、保存、使用学位论文的规定,同意如下各项内容: 按照学校要求提交学位论文的印刷本和电子版本;学校有权保存学位论文的印刷本和电子版,并采用影印、缩印、扫描、数字化或其它手段保存或汇编本学位论文;学校有权提供目录检索以及提供本学位论文全文或者部分的阅览服务;学校有权按有关规定向国家有关部门或者机构送交论文的复印件和电子版,允许论文被查阅和借阅。本人授权大学可以将本学位论文的全部或部分内容编入学校有关数据库和收录到《中国学位论文全文数据库》进行信息服务。在不以赢利为目的的前提下,学校可以适当复制论文的部分或全部内容用于学术活动。 论文作者签名:日期: 指导教师签名:日期:

如何做好数据分析报告

如何做好一份数据分析报告 现有数据分析报告当中存在一些问题,我们对现有的数据分析报告当中的问题进行分析,来找到如何做出更高质量的数据分析报告。 一、基础数据的采集缺乏科学依据 基础数据的采集对于整个数据分析报告具有非常重要的意义,基础数据采集的科学性决定了这个数据分析报告是不是有使用价值。只有当数据采集具有科学性、客观、严密的逻辑性时,建立在这样的数据分析基础之上的经济效益评价、现金流量分析以及数据分析结论才具有现实的价值和意义。一般来说,当拿到一个项目时我们首先会结合项目的特点来进行基础数据分析,一个项目刚形成,从无到有的时候,基础数据一般采用一手的数据,因为它没有历史的轨迹来遵循,所以用一手数据资料来进行分析。一手数据的采集方法比如:问卷调查、观察、抽样技术等等,来对一手数据进行分析。通常对拥有大量的历史数据的项目如服装业等,数据采集可借鉴同等的规模或一些历史数据,以他为基础来进一步研究和分析。同时也可借鉴行业公开的资料、网上资料、统计的年鉴等等来进行分析。从现有的数据分析报告来看,很多基础的数据就是简单的摆在那里,没有数据来源,数据提示,没有对基础数据严谨的分析。

作为数据分析报的使用方而言,拿到这样的报告会对于报告的科学性提出质疑。 二、数据分析的过程缺乏逻辑性,论证的结论不具备系统性 很多数据分析报告一般都是前面是一堆数据,后面是一个结论。当真正的研究数据和结论时,是结果单一,数据和结论找不到必然的联系,要不就是只有一个结论,比如对净现值、内部收益率做出说明等等。作为专业的数据分析报告,必须充分的考虑每一个数字科学来源的基础上运用定量的模型来对数据进行分析,一步步推导到数据的结论上。 例如,一个项目不确定性分析,风险概率分析 (一)、什么是影响这个项目的风险点,这些风险因素就是我们通常意义上的不确定性分析的模型来做 (二)、在这样的风险因素基础上,哪一些风险因素对投资项目的效益有重大影响,这些因素通过敏感性分析可以找出来。 (三)、找出这些风险因素下一步就是分析,这些影响效益的风险点出现的概率有多大? 三步分析完之后,风险对于这个项目的影响就显露出来,到这个时候只是数据分析的第一步工作。有一些数字和比率出现在报告上,更重要的在于结论,针对于这样的分险因素和风险变量(不可避免的),作为数据分析报告必须能搞提出来如何在项目的操作中

丁璐璐 英雄联盟网络游戏的营销策略分析

沈阳工学院 学年论文 题目:英雄联盟网络游戏的营销策略分析 学院:经济与管理学院 专业:市场营销 学号: 1520110537 学生姓名:丁璐璐 指导教师:董乃群 2017年1月6日

随着中国互联网络游戏产业的出现和发展,游戏行业这些年来也不断的变化更新中。网络游戏这个产业从初步发展到现在的蓬勃发展,这都归结于网络游戏行业资金得到迅速聚集,高利润使得许多竞争者大量研发新型、大型网络游戏,以及用户的成倍增长这些因素共同促进而成。 《英雄联盟》(简称LOL)是由美国拳头游戏(Riot Games)开发、中国大陆游戏代理运营的英雄对战MOBA竞技网游。游戏里拥有数百个个性英雄,并拥有排位系统、天赋系统、符文系统等特色养成系统。《英雄联盟》还致力于推动全球电子竞技的发展,除了联动各赛区发展职业联赛,每年还会举办“季中冠军赛”“全球总决赛”“All Star全明星赛”三大世界级赛事,获得了亿万玩家的喜爱,形成了自己独有的电子竞技文化。 本文主要分为六个部分。第一部写了研究的背景以及意义;第二部分主要写了英雄联盟的游戏规模、营销策略和存在问题;第三部分写了英雄联盟的竞争环境和SWOT分析;第四部分为英雄联盟的优化策略;第五部分为英雄联盟的4P策略;第六部分是结论。 关键词:英雄联盟;营销策略;LOL

摘要............................................................Ⅰ目录............................................................Ⅱ绪论............................................................11英雄联盟营销现状...............................................3 1.1英雄联盟的游戏规模.........................................3 1.2英雄联盟的营销策略.........................................4 1.3英雄联盟营销存在问题.......................................7 2英雄联盟竞争分析...............................................7 2.1英雄联盟的竞争环境.........................................72.2英雄联盟的SWOT分析....................................163英雄联盟的优化策略............................................18结论...........................................................20参考文献.........................................................

带新手入门大数据行业_光环大数据培训

https://www.360docs.net/doc/1912098205.html, 带新手入门大数据行业_光环大数据培训 最近很多同学咨询新手如何入门数据分析的事情,虽然网上类似的文章不少,但还是根据同学们的问题作了梳理回答。本文主要从职业选择角度解析数据分析适合的人群以及入门所需的基本准备。准备投身于这行的年轻人们,你真的想好了吗?我说的不一定对,Justdoyourself! 我适合数据分析吗 很多人选择大数据行业,选择数据分析更多看到的是这个岗位前景不错、薪资待遇也不错,各种培训让人看起来事情也挺简单。往往没有对岗位和自身进行合理评估,真正在求职或者入职之后或许才发现其实跟自己想的也许完全不一样。 其实在入行数据分析或者任何一行之前,你都要好好思考这些问题:我希望进入哪些行业呢?这行业有前景吗?需要什么样的知识结构?符合我的兴趣方向吗?知己知彼百战不殆,在做职业选择或者机会选择时可使用SWOT分析模型,更好的认识自己。 SWOT:优势(Strength)、劣势(Weakness)、机会(Opportunity)、威胁(Threat)。其中,优势与劣势是对自身条件的分析,机会与威胁是对外部环境的分析。 一、个人优势与劣势分析(不限以下) 对于个人的评估,可以自己进行,也可以邀请朋友家人协助。全面客观的判断自我,对职业选择尤为重要。 1、职业爱好:分析需求、写代码、与人沟通、探索未知是你喜欢的吗 2、思考能力:如何根据数据推演、分析、提出解决方案,这常常需要你脑洞大开哦 3、学习能力:数据分析与IT行业一样,是需要持续保持学习状态的,这你能坚持么 4、沟通合作能力:数据分析师需要与业务部门、研发部门等频繁沟通和合作,这你擅长么 5、性格:动要能沟通、吵架,静要能分析写代码,这随意切换可以么?

数据分析与软件应用心得.

数据分析与软件应用心得 贾学昌3118425 我很高兴选修了《数据分析与软件》这门课程,通过本课程的学习,让我学会应用数据分析和多元统计中的诸多方法进行数据分析,通过和不同的学科知识相结合,对所考虑具体问题能给出合理的推断,还学会了利用SPSS软件进行一些简单的操作,能够与EXCEL结合应用。总之,受益匪浅。 现实生活中的数据多不胜数,但要得到有用的数据并不容易,这就要应用数据分析的方法确定数据的属性,再用清理工具(清洗、集成、转换、消减)进行筛选转化为有用的信息,再用SPSS深入分析,得出规律。 对数据的分析是以统计学为基础的,统计学提供了一套完整的科学方法论,统计软件则是实现的手段,统计分析软件具有很多有点。它功能全面,系统地集成了多种成熟的统计分析方法;有完善的数据定义、操作和管理功能;方便地生成各种统计图形和统计表格;使用方式简单,有完备的联机帮助功能;软件开放性好,能方便地和其他软件进行数据交换。我们接触最多的统计软件是EXCEL 和SPSS。在统计学中应用EXCEL,在数据分析中则主要是SPSS,它具有很好的人机界面和完善的输出结果。 因此,要学好SPSS,必须掌握理论知识和对数据具有良好的分析处理能力。弄清楚数据分析的目的与对应的分析方法。掌握基本的统计方法是基础。我掌握的基本统计量有频数分布分析、描述性统计分析、多选项分析等等。利用这些方法可以得出计算数据和统计图形,看出数据的离散程度、集中趋势和分散程度,单变量的比重,还有对数据进行标准化处理,不过,我对这个不是太熟悉;利用多选项分析把每个变量设为1/0变量,一般应用于多选项的问卷调查处理。 在这门课程中我们学习了一个重要分析方法就是假设检验,它是用样本推断总体有用工具。尽管在统计学和概率论中学过,但学起来并轻松一些。假设检验分为参数假设检验和非参数假设检验以及方差分析。基本原理就是“小概率事件实际不可能发生”。其中参数检验是对总体分布作出某种假设,然后利用样本信息来判断关于总体的参数的原假设是否成立。方差分析实际上是通过多个总体均值相等的假设检验,来推断变量间因果联系的统计方法。在这里,我们主要要掌握原假设H0与被则假设H1的设置,看懂SPSS分析结果的数据,其中最为关注的一般是P-Value值,如果大则原假设成立,否则选择被则假设,还有F检验值和T检验值以及卡方检验值。与参数检验相比,在非参数检验中不需要对总体分布的具体形式作出严格假设,或者只需要很弱的假设。大部分非参数检验都是针对总体的分布进行的检验,但也可以对总体的某些参数进行检验。在这可学习中,最大的问题就是如何区分各种检验和合理应用。到现在我还很难理解,感觉很惭愧。 这门课程中我们学了另外一种数据分析方法就是聚类分析。它与“物以类聚,人以群分”是同样的道理。多元统计分析方法就是对样品或指标进行量化分类的问题,它们讨论的对象是大量的样品,要求能合理地按各自的特性也就是相似性来进行合理的分类,没有任何模式可供参考或依循,即是在没有先验知识的情况下进行的。我们学习了Q型聚类法、R型聚类法以及系统聚类法。Q型聚类分析样品间的聚类,用距离来测度亲疏程度。R型聚类分析变量间的聚类,用相似系数来测度亲疏程度。常用的Q聚类法有闵氏距离和马氏距离,只是我们必须掌握的。具体的计算方法有最短距离法、最长距离法、重心法、离差平方和连接法等等。在最后一节课老师讲了贝叶斯理论,根据先验概率和实验事件得出后验概率,从而得出更为可信的概率。