模式识别实验二

感知器准则算法

一、实验原理:

假设已知一组容量为N 的样本集1y ,2y ,…,N y ,其中N y 为d 维增广样本向量,分别来自1ω和2ω类。如果有一个线性机器能把每个样本正确分类,即存在一个权向量a ,使得对于任何1ω∈y ,都有y a T >0,而对一任何2ω∈y ,都有y a T <0,则称这组样本集线性可分;否则称线性不可分。若线性可分,则必存在一个权向量a ,能将每个样本正确分类。 由上面原理可知,样本集1y ,2y ,…,N y 是线性可分,则必存在某个权向量a ,使得

??

???∈<∈>21

y ,0y ,0ωωj j T

i i T y a y a 对一切对一切 如果我们在来自2ω类的样本j y 前面加上一个负号,即令j y =—j y ,其中2ω∈j y ,则也有

y a T

>0。因此,我们令???∈∈='21

y ,-y ,ωωj j

i i n

y y y 对一切对一切 那么,我们就可以不管样本原来的类型标志,只要找到一个对全部样本n

y '都满足y a T

>0,N n ,,3,2,1??=的权向量a 就行了。此过程称为样本的规范化,n

y '成为规范化增广样本向量,后面我们用y 来表示它。

我们的目的是找到一个解向量*

a ,使得N n y a n T ,...,2,1,0=>

为此我们首先考虑处理线性可分问题的算法,先构造这样一个准则函数)()(∑∈-=

k

y T

p y a

a J γ

式中k

γ是被权向量a 错分类的样本集合。错分类时有0≤y a T

,或0≥-y a T 因此()a J p 总是大于等于0。下一步便是求解使0≤y a T

达到极小值时的解向量*

a 。这里我们采用梯度下降法,首先对a 求梯度,这是一个纯量函数对向量的求导问题,不难看出

∑∈-=

??=

?k

y p p y a

a J a J γ)()()(

梯度是一个向量,其方向是J 增长最快的方向,福梯度方向是减小最快的,这指引我们在求

准则函数的极小值时沿负梯度方向能最快达到极小值点。梯度下降法的迭代公式为

,将上式代入得∑∈+=+k

y k y

k a k a γρ

)()1(

这样,经过有限次修改,一定能找到一个解向量*

a 。其中任意给定权向量)1(a 。

J k a k K ?-=+ρ)()1(a

三、实验内容:

实验所需样本数据如下表给出(每个样本空间为两维,x1表示一维的值,x2表示第二维的值),编制程序实现1ω、2ω、3ω类的分类。我们将符号简化,把k ρ=1。这样,梯度下降算法可以写成??

?

+=+k

y k a k a a )()1(),1(任意

其中对任何k 都有0)(≤k

T

y k a 。实验时0)1(=a ,k ρ=1的情况来找到一个解向量*

a 。 感知器算法实验数据 样本

1 2 3 4 5 6 7 8 9 10 W1

x1

0.1 6.8 -3.5 2.0 4.1 3.1 -0.8 0.9 5.0 3.9 x2 1.1 7.1 -4.1 2.7 2.8 5.0 -1.3 1.2 6.4 4.0 W2

x1

7.1 -1.4 4.5 6.3 4.2 1.4 2.4 2.5 8.4 4.1 x2 4.2 -4.3 0.0 1.6 1.9 -3.2 -4.0 -6.1 3.7 -2.2 W3

x1

-3.0 0.5 2.9 -0.1 -4.0 -1.3 -3.4 -4.1 -5.1 1.9 x2 -2.9 8.7 2.1 5.2 2.2 3.7 6.2 3.4 1.6 5.1 W4

x1

-2.0 -8.9 -4.2 -8.5 -6.7 -0.5 -5.3 -8.7 -7.1 -8.0 x2

-8.4

0.2

-7.7 -3.2 -4.2 -9.2 -6.7

-6.4

-9.7

-6.3

四、实验结果及分析:

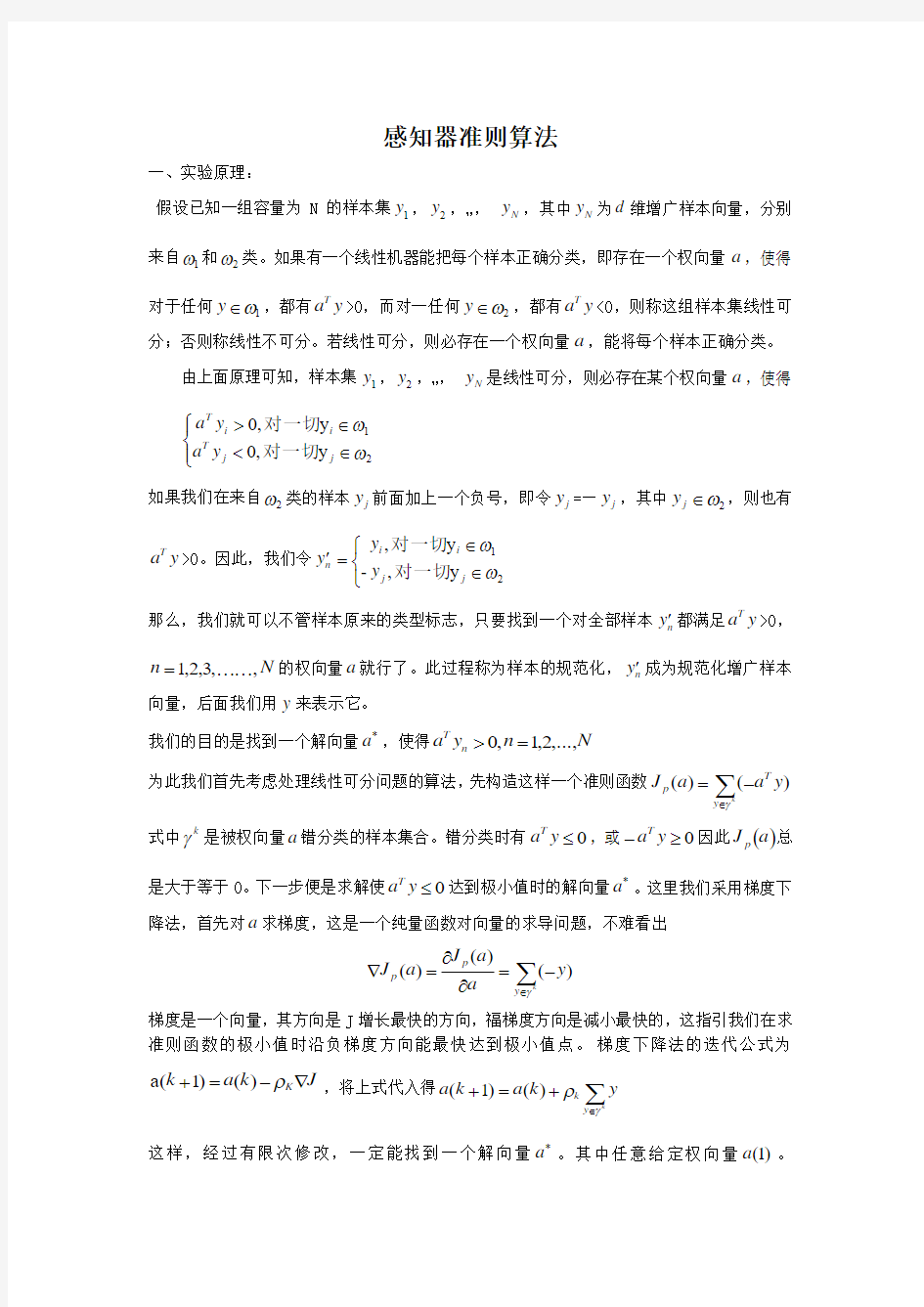

1)梯度下降算法输出结果:

a=[0;0;0]的收敛步骤

a=[1;1;1]的收敛步骤

a=[1;1;1]将更快收敛到*a。由此可见对于同一个样本,权向量的初值会影响到修正时的收敛步数。

梯度下降算法:主要程序 clear;

W1=[0.1 6.8 -3.5 2.0 4.1 3.1 -0.8 0.9 5.0 3.9; 1.1 7.1 -4.1 2.7 2.8 5.0 -1.3 1.2 6.4 4.0]; W2=[7.1 -1.4 4.5 6.3 4.2 1.4 2.4 2.5 8.4 4.1;

4.2 -4.3 0.0 1.6 1.9 -3.2 -4.0 -6.1 3.7 -2.2]; W3=[-3.0 0.5 2.9 -0.1 -4.0 -1.3 -3.4 -4.1 -

5.1 1.9; -2.9 8.7 2.1 5.2 2.2 3.7

6.2 3.4 1.6 5.1]; %将所有训练样本进行规范化增广 ww1=[ones(1,size(W1,2));W1]; ww2=[ones(1,size(W2,2));W2]; ww3=[ones(1,size(W3,2));W3];

%对W1、W2训练

w12=[ww1,-ww2];%增广样本规范化为w12

y=zeros(1,size(w12,2));%产生大小为1行,size(x,2)列的矩阵,矩阵元素都是0。 a=[0;0;0];%初始权向量a k=0;

while any(y<=0)

for i=1:size(y,2) %y 矩阵的列数 y(i)=a'*w12(:,i); %a ’表示转秩 end;

a=a+(sum((w12(:,find(y<=0)))'))';%修正向量a ∑∈+=+k

y k y k a k a γρ)()1(

k=k+1;%收敛步数 end;

a %显示最终求得的权向量a 的值 k %迭代次数值 subplot(1,2,1);

plot(W1(1,:),W1(2,:),'r.'); hold on;

plot(W2(1,:),W2(2,:),'*');

%找到样本在坐标中的集中区域,以便于打印样本坐标图 xmin=min(min(W1(1,:)),min(W2(1,:))); xmax=max(max(W1(1,:)),max(W2(1,:))); xindex=xmin-1:(xmax-xmin)/100:xmax+1; yindex=-a(2)*xindex/a(3)-a(1)/a(3); plot(xindex,yindex);

BP 算法实现异或问题

一、实验原理

BP 算法由于硬限幅函数是非可微函数,不能实现多层神经网络的一种有效的LMS 学习算法。而BP 算法中所用到的是Sigmoid 型函数,它既具有完成分类所需的非线性特性,又具有实现LMS 算法所需的可微特性。采用S 型函数的神经元的输入和输出之间的关系为:

u s e u f -+=

11)(

采用了S 型函数就可将用于单神经元的LMS 学习算法适当推广,得到一种适用于前向多层神经网络的有效学习算法。

我们现在着手研究一个采用S 型函数的前向三层神经网络来说明其原理。

对于训练样本p,它的输入是N 维矢量X ,X=],,[1,10-N p p p x x x ,网络的第一,二,三层分别包括J ,K ,M 个神经元,它的总输出是一个M 维矢量,Y=],,[1,10-M p p p y y y ,第i 层到

第i+1层之间的权重系数用)

1(+i nj w 来表示。可设前向三层神经网络输出各个分量的理想值是pi d ,i=0,1,……M-1,而这些分量的实际值是)

3(pi

pi o y =, i=0,1,……M-1,理想值和实际值之间的误差是

)

(pi pi pi y d -=ε。各输出误差的平方和可以表示为:

∑-==1

2

M i pi

p E ε

现在我们希望改变网络中的各个加权系数)

(l ij w ,使得p E 尽可能的减小。为此我们可以采取最陡下降算法的公式来调整权重系数)(l ij p w ?。公式如下:

,)()

(l ij

p

l ij

p w E a w

???

-=?

式中的a 是学习的步幅,它应随学习过程而变化。

对于通用神经层,它的各个输出)(l pL o 与各个输入)

1(-l pL o 之间的关系可以表示为:

∑-=--==10

)

()

1()()()

(),(L j l i l pj l ij l pi

l pi s l pi

O w I

I f o

θ

如果设)

()()

1(,1l iL l i

l pL

w

o

=-=-θ

,则

∑=-=L

j l pj l ij l pi

O w I

)

1()()( 式中的[]?f 表示s 型函数。我们不难看出上式即为给输入加一个恒等于1部分,在神经网络中也应相应的加一个节点,而且这个节点的权系数就是这一层网络的阈值。我们省去具体的

推导过程,下面直接给出结果。

(1)对于第三层:

)1(**)(*2)3()3()3()3(pi pi pi pi pi o o o d --=δ

(2)对于第二层:

)1(**)2()2(10)3()3()

2(pi pi M k ki pk pi

o o w -?

?????=∑-=δδ

(3)对于第一层:

)

0()1()1(10)2()2()

1(*)1(***pj

pi pi K k ki pk ij

o o o w w

-?

?????=?∑-=δα 其中:pi pi y o =)

3(

pi pi x o =)

0(

通过以上公式就可得到三层神经网络的各个权系数的调整量)(l ij p w ?。可见,这一算法的计算过程是先计算第三层(即输出层)的各项“误差分量”)3(pi δ,然后用)3(pi δ计算第二层(隐含层)的“等效误差分量”)2(pi δ,最后再用)2(pi δ计算第一层的“等效误差分量”)1(pi δ。只要

算出这些误差分量,系数调整量即可立即求得。所以,这是一种由输出层向输入层逐步反推的学习算法,故称之为“逆推”学习算法,即BP 算法。 二、实验步骤

1、生成训练样本和测试样本。在(1,0)(0,1)(0,0)(1,1)四个点附近各有随机生成服从高斯分布的30个样本,其中20个用作训练,剩下10个用作测试。根据异或问题要求,将(1,0)(0,1)附近的点归为第一组,(0,0)(1,1)附近的点归为第二组。由于有2个类别,对于目标结果,我们用0.9表示第一组,0.1表示第二组。

2、样本数据处理。把数据重新打乱顺序进行输入,可以让数据更加具备典型性和更优良的泛化能力。

3、建立神经网络,设置网络层数为3层,即输入层、隐层、输出层;输入层神经元数为2,隐层神经元数为5,输出层神经元数为1。

4、确定训练函数进行训练。选择适用于模式识别分类时速度最快的弹性算法。

5、完成训练后,调用训练结果,输入测试数据进行测试,分析分类结果。 三、实验结果及分析

运行程序后得到样本(包括训练样本和测试样本),样本如图所示。

)

2()3()3(**pj

pi ij p o w δα=?)1()2()2(**pj

pi ij p o w δα=?

设定网络误差为0.001,样经过训练,经过30次迭代,得到的满足误差限的网络性能曲线如图所示。

对于训练好的满足要求的网络测试剩下40个样本,第1-10个样本在以点(1,0)为中心的区域内,第11-20个样本在以点(0,1)为中心的区域内,第21-30个样本在以点(0,0)为中心的区域内,第31-40个样本在以点(1,1)为中心的区域内,按异或规则,我们希望得到的前20个值在0.9左右,后20个值在0.1左右。测试结果如下,显然与我们期望吻合,故分类正确。

如果我们以Y=0.5为阈值,当Y>0.5时,将样本归为第一类,当Y<0.5时,将样本归为第二类,则可得到某个满足要求的网络近似分界面,如图所示。

上图中,两条点线两侧的区域在此网络中分为第一类,中间所夹的区域为第二类,点线为大致的分界面。显然网络确实可以实现非线性样本特征的分类。

异或问题的BP网络分类法程序:

clear

n=30;

a=[1 0;0 1;0 0;1 1];

for k=1:4

x((n*(k-1)+1):(n*k),1:2)=[random('normal',a(k,1),0.05,n,1),random('normal',a(k, 2),0.05,n,1)]; %产生n行1列均值为a(k,1)a(k,2)标准差为0.05的正态分布

%取1至n行,1至2列的数据

x((n*(k-1)+1):(n*k),3)=abs(floor(k/2-0.1)-0.9); %不大于的最大整数

end

figure;%画两类样本

for i=1:2*n

plot(x(i,1),x(i,2),'r+')

hold on

end

for i=1:2*n

plot(x(i+2*n,1),x(i+2*n,2),'b+')

hold on

end

xlabel('x(1)')

ylabel('x(2)')

title('训练样本')

grid on

axis([-0.5 1.5 -0.5 1.5])

M=20;%抽取样本训练

for k=1:4

for i = 1:M

xpt(i+(k-1)*M,:)=x(i+(k-1)*n,:);

end

end

%训练网络

xd=xpt(randperm(numel(xpt)/3),:);

%%P=randperm(N,K)返回一个包含K个在0到N之间的随机元素向量,P=randperm(N)返回一个包含N个在0到N之间产生的随机元素的向量,各行各列重新排

P=xd(:,1:2);

T=xd(:,3);

net=newff(minmax(P'),[6,1],{'logsig' 'logsig'},'trainrp');

%创建一个反馈式网络,6为隐含层节点数,1为输出层节点数,'logsig'为输入层到隐含层、隐含层到输出层的传递函数,'trainrp'为输出层的训练函数

net.trainparam.epochs=1000; %网络最大收敛次数

net.trainparam.goal=0.0001; %收敛误差

net=train(net,P',T'); %调用TRAINGND算法训练BP网络

sim(net,P') %BP网络进行仿真结果

figure %画网络分界面

s=100;

for i=1:s

for j=1:s

tt(:,(i-1)*s+j)=[i/s;j/s];

Y=sim(net,tt(:,(i-1)*s+j)); %对bp网络进行仿真 if(abs(Y-0.5)<0.01)

plot(i/s,j/s,'b.')

hold on

end

end

end

grid on

title('网络分界面')

N=n-M;%提取测试样本

for k=1:4

for i = 1:N

x_test(i+(k-1)*N,:) = x(i+(k-1)*n+M,1:2);

end

end

P_p=x_test';

Y=sim(net,P_p)

Iris 数据BP 神经网络分类

一、实验原理

BP 算法由于硬限幅函数是非可微函数,不能实现多层神经网络的一种有效的LMS 学习算法。而BP 算法中所用到的是Sigmoid 型函数,它既具有完成分类所需的非线性特性,又具有实现LMS 算法所需的可微特性。采用S 型函数的神经元的输入和输出之间的关系为:

u s e u f -+=

11)(

采用了S 型函数就可将用于单神经元的LMS 学习算法适当推广,得到一种适用于前向多层神经网络的有效学习算法。

对于训练样本p,它的输入是N 维矢量X ,X=],,[1,10-N p p p x x x ,网络的第一,二,三层分别包括J ,K ,M 个神经元,它的总输出是一个M 维矢量,Y=],,[1,10-M p p p y y y ,第i 层到

第i+1层之间的权重系数用)

1(+i nj w 来表示。可设前向三层神经网络输出各个分量的理想值是pi d ,i=0,1,……M-1,而这些分量的实际值是)

3(pi

pi o y =, i=0,1,……M-1,理想值和实际值之间的误差是)

(pi pi pi

y d -=ε。各输出误差的平方和可以表示为:

∑-==

1

2M i pi

p

E

ε

现在我们希望改变网络中的各个加权系数)

(l ij w ,使得p E 尽可能的减小。为此我们可以采取

最陡下降算法的公式来调整权重系数)(l ij p w ?。公式为:,)

()

(l ij

p l ij p w

E a w ???

-=?

式中的a 是学习的步幅,它应随学习过程而变化。

对于通用神经层,它的各个输出)(l pL o 与各个输入)

1(-l pL o 之间的关系可以表示为:

∑-=--==10

)

()

1()()()

(),(L j l i l pj l ij l pi

l pi s l pi

O w I

I f o

θ

如果设)

()()

1(,1l iL l i

l pL

w

o

=-=-θ

,则

∑=-=L

j l pj l ij l pi

O w I

)

1()()( 式中的[]?f 表示s 型函数。我们不难看出上式即为给输入加一个恒等于1部分,在神经网络中也应相应的加一个节点,而且这个节点的权系数就是这一层网络的阈值。我们省去具体的

推导过程,下面直接给出结果。 (1)对于第三层:

)1(**)(*2)3()3()3()3(pi pi pi pi pi o o o d --=δ

)

2()3()3(**pj

pi ij p o w δα=?

(2)对于第二层:

)1(**)2()2(10)3()3()2(pi pi M k ki pk pi

o o w -?

?????=∑-=δδ

(3)对于第一层:

)

0()1()1(10)2()2()

1(*)1(***pj

pi pi K k ki pk ij

o o o w w

-?

?????=?∑-=δα 其中:pi pi y o =)

3(

pi pi x o =)

0(

通过以上公式就可得到三层神经网络的各个权系数的调整量)(l ij p w ?。可见,这一算法的计算过程是先计算第三层(即输出层)的各项“误差分量”)3(pi δ,然后用)3(pi δ计算第二层(隐含层)的“等效误差分量”)2(pi δ,最后再用)2(pi δ计算第一层(隐含层)的“等效误差分量”)

1(pi

δ。只要算出这些误差分量,系数调整量即可立即求得。所以,这是一种由输出层向输入层逐步反推的学习算法,故称之为“逆推”学习算法,或BP 算法。 二、实验步骤

1、确定训练样本和测试样本。三类样本各取前30个样本作为训练,剩下的用作测试分类样本。由于有3个类别,我们用2个数表示类别,0.9 0.1表示第一组,0.1 0.9表示第二组,0.9 0.9表示第三组,然后将二进制数组合成目标向量。

2、样本数据处理,包括归一化和打乱样本数据顺序。其中把数据重新打乱顺序进行输入,可以让数据更加具备典型性和更优良的泛化能力。

3、建立神经网络,设置网络层数为3层,即输入层、隐层、输出层;输入层神经元数为4,隐层神经元数为10,,输出层神经元数为2,隐含层的传输函数为sigmoid 函数,输出层传输函数亦为sigmoid 函数。

4、确定训练函数进行训练。当连续两迭代的梯度方向相同时,可将权值和阈值的修正值乘以一个增量因子,使其修正值增加,当连续两迭代的梯度方向相反时,可将权值和阈值的修正值乘以一个减量因子,使其修正值减小;当梯度为零时,权值和修正值保持不变;当权值的修正发生震荡时,其修正值将减小。

5、完成训练后,调用训练结果,输入测试数据,进行测试。

6、分析分类结果。 三、实验结果及分析

三类样本前30个样本训练,设定误差为0.0045,经过1178次迭代,得到的误差性能曲线如图所示。

)1()2()2(**pj

pi ij p o w δα=?

同时得到的统计结果为n1 = 20 n2 = 19 n3 = 18。分类结果如下图所示,图中“+”为第一组测试样本,“*□”为第二组测试样本,“*”为第三组测试样本,可以看到第一组测试样本分类完全正确,第二类测试样本有一个样本分到了第三组中,第三组测试样本有2个分到第二组中。

对于BP神经网络,只要网络隐层合适,训练的样本有足够的代表性,经训练后的网络能够有效且快捷地解决很多非线性多类样本的模式分类问题,它在工程应用上也取得了很大的成功。但是对于网络层数,接点数、初始权值和学习速率能诸多因素有时还需凭经验确定,另外它所得到的解不唯一,且不能保证得到最优解。

Iris数据BP神经网络分类程序:

clear

iris = load('iris.txt');

M=30;

for k=1:3

for i = 1:M

for j = 1:4

x1(i+(k-1)*M,j) = iris(i+(k-1)*50,j+1);

end

d1(i+(k-1)*M,1)=abs(mod(k,2)-0.1); %mod两数相除的余数 0.9 0.1 0.9 d1(i+(k-1)*M,2)=abs(floor(k/2)-0.1); 0.9 0.9 0.9

end

end

x2(:,1:4)=x1;

x2(:,5:6)=d1;

%训练样本顺序打乱

xd=x2(randperm(numel(x2)/6),:);

x=xd(:,1:4); d=xd(:,5:6);

[P,minp,maxp] = premnmx(x);

%归一化,[Pn,minp,maxp,Tn,mint,maxt]=premnmx(P,T);P,T分别为原始输入和输出数据,minp和maxp分别为P中的最小值和最大值。mint和maxt分别为T的最小值和最大值。premnmx函数用于将网络的输入数据或输出数据进行归一化,归一化后的数据将分布在[-1,1]区间内。

P=P'; T=d';

net=newff(minmax(P),[12,2],{'logsig' 'logsig'},'trainrp');

net.trainparam.epochs=2000;

net.trainparam.goal=0.0045;

net=train(net,P,T);

sim(net,P)

N=50-M;

for k=1:3

for i = 1 : N

for j = 1:4

P_test(i+(k-1)*N,j) = iris(i+(k-1)*50+M,j+1);

end

end

end

[P_p,minp,maxp] = premnmx(P_test);

P_p=P_p';

Y=sim(net,P_p)

figure

n1=0;n2=0;n3=0;%统计各组分类正确数

for k=1:3

for i=1:N

switch k

case 1

plot(Y(1,i+(k-1)*N),Y(2,i+(k-1)*N),'r+')

if(Y(1,i)>0.5&& Y(2,i)<0.5)

n1=n1+1;

end

case 2

plot(Y(1,i+(k-1)*N),Y(2,i+(k-1)*N),'gs')

if(Y(1,i+N)<0.5&&Y(2,i+N)>0.5)

n2=n2+1;

end

case 3

plot(Y(1,i+(k-1)*N),Y(2,i+(k-1)*N),'b*') if(Y(1,i+2*N)>0.5&&Y(2,i+2*N)>0.5)

n3=n3+1;

end

end

hold on

end

end

hold on

plot(0:0.001:1,0.5,'--b' )

hold on

plot(0.5,0:0.001:1,'--b')

axis([-0.2 1.2 -0.2 1.2])

xlabel('Y(1)')

ylabel('Y(2)')

title('分类结果')

grid on

模式识别实验指导书

类别1234 样本x 1x 2x 1x 2x 1x 2x 1x 2 10.1 1.17.1 4.2-3.0-2.9-2.0-8.4 2 6.87.1-1.4-4.30.58.7-8.90.23-3.5-4.1 4.50.0 2.9 2.1-4.2-7.74 2.0 2.7 6. 3 1.6-0.1 5.2-8.5-3.25 4.1 2.8 4.2 1.9-4.0 2.2-6.7-4.06 3.1 5.0 1.4-3.2-1.3 3.7-0.5-9.27-0.8-1.3 2.4-4.0-3. 4 6.2-5.3-6.7 80.9 1.2 2.5-6.1-4.1 3.4-8.7-6.4 9 5.0 6.48.4 3.7-5.1 1.6-7.1-9.7 10 3.9 4.0 4.1-2.2 1.9 5.1-8.0-6.3 实验一 感知器准则算法实验 一、实验目的: 贝叶斯分类方法是基于后验概率的大小进行分类的方法,有时需要进行概率密度函数的估计,而概率密度函数的估计通常需要大量样本才能进行,随着特征空间维数的增加,这种估计所需要的样本数急剧增加,使计算量大增。 在实际问题中,人们可以不去估计概率密度,而直接通过与样本和类别标号有关的判别函数来直接将未知样本进行分类。这种思路就是判别函数法,最简单的判别函数是线性判别函数。采用判别函数法的关键在于利用样本找到判别函数的系数,模式识别课程中的感知器算法是一种求解判别函数系数的有效方法。本实验的目的是通过编制程序,实现感知器准则算法,并实现线性可分样本的分类。 二、实验内容: 实验所用样本数据如表2-1给出(其中每个样本空间(数据)为两维,x 1表示第一维的值、x 2表示第二维的值),编制程序实现1、 2类2、 3类的分类。分析分类器算法的性能。 2-1 感知器算法实验数据 具体要求 1、复习 感知器算法;2、写出实现批处理感 知器算法的程序1)从a=0开 始,将你的程序应用在和的训练数据上。记下收敛的步数。2)将你的程序应用在和类上,同样记下收敛的步数。3)试解释它们收敛步数的差别。 3、提高部分:和的前5个点不是线性可分的,请手工构造非线性映射,使这些点在映射后的特征空间中是线性可分的,并对它们训练一个感知

第十章 幼儿知觉学习及教育指导

第十章幼儿知觉学习及教育指导 教学目的 1 学习并掌握知觉及幼儿知觉学习的概念。 2、学习和了解模式识别。 2 理解和运用促进幼儿知觉学习的教育措施。 教学重难点 重点:学习和了解模式识别。。 难点:理解和运用促进幼儿知觉学习的教育措施。 教学方法:讲授、讨论 教学时数:3课时 教学过程 第一节:知觉学习 一、知觉概述 (一)对知觉的看法 1、古希腊哲学家赫拉克利特:知觉是由对象与感觉器官之间相互作用引起的。 2、苏格拉底:是成人的一种生理和心理感受。 3、现代心理学家:知觉含有直接经验,表现为环境中某种信息源的揭示,是一切智力活动发展的基础。 (二)知觉产生的理论 1、人类文化研究 2、图式和认知风格 3、形、基组织

4、婴儿的深度知觉 二、知觉学习研究 (一)知觉学习中经验作用的研究 1、图形实验法。 2、知觉恒常法。 3、人工知觉。 4、自然场景实验法。 (二)知觉过程的研究方法 1、纹理梯度法 2、模式识别法 3、图像空间结构实验法 4、结构优势效应法 5、知觉加工方式的实验法 第二节:注意与知觉的模式识别一、注意的概述。 (一)注意的概念及其与知觉的关系 (二)注意过程的模式 1、双通道或多通道模式 2、资源分配模式 (三)注意的分类 1、无意注意 2、有意注意 3、随意后注意

二、知觉模式识别 (一)模式与模式识别的概念 (二)模式识别的理论 1、假设考验理论 2、直接作用理论 3、自下而上和自上而下的加工理论 (三)模式识别的模型 1、模板匹配模式 2、原型匹配模式 3、特征匹配模式 第三节幼儿知觉学习的教育指导 一、空间知觉 1、培养幼儿的观察力 2、通过实际生活培养幼儿的空间知觉能力 3、通过游戏活动发展幼儿的空间知觉能力 4、通过语言活动发展幼儿空间知觉能力 5、通过绘画教学培养幼儿的空间知觉能力 二、时间知觉 三、运动知觉 1、距离的感知培养 2、物体形态的感知培养 3、时间节奏的感知练习 4、主体方向性的感知练习

模式识别实验报告

模式识别实验报告

————————————————————————————————作者:————————————————————————————————日期:

实验报告 实验课程名称:模式识别 姓名:王宇班级: 20110813 学号: 2011081325 实验名称规范程度原理叙述实验过程实验结果实验成绩 图像的贝叶斯分类 K均值聚类算法 神经网络模式识别 平均成绩 折合成绩 注:1、每个实验中各项成绩按照5分制评定,实验成绩为各项总和 2、平均成绩取各项实验平均成绩 3、折合成绩按照教学大纲要求的百分比进行折合 2014年 6月

实验一、 图像的贝叶斯分类 一、实验目的 将模式识别方法与图像处理技术相结合,掌握利用最小错分概率贝叶斯分类器进行图像分类的基本方法,通过实验加深对基本概念的理解。 二、实验仪器设备及软件 HP D538、MATLAB 三、实验原理 概念: 阈值化分割算法是计算机视觉中的常用算法,对灰度图象的阈值分割就是先确定一个处于图像灰度取值范围内的灰度阈值,然后将图像中每个像素的灰度值与这个阈值相比较。并根据比较的结果将对应的像素划分为两类,灰度值大于阈值的像素划分为一类,小于阈值的划分为另一类,等于阈值的可任意划分到两类中的任何一类。 最常用的模型可描述如下:假设图像由具有单峰灰度分布的目标和背景组成,处于目标和背景内部相邻像素间的灰度值是高度相关的,但处于目标和背景交界处两边的像素灰度值有较大差别,此时,图像的灰度直方图基本上可看作是由分别对应于目标和背景的两个单峰直方图混合构成。而且这两个分布应大小接近,且均值足够远,方差足够小,这种情况下直方图呈现较明显的双峰。类似地,如果图像中包含多个单峰灰度目标,则直方图可能呈现较明显的多峰。 上述图像模型只是理想情况,有时图像中目标和背景的灰度值有部分交错。这时如用全局阈值进行分割必然会产生一定的误差。分割误差包括将目标分为背景和将背景分为目标两大类。实际应用中应尽量减小错误分割的概率,常用的一种方法为选取最优阈值。这里所谓的最优阈值,就是指能使误分割概率最小的分割阈值。图像的直方图可以看成是对灰度值概率分布密度函数的一种近似。如一幅图像中只包含目标和背景两类灰度区域,那么直方图所代表的灰度值概率密度函数可以表示为目标和背景两类灰度值概率密度函数的加权和。如果概率密度函数形式已知,就有可能计算出使目标和背景两类误分割概率最小的最优阈值。 假设目标与背景两类像素值均服从正态分布且混有加性高斯噪声,上述分类问题可以使用模式识别中的最小错分概率贝叶斯分类器来解决。以1p 与2p 分别表示目标与背景的灰度分布概率密度函数,1P 与2P 分别表示两类的先验概率,则图像的混合概率密度函数可用下式表示为

模式识别第二次上机实验报告

北京科技大学计算机与通信工程学院 模式分类第二次上机实验报告 姓名:XXXXXX 学号:00000000 班级:电信11 时间:2014-04-16

一、实验目的 1.掌握支持向量机(SVM)的原理、核函数类型选择以及核参数选择原则等; 二、实验内容 2.准备好数据,首先要把数据转换成Libsvm软件包要求的数据格式为: label index1:value1 index2:value2 ... 其中对于分类来说label为类标识,指定数据的种类;对于回归来说label为目标值。(我主要要用到回归) Index是从1开始的自然数,value是每一维的特征值。 该过程可以自己使用excel或者编写程序来完成,也可以使用网络上的FormatDataLibsvm.xls来完成。FormatDataLibsvm.xls使用说明: 先将数据按照下列格式存放(注意label放最后面): value1 value2 label value1 value2 label 然后将以上数据粘贴到FormatDataLibsvm.xls中的最左上角单元格,接着工具->宏执行行FormatDataToLibsvm宏。就可以得到libsvm要求的数据格式。将该数据存放到文本文件中进行下一步的处理。 3.对数据进行归一化。 该过程要用到libsvm软件包中的svm-scale.exe Svm-scale用法: 用法:svmscale [-l lower] [-u upper] [-y y_lower y_upper] [-s save_filename] [-r restore_filename] filename (缺省值:lower = -1,upper = 1,没有对y进行缩放)其中,-l:数据下限标记;lower:缩放后数据下限;-u:数据上限标记;upper:缩放后数据上限;-y:是否对目标值同时进行缩放;y_lower为下限值,y_upper为上限值;(回归需要对目标进行缩放,因此该参数可以设定为–y -1 1 )-s save_filename:表示将缩放的规则保存为文件save_filename;-r restore_filename:表示将缩放规则文件restore_filename载入后按此缩放;filename:待缩放的数据文件(要求满足前面所述的格式)。缩放规则文件可以用文本浏览器打开,看到其格式为: y lower upper min max x lower upper index1 min1 max1 index2 min2 max2 其中的lower 与upper 与使用时所设置的lower 与upper 含义相同;index 表示特征序号;min 转换前该特征的最小值;max 转换前该特征的最大值。数据集的缩放结果在此情况下通过DOS窗口输出,当然也可以通过DOS的文件重定向符号“>”将结果另存为指定的文件。该文件中的参数可用于最后面对目标值的反归一化。反归一化的公式为: (Value-lower)*(max-min)/(upper - lower)+lower 其中value为归一化后的值,其他参数与前面介绍的相同。 建议将训练数据集与测试数据集放在同一个文本文件中一起归一化,然后再将归一化结果分成训练集和测试集。 4.训练数据,生成模型。 用法:svmtrain [options] training_set_file [model_file] 其中,options(操作参数):可用的选项即表示的涵义如下所示-s svm类型:设置SVM 类型,默

模式识别实验指导书

实验一、基于感知函数准则线性分类器设计 1.1 实验类型: 设计型:线性分类器设计(感知函数准则) 1.2 实验目的: 本实验旨在让同学理解感知准则函数的原理,通过软件编程模拟线性分类器,理解感知函数准则的确定过程,掌握梯度下降算法求增广权向量,进一步深刻认识线性分类器。 1.3 实验条件: matlab 软件 1.4 实验原理: 感知准则函数是五十年代由Rosenblatt 提出的一种自学习判别函数生成方法,由于Rosenblatt 企图将其用于脑模型感知器,因此被称为感知准则函数。其特点是随意确定的判别函数初始值,在对样本分类训练过程中逐步修正直至最终确定。 感知准则函数利用梯度下降算法求增广权向量的做法,可简单叙述为: 任意给定一向量初始值)1(a ,第k+1次迭代时的权向量)1(+k a 等于第k 次的权向量)(k a 加上被错分类的所有样本之和与k ρ的乘积。可以证明,对于线性可分的样本集,经过有限次修正,一定可以找到一个解向量a ,即算法能在有限步内收敛。其收敛速度的快慢取决于初始权向量)1(a 和系数k ρ。 1.5 实验内容 已知有两个样本空间w1和w2,这些点对应的横纵坐标的分布情况是: x1=[1,2,4,1,5];y1=[2,1,-1,-3,-3]; x2=[-2.5,-2.5,-1.5,-4,-5,-3];y2=[1,-1,5,1,-4,0]; 在二维空间样本分布图形如下所示:(plot(x1,y1,x2,y2))

-6-4-20246 -6-4 -2 2 4 6w1 w2 1.6 实验任务: 1、 用matlab 完成感知准则函数确定程序的设计。 2、 请确定sample=[(0,-3),(1,3),(-1,5),(-1,1),(0.5,6),(-3,-1),(2,-1),(0,1), (1,1),(-0.5,-0.5),( 0.5,-0.5)];属于哪个样本空间,根据数据画出分类的结果。 3、 请分析一下k ρ和)1(a 对于感知函数准则确定的影响,并确定当k ρ=1/2/3时,相应 的k 的值,以及)1(a 不同时,k 值得变化情况。 4、 根据实验结果请说明感知准则函数是否是唯一的,为什么?

2014春《文献检索》实验指导书-机械类六个专业-(需要发送电子稿给学课件

《文献检索》实验指导书 刘军安编写 适用专业:机械类各专业 总学时:24~32学时 实验学时:6~14 机械设计与制造教研室 2014. 3

一、课程总实验目的与任务 《文献检索》课程实验是机械学院机械类专业的选修课的实验。通过实验内容与过程,主要培养学生在信息数字化、网络化存储环境下信息组织与检索的原理、技术和方法,以及在数字图书馆系统和数字信息服务系统中检索专业知识的能力,辅助提高21世纪大学生人文素质。通过实验,使学生对信息检索的概念及发展、检索语言、检索策略、检索方法、检索算法、信息检索技术、网络信息检索原理、搜索引擎、信息检索系统的结构、信息检索系统的使用、信息检索系统评价以及所检索信息的分析等技术有一个全面熟悉和掌握。本实验主要培养和考核学生对信息检索基本原理、方法、技术的掌握和知识创新过程中对知识的检索与融合能力。实验主要侧重于培养学生对本专业技术原理和前言知识的信息检索能力,引导学生应理论联系实际,同时要了解本专业科技信息的最新进展和研究动态与走向。 二、实验内容 通过课程的学习,结合老师给出的检索主题,学生应该完成以下内容的实验: 实验一:图书馆专业图书检索(印刷版图书) 实验二:中文科技期刊信息检索 实验三:科技文献数据库信息检索 实验四:网络科技信息检索(含报纸和网络) 文献检索参考主题: 1.工业工程方向: 工业工程;工业工程师的素质、精神、修养、气质与能力;工业工程的本质;企业文化与工业工程;战略工程管理;工程哲学;创新管理;生产管理;品质管理;优化管理或管理的优化;零库存;敏捷制造;敏捷管理;(优秀的、现代的、或未来的)管理哲学;生产管理七大工具;质量管理;设备管理;基础管理;现场管理;六西格玛管理;生产线平衡;工程经济;系统哲学;系统管理;柔性制造;看板管理;工程心理学;管理心理学;激励管理;管理中的真、善、美(或假、恶、丑);工程哲学;工业工程中的责任;安全管理;优化调度;系统工程;系统管理与过程控制;设计哲学;智能管理;工业工程中的数学;智能工业工程,或工业工程的智能化;生态工程管理;绿色工业工程,或绿色管理;协同学与协同管理;工业工程中的协同;概念工程与概念管理;工业工程与蝴蝶效应;管理中的蝴蝶效应,等等…… 2.机械电子工程方向: CAD;CAM;CAE;CAPP;PDM;EPR;CIMS;VD;VM;FMS;PLC;协同设计;协同制造;概念设计;自底向上;自顶向下;智能设计;智能制造;智能材料;特种加工(线切割、电火花、激光加工、电化学加工、超声波加工、光刻技术、快速成型、反求工程);微机械;精密加工;精密制造;机电一体化;自动化;控制论;线性控制;非线性控制;混沌控制;模糊控制;人工智能;神经网络;纳米技术;纳米制造;机器人;智能机器人;传感器;智能传感器;自动化生产线;机械手;智能机械手;自动检测;数据采集;信号处理;信息识别、模式识别等等……

《认知心理学》实验指导

概念形成 简介: 概念是人脑反映事物本质属性的思维形式。个体掌握一类事物本质属性的过程,就是概念形成的过程。实验室中为了研究概念形成的过程,常使用人工概念。 制造人工概念时先确定一个或几个属性作为分类标准,但并不告诉被试,只是将材料交给被试,请其分类。在此过程中,反馈给被试是对还是错。通过这种方法,被试可以发现主试的分类标准,从而学会正确分类,即掌握了这个人工概念。通过人工概念的研究,可以了解概念形成的过程。一般来讲,被试都是经过概括-假设-验证的循环来达到概念形成的。 叶克斯复杂选择器可用来制造人工概念。本实验模拟叶克斯复杂选择器来研究简单空间位置关系概念的形成。 方法与程序: 本实验共有4个人工概念,难度顺次增加,被试可以任选其中1个。 实验时,屏幕上会出现十二个圆键,有空心和实心两种。其中只有一个实心圆与声音相联系,此键出现的相对位置是有规律的,被试要去发现其中的规律(概念),找到这个键。被试用鼠标点击相应的实心圆,如果没有发生任何变化,表明选择错误;如果有声音呈现,同时该圆变为红色,则表明选择正确。只有选择正确,才能继续下一试次。当连续三次第一遍点击就找对了位置时,就认为被试已形成了该人工概念,实验即结束。如果被试在60个试次内不能形成正确概念,实验自动终止。 结果与讨论: 结果文件第一行是被试达到标准所用的遍数(不包括连续第一次就对的三遍)。其后的结果分三列印出:第一列是遍数;第二列为每遍中反应错的次数,如为0则表示这一遍第一次就做对了;第三列表示这一遍所用的时间,以毫秒为单位。 根据结果试说明被试概念形成的过程。 交叉参考:思维策略 参考文献: 杨博民主编心理实验纲要北京大学出版社 319-321页

华南理工大学《模式识别》大作业报告

华南理工大学《模式识别》大作业报告 题目:模式识别导论实验 学院计算机科学与工程 专业计算机科学与技术(全英创新班) 学生姓名黄炜杰 学生学号201230590051 指导教师吴斯 课程编号145143 课程学分2分 起始日期2015年5月18日

实验概述 【实验目的及要求】 Purpose: Develop classifiers,which take input features and predict the labels. Requirement: ?Include explanations about why you choose the specific approaches. ?If your classifier includes any parameter that can be adjusted,please report the effectiveness of the parameter on the final classification result. ?In evaluating the results of your classifiers,please compute the precision and recall values of your classifier. ?Partition the dataset into2folds and conduct a cross-validation procedure in measuring the performance. ?Make sure to use figures and tables to summarize your results and clarify your presentation. 【实验环境】 Operating system:window8(64bit) IDE:Matlab R2012b Programming language:Matlab

《人工智能及其应用》实验指导书Word版

《人工智能及其应用》 实验指导书 浙江工业大学计算机科学与技术学院—人工智能课程组 2011年9月

前言 本实验是为了配合《人工智能及其应用》课程的理论学习而专门设置的。本实验的目的是巩固和加强人工智能的基本原理和方法,并为今后进一步学习更高级课程和信息智能化技术的研究与系统开发奠定良好的基础。 全书共分为八个实验:1.产生式系统实验;2.模糊推理系统实验;3.A*算法求解8数码问题实验;4.A*算法求解迷宫问题实验;5.遗传算法求解函数最值问题实验;6.遗传算法求解TSP问题实验;7.基于神经网络的模式识别实验;8.基于神经网络的优化计算实验。每个实验包括有:实验目的、实验内容、实验条件、实验要求、实验步骤和实验报告等六个项目。 本实验指导书包括两个部分。第一个部分是介绍实验的教学大纲;第二部分是介绍八个实验的内容。 由于编者水平有限,本实验指导书的错误和不足在所难免,欢迎批评指正。 人工智能课程组 2011年9月

目录 实验教学大纲 (1) 实验一产生式系统实验 (3) 实验二模糊推理系统实验 (5) 实验三A*算法实验I (9) 实验四A*算法实验II (12) 实验五遗传算法实验I (14) 实验六遗传算法实验II (18) 实验七基于神经网络的模式识别实验 (20) 实验八基于神经网络的优化计算实验 (24)

实验教学大纲 一、学时:16学时,一般安排在第9周至第16周。 二、主要仪器设备及运行环境:PC机、Visual C++ 6.0、Matlab 7.0。 三、实验项目及教学安排 序号实验名称实验 平台实验内容学 时 类型教学 要求 1产生式系统应用VC++设计知识库,实现系统识别或 分类等。 2设计课内 2模糊推理系统应用Matlab1)设计洗衣机的模糊控制器; 2)设计两车追赶的模糊控制 器。 2验证课内 3A*算法应用I VC++设计与实现求解N数码问题的 A*算法。 2综合课内4A*算法应用II VC++设计与实现求解迷宫问题的A* 算法。 2综合课内5遗传算法应用I Matlab1)求某一函数的最小值; 2)求某一函数的最大值。 2验证课内6遗传算法应用II VC++设计与实现求解不同城市规模 的TSP问题的遗传算法。 2综合课内 7基于神经网络的模式识别Matlab1)基于BP神经网络的数字识 别设计; 2)基于离散Hopfiel神经网络 的联想记忆设计。 2验证课内 8基于神经网络的 优化计算 VC++设计与实现求解TSP问题的连2综合课内 四、实验成绩评定 实验课成绩单独按五分制评定。凡实验成绩不及格者,该门课程就不及格。学生的实验成绩应以平时考查为主,一般应占课程总成绩的50%,其平时成绩又要以实验实际操作的优劣作为主要考核依据。对于实验课成绩,无论采取何种方式进行考核,都必须按实验课的目的要求,以实际实验工作能力的强弱作为评定成绩的主要依据。

《模式识别》实验报告

《模式识别》实验报告 一、数据生成与绘图实验 1.高斯发生器。用均值为m,协方差矩阵为S 的高斯分布生成N个l 维向量。 设置均值 T m=-1,0 ?? ??,协方差为[1,1/2;1/2,1]; 代码: m=[-1;0]; S=[1,1/2;1/2,1]; mvnrnd(m,S,8) 结果显示: ans = -0.4623 3.3678 0.8339 3.3153 -3.2588 -2.2985 -0.1378 3.0594 -0.6812 0.7876 -2.3077 -0.7085 -1.4336 0.4022 -0.6574 -0.0062 2.高斯函数计算。编写一个计算已知向量x的高斯分布(m, s)值的Matlab函数。 均值与协方差与第一题相同,因此代码如下: x=[1;1]; z=1/((2*pi)^0.5*det(S)^0.5)*exp(-0.5*(x-m)'*inv(S)*(x-m)) 显示结果: z = 0.0623 3.由高斯分布类生成数据集。编写一个Matlab 函数,生成N 个l维向量数据集,它们是基于c个本体的高斯分布(mi , si ),对应先验概率Pi ,i= 1,……,c。 M文件如下: function [X,Y] = generate_gauss_classes(m,S,P,N) [r,c]=size(m); X=[]; Y=[]; for j=1:c t=mvnrnd(m(:,j),S(:,:,j),fix(P(j)*N)); X=[X t]; Y=[Y ones(1,fix(P(j)*N))*j]; end end

调用指令如下: m1=[1;1]; m2=[12;8]; m3=[16;1]; S1=[4,0;0,4]; S2=[4,0;0,4]; S3=[4,0;0,4]; m=[m1,m2,m3]; S(:,:,1)=S1; S(:,:,2)=S2; S(:,:,3)=S3; P=[1/3,1/3,1/3]; N=10; [X,Y] = generate_gauss_classes(m,S,P,N) 二、贝叶斯决策上机实验 1.(a)由均值向量m1=[1;1],m2=[7;7],m3=[15;1],方差矩阵S 的正态分布形成三个等(先验)概率的类,再基于这三个类,生成并绘制一个N=1000 的二维向量的数据集。 (b)当类的先验概率定义为向量P =[0.6,0.3,0.1],重复(a)。 (c)仔细分析每个类向量形成的聚类的形状、向量数量的特点及分布参数的影响。 M文件代码如下: function plotData(P) m1=[1;1]; S1=[12,0;0,1]; m2=[7;7]; S2=[8,3;3,2]; m3=[15;1]; S3=[2,0;0,2]; N=1000; r1=mvnrnd(m1,S1,fix(P(1)*N)); r2=mvnrnd(m2,S2,fix(P(2)*N)); r3=mvnrnd(m3,S3,fix(P(3)*N)); figure(1); plot(r1(:,1),r1(:,2),'r.'); hold on; plot(r2(:,1),r2(:,2),'g.'); hold on; plot(r3(:,1),r3(:,2),'b.'); end (a)调用指令: P=[1/3,1/3,1/3];

温度控制系统曲线模式识别及仿真

锅炉温度定值控制系统模式识别及仿真专业:电气工程及其自动化姓名:郭光普指导教师:马安仁 摘要本文首先简要介绍了锅炉内胆温度控制系统的控制原理和参数辨识的概念及切线近似法模式识别的基本原理,然后对该系统的温控曲线进行模式识别,而后着重介绍了用串级控制和Smith预估器设计一个新的温度控制系统,并在MATLAB的Simulink中搭建仿真模型进行仿真。 关键词温度控制,模式识别,串级控制,Smith预测控制 ABSTRACT This article first briefly introduced in the boiler the gallbladder temperature control system's control principle and the parameter identification concept and the tangent approximate method pattern recognition basic principle, then controls the curve to this system to carry on the pattern recognition warm, then emphatically introduced designs a new temperature control system with the cascade control and the Smith estimator, and carries on the simulation in the Simulink of MATLAB build simulation model. Key Words:Temperature control, Pattern recognition, Cascade control, Smith predictive control

《人工智能及其应用》实验指导书

《人工智能及其应用》 实验指导书

浙江工业大学计算机科学与技术学院—人工智能课程组 2011年9月

前言 本实验是为了配合《人工智能及其应用》课程的理论学习而专门设置的。本实验的目的是巩固和加强人工智能的基本原理和方法,并为今后进一步学习更高级课程和信息智能化技术的研究与系统开发奠定良好的基础。 全书共分为八个实验:1.产生式系统实验;2.模糊推理系统实验;3.A*算法求解8数码问题实验;4.A*算法求解迷宫问题实验;5.遗传算法求解函数最值问题实验;6.遗传算法求解TSP问题实验;7.基于神经网络的模式识别实验;8.基于神经网络的优化计算实验。每个实验包括有:实验目的、实验内容、实验条件、实验要求、实验步骤和实验报告等六个项目。 本实验指导书包括两个部分。第一个部分是介绍实验的教学大纲;第二部分是介绍八个实验的内容。 由于编者水平有限,本实验指导书的错误和不足在所难免,欢迎批评指正。 人工智能课程组 2011年9月

目录 实验教学大纲 (1) 实验一产生式系统实验 (4) 实验二模糊推理系统实验 (7)

实验三A*算法实验I (13) 实验四A*算法实验II (17) 实验五遗传算法实验I (19) 实验六遗传算法实验II (26) 实验七基于神经网络的模式识别实验 (29) 实验八基于神经网络的优化计算实验 (35)

实验教学大纲 一、学时:16学时,一般安排在第9周至第16周。 二、主要仪器设备及运行环境:PC机、Visual C++ 6.0、Matlab 7.0。 三、实验项目及教学安排 序号实验名称实验 平台实验内容学 时 类型教学 要求 1 产生式系统应用VC++ 设计知识库,实现系统识别或 分类等。 2 设计课内 2 模糊推理系统应 用Matla b 1)设计洗衣机的模糊控制器; 2)设计两车追赶的模糊控制 器。 2 验证课内 3 A*算法应用I VC++ 设计与实现求解N数码问题的 A*算法。 2 综合课内 4 A*算法应用II VC++ 设计与实现求解迷宫问题的A* 算法。 2 综合课内 5 遗传算法应用I Matla b 1)求某一函数的最小值; 2)求某一函数的最大值。 2 验证课内 6 遗传算法应用II VC++ 设计与实现求解不同城市规模 的TSP问题的遗传算法。 2 综合课内7 基于神经网络的Matla1)基于BP神经网络的数字识 2 验证课内

模式识别实验

实验1 图像的贝叶斯分类 1.1 实验目的 将模式识别方法与图像处理技术相结合,掌握利用最小错分概率贝叶斯分类器进行图像分类的基本方法,通过实验加深对基本概念的理解。 1.2 实验仪器设备及软件 HP D538、MATLAB 1.3 实验原理 1.3.1 基本原理 阈值化分割算法是计算机视觉中的常用算法,对灰度图象的阈值分割就是先确定一个处于图像灰度取值范围内的灰度阈值,然后将图像中每个像素的灰度值与这个阈值相比较。并根据比较的结果将对应的像素划分为两类,灰度值大于阈值的像素划分为一类,小于阈值的划分为另一类,等于阈值的可任意划分到两类中的任何一类。此过程中,确定阈值是分割的关键。 对一般的图像进行分割处理通常对图像的灰度分布有一定的假设,或者说是基于一定的图像模型。最常用的模型可描述如下:假设图像由具有单峰灰度分布的目标和背景组成,处于目标和背景内部相邻像素间的灰度值是高度相关的,但处于目标和背景交界处两边的像素灰度值有较大差别,此时,图像的灰度直方图基本上可看作是由分别对应于目标和背景的两个单峰直方图混合构成。而且这两个分布应大小接近,且均值足够远,方差足够小,这种情况下直方图呈现较明显的双峰。类似地,如果图像中包含多个单峰灰度目标,则直方图可能呈现较明显的多峰。 上述图像模型只是理想情况,有时图像中目标和背景的灰度值有部分交错。这时如用全局阈值进行分割必然会产生一定的误差。分割误差包括将目标分为背

景和将背景分为目标两大类。实际应用中应尽量减小错误分割的概率,常用的一种方法为选取最优阈值。这里所谓的最优阈值,就是指能使误分割概率最小的分割阈值。图像的直方图可以看成是对灰度值概率分布密度函数的一种近似。如一幅图像中只包含目标和背景两类灰度区域,那么直方图所代表的灰度值概率密度函数可以表示为目标和背景两类灰度值概率密度函数的加权和。如果概率密度函数形式已知,就有可能计算出使目标和背景两类误分割概率最小的最优阈值。 假设目标与背景两类像素值均服从正态分布且混有加性高斯噪声,上述分类问题可以使用模式识别中的最小错分概率贝叶斯分类器来解决。以1p 与2p 分别表示目标与背景的灰度分布概率密度函数,1P 与2P 分别表示两类的先验概率,则图像的混合概率密度函数可用下式表示 1122()()()p x P p x P p x =+ 式中1p 和2p 分别为 212 1()21()x p x μσ--= 222()22()x p x μσ-- = 121P P += 1σ、2σ是针对背景和目标两类区域灰度均值1μ与2μ的标准差。若假定目标的灰 度较亮,其灰度均值为2μ,背景的灰度较暗,其灰度均值为1μ,因此有 12μμ< 现若规定一门限值T 对图像进行分割,势必会产生将目标划分为背景和将背景划分为目标这两类错误。通过适当选择阈值T ,可令这两类错误概率为最小,则该阈值T 即为最佳阈值。 把目标错分为背景的概率可表示为 12()()T E T p x dx -∞ =? 把背景错分为目标的概率可表示为

模式识别实验报告(一二)

信息与通信工程学院 模式识别实验报告 班级: 姓名: 学号: 日期:2011年12月

实验一、Bayes 分类器设计 一、实验目的: 1.对模式识别有一个初步的理解 2.能够根据自己的设计对贝叶斯决策理论算法有一个深刻地认识 3.理解二类分类器的设计原理 二、实验条件: matlab 软件 三、实验原理: 最小风险贝叶斯决策可按下列步骤进行: 1)在已知 ) (i P ω, ) (i X P ω,i=1,…,c 及给出待识别的X 的情况下,根据贝叶斯公式计 算出后验概率: ∑== c j i i i i i P X P P X P X P 1 ) ()() ()()(ωωωωω j=1,…,x 2)利用计算出的后验概率及决策表,按下面的公式计算出采取i a ,i=1,…,a 的条件风险 ∑== c j j j i i X P a X a R 1 )(),()(ωω λ,i=1,2,…,a 3)对(2)中得到的a 个条件风险值) (X a R i ,i=1,…,a 进行比较,找出使其条件风险最小的 决策k a ,即()() 1,min k i i a R a x R a x == 则 k a 就是最小风险贝叶斯决策。 四、实验内容 假定某个局部区域细胞识别中正常(1ω)和非正常(2ω)两类先验概率分别为 正常状态:P (1ω)=; 异常状态:P (2ω)=。 现有一系列待观察的细胞,其观察值为x : 已知先验概率是的曲线如下图:

)|(1ωx p )|(2ωx p 类条件概率分布正态分布分别为(-2,)(2,4)试对观察的结果 进行分类。 五、实验步骤: 1.用matlab 完成分类器的设计,说明文字程序相应语句,子程序有调用过程。 2.根据例子画出后验概率的分布曲线以及分类的结果示意图。 3.最小风险贝叶斯决策,决策表如下: 结果,并比较两个结果。 六、实验代码 1.最小错误率贝叶斯决策 x=[ ] pw1=; pw2=; e1=-2; a1=; e2=2;a2=2; m=numel(x); %得到待测细胞个数 pw1_x=zeros(1,m); %存放对w1的后验概率矩阵 pw2_x=zeros(1,m); %存放对w2的后验概率矩阵

模式识别实验报告年月

模式识别实验报告-年月

————————————————————————————————作者: ————————————————————————————————日期:

学院: 班级: 姓名: 学号: 2012年3月

实验一 Bay es分类器的设计 一、 实验目的: 1. 对模式识别有一个初步的理解,能够根据自己的设计对贝叶斯决策理论算法有一个深刻地认识; 2. 理解二类分类器的设计原理。 二、 实验条件: 1. PC 微机一台和MA TL AB 软件。 三、 实验原理: 最小风险贝叶斯决策可按下列步骤进行: 1. 在已知 ) (i P ω, )|(i X P ω,c i ,,1 =及给出待识别的X 的情况下,根据贝叶斯 公式计算出后验概率: ∑== c j j j i i i P X P P X P X P 1 ) ()|() ()|()|(ωωωωω c j ,,1 = 2. 利用计算出的后验概率及决策表,按下式计算出采取 i α决策的条件风险: ∑==c j j j i i X P X R 1) |(),()|(ωωαλα a i ,,1 = 3. 对2中得到的a 个条件风险值) |(X R i α(a i ,,1 =)进行比较,找出使条件 风险最小的决策k α,即: ) |(min )|(,,1X R X R k c i k αα ==, 则 k α就是最小风险贝叶斯决策。 四、 实验内容: (以下例为模板,自己输入实验数据) 假定某个局部区域细胞识别中正常(1ω)和非正常(2ω)两类先验概率分别为: 正常状态:)(1ωP =0.9; 异常状态:)(2ωP =0.1。

模式识别实验最小错误率下的贝叶斯决策

《模式识别》实验报告题目:最小错误率贝叶斯决策

一、实验内容 1,实验原理 2,实验步骤 1)从iris.txt 文件(课程邮箱-文件中心)中读取估计参数用的样本,每一类样本抽出前40个,分别求其均值; (2)求每类样本的协方差矩阵、逆矩阵以及协方差矩阵的行列式; (3)对三个类别,分别取每组剩下的 10个样本,每两组进行分类。由于每类样本都相等, 且每类选取用作训练的样本也相等,在每两组进行分类时,待分类样本的类

先验概率为0.5。 将各个样本代入判别函数既公式(5),进行分类。 3,实验要求 (1)复习最小错误率贝叶斯决策原理,写出实验代码,实现对三类样本的分类; (2)计算分类的正确率,画出三维空间的样本分类图; (3)分析实验结果,完成实验报告。 二、实验代码 (1), clear % 原始数据导入 iris=load('iris.txt'); N=40;%每组取N=40个样本 %求第一类样本均值 for i = 1:N for j = 1:4 w1(i,j) = iris(i,j+1); end end sumx1 = sum(w1,1); for i=1:4 meanx1(1,i)=sumx1(1,i)/N; end %求第二类样本均值 for i = 1:N for j = 1:4 w2(i,j) = iris(i+50,j+1); end end sumx2 = sum(w2,1); for i=1:4 meanx2(1,i)=sumx2(1,i)/N; end %求第三类样本均值

for i = 1:N for j = 1:4 w3(i,j) = iris(i+100,j+1); end end sumx3 = sum(w3,1); for i=1:4 meanx3(1,i)=sumx3(1,i)/N; end (2), %求第一类样本协方差矩阵 z1(4,4) = 0; var1(4,4) = 0; for i=1:4 for j=1:4 for k=1:N z1(i,j)=z1(i,j)+(w1(k,i)-meanx1(1,i))*(w1(k,j)-meanx1(1,j)); end var1(i,j) = z1(i,j) / (N-1); end end %求第二类样本协方差矩阵 z2(4,4) = 0 ; var2(4,4) = 0; for i=1:4 for j=1:4 for k=1:N z2(i,j)=z2(i,j)+(w2(k,i)-meanx2(1,i))*(w2(k,j)-meanx2(1,j)); end ar2(i,j) = z2(i,j) / (N-1); end end %求第三类样本协方差矩阵 z3(4,4) = 0 ;

模式识别实验报告

实验一Bayes 分类器设计 本实验旨在让同学对模式识别有一个初步的理解,能够根据自己的设计对贝叶斯决策理论算法有一个深刻地认识,理解二类分类器的设计原理。 1实验原理 最小风险贝叶斯决策可按下列步骤进行: (1)在已知)(i P ω,)(i X P ω,i=1,…,c 及给出待识别的X 的情况下,根据贝叶斯公式计算出后验概率: ∑== c j i i i i i P X P P X P X P 1 ) ()() ()()(ωωωωω j=1,…,x (2)利用计算出的后验概率及决策表,按下面的公式计算出采取i a ,i=1,…,a 的条件风险 ∑== c j j j i i X P a X a R 1 )(),()(ωω λ,i=1,2,…,a (3)对(2)中得到的a 个条件风险值)(X a R i ,i=1,…,a 进行比较,找出使其条件风险最小的决策k a ,即 则k a 就是最小风险贝叶斯决策。 2实验内容 假定某个局部区域细胞识别中正常(1ω)和非正常(2ω)两类先验概率分别为 正常状态:P (1ω)=0.9; 异常状态:P (2ω)=0.1。

现有一系列待观察的细胞,其观察值为x : -3.9847 -3.5549 -1.2401 -0.9780 -0.7932 -2.8531 -2.7605 -3.7287 -3.5414 -2.2692 -3.4549 -3.0752 -3.9934 2.8792 -0.9780 0.7932 1.1882 3.0682 -1.5799 -1.4885 -0.7431 -0.4221 -1.1186 4.2532 已知类条件概率密度曲线如下图: )|(1ωx p )|(2ωx p 类条件概率分布正态分布分别为(-2,0.25)(2,4)试对观察的结果进 行分类。 3 实验要求 1) 用matlab 完成分类器的设计,要求程序相应语句有说明文字。 2) 根据例子画出后验概率的分布曲线以及分类的结果示意图。 3) 如果是最小风险贝叶斯决策,决策表如下:

模式识别作业--两类贝叶斯分类

深圳大学研究生课程:模式识别理论与方法 课程作业实验报告 实验名称:Bayes Classifier 实验编号:proj02-01 姓名:汪长泉 学号:2100130303 规定提交日期:2010年10月20日 实际提交日期:2010年10月20日 摘要:在深入掌握多维高斯分布性质,贝叶斯分类的基础上,用计算机编程实现一个分类两类模式样本的贝叶斯分类器。用matlab编程,并分析了实验结果,得出贝叶斯分类的一般结论。

1. 贝叶斯分类器 贝叶斯分类器的分类原理是通过某对象的先验概率,利用贝叶斯公式计算出其后验概率,即该对象属于某一类的概率,选择具有最大后验概率的类作为该对象所属的类。 1.1 两类情况 两类情况是多类情况的基础,多类情况往往是用多个两类情况解决的。 ① 用i ω,i =1, 2表示样本x (一般用列向量表示)所属的类别。 ② 假设先验概率()P ω1,()P ω2已知。(这个假设是合理的,因为如果先验概率未知,可以从训 练特征向量中估算出来,即如果N 是训练样本总数,其中有,N N 12个样本分别属于 2,1ωω,则相应的先验概率: ()/P N N ω≈11,2 ()/P N N ω≈2) ③ 假设(类)条件概率密度函数 (|),i p ωx i =1,2 已知,用来描述每一类中特征向量的分 布情况。如果类条件概率密度函数未知,则可以从可用的训练数据中估计出来。 1.2贝叶斯判别方法 贝叶斯分类规则描述为: 如果2(|)(|)P ωP ω>1x x ,则x ∈1ω 如果2(|)(|)P ωP ω<1x x ,则x ∈2ω (2-1-1) 贝叶斯分类规则就是看x ∈ω1的可能性大,还是x ∈2ω的可能性大。(|)i P ωx , i =1,2解释为当样本x 出现时,后验概率(|)P ω1x 和(|)P ω2x 的大小从而判别为属于 1ω或属于2ω类。 1.3三种概率的关系――――贝叶斯公式 ()() (|)= () i i i p |P P p ωωωx x x (2-1-3) 其中,()p x 是x 的概率密度函数(全概率密度),它等于所有可能的类概率密度函数乘以相应的先验概率之和。 ()(|)()i i i p p P ωω==∑2 1 x x