MPI函数简表-C-Fortran

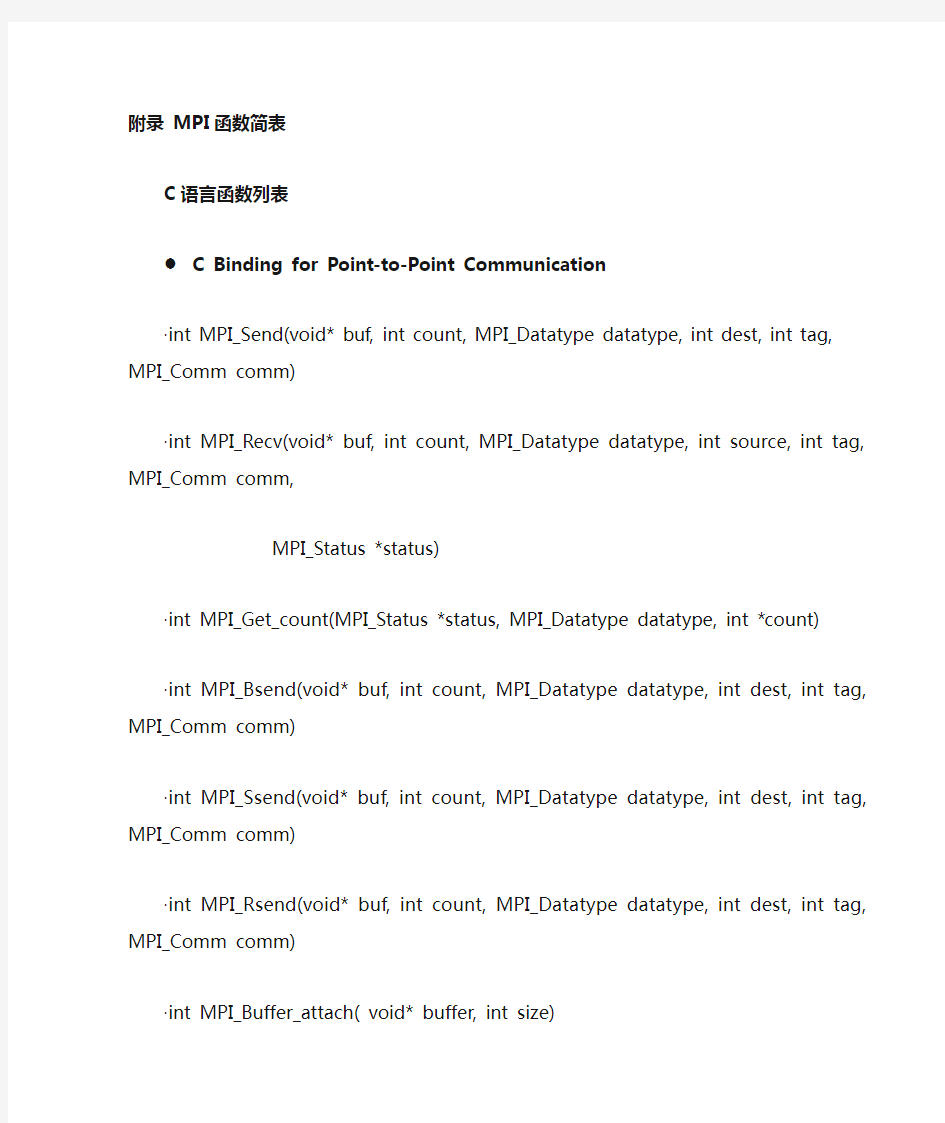

附录MPI函数简表

C语言函数列表

C Binding for Point-to-Point Communication

·int MPI_Send(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm) ·int MPI_Recv(void* buf, int count, MPI_Datatype datatype, int source, int tag, MPI_Comm comm, MPI_Status *status)

·int MPI_Get_count(MPI_Status *status, MPI_Datatype datatype, int *count)

·int MPI_Bsend(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm) ·int MPI_Ssend(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm) ·int MPI_Rsend(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm) ·int MPI_Buffer_attach( void* buffer, int size)

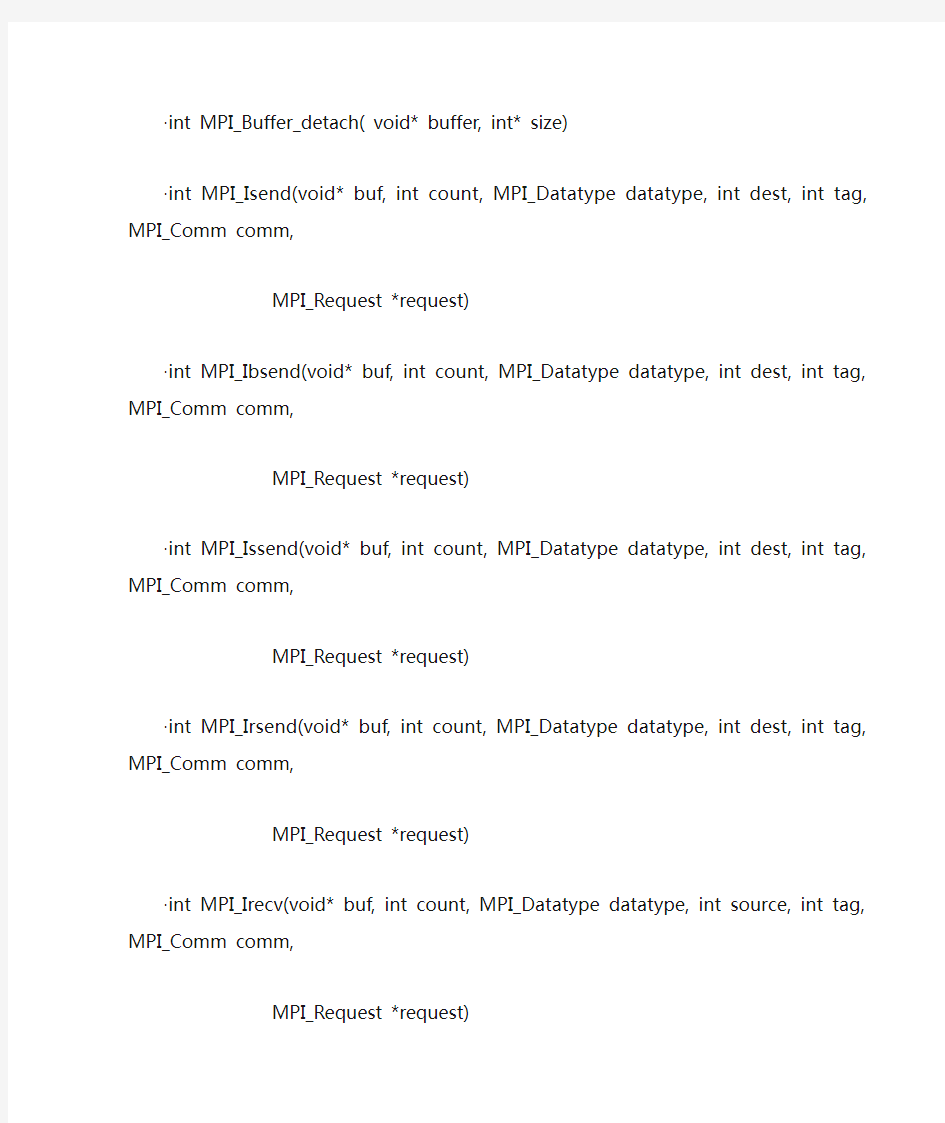

·int MPI_Buffer_detach( void* buffer, int* size)

·int MPI_Isend(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm, MPI_Request *request)

·int MPI_Ibsend(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm, MPI_Request *request)

·int MPI_Issend(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm, MPI_Request *request)

·int MPI_Irsend(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm, MPI_Request *request)

·int MPI_Irecv(void* buf, int count, MPI_Datatype datatype, int source, int tag, MPI_Comm comm, MPI_Request *request)

·int MPI_Wait(MPI_Request *request, MPI_Status *status)

·int MPI_Test(MPI_Request *request, int *flag, MPI_Status *status)

·int MPI_Request_free(MPI_Request *request)

·int MPI_Waitany(int count, MPI_Request *array_of_requests, int *index, MPI_Status *status) ·int MPI_Testany(int count, MPI_Request *array_of_requests, int *index, int *flag, MPI_Status *status)

·int MPI_Waitall(int count, MPI_Request *array_of_requests, MPI_Status *array_of_statuses) ·int MPI_Testall(int count, MPI_Request *array_of_requests, int *flag, MPI_Status

*array_of_statuses)

· int MPI_Waitsome(int incount, MPI_Request *array_of_requests, int *outcount,

int *array_of_indices, MPI_Status *array_of_statuses)

˙int MPI_Testsome(int incount, MPI_Request *array_of_requests, int *outcount,

int *array_of_indices, MPI_Status *array_of_statuses)

·int MPI_Iprobe(int source, int tag, MPI_Comm comm, int *flag, MPI_Status *status)

·int MPI_Probe(int source, int tag, MPI_Comm comm, MPI_Status *status)

·int MPI_Cancel(MPI_Request *request)

·int MPI_Test_cancelled(MPI_Status *status, int *flag)

·int MPI_Send_init(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm,

MPI_Request *request)

·int MPI_Bsend_init(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm,

MPI_Request *request)

·int MPI_Ssend_init(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm,

MPI_Request *request)

·int MPI_Rsend_init(void* buf, int count, MPI_Datatype datatype, int dest, int tag, MPI_Comm comm,

MPI_Request *request)

·int MPI_Recv_init(void* buf, int count, MPI_Datatype datatype, int source, int tag, MPI_Comm comm,

MPI_Request *request)

·int MPI_Start(MPI_Request *request)

·int MPI_Startall(int count, MPI_Request *array_of_requests)

·int MPI_Sendrecv(void *sendbuf, int sendcount, MPI_Datatype sendtype, int dest, int sendtag, void

*recvbuf, int recvcount, MPI_Datatype recvtype, int source, MPI_Datatype recvtag,

MPI_Comm comm, MPI_Status *status)

·int MPI_Sendrecv_replace(void* buf, int count, MPI_Datatype datatype, int dest, int sendtag, int

source, int recvtag, MPI_Comm comm, MPI_Status *status)

·int MPI_Type_contiguous(int count, MPI_Datatype oldtype, MPI_Datatype *newtype)

·int MPI_Type_vector(int count, int blocklength, int stride, MPI_Datatype oldtype, MPI_Datatype *newtype)

·int MPI_Type_hvector(int count, int blocklength, MPI_Aint stride, MPI_Datatype oldtype,

MPI_Datatype *newtype)

·int MPI_Type_indexed(int count, int *array_of_blocklengths, int *array_of_displacements, MPI_Datatype oldtype, MPI_Datatype *newtype)

·int MPI_Type_hindexed(int count, int *array_of_blocklengths, MPI_Aint *array_of_displacements, MPI_Datatype oldtype, MPI_Datatype *newtype)

·int MPI_Type_struct(int count, int *array_of_blocklengths, MPI_Aint *array_of_displacements, MPI_Datatype *array_of_types, MPI_Datatype *newtype)

·int MPI_Address(void* location, MPI_Aint *address)

·int MPI_Type_extent(MPI_Datatype datatype, MPI_Aint *extent)

·int MPI_Type_size(MPI_Datatype datatype, int *size)

·int MPI_Type_lb(MPI_Datatype datatype, MPI_Aint* displacement)

·int MPI_Type_ub(MPI_Datatype datatype, MPI_Aint* displacement) 、

·int MPI_Type_commit(MPI_Datatype *datatype)

·int MPI_Type_free(MPI_Datatype *datatype)

·int MPI_Get_elements(MPI_Status *status, MPI_Datatype datatype, int *count)

·int MPI_Pack(void* inbuf, int incount, MPI_Datatype datatype, void *outbuf, int outsize, int *position, MPI_Comm comm)

·int MPI_Unpack(void* inbuf, int insize, int *position, void *outbuf, int outcount, MPI_Datatype datatype, MPI_Comm comm)

·int MPI_Pack_size(int incount, MPI_Datatype datatype, MPI_Comm comm, int *size)

● C Binding for Collective Communication:

·int MPI_Barrier(MPI_Comm comm )

·int MPI_Bcast(void* buffer, int count, MPI_Datatype datatype, int root, MPI_Comm comm ) ·int MPI_Gather(void* sendbuf, int sendcount, MPI_Datatype sendtype, void* recvbuf, int recvcount,

MPI_Datatype recvtype, int root, MPI_Comm comm)

· int MPI_Gatherv(void* sendbuf, int sendcount, MPI_Datatype sendtype, void* recvbuf,

int *recvcounts, int *displs, MPI_Datatype recvtype, int root, MPI_Comm comm) ·int MPI_Scatter(void* sendbuf, int sendcount, MPI_Datatype sendtype, void* recvbuf, int recvcount,

MPI_Datatype recvtype, int root, MPI_Comm comm)

·int MPI_Scatterv(void* sendbuf, int *sendcounts, int *displs, MPI_Datatype sendtype, void* recvbuf, ·int recvcount, MPI_Datatype recvtype, int root, MPI_Comm comm) · int MPI_Allgather(void* sendbuf, int sendcount, MPI_Datatype sendtype, void* recvbuf,

int recvcount, MPI_Datatype recvtype, MPI_Comm comm)

·int MPI_Allgatherv(void* sendbuf, int sendcount, MPI_Datatype sendtype, void* recvbuf, int *recvcounts, int *displs, MPI_Datatype recvtype, MPI_Comm comm)

·int MPI_Alltoall(void* sendbuf, int sendcount, MPI_Datatype sendtype, void* recvbuf, int recvcount,

MPI_Datatype recvtype, MPI_Comm comm)

·int MPI_Alltoallv(void* sendbuf, int *sendcounts, int *sdispls, MPI_Datatype sendtype,

void* recvbuf, int *recvcounts, int *rdispls, MPI_Datatype recvtype,

MPI_Comm comm)

·int MPI_Reduce(void* sendbuf, void* recvbuf, int count, MPI_Datatype datatype, MPI_Op op, int root, MPI_Comm comm)

·int MPI_Op_create(MPI_User_function *function, int commute, MPI_Op *op)

·int MPI_Op_free( MPI_Op *op)

·int MPI_Allreduce(void* sendbuf, void* recvbuf, int count, MPI_Datatype datatype, MPI_Op op, MPI_Comm comm)

·int MPI_Reduce_scatter(void* sendbuf, void* recvbuf, int *recvcounts, MPI_Datatype datatype, MPI_Op op, MPI_Comm comm)

·int MPI_Scan(void* sendbuf, void* recvbuf, int count, MPI_Datatype datatype, MPI_Op op,

MPI_Comm comm )

● C binding for Groups,Contexts,and Communicator:

·int MPI_Group_size(MPI_Group group, int *size)

·int MPI_Group_rank(MPI_Group group, int *rank)

·int MPI_Group_translate_ranks (MPI_Group group1, int n, int *ranks1, MPI_Group group2, int

*ranks2)

·int MPI_Group_compare(MPI_Group group1,MPI_Group group2, int *result)

·int MPI_Comm_group(MPI_Comm comm, MPI_Group *group)

·int MPI_Group_union(MPI_Group group1, MPI_Group group2, MPI_Group *newgroup)

·int MPI_Group_intersection(MPI_Group group1, MPI_Group group2, MPI_Group *newgroup)

·int MPI_Group_difference(MPI_Group group1, MPI_Group group2, MPI_Group *newgroup)

·int MPI_Group_incl(MPI_Group group, int n, int *ranks, MPI_Group *newgroup)

·int MPI_Group_excl(MPI_Group group, int n, int *ranks, MPI_Group *newgroup)

·int MPI_Group_range_incl(MPI_Group group, int n, int ranges[][3], MPI_Group *newgroup) ·int MPI_Group_range_excl(MPI_Group group, int n, int ranges[][3], MPI_Group *newgroup) ·int MPI_Group_free(MPI_Group *group)

·int MPI_Comm_size(MPI_Comm comm, int *size)

·int MPI_Comm_rank(MPI_Comm comm, int *rank)

·int MPI_Comm_compare(MPI_Comm comm1,MPI_Comm comm2, int *result)

·int MPI_Comm_dup(MPI_Comm comm, MPI_Comm *newcomm)

·int MPI_Comm_create(MPI_Comm comm, MPI_Group group, MPI_Comm *newcomm)

·int MPI_Comm_split(MPI_Comm comm, int color, int key, MPI_Comm *newcomm)

·int MPI_Comm_free(MPI_Comm *comm)

·int MPI_Comm_test_inter(MPI_Comm comm, int *flag)

·int MPI_Comm_remote_size(MPI_Comm comm, int *size)

·int MPI_Comm_remote_group(MPI_Comm comm, MPI_Group *group)

·int MPI_Intercomm_create(MPI_Comm local_comm, int local_leader, MPI_Comm peer_comm,

·int remote_leader, int tag, MPI_Comm *newintercomm)

·int MPI_Intercomm_merge(MPI_Comm intercomm, int high, MPI_Comm *newintracomm)

·int MPI_Keyval_create(MPI_Copy_function *copy_fn, MPI_Delete_function *delete_fn, int *keyval, void* extra_state)

·int MPI_Keyval_free(int *keyval)

·int MPI_Attr_put(MPI_Comm comm, int keyval, void* attribute_val)

·int MPI_Attr_get(MPI_Comm comm, int keyval, void* attribute_val, int *flag)

·int MPI_Attr_delete(MPI_Comm comm, int keyval)

C Binding for Process Topologies:

·int MPI_Cart_create(MPI_Comm comm_old, int ndims, int *dims, int *periods, int reorder,

MPI_Comm *comm_cart)

·int MPI_Dims_create(int nnodes, int ndims, int *dims)

·int MPI_Graph_create(MPI_Comm comm_old, int nnodes, int *index, int *edges, int reorder,

MPI_Comm *comm_graph)

·int MPI_Topo_test(MPI_Comm comm, int *status)

·int MPI_Graphdims_get(MPI_Comm comm, int *nnodes, int *nedges)

·int MPI_Graph_get(MPI_Comm comm, int maxindex, int maxedges, int *index, int *edges)

·int MPI_Cartdim_get(MPI_Comm comm, int *ndims)

·int MPI_Cart_get(MPI_Comm comm, int maxdims, int *dims, int *periods, int *coords)

·int MPI_Cart_rank(MPI_Comm comm, int *coords, int *rank)

·int MPI_Cart_coords(MPI_Comm comm, int rank, int maxdims, int *coords)

·int MPI_Graph_neighbors_count(MPI_Comm comm, int rank, int *nneighbors)

·int MPI_Graph_neighbors(MPI_Comm comm, int rank, int maxneighbors, int *neighbors)

·int MPI_Cart_shift(MPI_Comm comm, int direction, int disp, int *rank_source, int *rank_dest) ·int MPI_Cart_sub(MPI_Comm comm, int *remain_dims, MPI_Comm *newcomm)

·int MPI_Cart_map(MPI_Comm comm, int ndims, int *dims, int *periods, int *newrank)

·int MPI_Graph_map(MPI_Comm comm, int nnodes, int *index, int *edges, int *newrank)

● C Binding for Envoronmental Inquery:

·int MPI_Get_processor_name(char *name, int *resultlen)

·int MPI_Errhandler_create(MPI_Handler_function *function, MPI_Errhandler *errhandler)

·int MPI_Errhandler_set(MPI_Comm comm, MPI_Errhandler errhandler)

·int MPI_Errhandler_get(MPI_Comm comm, MPI_Errhandler *errhandler)

·int MPI_Errhandler_free(MPI_Errhandler *errhandler)

·int MPI_Error_string(int errorcode, char *string, int *resultlen)

·int MPI_Error_class(int errorcode, int *errorclass)

·int double MPI_Wtime(void)

·int double MPI_Wtick(void)

·int MPI_Init(int *argc, char ***argv)

·int MPI_Finalize(void)

·int MPI_Initialized(int *flag)

·int MPI_Abort(MPI_Comm comm, int errorcode)

● C Binding for Profiling:

·int MPI_Pcontrol(const int level, ...)

Fortran语言函数列表

●Fortran Binding for Point-to Point Communication:

·MPI_SEND(BUF, COUNT, DATATYPE, DEST, TAG, COMM, IERROR)

INTEGER COUNT, DATATYPE, DEST, TAG, COMM, IERROR

·MPI_RECV(BUF, COUNT, DATATYPE, SOURCE, TAG, COMM, STATUS, IERROR)

INTEGER COUNT, DATATYPE, SOURCE, TAG, COMM, STATUS(MPI_STATUS_SIZE), IERROR

·MPI_GET_COUNT(STATUS, DATATYPE, COUNT, IERROR)

INTEGER STATUS(MPI_STATUS_SIZE), DATATYPE, COUNT, IERROR

·MPI_BSEND(BUF, COUNT, DATATYPE, DEST, TAG, COMM, IERROR)

INTEGER COUNT, DATATYPE, DEST, TAG, COMM, IERROR

·MPI_SSEND(BUF, COUNT, DATATYPE, DEST, TAG, COMM, IERROR)

INTEGER COUNT, DATATYPE, DEST, TAG, COMM, IERROR

·MPI_RSEND(BUF, COUNT, DATATYPE, DEST, TAG, COMM, IERROR)

INTEGER COUNT, DATATYPE, DEST, TAG, COMM, IERROR

·MPI_BUFFER_ATTACH( BUFFER, SIZE, IERROR)

INTEGER SIZE, IERROR

·MPI_BUFFER_DETACH( BUFFER, SIZE, IERROR)

INTEGER SIZE, IERROR

·MPI_ISEND(BUF, COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR)

INTEGER COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR

·MPI_IBSEND(BUF, COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR)

INTEGER COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR

·MPI_ISSEND(BUF, COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR)

INTEGER COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR

·MPI_IRSEND(BUF, COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR)

INTEGER COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR

·MPI_IRECV(BUF, COUNT, DATATYPE, SOURCE, TAG, COMM, REQUEST, IERROR)

INTEGER COUNT, DATATYPE, SOURCE, TAG, COMM, REQUEST, IERROR

·MPI_WAIT(REQUEST, STATUS, IERROR)

INTEGER REQUEST, STATUS(MPI_STATUS_SIZE), IERROR

·MPI_TEST(REQUEST, FLAG, STATUS, IERROR)

LOGICAL FLAG

INTEGER REQUEST, STATUS(MPI_STATUS_SIZE), IERROR

·MPI_REQUEST_FREE(REQUEST, IERROR)

INTEGER REQUEST, IERROR

·MPI_WAITANY(COUNT, ARRAY_OF_REQUESTS, INDEX, STATUS, IERROR)

INTEGER COUNT, ARRAY_OF_REQUESTS(*), INDEX, STATUS(MPI_STATUS_SIZE), IERROR ·MPI_TESTANY(COUNT, ARRAY_OF_REQUESTS, INDEX, FLAG, STATUS, IERROR)

LOGICAL FLAG

INTEGER COUNT, ARRAY_OF_REQUESTS(*), INDEX, STATUS(MPI_STATUS_SIZE), IERROR ·MPI_WAITALL(COUNT, ARRAY_OF_REQUESTS, ARRAY_OF_STATUSES, IERROR)

INTEGER COUNT, ARRAY_OF_REQUESTS(*), ARRAY_OF_STATUSES(MPI_STATUS_SIZE,*), IERROR ·MPI_TESTALL(COUNT, ARRAY_OF_REQUESTS, FLAG, ARRAY_OF_STATUSES, IERROR)

LOGICAL FLAG

INTEGER COUNT, ARRAY_OF_REQUESTS(*), ARRAY_OF_STATUSES(MPI_STATUS_SIZE,*), IERROR

·MPI_WAITSOME(INCOUNT, ARRAY_OF_REQUESTS, OUTCOUNT, ARRAY_OF_INDICES, ARRAY_OF_STATUSES, IERROR)

INTEGER INCOUNT, ARRAY_OF_REQUESTS(*), OUTCOUNT, ARRAY_OF_INDICES(*),

ARRAY_OF_STATUSES(MPI_STATUS_SIZE,*), IERROR

·MPI_TESTSOME(INCOUNT, ARRAY_OF_REQUESTS, OUTCOUNT, ARRAY_OF_INDICES, ARRAY_OF_STATUSES, IERROR)

INTEGER INCOUNT, ARRAY_OF_REQUESTS(*), OUTCOUNT, ARRAY_OF_INDICES(*),

ARRAY_OF_STATUSES(MPI_STATUS_SIZE,*), IERROR

·MPI_IPROBE(SOURCE, TAG, COMM, FLAG, STATUS, IERROR)

LOGICAL FLAG

INTEGER SOURCE, TAG, COMM, STATUS(MPI_STATUS_SIZE), IERROR

·MPI_PROBE(SOURCE, TAG, COMM, STATUS, IERROR)

INTEGER SOURCE, TAG, COMM, STATUS(MPI_STATUS_SIZE), IERROR

·MPI_CANCEL(REQUEST, IERROR)

INTEGER REQUEST, IERROR

·MPI_TEST_CANCELLED(STATUS, FLAG, IERROR)

LOGICAL FLAG

INTEGER STATUS(MPI_STATUS_SIZE), IERROR

·MPI_SEND_INIT(BUF, COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR)

INTEGER REQUEST, COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR

·MPI_BSEND_INIT(BUF, COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR)

INTEGER REQUEST, COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR

·MPI_SSEND_INIT(BUF, COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR)

INTEGER COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR

·MPI_RSEND_INIT(BUF, COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR)

INTEGER COUNT, DATATYPE, DEST, TAG, COMM, REQUEST, IERROR

·MPI_RECV_INIT(BUF, COUNT, DATATYPE, SOURCE, TAG, COMM, REQUEST, IERROR)

INTEGER COUNT, DATATYPE, SOURCE, TAG, COMM, REQUEST, IERROR

·MPI_START(REQUEST, IERROR)

INTEGER REQUEST, IERROR

·MPI_STARTALL(COUNT, ARRAY_OF_REQUESTS, IERROR)

INTEGER COUNT, ARRAY_OF_REQUESTS(*), IERROR

·MPI_SENDRECV(SENDBUF, SENDCOUNT, SENDTYPE, DEST, SENDTAG, RECVBUF, RECVCOUNT, RECVTYPE, SOURCE, RECVTAG, COMM, STATUS, IERROR)

INTEGER SENDCOUNT, SENDTYPE, DEST, SENDTAG, RECVCOUNT, RECVTYPE, SOURCE, RECVTAG, COMM,

STATUS(MPI_STATUS_SIZE), IERROR

·MPI_SENDRECV_REPLACE(BUF, COUNT, DATATYPE, DEST, SENDTAG, SOURCE, RECVTAG, COMM, STATUS, IERROR)

INTEGER COUNT, DATATYPE, DEST, SENDTAG, SOURCE, RECVTAG, COMM, STATUS(MPI_STATUS_SIZE), IERROR

·MPI_TYPE_CONTIGUOUS(COUNT, OLDTYPE, NEWTYPE, IERROR)

INTEGER COUNT, OLDTYPE, NEWTYPE, IERROR

·MPI_TYPE_VECTOR(COUNT, BLOCKLENGTH, STRIDE, OLDTYPE, NEWTYPE, IERROR)

INTEGER COUNT, BLOCKLENGTH, STRIDE, OLDTYPE, NEWTYPE, IERROR

·MPI_TYPE_HVECTOR(COUNT, BLOCKLENGTH, STRIDE, OLDTYPE, NEWTYPE, IERROR)

INTEGER COUNT, BLOCKLENGTH, STRIDE, OLDTYPE, NEWTYPE, IERROR

·MPI_TYPE_INDEXED(COUNT, ARRAY_OF_BLOCKLENGTHS, ARRAY_OF_DISPLACEMENTS, OLDTYPE, NEWTYPE, IERROR)

INTEGER COUNT, ARRAY_OF_BLOCKLENGTHS(*), ARRAY_OF_DISPLACEMENTS(*), OLDTYPE, NEWTYPE, IERROR ·MPI_TYPE_HINDEXED(COUNT,ARRAY_OF_BLOCKLENGTHS,ARRAY_OF_DISPLACEMENTS, OLDTYPE, NEWTYPE, IERROR)

INTEGER COUNT, ARRAY_OF_BLOCKLENGTHS(*), ARRAY_OF_DISPLACEMENTS(*), OLDTYPE, NEWTYPE, IERROR ·MPI_TYPE_STRUCT(COUNT, ARRAY_OF_BLOCKLENGTHS, ARRAY_OF_DISPLACEMENTS, ARRAY_OF_TYPES, NEWTYPE,

IERROR)

INTEGER COUNT,ARRAY_OF_BLOCKLENGTHS(*),ARRAY_OF_DISPLACEMENTS(*), ARRAY_OF_TYPES(*), NEWTYPE,

IERROR

·MPI_ADDRESS(LOCATION, ADDRESS, IERROR)

INTEGER ADDRESS, IERROR

·MPI_TYPE_EXTENT(DATATYPE, EXTENT, IERROR)

INTEGER DATATYPE, EXTENT, IERROR

·MPI_TYPE_SIZE(DATATYPE, SIZE, IERROR)

INTEGER DATATYPE, SIZE, IERROR

·MPI_TYPE_LB( DATATYPE, DISPLACEMENT, IERROR)

INTEGER DATATYPE, DISPLACEMENT, IERROR

·MPI_TYPE_UB( DATATYPE, DISPLACEMENT, IERROR)

INTEGER DATATYPE, DISPLACEMENT, IERROR

·MPI_TYPE_COMMIT(DATATYPE, IERROR)

INTEGER DATATYPE, IERROR

·MPI_TYPE_FREE(DATATYPE, IERROR)

INTEGER DATATYPE, IERROR

·MPI_GET_ELEMENTS(STATUS, DATATYPE, COUNT, IERROR)

INTEGER STATUS(MPI_STATUS_SIZE), DATATYPE, COUNT, IERROR

·MPI_PACK(INBUF, INCOUNT, DATATYPE, OUTBUF, OUTSIZE, POSITION, COMM, IERROR)

INTEGER INCOUNT, DATATYPE, OUTSIZE, POSITION, COMM, IERROR

·MPI_UNPACK(INBUF, INSIZE, POSITION, OUTBUF, OUTCOUNT, DATATYPE, COMM, IERROR)

INTEGER INSIZE, POSITION, OUTCOUNT, DATATYPE, COMM, IERROR

·MPI_PACK_SIZE(INCOUNT, DATATYPE, COMM, SIZE, IERROR)

INTEGER INCOUNT, DATATYPE, COMM, SIZE, IERROR

Fortran Binding for Collective Communication:

·MPI_BARRIER(COMM, IERROR)

INTEGER COMM, IERROR

·MPI_BCAST(BUFFER, COUNT, DATATYPE, ROOT, COMM, IERROR)

INTEGER COUNT, DATATYPE, ROOT, COMM, IERROR

·MPI_GATHER(SENDBUF, SENDCOUNT, SENDTYPE, RECVBUF, RECVCOUNT, RECVTYPE, ROOT, COMM, IERROR)

INTEGER SENDCOUNT, SENDTYPE, RECVCOUNT, RECVTYPE, ROOT, COMM, IERROR

·MPI_GATHERV(SENDBUF, SENDCOUNT, SENDTYPE, RECVBUF, RECVCOUNTS, DISPLS, RECVTYPE, ROOT, COMM, IERROR)

INTEGER SENDCOUNT, SENDTYPE, RECVCOUNTS(*), DISPLS(*), RECVTYPE, ROOT, COMM, IERROR

·MPI_SCATTER(SENDBUF, SENDCOUNT, SENDTYPE, RECVBUF, RECVCOUNT, RECVTYPE, ROOT, COMM, IERROR)

INTEGER SENDCOUNT, SENDTYPE, RECVCOUNT, RECVTYPE, ROOT, COMM, IERROR

·MPI_SCATTERV(SENDBUF, SENDCOUNTS, DISPLS, SENDTYPE, RECVBUF, RECVCOUNT, RECVTYPE, ROOT, COMM, IERROR)

INTEGER SENDCOUNTS(*), DISPLS(*), SENDTYPE, RECVCOUNT, RECVTYPE, ROOT, COMM, IERROR

·MPI_ALLGATHER(SENDBUF, SENDCOUNT, SENDTYPE, RECVBUF, RECVCOUNT, RECVTYPE, COMM, IERROR)

INTEGER SENDCOUNT, SENDTYPE, RECVCOUNT, RECVTYPE, COMM, IERROR

·MPI_ALLGATHERV(SENDBUF, SENDCOUNT, SENDTYPE, RECVBUF, RECVCOUNTS, DISPLS, RECVTYPE, COMM, IERROR)

INTEGER SENDCOUNT, SENDTYPE, RECVCOUNTS(*), DISPLS(*), RECVTYPE, COMM, IERROR

·MPI_ALLTOALL(SENDBUF, SENDCOUNT, SENDTYPE, RECVBUF, RECVCOUNT, RECVTYPE, COMM, IERROR)

INTEGER SENDCOUNT, SENDTYPE, RECVCOUNT, RECVTYPE, COMM, IERROR

· MPI_ALLTOALLV(SENDBUF, SENDCOUNTS, SDISPLS, SENDTYPE, RECVBUF, RECVCOUNTS, RDISPLS, RECVTYPE, COMM, IERROR)

INTEGER SENDCOUNTS(*), SDISPLS(*), SENDTYPE, RECVCOUNTS(*), RDISPLS(*), RECVTYPE, COMM, IERROR

·MPI_REDUCE(SENDBUF, RECVBUF, COUNT, DATATYPE, OP, ROOT, COMM, IERROR)

INTEGER COUNT, DATATYPE, OP, ROOT, COMM, IERROR

·MPI_OP_CREATE( FUNCTION, COMMUTE, OP, IERROR)

EXTERNAL FUNCTION

LOGICAL COMMUTE

INTEGER OP, IERROR

·MPI_OP_FREE( OP, IERROR)

INTEGER OP, IERROR

·MPI_ALLREDUCE(SENDBUF, RECVBUF, COUNT, DATATYPE, OP, COMM, IERROR)

INTEGER COUNT, DATATYPE, OP, COMM, IERROR

·MPI_REDUCE_SCATTER(SENDBUF, RECVBUF, RECVCOUNTS, DATATYPE, OP, COMM, IERROR)

INTEGER RECVCOUNTS(*), DATATYPE, OP, COMM, IERROR

·MPI_SCAN(SENDBUF, RECVBUF, COUNT, DATATYPE, OP, COMM, IERROR)

INTEGER COUNT, DATATYPE, OP, COMM, IERROR

Fortran Binding for Group, Contexts,etc.

·MPI_GROUP_SIZE(GROUP, SIZE, IERROR)

INTEGER GROUP, SIZE, IERROR

·MPI_GROUP_RANK(GROUP, RANK, IERROR)

INTEGER GROUP, RANK, IERROR

·MPI_GROUP_TRANSLATE_RANKS(GROUP1, N, RANKS1, GROUP2, RANKS2, IERROR)

INTEGER GROUP1, N, RANKS1(*), GROUP2, RANKS2(*), IERROR

·MPI_GROUP_COMPARE(GROUP1, GROUP2, RESULT, IERROR)

INTEGER GROUP1, GROUP2, RESULT, IERROR

·MPI_COMM_GROUP(COMM, GROUP, IERROR)

INTEGER COMM, GROUP, IERROR

·MPI_GROUP_UNION(GROUP1, GROUP2, NEWGROUP, IERROR)

INTEGER GROUP1, GROUP2, NEWGROUP, IERROR

·MPI_GROUP_INTERSECTION(GROUP1, GROUP2, NEWGROUP, IERROR)

INTEGER GROUP1, GROUP2, NEWGROUP, IERROR

·MPI_GROUP_DIFFERENCE(GROUP1, GROUP2, NEWGROUP, IERROR)

INTEGER GROUP1, GROUP2, NEWGROUP, IERROR

·MPI_GROUP_INCL(GROUP, N, RANKS, NEWGROUP, IERROR)

INTEGER GROUP, N, RANKS(*), NEWGROUP, IERROR

·MPI_GROUP_EXCL(GROUP, N, RANKS, NEWGROUP, IERROR)

INTEGER GROUP, N, RANKS(*), NEWGROUP, IERROR

·MPI_GROUP_RANGE_INCL(GROUP, N, RANGES, NEWGROUP, IERROR)

INTEGER GROUP, N, RANGES(3,*), NEWGROUP, IERROR

·MPI_GROUP_RANGE_EXCL(GROUP, N, RANGES, NEWGROUP, IERROR)

INTEGER GROUP, N, RANGES(3,*), NEWGROUP, IERROR

·MPI_GROUP_FREE(GROUP, IERROR)

INTEGER GROUP, IERROR

·MPI_COMM_SIZE(COMM, SIZE, IERROR)

INTEGER COMM, SIZE, IERROR

·MPI_COMM_RANK(COMM, RANK, IERROR)

INTEGER COMM, RANK, IERROR

·MPI_COMM_COMPARE(COMM1, COMM2, RESULT, IERROR)

INTEGER COMM1, COMM2, RESULT, IERROR

·MPI_COMM_DUP(COMM, NEWCOMM, IERROR)

INTEGER COMM, NEWCOMM, IERROR

·MPI_COMM_CREATE(COMM, GROUP, NEWCOMM, IERROR)

INTEGER COMM, GROUP, NEWCOMM, IERROR

·MPI_COMM_SPLIT(COMM, COLOR, KEY, NEWCOMM, IERROR)

INTEGER COMM, COLOR, KEY, NEWCOMM, IERROR

·MPI_COMM_FREE(COMM, IERROR)

INTEGER COMM, IERROR

·MPI_COMM_TEST_INTER(COMM, FLAG, IERROR)

INTEGER COMM, IERROR

LOGICAL FLAG

·MPI_COMM_REMOTE_SIZE(COMM, SIZE, IERROR)

INTEGER COMM, SIZE, IERROR

·MPI_COMM_REMOTE_GROUP(COMM, GROUP, IERROR)

INTEGER COMM, GROUP, IERROR

·MPI_INTERCOMM_CREATE(LOCAL_COMM, LOCAL_LEADER, PEER_COMM, REMOTE_LEADER, TAG, NEWINTERCOMM, IERROR)

INTEGER LOCAL_COMM, LOCAL_LEADER, PEER_COMM, REMOTE_LEADER, TAG, NEWINTERCOMM, IERROR ·MPI_INTERCOMM_MERGE(INTERCOMM, HIGH, INTRACOMM, IERROR)

INTEGER INTERCOMM, INTRACOMM, IERROR

LOGICAL HIGH

·MPI_KEYVAL_CREATE(COPY_FN, DELETE_FN, KEYVAL, EXTRA_STATE, IERROR)

EXTERNAL COPY_FN, DELETE_FN

INTEGER KEYVAL, EXTRA_STATE, IERROR

·MPI_KEYVAL_FREE(KEYVAL, IERROR)

INTEGER KEYVAL, IERROR

·MPI_ATTR_PUT(COMM, KEYVAL, ATTRIBUTE_VAL, IERROR)

INTEGER COMM, KEYVAL, ATTRIBUTE_VAL, IERROR

·MPI_ATTR_GET(COMM, KEYVAL, ATTRIBUTE_VAL, FLAG, IERROR)

INTEGER COMM, KEYVAL, ATTRIBUTE_VAL, IERROR

LOGICAL FLAG

·MPI_ATTR_DELETE(COMM, KEYVAL, IERROR)

INTEGER COMM, KEYVAL, IERROR

Fortran Binding for Progress Topology:

·MPI_CART_CREATE(COMM_OLD, NDIMS, DIMS, PERIODS, REORDER, COMM_CART, IERROR)

INTEGER COMM_OLD, NDIMS, DIMS(*), COMM_CART, IERROR

LOGICAL PERIODS(*), REORDER

·MPI_DIMS_CREATE(NNODES, NDIMS, DIMS, IERROR)

INTEGER NNODES, NDIMS, DIMS(*), IERROR

·MPI_GRAPH_CREATE(COMM_OLD, NNODES, INDEX, EDGES, REORDER, COMM_GRAPH, IERROR) INTEGER COMM_OLD, NNODES, INDEX(*), EDGES(*), COMM_GRAPH, IERROR

LOGICAL REORDER

·MPI_TOPO_TEST(COMM, STATUS, IERROR)

INTEGER COMM, STATUS, IERROR

·MPI_GRAPHDIMS_GET(COMM, NNODES, NEDGES, IERROR)

INTEGER COMM, NNODES, NEDGES, IERROR

·MPI_GRAPH_GET(COMM, MAXINDEX, MAXEDGES, INDEX, EDGES, IERROR)

INTEGER COMM, MAXINDEX, MAXEDGES, INDEX(*), EDGES(*), IERROR

·MPI_CARTDIM_GET(COMM, NDIMS, IERROR)

INTEGER COMM, NDIMS, IERROR

·MPI_CART_GET(COMM, MAXDIMS, DIMS, PERIODS, COORDS, IERROR)

INTEGER COMM, MAXDIMS, DIMS(*), COORDS(*), IERROR

LOGICAL PERIODS(*)

·MPI_CART_RANK(COMM, COORDS, RANK, IERROR)

INTEGER COMM, COORDS(*), RANK, IERROR

·MPI_CART_COORDS(COMM, RANK, MAXDIMS, COORDS, IERROR)

INTEGER COMM, RANK, MAXDIMS, COORDS(*), IERROR

·MPI_GRAPH_NEIGHBORS_COUNT(COMM, RANK, NNEIGHBORS, IERROR)

INTEGER COMM, RANK, NNEIGHBORS, IERROR

·MPI_GRAPH_NEIGHBORS(COMM, RANK, MAXNEIGHBORS, NEIGHBORS, IERROR)

INTEGER COMM, RANK, MAXNEIGHBORS, NEIGHBORS(*), IERROR

·MPI_CART_SHIFT(COMM, DIRECTION, DISP, RANK_SOURCE, RANK_DEST, IERROR)

INTEGER COMM, DIRECTION, DISP, RANK_SOURCE, RANK_DEST, IERROR

·MPI_CART_SUB(COMM, REMAIN_DIMS, NEWCOMM, IERROR)

INTEGER COMM, NEWCOMM, IERROR

LOGICAL REMAIN_DIMS(*)

·MPI_CART_MAP(COMM, NDIMS, DIMS, PERIODS, NEWRANK, IERROR)

INTEGER COMM, NDIMS, DIMS(*), NEWRANK, IERROR

LOGICAL PERIODS(*)

·MPI_GRAPH_MAP(COMM, NNODES, INDEX, EDGES, NEWRANK, IERROR)

INTEGER COMM, NNODES, INDEX(*), EDGES(*), NEWRANK, IERROR

Fortran Binding for Envoronmental Inquery:

·MPI_GET_PROCESSOR_NAME(NAME, RESULTLEN, IERROR)

CHARACTER*(*) NAME

INTEGER RESULTLEN, IERROR

·MPI_ERRHANDLER_CREATE(FUNCTION, HANDLER, IERROR)

EXTERNAL FUNCTION

INTEGER ERRHANDLER, IERROR

·MPI_ERRHANDLER_SET(COMM, ERRHANDLER, IERROR)

INTEGER COMM, ERRHANDLER, IERROR

·MPI_ERRHANDLER_GET(COMM, ERRHANDLER, IERROR)

INTEGER COMM, ERRHANDLER, IERROR

·MPI_ERRHANDLER_FREE(ERRHANDLER, IERROR)

INTEGER ERRHANDLER, IERROR

·MPI_ERROR_STRING(ERRORCODE, STRING, RESULTLEN, IERROR) INTEGER ERRORCODE, RESULTLEN, IERROR

CHARACTER*(*) STRING

·MPI_ERROR_CLASS(ERRORCODE, ERRORCLASS, IERROR)

INTEGER ERRORCODE, ERRORCLASS, IERROR

DOUBLE PRECISION MPI_WTIME()

DOUBLE PRECISION MPI_WTICK()

·MPI_INIT(IERROR)

INTEGER IERROR

·MPI_FINALIZE(IERROR)

INTEGER IERROR

·MPI_INITIALIZED(FLAG, IERROR)

LOGICAL FLAG

INTEGER IERROR

·MPI_ABORT(COMM, ERRORCODE, IERROR)

INTEGER COMM, ERRORCODE, IERROR

Fortran Binding for Profiling:

·MPI_PCONTROL(level)

INTEGER LEVEL, ...

C题库--自定义数据类型(精)

本题序号:118 当定义一个结构体变量时,系统分配给它的内存大小的理论值是__________。 A 各成员所需内存的总和 B 结构体中的第一个成员所需内存 C 成员中所需内存最大者的存储空间 D 结构体中的最后一个成员所需存储容量参考答案 A 本题序号:165 存放多个字符串,用________比较适合。 A 二维字符数组 B 一维字符数组 C 自定义结构体 D 自定义联合体 参考答案 A 本题序号:169 定义生成非静态变量时,将对变量进行_______。 A 自动赋初值 B 自动赋0 C 不会自动赋初值 D 自动赋-1 参考答案 C 本题序号:180 x为int型,s为float型,x=3,s=2.5。表达式s+x/2的值为________。 A 4 B 3.5 C 2.5 D 3 参考答案 B 本题序号:182 x、y为整数,x=15,y=-2。表达式x>10 and y<2 or x*y==10 and x的值为_________。 A 0 B 15 C 1 D 2 参考答案 C 本题序号:211 以下定义, struct st1{int a,b;float x,y;}; struct st2{int a,b;st1 s1; } ss; 对成员变量x的引用形式正确的是:_________ 。 A ss.s1.x B st2.st1.x C st2.s1.x D ss.x 参考答案 A 本题序号:215 对任意整型数据数据m,n(m>n>0), 则 C 语言表达式m-m/n*n的值为:_______________。 A 0 B m%n C 1 D n%m 参考答案 B 本题序号:223 设有以下定义: enum t1 {a1,a2=7,a3,a4=15} time; 则枚举常量a1和a3的值分别是 A 1和2 B 6和3 C 1和8 D 0和8 参考答案 D 本题序号:225 设有类型说明:enum color{red,yellow=3,white,black}; 则执行语句cout< 第7章自定义数据类型习题 一.选择题: 1.当定义一个结构体变量时,系统分配给它的内存空间是【】。 A) 结构中一个成员所需的内存量B) 结构中最后一个成员所需的内存量 C) 结构体中占内存量最大者所需的容量D) 结构体中各成员所需内存量的总和2.若有以下说明,对初值中整数2的正确引用方式是【】。 static struct { char ch; int i; double x; } a[2][3]={{…a?,1,3 .45,?b?,2,7.98,?c?,3,1.93I} {…d?,4,4.73,?e?,5,6.78,?f?,6,8.79 }}; A) a[1][1].i B) a[0][1].i C) a[0][0].i D) a[0][2].i 3.根据以下定义,能打印字母M的语句是【】。 struct p { char name[9]; int age; }c[10]={“Jobn”,17,”Paul”,19,”Mary”,18,”Adam”,16}; A) printf(“%c”,c[3].name);B) printf(“%c”,c[3].name[1]); C) printf(“%c”,c[2].name);D) printf(“%c”,c[2].name[0]); 4.以下说明和语句中,已知int型数据占两个字节,则以下语句的输出结果是【】。 struct st { char a[l0]; int b; double c; }; printf(“%d”,sizeof(struct st)); A) 0 B) 8 C) 20 D) 2 5.以下说明和语句中,对结构体变量std中成员id的引用方式不正确的是【】。 struct work { int id; int name; } std, *p; p=&std; A) std.id B) *p.id C) (*p).id D) &std.id 6.如设有如下定义,若要使px指向rec中的成员x,正确的赋值语句是【】。 struct aa 数据库系统原理实验报告 实验名称:__用户定义数据类型与自定义函数_ 指导教师:_叶晓鸣刘国芳_____ 专业:_计算机科学与技术_ 班级:__2010级计科班_ 姓名:_文科_____学号: 100510107 完成日期:_2012年11月10日_成绩: ___ ___一、实验目的: (1)学习和掌握用户定义数据类型的概念、创建及使用方法。 (2)学习和掌握用户定义函数的概念、创建及使用方法。 二、实验内容及要求: 实验 11.1 创建和使用用户自定义数据类型 内容: (1)用SQL语句创建一个用户定义的数据类型Idnum。 (2)交互式创建一个用户定义的数据类型Nameperson。 要求: (1)掌握创建用户定义数据类型的方法。 (2)掌握用户定义数据类型的使用。 实验 11.2 删除用户定义数据类型 内容: (1)使用系统存储过程删除用户定义的数据类型Namperson。 (2)交互式删除用户定义的数据类型Idnum。 要求: (1)掌握使用系统存储过程删除用户定义的数据类型。 (2)掌握交互式删除用户定义的数据类型。 实验 11.3 创建和使用用户自定义的函数 内容: (1)创建一个标量函数Score_FUN,根据学生姓名和课程名查询成绩。 (2)创建一个内嵌表值函数S_Score_FUN,根据学生姓名查询该生所有选课的成绩。 (3)创建一个多语句表值函数ALL_Score_FUN,根据课程名查询所有选择该课程学生的成绩信息。 要求: (1)掌握创建标量值函数的方法。 (2)掌握创建内嵌表值函数的方法。 (3)掌握创建多语句表值函数的方法。 实验 11.4 修改用户定义的函数 内容: (1)交互式修改函数Score_FUN,将成绩转换为等级输出。 (2)用SQL修改函数S_Score_FUN,要求增加一输出列定义的成绩的等级。要求: (1)掌握交互式修改用户定义函数的方法。 (2)掌握使用SQL修改用户定义函数的方法。 实验 11.5 输出用户定义的函数 内容: (1)交互式删除函数Score_FUN。 (2)用SQL删除函数S_Score_FUN。 要求: (1)掌握交互式删除用户定义函数的方法。 (2)掌握使用SQL删除用户定义函数的方法。 编辑推荐 ◆书中内容侧重于以MPI库为基础开发并行应用程序,对MP规范定义的各项功能和特征在阐述其特点基础上均配以实例加以说明和印证。 ◆书中所附实例尽量采用独立的功能划分,其中的代码片段可直接用于并行应用程序开发 ◆在讲述基本原理的同时,注重对各项消息传递和管理操作的功能及局限性、适用性进行分析从而使熟读此书的读者能够编写出适合应用特点,易维护、高效率的并行程序。 ◆与本书配套的电子教案可在清华大学出版社网站下载。 本书简介 本书旨在通过示例全面介绍MP1并行程序开发库的使用方法、程序设计技巧等方面的内容,力争完整讨论MP1规范所定义的各种特征。主要也括MPI环境下开发并行程序常用的方法、模式、技巧等 内容。在内容组织上力求全面综合地反映MPl-1和MPI-2规范。对MPI所定义的各种功能、特征分别 给出可验证和测试其工作细节的示例程序 目录 第1章 MPI并行环境及编程模型 1.1 MPICH2环境及安装和测试 1.1.1 编译及安装 1.1.2 配置及验汪 1.1.3 应用程序的编译、链接 1.1.4 运行及调试 1.1.5 MPD中的安全问题 1.2 MPI环境编程模型 1.2.1 并行系统介绍 1.2.2 并行编程模式 1.2.3 MPI程序工作模式 1.3 MPI消息传递通信的基本概念 1.3.1 消息 1.3.2 缓冲区 1.3.3 通信子 1.3.4 进样号和进程纰 1.3.5 通价胁议 1.3.6 隐形对象 第2章 点到点通信 2.1 阻糍通信 2.1.1 标准通信模式 2.1.2 缓冲通信模式 2.1.3 就绪通信模式 2.1.4 同步通信模式 2.1.5 小结 2.2 非阻塞通信 2.2.1 通信结束测试 2.2.2 非重复的非阻塞通信 2.2.3 可醺复的非阻塞通信 2.2.4 Probe和Cancel 2.3 组合发送接收 2.3.1 MPl_Send,MPI_RecvoMPl_Sendreev 2.3.2 MPI_Bsend←→MPl_Sendrecv 2.3.3 MPI_Rsend←→MPI_Sendrecv 2.3.4 MPl_Ssend←→MPl_Sendrecv 2.3.5 MPl_lsend←→MP1一Sendrecv 2.3.6 MPl_Ibsend←→MPI_Sendrecv 2.3.7 MPI_Irsend←→MPI_Sendrecv 2.3.8 MPl_Issend,MPI_Irecv←→MPI_Sendrecv 2.3.9 MPI Send_init←→MPl_Sendrecv 2.3.10 MPI一Bsendj init←→MPl_Sendrecv 2.3.11 MPI_Rsend_init←→MPI_Sendrecv 2.3.12 MPl_Ssend_init,MPl_Recv_init←→MPl_Sendrecv 2.4 点到点通信总结 自定义数据类型 结构体 结构体是程序员在程序中自定义的一种数据类型,在说明和使用之前必须先定义它,也就是构造它。定义一个结构体的语法格式如下: Struct 结构体类型名 { 成员1的数据类型名成员1名称; 成员2的数据类型名成员2名称; . . 成员n的数据类型名成员n名称; }结构体变量表={成员初始化}; 注意成员可以由若干个不同的数据类型组成,每个成员也可以是结构体,即可以嵌套定义。 例如: Struct student { Long num; Char name; Char sex; Float score; }; 已经定义的某种结构体类型可以视为一种标准的数据类型,它的使用方法与标准数据类型使用方法相同,可以用来定义变量、数组、指针。 结构体变量说明 结构体变量的说明在程序的变量说明部分给出,一般在结构定义之后,它的语法格式如下: Struct 结构类型名结构变量名表; 例如: Struct student stu; 指出了结构变量stu是student类型的变量,它由四个成员组成,每个成员的数据类型和名字都与student结构定义中给出的相同。系统完全按照结构定义时制定的内存模式为结构变量分配内存空间。 可以在定义结构体类型的同时给出结构体变量。 Struct student { Long num; Cha name[20]; Cha sex; Float score; }stu1,stu2; 这种形式与前面给出的结构定义和结构说明分开处理效果相同。 结构体成员访问 结构体成员是通过结构体变量名和成员名进行访问的,不能把他作为一个整体进行访问。其访问格式如下: 结构体变量名.成员名 其中运算符.是成员访问运算符,其运算级别是最高的,和圆括号运算符()、下标运算符[]是同一级别的。如果结构体成员是指针变量,则访问格式为: *https://www.360docs.net/doc/e64064988.html, 如果某个结构体变量的成员数据类型又是一个结构体,则访问方式为: 外层结构体变量名.外层成员名.内层成员名 可以在定义结构体变量的同时对结构体变量初始化。 {结构体成员}结构体变量={初始数据}; struct student { long num; char name[20]; char sex; float score; } stu1={200401L,"ZhangHong",'f',92.5f}; 对于嵌套的结构体类型数据,访问格式为: 结构体变量名1.结构体变量名2.成员名 结构体变量初始化的格式如下: struct 结构体名 {结构体成员}结构体变量={初始数据}; 初始数据类型必须与结构成员的数据类型相匹配,并且先后顺序一一对应赋值。 要对结构体变量的成员地址进行访问,其语法格式为: &结构体变量.成员名 当一个指针变量用来指向一个结构变量时,称为结构体指针变量。结构体指针变量中的值是所指向的结构体变量的首地址。 结构体指针变量: Struct 结构名*结构体指针变量名 Struct student *pstu; 必须先赋值后使用,把结构体变量的首地址赋给指针变量,不能把结构名或结构体变量名赋给指针变量。 pstu=&stu1; 结构体名和结构体变量是两个不同的概念,结构体名只能表示一个结构形式,编译系统并不对它分配内存空间,只有当某变量被说明为这种类型的结构时,才对该变量分配存储空间。这是因为结构体变量被定义后相当于标准数据类型被使用。 利用结构体指针变量访问成员如下: (*结构体指针变量).成员名 或者: 结构体指针变量->成员名 后一种形式较为方便,容易区分。 第10章合理使用数据类型 在进一步讨论更深的主题之前,我们需要先停一停,快速地回顾一下可移植问题。Linux1.2版本和2.0版本之间的不同就在于额外的多平台能力;结果是,大多数源代码级的移植问题已经被排除了。这意味着一个规范的Linux驱动程序也应该是多平台的。 但是,与内核代码相关的一个核心问题是,能够同时存取各种长度已知的数据项(例如,文件系统数据类型或者设备卡上的寄存器)和利用不同处理器的能力(32位和64位的体系结构,也有可能是16位的)。 当把x86的代码移植到新的体系结构上时,核心开发者遇到的好几个问题都和不正确的数据类型相关。坚持强数据类型以及编译时使用-Wall-Wstrict-prototypes选项能够防止大部分的臭虫。 内核使用的数据类型划分为三种主要类型:象int这样的标准C语言类型,象u32这样的确定数据大小的类型和象pid_t这样的接口特定类型。我们将看一下这三种类型在何时使用和如何使用。本章的最后一节将讨论把驱动器代码从x86移植到其它平台上可能碰到的其它一些典型问题。 如果你遵循我提供的这些准则,你的驱动程序甚至可能在那些你未能进行测试的平台上编译并运行。 使用标准C类型 大部分程序员习惯于自由的使用诸如int和long这样的标准类型,而编写设备驱动程序就必须细心地避免类型冲突和潜在的臭虫。 问题是,当你需要“2个字节填充单位(filler)”或“表示4个字节字符串的某个东西”时,你不能使用标准类型,因为通常的C数据类型在不同的体系结构上所占空间大小并不相同。例如,长整数和指针类型在Alpha上和x86上所占空间大小就不一样,下面的屏幕快照表明了这一点: morgana%./datasize system/machine:Linux i486 sizeof(char)=1 sizeof(short)=2 sizeof(int)=4 sizeof(long)=4 sizeof(longlong)=8 sizeof(pointer)=4 *** 特性分类和关键件、重要件及关键过程质量控制程序 1 目的 单元件特性分类是对产品质量控制的基础。通过对单元件特性的分类,使各类人员了解和掌握设计意图,使产品在形成的全过程主次清楚,重点突出,以便对关键件、重要件实行重点控制,提高产品质量、稳定性和可追溯性,以保证产 品的最终质量。 2 适用范围 本程序规定了技术资料中单元件的分类和标记的类别、形式的标注方法、审批、更改及单元件特性及关键件、重要件和关键过程的质量控制原则。 本程序适用于正式生产的各类产品的特性分类及关键件、重要件和关键过程的质量控制。 3 职责 3.1 设计部门负责对产品进行特性分析,形成特性分析报告,并对产品实施特 性分类,编制“关键件、重要件项目明细表”。 3.2 工艺部门负责编制“关键件、重要件工艺规程、质量跟踪卡、关键过程明细表”并进行质量控制要求并贯彻实施。 3.3 质量管理部门负责编制“关键件(特性)、重要件(特性)和关键过程检验规范”并进行关键过程质量控制的检查和考核。 4 工作程序 4.1 特性分类 在划定特性类别之前,应对产品进行特性分析(即技术指标分析,设计分析和选定检验单元)提出特性分析资料,并征集有关部门的意见,结合特性分析结果由设计部门根据产品出现故障的严重程度将特性类别分为三类,即关键特性、 重要特性和一般特性,划定的特性类别应该与特性分析保持一致。 4.2 特性分类符号 特性分类符号由特性类别代号、顺序号组成,必要时增加补充代号。 4.2.1 特性类别代号 用大写汉语拼音字母表示。 *** 编写批准修改单号修改 审核日期修改页码审核 标准化备注修改状态批准关键特性:G 重要特性:Z 一般特性:不规定 3.4顺序号 在同一图(代)号的设计文件,按阿拉伯数字顺序表示在特性类别代号后。 关键特性:G1~G99 重要特性:Z101~Z199 一般特性:不规定 3.5补充代号 用大写汉语拼音字母表示在顺序号后。 A—产品单独销售时,该特性被分类为关键特性或重要特性,而在高一级装配中检查或试验时则为一般特性。 B—装配前复检。 C—工艺过程数据作为验收数据。 D—要求特殊的实验或检验。 3.6关键件、重要件标记 标记的形式为等边三角形,规格、尺寸见图10-1 及表10-1。 图10-1 表10-1 规格L C B 字体 1 号标记25 1 1.5 10PB按GB5888 2 号标记7.5 0. 3 0.45 3PB按GB5888 3.7单元件类别的标注 4.3设计资料 第27卷 第3期河北理工学院学报Vol127 No13 2005年8月Journa l of Hebe i I n stitute of Technology Aug.2005 文章编号:100722829(2005)0320041203 MP I并行编程环境及程序设计 杨爱民1,陈一鸣2 (11河北理工大学理学院,河北唐山063009;21燕山大学理学院,河北秦皇岛066004)关键词:MP I;并行编程;消息传递 摘 要:通过对MP I原理和特点的研究,给出了并行MP I程序的基本设计思路和执行过程,并 实现了向量相加的并行计算。 中图分类号:TP316 文献标识码:A 0 引 言 近几十年来,大规模和超大规模的并行机取得了快速发展,由于各种原因,开发商对用户提供的必要支持,如它们各自专有的消息传递包NX、EU I、P VM等,虽然在特定平台上具有很优越的性能,但是从应用程序来看,可移植性差。1992年11月,在Supercomputi ong’92会议上,正式成立了一个旨在建立一个消息传递标准平台的MP I(Message Passing I nterface)论坛,该论坛不仅包括了许多P VM、Exp ress等的研制者及并行程序用户,还吸收了许多著名计算机厂商的代表。论坛于1994年5月,公布了MP I标准。MP I是一种为消息传递而开发的广泛使用的标准,它为消息传递建立了一个可移植的、高效、灵活的标准。 1 MP I的原理与特征 MP I是一个函数库,而不是一门语言,它是一种消息传递模型,它的最终目的是服务于进程间通信。MP I作为一个并行程序库的开发平台,为用户编写和运行程序提供了便利的条件。由于MP I是基于消息传递机制构建的系统,因此它在体系结构为分布存储的并行机中有很宽阔的应用空间,它可以应用在各种同构和异构的网络平台中。它的编程语言可以为Fortran77/90、C/C++。在Fortran77/90、C/C++语言中都可以对MP I的函数进行调用,它作为一种消息传递模式的并行编程环境,MP I并行程序要求将任务进行划分,同时启动多个进程并发的执行,而各个进程之间通过MP I的库函数来实现其中的消息传递。 MP I与其它并行编程环境相比,显著的特点有: (1)可移植性强,能同时支持同构和异构的并行计算; (2)可伸缩性强,允许并行结构中的节点任意增加或减少; (3)能很好的支持点对点通信和集体通信方式; (4)对C语言和Fortran语言的支持,使其能很好的满足各种大规模科学和工程计算的需要。 这样,以MP I作为公共消息传递接口的并行应用程序就可以不作任何改动的移植到不同种类和型号的并行机上,也能够正常运行,或者移到网络环境中也一样。 2 MP I的基本函数 MP I为消息传递和相关操作提供了功能强大的库函数,MPl-1中有128个,MP I-2中有287个库函数。但是从理论上来说,MP I的所有通信功能都可以用它的6个基本调用来完成,即使用这6个函数可以实现所有的消息传递并行程序。这六个函数分别为呼(Fortran77语言的调用格式来描述): (1)MP I初始化 MP I程序的初始化工作通过调用MPl l N I T(I ERROR)来实现,所有MP I程序的第一条可执行语句都是 收稿日期:2004210221 基金项目:河北省自然科学基金项目(E2004000245) 作者简介:杨爱民(19782),男,河北顺平人,河北理工大学理学院教师,硕士。 6.2 用户自定义数据类型 6.2.1 创建用户自定义数据类型 可以使用T-SQL语句或企业管理器来完成用户自定义数据类型的创建。 1. 使用T-SQL语句 可以使用系统存储过程sp_addtype来创建用户自定义数据类型。语法是:sp_addtype type_name[,system_type] {'NULL'|'NOT NULL'|'NONULL'}-默认为'NULL' 其中: type_name为用户定义数据类型名,这个名称在数据库中必须是惟一的。 system_type 为用户定义的数据类型所基于的系统数据类型,可以包括数据的长度、精度等。当系统数据类型中包括标点符号(例如括号、逗号)时,应用引号括起来。 例如,创建一个“号码”数据类型可使用如下代码: USE 学生图书借阅管理 EXEC sp_addtype 号码,'varchar(8)','NULL' 在查询分析器中执行上述语句,结果窗口显示如下信息: (所影响的行数为1行) 类型已添加。 2. 使用企业管理器 使用企业管理器创建用户自定义数据类型的操作步骤如下: (1)在企业管理器中展开要创建用户自定义数据类型的数据库,用鼠标右键单击“用户定义的数据类型”目录,在弹出的快捷菜单中选择“新建用户定义数据类型”命令,如图6-14所示。 图6-14 新建用户自定义数据类型 (2)打开的用户自定义数据类型属性对话框如图6-15所示。在图6-15所示对话框的名 称文本框中输入用户自定义数据类型的名称,如“号码”。 图6-15 用户自定义数据类型属性对话框 图6-16 创建用户自定义数据类型“号码” (3)在图6-15所示对话框的“数据类型”下拉列表框中,选择该用户自定义数据类型所基于的系统数据类型,如varchar。 (4)如果选择的基类型是可以设定长度的(如varchar、char等),则还需要在长度文本框中设定数据类型的长度。 (5)如果允许空值,则选中“允许NULL值”复选框。 (6)如果希望该数据类型与规则或默认值捆绑,则分别在“规则”和“默认值”下拉列表框中选择要绑定的规则和默认值,否则选择“无”,如图6-16所示。规则和默认值将在 6.3节和6.4节中介绍。 (7)单击“确定”按钮,关闭对话框。 6.2.2 查看用户自定义数据类型 要查看用户自定义数据类型,可以使用sp_help 系统存储过程来查看用户自定义数据 第十章-CO10_作业类型主数据维护流程 1.流程说明 此流程描述对作业类型在SAP系统中之维护(创建、修改、删除、冻结),以利于成本进行分摊。 家具公司实际业务中,作业类型仅作为计算生产成本,不作其他任何用途。因此,作业类型只有与生产部门之工作中心相关。另外,哪一类成本中心之费用及该费用通过作业类型分摊至哪个次级成本要素中去均须于创建作业类型时予以确定。 作业类型编码原则以及作业类型与次级成本要素之对应关系(参见附件一),由主数据专职维护人员统一定义、维护。 维护时,财务主数据维护专职人员须填写“作业类型主数据维护申请表”,作为SAP系统维护之依据。 注意事项: 通常,作业类型于SAP上线后即可交付使用,一般不需要创建、修改、删除或冻结。 因系统的高度集成,故创建作业类型前,必须与生产部门(PP模组)达成共识后方可进行,否则将引起前端部门作业困扰,冻结时亦然(若仅在CO模组已创建作业类型但不能与PP模组集成,则该作业类型是无用的)。 修改作业类型时,亦应事先与生产部门取得共识后方可进行。 2.流程图 3.系统操作 3.1.操作范例 例1:因公司内部核算需要,生技部门于2000/12/01起实行独立核算,各生产车间凡涉及之维 修费用均透过生技部门进行,生技部门按实际维修工时(维修内部价格按公司制定标准执行)结 算各生产车间费用。为此,财务部门决定创建一个作业类型——维修工时(代码:AMAINT),以 满足依维修工时核算所需。 例2:上述作业类型创建后,发现中文名称定义不够恰当,变更为生技维修工时。 例3:生技部门试运行后,未能继续推行下去,故将作业类型冻结。 例4:将作业类型——维修工时(代码:AMAINT)删除 3.2.系统菜单及交易代码 案例1:会计→控制→成本中心会计→主数据→作业类型→单个处理→创建 交易代码:KL01 案例2:会计→控制→成本中心会计→主数据→作业类型→单个处理→更改 交易代码:KL02 国家973项目高性能计算环境支持讲座 MPI与PETSc 莫则尧 (北京应用物理与计算数学研究所) 个人介绍 莫则尧,男,汉族,1971年7月生,副研究员:●1992年国防科技大学应用数学专业本科毕业; ●1997年国防科技大学计算机应用专业并行算法 方向博士毕业; ●1999年北京应用物理与计算数学数学博士后流 动站出站,并留所工作; ●主要从事大规模科学与工程并行计算研究。 消息传递并行编程环境MPI 一、进程与消息传递 二、MPI环境的应用现状 三、MPI并行程序设计入门(程序例1) 四、初步的MPI消息传递函数 五、作业一 六、先进的MPI函数 七、MPI并行程序示例2(求解- u=f); 八、MPI环境的发展 九、作业二 一、进程与消息传递 1.单个进程(process ) ● 同时包含它的执行环境(内存、寄存器、程序计数器等),是操作系统中独立存在的可执行的基本程序单位; ● 通俗理解:串行应用程序编译形成的可执行代码,分为“指令”和“数据”两个部分,并在程序执行时“独立地申请和占有”内存空间,且所有计算均局限于该内存空间。 2.单机内多个进程: ● 多个进程可以同时存在于单机内同一操作系统:由操作系统负责调度分时共享处理机资源(CPU 、内存、存储、外设等); ● 进程间相互独立(内存空间不相交):在操作系统调度下各自独立地运行,例如多个串行应用程序在同一台计算机中运行; ● 进程间可以相互交换信息:例如数据交换、同步等待,内存 些信息在进程间的相互交换,是实现进程间通信的唯 一方式; ●最基本的消息传递操作:发送消息(send)、接受消 息(receive)、进程同步(barrier)、规约(reduction); ●消息传递的实现:共享内存或信号量,用户不必关心; 3.包含于通过网络联接的不同计算机的多个进程: ●进程独立存在:进程位于不同的计算机,由各自独立 的操作系统调度,享有独立的CPU和内存资源; ●进程间相互信息交换:消息传递; ●消息传递的实现:基于网络socket机制,用户不必关 心; 4.消息传递库函数: ●应用程序接口(API):提供给应用程序(FORTRAN、 C、C++语言)的可直接调用的完成进程间消息传递 AB PLC编程软件RSLOGIX5000入门7——UDT用户自定义数据类型 在本章中,我们将介绍如何通过用户自定义数据类型和数据范围划定来规划标签数据库。这里将学到 § 了解使用 UDT 的优势 § 学习如何优化 UDT 规划 § 使用数据范围划定帮助简化并加快开发工作 我们现在将重点关注 Logix 控制器中的数据规划。 打开现有控制器文件 1. 在计算机桌面上,双击 Lab Files 文件夹。 2. 双击名为 Conveyor_Program_S 3.ACD 的现有项目。 这样将在 RSLogix 5000 中启动该项目。 为传送带创建用户自定义数据类型 您已重新组织了程序规划以更好地利用 Logix,现在已准备好开始对数据规划进行重新组织。可注意到,工程师规划数据的方式仍像使用带有整数、实数和定时器数据表的传统 PLC 一样。问题是,当与设备关联的数据分布到控制器内存中的各处时便很难进行跟踪。您已再次决定充分利用 Logix,使用用户自定义数据类型。 用户自定义数据类型 用户自定义数据类型也称为 UDT 或结构,借此按逻辑方式对数据进行组织或分组,以便所有与设备关联的数据都可组合在一起。 例如,每个传送带都有 8 个整数值、3 个实数值、2 个定时器和 11 个与其关联的布尔值。在传统PLC 中,可能需要 4 个不同的数据表。然后,当您具有多条传送带时,您可能需要详细地将传送带映射到各个数据表中。这样就会变得很难管理。 通过 UDT 能够实现的是将不同的数据类型(整数、实数、定时器、布尔等)组合到一起,共同作为用户自定义数据类型。然后便可创建该 UDT 类型的数组。这可使得编程工作、代码的记录和数据的跟踪都更加轻松。 1. 在控制器项目管理器中,双击"控制器标签"(Controller Tags)。 MPI并行编程系列二快速排序 阅读:63评论:0作者:飞得更高发表于2010-04-06 09:00原文链接在上一篇中对枚举排序的MPI并行算法进行了详细的描述和实现,算法相对简单,采用了并行编程模式中的单程序多数据流的并行编程模式。在本篇中,将对快速排序进行并行化分析和实现。本篇代码用到了上篇中的几个公用方法,在本篇中将不再做说明。 在本篇中,我们首先对快速排序算法进行描述和实现,并在此基础上分析此算法的并行性,确定并行编程模式,最后给出该算法的MPI实现。 一、快速排序算法说明 快速排序时一种最基本的排序算法,效率相对较高。其基本思想是:在当前无序数组R[1,n]中选取一个记录作为比较的"基准",即作为排序中的"轴"。经过一趟排序后,当前无序数组R[1,n]就会以这个轴为核心划分为两个无序的子区r1[1,i-1],r2[i,n]。其中左边的无序子区都会比"轴"小,右边的无序子区都会比"轴"大。这样下一趟排序,我们就可以对这两个子区用同样的方法进行划分排序,知道所有的无序子区中的记录均排好为止。 根据算法的说明,快速排序时一个典型的递归算法,算法描述如下: 无序数组R[1],R[2],.,R[n] quick_sort(R,start,end) if(start end) r=partion(R,start,end) quick_sort(R,start,r-1) quick_sort(R,r+1,end) endif end quick_sort方法partion的作用就是选取"轴",并将数组分为两个无序子区,并将该"轴"的最终位置返回,在这里我们选择数组的第一个元素为"轴",其算法描述为: partion(R,start,end) r=R[start] while(start end) 一,单选题 1. 已知枚举类型定义语句为: enum Token { NAME, NUMBER, PLUS=5, MINUS, PRINT=10 }; 则下列叙述中错误的是( )。 A 枚举常量NAME的值为1 B 枚举常量NUMBER的值为1 C 枚举常量MINUS的值为6 D 枚举常量PRINT的值为10 参考答案 A 2. 当定义一个结构体变量时,系统分配给它的内存大小的理论值是__________。 A 各成员所需内存的总和 B 结构体中的第一个成员所需内存 C 成员中所需内存最大者的存储空间 D 结构体中的最后一个成员所需存储容量 参考答案 A 3. 以下对枚举类型名的定义中正确的是()。 A enum a={“one”, “two”, “three”}; B enum a {“one”, “two”, “three”}; C enum a={one, two, three}; D enum a {one=9,two=-1,three}; 参考答案 D 4. 下面程序的正确的输出是()。 #include 5. 设有以下定义: enum t1 {a1,a2=7,a3,a4=15} time; 则枚举常量a1和a3的值分别是 A 1和2 B 6和3 C 1和8 D 0和8 参考答案 D 6. 设有类型说明: enum color{red, yellow=3, white, black}; 则执行语句cout< 实验8--自定义数据类型1 实验8 自定义数据类型 三、实验思考 1.有10名学生的数据,每个学生的数据包括学号、姓名、性别、三门课的考试成绩及平均成绩。要求: (1)编写一个input函数,用来输入10个学生的信息。 (2)编写一个output函数,用来输出10个学生的信息。 (3)计算每个学生的平均成绩,并按平均成绩由小到大进行排序后输出。 2.设有5个学生和教师的数据。学生的数据包括:姓名、年龄、性别、职业和年级。教师的数据包括:姓名、年龄、性别、职业和职务。现要求输入学生和教师的数据,并输出这些数据,要求当职业项为学生时,输出的最后一项为年级;当职业项为教师时,输出的最后一项为职务。3.利用结构体数组和结构体指针,根据从键盘输入的学生姓名,查找已给出数据的结构体数组,若找到该名学生,则输出其所有信息;若找不到该名学生,则输出相应提示信息。 4.编程实现,从红、黄、蓝、绿四种颜色中任取三种不同的颜色,共有多少种取法,并请输出所有的排列? 5.从键盘输入一批正整数(以-1作为输入结束标志),按插表尾形式把它们组成一个线性链表。然后,从表头开始,遍历所有结点并输出各结点中的数据。要求线性链表的生成与遍历均写成函数定义。 6.从键盘输入一系列非负整数,遇0时停止。对于输入的所有偶数和奇数,分别建立一个偶数链表和一个奇数链表,然后输出两个链表中的数据。 答案 1. #include 用户自定义的数据类型、默认值、规则 一、用户自定义的数据类型 用户自定义数据类型可看做是系统数据类型的别名。 在多表操作的情况下,当多个表中的列要存储相同类型的数据时,往往要确保这些列具有完全相同的数据类型、长度和为空性(数据类型是否允许为空)。例如,对于student数据库中表student、grade和course三张表的xh,kh两个列必须具有相同的数据类型。 创建用户自定义数据类型时首先应考虑如下三个属性: (1)数据类型名称 (2)新数据类型所依据的系统数据类型(又称为基类型) (3)为空性 如果为空性未明确定义,系统将依据数据库或连接的ANSI NULL默认设置进行指派。 1、创建用户自定义数据类型的方法如下: (1)利用企业管理器定义 (2)利用SQL命令定义数据类型 在SQL Server中,通过系统存储过程实现用户数据类型的定义。 语法格式如下: sp_addtype [@typename=] type, /*自定义类型名称*/ [@phystype=] system_data_type /*基类型*/ [,[@nulltype=] null_type /*为空性*/ [,[@owner=] owner_name] /*创建者或所有者*/ 其中: type:用户自定义数据类型的名称。 System_data_type:用户自定义数据类型所依据的基类型。如果参数中嵌入有空格或标点符号,则必须用引号将该参数引起来。 null_type:指明用户自定义数据类型处理空值的方式。取值可为’NULL’、’NOT NULL’、’NONULL’三者之一(注意:必须用单引号引起来)。如果没有用sp_addtype显式定义null_type,则将其设置为当前默认值,系统默认值一般为’NULL’。 例:定义学号字段的数据类型 sp_addtype ’student_xh’,’char(4)’,’not null’ 2、删除用户自定义数据类型 (1)利用企业管理器 (2)利用SQL语句 语法格式如下: sp_droptype [@typename=] type 其中type为用户自定义数据类型的名称,应用单引号括起来。 例:删除student_xh用户自定义数据类型 sp_droptype ’student_xh’ 说明: (1)如果在表定义内使用某个用户定义的数据类型,或者将某个规则或默认值绑定到这种数据类型,则不能删除该类型。 (2)要删除一用户自定义类型,该数据类型必须存在,否则返回一条错误信息。 3、执行权限 特殊特性 可能影响产品的安全性或法规符合性、配合、功能、性能或其后续过程的产品特性或制造过程参数。在APQP中,特殊特性(SpecialCharacteristics)指由顾客指定的产品和过程特性,包括政府法规和安全特性,和/或由供方通过产品和过程的了解选出的特性。 中文名:特殊特性 外文名:Special Characteristics 影????响:产品的安全性或法规符合性等 分为两类:产品特性和过程特性 产品特性:如尺寸、材质、外观、性能等 特殊特性定义 特性分为两类:产品特性和过程特性 产品特性: 是指在图纸或其他的工程技术资料中所描述的零部件或总成的特点与性能,如尺寸、材质、外观、性能等特性。 过程特性: 是指被识别产品特性具有因果关系的过程变量,也称为过程参数。过程特性仅能在它发生时才能测量出,对于每一个产品特性,可能有一个或者多个过程特性。在某些过程中,一个过程特性可能影响到多个产品特性。 特殊特性特性 1)影响产品的安全性或法规要求的符合性的产品特性或过程参数。 2)影响产品配合/功能或者关于控制和文件化有其他原因(如顾客需求)的产品特性和过程参数。 3)在验证活动中要求特别关注的特性(如检验与试验、产品和过程审核) 说明:特殊特性包括产品特性和过程特性。 特殊特性非特性 产品的每一尺寸或者性能要求都可成为特性。 特性中有的符合上述要求的或者顾客规定的成为特殊特性,剩下的则成为非特殊特性。 非特殊特性的定义可概括为:有合理的预计的变差,且不大可能严重影响产品的安全性、政府法规的符合性及配合/功能的产品特性或过程参数。 为什么要对特殊特性分等级呢?因为并非所有的特殊特性对客户满意度具有同等的影响力,所以就需要对特殊特性的重要性进行分等级。 特殊特性的重要性分等级可以在后续的控制中提供很大的帮助,如: 确定一种优先控制策略;合理分配资源;把特性作为目标控制的程度;建立的沟通的标 准等等! 不过,这里可以简单叙述。我们根据福特的公司为例,基本上可以这样去细分重要特性 和关键特性。 重要特性:指那些对顾客满意程度重要的产品、过程和试验要求,其质量策划措施应包 括在控制计划之中。 关键特性:指那些能与政府法规符合性或车辆/产品功能安全性并包括在控制计划之中需 要特殊生产者、装配、发运、或监控的产品要求(尺寸、规范、试验)或过程能数。 通俗地说,关键特性指符合法律法规的和对安全性能有显着影响地特性。重要特性是对 公差配合,性能有重大影响的严重影响顾客满意度的。 也就是说,我们在APQP附录C中看到的主要特性其实就是特殊特性,也就是说重要特 性和关键特性属于特殊特性的范畴,只是特殊特性的重要性分级中的不同阶段。 关键特性的重要程度大于重要特性! 特殊特性有两种,一种是产品特性,一种是过程特性,对于产品特性,漆膜厚度,附着 力都是很重要的,对于过程特性,链条的速度,烘箱的温度控制等也都很重要。 针对不同的产品要求也不一样,如果是内饰件呢,外观就很重要,那么前处理显得就更 加重要;如果是底盘件,那么耐腐蚀性就显得更加重要 “特殊特性清单”是表示——涉及产品安全及客户指定的、或者是该类产品应当具备的功能、性能等组成的产品特性。一般由设计部门或客户提出。你可以向他们要。。。。。 你这里的控制计划上的“特殊特性”来源于上面的“特殊特性清单”、图纸或者工艺流程图中 标识出的产品特性和过程特性,这些特性是必须在过程中被控制的。你可以向工程或者设计要这些文件自定义数据类型习题及答案(C语言)

用户定义数据类型与自定义函数

MPI并行程序设计实例教程

C语言自定义数据类型

第10章 合理使用数据类型

特性分类及关键过程控制程序

MPI并行编程环境及程序设计

sql自定义数据类型

第十章-CO10-作业类型主数据维护流程.

消息传递并行编程环境MPI

AB PLC编程软件RSLOGIX5000入门7——UDT用户自定义数据类型

MPI并行编程系列二快速排序

C++(练习)第5章,自定义数据类型

实验8--自定义数据类型1

SQL_用户自定义的数据类型规则默认

特殊特性定义