信息论复习资料

信息论基础总复习

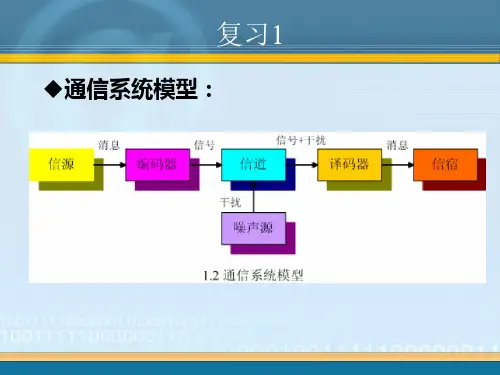

2. 编码器 编码器是将消息变成适合于 信道传送的信号的设备。

信源编码器,提高传输效率

编码器

信道编码器,提高传输可靠性

3. 信道 信道是信息传输和存储的媒介。

4. 译码器 译码是编码的逆变换,分为 信道译码和信源译码。

5. 信宿 信宿是消息的接收者。

1.3 离散信源及其数学模型

信源是产生消息的源,根据X的不同情况,信源可分为以下

条件互信息

I(X ;Y|Z ) x y z p (x) ylo zp p (g (x x||z y z ))

I(X ;Y |Z ) H (X |Z ) H (X |Y )Z

I(X;Y)ZI(X;Y)I(X;Z|Y) I(X;Z)I(X;Y|Z)

连续随机变量的互信息

I(X;Y) 0 I (X ;Y ) I (Y; X ) I (X ;Y | Z) I (Y; X | Z) I(X;Z) I(X;Y) I (XY; Z) I (X ; Z) I (Y; Z | X )

说明: R(D)也称率失真函数。

对于离散无记忆信源,R(D)函数可写成

R (D )p m i jpDi n i1n jm 1p(xi)p(yj/xi)lop(p g y (jy/jx )i)

输入 xX

信道模型

输入 y Y

转移概率矩阵

p(y/ x)

图5-1-2 信道模型

5.1.2 信道容量

• 1.如何刻画DMC信道的容量 考虑一个DMC信道,其输入字符集是X={x0, x1,…,xq-1},输出字符集是Y={y0,y1,…, yQ-1},转移概率P(yj/xi). 若给定信道的转 移概率和对应于输入符号的概率分布p(xi), 则 DMC信道容量C为

• 这个表达式平均错误译码概率的最小值, 是把每一个yj对应的后验概率排除后再连 续求和。

信息论复习资料

判断30名词解释4*5计算3道20分第一章1、自信息和互信息P6 公式2、信道P9 概念第二章1、离散平稳信源P18概念2、离散无记忆信源P19概念3、时齐马尔可夫信源P20概念4、自信息P22概念5、信息熵P25概念6、信息熵的基本性质P281)对称性2)确定性3)非负性4)扩展性5)可加性6)强可加性7)递增性8)极值性9)上凸性7、联合熵条件熵P42公式P43例题8、马尔克夫信源P54公式P55例题9、信源剩余度P5810、熵的相对率信源剩余度P5811、课后作业:2、4、13、21、22第三章1、有记忆信道P73概念2、二元对称信道BSC P743、前向概率、后向概率、先验概率、后验概率P764、条件熵信道疑义度、平均互信息P775、平均互信息、联合熵、信道疑义度、噪声熵计算公式P786、损失熵噪声熵 P797、平均互信息的特性P821)非负性2)极值性3)交互性4)凸状性8、信息传输率R P869、无噪无损信道P87概念10、有噪无损信道P88概念11、对称离散信道 P89概念12、对称离散信道的信道容量P90公式张亚威2012/06/20张亚威2012/06/2116、 数据处理定理 P113定理 17、 信道剩余度 P118公式 18、 课后作业:1、 3、 9第五章1、 编码:实质上是对信源的原始符号按一定的数学规则进行的一种变换。

2、 等长码 P172概念3、 等长信源编码定理 P1784、 编码效率 P1805、 克拉夫特不等式 P1846、 香农第一定理 P1917、 码的剩余度 P194第六章1、 最大后验概率准则 最小错误概率准则 P2002、 最大似然译码准则 P2013、 费诺不等式 P2024、 信息传输率(码率) P2055、 香农第二定理 P2156、 课后习题 3、第八章1、 霍夫曼码 最佳码 P2732、 费诺码 P2793、 课后习题 11、第八章1、 编码原则 译码原则 P3072、 定理9.1 P3133、 分组码的码率 P314公式4、 课后习题 3、一、 填空题1、 在现代通信系统中,信源编码主要用于解决信息传输中的 有效性 ,信道编码主要用于解决信息传输中的 可靠性 ,加密编码主要用于解决信息传输中的 安全性 。

信息论复习1

(4) 平均互信息与各类熵的关系

I(X;Y)=H(X)-H(X|Y)=H(Y)-H(Y|X)=H(X)+H(Y)-H(XY) (5) 平均互信息的物理含义

• 表示接收到输出信号的前、后关于输入信号的平均不确 定性的消除。 • 表示输入信号发出的前、后,关于输出信号的平均不确 定性的消除。 • 表示信道的输出信号和输入信号之间相互提供的平均信 息量。 • 是输入信号和输出信号之间统计依赖关系的信息量度。 • 表示信道中平均每个)条件熵 条件熵是在联合符号集合XY上的条件自信息的数学 期望。

(4)极限熵

若离散平稳信源当N趋于无穷时,平均符号熵的极限 存在,则称此极限为离散平稳信源的极限熵(也称炳 率),记为H∞ 无记忆:

有记忆:

离散平稳信源信息熵的性质 (1)条件熵H(XN|X1X2…XN-1)随N的增加是递减的;

(6)平均互信息的特性 非负性; I(X;Y)>=0 极值性;I(X;Y)<=min[ H(X) , H(Y) ] 对称性;I(X;Y)=I(Y;X) 凸状性; I (X;Y)是输入信源的概率分布p(ai)的∩ 不增性;X→Y→Z I(X;Z)<=I(X;Y)

型 上凸函数。I (X;Y)是信道传递概率p(bj|ai)的∪ 型凸函 数。

习题:

2. 为了传输一个由字母A,B,C,D组成的符号集,把每个字 母编码成两个二元码脉冲序列,以00代表A,01代表B,10代表C, 11代表D。每个二元码脉冲宽度为5ms (1)不同字母等概率出现时,计算传输的平均信息速率? (2)若每个字母出现的概率分别为PA=1/5,PB= 1/4,PC=1/4,PD=3/10,试计算传输的平均信息速率?

矩阵中每一行之和必等于1.

(1)对称离散信道

信息论复习

0

③ 确定性

④ 扩展性 ⑤ 极值性 ⑥ 可加性

H ( p1 , p 2 , ..., p q ) H (1 / q ,1 / q , ...,1 / q ) log q

***********

H(XY)= H(X)+ H(Y)*******

H ( p 1 , p 2 , , p n 1 , q 1 , q 2 , , q m ) q1 pn , q2 pn , , qm pn )

⑦ 强可加性 H(XY)=H(X)+H(Y/X) *******

⑧ 递增性

⑨ 上凸性

3.平均互信息( ***** *******课后习题3.3,6.1求输入符号 概率分别为1/4, 1/2, 1/4 时平均互信息和信道容量)

I ( X ;Y )

P ( xy ) log

X ,Y

P(x y) P (x)

X ,Y

P ( xy ) log

P ( xy ) P (x)P ( y)

( b1b1b1b1 b1 ) 1

( b1b1b1b1 b 2 ) 2

XN

(ar ar ar ar ar ) r N

P ( h / k )

(bs bs bs bs bs ) s N

YN

kn P ( h / k ) P ( b h b h b h a k a k a k )

6.马尔可夫信源及其信息熵(*****) (1)马尔可夫信源的定义******(特别是M阶马尔可夫信源 若一个信源满足下面两个条件,则称为马尔可夫信源: ① 某一时刻信源输出的符号的概率只与当前所处的 状态有关,而与以前的状态无关; ② 信源的下一个状态由当前状态和下一刻的输出唯 一确定。 (2)时齐遍历马尔可夫信源的信息熵(***********) H Q ( E ) H ( X | E ) Q ( E ) P ( a | E ) lo g P ( a | E )

信息论 总复习 new

27

3 哈夫曼编码

Wuhan University

a.将信源符号按概率从大到小的顺序排列,令

b.给两个概率最小的信源符号p(xn-1)和p(xn)各分配

一个码位0和1,将这两个符号合并成一个新符号,其

概率之和作为新符号的概率,得到(n-1)个符号。

c.将缩减信源符号按概率排列,重复步骤a,b。直至缩 减信源只剩两个符号为止。

译码错误概率 pe

P eP r[|I(L uL)H(U)|]L I22

I(ak)的方差

信源序列中每个符号含 有信息量的算术平均值

I(ak)的数学期望

2 I

L 2

契比雪夫不等式的右边是理论上的误码率的上限,

必须小于给定的误码率才能保证到达编码性能要求

24

定长编码定理

Wuhan University

其中差错率满足如下式子

Def. 可达速率:对于给定的信源和编码速率R及 任意δ>0,若存在L0、ξ()、D(),使当码长 L>L0时,Pe< δ ,就称R是可达的,否则R是 不可达的。

22

Wuhan University

Th. 若R>H(U),则R是可达的;若R<H(U),则R是 不可达的。

• 对于给定的离散无记忆信源,若D元码的速率R超 过信源的熵,即NlogD/L ≥H(U)+ε,则存在 编码方法,当L足够大时能使译码错误概率任意小 。

离散信源的无失真编码实质上是一种统计匹配编 码。信息论指出信源中的统计多余度主要决定于以 下两个主要因素:

一是消息概率分布的非均匀性,另一个是消息间 的相关性。对无记忆信源主要决定于概率分布的非 均匀性,但是,对于有记忆信源,两者都起作用, 且后者相关性更加重要。

信息论总结与复习

i 1 k 1

i 1

k 1

结论:N阶马氏信源稳态信息熵(即极限熵)等于N+1阶条件熵。

H lN iN 1 m H (X 1 X 2 X N 1 X N ) H (X N 1 |X 1 X 2 X N )

第一部分、信息论基础

1.1 信源的信息理论

[例1] 已知二阶马尔可夫信源的条件概率:

第一部分、信息论基础

1.1 信源的信息理论

(4)序列信息熵的性质:

《1》条件熵不大于无条件熵,强条件熵不大于弱

条件熵:H(X1) ≥ H(X2|X1) ≥ H(X3|X1X2) ≥ …

…… ≥H (XN|X1X2……XN-1)

《2》条件熵不大于同阶的平均符号熵:

HN ≥H (XN|X1X2……XN-1)

[例3]求对称信道

P00..32

0.3 0.2

0.2 0.3

00..23的信道容量。

解:C =log4-H(0.2,0.3,0.2,0.3)

=2+(0.2log0.2+0.3log0.3)×2 = 0.03 bit/符号;

第二部分、无失真信源编码

2.1 信源编码理论

第二部分、无失真信源编码

1.1 信源编码理论:

稳态方程组是:

QQ((EE32

) )

0.2Q(E1 0.6Q(E2

) )

0.6Q(E3 ) 0.2Q(E4 )

Q(E4 ) 0.4Q(E2 ) 0.8Q(E4 )

Q(E1) Q(E2 ) Q(E3 ) Q(E4 ) 1

第一部分、信息论基础

1.1 信源的信息理论

可解得:

Q (E1 )

[例5] 以下哪些编码一定不是惟一可译码?写出每 种编码克拉夫特不等式的计算结果。

信息论 总复习

等概率分布

设 B {b1,b2 , , bs } 等概率分布, 应由P ( x )保证

(3)对称离散信道容量

当 P( x) 等概率分布时

' C log s H ( p1',p2, ,ps' ) bit / 符号

(4)准对称离散信道容量

C log r H ( p ,p , ,p )

3、有噪信道编码定理 定理6.5 有噪信道编码逆定理

设离散无记忆信道 [ X , P ( y | x ), Y ], 其 信道容量为C。当信息传输率 R>C , 则无论码长n多长,总也找不到一种 编码(M 2nR,n) ,使译码错误概率任 意小。

第9章信道的纠错编码

1、线性分组码 生成矩阵G、校验矩阵H、伴随式译码 2、循环码

2、最大似然译码准则

则选择译码函数 F (b ) a 的条件应满足

j

P ( b j | a) P ( b j | a i )

PE P(ai )P

X

(i ) e

3、有噪信道编码定理 定理6.4 (有噪信道编码定理) P 设离散无记忆信道 [ X , P ( y | x ), Y ] ,( y | x ) 为其信道传递概率,其信道容量为C。当 信息传输率R<C 时;只要码长n足够长, M ( 2 nR ) 总可以在输入符号集中找到 ( 2 nR , n) 和相应的 个码字组成的一组码 译码规则,使译码的错误概率任意 小 ( PE 0) 。

N

称 H 为平稳信源的极限熵或熵率。

第三章离散信道及其信道容量

1、单符号离散信道的数学模型 a1 b1 a2 b2

X

ar

P (b j | a i )

信息论基础复习提纲

第一章 绪论1、什么是信息?香农对于信息是如何定义的。

答:信息是事物运动状态或存在方式的不确定性的描述(Information is a measure of one's freedom of choice when one selects a message )。

2、简述通信系统模型的组成及各部分的含义。

答:(1)、信源:信源是产生消息的源。

信源产生信息的速率---熵率。

(2)、编码器:编码器是将消息变成适合于信道传送的信号的设备。

包括信源编码器(提高传输效率)、信道编码器(提高传输可靠性)、调制器。

(3)、信道:信道是信息传输和存储的媒介。

(4)、译码器:译码是编码的逆变换,分为信道译码和信源译码。

(5)、信宿:信宿是消息的接收者(人或机器)。

3、简述香农信息论的核心及其特点。

答:(1)、香农信息论的核心:在通信系统中采用适当的编码后能够实现高效率和高可靠性的信息传输,并得出了信源编码定理和信道编码定理。

(2)、特点:①、以概率论、随机过程为基本研究工具。

②、研究的是通信系统的整个过程,而不是单个环节,并以编、译码器为重点。

③、关心的是最优系统的性能和怎样达到这个性能(并不具体设计系统)。

④、要求信源为随机过程,不研究信宿。

第二章 信息的度量2.1 自信息和互信息1、自信息(量):(1)、定义:一个事件(消息)本身所包含的信息量,它是由事件的不确定性决定的。

某个消息i x 出现的不确定性的大小定义为自信息,用这个消息出现的概率的对数的负值来表示: (2)、性质:①、()i x I是()i x p 的严格递减函数。

当()()21x p x p <时()()21x I x I >概率越小,事件发生的不确定性越大,事件发生以后所包含的自信息量越大。

()()()i i i x p x p x I 1loglog =-=②、极限情况下,当()0=i x p 时()∞→i x I ;当()1=i x p 时,()0→i x I 。

信息论复习提纲

信道传递概率可以用信道矩阵来表示:

x1 x2 P xr

y1 p( y1 | x1 ) p( y | x ) 1 2 p( y1 | xr )

y2 p( y2 | x1 )

p( y2 | x2 ) p( y2 | xr )

ys p( ys | x1 ) 1 p( ys | x2 ) p( ys | xr )

i

第四章:信道及信道容量

二、离散单符号信道及其信道容量

1.离散单符号信道的数学模型(续14)

例3:求二元删除信道的 H ( X )、H (Y )、H ( X | Y )和I ( X ;Y ) 。

已知

1 3 PX 4 4

1 1 2 2 0 P 1 2 0 3 3

3. 后验概率(后向概率): 贝叶斯公式

p ( xi | y j ) p ( xi y j ) p( y j ) p ( xi ) p ( y j | xi )

p( x ) p( y

i 1 i

r

j

| xi )

(i =1,2,…,r;j =1,2,…,s)

且

p ( xi | y j ) 1

Y y2

ys

i 1, 2,..., r ; j 1, 2,..., s

满足: (1)0≤ p(yj|xi) ≤ 1 (i=1,2,…,r;j=1,2,…,s) (2)

p( y j | xi ) 1

j 1

s

(i=1,2,…,r)

第四章:信道及信道容量

二、离散单符号信道及其信道容量

1.离散单符号信道的数学模型(续2)

r s

第四章:信道及信道容量

信息论总复习

I□离散信源的不肯定程度表示某些随机事件是否会发生。

2□离散信源的不肯定性表示信源某时刻发不发送信源符号不能肯定。

3□离散信源的不肯定性表示信源某时刻发送某个信源符号的概率大小不能肯定。

4□离散信源的不肯定性表示信源某时刻发送哪个信源符号是不能绝对肯定的。

5□离散信源的不肯定程度表示某些随机事件是否会发生的难易程度。

6□不肯定程度仅与离散信源概率空间的状态数有关。

7□不肯定程度仅与离散信源概率空间的概率分布有关。

8□不肯定程度与离散信源概率空间的状态数及概率分布有关。

9□离散信源概率空间的概率分布差别越大时不肯定程度也越大。

10□离散信源概率空间的概率分布差别越小时不肯定程度就越大。

II□离散信源概率空间的概率分布为等概时不肯定程度最大。

12 □不肯定度用取对数的度量方法是因为不这样定义是错的。

13□不肯定度用取对数的度量方法是因为其符合人对信息量的直观理解。

14 □信息的多少定义为信息量。

15□信息量定义为不肯定程度的减小量。

16□先验概率分布和后验概率分布分别表示信源发送消息前后的概率分布。

17□先验概率分布和后验概率分布分别表示收信者收到消息前后的概率分布。

18 □信源输出所有消息的量叫做信源熵。

19□信源输出一个消息所提供的信息量叫做信源熵。

20□信源输出所有消息所提供的总的信息量叫做信源熵。

21口信源输出一个消息所提供的平均信息量叫做信源熵。

22口信源的不肯定度叫做信源熵。

23□离散信源熵不可能为负数。

24□信源如发送错误消息则其输出的熵为负数。

25□二元联合信源的共熵一定小于每个单独信源熵的和。

26□二元联合信源的共熵小于或等于每个单独信源熵的和。

27□二元联合信源的共熵有可能等于每个单独信源熵的和。

28□—个离散信源输出的符号前后无相关性时表示该信源无剩余。

29□—个离散信源输出的符号前后有相关性时其熵将减少。

30□—个离散信源输出的符号前后有相关性时表示该信源有剩余。

31□条件熵永远小于无条件熵。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

8、 解释最小错误概率译码准则,最大似然译码准则和最小距离译码准则,说明三者的关系。 答:最小错误概率译码准则下,将接收序列译为后验概率最大时所对应的码字。 最大似然译码准则下,将接收 序列译为信道传递概率最大时所对应的码字。 最小距离译码准则下,将接收序列译为与其距离最小的码字。 三者关系为:输入为等概率分布时,最大似然译码准则等效于最小错误概率译码准则。在二元对称无记忆信道 中,最小距离译码准则等效于最大似然译码准则。 9、 保真度准则为:平均失真度不大于允许的失真度。 10、限失真信源编码:有失真信源编码的中心任务,在允许的失真范围内把编码的信息率压缩到最小。

4、线性分组码不具有的性质是(C)

1 / 2 1 / 4 [P XY ] 1 / 12 1 / 6

; [ PY ] [7 / 12 5 / 12] ;

; H (Y ) 7 / 12 log 2 (12 / 7) 5 / 12 log 2 (12 / 5)

I ( X ; Y ) H (Y ) H (Y | X )

对应的剩余度为

1 1

H1 0.811 1 0.189 H0 1 1 1 1 log log 2 2 2 2 H2 0.681 1 0.319 H0 1 1 1 1 log log 2 2 2 2

H ( p1 , p2 , , pL 1 , pL ) pL H (

并说明等式的物理意义

q q1 q2 , , , m ) pL p L pL

14、一阶齐次马尔可夫信源消息集

X∈{a1,a2,a3} ,状态集S∈{S1,S2,S3}且令 Si=ai,

1 4 1 4 1 2 P(aj / S i ) 1 3 1 3 1 3 2 3 1 3 0

H (U1 ) H (

U2

); H (U 2 ) H (

U1

)

U H (U1U 2 ) H (U1 ) H ( 2

这两个不等式又称为 Shannon 不等式

U1

U ) H (U 2 ) H ( 1

U2

)

13、证明:若

p

i 1

L

i

1, q j pL

j 1

m

则

重点:无干扰离散信道、对称 DMC(离散无记忆)信道 、准对称信道 信道容量 C:最大的信息传输率 1、 写出香农公式,并说明其物理意义。当信道带宽为 5000Hz,信噪比为 30dB 时求信道容量。

2、信源冗余度;香农第一定理内容和含义 3、解释最小错误概率译码准则,最大似然译码准则和最小距离译码准则,说明三者的关系。 4、香农第二定理的内容和含义? 5、码距:两个等长码字之间对应码元不相同的数目,称为码距。 2 、设有一离散信道,其信道矩阵为 最佳概率分布?当 P(X1)=0.7, P(X2)=0.3 时,

率失真的定义域问题就是在信源和失真函数已知的情况下,讨论允许平均失真度 D 的最小和最大取值问题。 由于平均失真度是非负实数 d(xi,yj)的数学期望,因此也是非负的实数,即¯D≥ 0,¯D 的下界是 0。 R(D)=0 意味着不需传输任何消息,D 越大,直至无穷大都能满足这种情况。 5、Dmin 和 R(Dmin)的计算 信源的最小平均失真度: • 只有当失真矩阵的每一行至少有一个 0 元素时,信源的平均失真度才能达到下限值 0。 • 只有当失真矩阵每一行至少有一个 0,每一列至多只有一个 0,才能保证 R(0) =H(X)。 5、 限失真信源编码;保真度准则;奇异码; 6、 即时码;Huffman 编码

(3)该马尔可夫信源的极限熵为:

H P Si P S j | Si log P S j | Si

i 1 j 1

2

2

3 2 2 3 1 1 log log 4 3 3 4 3 3 1 1 0.578 1.599 2 4 0.681bit 符号 0.472 nat 符号 0.205 hart 符号

7、设离散信源 X={X1,X2},P(X1)=1/3,P(X2)=2/3,编码后的输出为 Y={y1,y2},失真矩阵为:

d(x 1,y 1) d(x 1,y 2) 0 1 H 1 . 求 Dmin,Dmax、R(Dmin)和 R(Dmax)及对应的转移概率矩阵。 d(x 2,y 1) d(x 2,y 2) 0

(4)计算稳态下 H 1, H2 及其对应的剩余度 解:(1)

S1

1 3

1

S2

2 2 P S 1 P S1 | Si P Si 3 P S1 P S 2 i 1 3 P S1 2 2 1 4 (2)由公式 P Si P Si | S j P S j 有 得 P S 2 P S 2 | Si P Si P S1 3 j 1 i 1 P S 1 2 4 P S1 P S 2 1

(4)在稳态下:

2 3 1 1 3 P xi log P xi log log 0.811bit 符号 4 4 4 4 i 1

H 2 H 0.205 hart 符号 0.472 nat 符号 0.681bit 符号

2 1

1、设二元对称信道的输入概率分布分别为 [ PX ] [3 / 4 1 / 4] ,转移矩阵为 PY | X 求信道的输入熵,输出熵,平均互信息量; 求信道容量和最佳输入分布;求信道剩余度。

2 熵 H ( X ) 3 / 4 log 2 (4 / 3) 1 / 4 log 2 4 ;

1、 说明信息、消息及信号三者之间的联系与区别? 2、 信息论的研究目的和对象? 3、 自信息的定义及物理含义? 熵的定义及物理含义? 4、 马尔可夫信源 5、 信道疑义度的概念和物理含义? 6、 熵功率 7、 信源冗余度 8、 离散信源和连续信源的最大熵定理。 9、 一个随即变量 x 的概率密度函数 P(x)= x /2,0≤X≤2V,则信源的相对熵为 1bit 10、同时扔两个正常的骰子,即各面呈现的概率都是 1/6,若点数之和为 12,则得到的自信息是 log36bit 11、有一个无记忆信源发出符号 A 和 B,已知 P(A)=1/4,P(B)=3/4,发出二重符号序列消息的信源,无记忆信源熵 H(X2)为多少?0.81bit/二重信号 12、二进制通信系统使用符号 0 和 1,由于存在失真,传输时会产生误码,用符号表示下列事件,u0:一个 0 发 出,u1:一个 1 发出,v0 :一个 0 收到,v1:一个 1 收到,则已知收到的符号,被告知发出的符号能得到的信 息量如何表示?H(U/V) 13、证明:由两个消息(符号)组成的联合信源有如下结论: U1 U2

H (Y | X ) 3 / 4H (1 / 2,1 / 4) 1 / 4H (1 / 12,1 / 6)

2)最佳输入分布为 [ PX ] [1 / 2 1 / 2] ,此时信道的容量为 C 1 H (2 / 3,1 / 3) (3)信道的剩余度: C I ( X ; Y )

i=1,2,3 条件转移概率为(右) ,

(1)画出状态转移图(2)计算稳态概率 (3)计算马尔可夫信源的极限熵 (4)计算稳态下 H 1, H2 及其对应的剩余度

1.一个一阶马尔可夫信源, 转移概率为 (1)画出状态转移图 (2)计算稳态概率 (3)计算马尔可夫信源的极限熵

2 1 P S1 | S1 , P S2 | S1 , P S1 | S2 1, P S2 | S2 0 3 3

求平均互信息和信道疑义度; 输入为等概率分布时,试写出一译码则,使平均译码错误率最小,并求此错误率。

1、概念、定义:失真函数、平均失真、允许失真度、试验信道 2、 信息率失真函数(注意与信道容量的比较 ) 3、 信息率失真函数的定义域(即 Dmin 和 Dmax) 、R(Dmin)、R(Dmax)及相应的信道转移概率的计算 4、 R(D):在限定失真为 D 的条件下信源输出的最小信息速率。 R(D)的定义域 [Dmin Dmax]为 R(D)的定义域。 (确界)