信息论与编码复习整理1

信息论与编码-复习

第6章 信道编码

计算:

对于循环码,已知(n,k)循环码 会求g(x),并根据g(x)求G, 例p191-192 6.3.3,p193 6.3.4 会求h(x)=(xn+1)/g(x),并根据h(x), 例p193 6.3.4 会求系统循环码码字:由G经过初等行变换得Gs, 再通过C=mGS得系统循环码码字

第4章 信息率失真函数

计算:

对于离散信源(如作业4.1(3)):

R(D)的计算、R(D)与D的关系图 只要求等概信源,对称失真的R(D),见P120 (4.2.50式) 关系图见P109 图4.1.1(注意区分离散和连续信源), 所取的点的纵坐标根据R(D)的计算式求得

第4章 信息率失真函数

计算:

会计算达到稳态时的状态概率分布(作业2.16(1))和 极限熵(作业2.16(2),2.17(2)和p48 例2.2.4);

给定状态转移概率,会画状态转移图,反之亦要求。

第二章 ——续

计算:

信源冗余度的计算(作业2.17(3)) 根据给出的离散信源,能够进行定长编码,求出码字。

掌握信源编码器的性能指标(编码效率η)及其与码 长(k)之间的关系。

第3章 信道容量

掌握离散无记忆信道的N次扩展信道的容量的求解

CN次扩展 NC单符号无记忆信道

无噪信道的容量:见作业3.14 应用连续信道的信道容量公式进行解题

连续信道的容量 所需的信号功率

S 如作业3.19,使用公式 C连续 B log 2 (1 ) N 注意:

C就是信号的传输速率 dB表示的信噪比在代入时要进行转换

能够通过分析电路的运行过程,得到生成的循环码字。 见课件

信息论与编码总复习

“信息论与编码”总复习1.消息、信号、信息的含义、定义及区别。

信息是指各个事物运动的状态及状态变化的方式。

消息是指包含信息的语言,文字和图像等。

信号是消息的物理体现。

消息是信息的数学载体、信号是信息的物理载体信号:具体的、物理的消息:具体的、非物理的信息:非具体的、非物理的同一信息,可以采用不同形式的物理量来载荷,也可以采用不同的数学描述方式。

同样,同一类型信号或消息也可以代表不同内容的信息2.信息的特征与分类。

1接收者在收到信息之前,对其内容是未知的,所以信息是新知识,新内容;2信息是能使认识主体对某一事物的未知性或不确定性减少的有用知识;3信息可以产生,也可以消失,同时信息可以被携带,被存储及处理;4信息是可以量度的,信息量有多少的差别。

3.狭义信息论、广义信息论、一般信息论研究的领域。

狭义信息论:信息论是在信息可以量度的基础上,对如何有效,可靠地传递信息进行研究的科学。

它涉及信息量度,信息特性,信息传输速率,信道容量,干扰对信息传输的影响等方面的知识。

广义信息论:信息是物质的普遍属性,所谓物质系统的信息是指它所属的物理系统在同一切其他物质系统全面相互作用(或联系)过程中,以质、能和波动的形式所呈现的结构、状态和历史。

包含通信的全部统计问题的研究,除了香农信息论之外,还包括信号设计,噪声理论,信号的检测与估值等。

概率信息:信息表征信源的不定度,但它不等同于不定度,而是为了消除一定的不定度必须获得与此不定度相等的信息量4.信息论的起源、历史与发展。

⏹1924年,Nyquist提出信息传输理论;⏹1928年,Hartly提出信息量关系;⏹1932年,Morse发明电报编码;⏹1946年,柯切尼柯夫提出信号检测理论;⏹1948年,Shannon提出信息论,“通信中的数学理论”—现代信息论的开创性的权威论文,为信息论的创立作出了独特的贡献。

5.通信系统的物理模型(主要框图),各单元(方框)的主要功能及要解决的主要问题。

信息论与编码复习重点整理(1页版)

第1章 概论1. 信号(适合信道传输的物理量)、信息(抽象的意识/知识,是系统传输、转换、处理的对象)和消息(信息的载体)定义;相互关系:(1信号携带消息,是消息的运载工具(2信号携带信息但不是信息本身(3同一信息可用不同的信号来表示(4同一信号也可表示不同的信息。

2. 通信的系统模型及目的:提高信息系统可靠性、有效性和安全性,以达到系统最优化.第2章 信源及信息量1. 单符号离散信源数学模型2. 自信息量定义:一随机事件发生某一结果时带来的信息量I(xi)=- log2P(xi)、单位:bit 、物理意义:确定事件信息量为0;0概率事件发生信息量巨大、性质:I(xi)非负;P(xi)=1时I(xi)=0;P(xi)=0时I(xi)无穷;I(xi)单调递减;I(xi)是随机变量。

3. 联合自信息量:I(xiyi)=- log2P(xiyj) 物理意义:两独立事件同时发生的信息量=各自发生的信息量的和、条件自信息量:I(xi/yi)=- log2P(xi/yj);物理意义:特定条件下(yj 已定)随机事件xi 所带来的信息量。

三者关系:I(xi/yi)= I(xi)+ I(yi/xi)= I(yi)+ I(xi/yi)4. 熵:定义(信源中离散消息自信息量的数学期望)、单位(比特/符号)、物理意义(输出消息后每个离散消息提供的平均信息量;输出消息前信源的平均不确定度;变量的随机性)、计算:(H(X)=-∑P(xi)log2 P(xi)) 1)连续熵和离散的区别:离散熵是非负的2)离散信源当且仅当各消息P 相等时信息熵最大H (X )=log 2 n 。

3)连续信源的最大熵:定义域内的极值.5.条件熵H(Y/X) = -∑∑P(xiyj) log2P(yj/xi),H (X /Y )= -∑∑P(xiyj) log2P(xi/yj) 、物理意义:信道疑义度H(X/Y):信宿收到Y 后,信源X 仍存在的不确定度,有噪信道传输引起信息量的损失,也称损失熵。

《信息论和编码技术》复习提纲复习题

《信息论和编码技术》复习提纲复习题《信息论与编码技术》复习提纲复习题纲第0章绪论题纲:I.什么是信息?II.什么是信息论?III.什么是信息的通信模型?IV.什么是信息的测度?V.自信息量的定义、含义、性质需掌握的问题:1.信息的定义是什么?(广义信息、狭义信息——Shannon信息、概率信息)2.Shannon信息论中信息的三要素是什么?3.通信系统模型图是什么?每一部分的作用的是什么?4.什么是信息测度?5.什么是样本空间、概率空间、先验概率、自信息、后验概率、互信息?6.自信息的大小如何计算?单位是什么?含义是什么(是对什么量的度量)?第1章信息论基础㈠《离散信源》题纲:I.信源的定义、分类II.离散信源的数学模型III.熵的定义、含义、性质,联合熵、条件熵IV.离散无记忆信源的特性、熵V.离散有记忆信源的熵、平均符号熵、极限熵VI.马尔科夫信源的定义、状态转移图VII.信源的相对信息率和冗余度需掌握的问题:1.信源的定义、分类是什么?2.离散信源的数学模型是什么?3.信息熵的表达式是什么?信息熵的单位是什么?信息熵的含义是什么?信息熵的性质是什么?4.单符号离散信源最大熵是多少?信源概率如何分布时能达到?5.信源的码率和信息率是什么,如何计算?6.什么是离散无记忆信源?什么是离散有记忆信源?7.离散无记忆信源的数学模型如何描述?信息熵、平均符号熵如何计算?8.离散有记忆多符号离散平稳信源的平均符号熵、极限熵、条件熵(N阶熵)的计算、关系和性质是什么?9.什么是马尔科夫信源?马尔科夫信源的数学模型是什么?马尔科夫信源满足的2个条件是什么?10.马尔科夫信源的状态、状态转移是什么?如何绘制马尔科夫信源状态转移图?11.马尔科夫信源的稳态概率、稳态符号概率、稳态信息熵如何计算?12.信源的相对信息率和冗余度是什么?如何计算?㈡《离散信道》题纲:I.信道的数学模型及分类II.典型离散信道的数学模型III.先验熵和后验熵IV.互信息的定义、性质V.平均互信息的定义、含义、性质、维拉图VI.信道容量的定义VII.特殊离散信道的信道容量需掌握的问题:1.信道的定义是什么?信道如何分类?信道的数学模型是2.二元对称信道和二元删除信道的信道传输概率矩阵是什么?3.对称信道的信道传输概率矩阵有什么特点?4.根据信道的转移特性图,写出信道传输概率矩阵。

信息论与编码复习整理1

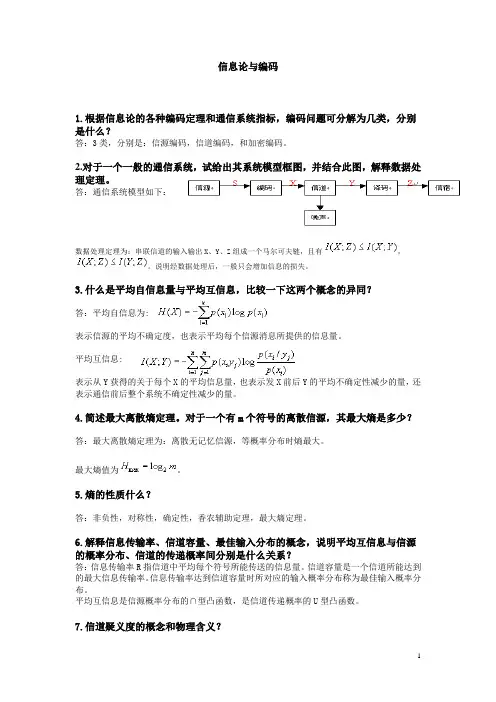

信息论与编码1.根据信息论的各种编码定理和通信系统指标,编码问题可分解为几类,分别是什么?答:3类,分别是:信源编码,信道编码,和加密编码。

2.对于一个一般的通信系统,试给出其系统模型框图,并结合此图,解释数据处理定理。

答:通信系统模型如下:数据处理定理为:串联信道的输入输出X 、Y 、Z 组成一个马尔可夫链,且有,。

说明经数据处理后,一般只会增加信息的损失。

3.什么是平均自信息量与平均互信息,比较一下这两个概念的异同?答:平均自信息为:表示信源的平均不确定度,也表示平均每个信源消息所提供的信息量。

平均互信息:表示从Y 获得的关于每个X 的平均信息量,也表示发X 前后Y 的平均不确定性减少的量,还表示通信前后整个系统不确定性减少的量。

4.简述最大离散熵定理。

对于一个有m 个符号的离散信源,其最大熵是多少?答:最大离散熵定理为:离散无记忆信源,等概率分布时熵最大。

最大熵值为。

5.熵的性质什么?答:非负性,对称性,确定性,香农辅助定理,最大熵定理。

6.解释信息传输率、信道容量、最佳输入分布的概念,说明平均互信息与信源的概率分布、信道的传递概率间分别是什么关系?答:信息传输率R 指信道中平均每个符号所能传送的信息量。

信道容量是一个信道所能达到的最大信息传输率。

信息传输率达到信道容量时所对应的输入概率分布称为最佳输入概率分布。

平均互信息是信源概率分布的∩型凸函数,是信道传递概率的U 型凸函数。

7.信道疑义度的概念和物理含义?答:概念:)|(log )()|(j i j i jib a p b a p Y XH ∑∑-=物理含义:输出端收到全部输出符号Y 以后,对输入X 尚存在的平均不确定程度。

8.写出香农公式,并说明其物理意义。

当信道带宽为5000Hz ,信噪比为30dB 时求信道容量。

答:香农公式为 ,它是高斯加性白噪声信道在单位时 间内的信道容量,其值取决于信噪比和带宽。

由得,则9.解释无失真变长信源编码定理?答:只要,当N 足够长时,一定存在一种无失真编码。

信息论与编码复习

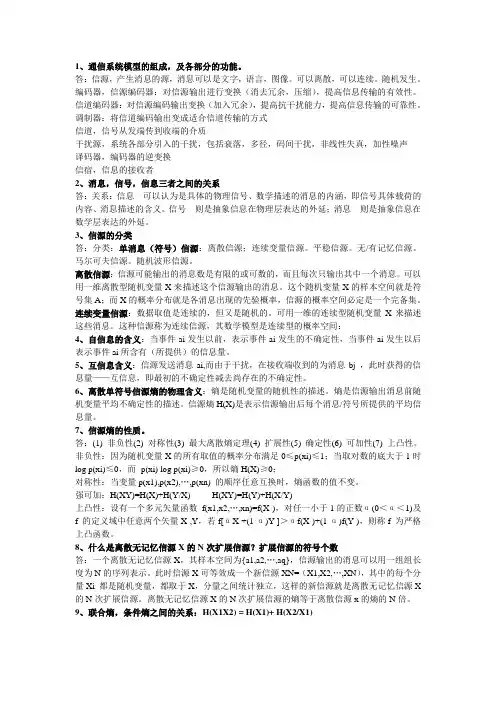

1、通信系统模型的组成,及各部分的功能。

答:信源,产生消息的源,消息可以是文字,语言,图像。

可以离散,可以连续。

随机发生。

编码器,信源编码器:对信源输出进行变换(消去冗余,压缩),提高信息传输的有效性。

信道编码器:对信源编码输出变换(加入冗余),提高抗干扰能力,提高信息传输的可靠性。

调制器:将信道编码输出变成适合信道传输的方式信道,信号从发端传到收端的介质干扰源,系统各部分引入的干扰,包括衰落,多径,码间干扰,非线性失真,加性噪声译码器,编码器的逆变换信宿,信息的接收者2、消息,信号,信息三者之间的关系答:关系:信息---可以认为是具体的物理信号、数学描述的消息的内涵,即信号具体载荷的内容、消息描述的含义。

信号---则是抽象信息在物理层表达的外延;消息---则是抽象信息在数学层表达的外延。

3、信源的分类答:分类:单消息(符号)信源:离散信源;连续变量信源。

平稳信源。

无/有记忆信源。

马尔可夫信源。

随机波形信源。

离散信源:信源可能输出的消息数是有限的或可数的,而且每次只输出其中一个消息。

可以用一维离散型随机变量X来描述这个信源输出的消息。

这个随机变量X的样本空间就是符号集A;而X的概率分布就是各消息出现的先验概率,信源的概率空间必定是一个完备集。

连续变量信源:数据取值是连续的,但又是随机的。

可用一维的连续型随机变量X来描述这些消息。

这种信源称为连续信源,其数学模型是连续型的概率空间:4、自信息的含义:当事件ai发生以前,表示事件ai发生的不确定性,当事件ai发生以后表示事件ai所含有(所提供)的信息量。

5、互信息含义:信源发送消息ai,而由于干扰,在接收端收到的为消息bj ,此时获得的信息量——互信息,即最初的不确定性减去尚存在的不确定性。

6、离散单符号信源熵的物理含义:熵是随机变量的随机性的描述。

熵是信源输出消息前随机变量平均不确定性的描述。

信源熵H(X)是表示信源输出后每个消息/符号所提供的平均信息量。

信息论与编码总结

信息论与编码1. 通信系统模型信源—信源编码—加密—信道编码—信道—信道解码—解密—信源解码—信宿 | | |(加密密钥) 干扰源、窃听者 (解密秘钥)信源:向通信系统提供消息的人或机器信宿:接受消息的人或机器信道:传递消息的通道,也是传送物理信号的设施干扰源:整个系统中各个干扰的集中反映,表示消息在信道中传输受干扰情况 信源编码:编码器:把信源发出的消息变换成代码组,同时压缩信源的冗余度,提高通信的有效性 (代码组 = 基带信号;无失真用于离散信源,限失真用于连续信源)译码器:把信道译码器输出的代码组变换成信宿所需要的消息形式基本途径:一是使各个符号尽可能互相独立,即解除相关性;二是使各个符号出现的概率尽可能相等,即概率均匀化信道编码:编码器:在信源编码器输出的代码组上增加监督码元,使之具有纠错或检错的能力,提高通信的可靠性译码器:将落在纠检错范围内的错传码元检出或纠正基本途径:增大码率或频带,即增大所需的信道容量2. 自信息:()log ()X i i I x P x =-,或()log ()I x P x =-表示随机事件的不确定度,或随机事件发生后给予观察者的信息量。

条件自信息://(/)log (/)X Y i j X Y i j I x y P x y =-联合自信息:(,)log ()XY i j XY i j I x y P x y =-3. 互信息:;(/)()(;)log log ()()()i j i j X Y i j i i j P x y P x y I x y P x P x P y ==信源的先验概率与信宿收到符号消息后计算信源各消息的后验概率的比值,表示由事件y 发生所得到的关于事件x 的信息量。

4. 信息熵:()()log ()i iiH X p x p x =-∑ 表示信源的平均不确定度,或信源输出的每个信源符号提供的平均信息量,或解除信源不确定度所需的信息量。

信息论与编码复习重点整理(1页版)

1第1章 概论1. 信号(适合信道传输的物理量)、信息(抽象的意识/知识,是系统传输、转换、处理的对象)和消息(信息的载体)定义;相互关系:(1信号携带消息,是消息的运载工具(2信号携带信息但不是信息本身(3同一信息可用不同的信号来表示(4同一信号也可表示不同的信息。

2. 通信的系统模型及目的:提高信息系统可靠性、有效性和安全性,以达到系统最优化.第2章 信源及信息量1. 单符号离散信源数学模型2. 自信息量定义:一随机事件发生某一结果时带来的信息量I(xi)=-log2P(xi)、单位:bit 、物理意义:确定事件信息量为0;0概率事件发生信息量巨大、性质:I(xi)非负;P(xi)=1时I(xi)=0;P(xi)=0时I(xi)无穷;I(xi)单调递减;I(xi)是随机变量。

3. 联合自信息量:I(xiyi)=- log2P(xiyj) 物理意义:两独立事件同时发生的信息量=各自发生的信息量的和、条件自信息量:I(xi/yi)=- log2P(xi/yj);物理意义:特定条件下(yj 已定)随机事件xi 所带来的信息量。

三者关系:I(xi/yi)= I(xi)+ I(yi/xi)= I(yi)+ I(xi/yi)4. 熵:定义(信源中离散消息自信息量的数学期望)、单位(比特/符号)、物理意义(输出消息后每个离散消息提供的平均信息量;输出消息前信源的平均不确定度;变量的随机性)、计算:(H(X)=-∑P(xi)log2 P(xi)) 1)连续熵和离散的区别:离散熵是非负的2)离散信源当且仅当各消息P相等时信息熵最大H (X )=log 2 n 。

3)连续信源的最大熵:定义域内的极值. 5.条件熵H(Y/X) = -∑∑P(xiyj) log2P(yj/xi),H (X /Y )= -∑∑P(xiyj) log2P(xi/yj) 、物理意义:信道疑义度H(X/Y):信宿收到Y 后,信源X 仍存在的不确定度,有噪信道传输引起信息量的损失,也称损失熵。

信息论与编码总复习

VS

奇偶校验位

奇偶校验位是添加到数据中的一个额外位 ,用于检测数据中的错误。根据数据的二 进制位数,可以选择奇校验或偶校验。

05

编码的应用

数据压缩

1 2 3

数据压缩

数据压缩是编码技术的重要应用之一,通过去除 数据中的冗余信息,减少数据的存储空间和传输 时间,提高数据传输效率。

压缩算法

常用的数据压缩算法包括哈夫曼编码、算术编码、 LZ77和LZ78等,这些算法通过不同的方式实现 数据的压缩和解压缩。

互信息与条件互信息

互信息的定义

互信息是两个随机变量之间的相关性度量。对于两个随机变量$X$和$Y$,其互信息定义为$I(X;Y) = sum_{x,y} P(X=x,Y=y) log_2 frac{P(X=x,Y=y)}{P(X=x)P(Y=y)}$。

条件互信息的定义

条件互信息是给定一个随机变量条件下,另一个随机变量的不确定性减少的量度。对于两个随机变量$X$ 和$Y$以及第三个随机变量$Z$,其条件互信息定义为$I(X;Y|Z) = sum_{x,y,z} P(X=x,Y=y,Z=z) log_2 frac{P(X=x,Y=y|Z=z)}{P(X=x|Z=z)P(Y=y|Z=z)}$。

压缩比与效率

数据压缩比和压缩效率是衡量数据压缩算法性能 的重要指标,不同的应用场景需要选择合适的压 缩算法以满足需求。

加密通信

加密通信

编码技术在加密通信中发挥着重要作用,通过将明文转换为密文, 保护数据的机密性和完整性。

加密算法

常见的加密算法包括对称加密和公钥加密,这些算法利用数学函数 和密钥对数据进行加密和解密。

纠错码与检错码

纠错码不仅能够检测错误,还能够纠 正错误,而检错码只能检测错误。

信息论与编码复习资料

1、在认识论层次上研究信息时,必须同时考虑到形式、(含义)和(效用)3个方面的因素2、如果从随机不确定性的角度来定义信息,信息反映(不确定性)的消除量。

3、信源编码的结果是(减少)冗余;而信道编码的手段是(增加)冗余。

4(1948)年,香农发表了著名的论文(通信的数学理论),标志着信息论的诞生。

5、信息商品是一种特殊商品,它有(客观)性、(共享)性、(时效)性和知识创造征。

6、对信源进行观查之前,对认识的主体来说,信源存在(先验)不确定性,观察之后,信源还存在(后验)不确定性。

7、联合符号(x i ,y j )的不确定性,等于(关于y j )不确定性加上(观查到y j 后还剩余)不确定性。

8、256个亮度构成的信源,其熵值最大为(log256=8)。

9、无条件熵(不小于)条件熵,条件多的熵(不大于)条件少的熵。

10、信源编码实质上是对信源进行信息处理,无失真信源编码只是信息处理的方法之一,除此外,还可以对信源进行(限失真)编码。

11、无失真编码对应于无损信道,有失真编码对应于(有噪)信道。

12、有失真编码的(失真范围)受限,所以又称为限失真编码;编码后的(信息率)得到压缩,因此属熵压缩编码。

13、满足(平均失真D D ≤失真度)的信道称为D 允许[试验]信道。

1、无失真编码只对信源的(冗余度)一进行压缩,而不会改变信源的熵,又称冗余度压缩编码。

2、无失真信源编码的作用可归纳为:(1)(符号变换); (2)(冗余度压缩)。

3、(含相同的码字)的码称为奇异码。

1、 研究信息论的主要目的是什么?答:能够高效、可靠、安全并且随心所欲地交换和利用各种各样的信息。

2、信息论的定义(狭义、广义)答:狭义:在信息可以度量的基础上,研究有效和可靠的传递信息的科学。

广义:包含通信的全部统一问题的研究,香农信息论、信号设计、噪声理论、信号检测与估值等。

3、信息有哪些特征?答:(1)接收者在收到信息前对它的内容未知;(2)信息是能使认识主体对某一事物的未知性或不确定性减少的有用的知识;3)信息可以产生、消灭、被携带、贮存及处理;(4)信息可以度量。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

信息论与编码1.根据信息论的各种编码定理和通信系统指标,编码问题可分解为几类,分别是什么?答:3类,分别是:信源编码,信道编码,和加密编码。

2.对于一个一般的通信系统,试给出其系统模型框图,并结合此图,解释数据处理定理。

答:通信系统模型如下:数据处理定理为:串联信道的输入输出X 、Y 、Z 组成一个马尔可夫链,且有,。

说明经数据处理后,一般只会增加信息的损失。

3.什么是平均自信息量与平均互信息,比较一下这两个概念的异同?答:平均自信息为:表示信源的平均不确定度,也表示平均每个信源消息所提供的信息量。

平均互信息:表示从Y 获得的关于每个X 的平均信息量,也表示发X 前后Y 的平均不确定性减少的量,还表示通信前后整个系统不确定性减少的量。

4.简述最大离散熵定理。

对于一个有m 个符号的离散信源,其最大熵是多少?答:最大离散熵定理为:离散无记忆信源,等概率分布时熵最大。

最大熵值为。

5.熵的性质什么?答:非负性,对称性,确定性,香农辅助定理,最大熵定理。

6.解释信息传输率、信道容量、最佳输入分布的概念,说明平均互信息与信源的概率分布、信道的传递概率间分别是什么关系?答:信息传输率R 指信道中平均每个符号所能传送的信息量。

信道容量是一个信道所能达到的最大信息传输率。

信息传输率达到信道容量时所对应的输入概率分布称为最佳输入概率分布。

平均互信息是信源概率分布的∩型凸函数,是信道传递概率的U 型凸函数。

7.信道疑义度的概念和物理含义?答:概念:)|(log )()|(j i j i jib a p b a p Y XH ∑∑-=物理含义:输出端收到全部输出符号Y 以后,对输入X 尚存在的平均不确定程度。

8.写出香农公式,并说明其物理意义。

当信道带宽为5000Hz ,信噪比为30dB 时求信道容量。

答:香农公式为 ,它是高斯加性白噪声信道在单位时 间内的信道容量,其值取决于信噪比和带宽。

由得,则9.解释无失真变长信源编码定理?答:只要,当N 足够长时,一定存在一种无失真编码。

10.解释有噪信道编码定理?答:当R <C 时,只要码长足够长,一定能找到一种编码方法和译码规则,使译码错误概率无穷小。

11.最佳变长编码有哪些?答:香农编码方法,费诺编码方法和哈夫曼编码方法。

12.解释等长信源编码定理和无失真变长信源编码定理,说明对于等长码和变长码,最佳码的每符号平均码长最小为多少?编码效率最高可达多少?答:等长信源编码定理:对于任意,只要,则当L 足够长时必可使译码差错。

变长信源编码定理:只要,一定存在一种无失真编码。

等长码和变长码的最小平均码长均为,编码效率最高可达100%。

13.解释最小错误概率译码准则,最大似然译码准则和最小距离译码准则,说明三者的关系。

答:最小错误概率译码准则下,将接收序列译为后验概率最大时所对应的码字。

最大似然译码准则下,将接收序列译为信道传递概率最大时所对应的码字。

最小距离译码准则下,将接收序列译为与其距离最小的码字。

三者关系为:输入为等概率分布时,最大似然译码准则等效于最小错误概率译码准则。

在二元对称无记忆信道中,最小距离译码准则等效于最大似然译码准则。

14.什么是保真度准则?对二元信源,其失真矩阵,求a>0时率失真函数的和?答:1)保真度准则为:平均失真度不大于允许的失真度。

2)因为失真矩阵中每行都有一个0,所以有,而。

15.差错控制系统分类有哪些?答:前向纠错,反馈重发,混合纠错。

16.分别说明信源的概率分布和信道转移概率对平均互信息的影响,说明平均互信息与信道容量的关系。

答:平均互信息相对于信源概率分布为上凸函数,相对于信道传递概率分布为下凹函数。

平均互信息的最大值为信道容量。

17.香农第二定理的内容和含义?答:内容:设有一离散无记忆平稳信道,其信道容量为C ,只要待传送的信息传输率 R <C ,则存在一种编码,当输入序列长度n 足够大,使译码错误概率任意小.含义:只要R <C ,就可以在有噪信道中以任意小的错误概率(E p <ε)传输信息. 当输入序列长度n 足够大时,可以以任意接近信道容量C 的信息传输率传递信息。

2.1 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍?解:四进制脉冲可以表示4 个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示8 个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2 个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则:四进制脉冲的平均信息量H (X ) log n log4 2 bit / symbol 1 = = = 八进制脉冲的平均信息量H (X ) log n log8 3 bit / symbol 2 = = = 二进制脉冲的平均信息量H (X ) log n log2 1 bit / symbol 0 = = = 所以:四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2 倍和3 倍2.4 设离散无记忆信源⎭⎬⎫⎩⎨⎧=====⎥⎦⎤⎢⎣⎡8/14/1324/18/310)(4321x x x x X P X ,其发出的信息为(202120130213001203210110321010021032011223210),求 (1) 此消息的自信息量是多少?(2) 此消息中平均每符号携带的信息量是多少?解:(1) 此消息总共有14个0、13个1、12个2、6个3,因此此消息发出的概率是:62514814183⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=p此消息的信息量是:bit p I 811.87log =-=(2) 此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/==2.5 从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为0.5%,如果你问一位男士:“你是否是色盲?”他的回答可能是“是”,可能是“否”,问这两个回答中各含多少信息量,平均每个回答中含有多少信息量?如果问一位女士,则答案中含有的平均自信息量是多少?解:男士:sym bolbit x p x p X H bitx p x I x p bit x p x I x p i i i N N N Y Y Y / 366.0)93.0log 93.007.0log 07.0()(log )()( 105.093.0log )(log )(%93)( 837.307.0log )(log )(%7)(2=+-=-==-=-===-=-==∑女symbol bit x p x p X H ii i / 045.0)995.0log 995.0005.0log 005.0()(log )()(2=+-=-=∑2.15 某一无记忆信源的符号集为{0, 1},已知P(0) = 1/4,P(1) = 3/4。

(1) 求符号的平均熵;(2) 有100个符号构成的序列,求某一特定序列(例如有m 个“0”和(100 - m )个“1”)的自信息量的表达式; (3) 计算(2)中序列的熵。

解: (1)symbol bit x p x p X H ii i / 811.043log 4341log 41)(log )()(=⎪⎭⎫ ⎝⎛+-=-=∑(2)bit m x p x I x p mi i m mmi 585.15.4143log)(log )(434341)(100100100100100+=-=-==⎪⎭⎫⎝⎛⨯⎪⎭⎫ ⎝⎛=---(3) symbol bit X H XH / 1.81811.0100)(100)(100=⨯==2.16 一阶马尔可夫信源的状态图如下图所示。

信源X 的符号集为{0, 1, 2}。

(1) 求平稳后信源的概率分布; (2) 求信源的熵H ∞。

解: (1)⎪⎩⎪⎨⎧===⎩⎨⎧=++==⎪⎪⎩⎪⎪⎨⎧⋅+⋅=⋅+⋅=⋅+⋅=⎪⎩⎪⎨⎧+=+=+=3/1)(3/1)(3/1)(1)()()()()()()()()()()()()()()()/()()/()()()/()()/()()()/()()/()()(321321321133322211131333332322222121111e p e p e p e p e p e p e p e p e p e p p e p p e p e p p e p p e p e p p e p p e p e e p e p e e p e p e p e e p e p e e p e p e p e e p e p e e p e p e p⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡⎪⎪⎩⎪⎪⎨⎧=+=⋅+⋅=+==+=⋅+⋅=+=⋅=+=3/123/113/10)(3/13/)()()()/()()/()()(3/13/)()()()/()()/()()()/()()/()()(131313333323232222212121111X P X p p e p p e p p e x p e p e x p e p x p p p e p p e p p e x p e p e x p e p x p pp p e x p e p e x p e p x p (2)()sym bolbit p p p p p p p p p p p p p p p p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e p H iji j i j i / log log log 31log 31log 31log 31log 31log 31 )/(log )/(31)/(log )/(31)/(log )/(31 )/(log )/(31)/(log )/(31)/(log )/(31 )/(log )/(31)/(log )/(31)/(log )/(31)/(log )/()(33333232313123232222212113131212111133⋅+⋅-=⎥⎦⎤⎢⎣⎡⋅⋅+⋅⋅+⋅⋅+⋅⋅+⋅+⋅⋅-=⎥⎦⎤++++++⎢⎣⎡++-=-=∑∑∞2.17黑白气象传真图的消息只有黑色和白色两种,即信源X ={黑,白}。

设黑色出现的概率为P(黑) = 0.3,白色出现的概率为P(白) = 0.7。

(1) 假设图上黑白消息出现前后没有关联,求熵H(X);(2) 假设消息前后有关联,其依赖关系为P(白/白) = 0.9,P(黑/白) = 0.1,PPPP(白/黑) = 0.2,P(黑/黑) = 0.8,求此一阶马尔可夫信源的熵H 2(X);(3) 分别求上述两种信源的剩余度,比较H(X)和H 2(X)的大小,并说明其物理含义。