gboost算法原理与实战.doc

集成学习Boosting算法综述

集成学习Boosting算法综述一、本文概述本文旨在全面综述集成学习中的Boosting算法,探讨其发展历程、基本原理、主要特点以及在各个领域的应用现状。

Boosting算法作为集成学习中的一类重要方法,通过迭代地调整训练数据的权重或分布,将多个弱学习器集合成一个强学习器,从而提高预测精度和泛化能力。

本文将从Boosting算法的基本概念出发,详细介绍其发展历程中的代表性算法,如AdaBoost、GBDT、GBoost等,并探讨它们在分类、回归等任务中的性能表现。

本文还将对Boosting算法在各个领域的应用进行综述,以期为读者提供全面、深入的Boosting 算法理解和应用参考。

二、Boosting算法概述Boosting算法是一种集成学习技术,其核心思想是将多个弱学习器(weak learner)通过某种策略进行组合,从而形成一个强学习器(strong learner)。

Boosting算法的主要目标是提高学习算法的精度和鲁棒性。

在Boosting过程中,每个弱学习器都针对前一个学习器错误分类的样本进行重点关注,从而逐步改善分类效果。

Boosting算法的基本流程如下:对训练集进行初始化权重分配,使得每个样本的权重相等。

然后,使用带权重的训练集训练一个弱学习器,并根据其分类效果调整样本权重,使得错误分类的样本权重增加,正确分类的样本权重减少。

接下来,使用调整后的权重训练下一个弱学习器,并重复上述过程,直到达到预定的弱学习器数量或满足其他停止条件。

将所有弱学习器进行加权组合,形成一个强学习器,用于对新样本进行分类或预测。

Boosting算法有多种变体,其中最具代表性的是AdaBoost算法。

AdaBoost算法采用指数损失函数作为优化目标,通过迭代地训练弱学习器并更新样本权重,逐步提高分类精度。

还有GBDT(Gradient Boosting Decision Tree)、GBoost、LightGBM等基于决策树的Boosting算法,它们在处理大规模数据集和高维特征时表现出良好的性能。

boost工作原理

boost工作原理Boost是一个全面的C++库,用来增强C++程序的性能和功能。

Boost库包含了很多库,比如智能指针、信号与槽、线程和数据结构等。

Boost库的实现不是魔法,而是基于常见的C++编程技术和模式。

本文将介绍Boost库的工作原理,包括其对C++编程技术的应用和所使用的核心算法。

1.智能指针Boost实现了智能指针的概念,用于确保在C++程序中,动态分配的内存可以被正确地管理和删除。

智能指针允许程序员动态分配内存,并将该内存绑定到一个指针变量上,当指针超出该内存范围时,自动处理内存回收。

Boost实现了三种类型的智能指针:shared_ptr、scoped_ptr和weak_ptr。

shared_ptr是最常见的类型,当多个指针引用同一块内存时,可确保该内存空间的正确释放。

2.信号与槽Boost库还实现了信号与槽机制,这是一种基于事件的编程模型。

在该模型中,程序中的某些对象可以发送信号,其他对象可以接收并处理这些信号。

当用户单击按钮时,按钮对象可以发送一个“clicked”信号,主程序接收到该信号并执行相应的处理操作。

这种机制实现了对象之间的松散耦合,使得代码更加灵活和易于维护。

3.线程Boost库还包含了多线程编程支持。

这个功能集成了许多开发人员所需的常见任务,如全局互斥访问、线程同步和线程池等。

Boost库提供多种不同的线程类型,其中包括:thread、mutex、condition_variable 等。

这些线程类型使编写多线程应用程序更加直观和简单。

4.数据结构Boost库提供了很多常见的数据结构和算法,这些数据结构和算法依赖于其他Boost库中的组件,如智能指针、模板元编程和内存管理等。

Boost库实现的数据结构有:vector、list、map和set等;实现的算法有:排序、查找和字符串处理等。

这些数据结构和算法已经被证明是高效、灵活和可扩展的。

5.核心算法Boost库实现了许多与C++核心算法相关的组件,使得C++程序员可以更直接地使用它们。

boost any 原理

boost any 原理(最新版)目录1.Boost 算法的原理2.Boost 算法的实现方式3.Boost 算法的应用实例正文Boost 算法是一种集成学习算法,其核心思想是结合多个弱学习器以提高预测准确性。

Boost 算法的原理可以概括为以下几点:1.Boost 算法的原理Boost 算法的基本原理是加权训练样本。

在每一轮迭代中,算法会根据之前弱学习器的预测错误调整训练样本的权重,使得后续的弱学习器更加关注错误的训练样本。

经过多轮迭代,Boost 算法将多个弱学习器的预测结果进行加权结合,从而得到最终的预测输出。

2.Boost 算法的实现方式Boost 算法有多种实现方式,其中最常用的是 AdaBoost 和Gradient Boosting Machine (GBM)。

AdaBoost 是一种自适应的 Boost 算法,通过调整弱学习器的权重来实现不同的融合策略。

GBM 是另一种Boost 算法,它使用树模型作为弱学习器,通过逐步构建树模型并组合多个树模型的预测结果来得到最终预测。

3.Boost 算法的应用实例Boost 算法在许多领域都有广泛应用,例如计算机视觉、自然语言处理和推荐系统等。

以计算机视觉中的对象检测为例,可以使用多个弱学习器(如卷积神经网络)检测图像中的目标,然后通过 Boost 算法结合这些弱学习器的预测结果,从而得到最终的目标检测结果。

在自然语言处理中,Boost 算法可以用于词性标注、情感分析等任务,通过结合多个弱学习器的预测结果提高标注准确性。

总之,Boost 算法是一种强大的集成学习方法,通过结合多个弱学习器提高预测准确性。

基于XGBoost算法的硬盘故障预测

1230 引言硬盘故障会导致大量重要数据丢失,这不仅会影响到数据中心正常运行,而且可能会产生巨额的修复成本,甚至使客户满意度降低,影响企业声誉。

可见硬盘故障造成的数据丢失给企业带来的影响不容小觑,预防数据丢失的一个重要途径就是硬盘剩余寿命预测,硬盘剩余寿命预测能有效降低数据丢失率,减少因数据丢失带来的巨大损失。

近年来机器学习方法被用于预测硬盘剩余寿命(RUL),并取得了较好的预测结果。

其中Farzaneh Ahmadzadeh等在2011年将贝叶斯方法、隐式马尔可夫模型(hmm),隐式半马尔可夫模型(hsmm)方法进行对比,应用于硬盘剩余寿命预测[1]。

2014年Jing Li等提出用决策回归树CART对硬盘剩余寿命进行预测,决策树CART模型预测准确率为95%以上,并且性能优于反向传播神经网络(BP ANN)[2]。

2015年贾宇晗等应用CART决策树和BP神经网络两种机器学习方法,对硬盘故障预测,取得不错的结果[3]。

2016年Botezatu等提出了用随机森林(RF)对硬盘剩余寿命(RUL)进行预测[4]。

2017年Nicolas Aussel等利用支持向量机、随机森林和GBDT机器学习方法对硬盘故障进行预测,并得出RF有95%的准确率,67%的召回率;GBDT有94%的准确率和67%的召回率[5]。

2018年Fernando Dione S.Lima等通过将随机森林与RNN、LSTM应用到硬盘剩余寿命预测,对比得到LSTM短期精度为98.40%长期精度为68.61%,RF短期精度为25.13%,长期精度为23.89%[6]。

2018年Preethi Anantharaman等通过建立LSTM、CNN、RNN等深度学习模型,预测硬盘剩余寿命,实验结果表明LSTM 的整体性能最好,其次是CNN [7]。

贾润莹等在2014年提出用Adaboost算法优化BP神经网络模型,得到了较好的预测结果[8]。

xgboost导读和实战

让平台往接口需求上面去走,最终使得各种比较有效的分布式机器学习 abstraction 的实现在各个平台下面跑。

这里按自己理解给出一个整体框架的理念的分层抽象逻辑。

Gbdt

Lr

…

Interface abstraction(AllReduce,异步 SGD,…)

Yarn

MPI

Openmp …

3.可容错 Rabit 版本的 Allreduce 有一个很好的性质,支持容错,而传统的 mpi 是不支持的。 具体实现方式:Allreduce 每一个节点最后拿到的是一样的结果,这意味着可以让 一些节点记住结果。当有节点挂掉重启的时候,可以直接向还活着的节点索要结

第三版原生支持 Yarn Yarn 为了能自由的掌控各个节点的资源分配并且能使文件均衡的分割到各个节 点,直接把 rabit 作为 yarn 的一个 APP 运行。在这一版里,实现了 c++读写 hdfs 的功能,解决了 streaming 版本中 xgboost 中对文件操作自由不高的问题。

分布式通信框架 rabit 简述

rabit 是容错的 allreduce 实现,在启动 yarn 集群基于 rabit 的任务时,首先在节点 间建立树形的连接关系(下图)来提高节点间的通信效率。建立连接关系后,各 节点可通过 allreduce 接口通信内存单元。

上图是 rabit 中 allreduce 求和的例子。每个节点依次向父节点发送节点值,父节 点接受子节点的值并和父节点自己的值求和后,再往上一层节点发送。最后根节 点得到全部子节点的和并和自己的节点值相加后就得到了所有节点的和,然后将 根节点求得的值沿着树的路径传播给各个节点。allreduce 的求和操作完成后,各 个节点得到了所有节点值的和。 rabit allreduce 支持对连续内存单元简单的 sum max min 操作,也支持自定义的 reduce 操作来对不同节点中的类的数据成员合并。xgboost 的分布式算法主要用 到了自定义的 reduce 操作来合并计算特征候选分割点的统计量,以及合并由候 选分割点得到的区间内样本的统计量。

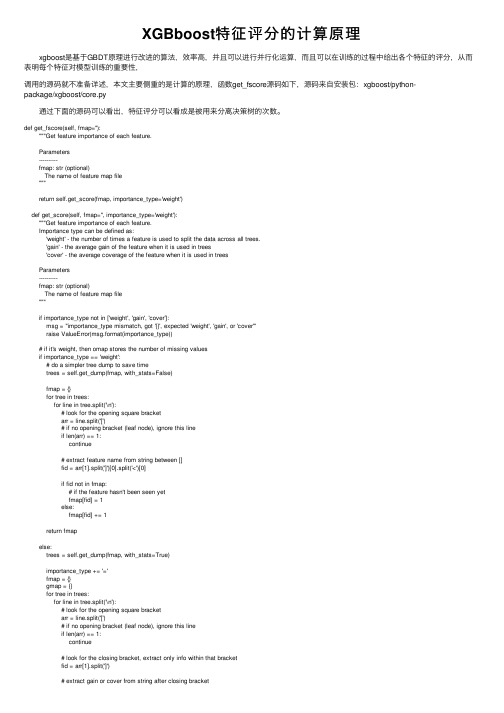

XGBboost特征评分的计算原理

XGBboost特征评分的计算原理 xgboost是基于GBDT原理进⾏改进的算法,效率⾼,并且可以进⾏并⾏化运算,⽽且可以在训练的过程中给出各个特征的评分,从⽽表明每个特征对模型训练的重要性,调⽤的源码就不准备详述,本⽂主要侧重的是计算的原理,函数get_fscore源码如下,源码来⾃安装包:xgboost/python-package/xgboost/core.py 通过下⾯的源码可以看出,特征评分可以看成是被⽤来分离决策树的次数。

def get_fscore(self, fmap=''):"""Get feature importance of each feature.Parameters----------fmap: str (optional)The name of feature map file"""return self.get_score(fmap, importance_type='weight')def get_score(self, fmap='', importance_type='weight'):"""Get feature importance of each feature.Importance type can be defined as:'weight' - the number of times a feature is used to split the data across all trees.'gain' - the average gain of the feature when it is used in trees'cover' - the average coverage of the feature when it is used in treesParameters----------fmap: str (optional)The name of feature map file"""if importance_type not in ['weight', 'gain', 'cover']:msg = "importance_type mismatch, got '{}', expected 'weight', 'gain', or 'cover'"raise ValueError(msg.format(importance_type))# if it's weight, then omap stores the number of missing valuesif importance_type == 'weight':# do a simpler tree dump to save timetrees = self.get_dump(fmap, with_stats=False)fmap = {}for tree in trees:for line in tree.split('\n'):# look for the opening square bracketarr = line.split('[')# if no opening bracket (leaf node), ignore this lineif len(arr) == 1:continue# extract feature name from string between []fid = arr[1].split(']')[0].split('<')[0]if fid not in fmap:# if the feature hasn't been seen yetfmap[fid] = 1else:fmap[fid] += 1return fmapelse:trees = self.get_dump(fmap, with_stats=True)importance_type += '='fmap = {}gmap = {}for tree in trees:for line in tree.split('\n'):# look for the opening square bracketarr = line.split('[')# if no opening bracket (leaf node), ignore this lineif len(arr) == 1:continue# look for the closing bracket, extract only info within that bracketfid = arr[1].split(']')# extract gain or cover from string after closing bracketg = float(fid[1].split(importance_type)[1].split(',')[0])# extract feature name from string before closing bracket fid = fid[0].split('<')[0]if fid not in fmap:# if the feature hasn't been seen yetfmap[fid] = 1gmap[fid] = gelse:fmap[fid] += 1gmap[fid] += g# calculate average value (gain/cover) for each featurefor fid in gmap:gmap[fid] = gmap[fid] / fmap[fid]return gmap。

梯度boosting算法 原理及应用

梯度boosting算法原理及应用梯度提升算法(Gradient Boosting)是一种集成学习方法,它通过串行地训练一系列的弱学习器,并寻找下一个学习器的方向来最小化损失函数。

其原理主要通过梯度下降来进行模型训练。

梯度提升算法的步骤如下:1. 初始化模型,可以是一个简单的初始预测值,比如用训练集的均值来初始化。

2. 计算当前模型的损失函数的梯度和对应的残差。

损失函数可以根据具体任务选择,比如平方误差损失函数用于回归问题,对数损失函数用于二分类问题等。

3. 使用一个弱学习器来拟合当前模型的残差。

弱学习器可以选择决策树等简单的模型。

4. 更新模型,在当前模型的基础上添加一个新的弱学习器,通过寻找残差在新学习器上的梯度方向来更新模型。

5. 重复步骤2-4,直到达到预定的学习器个数或者达到某个停止条件。

6. 将所有弱学习器的预测结果叠加起来,得到最终的模型预测结果。

梯度提升算法的优点主要体现在以下几个方面:1. 高预测精度:梯度提升算法能够通过不断拟合残差来提高模型的预测精度,尤其是在数据集复杂、噪音较大的情况下表现出色。

2. 可解释性:梯度提升算法可以基于决策树等简单模型进行拟合,使得最终的模型具有较强的可解释性,可以帮助分析数据的特征重要性等问题。

3. 损失函数灵活性:梯度提升算法可以根据不同任务选择合适的损失函数,适用于回归、分类和排名等各种场景。

梯度提升算法有广泛的应用领域,包括但不限于以下几个方面:1. 预测建模:梯度提升算法在预测建模中广泛应用,比如房价预测、用户购买意向预测等任务。

它能够通过不断拟合残差来提高模型的预测精度。

2. 金融风控:在金融领域,梯度提升算法被广泛应用于风控模型的建设。

通过分析用户的历史行为数据,预测用户的信用违约风险,提高风控能力。

3. 推荐系统:在推荐系统中,梯度提升算法可以通过分析用户的历史行为记录,建立用户画像并预测用户的兴趣偏好,从而提供个性化的推荐服务。

boosting算法原理

boosting算法原理Boosting算法是一种非常常用的机器学习算法,被广泛应用于分类、回归等领域。

它的原理是将若干个弱分类器(weak classifier)通过加权平均的方式组合成一个强分类器(strong classifier),以提高分类的准确率。

下面,我们将介绍Boosting算法的原理和实现方法。

一、原理Boosting算法的核心思想是以一种特殊的方式组合弱分类器,每个弱分类器只能做出比随机猜测稍微好一点的决策。

Boosting将它们组合起来,变成一个强分类器。

具体实现的过程如下:1. 给每个样本赋一个权重值,初始化为1/n,其中n为样本数目。

2. 针对每个样本训练一个弱分类器,例如决策树。

3. 对每个弱分类器计算出它们的误差率,即错误分类样本的权重和。

4. 更新每个样本的权重,在每轮训练中,分类错误的样本会获得更高的权重值。

5. 将所有的弱分类器按照误差率给出权重。

6. 以各个弱分类器的权重作为权重进行加权平均,得到最终的分类器。

二、实现Boosting算法有多种实现方式,其中比较常用的是Adaboost算法,它是一种迭代算法,通过调整样本权重和弱分类器权重实现分类器的训练。

具体实现步骤如下:1. 给每个样本赋一个权重值,初始化为1/n,其中n为样本数目。

2. 针对每个样本训练一个弱分类器,例如决策树。

3. 对每个弱分类器计算出它们的误差率,即错误分类样本的权重和。

4. 计算每个弱分类器的权重,并更新样本的权重,增加分类错误的样本的权重,减少分类正确的样本的权重。

5. 重复上述步骤,直至满足条件为止(例如:弱分类器的数目、误差率等)。

6. 将所有的弱分类器按照误差率给出权重。

7. 以各个弱分类器的权重作为权重进行加权平均,得到最终的分类器。

三、总结在使用Boosting算法时,需要注意选择合适的弱分类器。

这里我们以决策树为例,在实际应用中,我们可以采用其他的算法,如神经网络等。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

xgboost 算法原理与实战前言:xgboost 是大规模并行boosted tree 的工具,它是目前最快最好的开源boosted tree 工具包,比常见的工具包快10 倍以上。

在数据科学方面,有大量kaggle 选手选用它进行数据挖掘比赛,其中包括两个以上kaggle 比赛的夺冠方案。

在工业界规模方面,xgboost 的分布式版本有广泛的可移植性,支持在YARN, MPI, Sungrid Engine 等各个平台上面运行,并且保留了单机并行版本的各种优化,使得它可以很好地解决于工业界规模的问题。

花了几天时间粗略地看完了xgboost 原论文和作者的 slide 讲解,仅仅是入门入门入门笔记。

给我的感觉就是xgboost 算法相关文献资料:Xgboost Slides XGBoost 中文版原理介绍原始论文 XGBoost: A Scalable TreeBoosting System XGBoost Parameters (official guide)精彩博文: XGBoost 浅入浅出—— wepon xgboost: 速度快效果好的boosting 模型 CompleteGuide to Parameter Tuning in XGBoost (with codes in Python)一、 xgboost 基本原理介绍1.提升方法是一种非常有效的机器学习方法,在前几篇笔记中介绍了提升树与GBDT基本原理, xgboost( eXtreme Gradient Boosting )可以说是提升方法的完全加强版本。

xgboost 算法在各大比赛中展现了强大的威力,引用原论文中的一段描述:The impact of the system has been widely recognized in a number of machine learning and datamining challenges. Take the challenges hosted by the machine learning competition site Kagglefor example. Among the 29 challenge winning solutions published at Kaggle ’ s blog during 2015, 17 solutions used XGBoost. Among these solutions, eight solely used XGBoost to train themodel,while most others combined XGBoost with neural nets in ensembles. For comparison, thesecond most popular method,deep neural nets, was used in 11 solutions. The success of thesystem was also witnessed in KDDCup 2015, where XGBoost was used by every winning team inthe top -10.Moreover, the winning teams reported that ensemble methods outperform awell -configured XGBoost by only a small amount.2.Regression Tree and Ensemble (What are we Learning,得到学习目标)(1) .Regression Tree (CART)回归树(2) .Regression Tree Ensemble 回归树集成在上面的例子中,我们用两棵树来进行预测。

我们对于每个样本的预测结果就是每棵树预测分数的和。

(3) .Objective for Tree Ensemble 得到学习目标函数这里是构造一个目标函数,然后我们要做的就是去尝试优化这个目标函数。

读到这里,感觉与gbdt 好像没有什么区别,确实如此,不过在后面就能看到他们的不同了(构造(学习)模型参数)。

3.Gradient Boosting (How do we Learn ,如何学习 )(1) .So How do we Learn? 目标函数:(2) .Additive Training(3) .Taylor Expansion Approximation of Loss 泰勒近似展开把平方损失函数的一二次项带入原目标函数,你会发现与之前那张ppt 的损失函数是一致的(4) .Our New Goal 得到新的学习目标函数从这里就可以看出xgboost 的特点了,目标函数保留了泰勒展开的二次项。

(5) .Refine the definition of tree重新定义每棵树(6) .Define the Complexity of Tree 树的复杂度项L2 正则化项,针对每个叶结点从图中可以看出, xgboost 算法中对树的复杂度项增加了一个的得分增加 L2 平滑,目的也是为了避免过拟合。

(7) .Revisit the Objectives(8).The Structure Score 这个score 你可以理解成类似于信息增益的一个指标,在切分点查找算法中用到。

(9)切分点查找算法(贪心算法)上图中 G 都是各自区域内的 gi 总和,此外,作者针对算法设计对特征进行了排序,有兴趣的可以阅读原始论文,这里不做详解。

二、 xgboost 特点(与 gbdt 对比)说明一下:这部分内容参考了知乎上的一个问答—机器学习算法中 GBDT 和 XGBOOST的区别有哪些?,答主是 wepon 大神,根据他的总结我自己做了一理解和补充。

1.传统 GBDT以 CART作为基分类器, xgboost 还支持线性分类器,这个时候xgboost 相当于带 L1 和 L2 正则化项的逻辑斯蒂回归(分类问题)或者线性回归(回归问题)。

—可以通过booster [default=gbtree] 设置参数 :gbtree: tree -based models/gblinear: linear models2.传统 GBDT在优化时只用到一阶导数信息,xgboost 则对代价函数进行了二阶泰勒展开,同时用到了一阶和二阶导数。

顺便提一下,xgboost 工具支持自定义代价函数,只要函数可一阶和二阶求导。

—对损失函数做了改进(泰勒展开,一阶信息 g 和二阶信息 h,上一章节有做介绍)3.xgboost 在代价函数里加入了正则项,用于控制模型的复杂度。

正则项里包含了树的叶子节点个数、每个叶子节点上输出的 score 的 L2 模的平方和。

从 Bias-variance tradeoff 角度来讲,正则项降低了模型 variance,使学习出来的模型更加简单,防止过拟合,这也是 xgboost 优于传统GBDT 的一个特性—正则化包括了两个部分,都是为了防止过拟合,剪枝是都有的,叶子结点输出L2 平滑是新增的。

4.shrinkage and column subsampling还是为了—防止过拟合,论文2.3节有介绍,这里答主已概括的非常到位(1)shrinkage 缩减类似于学习速率,在每一步tree boosting 之后增加了一个参数n(权重),通过这种方式来减小每棵树的影响力,给后面的树提供空间去优化模型。

(2)column subsampling 列 (特征 )抽样,说是从随机森林那边学习来的,防止过拟合的效果比传统的行抽样还好(行抽样功能也有),并且有利于后面提到的并行化处理算法。

5.split finding algorithms( 划分点查找算法):—理解的还不够透彻,需要进一步学习(1) exact greedy algorithm 贪—心算法获取最优切分点(2) approximate algorithm —近似算法,提出了候选分割点概念,先通过直方图算法获得候选分割点的分布情况,然后根据候选分割点将连续的特征信息映射到不同的buckets 中,并统计汇总信息。

详细见论文 3.3 节(3)Weighted Quantile Sketch 分—布式加权直方图算法,论文 3.4 节这里的算法( 2)、( 3)是为了解决数据无法一次载入内存或者在分布式情况下算法( 1 )效率低的问题,以下引用的还是 wepon 大神的总结:可并行的近似直方图算法。

树节点在进行分裂时,我们需要计算每个特征的每个分割点对应的增益,即用贪心法枚举所有可能的分割点。

当数据无法一次载入内存或者在分布式情况下,贪心算法效率就会变得很低,所以xgboost 还提出了一种可并行的近似直方图算法,用于高效地生成候选的分割点。

6.对缺失值的处理。

对于特征的值有缺失的样本, xgboost 可以自动学习出它的分裂方向。

—稀疏感知算法,论文 3.4 节, Algorithm 3: Sparsity -aware Split Finding7.Built -in Cross-Validation (内置交叉验证)XGBoost allows user to run a cross -validation at each iteration of the boosting process and thusit is easy to get the exact optimum number of boosting iterations in a single run. This is unlike GBM where we have to run a grid -search and only a limited values can be tested.8.continue on Existing Model (接着已有模型学习)User can start training an XGBoost model from its last iteration of previous run. This can be of significant advantage in certain specific applications. GBM implementation of sklearn also has this feature so they are even on this point.9.High Flexibility (高灵活性)**XGBoost allow users to define custom optimization objectives and evaluation criteria. Thisadds a whole new dimension to the model and there is no limit to what we can do.**10.并行化处理—系统设计模块 ,块结构设计等xgboost 工具支持并行。