Lucene技术研究

基于Lucene的搜索引擎的研究与应用的开题报告

基于Lucene的搜索引擎的研究与应用的开题报告一、选题背景与意义随着大数据时代的到来,信息处理与搜索引擎的需求越来越旺盛。

搜索引擎已经成为了用户最主要的获取信息的方式之一,而其对于信息的快速准确检索,已经逐渐成为了搜索引擎最基本的核心要素。

在搜索引擎的实现中,建立搜索引擎的核心技术是信息检索技术。

Lucene是一种优秀的信息检索工具,它是一个开源的高性能全文检索引擎,是全球范围内最受欢迎和广泛使用的Java搜索引擎工具之一。

Lucene的出现,大大减轻了开发人员在搜索引擎上面的工作。

因此,本研究旨在结合Lucene技术,建立一个基于Lucene的高性能搜索引擎。

同时,本研究旨在建立一个高效可用的开源搜索引擎,提供了一种降低信息检索门槛的工具,可以帮助各行业快速掌握搜索引擎,实现业务数据的快速检索。

对于大数据时代进行数据分析、处理、挖掘和管理具有重要意义,提高企业的决策效率和准确性,并且降低成本和人力资源。

二、研究内容及方法2.1 研究内容:(1)了解信息检索和全文检索的概念和原理。

(2)分析Lucene架构和工作原理,掌握Lucene的基本概念和核心技术。

(3)按照Lucene的架构,设计并实现搜索引擎的各个模块。

(4)进行搜索引擎的基本测试和功能测试,检查搜索引擎的性能和可靠性。

2.2 研究方法:(1)文献综述法:阅读大量的文献和资料,理清搜索引擎的基本概念和原理。

(2)实验法:按照Lucene的架构,建立实验室,开发搜索引擎的各个模块,并进行测试和评估。

三、研究计划时间节点研究任务2021.1-2021.2 阅读文献,调研和理解搜索引擎的基本概念和原理。

2021.3-2021.4 学习Lucene技术,分析Lucene的架构和工作原理。

2021.5-2021.6 根据Lucene技术建立搜索引擎,在本地环境中逐步完善各个模块。

2021.7-2021.8 进行搜索引擎的基本测试和功能测试,并检查搜索引擎的性能和可靠性。

基于Lucene的中文分词技术研究

向或逆 向最大匹配 的方法来分 词。例如 ,假设词 典包括 如下

的 词语 :

今天 / 很好” 。

天

天气

很

好

很好

输入 “ 今天天气很好 ” ,最后 的分词结 果为 “ 今天 , 天气

正 向最大匹配 和逆向最大 匹配 的实 现大 同小 异 ,最 大的 区别 就是正 向最 大匹配是 正向扫描字符 串 ,逆 向最大 匹配是

除 了这 两种 ,另外 一种最 少切分 的方法是使 每一句 中切 出的词数最小 。 22 基于统计 的分词方法 .

所周 知 ,英 语等西方 语言是使 用空格 和标 点来分 隔单词 。但 是在 汉语等 亚洲语种 中 ,一 般使用 表意文 字 ,而 不是使 用 由

字母 组成 的单词 。所 以相对 于西方语 言 ,L c n 中文 分词 ue e对

a c a y c ur c ・

Ke r s h n s e me t t n; u e e; xma t h n ma i m rb b l y y wo d :C i e e s g n ai o L c n ma i lma c i g; x mu p a i t o i

1 引 言

的效果并不是很好 。L cn 处理 中文分词常用方法有 3种 : ue e ()单字方式 : 【 【 【 【 [ 【 。 1 咬】 死】 猎】 人】 的】 狗]

() 二元覆 盖方式 : 【 2 咬死】 [ 死猎】 [ 人1 【 的1 猎 人 【 的狗】 。

w r e e t t n meh d a d ma i m r b b l y p rii l t o i h i t ov h r b e o n e u t o o d s g n a i t o n x mu p o a i t a t p e me d wh c s o s le t e p o l m f ma y r s l f m o i c h s

lucene算法原理

lucene算法原理Lucene算法原理Lucene是一个开源的全文检索引擎工具包,采用Java语言编写,被广泛应用于各类信息检索系统中。

它的核心思想是将文本信息转化为可被计算机理解和处理的数据结构,以实现高效的文本搜索和检索功能。

本文将介绍Lucene算法的原理及其核心组成部分。

一、倒排索引Lucene的核心数据结构是倒排索引(Inverted Index),它是一种将文档中的单词映射到文档的数据结构。

传统的索引方式是顺序索引,即根据文档顺序逐个记录单词。

而倒排索引则是根据单词逐个记录文档,将每个单词对应的文档存储在一个倒排列表中。

这种方式可以极大地提高搜索效率,因为它能够快速地找到包含某个特定单词的文档。

二、分词器在构建倒排索引前,需要将文本进行分词处理。

分词器(Tokenizer)将文本切分成一个个独立的词项(Term),并去除停用词等无关信息。

Lucene提供了多种分词器,如标准分词器(StandardTokenizer)、简单分词器(SimpleTokenizer)等,用户也可以自定义分词器以适应不同的需求。

三、索引构建索引构建是指将文档转化为倒排索引的过程。

首先,需要创建一个索引目录(Index Directory),用于存储索引文件;然后,通过Analyzer对文档进行分词处理;最后,将分词结果按照倒排索引的结构存储到索引目录中。

四、搜索过程Lucene的搜索过程主要包括查询解析、查询扩展和评分排序三个步骤。

1. 查询解析:用户输入的查询语句经过查询解析器(Query Parser)处理,将其解析为一个个查询表达式。

查询解析器支持多种查询语法,如布尔查询、模糊查询、范围查询等。

2. 查询扩展:为了提高搜索的准确性和覆盖率,Lucene支持查询扩展功能。

通过分析用户查询的上下文,自动为查询语句添加相关的词项,从而扩展查询范围。

3. 评分排序:Lucene使用TF-IDF算法对搜索结果进行评分排序。

lucene 搜索技术

本文主要通过三个部分来分别介绍lucene:认识lucene、通过lucene建立索引和对已经建立的索引进行搜索,文章内容大部分参考”IBM developerWorks 中国”,我想这篇文章对于要学习或已经接触过Lucene的朋友是一个比较好的资料。

第一部分Lucene 简介Lucene 是一个基于 Java 的全文信息检索工具包,它不是一个完整的搜索应用程序,而是为你的应用程序提供索引和搜索功能。

Lucene 是一个开源、高度可扩展的搜索引擎库,可以从 Apache Software Foundation 获取。

您可以将Lucene 用于商业和开源应用程序。

Lucene 强大的 API 主要关注文本索引和搜索。

它可以用于为各种应用程序构建搜索功能,目前已经有很多应用程序的搜索功能是基于 Lucene 的,比如 Eclipse 的帮助系统的搜索功能、电子邮件客户端、邮件列表、Web 搜索、数据库搜索等等。

Wikipedia、TheServerSide、jGuru 和 LinkedIn 等网站都使用了 Lucene。

Lucene 能够为文本类型的数据建立索引,所以你只要能把你要索引的数据格式转化的文本的,Lucene 就能对你的文档进行索引和搜索。

比如你要对一些HTML 文档,PDF 文档进行索引的话你就首先需要把 HTML 文档和 PDF 文档转化成文本格式的,然后将转化后的内容交给 Lucene 进行索引,然后把创建好的索引文件保存到磁盘或者内存中,最后根据用户输入的查询条件在索引文件上进行查询。

不指定要索引的文档的格式也使 Lucene 能够几乎适用于所有的搜索应用程序。

到 2009 年 7 月 30 日止,用于Java™ 编程语言的最新版 Lucene 为V2.4.1。

Lucene 功能众多:• 拥有强大、准确、有效的搜索算法。

• 计算每个文档匹配给定查询的分数,并根据分数返回最相关的文档。

Lucene技术总结共15页word资料

2012/2/26一、摘要本文档是在完成山东农信知识库项目的基础上编写的,简要介绍了lucene技术的原理、分词技术、索引技术、文档权重、文档排重技术等,本文档的定位是lucene初级开发人员,如果您已经是lucene专家或者是搜索引擎的大牛,就没必要来看本文档了。

本文档的所有编码是基于lucene 3.0.4完成的,使用的是标准分析器,对于不同的lucene版本或者不同的分析器,代码会有一定的差异。

二、Lucene全文检索的实现Lucene是一个高效的全文检索库。

相信各位同事在项目中通过数据库检索的案例很多,数据库检索大家一定非常熟悉了,我们知道在正常情况下数据库查询搜索能够满足我们的需求,那为什么还要用到lucene全文检索呢?在学习lucene之前,我们先了解一下全文检索吧。

数据分为两种:结构化数据和全文数据(又叫做非结构化数据)。

•结构化数据:指具有固定格式或有限长度的数据,如数据库,元数据等。

•全文数据:指不定长或无固定格式的数据,如邮件,word文档等。

对结构化数据的搜索,我们一般用到数据库比较多。

那对于全文数据的搜索呢?我们需要针对全文数据制定全文搜索的方式,其中像lucene这样,先建立索引,再对索引进行搜索就是其中的一种。

Lucene是一个基于java的全文索引引擎工具包,它提供了各种借口,可以方便的此文档讲述了lucent技术的基本用法,包括分词、索引、排重等技术。

嵌入到各种应用中,通过对接口的实现满足我们全文索引或者检索功能。

在对非结构化数据索引之前,我们需要先将数据进行分词处理,对于英文分词比较简单,一个空格间隔就是一个单词,而对于中文,我们如何将中文的词提取出来再进行索引难度就比较大了。

Lucene提供了多种语言分析器,在本文档的第四节中,我们将会对lucene分词技术做详细的讲解。

在对文字进行关键字提取之后,下一步就需要对内容进行索引了。

索引是通过document存储的,document可以设定多个field字段,根据需要按照规则索引或者存储字段。

Lucene排序算法的研究和改进

与相应的页面 i一起保存 。 d 这样 ,ቤተ መጻሕፍቲ ባይዱ在下~次计算 ㈩ (){ 】 ( 】 =dd 十 1+ - l l _

指标 。

关 键 字 :u e e ̄ 序 算 法 ;ae n ; ed1 代 L c n ;} P gRa k S ie 迭 中图分 类号 : 3 文献标 识 码 : TP A

在搜索引擎的研究中 , —个核心 问题就是 排序算法 的确定 。较成熟 的方法包括 向量空间 模型, 概率模型和统计语言模型等。 ue e 用 L cn 采 的是向量 空间模型 ,基本思想是将 网页文档集

, …

矩 阵特征向量的过程 : M表示 C的过 渡矩阵 , 如 可使有效地对某个查询或某 一域 给评分 带来的 果存 在节点 i 到节点 i 的边 , 则置矩 阵中元素 的 影响施加控制。 值 为 士一, 否则 为 0 。这 样 , 最终 的结果 满 足 : 3 基于链接 分析的 L c n 排序算法 . 2 uee x M ,其 中 x 示各 网页的 PgR n 构成 的 =x 表 ae ak 本文在 L cn 默认的排序算 法的基 础上加 u ee 向量。 我们可以用简单迭代法对上式进行求解 , 入 PgR n 算法 , 法中考虑网页点 击信息和 ae ak 算 时间反馈 因素 ,实现 网页根据浏览 点击 率和网 : M ’ M + 1 c( ) =c (_ ) ÷ 页文档的新旧程度 , P 其 R值也随之上下浮动 。 用 M 代替 M进行计算 , 相当于在 G的每两个节 戚华春 等 提出了一个具有 时间反馈 的 PgR ae — 点间增加了两条边 ,这样做 的同时也解决了所 ak改进算法 , PgR n 计算 时引入 时间反 n 在 ae ak 谓的 R n n 问题 此时迭代 形式 如下 : ak i S k 馈因子 , 网页 的发布时 间长短影 响网页的 P 使 R  ̄3/ 。 vJ 这种算法有利于旧网页的下 沉 , ' 新网页 +=c l M +1c ( ( ) ÷) 一 的上浮 , 符合人们 的直观期望 , 但不一定符 合实 这样 ,在保证迭代 收敛 的同时 ,ae ak PgR n 的计 际检索的需 要。 基于这个思想 ,本文在系统 中将用 户对搜 算公式 可以定 义如 下: 假设 页面 , … 有 链接指 向页面 A, 索排序结 果 中 ul r的每一次点击 都看做是 对相 参数 d 为值 在 0 1 — 之间 的衰退 因子 , ㈣ 为页 应网页 的一次选择 , c 将它作 为评价 网页重要性 面 T中超链接 的个数 ,则 A的 PgR n 值 P 的一个因素。 。 ae ak R 在用户使用搜索 引擎 时, 其每次点 击 ul r的动作都被 引擎服务器记录下来 , 用户 I P

基于 Lucene 搜索引擎的研究与改进

基于 Lucene 搜索引擎的研究与改进摘要Lucene 是目前已经几年,最受欢迎的免费 Java 的全文检索库。

首先,本文分析了珠光体系结构、索引机制、搜索机制;其次,它研究排序技术和如何调整索引的性能;最后,文章提出了新的检索排序算法。

关键字:索引;搜索;条款;因子;maxMergeDocs;满意程度;;新的算法一、引言Lucene 是优秀的全文搜索引擎工具软件包和一个成熟的、免费的、开源的项目,在Java 中实现。

然而,它不是一个完整的全文搜索引擎,而是全文搜索引擎的体系结构。

Lucene 提供完整的搜索引擎,完整的索引引擎,部分文本分析引擎 (两种西方语言:英语和德语)[1]。

它是项目 Apache 雅加达家庭成员。

本文的结构如下:第二部分我们分析 Lucene 系统结构;第三部分研究 Lucene 运行机制 (索引和搜索);第四部分讨论如何调整索引的性能;第五部分我们对分类技术的研究,提出新的检索排序算法。

在第六部分我们进行有关的新算法的可行性分析;最后在第七部分得出结论。

二、LUCENE 系统结构作为一个优秀的全文搜索引擎,Lucene 系统结构具有强烈的面向对象特征。

首先,Lucene 系统定义一个索引文档格式已无关平台;第二,该系统的核心部件旨在抽象类,和混凝土平台实现设计用来抽象类实现;最后,它穿过层面向对象处理,实现一种低耦合,高效率,便于二次开发的搜索引擎系统。

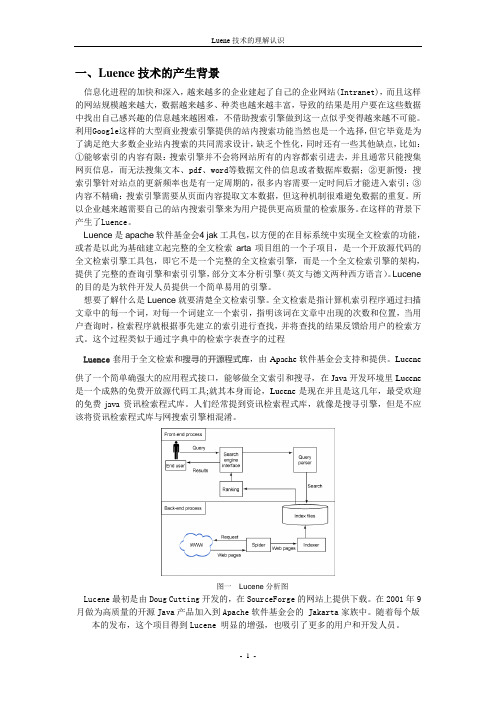

Lucene 体系结构如图 1 所示:图1 Lucene索引结构从图 1,我们可以看到,Lucene 系统由3个主要部分,即基本的封装结构、索引核心、外部接口组成。

索引核心也是系统的关键所在。

Lucene 系统所有源代码都划分成 7个模块 (在Java包来表示),并且每包完成特定的功能。

其核心类软件包是组织 Apache.Lucene.analysis,org.apache lucene.index,org.apache lucene.search。

luence技术

一、Luence技术的产生背景信息化进程的加快和深入,越来越多的企业建起了自己的企业网站(Intranet),而且这样的网站规模越来越大,数据越来越多、种类也越来越丰富,导致的结果是用户要在这些数据中找出自己感兴趣的信息越来越困难,不借助搜索引擎做到这一点似乎变得越来越不可能。

利用Google这样的大型商业搜索引擎提供的站内搜索功能当然也是一个选择,但它毕竟是为了满足绝大多数企业站内搜索的共同需求设计,缺乏个性化,同时还有一些其他缺点,比如:①能够索引的内容有限:搜索引擎并不会将网站所有的内容都索引进去,并且通常只能搜集网页信息,而无法搜集文本、pdf、word等数据文件的信息或者数据库数据;②更新慢:搜索引擎针对站点的更新频率也是有一定周期的,很多内容需要一定时间后才能进入索引;③内容不精确:搜索引擎需要从页面内容提取文本数据,但这种机制很难避免数据的重复。

所以企业越来越需要自己的站内搜索引擎来为用户提供更高质量的检索服务。

在这样的背景下产生了Luence。

Luence是apache软件基金会4 jak工具包,以方便的在目标系统中实现全文检索的功能,或者是以此为基础建立起完整的全文检索arta项目组的一个子项目,是一个开放源代码的全文检索引擎工具包,即它不是一个完整的全文检索引擎,而是一个全文检索引擎的架构,提供了完整的查询引擎和索引引擎,部分文本分析引擎(英文与德文两种西方语言)。

Lucene 的目的是为软件开发人员提供一个简单易用的引擎。

想要了解什么是Luence就要清楚全文检索引擎。

全文检索是指计算机索引程序通过扫描文章中的每一个词,对每一个词建立一个索引,指明该词在文章中出现的次数和位置,当用户查询时,检索程序就根据事先建立的索引进行查找,并将查找的结果反馈给用户的检索方式。

这个过程类似于通过字典中的检索字表查字的过程Luence套用于全文检索和搜寻的开源程式库,由Apache软件基金会支持和提供。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1、lucene是apache下的一个开源框架,主要使用于处理大量资源全文搜索的时间使用的工具。

从其官方网站定义为:Apache的Lucene的是一种基于java语言开发的、高性能、跨平台、几乎适用于任何程序的全文搜索引擎。

并且apache的Lucenea是完全开源的。

当前最新版本是2.4.1。

下边我们首先看一个简单的Lucene的例子。

所有的暂时:2

Document<stored/uncompressed,indexed,tokenized<bookname:“黑西装”直奔克拉厅的柜台前,称要买之前看中的33万元的裸钻。

得知是前一天预约的顾客后,营业员顿时兴高采烈地拿出了裸钻。

“黑西装”取出了自带的放大镜,还拿出了一个镊子,仔细观察钻石的成色。

大约10分钟后,“黑西装”查看结束,将裸钻还给营业员,表示十分满意,提出1小时后来取货。

在“黑西装”查看裸钻的时候,“白夹克”并未凑过来,而是在旁边挑选其他饰品。

>>

Document<stored/uncompressed,indexed,tokenized<bookname:24日早晨,民警追查到,这3人目前正住在闵行区金汇路颐美庭园酒店内。

当天下午3点半左右,民警在306房间内将“黑西装”李银林和“白夹克”万尧荣等3人抓获。

此时距离钻石被盗仅24个小时。

经审问,李银林在拿镊子查看裸钻时,曾利用营业员低头的一刹那,伸手摸了摸自己的裤子口袋———短短几秒钟的时间,他便完成了调包。

>>

1、我们去分析一下该段程序。

a> 首先我们创建一个类IndexWriter,该类是lucene创建索引的核心,其主要功能是将所有的数据源所有内容,经过分词处理,创建成索引格式的文件<同数据库想对比,一个索引文件就相当一张表)

b> 然后,我们定义了document类。

Lucene是将所有的数据源都转换成Document 类型的文件,lucene内部只能识别出Document类型的文件。

<同数据库相比的话,Document就像一个表的每一条记录。

)

c> 然后我们定义了一些File类,其中File是作为真实的数据存储使用,每一个需要索引的内容都对应一个Filed,<和数据库相比,Field就相当一一条记录的一个属性与其值)。

d> 然后将Field增加到Document中,其中每个Document可以增加到多个Field对象。

然后将所有的Doc交给IndexWriter去创建索引,创建完成后,如图一

图一 lucene索引后的文件

E> 然后开始查询,首先使用IndexReader来读取所创建目录下的索引文件,然后创建一个IndexSearch对象,该对象主要功能就是从索引中查询。

F> 然后定义查询策略,本例中采用queryParse来查询,然后循环,将所有查询的结果打印出来。

1、Document文件

Document是lucene自己定义的一种文件格式,lucene使用docement来代替对应的物理文件或者保存在数据库中的数据。

因此Document只能作为数据源在Lucene中的数据存贮的一种文件形式。

Document只是负责收集数据源,因为不同的文件可以构建同一个Document。

只要用户将不同的文件创建成Document类型的文件,Lucene就能快速找到查找并且使用他们。

对于一个Document文件,可以同时增加多个Field。

Lucene中对于每个数据源是使用Field类来表示的。

多个Field组成一个Document,多个Document组成一个索引文件。

Document与Fi eld关系如果一所示

图片看不清楚?请点击这里查看原图<大图)。

此时,我们去看看Document这个类的源代码。

Document采用默认不带参数的构造函数,但是我们他在创建的时间,

产生两个变量:fields和boost

其中fields是创建了一个arrayList,其主要是保存Field类

Boost主要是设置该doc的优先级

其方法:add<Fieldable field)增加一个field对象

removeField(String name> 根据name移除一个ield对象<找到一个就返回)

removeFields(String name> 根据name移除所有的field对象

Field getField(String name> 根据名字找到该Field对象。

Fieldable getFieldable(String name> 根据名字找到Fieldable子类<Fieldable是

接口,具体有Filed来实现)

String get(String name> 根据名字,找到给Filed对象中包含的内容

public final byte getBinaryValue(String name> 主要查找Doc中包含有二进制field 数据<如果不存在,则返回null)

public final List getFields(> 直接返回该Doc中包含的Field。

Field类<类似数据库中的字段与属性)

该类实现接口:Fieldable 继承静态类: AbstractField

Fieldable接口。

主要是描述一些基础信息的内容

Filed类源代码解读

首先Filed内部定义了三个静态类Store、Index、TermVector。

这是一个与词条有关的类。

因为在检索的时候需要指定检索关键字,通过为一个Field添加一个TermVector,就可以在检索中把该Field检索到。

流程:

首先检查name以及values不能为空以及Nnull。

然后检查是否是存储以及是否分词如果两者都是No,则抛出异常。

然后检查是否存储以及是否向量分词,如果两者都是No',则抛出异常。

然后将该Filed的名称命令传递过来的名称源代码< = name.intern)表示获取JVM String常量池的地址

此时根据Store的值,来设置是否存储以及压缩的值

然后根据Index的值,来设置是否索引、是否分词、omitNorms的值以及置是否是二进制

然后开始根据TermVector 的值,来设置是否存储向量、是否存储偏移量、是否存储位置等信息。

注意:

如果使用高版本的话,对于Field的初始化已经发生改变,如下:

new Field(String name,TokenStream> new Field(String name,String value,Store,Index> 原有的Text,KeyWord已经不存在了:

doc.add(Field.Text("content",new FileReader(f>>>。

doc.add(Field.Keyword("filename",f.getCanonicalPath(>>>。