信源及信源熵习题答案

信息论与编码习题与答案第二章

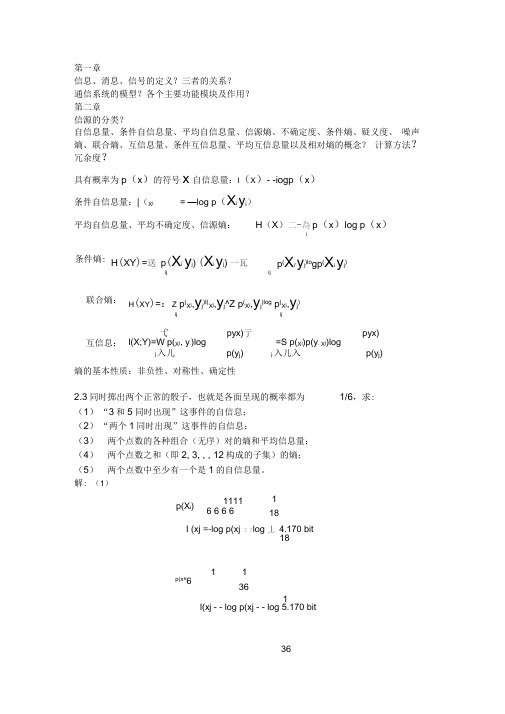

36第一章信息、消息、信号的定义?三者的关系? 通信系统的模型?各个主要功能模块及作用? 第二章信源的分类?自信息量、条件自信息量、平均自信息量、信源熵、不确定度、条件熵、疑义度、 噪声熵、联合熵、互信息量、条件互信息量、平均互信息量以及相对熵的概念? 计算方法? 冗余度?具有概率为p (x )的符号x 自信息量:I (X )- -iogp (x ) 条件自信息量:|(X i= —log p (X i y i )平均自信息量、平均不确定度、信源熵:H (X )二-為p (x )log p (x )iH (XY )=送 p (X i ,y j )|(X i y j ) 一瓦ijij联合熵: H (XY )=:Z p (X i ,y j )I(X i ,y j ^Z p (X i ,y j )log p (X i ,y j)ijij互信息: 弋pyx)亍 pyx) l(X;Y)=W p(X i , y .)log=S p(X i )p(y . X i )log j 入儿p(y j )j 入儿入p(y j )熵的基本性质:非负性、对称性、确定性2.3同时掷出两个正常的骰子,也就是各面呈现的概率都为 1/6,求:(1) “3和5同时出现”这事件的自信息; (2) “两个1同时出现”这事件的自信息;(3) 两个点数的各种组合(无序)对的熵和平均信息量; (4) 两个点数之和(即2, 3, , , 12构成的子集)的熵; (5) 两个点数中至少有一个是1的自信息量。

解: (1)I (xj =-log p(xj 工「log 丄 4.170 bit181l(xj - - log p(xj - - log 5.170 bit条件熵: p (X i ,y j )lo gp (X i y j )p(X i )11116 6 6 61 181 p(x"61 36(1 1 11、 H(X)=—E p(X j )log p(xj = — 6汉 一log — +15 汉一log — 丨=4.337 bit/symbol i< 36 36 18 18 丿(4)两个点数求和的概率分布如下:X234 5 6 7 8 9 10 11 12\=V1 115 15 11 1 1P(X)広 18 12 9 36 6 36 9 12 18 36 H(X) =p(X i )log p(X i )i(1 1 11 1 1 1 1 5511)=_2汉 log +2 乂 log+2 工 log +2乂 log +2 工 log + log< 36 36 181812 12 9 936 36 6 6 J= 3.274 bit / symbol(5){(1,2),(1,3),(1,4),(1,5),(1,6),(2,1),(3,1),(4,1),(5,1),(6,1),(1,1)}11 l(x 」--log p(x 」-- log 1.71036X x 1 = 0 x 2 = 1 x 3 = 2 x 4 = 32.7设有一离散无记忆信源,其概率空间为=f 丿 <3/8 1/41/4 1/8 丿(1 )求每个符号的自信息量 (2)信源发出一消息符号序列为 {202 120 130 213 001 203 210 110 321010 021032 011 223210},求该序列的自信息量和平均每个符号携带的信息量18I (x 1) = log 2log 21.415bit p(x 1)3同理可以求得 1(x2)二 2bit, I (x3) = 2bit, I (x4) = 3bit因为信源无记忆,所以此消息序列的信息量就等于该序列中各个符号的信息量之和 就I =141(X 1) 131(X 2) 121(X 3) 61(X 4)=87.81bit11 12 13 14 1516 21 22 23 24 2526 31 32 33 34 3536 41 42 43 44 4546 51 52 53 54 5556 616263646566共有21种组合:其中11,22,33, 44,55, 66的概率是 1 1 X —6 6 ⑶两个点数的排列如下:1 1 1其他15个组合的概率是2 ——二—6 6 181 36p(X i )— 11 6 6 11 36bit解:2.8试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍?解:四进制脉冲可以表示 4个不同的消息,例如 八进制脉冲可以表示 8个不同的消息,例如 二进制脉冲可以表示 2个不同的消息,例如 假设每个消息的发出都是等概率的,则:四进制脉冲的平均信息量 H (XJ = log n = Iog4 = 2 bit/symbol 八进制脉冲的平均信息量 H (X 2) = log n = Iog8 = 3 bit/symbol 二进制脉冲的平均信息量 H (X 0) = log n = log2 = 1 bit/symbol所以:四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的 2倍和3倍。

通信原理第4章信息熵例题

(5)接收到信息 Y 后获得的平均互信息为: I ( X ; Y ) = H ( X ) − H ( X | Y ) = 0.0075 比特/符号

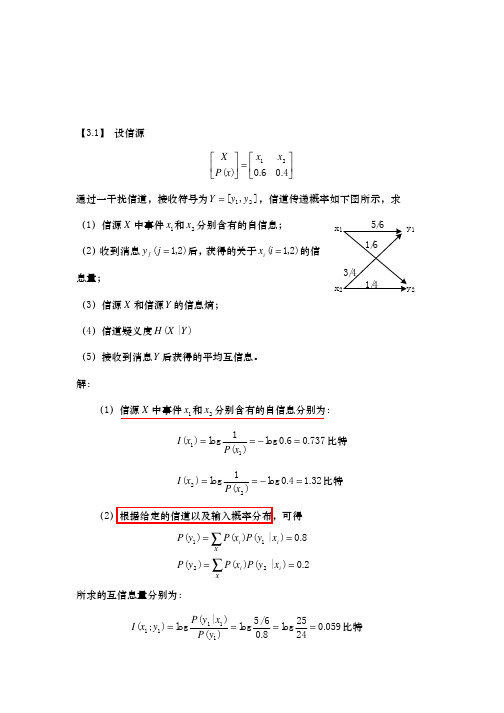

I ( x1 ; y 2 ) = log

I ( x 2 ; y 2 ) = log

(3)信源 X 以及 Y 的熵为: H ( X ) = − ∑ P( x) log P( x) = −0.6 log 0.6 − 0.4 log 0.4 = 0.971 比特/符号

X

H (Y ) = −∑ P( y ) log P( y ) = −0.8 log 0.8 − 0.2 log 0.2 = 0.722 比特/符号

【3.1】 设信源 X x1 x 2 P( x) = 0.6 0.4 通过一干扰信道,接收符号为 Y = [ y1 , y 2 ] ,信道传递概率如下图所示,求 (1)信源 X 中事件 x1 和 x 2 分别含有的自信息; (2) 收到消息 y j ( j = 1,2) 后,获得的关于 xi (i = 1,2) 的信 息量; (3)信源 X 和信源 Y 的信息熵; (4)信道疑义度 H ( X | Y ) (5)接收到消息 Y 后获得的平均互信息。 解: (1)信源 X 中事件 x1 和 x 2 分别含有的自信息分别为: I ( x1 ) = log 1 = − log 0.6 = 0.737 比特 P( x1 ) 1 = − log 0.4 = 1.32 比特 P( x2 ) 3/4 x2 1/4 y2 x1 5/6 1/6 y1

I ( x 2 ; y1 ) = log

P( y1 | x2 ) 3/ 4 15 = log = log = −0.093 比特 P( y1 ) 0.8 16 P( y 2 | x1 ) 1/ 6 5 = log = log = −0.263 比特 P( y 2 ) 0.2 6 P( y 2 | x2 ) 1/ 4 5 = log = log = 0.322 比特 P( y 2 ) 0.2 4

第三章 信道与信道容量 习题解答

,

,求

,

,

和

;

(2) 求该信道的信道容量及其达到信道容量时的输入概率分布。

解:

(1)先写出

:

根据公式

计算联合概率:

信宿端符号分布概率:

根据公式

计算:

3

求各熵: 信源熵:

比特/消息

信宿熵:

比特/消息

可疑度:

平均互信息量: 噪声熵: (2)二元对称离散信道的信道容量:

比特/消息 比特/消息

比特/秒

信源等概分布时(

解:设下标 1为原状况,下标 2为改变后状况。由

可得:

,

倍

如果功率节省一半则

倍 ,为 了 使 功 率 节 省 一 半 又 不 损 失 信 息 量 I,根 据

,可以: (1) 加大信道带宽 W,用带宽换取信噪比

,

,

7

缺点是对设备要求高。 (2) 加大传输时间 T,用传输时间换取信噪比,同理可得:

缺点是传输速度降低了。

噪声熵:

(5)平均互信息量:

2.有一个生产 A、B、C、D四种消息的信源其出现的概率相等,通过某一通信系统传输时,B和 C无误,A 以 1/4概率传为 A,以 1/4概率误传为 B、C、D,而 D以 1/2概率正确传输,以 1/2概率误传为 C,

(1)试求其可疑度?(2)收到的信号中哪一个最可靠?(3)散布度为多少? 解:(1)

,

将各数据代入: 解得:

如果

则

将各数据代入: 解得:

14.在理想系统中,若信道带宽与消息带宽的比为 10,当接收机输入端功率信噪比分别为 0.1和 10时,试

比较输出端功率信噪比的改善程度,并说明

与

之间是否存在阀值效应。

信息论第三版课后答案

信息论第三版课后答案【篇一:西电邓家先版信息论与编码第3章课后习题解答】6x11/6y13/41/4x2图3.1 二元信道y2?x??x1x2???=?0.60.4?通过一干扰信道,接收符号y=?y1y2?,信道传递概率如p(x)????图3.33所示。

求:(1)信源x中事件x1,和x2分别含有的自信息。

(2)收到消息yj(j=1,2)后,获得的关于xi(i=1,2)的信息量。

(3)信源x和信源y的信息熵。

(4)信道疑义度h(x|y)和噪声熵h(y|x)。

(5)接收到消息y后获得的平均互信息。

解:(1)由定义得:i(x1)= -log0.6=0.74biti(x2)= -log0.4=1.32biti(xi;xj)= i(xi)-i(xi|yj)=log[p(xi|yj)/p(xi)]= log[p(yj|xi)/p(yj)]则 i(x1;y1)= log[p(y1|x1)/p(y1)]=log5/6/0.8=0.059bit i (x1;y2)= log[p(y2|x2)/p(y2)]=log1/6/0.2=-0.263biti(x2;y1)= log[p(y1|x2)/p(y1)]=log3/4/0.8=-0.093bit i(x2;y2)= log[p(y2|x2)/p(y2)]=log1/4/0.2=0.322bit(3)由定义显然 h(x)=0.97095bit/符号h(y)=0.72193bit/符号(4)h(y|x)=?22p(xy)log[1/p(y|x)]=??i?1j?1p(xi)p(yj|xi)log[1/p(yj|xi)]h(x|y)= h(x)+h(y|x)-h(y)=0.9635bit/符号(5) i(x;y)= h(x)-h(x|y)=0.00745 bit/符号3.2设8个等概率分布的消息通过传递概率为p的bsc进行传送。

八个消息相应编成下述码字:m1=0000, m2=0101, m3=0110, m4=0011, m5=1001, m6=1010, m7=1100, m8=1111, 试问 (1) 接受到第一个数字0与m之间的互信息。

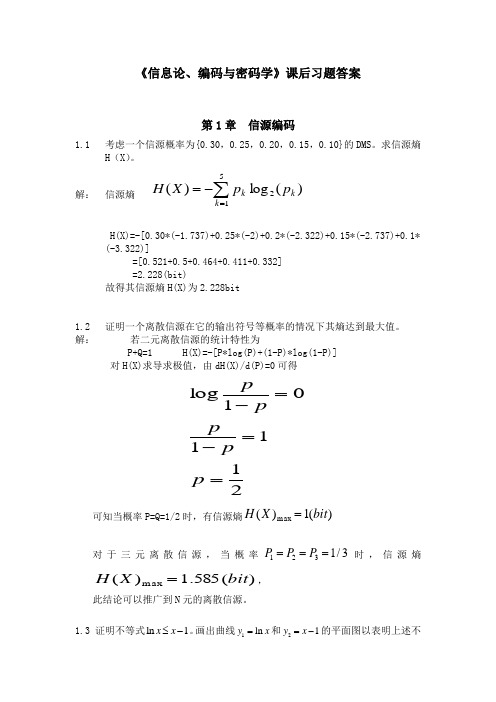

信息论、编码与密码学课后习题答案

第1章 信源编码

1.1考虑一个信源概率为{0.30,0.25,0.20,0.15,0.10}的DMS。求信源熵H(X)。

解: 信源熵

H(X)=-[0.30*(-1.737)+0.25*(-2)+0.2*(-2.322)+0.15*(-2.737)+0.1*(-3.322)]

10100+11110=01010 10100+00111=10011

10100+01101=11001

11110+00111=11001 11110+01101=10011

00111+01101=01010

满足第一条性质

2、全零码字总是一个码字

{00000,01010,10011,11001,10100,11110,00111,01101}

(1)给出此信源的霍夫曼码并确定编码效率。

(2)每次考虑两个符号时,给出此信源的霍夫曼码并确定编码效率。

(3)每次考虑三个符号时,给出此信பைடு நூலகம்的霍夫曼码并确定编码效率。

解:

(1)本题的霍夫曼编码如下图所示:

图1.11 霍夫曼编码

则霍夫曼码如下表:

符号

概率

码字

x1

0.5

1

x2

0.4

00

x3

0.1

01

该信源的熵为:

(2)全零字总是一个码字,

(3)两个码字之间的最小距离等于任何非零码字的最小重量,即

设 ,即 , , , ,

首先证明条件(1):

, , , , , ,

很明显,条件(1)是满足的。条件(2)也是显然成立的。

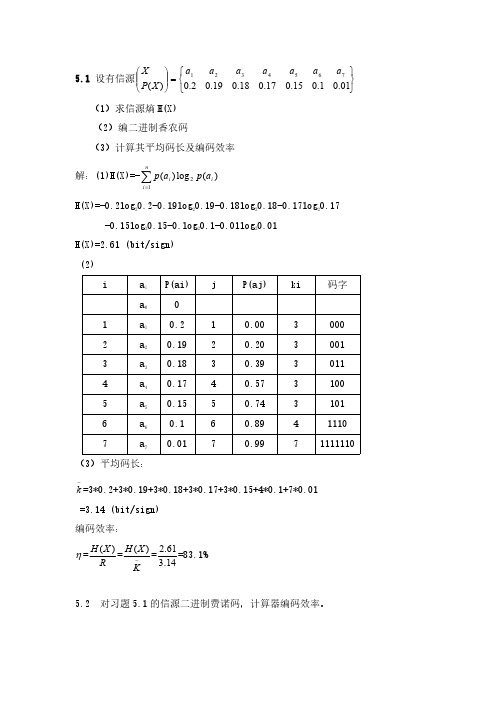

信息论基础第五章课后答案

5.1设有信源⎭⎬⎫⎩⎨⎧=⎪⎪⎭⎫ ⎝⎛01.01.015.017.018.019.02.0)(7654321a a a a a a a X P X (1)求信源熵H(X)(2)编二进制香农码(3)计算其平均码长及编码效率解:(1)H(X)=-)(log )(21i ni i a p a p ∑=H(X)=-0.2log 20.2-0.19log 20.19-0.18log 20.18-0.17log 20.17-0.15log 20.15-0.log 20.1-0.01log 20.01H(X)=2.61(bit/sign)(2)ia i P(ai)jP(aj)ki码字a 001a 10.210.0030002a 20.1920.2030013a 30.1830.3930114a 40.1740.5731005a 50.1550.7431016a 60.160.89411107a 70.0170.9971111110(3)平均码长:-k =3*0.2+3*0.19+3*0.18+3*0.17+3*0.15+4*0.1+7*0.01=3.14(bit/sign)编码效率:η=R X H )(=-KX H )(=14.361.2=83.1%5.2对习题5.1的信源二进制费诺码,计算器编码效率。

⎭⎬⎫⎩⎨⎧=⎪⎪⎭⎫ ⎝⎛0.01 0.1 0.15 0.17 0.18 0.19 2.0 )(7654321a a a a a a a X P X 解:Xi)(i X P 编码码字ik 1X 0.2000022X 0.191001033X 0.18101134X 0.17101025X 0.151011036X 0.110111047X 0.01111114%2.9574.2609.2)()(74.2 01.0.041.0415.0317.0218.0319.032.02 )(/bit 609.2)(1.5=====⨯+⨯+⨯+⨯+⨯+⨯+⨯===∑KX H R X H X p k K sign X H ii i η已知由5.3、对信源⎭⎬⎫⎩⎨⎧=⎪⎪⎭⎫ ⎝⎛01.01.015.017.018.019.02.0)(7654321x x x x x x x X P X 编二进制和三进制赫夫曼码,计算各自的平均码长和编码效率。

信息论与编码第二章答案

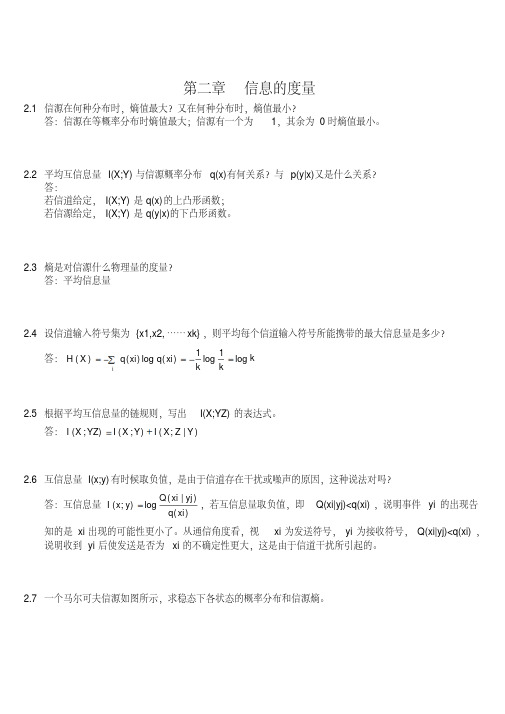

第二章信息的度量2.1信源在何种分布时,熵值最大?又在何种分布时,熵值最小?答:信源在等概率分布时熵值最大;信源有一个为1,其余为0时熵值最小。

2.2平均互信息量I(X;Y)与信源概率分布q(x)有何关系?与p(y|x)又是什么关系?答:若信道给定,I(X;Y)是q(x)的上凸形函数;若信源给定,I(X;Y)是q(y|x)的下凸形函数。

2.3熵是对信源什么物理量的度量?答:平均信息量2.4设信道输入符号集为{x1,x2,……xk},则平均每个信道输入符号所能携带的最大信息量是多少?答:kk k xi q xi q X H i log 1log 1)(log )()(2.5根据平均互信息量的链规则,写出I(X;YZ)的表达式。

答:)|;();();(Y Z X I Y X I YZ X I 2.6互信息量I(x;y)有时候取负值,是由于信道存在干扰或噪声的原因,这种说法对吗?答:互信息量)()|(log );(xi q yj xi Q y x I ,若互信息量取负值,即Q(xi|yj)<q(xi),说明事件yi 的出现告知的是xi 出现的可能性更小了。

从通信角度看,视xi 为发送符号,yi 为接收符号,Q(xi|yj)<q(xi),说明收到yi 后使发送是否为xi 的不确定性更大,这是由于信道干扰所引起的。

2.7一个马尔可夫信源如图所示,求稳态下各状态的概率分布和信源熵。

答:由图示可知:43)|(41)|(32)|(31)|(41)|(43)|(222111110201s x p s x p s x p s x p s x p s x p 即:43)|(0)|(41)|(31)|(32)|(0)|(0)|(41)|(43)|(222120121110020100s s p s s p s s p s s p s s p s s p s s p s s p s s p 可得:1)()()()(43)(31)()(31)(41)()(41)(43)(210212101200s p s p s p s p s p s p s p s p s p s p s p s p得:114)(113)(114)(210s p s p s p )]|(log )|()|(log )|()[()]|(log )|()|(log )|()[()]|(log )|()|(log )|()[(222220202121211111010100000s s p s s p s s p s s p s p s s p s s p s s p s s p s p s s p s s p s s p s s p s p H 0.25(bit/符号)2.8一个马尔可夫信源,已知:0)2|2(,1)2|1(,31)1|2(,32)1|1(x x p x x p x x p x x p 试画出它的香农线图,并求出信源熵。

信源熵例题

物理与信息工程学院 郭里婷

10

2019/2/7

例2:随机变量X表示人的性别,X=0表示男性,X=1表示女性;随即变量Y表 示是否抽烟,Y=0表示抽烟,Y=1表示不抽烟。(X,Y)的联合分布分别如下3 种情况时,求抽到的是男性给抽烟这个事件提供多大的信息量。

物理与信息工程学院 郭里婷

11

2019/2/7

物理与信息工程学院 郭里婷

12

2019/2/7

例3:设信源发出8种消息(符号),各消息等概发送,各符号分别用3位二进 码元表示,并输出消息(事件),设8个消息按自然二进制进行编码,见 p23表2-3。通过对输出码元序列的观察来推测信源的输出。假设信源发出 的消息x4,用二进码011表示, 求依次接收0,01,011后,得到的关于x4 的信息量。

X x1 (红), x2 (白) P 0.8, 0.2

物理与信息工程学院 郭里婷

2

2019/2/7

单符号无记忆连续信源 例2:一节5V的干电池,测电压。电压可以看成单符号无记 忆连续信源。消息数无限多.

物理与信息工程学院 郭里婷

3

2019/2/7

信息论与编码

第二章 信源熵 例题

福州大学物理与信息工程学院 郭里婷

物理与信息工程学院 郭里婷

1

2019/2/7

第二章 第一节例题

单符号无记忆离散信源 例1:一个布袋中有100个球,其中80个红色,20个白色。随 机摸取一个球,看颜色。球的颜色可以看成单符号无记忆离 散信源。消息数量为2,红白消息的概率分别为0.8和0.2。

X x1 x1 , x1 x2 , x2 x1 , x2 x2 P 0.64, 0.16, 0.16, 0.04

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

第二章:试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍解:四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3}八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则:四进制脉冲的平均信息量H(X 1) = log 2n = log 24 = 2 bit/symbol 八进制脉冲的平均信息量H(X 2) = log 2n = log 28 = 3 bit/symbol 二进制脉冲的平均信息量H(X 0) = log 2n = log 22 = 1 bit/symbol 《所以:四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。

居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,而女孩子中身高160厘米以上的占总数的一半。

假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量解:设随机变量X 代表女孩子学历X x 1(是大学生)x 2(不是大学生)P(X)(设随机变量Y 代表女孩子身高Y y 1(身高>160cm ) y 2(身高<160cm )P(Y)"已知:在女大学生中有75%是身高160厘米以上的 即:p(y 1/ x 1) =求:身高160厘米以上的某女孩是大学生的信息量即:bit y p x y p x p y x p y x I 415.15.075.025.0log )()/()(log )/(log )/(2111121111=⎪⎭⎫⎝⎛⨯-=⎥⎦⎤⎢⎣⎡-=-=一副充分洗乱了的牌(含52张牌),试问(1) 任一特定排列所给出的信息量是多少(2) 若从中抽取13张牌,所给出的点数都不相同能得到多少信息量》解:(1) 52张牌共有52!种排列方式,假设每种排列方式出现是等概率的则所给出的信息量是:bit x p x I i i 581.225!52log )(log )(2==-=(2) 52张牌共有4种花色、13种点数,抽取13张点数不同的牌的概率如下:bit C x p x I C x p i i i 208.134log )(log )(4)(13521322135213=-=-==设离散无记忆信源⎭⎬⎫⎩⎨⎧=====⎥⎦⎤⎢⎣⎡8/14/1324/18/310)(4321x x x x X P X ,其发出的信息为(202032),求 (1) 此消息的自信息量是多少(2) 此消息中平均每符号携带的信息量是多少解: ~(1) 此消息总共有14个0、13个1、12个2、6个3,因此此消息发出的概率是:62514814183⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=p此消息的信息量是:bit p I 811.87log 2=-=(2) 此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/==从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为%,如果你问一位男士:“你是否是色盲”他的回答可能是“是”,可能是“否”,问这两个回答中各含多少信息量,平均每个回答中含有多少信息量如果问一位女士,则答案中含有的平均自信息量是多少解: 男士:symbolbit x p x p X H bitx p x I x p bit x p x I x p i i i N N N Y Y Y / 366.0)93.0log 93.007.0log 07.0()(log )()( 105.093.0log )(log )(%93)( 837.307.0log )(log )(%7)(22222222=+-=-==-=-===-=-==∑女士: @symbol bit x p x p X H ii i / 045.0)995.0log 995.0005.0log 005.0()(log )()(2222=+-=-=∑设信源⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡17.016.017.018.019.02.0)(654321x x x x x x X P X ,求这个信源的熵,并解释为什么H(X) > log6不满足信源熵的极值性。

解:585.26log )(/ 657.2)17.0log 17.016.0log 16.017.0log 17.018.0log 18.019.0log 19.02.0log 2.0()(log )()(222222262=>=+++++-=-=∑X H symbol bit x p x p X H ii i 不满足极值性的原因是107.1)(6>=∑iix p 。

证明:H(X 3/X 1X 2) ≤ H(X 3/X 1),并说明当X 1, X 2, X 3是马氏链时等式成立。

证明:log 1)/()(log )()/()(log 1)/()/()()/()/(log)()/(log )()/(log )()/(log )()/(log )()/()/(2123132121233211231321123221313321123213133211231332112321332113133112321332113213=⎪⎪⎭⎫ ⎝⎛-⎥⎦⎤⎢⎣⎡=⎪⎭⎫⎝⎛-=⎪⎪⎭⎫⎝⎛-≤=+-=+-=-∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑∑ex x p x x p ex x x p x x p x x p e x x x p x x p x x x p x x x p x x p x x x p x x p x x x p x x x p x x x p x x p x x p x x x p x x x p X X H X X X H i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i】氏链是马等式成立的条件是时等式成立当_,,)/()/()/()()/()/()()()/()/()()/()/(01)/()/()/()/(321132131232113121212131321213132131313213X X X x x x p x x p x x p x x x p x x p x x p x p x x p x x x p x x p x x p x x x p x x p x x x p x x p X X H X X X H i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i i ∴=⇒=⇒=⇒=⇒=-≤∴证明:H(X 1X 2 。

X n ) ≤ H(X 1) + H(X 2) + … + H(X n )。

证明:)(...)()()()...().../()(0)...;(...)/()(0);()/()(0);().../(...)/()/()()...(3212112112121332131221212121312121N N N N N N N N N N X H X H X H X H X X X H X X X X H X H X X X X I X X X H X H X X X I X X H X H X X I X X X X H X X X H X X H X H X X X H ++++≤∴≥⇒≥≥⇒≥≥⇒≥++++=---设有一个信源,它产生0,1序列的信息。

它在任意时间而且不论以前发生过什么符号,均按P(0) = ,P(1) = 的概率发出符号。

(1) 试问这个信源是否是平稳的 (2) 试计算H(X 2), H(X 3/X 1X 2)及H ∞;(3) 试计算H(X 4)并写出X 4信源中可能有的所有符号。

;解: (1)这个信源是平稳无记忆信源。

因为有这些词语:“它在任意时间....而且不论以前发生过什么符号...........……” (2)symbolbit X H H symbol bit x p x p X H X X X H symbolbit X H X H ii i / 971.0)(/ 971.0)6.0log 6.04.0log 4.0()(log )()()/(/ 942.1)6.0log 6.04.0log 4.0(2)(2)(2223213222===+-=-===+⨯-==∞∑(3)1011111111101101110010101001100001110110010101000011001000010000的所有符号:/ 884.3)6.0log 6.04.0log 4.0(4)(4)(4224X symbol bit X H X H =+⨯-==一阶马尔可夫信源的状态图如下图所示。

信源X 的符号集为{0, 1, 2}。

(1) 求平稳后信源的概率分布; 。

(2) 求信源的熵H ∞。

PP解: (1)⎪⎩⎪⎨⎧===⎩⎨⎧=++==⎪⎪⎩⎪⎪⎨⎧⋅+⋅=⋅+⋅=⋅+⋅=⎪⎩⎪⎨⎧+=+=+=3/1)(3/1)(3/1)(1)()()()()()()()()()()()()()()()/()()/()()()/()()/()()()/()()/()()(321321321133322211131333332322222121111e p e p e p e p e p e p e p e p e p e p p e p p e p e p p e p p e p e p p e p p e p e e p e p e e p e p e p e e p e p e e p e p e p e e p e p e e p e p e p⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡⎪⎪⎩⎪⎪⎨⎧=+=⋅+⋅=+==+=⋅+⋅=+==+=⋅+⋅=+=3/123/113/10)(3/13/)()()()/()()/()()(3/13/)()()()/()()/()()(3/13/)()()()/()()/()()(131313333323232222212121111X P X p p e p p e p p e x p e p e x p e p x p p p e p p e p p e x p e p e x p e p x p p p e p p e p p e x p e p e x p e p x p (2)()symbolbit p p p p p p p p p p p p p p p p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e e p e p H iji j i j i / log log log 31log 31log 31log 31log 31log 31)/(log )/(31)/(log )/(31)/(log )/(31)/(log )/(31)/(log )/(31)/(log )/(31)/(log )/(31)/(log )/(31)/(log )/(31)/(log )/()(2222222233233322323123123223222222122113213122121121133⋅+⋅-=⎥⎦⎤⎢⎣⎡⋅⋅+⋅⋅+⋅⋅+⋅⋅+⋅+⋅⋅-=⎥⎦⎤++++++⎢⎣⎡++-=-=∑∑∞黑白气象传真图的消息只有黑色和白色两种,即信源X ={黑,白}。