通信原理第4章信息熵例题

通信原理例题

Xcos t Y sin t E EX cos t EY sin t

2

- EXY sin20 t

0

2

0

E X 0

2 E X2 E X 2 E 2 X X 2 2 同理 E Y 2 Y 2

a 2

1

n0 1 2 1 RC 2

n0 R 0 R 4 RC 2 RCx 2 x2 1 2 RC f x exp 2 exp n0 n0 2 2

2

例4-1 如图所示的BSC信道,设信源发送符号概率为P x1 0.25, P x2 0.75;信道转移概率为P y1 / x1 P y2 / x2 0.9, P y2 / x1 P y1 / x2 0.1, 试求:

例3-2一个均值为a,自相关函数为R X τ 的平稳随机过程X t 通过一个线性系统后的输出过程为Y t =X t +X t-T T为延迟时间:

(1)试画出该线性系统的框图;

(2)试求Y t 的自相关函数和功率谱密度。

解:(1)

X(t) + T Y(t)

i

例4 2设两恒参信道等效模型如图所示,试求它们的 幅频特性和群迟延特性,并分析信号S t 通过这两个 信道时有无群迟延失真。

R1 R

R2

C

(a)

(b)

R2 解: a H ω = R1 +R 2 1 b H ω jωRC+1

φ ω 0 τ ω =0 没有任何失真 H ω

第 3章

随机过程

通信原理各章重要知识常考知识总结通信原理习题及详细答案(第六版)

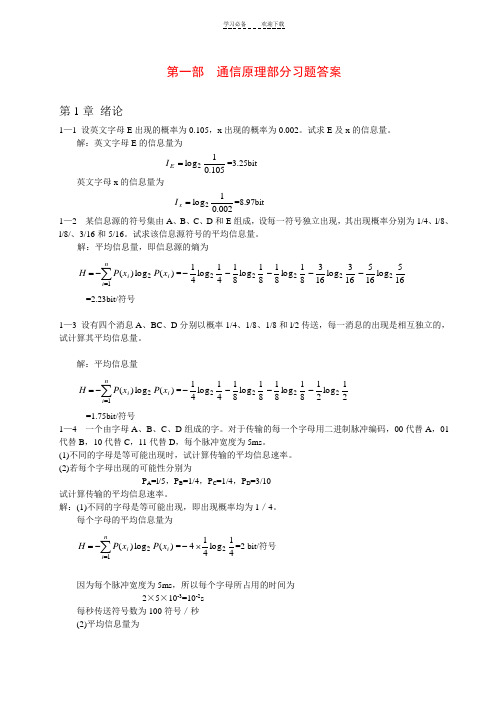

第一部 通信原理部分习题答案第1章 绪论1—1 设英文字母E 出现的概率为0.105,x 出现的概率为0.002。

试求E 及x 的信息量。

解:英文字母E 的信息量为105.01log 2=E I =3.25bit 英文字母x 的信息量为002.01log 2=x I =8.97bit 1—2 某信息源的符号集由A 、B 、C 、D 和E 组成,设每一符号独立出现,其出现概率分别为1/4、l/8、l/8/、3/16和5/16。

试求该信息源符号的平均信息量。

解:平均信息量,即信息源的熵为∑=-=ni i i x P x P H 12)(log )(=41log 412-81log 812-81log 812-163log 1632-165log 1652- =2.23bit/符号1—3 设有四个消息A 、BC 、D 分别以概率1/4、1/8、1/8和l/2传送,每一消息的出现是相互独立的,试计算其平均信息量。

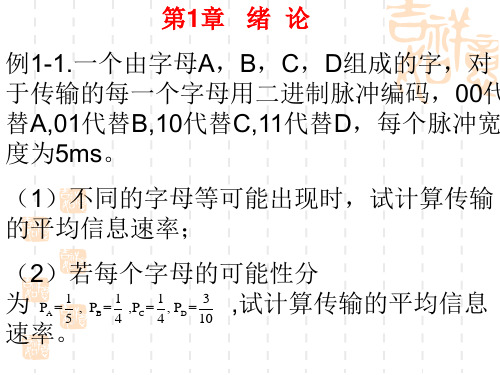

解:平均信息量∑=-=ni i i x P x P H 12)(log )(=41log 412-81log 812-81log 812-21log 212- =1.75bit/符号1—4 一个由字母A 、B 、C 、D 组成的字。

对于传输的每一个字母用二进制脉冲编码,00代替A ,01代替B ,10代替C ,11代替D ,每个脉冲宽度为5ms 。

(1)不同的字母是等可能出现时,试计算传输的平均信息速率。

(2)若每个字母出现的可能性分别为P A =l/5,P B =1/4,P C =1/4,P D =3/10 试计算传输的平均信息速率。

解:(1)不同的字母是等可能出现,即出现概率均为1/4。

每个字母的平均信息量为∑=-=ni i i x P x P H 12)(log )(=41log 4142⨯-=2 bit/符号因为每个脉冲宽度为5ms ,所以每个字母所占用的时间为 2×5×10-3=10-2s每秒传送符号数为100符号/秒 (2)平均信息量为∑=-=ni i i x P x P H 12)(log )(=51log 512-41log 412-41log 412-103log 1032-=1.985 bit/符号 平均信息速率为 198.5 比特/秒1—5 国际莫尔斯电码用点和划的序列发送英文字母,划用持续3单位的电流脉冲表示,点用持续1个单位的电流脉冲表示;且划出现的概率是点出现概率的l/3; (1)计算点和划的信息量; (2)计算点和划的平均信息量。

通信原理习题总结

平均信息量 / 符号=H(x) – H(x / y) = 1 – 0.045 = 0.955 (比特 / 符号) 因传输错误每个符号损失的信息量为 H(x / y) = 0.045(比特/ 符号)

信道的容量C等于: C max [ H ( x) H ( x / y )] 0.955

P( x)

4

第4章 信 道

H ( x / y) P( x1 / y1 ) log2 P( x1 / y1 ) P( x2 / y1 ) log2 P( x2 / y1 ) (127/ 128) log2 (127/ 128) (1 / 128) log2 (1 / 128) (127/ 128) 0.01 (1 / 128) (7) 0.01 0.055 0.045

j 1 i 1 m n

P( y 2 )P( x1 / y 2 ) log2 P( x1 / y 2 ) P( x 2 / y 2 ) log2 P( x 2 / y 2 )}

现在P(x1 / y1) = P(x2 / y2) = 127/128,

P(x1 / y2) = P(x2 / y1) = 1/128, 并且考虑到P(y1) +P(y2) = 1,所以上式可以改写为

(4.6-19)

(4.6-20)

6

0

接 收 端

发 送 P(0/1) = 1/128 P(1/0) = 1/128 端 P(1/1) = 127/128

1

1

图4-23 对称信道模型

3

第4章 信 道

此信源的平均信息量(熵)等于:

1 1 1 H ( x) P( xi ) log2 P( xi ) log2 log2 2 2 2 i 1

通信原理各章重要知识

第一部 各章重要习题及详细解答过程第1章 绪论1—1 设英文字母E 出现的概率为0.105,x 出现的概率为0.002。

试求E 及x 的信息量。

解:英文字母E 的信息量为105.01log 2=E I =3.25bit 英文字母x 的信息量为002.01log 2=x I =8.97bit 1—2 某信息源的符号集由A 、B 、C 、D 和E 组成,设每一符号独立出现,其出现概率分别为1/4、l/8、l/8/、3/16和5/16。

试求该信息源符号的平均信息量。

解:平均信息量,即信息源的熵为∑=-=ni i i x P x P H 12)(log )(=41log 412-81log 812-81log 812-163log 1632-165log 1652- =2.23bit/符号1—3 设有四个消息A 、BC 、D 分别以概率1/4、1/8、1/8和l/2传送,每一消息的出现是相互独立的,试计算其平均信息量。

解:平均信息量∑=-=ni i i x P x P H 12)(log )(=41log 412-81log 812-81log 812-21log 212-=1.75bit/符号1—4 一个由字母A 、B 、C 、D 组成的字。

对于传输的每一个字母用二进制脉冲编码,00代替A ,01代替B ,10代替C ,11代替D ,每个脉冲宽度为5ms 。

(1)不同的字母是等可能出现时,试计算传输的平均信息速率。

(2)若每个字母出现的可能性分别为P A =l/5,P B =1/4,P C =1/4,P D =3/10 试计算传输的平均信息速率。

解:(1)不同的字母是等可能出现,即出现概率均为1/4。

每个字母的平均信息量为∑=-=ni i i x P x P H 12)(log )(=41log 4142⨯-=2 bit/符号因为每个脉冲宽度为5ms ,所以每个字母所占用的时间为 2×5×10-3=10-2s每秒传送符号数为100符号/秒 (2)平均信息量为∑=-=ni i i x P x P H 12)(log )(=51log 512-41log 412-41log 412-103log 1032-=1.985 bit/符号平均信息速率为 198.5 比特/秒1—5 国际莫尔斯电码用点和划的序列发送英文字母,划用持续3单位的电流脉冲表示,点用持续1个单位的电流脉冲表示;且划出现的概率是点出现概率的l/3;(1)计算点和划的信息量;(2)计算点和划的平均信息量。

通信原理 第1-9 11章 习题 测试题 1-15 答案 ok

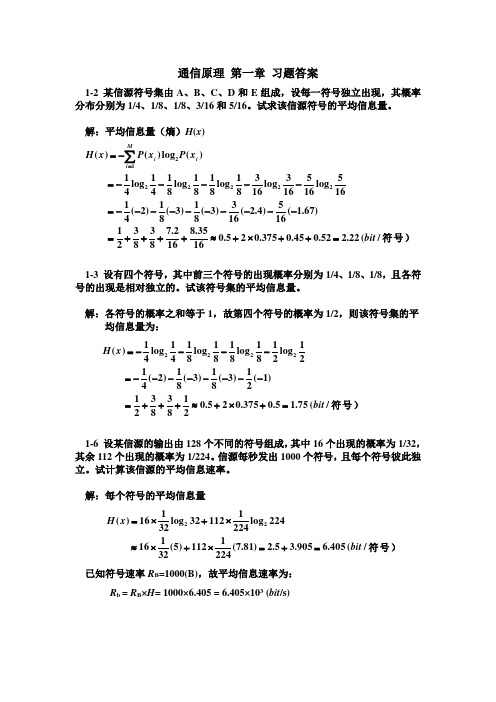

1-2 某信源符号集由A 、B 、C 、D 和E 组成,设每一符号独立出现,其概率分布分别为1/4、1/8、1/8、3/16和5/16。

试求该信源符号的平均信息量。

解:平均信息量(熵)H (x )符号)/(22.252.045.0375.025.01635.8162.7838321)67.1(165)4.2(163)3(81)3(81)2(41165log 165163log 16381log 8181log 8141log 41)(log )()(2222212bit x P x P x H i Mi i =++⨯+≈++++=----------=-----=-=∑=1-3 设有四个符号,其中前三个符号的出现概率分别为1/4、1/8、1/8,且各符号的出现是相对独立的。

试该符号集的平均信息量。

解:各符号的概率之和等于1,故第四个符号的概率为1/2,则该符号集的平均信息量为:符号)/(75.15.0375.025.021838321)1(21)3(81)3(81)2(4121log 2181log 8181log 8141log 41)(2222bit x H =+⨯+≈+++=--------=----=1-6 设某信源的输出由128个不同的符号组成,其中16个出现的概率为1/32,其余112个出现的概率为1/224。

信源每秒发出1000个符号,且每个符号彼此独立。

试计算该信源的平均信息速率。

解:每个符号的平均信息量符号)/(405.6905.35.2)81.7(2241112)5(32116224log 224111232log 32116)(22bit x H =+=⨯+⨯≈⨯+⨯=已知符号速率R B =1000(B),故平均信息速率为: R b = R B ×H = 1000×6.405 = 6.405×103 (bit /s)2-6 设信号s (t )的傅里叶变换S ( f ) = sin πf /πf ,试求此信号的自相关函数R s (τ)。

通信原理复习资料和练习题(完整版)

通信原理复习题第一章 绪论 重要概念:1、通信的目的:就是传递消息。

2、通信的定义:利用电子等技术手段,借助电信号(含光信号)实现从一地向另一地进行消息的有效传递称为通信。

3、通信系统模型:信源:原始信号的来源,其作用是将消息转换成相应的电信号。

发送设备:对原始电信号(基带信号)进行各种处理和变换,使它变成适合于信道中传输的形式。

信道:是指传输信号的物理媒质。

接收设备:任务是从带有干扰的接收信号中恢复出相应的原始电信号。

信宿:将复原的原始电信号转换成相应的消息。

4、模拟信号:信号参量的取值是连续的或无穷多个值,且直接与消息相对应的信号,例如语音信号。

数字信号:信号参量只能取有限个值,并常常不直接与消息向对应的信号。

它们都有可能是连续信号或离散信号。

5、通信系统的分类 按调制方式分类:基带传输系统和带通(调制)传输系统 按信号特征分类:模拟通信系统和数字通信系统按传输媒介分类:有线通信系统和无线通信系统6、通信方式:按传输方向:单工、半双工和全双工通信 按码元排列方式:并行传输和串行传输 7、信息与消息:消息:通信系统中传送的对象。

信息:消息中包含的抽象的、本质的内容。

消息所表达的事件越不可能发生,信息量就越大。

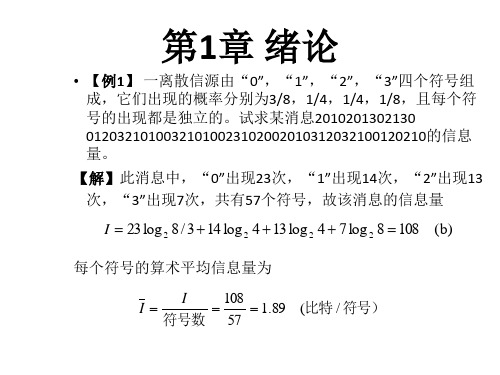

8、信息量计算公式:)(log )(1log x p x p I a a-==平均信息量(信息熵)的计算公式:典型例题:例:设有四个信息A 、B 、C 、D 分别以概率1/4、1/8、1/8、1/2传送,每个消息出现是相互独立的,其平均住处量H=___________。

通信系统的评价:有效性和可靠性。

模拟系统的评价:有效带宽和信噪比;数字系统的评价:传输速率(传信率、传码率)和频带利用率。

)(2log 2log }{)(1111b p p I p I E x H mi p i mi p i mi i i i i∑∑∑===-====例:某数据通信系统调制速率为1200 Bd ,采用8电平传输,假设100秒误了1个比特,①求误码率。

通信原理课后练习答案

1/ 2

Rz ( )

1

1 / 2

⑶ 试求功率谱密度 Pz ( f ) 及功率S。

平稳随机过程的功率谱密度是其自相关函数的傅里 1 叶变换,即 Pz ( f ) Rm ( ) cos c t

2 1 1 Pz ( f ) Pm ( f ) * ( f f c ) ( f f c ) 2 2

j 2 fT 2 2

H ( f ) 2(1 cos 2 fT )

n0 输入噪声的功率谱密度: Pn ( f ) , 2

f 第3章课后作业解答

3-8 一个中心频率为fc、带宽为B的理想带通滤波器如 下图所示。假设输入是 均值为零、功率谱密度 为n0/2 的高斯白噪声,试求:

H( f )

B B

0

fc

fc

f

⑴ 滤波器输出噪声的自相关函数;

⑵ 滤波器输出噪声的平均功率;

⑶ 输出噪声的一维概率密度函数。

第3章课后作业解答

⑴ 滤波器输出噪声的自相关函数;

可以很容易得到滤波器输出噪声的功率谱密度:

ì n0 B ï ï fc - # f Pn ( f ) = ï 2 í 2 ï ï ï î 0 其他 B fc + 2

第3章课后作业解答

P Y ( f ) RY ( )

j 2 fT j 2 fT P ( f ) 2 P ( f ) P ( f ) e P ( f ) e Y X X X

2(1 cos 2 fT ) PX ( f )

或者:

PY ( f ) PX ( f ) H ( f ) H( f ) 1 e

1-10 已知某四进制数字传输系统的传信率为2400b/s, 接收端在 0.5h 内共收到 216 个错误码元,试计算该系 统的误码率 Pe。

数字通信原理例题

6、设四进制数字传输系统的每个码元的持续时间为 833×10-6s,连续工作1h后,接收端收到6个错码,且错 误码元中发生1bit的错误。 1)求该系统的码元速率和信息速率 2)求该系统的误码率和误信率

7、黑白电视机的图象每秒传输25帧,每帧有625行;屏 幕的宽度与高度之比为4:3。设图象的每个像素的亮度 有10个电平,各像素的亮度相互独立,且等概出现,求 电视图像给观众的平均信息速率。

4、设A系统以2000b/s的比特率传输2PSK调制信号的带 宽为2000Hz,B系统以2000b/s的比特率传输4PSK调制 信号的带宽为1000传输系统传送二进制码元的速率为1200B, 试求该系统的信息速率;若该系统改为传送八进制信号 码元,则这时系统的信息速率是?

1若01等概出现求每个符号的信息量和平均信息量熵2若0出现概率为13求每个符号的信息量和平均信息量熵2设有一个四进制离散信源0123独立等概发送求传送每一符号的信息量

1、设有一个二进制离散信源(0,1),每个符号独立发送。 (1)若“0”、“1”等概出现,求每个符号的信息量和平 均信息量(熵) (2)若“0”出现概率为1/3,求每个符号的信息量和平均 信息量(熵)

2、设有一个四进制离散信源(0,1,2,3),独立 等概发送,求传送每一符号的信息量。

3、已知某四进制离散信源(0,1,2,3)中各符号 出现的概率分别为3/8,1/4,1/4, 1/8,且每个符号的出 现都是独立的,试求: (1)信源的平均信息量(熵); (2)信源发送200101020130201030012…消息的信息 量。其中,0出现38次,1出现25次,2出现24 次,3出现13次,共有100个符号。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

(5)接收到信息 Y 后获得的平均互信息为: I ( X ; Y ) = H ( X ) − H ( X | Y ) = 0.0075 比特/符号

I ( x1 ; y 2 ) = log

I ( x 2 ; y 2 ) = log

(3)信源 X 以及 Y 的熵为: H ( X ) = − ∑ P( x) log P( x) = −0.6 log 0.6 − 0.4 log 0.4 = 0.971 比特/符号

X

H (Y ) = −∑ P( y ) log P( y ) = −0.8 log 0.8 − 0.2 log 0.2 = 0.722 比特/符号

【3.1】 设信源 X x1 x 2 P( x) = 0.6 0.4 通过一干扰信道,接收符号为 Y = [ y1 , y 2 ] ,信道传递概率如下图所示,求 (1)信源 X 中事件 x1 和 x 2 分别含有的自信息; (2) 收到消息 y j ( j = 1,2) 后,获得的关于 xi (i = 1,2) 的信 息量; (3)信源 X 和信源 Y 的信息熵; (4)信道疑义度 H ( X | Y ) (5)接收到消息 Y 后获得的平均互信息。 解: (1)信源 X 中事件 x1 和 x 2 分别含有的自信息分别为: I ( x1 ) = log 1 = − log 0.6 = 0.737 比特 P( x1 ) 1 = − log 0.4 = 1.32 比特 P( x2 ) 3/4 x2 1/4 y2 x1 5/6 1/6 y1

I ( x 2 ; y1 ) = log

P( y1 | x2 ) 3/ 4 15 = log = log = −0.093 比特 P( y1 ) 0.8 16 P( y 2 | x1 ) 1/ 6 5 = log = log = −0.263 比特 P( y 2 ) 0.2 6 P( y 2 | x2 ) 1/ 4 5 = log = log = 0.322 比特 P( y 2 ) 0.2 4

Y

(4)信道疑义度 H ( X | Y ) =og P( x | y )

X Y

而相关条件概率 P( x | y ) 计算如下: P( x1 | y1 ) = P( x 2 | y1 ) = P( x1 | y 2 ) = P( x 2 | y 2 ) = 由此计算出信道疑义度为: 5 1 1 3 1 1 3 5 H ( X | Y ) = −0.6 log + log − 0.4 log + log = 0.9635 比特/符号 8 6 2 8 4 2 6 4 P( x1 , y1 ) P( y1 | x1 ) P( x1 ) 0.5 5 = = = 0.8 8 P( y1 ) P( y1 ) 3 8 P( x1 , y 2 ) P( y 2 | x1 ) P( x1 ) 0.6 / 6 1 = = = 0.2 2 P( y2 ) P( y 2 ) 1 2

I ( x 2 ) = log

(2)根据给定的信道以及输入概率分布,可得 P( y1 ) = ∑ P( xi ) P( y1 | x i ) = 0.8

X

P( y 2 ) = ∑ P( xi ) P( y 2 | xi ) = 0.2

X

所求的互信息量分别为: I ( x1 ; y1 ) = log P( y 1 | x1 ) 5/6 25 = log = log = 0.059 比特 P( y1 ) 0.8 24