数据挖掘实验报告 Weka的数据聚类分析

WEKA聚类算法wine数据集分析研究报告

WEKA聚类算法wine数据集分析研究报告一、引言WEKA是一款强大的机器学习软件,它提供了多种聚类算法,包括K-Means、SimpleKMeans、BIRCH等。

这些算法可以用来解决各种不同的聚类问题。

在本文中,我们将使用WEKA的聚类算法对wine数据集进行分析和研究。

二、数据集介绍wine数据集是一个非常知名的数据集,它包含了178个样本和13个特征。

这些特征包括醇类、酸度、PH值等,可以用来预测葡萄酒的质量。

这个数据集是一个多类别的数据集,它的类别数是3。

三、WEKA聚类算法介绍WEKA的聚类算法有很多种,其中最常用的是K-Means算法。

K-Means 算法是一种迭代的算法,它将数据集划分为K个簇,每个簇的中心点是该簇所有点的平均值。

这个算法的目标是最小化所有簇内的距离之和。

四、实验过程1、数据预处理:我们对wine数据集进行预处理,包括去除缺失值、标准化数据等。

2、聚类实验:然后,我们使用WEKA的K-Means算法对wine数据集进行聚类实验。

我们设定了不同的K值,进行了多次实验,并记录了每次实验的结果。

3、结果分析:我们分析了实验结果,发现当K=3时,聚类效果最好。

此时,每个簇的样本数分别是60、61和57,非常接近于原始数据集中的类别数。

五、结论通过WEKA聚类算法对wine数据集的分析和研究,我们发现当K=3时,聚类效果最好。

这意味着wine数据集可以被分为三个类别,每个类别对应一种葡萄酒。

这个结果与实际情况相符,说明我们的聚类方法是有效的。

六、展望未来,我们可以进一步研究WEKA的其他聚类算法,如SimpleKMeans、BIRCH等,看看它们是否可以更好地解决wine数据集的聚类问题。

我们也可以研究如何通过调整WEKA的参数来优化聚类效果。

聚类分析算法研究聚类分析是一种无监督学习方法,它在许多领域都有广泛的应用,包括数据挖掘、机器学习、图像处理、生物信息学等。

在本文中,我们将探讨聚类分析的基本概念、常见的聚类算法以及未来的研究方向。

基于weka的数据分类和聚类分析实验报告

基于w e k a的数据分类和聚类分析实验报告文件编码(008-TTIG-UTITD-GKBTT-PUUTI-WYTUI-8256)基于w e k a的数据分类分析实验报告1实验基本内容本实验的基本内容是通过使用weka中的三种常见分类和聚类方法(决策树J48、KNN和k-means)分别在训练数据上训练出分类模型,并使用校验数据对各个模型进行测试和评价,找出各个模型最优的参数值,并对三个模型进行全面评价比较,得到一个最好的分类模型以及该模型所有设置的最优参数。

最后使用这些参数以及训练集和校验集数据一起构造出一个最优分类器,并利用该分类器对测试数据进行预测。

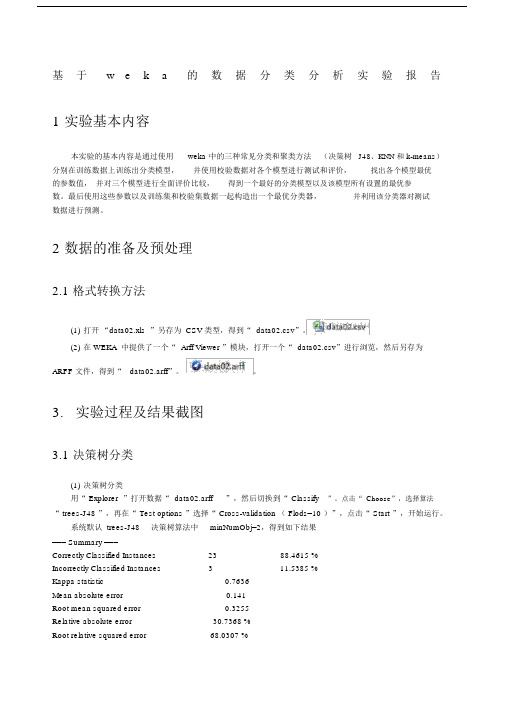

2数据的准备及预处理格式转换方法(1)打开“”另存为CSV类型,得到“”。

(2)在WEKA中提供了一个“Arff Viewer”模块,打开一个“”进行浏览,然后另存为ARFF文件,得到“”。

3. 实验过程及结果截图决策树分类(1)决策树分类用“Explorer”打开数据“”,然后切换到“Classify”。

点击“Choose”,选择算法“trees-J48”,再在“Test options”选择“Cross-validation(Flods=10)”,点击“Start”,开始运行。

系统默认trees-J48决策树算法中minNumObj=2,得到如下结果=== Summary ===Correctly Classified Instances 23 %Incorrectly Classified Instances 3 %Kappa statisticMean absolute errorRoot mean squared errorRelative absolute error %Root relative squared error %Total Number of Instances 26=== Detailed Accuracy By Class ===TP Rate FP Rate Precision Recall F-Measure ROC Area Class0 1 N1 1 YWeighted Avg.=== Confusion Matrix ===a b <-- classified as14 3 | a = N0 9 | b = Y使用不同的参数准确率比较:由上表,可知minNumObj为2时,准确率最高。

基于weka的数据分类和聚类分析实验报告.docx

基于w e k a的数据分类分析实验报告1实验基本内容本实验的基本内容是通过使用weka 中的三种常见分类和聚类方法(决策树J48、KNN 和 k-means)分别在训练数据上训练出分类模型,并使用校验数据对各个模型进行测试和评价,找出各个模型最优的参数值,并对三个模型进行全面评价比较,得到一个最好的分类模型以及该模型所有设置的最优参数。

最后使用这些参数以及训练集和校验集数据一起构造出一个最优分类器,并利用该分类器对测试数据进行预测。

2数据的准备及预处理2.1 格式转换方法(1)打开“data02.xls ”另存为 CSV 类型,得到“ data02.csv”。

(2)在 WEKA 中提供了一个“ Arff Viewer ”模块,打开一个“ data02.csv”进行浏览,然后另存为ARFF 文件,得到“data02.arff”。

3.实验过程及结果截图3.1 决策树分类(1)决策树分类用“ Explorer ”打开数据“ data02.arff”,然后切换到“Classify”。

点击“ Choose”,选择算法“ trees-J48 ”,再在“ Test options ”选择“ Cross-validation ( Flods=10 )”,点击“ Start ”,开始运行。

系统默认 trees-J48决策树算法中minNumObj=2,得到如下结果=== Summary ===Correctly Classified Instances2388.4615 %Incorrectly Classified Instances311.5385 %Kappa statistic0.7636Mean absolute error0.141Root mean squared error0.3255Relative absolute error30.7368 %Root relative squared error68.0307 %Total Number of Instances26=== Detailed Accuracy By Class ===TP Rate FP Rate Precision Recall F-Measure ROC Area Class0.824010.8240.9030.892N10.1760.7510.8570.892Y Weighted Avg.0.8850.0610.9130.8850.8870.892=== Confusion Matrix ===a b<-- classified as14 3 | a = N09 | b = Y使用不同的参数准确率比较:minNumObj2345Correctly23222323 Classified( 88.4615 %)( 84.6154 %)( 88.4615 %)( 88.4615 %)Instances由上表,可知minNumObj为 2 时,准确率最高。

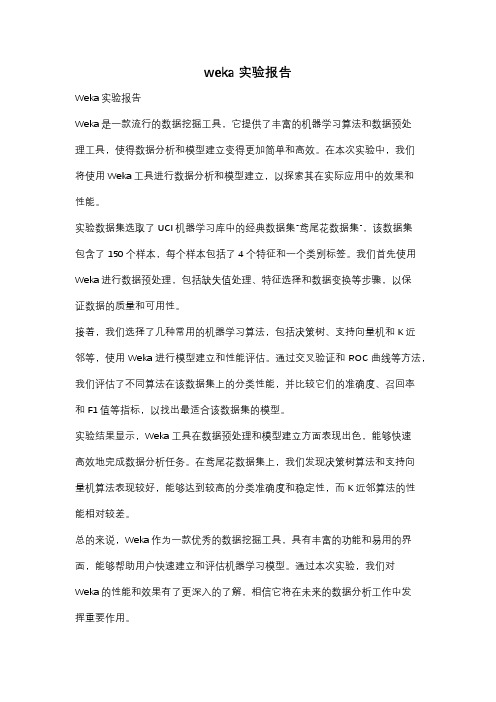

weka实验报告

weka实验报告

Weka实验报告

Weka是一款流行的数据挖掘工具,它提供了丰富的机器学习算法和数据预处

理工具,使得数据分析和模型建立变得更加简单和高效。

在本次实验中,我们

将使用Weka工具进行数据分析和模型建立,以探索其在实际应用中的效果和

性能。

实验数据集选取了UCI机器学习库中的经典数据集“鸢尾花数据集”,该数据集

包含了150个样本,每个样本包括了4个特征和一个类别标签。

我们首先使用Weka进行数据预处理,包括缺失值处理、特征选择和数据变换等步骤,以保

证数据的质量和可用性。

接着,我们选择了几种常用的机器学习算法,包括决策树、支持向量机和K近

邻等,使用Weka进行模型建立和性能评估。

通过交叉验证和ROC曲线等方法,我们评估了不同算法在该数据集上的分类性能,并比较它们的准确度、召回率

和F1值等指标,以找出最适合该数据集的模型。

实验结果显示,Weka工具在数据预处理和模型建立方面表现出色,能够快速

高效地完成数据分析任务。

在鸢尾花数据集上,我们发现决策树算法和支持向

量机算法表现较好,能够达到较高的分类准确度和稳定性,而K近邻算法的性

能相对较差。

总的来说,Weka作为一款优秀的数据挖掘工具,具有丰富的功能和易用的界面,能够帮助用户快速建立和评估机器学习模型。

通过本次实验,我们对

Weka的性能和效果有了更深入的了解,相信它将在未来的数据分析工作中发

挥重要作用。

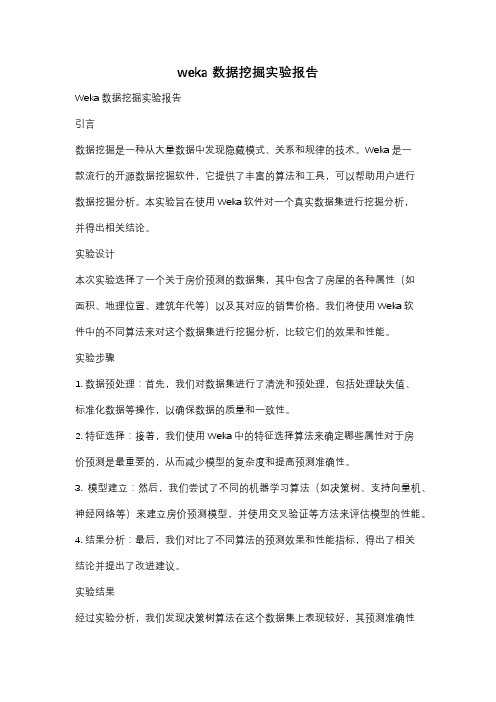

weka 数据挖掘实验报告

weka 数据挖掘实验报告Weka 数据挖掘实验报告引言数据挖掘是一种从大量数据中发现隐藏模式、关系和规律的技术。

Weka 是一款流行的开源数据挖掘软件,它提供了丰富的算法和工具,可以帮助用户进行数据挖掘分析。

本实验旨在使用Weka软件对一个真实数据集进行挖掘分析,并得出相关结论。

实验设计本次实验选择了一个关于房价预测的数据集,其中包含了房屋的各种属性(如面积、地理位置、建筑年代等)以及其对应的销售价格。

我们将使用Weka软件中的不同算法来对这个数据集进行挖掘分析,比较它们的效果和性能。

实验步骤1. 数据预处理:首先,我们对数据集进行了清洗和预处理,包括处理缺失值、标准化数据等操作,以确保数据的质量和一致性。

2. 特征选择:接着,我们使用Weka中的特征选择算法来确定哪些属性对于房价预测是最重要的,从而减少模型的复杂度和提高预测准确性。

3. 模型建立:然后,我们尝试了不同的机器学习算法(如决策树、支持向量机、神经网络等)来建立房价预测模型,并使用交叉验证等方法来评估模型的性能。

4. 结果分析:最后,我们对比了不同算法的预测效果和性能指标,得出了相关结论并提出了改进建议。

实验结果经过实验分析,我们发现决策树算法在这个数据集上表现较好,其预测准确性和泛化能力都较高。

而支持向量机和神经网络算法虽然在训练集上表现良好,但在测试集上的表现并不理想。

此外,特征选择对于模型的性能和复杂度也有着重要的影响。

结论与展望本实验通过Weka软件对房价预测数据集进行了挖掘分析,得出了不同算法的性能比较和结论。

未来,我们将进一步探索更多的数据挖掘技术和算法,以提高模型的预测准确性和实用性。

总结Weka 数据挖掘实验报告通过对房价预测数据集的挖掘分析,展示了Weka软件在数据挖掘领域的应用和优势。

通过本次实验,我们不仅对数据挖掘的流程和方法有了更深入的理解,也为未来的数据挖掘工作提供了一定的参考和借鉴。

数据挖掘WEKA实验报告

数据挖掘WEKA实验报告一、实验目的本次实验的目的是使用WEKA软件对一个数据集进行数据挖掘,并通过数据挖掘的方法来预测数据集中其中一特定变量的值。

二、实验流程1. 数据集的导入:首先,我们将数据集导入WEKA软件中。

在WEKA主界面中,选择“Explorer”选项,并在弹出的窗口中选择“Open File”选项,然后选择要导入的数据集文件即可。

2. 数据预处理:在导入数据集后,我们需要对数据集进行预处理。

预处理的目的是为了提高数据挖掘的准确性和可靠性。

在WEKA中,我们可以通过选择“Preprocess”选项进行数据预处理。

常见的数据预处理方法有缺失值处理、异常值处理、离散化、标准化等。

3. 数据分析与建模:在数据预处理完成后,我们需要进行数据分析和建模。

在WEKA中,我们可以使用分类、回归、聚类等方法进行数据分析。

在本次实验中,我们选择使用朴素贝叶斯分类器进行数据分析与建模。

在WEKA中,我们可以通过选择“Classify”选项,并在弹出的窗口中选择“NaiveBayes”选项来使用朴素贝叶斯分类器。

4.模型评估与优化:在完成数据分析与建模后,我们需要对模型进行评估与优化。

在WEKA中,我们可以使用交叉验证、混淆矩阵、ROC曲线等方法进行模型评估。

根据评估结果,我们可以对模型进行优化,以提高模型的准确性和可靠性。

5.结果可视化:最后,我们可以对挖掘结果进行可视化展示。

在WEKA中,我们可以使用图表和图形来展示挖掘结果。

根据可视化结果,我们可以更加直观地理解和分析挖掘结果。

三、实验结果与分析在本次实验中,我们选择了一个含有1000个样本的数据集,并使用朴素贝叶斯分类器进行数据挖掘。

经过数据预处理和模型评估,我们最终得到了一个准确率为80%的分类模型。

通过对模型进行优化,我们成功的预测了数据集中其中一特定变量的值。

四、实验总结通过本次实验,我们学习了如何使用WEKA软件进行数据挖掘。

WEKA是一个功能强大的数据挖掘工具,它提供了丰富的数据预处理和分析方法,可以帮助我们进行高效准确的数据挖掘。

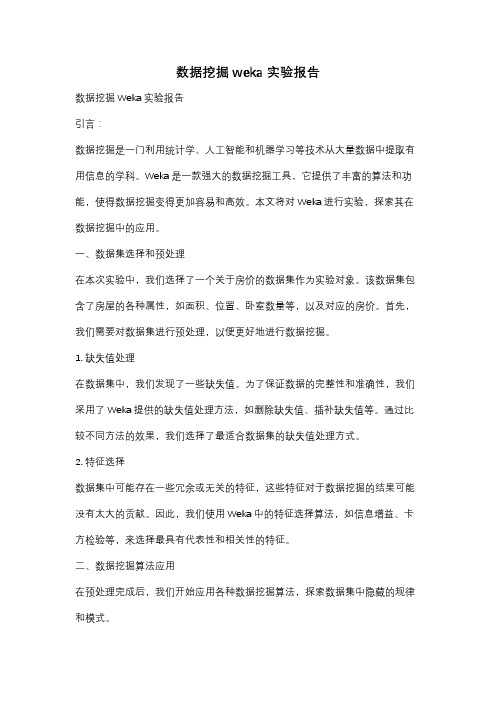

数据挖掘weka实验报告

数据挖掘weka实验报告数据挖掘Weka实验报告引言:数据挖掘是一门利用统计学、人工智能和机器学习等技术从大量数据中提取有用信息的学科。

Weka是一款强大的数据挖掘工具,它提供了丰富的算法和功能,使得数据挖掘变得更加容易和高效。

本文将对Weka进行实验,探索其在数据挖掘中的应用。

一、数据集选择和预处理在本次实验中,我们选择了一个关于房价的数据集作为实验对象。

该数据集包含了房屋的各种属性,如面积、位置、卧室数量等,以及对应的房价。

首先,我们需要对数据集进行预处理,以便更好地进行数据挖掘。

1. 缺失值处理在数据集中,我们发现了一些缺失值。

为了保证数据的完整性和准确性,我们采用了Weka提供的缺失值处理方法,如删除缺失值、插补缺失值等。

通过比较不同方法的效果,我们选择了最适合数据集的缺失值处理方式。

2. 特征选择数据集中可能存在一些冗余或无关的特征,这些特征对于数据挖掘的结果可能没有太大的贡献。

因此,我们使用Weka中的特征选择算法,如信息增益、卡方检验等,来选择最具有代表性和相关性的特征。

二、数据挖掘算法应用在预处理完成后,我们开始应用各种数据挖掘算法,探索数据集中隐藏的规律和模式。

1. 分类算法我们首先尝试了几种分类算法,如决策树、朴素贝叶斯等。

通过比较不同算法的准确率、召回率和F1值等指标,我们找到了最适合该数据集的分类算法,并对其进行了优化。

2. 聚类算法除了分类算法,我们还尝试了一些聚类算法,如K均值聚类、层次聚类等。

通过可视化聚类结果,我们发现了数据集中的一些簇,从而更好地理解了数据集的结构和分布。

3. 关联规则挖掘关联规则挖掘是一种发现数据集中项集之间关系的方法。

我们使用了Apriori算法来挖掘数据集中的关联规则,并通过支持度和置信度等指标进行评估。

通过发现关联规则,我们可以了解到不同属性之间的相关性和依赖性。

三、实验结果分析通过实验,我们得到了一系列数据挖掘的结果。

根据实验结果,我们可以得出以下结论:1. 分类算法的准确率较高,可以用于预测房价等问题。

数据挖掘WEKA实验报告

数据挖掘WEKA实验报告一、实验目的本实验旨在使用WEKA数据挖掘工具,对给定的数据集进行分析和挖掘,探索其中的隐藏规律和关联关系,为决策提供科学依据。

二、实验过程1.数据集选择2.数据预处理首先,对数据集进行了探索性数据分析,了解数据的特征和分布情况。

随后,针对缺失数据和异常值进行了处理操作,采用了替换和删除的策略,以保证数据的质量和准确性。

3.特征选择使用WEKA提供的属性选择过程,对数据集中的特征进行了选择。

通过比较不同的特征选择算法(如信息增益、卡方检验、相关系数等),选取了最优的特征子集用于后续的建模。

4.分类建模为了预测年收入水平,我们选择了几个常用的分类算法进行建模和评估。

包括朴素贝叶斯、决策树、随机森林和支持向量机等。

对于每一种算法,我们使用了10折交叉验证的方式进行模型的训练和测试,并记录了准确率、召回率和F1值等指标作为评估结果。

5.结果分析通过比较不同算法的评估结果,我们发现随机森林算法在该数据集上的表现最好,准确率达到了80%以上。

决策树和朴素贝叶斯算法也有不错的表现,分别达到了75%和70%的准确率。

而支持向量机算法的准确率相对较低,仅为60%左右。

三、实验总结通过本次实验,我们学习并掌握了使用WEKA工具进行数据挖掘的基本操作和流程。

通过数据预处理、特征选择和分类建模等步骤,我们成功地对给定的数据集进行了分析和挖掘,并得到了有意义的结果。

但是需要注意的是,数据挖掘并非一种万能的解决方案,其结果也往往受到多个因素的影响。

因此,在实际应用中,我们需要根据具体情况选择合适的算法和方法,并对结果进行合理的解释和评估。

综上所述,本次实验为我们提供了一个良好的实践机会,帮助我们理解和掌握数据挖掘的基本理论和技术,为今后的科学研究和决策提供了有力的支持。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

0 41 ( 44%)

1 52 ( 56%)

6、对上述实验结果进行分析

7、显示散点图

我们在左下方“Result list”列出的结果上右击,点“Visualize cluster assignments”。弹出的窗口给出了各实例的散点图。最上方的两个框是选择横坐标和纵坐标,第二行的”color”是散点图着色的依据,默认是根据不同的簇“Cluster”给实例标上不同的颜色。

Passenger_capacity

Length

Wheelbase

Width

U-turn_space

Rear_seat_room

Luggage_capacity

Weight

Domestic

class

Test mode: evaluate on training data

=== Model and evaluation on training set ===

2、利用Weka中提供的simpleKmeans方法对数据文件进行聚类分析,更深刻的理解k均值算法,并通过对实验结果进行观察分析,找出实验中所存在的问题。

二.实验环境

Win

在WEKA中实现K均值的算法,观察实验结果并进行分析。

四、实验过程与分析

一、实验过程

1、添加数据文件

甘肃政法学院

本科生实验报告

(2)

姓名:

学院:计算机科学学院

专业:信息管理与信息系统

班级:

实验课程名称:数据挖掘

实验日期:

指导教师及职称:

实验成绩:

开课时间:2013—2014学年一学期

甘肃政法学院实验管理中心印制

实验题目

Weka的数据聚类分析

小组合作

姓名

班级

学号

一、实验目的

1、了解和熟悉K均值聚类的步骤

Cluster 1

Mean/Mode: Ford Small 24.9615 31.2692 0 1 4.2301 1.9942 120.1538 5528.8462 2622.3077 1 15.1346 4.7115 174.8654 100.2692 67.0385 36.8462 26.891 12.6069 2722.3077 0 16.4019

二、实验分析

本次实验采用的数据文件是“1993 New Car Data”。通过观察本次实验的实验结果观察,我们可以知道:

1、Number of iterations: 5,意味着本次实验把这93条实例聚成了5类,即K=5

2、Within cluster sum of squared errors: 282.17934341063733

Cluster 1

Mean/Mode: Ford Small 24.9615 31.2692 0 1 4.2301 1.9942 120.1538 5528.8462 2622.3077 1 15.1346 4.7115 174.8654 100.2692 67.0385 36.8462 26.891 12.6069 2722.3077 0 16.4019

Std Devs: N/A N/A 6.0746 5.7467 N/A N/A 0.7301 0.5047 40.8149 484.7019 377.1753 N/A 3.0204 0.848 11.2599 5.5735 2.4968 2.338 2.7753 2.3975 492.4971 N/A 7.9863

Std Devs: N/A N/A 2.3916 3.0368 N/A N/A 1.261 0.9015 50.3232 581.2098 370.73 N/A 2.4903 1.0735 11.1232 5.2435 2.9632 1.9462 2.772 2.4527 358.6609 N/A 10.2372

kMeans

======

Number of iterations: 5

Within cluster sum of squared errors: 282.17934341063733

Cluster centroids:

Cluster 0

Mean/Mode: Chevrolet Midsize 19.0732 26.3171 1 1 5.9024 3.522 173.8537 4965.8537 1964.2683 0 18.6049 5.561 193.7805 108.6098 72.3415 41.6341 29.0202 15.5178 3517.561 1 23.4512

Cluster 0

Mean/Mode: Chevrolet Midsize 19.0732 26.3171 1 1 5.9024 3.522 173.8537 4965.8537 1964.2683 0 18.6049 5.561 193.7805 108.6098 72.3415 41.6341 29.0202 15.5178 3517.561 1 23.4512

Std Devs: N/A N/A 2.3916 3.0368 N/A N/A 1.261 0.9015 50.3232 581.2098 370.73 N/A 2.4903 1.0735 11.1232 5.2435 2.9632 1.9462 2.772 2.4527 358.6609 N/A 10.2372

=== Run information ===

Scheme: weka.clusterers.SimpleKMeans -N 2 -S 10

Relation: s

Instances: 93

Attributes: 23

Manufacturer

Type

City_MPG

Highway_MPG

Manual_transmission_available

Fuel_tank_capacity

Passenger_capacity

Length

Wheelbase

Width

U-turn_space

Rear_seat_room

Luggage_capacity

Weight

Domestic

class

Test mode: evaluate on training data

打开Weka的Explore,使用Open file点击打开本次实验所要使用的raff格式数据文件“auto93.raff”

2、选择算法类型

点击Cluster中的Choose,选择本次实验所要使用的算法类型“SimpleKMeans”

3、得出实验结果

选中“Cluster Mode”的“Use training set”,点击“Start”按钮,观察右边“Clusterer output”给出的聚类结果如下:

Air_Bags_standard

Drive_train_type

Number_of_cylinders

Engine_size

Horsepower

RPM

Engine_revolutions_per_mile

Manual_transmission_available

Fuel_tank_capacity

五、实验总结

通过本次试验,使我对如何在Weka中进行聚类分析有了更深刻的了解,对Weka中进行聚类分析的simpleKmeans算法也有了进一步的理解,但是实验中所遇到的,有关如何以最快的速度找出最好的聚类方案的相关问题,我还理解和运用的不是非常熟悉。在今后的学习中我将通过查阅文献和咨询老师、同学,对此加以熟悉和改进。

Clustered Instances

0 41 ( 44%)

52 ( 56%)

4、修改Seed值

5、得出修改Seed值后的实验结果

=== Run information ===

Scheme: weka.clusterers.SimpleKMeans -N 2 -S 8

Relation: s

Instances: 93

Attributes: 23

Manufacturer

Type

City_MPG

Highway_MPG

Air_Bags_standard

Drive_train_type

Number_of_cylinders

Engine_size

Horsepower

RPM

Engine_revolutions_per_mile

这是评价聚类好坏的标准,数值越小说明同一簇实例之间的距离越小。如果把“seed”参数改一下,得到的这个数值就可能会不一样。我们应该多尝试几个“seed”,并采纳这个数值最小的那个结果。

3、Cluster centroids:”之后列出了各个簇中心的位置。对于数值型的属性,簇中心就是它的均值(Mean),如cluster0的数值型变量Manufacturer的均值19.0732;分类型的就是它的众数(Mode),如cluster0的分类型变量Drive_train_type的众数为1,也就是说这个属性上取值为众数值1(有1个孩子)的实例最多。对于数值型的属性,还给出了它在各个簇里的标准差(Std Devs)。最后的“Clustered Instances”是各个簇中实例的数目及百分比。

Std Devs: N/A N/A 6.0746 5.7467 N/A N/A 0.7301 0.5047 40.8149 484.7019 377.1753 N/A 3.0204 0.848 11.2599 5.5735 2.4968 2.338 2.7753 2.3975 492.4971 N/A 7.9863

=== Model and evaluation on training set ===

kMeans

======