主流服务器网卡Teaming模式配置

Linux网卡Bonding配置

Linux⽹卡Bonding配置⼀、bonding技术简介 bonding(绑定)是⼀种将n个物理⽹卡在系统内部抽象(绑定)成⼀个逻辑⽹卡的技术,能够提升⽹络吞吐量、实现⽹络冗余、负载等功能,有很多优势。

Linux 系统下⽀持⽹络 Bonding,也叫 channel Bonding,它允许你将 2 个或者更多的⽹卡绑定到⼀起,成为⼀个新的逻辑⽹卡,从⽽实现故障切换或者负载均衡的功能,具体情况要取决于 mode 参数的具体配置。

Linux系统bonding技术是内核层⾯实现的,它是⼀个内核模块(驱动)。

使⽤它需要系统有这个模块, 我们可以modinfo命令查看下这个模块的信息, ⼀般来说都⽀持.modinfo bondingbonding的七种⼯作模式bonding技术提供了七种⼯作模式,在使⽤的时候需要指定⼀种,每种有各⾃的优缺点.balance-rr (mode=0) 默认, 有⾼可⽤ (容错) 和负载均衡的功能, 需要交换机的配置,每块⽹卡轮询发包 (流量分发⽐较均衡).active-backup (mode=1) 只有⾼可⽤ (容错) 功能, 不需要交换机配置, 这种模式只有⼀块⽹卡⼯作, 对外只有⼀个mac地址。

缺点是端⼝利⽤率⽐较低balance-xor (mode=2) 不常⽤broadcast (mode=3) 不常⽤802.3ad (mode=4) IEEE 802.3ad 动态链路聚合,需要交换机配置,没⽤过balance-tlb (mode=5) 不常⽤balance-alb (mode=6) 有⾼可⽤ ( 容错 )和负载均衡的功能,不需要交换机配置 (流量分发到每个接⼝不是特别均衡)详细说明请参考⽹络上其他资料,了解每种模式的特点根据⾃⼰的选择就⾏, ⼀般会⽤到0、1、4、6这⼏种模式。

⼆、RHEL6 下的 Boding 配置: 在所有的 RHEL 版本下,⽬前都不⽀持在 NetworkManager 服务协作下实现 Bonding 配置.所以要么直接关闭 NetworkManager 服务,并取消其开机启动,要么在所有涉及 Bonding 的⽹卡配置⽂件中(包含ethx 或者 bondY),显式地添加⼀⾏:NM_CONTROLLED=no 要配置⽹卡 Bonding,你必须在/etc/sysconfig/network-scripts/⽬录下建⽴逻辑⽹卡的配置⽂件 ifcfg-bondX,⼀般 X 从 0 开始,依次增加.具体的⽂件内容根据参与 Bonding 的⽹卡类型的不同⼜有所差别,以最最常见的 Ethernet 为例,配置⽂件⼤致是这样的:DEVICE=bond0IPADDR=192.168.0.1NETMASK=255.255.255.0ONBOOT=yesBOOTPROTO=noneUSERCTL=noBONDING_OPTS="bonding parameters separated by spaces"NM_CONTROLLED=no BONDING_OPTS 这⼀⾏填写你需要的 Bonding 模式,⽐如 BONDING_OPTS="miimon=100 mode=1" ,下⾯也会介绍⼏种常见的配置⽅式和它代表的意义,这⾥暂时不展开说明.为了⽅便称呼,我们把Bongding 后的逻辑⽹卡 bondX 称为主⽹卡(Master),参与 Bonding 的物理⽹卡 ethY 称为⼦⽹卡(Slave). 主⽹卡配置⽂件创建完毕以后,⼦⽹卡的配置⽂件也需要做相应的改变,主要是添加 MASTER=和SLAVE=这两项参数,我们假设 2 张⼦⽹卡为 eth0 和 eth1,那么他们的配置⽂件⼤致的样⼦会是这样⼦:DEVICE=ethXBOOTPROTO=noneONBOOT=yesMASTER=bond0SLAVE=yesUSERCTL=noNM_CONTROLLED=no 像这样,分别修改 ifcfg-eth0 和 ifcfg-eth1 配置⽂件,DEVICE=ethX 中的 X ⽤相应的值代替.然后我们重启⽹络服务.service network restart这样⼦,⼦⽹卡为 eth0 和 eth1,主⽹卡为 bond0,模式为 mode 1 的⽹络 Bonding 就完成了rhel6 bonding 实例展⽰系统: rhel6⽹卡: eth2、eth3bond0:10.200.100.90负载模式: mode1(active-backup) # 这⾥的负载模式为1,也就是主备模式.1、关闭和停⽌NetworkManager服务service NetworkManager stopchkconfig NetworkManager offps: 如果有装的话关闭它,如果报错说明没有装这个,那就不⽤管2、加载bonding模块modprobe --first-time bonding3、创建基于bond0接⼝的配置⽂件[root@rhel6.6 network-scripts]# cat ifcfg-bond0DEVICE=bond0BOOTPROTO=noneIPADDR=10.200.100.90NETMASK=255.255.255.0ONBOOT=yesNM_CONTROLLED=noUSERCTL=noBONDING_OPTS="mode=1 miimon=200"4、SLAVE⽹卡的配置⽂件两种⼦⽹卡的配置⽂件如下[root@rhel6.6 network-scripts]# cat ifcfg-eth2DEVICE=eth2#HWADDR=14:58:D0:5A:0F:76NM_CONTROLLED=no#UUID=3b718bed-e8d4-4b64-afdb-455c8c3ccf91ONBOOT=yes#NM_CONTROLLED=yesBOOTPROTO=noneMASTER=bond0SLAVE=yesUSERCTL=no[root@rhel6.6 network-scripts]# cat ifcfg-eth3DEVICE=eth3#HWADDR=14:58:D0:5A:0F:77NM_CONTROLLED=no#UUID=988835c2-8bfa-4788-9e8d-e898f68458f0ONBOOT=yes#NM_CONTROLLED=yesBOOTPROTO=noneMASTER=bond0SLAVE=yesUSERCTL=no5、bonding信息查看重启⽹络服务器后bonding⽣效[root@rhel6.6 network-scripts]# ip a4: eth2: <BROADCAST,MULTICAST,SLAVE,UP,LOWER_UP> mtu 1500 qdisc mq master bond0 state UP qlen 1000link/ether c4:34:6b:ac:5c:9e brd ff:ff:ff:ff:ff:ff5: eth3: <BROADCAST,MULTICAST,SLAVE,UP,LOWER_UP> mtu 1500 qdisc mq master bond0 state UP qlen 1000link/infiniband a0:00:03:00:fe:80:00:00:00:00:00:00:00:02:c9:03:00:0a:6f:ba brd 00:ff:ff:ff:ff:12:40:1b:ff:ff:00:00:00:00:00:00:ff:ff:ff:ff10: bond0: <BROADCAST,MULTICAST,MASTER,UP,LOWER_UP> mtu 1500 qdisc noqueue state UPlink/ether c4:34:6b:ac:5c:9e brd ff:ff:ff:ff:ff:ffinet 10.200.100.90/24 brd 10.212.225.255 scope global bond0inet6 fe80::c634:6bff:feac:5c9e/64 scope linkvalid_lft forever preferred_lft forever[root@rhel6.6 network-scripts]# cat /proc/net/bonding/bond0Ethernet Channel Bonding Driver: v3.6.0 (September 26, 2009)Bonding Mode: fault-tolerance (active-backup) # bond0接⼝采⽤mode1Primary Slave: NoneCurrently Active Slave: eth2MII Status: upMII Polling Interval (ms): 200Up Delay (ms): 0Down Delay (ms): 0Slave Interface: eth2MII Status: upSpeed: 1000 MbpsDuplex: fullLink Failure Count: 0Permanent HW addr: c4:34:6b:ac:5c:9eSlave queue ID: 0Slave Interface: eth3MII Status: upSpeed: 1000 MbpsDuplex: fullLink Failure Count: 0Permanent HW addr: c4:34:6b:ac:5c:9fSlave queue ID: 0进⾏⾼可⽤测试,拔掉其中的⼀条⽹线看丢包和延时情况, 然后在插回⽹线(模拟故障恢复),再看丢包和延时的情况.三、RedHat7配置bonding系统: Red Hat Enterprise Linux Server release 7.6 (Maipo)⽹卡: eno3、eno4bonding:bond0负载模式: mode1(active-backup)服务器上两张物理⽹卡eno3和eno4, 通过绑定成⼀个逻辑⽹卡bond0,bonding模式选择mode1注: ip地址配置在bond0上, 物理⽹卡不需要配置ip地址.1、关闭和停⽌NetworkManager服务RedHat7默认安装了NetworkManager,在配置前先关掉NetworkManager服务,否则可能会对bonding或造成问题。

双线路双网卡双网关如何设置

双线路双网卡双网关如何设置以下是双线路双网卡双网关的设置步骤:1.选择适合的硬件设备:确保计算机或服务器上有两个可用的网卡插槽。

可以选择经济实惠的PCI或PCIe网卡。

2.安装网卡:将两个网卡插入计算机或服务器的网卡插槽中,确保插入牢固并连接好网线。

3.连接到两个网络:将一条网线连接到一个网卡插槽上,连接到一个网络。

将另一条网线连接到另一个网卡插槽上,连接到另一个网络。

4.配置IP地址:打开计算机的网络设置,为每个网卡配置IP地址、子网掩码和默认网关。

确保每个网卡有唯一的IP地址,并且网关不同。

5.调整网络优先级:在网络设置中,调整每个网卡的网络优先级。

一般情况下,将主要网络连接的网卡设置为首选并提高优先级。

6.设置负载均衡/冗余模式:根据实际需求,选择负载均衡模式或冗余模式。

负载均衡模式将流量分担到两个网卡上,提高网络吞吐量;冗余模式则保证一条线路失效时,仍能通过另一条线路正常工作。

7. 测试网络连接:通过ping命令测试两个网络是否正常连接。

在命令提示符下输入"ping IP地址",其中IP地址替换为另一个网卡所连接的网络中的一些设备的IP地址。

如果ping命令成功,表示连接正常。

8.配置防火墙设置:根据实际需求,配置防火墙允许两个网络之间的通信。

确保网络畅通的同时,保证网络的安全性。

9.定期监控和维护:定期检查两个网卡的连接状态和IP地址配置,确保网络正常工作。

当发现故障时,及时进行排查和修复。

总之,双线路双网卡双网关的设置可以提高网络的可用性和吞吐量,但在配置前需要考虑实际需求和硬件设备的兼容性,确保正确连接和合适的设置。

定期的监控和维护也是保证网络正常工作的重要环节。

多网卡负载均衡设定说明

多网卡负载均衡设定说明1、到Inte网站上,下载最新的Intel网卡驱动

/?lang=zho&changeLang=true

下载完成后,解压安装,如下图,点击Autorun.exe

2、弹出下图,点选“安装驱动程式和软件”,一路“下一步”,直到安装完成

3、然后打开,设备管理器,点击“网络适配器”,双击一块网卡,

4、弹出窗口,点选“分组”,

5、弹出下图,勾选,“将此适配器与其他适配器组合”,然后点击“新组”,

6、点击确定后,弹出下图,

如图,给新组命名team1,然后点击下一步7、弹出下图,勾选所有适配器,然后下一步

8、弹出下图,点选,“适应性负载均衡”,下一步

9、弹出下图窗口,单击完成,

10、等待配置完成

11、完成后,回到设备管理器,网络适配器,会发现team1组

12、双击其中,一块网卡,弹出下图,查看team1属性,

13、再弹出窗口中,点击设置,点选任一网卡后,再点击“详细信息”,可以确认,此组类型为:适应性负载均衡

14、再打开本地连接,会多出一个“本地连接5”,即为新增的“team1”

15、双击打开“本地连接5”,查看连接状态,速度为4.0Gbps,同时集成了网络聚合和容错。

16、点击属性,配置IP地址后,完成。

服务器双网卡配置方法

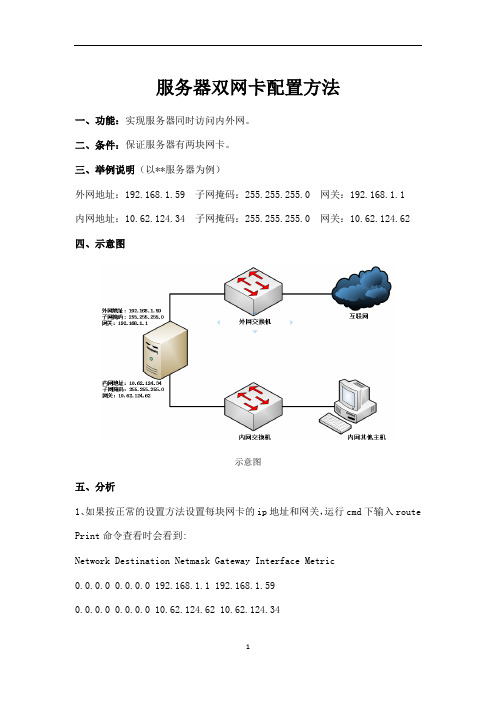

服务器双网卡配置方法一、功能:实现服务器同时访问内外网。

二、条件:保证服务器有两块网卡。

三、举例说明(以**服务器为例)外网地址:192.168.1.59 子网掩码:255.255.255.0 网关:192.168.1.1内网地址:10.62.124.34 子网掩码:255.255.255.0 网关:10.62.124.62 四、示意图示意图五、分析1、如果按正常的设置方法设置每块网卡的ip地址和网关,运行cmd下输入route Print命令查看时会看到:Network Destination Netmask Gateway Interface Metric0.0.0.0 0.0.0.0 192.168.1.1 192.168.1.590.0.0.0 0.0.0.0 10.62.124.62 10.62.124.34即指向0.0.0.0的有两个网关,这样就会出现路由冲突,造成数据不知如何转发,两个网络都不能访问。

2、实现同时访问两个网络的步骤第一步:按需求配置两个网卡的IP地址和网关,注意在tcp/ip设置要里去掉接在企业内部网的网卡的网关,如下图:建阳外网网卡配置建阳内网网卡配置第二步:route delete 0.0.0.0 // "删除所有0.0.0.0的路由"备注:如果是远程操作,使用此命令,会断开外网,无法远程,可重启服务器,重新配置上外网地址,然后再远程操作以下步骤。

第三步:route add –p 0.0.0.0 mask 0.0.0.0 192.168.1.1//"添加0.0.0.0网络路由",即访问外网的路由。

第三步:route add –p 10.0.0.0 mask 255.0.0.0 10.62.124.62// "添加10.0.0.0网络路由",注意mask为255.0.0.0,而不是255.255.255.0 ,这样内部的多网段才可用。

RHEL7多网卡绑定实验bond和team

这两种方法重启后效果是不会变的

一,传统的方法(bond):

记住要绑定的网卡的网卡名和对应的MAC地址

1,这种方法要将NetworkManager.service给给关闭(为什么?——>不然NetworkManager会识别这两块网卡的配置文件了,设bond就不灵了,重启就消失了,哈哈)

下面这个关不了:

2查看一下,已经停了:

3配置网卡1(仆)的配置文件:

4配置网卡2(仆)的配置文件:

4重启网络:

5新建一个虚拟网卡(主)的配置文件(名字是无所谓的)

配置文件内容:

6将刚才配的那两个(仆)网卡加上规则信息:

7都配置好了就可以重启网络了(和刚才的那个重启网络有什么区别?——>一样的service network restart

查看现在哪个网卡提供服务:

查看效果:

二,Team绑定法:先配主再配仆(两步完事儿)

这个方法的网卡切换时网络是无缝转接,而bond切换时会暂停一会儿。

对象是这两个网卡:

查看帮助:

运行策略:

1,先创建“主”,即虚拟网卡的配置:

给“主”添加IP和模式:

2,给那两个网卡添加配置文件,指定为“仆”属性

Ifconfig查看时可以看到team0已经生效了

查看team0的运行状态:

检验效果:。

Broadcom_多网卡聚合简要配置手册v1.1

Windows环境Broadcom多网卡聚合简要配置说明V1.1V1.0 Broadcom Control Suite2 配置说明V1.1 使用Broadcom Control Suite3界面说明配置步骤,增加主备网卡冗余配置说明一、配置工具介质准备:配置前请针对所使用的IBM服务器型号,下载对应的Broadcom工具。

运行Broadcom Control Suite 3时还需要准备 .Net Framework 2.0,否则无法正常进行配置,.Net Framework 2.0请到微软下载。

Broadcom网卡工具下载连接一(请注意支持机器型号):https:///systems/support/supportsite.wss/docdisplay?lndocid=MIGR-438 15&brandind=5000008Supported systems:- IBM eServer 325, 326, 326m- IBM eServer xSeries 100, 205, 206m, 226- IBM eServer xSeries 235, 236, 255, 260- IBM eServer xSeries 225 (Type 8647)- IBM eServer xSeries 305, 306m, 335, 336- IBM eServer xSeries 346, 365,366, 440- IBM eServer xSeries 445, 450, 455, 460- IBM eServer xSeries MXE 460- IBM BladeCenter JS20- IBM BladeCenter JS21- IBM BladeCenter HS20- IBM BladeCenter LS20- IBM System x3105- IBM System x3200- IBM System x3200 M2- IBM System x3250- IBM System x3250 M2- IBM System x3350- IBM System x3400- IBM System x3400- IBM System x3455- IBM System x3500- IBM System x3800- IBM System x3850- IBM System x3950- IBM System x3950 E- IBM IntelliStation A Pro- IBM IntelliStation E Pro- IBM IntelliStation M Pro- IBM IntelliStation Z ProBroadcom网卡工具下载连接二(请注意支持机器型号):https:///systems/support/supportsite.wss/docdisplay?lndocid=MIGR-507 8665&brandind=5000020Systems supported:- IBM BladeCenter HC10 (7996)- IBM BladeCenter HS21 (8853, 1885)- IBM BladeCenter HS21 XM (7995, 1915)- IBM BladeCenter LS21 (7971)- IBM BladeCenter LS22 (7901)- IBM BladeCenter LS41 (7972)- IBM BladeCenter LS42 (7902)- IBM System x3455 (7940, 7941)- IBM System x3550 (1913, 7978)- IBM System x3650 (1914, 7979)- IBM System x3655 (7943, 7985)- IBM System x3755 (7163, 8877)建议下载ISO文件,并烧录成CD,用CD运行。

Linux服务器网卡聚合简单操作

1、网卡聚合需要将服务器的两个网口都接到交换机,并且交换机网口在同一网段,网卡聚合要在本地,不能远程进去,因此最开始也不要给网口设置IP,直接做网口聚合即可①nmcli con add type team con-name team0 ifname team0 config'{"runner":{"name":"activebackup"}} 回车②nmcli dev 回车查看网卡连接信息③nmcli con add type team-slave con-name team0-port1 ifname em1 master team0 回车④nmcli con add type team-slave con-name team0-port2 ifname em2 master team0 回车⑤nmcli con modify team0 ipv4.addresses 172.16.6.49/24 #ip/子网掩码⑥nmcli con modify team0 ipv4.gateway 172.16.6.1 #网关⑦nmcli con modify team0 ipv4.dns 172.16.6.1 #配置 dns⑧nmcli con modify team0 ipv4.method manual #手动设置模式⑨nmcli con modify team0 connection.autoconnect yes #网卡自动连接⑩nmcli con up team0 #启动 team0配置完成之后重启网络服务systemctl restart network查看网络配置文件nmcli con show最后看到有连接成功即可,测试打开一个窗口一直 ping,交替拔掉两根网线,服务器保持通信状态,只会掉一帧如果有遇到配置完成之后重启网络服务 systemctl restart network报错的可以试一下重启服务器,然后nmcli dev 回车查看网卡连接信息,如果成功了就可以再不行就删了之前的操作,再来一遍删除 team:nmcli con del team0 team0 team0-port1 team0-port2断开 team-slave:nmcli dev dis em1nmcli dev con em1。

网卡优化设置(很详细很详细)

⽹卡优化设置(很详细很详细)⽹卡优化设置(很详细很详细)INTEL⽹卡优化设置感谢⽹络蜘蛛提供以下技术资料⽹卡优化设置INTEL⽹卡优化设置感谢⽹络蜘蛛提供以下技术资料经过测试后发现,INTEL千兆⽹卡经过以下设置优化后,在⽆盘的启动速度⽅⾯有很⼤的提升,启动时不转圈或者不到⼀圈进桌⾯。

⽹卡的⾼级属性设置:QoS数据包标签建议设置:已禁⽤本地管理的地址建议设置:不存在传输描述符建议设置:256等待连接建议设置:开分载传输IP效验和建议设置:开分载传输TCP效验和建议设置:关分载接收IP效验和建议设置:开分载接收TCP效验和建议设置:关唤醒链接设置建议设置:已禁⽤唤醒设置建议设置:已禁⽤纪录链接状态设置建议设置:已禁⽤接收描述符建议设置:256巨帧建议设置:已禁⽤链接速度和双⼯建议设置:1000 Mbps ⾃动协商流程控制建议设置:关启⽤ PME建议设置:控制操作系统适应性帧间距调整建议设置:已启⽤中断节流率建议设置:关经过前期的测试发现,INTEL⽹卡驱动使⽤11.2以后的版本⽐较好,11.2以后的版本驱动在传输相同数据,相同传输速率时,对⼯作站的CPU利⽤率⽐较低。

其他各种⽹卡做⽆盘的⾼级设置NF⽹卡⾼级设置Checksum Offload 数据包校验建议关闭Flow Control 流量控制⼀定要关闭IEEE802.1P Support IEEE802.1P⽀持建议关闭Jumbo Frame Payload Size 默认是1500 这个是千兆⽹络⼀个新的设置,在下⽂详细叙述。

Low Power State Link Speed ⽹卡节能建议关闭Network Address MAC的修改默认为不存在⼀般不必改动Optimize For CPU/Throughput 为CPU占⽤优化或为吞吐量进⾏优化,设置为CPU的话,⽹卡的速度被限制,但CPU占⽤会很低,假如改为Throughput的话,⽹卡的性能才能完全发挥,但CPU的占⽤也会上升不少。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

主流服务器网卡Teaming模式配置

目前市面上服务器网卡中Intel和Broadcom较为常见,本文就以此两个品牌的网卡

Teaming模式的配置进行介绍。

一、测试使用的网卡:

Intel:Intel? PRO/1000 PT Dual Port Server Adapter

芯片组:Intel? 82571GB Gigabit Controller

Broadcom:Broadcom BCM5708C NetXtreme Ⅱ GigE

芯片组:Broadcom BCM5708C

二、测试环境

硬件:IBM 3650

软件:Windows server 2008 R2 (偶也尝尝鲜,嘿嘿)

三、Teaming模式配置

1. Intel篇

将网卡安装好后,启动操作系统,Windows Server 2008 R2此时已经识别出了两块网卡,并

且已经通过DHCP自动获取到了IP地址

但是此时点击网卡的属性发现,驱动程序虽然是09年3月份的,但是相关的高级属性配置

选项却没有,看来还是要去Intel官方下载相关驱动管理程序才可以呀。

在官网中找到Intel? Ethernet Drivers and Software for Multiple Operating Systems 从描述中知

道该程序支持多种OS及数种Intel网卡。下载到本地后,运行Autorun,选择【安装驱动程

序和软件】

弹框提示

选择需要安装的功能

驱动程序安装好后,再次点击网卡属性发现,驱动程序已更新至09年6月,并且相应的高

级功能选项也出现了

此时点击【分组】,勾选【将此适配器与其他适配器组合】,并单击【新组】,来创建一个Teaming

先给新组起个名字,这里我就叫【Team 1#】

然后勾选要组成Team的网卡

下一步就要选择网卡组的类型了,这里Intel一共支持5中类型的组模式,分别是:适配器

容错、适应性负载均衡、静态链接聚合、IEEE802.3 ad动态链接聚合、交换机容错。其中

适配器容错和交换机容错主要是为了防止硬件设备的单点故障。两种链接聚分别代表两种状

态,旨在提高交换器之间或服务器和交换器之间的吞吐量。而我要使用的组模式为适应性负

载均衡。关于适应性负载均衡的说明如下:

适应性负载平衡

适应性负载平衡(ALB) 在交换器端口、电缆或适配器发生故障时提供传输通信量的负载平衡及容错。

英特尔(R) PROSet 分析各成员适配器的传输负载并在成员适配器之间平衡通信量。一个适配器接受所有接

收通信量。

ALB 组有用于接收负载平衡 (RLB) 的选项。RLB 允许组在所有成员适配器之间平衡接收通信量。RLB 默认

启用。

可以为组选择主适配器和次适配器,但在 RLB 禁用的情况下则不是必需的。如果启用了 RLB,则会自动指

派主适配器。

RLB 必须有一个主适配器。您可以将一个新适配器设定为主适配器,但是不能从组中移除此主适配器。

RLB 禁用的情况下,设定主适配器为可选。

在 RLB 禁用的情况下,主适配器是接收通信量的唯一适配器。

如果启用了 RLB,则会自动将功能最健全的高速度适配器选定并标为主适配器。

如果更改或添加了主适配器,该组将重新加载,导致短时间丢失连接。

配置说明

ALB 不平衡非路由协议,如 NetBEUI 和一些 IPX* 通信量。

AFT 支持每组两到八个适配器端口。

RLB 在 Hyper-V* 上不受支持。

组成员不必以相同的速度或双工模式运行。

此组类型不要求配置交换器。

此种组类型适用于任何交换器或集线器。

适应性负载均衡实际是取了容错和链接聚合的优点

选择完组类型,完成向导。

接下来,向导会生成一块类型为组的逻辑网卡,本文为【本地连接5】,同时查看此网卡属

性,可以发现已经包含了组里的两块物理网卡,并处于活动状态。

此时点击【修改组】,可查看和修改组的配置信息,比如在【适配器】中就可以设置主次适

配器,此适配器可以不用设置,但一定要有一个主适配器,并且是自动指派的。

这时两块物理网卡的TCP/IP协议已经不允许在进行配置了,这个和HYPER-V的父分区有

点像,类似一个虚拟交换机。

不过可以通过编辑逻辑网卡的TCP/IP协议来定义IP地址

使用IPCONFIG命令查看一下,IP地址没有问题,与外网通信也正常。

Intel 网卡 Teaming模式配置完成。