各种BP学习算法MATLAB仿真

Bp神经网络的Matlab实现

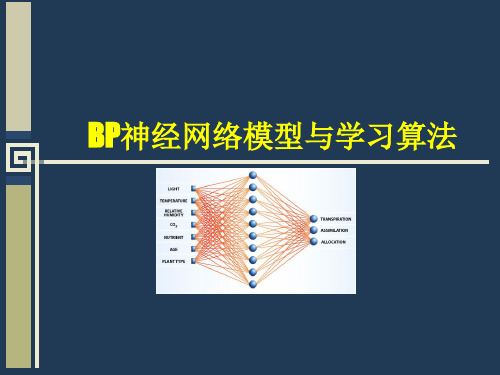

式, 同一层之 间不存 在相 互连接 , 隐层 可 以有 一层或 多层 . 层与层 之 间有 两种 信号在 流通 : 一种是 工 作信 号 ( 实线 表 示 )它是 施 加输 入信 号 后 用 , 向前传 播直 到在输 出端 产生 实 际输 出的信 号 , 是输 入 和权 值 的 函数 . 另

我们 可 以直观 、 便地进 行分 析 、 算 及仿 真 工作 _ . 经 网络 工 具箱 是 M tb以神 经 网 络 为基 础 , 方 计 2神 j aa l 包含 着 大

量B p网络 的作 用 函数和算 法 函数 , B 为 p网络 的仿 真研 究 提供 了便 利 的工 具 . 运用 神 经 网络 工具 箱 一般 按 照

21年 1 00 0月

湘 南 学 院 学报

J u n lo a g a o ra f Xin n n Umv  ̄i e t y

Oc . 2 0 t . 01 V0 . l No. J3 5

第 3 卷第 5期 1

B p神 经 网络 的 Ma a 现 t b实 l

石 云

一

输 入层

隐 层

输 出层

种是 误差信 号 ( 虚线 表示 )网络实 际输 出与期望 输 出间的差 值 即为 用 ,

图 1 典型 B p网络 模 型

误差 , 由输 出端开 始逐层 向后传 播 . p网络 的学 习过程 程 由前 向计 算 它 B

如何利用Matlab进行模拟和仿真实验

如何利用Matlab进行模拟和仿真实验Matlab是一种功能强大的数学计算和数据可视化软件。

它不仅可以进行数学模拟和仿真实验,还可以处理数据、绘制图表和实施算法。

在工程、物理学、生物学等领域,Matlab被广泛用于解决各种实际问题。

本文将介绍如何利用Matlab进行模拟和仿真实验,并探讨其在实验设计和结果分析中的应用。

一. Matlab的基本功能Matlab具有很多基本功能,如矩阵操作、数值计算、符号计算等。

这些功能使得Matlab成为进行模拟和仿真实验的理想选择。

在Matlab中,可以定义和操作矩阵,进行线性代数运算,如求解方程组、矩阵求逆等。

此外,Matlab还提供了许多内置函数,可以进行数值计算和符号计算,如求解微分方程、积分、数值优化等。

二. 模拟实验的设计在进行模拟实验之前,首先需要设计实验方案。

实验设计包括选择合适的模型和参数设置,确定实验变量和观测指标等。

在Matlab中,可以使用函数或脚本来定义模型和参数,通过修改参数值来观察实验结果的变化。

比如,可以使用Matlab的模型库来选择合适的模型,然后使用函数传入参数值进行求解。

此外,Matlab还提供了绘图功能,可以绘制实验结果的图表,以便更直观地分析数据。

三. 仿真实验的实施在设计好实验方案后,就可以开始进行仿真实验了。

在Matlab中,可以使用已定义的模型和参数进行仿真计算。

可以通过Matlab的编程功能来实现计算过程的自动化。

比如,可以使用循环语句来迭代计算,以观察参数变化对结果的影响。

此外,Matlab还提供了随机数生成和统计分析函数,可以用于生成随机变量和分析实验数据。

四. 实验结果的分析在完成仿真实验后,需要对实验结果进行分析。

Matlab提供了丰富的数据处理和分析工具,可以对实验数据进行统计分析、绘图和可视化展示。

可以使用Matlab的数据处理函数来计算均值、标准差、相关系数等统计指标。

此外,Matlab还可以通过绘图函数来绘制直方图、散点图、线图等图形,以便更好地理解和展示数据。

标准的BP神经网络算法程序MATLAB

count=1;

while (count<=maxcount) %结束条件1迭代1000次

c=1;

while (c<=samplenum)

for k=1:outputNums

d(k)=expectlist(c,k); %获得期望输出的向量,d(1:3)表示一个期望向量内 的值

end

break;

end

count=count+1;%训练次数加1

end%第一个while结束

error(maxcount+1)=error(maxcount);

p=1:count;

pp=p/50;

plot(pp,error(p),"-"); %显示误差

deltv(i,j)=alpha*yitay(j)*x(i); %同上deltw

v(i,j)=v(i,j)+deltv(i,j)+a*dv(i,j);

dv(i,j)=deltv(i,j);

end

end

c=c+1;

end%第二个while结束;表示一次BP训练结束

double tmp;

for i=1:inputNums

x(i)=samplelist(c,i); %获得输入的向量(数据),x(1:3)表一个训练向量

字串4

end

%Forward();

for j=1:hideNums

net=0.0;

for i=1:inputNums

net=net+x(i)*v(i,j);

dw=zeros(hideNums,outputNums); %10*3

BP神经网络matlab教程

w

N 1 ho

w o (k )hoh (k )

N ho

2.4.2 BP网络的标准学习算法

第七步,利用隐含层各神经元的 h (k )和 输入层各神经元的输入修正连接权。

e e hih (k ) wih (k ) h (k ) xi (k ) wih hih (k ) wih w

p

i 1

h 1,2,

o 1,2,

,p

q

yio (k ) whohoh (k ) bo

o 1,2,

yoo (k ) f( yio (k ))

h 1

q

2.4.2 BP网络的标准学习算法

第四步,利用网络期望输出和实际输出, 计算误差函数对输出层的各神经元的偏导 o (k ) 数 。 ( w ho (k ) b ) e e yio yi (k )

输入样本---输入层---各隐层---输出层

判断是否转入反向传播阶段:

若输出层的实际输出与期望的输出(教师信号)不 符

误差反传

误差以某种形式在各层表示----修正各层单元 的权值

网络输出的误差减少到可接受的程度 进行到预先设定的学习次数为止

2.4.2 BP网络的标准学习算法

网络结构 输入层有n个神经元,隐含层有p个神经元, 输出层有q个神经元 变量定义 x x1, x2 , , xn 输入向量; 隐含层输入向量; hi hi1 , hi2 , , hi p 隐含层输出向量; ho ho1 , ho2 , , ho p 输出层输入向量; yi yi1 , yi2 , , yiq 输出层输出向量; yo yo1 , yo2 , , yoq 期望输出向量; d o d1 , d 2 , , d q

qpsk、bpsk蒙特卡洛仿真matlab代码

qpsk、bpsk的蒙特卡洛仿真是一种用于测试和验证通信系统性能的重要工具。

通过模拟大量的随机输入数据,并对系统进行多次仿真运算,可以对系统的性能进行全面评估,包括误码率、信噪比要求等。

在matlab中,我们可以通过编写相应的仿真代码来实现qpsk、bpsk 的蒙特卡洛仿真。

下面将分别介绍qpsk和bpsk的蒙特卡洛仿真matlab代码。

一、qpsk的蒙特卡洛仿真matlab代码1. 生成随机的qpsk调制信号我们需要生成一组随机的qpsk调制信号,可以使用randi函数生成随机整数序列,然后将其映射到qpsk符号点上。

2. 添加高斯白噪声在信号传输过程中,会受到各种干扰,其中最主要的干扰之一就是高斯白噪声。

我们可以使用randn函数生成高斯白噪声序列,然后与调制信号相加,模拟信号在传输过程中受到的噪声干扰。

3. 解调和判决接收端需要进行解调和判决操作,将接收到的信号重新映射到qpsk符号点上,并判断接收到的符号与发送的符号是否一致,从而判断是否发生误码。

4. 统计误码率通过多次仿真运算,记录错误判决的次数,从而可以计算出系统的误码率。

二、bpsk的蒙特卡洛仿真matlab代码1. 生成随机的bpsk调制信号与qpsk相似,我们需要先生成一组随机的bpsk调制信号,然后模拟信号传输过程中的噪声干扰。

2. 添加高斯白噪声同样使用randn函数生成高斯白噪声序列,与bpsk调制信号相加。

3. 解调和判决接收端对接收到的信号进行解调和判决,判断接收到的符号是否与发送的符号一致。

4. 统计误码率通过多次仿真运算,记录错误判决的次数,计算系统的误码率。

需要注意的是,在编写matlab代码时,要考虑到信号的长度、仿真次数、信噪比的范围等参数的选择,以及仿真结果的统计分析和可视化呈现。

qpsk、bpsk的蒙特卡洛仿真matlab代码可以通过以上步骤实现。

通过对系统性能进行全面评估,可以帮助工程师优化通信系统设计,提高系统的可靠性和稳定性。

共轭梯度法在bp算法中的应用及其matlab仿真

共轭梯度法在bp算法中的应用及其matlab仿真共轭梯度法在BP算法中的应用:BP神经网络的训练通常会涉及到对于权值矩阵的更新,而梯度下降法是最常用的一种训练方法。

然而梯度下降法存在一些问题,例如收敛速度慢,易陷入局部最优解等。

因此,人们开始尝试使用共轭梯度法对权值矩阵进行更新。

共轭梯度法在更新权值矩阵时可以更快地找到全局最优解。

共轭梯度法是一种迭代法,其思想是不断地利用之前的搜索方向来确定下一个搜索方向,从而加快搜索速度。

在BP神经网络的训练中,共轭梯度法就是针对误差函数进行优化,同时也就是针对权值矩阵进行更新。

具体来说,共轭梯度法主要可以分为以下几个步骤:1.初始化权值矩阵和搜索方向;2.计算误差函数的梯度;3.利用搜索方向计算误差函数在该方向上的最小值;4.更新权值矩阵和搜索方向;5.判断是否满足一定的停止条件,如果满足,则结束迭代。

通过以上步骤,共轭梯度法可以更快地找到全局最优解,从而提高了BP神经网络的训练效率。

Matlab中实现共轭梯度法的代码:在Matlab中,可以使用cg函数来实现共轭梯度法。

cg函数的输入为一个函数句柄和一个初始向量,输出为最优解和最优值。

我们可以以一元二次方程的最小化为例,来展示如何利用cg函数实现共轭梯度法。

代码如下:function [x_star, f_star] = cg_example。

%定义目标函数。

%定义目标函数的梯度。

%定义初始向量。

x0=0;。

% 调用cg函数。

[x_star, f_star] = cg(f, df, x0);。

其中,cg函数的具体实现可以参考Matlab的官方文档。

在实际应用时,需要根据具体的问题来定义目标函数和梯度函数,以及初始向量。

利用matlab仿真的BP-ANN分类器设计

BP-ANN分类器设计1.引言从深层意义上看,模式识别和人工智能本质都是在解决如何让用机器模拟人脑认知的过程。

一方面,从需要实现的功能出发,我们可以将目标分解为子功能,采用自定而下的的分解法实现我们需要的拟合算法。

而另一方面,无论人脑多么复杂,人类的认知过程都可以认为若干个神经元组成的神经网络在一定机制下经由复杂映射产生的结果。

从神经元的基本功能出发,采用自下而上的设计方法,从简单到复杂,也是实现拟合算法的一条高效途径。

1.1什么是人工神经网络人工神经网络(Artificial Neural Network,ANN)是一种应用类似于大脑神经突触联接的结构进行信息处理的数学模型。

在工程与学术界也常直接简称为神经网络或类神经网络。

神经网络是一种运算模型,由大量的节点(或称神经元)之间相互联接构成。

每个节点代表一种特定的输出函数,称为激励函数(activation function)。

每两个节点间的连接都代表一个对于通过该连接信号的加权值,称之为权重,这相当于人工神经网络的记忆。

网络的输出则依网络的连接方式,权重值和激励函数的不同而不同。

而网络自身通常都是对自然界某种算法或者函数的逼近,也可能是对一种逻辑策略的表达。

人工神经网络是由大量处理单元互联组成的非线性、自适应信息处理系统。

它是在现代神经科学研究成果的基础上提出的,试图通过模拟大脑神经网络处理、记忆信息的方式进行信息处理。

人工神经网络具有四个基本特征:(1)非线性非线性关系是自然界的普遍特性。

大脑的智慧就是一种非线性现象。

人工神经元处于激活或抑制二种不同的状态,这种行为在数学上表现为一种非线性关系。

具有阈值的神经元构成的网络具有更好的性能,可以提高容错性和存储容量。

(2)非局限性一个神经网络通常由多个神经元广泛连接而成。

一个系统的整体行为不仅取决于单个神经元的特征,而且可能主要由单元之间的相互作用、相互连接所决定。

通过单元之间的大量连接模拟大脑的非局限性。

(完整版)BP神经网络matlab实例(简单而经典)

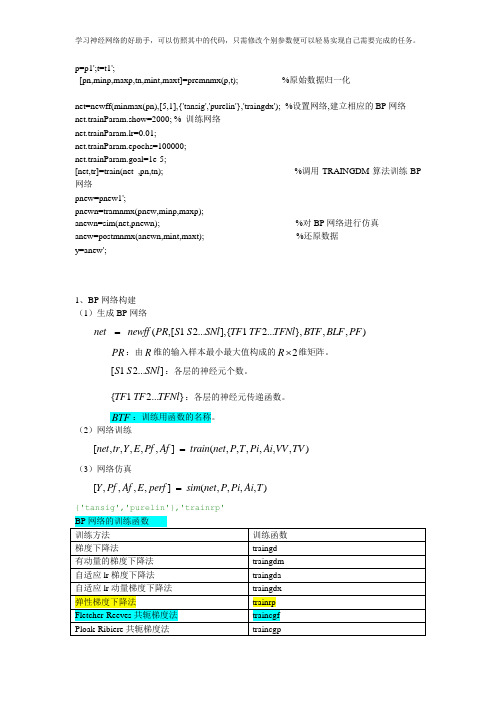

p=p1';t=t1';[pn,minp,maxp,tn,mint,maxt]=premnmx(p,t); %原始数据归一化net=newff(minmax(pn),[5,1],{'tansig','purelin'},'traingdx');%设置网络,建立相应的BP网络net.trainParam.show=2000; % 训练网络net.trainParam.lr=0.01;net.trainParam.epochs=100000;net.trainParam.goal=1e-5;[net,tr]=train(net ,pn,tn); %调用TRAINGDM算法训练BP 网络pnew=pnew1';pnewn=tramnmx(pnew,minp,maxp);anewn=sim(net,pnewn); %对BP网络进行仿真anew=postmnmx(anewn,mint,maxt); %还原数据y=anew';1、BP网络构建(1)生成BP网络=net newff PR S S SNl TF TF TFNl BTF BLF PF(,[1 2...],{ 1 2...},,,)PR:由R维的输入样本最小最大值构成的2R⨯维矩阵。

S S SNl:各层的神经元个数。

[ 1 2...]{ 1 2...}TF TF TFNl:各层的神经元传递函数。

BTF:训练用函数的名称。

(2)网络训练[,,,,,] (,,,,,,)=net tr Y E Pf Af train net P T Pi Ai VV TV(3)网络仿真=[,,,,] (,,,,)Y Pf Af E perf sim net P Pi Ai T{'tansig','purelin'},'trainrp'2、BP网络举例举例1、%traingdclear;clc;P=[-1 -1 2 2 4;0 5 0 5 7];T=[-1 -1 1 1 -1];%利用minmax函数求输入样本范围net = newff(minmax(P),T,[5,1],{'tansig','purelin'},'trainrp');net.trainParam.show=50;%net.trainParam.lr=0.05;net.trainParam.epochs=300;net.trainParam.goal=1e-5;[net,tr]=train(net,P,T);net.iw{1,1}%隐层权值net.b{1}%隐层阈值net.lw{2,1}%输出层权值net.b{2}%输出层阈值sim(net,P)举例2、利用三层BP神经网络来完成非线性函数的逼近任务,其中隐层神经元个数为五个。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

3.3.2 各种BP学习算法MATLAB仿真根据上面一节对BP神经网络的MATLAB设计,可以得出下面的通用的MATLAB程序段,由于各种BP学习算法采用了不同的学习函数,所以只需要更改学习函数即可。

MATLAB程序段如下:x=-4:0.01:4;y1=sin((1/2)*pi*x)+sin(pi*x);%trainlm函数可以选择替换net=newff(minmax(x),[1,15,1],{'tansig','tansig','purelin'},'trainlm');net.trainparam.epochs=2000;net.trainparam.goal=0.00001;net=train(net,x,y1);y2=sim(net,x);err=y2-y1;res=norm(err);%暂停,按任意键继续Pause%绘图,原图(蓝色光滑线)和仿真效果图(红色+号点线)plot(x,y1);hold onplot(x,y2,'r+');注意:由于各种不确定因素,可能对网络训练有不同程度的影响,产生不同的效果。

如图3-8。

标准BP算法(traingd)图3-8 标准BP算法的训练过程以及结果(原图蓝色线,仿真图+号线)增加动量法(traingdm) 如图3-9。

图3-9 增加动量法的训练过程以及结果(原图蓝色线,仿真图+号线)弹性BP算法(trainrp)如图3-10图3-10 弹性BP算法的训练过程以及结果(原图蓝色线,仿真图+号线)动量及自适应学习速率法(traingdx)如图3-11。

图3-11 动量及自适应学习速率法的训练过程以及结果(原图蓝色线,仿真图+号线)共轭梯度法(traincgf)如图3-12。

图3-12 共轭梯度法的训练过程以及结果(原图蓝色线,仿真图+号线)Levenberg-Marquardt算法(trainlm)如图3-13。

图3-13 Levenberg-Marquardt算法的训练过程以及结果(原图蓝色线,仿真图+号线)3.3.3 各种算法仿真结果比较与分析由上面的仿真结果可以得到下表的比较和下面的结论与分析:表3-2表3-2各种BP学习算法MATLAB仿真结果比较结论与分析:从仿真结果可以看出,标准BP算法、增加动量发、弹性BP算法、动量及自适应学习速率法的收敛速度都不如共轭梯度法和Levenberg-Marquardt法(L-M 算法)收敛速度明显的快。

从仿真结果和均方误差综合来看,只有L-M算法达到了目标误差,可见对高要求的误差来说,L-M算法的优势要明显的多,其余均未达到目标误差;从均方误差的效果来看,所仿真的BP算法的优劣(从优到劣)顺序依次为L-M算法、共轭梯度法、弹性BP算法、动量及自适应学习速率法、增加动量法、标准BP算法。

从仿真效果图可以看出,L-M算法的效果最好,其次是共轭梯度法,其余均有不同范围内的失真。

从误差曲线来看,L-M算法达到了目标误差(较高的误差),标准BP算法的误差曲线较粗,是因为较小范围振荡产生锯齿,在图形中由于间距加大,图形不断重叠而成,收敛速度很慢;增加动量法、弹性BP算法、动量及自适应学习速率法的误差曲线较为平滑,在刚开始收敛较快,在训练步数增加的时候,曲线趋于水平,收敛速度比较慢;共轭梯度法和L-M算法的误差曲线变化较大且产生局部锯齿状,说明不是最优,仍需要进行优化,其中L-M算法达到了目标误差。

共轭梯度法在相邻迭代的正交方向搜索,综合误差曲线可知当接近极值时会产生锯齿形振荡。

再根据前面对各种BP改进算法的描述可知,弹性BP算法不需要进行搜索,需要内存比较小,因此在一些大型网络中比较适用,但是需要很长的训练时间。

对收敛速度要求不高时也可使用动量及自适应学习速率法。

在小型网络中,共轭梯度法仅次于L-M算法,但是L-M算法需要更大的内存做临时存储,对于较大复杂的网络和内存受限的设备来说不是很好的选择,但是对于小型网络来说却是首要选择。

对训练时间允许的条件下,共轭梯度法和弹性BP算法是对复杂大型网络较好的选择。

其中共轭梯度法在训练的时候,训练次数为769次,均方误差为0.00499915,均未达到所设定的要求,产生了“Minimum step size reached, performance goal was not met”的结果。

可能意味着子区间的长度与计算机舍入误差相当,无法继续计算了,原因可能是有奇点(无限小且不实际存在),另外也存在是初值问题,理论上得知:共轭梯度法最大局限是依赖于初值,在有限的迭代次数内可能既不能搜索到全局极值也不能搜索到局部极值。

因此该算法适用于精度要求比较低的高维网络之中。

3.3.4 调整初始权值和阈值的仿真在分析了初始权值设置影响因素对BP神经网络的影响,下面首先通过MATLAB程序段一,通过随机设置权值初始化网络方式获取训练好的阈值和权值,作为MATLAB程序段二的初始化值。

由此进行仿真分析。

如图3-14。

①MATLAB程序段一:x=-4:0.01:4;y1=sin((1/2)*pi*x)+sin(pi*x);net=newff(minmax(x),[1,15,1],{'tansig','tansig','purelin'},'trainlm');net.trainparam.epochs=2000;net.trainparam.goal=0.00001;%初始化网络,用newff创建网络,其权值和阈值初始化函数的默认值是initnw。

%initnw据Nguyen-Widrow规则初始化算法对网络层的权值和阈值进行初始%化,该算法的初始化值,可以使网络层中每个神经元的作用范围近似地在%网络层的输入空间均匀分布。

与纯随机初始化权值和阈值的方法比较,%初始化算法有以下优点:神经元的浪费少(因为所有神经元都分布在输%入空间内);网络的训练速度快(因为输入空间的每一个区域都有神经%元);这里是用rands重新设置权值和阈值。

yers{1}.initFcn='initnw';yers{2}.initFcn='initnw';net.inputWeights{1,1}.initFcn='rands';net.inputWeights{2,1}.initFcn='rands';net.biases{1,1}.initFcn='rands';net.biases{2,1}.initFcn='rands';net=init(net);%查看初始化后的权值和阈值net.iw{1,1}net.b{1}net.lw{2,1}net.b{2}net=train(net,x,y1);%得出训练好的权值和阈值供MATLAB程序段二使用net.iw{1,1}net.b{1}net.lw{2,1}net.b{2}y2=sim(net,x);err=y2-y1;res=norm(err);pauseplot(x,y1);hold onplot(x,y2,'r+');②MATLAB程序段二:x=-4:0.01:4;y1=sin((1/2)*pi*x)+sin(pi*x);net=newff(minmax(x),[1,15,1],{'tansig','tansig','purelin'},'trainlm');net.trainparam.epochs=2000;net.trainparam.goal=0.00001;%从程序段一得出的数据net.iw{1,1}=-0.3740;net.b{1}=-0.1930;net.lw{2,1}=[-20.7192;19.6478;10.9678;-9.4500;21.3555;6.7648;-20.7057;-6.10 23;-9.4889;-12.7880;-15.5183;-13.9643;-21.2201;29.9987;-15.3738];net.b{2}=[21.2768;-16.9303;-7.9953;4.8688;-6.6081;-1.3465;-0.8528;-1.2791;-4 .7658;-15.4970;-9.2069;-10.5259;-20.1442;3.5287;-13.6953];net=train(net,x,y1);y2=sim(net,x);err=y2-y1;res=norm(err);pauseplot(x,y1);hold onplot(x,y2,'r+');(a) 随机设置权值误差曲线图(b)获取训练好的阈值和权值误差曲线图图3-14 两程序段运行后误差曲线图从上面的仿真结果看,第一个程序用随机的初始权值和阈值达到目标误差完成训练需要264个回合,而选用已训练好的权值和阈值仅用167个回合就完成了训练,因此选择合适的初始化权值和阈值将加速网络的训练,大大提高了学习的收敛速度。

因此关于设置网络初始权值和阈值的优化方法是一个值得研究的问题。

3.3.5 其他影响因素仿真在算法选择上,在下面的仿真中将使用L-M算法测试其他影响因素,比如通过选择不同的激活函数、修改学习步长和目标误差等观察对仿真曲线的影响程度。

如果将输入层激活函数设置为purelin,x=-4:0.1:4,epochs=1000,goal=0.001,其余不变则会产生如下结果:经过多次反复实验,有时不能达到目标误差,有时又很快达到目标误差,且仿真效果会产生不同程度的失真或有时效果很好。

如果将输入层激活函数设为tansig,则学习很快收敛且达到目标误差,仿真效果很好,且多次仿真结果比较稳定,明显要比输入层激活函数设为purelin要好。

如果将这三层神经元的激活函数都设置为tansig的话,在多次试验中,训练回合数为1000,均未达到目标误差0.001的要求。

3.4 BP神经网络在样本分类中的应用3.4.1问题的提出这是一个用BP神经网络来将不同的混合在一起的数据或者样本进行分类的例子。

利用上述研究的结果,采用15个隐层节点。

我们先自己随机的输入两个样本:%产生训练样本与测试样本,每一列为一个样本P1 = [rand(3,5),rand(3,5)+1,rand(3,5)+2];T1 = [repmat([1;0;0],1,5),repmat([0;1;0],1,5),repmat([0;0;1],1,5)];P2 = [rand(3,5),rand(3,5)+1,rand(3,5)+2];T2 = [repmat([1;0;0],1,5),repmat([0;1;0],1,5),repmat([0;0;1],1,5)];%然后再将样本归一化处理,这样有利于我们简便、准确、定量结果。