线性回归的显著性检验

线性回归的显著性检验

线性回归的显着性检验1.回归方程的显着性在实际问题的研究中,我们事先并不能断定随机变量y与变量人,乂2,…,x p之间确有线性关系,在进行回归参数的估计之前,我们用多元线性回归方程去拟合随机变量y与变量X「X2,…,X p之间的关系,只是根据一些定性分析所作的一种假设。

因此,和一元线性回归方程的显着性检验类似,在求出线性回归方程后,还需对回归方程进行显着性检验。

设随机变量丫与多个普通变量x1, x2^ ,x p的线性回归模型为其中;服从正态分布N(0,;「2)对多元线性回归方程的显着性检验就是看自变量若接受X i,X2,…,X p从整体上对随机变量y是否有明显的影响。

为此提出原假设如果H。

被接受,则表明随机变量y与x「X2,…,X p的线性回归模型就没有意义。

通过总离差平方和分解方法,可以构造对H o进行检验的统计量。

正态随机变量y i,y2/ , y n的偏差平方和可以分解为:n n nS r f (y—y)2为总的偏差平方和,S R=為(懈-y)2为回归平方和,S E f (% - ?)2为残i 1i# im差平方和。

因此,平方和分解式可以简写为:回归平方和与残差平方和分别反映了b = 0所引起的差异和随机误差的影响。

构造F检验统计量则利用分解定理得到:在正态假设下,当原假设H o :b i =0, b2 =0,…,b p =0成立时,F服从自由度为(p,n -p-1)的F分布。

对于给定的显着水平[,当F大于临界值(p, n-p-1)时,拒绝H。

,说明回归方程显着,x与y有显着的线性关系。

实际应用中,我们还可以用复相关系数来检验回归方程的显着性。

复相关系数R定义为:平方和分解式可以知道,复相关系数的取值范围为0空R乞1。

R越接近1表明S E越小,回归方程拟合越好。

2.回归系数的显着性若方程通过显着性检验,仅说明b o,b i,b2,…b p不全为零,并不意味着每个自变量对y的影响都显着,所以就需要我们对每个自变量进行显着性检验。

线性回归的显著性检验

线性回归的显着性检验1.回归方程的显着性在实际问题的研究中,我们事先并不能断定随机变量y 与变量p x x x ,,,21 之间确有线性关系,在进行回归参数的估计之前,我们用多元线性回归方程去拟合随机变量y 与变量p x x x ,,,21 之间的关系,只是根据一些定性分析所作的一种假设;因此,和一元线性回归方程的显着性检验类似,在求出线性回归方程后,还需对回归方程进行显着性检验;设随机变量Y 与多个普通变量p x x x ,,,21 的线性回归模型为其中ε服从正态分布),0(2σN对多元线性回归方程的显着性检验就是看自变量若接受p x x x ,,,21 从整体上对随机变量y 是否有明显的影响;为此提出原假设如果0H 被接受,则表明随机变量y 与p x x x ,,,21 的线性回归模型就没有意义;通过总离差平方和分解方法,可以构造对0H 进行检验的统计量;正态随机变量n y y y ,,,21 的偏差平方和可以分解为:∑=-=n i i T y y S 12)(为总的偏差平方和,∑=-=n i i R y y S 12)ˆ(为回归平方和,∑=-=n i i i E yy S 12)ˆ(为残差平方和;因此,平方和分解式可以简写为: 回归平方和与残差平方和分别反映了0≠b 所引起的差异和随机误差的影响;构造F 检验统计量则利用分解定理得到:在正态假设下,当原假设0,,0,0:210===p b b b H 成立时,F 服从自由度为)1,(--p n p 的F 分布;对于给定的显着水平α,当F 大于临界值)1,(--p n p 时,拒绝0H ,说明回归方程显着,y x 与有显着的线性关系;实际应用中,我们还可以用复相关系数来检验回归方程的显着性;复相关系数R 定义为:平方和分解式可以知道,复相关系数的取值范围为10≤≤R ;R 越接近1表明E S 越小,回归方程拟合越好;2.回归系数的显着性若方程通过显着性检验,仅说明p b b b b ,,,210不全为零,并不意味着每个自变量对y 的影响都显着,所以就需要我们对每个自变量进行显着性检验;若某个系数0=j b ,则j x 对y 影响不显着,因此我们总想从回归方程中剔除这些次要的,无关的变量;检验i x 是否显着,等于假设已知])(,[~ˆ12-'X X B N B σ,p j i c X X ij ,,2,1,0,)(1 =='-)(记,可知],[~ˆ2σijj j c b N b ,,,2,1,0p j =据此可构造t 统计量 其中回归标准差为当原假设0:0=j j b H 成立时,则j t 统计量服从自由度为1--p n 的t 分布,给定显着性水平α,当2αt t j ≥时拒绝原假设0:0=j j b H ,认为j x 对y 影响显着,当2αt t j <时,接受原假设0:0=j j b H ,认为j x 对y 影响不显着;。

多元线性回归模型的各种检验方法

多元线性回归模型的各种检验方法多元线性回归模型是常用于数据分析和预测的方法,它可以用于研究多个自变量与因变量之间的关系。

然而,仅仅使用多元线性回归模型进行参数估计是不够的,我们还需要对模型进行各种检验以确保模型的可靠性和有效性。

下面将介绍一些常用的多元线性回归模型的检验方法。

首先是模型的整体显著性检验。

在多元线性回归模型中,我们希望知道所构建的模型是否能够显著解释因变量的变异。

常见的整体显著性检验方法有F检验和显著性检查表。

F检验是通过比较回归模型的回归平方和和残差平方和的比值来对模型的整体显著性进行检验。

若F值大于一定的临界值,则可以拒绝原假设,即模型具有整体显著性。

通常,临界值是根据置信水平和自由度来确定的。

显著性检查表是一种常用的汇总表格,它可以提供关于回归模型的显著性水平、标准误差、置信区间和显著性因素的信息。

通过查找显著性检查表,我们可以评估模型的显著性。

其次是模型的参数估计检验。

在多元线性回归模型中,我们希望知道每个自变量对因变量的影响是否显著。

通常使用t检验来对模型的参数估计进行检验。

t检验是通过对模型的回归系数进行检验来评估自变量的影响是否显著。

与F检验类似,t检验也是基于假设检验原理,通过比较t值和临界值来决定是否拒绝原假设。

通常,临界值可以通过t分布表或计算机软件来获取。

另外,我们还可以使用相关系数来评估模型的拟合程度。

相关系数可以用来衡量自变量与因变量之间的线性关系强度,常见的相关系数包括Pearson相关系数和Spearman相关系数。

Pearson相关系数适用于自变量和因变量都是连续变量的情况,它衡量的是两个变量之间的线性关系强度。

取值范围为-1到1,绝对值越接近1表示关系越强。

Spearman相关系数适用于自变量和因变量至少有一个是有序变量或者都是有序变量的情况,它衡量的是两个变量之间的单调关系强度。

取值范围也是-1到1,绝对值越接近1表示关系越强。

最后,我们还可以使用残差分析来评估模型的拟合程度和误差分布。

回归方程及回归系数的显著性检验

§ 3回归方程及回归系数的显著性检验1、回归方程的显著性检验(1)回归平方和与剩余平方和建立回归方程以后,回归效果如何呢?因变量丿与自变量旳=乜严\茂更是否确实存在线性关系呢?这是需要进行统计检验才能加以肯定或否定,为此,我们要进一步研究因变量丿取值的变化规律。

丿的每次取值找优■1,2严诃)是有波动的,这种波动常称为变差,每次观测值的变差大小,常用该次观侧值戸=』^^与觅次观测值的平均值” j 的差丿鸟-P(称为离差)来表示,而全部n次观测值的总变差可由总的离差平方和3护=另0丘-』卩=2。

氐-A?十刀庆-/PJU1 JU1其中:31 称为回归平方和,是回归值丿化与均值7之差的平方和,它反映了自变量xwr的变化所引起的丿的波动,其自由度f戸-E (帆为自变量的个数)。

Z 称为剩余平方和(或称残差平方和),是实测值丿代与回归值之差的平方和,它是由试验误差及其它因素引起的,其自由度巾。

总的离差平方和g邓的自由度为播-1。

如果观测值给定,则总的离差平方和'a是确定的,即2+B是确定的,因此^大则e小,反之,卩小则2大,所以了与e都可用来衡量回归效果,且回归平方和*^越大则线性回归效果越显著,或者说剩余平方和2越小回归效果越显著,如果E = 0,则回归超平面过所有观测点;如果2大,则线性回归效果不好。

(2)复相关系数为检验总的回归效果,人们也常引用无量纲指标V 氏刃,(3.2)丘称为复相关系数。

因为回归平方和实际上是反映回归方程中全部自变量的“方差贡献”,因此丘2就是这种贡献在总回归平方和中所占的比例,因此丘表示全部自变量与因变量丿的相关程度。

显然0<丘<1。

复相关系数越接近1 ,回归效果就越好,因此它可以作为检验总的回归效果的一个指标。

但应注意回归方程中自变量的个数闻及观测组数n有关,当?2相对于m并不很大时,常有较大的兄值,因此实际计算中应注意揪与N的适当比例,一般认为应取n至少为rn的5到10倍为宜。

回归方程和回归系数的显著性检验

§3 回归方程及回归系数的显著性检验1、回归方程的显著性检验(1) 回归平方和与剩余平方和建立回归方程以后, 回归效果如何呢因变量与自变量是否确实存在线性关系呢这是需要进行统计检验才能加以肯定或否定, 为此, 我们要进一步研究因变量取值的变化规律。

的每次取值是有波动的, 这种波动常称为变差, 每次观测值的变差大小, 常用该次观侧值与次观测值的平均值的差(称为离差)来表示, 而全部次观测值的总变差可由总的离差平方和,其中:称为回归平方和, 是回归值与均值之差的平方和, 它反映了自变量的变化所引起的的波动, 其自由度(为自变量的个数)。

称为剩余平方和(或称残差平方和), 是实测值与回归值之差的平方和, 它是由试验误差及其它因素引起的, 其自由度。

总的离差平方和的自由度为。

如果观测值给定, 则总的离差平方和是确定的, 即是确定的, 因此大则小, 反之, 小则大, 所以与都可用来衡量回归效果, 且回归平方和越大则线性回归效果越显著, 或者说剩余平方和越小回归效果越显著, 如果=0, 则回归超平面过所有观测点; 如果大, 则线性回归效果不好。

(2) 复相关系数为检验总的回归效果, 人们也常引用无量纲指标,或,称为复相关系数。

因为回归平方和实际上是反映回归方程中全部自变量的“方差贡献”, 因此就是这种贡献在总回归平方和中所占的比例, 因此表示全部自变量与因变量的相关程度。

显然。

复相关系数越接近1, 回归效果就越好, 因此它可以作为检验总的回归效果的一个指标。

但应注意, 与回归方程中自变量的个数及观测组数有关, 当相对于并不很大时, 常有较大的值, 因此实际计算中应注意与的适当比例, 一般认为应取至少为的5到10倍为宜。

(3) 检验要检验与是否存在线性关系, 就是要检验假设,当假设成立时, 则与无线性关系, 否则认为线性关系显著。

检验假设应用统计量,这是两个方差之比, 它服从自由度为及的分布, 即,用此统计量可检验回归的总体效果。

线性回归的显著性检验

线性回归的显着性检验1.回归方程的显着性在实际问题的研究中,我们事先并不能断定随机变量y与变量x1,x2/ ,x p之间确有线性关系,在进行回归参数的估计之前,我们用多元线性回归方程去拟合随机变量y与变量人〃2,…,X p之间的关系,只是根据一些定性分析所作的一种假设。

因此,和一元线性回归方程的显着性检验类似,在求出线性回归方程后,还需对回归方程进行显着性检验。

设随机变量丫与多个普通变量X j,X2,…,X p的线性回归模型为其中;服从正态分布N(o,;「2)对多元线性回归方程的显着性检验就是看自变量若接受X i, X2,…,X p从整体上对随机变量y是否有明显的影响。

为此提出原假设如果H。

被接受,则表明随机变量y与X i,X2,…,X p的线性回归模型就没有意义。

通过总离差平方和分解方法,可以构造对H o进行检验的统计量。

正态随机变量y i, y2/ , y n的偏差平方和可以分解为:n n nS r八(y i -y)2为总的偏差平方和,S R八(场-y)2为回归平方和,S E八(y i-?)2为残i 1i £i A差平方和。

因此,平方和分解式可以简写为:回归平方和与残差平方和分别反映了 b = 0所引起的差异和随机误差的影响。

构造F检验统计量则利用分解定理得到:在正态假设下,当原假设H°:b1 =0, d =0,…,b p =0成立时,F服从自由度为(p,n - p「1)的F 分布。

对于给定的显着水平[,当F大于临界值(p, n-p-1)时,拒绝H。

,说明回归方程显着,x与y有显着的线性关系。

R定义实际应用中,我们还可以用复相关系数来检验回归方程的显着性。

复相关系数为:平方和分解式可以知道,复相关系数的取值范围为O^R^I。

R越接近1表明S E越小,回归方程拟合越好。

2•回归系数的显着性若方程通过显着性检验,仅说明bog,b2,…b p不全为零,并不意味着每个自变量对y的影响都显着,所以就需要我们对每个自变量进行显着性检验。

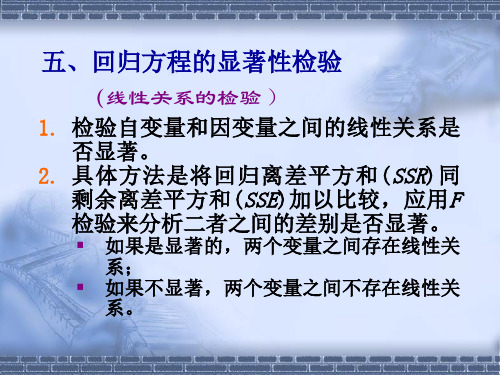

回归方程的显著性检验线性关系的检验

回归系数的显著性检验

(实例)

对前例的回归系数进行显著性检验(=0.05):

1.提出假设

H0:1 = 0 人均收入与人均消费之间无线性关系; H1:1 0 人均收入与人均消费之间有线性关系。

2.计算检验的统计量

3. 收t=入65与.07人58均>t消费=2之20间1,有拒线绝性H关0系,。表明人均

{y1 = 0 1 x11 x12 px1p 1 y2= 0 1 x21 x22 px2p …… yn= 0 1 xn1 xn2 pxnp n

多元线性回归模型

(基本假定)

1. 自变量 x1,x2,…,xp是确定性变量,不是随机变量。 2. 随机误差项ε的期望值为0,且方差σ2 都相同。 3. 误差项ε是一个服从正态分布的随机变量 ,即

3. 图像

1 =1

=-1 <-1

0< < 1

-1< <0

非线性模型及其线性化方法

双曲线函数

1. 基本形式: 2. 线性化方法

令:y' = 1/y,x'= 1/x, 则有y' = + x'

3. 图像

<0

>0

非线性模型及其线性化方法

对数函数

1. 基本形式: 2. 线性化方法

废品率与生产率的关系

生产率(周/单位) x

1000

2000

3000 3500 4000 4500 5000

废品率(%) y

5.2 6.5 6.8 8.1 10.2 10.3 13.0

非线性回归

(实例) 生产率与废品率的散点图

16

·Ï

从统计学看线性回归(2)——一元线性回归方程的显著性检验

从统计学看线性回归(2)——⼀元线性回归⽅程的显著性检验⽬录1. σ2 的估计2. 回归⽅程的显著性检验 t 检验(回归系数的检验) F 检验(回归⽅程的检验) 相关系数的显著性检验 样本决定系数 三种检验的关系⼀、σ2 的估计 因为假设检验以及构造与回归模型有关的区间估计都需要σ2的估计量,所以先对σ2作估计。

通过残差平⽅和(误差平⽅和)(1)(⽤到和,其中)⼜∵(2)∴(3)其中为响应变量观测值的校正平⽅和。

残差平⽅和有n-2 个⾃由度,因为两个⾃由度与得到的估计值与相关。

(4)(公式(4)在《线性回归分析导论》附录C.3有证明)∴σ2的⽆偏估计量:(5)为残差均⽅,的平⽅根称为回归标准误差,与响应变量y 具有相同的单位。

因为σ2取决于残差平⽅和,所以任何对模型误差假设的违背或对模型形式的误设都可能严重破坏σ2的估计值的实⽤性。

因为由回归模型残差算得,称σ2的估计值是模型依赖的。

⼆、回归⽅程的显著性检验 ⽬的:检验是否真正描述了变量 y 与 x 之间的统计规律性。

假设:正态性假设(⽅便检验计算)1. t 检验 ⽤t 检验来检验回归系数的显著性。

采⽤的假设如下:原假设 H0:β1 = 0 (x 与 y 不存在线性关系)对⽴假设 H1:β1 ≠ 0 回归系数的显著性检验就是要检验⾃变量 x 对因变量 y 的影响程度是否显著。

下⾯我们分析接受和拒绝原假设的意义。

(1)接受 H0:β1 = 0 (x 与 y 不存在线性关系) 此时有两种情况,⼀种是⽆论 x 取值如何, y 都在⼀条⽔平线上下波动,即,如下图1,另⼀种情况为, x 与 y 之间存在关系,但不是线性关系,如图2。

图 1图 2 (2)拒绝 H0:β1 = 0 (x 对解释 y 的⽅差是有⽤的) 拒绝原假设也有两种情况,⼀种是直线模型就是合适的,如图 3,另⼀种情况为存在 x 对 y 的线性影响,也可通过 x 的⾼阶多项式得到更好的结果,如图 4。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

线性回归的显着性检验

1.回归方程的显着性

在实际问题的研究中,我们事先并不能断定随机变量y 与变量p x x x ,,,21 之间确有线性关系,在进行回归参数的估计之前,我们用多元线性回归方程去拟合随机变量y 与变量p x x x ,,,21 之间的关系,只是根据一些定性分析所作的一种假

设。

因此,和一元线性回归方程的显着性检验类似,在求出线性回归方程后,还需对回归方程进行显着性检验。

设随机变量Y 与多个普通变量p x x x ,,,21 的线性回归模型为

其中 服从正态分布),0(2 N

对多元线性回归方程的显着性检验就是看自变量若接受p x x x ,,,21 从整体

上对随机变量y 是否有明显的影响。

为此提出原假设

如果0H 被接受,则表明随机变量y 与p x x x ,,,21 的线性回归模型就没有意义。

通过总离差平方和分解方法,可以构造对0H 进行检验的统计量。

正态随机变量n y y y ,,,21 的偏差平方和可以分解为:

n i i T y y S 1

2

)(为总的偏差平方和, n i i R y y S 12)ˆ(为回归平方和, n i i i E y

y S 1

2)ˆ(为残差平方和。

因此,平方和分解式可以简写为: 回归平方和与残差平方和分别反映了0 b 所引起的差异和随机误差的影响。

构造F 检验统计量则利用分解定理得到:

在正态假设下,当原假设0,,0,0:210 p b b b H 成立时,F 服从自由度为)1,( p n p 的F 分布。

对于给定的显着水平 ,当F 大于临界值)1,( p n p 时,拒绝0H ,说明回归方程显着,y x 与有显着的线性关系。

实际应用中,我们还可以用复相关系数来检验回归方程的显着性。

复相关系数R 定义为:

平方和分解式可以知道,复相关系数的取值范围为10 R 。

R 越接近1表明E S 越小,回归方程拟合越好。

2.回归系数的显着性

若方程通过显着性检验,仅说明p b b b b ,,,210不全为零,并不意味着每个自变量对y 的影响都显着,所以就需要我们对每个自变量进行显着性检验。

若某个系数0 j b ,则j x 对y 影响不显着,因此我们总想从回归方程中剔除这些次要的,无关的变量。

检验i x 是否显着,等于假设

已知])(,[~ˆ12 X X B N B ,p j i c X X ij ,,2,1,0,)(1 )(记,可知],[~ˆ2 ij

j j c b N b ,,,2,1,0p j 据此可构造t 统计量 其中回归标准差为

当原假设0:0 j j b H 成立时,则j t 统计量服从自由度为1 p n 的t 分布,给定显着性水平 ,当2 t t j 时拒绝原假设0:0 j j b H ,认为j x 对y 影响显着,当2 t t j 时,接受原假设0:0 j j b H ,认为j x 对y 影响不显着。