IBM虚拟化基本概念(1)---设计

虚拟化技术应用与实践01

1.4 服务虚拟化概述

通过服务器虚拟化技术,用户可以动 态启用虚拟服务器(又叫虚拟机)。服务 器可以让操作系统(以及在上面运行的任 何应用程序)误以为虚拟机就是实际硬件。 运行多个虚拟机还可以充分发挥物理服务 器的计算潜能,迅速应对数据中心不断变 化的需求。在数据中心部署虚拟化技术可 以减少物理服务器的购买成本。

虚拟化技术应用与实践

第1章 虚拟化技术基础知识

虚拟化是当今热门技术云计算的核心技术之一,它可以实现IT资源弹性分配,使IT资源分 配更加灵活,能更弹性地满足多样化的应用需求。本章将为读者介绍虚拟化技术的基础知识。

1 虚拟化定义

2 服务器虚拟化和桌面虚拟化技术概述

3 虚拟化的发展前景

教学重点

4 虚拟化厂家及产品 5 云计算概述及其与虚拟化的关系

1.1 虚拟化定义

虚 拟 化 ( Virtualization ) 可 将 信 息 系 统 的各种物理资源(如服务器、网络、存储等) 进行抽象、转换后呈现出来,打破现实结构 件的不可切割的障碍,使用户可以更好地应 用这些资源。这些新虚拟出来的资源不受现 有资源的架设方式、地域或物理配置所限制。

虚拟化技术是一种调配计算资源的方法, 它将不同层面的硬件、软件、数据、网络、 储存一一隔离开来,使改动更易被实施,其 带来的结果是简化了管理,用户能更有效地 利用IT资源。

桌面虚拟化的演进

1.5.2 客户端/服务器(C/S)模式

自20世纪90年代开始,特别是随着Windows操作系统和以太网网络通信的流行,PC开始普 及,越来越多的企业选用PC作为用户的终端设备,并使用客户端/服务器(C/S)模式的架构来搭 建用户的应用系统。

在此期间,微软发布了Windows NT Server 4.0 TSE操作系统产品 (Terminal Server Edition,终端服务 版本的服务器操作系统),并提出了多 用户(Multi-User)的概念,首次将图 形化终端服务技术集成到服务器版本的 Windows操作系统之中。同时,数以千 计的应用程序被用于满足百万用户的业 务需求,数据仓库的构建使C/S模式更壮 大。

IBM服务器虚拟化PowerVM介绍

IBM Cloud Infrastructure(云架构 ) 之 “服务器虚拟化 PowerVM”云架构 L3 级课程© Copyright IBM Corporation 2010L3级课程云架构“PowerCloud 之虚拟化 PowerVM” 内容安排ØPowerVM 虚拟化概述 ØPowerVM 虚拟化技术特点 ØPowerVM 高级虚拟化(LPM,AMS) ØPowerVM 虚拟化优势Page 2L3级课程云架构PowerVM 虚拟化概述Page 3L3级课程云架构IBM 虚拟化的领导者A 40+ year tradition continues with PowerVM™1967IBM develops hypervisor that would become VM on the mainframe1973IBM announces first machines to do physical partitioning1987IBM announces LPAR on the mainframe1999IBM announces LPAR on POWER™2004IBM intro’s POWER Hypervisor™ for System p™ and System i™200720082009IBM announces POWER6™, the first UNIX® servers with Live Partition MobilityIBM announces PowerVMPowerVM is the leading virtualization platform for UNIX, IBM i and Linux® clientsü üUnify virtualization branding & technology for AIX®, i and Linux Exploit 40 years of IBM virtualization leadershipPage 4L3级课程云架构什么是 PowerVM?为IBM Power系统提供基于AIX, i, Linux操作系统的业界领先的统一虚拟化平台PowerVM 提供如下功能: 微分区 虚拟 I/O 服务器 集成虚拟化管理器 活动分区迁移 主动内存共享 Lx86 SupportMicro-Partitioning™ SubsystemsWorkload Partitions Live Application Mobility动态逻辑分区Page 5L3级课程云架构PowerVM虚拟化架构工作负载管理和控制AIX Partitions 分区 硬件 管理 控制台Linux Partitions 分区i5/OS i Partitions 分区虚拟 I/O 服务器 虚拟 适配器 虚拟 磁盘Unassigned 没有分配的 On Demand 随需应变的 Resources 资源POWER Hypervisor 固件 POWER 服务器 硬件 服务 子系统虚拟网络 虚拟处理器 处理器 内存 I/O 扩展槽 本地设备和存储 虚拟内存网络和网络存储Page 6L3级课程云架构PowerVM 的三种版本ExpressPowerVM 版本Standard JS12/22/23/43 Power560/570/ 770*/595/780 10 per core (up to 1000) VMControl IVM, HMC ü Enterprise JS12/22/23/43 Power560/570/ 770/595*/780* 10 per core (up to 1000) VMControl IVM, HMC ü ü ü System i*, System p* ü AIX / Linux / i ü ü AIX / Linux / i ü System i*, System p* ü AIX / Linux / i üPowerVM 提供如下功能: 微分区 虚拟 I/O 服务器服务器Power 520/550/750 PS700/701* 2 per server + VIOS VMControl IVM ü最大分区数 管理平台集成虚拟化管理器 活动分区迁移 Lx86 量身定制虚拟IO服务器 分区在线迁移 动态内存共享 多CPU共享池 共享专有分区 客户分区支持 Lx86Multiple Shared Processor Pools are supported by POWER6 and HMC managed environments Live Partition Mobility works with AIX V5.3 and above and Linux on POWERPage 7* POWER6 processor-based servers onlyL3级课程云架构PowerVM的功能与PowerVM版本,处理器以及操作系统的兼容性Feature LPAR Licensed by All Editions (limited on Express) Processor support POWER4,5 and 6 Operating System supporta AIX 5.3 and 6.1 SLES 9, 10 for POWER (not POWER4) RHEL 4, 5 for POWER (not POWER4 AIX 5.3 and 6.1 SLES 9, 10 for POWER RHEL 4, 5 for POWER (5.1 for POWER6) AIX 5.3 and 6.1 SLES 9, 10 for POWER RHEL 4, 5 for POWER AIX 5.3 and 6.1 SLES 10 update 1 for POWER RHEL 5.1 for POWER AIX 5.3 and 6.1 SLES 10 for POWER6 RHEL 5.1 for POWER6 Virtual I/O Server Integrated Virtualization Manager AIX 5.3 and 6.1 SLES 10 for POWER RHEL 4, 5, 5.1 for POWER AIX 5.3 and 6.1 SLES 9 for POWER (10 for POWER6) RHEL 4, 5 for POWER (5.1 for POWER6) AIX 6.1 AIX 6.1 TL3 No AIX 5.3 support SUSE Linux Enterprise Server 11 IBM i 6.1 plus PTF SI32798 AIX 5.3 and 6.1 SLES 10 update 1 for POWER RHEL 5.1 for POWERCapacity Upgrade on DemandAll Editions (specific models)POWER4, 5 and 6Micro-PartitioningAll EditionsPOWER5 and 6Shared Dedicated CapacityAll EditionsPOWER6Multiple Shared Processor Pools Virtual I/O Server IVM Virtual SCSIPowerVM SE and EE All Editions PowerVM Express, SE and EE All EditionsPOWER6 with HMC POWER5 and 6 POWER5 and 6 POWER5 and 6Virtual EthernetAll EditionsPOWER5 and 6 POWER4, 5 and 6Workload Partitions (WPARs)Workload Partitions managerActive memory sharingPowerVM Enterprise EditionPOWER6Live Partition Page Mobility 8PowerVM Enterprise EditionPOWER6L3级课程云架构PowerVM 虚拟化技术特点Page 9L3级课程云架构PowerVM 技术特点概览灵活动态逻辑分区/微分区/WPAR Shared Dedicated Processor1 1 CPU CPU Virtual I/O server Virtual I/O server partition partitionIVM IVM Storage sharing Storage sharing Ethernet sharing Ethernet sharingLive Partition Mobility / Live Application Mobility 分区迁移 / 应用迁移4 4 CPUs CPUs4 4 CPU CPU1 1 CPUs CPUs4 4 CPUs CPUsLinux LinuxLinux LinuxAIX AIXAIX AIXAIX AIX22Hypervisor HypervisorVirtual I/O paths Virtual I/O pathsAIX AIXAIX AIXApp1 App2 3App3 App1 App2 App336 6 CPUs CPUs Micro-Partitioning Micro-PartitioningApp4 App4VIOS Virtual SCSI/FC/Ethernet SupportActive Memory Sharing 活动内存共享x86 Linux的支持IBM Systems Director VMControl 简化IT操作/降低成本Page 10A I X 5L V 5.3Dedicated processor partition (LPar)2 CPUsAIX 5L V5.3LinuxAIX6V6.1VIOS IVMIntegrated Virtualization ManagerIntegrated Virtualization MgrP P P Dedicated / SharedDedicatedProcessorsPlanned Dedicated Shared ProcessorsDonation option enabled, a dedicated partition donates its excesscycles to the uncapped partitions. Unused processor cycles are utilized.提高系统使用率Dedicated CoreShared Core2 partitions§Uncapped§Evenly weighted1 partitionTwo evenly weighted 1-way uncapped partitions ( 100% Utilized )Unused processor cycles in dedicated partition are wasted usedoverL3级课程云架构专用和共享资源的转换Development/Test/QA DB-Server ProductionDB-Server Test 1 Test 2 Permantenly load balancing within the shared poolApp 1App 2App 3Shared Pool Move dedicated resources to the shared poolDynamic movement of resources from/to dedicated LPARsPage 21QAL3级课程云架构虚拟I/O服务器虚拟 I/O服务器* AIX 或 Linux AIX 或 Linux 虚拟 I/O服务器*虚拟 SCSI 功能虚拟以太网功 能以太网FC以太网BB’虚拟以太网功 能虚拟 SCSI 功能Hypervisor以太网 B A 以太网 B’Ø 虚拟I/O架构l lØ 优势l l虚拟及/或物理设备的组合 支持多个VIO服务器*减少适配器、I/O抽屉和端口数量 加快部署速度Ø 虚拟SCSIl l lØ 虚拟以太网l l l虚拟 SCSI、光纤通道和DVD 逻辑和物理卷虚拟磁盘 多路径和冗余选项VLAN和链路汇聚支持 LPAR之间的虚拟局域网 高可用性选项* 通过PowerVM特性在Power Systems上提供。

虚拟化技术简述

虚拟化技术简述作者:谢永坚来源:《科学与财富》2016年第13期近年来随着云计算的广泛应用,虚拟化技术在商业上的价值日益体现,不仅可以降低硬件成本,简化集群系统的管理,而且还可以增强了系统安全性和可靠性,虚拟化的概念也开始逐渐被大众提及。

本文将简要介绍以下虚拟化的概念与分类,然后介绍相应的几种虚拟化产品。

1 .虚拟化的概念与分类虚拟化(Virtualization)是一种资源管理技术,是将计算机的各种实体资源,如服务器、网络、内存及存储等,予以抽象、转换后呈现出来,打破实体结构间的不可切割的障碍,以用户定制的组态(虚拟机)来使用这些资源。

这些资源的新虚拟部份是不受现有资源的架设方式,地域或物理组态所限制。

一般所指的虚拟化资源包括计算能力和资料存储。

虚拟化技术最早出现在20世纪60年代的IBM大型机系统中,并在70年代的System 370系列中逐渐流行。

虚拟化技术主要分为两个大类:(1)软件虚拟化,主要包括桌面,数据库,应用程序等指令代码的仿真、模拟。

解释等技术。

通常意义上的虚拟化指的是针对平台硬件与操作系统的虚拟化(PV)。

通过使用超级核(Hypervisor)或虚拟机监视器(Virtual Machine Monitor)隐藏计算平台实际的物理特性,提供抽像、统一、模拟的计算环境(虚拟机)。

在虚拟机上运行的操作系统被称为客户机操作系统(Guest OS),运行虚拟机监控器的操作系统被称为主机操作系统(Host OS),当然某些虚拟机监控器可以脱离操作系统直接运行在硬件之上(如 VMWARE 的 ESX 产品),运行虚拟机的真实系统我们称之为主机系统。

VMM/Hypervisor需要为每个虚拟机分配一套数据结构来管理它们的状态,包括虚拟处理器的全套寄存器,物理内存的使用情况,虚拟设备的状态等等。

由于将虚拟机的状态保存带对应的数据文件之中,因此,迁移相应的虚拟机只需要拷贝对应的数据文件到另一主机系统上启动即可。

虚拟化技术 ppt课件

7.虚拟化技术

云计算技术

数据

中心

规模不断增大 成本逐渐上升 管理日趋复杂

云计算

6/82

7.1 虚拟化技术简介 虚拟化技术简介

传统的数据中心

7.虚拟化技术

采用了多种技术 业务之间孤立

网络结构复杂

虚拟数据中心

高速

扁平

虚拟化

云计算

7/82

7.1 虚拟化技术简介 虚拟化技术简介

7.虚拟化技术

数据中心

服务器虚拟化

应用程序的代码运行在最低运行级别上ring3上,不能做受控操作。如果要做,那就要 通过执行系统调用(函数),执行的时候,CPU的运行级别会发生从ring3到ring0的 切换,并跳转到系统调用对应的内核代码位置执行,这样内核就为你完成了设备访问, 完成之后再从ring0返回ring3。这个过程也称作用户态和内核态的切换。

服务器虚拟化 存储虚拟化 网络虚拟化 桌面虚拟化

云计算

4/82

20世纪60年代

IBM公司推出虚拟化技术

主要用于当时的IBM大型机的服务器虚拟化

虚拟化技术的核心思想是利用软件或固件管理程序构成虚拟化层,把 物理资源映射为虚拟资源。在虚拟资源上可以安装和部署多个虚拟机, 实现多用户共享物理资源。

7.1 虚拟化技术简介 虚拟化技术简介

云计算

19/82

硬件辅助的全虚拟化

7.虚拟化技术

2005年后,CPU厂商Intel 和 AMD 开始支持虚拟化了。 Intel 引入了 Intel-VT 技术。

主机操作系统

物理机(底层硬件)

图7-1 寄居虚拟化架构

云计算

12/82

7.2 服务器虚拟化

服务器虚拟化的层次

虚拟化技术ppt课件

网络上在线迁移,容错 安全:隔离,访问审计,法规遵从,防病毒,入

侵防范,数据备份,远程容灾

14/10

服务器虚拟化软件

VMware:vSphere ESXi,vCenter,Server, Workstation

远程桌面、无盘站、还原卡、影子系统、瘦客户机

16/10

虚拟桌面拓扑图

17/10

桌面虚拟化软件

Microsoft:远程桌面(RDP),Hyper-V VMware:View(ICA),vSphere ESXi Citrix:XenDesktop(PCoIP),XenServer

18/10

4、存储虚拟化

一块物理网卡虚拟出多块虚拟网卡(VFA网卡,每端口1-4 个 vNIC)

26/10

谢谢!

27/10

6/10

2、服务器虚拟化

硬件体系结构

(hypervisor)虚拟化层 硬件体系结构

7/10

服务器虚拟化-资源共享

虚拟化层

8/10

服务器虚拟化

将单台物理服务器虚拟出多台相互隔离虚拟服务 器

将多台物理服务器资源进行整合,提供资源动态 调配

对所有物理资源进虚拟资源进行统一、集中管理 提供统一的高可用、系统安全、数据备份解决方

2/10

什么是“虚拟化技术”

屏蔽同一类物理设备的专有特性 将处理后相同特性的物理设备进行资源整合 将整合的资源虚拟出多个类似的虚拟设备 对物理设备、虚拟设备进行统一管理

3/10

现有的虚拟化技术-磁盘阵列存储

多块相同特性的物理硬盘 通过RAID技术变成一块RAID盘 硬盘整合,提高容量、性能,提供数据保护 一个RAID盘划分成一个逻辑盘分配给一台主机 一个RAID盘划分成多个逻辑盘分配给多台主机使用 对存储空间、连接主机进行集中管理

虚拟化基本概念(综述)

虚拟化基本概念1虚拟化技术起源随着云计算的日益普及,虚拟化技术突然变得重要起来。

事实上,云计算中的IaaS(Infrastructure as a service)本质上就是计算资源的池化或者虚拟化,简而言之虚拟化技术是构建云计算数据中心的基础。

但是,虚拟化技术并非是随着云计算的概念而诞生的,从时间来看虚拟化技术最早可追溯到上世纪60年代。

当时IBM的大型机上已经使用了虚拟化技术,其目的也跟今日基本一致:允许多租户复用同一物理计算资源。

这一时期可称为虚拟化技术的萌芽阶段。

早期计算机硬件是相当昂贵的基础设施,注定不可能为个人所拥有,虚拟化技术能显著地提高计算资源使用效率,因此在大型机时代得到了青睐;随着半导体技术遵循摩尔定律快速发展,计算机的价格也慢慢地平民化,“旧时王谢堂前燕,飞入寻常百姓家”,PC机的私人属性注定了资源复用这一特性不再是什么优点。

虚拟化技术进入低潮期。

虚拟化技术的复归,其实走了一条相当漫长的路,推动虚拟化技术从新繁荣的因素有很多,但最决定性的因素还是以下两点:a)半导体技术的发展。

当摩尔定律每18个月翻番的规律持续奏效的时候,我们知道这一定律迟早会终结。

但在摩尔定律尚未完全触碰到硅技术的物理极限前,单芯片的性能已经强大到过剩了,换言之安迪-比尔定律里的比尔,已经无法完全吃掉安迪提供的性能了。

b)能源网络等助攻因素。

相比半导体技术的飞速发展,电池技术的发展可以用龟速来形容。

而能源危机的阴影也时刻笼罩着这个世界,节能已经成了科技界的主旋律。

从能耗的管理来说,集约式地管理方式显然比各自为政式的管理更为高效。

而随着网络技术的快速发展,低功耗终端设备+大规模云计算的模式成为了可能(更愿意称之为数据中心计算)。

1959年,计算机科学家Christopher Strachey发表了一篇名为《大型高速计算机中的时间共享》(Time Sharing in Large Fast Computers)的学术报告,他在文中首次提出了虚拟化的基本概念,被认为是虚拟化技术的最早论述。

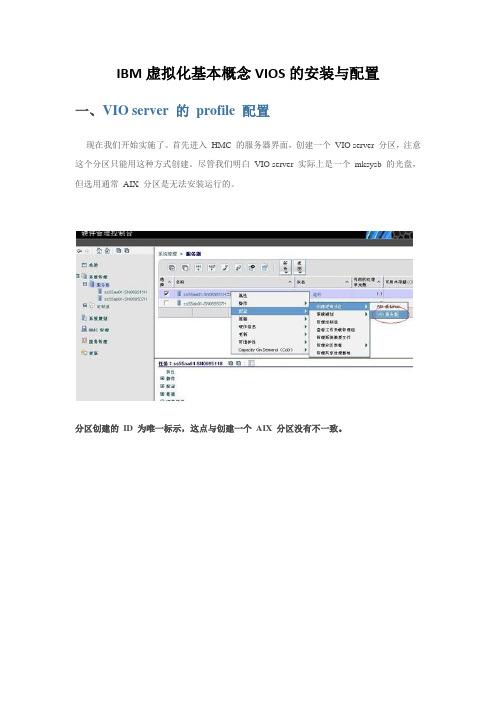

IBM虚拟化基本概念VIOS的安装与配置

IBM虚拟化基本概念VIOS的安装与配置一、VIO server 的profile 配置现在我们开始实施了。

首先进入HMC 的服务器界面,创建一个VIO server 分区,注意这个分区只能用这种方式创建。

尽管我们明白VIO server 实际上是一个mksysb 的光盘,但选用通常AIX 分区是无法安装运行的。

分区创建的ID 为唯一标示,这点与创建一个AIX 分区没有不一致。

如前所述,考虑到为实验室环境,因此这里设为共享,而非专用。

按设计实施,设置CPU 各个值。

按设计,实施内存值。

这里将所有设备加入VIO Server, 包含CD ROM,但记住安装完成后去除T16 的IDE CD ROM。

实际安装时能够根据设计来不一致实施。

下面开始配置VIO SERVER 的特殊部分,首先将最大适配器数调到500,便于增加虚拟网卡与存储卡,缺省值远远不够。

我们先来配置需共享的网卡:按设计配置第一块需共享的虚拟网卡同样增加其他虚拟网卡,此处11、12、13、14 共 4 块下面增加虚拟SCSI 存储卡增加第一块卡同样一直增加到202 虚拟存储卡,共增加20 块。

这里只设计20 个adapter,但建议能够设计更多,由于事后添加需要重起VIO server。

跟着安装向导,设置为正常启动,以免启动停留在SMS 菜单。

当然事后也能够修改。

能够点击全面信息确认配置建立完成,如今再逐一确认一下CPU 设置确认内存配置确认设备确认虚拟网卡确认虚拟SCSI 卡确认开启确认二、VIO server 的安装注:由于下列此处文档事后所补,因此截图中分区名称有所区别,供参考示意。

开始激活该分区(之前请记得把VIO server 的安装光盘放入光驱):选择profile,开启终端窗口开始启动按 5 进入SMS 菜单,选择CD-ROM 启动安装接下来实际就是一个mksysb 的恢复过程。

安装完毕就会自动重起三、VIO server 配置--- 微分区的共享资源设置VIO server 为有限制的AIX 操作系统,不同意root 登录,用户名为padmin,缺省口令无。

虚拟化概念、目的、解决方案、维护、模式、评估

虚拟化目录虚拟化 (1)一、基本概念 (1)二、虚拟化的目的 (2)三、解决方案 (3)四、软件 (4)五、厂商 (7)六、虚拟化方案比较 (8)七、维护 (8)八、模式 (9)八、评估 (10)一、基本概念虚拟化[1]是一个广义的术语,是指计算元件在虚拟的基础上而不是真实的基础上运行,是一个为了简化管理,优化资源的解决方案。

如同空旷、通透的写字楼,整个楼层几乎看不到墙壁,用户可以用同样的成本构建出更加自主适用的办公空间,进而节省成本,发挥空间最大利用率。

这种把有限的固定的资源根据不同需求进行重新规划以达到最大利用率的思路,在IT领域就叫做虚拟化技术。

虚拟化技术可以扩大硬件的容量,简化软件的重新配置过程。

CPU的虚拟化技术可以单CPU模拟多CPU并行,允许一个平台同时运行多个操作系统,并且应用程序都可以在相互独立的空间内运行而互不影响,从而显著提高计算机的工作效率。

虚拟化技术与多任务以及超线程技术是完全不同的。

多任务是指在一个操作系统中多个程序同时并行运行,而在虚拟化技术中,则可以同时运行多个操作系统,而且每一个操作系统中都有多个程序运行,每一个操作系统都运行在一个虚拟的CPU或者是虚拟主机上;而超线程技术只是单CPU模拟双CPU来平衡程序运行性能,这两个模拟出来的CPU是不能分离的,只能协同工作。

虚拟化技术也与VMware Workstation等同样能达到虚拟效果的软件不同,是一个巨大的技术进步,具体表现在减少软件虚拟机相关开销和支持更广泛的操作系统方面。

虚拟化技术有很多定义,下面就给出了一些这样的定义。

“虚拟化是以某种用户和应用程序都可以很容易从中获益的方式来表示计算机资源的过程,而不是根据这些资源的实现、地理位置或物理包装的专有方式来表示它们。

换句话说,它为数据、计算能力、存储资源以及其他资源提供了一个逻辑视图,而不是物理视图。

” —— Jonathan Eunice, Illuminata Inc。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

IBM虚拟化基本概念(1)---设计前言为什么服务器需要虚拟化可以有效控制服务器数量,提高资源利用率。

利用IBM 的PowerVM 技术,我们实现了 1 台p570 划分20 个分区,如果实际购买机器,至少需要20 台p510。

节能减排,降低投资.显而易见,服务器虚拟化可以省电省散热省空间,大量减少PCI 卡等等投资。

拿宝信实验室举例,1 台p55A 能顶掉原来10 台p52A,空间节省75%,电节省80%,散热减少80%,投资也至少减少70%,长期下来节能效果相当惊人。

简化服务器的部署、管理利用IBM 的PowerVM 技术,可以使得服务器的环境完全一致,使得加上NIM 安装技术的成功率大大提高,可以在短短60 分钟内,部署8 台以上的虚拟服务器,由于APV 和IBM 硬件控制台(HMC)密不可分,也就可以很方便地实现了这些虚拟服务器远程管理,包括启停、调整系统资源等等。

模拟各类操作系统和各个资源不同的机器,实现良好的学习测试实验环境。

对于IBM 的PowerVM 技术,目前支持AIX5.3、AIX6.1,部分Linux,可以模拟多台从0.1CPU,128 MB 到小于物理机器资源的机器。

PowerVM 的主要组成部分及概念最新的PowerVM 是在基于IBM POWER 处理器的硬件平台上提供的具有行业领先水平的虚拟化技术家族。

它是IBM Power System 虚拟化技术全新和统一的品牌(逻辑分区,微分区,Hypervisor,虚拟I/O 服务器,APV,PowerVM Lx86,Live Partition Mobility)。

随着Power6 的推出和i 和p 系列的合并,APV 也发展成为PowerVM。

PowerVM 有三个版本,分别是PowerVM Express Edition,PowerVM Standard Edition,PowerVM Enterprise Edition。

对于Power6,PowerVM 新支持Multiple Shared Processor Pools 功能和Live Partition Mobility 功能。

下面就其主要部分介绍一下,以方便后面实战部分的阅读。

微分区(Micro-Partitioning)微分区改变了POWER 系列服务器的整个规划结构。

实施APV 后,可以在资源分配方面提供更大的灵活性和细分能力。

添加处理器的部分处理能力而不是整个处理器,还能够帮助客户更好地利用服务器。

使用工作负载管理器(WLM)和PLM 有助于更好地优化这些资源。

现在,分区要么是专用的处理器分区(按整个处理器的增量来分配处理能力),要么是共享的处理器分区(使用微分区);不会出现两者的组合。

使用微分区时,可以将一组处理器分配到共享处理器池(SPP),然后使LPAR 可以(根据在池中获得的容量和优先级)使用这些处理器。

此时,服务器上仅有一个SPP 可用,但多个LPAR 可以共享这些资源。

虚拟I/O 服务器APV 功能部件的关键组件之一是虚拟I/O 服务器。

该设施可以提供I/O 虚拟化和网络资源虚拟化。

虚拟I/O 服务器是一个分区,用于提供I/O 资源共享,还用于为一个或多个客户机LPAR 托管虚拟盘、光存储和SEA。

虚拟LAN虚拟LAN 不是APV 的一部分,它只需要POWER5 系统上有AIX 5L V5.3 或支持的Linux 版本。

HMC 用于定义虚拟LAN 设备,从而使LPAR 通过内存而非以太网卡连接。

一个LPAR 可支持多达256 个虚拟LAN,每个虚拟LAN 的传输速度都在1 到3 Gbps 之间。

在这里,性能是值得关注的一点。

如果在分区之间使用物理 LAN 连接,则适配器以 LAN 的传输速度运行,而不是以通常快许多的内存传输速度运行。

由于适配器能够自行处理其任务,所以需要的处理器开销非常少。

如果使用 VLAN ,数据传输/交换速度会更快,因为两个分区之间基本上是内存传送。

但是,这种传输需要处理器的参与。

这两种传输方式的速度可能各有不同,视具体情况而定。

但总的来说,VLAN 比物理互连要快。

共享以太网适配器SEA 是一种与 APV 一起提供的 POWER5 中的新服务,它支持多个分区共享虚拟 I/O 服务器上的物理适配器。

它实际上起着第 2 层网桥的作用,在客户机中的虚拟以太网适配器和主机服务器中的实际适配器之间路由数据。

网络适配器共享是通过虚拟 I/O 服务器上配置的 SEA 实现的。

通过虚拟 I/O 服务器,数据或者在实际网络中流动,或者经由 Hypervisor 流向实际分区。

虚拟 SCSI在 I/O 方面,使用虚拟 SCSI 服务器共享磁盘和适配器。

虚拟 SCSI 服务器运行在虚拟 I/O 服务器上,它能够支持您在一个物理磁盘上分配多个逻辑卷(LV )。

然后,您可以将每个 LV 导出到不同的客户机 LPAR 。

客户机 LPAR 会将这些 LV 视为常规 SCSI 磁盘,而它们实际上可能是通过光纤连接到服务器。

例如,您可以使用一个 146GB 磁盘驱动器,将它划分为 3 个 45 Gb LV 并将它们用作 3 个不同 LPAR 的引导磁盘。

总的来说,这些概念相互独立。

为便于后面阅读和实践,我们主要弄清 2 个大的概念:微分区和 VIO server 即可,以下是我个人的白话理解:微分区 可以理解成可以小于 1 个 CPU 并和其他分区充分共享 CPU 的 LPAR ,内存的使用和 LPAR 没有什么不同。

它可以使用 VIO server 共享出来的网卡和存储,也可以不用。

VIO server 是一个特殊的分区,负责共享 I/O( 网卡和存储 ) 供其他分区使用。

不仅仅是微分区,实际也可以供一般 LPAR 使用,只是考虑到性能的原因,一般不这么做。

其中网卡通过实际网卡通过 SEA 勾连转换为共享虚拟网卡,通过 虚拟 LAN 和各个分区连通,同时使得各个分区可以通过共享虚拟网卡的桥接与外界联系。

共享存储是通过设置虚拟 SCSI 卡 vhost ,可以把 VIO server 的 lv 或磁盘,(新 powerVM 还可以包括文件)映射给 vhost ,实际 vhost 对应到其他分区就是一块 SCSI 卡,可以供其他分区使用实验环境说明:机器一览表设备名 配置 备注ss55aa01 IBM P55A (机架式):4* 1.9GHz ,32GB 内存,底板集成双口双绞线网卡,1×双口千兆双绞线网卡,1×双口 4Gb HBA 卡,1×显卡,HDD :2*146GB 15Krpm ,DVD-ROM,内置 DAT72 带机,冗余电源,AIX 5.3,2×异步卡,HMC,虚拟分区 微分区主服务器sse4km300a01 Eternus 4000 Module 3000ET4K M300 rack mount;4GB Cache Memory (2x1GBx2CM);FC (4Gbp s) host interface (4-portx2CA) E4KM300;146GB/15Krpm disk drive siglex13;500GB/7.2Krpm(single)X4;磁盘阵列ss210ea01,ss210eb01 Brocade Silkworm 210E (机架式机箱,带快速上架导轨)SAN 交换16 块4G 短波光纤模块,16 口激活,带相应管理软件机实验环境示意图规划设计规划前的需求调研在做规划之前,或者说一个准备实施微分区的服务器来说,至少需要调查了解各个分区系统的以下相关情况,这些都可能影响到微分区的配置和划分。

各个微分区负载应用特点如CPU、内存、网络等特别是I/O 的负载的侧重。

各个微分区网络需求包括网段的划分、路由、网络设备的冗余等等在系统上线前的状况和可提供条件,以及实施运行过程中可能出现的变更。

各个微分区存储需求包括存储的大小,性能的要求,以后扩展的需要。

微分区的设计本文由于是实验室环境,性能要求不高,所以网卡和HBA 卡设备都由VIO server 共享出来。

实际使用时,对于性能要求较高的微分区,网卡和HBA 卡可以单独划分给某个分区。

当然需要设计和购买相应的卡。

分区规划考虑到实验室实际情况,本次实施只划分了10 个微分区,但实际可以更多,可以事后再追加。

分区名名称ss55aa01 v io serverss55aa11 微分区1ss55aa12 微分区2ss55aa13 微分区3ss55aa14 微分区4ss55aa15 微分区5ss55aa16 微分区6ss55aa17 微分区7ss55aa18 微分区8ss55aa19 微分区9ss55aa20 微分区10CPU 的设计这些微分区为开发测试分区,开发测试的人员为同一批人,所以不太可能所有的分区都同时繁忙,所以做了如下设计:分区名min d esire m ax v_min v_desire v_max share_mode 权重ss55aa01 0.3 0.5 1 1 2 4 uncapped 128ss55aa11 0.1 0.3 4 1 2 4 uncapped 64ss55aa12 0.1 0.3 4 1 2 4 uncapped 64ss55aa13 0.1 0.3 4 1 2 4 uncapped 64ss55aa14 0.1 0.3 4 1 2 4 uncapped 64ss55aa15 0.1 0.3 4 1 2 4 uncapped 64ss55aa16 0.1 0.3 4 1 2 4 uncapped 64ss55aa17 0.1 0.3 4 1 2 4 uncapped 64ss55aa18 0.1 0.3 4 1 2 4 uncapped 64ss55aa19 0.1 0.3 4 1 2 4 uncapped 2ss55aa20 0.1 0.3 4 1 2 4 uncapped 2权重越高,是当CPU 不够分配的时候,按此比例来分配,即 2 个学习分区的权重最低,分配的CPU 会最少。

注意,此处VIO server 的CPU 也为共享,优先级最高,基于以下原因:CPU 数量有限,专有CPU 至少为1 颗,有些浪费。

这是由于该机器为实验室用途,性能要求不高,对VIO server 的压力不大。

此powerVM 实际为power5 的APV,不能实现power6 的Multiple Shared Processor Pools 功能, 设为专有CPU 后,将不能自动调整实际CPU 的使用。

实际使用过程中,如果CPU 宽裕,对性能有要求,建议采用专有CPU 模式。