语义分割评价指标 代码

mmsegmentation使用iou评价指标

MMSegmentation是一个流行的开源库,用于图像分割任务。

它提供了许多功能,包括预处理、模型训练和评估等。

在MMSegmentation中,使用iou(Intersection over Union)指标进行评估是一种常见的做法。

iou是一种常用的图像分割评价指标,用于比较不同算法或模型生成的分割结果。

它衡量了预测分割区域与真实标签之间的重叠程度,并给出了一种综合评估。

在使用MMSegmentation进行图像分割评估时,iou指标的计算通常涉及以下几个步骤:1. 准备数据集:首先,需要准备包含真实标签和预测分割结果的图像数据集。

真实标签通常由专业人员手动标记,而预测分割结果由算法生成。

2. 提取预测结果:从MMSegmentation模型输出的预测分割结果中,提取每个像素的预测类别和位置信息。

通常,模型会生成一个二进制掩码表示每个像素是否属于某个类别。

3. 提取真实标签:从数据集中提取每个图像的真实标签,并将其与预测分割结果进行比较。

通常,真实标签以相同的格式存储在数据集中。

4. 计算iou:根据预测分割结果和真实标签,计算每个像素的iou值。

iou的计算公式为:iou = (intersection) / (union),其中intersection表示预测分割结果和真实标签重叠的部分,union 表示两个区域的并集。

5. 汇总和比较:将所有图像的iou值进行汇总,并与其他算法或模型生成的分割结果进行比较。

通常,iou值越高,表示模型的性能越好。

在MMSegmentation中使用iou指标评估图像分割的优点包括:* 客观性:iou指标是一种客观的评价标准,不受人为因素的影响,可以提供更公正的评价结果。

* 可重复性:iou指标的计算方法在学术界和工业界得到了广泛的应用和验证,具有可重复性。

* 适用于多种任务:iou指标不仅适用于语义分割任务,还适用于实例分割任务。

它可以帮助我们比较不同算法在不同任务上的性能。

语义分割评价指标 代码

语义分割评价指标代码语义分割是计算机视觉领域的一项重要任务,旨在将图像中的每个像素分类到不同的语义类别中。

评价语义分割的好坏,需要使用一些指标来衡量其准确性和效果。

下面将介绍几个常用的语义分割评价指标,帮助读者更好地了解语义分割的性能。

1. 像素准确率(Pixel Accuracy):像素准确率是最简单的评价指标之一,计算分类正确的像素占总像素数的比例。

它忽略了分类错误的像素,不考虑分类的细节。

2. 平均像素准确率(Mean Pixel Accuracy):平均像素准确率是像素准确率的一种改进,它计算每个类别的像素准确率并求平均值。

这个指标能更好地反映语义分割的整体准确性。

3. 平均交并比(Mean Intersection over Union,mIOU):交并比是语义分割中常用的指标之一,它衡量预测结果与真实标签之间的相似度。

交并比定义为预测结果与真实标签的交集面积除以它们的并集面积。

平均交并比是所有类别交并比的平均值,能更全面地评价语义分割的效果。

4. 频率加权交并比(Frequency Weighted Intersection over Union,FWIOU):频率加权交并比是对平均交并比的改进,它考虑了每个类别的像素频率。

频率加权交并比将每个类别的交并比乘以该类别的像素频率,并对所有类别求和,以更准确地评价语义分割的效果。

5. 边界准确率(Boundary Accuracy):边界准确率是衡量语义分割边界预测准确性的指标。

它计算预测结果中正确预测的边界像素数占总边界像素数的比例。

像素准确率、平均像素准确率、平均交并比、频率加权交并比和边界准确率是常用的语义分割评价指标。

通过这些指标的综合分析,可以全面地评估语义分割的性能,为后续的算法优化和改进提供参考。

语义分割 测试 指标设置

语义分割测试指标设置全文共四篇示例,供读者参考第一篇示例:语义分割是计算机视觉领域中的一个重要任务,其目的是将图像中的每个像素分配到不同的语义类别中。

在实际应用中,对语义分割算法进行测试是非常必要的,通过测试可以评估算法的性能并确定其在不同数据集上的表现情况。

为了准确评估语义分割算法的性能,需要设置合适的测试指标。

在进行语义分割的测试时,通常会使用一些常见的指标来评价算法的性能,这些指标可以帮助我们了解算法对于不同类别的像素分割准确度以及整体的表现。

常用的测试指标包括像素准确率(pixel accuracy)、平均像素准确率(mean pixel accuracy)、平均交并比(mean intersection over union)等。

像素准确率是最简单的一个指标,它表示算法在图像中对每个像素进行分类时的准确率,即正确分类的像素数量占总像素数量的比例。

平均像素准确率是对所有类别像素准确率的平均值,它可以更全面地评估算法的整体性能。

平均交并比是另一个常用的指标,它通过计算预测结果和真实标签之间的交集和并集的比值来评估算法的分割准确度。

除了这些基本的测试指标外,还可以根据具体应用场景的需求来设置更多的指标。

针对一些对边缘精度要求较高的任务,可以设置边缘准确率和边缘错误率等指标;对于动态场景下的语义分割任务,可以考虑设置时间效率等指标。

综合考虑各方面因素,合理设置测试指标是保证测试结果准确性和可靠性的重要保障。

在进行语义分割算法的测试时,还需要注意选取合适的数据集和评估标准。

数据集的选择应该能够充分覆盖不同场景、不同类别和不同复杂度的图像,以确保算法的泛化能力和鲁棒性。

评估标准的设置需要结合具体任务的要求,充分考虑算法的应用场景和目标,并进行多方面的综合评估。

第二篇示例:语义分割是计算机视觉领域中一个重要的任务,其目标是将图像中的每个像素分配到预定义的类别中。

语义分割任务要求对图像中的每个像素进行分类,而不仅仅是对整个图像进行分类。

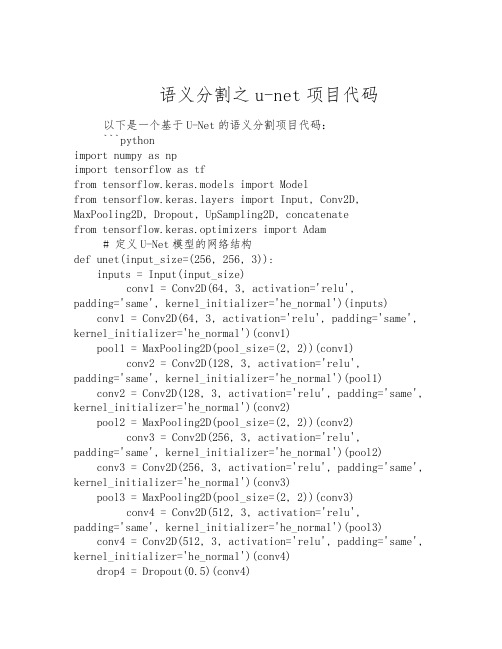

语义分割之u-net项目代码

语义分割之u-net项目代码以下是一个基于U-Net的语义分割项目代码:```pythonimport numpy as npimport tensorflow as tffrom tensorflow.keras.models import Modelfrom yers import Input, Conv2D, MaxPooling2D, Dropout, UpSampling2D, concatenatefrom tensorflow.keras.optimizers import Adam# 定义U-Net模型的网络结构def unet(input_size=(256, 256, 3)):inputs = Input(input_size)conv1 = Conv2D(64, 3, activation='relu',padding='same', kernel_initializer='he_normal')(inputs)conv1 = Conv2D(64, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv1)pool1 = MaxPooling2D(pool_size=(2, 2))(conv1)conv2 = Conv2D(128, 3, activation='relu',padding='same', kernel_initializer='he_normal')(pool1)conv2 = Conv2D(128, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv2)pool2 = MaxPooling2D(pool_size=(2, 2))(conv2)conv3 = Conv2D(256, 3, activation='relu',padding='same', kernel_initializer='he_normal')(pool2)conv3 = Conv2D(256, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv3)pool3 = MaxPooling2D(pool_size=(2, 2))(conv3)conv4 = Conv2D(512, 3, activation='relu',padding='same', kernel_initializer='he_normal')(pool3)conv4 = Conv2D(512, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv4)drop4 = Dropout(0.5)(conv4)pool4 = MaxPooling2D(pool_size=(2, 2))(drop4)conv5 = Conv2D(1024, 3, activation='relu',padding='same', kernel_initializer='he_normal')(pool4)conv5 = Conv2D(1024, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv5)drop5 = Dropout(0.5)(conv5)up6 = Conv2D(512, 2, activation='relu',padding='same',kernel_initializer='he_normal')(UpSampling2D(size=(2,2))(drop5))merge6 = concatenate([drop4, up6], axis=3)conv6 = Conv2D(512, 3, activation='relu', padding='same', kernel_initializer='he_normal')(merge6)conv6 = Conv2D(512, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv6)up7 = Conv2D(256, 2, activation='relu',padding='same',kernel_initializer='he_normal')(UpSampling2D(size=(2,2))(conv6))merge7 = concatenate([conv3, up7], axis=3)conv7 = Conv2D(256, 3, activation='relu', padding='same', kernel_initializer='he_normal')(merge7)conv7 = Conv2D(256, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv7)up8 = Conv2D(128, 2, activation='relu',padding='same',kernel_initializer='he_normal')(UpSampling2D(size=(2,2))(conv7))merge8 = concatenate([conv2, up8], axis=3)conv8 = Conv2D(128, 3, activation='relu', padding='same', kernel_initializer='he_normal')(merge8)conv8 = Conv2D(128, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv8)up9 = Conv2D(64, 2, activation='relu',padding='same',kernel_initializer='he_normal')(UpSampling2D(size=(2,2))(conv8))merge9 = concatenate([conv1, up9], axis=3)conv9 = Conv2D(64, 3, activation='relu', padding='same', kernel_initializer='he_normal')(merge9)conv9 = Conv2D(64, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv9)conv9 = Conv2D(2, 3, activation='relu', padding='same', kernel_initializer='he_normal')(conv9)conv10 = Conv2D(1, 1, activation='sigmoid')(conv9) model = Model(inputs=inputs, outputs=conv10)return model# 加载数据集def load_data():# 从文件或数据库加载图像和对应的标签# 数据预处理和划分训练集/验证集/测试集pass# 训练模型def train_model():# 加载数据集x_train, y_train, x_val, y_val = load_data()# 创建并编译U-Net模型model = unet()modelpile(optimizer=Adam(lr=1e-4),loss='binary_crossentropy', metrics=['accuracy'])# 训练模型model.fit(x_train, y_train, batch_size=16, epochs=10, validation_data=(x_val, y_val))# 保存模型model.save('unet_model.h5')# 测试模型def test_model():# 加载已训练的模型model = tf.keras.models.load_model('unet_model.h5')# 加载测试数据集x_test, y_test = load_test_data()# 对测试数据进行预测y_pred = model.predict(x_test)# 计算预测结果的准确率或其他评估指标accuracy = calculate_accuracy(y_test, y_pred)print("Accuracy: ", accuracy)# 项目入口函数if __name__ == '__main__':train_model()test_model()```上述代码包含了U-Net模型的网络结构定义(`unet`函数)以及训练和测试模型的代码逻辑(`train_model`和`test_model`函数)。

unet语义分割评价指标的所有代码

unet语义分割评价指标的所有代码以下是UNet语义分割评价指标的代码示例:1. 混淆矩阵pythonimport numpy as npfrom sklearn.metrics import confusion_matrix# 根据预测结果和真实标签计算混淆矩阵def compute_confusion_matrix(y_true, y_pred, num_classes): y_true = y_true.flatten()y_pred = y_pred.flatten()cm = confusion_matrix(y_true, y_pred, labels=range(num_classes)) return cm2. 像素准确率pythondef compute_pixel_accuracy(y_true, y_pred):y_true = y_true.flatten()y_pred = y_pred.flatten()total_pixels = len(y_true)correct_pixels = np.sum(y_true == y_pred)acc = correct_pixels / total_pixelsreturn acc3. 平均像素准确率(mPA)pythondef compute_mean_pixel_accuracy(cm): num_classes = cm.shape[0]# 计算每个类别的像素准确率class_accs = []for i in range(num_classes):tp = cm[i, i]fp = np.sum(cm[:, i]) - tpfn = np.sum(cm[i, :]) - tpif tp + fp + fn == 0:acc = 0.0else:acc = tp / (tp + fp + fn)class_accs.append(acc)# 计算总体像素准确率的平均值mean_acc = np.mean(class_accs)return mean_acc4. 平均交并比(mIoU)pythondef compute_mean_intersection_over_union(cm): num_classes = cm.shape[0]ious = []for i in range(num_classes):tp = cm[i, i]fp = np.sum(cm[:, i]) - tpfn = np.sum(cm[i, :]) - tpif tp + fp + fn == 0:iou = 0.0else:iou = tp / (tp + fp + fn) ious.append(iou)# 计算总体交并比的平均值mean_iou = np.mean(ious)return mean_iou使用示例:python# 加载模型和测试数据model = load_model()test_data = load_test_data()# 预测测试数据的标签y_pred = model.predict(test_data)# 加载测试数据的真实标签y_true = load_ground_truth()# 计算混淆矩阵cm = compute_confusion_matrix(y_true, y_pred, num_classes=10)# 计算评价指标acc = compute_pixel_accuracy(y_true, y_pred)mPA = compute_mean_pixel_accuracy(cm)mIoU = compute_mean_intersection_over_union(cm)。

语义分割指标范文

语义分割指标范文1. 像素准确率(Pixel Accuracy):像素准确率是语义分割中最简单的指标之一,它表示被正确分类的像素数与总像素数之间的比例。

这个指标不考虑每个类别的像素数量,只关注分类是否正确。

像素准确率可以通过以下公式计算:像素准确率=分类正确的像素数/总像素数2. 平均像素准确率(Mean Pixel Accuracy):平均像素准确率是像素准确率在所有类别上的平均值。

它考虑了每个类别的像素数量差异,并给出了每个类别的分类准确性。

平均像素准确率可以通过以下公式计算:平均像素准确率=Σ(分类正确的像素数/总像素数)/类别总数3. 平均交并比(Mean Intersection over Union,mIoU):交并比是语义分割中常用的指标之一,它衡量了模型预测的分割结果与真实分割结果之间的重叠程度。

交并比在每个类别上计算,然后求平均值。

交并比可以通过以下公式计算:交并比=Σ(交集像素数/并集像素数)/类别总数4. 频率加权交并比(Frequency Weighted Intersection over Union,FWIoU):频率加权交并比是对平均交并比的改进,它考虑了每个类别在图像中的像素数量差异。

像素数量多的类别会对模型的性能评估产生更大的影响。

频率加权交并比可以通过以下公式计算:频率加权交并比=Σ(类别像素数×交并比)/总像素数5. Dice系数:Dice系数是一种衡量相似度的指标,用于评估语义分割模型分割结果的准确性。

Dice系数可以通过以下公式计算:Dice系数= 2 × (交集像素数) / (预测结果像素数 + 真实结果像素数)除了上述指标,还有很多其他的语义分割指标,如F1-score、Precision、Recall等,它们都可以用来评估语义分割模型的性能。

在实际应用中,选择适合具体任务类型和需求的指标来评估模型的性能是非常重要的。

语义分割特征可视化代码

语义分割特征可视化代码语义分割特征可视化是一种用于理解神经网络在图像语义分割任务中学到的特征表示的方法。

以下是一个简单的Python代码示例,使用常见的深度学习库PyTorch和Matplotlib来可视化语义分割模型的特征。

在示例中,我们使用的是一个预训练的语义分割模型,例如DeepLabV3,以及一张输入图像。

代码中主要使用了PyTorch进行模型加载和图像处理,以及Matplotlib进行可视化。

```pythonimport torchimport torchvision.transforms as transformsfrom PIL import Imageimport matplotlib.pyplot as pltimport numpy as np# 加载预训练的语义分割模型(以DeepLabV3为例)model = torch.hub.load('pytorch/vision:v0.9.0', 'deeplabv3_resnet101', pretrained=True) model.eval()# 图像预处理input_image = Image.open('path/to/your/image.jpg')preprocess = pose([transforms.ToTensor(),transforms.Normalize(mean=[0.485, 0.456, 0.406], std=[0.229, 0.224, 0.225]),])input_tensor = preprocess(input_image)input_batch = input_tensor.unsqueeze(0) # 添加batch 维度# 推断with torch.no_grad():output = model(input_batch)['out'][0]output_predictions = output.argmax(0) # 取预测结果中的类别# 可视化特征def visualize_feature_map(feature_map):# 将特征图转为可视化的图像feature_map = feature_map.detach().numpy()plt.imshow(feature_map, cmap='viridis') # 使用'viridis' 颜色映射plt.show()# 选择某一层的特征图进行可视化(这里选择第三层)target_layer = 3selected_feature_map = output[target_layer]visualize_feature_map(selected_feature_map)```请注意,这只是一个简单的示例,实际可视化方法可能需要根据你使用的模型和框架进行调整。

实例分割与语义分割的指标

实例分割与语义分割的指标1.引言1.1 概述实例分割和语义分割是计算机视觉领域中的两个重要任务,用于对图像或视频进行像素级别的分割和标注。

实例分割旨在将图像中的不同目标实例进行分割,并为每个实例分配一个唯一的标识符。

相比之下,语义分割的目标是将图像划分为不同的语义区域,每个区域代表着一类特定的对象或物体。

在实例分割中,主要关注的是每个物体实例的边界和位置。

该任务的核心指标是IoU(Intersection over Union),它是通过将模型预测的分割结果与真实分割结果进行比较得出的。

另一个重要的指标是mAP (mean Average Precision),它考虑了不同分割类别的准确性和检测率,提供了一个全面评估模型性能的指标。

与实例分割相比,语义分割更侧重于图像的语义信息。

常用的度量指标包括像素准确率(Pixel Accuracy)和平均交并比(Mean Intersection over Union,简称mIoU)。

像素准确率衡量了模型预测的每个像素的正确性,而mIoU则考虑了预测和真实分割结果之间的交集和并集的比例,用于综合评估不同类别的分割准确性。

本文将重点探讨实例分割和语义分割的指标,并比较它们在不同任务和应用场景中的优劣。

此外,还将讨论它们在计算机视觉领域中的应用前景。

通过深入了解实例分割和语义分割的指标,我们可以更好地评估和选择适用于特定任务的模型和算法。

文章结构部分的内容可以按照以下方式编写:1.2 文章结构本文将从实例分割和语义分割两个方面对相关指标进行介绍和比较。

首先,我们将在引言部分概述实例分割和语义分割的基本概念和应用背景。

然后,在正文部分,我们将详细讨论实例分割和语义分割的指标。

在2.1节中,我们将介绍实例分割的指标。

具体来说,我们将详细解释IoU(Intersection over Union)指标的原理和计算方法,并介绍mAP (mean Average Precision)指标的含义和计算过程。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

语义分割评价指标代码

语义分割是计算机视觉领域的重要任务,用于将图像中的每个像素分配到特定的语义类别中。

评价语义分割模型的指标通常包括像素精度、平均精度、交并比等。

下面我将从不同角度对这些指标进行解释。

像素精度(Pixel Accuracy)是指语义分割模型正确分类的像素数量占总像素数量的比例。

其计算公式为,像素精度 = (正确分类的像素数) / (总像素数)。

这个指标简单直观,但不能很好地反映类别不平衡的情况。

平均精度(Mean Accuracy)是指每个类别预测正确的像素占该类别总像素的比例的平均值。

其计算公式为,平均精度= Σ(类别正确分类的像素数 / 类别总像素数) / 类别数。

这个指标考虑了类别不平衡的情况,能更全面地评价模型性能。

交并比(Intersection over Union,IoU)是指预测结果与真实标签的交集与并集之比,用于衡量模型对目标的定位能力。

其计算公式为,IoU = (预测结果与真实标签的交集) / (预测结果与真实标签的并集)。

IoU范围在0到1之间,值越大表示模型定位能力

越好。

以上是常用的语义分割评价指标,当然还有其他指标,如Dice 系数、F1分数等。

关于代码部分,评价指标的计算通常可以使用Python的深度学习框架(如TensorFlow、PyTorch)提供的函数进行计算,也可以自行编写相应的函数进行计算。

具体的代码实现可以根据具体的深度学习框架和任务需求进行调整和编写。

希望以上内容能够满足你的需求。