ffmpeg时间戳问题汇总

ffmpeg编译、使用与常见问题

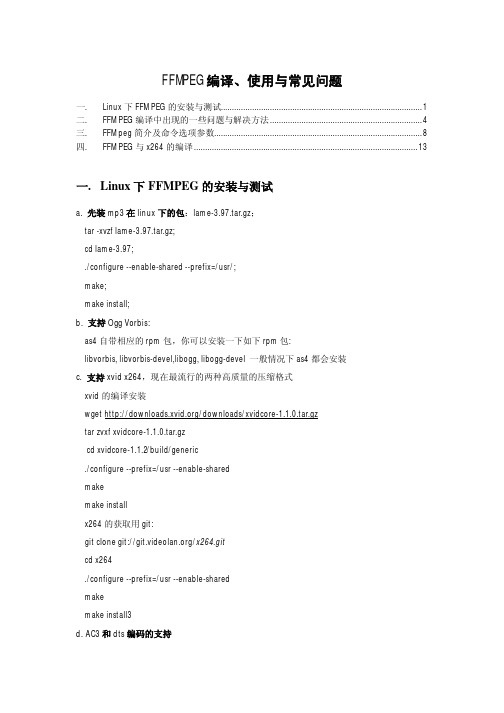

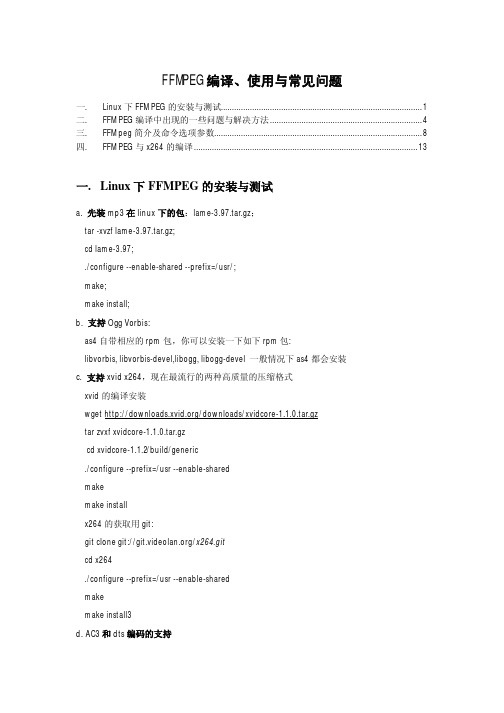

FFMPEG编译、使用与常见问题一. Linux下FFMPEG的安装与测试 (1)二. FFMPEG编译中出现的一些问题与解决方法 (4)三. FFMpeg简介及命令选项参数 (8)四. FFMPEG与x264的编译 (13)一.Linux下FFMPEG的安装与测试a. 先装mp3在linux下的包:lame-3.97.tar.gz;tar -xvzf lame-3.97.tar.gz;cd lame-3.97;./configure --enable-shared --prefix=/usr/;make;make install;b. 支持Ogg Vorbis:as4自带相应的rpm包,你可以安装一下如下rpm包:libvorbis, libvorbis-devel,libogg, libogg-devel 一般情况下as4都会安装c. 支持xvid x264,现在最流行的两种高质量的压缩格式xvid的编译安装wget /downloads/xvidcore-1.1.0.tar.gztar zvxf xvidcore-1.1.0.tar.gzcd xvidcore-1.1.2/build/generic./configure --prefix=/usr --enable-sharedmakemake installx264的获取用git:git clone git:///x264.gitcd x264./configure --prefix=/usr --enable-sharedmakemake install3d. AC3和dts编码的支持as4系统似乎已经支持ac3编码,编译的时候只要加--enable-a52 --enable-gpl参数就行libdts编译参数tar zxvf libdts-0.0.2.tar.gz./configure --prefix=/usrmakemake installe. mpg4 aac格式支持,由于服务器还针对手机用户服务,所以,类似aac,mpg4铃声格式的支持,我们也得做。

ffmpeg编码获取时间戳函数

一、介绍ffmpeg编码ffmpeg是一个开源的音视频处理工具,能够实现音视频的编解码、转换、截取、录制等功能。

它支持几乎所有主流的音视频格式,拥有强大的功能和丰富的参数选项,被广泛应用于音视频处理领域。

二、获取ffmpeg编码时间戳函数的作用在音视频处理中,时间戳是一个非常重要的概念。

时间戳是指在一段音视频数据中,每一帧的具体时间信息。

在使用ffmpeg进行编码时,获取时间戳函数可以帮助我们准确地控制每一帧的时间序列,实现精准的音视频处理效果。

三、ffmpeg编码获取时间戳函数的使用方法1. 获取视频流时间戳函数在使用ffmpeg进行视频编码时,我们可以使用`av_gettime()`函数来获取当前时间的微秒数。

代码示例如下:```cint64_t time = av_gettime();```这样我们就可以获取当前时间的时间戳,用于视频流的编码。

2. 获取音频流时间戳函数对于音频流的时间戳获取,我们可以使用`av_gettime()`函数获取当前时间的微秒数,然后通过音频帧的采样率来计算每一帧的时间戳。

代码示例如下:```cint64_t time = av_gettime();int64_t audio_time = time * audio_sample_rate / 1000000;```这样我们就可以根据当前时间和音频采样率来计算音频流的时间戳。

四、ffmpeg编码获取时间戳函数的注意事项1. 时间戳精度在使用ffmpeg获取时间戳时,需要注意时间戳的精度。

通常情况下,ffmpeg的时间戳精度可以达到微秒级别,能够满足大部分音视频处理的需求。

2. 时间戳同步在处理音视频数据时,需要注意音视频流的时间戳同步。

通常情况下,视频流和音频流的时间戳是相互关联的,需要保持同步,以确保音视频同步播放。

3. 时间戳溢出在使用时间戳进行计算时,需要考虑时间戳的溢出问题。

通常情况下,时间戳会在一定范围内进行循环计算,需要进行合理的处理,以避免溢出导致的错误。

javacv中ffmpegframegrabber使用时的一些注意事项

javacv中ffmpegframegrabber使用时的一些注意事项在使用javacv库中的FFmpegFrameGrabber进行视频帧的抓取时,有一些注意事项需要注意。

下面是一些常见的问题和解决方法,以帮助您更好地使用FFmpegFrameGrabber。

1. 确保安装了FFmpeg库:FFmpegFrameGrabber依赖于FFmpeg库来处理视频文件。

在开始使用之前,请确保已经安装了FFmpeg库,并在Java项目中正确配置了库文件路径。

2. 理解视频帧的时间戳:FFmpegFrameGrabber可以以帧为单位捕获视频的时间戳。

在处理视频帧时,您需要根据时间戳执行适当的操作,例如跳过或处理特定的帧。

3. 设置视频源:在创建FFmpegFrameGrabber对象时,需要设置视频源。

可以是视频文件的路径、URL或其他类型的输入源。

4. 设置视频帧的宽度和高度:通过grabber对象的setWidth和setHeight方法,您可以设置抓取的视频帧的宽度和高度。

默认情况下,它们将被设置为视频源的宽度和高度。

5. 设置视频帧的像素格式:使用setPixelFormat方法可以设置抓取的视频帧的像素格式。

不同的像素格式将影响图像的质量和大小。

通常,推荐使用BGR24或GRAY格式。

6. 抓取视频帧:通过调用grab方法,可以抓取视频源中的下一帧。

在调用grab方法之前,请确保已经启动了grabber对象。

7. 读取抓取的视频帧:调用grabber对象的grab方法后,可以使用getFrame方法来获取抓取的视频帧。

请注意,getFrame方法可能返回null,表示已经抓取完所有的帧。

8. 解码抓取的视频帧:获取抓取的视频帧后,可以使用grabber对象的convert方法将其解码为Java的BufferedImage。

使用BufferedImage可以方便地进行图像处理和分析。

9. 释放资源:在使用完FFmpegFrameGrabber后,应该及时释放资源。

时间戳

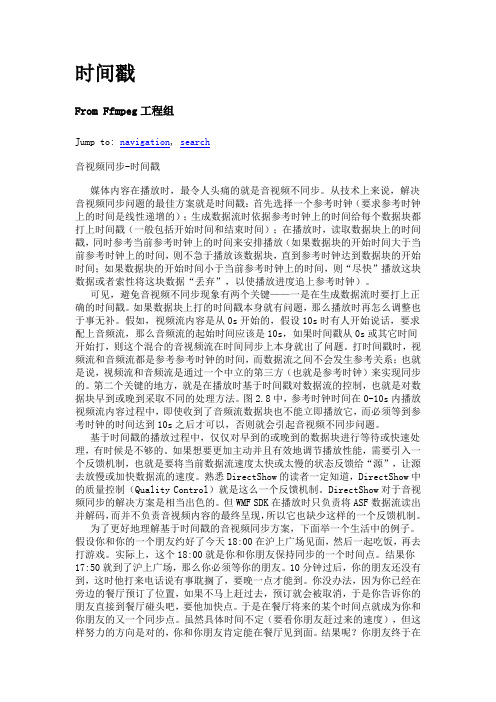

时间戳From Ffmpeg工程组Jump to: navigation, search音视频同步-时间戳媒体内容在播放时,最令人头痛的就是音视频不同步。

从技术上来说,解决音视频同步问题的最佳方案就是时间戳:首先选择一个参考时钟(要求参考时钟上的时间是线性递增的);生成数据流时依据参考时钟上的时间给每个数据块都打上时间戳(一般包括开始时间和结束时间);在播放时,读取数据块上的时间戳,同时参考当前参考时钟上的时间来安排播放(如果数据块的开始时间大于当前参考时钟上的时间,则不急于播放该数据块,直到参考时钟达到数据块的开始时间;如果数据块的开始时间小于当前参考时钟上的时间,则“尽快”播放这块数据或者索性将这块数据“丢弃”,以使播放进度追上参考时钟)。

可见,避免音视频不同步现象有两个关键——一是在生成数据流时要打上正确的时间戳。

如果数据块上打的时间戳本身就有问题,那么播放时再怎么调整也于事无补。

假如,视频流内容是从0s开始的,假设10s时有人开始说话,要求配上音频流,那么音频流的起始时间应该是10s,如果时间戳从0s或其它时间开始打,则这个混合的音视频流在时间同步上本身就出了问题。

打时间戳时,视频流和音频流都是参考参考时钟的时间,而数据流之间不会发生参考关系;也就是说,视频流和音频流是通过一个中立的第三方(也就是参考时钟)来实现同步的。

第二个关键的地方,就是在播放时基于时间戳对数据流的控制,也就是对数据块早到或晚到采取不同的处理方法。

图2.8中,参考时钟时间在0-10s内播放视频流内容过程中,即使收到了音频流数据块也不能立即播放它,而必须等到参考时钟的时间达到10s之后才可以,否则就会引起音视频不同步问题。

基于时间戳的播放过程中,仅仅对早到的或晚到的数据块进行等待或快速处理,有时候是不够的。

如果想要更加主动并且有效地调节播放性能,需要引入一个反馈机制,也就是要将当前数据流速度太快或太慢的状态反馈给“源”,让源去放慢或加快数据流的速度。

ffmpeg时间戳

FFmpeg里有两种时间戳:DTS(Decoding Time Stamp)和PTS(Presentation Time Stamp)。

顾名思义,前者是解码的时间,后者是显示的时间。

要仔细理解这两个概念,需要先了解FFmpeg中的packet和frame的概念。

FFmpeg中用AVPacket结构体来描述解码前或编码后的压缩包,用AVFrame结构体来描述解码后或编码前的信号帧。

对于视频来说,AVFrame就是视频的一帧图像。

这帧图像什么时候显示给用户,就取决于它的PTS。

DTS是AVPacket里的一个成员,表示这个压缩包应该什么时候被解码。

如果视频里各帧的编码是按输入顺序(也就是显示顺序)依次进行的,那么解码和显示时间应该是一致的。

可事实上,在大多数编解码标准(如H.264或HEVC)中,编码顺序和输入顺序并不一致。

于是才会需要PTS和DTS这两种不同的时间戳。

FFmpeg里有两种时间戳:DTS(Decoding Time Stamp)和PTS(Presentation Time Stamp)。

顾名思义,前者是解码的时间,后者是显示的时间。

要仔细理解这两个概念,需要先了解FFmpeg中的packet和frame的概念。

FFmpeg中用AVPacket结构体来描述解码前或编码后的压缩包,用AVFrame结构体来描述解码后或编码前的信号帧。

对于视频来说,AVFrame就是视频的一帧图像。

这帧图像什么时候显示给用户,就取决于它的PTS。

DTS是AVPacket里的一个成员,表示这个压缩包应该什么时候被解码。

如果视频里各帧的编码是按输入顺序(也就是显示顺序)依次进行的,那么解码和显示时间应该是一致的。

可事实上,在大多数编解码标准(如H.264或HEVC)中,编码顺序和输入顺序并不一致。

于是才会需要PTS和DTS这两种不同的时间戳。

视频的显示和存放原理对于一个电影,帧是这样来显示的:I B B P。

现在我们需要在显示B帧之前知道P帧中的信息。

ffmpeg编译、使用与常见问题

FFMPEG编译、使用与常见问题一. Linux下FFMPEG的安装与测试 (1)二. FFMPEG编译中出现的一些问题与解决方法 (4)三. FFMpeg简介及命令选项参数 (8)四. FFMPEG与x264的编译 (13)一.Linux下FFMPEG的安装与测试a. 先装mp3在linux下的包:lame-3.97.tar.gz;tar -xvzf lame-3.97.tar.gz;cd lame-3.97;./configure --enable-shared --prefix=/usr/;make;make install;b. 支持Ogg Vorbis:as4自带相应的rpm包,你可以安装一下如下rpm包:libvorbis, libvorbis-devel,libogg, libogg-devel 一般情况下as4都会安装c. 支持xvid x264,现在最流行的两种高质量的压缩格式xvid的编译安装wget /downloads/xvidcore-1.1.0.tar.gztar zvxf xvidcore-1.1.0.tar.gzcd xvidcore-1.1.2/build/generic./configure --prefix=/usr --enable-sharedmakemake installx264的获取用git:git clone git:///x264.gitcd x264./configure --prefix=/usr --enable-sharedmakemake install3d. AC3和dts编码的支持as4系统似乎已经支持ac3编码,编译的时候只要加--enable-a52 --enable-gpl参数就行libdts编译参数tar zxvf libdts-0.0.2.tar.gz./configure --prefix=/usrmakemake installe. mpg4 aac格式支持,由于服务器还针对手机用户服务,所以,类似aac,mpg4铃声格式的支持,我们也得做。

ffmpeg解码编码时间基转换

ffmpeg解码编码时间基转换最近,我接触了一些关于音视频处理的知识,特别是有关于ffmpeg 解码编码时间基转换的内容。

在这篇文章中,我会对这一主题进行深入的探讨,并根据我的理解进行分析和总结。

1. 什么是ffmpeg解码编码时间基转换?让我们来了解一下ffmpeg解码编码时间基转换的基本概念。

在音视频处理中,时间基是一个非常重要的概念,它涉及到音视频帧的时间轴和时刻的处理。

而解码编码时间基转换则是针对音视频解码和编码过程中时间基的转换和处理。

通过ffmpeg解码编码时间基转换,我们可以实现对视频的快慢播放、变速播放和时长调整等功能。

2. 解码编码时间基转换的原理和方法在进行ffmpeg解码编码时间基转换时,我们首先需要了解相关的原理和方法。

在音视频处理中,时间基转换通常涉及到PTS (Presentation Time Stamp)、DTS(Decode Time Stamp)和时钟基准等概念。

通过改变这些时间基准,我们可以实现对视频帧的时间轴和时刻进行调整和转换。

而解码编码时间基转换的方法主要包括修改PTS和DTS值、调整时钟基准和重新编码等操作。

3. 解码编码时间基转换的应用场景解码编码时间基转换在音视频处理中有很多应用场景。

在视频编辑软件中,我们可以通过对视频进行时间基转换来实现快慢播放、变速播放和时长调整等功能。

在直播和实时传输中,解码编码时间基转换也可以帮助我们实现时间同步和延迟控制等功能。

在一些特殊的场景中,比如VR和AR应用中,解码编码时间基转换也可以帮助实现对视频内容的时间轴和时刻的精确控制。

4. 个人观点和总结ffmpeg解码编码时间基转换是音视频处理中一个非常重要的技术,它可以帮助我们实现对视频帧的时间轴和时刻的精确控制。

通过对解码编码时间基转换的理解和应用,我们可以更加灵活地处理音视频内容,并实现一些创新的功能和效果。

在未来,随着音视频处理和应用场景的不断扩大,解码编码时间基转换技术也将发挥越来越重要的作用。

ffmpeg 编码 avframe pts不生效

ffmpeg 编码avframe pts不生效

在FFmpeg中,AVFrame的PTS(Presentation TimeStamp)是用于指定视频帧的播放时间戳。

如果您发现AVFrame的PTS没有生效,可能有几个原因需要检查和解决。

1. 检查编码器配置:确保您正确配置了编码器参数。

对于x264编码器,您需要设置适当的编码参数,例如qmin、qmax等。

这些参数可以影响PTS的计算方式。

2. 确定时间基准:确保您的视频流具有正确的时间基准。

在处理视频流时,必须将PTS与正确的时间基准关联起来。

如果时间基准不正确,可能会导致PTS失效。

3. 检查时间戳设置:在某些情况下,您可能需要手动设置时间戳。

例如,您可以使用`av_packet_set_pts`函数来设置包的时间戳。

确保您正确设置了时间戳,并且与您的视频流时间基准一致。

4. 检查视频帧序列:PTS是按帧序列计算的。

如果您的视频帧顺序不正确,可能会导致PTS失效。

请确保您的视频帧顺序与时间戳一致。

5. 检查硬件设备或驱动程序:某些硬件设备或驱动程序可能不支持某些编码器或功能。

如果您使用的是特定的硬件设备或驱动程序,请确保它们与您的FFmpeg版本兼容,并支持所需的编码器和功能。

总之,要解决FFmpeg中AVFrame的PTS不生效的问题,您需要检查编码器配置、时间基准、时间戳设置、视频帧序列以及硬件设备或驱动程序的兼容性。

根据具体情况进行排查和修复。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

ffmpeg时间戳问题汇总A:RFC3984 规定采用 90000 Hz 的时钟,因此如果编码帧频是 30,那么时间戳间隔就该是 90000 / 30 3000,根据抓包来看,似乎时间戳间隔的确是 3000。

时间戳的间隔不固定,比如有的时间戳间隔是 2990 有的是 3002,会导致解析出来的视频快播的效果么Q:各位大侠好:我现在正在开发视频实时流播放,简单的过程如下:采集视频流 - 视频流转换为 Sorenson H.263 编码格式 - 把编码的实时流通过RTMP 协议发送 - flash 客户端进行播放。

现在我的时间戳颗粒是这样生成的:第一帧的时间戳为 0;第二帧的时间戳的算法为:第一个字符编码的当前时间 -上一帧第一个字符编码的当前时间根据这个时间颗粒的算法,我在 flash 客户端播放就会产生延时。

请问各位大侠有什么好的建议或是文档之类的,以前 firstime 管管建议我看 RFC4629 文档,但是效果不太明显,谢谢~A;时间戳顺序累加就行了,每次加 1Q:最近做了一个捕捉摄像头并保存 FLV 的小东西,发现转换完毕后的FLV 文件,用播放器播放的时候,速度特别快,大概是正常速度的 4 倍。

请问这是怎么回事,网上搜了一下,说是时间戳的问题,可是 PTS 我跟了,AVPacket 的PTS 是每帧增长 40,time_base 为: 25/s.。

DTS 是个无效值。

PTS 的计算是根据ffmpeg 的例子写的。

pkt.pts av_rescale_qoAcc-coded_frame-pts oAcc-time_base audio_st-time_base1. dts 到底需不需要自己计算,2. 还有播放速度过快的可能原因,3. 还有 PTS 和 DTS 的具体含义,int64_t pts /// presentation time stamp in time_base unitsint64_t dts /// decompression time stamp in time_base units上面的意思是不是说,播放器根据 PTS 进行播放。

然后 DTS 是在编码的时候自己设置,刚用 ffmpeg,好些东西不懂,还请大侠多多指教------刚才又试了一下,把time_base 降为 10 帧每秒。

播放速度和正常速度接近。

但是不知道 FLV 文件的帧率该设置多少合适。

有没有一个权威的说法。

A:我也做摄像头捕捉,跟你出现一样的问题,我自己分析的话,应该是捕捉摄像头的图像的速度只有 10 帧每秒,但是保存成视频25 帧每秒的话播放看起来就非常快,但是我摄像头捕捉设定的是 25 帧每秒,难道是速度达不到,反正我还没解决,LZ 解决了的话告诉下,谢谢。

暂时认为是摄像头捕捉速率问题。

换了一个高清无驱摄像头就好了Q:在每个音视频数据包中都含有PTS 和 DTS,一个数据包中应该含有多个数据帧以及音频数据,那么这里的PTS和 DTS 它是如何来标识数据帧的,PTS 和 DTS 的单位是什么,视频的最小单位是帧,可通过 PTS 来指定它何时播放,那音频的最小单位是什么,这里的PTS对音频而言它标识的是什么,是这个时间点采样点吗,在网上找了很久关于音视频编解码的资料,都没有合适的A:audio_timebaseav_q2dfmtctx-streamsaudio_index-time_basevideo_timebaseav_q2dfmtctx-streamsvideo_index-time_baselast_video_pts ptsvideo_timebaselast_audio_pts pts audio_timebasetimebase 就是单位以 audio 为基准同步 video。

只要设置好了 ao 的参数,如 sample rate channels sample size 等,audio 驱动就能以正确的速度播放,所以只要程序里 write不出大问题的话,这种同步是非常有效的。

在 video out 里如下做:pre_timeav_gettimegl_vo-vo_displaypicafter_time av_gettimerest_time 10001000/fps -after_time - pre_timeav_diff last_audio_pts - last_video_ptsifav_diff 0.2 ifav_diff 0.5 rest_time - rest_time / 4 else rest_time - rest_time /2else if av_diff-0.2 if av_diff -0.5 rest_time rest_time / 4 else rest_timerest_time / 2if rest_time0 usleeprest_timeQ:谢谢 kf701 的回复,看后明白了不少这种同步是音频抽样一次就与一帧图像去同步的吗,A:上面的代码是每 display 一个 picture就与audio 的PTS 比较一下如果没有 audio只有 video那么 video 就会以 fps 显示靠的就是那个 usleeprest_timeQ:如何利用 AVPacket 包里的 ptsdts 实现音视频同步,声频播放是只管自己播放,视频有一个初始化播放帧率,如何根据 AVPacket 里的ptsdts还实现两者的同步,现在我的视频播放一直按原始播放帧率播放,声音有点卡~哪位知道,尽快告知小弟~A:DTS:decoding time stampPTS:presentation time stampGenerally the PTS and DTS will only differ when the stream we are playing has Bframes in it.Q: 关于 b 帧和时间戳的问题我从 mpeg2 视频中用av_read_frame读取视频帧并解码,顺序是IPBBPBB...它们的 pts 顺序是 1423756...现在我要把这个视频再用 mpeg2 编码,最大 b帧数还是 2.那么我在编码时是否要将视频数据调整为按显示时间先后的顺序,再交给 avcodec_encode_video编码,即把第 2 帧放在3、4 帧之后,第 7帧放在 5、6 帧之后,A:你不能这么做,编码器会给你这么做的。

如果你有 B 帧,那么所有的 B 帧都会被放在缓冲区里直到下一个 I/P 帧到来例如:你的输入序列是 IBBPBBPBBI那么输出的序列是输入 I,编码 I,输出 I 输入 B输入 B输入 P,编码 P,输出 P编码 B,输出 B编码 B,输出 B输入 P编码P,输出 P。

在解码端所有的 P 帧都会被放在缓冲力直到下一个 I/P 真的到来如:解码 I,输出 I解码 P放入缓冲 P解码 B,输出 B解码 B,输出 B 解码 P,输出上一次 P 帧Q:解码出来的图片的时间戳问题 MPEG 一个包中包含有时间戳而可能几个包才能解码出一张图象也可能一个包能解码出几张图请问包中的时间戳与解码出来的图象如何对应上A:在 ffmpeg 中通过 parser 部件把从avformat 部件取下来的原始包重新“合成”为有仅包含一个完整帧的包。

从 MPEG2 部份的代码中看出,如果“几个包才能解码出一张图象”的话,会取第一个包的 PTS 和DTS,如果“也可能一个包能解码出几张图”,则会跟据这个包的 PTS 和 DTS通过帧频推算出其它帧的 DTS。

Q: ffmpeg 的 avcodec_decode_video 函数解码时间戳问题,在VLC 中调用 avcodec_decode_video 函数进行解码时,AVFrame-pts 时间戳不对,导致我的图像不能够显示, 请问有谁知道它的解码原理,这个 PTS 怎么得出的吗,还是外部传入的,A: / NOTE: ipts is the PTS of the _first_ picture beginning in this packet if any / is-video_st-codec-reordered_opaque pkt-pts len1 avcodec_decode_videois-video_st-codec frame got_picture pkt-data pkt-size if decoder_reorder_pts pkt-dts AV_NOPTS_VALUE frame-reordered_opaque AV_NOPTS_VALUE pts frame-reordered_opaque else ifpkt-dts AV_NOPTS_VALUE pts pkt-dts else pts 0 pts av_q2dis-video_st-time_baseQ:我贴下 VLC 的代码,(vlc-0.9.8a/modules/codec/avcodec/video.c 文件中) i_usedavcodec_decode_videop_sys-p_context p_sys-p_ff_pic b_gotpicture p_sys-i_buffer b_flush NULL :uint8_tp_sys-p_buffer p_sys- i_buffer 中间省略取得 PTS , ifp_sys-p_ff_pic-pts printf p_sys-p_ff_pic-pts Lxn p_sys-p_ff_pic-pts p_sys-i_pts p_sys-p_ff_pic-pts 从 AVFrame 结构中取得这个 PTS ,但是这个AVFrame 结构中取得这个 PTS 从哪里取得的呢,A:时间戳一般是在编码的时候加入到媒体文件中的,所以在解码时可以从中分析出 PTS。