基于标签相关性的K近邻多标签分类方法

多标签多分类算法

多标签多分类算法

多标签多分类算法指的是同时将一个样本分到多个分类标签中的分类算法。

在传统的分类算法中,每个样本只能被分到一个分类标签中,而多标签多分类算法可以将一个样本分到多个分类标签中,从而更准确地描述样本的特征。

常见的多标签多分类算法包括:

1. One-vs-Rest (OvR):将每个分类标签作为一个二分类问题,训练多个分类器,将样本分到每个分类标签中的一个或多个分类器中。

2. Binary Relevance (BR):将多标签多分类问题转化为多个二分类问题,每个标签对应一个二分类问题,训练多个二分类器,将样本分到每个标签中的一个分类器中。

3. Classifier Chains (CC):将每个标签作为一个二分类问题,但是每个分类器的输入还包括前面的分类结果,训练多个二分类器,将样本按照一定的顺序传递给不同的分类器进行分类。

4. Label Powerset (LP):将每个样本的多个标签组合成一个新的标签,将多标签多分类问题转化为多分类问题,训练一个多分类器。

5. Random k-labelsets (RAkEL):随机选择k个标签子集,将多标签多分类问题转化为多个二分类问题,训练多个二分类器,根据预测结果组合成最终的标签集。

这些算法各有优缺点,适用于不同的问题和数据集。

在选择多

标签多分类算法时,需要根据实际情况考虑算法的复杂度、准确性和可扩展性等因素。

机器学习经典分类算法——k-近邻算法(附python实现代码及数据集)

机器学习经典分类算法——k-近邻算法(附python实现代码及数据集)⽬录⼯作原理存在⼀个样本数据集合,也称作训练样本集,并且样本集中每个数据都存在标签,即我们知道样本集中每⼀数据与所属分类的对应关系。

输⼊没有标签的新数据后,将新数据的每个特征与样本集中数据对应的特征进⾏⽐较,然后算法提取样本集中特征最相似数据(最近邻)的分类特征。

⼀般来说,我们只选择样本数据集中前k个最相似的数据,这就是k-近邻算法中k的出处,通常k是不⼤于20的整数。

最后选择k个最相似数据中出现次数最多的分类,作为新数据的分类。

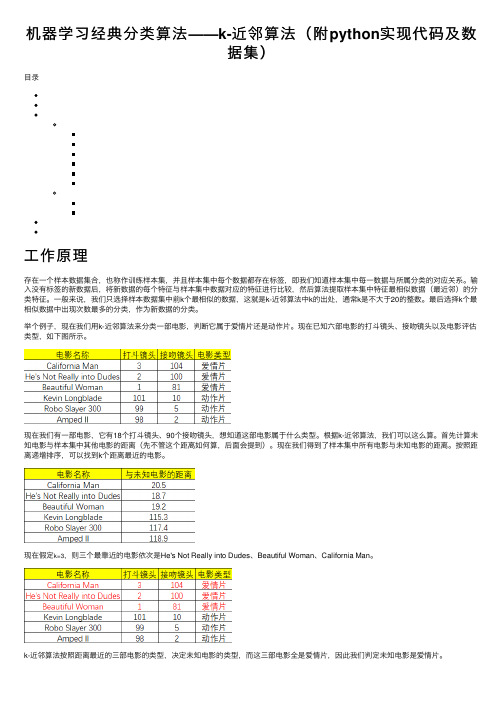

举个例⼦,现在我们⽤k-近邻算法来分类⼀部电影,判断它属于爱情⽚还是动作⽚。

现在已知六部电影的打⽃镜头、接吻镜头以及电影评估类型,如下图所⽰。

现在我们有⼀部电影,它有18个打⽃镜头、90个接吻镜头,想知道这部电影属于什么类型。

根据k-近邻算法,我们可以这么算。

⾸先计算未知电影与样本集中其他电影的距离(先不管这个距离如何算,后⾯会提到)。

现在我们得到了样本集中所有电影与未知电影的距离。

按照距离递增排序,可以找到k个距离最近的电影。

现在假定k=3,则三个最靠近的电影依次是He's Not Really into Dudes、Beautiful Woman、California Man。

python实现⾸先编写⼀个⽤于创建数据集和标签的函数,要注意的是该函数在实际⽤途上没有多⼤意义,仅⽤于测试代码。

def createDataSet():group = array([[1.0,1.1],[1.0,1.0],[0,0],[0,0.1]])labels = ['A','A','B','B']return group, labels然后是函数classify0(),该函数的功能是使⽤k-近邻算法将每组数据划分到某个类中,其伪代码如下:对未知类别属性的数据集中的每个点依次执⾏以下操作:(1)计算已知类别数据集中的点与当前点之间的距离;(2)按照距离递增次序排序;(3)选取与当前点距离最⼩的k个点;(4)确定前k个点所在类别的出现频率;(5)返回前k个点出现频率最⾼的类别作为当前点的预测分类。

多标签文本分类 匹配方法 比赛方案

多标签文本分类匹配方法比赛方案在自然语言处理领域,多标签文本分类是一项具有挑战性的任务。

为了提高分类的准确性和效率,研究者们提出了各种各样的匹配方法和比赛方案。

本文将详细介绍多标签文本分类中的匹配方法以及一些典型的比赛方案。

一、多标签文本分类概述多标签文本分类是指在一个文本中同时存在多个标签,且这些标签之间具有一定的关联性。

与传统的单标签分类不同,多标签分类任务需要模型能够识别出文本中所有的相关标签。

例如,在新闻分类任务中,一篇文章可能同时属于“体育”、“娱乐”和“财经”等多个类别。

二、匹配方法在多标签文本分类任务中,匹配方法的选择至关重要。

以下是一些常见的匹配方法:1.基于集合的方法:将标签看作一个集合,通过计算文本与每个标签的相似度,选择相似度最高的标签集合作为预测结果。

常见的基于集合的方法有K 近邻(KNN)和基于聚类的分类方法。

2.基于规则的方法:通过预定义的规则对文本进行分类。

这些规则可以是基于词汇、语法或语义的。

例如,使用正则表达式或条件随机字段(CRF)进行分类。

3.基于模型的方法:利用机器学习模型对文本进行分类。

常见的模型包括朴素贝叶斯、支持向量机(SVM)、决策树、随机森林和深度学习方法(如卷积神经网络、循环神经网络等)。

4.基于注意力机制的方法:通过为文本中的不同部分分配不同的权重,提高分类的准确性。

注意力机制可以与深度学习模型结合使用,如基于注意力机制的卷积神经网络(ACNN)和基于注意力机制的循环神经网络(ARNN)。

5.基于图的方法:将文本表示为图结构,利用图神经网络(GNN)等模型进行分类。

三、比赛方案在多标签文本分类比赛中,参赛者通常会采用以下方案:1.数据预处理:对原始数据进行清洗、去重、分词等操作,提高数据质量。

2.特征工程:从文本中提取有助于分类的特征,如词袋模型、TF-IDF、词嵌入等。

3.模型选择与调优:根据任务特点选择合适的模型,并通过交叉验证等方法对模型参数进行调优。

k-近邻分类算法

k-近邻分类算法K近邻分类算法是一种基于实例的分类算法,它的主要思想是通过计算每个样本点与其周围的k个最近邻点的距离来确定该点的类别。

该算法主要应用于分类问题中,并且在实际应用过程中具有很好的可用性、易实现性和理解性。

算法原理算法首先通过确定k值来确定分类的邻域大小,以及根据k值的选择来确定分类的准确性和鲁棒性。

之后通过计算每个样本点与其邻域内k个最近邻点之间的距离来确定该样本点所属的分类。

具体流程如下:1.确定数据集中的k值和距离度量标准;2.对于每个待分类的样本点,计算与其邻域中k个最近邻点之间的距离;3.根据邻域中k个最近邻点的类别来确定该样本点所属的类别;4.重复步骤2和3,直到所有待分类的样本点均被分类完毕;5.给出分类结果。

距离度量标准在k-近邻分类算法中,距离度量标准是非常重要的,因为它决定了样本点之间距离的计算方式。

目前常见的距离度量标准有欧式距离、曼哈顿距离和切比雪夫距离。

欧式距离:$d=\sqrt{{\sum_{i=1}^{n}{(x_i-y_i)^2}}}$优缺点1.基于实例,不需要对数据进行任何假设和理论分析;2.算法的可预测性高,具有很好的分类性能;3.没有过拟合的现象,可以对复杂的数据集进行分类;4.整体而言,k-近邻分类算法非常容易理解和实现。

1.计算量比较大,对于大型数据集而言,算法的效率较低;2.对于高维数据集而言,容易出现维数灾难问题,即算法的效果会逐渐降低;3.容易受到异常值的影响,且在分类决策区域方面可能存在不连续的问题。

应用场景k-近邻分类算法广泛应用于模式识别、数据挖掘和生物信息学等领域,特别适合处理较小的数据集。

目前该算法已被应用于医疗诊断、电子商务、物联网等领域,既可以用于分类问题,也可以用于回归问题。

同时,对于分类问题而言,该算法并不适用于类别数比较多或类别间存在相互交叉的情况。

因此,在实际应用过程中,应根据具体情况来选择算法,以达到最佳的分类效果。

knn算法的例子

knn算法的例子k-最近邻算法(k-nearest neighbors,简称k-NN)是一种常用的分类和回归算法。

它基于一个简单的假设:如果一个样本的k个最近邻属于某个类别,那么该样本也很可能属于该类别。

k-NN算法非常直观和易于理解,因此被广泛应用于各种领域。

下面将以几个具体的例子来说明k-NN算法的应用。

1. 手写数字识别在机器学习领域,手写数字识别是一个经典的问题。

k-NN算法可以用于将手写数字图片分类成0到9之间的数字。

基于已有的数字图片数据集,可以计算待分类图片与每个已有图片的距离,并找出k 个最近邻。

然后根据这k个最近邻的标签来判断待分类图片的数字。

2. 电影推荐系统在电影推荐系统中,k-NN算法可以根据用户的历史评分和其他用户的评分来预测用户可能喜欢的电影。

通过计算待推荐电影与用户历史评分电影的相似度,找出k个最相似的电影,并根据这些电影的评分来预测用户对待推荐电影的评分。

3. 股票市场预测k-NN算法可以用于预测股票市场的趋势。

基于已有的股票数据,可以计算待预测股票与历史股票的相似度,并找出k个最相似的股票。

然后根据这k个股票的涨跌情况来预测待预测股票的涨跌。

4. 医学诊断在医学诊断中,k-NN算法可以帮助医生根据患者的各项指标来预测患有哪种疾病。

通过计算待预测患者与已有患者的相似度,找出k 个最相似的患者,并根据这些患者的疾病情况来预测待预测患者的疾病。

5. 文本分类k-NN算法可以用于文本分类,例如将新闻文章分类成不同的主题。

基于已有的训练数据,可以计算待分类文本与每个已有文本的相似度,并找出k个最相似的文本。

然后根据这k个文本的主题来预测待分类文本的主题。

6. 信用评估在信用评估中,k-NN算法可以用于预测申请贷款的人是否具有良好的信用记录。

通过计算待评估人员与已有人员的相似度,找出k个最相似的人员,并根据这些人员的信用记录来预测待评估人员的信用状况。

7. 图像处理k-NN算法可以用于图像处理,例如图像分类和图像检索。

k近邻算法模型

k近邻算法模型

K近邻算法(K-Nearest Neighbors, KNN)是一种基于实例的学习方法,它通过计算输入样本与训练样本之间的距离,找到与输入样本距离最近的K个训练样本,然后根据这K个样本的标签进行分类或回归。

K近邻算法的基本思想是:如果一个样本在特征空间中的K个最相似(即特征空间中最邻近)的样本中的大多数属于某一个类别,则该样本也属于这个类别。

K近邻算法的模型可以分为两种:分类模型和回归模型。

1. 分类模型

K近邻算法的分类模型是指将输入样本分到K个最近邻样本所属的类别中的多数类别。

具体步骤如下:

(1)计算训练样本集中每个样本与输入样本之间的距离。

(2)按照距离从小到大的顺序,选取K个距离最近的样本。

(3)统计这K个样本所属类别的出现次数。

(4)将输入样本分到出现次数最多的类别中。

2. 回归模型

K近邻算法的回归模型是指根据K个最近邻样本的标签值,预测输入样本的标签值。

具体步骤如下:

(1)计算训练样本集中每个样本与输入样本之间的距离。

(2)按照距离从小到大的顺序,选取K个距离最近的样本。

(3)计算这K个样本的标签值的平均值。

(4)将输入样本的标签值预测为平均值。

K近邻算法是一种简单而有效的模型,但是它也有一些缺点,比如计算复杂度高、存储空间大、容易受到噪声干扰等。

在实际应用中,需要根据具体情况选择合适的K值和距离度量方法,以取得更好的分类或回归效果。

多标签分类(multi-labelclassification)综述

多标签分类(multi-labelclassification)综述意义⽹络新闻往往含有丰富的语义,⼀篇⽂章既可以属于“经济”也可以属于“⽂化”。

给⽹络新闻打多标签可以更好地反应⽂章的真实意义,⽅便⽇后的分类和使⽤。

难点(1)类标数量不确定,有些样本可能只有⼀个类标,有些样本的类标可能⾼达⼏⼗甚⾄上百个。

(2)类标之间相互依赖,例如包含蓝天类标的样本很⼤概率上包含⽩云,如何解决类标之间的依赖性问题也是⼀⼤难点。

(3)多标签的训练集⽐较难以获取。

⽅法⽬前有很多关于多标签的学习算法,依据解决问题的⾓度,这些算法可以分为两⼤类:⼀是基于问题转化的⽅法,⼆是基于算法适⽤的⽅法。

基于问题转化的⽅法是转化问题数据,使之使⽤现有算法;基于算法适⽤的⽅法是指针对某⼀特定的算法进⾏扩展,从⽽能够处理多标记数据,改进算法,适⽤数据。

基于问题转化的⽅法基于问题转化的⽅法中有的考虑标签之间的关联性,有的不考虑标签的关联性。

最简单的不考虑关联性的算法将多标签中的每⼀个标签当成是单标签,对每⼀个标签实施常见的分类算法。

具体⽽⾔,在传统机器学习的模型中对每⼀类标签做⼆分类,可以使⽤SVM、DT、Naïve Bayes、DT、Xgboost等算法;在深度学习中,对每⼀类训练⼀个⽂本分类模型(如:textCNN、textRNN等)。

考虑多标签的相关性时候可以将上⼀个输出的标签当成是下⼀个标签分类器的输⼊。

在传统机器学习模型中可以使⽤分类器链,在这种情况下,第⼀个分类器只在输⼊数据上进⾏训练,然后每个分类器都在输⼊空间和链上的所有之前的分类器上进⾏训练。

让我们试着通过⼀个例⼦来理解这个问题。

在下⾯给出的数据集⾥,我们将X作为输⼊空间,⽽Y作为标签。

在分类器链中,这个问题将被转换成4个不同的标签问题,就像下⾯所⽰。

黄⾊部分是输⼊空间,⽩⾊部分代表⽬标变量。

在深度学习中,于输出层加上⼀个时序模型,将每⼀时刻输⼊的数据序列中加⼊上⼀时刻输出的结果值。

knn分类方法的原理

knn分类方法的原理

KNN(K-Nearest Neighbors)分类方法的原理是基于近邻实例的特征相似性原则。

它可以被描述为以下步骤:

1. 计算待分类样本与训练集中每个样本之间的距离。

常见的距离度量方式包括欧氏距离、曼哈顿距离、余弦距离等。

2. 选择与待分类样本距离最近的K个训练集样本,这些样本被称为K个最近邻。

3. 根据这K个最近邻的标签,进行投票或加权投票来确定待分类样本的类别。

投票策略可以是简单多数表决,也可以是加权投票,即根据距离远近对投票结果进行加权。

KNN分类方法的主要原理是基于实例间的相似性,即认为与一个实例相似的实例往往具有相似的类别标签。

KNN方法的可解释性较强,并且它不需要在训练阶段建立模型,因此它是一种懒惰学习(lazy learning)算法。

但是,KNN方法的计算复杂度较高,特别是在处理大规模数据集时。

另外,KNN方法对于维度灾难问题比较敏感,即在高维空间中往往会出现样本稀疏和距离失效的问题,因此需要进行特征选择和降维预处理。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

5) 6)

equation(2);

end

(2)得到:

for^∈{1,2,…,ml

set

do

to

calculate F“and Fi according m and

n

equation(5);

P(叫)=1羔,尸(砩)=l—P(硝) E)=———土坚咀币r

s+∑于q P(雩l

(s

7)

according

set

equation(8)

出它与其他标签的关系。设凡表示在未见示例并中Ⅳ。成立

20)

y.to+1,

21)else

221 end

y。to 0;

时,珥成立的事件;F#表示在未见示例茗中皿不成立时,q成

立的事件。

fP(璺)=P(钙I皿)=尸(q鼠)/P(只’

个近邻后统计近邻样本所包含的标签信息,通过最大化后验 概率的方式预测未见示例的标签集合。 已知未见示例戈和其对应的标签集Y且有Y∈Y,令Y,表 示样本的标签集向量,对于每一个取自Y的标签z,在示例茗含 有z时,Y,的分量Y,(f)=1;否则取值为0。设Ⅳ(石)表示未见 示例戈在训练集中的后个最近邻集,c;(z)表示近邻集合N(X)

输入训练数据集x和标签集Y,设置近邻数K,平滑参数s,参 数n。 输出未知示例x对应的标签集合。 1)fori∈{1,2,…,q}do 2)

3)

将z作为其相关标签的样本个数;硝为示例茗含有标签z的事 件,成为示例石不含有标签f的事件;E:(0≤j≤l N(t)I)表

示在石的近邻中有J个示例含有标签f的事件。 基于贝叶斯概率公式的ML.KNN方法的分类函数如式 (1)所示:来自tothe Fi and

R;

(2)

8)

end

9)end lO)foriE{1,2,…,m}do 11)identi母Ⅳ(x)for。;

后验概率P(耳I联)可以由式(3)~(4)得到:

(3)

12)end

P(彰f珑)=———』业业‰厂

(s

I,v(£)I+1)+∑c[p]

13)forJ∈{1,2,…,g}do 14) for^∈{1,2,…,JⅣ(x)l}

calculate

(4)

15)

P(q q)and Jp(q I、吩)for

Yl accoIding

to

IⅣ(t)I+1)+∑c’[p]

equation(3);

161 end

2

本文算法

本文采用二阶处理方法,对每一个标签),。(1≤i≤q)求

17)end

18)for Y。∈t

19)

do

to

set月x,yf)accoIding if,(x,y。)>1,set

(‘,n)一rg。一maHx(P(■))

ML.KNN算法 ML—KNN算法是采用K近邻分类准则,在求出样本的K

碍成立的概率的最大值;在求得‘和‘的过程中充分考虑了

标签之间的相关性,m和n分别表示在对应最大值时的标签。 利用求得的最大值和其预测值结合到式(2)中来预测标签Y。 的值,即有分类函数: 灭聋,,,.)=

Anhui 230601,China)

Abstract:Since the Muhi—Label K Nearest Neighbor f ML.KNNl classification algorithm ignores the correlation between labels,a multi—label classification algorithm by exploiting label correlation named CML.KNN Was proposed.Firstly。the

conditional probability between each pair of labels was calculated.Secondly.the conditional probabilities of predicted labels and the conditional probability of the label to be predicted

Journal of Computer Applications

ISSN 100l,9081 CODEN JYIIDU

2015—10.10

计算机应用,2015,35(10):2761—2765 文章编号:1001—9081(2015)10—2761-05

http://www.joca.an

doi:10.11772/j.issn.1001—9081.2015.10.2761

收稿日期:2015—06一01:修回日期:2015-06—24。

Classifiers)’91方法是使用cc作为基分类器来进行集成的方

基金项目:安徽省科技攻关计划项目(1301hiM2020);高等学校博士学科点专项科研基 刘政怡(1978一),女,安徽芜湖人,副教

金资助项目(20133401110009);安徽大学研究生学术创新项目(Yghl00166)。 作者简介:檀何风(1990一),女,安徽安庆人,硕士研究生,主要研究方向:机器学习、人工智能; 授,博士,主要研究方向:人工智能。

1≤i≤m,戈。E

x,¨£Y}。多标签学习算法的主

要任务是从训练集D中学习得到一个多标签分类函数厂:石× l,一R,以戈,y)可以看作示例z具有类别标签),的最大可能 性,从而根据此分类函数来判断未知示例所含有的标签集合。

1.2

其中:‘表示P(FF)中的最大值,即当Hm成立时,吗成立的

概率的最大值;FJ表示P(Fi)中的最大值,即当玩不成立时,

竺!堡![竺兰竺!g!堡!±!!二竺!兰生兰里!竺塑兰!竺!]

P(、只)[n×P(q I,哆)+(1—8)×t

X

prection(n)] (8)

其中:prection(m)和prection(n)分别表示对应最大值的标 签的预测值;o值是为了调节标签相关性的影响度,从而得到 使分类效果最好时的比例关系。 算法CML-KNN。

万方数据

2762

计算机应用

第35卷

入标签相关性后的K近邻多标签分类算法,有效地解决了标 签相关性的问题,并取得了良好的分类效果。 1

1.1

相关介绍

多标签问题的定义 设示例空间为x={x。,戈:,…,x。}¨0】,标签空间为l,=

尸(钙、刖=—型—瓦_了一

(1,m)=arg。;m。;aJ-lx(P(Fi))

on

Emotions dataset outperforms the other four algorithms,namely ML—KNN,AdaboostMH,RAkEL,BPMLL,while only two

on

evaluation metric values are lower than those of ML.KNN and RAkEL show that CML.KNN obtains better classification results. Key words:label classification correlation;Multi—label K Nearest

were

ranked,then the

maximum

was

got.Finally,a

new

classification model by combining Maximum A Posteriori(MAP)and the product of the maximum and its corresponding label value was proposed and the new label value was predicted.The experimental results show that the performance of CML—KNN

Yeast and Enron datasets.The experimental analyses

Neighbor(ML・KNN);conditional probability;multi—label

0

引言

随着信息技术的发展与社会的进步,多标签分类‘1。已经

处理,但其忽略了标签问的相关性。“,很大程度上影响了分 类的效果;LP(Label Power—set)”。方法考虑到标签间的相关 性,将每个样本所含的标签全部融合成一个新的标签,但该方 法可能导致训练样本不足以及训练复杂度过高等问题。算法 转化法是通过对传统的分类方法进行改进,使其能适应于多 标签数据的分类,该类方法没有对特定的单标签方法进行限 定,主要有基于BP神经网络”j、Adaboost‘6 o、K近邻方法07j等 的多标签分类方法。集成方法主要是为了实现更好的分类效 果,对常用的问题转换方法和算法转换方法进行结合来处理 多标签分类问题。如:RAkEL(Random k-labelsets)哺1方法是 基于LP方法的集成算法,此方法在考虑标签间相关性的同 时,避免了LP方法存在的缺点;ECC(Ensemble 法,降低了CC方法在分类准确率方面的负面影响。 K近邻多标签分类方法是使用较多的多标签分类方法, 但是在此方法中没有考虑标签间的相关性,从而使得其在分 类时不能取得很好的性能。本文针对这类问题提出了一种加

Yz¨)’8。g。毋踽—■雨扩2

…P(磁)P(E;I域)

arg。ma…x P(珑)P(E;I磁)

(1) 对于每一个单独的类别y,,其对应的先验概率可以由式

forJ∈{1,2,…,m}do

calculate label counting

P(只)and P(1只)according

to

即通过式(1)值的大小来确定示例石是否包含标签f。

s+∑(y。∈l

and乃隹yf)