关于广义线性回归参数极大似然估计相合性的若干问题

第四章-广义线性回归

p 维向量

。

;其中

此时,对应的检验假说为

。

在 下有

。

假定扰动项服从正态分布,则无约束下的对数似然函数为:

,参数 为

参数 对应的一阶导和二阶导为:

则在 下有

其中, 由于信息矩阵 可构造如下:

,

。

为分块对角阵,则约束

即 LM 统计量的值等于 g 对 Z 回归的回归平方和的一半。 又因为在正态分布设定条件下有

检验统计量计算如下:

(4-14)

其中, 和 通常取

分别为两段样本 LS 回归的残差, 和 ,则上式可简化为:

为对应的样本长度。

(4-15)

注意,计算上式 F 统计量时,必须把较大者放在分子。 Goldfeld-Quandt 检验是 LS 估计框架下最简单的方差检验,它与普通的方差结构变化检

验非常接近,比较容易计算。但它也具有一定的局限性:首先,扰动项假定服从正态分布;

和 )下,上述的两

5 / 26

第四章 广义线性回归

其中,

。

需要注意的是,当我们假定

时,事实上是假定了一种特殊的非球形扰动形

式,这种假定很有可能是不准确的,因此,基于这种特定形式下的估计结果必须建立在相应

的诊断性检验上。

4.2 异方差

4.2.1 异方差检验

异方差设定具体有两种形式:一般的异方差形式设定各期扰动项的方差都不同,此时通 常会假定这种异方差与某些变量有关;另一种特殊的形式则是设定不同组间存在异方差,即 把数据划分为若干组,并假定各组扰动项的方差不同,但在同一组内方差相同。

如果协方差阵未知,则 FGLS 估计如下:

此时,对 WLS 估计的两步估计可以使用迭代的方法。

3.协方差一致稳健估计

回归系数的估计方法 -回复

回归系数的估计方法-回复回归分析是统计学中常用的一种方法,用于研究两个或多个变量之间的关系。

在回归分析中,我们常常需要估计回归模型的系数,以了解自变量对因变量的影响程度。

本文将介绍几种常见的回归系数估计方法。

2. 最小二乘法估计(OLS)最小二乘法(Ordinary Least Squares, OLS)是回归分析中最常用的系数估计方法之一。

其基本思想是通过最小化实际观测值与回归直线(或曲线)之间的误差平方和来估计回归系数。

具体而言,OLS方法估计的回归系数使得误差平方和最小化。

常见的回归模型可以表示为:Y = β0 + β1X1 + β2X2 + ... + βnXn + ε其中,Y是因变量,X1、X2、...、Xn是自变量,β0、β1、β2、...、βn是待估计的回归系数,ε是误差项。

OLS方法通过最小化误差平方和来估计β0、β1、β2、...、βn的值,使得预测结果与实际观测值的差异最小化。

3. 最大似然估计(MLE)最大似然估计(Maximum Likelihood Estimation, MLE)是另一种常用的回归系数估计方法。

MLE方法基于一个假设,即回归模型中的误差项是独立同分布的,并且服从某个已知的概率分布(如正态分布)。

根据这一假设,MLE方法通过选择最有可能产生已观测数据的参数值来估计回归系数。

具体而言,MLE方法通过构建似然函数来描述已观测数据出现的概率,并最大化似然函数。

似然函数的形式取决于回归模型和误差项的分布假设。

对于线性回归模型和正态分布的误差项,似然函数可以用正态分布的概率密度函数表示。

通过最大化似然函数,得到的参数值即为回归系数的估计值。

4. 鲁棒回归估计(Robust Regression)OLS方法和MLE方法都对数据的假设有一些要求,包括误差项的独立同分布性和分布假设。

然而,现实中的数据往往并不满足这些要求。

因此,为了提高回归模型的鲁棒性,鲁棒回归估计方法被提出。

回归系数的估计方法 -回复

回归系数的估计方法-回复回归系数的估计方法是在回归分析中使用的一种统计技术。

回归分析用于研究因变量与自变量之间的关系,并且可以预测因变量的值。

回归系数是用来衡量自变量对因变量的影响程度的指标。

本文将介绍常用的回归系数估计方法,并对每个方法进行详细说明和比较。

回归系数的估计方法主要有:最小二乘法、最大似然估计和贝叶斯估计。

最小二乘法是回归分析中最常用的估计方法。

该方法的基本思想是通过最小化观测数据与回归线之间的残差平方和来估计回归系数。

残差是预测值与实际观测值之间的差异,在最小二乘法中,我们尝试找到一条回归线,使得所有观测值与该回归线的残差平方和最小。

通过最小二乘法估计的回归系数具有良好的统计性质,包括无偏性和最小方差性。

最小二乘法适用于线性回归和非线性回归模型。

最大似然估计是另一种常用的回归系数估计方法。

该方法的基本思想是找到一组回归系数,使得对观测数据的似然函数达到最大。

似然函数是描述观测数据在给定模型下出现的概率,通过最大化似然函数,我们可以得到最有可能生成观测数据的回归系数估计。

最大似然估计方法通常需要对数据的分布做出一些假设,例如正态分布假设。

与最小二乘法不同,最大似然估计方法能够提供回归系数的置信区间,用于评估回归系数的统计显著性。

贝叶斯估计是一种基于贝叶斯统计理论的回归系数估计方法。

该方法的特点是将先验分布与观测数据进行结合,得到后验分布,并且通过后验分布来估计回归系数。

在贝叶斯估计中,先验分布可以是任意的概率分布,可以通过专家知识或历史数据进行设定。

通过后验分布,我们可以得到回归系数的点估计和区间估计,并且可以对不确定性进行概括。

贝叶斯估计方法通常需要进行模型的较复杂的计算,但在面对数据不完备或先验不确定的情况下具有一定的优势。

在实际应用中,选择适合的回归系数估计方法取决于具体的问题和数据特征。

最小二乘法是一种简单直观的估计方法,适用于大多数的回归问题。

最大似然估计方法对数据的概率分布做出假设,可以提供回归系数的统计显著性。

逻辑回归的极大似然估计推导

逻辑回归的极大似然估计推导逻辑回归是一种常用的分类模型,它通过将线性回归应用于逻辑函数(也称为“sigmoid函数”)来解决二分类问题。

在逻辑回归中,我们可以使用极大似然估计来推导模型参数,并通过最大化似然函数来获得最优参数。

假设我们有一个二分类问题,标签为0和1。

我们的目标是根据输入特征x预测样本的标签。

逻辑函数是一种常用的数学函数,它可以将连续的实数映射到介于0和1之间的概率。

逻辑函数的定义如下:f(z) = 1 / (1 + e^(-z))其中z为线性回归的结果,可以表示为:z = w^T * x + b我们希望通过调整参数w和b,使得逻辑函数f(z)能够最好地拟合训练数据。

在逻辑回归中,我们假设每个样本的标签都是独立同分布的,并且服从伯努利分布。

给定样本特征x和标签y,我们可以表示样本的标签概率为:P(y=1|x) = f(z)^y * (1 - f(z))^(1-y)P(y=0|x) = (1 - f(z))^y * f(z)^(1-y)由于y的取值只能是0或1,上述两个公式可以简化为:P(y=1|x) = f(z)^y * (1 - f(z))^((1-y))P(y=0|x) = (1 - f(z))^y * f(z)^(1-y)我们可以将上述两个公式合并为一个公式:P(y|x) = f(z)^y * (1 - f(z))^((1-y))这个公式的含义是,当样本标签为1时,我们希望预测的概率P(y|x)尽可能接近1;当样本标签为0时,我们希望预测的概率P(y|x)尽可能接近0。

接下来,我们使用极大似然估计的方法来推导模型参数w和b。

假设我们有m个训练样本,x1, x2, ..., xm,并且分别对应的标签为y1, y2, ..., ym。

我们希望找到最优的参数w和b,使得似然函数(likelihood function)最大。

似然函数表示观察到训练数据的概率。

假设每个样本之间是独立同分布的,我们可以将似然函数表示为:L(w,b) = Π(P(yi|xi))我们可以使用对数似然函数(log-likelihood function)来简化计算:l(w,b) = log L(w,b) = Σ(log(P(yi|xi)))最大化对数似然函数等价于最小化损失函数(cost function):J(w,b) = -l(w,b)我们希望最小化损失函数,可以使用梯度下降等优化算法求解。

多元线性回归分析的参数估计方法

多元线性回归分析的参数估计方法多元线性回归是一种常用的数据分析方法,用于探究自变量与因变量之间的关系。

在多元线性回归中,参数估计方法有多种,包括最小二乘估计、最大似然估计和贝叶斯估计等。

本文将重点讨论多元线性回归中的参数估计方法。

在多元线性回归中,最常用的参数估计方法是最小二乘估计(Ordinary Least Squares,OLS)。

最小二乘估计是一种求解最优参数的方法,通过最小化残差平方和来估计参数的取值。

具体而言,对于给定的自变量和因变量数据,最小二乘估计方法试图找到一组参数,使得预测值与观测值之间的残差平方和最小。

这样的估计方法具有几何和统计意义,可以用来描述变量之间的线性关系。

最小二乘估计方法有一系列优良的性质,比如无偏性、一致性和有效性。

其中,无偏性是指估计值的期望等于真实参数的值,即估计值不会出现系统性的偏差。

一致性是指当样本容量趋近无穷时,估计值趋近于真实参数的值。

有效性是指最小二乘估计具有最小的方差,即估计值的波动最小。

这些性质使得最小二乘估计成为了多元线性回归中最常用的参数估计方法。

然而,最小二乘估计方法在面对一些特殊情况时可能会出现问题。

比如,当自变量之间存在多重共线性时,最小二乘估计的解不存在或不唯一。

多重共线性是指自变量之间存在较高的相关性,导致在估计回归系数时出现不稳定或不准确的情况。

为了解决多重共线性问题,可以采用一些技术手段,如主成分回归和岭回归等。

另外一个常用的参数估计方法是最大似然估计(Maximum Likelihood Estimation,MLE)。

最大似然估计方法试图找到一组参数,使得给定样本观测值的条件下,观测到这些值的概率最大。

具体而言,最大似然估计方法通过构建似然函数,并对似然函数求导,找到能够最大化似然函数的参数取值。

最大似然估计方法在一定条件下具有良好的性质,比如一致性和渐近正态分布。

但是,在实际应用中,最大似然估计方法可能存在计算复杂度高、估计值不唯一等问题。

最大似然估计及三大检验(WaldLMLR)讲解

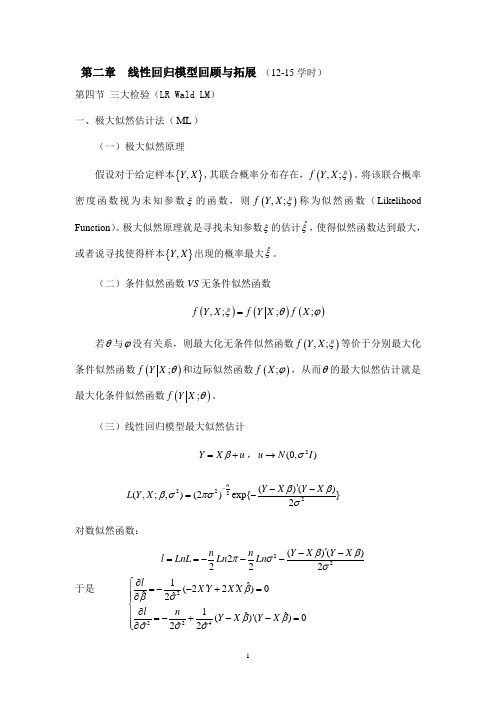

第二章 线性回归模型回顾与拓展 (12-15学时)第四节 三大检验(LR Wald LM ) 一、极大似然估计法(ML )(一)极大似然原理假设对于给定样本{},Y X ,其联合概率分布存在,(),;f Y X ξ。

将该联合概率密度函数视为未知参数ξ的函数,则(),;f Y X ξ称为似然函数(Likelihood Function )。

极大似然原理就是寻找未知参数ξ的估计ˆξ,使得似然函数达到最大,或者说寻找使得样本{},Y X 出现的概率最大ˆξ。

(二)条件似然函数VS 无条件似然函数()()(),;;;f Y X f Y X f X ξθϕ=若θ与ϕ没有关系,则最大化无条件似然函数(),;f Y X ξ等价于分别最大化条件似然函数();f Y X θ和边际似然函数();f X ϕ,从而θ的最大似然估计就是最大化条件似然函数();f Y X θ。

(三)线性回归模型最大似然估计Y X u β=+,2(0,)u N I σ→2222()()(,;,)(2)exp{}2nY X Y X L Y X βββσπσσ-'--=-对数似然函数:22()()2222n n Y X Y X l LnL Ln Ln ββπσσ'--==---于是 22241ˆ(22)0ˆˆ21ˆˆ()()0ˆˆˆ22l X Y X X l n Y X Y X βσβββσσσ∂⎧''=--+=⎪⎪∂⎨∂⎪'=-+--=⎪∂⎩得到 12ˆ()1ˆMLML X X X Y e e n βσ-⎧''=⎪⎨'=⎪⎩(三)得分(Score )和信息矩阵(Information Matrix )(;,)lf Y X θθ∂=∂称为得分; 12...k l l l l θθθθ∂⎡⎤⎢⎥∂⎢⎥∂⎢⎥⎢⎥∂⎢⎥∂⎢⎥=∂⎢⎥⎢⎥⎢⎥⎢⎥∂⎢⎥⎢⎥∂⎣⎦得分向量;(Gradient ) 海瑟矩阵(Hessian Matrix ):2l H θθ∂='∂∂信息矩阵:三*、带约束条件的最小二乘估计(拉格朗日估计)在计量经济分析中,通常是通过样本信息对未知参数进行估计。

INGARCH模型拟极大似然估计的相合性

INGARCH模型拟极大似然估计的相合性潘保国;林依勤【摘要】利用拟极大似然方法研究INGARCH模型参数的估计问题, 证明了拟极大似然估计的强相合性. 模拟结果表明, 在样本数较大时, 拟极大似然估计比最大似然估计效果更好.【期刊名称】《吉林大学学报(理学版)》【年(卷),期】2010(048)004【总页数】5页(P600-604)【关键词】INGARCH模型;平稳性;拟极大似然;相合性【作者】潘保国;林依勤【作者单位】湖南科技学院,数学与计算科学系,湖南,永州,425100;湖南科技学院,数学与计算科学系,湖南,永州,425100【正文语种】中文【中图分类】O212.6整数值时间序列在实际生活中普遍存在, 如某高校每年的退学学生人数, 某医院的每天住院病人数. 文献[1]提出了用整值GARCH(INGARCH)模型建模加拿大魁北克省北部从1990年1月到2000年10月弯曲杆菌感染的人数; 文献[2]研究了整值ARCH(p)模型的经验似然推断; 文献[3]利用矩方法和Bayes方法研究INGARCH(1,1)模型的参数估计问题; 文献[4]考虑了整值ARCH(p)模型的诊断检验问题; 文献[5]研究了泊松自回归过程, 并考虑了INGARCH(1,1)模型;文献[6]研究了泊松自回归模型的参数估计问题和检验问题. 一个整值过程{Xt}, 如果满足下列条件, 则称为INGARCH(p,q)过程:其中: Ft-1=σ(Xt-1,Xt-2,…); 参数α0>0, αi,βj(i=1,2,…,p; j=1,2,…,q)是非负的.文献[1]考虑了模型参数的最大似然估计, 本文在文献[1]的基础上给出该模型参数的拟极大似然估计, 讨论拟极大似然估计的相合性, 并给出了数值模拟.定义设其中: λt非负, 且关于Ft-1可测; {gθ|θ∈Θ}是定义在R×[0,∞)上满足一定正则条件的非负函数. 设Xt=(Xt,…,Xt-p+1)T, Ut=(λt,…,λt-q+1)T,则式(4)可表示为λt=gθ(Xt-1,Ut-1), 其中: θ∈K⊂Θ⊂Rd; K为紧参数空间.对任何初始值ν0∈[0,∞)q, 定义当t=0时, 当t≥1时, 其中随机映射Φt:C(K,[0,∞)q)C(K,[0,∞)q)满足[Φt(S)](θ)=(gθ(Xt,S(θ)),s1(θ),…,sq-1(θ))T,(5)且S(θ)=(s1(θ),…,sq-1(θ),sq(θ))T, 从而是Ut=(λt,…,λt-q+1)T的一个估计.定义其中是向量μ(s)=(μ1(s),…,μd(s))T的欧几里德范数.对于空间(B,‖·‖)中的序列(vt), 如果存在γ>1, 使得则称(vt)为这里‖·‖为一范数. 引理1[7] 假设模型(3)-(4)有唯一平稳遍历解(Xt,λt), 对于任意的x∈Rp, 映射(θ,s)gθ(x,s)是连续的, 满足下列条件:(1) E(log+‖Φ0(ν0)‖K)<∞;(2) E[(log+Λ(Φ0)]<∞, 并且存在正整数r, 使得则方程St+1=Φt(St)有唯一平稳遍历的解ht, 且ht关于Ft-1可测,其中引理2[7] 设ξt是一实值随机变量, 且是一可分Banch空间(B,‖·‖)的i.i.d随机元, 如果E(log+‖v0‖)<∞, 则收敛a.s.假设X-p+1,…,X0是已知数据, θ0是真实参数, 设(6)则拟极大似然估计定义为再定义(7)其中ht(θ)为引理1中方程St+1=Φt(St)(t∈Z)的唯一平稳遍历解ht的第一个分量. 引理3 假设下列条件成立:(1) 当θ=θ0, E(λ0)<∞时, 模型(3)-(4)有唯一的平稳遍历解(Xt,λt);(2) 设θ0∈K⊂Θ, K为紧集, 引理1的条件满足;(3) 存在常数M>0, 使得对任意的(x,s)∈ Rp×[0,∞)q, θ∈K, 有gθ(x,s)≥M;(4) 对所有的θ∈K, h0(θ)=λ0当且仅当θ=θ0;(5)(6)则拟极大似然估计是强相合的, 即证明: 设则由引理1知ξt是平稳遍历的. 由条件(1)和(5)知, E‖ξ0‖K<∞, 故由强大数定律知因为所以又由条件(1)和(6)知于是由引理2得故从而设则设则令f′(x)=0, 得x=λ0, x=-(λ0+1)(舍去), 所以当且仅当h0(θ)=λ0时, L(θ)取最大值. 由条件(4)知h0(θ)=λ0当且仅当θ=θ0, 因此当且仅当θ=θ0时, L(θ)取最大值. 假设∀ε>0, 有因为K∩{θ: |θ-θ0|≥ε}是紧集, 并且故存在D⊂及序列使得且由拟极大似然估计的定义可知,因为D≠Ø, 所以至少存在一个θ∈K∩{θ: |θ-θ0|≥ε}, 使得L(θ)≥L(θ0), 这与L在θ=θ0取极大值矛盾. 因此, 当n→∞时,定理1 设(Xt)是一个INGARCH(p,q)过程, 真实参数满足下列条件:(1)(2) 多项式和无公共根.设K⊂(0,∞)×[0,∞)p×B是紧集并且包含θ0, 其中B={(β1,…,βq)T∈[0,1)q|α1+…+αp+β1+…+βq<1}.(8)则证明: 由引理3, 只需验证引理3中条件(1)~(6)即可.由文献[1]知EX0<∞, 故Eλ0=EX0<∞, 因此引理3的条件(1)成立. 又由文献[1]知从而因此引理3的条件(6)成立. 引理3的条件(3)显然成立. 下面验证引理3的条件(2).由式(5)知其中:e1=(1,0,…,0)T∈Rq;设δ=β1+…+βq, 取b0∈Rq, r为正整数, 则易得(9)于是从而故当r→∞时, 而因此, 引理1的条件(2)满足. 引理1的条件(1)显然成立, 所以引理3的条件(2)成立.又由文献[1]知(10)其中序列(πl(θ))l∈N满足和并且(11)故存在M>0, 使得h0>M, 从而又存在0<λ<1, c>0, 使得|πl(θ)|≤cλl, 因此其中M′是一正常数, 故引理3的条件(5)成立.最后验证引理3的条件(4). 由引理1和引理3的条件(2)知, 当h0(θ)=λ0时,因此πl(θ)=πl(θ0), l∈N, 从而于是, 由式(11)和定理1的条件(1)和(2)可得θ=θ0, 显然当θ=θ0时, h0(θ)=λ0, 引理3的条件(4)得证.下面给出模型(1)-(2)的拟极大似然估计的数值模拟.以文献[5]中的模型(2)为例:其中: d=0.3; b=0.5; a=0.4.当模型(12)-(13)产生的样本数分别为n=500,1 000,5 000,10 000时, 对每组数据重复实现1 000次, 得到该模型参数的拟极大似然估计值和标准误差, 结果列于表1.表1 拟极大似然估计值和标准误差Table 1 Quasi-maximum likelihood estimators and standard errors参数样本数n拟极大似然估计标准误差d2000.317 2670.003 463 0a2000.398 5100.003 492 0b2000.487 3370.004 071 0d5000.310 6440.002 167 0a5000.397 2830.002 223 0b5000.495 6200.002 632 0d1 0000.301 5630.000 976 3a1 0000.398 5580.001 594 3b1 0000.501 0220.001 900 3由表1可见, 随着样本数的增加, 标准误差越来越小, 模型参数的估计值越来越接近真实值, 估计是相合的, 较准确. 与文献[5]中表1比较可见: 当n=200时, 拟极大似然估计值相对于极大似然估计值无明显优势;但当n=500,1 000时, 拟极大似然估计值比极大似然估计值更接近真实值. 因此, 拟极大似然估计在样本数较大时估计效果较好, 在样本数较小时, 估计效果较差.参考文献【相关文献】[1] Ferland R, Latour A, Oraichi D. Integer-Valued GARCH Process [J]. Journal of Time Series Analysis, 2006, 27(6): 923-942.[2] ZHU Fu-kang, WANG De-hui, LI Feng-xiang, et al. Empirical Likelihood Inference for an Integer-Valued ARCH(p) Model [J]. Journal of Jilin University: Science Edition, 2008, 46(6): 1042-1048. (朱复康, 王德辉, 李凤翔, 等. 一个整值ARCH(p)模型的经验似然推断 [J]. 吉林大学学报: 理学版, 2008, 46(6): 1042-1048.)[3] ZHU Fu-kang, LI Qi. Moment and Bayesian Estimation of Parameters in the INGARCH(1,1) Model [J]. Journal of Jilin University: Science Edition, 2009, 47(5): 899-902. (朱复康, 李琦. INGARCH(1,1)模型参数的矩估计和Bayes估计 [J]. 吉林大学学报: 理学版, 2009, 47(5): 899-902.)[4] ZHU Fu-kang, WANG De-hui. Diagnostic Checking Integer-Valued ARCH(p) Models Using Conditional Residual Autocorrelations [J]. Computational Statistics and Data Analysis, 2010, 54(2): 496-508.[5] Fokianos K, Rahbek A, Tjotheim D. Poisson Autoregression [J]. Journal of the American Statistical Association, 2009, 104: 1430-1439.[6] ZHU Fu-kang, WANG De-hui. Estimation and Testing for a Poisson Autoregressive Model [J]. Metrika, 2009, doi: 10.1007/s00184-009-0274-z.[7] Straumann Daniel. Estimation in Conditionally Herteroscedastic Time Series Models [M]. Berlin: Springer, 2005.。

计量经济学学习与Stata应用笔记(五)极大似然估计MLE

计量经济学学习与Stata 应⽤笔记(五)极⼤似然估计MLE极⼤似然估计的思想,就是在给定样本值的情况下,构建未知参数的函数,寻找能够使得观测到样本数据的可能性最⼤的估计参数。

定义似然函数为似然函数与联合密度函数相等,只是似然函数中 为⾃变量。

极⼤似然估计量为该⽆约束极值问题的⼀阶条件为对数似然函数的梯度向量为0,称为得分函数。

可以证明,得分函数的期望为0。

线性回归模型的极⼤似然估计假设线性回归模型为,扰动项符合独⽴同分布的正态变量。

写出对数似然函数,先计算给定的情况下选择最优,再带⼊求得最优。

可以解得可以看出MLE对于 的估计与 OLS 是⼀致的,对于⽅差的估计则不同,但此差别在⼤样本下消失。

MLE的⽅差估计量是有偏的,其优点在于⼤样本性质好。

三类渐进等价的统计检验对于线性回归模型,检验,其中为位置参数,已知,约束共有个。

沃尔德检验(Wald test)通过研究 的⽆约束估计量 与 的距离来检验。

其基本思想是,如果正确,则的绝对值不应该很⼤。

似然⽐检验(LR)LR检验的基本思想是,如果 正确,则 不应该很⼤。

L (θ;y ,⋯,y )=1n f (y ;θ)i =1∏n i θ=θML^arg max ln L (θ;y )s (θ;y )==∂θ∂ln L (θ;y )0y =Xβ+ϵy =Xβ+ϵln L (,)ββ~σ~2σ~2ββ~σ~2=β~ML (X X )X y(X X )X y T −1T T −1T =σ~ML 2ne e T βH :0β=β0ββ0K ββ^U β0H 0−β^U β0H 0ln L ()−β^U ln L (β)0拉格朗⽇乘⼦检验(LM)考虑有约束条件的对数似然函数最⼤化问题:引⼊拉格朗⽇乘⼦函数其中, 为拉格朗⽇乘⼦向量。

如果 接近0,则说明此约束条件不 tight,加上这个约束条件并不会使得似然函数的最⼤值下降很多,说明原假设很可能成⽴。

对 求导,求得⼀阶极值条件为 。