ceph安装配置说明

Ceph094安装手册

Ceph094.6安装-2016一、安装环境4台虚拟机,1台deploy,1台mon,2台osd,操作系统rhel71Ceph-adm 192.168.16.180Ceph-mon 192.168.16.181Ceph-osd1 192.168.16.182Ceph-osd2 192.168.16.183二、安装预环境1、配置主机名/ip地址(所有主机单独执行)hostnamectl set-hostname 主机名修改/etc/sysconfig/network-scripts/ifcfg-eno*IPADDR/NETMASK/GATEWAY2、adm节点上生成节点列表,/etc/ceph/cephlist.txt192.168.16.180192.168.16.181192.168.16.182192.168.16.1833、在adm上编辑/etc/hosts4、adm利用脚本同步所有节点的/etc/hosts[root@ceph-adm ceph]# cat /etc/ceph/rsync_hosts.shWorkDir=/etc/cephfor ip in $(cat ${WorkDir}/cephlist.txt);do echo -----$ip-----;rsync -avp --delete /etc/hosts $ip:/etc/;done5、所有主机生成ssh-key,并所有主机都执行id的copyssh-keygen -t rsassh-copy-id root@ceph-admssh-copy-id root@ceph-monssh-copy-id root@ceph-osd1ssh-copy-id root@ceph-osd26、adm上执行A、同步创建/etc/ceph目录[root@ceph-adm ceph]# cat mkdir_workdir.shWorkDir=/etc/cephfor ip in $(cat ${WorkDir}/cephlist.txt);do echo -----$ip-----;ssh root@$ip mkdir -p /etc/ceph ;doneb、同步关闭防火墙[root@ceph-adm ceph]# cat close_firewall.sh#!/bin/shset -xWorkDir=/etc/cephfor ip in $(cat ${WorkDir}/cephlist.txt)do echo -----$ip-----ssh root@$ip "sed -i 's/SELINUX=enforcing/SELINUX=disabled/g' /etc/selinux/config"ssh root@$ip setenforce 0ssh root@$ip "firewall-cmd --zone=public --add-port=6789/tcp --permanent"ssh root@$ip "firewall-cmd --zone=public --add-port=6800-7100/tcp --permanent"ssh root@$ip "firewall-cmd --reload"donec、所有脚本执行系统优化,打开文件限制[root@ceph-adm ceph]# cat system_optimization.sh#!/bin/shset -xWorkDir=/etc/cephfor ip in $(cat ${WorkDir}/cephlist.txt)do echo -----$ip-----ssh root@$ip "sed -i 's/4096/102400/' /etc/security/limits.d/20-nproc.conf"ssh root@$ip "cat /etc/rc.local | grep "ulimit -SHn 102400" || echo "ulimit -SHn 102400" >>/etc/rc.local"doned、编辑wty_project.repo和wty_rhel7.repo文件,并同步到所有节点[root@ceph-adm ceph]# cat rsync_repo.shWorkDir=/etc/cephfor ip in $(cat ${WorkDir}/cephlist.txt);do echo -----$ip-----;rsync -avp --delete /etc/ceph/*.repo$ip:/etc/yum.repos.d/;donee、安装ceph以及必要的rpm包[root@ceph-adm ceph]# cat ceph_install.sh#!/bin/shset -xWorkDir=/etc/cephfor ip in $(cat ${WorkDir}/cephlist.txt)do echo -----$ip-----ssh root@$ip "yum install redhat-lsb -y"ssh root@$ip "yum install ceph -y"done三、deploy安装,在adm节点1、deploy安装cd /etc/ceph/yum install ceph-deploy -y2、初始化集群[root@ceph-adm ceph]# ceph-deploy new ceph-mon3、安装集群ceph软件包(与二e的那一步有点重复,但是还是有需要的包要安装例如fcgi/ceph-radosgw)Ceph-deploy Install ceph-adm ceph-mon ceph-osd1 ceph-osd24、添加初始monitor节点和收集秘钥[root@ceph-adm ceph]# ceph-deploy mon create-initial5、osd节点操作A、osd1/osd2各增加2块100G硬盘B、adm节点操作ceph-deploy disk zap ceph-osd1:sdb ceph-osd1:sdc ceph-osd2:sdb ceph-osd2:sdcceph-deploy osd create ceph-osd1:sdb ceph-osd1:sdc ceph-osd2:sdb ceph-osd2:sdcceph –sceph osd tree检测正常*disk zap操作对硬盘进行zero操作,*osd create操作合并了osd prepare/osd activate操作,但是挂载目录不能指定/var/lib/ceph/osd/ceph-X6、将所有节点加为admin,使节点可以运行ceph的所有命令Ceph-deploy admin ceph-adm ceph-mon ceph-osd1 ceph-osd2。

Ceph iSCSI Gateway Demo安装配置

1)支持的传输协议较少; 2)对 SCSI 协议支持比较简单,一些 cluster 中的特性比如 PR 等都不支持,所以基于 stgt 的方案不能在 cluster 中使用; 3)由于是用户态框架,性能问题较差,根据网上的相关数据, tgt 在使用本地存储的 情况下,性能相比后面会提到的 SCST、 LIO 等是有一定差距的。

4.1.4 安装 scstadmin

拷贝 scstadmin-3.0.1.tar.bz2 到 iscsi gateway 节点上,执行以下命令: tar -jxvf scstadmin-3.0.1.tar.bz2 cd scstadmin-3.0.1 make make install

4.1.5 启动 iscst target

Client(linux)包括 multpath 和 iscsi initiator,initiator 使用 open-iscsi,每 个 initiator 可以连接到多个 Iscsi target。对于多个 target 后端对应的同一个 image, 则使用多路径软件聚合成一个块设备后提供给用户使用。这样可以解决网络故障或者 gateway 故障后,通过另一条链路能够继续提供服务。

由于我们的 Demo 是把多路径接入 ceph,把 ceph 通过 scsi target 软件映射到主机上使 用,因此我们多路径软件选择的是 linux 开源软件通用多路径 multipath 和 windows server 的 MPIO

3 总体概述

Ceph iSCSI Gateway Demo 整体框架包括三个部分,ceph cluster、iscsi gateway 和 client。

ceph使用方法

ceph使用方法摘要:1.Ceph简介2.Ceph组件及其作用3.安装Ceph4.Ceph使用方法5.Ceph的日常维护与管理6.Ceph性能优化7.常见问题与解决方案正文:Ceph是一款开源的分布式存储系统,具有高性能、可靠性高、可扩展性强等特点。

它主要由以下几个组件构成:1.Ceph Monitor(CMS):负责维护整个Ceph集群的元数据信息,包括监控各个节点的状态、集群映射关系等。

2.Ceph OSD:负责存储数据,包括数据存储和数据恢复。

OSD节点之间通过CRUSH算法实现数据分布和平衡。

3.Ceph Metadata Server:为Ceph客户端提供元数据服务,包括存储卷配置、快照、克隆等。

接下来,我们来了解一下如何安装和配置Ceph。

1.安装Ceph:首先,确保操作系统为CentOS 7及以上版本。

然后,按照官方文档的指引,依次安装Ceph Monitor、OSD和Metadata Server组件。

2.配置Ceph:安装完成后,需要对Ceph进行配置。

编辑Ceph配置文件(/etc/ceph/ceph.conf),设置相关参数,如:osd pool默认配置、monitor 选举算法等。

3.初始化Ceph:使用ceph-init命令初始化Ceph,之后启动Ceph相关服务。

4.创建存储池:使用ceph-volume命令创建存储池,为存储池分配OSD 节点。

5.创建卷:使用ceph-volume命令创建卷,并将卷挂载到客户端节点。

6.扩容存储池:当存储池空间不足时,可以通过添加OSD节点或调整pool参数进行扩容。

7.维护与管理:定期检查Ceph集群状态,使用ceph命令监控性能指标,如:osd tree、health monitor等。

8.性能优化:根据实际需求,调整Ceph配置文件中的相关参数,如:调整osd的osd_cache_size、osd_timeout等。

9.常见问题与解决方案:遇到问题时,可通过查询官方文档、社区论坛等途径寻求解决方案。

ceph安装手册(实验版)20220118

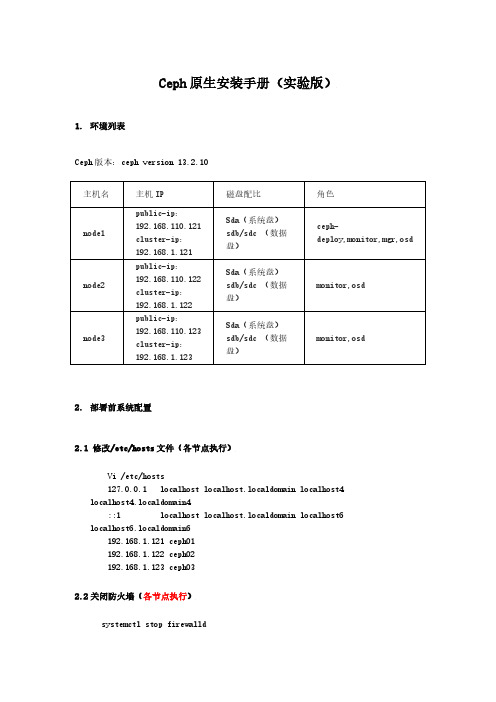

Ceph原生安装手册(实验版)1.环境列表Ceph版本:ceph version 13.2.10主机名主机IP 磁盘配比角色node1 public-ip:192.168.110.121cluster-ip:192.168.1.121Sda(系统盘)sdb/sdc (数据盘)ceph-deploy,monitor,mgr,osdnode2 public-ip:192.168.110.122cluster-ip:192.168.1.122Sda(系统盘)sdb/sdc (数据盘)monitor,osdnode3 public-ip:192.168.110.123cluster-ip:192.168.1.123Sda(系统盘)sdb/sdc (数据盘)monitor,osd2.部署前系统配置2.1 修改/etc/hosts文件(各节点执行)Vi /etc/hosts127.0.0.1 localhost localhost.localdomain localhost4 localhost4.localdomain4::1 localhost localhost.localdomain localhost6 localhost6.localdomain6192.168.1.121 ceph01192.168.1.122 ceph02192.168.1.123 ceph032.2关闭防火墙(各节点执行)systemctl stop firewalldsystemctl disable firewalldiptables -F(flush 清除所有的已定规则)setenforce 0vi /etc/selinux/configSELINUX =disabled2.3节点设置ssh免密(各节点执行)[root@ceph02 ~]# ssh-keygenGenerating public/private rsa key pair.Enter file in which to save the key (/root/.ssh/id_rsa):Created directory '/root/.ssh'.Enter passphrase (empty for no passphrase):Enter same passphrase again:Your identification has been saved in /root/.ssh/id_rsa.Your public key has been saved in /root/.ssh/id_rsa.pub.The key fingerprint is:SHA256:RZxC7W733+iZCG9EPcnGye5li4ZCvTYqDFnhdcsjIz8 root@ceph02The key's randomart image is:+---[RSA 2048]----+| ..o.. || ..o+. || . oo+ .= o || + +.+. X || o S.+..o . || o Eo.o . o|| o ..oooo.o.|| o . B.+o=.|| ..+.=.=.o|+----[SHA256]-----+[root@ceph02 ~]# ssh-copy-id root@ceph01/usr/bin/ssh-copy-id: INFO: Source of key(s) to be installed: "/root/.ssh/id_rsa.pub"The authenticity of host 'ceph01 (192.168.1.121)' can't beestablished.ECDSA key fingerprint is SHA256:0TJBpy/sIxnagPsU62jCRfo3u/FRb4roi7+Qup 7tRx0.ECDSA key fingerprint isMD5:ca:14:e6:a5:3c:72:fa:a2:62:0a:46:dd:fd:05:17:af.Are you sure you want to continue connecting (yes/no)? yes/usr/bin/ssh-copy-id: INFO: attempting to log in with the new key(s),to filter out any that are already installed/usr/bin/ssh-copy-id: INFO: 1 key(s) remain to be installed -- if you are prompted now it is to install the new keysroot@ceph01's password:Number of key(s) added: 1Now try logging into the machine, with: "ssh 'root@ceph01'"and check to make sure that only the key(s) you wanted were added.[root@ceph02 ~]# ssh-copy-id root@ceph02/usr/bin/ssh-copy-id: INFO: Source of key(s) to be installed: "/root/. ssh/id_rsa.pub"The authenticity of host 'ceph02 (192.168.1.122)' can't beestablished.ECDSA key fingerprint is SHA256:7nRC3lyJyxliOolJgRNTvqKQzjX2zlEn5+xadg 0DTFk.ECDSA key fingerprint isMD5:9b:71:f5:ca:b0:bc:db:7c:96:3c:09:02:a7:c8:0e:e1.Are you sure you want to continue connecting (yes/no)? yes/usr/bin/ssh-copy-id: INFO: attempting to log in with the new key(s), to filter out any that are already installed/usr/bin/ssh-copy-id: INFO: 1 key(s) remain to be installed -- if you are prompted now it is to install the new keysroot@ceph02's password:Number of key(s) added: 1Now try logging into the machine, with: "ssh 'root@ceph02'"and check to make sure that only the key(s) you wanted were added.[root@ceph02 ~]# ssh-copy-id root@ceph03/usr/bin/ssh-copy-id: INFO: Source of key(s) to be installed: "/root/. ssh/id_rsa.pub"The authenticity of host 'ceph03 (192.168.1.123)' can't beestablished.ECDSA key fingerprint is SHA256:MbLYNIWonbVIyPpbbFw1tE99s9LS68TezGU8Mw +BOO8.ECDSA key fingerprint isMD5:3f:62:0b:1a:1c:13:8c:09:66:9c:c8:3a:e6:eb:12:89.Are you sure you want to continue connecting (yes/no)? yes/usr/bin/ssh-copy-id: INFO: attempting to log in with the new key(s), to filter out any that are already installed/usr/bin/ssh-copy-id: INFO: 1 key(s) remain to be installed -- if you are prompted now it is to install the new keysroot@ceph03's password:Number of key(s) added: 1Now try logging into the machine, with: "ssh 'root@ceph03'"and check to make sure that only the key(s) you wanted were added.2.4 配置yum源(各节点执行)//安装wget命令,方便下载新的yum源。

ceph运维手册

ceph运维手册一、介绍Ceph是一个分布式存储系统,具有高性能、高可靠性和高可扩展性的特点。

在大规模数据存储领域,Ceph已经成为一种非常流行的解决方案。

本文将深入探讨Ceph的运维手册,包括必要的配置、监控、故障处理等方面。

二、环境准备在进行Ceph的运维工作之前,需要准备以下环境:1.硬件设备:Ceph要求至少3台服务器,并且每台服务器要有足够的计算和存储资源。

2.操作系统:推荐使用Linux操作系统,例如CentOS、Ubuntu等。

3.网络配置:确保服务器之间能够正常通信,并且网络带宽要足够支持存储系统的数据传输。

三、Ceph集群部署3.1 安装Ceph软件包在每台服务器上执行以下命令,安装Ceph软件包:$ sudo apt-get install ceph -y3.2 配置Ceph集群1.创建一个用于存储Ceph配置文件的目录:$ sudo mkdir /etc/ceph2.在主节点上执行以下命令,生成配置文件:$ sudo ceph-deploy new <主节点>3.编辑生成的Ceph配置文件,添加以下内容:osd pool default size = 2osd crush chooseleaf type = 14.在主节点上执行以下命令,部署配置文件到所有节点:$ sudo ceph-deploy --overwrite-conf config push <所有节点>3.3 启动Ceph集群在主节点上执行以下命令,启动Ceph集群:$ sudo ceph-deploy mon create-initial四、Ceph监控Ceph提供了一套监控工具,可以用于实时监控集群的状态和性能。

4.1 安装和配置监控工具在主节点上执行以下命令,安装和配置监控工具:$ sudo apt-get install ceph-mgr ceph-mgr-dashboard -y4.2 访问监控面板通过浏览器访问主节点的IP地址和监控面板端口,例如:主节点IP地址>:7000。

ceph接口使用方法

ceph接口使用方法Ceph接口使用方法Ceph是一个开源的分布式存储系统,拥有强大的可扩展性和高可靠性。

它通过将数据分布在多个节点上,实现了数据冗余和负载均衡的功能。

Ceph提供了一系列的接口,让开发者可以轻松地使用其功能。

本文将介绍Ceph接口的使用方法,包括安装和配置Ceph、使用Ceph 接口进行数据操作等。

通过本文的指导,读者可以快速上手并深入了解Ceph接口的使用。

第一步:安装Ceph在开始使用Ceph接口之前,首先需要在集群中安装和配置Ceph。

Ceph 可以在Linux系统上运行,支持多种发行版。

以下是在Ubuntu上安装Ceph的步骤:1. 更新系统软件包:使用以下命令更新系统软件包以获取最新的软件包列表和安全修复程序。

sudo apt-get updatesudo apt-get upgrade2. 安装Ceph软件包:使用以下命令安装Ceph软件包。

sudo apt-get install ceph ceph-deploy3. 配置Ceph集群:使用Ceph提供的命令行工具ceph-deploy来配置Ceph集群。

首先需要创建一个新的目录作为Ceph集群的工作目录。

mkdir my-clustercd my-cluster然后,在此目录下,运行以下命令来初始化Ceph集群。

ceph-deploy new <MON节点>这将在当前目录下创建一个名为ceph.conf的配置文件,其中包含了集群的基本配置信息。

接下来,使用以下命令将Ceph软件包安装到集群的所有节点。

ceph-deploy install <所有节点>最后,使用以下命令来为集群添加MON节点。

ceph-deploy mon create-initial第二步:配置Ceph存储池一旦Ceph集群安装和配置完成,下一步是创建一个或多个存储池,以供存储数据。

存储池是Ceph中最基本的单元,用于管理数据的存储和分发。

ceph工作原理和安装

ceph工作原理和安装Ceph是一个开源的分布式存储系统,它提供了高可用性、高性能和可扩展性的存储解决方案。

本文将介绍Ceph的工作原理和安装过程,以帮助读者更好地理解和使用这个强大的存储系统。

一、Ceph的工作原理Ceph的核心是一个分布式对象存储系统,它将数据分散存储在多个节点上,通过复制和故障转移来保证数据的可靠性和高可用性。

Ceph采用了RADOS (Reliable Autonomic Distributed Object Store)作为底层存储引擎,它将数据划分为多个对象,并将这些对象分布在不同的存储设备上。

Ceph的工作原理可以简单描述为以下几个步骤:1. 客户端发送请求:当客户端需要读取或写入数据时,它会向Ceph集群发送请求。

这个请求包含了数据的标识符和操作类型。

2. CRUSH算法计算数据位置:Ceph集群中的OSD(Object Storage Device)使用CRUSH算法计算出数据存储的位置。

CRUSH算法基于一致性哈希和散列函数,可以将数据均匀地分布在不同的OSD上。

3. 数据访问和传输:一旦找到了数据存储的位置,客户端就可以直接与对应的OSD进行数据的读取和写入。

Ceph使用了RADOS协议来实现数据的传输和访问。

4. 数据复制和故障转移:Ceph通过数据的复制和故障转移来保证数据的可靠性和高可用性。

它使用了副本和恢复机制来处理节点故障和数据损坏的情况。

5. 数据一致性和完整性:Ceph使用了一致性哈希和版本控制等技术来保证数据的一致性和完整性。

它可以检测和修复数据的错误,并提供了数据的校验和功能。

二、Ceph的安装Ceph的安装过程相对复杂,但是通过正确的步骤和配置,可以顺利地搭建一个稳定可靠的存储系统。

下面是一个简要的安装过程:1. 准备环境:首先,需要准备一组服务器作为Ceph集群的节点。

这些服务器应该满足一定的硬件要求,并且已经安装了适当的操作系统。

2. 安装Ceph软件包:在每个节点上,需要安装Ceph软件包。

ceph安装配置说明

ceph安装配置说明一、环境说明:注:在配置系统环境时,需要指定各结点的机器名,关闭iptables、关闭selinux(重要)。

相关软件包:ceph-0.61.2.tar.tarlibedit0-3.0-1.20090722cvs.el6.x86_64.rpmlibedit-devel-3.0-1.20090722cvs.el6.x86_64.rpmsnappy-1.0.5-1.el6.rf.x86_64.rpmsnappy-devel-1.0.5-1.el6.rf.x86_64.rpmleveldb-1.7.0-2.el6.x86_64.rpmleveldb-devel-1.7.0-2.el6.x86_64.rpmbtrfs-progs-0.19.11.tar.bz2$src为安装包存放目录二、内核编译及配置:cp /boot/config-2.6.32-279.el6.x86_64 /usr/src/linux-2.6.34.2/.config make menuconfig #选择把ceph编译成模块和加载btrfs文件系统make all #若是多核处理器,则可以使用make -j8命令,以多线程方式加速构建内核makemodules_installmake install修改/etc/grub.conf文件,把新编译的linux-2.6.34.2版本内核做为默认启动内核。

三、Ceph安装配置:先安装相关依赖包:rpm -ivh libedit0-3.0-1.20090722cvs.el6.x86_64.rpm --forcerpm -ivh libedit-devel-3.0-1.20090722cvs.el6.x86_64.rpmrpm -ivh snappy-1.0.5-1.el6.rf.x86_64.rpmrpm -ivh snappy-devel-1.0.5-1.el6.rf.x86_64.rpmrpm -ivh leveldb-1.7.0-2.el6.x86_64.rpmrpm -ivh leveldb-devel-1.7.0-2.el6.x86_64.rpm编译安装ceph:./autogen.sh./configure --without-tcmalloc --without-libatomic-opsmakemake install配置ceph:cp $src/ceph-0.61.2/src/sample.ceph.conf /usr/local/etc/ceph/ceph.confcp $src/ceph-0.61.2/src/init-ceph /etc/init.d/cephmkdir /var/log/ceph #建立存放ceph日志目录。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

ceph安装配置说明

一、环境说明:

注:在配置系统环境时,需要指定各结点的机器名,关闭iptables、关闭selinux(重要)。

相关软件包:

ceph-0.61.2.tar.tar

libedit0-3.0-1.20090722cvs.el6.x86_64.rpm

libedit-devel-3.0-1.20090722cvs.el6.x86_64.rpm

snappy-1.0.5-1.el6.rf.x86_64.rpm

snappy-devel-1.0.5-1.el6.rf.x86_64.rpm

leveldb-1.7.0-2.el6.x86_64.rpm

leveldb-devel-1.7.0-2.el6.x86_64.rpm

btrfs-progs-0.19.11.tar.bz2

$src为安装包存放目录

二、内核编译及配置:

cp /boot/config-2.6.32-279.el6.x86_64 /usr/src/linux-2.6.34.2/.config make menuconfig #选择把ceph编译成模块和加载btrfs文件系统

make all #若是多核处理器,则可以使用make -j8命令,以多线程方式加速构建内核makemodules_install

make install

修改/etc/grub.conf文件,把新编译的linux-2.6.34.2版本内核做为默认启动内核。

三、Ceph安装配置:

先安装相关依赖包:

rpm -ivh libedit0-3.0-1.20090722cvs.el6.x86_64.rpm --force

rpm -ivh libedit-devel-3.0-1.20090722cvs.el6.x86_64.rpm

rpm -ivh snappy-1.0.5-1.el6.rf.x86_64.rpm

rpm -ivh snappy-devel-1.0.5-1.el6.rf.x86_64.rpm

rpm -ivh leveldb-1.7.0-2.el6.x86_64.rpm

rpm -ivh leveldb-devel-1.7.0-2.el6.x86_64.rpm

编译安装ceph:

./autogen.sh

./configure --without-tcmalloc --without-libatomic-ops

make

make install

配置ceph:

cp $src/ceph-0.61.2/src/sample.ceph.conf /usr/local/etc/ceph/ceph.conf

cp $src/ceph-0.61.2/src/init-ceph /etc/init.d/ceph

mkdir /var/log/ceph #建立存放ceph日志目录。

修改ceph配置文件,除客户端外,其它的节点都需一个配置文件ceph.conf,并需要是完全一样的。

这个文件要位于/etc/ceph下面,如果在./configure时没有修改prefix的话,则应该是在/usr/local/etc/ceph下:

vimceph.conf

[global]

max open files = 131072

log file = /var/log/ceph/$name.log

pid file = /var/run/ceph/$name.pid

keyring = /etc/ceph/keyring.admin

auth supported = none #取消挂载时的认证

auth cluster required = none #取消挂载时的认证

auth service required = none #取消挂载时的认证

auth client required = none #取消挂载时的认证

[mon]

mon data = /data/$name

[mon.0]

host = mm

monaddr = 1.1.1.12:6789

[mds]

keyring = /data/keyring.$name

[mds.0]

host = mm

[osd]

osd data = /data/$name

osd journal = /data/$name/journal

osd journal size = 1000 ; journal size, in megabytes

keyring = /data/keyring.$name

osdmkfs type = btrfs

osd mount options btrfs = rw,noatime

; working with ext4

;filestorexattr use omap = true

; solve rbd data corruption

;filestorefiemap = false

[osd.0]

host = osd0

devs = /dev/sda5

[osd.1]

host = osd1

devs = /dev/sda5

注:配置时加入取消挂载时的认证,否则启动ceph时会提示“ERROR: missing keyring, cannot use cephx for authentication”的错误。

Ceph有两种认证模式:一种是none模式,允许任意用户不需要认证就可访问数据;另一种是cephx模式,ceph需要类似于kerberos的用户认证。

对象存储结点(osd)上,除了要加载btrfs模块,还要安装btrfs-progs,这样才有mkfs.btrfs 命令。

另外就是要在osd节点上创建分区或逻辑卷供ceph使用:可以是磁盘分区(如

/dev/sda2),也可以是逻辑卷(如/dev/mapper/VolGroup-lv_ceph),只要与配置文件ceph.conf中写的一致即可。

修改各节点的hostname,使能够通过hostname来互相访问,并且各节点能够ssh互相访问而不输入密码。

建立配置文件中指定的相关结点目录:

mkdir /etc/ceph #元数据结点和对象存储结点建立

mkdir -p /data/mon.0 #元数据结点建立

mkdir–p /data/osd.0 #元数据结点和对象存储结点建立

mkdir–p /data/osd.1 #元数据结点和对象存储结点建立

osd结点上格式化分区并挂载:

mkfs.btrfs /dev/sda5

mount /dev/sda5 /data/osd.0 #osd0

mount /dev/sda5 /data/osd.1 #osd1

拷贝配置文件到各结点:

scp /usr/local/etc/ceph/ceph.conf root@osd0:/usr/local/etc/ceph/ceph.conf

scp /usr/local/etc/ceph/ceph.conf root@osd0:/etc/ceph/ceph.conf

scp /usr/local/etc/ceph/ceph.conf root@osd1:/usr/local/etc/ceph/ceph.conf

scp /usr/local/etc/ceph/ceph.conf root@osd1:/etc/ceph/ceph.conf

创建ceph文件系统:

元数据结点执行:

mkcephfs -a -c /usr/local/etc/ceph/ceph.conf -k /etc/ceph/keyring.admin

启动ceph并查看ceph状态:

/etc/init.d/ceph–a start

health HEALTH_OK

monmap e1: 1 mons at {0=1.1.1.12:6789/0}, election epoch 2, quorum 0 0

osdmap e5: 2 osds: 2 up, 2 in

pgmap v21: 576 pgs: 576 active+clean; 9518 bytes data, 2010 MB used, 99930 MB / 103 GB avail mdsmap e4: 1/1/1 up {0=0=up:active}

客户端挂载:

客户端安装完ceph后使用命令挂载分区:

mount.cephmm:/ /mnt/ceph

四、总结:

ceph是对象存贮,文件服务是通过cephfs转换完成的,但此部件稳定性不佳,查阅资料表明不建议使用,只能用于实验与研究环境。

但是ceph block storage相对较稳定,可以用于生产系统。