数据挖掘之聚类分析

数据挖掘-聚类分析

0 1 0 1 1 1 0 0 .......... ......... .......... ......... .......... .........

2

Байду номын сангаас

数据结构和类型

数据类型

• 混合变量相异度计算 其中为单个类型变量定义的距离; p p为变量的个数。

d (i, j )

(f) d ij 1

p

3

聚类分析方法的分类

聚类方法分类

聚类分析技术通常可分为五大类 :

• 基于划分的方法

• 基于层次的方法

• 基于密度的方法 • 基于网格的方法 • 基于模型的方法

3

聚类分析方法的分类

DS (Ca , Cb ) min{ d ( x, y) | x Ca , y Cb }

2

数据结构和类型

簇间距离度量

最长距离法:定义两个类中最远的两个元素间的距离为类间距离。

D ,C max{ d ( x, 为类间 y) | x Ca , y Cb义类 } L (Ca 的 b) 中心法:定 义两类 两个 中心 间的距离 距离。首先定 中心,而后给出类间距离。 假如Ci是一个聚类,x是Ci内的一个数据点,即x∈ Ci,那么类 中心 定义为:

K-means算法

• k-平均算法,也被称为k-means或k-均值,是一种得到最广泛使用 的聚类算法。 k-平均算法以k为参数,把n个对象分成k个簇,以使 簇内具有教高的相似度,而簇间的相似度较低相似度的计算根据一 个簇中对象的平均值来进行。 • 算法首先随机地选择k个对象,每个对象初始地代表了一个簇的平 均值或中心。对剩余的每个对象根据其与各个簇中心的距离,将它 赋给最近的簇。然后重新计算每个簇的平均值。这个过程不断重复, 直到准则函数收敛。准则如下:

完整版数据挖掘中的聚类分析方法

完整版数据挖掘中的聚类分析方法聚类分析方法是数据挖掘领域中常用的一种数据分析方法,它通过将数据样本分组成具有相似特征的子集,并将相似的样本归为一类,从而揭示数据中隐藏的模式和结构信息。

下面将从聚类分析的基本原理、常用算法以及应用领域等方面进行详细介绍。

聚类分析的基本原理聚类分析的基本原理是将数据样本分为多个类别或群组,使得同一类别内的样本具有相似的特征,而不同类别之间的样本具有较大的差异性。

基本原理可以总结为以下三个步骤:1.相似性度量:通过定义距离度量或相似性度量来计算数据样本之间的距离或相似度。

2.类别划分:根据相似性度量,将样本分组成不同的类别,使得同一类别内的样本之间的距离较小,不同类别之间的距离较大。

3.聚类评估:评估聚类结果的好坏,常用的评估指标包括紧密度、分离度和一致性等。

常用的聚类算法聚类算法有很多种,下面将介绍常用的几种聚类算法:1. K-means算法:是一种基于划分的聚类算法,首先通过用户指定的k值确定聚类的类别数,然后随机选择k个样本作为初始聚类中心,通过迭代计算样本到各个聚类中心的距离,然后将样本划分到距离最近的聚类中心对应的类别中,最后更新聚类中心,直至达到收敛条件。

2.层次聚类算法:是一种基于树状结构的聚类算法,将样本逐步合并到一个大的类别中,直至所有样本都属于同一个类别。

层次聚类算法可分为凝聚式(自底向上)和分裂式(自顶向下)两种。

凝聚式算法首先将每个样本作为一个初始的类别,然后通过计算样本之间的距离来逐步合并最近的两个类别,直至达到停止准则。

分裂式算法则是从一个包含所有样本的初始类别开始,然后逐步将类别分裂成更小的子类别,直至达到停止准则。

3. 密度聚类算法:是一种基于样本密度的聚类算法,通过在数据空间中寻找具有足够高密度的区域,并将其作为一个聚类。

DBSCAN (Density-Based Spatial Clustering of Applications with Noise)算法是密度聚类算法的代表,它通过定义距离和邻域半径来确定样本的核心点、边界点和噪声点,并通过将核心点连接起来形成聚类。

数据挖掘第七章__聚类分析

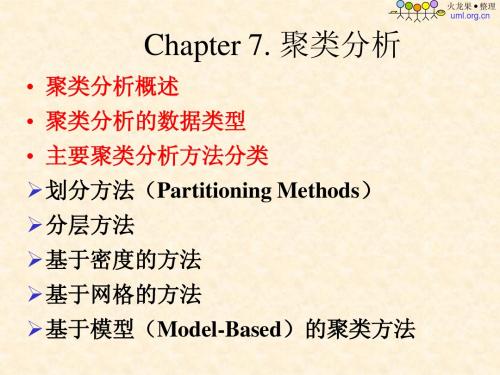

Chapter 7. 聚类分析

• 聚类分析概述 • 聚类分析的数据类型

• 主要聚类分析方法分类

划分方法(Partitioning Methods)

分层方法

基于密度的方法

基于网格的方法

基于模型(Model-Based)的聚类方法

火龙果 整理

• 差异度矩阵

– (one mode)

0 d(2,1) 0 d(3,1 ) d ( 3, 2 ) : : d ( n,1) d ( n,2)

0 : ... ... 0

火龙果 整理

1.数据矩阵 数据矩阵是一个对象—属性结构。它是n个对象组

6.3 聚类分析中的数据类型

假设一个要进行聚类分析的数据集包含 n

个对象,这些对象可以是人、房屋、文件等。

聚类算法通常都采用以下两种数据结构:

火龙果 整理

两种数据结构

• 数据矩阵

– (two modes)

x11 ... x i1 ... x n1 ... x1f ... ... ... xif ... ... ... xnf ... x1p ... ... ... xip ... ... ... xnp

• 保险: 对购买了汽车保险的客户,标识那些有较高平均赔偿 成本的客户;

• 城市规划: 根据类型、价格、地理位置等来划分不同类型的 住宅; • 地震研究: 根据地质断层的特点把已观察到的地震中心分成 不同的类;

火龙果 整理

生物方面,聚类分析可以用来对动物或植物分类,或 根据基因功能对其进行分类以获得对人群中所固有的

(6.2)

火龙果 整理

数据挖掘中的聚类分析与异常检测方法综合比较

数据挖掘中的聚类分析与异常检测方法综合比较数据挖掘是一种从大量数据中提取有用信息的技术。

其中,聚类分析和异常检测是两种常用的数据挖掘方法。

聚类分析是将相似的数据对象归为一类,从而识别数据中的内在结构。

而异常检测是识别数据中的异常点或异常模式。

本文将对这两种方法进行综合比较。

首先,我们来看聚类分析。

聚类分析通过计算数据对象之间的相似度或距离,将相似的数据对象归为一类。

常用的聚类算法包括K均值聚类、层次聚类、密度聚类等。

聚类分析可以帮助我们发现数据中的群组结构,并提供对这些群组的理解和描述。

相较于异常检测,聚类分析更侧重于寻找数据中的相似性和内在结构。

聚类分析的优点之一是可以自动化地进行数据分析。

它不需要预先定义分类标准,而是根据数据本身的特征进行分类。

聚类分析也适用于多种数据类型,如数值型、文本型和图像型数据。

此外,聚类分析还可以用于数据预处理,例如去除重复数据、数据降维等。

然而,聚类分析也存在一些限制。

首先,聚类的结果依赖于选择的聚类算法和距离度量方法。

不同的算法和度量方法可能会得到不同的结果。

其次,聚类结果的解释和解释可能并不直观。

当数据集较大或维度较高时,聚类结果也较难解释。

最后,聚类分析可能受到异常值的影响。

异常值可能会导致聚类结果出现偏差,从而影响数据的准确性。

接下来,我们来看异常检测。

异常检测是识别数据集中的异常点或模式。

异常点是指与其他数据对象明显不同的数据点,而异常模式是指与大多数数据对象显著不同的模式。

异常检测可以帮助我们发现潜在的问题或异常情况,并采取相应的措施。

常用的异常检测方法包括统计学方法、基于距离的方法、基于密度的方法等。

异常检测的一个优点是可以快速发现数据中的异常情况。

与聚类分析不同,异常检测更关注数据中的离群值或异常点。

异常检测也可以应用于多种领域,如金融、网络安全、工业制造等。

此外,异常检测还可以帮助我们识别数据中的缺陷和瑕疵。

然而,异常检测也存在一些挑战。

首先,选择合适的异常检测方法是一个挑战。

聚类分析法

聚类分析法聚类分析法是一种常用的数据挖掘技术。

它是一种一般数据挖掘流程的主要组成部分,主要用于对海量数据进行分类,以便更好地理解数据之间的关系。

它能有助于各种研究者、商业企业、政府等对海量数据进行分析。

聚类分析法的主要思想是将各个数据分组归类,使同类的数据在一起,而不同的数据分布在不同的组别中。

它利用某种规则,将不同的数据样本分类,认为它们具有距离接近的特征。

因此,它能够根据数据特征之间的差异性将数据分类,以更好地了解这些数据的内部结构。

聚类分析法通常分为聚类分析和层次聚类分析。

聚类分析的操作过程是:先将原始数据分成若干类,然后用某种距离或相似度度量两个数据样本点之间的距离,得到数据样本的相似度,然后将原始数据的每一组点重新分组,以使得每个类内样本点之间的距离大于每个类中不同类之间的距离。

而层次聚类分析着重于根据数据特征之间的相似度进行分类,使用层次聚类算法能够实现数据的优化分类,有利于更好地理解数据的内部结构。

聚类分析法的实现过程非常复杂,一般分为数据预处理、距离/相似度度量、聚类决策和结果评估几个步骤,其中最为关键的是距离/相似度度量。

由于距离/相似度度量是聚类分析法的核心步骤,其结果将会影响到聚类分析结果的准确性。

聚类分析法在数据挖掘领域具有重要的应用价值,在客户关系管理、市场细分、碎片化信息处理、文本分析、文档聚类等方面都可以运用聚类分析法。

通过聚类分析法可以有效地探索隐藏在数据中的潜在关系,为企业提供有用的决策信息,有助于企业更好地运用数据资源,实现更好更有效的决策。

聚类分析法在数据挖掘领域具有重要的应用价值,但它存在一定的局限性,比如聚类决策的准确性取决于选择的距离/相似度度量方法,而且在处理大规模数据时,它的计算速度比较慢,也无法完全给出准确的聚类结果。

另外,聚类分析法的结果可能会受到环境变化的影响。

总之,聚类分析法是一种常用的数据挖掘技术,具有很高的应用价值,可以有效地探索数据之间的关系,为企业提供有用的决策信息,帮助企业更好地管理数据和实现更好更有效的决策。

数据挖掘中的聚类分析方法

数据挖掘中的聚类分析方法数据挖掘是一种通过智能计算和算法挖掘数据价值的技术。

而数据挖掘中的聚类分析方法则是其中的一个重要分支。

聚类分析是指将相似的数据组合在一起,不同的数据分开,形成不同的类别。

聚类分析在机器学习、数据分析、数据挖掘、图像处理等领域有广泛的应用。

本文将从聚类分析的定义、算法、分类等方面进行讲解。

一、聚类分析的定义聚类分析是一种无监督学习算法,它主要用于将样本根据各自的相似性分成若干类别。

聚类分析主要有两种方法:层次聚类和划分聚类。

层次聚类是一种自下而上的聚类方法,将每个样本视为一个初始聚类,然后将聚类依次合并,形成更大的聚类,直到所有样本都组成一个聚类。

层次聚类的结果是一个聚类树状结构,通过剪枝可以获得不同的聚类结果。

划分聚类是一种自上而下的聚类方法,将所有样本看作一个大的聚类,然后逐渐将其划分成更小的聚类,最终得到所需的聚类数目。

划分聚类主要有K均值聚类和高斯混合模型聚类二、聚类分析的算法(一) 层次聚类算法层次聚类常用的算法是自底向上的聚合算法和自顶向下的分裂算法。

自底向上的聚合算法是指先构造n个初始聚类,然后迭代合并最接近的两个聚类,直到达到某个停止条件。

这个停止条件可以是达到了所需的聚类数目,也可以是聚类之间距离的最大值。

自顶向下的分裂算法则是从所有样本开始,将其划分成两个聚类,然后逐步分裂聚类,得到所需的聚类数目。

(二) K均值聚类K均值聚类是一种划分聚类算法,它需要先指定K个聚类中心,然后根据距离来将样本点分配给不同的聚类中心。

然后将每个聚类内部的样本的均值作为该聚类的新中心,重新计算每个样本点和聚类中心的距离,直到聚类中心不再改变或达到一定的迭代次数。

K均值聚类的优势在于简单快速,具有很好的可扩展性和聚类效果。

但是这种算法需要预先确定聚类中心数,且对初始聚类中心的选择比较敏感。

(三) 高斯混合模型聚类高斯混合模型聚类是一种基于概率密度估计的算法,它假设每个聚类的密度函数是一个高斯分布。

聚类分析方法

聚类分析方法

聚类分析是一种常用的数据挖掘方法,它可以将相似的数据点分组在一起。

在聚类分析中,数据被分为多个类别,每个类别都包含具有类似特征的数据点。

聚类分析方法有很多种,其中一种是K均值聚类。

K均值聚

类的目标是将数据点分为K个簇,使得每个数据点都属于与

其最近的质心所代表的簇。

首先,在聚类分析中,需要先选择一个初始的簇质心,然后迭代地将每个数据点分配到与其最近的质心所代表的簇中,然后更新簇质心的位置,直到达到收敛。

另一种常见的聚类分析方法是层次聚类。

层次聚类将数据点逐渐合并成一个个的簇,直到所有数据点都属于同一个簇。

层次聚类可以根据不同的相似性度量来合并簇,例如单链接、完全链接或平均链接等。

另外,谱聚类是一种基于图论的聚类方法,它利用数据点之间的相似性构建一个相似度矩阵,并将其转化为一个图。

然后,通过计算图的特征向量来对数据进行聚类分析。

聚类分析方法还有很多其他的变体和扩展,例如密度聚类、模糊聚类和网格聚类等。

这些方法可以根据具体的问题和数据类型来选择和应用。

总的来说,聚类分析方法是一种无监督学习的方法,可以用于发现数据中的内在结构和模式。

它在很多领域都有广泛的应用,

如市场分析、社交网络分析和生物信息学等。

通过应用聚类分析方法,可以帮助我们更好地理解和分析数据。

数据挖掘中的聚类分析与分类模型比较

数据挖掘中的聚类分析与分类模型比较数据挖掘是一种通过自动或半自动的方法来发现数据模式、建立模型和进行预测的技术。

在数据挖掘的过程中,聚类分析和分类模型是两种重要的方法,它们在从数据中提取有用信息方面起到了关键作用。

本文将对这两种方法进行比较,探讨它们的优缺点及在实际应用中的差异。

一、聚类分析聚类分析是一种无监督学习的方法,它是指在没有预定义类别标签的情况下自动将数据分组或分类的方法。

聚类分析的目标是利用数据自身的特点将相似的数据点聚集在一起,不同的数据点被分成不同的类别。

聚类分析可以帮助我们发现数据中的隐藏模式和结构,进行数据的可视化和理解,识别异常值和离群点等。

聚类分析的优点:1.适用范围广:聚类分析可以适用于各种类型的数据,包括数值型数据、文本数据和图像数据等,因此在各个领域都有着广泛的应用。

2.无需先验知识:聚类分析不需要先验知识或者标签,它可以自动发现数据中的结构和模式,适用于未知的数据集。

3.可解释性强:聚类分析生成的结果是一组相互独立的类别,每个类别都有其特定的特征和属性,因此结果易于理解和解释。

聚类分析的缺点:1.结果不稳定:聚类分析的结果会受到初始化的影响,有时候可能会出现不稳定的情况,需要多次运行算法来得到稳定的结果。

2.难以确定聚类数目:在聚类分析中,通常需要指定聚类的数目,但是很难确定一个合适的聚类数目,这可能会影响聚类分析的结果。

3.对噪声和异常值敏感:聚类分析对数据中的噪声和异常值比较敏感,它可能会将这些噪声和异常值也划分到一个类别中,影响聚类的结果。

二、分类模型分类模型是一种监督学习的方法,它是指在有预定义类别标签的情况下建立模型,用来预测新数据点的类别标签。

分类模型的目标是根据已知的类别标签来训练模型,使其能够对未知数据进行分类。

分类模型可以帮助我们进行预测和决策,识别潜在的规律和模式,进行风险评估和市场分析等。

分类模型的优点:1.预测准确性高:分类模型可以利用已知的类别标签来建立模型,因此通常具有比较高的预测准确性,能够较好地进行分类。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

Start from a randomly selected unseen point P.

If P is a core point, build a cluster by gradually adding all points that are density reachable to the current point set. Noise points are discarded (unlabelled).

E[ zij ]

p( x xi | j ) j

p( x x | )

k 1 i k

ij

n

k

e

n k 1

1 2

2

( xi j ) 2

j k

e

1 2

2

( xi k ) 2

j

E[ z

i 1 m i 1

m

]xi

ij

Social Networks Discovering groups of individuals with close friendships internally.

6

Earthquakes

7

Image Segmentation

8

The Big Picture

9

Requirements

1 2 3 4 5 6

2

1

0 0

X

11

Normalization or Not?

12

13

Evaluation

c

J e x mi ,

2 i 1 xDi

1 mi ni

xDi

x

VS.

14

Evaluation

15

Silhouette

A method of interpretation and validation of clusters of data. A succinct graphical representation of how well each data point lies within its cluster compared to other clusters. a(i): average dissimilarity of i with all other points in the same cluster b(i): the lowest average dissimilarity of i to other clusters

Finding groups of objects

Objects similar to each other are in the same group.

Objects are different from those in other groups. Unsupervised Learning

No labels

Data driven

3

Clusters

Inter-Cluster

Intra-Cluster

4

Clusters

5

Applications of Clustering

Marketing Finding groups of customers with similar behaviours. Biology Finding groups of animals or plants with similar features.

Scalability Ability to deal with different types of attributes Ability to discover clusters with arbitrary shape Minimum requirements for domain knowledge Ability to deal with noise and outliers Insensitivity to order of input records Incorporation of user-defined constraints

• Non-convex shapes

22

The Influence of Initial Centroids

23

The Influence of Initial Centroids

24

Sequential Leader Clustering

A very efficient clustering algorithm.

E[ z

]

1 m j E[ zij ] m i 1

32

33

Density Based Methods

Generate clusters of arbitrary shapes. Robust against noise. No K value required in advance.

25

26

Gaussian Mixture

g ( x, , )

n

1 2

2

e

( x ) 2 /( 2 2 )

f ( x) i g ( x, i , i ), i 0 & i 1

i 1 i

27

Clustering by Mixture Models

No iteration

A single pass of the data No need to specify K in advance. Choose a cluster threshold value. For every new data point: Compute the distance between the new data point and every cluster's centre. If the minimum distance is smaller than the chosen threshold, assign the new data point to the corresponding cluster and re-compute cluster centre. Otherwise, create a new cluster with the new data point as its centre. Clustering results may be influenced by the sequence of data points.

May converge to local optima.

• In practice, try different initial centroids.

May be sensitive to noisy data and outliers.

• Mean of data points …

Not suitable for clusters of

Clustering

LOGO

Overview

Partitioning Methods K-Means Sequential Leader Model Based Methods Density Based Methods Hierarchical Methods

2

What is cluster analysis?

Determine the value of K. Choose K cluster centres randomly. Each data point is assigned to its closest centroid.

Use the mean of each cluster to update each centroid.

Core Point

Border Point

Noise Point

35

DBSCAN

q p p

q

directly density reachable

density reachable

p o

q

density connected

36

DBSCAN

A cluster is defined as the maximal set of density connected points.

Somewhat similar to human vision.

34

DBSCAN

Density-Based Spatial Clustering of Applications with Noise Density: number of points within a specified radius Core Point: points with high density Border Point: points with low density but in the neighbourhood of a core point Noise Point: neither a core point nor a border point

Interpretability and usability

10

Practical Considerations

6

6

4

5

4

5

3

4

3

4

Y

2

Y

1

3

3

2

1

1

1

2

0 0 1 2 3 4 5 6

2

0 0 1 2 3 4 5 6

X

6

X1=0.2X

5

4

Y1=0.2Y

3

Scaling matters!