三种常见的损失函数和两种常用的激活函数介绍和可视化

pytorch常见损失函数

pytorch常见损失函数

PyTorch是一个流行的深度学习框架,提供了许多常见的损失

函数,用于训练神经网络。

下面是一些PyTorch中常见的损失函数:

1. nn.CrossEntropyLoss,用于多分类问题的交叉熵损失函数。

适用于输出是类别标签的情况。

2. nn.MSELoss,均方误差损失函数,用于回归问题,衡量模型

输出与真实标签之间的平均平方差。

3. nn.BCELoss,二元交叉熵损失函数,适用于二分类问题。

4. nn.BCEWithLogitsLoss,结合了Sigmoid激活函数和二元交

叉熵损失的函数,通常用于二分类问题。

5. nn.NLLLoss,负对数似然损失函数,用于多分类问题,要求

输入是对数概率。

6. nn.KLDivLoss,Kullback-Leibler散度损失函数,用于衡

量两个概率分布之间的差异。

7. nn.SmoothL1Loss,平滑的L1损失函数,用于回归问题,相

比于MSELoss,在存在离群值时具有更好的性能。

以上列举的损失函数是PyTorch中常见的一些,每个损失函数

都有其特定的应用场景和数学原理。

在选择损失函数时,需要根据

具体的问题和数据特点进行选择,以达到最佳的训练效果。

同时,PyTorch也提供了灵活的接口,用户可以根据需要自定义损失函数。

希望这些信息能够帮助到你。

常用的损失函数 与损失函数的梯度

常用的损失函数与损失函数的梯度1. 引言在机器学习和深度学习领域,损失函数是一个非常重要的概念。

它用来衡量模型预测结果与真实数据之间的差异,是优化算法的核心部分。

在训练模型的过程中,我们需要通过最小化损失函数来不断调整模型的参数,使得模型可以更好地拟合数据。

本文将介绍常用的损失函数以及它们的梯度计算方法。

2. 常用的损失函数(1)均方误差损失函数(MSE)均方误差损失函数是回归任务中常用的损失函数,它衡量模型预测值与真实值之间的差异。

其计算公式如下:MSE = 1/n * Σ(yi - y^i)^2其中,n表示样本数量,yi表示真实值,y^i表示模型的预测值。

对于均方误差损失函数,我们需要计算其关于模型参数的梯度,以便进行参数的更新。

(2)交叉熵损失函数交叉熵损失函数是分类任务中常用的损失函数,特别适用于多分类问题。

它的计算公式如下:Cross-Entropy = -Σ(yi * log(y^i))其中,yi表示真实标签的概率分布,y^i表示模型的预测概率分布。

与均方误差损失函数类似,我们也需要计算交叉熵损失函数的梯度,以便进行参数的更新。

(3)Hinge损失函数Hinge损失函数通常用于支持向量机(SVM)中,它在二分类问题中表现良好。

其计算公式如下:Hinge = Σ(max(0, 1 - yi * y^i))其中,yi表示真实标签,y^i表示模型的预测值。

Hinge损失函数的梯度计算相对复杂,但可以通过数值方法或者约束优化方法进行求解。

3. 损失函数的梯度损失函数的梯度是优化算法中至关重要的一部分,它决定了参数更新的方向和步长。

在深度学习中,我们通常使用梯度下降算法来最小化损失函数,因此需要计算损失函数关于参数的梯度。

(1)均方误差损失函数的梯度对于均方误差损失函数,其关于模型参数的梯度计算相对简单。

以单个参数θ为例,其梯度可以通过以下公式计算得出:∂MSE/∂θ = 2/n * Σ(yi - y^i) * ∂y^i/∂θ其中,∂y^i/∂θ表示模型预测值关于参数θ的梯度。

激活函数与损失函数

激活函数与损失函数激活函数激活函数(Activation Function)一般为非线性函数。

在神经网络中,仅仅依靠权重之间线性关系很难学习和理解复杂的模型,为此,引入Activation Function 可以提升模型的‘Nonlinear’表达能力,只有加入Activation Function,模型才有‘Nonlinear’映射学习能力。

常用的Activation Function有Sigmoid Function、Tanh Function和Relu Function。

3.3.1 sigmoid激活函数Sigmoid Function是使用最多的Activation Function,它具有是指数函数的性质。

Sigmoid Function的值域与概率值范围相同为(0,1),此就可以和概率分布结合在一起研究学习。

另一方面,近三十年里的神经网络难以有有效的进展也是和Sigmoid Function的性质有关,这种性质是Sigmoid Function是平滑饱和Activation Function。

平滑饱和Activation Function就是因为当x趋于-∞时,它的导数值会逼近于0,这会引起Gradient Disappeared。

Gradient Disappeared是指Sigmoid Function在向下传递的梯度里有k’(s)k(s)因子,k’(s)k(s)会在输入落入饱和区时趋近于0,使得向底层传递的梯度变小,通常五层之内就会出现这种情况。

图3-2 sigmoid函数曲线3.3.2 Tanh激活函数Tanh Function的值域为(1,-1),与Sigmoid Function幅度增大后相似。

Tanh Function的导数的取值范围在(0,1),而Sigmoid Function导数值域为(0,0.25),所以Tanh Function在一定程度上能够防止梯度消失的情况发生。

三种常见的损失函数和两种常用的激活函数介绍和可视化

三种常见的损失函数和两种常用的激活函数介绍和可视化损失函数(Loss Function)是用于衡量模型在训练过程中预测值与真实值之间的差异程度的函数。

在深度学习中,常见的损失函数有均方误差(Mean Squared Error,MSE)、交叉熵损失(Cross Entropy Loss)和对数损失(Log Loss)。

1. 均方误差(Mean Squared Error,MSE):均方误差是最常见的损失函数之一,用于衡量模型预测值与真实值之间的差异程度。

均方误差的计算公式为:MSE = 1/n * Σ(y_pred - y_true)^2其中,y_pred表示模型的预测值,y_true表示真实值,n表示样本数量。

均方误差对于离群值比较敏感,即当预测值与真实值相差较大时,均方误差会变得较大。

2. 交叉熵损失(Cross Entropy Loss):CrossEntropy = -y_true * log(y_pred) - (1 - y_true) * log(1 - y_pred)3. 对数损失(Log Loss):对数损失也是一种常见的用于衡量分类模型的损失函数。

对数损失的计算公式为:LogLoss = -Σ(y_true * log(y_pred) + (1 - y_true) * log(1 - y_pred)) / n激活函数(Activation Function)是神经网络中引入非线性变换的一种函数,用于增加神经网络的表达能力。

常见的激活函数有sigmoid函数和ReLU函数。

1. sigmoid函数(Sigmoid Function):sigmoid函数是一种常用的激活函数,其输出值介于0和1之间,具有将输入限定在一定范围内的特性。

sigmoid函数的计算公式为:sigmoid(x) = 1 / (1 + exp(-x))sigmoid函数将所有的输入映射到一个0到1之间的范围内,适用于二分类问题或输出概率的场景。

损失函数历程曲线

损失函数历程曲线是一种重要的工具,用于衡量模型在训练过程中的性能。

通过观察损失函数的变化,可以了解模型的训练过程,并针对问题进行优化。

下面我将用1500字回答这个问题。

一、损失函数简介损失函数(Loss Function)是用于衡量模型预测结果与真实结果之间差距的函数。

在机器学习中,损失函数是用于优化模型参数的重要工具,通过不断调整模型参数,使得损失函数值逐渐减小,从而达到更好的预测效果。

常见的损失函数包括均方误差(MSE)、交叉熵(Cross-Entropy)等。

二、损失函数历程曲线的作用损失函数历程曲线的作用主要有两个方面:1. 了解模型训练过程:通过观察损失函数的变化,可以了解模型在训练过程中的表现。

随着训练的进行,损失函数值逐渐减小,说明模型在逐步接近最优解。

但如果损失函数值一直上升,则说明模型训练效果不佳,需要调整参数或优化模型结构。

2. 优化模型参数:损失函数历程曲线可以帮助我们找到最优的模型参数。

通过观察不同参数下的损失函数值,可以找到使损失函数值最小化的参数组合。

此外,通过分析损失函数的变化趋势,还可以预测模型的未来表现,为进一步的优化提供参考。

三、如何绘制损失函数历程曲线绘制损失函数历程曲线的方法因所使用的软件而异。

以TensorFlow、PyTorch等常见的机器学习框架为例,绘制损失函数历程曲线的一般步骤如下:1. 导入相关库和数据:根据所使用的框架和数据集,导入相应的库和数据。

2. 定义模型和优化器:根据问题需求,定义相应的模型和优化器。

3. 训练模型:使用训练数据对模型进行训练,并记录损失函数值。

4. 可视化损失函数:使用可视化工具(如Matplotlib)将损失函数值绘制成曲线。

四、案例分析以下是一个简单的例子,展示了如何使用TensorFlow绘制损失函数历程曲线。

假设我们使用TensorFlow进行二元分类问题,并使用交叉熵作为损失函数。

1. 导入相关库和数据:```pythonimport tensorflow as tffrom sklearn.datasets import make_classificationfrom tensorflow.keras.models import Sequentialfrom yers import Dense```2. 生成模拟数据:```pythonX, y = make_classification(n_samples=1000, n_features=20, n_informative=2, n_redundant=10, random_state=42)```3. 定义模型:```pythonmodel = Sequential([Dense(1, activation='sigmoid')])```4. 编译模型:```pythonpile(loss='binary_crossentropy', optimizer='adam')```5. 训练模型:使用模拟数据进行模型训练,并记录损失函数值:```pythonepochs = 50for epoch in range(epochs):losses = []for batch in X:preds = model.predict(batch)loss = pute_loss(y, preds) # 计算交叉熵损失值losses.append(loss)# 将所有批次的损失值绘制成曲线plt.plot(losses)plt.title('Training loss')plt.xlabel('Epoch')plt.ylabel('Loss')plt.show()```上述代码将所有批次的损失值绘制成曲线,即为损失函数历程曲线。

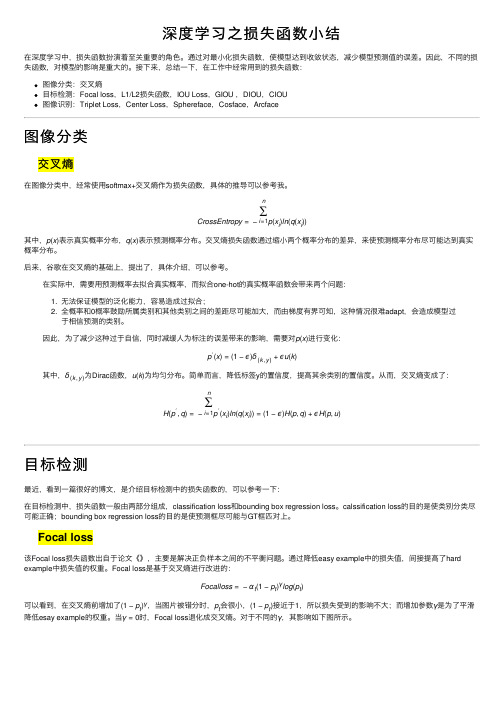

深度学习之损失函数小结

深度学习之损失函数⼩结在深度学习中,损失函数扮演着⾄关重要的⾓⾊。

通过对最⼩化损失函数,使模型达到收敛状态,减少模型预测值的误差。

因此,不同的损失函数,对模型的影响是重⼤的。

接下来,总结⼀下,在⼯作中经常⽤到的损失函数:图像分类:交叉熵⽬标检测:Focal loss,L1/L2损失函数,IOU Loss,GIOU ,DIOU,CIOU图像识别:Triplet Loss,Center Loss,Sphereface,Cosface,Arcface图像分类交叉熵在图像分类中,经常使⽤softmax+交叉熵作为损失函数,具体的推导可以参考我。

CrossEntropy=−n∑i=1p(x i)ln(q(x i))其中,p(x)表⽰真实概率分布,q(x)表⽰预测概率分布。

交叉熵损失函数通过缩⼩两个概率分布的差异,来使预测概率分布尽可能达到真实概率分布。

后来,⾕歌在交叉熵的基础上,提出了,具体介绍,可以参考。

在实际中,需要⽤预测概率去拟合真实概率,⽽拟合one-hot的真实概率函数会带来两个问题:1. ⽆法保证模型的泛化能⼒,容易造成过拟合;2. 全概率和0概率⿎励所属类别和其他类别之间的差距尽可能加⼤,⽽由梯度有界可知,这种情况很难adapt,会造成模型过于相信预测的类别。

因此,为了减少这种过于⾃信,同时减缓⼈为标注的误差带来的影响,需要对p(x)进⾏变化:p′(x)=(1−ϵ)δ(k,y)+ϵu(k)其中,δ(k,y)为Dirac函数,u(k)为均匀分布。

简单⽽⾔,降低标签y的置信度,提⾼其余类别的置信度。

从⽽,交叉熵变成了:H(p′,q)=−n∑i=1p′(x i)ln(q(x i))=(1−ϵ)H(p,q)+ϵH(p,u)⽬标检测最近,看到⼀篇很好的博⽂,是介绍⽬标检测中的损失函数的,可以参考⼀下:在⽬标检测中,损失函数⼀般由两部分组成,classification loss和bounding box regression loss。

深度学习损失函数

深度学习损失函数

深度学习中的损失函数是一种衡量模型预测结果与真实结果之间差距的度量。

常用的损失函数有以下几种:

1.均方误差(Mean Squared Error, MSE):这是最常用的回归问题中

的损失函数,它计算预测值与真实值之间的差的平方和的平均值。

2.交叉熵(Cross-Entropy):这是常用的分类问题中的损失函数,它

计算预测概率分布与真实概率分布之间的差异。

3.二元交叉熵(Binary Cross-Entropy):这是二分类问题中的损失

函数,与交叉熵类似,但只针对0/1标签。

4.多类对数损失(Categorical Cross-entropy):这是多类分类问题

中的损失函数,与交叉熵类似,但针对多类标签。

5.Hinge Loss:这是常用于支持向量机(SVM)等线性分类器中的损

失函数,它只考虑预测值与真实值之间的间隔。

6.软max损失(Softmax Loss):这是常用于多类分类问题中的损失

函数,它针对每个类别计算预测概率与真实标签的差异,并将所有类别的差异值求和。

7.信息增益(Information gain):这是常用于决策树等非深度学习

模型中的损失函数,它衡量预测结果对数据的信息增益。

这只是深度学习中常用的一部分损失函数,还有许多其他类型的损失函数,在不同的应用场景中使用不同的损失函数可能会得到更优的模型效果。

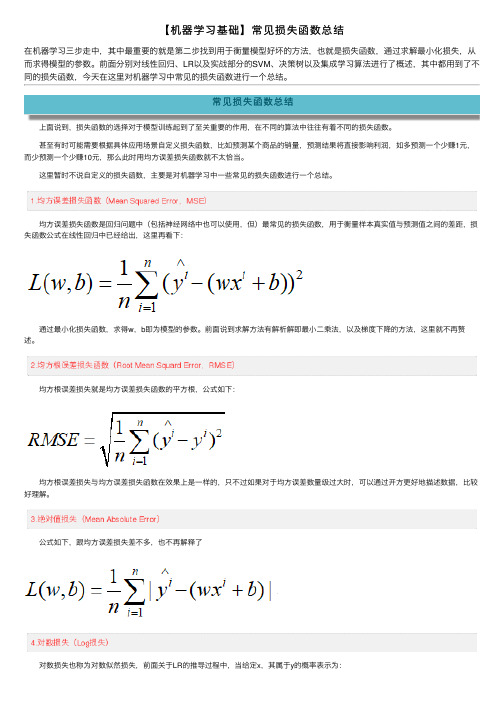

【机器学习基础】常见损失函数总结

【机器学习基础】常见损失函数总结在机器学习三步⾛中,其中最重要的就是第⼆步找到⽤于衡量模型好坏的⽅法,也就是损失函数,通过求解最⼩化损失,从⽽求得模型的参数。

前⾯分别对线性回归、LR以及实战部分的SVM、决策树以及集成学习算法进⾏了概述,其中都⽤到了不同的损失函数,今天在这⾥对机器学习中常见的损失函数进⾏⼀个总结。

常见损失函数总结 上⾯说到,损失函数的选择对于模型训练起到了⾄关重要的作⽤,在不同的算法中往往有着不同的损失函数。

甚⾄有时可能需要根据具体应⽤场景⾃定义损失函数,⽐如预测某个商品的销量,预测结果将直接影响利润,如多预测⼀个少赚1元,⽽少预测⼀个少赚10元,那么此时⽤均⽅误差损失函数就不太恰当。

这⾥暂时不说⾃定义的损失函数,主要是对机器学习中⼀些常见的损失函数进⾏⼀个总结。

均⽅误差损失函数是回归问题中(包括神经⽹络中也可以使⽤,但)最常见的损失函数,⽤于衡量样本真实值与预测值之间的差距,损失函数公式在线性回归中已经给出,这⾥再看下: 通过最⼩化损失函数,求得w,b即为模型的参数。

前⾯说到求解⽅法有解析解即最⼩⼆乘法,以及梯度下降的⽅法,这⾥就不再赘述。

均⽅根误差损失就是均⽅误差损失函数的平⽅根,公式如下: 均⽅根误差损失与均⽅误差损失函数在效果上是⼀样的,只不过如果对于均⽅误差数量级过⼤时,可以通过开⽅更好地描述数据,⽐较好理解。

公式如下,跟均⽅误差损失差不多,也不再解释了 对数损失也称为对数似然损失,前⾯关于LR的推导过程中,当给定x,其属于y的概率表⽰为: 期望对所有的样本都能够正确分类,则有:、 然后对L两边取对数,注意这⾥是最⼤化。

那么带⼊上式,然后两边再取负号,就变成最⼩化了,最终得到对数损失函数的形式为: 这⾥还要说⼀下,其实对数损失函数还有另外⼀种形式,在GBDT中利⽤GBDT处理分类问题时提到过,注意上⾯的类别取值为{0,1},我们只需将取值设为{-1,1},就可得到如下形式的对数损失函数: 交叉熵损失和对数损失其实是⼀样的(很多资料中有提到),⼆者的表达式在本质上是⼀致的。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

三种常见的损失函数和两种常用的激活函数介绍和可视化

【导语】本文对梯度函数和损失函数间的关系进行了介绍,并通过可视化方式进行了详细展示。

另外,作者对三种常见的损失函数和两种常用的激活函数也进行了介绍和可视化。

你需要掌握关于神经网络训练的基础知识。

本文尝试通过可视化方法,对损失函数、梯度下降和反向传播之间的关系进行介绍。

损失函数和梯度下降之间的关系

为了对梯度下降过程进行可视化,我们先来看一个简单的情况:假设神经网络的最后一个节点输出一个权重数w,该网络的目标值是0。

在这种情况下,网络所使用的损失函数为均方误差(MSE)。

当w大于0时,MSE的导数dy/dw 值为正。

dy/dw 为正的原因可以解释为,w中的正方向变化将导致y的正方向变化。

为了减少损失值,需要在w的负方向上进行如下变换:

当w小于0时,MSE的导数dy/dw 值为负,这意味着w中的正方向变化将导致y的负方向变化。

为了减少损失,需要在w的正方向上做如下变换:

因此,权重更新的公式如下:

其中learning_rate 是一个常量,用于调节每次更新的导数的百分比。

调整Learning_rate 值主要是用于防止w更新步伐太小或太大,或者避免梯度爆炸(梯度太大)或梯度消失的问题(梯度太小)。

下图展示了一个更长且更贴近实际的计算过程,在该计算过程中,需要使用sigmoid激活函数对权重进行处理。

为了更新权重w1,相对于w1的损失函数的导数可以以如下的方式得到:。