【CN109767790A】一种语音情感识别方法及系统【专利】

【CN109961792A】用于识别语音的方法和装置【专利】

(19)中华人民共和国国家知识产权局(12)发明专利申请(10)申请公布号 (43)申请公布日 (21)申请号 201910160480.0(22)申请日 2019.03.04(71)申请人 百度在线网络技术(北京)有限公司地址 100085 北京市海淀区上地十街10号百度大厦三层(72)发明人 贺学焱 宋晔 (74)专利代理机构 北京英赛嘉华知识产权代理有限责任公司 11204代理人 王达佐 马晓亚(51)Int.Cl.G10L 15/30(2013.01)G10L 15/34(2013.01)G10L 15/26(2006.01)H04L 12/26(2006.01)G06F 17/27(2006.01)(54)发明名称用于识别语音的方法和装置(57)摘要本公开的实施例公开了用于识别语音的方法和装置。

该方法的一具体实施方式包括:响应于接收到用户输入的语音,检测当前网络状态;若当前网络状态良好,则将语音发送给语音识别服务器,以接收所述语音识别服务器返回的识别文字结果;将识别文字结果与本地预解析指令集进行匹配;若匹配成功,则执行识别文字结果对应的指令。

该实施方式实现了离线在线混合语音识别,从而提高了语音识别速度。

权利要求书2页 说明书9页 附图5页CN 109961792 A 2019.07.02C N 109961792A权 利 要 求 书1/2页CN 109961792 A1.一种用于识别语音的方法,包括:响应于接收到用户输入的语音,检测当前网络状态;若当前网络状态良好,则将所述语音发送给语音识别服务器,以接收所述语音识别服务器返回的识别文字结果;将所述识别文字结果与本地预解析指令集进行匹配;若匹配成功,则执行所述识别文字结果对应的指令。

2.根据权利要求1所述的方法,其中,所述方法还包括:若当前网络状态不佳,则进行本地语音识别,得到识别文字结果。

3.根据权利要求1所述的方法,其中,所述方法还包括:若匹配失败,则再次检测当前网络状态;若再次检测出网络状态为良好,则将所述识别文字结果发送到语义理解服务器,以在预定的时间内得到所述语义理解服务器返回的所述识别文字结果对应的语义结果,以及将所述语义结果与所述识别文字结果的对应关系存储在本地语义缓存区。

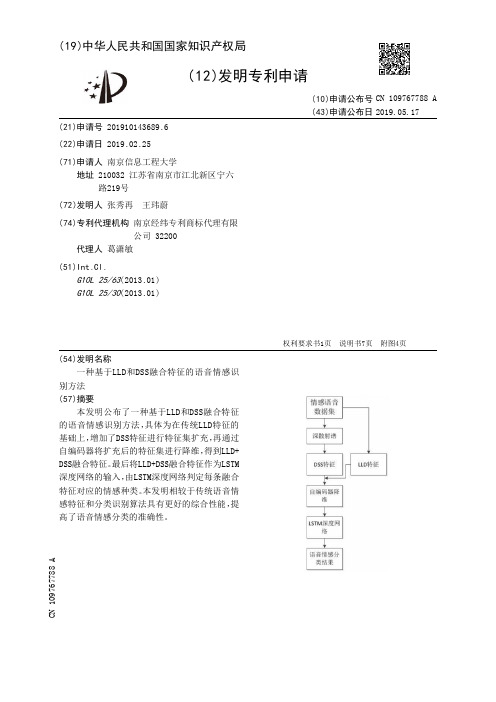

【CN109767788A】一种基于LLD和DSS融合特征的语音情感识别方法【专利】

(19)中华人民共和国国家知识产权局(12)发明专利申请(10)申请公布号 (43)申请公布日 (21)申请号 201910143689.6(22)申请日 2019.02.25(71)申请人 南京信息工程大学地址 210032 江苏省南京市江北新区宁六路219号(72)发明人 张秀再 王玮蔚 (74)专利代理机构 南京经纬专利商标代理有限公司 32200代理人 葛潇敏(51)Int.Cl.G10L 25/63(2013.01)G10L 25/30(2013.01)(54)发明名称一种基于LLD和DSS融合特征的语音情感识别方法(57)摘要本发明公布了一种基于LLD和DSS融合特征的语音情感识别方法,具体为在传统LLD特征的基础上,增加了DSS特征进行特征集扩充,再通过自编码器将扩充后的特征集进行降维,得到LLD+DSS融合特征。

最后将LLD+DSS融合特征作为LSTM深度网络的输入,由LSTM深度网络判定每条融合特征对应的情感种类。

本发明相较于传统语音情感特征和分类识别算法具有更好的综合性能,提高了语音情感分类的准确性。

权利要求书1页 说明书7页 附图4页CN 109767788 A 2019.05.17C N 109767788A1.一种基于LLD和DSS融合特征的语音情感识别方法,其特征在于,该方法包括如下步骤:步骤1:提取情感语音数据集的LLD特征和DSS特征;步骤2:将LLD特征与DSS特征作为自编码器的训练集,所述自编码器对LLD特征和DSS特征进行降维计算,得到降维后的LLD+DSS的融合特征;步骤3:将步骤2中所述的LLD+DSS的融合特征依次输入至LSTM深度网络中,由LSTM深度网络识别每条融合特征对应的情感种类。

2.基于权利要求1所述的方法,其特征在于,所述步骤1中,采用DSS算法对情感语音数据集进行DSS特征的提取;所述DSS算法的阶数设为2阶,即提取的DSS特征包括情感语音数据集的零阶特征、一阶特征和二阶特征,各特征的获取方法为:将情感语音数据集作为输入信号通过第一低通滤波器获得零阶特征;将情感语音数据集作为输入信号依次通过第一小波带通滤波器和第二低通滤波器获得一阶特征;将情感语音数据集作为输入信号依次通过第一小波带通滤波器、第二小波带通滤波器和第三低通滤波器获得二阶特征,所述第二小波带通滤波器的频率高于第一小波带通滤波器的频率。

【CN109767791A】一种针对呼叫中心通话的语音情绪识别及应用系统【专利】

(19)中华人民共和国国家知识产权局(12)发明专利申请(10)申请公布号 (43)申请公布日 (21)申请号 201910217722.5(22)申请日 2019.03.21(71)申请人 中国—东盟信息港股份有限公司地址 530200 广西壮族自治区南宁市良庆区平乐大道18号(72)发明人 林僚 梁冬明 张超婧 韦建福 蒋莉芳 (74)专利代理机构 北京天奇智新知识产权代理有限公司 11340代理人 谭连香(51)Int.Cl.G10L 25/63(2013.01)H04M 3/51(2006.01)(54)发明名称一种针对呼叫中心通话的语音情绪识别及应用系统(57)摘要一种针对呼叫中心通话的语音情绪识别及应用系统包括,语音处理模块,其用于提取语音信息并对语音信息进行预处理;语音关键词检测模块其用于将所述语音特征分析子模块的语音数据识别为情感类关键词和主题类关键词,并获取情绪数据信息及所反应问题数据信息;情感模型集模块,其用于对通话者的情感状态进行动态的捕获及跟踪;情绪分类模块,其用于判断待检测的通话中语音的情绪类别;业务应用模块,其用于为客服人员提供应答辅助及为管理人员提供管理辅助。

本发明的一种针对呼叫中心通话的语音情绪识别及应用系统能够使客服人员准确了解的客户的情绪,同时提供有效的应答方案,而且能够对客服人员进行准确地考核。

权利要求书2页 说明书8页 附图1页CN 109767791 A 2019.05.17C N 109767791A权 利 要 求 书1/2页CN 109767791 A1.一种针对呼叫中心通话的语音情绪识别及应用系统,其特征在于,包括语音处理模块(1)、语音关键词检测子模块(2)、情感模型集模块(3)、情绪分类模块(4)、业务应用模块(5)及数据库模块(6);所述语音处理模块(1)包括语音提取子模块(11)及语音特征分析子模块(12),所述语音提取子模块(11)用于在待检测的通话中语音的获取;所述语音特征分析子模块(12)用于将接收所述语音提取子模块(11)的语音数据,并通过预加重、加窗分帧及端点检测方式对所述语音提取子模块(11)的语音进行处理,以获取所述语音提取子模块(11)的音律、音质及频谱特征;所述语音关键词检测模块(2)用于接收所述语音特征分析子模块(12)的语音数据,并通过建立关键词库识别情感类关键词和主题类关键词,以获得所述语音提取子模块(11)中客户的情绪数据信息及所反应问题数据信息;所述情感模型集模块(3)用于储存多个不同的情感分类模型集,并接收所述语音特征分析子模块(12)的数据信息,以对通话者的情感状态进行动态的捕获及跟踪;所述情绪分类模块(4)用于获取所述语音关键词检测模块(2)及所述情感模型集模块(3)的数据信息,并采用分类模型判断待检测的通话中语音的情绪类别;所述业务应用模块(5)包括客户信息显示子模块(51)、情绪显示子模块(52)、应答提示子模块(53)、考核数据子模块(54)及企业问题分析子模块(55),所述客户信息显示子模块(51)与产品销售记录平台通讯连接,所述客户信息显示子模块(51)用于根据客户的电话号码在产品销售记录平台显示客户的购买信息;所述情绪显示子模块(52)用于接收所述语音关键词检测子模块(2)及所述情绪分类模块(3)的数据信息,并实时显示当前通话中客户的情绪倾向信息;所述应答提示子模块(53)包括应答方案数据库(531)及应答提示框(532),所述应答方案数据库(531)用于存储产品相关信息、应对不同情绪类型处理方案、应答术语及问题处理流程的数据信息;所述应答提示框(532)用于通过机器学习算法结合所述语音关键词检测子模块(2)、所述情绪分类模块(3)及所述应答方案数据库(531)数据,自动生成应答提示方案并显示;所述考核数据子模块(54)用于根据所述情绪分类模块(4)的数据对客服服务质量的考核;所述企业问题分析子模块(55)用于根据所述语音关键词检测模块(2)的数据对产品情况的分析;所述数据库模块(6)用于所述语音关键词检测模块(2)、所述情感模型集模块(3)、所述情绪分类模块(4)及所述业务应用模块(5)数据的存储及发送。

【CN109767789A】一种用于语音情感识别的新特征提取方法【专利】

(19)中华人民共和国国家知识产权局(12)发明专利申请(10)申请公布号 (43)申请公布日 (21)申请号 201910168424.1(22)申请日 2019.03.06(71)申请人 慧言科技(天津)有限公司地址 300384 天津市西青区天津华苑产业区海泰发展六道6号海泰绿色产业基地J座210、211(72)发明人 关昊天 张林娟 (74)专利代理机构 北京栈桥知识产权代理事务所(普通合伙) 11670代理人 潘卫锋(51)Int.Cl.G10L 25/63(2013.01)G10L 25/30(2013.01)G10L 25/03(2013.01)(54)发明名称一种用于语音情感识别的新特征提取方法(57)摘要本发明公开了一种用于语音情感识别的新特征提取方法,包括以下几个步骤:第一步:计算分段语谱图;第二步:特征准备与融合;步骤三,特征提取与分类。

利用先验知识和光谱信息的组合光谱特征(CSF)和优化光谱特征(RSF),用CNN -BLSTM模型从新特征中学习深度特征并区分情感。

与语谱图相比,组合光谱特征和优化光谱特征相对错误率分别降低了32.04%和36.91%,能有效提高语音情感识别的准确性。

权利要求书2页 说明书4页 附图1页CN 109767789 A 2019.05.17C N 109767789A权 利 要 求 书1/2页CN 109767789 A1.一种用于语音情感识别的新特征提取方法,其特征在于,包括以下步骤:第一步,计算分段语谱图:将句子分成固定长度的语音段,经过短时傅立叶变换之后,获得分段语谱图的原始光谱矩阵,其大小为M×N,其中M表示时间点的数量,N表示所选区域和频率分辨率;第二步,特征准备与融合:1)获取帧级LLDs和段级统计特征;2)将固定帧数语音的LLDs特征按时间序列排列起来,构成段级时序LLDs特征,归一化后,获得时序LLDs的矩阵,其大小为M×P,其中M表示一段中的帧数,P表示LLDs的维数;3)按照时间序列为轴,将所述分段语谱图和所述时序LLDs拼接在一起作为组合光谱特征的矩阵,其大小是M×Q;4)将所述分段语谱图、时间序列LLDs和统计特征拼接在一起成优化光谱特征的矩阵,其大小为M×T;第三步,特征提取与分类:利用CNN分别从组合光谱特征和优化光谱特征中提取深度特征并将它们按时间排列成话语级特征,送到BLSTM中完成7种情感分类,构建CNN-BLSTM模型。

【CN109767766A】一种语音识别方法及装置【专利】

3

CN 109767766 A

说 明 书

1/7 页

一种语音识别方法及装置

技术领域 [0001] 本发明实施例涉及语音识别领域,尤其涉及页 说明书7页 附图3页

CN 109767766 A

CN 109767766 A

权 利 要 求 书

1/2 页

1 .一种语音识别方法,应用于语音识别装置,所述语音识别装置包括:传声器阵列,其 特征在于,所述方法包括:

通过所述传声器阵列采集第一声源; 采用预设算法,从所述第一声源中分离出目标声源; 接收与所述语音识别装置连接的外设发送的第二声源; 对所述目标声源和所述第二声源进行叠加,得到叠加后的声源; 识别所述叠加后的声源,并根据识别结果执行相应的操作。 2 .根据权利要求1所述的语音识别方法,其特征在于,所述识别所述叠加后的声源,并 根据识别结果执行相应的操作,包括: 采用声音模型识别所述叠加后的声源,如果结果与预存的唤醒词相同 ,则启动人机交 互功能; 去除所述语音识别装置的声音。 3 .根据权利要求1或2所述的语音识别方法,其特征在于,所述对所述目标声源和所述 第二声源进行叠加,包括: 采用快拍数方法,对所述目标声源和所述第二声源进行相关性计算,得到延时时间; 以所述目标声源的时间为基准,根据所述延时时间对所述第二声源进行延时处理; 根据所述目标声源和所述第二声源分别对应的权重,对所述目标声源和延时后的所述 第二声源进行叠加。 4 .根据权利要求1所述的语音识别方法,其特征在于,所述第二声源为所述外设采集的 单一方向声源。 5 .一种语音识别装置,其特征在于,所述语音识别装置包括:传声器阵列、采集单元、分 离单元、接收单元、叠加单元和处理单元; 所述采集单元,用于通过所述传声器阵列采集第一声源; 所述分离单元,用于采用预设算法,从所述第一声源中分离出目标声源; 所述接收单元,用于接收与所述语音识别装置连接的外设发送的第二声源; 所述叠加单元,用于对所述目标声源和所述第二声源进行叠加,得到叠加后的声源; 所述处理单元,用于识别所述叠加后的声源,并根据识别结果执行相应的操作。 6 .根据权利要求5所述的语音识别装置,其特征在于,所述处理单元,具体用于: 采用声音模型识别所述叠加后的声源,如果结果与预存的唤醒词相同 ,则启动人机交 互功能; 去除所述语音识别装置的声音。 7 .根据权利要求5或6所述的语音识别装置,其特征在于,所述叠加单元,具体用于: 采用快拍数方法,对所述目标声源和所述第二声源进行相关性计算,得到延时时间; 以所述目标声源的时间为基准,根据所述延时时间对所述第二声源进行延时处理; 根据所述目标声源和所述第二声源分别对应的权重,对所述目标声源和延时后的所述 第二声源进行叠加。 8 .根据权利要求5所述的语音识别装置,其特征在于,所述第二声源为所述外设采集的 单一方向声源。 9 .一种语音识别装置,其特征在于,所述语音识别装置包括:处理器、存储器、通信接口

一种情感识别方法及系统[发明专利]

![一种情感识别方法及系统[发明专利]](https://img.taocdn.com/s3/m/dfafddeeeff9aef8951e0685.png)

专利名称:一种情感识别方法及系统

专利类型:发明专利

发明人:陈桂军,张雪英,李凤莲,孙颖,黄丽霞,王杰申请号:CN201910201740.4

申请日:20190318

公开号:CN109871831A

公开日:

20190611

专利内容由知识产权出版社提供

摘要:本发明公开了一种情感识别方法及系统,该方法包括:获取待识别的脑电信号;提取待识别时频域特征、待识别非线性特征和待识别脑网络属性特征;待识别时频域特征为根据待识别的脑电信号的小波分解系数计算得到的小波熵;待识别非线性特征包括对待识别的脑电信号进行离散傅里叶变换后得到的功率谱密度和对待识别的脑电信号进行平均误差计算后得到的Hurst指数;待识别脑网络属性特征反应待识别的脑电信号之间的相关性;对待识别的脑电信号特征采用训练好的支持向量分类机进行情感识别。

本发明提出的方法及系统,具有的能够提高情感识别准确率优点。

申请人:太原理工大学

地址:030000 山西省太原市迎泽西大街79号太原理工大学

国籍:CN

代理机构:北京高沃律师事务所

代理人:程华

更多信息请下载全文后查看。

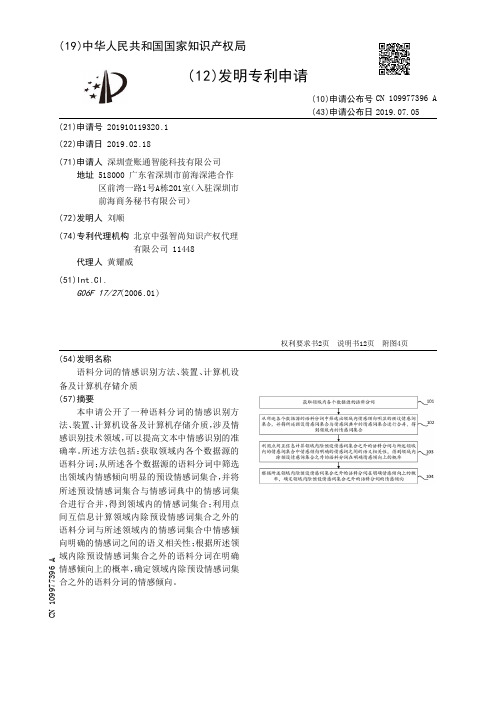

【CN109977396A】语料分词的情感识别方法、装置、计算机设备及计算机存储介质【专利】

(19)中华人民共和国国家知识产权局(12)发明专利申请(10)申请公布号 (43)申请公布日 (21)申请号 201910119320.1(22)申请日 2019.02.18(71)申请人 深圳壹账通智能科技有限公司地址 518000 广东省深圳市前海深港合作区前湾一路1号A栋201室(入驻深圳市前海商务秘书有限公司)(72)发明人 刘顺 (74)专利代理机构 北京中强智尚知识产权代理有限公司 11448代理人 黄耀威(51)Int.Cl.G06F 17/27(2006.01)(54)发明名称语料分词的情感识别方法、装置、计算机设备及计算机存储介质(57)摘要本申请公开了一种语料分词的情感识别方法、装置、计算机设备及计算机存储介质,涉及情感识别技术领域,可以提高文本中情感识别的准确率。

所述方法包括:获取领域内各个数据源的语料分词;从所述各个数据源的语料分词中筛选出领域内情感倾向明显的预设情感词集合,并将所述预设情感词集合与情感词典中的情感词集合进行合并,得到领域内的情感词集合;利用点间互信息计算领域内除预设情感词集合之外的语料分词与所述领域内的情感词集合中情感倾向明确的情感词之间的语义相关性;根据所述领域内除预设情感词集合之外的语料分词在明确情感倾向上的概率,确定领域内除预设情感词集合之外的语料分词的情感倾向。

权利要求书2页 说明书12页 附图4页CN 109977396 A 2019.07.05C N 109977396A权 利 要 求 书1/2页CN 109977396 A1.一种语料分词的情感识别方法,其特征在于,所述方法包括:获取领域内各个数据源的语料分词;从所述各个数据源的语料分词中筛选出领域内情感倾向明显的预设情感词集合,并将所述预设情感词集合与情感词典中的情感词集合进行合并,得到领域内的情感词集合,所述领域内情感词集合中记录有领域内情感倾向明确的情感词;利用点间互信息计算领域内除预设情感词集合之外的语料分词与所述领域内的情感词集合中情感倾向明确的情感词之间的语义相关性,得到领域内除预设情感词集合之外的语料分词在明确情感倾向上的概率;根据所述领域内除预设情感词集合之外的语料分词在明确情感倾向上的概率,确定领域内除预设情感词集合之外的语料分词的情感倾向。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

(19)中华人民共和国国家知识产权局

(12)发明专利申请

(10)申请公布号 (43)申请公布日 (21)申请号 201910173689.0

(22)申请日 2019.02.28

(71)申请人 中国传媒大学

地址 100000 北京市朝阳区定福庄东街1号

(72)发明人 巩微 范文庆 金连婧 伏文龙

黄玮

(51)Int.Cl.

G10L 25/63(2013.01)

G10L 25/30(2013.01)

G10L 25/45(2013.01)

(54)发明名称

一种语音情感识别方法及系统

(57)摘要

本发明公开一种语音情感识别方法及系统。

所述识别方法包括:获取语音信号;预处理所述

语音信号,获得预处理语音信号;计算所述预处

理语音信号对应的语谱图;计算多个不同语段长

度的所述预处理语音信号的情感识别率,将所述

情感识别率最高对应的语段长度确定为最佳语

段长度;根据所述最佳语段长度对应的语谱图提

取所述语音信号的声学特征;将所述声学特征采

用卷积神经网络分类识别所述语音信号的情感。

采用基于语谱图和卷积神经网络的语音情感识

别方法提升了语音情感识别率。

权利要求书3页 说明书6页 附图1页CN 109767790 A 2019.05.17

C N 109767790

A

1.一种语音情感识别方法,其特征在于,所述识别方法包括:

获取语音信号;

预处理所述语音信号,获得预处理语音信号;

计算所述预处理语音信号对应的语谱图;

计算多个不同语段长度的所述预处理语音信号的情感识别率,将所述情感识别率最高对应的语段长度确定为最佳语段长度;

根据所述最佳语段长度对应的语谱图提取所述语音信号的声学特征;

将所述声学特征采用卷积神经网络分类识别所述语音信号的情感。

2.根据权利要求1所述的一种语音情感识别方法,其特征在于,所述预处理所述语音信号,获得预处理语音信号具体包括:

将所述语音信号经过数字化处理,获得脉冲语音信号;

将所述脉冲语音信号采样处理,获得离散时间和连续幅值的脉冲语音信号;

将所述离散时间和连续幅值的脉冲语音信号量化处理,获得离散时间和离散幅值的脉冲语音信号;

将所述离散时间和离散幅值的脉冲语音信号进行预加重处理,获得预加重语音信号;将所述预加重语音信号进行分帧加窗处理,获得预处理语音信号。

3.根据权利要求1所述的一种语音情感识别方法,其特征在于,所述计算所述预处理语音信号对应的语谱图具体包括:

获取所述预处理语音信号的采样频率F s 、采样数据序列S g 和语段长度;

根据所述语段长度和窗函数的窗长N new 将所述预处理语音信号分为N段,获得N段语音信号;

根据所述语段长度和所述N段语音信号计算帧移N sfgtft ;

对第i帧语音信号S i 加窗处理,获得加窗语音信号S i ′,

S i ′=S i ×hanning(N new ),其中i的取值为1,2,......,N;

将所述加窗语音信号S i ′进行傅里叶变换,获得傅里叶变换语音信号Z i ;

根据所述傅里叶变换语音信号Z i 的相位θi 计算所述第i帧语音信号S i 的能量密度函数|Z i |2;将所述窗函数进行N sfgtft 个帧移,获得第i+1帧语音信号S i+1的能量密度函数|Z i+1|2;

获得一个[N new /2]+1行、N列的矩阵R;

将所述矩阵R映射为灰度图,获得所述计算所述预处理语音信号对应的语谱图。

4.根据权利要求1所述的一种语音情感识别方法,其特征在于,所述将所述声学特征采用卷积神经网络分类识别所述语音信号的情感具体包括:

所述语谱图采用卷积神经网络的卷积层处理,

三维的所述语谱图转换为N个二维特征;其中,b j 为能够训练的偏差函数,k ij 为卷积核,x i 表示输入的第i段语谱图;y i 表示输出的第i段语谱图对应的二维特征;

将所述输出的第i段语谱图对应的二维特征y i 通过池化层处理,获得低分辨率声学特征y i ′;

所述卷积层与所述池化层之间设置有全连接层,所述全连接层中有激活函数,所述全

权 利 要 求 书1/3页2CN 109767790 A。