神经网络学习文章

医学影像分析中的卷积神经网络使用教程

医学影像分析中的卷积神经网络使用教程医学影像分析是一项重要且复杂的任务,对医疗诊断和治疗具有重要意义。

随着人工智能的发展,卷积神经网络(Convolutional Neural Networks, CNN)在医学影像分析领域取得了显著的成果。

本篇文章将介绍医学影像分析中的卷积神经网络使用教程,帮助读者理解和应用这一技术。

1. 卷积神经网络简介卷积神经网络是一种深度学习算法,最初被设计用于图像识别任务。

它具有多层神经网络结构,包括卷积层、池化层和全连接层。

卷积层用于从输入图像中提取特征,池化层用于降低特征图的维度,全连接层用于分类或回归预测。

卷积神经网络通过学习权重参数,可以自动从数据中学习特征并进行预测。

2. 医学影像分析中的应用卷积神经网络在医学影像分析中有广泛的应用,例如疾病诊断、影像分割、病灶检测等。

医学影像通常包含复杂的结构和纹理,传统的图像处理方法往往难以准确地提取有用的特征。

而卷积神经网络可以通过学习特征来解决这个问题,有效地抽取和表示医学影像中的信息。

3. 数据准备在使用卷积神经网络进行医学影像分析之前,我们需要准备好训练数据和测试数据。

训练数据是用于训练网络的样本,通常需要标记或注释,以提供预期的输出结果。

测试数据用于评估网络的性能,通常没有标记,需要进行预测并与真实结果进行比较。

4. 构建卷积神经网络模型构建卷积神经网络模型是医学影像分析中的关键步骤。

我们可以选择不同的网络结构和层数,根据具体的任务需求进行调整。

一般来说,常用的卷积神经网络结构有LeNet、AlexNet、VGG、GoogLeNet和ResNet等。

5. 数据预处理在输入数据进入卷积神经网络之前,需要进行预处理以提高网络性能和准确度。

常见的数据预处理方法包括图像增强、去噪、标准化和数据增强等。

图像增强用于增加图像的对比度和清晰度,去噪可以减少噪声对网络的影响,标准化可以将像素值映射到相同的尺度范围,数据增强可以增加样本的多样性和丰富性。

理解卷积神经网络中的自注意力机制

理解卷积神经网络中的自注意力机制展开全文作者:Shuchen Du编译:ronghuaiyang导读计算机视觉中的编解码结构的局限性以及提升方法。

卷积神经网络(CNN)广泛应用于深度学习和计算机视觉算法中。

虽然很多基于CNN的算法符合行业标准,可以嵌入到商业产品中,但是标准的CNN算法仍然有局限性,在很多方面还可以改进。

这篇文章讨论了语义分割和编码器-解码器架构作为例子,阐明了其局限性,以及为什么自注意机制可以帮助缓解问题。

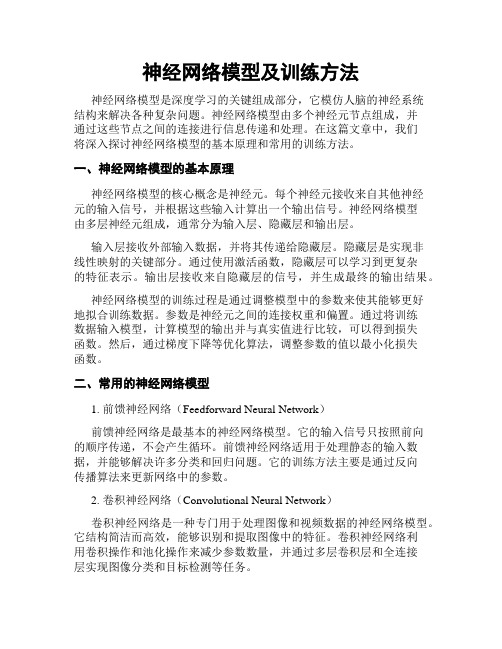

标准编解码结构的局限性图1:标准编解码结构解码器架构(图1)是许多计算机视觉任务中的标准方法,特别是像素级预测任务,如语义分割、深度预测和一些与GAN相关的图像生成器。

在编码器-解码器网络中,输入图像进行卷积、激活以及池化得到一个潜向量,然后恢复到与输入图像大小相同的输出图像。

该架构是对称的,由精心设计的卷积块组成。

由于其简单和准确,该体系结构被广泛使用。

图2:卷积的计算但是,如果我们深入研究卷积的计算(图2),编码器-解码器架构的局限性就会浮出表面。

例如,在3x3卷积中,卷积滤波器有9个像素,目标像素的值仅参照自身和周围的8个像素计算。

这意味着卷积只能利用局部信息来计算目标像素,这可能会带来一些偏差,因为看不到全局信息。

也有一些朴素的方法来缓解这个问题:使用更大的卷积滤波器或有更多卷积层的更深的网络。

然而,计算开销越来越大,结果并没有得到显著的改善。

理解方差和协方差方差和协方差都是统计学和机器学习中的重要概念。

它们是为随机变量定义的。

顾名思义,方差描述的是单个随机变量与其均值之间的偏差,而协方差描述的是两个随机变量之间的相似性。

如果两个随机变量的分布相似,它们的协方差很大。

否则,它们的协方差很小。

如果我们将feature map中的每个像素作为一个随机变量,计算所有像素之间的配对协方差,我们可以根据每个预测像素在图像中与其他像素之间的相似性来增强或减弱每个预测像素的值。

在训练和预测时使用相似的像素,忽略不相似的像素。

量子力学模拟神经网络功能

量子力学模拟神经网络功能量子力学和神经网络是两个当今科学领域中备受关注的领域。

量子力学探索微观世界的行为,而神经网络模拟人脑神经元的工作方式。

近年来,科学家们开始尝试结合这两个领域,以期望发现新的科学突破和应用前景。

本篇文章将围绕量子力学模拟神经网络功能展开讨论。

首先,让我们先了解什么是量子力学。

量子力学是基于量子理论的一个学科,研究微观粒子的行为规律和性质。

它提供了一种非常精确的描述微观粒子运动和相互作用的数学框架,可以用来解释和预测电子、光子等微观粒子的行为。

神经网络是一种模拟人脑神经元工作方式的系统。

它由许多人工神经元(节点)组成,通过连接权重和激活函数来模拟神经元之间的信息传递和处理。

神经网络通过学习和训练,可以解决各种问题,如图像识别、语音识别和自然语言处理等。

量子力学模拟神经网络是一种新兴的研究领域,旨在利用量子力学的性质来增强神经网络的功能。

量子力学的一些特性,如叠加态和纠缠态,可以提供在传统计算中不可实现的处理能力和信息传递速度。

一种应用量子力学模拟神经网络的方法是量子神经网络(Quantum Neural Network,QNN)。

QNN利用量子比特(Qubit)作为信息处理的基本单位,通过调控量子叠加态和纠缠态,提供对数据进行更复杂和高效处理的能力。

QNN可以在机器学习和数据处理领域中发挥重要作用,例如优化问题求解、模式识别和数据压缩等。

另一种应用量子力学模拟神经网络的方法是量子机器学习(Quantum Machine Learning,QML)。

QML利用量子力学的特性来改进传统机器学习算法,提高算法的效率和性能。

例如,量子支持向量机(Quantum Support Vector Machines,QSVM)可以通过利用量子计算的优势来加快分类和回归问题的求解过程。

量子神经网络(Quantum Neural Networks,QNNs)也可以用来训练和优化神经网络的参数。

除了在机器学习领域,量子力学模拟神经网络还可以应用于模拟生物系统和神经科学研究中。

neural processing letters文章模板 -回复

neural processing letters文章模板-回复问题,并陈述相关论点和论据。

【标题】神经处理信件:探索人脑与人工神经网络的相似之处【引言】人类的大脑一直被视为自然界最复杂且神秘的系统之一。

然而,随着人工智能的快速发展,人们开始对人脑与人工神经网络之间的相似之处产生了浓厚的兴趣。

本文将探讨神经处理信件,旨在回答关于人脑与人工神经网络相似性的问题,并提供支持这一观点的论据。

【主体】1. 人脑与神经网络相似的工作原理1.1 生物神经元和人工神经元的相似性论据:生物神经元和人工神经元在功能和结构上有诸多相似之处。

论据:生物神经元和人工神经元都能够接收、处理和传递信息。

1.2 神经网络与人脑神经元的连接性论据:神经网络的连接性模仿了人脑神经元之间的连接方式。

论据:人脑与神经网络均通过突触连接来传递信息。

2. 人工智能与认知能力的相似性2.1 神经网络训练与人类学习的相似性论据:神经网络通过反复训练来提高性能,这与人类学习的过程相似。

论据:神经网络通过调整权重和连接方式来优化性能,类似于人脑通过突触强化来加强连接。

2.2 神经网络能力模型与人类认知过程的相似性论据:神经网络在解决特定任务时,像人类一样使用特征提取和模式识别。

论据:神经网络具有分层结构,这类似于人脑的认知处理层次。

3. 人脑与神经网络的局限性3.1 人脑的复杂性和神经网络的简化性论据:人脑的结构和功能远比神经网络复杂得多。

论据:神经网络是人脑的简化模型,忽略了许多真实神经系统中存在的复杂细节。

3.2 神经网络对数据的依赖和人脑的灵活性论据:神经网络需要大量数据进行训练,而人脑可以通过少量数据进行学习和推理。

论据:人脑能够根据环境变化灵活调整和适应,而神经网络的适应性相较之下较为有限。

【结论】尽管人脑与人工神经网络之间存在相似性,但人脑的复杂性和灵活性依然是我们需要继续研究和模仿的领域。

通过探索人脑与人工神经网络的相似之处,我们能够更好地理解人脑的运作机制,并进一步改进人工智能系统的性能和能力。

神经网络基本知识

神经网络基本知识一、内容简述神经网络是机器学习的一个重要分支,是一种模拟生物神经网络结构和功能的计算模型。

它以其强大的学习能力和自适应能力广泛应用于多个领域,如图像识别、语音识别、自然语言处理等。

《神经网络基本知识》这篇文章将带领读者了解神经网络的基本概念、原理和应用。

1. 神经网络概述神经网络是一种模拟生物神经系统结构和功能的计算模型。

它由大量神经元相互连接构成,通过学习和调整神经元之间的连接权重来进行数据处理和模式识别。

神经网络的概念自上世纪五十年代提出以来,经历了漫长的发展历程,逐渐从简单的线性模型演变为复杂的多层非线性结构。

神经网络在人工智能领域发挥着核心作用,广泛应用于计算机视觉、语音识别、自然语言处理等领域。

神经网络的基本构成单元是神经元,每个神经元接收来自其他神经元的输入信号,通过特定的计算方式产生输出信号,并传递给其他神经元。

不同神经元之间的连接强度称为权重,通过训练过程不断调整和优化。

神经网络的训练过程主要是通过反向传播算法来实现的,通过计算输出层误差并反向传播到输入层,不断调整权重以减小误差。

神经网络具有强大的自适应能力和学习能力,能够处理复杂的模式识别和预测任务。

与传统的计算机程序相比,神经网络通过学习大量数据中的规律和特征,自动提取高级特征表示,避免了手动设计和选择特征的繁琐过程。

随着深度学习和大数据技术的不断发展,神经网络的应用前景将更加广阔。

神经网络是一种模拟生物神经系统功能的计算模型,通过学习和调整神经元之间的连接权重来进行数据处理和模式识别。

它在人工智能领域的应用已经取得了巨大的成功,并将在未来继续发挥重要作用。

2. 神经网络的历史背景与发展神经网络的历史可以追溯到上个世纪。

最初的神经网络概念起源于仿生学,模拟生物神经网络的结构和功能。

早期的神经网络研究主要集中在模式识别和机器学习的应用上。

随着计算机科学的快速发展,神经网络逐渐成为一个独立的研究领域。

在20世纪80年代和90年代,随着反向传播算法和卷积神经网络的提出,神经网络的性能得到了显著提升。

神经网络基础知识

神经网络基础知识神经网络是一种模拟大脑处理信息的计算机系统。

神经网络通过自动学习和适应来执行任务,例如图像和语音识别。

对于普通人来说,理解神经网络可能有些困难。

因此,我们准备了这篇文章,以帮助您了解神经网络的基本知识。

1.神经元神经元是神经网络最基本的组成部分。

神经元接收输入信号,将其加权处理,然后传递给下一个神经元。

每个神经元都有一个阈值,当加权输入信号超过该阈值时,它产生一个输出信号。

神经元的目的是对输入信号进行分类或数据处理。

可以通过调整神经元之间的连接权重来改变神经元的行为,从而调整神经网络的性能。

2.神经网络神经网络由许多相互连接的神经元组成,这些神经元可以分为层。

每个神经元接收其上一层的输出信号,加权后将其传递到下一层。

一般而言,神经网络通常有三层:输入层,隐藏层和输出层。

输入层接收外部输入,并将其传递到隐藏层。

隐藏层在接收输入信号后产生新特征,这些新特征可以用于进一步处理,最终生成输出。

输出层将处理后的结果展示给用户。

3.训练神经网络训练神经网络分为两个步骤:前向传递和反向传递。

·前向传递:给网络提供输入数据,网络经过处理后,输出一个结果。

·反向传递:通过改变神经元之间的连接权重(weight)来训练神经网络,在误差反向传播的过程中逐渐调整。

误差越小,神经网络的性能就越好。

4.损失函数损失函数的主要功能是对神经网络的性能进行评估。

损失函数可以描述神经网络的误差和数据之间的差异。

损失函数的大小越小,神经网络的性能就越好。

常用的损失函数有平方损失函数、交叉熵损失函数、绝对值损失函数等。

5.深度学习深度学习是一种基于神经网络的机器学习方法,这种方法通过将多层神经网络组合起来来模拟人类大脑的学习方式。

深度学习的一个优点是可以在没有人工干预的情况下自动学习。

由于网络和数据集的复杂性,深度学习的计算成本很高,但是随着技术的发展,越来越多的公司和研究机构正在将深度学习应用于实际场景中。

神经网络模型及训练方法

神经网络模型及训练方法神经网络模型是深度学习的关键组成部分,它模仿人脑的神经系统结构来解决各种复杂问题。

神经网络模型由多个神经元节点组成,并通过这些节点之间的连接进行信息传递和处理。

在这篇文章中,我们将深入探讨神经网络模型的基本原理和常用的训练方法。

一、神经网络模型的基本原理神经网络模型的核心概念是神经元。

每个神经元接收来自其他神经元的输入信号,并根据这些输入计算出一个输出信号。

神经网络模型由多层神经元组成,通常分为输入层、隐藏层和输出层。

输入层接收外部输入数据,并将其传递给隐藏层。

隐藏层是实现非线性映射的关键部分。

通过使用激活函数,隐藏层可以学习到更复杂的特征表示。

输出层接收来自隐藏层的信号,并生成最终的输出结果。

神经网络模型的训练过程是通过调整模型中的参数来使其能够更好地拟合训练数据。

参数是神经元之间的连接权重和偏置。

通过将训练数据输入模型,计算模型的输出并与真实值进行比较,可以得到损失函数。

然后,通过梯度下降等优化算法,调整参数的值以最小化损失函数。

二、常用的神经网络模型1. 前馈神经网络(Feedforward Neural Network)前馈神经网络是最基本的神经网络模型。

它的输入信号只按照前向的顺序传递,不会产生循环。

前馈神经网络适用于处理静态的输入数据,并能够解决许多分类和回归问题。

它的训练方法主要是通过反向传播算法来更新网络中的参数。

2. 卷积神经网络(Convolutional Neural Network)卷积神经网络是一种专门用于处理图像和视频数据的神经网络模型。

它结构简洁而高效,能够识别和提取图像中的特征。

卷积神经网络利用卷积操作和池化操作来减少参数数量,并通过多层卷积层和全连接层实现图像分类和目标检测等任务。

3. 循环神经网络(Recurrent Neural Network)循环神经网络是一种具有循环连接的神经网络模型。

它能够处理序列数据,并具有记忆能力。

循环神经网络通过在时间上展开,将过去的信息传递给未来,从而建立起对序列数据的依赖关系。

基于神经网络的机械产品结构优化设计研究

基于神经网络的机械产品结构优化设计研究随着人工智能技术的快速发展,神经网络在各个领域中的应用也日渐广泛。

机械产品结构的优化设计是其中一个重要的研究方向。

在这篇文章中,将探讨如何使用神经网络来进行机械产品结构的优化设计,并介绍相关的研究成果和应用案例。

一、引言机械产品的结构优化设计是为了在满足特定设计要求的前提下,使得产品的性能更加优越。

传统的机械产品结构设计通常通过试错法进行,需要花费大量时间和资源。

而神经网络的出现,为机械产品结构优化设计带来了新的思路和方法。

二、神经网络在机械产品结构优化设计中的应用神经网络是一种模拟人脑神经系统的计算模型,其强大的非线性拟合能力使其在机械产品结构优化设计中得到了广泛应用。

通过收集和分析产品设计相关的数据,神经网络可以学习到设计变量与性能指标之间的复杂关系,并通过训练模型来预测最佳的设计方案。

三、机械产品结构优化设计中的神经网络模型神经网络模型主要由输入层、隐藏层和输出层组成。

其中,输入层接收设计变量(如材料、尺寸等)作为输入,输出层则给出相应的性能指标。

隐藏层则起到对输入层和输出层之间的变量进行信息传递和处理的作用。

在构建神经网络模型时,需要选择适当的激活函数、损失函数和优化算法来提高模型的性能和训练效果。

四、神经网络在机械产品结构优化设计中的案例研究近年来,许多研究者已经在机械产品结构优化设计中应用了神经网络,并取得了一系列令人瞩目的成果。

例如,在飞机结构设计中,通过训练神经网络模型,可以准确地预测不同结构参数对飞机的气动性能、结构强度等指标的影响,从而快速得到优化的设计方案。

在汽车工业中,通过神经网络模型的优化设计,可以有效地降低汽车的重量,提高燃油效率和行驶稳定性。

五、机械产品结构优化设计中存在的挑战和解决方案虽然神经网络在机械产品结构优化设计中具有巨大的潜力,但仍然存在一些挑战。

例如,数据不足、训练时间过长等问题。

为了解决这些问题,研究者采用了一系列的解决方案,如引入模拟数据和增强学习技术。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

9.3 Neural NetworksNeural networks are an interesting topic for artificial intelligence researchers. Since they are related to man’s nervous system construction, the results of their investigations form a foundation on which hypotheses describing the working of a brain can be built [1].Neural Network ObjectivesAlthough various neural network models to a greater or a lesser extent remind one of the actual neural network, nevertheless they do differ from it (apart from cases where such models are constructed with the intention of an exact simulation). The purpose of the limits imposed is to simplify the reasoning, and to enable the executability of algorithms devised [2].Artificial neural networks enable the execution of certain intelligent operations, e.g. associations.The analysis of these networks also provides interesting conclusions on parallel processing. Neural cells are characterized by a very long response (reaction) time (i.e. they work slowly), but because of [3] the massively parallel processing man is capable of instant execution of tasks for which conventional sequential machines require significantly more time; for instance, image recognition. Investigations of such processes will eventually lead to the design of fast algorithms that use the parallelism of artificial neurons. Parallel processing is especially important in building search algorithms employing neural networks.In the last couple of years electronic cubes containing more and more densely packed neural networks have appeared.Neural Network StructureA neural network is a set of processing units (nodes) joined by links through which they communicate. Each unit is characterized by its activation state which changes in time. From the current unit's activation state a signal it sends into the network is calculated [4]. This signal is carried over the links to other nodes. During the transmission it may be weakened or strengthened, depending upon the link's characteristics. Signals reaching a unit from its neighbors are combined into an input signal, from which the next activation state of that unit is computed [5].Network definition comprises descriptions of the following elements:⏹set of nodes⏹links⏹rules for calculating the input signal⏹activation function⏹output signal functionWe should start the characterization of processing units (neurons) by first indicating the significance of each unit. In some of the systems, single nodes clearly represent defined objects, features or concepts. This representation method is called local. Its opposite is a distributed representation, where single units denote not whole concepts but rather their abstract parts which do not have a representation in the language in which the working of a network is interpreted [6]. Only subsets of the whole network form full concept descriptions.A processing unit executes a simple sequence of operations: receives signals from neighbors, computes its activation state, and sends that state into the network. Not all units have to have the same characteristics (activation function, input signal), although networksare usually homogeneous.From the standpoint of network topology, units are classified as input, output and hidden. Input units are those which receive signals directly from the environment in which the network operates. Output units send the signal outside the network, and hidden units do not communicate directly with the environment. Sets of input and output units may contain common elements.Let us assume that a network consists of N units. Each of these units we denote by ui(1≤ i ≤ N ). A unit ui’s activation state at time t is denoted by ai(t). The whole network activation state is described, then, by a vectora(t)= (a1(t), a2(t),… , an(t))For various network models various assumptions regarding the values that an activation state can take are made [7]. These values can be continuous or discrete. A continuous value set can be bounded or unbounded [8], i.e. an activation state can be expressed by any real number or a real number from a bounded interval, e.g. [0, 1].The most common case of a discrete set are binary values, e.g. 0,1 or -1,1. The 0 (-1) state means that a unit is inactive, and 1 that it is active. Another set of values is -1, 0, 1. There are also networks possible where these values are limited to a certain well defined set, for instance 0, 1, 2, 3, 4.Units are joined by links. A link transmits a signal from one unit to the other, either strengthening or weakening it [9]. Some of the links may be excitatory. In that case, the signal transmitted [10] may increase the activation state of the receiver. Other links may be inhibitory. The signal transmitted may then lower the receiver's activation state. The power of signal transformation by a link is called the weight of that link. A weight of a link joining units ui and uj is denoted by wij [11]. Excitatory links have a positive weight while the inhibitory ones have a negative one. The lack of a link is equivalent to a link of weight 0. A signal input to a link from a unit ui's side reaches a uj unit multiplied by wij [12]. A link schema of a neural network is represented as a square weight matrix W(N×N) containing all the links' weights.In this approach it is assumed that a receiving unit treats all the incoming links the same. If this assumption cannot be upheld, the links are divided into link types, and for each link type a separate weight matrix W is given. In this section we consider only the networks with homogeneous links. Weights associated with links may change during a network learning process.A pattern of links between units determines the network topology and its capabilities. Cycle-free networks work differently to cyclic networks. Networks with just one level of links between the input and output units are inferior to multi-level networks with respect to a set of representable (recognizable) functions. The biggest capacity for function representation have fully connected networks (each node linked with every other node). The network link model is chosen depending upon its intended use.A unit's input signal is calculated from the signals sent to it and from the incoming links’weights. A unit ui’s incoming input signal at time t, denoted by neti(t), is calculated as a weighed sum of signals sent.where ok(t) is an output signal of unit uk at time t. Globally, an input signal is represented b y a vector net(t): net(t)=wo(t), where o(t)=( o1(t), o2(t), …, oN(t)) is a vector of output signals at time t. The reasoning above is applicable to networks with homogeneous links. In other cases, the value of neti(t) would be calculated by a more complicated procedure. The method of input signal calculation for a given network is constant and the same for all units.Each unit's activation state changes in time. A new state is calculated from the previous state and an input signal ai(t+1)=F(ai(t), neti(t)), and is generally expressed by the formula a(t+1)=F(a(t), net(t)), where F is an activation rule.In the simplest of cases, F does not take into account the previous activation state, and is an identity ai(t+1) = neti(t). For binary activation states, F is often given as F(x)=0 if x<0, F(x)=1 if x≥0.This means that if an input signal exceeds some threshold value a unit becomes active. Otherwise it becomes passive (inactive).For continuous activation states sets F assumes a form of sigmoidal function close [13] to a threshold function.A popular class of activation functions are quasi-linear functions, i.e. non-decreasing functions of one argument —single type input signal’s:Sometimes differentiability of the quasi-linear function is assumed. In that case it is called a semi-linear function.In some of the models an activation function is stochastic. From the input signal the probability of taking on a set value is calculated.In most models activation functions do not change in time. Exceptions are thermodynamic models, where some of the function parameters are changed. It should be noted that even unchangeable stochastic functions can, for the same data, return different values.。