并行计算基础知识讲座(1)

大规模数据处理中的并行计算

大规模数据处理中的并行计算一、引言现代社会中,数据已经成为重要的生产力,大量数据处理成了越来越多的企业所进行的必要活动。

随着数据量的增大,传统的单机计算已经无法满足快速高效的数据分析需求,因此需要采用并行计算来进行大规模数据处理。

二、并行计算的基础知识1.并行计算的定义并行计算作为计算机科学的一个重要研究领域,主要研究如何通过一些技术手段,使多台计算机同时参与处理,从而使计算速度大幅提升,计算效率得到了提升。

2.并行计算的基本原理并行计算主要依靠多处理器的硬件环境和计算机系统的软件技术,将一个大型任务划分成多个子任务,分配给不同的处理器进行处理,最后合并各个处理器的处理结果,形成最终的处理结果。

数据并行任务也可以通过同步、通信、互斥等方法实现负载均衡和任务管理。

三、大规模数据处理中的并行计算1.大规模数据处理的挑战对于大规模数据处理,数据量很大,单机计算的速度慢,计算成本很高,效率很低,因此需要采取并行计算来提高处理速度和效率,处理大量数据。

2.大规模数据处理使用并行计算的优点通过采用并行计算,可以快速并行化处理,缩短单个任务的处理时间,提高处理速度,提高计算机的资源利用率,减少处理时间和成本。

3.大规模数据处理中并行计算的应用大规模数据处理中,通常采用分布式系统、云计算、MapReduce等技术来进行并行计算。

这些技术可以将大量数据并行化处理,有效地提高了处理效率和速度。

四、大规模数据处理中的数据并行1.什么是数据并行数据并行是通过多个处理器对数据进行并行处理。

多个处理器可以同时处理同一任务的不同数据部分,从而实现负载均衡和高效的数据处理。

2.大规模数据处理中的数据并行数据并行是大规模数据处理中最常用的技术之一。

通过将数据划分成多个部分,分配给不同的处理器进行处理,最后再将处理结果合并,形成最终的处理结果。

在这个过程中,需要采用负载均衡算法来确保任务得到平均分配和处理。

3.快速排序算法在大规模数据处理中的应用快速排序是一种比较高效的排序算法,在大规模数据处理中应用广泛。

并行计算的基本原理

并行计算的基本原理并行计算的基本原理什么是并行计算•并行计算是一种通过同时执行多个计算任务来提高计算效率的技术。

它可以同时处理多个相互独立的子任务,从而加快整个计算过程。

并行计算的优势•提高计算效率:通过同时处理多个任务,对计算资源进行最大化的利用,从而减少计算时间。

•解决复杂问题:某些计算任务可能因为规模庞大而难以处理,通过并行计算可以将任务分割成多个子任务进行处理,从而更容易解决复杂的问题。

•增加可靠性:通过并行计算,即使某个任务出现故障,其他任务仍然可以继续执行,不会影响整个计算过程的可靠性。

并行计算的基本原理任务划分•并行计算的第一步是将整个计算任务分割成多个子任务,每个子任务相互独立,可以同时执行。

•任务划分的关键是找到能够并行执行的子任务,尽量保证各个子任务的负载均衡,避免某个任务过于繁重,导致整体计算效率下降。

任务通信•并行计算中的各个子任务需要相互通信,以便协调计算过程和交换计算结果。

•任务通信可以通过共享内存或消息传递来实现。

共享内存是多个任务共享同一块内存空间,可以直接读写变量,但需要注意同步问题;消息传递是通过发送和接收消息来进行任务间的通信,需要建立通信通道,并确保消息的正确传递。

任务调度•任务调度是指将各个子任务分配到计算资源上进行执行的过程。

•任务调度的目标是最大化地利用计算资源,以提高计算效率。

任务调度算法可以根据任务的优先级、负载均衡等因素进行选择。

结果合并•各个子任务执行完成后,需要将它们的计算结果进行合并,得到最终的计算结果。

•结果合并的过程可能涉及到数据的整合、计算的合并等操作,需要确保合并过程的正确性和有效性。

并行计算的应用领域•科学计算:并行计算可以加快科学计算的速度,从而提高研究效率。

在天气预报、基因组测序等领域都有广泛应用。

•数据处理:在大数据处理的场景中,通过并行计算可以更快地对海量数据进行处理和分析。

•人工智能:训练深度学习模型时,可以利用并行计算提高训练速度,加快模型的收敛过程。

并行计算PPT课件

C

Shell P

C

Shell P

互连网络

互连网络

(a)无共享

互连网络 共享磁盘

共享存储器 共享磁盘

(c)共享存储

(b)共享磁盘

2020/9/16

5

五种结构特性一览表

属性 结构类型 处理器类型 互连网络 通信机制 地址空间 系统存储器 访存模型 代表机器

2020/9/16

PVP MIMD 专用定制

SMP MIMD 商用

HP/Convex Exemplar)

分 布 存 储 器 NCC-NUMA (Cray T3E)

MIMD

DSM

NORMA

Cluster

(IBM SP2,DEC TruCluster Tandem Hymalaya,HP,

Microsoft Wolfpack,etc)

( 松散耦合)

(TreadMarks, Wind Tunnel, IVY,Shrimp,

etc.)

多计算机 (多 地 址 空 间 非 共 享 存 储 器 )

MPP (Intel TFLOPS)

( 紧耦合)

2020/9/16

7

SMP\MPP\机群比较

系统特征 节点数量(N) 节点复杂度 节点间通信

节点操作系统

支持单一系统映像 地址空间 作业调度 网络协议 可用性 性能/价格比 互连网络

S

MP

(Intel SHV,SunFire,DEC 8400, SGI PowerChallenge,IBMR60,etc.)

多处理机 ( 单地址空间

共享存储器 )

NUMA

COMA (KSR-1,DDM)

CC-NUMA

(Stanford Dash, SGI Origin 2000,Sequent NUMA-Q,

并行计算基础知识

SPMD模式:单程序多数据流 模式: 模式

可执行代码 运行 复制多份并独立执行, 形成多个独立的进程

进 程 一 ( 内 存 ) 存 内 ( 二 程

ቤተ መጻሕፍቲ ባይዱ

进

进 程 三 ( 内 存 )

可并行处理

如何将串行程序改为并行

为理解创建一个并行程序中的步骤, 为理解创建一个并行程序中的步骤, 让 我们首先定义三个重要的概念: 任务, 我们首先定义三个重要的概念 任务, 进程和处理器。 进程和处理器。

任务

任务是程序要完成的一个工作, 任务是程序要完成的一个工作, 其内容 和大小是随意的, 和大小是随意的, 它是并行程序所能处 理的并发性最小的单元; 理的并发性最小的单元 即一个任务只能 由一个处理器执行, 由一个处理器执行, 处理器之间的并发 性只能在任务之间开发。 性只能在

组织进程间的通讯。即将B的各个子块 send()到各个进程。 通过mpirun运行,将进程映射到处理器上。

并行描述

for i = 0 to p - 1 do l = i+myid mod p Cl = A * B, mp1 = myid+1 mod p, mm1 = myid-1 mod p if i != p- 1, send(B, mm1), recv(B, mp1) Endfor

MPI标准的实现包括MPICH、LAM、IBM MPL等多个版本,最常用和稳定的是 MPICH。它提供了与C、Fortran语言的 绑定。

我们可以将MPI看成一个“库” ,目前 使用的消息传递库是MPICH 1.2,共有上 百个接口,在FORTRAN 77和C语言中可 以直接对这些函数进行调用。多个进程 通过调用这些函数(类似调用子程序), 进行通信;

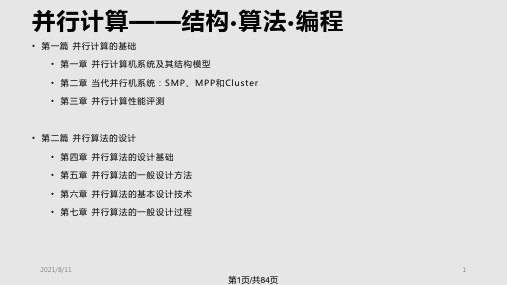

并行计算概述PPT课件

• 第一篇 并行计算的基础 • 第一章 并行计算机系统及其结构模型 • 第二章 当代并行机系统:SMP、MPP和Cluster • 第三章 并行计算性能评测

• 第二篇 并行算法的设计 • 第四章 并行算法的设计基础 • 第五章 并行算法的一般设计方法 • 第六章 并行算法的基本设计技术 • 第七章 并行算法的一盘

桥

系统 I

节点 2

节点 N

SAN(e.g.Myrinet)

I/O总 线 ,系 统 总 线

接口

LAN(e.g.以 太 网 ,FDDI)

系统 II

2021/8/11

15

第15页/共84页

网络性能指标

• 节点度(Node Degree):射入或射出一个节点的边数。在单向网络中, 入射和出射边之和称为节点度。

2

N / 2向)

4

2( N 1)

N

4

N 1

2N

4

2 N/2

2N

3 2loN g 1

1

非

N 1

是

N

非

2(N N)

非

2N

是

2N

非

N 1

星形

2

N N 1

超立方

N 2n

n

n

非 N / 2

是

N/2

N 1 nN/ 2

立方环

Nk2k

3

2k1k/2 N/(2k)

是

3N/ 2

2021/8/11

24

第24页/共84页

动态互连网络 (1)

1100

1110 1101

1111

0010

0011

1010

并行算法PPT课件

学习方式: ▪ 课程讲授、大作业和课堂讨论相结合

2021/3/12

《并行算法》 5 / Ch0

0.2 课程简介: 教材和主要参考书目

教材: ▪陈国良, 并行算法的设计与分析

《并行算法》 3 / Ch0

主要内容

0.1 任课教师和课程主页 0.2 课程介绍

▪ 课程内容、特点和授课方式 ▪ 教材和主要参考书目 ▪ 课程在并行计算技术中的地位 0.3 课程考核和评分要求 0.4 并行计算介绍 ▪ 什么是并行计算? ▪ 为什么需要并行计算? ▪ 几种实现方案 ▪ 并行计算的粒度 ▪ 并行计算的研究领域 ▪ TOP500和China TOP50 ▪ 问题示例

2021/3/12

《并行算法》 10 / Ch0

0.4 并行计算介绍: 什么是并行计算?

A parallel computer is a “collection of processing elements that communicate and cooperate to solve large problem fast”. –-David E. Culler

▪ 课程内容、特点和授课方式 ▪ 教材和主要参考书目 ▪ 课程在并行计算技术中的地位 0.3 课程考核和评分要求 0.4 并行计算介绍 ▪ 什么是并行计算? ▪ 为什么需要并行计算? ▪ 几种实现方案 ▪ 并行计算的粒度 ▪ 并行计算的研究领域 ▪ TOP500和China TOP100 ▪ 问题示例

2021/3/12

《并行算法》 4 / Ch0

0.2 课程介绍: 内容、特点和学习方式

并行算法讲稿

从以上一个简单的例子我们可以看到并行算法的真谛 !所以这么说基于普通的算法大家开始加,串行从1到 100加很累,而这个高斯思想的并行处理结果又快又准 确!体现出了这个思想,由此引申到计算机并行处理可 以看出它潜力巨大,对解决现实问题有很大的指导作用 ,希望大家认真听讲。

那么什么叫并行算法?

科学家已经定义为:利用并行计算机系统进行数据与 信息的并行处理称为并行计算。

{for i=1 to n do

for j=1 to n do

ci,j

=0 for

k=1

to

n

do

} ci,j += ai,k*bj,k

并行算法:

for i=1 to n do

for all Pj j=1 to n do ci,j = 0 // Ci. = 0

for k=1 to n d // Ci. = ∑ai,k * Bk. for all Pj j=1 to n do ci,j += ai,k*bk,j

(3)粒度(granularity)

三.并行计算基本概念

粒度是各个多处理机可独立并行执行的任务大小的度量 。大粒度反映可并行执行的运算量与程序量大,有时称 粗粒度。任务级并行的粒度大于语句级的并行。向量机 主要是对内层Do循环语句作向量化,所以向量化是一种 小粒度(细粒度)并行;在网络并行计算中,由于通信 开销比较大,应尽量采用粗粒度方式。

复杂性,即增加空间的维数,增加处理器的台数,来减少算 法实现所需的时间。从算法的结构观察,通常的串行算法树 “深而窄”,而并行算法树结构截然不同。为达到把时间的复 杂性转化为空间复杂性的目的,并行算法树采用了“浅而宽” 的结构。

(2)并行加速比

并行加速比表示采用多个处理器计算速度所能达到的加速 的倍数。

计算机基础知识理解计算机中的并行计算和多核处理器

计算机基础知识理解计算机中的并行计算和多核处理器在计算机科学领域中,计算机的性能提升一直是一个重要的研究方向。

而并行计算和多核处理器技术的引入为计算机性能的提升带来了重要的突破。

一、并行计算的概念和原理并行计算是指在同一时间内,多个任务可以同时进行,从而提高计算效率。

这是通过将一个问题拆分为多个子问题,并使用多个处理单元同时处理,最后再将各个子问题的结果进行合并得到最终解决方案。

并行计算的原理包括任务并行和数据并行。

任务并行是指将一个任务划分为多个子任务,然后由不同的处理单元分别处理,最后通过数据通信和同步机制进行结果的合并。

数据并行是指将同一个任务的数据划分为多个部分,然后由多个处理单元并行处理各自的数据,最后将结果进行合并。

二、多核处理器的介绍和原理多核处理器是指在一个芯片上集成了多个处理核心的处理器。

与传统的单核处理器相比,多核处理器能够并行地执行多个任务,从而提高系统的整体性能。

多核处理器的原理是将计算密集型的任务分配给不同的处理核心进行处理,而将串行和通信密集型的任务交给专门的处理核心进行处理。

多核处理器有两种形式:对称多处理器(SMP)和异构多处理器(AMP)。

在SMP架构中,每个处理核心都是相同的,并且共享同一片内存和总线。

而在AMP架构中,每个处理核心可以具有不同的性能和特点,它们可以独立地运行不同的任务。

三、并行计算和多核处理器的应用并行计算和多核处理器技术在各个领域都有着重要的应用。

在科学计算领域,它们被广泛应用于模拟和仿真、大规模数据处理和分析等任务。

在人工智能领域,它们被用于深度学习和机器学习算法的训练和推理。

在图像和视频处理领域,它们被应用于图像处理、视频编解码等任务。

并行计算和多核处理器技术还在云计算和大数据领域有着重要的应用。

通过将大规模的计算任务分配给多个处理核心并行处理,可以加快任务的执行速度,提高系统的负载均衡和资源利用率。

同时,多核处理器技术还能够提供更好的响应时间和性能预测能力,使得云计算和大数据系统能够更加高效地运行。

并行计算讲义

燕山大学课程讲义并行计算导论授课人:郭栋梁学时:32学时其中实验课:8学时三级项目:16学时第1章引言1.1概述单处理器计算机即将成为过时的概念.我们需要考虑如下因素来着手改进提高计算机的性能:(1)单纯依靠单处理器很难提升现有计算机的性能.即使有一个性能十分强大的单处理器,其功耗也让人无法接受.想要提升计算机的性能,更加可行的方法是同时使用多个简单处理器,它所能达到的性能可能是现有单处理器计算机性能的几千倍。

(2)观察结果显示,除非使用并行处理技术,一个程序在一台型号更新的单处理器计算机上的运行速度,可能比在旧的计算机上的运行速度更慢。

能依照给定算法检测出程序中的并行结构的编程工具还有待开发。

此算法需要能够检测出变ja之间的依赖关系是否规则;而且不管这些依赖是否规则,此算法都能在保证程序正确性的前提下,通过将程序中的一些子任务并行化来加速程序的执行。

(3)提升未来的计算机性能的关键就在于并行程序的开发,这涉及各个层面的工作:算法、程序开发、操作系统、编译器及硬件设备。

(4)并行计算除了要考虑到参与并行计算的处理器的数量,还应该考虑处理器与处理器、处理器与内存之间的通信。

最终计算性能的提升既依赖于算法能够提升的空间,更依赖于处理器执行算法的效率。

而通信性能的提升则依赖于处理器对数据的供应和提取的速度。

(5)内存系统的速度始终比处理器慢,而且由于一次只能进行单个字的读写操作,内存系统的带宽也有限制。

(6)内存系统的速度始终比处理器慢,而且由于一次只能进行单个字的读写操作,内存系统的带宽也有限制。

本书内容主要涉及并行算法与为了实现这些算法而设计的硬件结构。

硬件和软件是相互影响的,任何软件的最终运行环境是由处理器组成的底层硬件设备和相应的操作系统组成.我们在本章开始的部分会介绍一些概念,之后再来讨论为了实现这些概念有哪些方法和限制.1.2自动并行编程对于算法在软件中的实现过程我们都很熟悉。

在编程并不需要了解目标计算机系统的具体细节,因为编译器会处理这些细节.但是在编程和调试时依旧沿用着在单一央处理器(CPU)上顺序处理的模式.从另一方面讲,为了实现并行算法,硬件和软件之间的相互联系需要比我们想象的更加密切。

学习并行计算的基础知识

学习并行计算的基础知识并行计算是一项关键的计算机科学领域技术,它将任务分解为小的子任务,然后在多个处理器上同时执行这些子任务。

并行计算的概念源自于对计算效率的追求,因为串行计算往往无法满足日益增长的计算需求。

本文将介绍并行计算的基础知识,包括并行计算的定义、优点、应用和一些相关概念。

在简单了解并行计算的概念之前,我们先来明确串行计算和并行计算的区别。

串行计算即直接按照任务的顺序逐一执行,而并行计算则将任务分成多个子任务,在多个处理器上同时执行,从而提高整体的计算效率。

并行计算通过同时使用多个处理器,可以在短时间内完成更多的工作,极大地提高了计算速度和吞吐量。

并行计算有许多优点,首先是明显的性能提升。

并行计算可以将单一任务分解为多个子任务,在多个处理器上并行执行,所以相较于串行计算,它可以更快地完成任务。

其次,并行计算提高了系统的可用性和可靠性。

当一个处理器发生故障时,其他处理器仍然可以正常工作,从而保证整个系统的运行。

另外,并行计算还可以处理大规模的数据和复杂的计算问题,从而使得在科学、工程和商业领域等各个领域都能够得到广泛应用。

并行计算的应用广泛且多样。

在科学领域,各种模拟和数据处理问题都可以通过并行计算来解决,如天气预报、地球物理学模拟等。

在工程领域,并行计算可以用于设计和仿真各种产品,如飞机、汽车等。

在商业领域,比如金融业,由于需要处理大量的数据和进行复杂的风险评估,所以对并行计算有着很高的需求。

为了更好地理解并行计算,有几个相关的概念需要了解。

首先是任务并行和数据并行。

任务并行是将一个大任务分解为多个小任务,并行地执行,各个子任务之间相互独立;而数据并行是将一个大的数据集分成多个小的数据集,然后在多个处理器上同时处理。

其次是同步和异步。

同步即任务之间需要相互等待,一旦一个任务完成,其他任务才能继续执行;而异步则是任务可以独立执行,不需要等待其他任务的完成。

最后是并行计算的挑战,如任务的调度、数据的通信和负载均衡等问题都是需要解决的难题。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

王振海 西北工业大学理学院 西北工业大学高性能计算研究与发展中心

2019/3/17

1

主要内容

MPI并行编程环境

进程与消息传递 MPI并行程序设计入门 初步的MPI消息传递函数

先进的MPI函数

MPI并行程序示例

面向性能的程序设计

2019/3/17 2

ቤተ መጻሕፍቲ ባይዱ

并行编程环境简介

目前,高性能并行机主要可以分为对称多处理共 享存储并行机(SMP, Symmetric MultiProcessor)、 分布式共享存储多处理机 (DSM, Distributied Shared Memory)、大规模并行处理机(MPP, Massively Parallel Processor)和微机机群(Cluster) 等四类。在这些并行机上,并行程序设计平台主 要可分为消息传递、共享存储和数据并行三类, 其中消息传递具有很好的可移植性,它能被所有 这些类型的并行机所支持,而共享存储只能在在 SMP和DSM并行机中使用,数据并行只能在SMP, DSM和MPP并行机上使用。

2019/3/17 4

MPI并行环境的应用现状

MPI是全球工业、政府和科研部门联合推出的适合 进程间进行标准消息传递的并行程序设计平台,最初 版MPI 1.0本于1994年6月推出,目前最新的为MPI 2.0 版,于1998年10月推出。 MPI的具体实现:MPICH和LAMMPI,目前均已实 现MPI 1.2版,适用于任何并行计算平台;部分并行 机已实现MPI 2.0版。 MPI是目前应用最广的并行程序设计平台,几乎被 所有并行计算环境(共享和分布式存储并行机、MPP、 机群系统等)和流行的多进程操作系统(UNIX、 Windows NT)所支持,基于它开发的应用程序具有 最佳的可移植性。 2019/3/17 5

目前,各类并行机,特别式微机机群,只实现了MPI 2.0的部分功能。本中心机群所支持的为MPI 1.2.5版本。

2019/3/17 7

MPI并行编程环境

进程与消息传递

MPI并行程序设计入门

初步的MPI消息传递函数

先进的MPI函数 MPI并行程序示例 面向性能的程序设计

2019/3/17 8

单个进程(process)

2019/3/17 6

MPI并行环境的应用现状(续)

MPI 2.0版在1.0版的基础上,增加了如下的消息传递 功能:(1)并行I/O:允许多个进程同时读写同一个文 件;(2)线程安全:允许 MPI 进程的多个线程执行, 即支持与 OpenMP 的混合并行编程;( 3 )动态进程管 理:允许并行应用程序在执行过程中,动态地增加和 删除进程个数;(4)单边通信:允许某个进程对其它 进程的局部内存单元直接执行读写访问,而步需要对 方进程的显式干预;(5)并行应用程序之间的动态互 操作:允许各个MPI并行应用程序之间动态地建立和删 除消息传递通道。

2019/3/17 10

单机内多个进程(续)

最基本的消息传递操作:发送消息( send)、 接受消息( receive)、进程同步( barrier)、 规约(reduction)。 消息传递的实现:共享内存或信号量,用户不 必关心。

2019/3/17

11

包含于通过网络联接的不 同计算机的多个进程

单机内多个进程

多个进程可以同时存在于单机内同一操作系统: 由操作系统负责调度分时共享处理机资源( CPU、 内存、存储、外设等)。 进程间相互独立(内存空间不相交):在操作 系统调度下各自独立地运行,例如多个串行应用 程序在同一台计算机中运行。 进程间可以相互交换信息:例如数据交换、同 步等待,消息是这些交换信息的基本单位,消息 传递是指这些信息在进程间的相互交换,是实现 进程间通信的唯一方式。

MPI并行环境的应用现状(续)

目前高效率的超大规模并行计算( 1000 个处理 器)最可信赖的平台。 工业、科学与工程计算部门的大量科研和工程 软件(气象、石油、地震、空气动力学、核等) 目前已经移植到MPI平台,发挥了重要作用。 MPI的优点:(1)具有很好的可移植性,几乎 被所有的并行环境支持;(2)具有很好的可扩展 性,是目前高效率的大规模并行计算最可信赖的 平台;( 3)比其它消息传递系统好用;(4 )有 完备的异步通信功能;(5)有精确的定义,从而 为并行软件产业的发展提供了必要的条件。

2019/3/17 3

MPI并行编程环境

消息传递并行编程环境(MPI:Message Passing Interface) 是目前国际上最流行、可移植性和可扩展 性很好的并行程序设计平台,并被当前流行的所有高 性能并行机所支持。它是在标准串行程序设计语言 (C,Fortran,C++)的基础上,再加入实现进程间 通信的MPI消息传递库函数,就构成了MPI并行程序 设计所依赖的并行编程环境。 MPI已经在Windows系列的非Unix、Linux平台上实现, 其程序设计语言支持C, Fortran和Java。在国产的三 大并行机系列神威、银河和曙光上也都实现了对MPI 和支持。

进程是一个程序,同时包含它的执行环境(内 存、寄存器、程序计数器等),是操作系统中 独立存在的可执行的基本程序单位。 通俗理解:串行应用程序编译形成的可执行代 码,分为“指令”和“数据”两个部分,并在 程序执行时“独立地申请和占有”内存空间, 且所有计算均局限于该内存空间。 进程1 进程2 内存

2019/3/17 9

进程独立存在:进程位于不同的计算机,由各 自独立的操作系统调度,享有独立的 CPU 和内存 资源。 进程间相互信息交换:消息传递。

消息传递的实现:基于网络 socket 机制 , 用户不 必关心。

2019/3/17

12

消息传递库函数

应 用 程 序 接 口 ( API): 提 供 给 应 用 程 序 ( FORTRAN、C、C++ 语言)的可直接调用的完 成进程间消息传递的某项特定功能的函数。 消息传递库:所有定义的消息传递函数编译形 成的软件库,调用其内部函数的应用程序,通过 与之联接,即可成为可并行执行的程序。 目 前 流 行 的 消 息 传 递 函 数 库 : PVM 3.3.11、 MPICH 1.2、LAMMPI 6.4等。