基于向量空间模型的文本分类

向量空间算法在信息检索中的使用

向量空间算法在信息检索中的使用向量空间模型(Vector Space Model)是一种常见的信息检索模型。

它将文本数据表示为向量的形式,利用向量运算来比较文本的相似性,从而实现检索。

向量空间模型的基本思想是:将文本集合看作向量空间中的点集,每篇文本可以表示为一个向量,向量的每个维度表示一个特征,例如单词出现的频率。

这样,文本就可以用一个向量来表示了。

在这个模型中,可以用余弦相似度(Cosine Similarity)来计算两个文本向量之间的相似度。

余弦相似度是基于向量的夹角计算的,夹角越小,余弦相似度越大,相似度也就越高。

向量空间模型在信息检索中的应用非常广泛。

这里列举几个常见的应用场景:1. 文本分类向量空间模型可以用来实现文本分类。

每个类别可以看作一个向量,在训练过程中,根据文本特征的权重调整向量的取值,最终建立一个分类模型。

分类时,将待分类文本转换成向量形式,然后通过比较其与各个类别向量的相似度来确定其所属类别。

2. 相似文本查找向量空间模型可以用来寻找相似的文本。

首先将所有的文本转换成向量形式,然后计算待查找文本与数据库中各个文本向量的相似度,最后按照相似度进行排序,选取相似度较高的文本作为结果。

3. 关键词匹配向量空间模型可以用来实现关键词匹配。

将待匹配文本表示为向量形式,然后将关键词也表示为向量形式,最后计算两个向量之间的余弦相似度,根据相似度来决定是否匹配成功。

在以上三个场景中,向量空间算法都可以很好地发挥作用,实现高效的检索和分类。

当然,这只是该算法在信息检索中的一些应用,还存在着许多其他精彩的应用场景,需要不断地探索和实践。

总之,向量空间算法是一种巧妙的算法,它将复杂的文本数据转换为简单的向量形式,从而方便地进行处理。

在信息检索中,向量空间算法已经成为了一种基础工具,可以帮助我们处理各种复杂的问题。

基于向量空间模型的中文文本层次分类方法研究

rs e tv l .F n l , e p r n s ls s o t a h e p r a h,p p s d i h s p p r o t e o ms pan o e e c e p ciey ial y x i e me tr u t h w h tt e n w a p c e o o r o e n t i a , u p r r li r g n r e f i he a c ia t o swi mp o e c u a y ir rh c meh t i r v d a c r c . l d h

维普资讯

第2 6卷 第 5期

20 0 6年 5 月

文 章 编 号 :0 1— 0 1 20 ) 5—12 0 10 9 8 (0 6 0 15— 2

计 算机应 用

Co utrAp l ains mp e p i t c o

V l2 o 5 o _ 6 N .

Hir r h c lc tg rz t n meh d fC i ee tx a e n v co p c d l e a c ia a e o iai t o so hn s e tb s d o e t r s a emo e o

XI e HE Z o g s i AO Xu , h n —h

bt f tr sl t n a d ct o zt n m to , e e o , et e D a Slc o F S , nd a grh f o e ue e ci a gr a o ehd h a e o n e i i a nw m t d h F a r u -eetn( D ) a a o t o u l i n l i m

基于向量空间模型的公文分类系统研究与实现

利 用 当前流 行 的平 台技 术 和设计 架构 的高校 办 结果 。

公 系统 已趋 于成 熟 , 得 了很好 的应用 价值 , 大程 取 极

度上 实现 了办 公 管 理 的 t动 化 、 息 化 、 t 信 网络 化 要

1 文 本 分 类 技 术

. 求 , 而智 能化 程 度 却 较 低 。本 文 针对 办 公 信 息管 1 1 文本 分类技 术研 究现 状 然 理 的这一 要求 , 点 研究 了 贝叶 斯 文本 分 类 技 术 在 重

系 统 中 公 文 分 类 的 应 用 。 提 出 了 一 种 基 于 向 量 空 间模 型 的 贝 叶 斯 文 本分 类技 术 并将 其 应 用 到高 校 公 文 智 能 办 公 系 统 的 实 现

中, 给出了详细 的算法流程及设计步骤 , 最后 给出了示 例的实验 结果 及分析。实验结果表 明, 当训 练集合数 目有 限时 , 方法 该

Re e r h n m p e e t to fDo um e t Cl s i c to s a c a d I lm n a i n o c n a sf a i n i

S se s d On V e t r Sp c o l y t m Ba e co a e M de

T O Q u—xa g Y i A i in , U J n—k , U J —l n e T i i g a

( a c a g H n K n n e i , a ca g Ja g i 3 0 3 hn ) N nh n a g o g U i r t N n h n , in x 3 0 6 ,C ia v sy

i fr t n t c n lg n t e of e s se .A y s tx l s i c t n tc n q e b s d o e t rs a e mo e sp tfr a d a d i no ma i e h o o y i h f c y tms o i Ba e e tca sf ai e h iu a e n v co p c d li u o w r n s i o

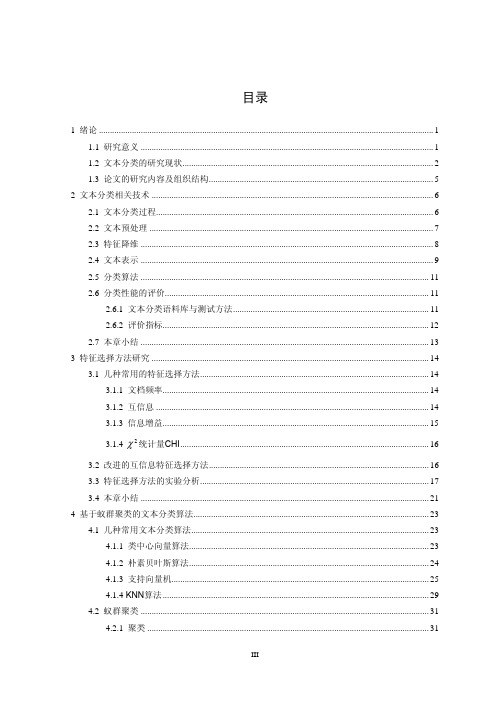

基于向量空间模型的文本分类研究

目录1 绪论 (1)1.1 研究意义 (1)1.2 文本分类的研究现状 (2)1.3 论文的研究内容及组织结构 (5)2 文本分类相关技术 (6)2.1 文本分类过程 (6)2.2 文本预处理 (7)2.3 特征降维 (8)2.4 文本表示 (9)2.5 分类算法 (11)2.6 分类性能的评价 (11)2.6.1 文本分类语料库与测试方法 (11)2.6.2 评价指标 (12)2.7 本章小结 (13)3 特征选择方法研究 (14)3.1 几种常用的特征选择方法 (14)3.1.1 文档频率 (14)3.1.2 互信息 (14)3.1.3 信息增益 (15)3.1.4 统计量CHI (16)2χ3.2 改进的互信息特征选择方法 (16)3.3 特征选择方法的实验分析 (17)3.4 本章小结 (21)4 基于蚁群聚类的文本分类算法 (23)4.1 几种常用文本分类算法 (23)4.1.1 类中心向量算法 (23)4.1.2 朴素贝叶斯算法 (24)4.1.3 支持向量机 (25)4.1.4 KNN 算法 (29)4.2 蚁群聚类 (31)4.2.1 聚类 (31)4.2.2蚁群聚类 (32)4.3 基于蚁群聚类的KNN分类算法 (35)4.4 分类算法的实验分析 (37)4.5 本章小结 (42)5 文本分类系统的设计与实现 (43)5.1 文本分类系统总体设计 (43)5.2 系统实现 (43)5.2.1训练模块 (44)5.2.2分类模块 (47)5.3 本章小结 (49)6 全文总结及未来工作展望 (50)6.1 全文总结 (50)6.2 工作展望 (50)参考文献 (52)致谢 (55)1 绪论1.1 研究意义随着计算机技术和网络技术的飞速发展,包括文本信息在内的各种信息资源呈现爆炸式增长。

面对如此庞大而且急剧膨胀的信息海洋,如何高效地组织和管理这些信息,并快速、准确、全面地从中搜索到用户所需要的信息是当前信息科学与技术领域面临的一大挑战[1]。

一种基于关键向量的文本分类模型

A e tc a sfc to o e a e n k Y v c o t x l s i a i n m d lb s d o e e t r i

Z HA0 o. DI B NG af Hu —u

(c ol f o ue cec n eh o g , ab nvr t o i c n eh o g , ab 500 C ia Sh o o mp t Si ead T cnl y H ri U iesyf S e eadT cn l y H ri 108 , hn ) C r n o n i c n o n

Ke r s d t n n ;tx ls i c t n;v c rs a e mo e y wo d : aa mii g e t a s ai c i f o et p c d l o

0 引言

上世纪 9 0年代 以来 , 联 网技 术得 到了快 速 的 互

向量的形式投影到该空 间中, 搜 索 引 擎 、 息 推 文 信

重) 向量在每一维上的分量对应该特征在这篇文本

中 的权 重 。

16 年 ,o r和 H r提出 了基于 向量空 间模 98 Cv e t a t

型的 ( —ersN i br KN a t e ho, e g ) 法 , 种 算 法 首 先 算 这

维普资讯

20 年g 2 07 1期

中图分类号 :P 8 T 11 文献标识码 : A 文章编号 :09 52 20 )2— 12— 3 10 —25 (07 1 02 0

一

种 基 于关 键 向量 的文本 分 类 模 型

赵 博 ,丁华福

( 哈尔滨理工大学计算机科学与技术学院,哈尔滨 108 ) 500

3 ~5 , % %)然后 用支持 向量集 学 习得 到新 知识 。同

文本处理中的向量空间模型

向量空间模型在文本处理中的应用引言在信息检索和自然语言处理领域,向量空间模型是一种常用的文本表示方法。

它将文本转换为向量形式,通过计算向量之间的相似度来实现文本分类、聚类和检索等任务。

本文将详细介绍向量空间模型在文本处理中的原理、应用和优化方法。

1. 向量空间模型的原理向量空间模型基于词袋模型,将文本表示为一个高维向量。

每个维度代表一个词语,而向量中的值表示该词语在文本中出现的次数或权重。

通过这种方式,可以捕捉到不同词语在文本中的重要性和关联性。

具体而言,向量空间模型包括以下步骤:1.文本预处理:去除停用词、标点符号等无关信息,并进行词干化或词形还原等操作。

2.构建词典:将所有文档中出现过的词语构建成一个词典。

3.文档表示:对每个文档进行向量化表示,常见的方法有计算词频(TermFrequency)或使用TF-IDF(Term Frequency-Inverse DocumentFrequency)对词频进行加权。

4.向量相似度计算:通过计算向量之间的余弦相似度或欧氏距离等指标,来度量文本之间的相似性。

2. 向量空间模型的应用向量空间模型在文本处理中有广泛的应用,包括但不限于以下几个方面:2.1 文本分类文本分类是将文本分为不同类别的任务。

向量空间模型可以将每个文档表示为一个向量,并使用分类算法(如朴素贝叶斯、支持向量机等)进行分类。

通过对训练集进行学习,可以构建一个分类器,用于对新文档进行分类。

2.2 文本聚类文本聚类是将相似的文档分到同一类别的任务。

向量空间模型可以通过计算向量之间的相似度,将相似的文档聚在一起。

常见的聚类算法有K-means、层次聚类等。

2.3 文本检索文本检索是根据用户输入的查询词,在大规模文本库中找到相关文档的任务。

向量空间模型可以将用户查询和每个文档表示为向量,并计算它们之间的相似度。

通过排序相似度得分,可以返回与查询最相关的前几个结果。

2.4 信息抽取信息抽取是从文本中提取结构化信息的任务。

哈特曼算法-概述说明以及解释

哈特曼算法-概述说明以及解释1.引言1.1 概述哈特曼算法是一种常用的文本分类算法,它经常被应用于信息检索、自然语言处理以及机器学习等领域。

该算法的核心思想是通过计算文本中每个单词的权重,来判断该文本属于哪个类别。

相比于传统的基于规则的文本分类方法,哈特曼算法具有更高的准确性和可靠性。

该算法的原理基于向量空间模型和向量相似度计算。

首先,将待分类的文本表示为一个向量,其中每个维度代表一个单词的权重。

然后,通过计算待分类文本与已知类别文本之间的相似度,来确定待分类文本属于哪个类别。

哈特曼算法的优点之一是能够处理大规模的文本数据。

由于它使用了文本的向量表示,可以很好地处理高维稀疏的数据。

此外,该算法还可以自动学习文本中的关键特征,无需人工干预。

这使得哈特曼算法在大数据时代具有广泛的适用性。

除了在文本分类领域应用广泛外,哈特曼算法还可以用于其他领域的问题。

例如,在情感分析中,可以利用哈特曼算法对文本进行情感极性的分类;在垃圾邮件过滤中,可以使用该算法将垃圾邮件与正常邮件进行区分;在推荐系统中,可以通过该算法将用户的兴趣进行分类,从而为用户提供个性化的推荐。

综上所述,哈特曼算法是一种强大而灵活的文本分类算法,通过计算文本中单词的权重和相似度,可以准确地将文本分配到不同的类别中。

它的优点在于能够处理大规模的文本数据,并且具有广泛的应用领域。

在未来的研究中,可以进一步改进该算法的性能,使其在各个领域都能发挥更大的作用。

文章结构:文章主要包含三个部分,即引言、正文和结论。

1. 引言部分介绍了本文的概述、文章结构和目的。

- 1.1 概述:对哈特曼算法进行简要介绍,说明该算法在信息检索领域中的重要性和应用背景。

同时,概述该算法的基本原理和特点。

- 1.2 文章结构:本部分具体说明文章的整体结构和各个章节的内容。

- 1.3 目的:明确本文的写作目的,即通过对哈特曼算法的介绍和分析,探讨其优点和应用,进一步推广和应用该算法。

基于词向量空间模型的中文文本分类方法

第3 0卷 第 1 0期 20 0 7年 1 0月

合 肥 工 业 大 学 学 报 (自然科 学版 )

J OURNAL OF E H FEI NI U VERS TY I OF TECHNOLOGY

Vo. 0No 1 13 . 0

p e e t d me h d h sh g e r cso n fi in y r s n e t o a i h rp e ii n a d e f e c 。 c

Ke r s t x ae o iain;v co p c o e;K — e r s eg b r y wo d :e tc tg r to z e t rs a em d l n a e tn ih o ;wo d v co p c d l r e t rs a emo e

似度 。实验证 明, ;向量空 间模型 ;K_ 最近邻 居 ; 向量空间模型 词

中图 分 类 号 : P 8 T 12 文献标识码 : A 文 章 编 号 :0 35 6 (0 7 1—2 10 10 —0 0 2 0 )01 6 —4

摘

要: 大多文本分类方法是基于 向量空间模 型的 , 基于这一模型 的文本 向量维数较高 , 导致分类器效率难 以

提高 。针对这一不足 , 该文提出基于词 向量空间模 型的文本 分类 方法 。其 主要思想是把文本 的特征词表示成 空间向量 , 通过训练得到词一 类别支持度 矩阵 , 据待分文 本的词 和词— 根 类别 支持度 矩 阵计 算文本 与类 别 的相

文本 分类 是指把 一组 预先 由专家 分类 过 的文 本 作为训 练集 , 对训 练集进 行分 析得 出分类 模式 , 用 导 出的分类模 式对其 他 文本加 以分 类 _。它 主 1 ] 要应 用于信 息检 索 、 机器 翻译 、 自动文 摘及信 息过

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

基于向量空间模型的文本分类

在向量空间模型中,文档以由n 个词组成的向量表示(这些词从文档集中选取得到),词也可以由m 篇文档组成的向量表示。

在实际使用中,用“文档向量矩阵”X 能最好的代表这种对偶的信息表示,其中一列j X ∙代表一个词、一行∙i X 代表一篇文档:

⎪⎪⎪⎪⎪⎭⎫ ⎝⎛==⎪⎪⎪⎪⎪⎭⎫ ⎝⎛=∙∙∙∙∙∙m n mn m m n n X X X X X X x x x x x x x x x X

2121212222111211),,,( 矩阵中的元素ij x ,一般表示词j 在文档i 中出现的频数;也可以根据其他因素调整它的权重

[4]。

比如,以反向文档频率(IDF: Inverse Document Frequency )调整:

)/log(*j ij ij df m tf x =

其中,文档频数j df 是出现词j 的文档数量。

说明一下,由于一个词只会在很少的文档中出现,因此矩阵X 中的大多数元素都会是零。

信息检索的典型处理方式就是关键字匹配。

用户提出一个查询q ,然后用和文档一样的方式,把它看成一个由关键字组成的向量。

通过计算查询向量和文档向量之间的点积(对向量的规一化消除文档长度的影响),可以得出两者之间的相似度。

所有m 篇文档的相似度可以构成一个向量s(T

Xq s =),查询q 的相关文档就可以根据这个指标排序并返回给用户。

文本分类,就是把新的文档归到已有的类别体系中去。

有很多方法可以实现这个目的,一种简单的分类方法是为每个类别计算一个中心向量i C (类中所有文档向量的平均值)[5]。

这些中心向量被认为是每个类别的代表。

所有k 个类别的k 个中心向量,组成一个n k ⨯ 的矩阵T k 21)c ,,c ,(c C ⋅⋅⋅=。

判别文档属于某个类的标准是,该文档距离哪个类别的中心向量更近。

其他的方法[6]则是通过最小化误差平方和C ,来解决文本分类问题,C 的定义如下: ||||min arg B CX C T C

-= 其中,B 是保存训练集文档的正确类别信息的m k ⨯矩阵。

一篇新进文档,要通过投影到变换向量上得到与每个类的相似度,并由具体的阈值,决定其到底属于哪个类或哪几个类。

应用LSI 模型的文本分类

在原始的“文档向量矩阵”中,存在着冗余、词语多义和噪音问题。

我们希望建立一个比原始矩阵小得多,并只包含有效语义的子空间。

要达到这个目的,一般可以通过有效的维数约减。

维数约减后,冗余的信息可以合并在一起,词语多义可以通过考虑上下文相关信息解决,把相对不重要的一些特征约去则可以部分解决噪音问题。

LSI 就是这样一种维数约减方法。

它可以通过对“文档向量矩阵”进行解奇异值分解(SVD: Singular Value Decomposition )运算,自动计算得到一个比原始空间小得多的有效语义空间:

⎪⎪⎪⎭⎫ ⎝⎛⎪⎪⎪⎭⎫ ⎝⎛==∑=r r r r

i i i i v v u u v u X 1111),,(σσσ

其中,r 是矩阵X 的阶,()∑≡r r diag σσ 1是由特征值构成的对角矩阵,

),,(1r r u u U ⋅⋅⋅=和),,(1r r v v V ⋅⋅⋅=分别是左、

右特征向量。

一般r 个特征值是按大小排序的,当要进行特征值截取的时候,比如只保留前k 个最大的特征值,下面的矩阵就是原始矩阵的非常好的近似:

T T V U V U X k k k r r r ∑≈∑=

在得到的k 维子空间中,一篇文档∙i X 的投影是k i V X ∙,而所有m 篇文档的投影就是k k k U XV ∑=。

查询q 的变换方式也是如此。

因此,查询q 和文档之间的相似度计算在LSI 的子空间中就变成了:

))(())((T T T q V U qV X V s k k k k k ∑==

维数的大量约减,既降低了计算的复杂度也滤去了一部分噪音。

比如,求矩阵中心向量或作矩阵变换的计算量就从n m ⨯变成了k m ⨯ [5]。

这样的方法在朴素贝叶斯分类模型[7]、KNN 模型和SVM 模型[8]中都被证明是非常有效的,提高了分类模型的准确度。

LSI 成功的原因在于,LSI 得到的语义空间比原始特征空间更能表达分类必须的语义结构,部分地解决了信息检索中的同义词和文本分类中的信息冗余问题。

在数学上,通过SVD 选取的矩阵是原始矩阵X 在k 阶情况下的最佳近似。

从统计观点看,LSI 和主成分分析类似,是一种非常有效的维数约减方法。

即:认为特征值较小的维是噪音,并将其滤去。

然而,LSI 在降低维数的同时也会丢失结构信息。

实际上,LSI 基于文档信息来建立语义空间(文档的类别信息并未考虑),得到的空间会保留原始矩阵中最主要的全局信息。

但有一种情况是:一些对特定类别分类贡献很大的特征,放在全局下考虑却会变得不重要了。

这样的特征在维数约减的过程中,就很容易被滤掉,而如果这样,特定类别的分类精度就会受影响。

要解决这个问题,文档的类别信息就应该也被考虑进来。

以传统方式使用LSI 的另一个问题是:没有理论说明,在得到的语义空间中到底应该保留多少维,而维数的变化对最后的结果又有很大的影响[8]。

在实际使用中,人们一般中只能通过反复的实验来确定这个值。